Sep

25

En realidad, las galaxias no deberían existir

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Curiosidades ~

Clasificado en Curiosidades ~

Comments (0)

Comments (0)

En los temas que estos días hemos tratado, ha sido la protagonista la “hipotética” materia oscura que, según algunos modelos supone el 90% de la materia que compone el universo. El tema ha dado pie a opininiones y algún debate que principalmente han llevado adelante Kike y Fandila que, con sus indudables conocimientos y formas de aplicar la lógica, nos llevan de la mano, con alguna metáfora incluída, a que podamos comprender mejor como son las cosas que, no siempre, coinciden con la realidad que algunos nos dibujan. Y, nuestra obligación, aunque el dibujo sea hermoso, armonioso y hasta placentero, debemos desconfiar, y, tomarlo, tan sólo como algo posible, algo que podría ser pero que de momento no es. Acordaos de aquel sabio que nos dijo: Todas las cosas son”. Con aquella simple frase, elevó a las “cosas” a la categoría de ser. Claro que las cosas a las que se refería estaban allí y podíamos contemplarlas. Por el contrario, la “materia oscura” nadie la vio nunca, es algo imaginario y supuesto que, al parecer, nos señalan algunos indicios observados, por lo demás, nada podemos concretar de ella.

Nuestro Universo es tan complejo que, seguramente, todo lo que hemos podido saber de él, es sólo una pequeñísima parte de lo que es. Quizá el inmenso trabajo y esfuerzo, el ingenio de muchos, la intuición de algunos, la genialidad de unos pocos, el avance, costoso avance en el campo de las matemáticas, todo ello unido como un todo, nos ha traído hasta aquí, un momento en el que, se podría decir sin temor a equivocarnos que estamos en la línea de partida para comenzar el camino hacia más grandes logros. Creerse más que eso, sería engañarnos a nosotros mismos, dado que, la cruda realidad es que sabemos menos de lo que creemos y decimos que sabemos.

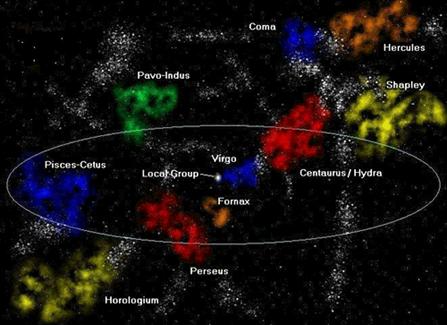

Arriba contemplamos la conocida y familiar imagen de una Galaxia y, si alguien nos preguntara como pudieron formarse las galaxias, la verdad sería que, no tendríamos contestación para esa pregunta. ¿Cómo es posible eso a estas alturas? Pués porque lo que podemos resumir de la moderno visión del universo se podría limitar a dos breves afirmaciones: Primera; el universo ha estado expandiéndose desde que se formó, y en el proceso ha evolucionado desde las estructuras simples a las complejas. Segunda: la materia visible en el universo está organizada jerárquicamente: las estrellas agrupadas en galaxias, las galaxias en cúmulos y los cúmulos en supercúmulos. El problema al que nos enfrentamos por tanto, es comprender como un universo cuya evolución está dominada por la primera afirmación, puede llegar a tener la estructura descrita en la segunda afirmación.

El problema de es explicar la existencia de la galaxias ha resultado ser uno de los más espinosos de la cosmología. Con todo derecho no deberían estar ahí y, sin embargo, ahí están. Es difícil comunicarl el abismo de frustración que este simple hecho produce entre los científicos. Una y otra vez han surgido nuevas revelaciones y ha parecido que el problema estaba resuelto. Cada vez la solución se debilitaba, aparecían nuevas dificultades que nos transportaban al punto de partida.

Cada pocos años, la American Physical Society, la Asociación Profesional de físicos, tienen una sesión en una de sus reuniones en la que los Astrofísicos hablan de los más nuevos métodos de afrontar el problema de las galaxias. Si te molestar en asistir a varias de esas reuniones, dos son las sensaciones contradictorias que te embargan: Por una parte sientes un gran respeto por la ingenuidad de algunas propuestas que son hechas “de corazón” y, desde luego, la otra sensación es la de un profundo excepticismo hacia las ideas que proponían, al escuchar alguna explicación de cómo las turbulencias de los agujeros negros, las explosiones durante la formación de galaxias, los neutrinos pesados y la materia oscura fría resolvía todos aquellos problemas.

Lo cierto es que, a pesar de lo que se pueda leer en la prensa en comunicados oficiales, todavía no tenemos ese “bálsamo milagroso” que nos permita responder a una pregunta simple: ¿Por qué está el cielo lleno de galaxias?

Es cierto, el cielo está lleno de cúmulos de galaxias y nosotros, tratándo de saber de su presencia allí, hemos llegado a conseguir eliminar muchas de las respuestas equivocadas. Podemos estar ahora mucho más cerca de la verdad de lo que lo estábamos antes. Pero, de ninguna manera sería bueno que nos dejémos adormecer por la credulidad de los postulados modernos que parecen “sacados de la manga” del jugador cosmológico, para que la partida salga redonda. Claro que, una cierta dosis de excepticismo no implica que no podamos aceptar como probables y ciertas, algunas de las ideas generales implícitas en las soluciones propuestas que podrían, al final de todo el camino, ser parte de la solución que buscamos.

Formalmente podríamos exponer aquí al menos cinco razones para tratar de justificar el por qué, las galaxias, no deberían estar ahí presentes.

1º) Las Galaxias no pueden haberse formado antes que los átomos. No es un asunto trivial. Durante muchisimos años se estuvo tratando de entender este proceso, comezando con ideas magicas, hasta que a principios del siglo 19 se empezo a a comprender como funcionan las estrellas y el Universo.

Es un proceso algo complicado, por eso se tardo tanto en reconocerlo. En este momento la mejor teoria que explica el Universo es que comenzo con el Big-Bang, la explosion inicial que dio origen a todo. En la explosion, de origen todavia incierto, habia pura energia, y al expandirse se fue enfriando, como lo haria cualquier gas. Al llegar a un nivel de energia un poco mas bajo del inicial, se pudieron condensar de la energia las primeras particulas elementales (protones, neutrones, etc). Esto ocurrio en los primeros minutos. La famosa ecuacion de Einstein E = mc al cuadrado, implica que se puede transformar materia en energia, como en un reactor nuclear, y tambien la energia puede condensarse en materia, como en este caso. A los 300 mil años, el nivel de energia fue lo suficientemente bajo como para permitir la formacion de los primeros atomos.

La existencia protones, electrones y neutrones dispersos, que cuando se juntaron fue para formar los elementos quimicos mas elementales: Hidrogeno, Helio y algo de litio. Nada mas se formo, en la proporcion de 75% de hidrogeno, casi 25% de helio, y trazas de los otros elementos.

Aquella primera “sopa de plasma primordial” posibilitó que se juntaran protones y neutrones para formar el elemento más simple del Universo: El Hidrógeno,

Así, podemos partir de la base cierta de que, hasta donde sabemos, podemos pensar en el Universo durante aquellas primeras etapas de la expansión de Hubble estaba formado por dos únicos constituyentes: materia y radiación. La materia sufrió una serie de congelaciones al construir gradualmente estructuras más y más complejas. A medida que tienen lugar estos cambios en la formación de la materia, la manera en que interaccionan, materia y radiación cambian radicalmente. Esto, a su vez, desempeña un papel fundamental en la formación de galaxias.

La luz y otros tipos de radiación interaccionan fuertemente con partículas libres eléctricamente cargadas, del tipo de las que existían en el plasma que constituía el universo antes de que los átomos se formara. A causa de esta interacción, cuando la radiación se mueve por este plasma, colisiona con partículas, rebotando y ejerciendo una presión del mismo modo que las moléculas de aire, al rebotar sobre las paredes de un neumático, mantienen el neumático inflado. Si se diese el caso de que una conglomeración de materia del tamaño de una galaxia tratase de formarse antes de la congelación de los átomos, la radiación que traspasaría el material habría destruído el conglomerado, y, la radiación tendería a quedar atrapada dentro de la materia. Si tratase de salir, sufriría colisiones y rebotaría.

2º) Las galaxias no tuvieron tiempo de formarse. La Gravedad es la gran fuerza desestabilizadora del Universo, Nunca lo abandona del todo; siempre está actuando tratando de unir trazos de materia, En cierto sentido, la historia entera del Universo se puede pensar como un último y futil intento de superar la Gravedad.

Sería asombroso, dada la naturaleza universal de la fuerza gravitatoria, que no hubiera desempeñado un papel importante en la formación de las galaxias. Escribir sobre este apartado nos llevaría a tener que explicar muchas implicaciones que están presentes en la dinámica del universo en relación a la materia. De todas las maneras que la queramos mirar, la sensación que percibimnos es la de que, en aquellos primeros momentos, podía existir “algo” (no sabemos qué) que generaba también, como la materia bariónica normal, fuerza gravitatoria.

Inmensas turbulencias que generaban fuerzas eléctricas y moldeaba la materia y todo el entorno

3º) La turbulencia tampoco nos vale. El Impulso a travgés de la turbulencia es una idea simple, cuyas primeras versiones fueron aireadas alrededor de 1950. El postulado es: cualquier proceso tan violento y caótico como las primeras etapas del Big Bang no será como un río profundo y plácido, sino como una corriente de montaña, llena de espuma y turbulencias. En este flujo caótico podemos esperar encontrar remolinos y vórtices de gas. Lo cierto es que, en este maremagnun, era de todo punto imposible que las galaxias se pudieran formar.

4º) Las Galaxias no han tenido tiempo para formar cúmulos. Quizá estamos encontrando dificultades porque consideramos el problema de las galaxias desde un punto de vista muy estrecho. Quizá lo que deberíamos hacer es ver las cosas en una escala más grande y esperar que si entendemos como se forman los cúmulos de galaxias, la génesis de las galaxias individuales, se resolverá por sí misma. La idea nos conduce naturalmente a la cuestión de cómo se pueden haber formado concentraciones muy grandes de masa al comienzo de la vida del universo. Una de las ideas más sencillas sobre como puede haber sido el universo cuando los átomos se estaban formando es que no importa lo que estuviese pasando, la temperatura era la misma en todas partes. Este se llama modelo isotérmico.

Explicar aquí las implicaciones matemáticas a que nos llevaría explicar el modelo isotérmico, estaría bien pero, no parece imprescindible para finalizar este trabajo que, de manera sencilla, sólo trata de explicar que, las galaxias no se pudieron formar conforme a lo que hemos observado y sabemos del Universo, algo nos falta por saber y, alguna fuerza “oculta” debería haber estado allí presente para evitar que, la materia se dispersara con la expansión de Hubble y las galaxias se pudieran formar.

5º) Si la radiación marcha junto con la materia y la materia con las galaxias, la radiación de microondas cósmicas sería contradictoria. Si la radiación no se hubiera dispersado uniformemente, con independencia de la materia del universo, ¿dónde hubiera estado? siguiendo el procedimiento normal de la física teórica, consideraremos a continuación la tesis opuesta.

Supongamos que en el comienzo del universo materia y radiación estaban unidas. Si era así, allí donde se encontrara una concentración de masa, también habría una concentración de radiación. En la jerga de la Física se dice que esta situación es “adiabática”. Aparece siempre que tienen lugar en las distribuciones del gas cambios tan rápidos que la energía no puede transferirse fácilmente de un punto al siguiente.

Sabemos que, para hacer galaxias, la materia del universo tuvo que estar muy bien distribuída en agregados cuando se formaron los átomos. Pero, todo este resultado choca con uno de los hechos más notables del universo que conocemos. Si consideramos la radiación de microondas, que llega hasta nosotros desde la dirección del Polo Norte de la Tierra, y luego nos volvemos y miramos la radiación que viene del Polo Sur, encontramos que son casi completamente idénticas. De esta notable uniformidad se deduce que cuando la radiación se despareja de la materia deberá de estar muy uniformemente distribuida por todo el universo.

Radiación de fondo de microondas

El resultado final es este: lo que el proceso de formación de galaxcias requiere del entorno de microondas y lo que observamos de su uniformidad son cosas diametralmente opuestas. Lo primero requiere radiación para ser reunida con la materia; así, si la materia estuviera agrupada cuando los átomos se formaron, habría trazas de esa agrupación en el fondo cósmico de microondas de hoy.

Por otra parte, la uniformidad observada en el entorno de microondas implica que la radiación nunca podría haber estado tan agrupada; si lo hubiera estado, hoy no sería uniforme. Cuando se hacen detallados cálculos núméricos, los astrofísicos encuentran que es imposible conciliar estas dos exigencias en conflicto. La radiación de microondas no puede ser uniforme y no uniforme al mismo tiempo.

Todos los razonamientos anteriores nos llevan a pensar y demuestran muy claramente que, no podemos dar por supuesto un universo lleno de galaxias y, si de hecho lo está, debemos buscar la causa real que lo hizo posible. Explicar ese universo ha sido mucho más difícil de lo que muchos llegaron a pensar y, como se dice en el título de este trabajo, no tenemos una explicación, ni las razones de peso que justifiquen la presencia de las galaxias.

¿Qué había y estaba presente en el comienzo del Universo, que nosotros desconocemos pero que, hizo posible que las galaxias se pudieran formar?

Yo no lo se.

Estamos de nuevo en el punto de siempre: Nuestros conocimientos son limitados. Nuestra ignorancia… ¡Infinita!

emilio silvera

Sep

25

Conociendo los secretos del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (2)

Comments (2)

¿Qué le habrá pasado a esta galaxia? La inusual concentración de estrellas nos viene a decir que, una fusión con otra galaxia ha llevado el Caos a ese lugar y, los mundos que por ahí puedan estar situados…, si tienen vida inteligente, no creo que lo estén pasando nada bien. Así es la Naturaleza, no tiene en cuenta a sus observadores cuando tiene que ejecutar acciones que, como estas, cambiaran totalmente la región que fue para convertirla en otra nueva, con nuevas estrellas, nuevos mundos y… nuevas formas de vida.

Ahora sabemos lo que da al Universo su carácter distintivo y lo hace singular, distinto a otros que podría, nuestra mente imaginar, son Las Constantes de la Naturaleza. Esos números misteriosos, a la vez que dejan al descubierto nuestros conocimientos, también dejan al desnudo nuestra enorme ignorancia sobre el Universo que nos acoge. Pues, las medimos con una precisión cada vez mayor y modelamos nuestros patrones fundamentales de masa y tiempo alrededor de su invariancia. Sin embargo, no podemos explicar sus valores.

La velocidad de la luz en el vacío, c, es una de esas misteriosas constancias que perduran a través del tiempo y del espacio, nunca varía. De hecho, quizá sin un substrato semejante de realidades invariables no podrían existir corrientes superficiales de cambio ni ninguna complejidad de mente y materia. La velocidad de la luz, c, es una constante universal que marca el límite de velocidad del universo en el que nada, ninguna información, puede transmitirse más rápida que la velocidad de la luz. Einstein nos demostró que la velocidad de la luz en el vacío debería actuar como ese límite último de velocidad.

Con razón nos decía Planck:

“La ciencia no puede resolver el misterio final de la Naturaleza. Y esto se debe a que, en el último análisis, nosotros mismos somos parte del misterio que estamos tratando de resolver.”

Y, quizás por eso prcisamente, será necesario que contactemos con otros seres inteligentes, con otras Civilizaciones de fuera de la Tierra para que nos podamos conocer mejor, ya que, al compararnos con otras especies del Universo, podremos ver con diáfana claridad, quiénes somos, y, precisamente, tiene mucho que ver con las constantes del universo, dado que, de ser distintas, no estaríamos aquí.

Desde siempre hemos querido explorar el Universo y la física del mundo que nos rodea para obtener respuestas

Nunca nadie ha explicado el valor numérico de ninguna de las constantes de la Naturaleza. ¿Os acordáis del 137? Ese número puro, adimensional que guarda los secretos del electrón (e) de la luz (c) y del cuanto de acción (h). Hemos descubierto otras nuevas, hemos relacionado las viejas y hemos entendido su papel crucial para hacer que las cosas sean como son, pero la razón de sus valores sigue siendo un secreto escondido por la Naturaleza.

Buscar esos secretos profundamente ocultos, implica que necesitamos desentrañar la teoría más profunda de todas y la más fundamental de las leyes de la Naturaleza: Definir si las constantes que las definen están determinadas y conformadas por alguna consistencia lógica superior o si, por el contrario, sigue existiendo un papel para el azar. Si estudiamos atenta y profundamente las constantes de la Naturaleza, nos encontramos con una situación muy peculiar. Mientras parece que ciertas constantes estuvieran fijadas, otras tienen espacio para ser distintas de las que son y algunas no parecen afectadas por ninguna otra cosa del Universo.

En la imagen también, están presentes las constantes universales que hacen que todo sea como es

¿ Llegaron estos valores al azar?

¿ Podrían ser realmente distintos?

¿Cuán diferentes podrían ser para seguir albergando la existencia de seres vivos en el Universo?, o, si fueran ligeramente diferentes ¿qué seres ejercerían la primacía del planeta? ¿De qué manera incidiría en las formas de vida de los mundos?

¿Os imagináis mundos con insectos de más de un metro?

En 1.986, el libro The Anthropic Cosmológicas Principle, exploraba las diez maneras conocidas en que la vida en el Universo era sensible a los valores de las Constantes Universales. Universos con constantes ligeramente alteradas nacerían muertos, privados del potencial para desarrollar y sostener la complejidad que llamamos vida. En la literatura científica puede encontrarse todo tipo de coincidencias numéricas que involucran a los valores de las constantes de la Naturaleza.

He aquí algunas de las formulas propuestas (ninguna tomada en serio) para la constante de estructura fina, conocida como alfa (α).

Valor experimental: 1/α = 137,035989561….

En primer lugar, ha habido intentos de “demostrar” que 1/a es igual a las siguientes expresiones que utilizan una extensión especulativa de física conocida:

- Lewis y Adams…. 1/α = 8p(8p5/15)1/3 = 137, 384

- Eddington………….. 1/α = (162– 16)/2+16-1 = 137

- Wiler………………….. 1/α = (8p4/9)(245!/p5)¼ = 137,036082

- Aspden y Eagles.. 1/α = 108p(8/1.843)1/6 = 137,035915

Ciertamente, si las constantes fueran diferentes de lo que son, podrían existir otros mundos de extrañas conformaciones que ni podemos imaginar. ¿Que pasaría si la constante gravitacional, por ejemplo, fuese diferente? ¿Qué extraños sucesos se podrían contemplar?

Por supuesto, si la teoría M da al fin con una determinación del valor de 1/α podría parecerse perfectamente a una de estas fórmulas especulativas. Sin embargo, ofrecería un amplio y constante edificio teórico del que seguiría la predicción. Todos estos ejercicios de juegos mentales numéricos, se acercan de manera impresionante al valor obtenido experimentalmente pero el premio para el ingenio persistente le corresponde a Gary Adamson, cuya muestra de 137-logía se mostraron en numerosas publicaciones.

Estos ejemplos tienen al menos la virtud de surgir de algún intento de formular una teoría de electromagnetismo y partículas. Pero hay también matemáticos “puros” que buscan cualquier combinación de potencias de números pequeños y constantes matemáticas importantes, como p, que se aproxime al requerido 137,035989561…… He aquí algún ejemplo de este tipo:

- Robertson…………. 1/α = 2-19/4310/3517/4p-2 = 137,03594

- Burger……………….. 1/α = (1372+p2)1/2 = 137, 0360157

Ni siquiera el gran físico teórico Werner Heisemberg pudo resistirse a la ironía o irónica sospecha de que: “En cuanto al valor numérico supongo que 1/α = 24 33/p”.

La física se ha devanado los sesos con el 137 durante décadas. Werner Heisember, proclamó una vez que, “todas las fuentes de perplejidad que existen en la mecánica cuántica se secarían si alguien explicara de una vez el 137”.

¿Por qué alfa es igual a 1 partido por 137? El 137 es un número primo. Su inversa, 1/137, es un valor muy cercano al de la constante alfa, que (según la electrodinámica cuántica) caracteriza la interacción entre fotones y electrones. El nombre técnico de alfa es “constante de estructura fina“, y es una de las constantes físicas cuya predicción teórica mejor coincide con los datos experimentales. Los físicos han demostrado que el valor de alfa es el que tiene que ser para que exista un Universo como el nuestro. De hecho, si alfa variara apenas un poco (menos del 5%), el carbono no se produciría en los hornos estelares y, la vida, tal como la concemos, estaría ausente.

Arthur Eddington, uno de los más grandes astrofísicos del siglo XX, y una notable combinación de lo profundo y lo fantástico, más que cualquier figura moderna, fue el responsable impulsor de poner en marcha los inacabables intentos de explicar las constantes de la Naturaleza mediante auténticas proezas de numerología pura. Él también advirtió un aspecto nuevo y espectacular de las constantes de la Naturaleza.

Cuando los físicos empezaron a apreciar el papel de los constantes en el dominio cuántico y a explorar y explotar la nueva teoría de la Gravedad de Einstein para describir el Universo en conjunto, las circunstancias eran las adecuadas para que alguien tratara de unirlas.

Entró en escena Arthur Eddington: un extraordinario científico que había sido el primero en descubrir cómo se alimentaban las estrellas a partir de reacciones nucleares. También hizo importantes contribuciones a nuestra comprensión de la galaxia, escribió la primera exposición sistemática de la teoría de la relatividad general de Einstein y fue el responsable de revificar, en una prueba decisiva, durante un eclipse de Sol, la veracidad de la teoría de Einstein en cuanto a que el campo gravitatorio del Sol debería desviar la luz estelar que venía hacia la Tierra en aproximadamente 1,75 segundos de arco cuando pasaba cerca de la superficie solar, y así resulto.

Albert Einstein y Arthur Stanley Eddington, se conocieron y se hicieron amigos. Se conservan fotos de los dos juntos conversando sentados en un banco del jardín de Eddington en el año 1.939, don se fueron fotografiados por la hermana del dueño de la casa.

Aunque Eddington era un hombre tímido con pocas dotes para hablar en público, sabía escribir de forma muy bella, y sus metáforas y analogías aún las utilizan los astrónomos que buscan explicaciones gráficas a ideas complicadas. Nunca se casó y vivió en el Observatorio en Cambridge, donde su hermana cuidaba de él y de su anciana madre. Eddington creía que a partir del pensamiento puro sería posible deducir leyes y constantes de la Naturaleza y predecir la existencia en el Universo de cosas como estrellas y Galaxias.

¡Se está saliendo con la suya!

Entre los números de Eddington que él consideraba importante y que se denomino “numero de Eddington”, que es igual al número de protones del Universo visible. Eddington calculó (amano) este número enorme y de enorme precisión en un crucero trasatlántico (ya lo he contado otras veces), concluyendo con esta memorable afirmación que nos dijo el número de protones y electrones que existían en el Universo.

Este número enorme, normalmente escrito NEdd, es aproximadamente igual a 1080. Lo que atrajo la atención de Eddington hacia él era el hecho de que debe ser un número entero, y por eso en principio puede ser calculado exactamente. Durante la década de 1.920, cuándo Eddington empezó su búsqueda para explicar las constantes de la Naturaleza, no se conocían bien las fuerzas débil y fuerte de la Naturaleza, y las únicas constantes dimensionales de la física que sí se conocían e interpretaban con confianza eran las que definían la Gravedad y las fuerzas electromagnéticas.

Eddington las dispuso en tres grupos o tres puros números adimensionales. Utilizando los valores experimentales de la época, tomó la razón entre las masas del protón y electrón:

mpr/me ≈ 1840,

la inversa de la constante de estructura fina

2phc/e2≈ 137

Y la razón entre la fuerza gravitatoria y la fuerza electromagnética entre un electrón y un protón,

22/Gmpr me ≈1040

A estas unió o añadió su número cosmológico, N Edd ≈ 1080.

A estos cuatro números los llamó “las constantes últimas”, y la explicación de sus valores era el mayor desafió de la ciencia teórica:

“¿Son estas cuatro constantes irreducibles, o una unificación posterior de la Física demostrará que alguna o todas ellas pueden ser prescindibles?”

¿Podrían haber sido diferentes de lo que realmente son? Existen algunos estudios que nos dicen que alfa (α) varía según la región del espacio donde la podamos medir. Y, si eso es así (que lo dudo), habría que devolver algunos Premios Nobel. Lo cierto es que la constante de estructura fina no ha variado ni en el espacio ni en el tiempo.

Nosotros, los humanos del planeta Tierra, sabemos de todas esas cuestiones y la última lección que aprendemos de la manera en que números puros como α definen el mundo es el verdadero significado de que los mundos sean diferentes. El número puro que llamamos constante de estructura fina, e identificamos con α, es una combinación de la carga del electrón, e, la velocidad de la luz, c, y la constante de Planck, h. Inicialmente podríamos estar tentados a pensar que un mundo en el que la velocidad de la luz fuera más lenta sería un mundo diferente. Pero sería un error. Si c, h y c cambian de modo que sus valores que tienen unidades métricas (o cualesquiera otras) fueran diferentes cuando las buscamos en nuestras tablas de constantes físicas pero el valor de alfa (α) permaneciera igual, este nuevo mundo sería observacionalmente indistinguible de nuestro mundo. Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la Naturaleza. Si se duplica el valor de todas las masas, no se puede llegar a saber por que todos los números puros definidos por las razones de cualquier par de masas son invariables.

¡Qué cosas! La Naturaleza, ¿hace las cosas de tal manera para que nosotros estémos aquí? Bueno, aunque parezca pretencioso, al menos así lo parece.

emilio silvera

Sep

25

El “universo” fascinante de lo muy pequeño

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (3)

Comments (3)

Muchas veces hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; tiene una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el universo.

El núcleo atómico es la parte central de un átomo tiene carga positiva, y concentra más del 99.99% de la masa total del átomo. Esta fuerza es la responsable de mantener unidos a los nucleones (protón y neutrón) que coexisten en el núcleo atómico venciendo a la repulsión electromagnética entre los protones que poseen carga eléctrica del mismo signo (positiva) y haciendo que los neutrones, que no tienen carga eléctrica, permanezcan unidos entre sí y también a los protones.

Hasta ahí, lo que es el nucleo. Sin embargo, la existencia de los átomos que forman las moléculas y los cuerpos -grandes y pequeños- que conforman los objetos del universo, es posible gracias a los electrones que, rodean el núcleo atómico y, al tener carga negativa similar a la positiva de los protones, crean la estabilidad necesaria para que todo nuestro mundo sea como lo podemos observar.

Los cuantos forman cosas bellas y útiles como el ozono atmosférico

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

Según la física clásica, la energía radiada debería ser igual para todas las longitudes de onda, y al aumentar la temperatura, la radiación debería ser uniformemente más intensa. Para explicar esto, Planck supuso que cada una de las partículas que constituyen la materia, está oscilando y emitiendo energía en forma de radiación electromagnética; esta energía emitida no puede tomar un valor cualquiera, sino que debe ser múltiplo entero de un valor mínimo llamado cuanto o paquete de energía.

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000º C un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = hν, donde E es la energía del paquete, ν es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ν de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza.

También en el movimiento de los átomos dentro del núcleo, está presente la simetría y la belleza de la Naturaleza.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Cuando Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero para los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de forma tal que con su explicación se pudo seguir trabajando, y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica que, dicho sea de paso, con la que no todos están de acuerdo.

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento musical se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal, no importa en qué galaxia la podamos medir.

Einstein y otros pioneros de la M.C., tales como Edwin Schrödinger…, creían que hay más de lo que se ve

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a esta interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos ahora se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de forma estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (Ψ) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un momento dado.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.

Albert Einstein, Nathan Rosen y Boris Podolski idearon un “Gedankenexperiment”, un experimento hipotético, realizado sobre el papel, para el cual la mecánica cuántica predecía como resultado algo que es imposible de reproducir en ninguna teoría razonable de variables ocultas. Más tarde, el físico irlandés John Stewar Bell consiguió convertir este resultado en un teorema matemático; el teorema de imposibilidad.

emilio silvera

Totales: 77.732.714

Totales: 77.732.714 Conectados: 49

Conectados: 49