Sep

14

Materia de sombra, Axiones, ¿WIMPs en el Sol? ¿Y la vida?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El saber: ¡Ese viaje interminable! ~

Clasificado en El saber: ¡Ese viaje interminable! ~

Comments (2)

Comments (2)

Es curioso como a veces, la realidad de los hechos observados, vienen a derribar esas barreras que muchos ponen en sus mentes para negar lo evidente. Por ejemplo: Los extraordinarios resultados de la sonda Kepler, que en su primer año de misión ha encontrado ya 1.235 candidatos a planetas, 54 de ellos en la zona habitable de sus estrellas, ha permitido a los investigadores extrapolar el número total de mundos que podría haber sólo en la Vía Láctea, nuestra galaxia. Y ese número ronda los 50.000 millones. De los cuales, además, unos 500 millones estarían a la distancia adecuada de sus soles para permitir la existencia de agua en estado líquido, una condición necesaria para la vida.

Planetas parecidos a la Tierra, como arriba nos dicen, hay miles de millones y sólo cabe esperar que estén situados en los lugares adecuados para que la vida tenga la oportunidad de surgir acogida por el ecosistema ideal del agua líquida, una atmósfera acogedora y húmeda, temperatura ideal media y otros parámetros que la vida reqiere para su existencia.

Un equipo de astrónomos internacionales pertenecientes al Observatorio Europeo Austral (ESO), el más importante del mundo, investiga la formación de un posible nuevo sistema planetario a partir de discos de material que rodea a una estrella joven. Según un comunicado difundido hoy por el centro astronómico que se levanta en la región norteña de Antofagasta, a través del “Very Large Telescope”(VLT), los científicos han estudiado la materia que rodea a una estrella joven.

Según los astrónomos, los planetas se forman a partir de discos de material que rodean a las estrellas, pero la transición desde discos de polvo hasta sistemas planetarios es rápida y muy pocos son identificados en esta fase. Uno de los objetos estudiados por los astrónomos de ESO, es la estrella T Chamaleontis (T-Cha), ubicada en la pequeña constelación de Chamaleón, la cual es comparable al sol pero en sus etapas iniciales.

Dicha estrella se encuentra a unos 330 años luz de la Tierra y tiene 7 millones de años de edad, lo que se considera joven para una estrella. “Estudios anteriores han demostrado que T Cha es un excelente objetivo para estudiar cómo se forman los sistemas planetarios”, señala el astrónomo Johan Olofsson, del Max Planck Institute of Astronomy de Alemania.

Algunas veces hablando de los extensos y complejos temas que subyacen en la Astronomía, lo mismo hablamos de “materia de sombre” que de “supercuerdas” y, se ha llegado a decir que existe otro universo de materia de sonbra que existe en paralelo al nuestro. Los dos universos se separaron cuando la Gravedad se congeló sepapándose de las otras fuerzas. Las partículas de sombra interaccionan con nosotros sólo a través de la fuerza de la gravedad, lo cual las convierte en candidatas ideales para la tan traida y llevada “materia oscura”.

Llegamos a los Axiones.

El estado actual de la cuestión es que los cosmólogos creen saber que hay una gran cantidad de materia oscura en el Universo y, han conseguido eliminar la candidatura de cualquier tipo de partícula ordinaria que conocemos. En tales circunstancias no se puede llegar a otra conclusión que la materia oscura debe de existir en alguna forma que todavía no hemos visto y cuyas propiedades ignoramos totalmente. Sin embargo, se atreven a decir que, la Gravedad, es el efecto que se produce cuando la “materia oscura” pierde consistencia… , o algo así. ¡Cómo son!

A los teóricos nada les gusta más que aquella situación en la cual puedan dejar volar libremente la imaginación sin miedo a que nada tan brusco como un experimento u observación acabe con su juego. En cualquier caso, han producido sugerencias extraordinarias acerca de lo que podría ser la “materia oscura” del universo.

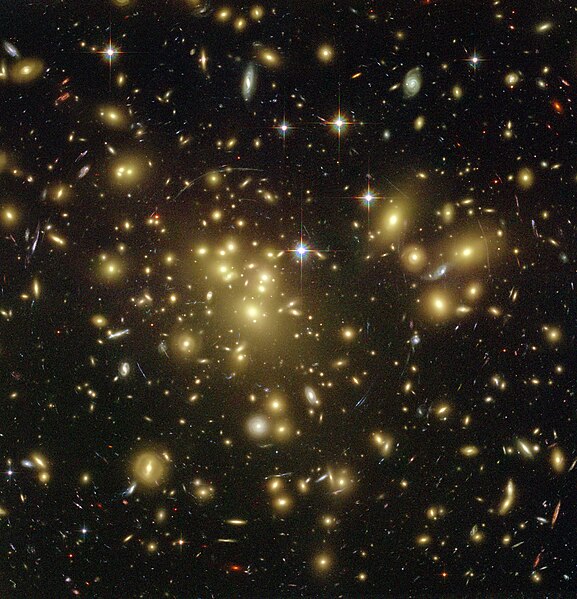

Lo que hay en el Universo…no siempre lo podemos comprender.

Otro de los WIMPs favoritos se llama axión. Como el fotino y sus compañeros, el axión fue sugerido por consideraciones de simetría. Sin embargo, a diferencia de las partículas, sale de las Grandes Teorías Unificadas, que describen el Universo en el segundo 10ˉ³5, más que de las teorías totalmente unificadas que operan en el tiempo de Planck.

Durante mucho tiempo han sabido los físicos que toda reacción entre partículas elementales obedece a una simetría que llamamos CPT. Esto significa que si miramos la partícula de una reacción, y luego vemos la misma reacción cuando (1) la miramos en un espejo, (2) sustituimos todas las partículas por antipartículas y (3) hacemos pasar la película hacia atrás, los resultados serán idénticos. En este esquema la P significa paridad (el espejo), la C significa conjugación de carga (poner las antipartículas) y T la reversa del tiempo (pasar la película al revés).

Se pensaba que el mundo era simétrico respecto a CPT porque, al menos al nivel de las partículas elementales, era simétrico respecto a C, P y T independientemente. Ha resultado que no es éste el caso. El mundo visto en un espejo se desvía un tanto al mundo visto directamente, y lo mismo sucede al mundo visto cuando la película pasa al revés. Lo que sucede es que las desviaciones entre el mundo real y el inverso en cada uno de estos casos se cancelan una a la otra cuando miramos las tres inversiones combinadas.

Aunque esto es verdad, también es verdad que el mundo es casi simétrico respecto a CP actuando solos y a T actuando solo; es decir, que el mundo es casi el mismo si lo miran en un espejo y sustituyen las partículas por antipartículas que si lo miran directamente. Este “casi” es lo que preocupa a los físicos. ¿Por qué son las cosas casi perfectas, pero les falta algo?

La respuesta a esta cuestión parece que puede estar en la posible existencia de esa otra partícula apellidada axión. Se supone que el Axión es muy ligero (menos de una millonésima parte de la masa del electrón) e interacciona sólo débilmente con otra materia. Es la pequeña masa y la interacción débil lo que explica el “casi” que preocupa a los teóricos.

Cuando nos asomamos a la Teoría de cuerdas, entramos en un “mundo” lleno de sombras en los que podemos ver brillar, a lo lejos, un resplandor cegador. Todos los físicos coinciden en el hecho de que es una teoría muy prometedora y de la que parece se podrán obtener buenos rendimientos en el futuro pero, de momento, es imposible verificarla.

El misterio de las funciones modulares podría ser explicado por quien ya no existe, Srinivasa Ramanujan, el hombre más extraño del mundo de los matemáticos. Igual que Riemann, murió antes de cumplir cuarenta años, y como Riemann antes que él, trabajó en total aislamiento en su universo particular de números y fue capaz de reinventar por sí mismo lo más valioso de cien años de matemáticas occidentales que, al estar aislado del mundo en las corrientes principales de los matemáticos, le eran totalmente desconocidos, así que los buscó sin conocerlos. Perdió muchos años de su vida en redescubrir matemáticas conocidas.

Dispersas entre oscuras ecuaciones en sus cuadernos están estas funciones modulares, que figuran entre las más extrañas jamás encontradas en matemáticas. Ellas reaparecen en las ramas más distantes e inconexas de las matemáticas. Una función que aparece una y otra vez en la teoría de las funciones modulares se denomina (como ya he dicho otras veces) hoy día “función de Ramanujan” en su honor. Esta extraña función contiene un término elevado a la potencia veinticuatro.

¿Podeis imaginar la existencia de un Universo en permanente sombra?

La idea de un universo en sombra nos proporciona una manera sencilla de pensar en la materia oscura. El universo dividido en materia y materia se sombra en el Tiempo de Planck, y cada una evolucionó de acuerdo con sus propias leyes. Es de suponer que algún Hubble de sombra descubrió que ese universo de sombra se estaba expandiendo y es de suponer que algunos astrónomos de sombras piensan en nosotros como candidatos para su materia oscura.

¡Puede que incluso haya unos ustedes de sombras leyendo la versión de sombra de este trabajo!

Partículas y partículas supersimétricas

Partículas son las que todos conocemos y que forman la materia, la supersimétricas, fotinos, squarks y otros, las estamos buscando sin poder hallarlas.

Estas partículas son predichas por las teorías que unifican todas las fuerzas de la naturaleza. Forman un conjunto de contrapartidas de las partículas a las que estamos habituados, pero son mucho más pesadas. Se nombran en analogía con sus compañeras: el squark es el compañero supersimétrico del quark, el fotino del fotón, etc. Las más ligeras de estas partículas podrían ser la materia oscura. Si es así, cada partícula probablemente pesaría al menos cuarenta veces más que el protón.

Materia de sombra, si existe, no hemos sabido dar con ella y, sin embargo, existen indicios de que está ahí

En algunas versiones de las llamadas teorías de supercuerdas hay todo un universo de materia de sombra que existe paralelo con el nuestro. Los dos universos se separaron cuando la gravedad se congeló separándose de las otras fuerzas. Las partículas de sombra interaccionan con nosotros sólo a través de la fuerza de la gravedad, lo que las convierte en candidatas ideales para la materia oscura.

Axiones

El Axión es una partícula muy ligera (pero presumiblemente muy común) que, si existiera, resolvería un problema antiguo en la teoría de las partículas elementales. Se estima que tiene una masa menor que una millonésima parte de la del electrón y se supone que impregna el universo de una manera semejante al fondo de microondas. La materia oscura consistiría en agregaciones de axiones por encima del nivel general de fondo.

Construímos inmensos aparatos de ingeniosas propiedades tecnológicas para tratar de que nos busquen las WIMPs

¿WIMPs en el Sol?

A lo largo de todo el trabajo se ha dado a entender que todas estas partículas candidatas a materia oscura de la que hemos estado hablando, son puramente hipotéticas. No hay pruebas de que ninguna de ellas se vaya a encontrar de hecho en la naturaleza. Sin embargo sería negligente si no mencionase un argumento –un diminuto rayo de esperanza- que tiende a apoyar la existencia de WIMPs de un tipo u otro. Este argumento tiene que ver con algunos problemas que han surgido en nuestra comprensión del funcionamiento y la estructura del Sol.

Creemos que la energía del Sol viene de reacciones nucleares profundas dentro del núcleo. Si éste es el caso en realidad, la teoría nos dice que esas reacciones deberían estar produciendo neutrinos que en principio son detectables sobre la Tierra. Si conocemos la temperatura y composición del núcleo (como creemos), entonces podemos predecir exactamente cuántos neutrinos detectaremos. Durante más de veinte años se llevó a cabo un experimento en una mina de oro de Dakota del Sur para detectar esos neutrinos y, desgraciadamente, los resultados fueron desconcertantes. El número detectado fue de sólo un tercio de lo que se esperaba. Esto se conoce como el problema del neutrino solar.

El problema de los neutrinos solares se debió a una gran discrepancia entre el número de neutrinos que llegaban a la Tierra y los modelos teóricos del interior del Sol. Este problema que duró desde mediados de la década de 1960 hasta el 2002, ha sido recientemente resuelto mediante un nuevo entendimiento de la física de neutrinos, necesitando una modificación en el modelo estándar de la física de partículas, concretamente en las oscilaciones de neutrinos. Básicamente, debido a que los neutrinos tienen masa, pueden cambiar del tipo de neutrino que se produce en el interior del Sol, el neutrino electrónico, en dos tipos de neutrinos, el muónico y el tauónico, que no fueron detectados.

La segunda característica del Sol que concierne a la existencia de WIMPs se refiere al hecho de las oscilaciones solares. Cuando los astrónomos contemplan cuidadosamente la superficie solar, la ven vibrar y sacudirse; todo el Sol puede pulsar en períodos de varias horas. Estas oscilaciones son análogas a las ondas de los terremotos, y los astrónomos llaman a sus estudios “sismología solar”. Como creemos conocer la composición del Sol, tenemos que ser capaces de predecir las propiedades de estas ondas de terremotos solares. Sin embargo hay algunas duraderas discrepancias entre la teoría y la observación en este campo.

No hace mucho que los astrónomos han señalado que si la Galaxia está en realidad llena de materia oscura en la forma de WIMPs, entonces, durante su vida, el Sol habría absorbido un gran número de ellos. Los WIMPs, por tanto, formarían parte de la composición del Sol, una parte que no se había tenido en cuenta hasta ahora. Cuando los WIMPs son incluidos en los cálculos, resultan dos consecuencias: primero, la temperatura en el núcleo del Sol resulta ser menor de lo que se creía, de forma que son emitidos menos neutrinos, y segundo, las propiedades del cuerpo del Sol cambian de tal modo que las predicciones de las oscilaciones solares son exactas.

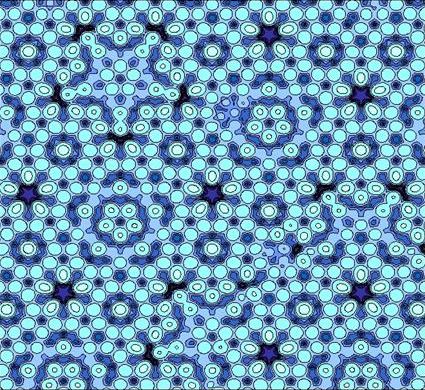

Hasta nos atrevemos a exponer una imagen que nos muestra la distribución de los WIMPs

Este resultado es insignificante en lo que se refiere a la existencia de WIMPs, pero como no debemos despreciar las coincidencias halladas, lo más prudente será esperar a nuevos y más avanzados experimentos (SOHO y otros). Tanto el problema del neutrino como las oscilaciones se pueden explicar igualmente bien por otros efectos que no tienen nada que ver con los WIMPs. Por ejemplo, el tipo de oscilaciones de neutrinos podría resolverse si el neutrino solar tuviera alguna masa, aunque fuese muy pequeña, y diversos cambios en los detalles de la estructura interna del Sol podrían explicar las oscilaciones. No obstante estos fenómenos solares constituyen la única indicación que tenemos de que uno de los candidatos a la materia oscura pueda existir realmente.

Toda esta charla sobre supersimetría y teoría últimas da a la discusión de la naturaleza de la materia oscura un tono solemne que no tiene ningún parecido con la forma en que se lleva en realidad el debate entre los cosmólogos. Una de las cosas que más me gusta de este campo es que todo el mundo parece ser capaz de conservar el sentido del humor y una distancia respecto a su propio trabajo, ya que, los buenos científicos saben que, todos los cálculos, conjeturas, hipótesis y finalmente teorías, no serán visadas en la aduana de la Ciencia, hasta que sean muy, pero que muy bien comprobadas mediante el experimento y la observación y, no una sino diez mil veces antes de que puedan ser aceptadas en el ámbito puramente científico.

El el Sol podemos hallar algunas respuestas

Posiblemente, el LHC nos pueda decir algo al respecto si, como no pocos esperan, de sus colisiones surgen algunas partículas supersimétricas que nos hablen de ese otro mundo oscuro que, estando en este, no hemos sabido encontrar hasta este momento. Otra posibilidad sería que la tan manoseada materia oscura no existiera y, en su lugar, se descubriera otro fenómeno o mecanismo natural desconocido hasta ahora que, incidiendo en el comportamiento de expansión del Universo, nos hiciera pensar en la existencia de la “materia oscura” para cubrir el hueco de nuestra ignorancia.

Hace algún tiempo, en esas reuniones periódicas que se llevan a cabo entre científicos de materias relacionadas: física, astronomía, astrofísica, comología…, alguien del grupo sacó a relucir la idea de la extinción de los dinosaurios y, el hombre se refirió a la teoría (de los muchas que circulan) de que el Sol, en su rotación alrededor de la Vía Láctea, se salía periódicamente fuera del plano de la Galaxia. Cuando hacía esto, el polvo existente en ese plano podía cesar de proteger la Tierra, que entonces quedaría bañada en rayos cósmicos letales que los autores de la teoría pensaban que podían permeabilizar el cosmos. Alguien, desde el fondo de la sala lanzó: ¿Quiere decir que los dinosaurios fueron exterminados por la radiación de fotinos?

La cosa se tomó a broma y risas marcaron el final de la reunión en la que no siempre se tratan los temas con esa seriedad que todos creen, toda vez que, los conocimientos que tenemos de las cosas son muy limitados y tomarse en serio lo que podría no ser… ¡No sería nada bueno!

emilio silvera

Sep

14

Los cuasicristales: un nuevo orden de la materia

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física-química ~

Clasificado en Física-química ~

Comments (0)

Comments (0)

La vida de la ciencia

El premio nobel de química de 2011 ha sido concedido a Daniel Shechtman (Instituto Technion, Israel) por su descubrimiento de los cristales cuasiperiódicos (cuasicristales) en 1982. Dicho descubrimiento vino acompañado por dos grandes paradojas de carácter fundamental. La primera, de naturaleza esencialmente estructural, se resolvió en 1992 mediante una nueva definición de cristal por parte de la Unión Cristalográfica Internacional, definición inspirada en la noción de sólido aperiódico introducida por Schrödinger medio siglo antes. La segunda paradoja surgió del estudio detallado de las propiedades físico-químicas de las fases cuasicristalinas termodinámicamente estables: aleaciones formadas por metales, pero que manifiestan un comportamiento atípico, semejante al de los materiales semiconductores. En este caso, y a pesar de la intensa actividad experimental y teórica desplegada durante dos décadas, la posible solución de la paradoja sigue aún abierta.

- Introducción

El estudio de las formas minerales, hermosa materialización en la Naturaleza de los poliedros ideales creados por la matemática, dio lugar a la descripción de la geometría básica del sólido en términos de un conjunto de celdas elementales, que al ensamblarse entre sí periódicamente dan lugar a la formación del entramado cristalino del que derivan las caras lisas y las aristas cinceladas propias del reino mineral. Y es que el orden periódico supone una economía del conocimiento extraordinaria, pues permite afirmar con certeza que la distribución atómica que encontramos en una celda arbitraria, se encontrará con idéntica disposición muy lejos de allí. Convenientemente matematizada esta propiedad hace posible resolver con elegancia y rigor un gran número de cuestiones relacionadas con las propiedades de los sólidos, lo que explica cómo fue arraigando progresivamente, desde los albores de la cristalografía, la idea de que el orden en la materia debe ser esencialmente periódico, un supuesto que se convirtió en el paradigma que definía la noción misma de cristal.

El teorema de restricción cristalográfica, en su forma básica, se basa en la observación de que las simetrías rotacionales de un cristal se limitan generalmente a los órdenes 2, 3, 4 y 6.1 Sin embargo, en los cuasicristales se pueden presentar otras simetrías, como la de orden 5, las cuales no fueron descubiertas hasta 1984 por el premio Nobel de Química 2011, Dan Shechtman.

- El teorema de restricción cristalográfica

A la par que sencilla y conveniente la noción de periodicidad resulta también muy exigente. Su servidumbre más importante viene descrita por el teorema de restricción cristalográfica, que determina cuáles son las simetrías de rotación compatibles con la existencia del entramado discreto de nudos que caracteriza una red cristalina periódica. Su enunciado es conciso: los únicos giros posibles, compatibles con la exigencia de que desde un nudo encontremos otro nudo del cristal vienen dados por la condición.

1 + cos 2φ = n, n є Z.

Donde φ es el ángulo de rotación. De modo que los únicos giros que son compatibles con la simetría de traslación periódica corresponden a los ejes de rotación de orden 2, 3, 4 y 6. La presencia de ejes quinarios está prohibida, al igual que la de cualquier eje de orden superior al 6. A pesar de su sencillez las consecuencias del teorema de restricción son tremendamente exigentes. No obstante, durante setenta años, la validez de este esquema interpretativo vino avalada por la notable concordancia entre los modelos cristalográficos propuestos y los patrones de difracción obtenidos experimentalmente para los distintos materiales estudiados. Hasta que el 8 de abril de 1982, los atónitos ojos de Daniel Shechtman contemplaron un patrón de difracción que, al parecer, no podía existir.

- El hallazgo

“Estaba analizando una aleación de aluminio y manganeso a través de un microscopio electrónico cuando sucedió algo muy extraño e improvisto. El patrón de difracción mostraba diez puntos brillantes, igualmente espaciados del centro y entre sí. Los conté y repetí la cuenta otra vez, diciéndome: ¡este bicho no existe! (en hebreo: Ein chaya kazo). Entonces salí al pasillo para compartirlo, pero ahí no había nadie…”.

Aquel pasillo vacío resultó ser toda una premonición de la fría acogida que su descubrimiento iba a recibir inicialmente entre sus colegas. Tan sorprendidos como él, aunque para petados, en su inmensa mayoría, en un prudente y oportuno escepticismo. Y las cosas empeoraron aún más cuando un octogenario Linus Pauling, dos veces laureado con el Premio Nobel (el de Química primero y el de la Paz después), declaró la guerra a la interpretación que Shechtman proponía para aquellos materiales que, prohibidos por los legisladores teóricos, se erguían desafiantes en el laboratorio como heraldos del advenimiento de una nueva cristalografía. No deja por ello de tener cierta sagaz ironía que, casi treinta años después del hallazgo y la polémica, la academia sueca haya decidido conceder a Shechtman el premio Nobel precisamente en Química, el campo en el que militaba también su feroz oponente.

- La primera paradoja

El primer análisis detallado de los patrones de difracción electrónica obtenidos por Schechtman apareció publicado en la prestigiosa revista Physical Review Letters bajo el título: “Una fase metáica con orden orientacional de largo alcance y sin simetría de traslación”. En efecto, si prestamos atención a la organización de los puntos que aparecen en el patrón mostrado en la Figura 1 podemos observar claramente la presencia de muchos picos de difracción (que evidencian la presencia de un orden de largo alcance) agrupados en motivos pentagonales (incompatibles con la simetría de traslación periódica). Debe existir, por tanto, otro tipo de orden que sea capaz de producir correlaciones de largo alcance y que no se base en la mera periodicidad. En efecto, dicho principio ordenador existe y está basado en la simetría de inflación. Si uno mide las distancias entre puntos consecutivos a lo largo de un eje radial en el patrón de difracción puede constatar que dichas separaciones definen una serie geométrica cuya razón viene dada por el número irracional τ = (1+√5)/2, conocido como la razón áurea, que expresa la proporción entre la longitud de la diagonal y el lado en un pentágono regular.

Es más, si trazamos sendas líneas uniendo los distintos vértices de un pentágono formado por los picos más intensos (tal como se muestra en el recuadro inferior), vemos que los puntos de intersección definen un nuevo pentágono cuyo tamaño guarda una relación de semejanza, determinada por la proporción τ2, con respecto al tamaño del pentágono original. Esta construcción geométrica, también denominada pentagrama pitagórico, manifiesta la presencia de una simetría de invariancia de escala (típica de las estructuras fractales), expresada de forma natural por la disposición espacial de los átomos en un fragmento de materia cuasicristalina.

- Un nuevo ordenamiento de la materia: Los cuasicristales

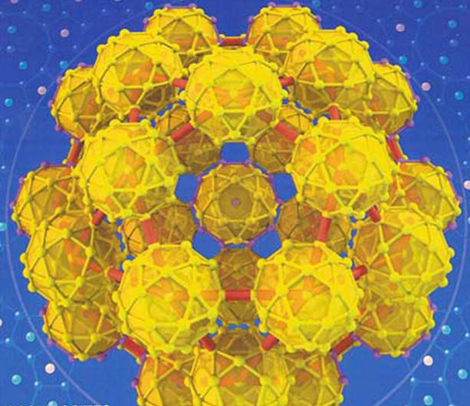

Así pues, la primera paradoja se desvela al considerar que los legisladores teóricos se dejaron seducir por un supuesto tácito: el único modo de rellenar el espacio con átomos de forma ordenada y sistemática- pensaron- debe basarse en el recurso de patrones periódicos. Sin embargo, el apilamiento periódico no es el único posible a tal efecto. También se pueden ordenar los átomos en un material siguiendo un proceso análogo al del conocido juego de muñecas rusas, de modo que pequeños agregados de átomos con simetría icosaédrica se anidan en el interior de otros agregados mayores con su misma forma, los cuales, a su vez, se incluyen dentro de nuevos agregados similares de mayor tamaño.

Enrique Maciá

Enrique MaciáModelo estructural de un cuasicristal icosaédrico de CdYb basado en agregados moleculares (clusters) en forma de icosidodecaedro, sólido regular formado por caras pentagonales y triangulares.

De este modo el átomo deja de ser el protagonista estructural, y es reemplazado por agregados de átomos (clusters en la terminología anglosajona) dotados de simetría icosaédrica, que se organizan de una forma jerárquica en el espacio. Como consecuencia de este esquema estructural, basado en la simetría de inflación, los átomos se disponen en el espacio según una distribución perfectamente regular (conocida técnicamente como ordenamiento cuasiperiódico), en lugar de en la forma periódica usual en los cristales clásicos. El término cuasicristal (contracción de los términos ingleses queasiperiodic cristal), propuesto en 1984 por Paul Steinhardt (Universidad de Pennsylvania), se impuso rápidamente para designar, de forma genérica, a este tipo de materiales. De este modo, el cuasicristal debe entenderse como “la extensión natural de la noción de cristal periódico a estructuras que posean orden de traslación cusiperiódico”. De manera que los cuasicristales son una forma de contracción de los términos “cristales ordenados cuasi periódicamente” o “cristales cuasiperiódicos”, y por tanto el prefijo cuasi que precede a la palabra cristal no hace referencia a la calidad estructural del material, sino a la descripción matemática que se hace del mismo, en términos de funciones cuasiperiódicas. En efecto, el marco teórico que progresivamente se fue desarrollando para dar cuenta de los finos detalles presentes en los diagramas de difracción obtenidos, hizo patente que nos hallábamos ante una nueva forma de ordenamiento de la materia. La forma de percibir este nuevo ordenamiento en todo su esplendor consiste en aprovechar la propiedad matemática por la que cualquier función cuasiperiódica se puede expresar como una función periódica en un espacio de dimensión adecuada. De esta forma la cristalografía se generaliza en el hiperespacio, dando lugar a la descripción de un cuasicristal icosaédrico como un cubo en seis dimensiones.

- Nueva definición de cristal

Debido al crecimiento número y a la gran variedad de cuasicristales observados desde 1982 (que contienen también ejes octogonales, decagonales y dodecagonales), la Unión Cristalográfica Internacional redefinió en 1992 el término de cristal, ampliándolo para dar cabida a este nuevo tipo de ordenamiento: “A partir de ahora por cristal entenderemos un sólido que tenga un patrón de difracción esencialmente discreto”. De este modo el atributo característico del sólido cristalino se traslada del espacio físico al espacio recíproco y dentro de la familia de los cristales aperiódicos, entendidos estos últimos como cristales en los que está ausente la simetría de traslación periódica, en línea con una antigua (1944) y original propuesta de Erwin Schrödinger.

Modelo atómico de cuasicristal de Ag-Al.

Un cuasicristal es una forma estructural que es ordenada pero no periódica. Se forman patrones que llenan todo el espacio aunque tienen falta de simetría traslacional. Mientras que los cristales, de acuerdo al clásico teorema de restricción cristalográfica, pueden poseer solo simetrías rotacionales de 2, 3, 4, y 6 pliegues, el patrón de difracción de Bragg de los cuasicristales muestra picos agudos con otros órdenes de simetría, por ejemplo de 5 pliegues.

- La segunda paradoja

El artículo en el que Levine y Steinhardt introdujeron el concepto de cuasicristal concluye con la frase “si los materiales cuasicristalinos existen realmente (…) con toda seguridad poseerán una gran variedad de nuevas propiedades estructurales y electrónicas reseñables”. Dicha propuesta contrasta marcadamente con el punto de vista sostenido por Pauling en otro trabajo en el que, tras afirmar que los cuasicristales se reducen a una serie de maclas ordenadas en forma sutil, añade que “Y señalo que no existe razón para esperar que estas aleaciones tengan propiedades físicas inusuales”. Así pues, ¿poseen los cristales cuasiperiódicos propiedades específicas en virtud de su peculiar forma de ordenamiento?

Las primeras fases cuasicristalinas descubiertas, obtenidas mediante técnicas de enfriamiento ultrarrápido, eran meta estables y pasaban con facilidad el estado cristalino al someter las muestras a tratamientos términos encaminados a mejorar su estructura. En consecuencia, el estudio de las propiedades físicas características de esta nueva fase de la materia no fue posible hasta que, a partir de 1986, diversos equipos internacionales, entre los que destaca el grupo del profesor An Pang Tsai en Japón, descubrieron un número creciente de materiales cuasicristalinos termodinámicamente estables, capaces de preservar una estructura cuasiperiódica de extraordinaria calidad hasta alcanzar su punto de fusión (en torno a los 1500 C), mostrando nuevos hábitos de crecimiento entre los que destacan los del dodecaedro regular, el prisma decagonal o el triacontaedro, sólido formado por treinta caras rómbicas. Estos cuasicristales pueden crecer hasta alcanzar tamaños del orden del cm de modo que ya se les puede someter a pruebas en las que se midan sus propiedades físicas con la certeza de que estamos midiendo propiedades intrínsecas, libres de posibles contaminaciones por fases secundarias. Y al hacerlo se constató la aparición de un extenso conjunto de propiedades físicas anómalas extraordinarias.

Por ejemplo, se observa que al aumentar la temperatura la conductividad eléctrica aumenta (que es justo lo contrario de lo que suele ocurrir con los metales), pero al estudiar el ritmo al que la conductividad aumenta ésta no se ajusta a un comportamiento de tipo exponencial (como ocurre en el caso de los semiconductores) sino que sigue una ley de potencia. La termoelectricidad es otra característica que distingue metales y semiconductores. En general los metales tienen un valor pequeño del coeficiente de Seebeck, que mide la magnitud del efecto termoeléctrico por el cual un material muestra la aparición de una diferencia de potencial entre sus extremos cuando estos se someten a un gradiente de temperatura. En la mayoría de los metales la magnitud de este efecto es del orden 10 μ V/K a temperatura ambiente y muestra un comportamiento lineal con la temperatura, mientras que los semiconductores, por el contrario, suelen presentar valores del orden de centenas de μ V/K y la curva S(T) varía no linealmente. Este es el caso también para ciertos cuasicristales cuyas curvas de termopotencia tienen al pirncipio un comportamiento lineal pero luego empiezan a curvarse, e inlcuso cambian de signo en algunos casos, lo cual podría interpretarse como una alternancia en el signo de la carga de los portadores mayoritarios, en conformidad con los resultados obtenidos al medir su efecto Hall. Pero, sin duda, la anomalía más llamativa para una aleación formada por átomos metálicos es que los cuasicristales son muy malos condcutores del calor debido, fundamentalmente, a que posen pocos electrones libres y, en consecuencia, el calor debe propagarse mediante las vibraciones de la estructura atómica; propagación que se ve; a su vez, dificultada por la ausencia de una simetría de traslación en el ordenamiento cuasiperiódico de dicha estructura, lo que explica el reducido valor de su conductividad térmica, del orden de 1 W/mK a temperatura ambiente, comparable el de buenos aislantes térmicos como la alúmina o el Pyrex, y dos órdenes de magnityd menos que la medida en los materiales metálicos. Podemos concluir, por tanto, que a la vista de sus propiedades los cuasicristales ocupan una posición intermedia entre los metales y los semiconductores, lo que resulta desconcertante para unos materiales compuestos por elementos que, como Al, Cu, Fe, Pd, Ni, Co o Mn, suelen dar lugar a compuestos típicamente metálicos. Este hecho define la segunda paradoja en el estudio de estos materiales y apunta hacia la posibilidad de la formación de enlaces químicos poco habituales en aleaciones.

- Posibles aplicaciones.

El conocimiento más detallado de los diagramas de fase de las distintas aleaciones implicadas, capaz de precisar las lindes de las pequeñas regiones de estabilidad de las distintas fases cuasicristalinas de gran calidad mediante el empleo de técnicas convencionales, lo cual permite su consideración para ciertas aplicaciones tecnológicas. En efecto, la primera patente industrial en la que se recoge una aplicación directa de los cuasicristales como barreras térmicas data de 1988 y fue obtenida por el equipo de Jean Marie Dubois en el Laboratoire Science et Gènie des Materieaux Métalliques (Nancy). Desde entonces el número de patentes relativas a la fase cuasicristalina se ha ido incrementando paulatinamente, con la intención de explotar las propiedades inusuales observadas en los cuasicristales, como su elevada dureza, resistencia al rayado y sus propiedades anticorrosivas, para el recubrimiento de instrumental quirúrgico o culinario. Las aleaciones cuasicristalinas se presentan como unos materiales competitivos con vistas a su utilización como recubrimientos de álabes de turbina, barreras térmicas o en dispositivos de refrigeración termoeléctrica, por lo que cabe esperar que su estudio depare interesantes resultados, tanto a nivel fundamental como aplicado, durante los próximos años.

Este trabajo ha sido patrocinado por la Comunidad Autónoma de Mdrid y la UCM mediante el Proyecto CCG10-UCM/MAT-4628.

Enrique Maciá Barber

Dpto. Física de Materiales, Facultad CC. Físicas

Universidad Complutense de Madrid

Sep

14

Galaxias generadoras de entropía negativa

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Las galaxias generan entropía negativa ~

Clasificado en Las galaxias generan entropía negativa ~

Comments (2)

Comments (2)

En alguna ocasión me refería a aquel comentario que hizo Darwin:

“… los materiales primigenios… en alguna pequeña charca caliente, tendrían la oportunidad de hacer el trabajo y organizarse en sistemas vivos…

Hasta que supimos que existían otros sistemas planetarios en nuestra Galaxia, ni siquiera se podía considerar esta posibilidad como una prueba de que la vida planetaria fuera algo común en la Vía Láctea. Pero ahora se sabe que más de cien estrellas de nuestra zona de la galaxia tienen planetas que describen órbitas alrededor de ellas. Casi todos los planetas descubiertos hasta ahora son gigantes de gas, como Júpiter y Saturno (como era de esperar, los planetas grandes se descubrieron primero, por ser más fáciles de detectar que los planetas pequeños), sin embargo es difícil no conjeturar que, allí, junto a estos planetas, posiblemente estarán también sus hermanos planetarios más pequeños que, como la Tierra, pudieran tener condiciones para generar la vida en cualquiera de sus millones de formas.

Supertierras que son fáciles de detectar por su inemnsas masas pero, los planetas terrestres también están por ahí, orbitando a miles y miles de estrellas y a la distancia adecuada para poder contener la vida.

Los elementos más abundantes del Universo: carbono, hidrógeno, oxígeno y nitrógeno (CHON). Están ahí, dispersos por las Nebulosas que forman los mundos y las estrellas y… ¡la vida!

Lee Smolin, de la Universidad de Waterloo, Ontario, ha investigado la relación existente entre, por una parte, las estrellas que convierten unos elementos más sencillos en algo como el CHON y arroja esos materiales al espacio, y, por otra parte, las nubes de gas y polvo que hay en éste, que se contrae para formar nuevas estrellas.

Nuestro hogar dentro del espacio, la Vía Láctea, es una entre los cientos de miles de millones de estructuras similares dispersas por todo el Universo visible, y parece ser una más, con todas las características típicas – de tipo medio en cuanto a tamaño, composición química, etc.- La Vía Láctea tiene forma de disco plano, con alrededor de cien mil años luz de diámetro, y está formada por doscientos mil millones de estrellas que describen órbitas en torno al centro del disco.

El Sol, en realidad, sólo es importante para nosotros al ser el cuerpo central de nuestro Sistema Solar, y con mucho, la estrella más cercana al planeta Tierra y la única que se puede estudiar con todo lujo de detalles. Se clasifica como una estrella G2V: una estrella amarilla con una temperatura efectiva de 5.770 K (tipo espectral G2) y una enana de la secuencia principal (clase de luminosidad V). Los detalles de su composición son sobradamente sabidos por todos y cabe destacar su abundancia de hidrógeno – 71% en masa- y de helio el 27% y elementos más pesados hasta completarlo. Por lo tanto, nuestro Sol no destaca por nada entre esa multitud de de cientos de miles de millones de estrellas.

Recorre su órbita a una distancia del centro que viene a ser más o menos dos tercios del diámetro. En el centro de la Galaxia las estrellas forman una protuberancia, de tal modo que desde el exterior daría la sensación de estar viendo un enorme huevo frito, en el que la protuberancia sería la yema. Sin embargo, el modo en que este disco gira revela que todo el material brillante (materia bariónica) que compone la parte visible de la Vía Láctea queda sujeto por el tirón gravitatorio de una materia invisible que no brilla ni emite radiación y que viene a ser más o menos diez veces mayor que la materia visible de la Galaxia y que muchos suponen que está diseminada en un halo situado alrededor de ella, extendiéndose mucho más allá del borde del disco de estrellas brillantes.

Descubrir qué es realmente esta materia oscura (yo prefiero llamarla no luminosa o materia escondida) constituye un tema de crucial interés para los astrónomos, pero no entraremos ahora en eso, ya que, para lo que estamos tratando, no tiene importancia. Muchas galaxias en forma de disco se caracterizan por una especie de serpentinas que se alejan en espiral desde su centro, lo que hace que se les aplique el nombre de galaxias espirales. Es fácil estudiar las pautas que siguen los llamados “brazos espirales”, porque las galaxias se encuentran relativamente cerca unas de otras, si comparamos estas distancias con sus tamaños.

Andrómeda, la galaxia espiral más cercana comparable a la Vía Láctea, se encuentra con respecto a nosotros a una distancia de poco más de dos millones de años luz; parece una gran distancia, pero la galaxia de Andrómeda es tan grande (un poco mayor que la Vía Láctea) que, incluso a esa distancia, vista desde la Tierra cubre un trozo de cielo del tamaño de la Luna, y puede observarse a simple vista en una noche despejada y sin luz lunar, si nos situamos lejos de las ciudades y de otras fuentes de emisión de luz.

Los brazos espirales, que son una característica tan llamativa en galaxias como la nuestra, son visibles porque están bordeados por estrellas calientes de gran masa que relucen con mucho brillo. Esto significa que también son estrellas jóvenes, ya que no hay estrellas viejas que tengan gran cantidad de masa.

No hay misterio alguno en cuanto al modo en que mantienen esa forma espiral. Se debe exclusivamente a un fenómeno de retroalimentación. Las nubes gigantescas a partir de las cuales se forman las estrellas pueden contener hasta un millón de veces la masa del Sol cuando empieza a contraerse gravitatoriamente para formar estrellas. Cada nube que se contrae produce, no una sola estrella de gran tamaño, sino todo un conglomerado de estrellas, así como muchas estrellas menores. Cuando las estrellas brillantes emiten luz, la energía de esta luz estelar (especialmente en la parte ultravioleta del espectro) forma una burbuja dentro de la nube, y tiende a frenar la formación de más estrellas. Sin embargo, una vez que las estrellas de gran masa han recorrido sus ciclos vitales y han explotado, sembrando además el material interestelar con elementos de distintos tipos, la onda expansiva ejerce presión sobre las nubes interestelares cercanas y hace que éstas comiencen a contraerse.

Las ondas procedentes de distintas supernovas, al entrecruzarse unas con otras, actúan mutuamente para barrer el material interestelar y formar nuevas nubes de gas y polvo que se contraen produciendo más estrellas y supernovas, en un ejemplo clásico de interacción que se mantiene por sí sola en la que intervienen una absorción de energía (procedentes de las supernovas) y una retroalimentación.

Si la nube es demasiado densa, su parte interna se contraerá gravitatoriamente de manera rápida, formando unas pocas estrellas grandes que recorren sus ciclos vitales rápidamente y revientan la nube en pedazos antes de que puedan formarse muchas estrellas. Esto significa que la generación siguiente de estrellas nace de una nube más delgada, porque ha habido pocas supernovas que barrieran material formando pedazos densos. Si la nube es tan delgada que su densidad queda por debajo de la densidad óptima, nacerán muchas estrellas, y habrá gran cantidad de explosiones supernovas, lo cual producirá gran número de ondas de choque que barrerán el material interestelar, acumulándolo en nubes más densas.

De esta manera, por ambas partes, las retroalimentaciones operan para mantener un equilibrio aproximadamente constante entre la densidad de las nubes y el número de supernovas (y estrellas de tipo Sol) que se producen en cada generación. La propia pauta espiral resulta del hecho de que la galaxia realiza movimiento de rotación y está sometida al tirón gravitatorio que crea la fuerza de marea proveniente de esa materia no luminosa.

Claro que, la materia interestelar es variada. Existen nubes de gas y polvo fríos, que son ricas en interesantes moléculas y se llaman nubes moleculares gigantes; a partir de estas nubes se forman nuevas estrellas (y planetas). Hay nubes de lo que consideraríamos gas “normal”, formadas por átomos y moléculas de sustancias tales como el hidrógeno, y quizá tan caliente como una habitación cerrada durante toda la noche y con la temperatura de dos cuerpos dormidos y emitiendo calor. Además, hay regiones que se han calentado hasta temperaturas extremas mediante la energía procedente de explosiones estelares, de tal modo que los electrones han sido arrancados de sus átomos para formar un plasma cargado de electricidad.

La densidad entre estrellas es escasa, dado que estas la obsorbieron

También existe una amplia variedad de densidades dentro del medio interestelar. En la modalidad más ligera, la materia que está entre las estrellas es tan escasa que sólo hay un átomo por cada mil centímetros cúbicos de espacio: en la modalidad más densa, las nubes que están a punto de producir nuevas estrellas y nuevos planetas contienen un millón de átomos por centímetro cúbico. Sin embargo, esto es algo muy diluido si se compara con el aire que respiramos, donde cada centímetro cúbico contiene más de diez trillones de moléculas, pero incluso una diferencia de mil millones de veces en densidad sigue siendo un contraste espectacular.

La cuestión es que, unos pocos investigadores destacaron allá por 1.990 en que todos estos aspectos –composición, temperatura y densidad- en el medio interestelar dista mucho de ser uniforme. Por decirlo de otra manera más firme, no está en equilibrio, y parece que lo que lo mantiene lejos del equilibrio son unos pocos de procesos asociados con la generación de las pautas espirales.

Esto significa que la Vía Láctea (como otras galaxias espirales) es una zona de reducción de la entropía. Es un sistema auto-organizador al que mantienen lejos del equilibrio, por una parte, un flujo de energía que atraviesa el sistema y, por otra, como ya se va viendo, la retroalimentación. En este sentido, nuestra Galaxia supera el test de Lovelock para la vida, y además prestigiosos astrofísicos han argumentado que las galaxias deben ser consideradas como sistemas vivos.

Creo que llevan toda la razón.

emilio silvera

Sep

14

Entropía,Gravedad, Materia… ¡Vida!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Entropía ~

Clasificado en El Universo y la Entropía ~

Comments (5)

Comments (5)

Con alguna frecuencia hemos hablado aquí de ENTROPÍA. Viene del griego entrope que significa transformación o vuelta. Es un proceso mediante el cual un sistema tiende a consumirse, desorganizarse y morir. Se basa en la segunda ley de la termodinámica que plantea que la pérdida de energía en los sistemas aislados los lleva a la degradación, degeneración, desintegración y desaparición.

En todo lo que ocurre hay una fuerza presente que conforma la dinámica de las cosas y del universo mismo

En nuestro Universo, todo se transforma, nada permanece siempre igual. El paso del Tiempo está acompañado por la Entropía y el deterioro de los “Sistemas” es visible a simple vista. En cierta ocasión, Darwin censuró a aquellos que especulaban con el origen de la Vida replicando que uno también podría especular sobre el origen de la Materia. Hoy, los físicos y los cosmólogos creen que saben cómo se originó la materia, y la comparación de este proceso con la biogénesis resulta extraordinariamente reveledora. El Universo observable contiene 1050 toneladas de materia, y el problema de la procedencia de dicha materia atormentó a la cosmología durante muchos años.

Aquellos primeros críticos de la teoría del Big Bang (como Fred Hpyle y otros), pusieron objeciones razonables a la hipótesis de que toda esta materia surgió simplemente, y sin una razón aparente, en el comienzo del Tiempo. La idea de que el Universo se originó con la matria necesaria ya allí, era para muchos una idea completamente acientífica, como sabemos, todo tiene una razón de ser y nada se produce “porque sí”.

Sep

14

¡La filosofía! Y, lo que creemos que sabemos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (4)

Comments (4)

- Moritz Schlick

- Rudolf Carnap

- Otto Neurath

- Herbert Feigl

- Philipp Frank

- Friedrich Waismann

- Hans Hahn

- Hans Reichenbach

- Kurt Gödel

- Alfred Tarski

- A. J. Ayer

- Charles Morris

- Felix Kaufmann

- Victor Kraft

- Sigmund Freud

- Otto Weininger

- Carl Hempel

- Karl Popper

Podemos considerar como precursores del Círculo de Viena a los siguientes autores.

- Auguste Comte

- Albert Einstein

- Gottlob Frege

- John Locke

- David Hume

- Ernst Mach

- Bertrand Russell

- Ludwig Wittgenstein

- Hans Kelsen

Vista de la Ciudad de Viena en aquellos tiempos

Existen cuatro tesis que definen el círculo:

- La posibilidad de verificar un hecho diferencia al conocimiento científico o ciencia, del resto de conocimientos

- Una observación se dice que es científica si pueden ser expresada con símbolos y relacionarse a traves de ellos.

- Todo enunciado científico se identifica dentro de un mismo área de la realidad, no existen distintas partes.

- Todo estudio científico se compone de fases de observación, procesamiento y conclusiones finales (o leyes generalistas). Una observación puntual puede arrojar resultados que no sean los esperados por lo que en muchos casos se hace uso de la probabilidad.

“El nacimiento y desarrollo de la ciencia experimental a partir del siglo XVII ha estado frecuentemente acompañado de polémicas filosóficas, y no pocas posturas filosóficas de la época moderna han representado, en parte, intentos diversos de solucionar esas polémicas”.

Resolver las diferentes polémicas filosóficas han hecho que en la época reciente se constituyese “la filosofía de la ciencia como disciplina autónoma, que ha dado lugar a la aparición de un nuevo tipo de dedicación profesional”.

Karl Popper

La aparición de este nuevo tipo de filósofo suele estar ligada a las actividades del círculo de Viena “que contribuyeron decisivamente a la consolidación de la filosofía de la ciencia como disciplina autónoma”. Desde esas actividades surgieron nuevas figuras que, ancladas en las consideraciones iniciales de la filosofía neopositivista del Círculo intenta responder a la cuestión de qué es la actividad científica y cual es su racionalidad propia. Heredan de la visión positivista que la ciencia es el paradigma de la objetividad y de la racionalidad.

Junto a la postura neopositivista crecen las figuras de otros pensadores. Entre esos nuevos filósofos se encuentra Karl Popper, cuya filosofía es también un intento de explicar el método científico y la racionalidad propia de la ciencia. Se convierte, tras alguno de los miembros del Círculo, en uno de los principales artífices de la consolidación de esta disciplina. A su sombra crecieron los principales filósofos de la ciencia del siglo XX y sus ideas constituyen siempre un paradigma, ya sea para seguirlas, ya sea para criticarlas.

Disolución del Círculo de Viena

La guerra, de Otto Dix. Dresde, Alemania, Gemaldegalerie, Neue Meister

En 1936 Schlick fue asesinado por un antiguo estudiante que era nazi, Hahn había muerto dos años antes, y casi todos los miembros del Círculo eran judíos. Esto produjo, con el advenimiento de los nazis, una diáspora que llevó a su disolución. Feigl se fue a Estados Unidos junto con Carnap, seguidos de Gödel y Ziegel; Neurath se exilió a Inglaterra; y, en 1938, las publicaciones del Círculo de Viena fueron prohibidas en Alemania. En 1939 Carnap, Neurath y Morris publicaron la Enciclopedia internacional de la ciencia unificada, que se puede considerar la última obra del Círculo de Viena.

Los procesos de la Ciencia, en todos sus ámbitos, siempre ha sido unificador del saber

“El proceso de la ciencia es el descubrimiento a cada paso de un nuevo orden que dé unidad a lo que desde hacía tiempo parecía desunirlo.”

Es lo que hizo Faraday cuando cerró el vínculo que unió la electricidad y el magnetismo. Es lo que hizo Clerk Maxwell cuando unió aquélla y éste con la luz. Y la ciencia siguió avanzando de manera que, nuevos paradigmas se implantaron en la física que comenzó a trastocarlo todo.

Él decía: “Todos somos ignorantes, nadie sabe las mismas cosas”. Ciertamente, nadie podrá nunca, saberlo todo de todo

Einstein unió el tiempo y el espacio, la masa a la energía y relacionó las grandes masas cosmológicas con la curvatura y la distorsión del tiempo y el espacio para traernos la gravedad en un teoría moderna; y dedicó los últimos años de su vida al intento de añadir a estas similitudes otra manera nueva y más avanzada, que instaurara un orden nuevo e imaginativo entre las ecuaciones de Maxwell y su propia geometría de la gravitación.

Cuando Coleridge intentaba definir la belleza, volvía siempre a un pensamiento profundo: la belleza, decía, es la “unidad de la variedad”.

“La ciencia no es otra cosa que la empresa de descubrir la unidad en la variedad desaforada de la naturaleza, o más exactamente, en la variedad de nuestra experiencia que está limitada por nuestra ignorancia.”

Hay muchas cosas que no podemos controlar, sin embargo, algo dentro de nosotros, nos envía mensajes sobre lo que podría ser importante para que nos fijemos mejor y continuemos profundizando. Algo dentro de nuestras mentes nos grita: ¡Fijaos en la Naturaleza, ella tiene todas las respuestas!

De los Quarks a las Galaxias

Para comprender mejor el panorama, hagamos una excursión hasta la astrofísica; hay que explicar por qué la física de partículas y la Astronomía se han fundido no hace muchos años, en un nivel nuevo de intimidad, al que alguien llamó la conexión espacio interior/espacio exterior.

Mientras los expertos del espacio interior construían aceleradores, microscopios cada vez más potentes para ver qué pasaba en el dominio subnuclear, los colegas del espacio exterior sintetizaban los datos que tomaban unos telescopios cada vez más potentes, equipados con nuevas técnicas cuyo objeto era aumentar su sensibilidad y la capacidad de ver detalles finos. Otro gran avance fueron los observatorios establecidos en el espacio, con sus instrumentos para detectar infrarrojos, ultravioletas, rayos X y rayos gamma; en pocas palabras, toda la extensión del espectro electromagnético, muy buena parte del cual era bloqueado por nuestra atmósfera opaca y distorsionadora.

La síntesis de la cosmología de los últimos cien años es el modelo cosmológico estándar. Sostiene que el universo empezó en forma de un estado caliente, denso, compacto, hace unos 15.000 millones de años. El universo era entonces infinitamente, o casi infinitamente, denso; infinita, o casi infinitamente, caliente. La descripción “infinito” es incómoda para los físicos; los modificadores son el resultado de la influencia difuminadota de la teoría cuántica. Por razones que quizá no conozcamos nunca, el universo estalló, y desde entonces ha estado expandiéndose y enfriándose.

Ahora bien, ¿cómo se han enterado de eso los cosmólogos? El modelo de la Gran Explosión (Big Bang) nació en los años treinta tras el descubrimiento de que las galaxias (conjuntos de 100.000 millones de estrellas, aproximadamente) se estaban separando entre sí, descubrimiento hecho por Edwin Hubble, que andaba midiendo sus velocidades en 1.929.

Hubble tenía que recoger de las galaxias lejanas una cantidad de luz que le permitiera resolver las líneas espectrales y compararlas con las líneas de los mismos elementos de la Tierra. Cayó en la cuenta de que todas las líneas se desplazaban sistemáticamente hacia el rojo. Se sabía que una fuente de luz que se aparta de un observador hace justo eso. El desplazamiento hacia el rojo era, de hecho, una medida de la velocidad relativa de la fuente y del observador.

Más tarde, Hubble halló que las galaxias se alejaban de él en todas las direcciones; esto era una manifestación de la expansión del espacio. Como el espacio expande las distancias entre todas las galaxias, la astrónoma Hedwina Kubble, que observase desde el planeta Penunbrio en Andrómeda, vería el mismo efecto o fenómeno: las galaxias se apartaría de ella.

Cuanto más distante sea el objeto, más deprisa se mueve. Esta es la esencia de la ley de Hubble. Su consecuencia es que, si se proyecta la película hacia atrás, las galaxias más lejanas, que se mueven más deprisa, se acercarán a los objetos más próximos, y todo el lío acabará juntándose y se acumulará en un volumen muy, muy pequeño, como, según se calcula actualmente, ocurría hace 13.700 millones de años.

La más famosa de las metáforas científicas te pide que imagines que eres una criatura bidimensional, un habitante del Plano. Conoces el este y el oeste, el norte y el sur, pero arriba y abajo no existen; sacaos el arriba y debajo de vuestras mentes. Vivís en la superficie de un globo que se expande. Por toda la superficie hay residencias de observadores, planetas y estrellas que se acumulan en galaxias por toda la esfera; todo bidimensional. Desde cualquier atalaya, todos los objetos se apartan a medida que la superficie se expande sin cesar. La distancia entre dos puntos cualesquiera de este universo crece. Eso es lo que pasa, precisamente, en nuestro mundo tridimensional. La otra virtud de esta metáfora es que, en nuestro universo, no hay ningún lugar especial. Todos los sitios o puntos de la superficie sin democráticamente iguales a todos los demás. No hay centro; no hay borde. No hay peligro de caerse del universo. Como nuestra metáfora del universo en expansión (la superficie del globo) es lo único que conocemos, no es que las estrellas se precipiten dentro del espacio. Lo que se expande es que espacio que lleva toda la barahúnda. No es fácil visualizar una expansión que ocurre en todo el universo. No hay un exterior, no hay un interior. Sólo hay este universo, que se expande. ¿En qué se expande? Pensad otra vez en vuestra vida como habitante del Plano, de la superficie del globo: en nuestra metáfora no existe nada más que la superficie.

Dos consecuencias adicionales de gran importancia que tiene la teoría del Big Bang acabaron por acallar la oposición, y ahora “reina un considerable consenso” -obligado o forzado por la ignorancia de no saber explicar lo que pudo pasar, de otra manera distinta a la del B.B.-. Una es la predicción de que la luz de la incandescencia original (presuponiendo que fue muy caliente) todavía está a nuestro alrededor, en forma de radiación remanente. Recordad que la luz está constituida por fotones, y que la energía de los fotones está en relación inversa con la longitud de onda. Una consecuencia de la expansión del universo es que todas las longitudes se expanden. Se predijo, pues, que las longitudes de onda, originalmente infinitesimales, como correspondía a unos fotones de gran energía, han crecido hasta pertenecer ahora a la región de las microondas, en la que las longitudes son unos pocos milímetros.

En 1.965 se descubrieron los rescoldos del Big Bang, es decir, la radiación de fondo de microondas. Esos fotones bañan el universo entero, y se mueven en todas las direcciones posibles. Los fotones que emprendieron viaje hace miles de millones de años cuando el universo era más pequeño y caliente, fueron descubiertos por una antena de los laboratorios Bell en Nueva Jersey.

Así que el descubrimiento hizo imprescindible medir la distribución de las longitudes de onda, y se hizo. Por medio de la ecuación de Planck, esta medición de la temperatura media de lo que quiera (el espacio, las estrellas, polvo, un satélite, los pitidos de un satélite que se hubiese colado ocasionalmente) que haya estado bañándose en esos fotones.

COBE de la NASA lanzado en 1989

Las mediciones últimas efectuadas por la NASA con el satélite COBE dieron un resultado de 2’73 grados sobre el cero absoluto (2’73 ºK). Esta radiación remanente es una prueba muy potente a favor de la teoría del Big Bang caliente.

Los astrofísicos pueden hablar tan categóricamente porque han calculado qué distancias separaban a dos regiones del cielo en el momento en que se emitió la radiación de microondas observadas por el COBE. Ese momento ocurrió 300.000 años después del Big Bang, no tan pronto como sería deseable, pero sí lo más cerca del principio que podemos.

Resulta que temperaturas iguales en regiones separadas del espacio que nunca habían estado en contacto y cuyas separaciones eran tan grandes que ni siquiera a la velocidad de la luz daba tiempo para que las dos regiones se comunicasen, y sin embargo, sí tenían la misma temperatura. La teoría del Big Bang no podía explicarlo; ¿un fallo?, ¿un milagro? Se dio en llamar a eso la crisis de la causalidad, o de la isotropía.

De la causalidad porque parecía que había una conexión causal entre distintas regiones del cielo que nunca debieran haber estado en contacto; de la isotropía porque donde quiera que mires a gran escala verás prácticamente el mismo patrón de estrellas, galaxias, cúmulos y polvo estelar. Se podría sobrellevar esto en un modelo del Big Bang diciendo que la similitud de las miles de millones de piezas del universo que nunca estuvieron en contacto es puro accidente. Pero no nos gustan los “accidentes”: los milagros están estupendamente si jugamos a la lotería, pero no en la ciencia. Cuando se ve uno, los científicos sospechan que algo más importante se nos mueve entre bastidores. Me parece que mi inclinación científica me hace poco receptivo a los milagros. Si algo para habrá que buscar la causa.

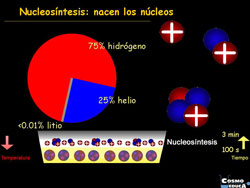

El segundo éxito de gran importancia del modelo del Big Bang tiene que ver con la composición de nuestro universo. Puede parecer que el mundo está hecho de aire, tierra, agua y fuego, pero si echamos un vistazo arriba y medimos con nuestros telescopios espectroscópicos, apenas sí encontramos algo más que hidrógeno, y luego helio. Entre ambos suman el 98% del universo que podemos ver. El resto se compone de los otros noventa elementos. Sabemos gracias a nuestros telescopios espectroscópicos las cantidades relativas de los elementos ligero, y hete aquí que los teóricos del Big Bang dicen que esas abundancias son precisamente las que cabría esperar. Lo sabemos así.

El universo prenatal tenía en sí toda la materia del universo que hoy observamos, es decir, unos cien mil millones de galaxias, cada una con cien mil millones de soles. Todo lo que hoy podemos ver estaba comprimido en un volumen muchísimos menos que la cabeza de un alfiler. La temperatura era alta, unos 1032 grados Kelvin, mucho más caliente que nuestros 273 ºK actuales. Y en consecuencia la materia estaba descompuesta en sus componentes primordiales.

Una imagen aceptable de aquello es la de una “sopa caliente”, o plasma, de quarks y leptones (o lo que haya dentro, si es que hay algo) en la que chocan unos contra otros con energías del orden de 1018 GeV, o un billón de veces la energía del mayor colisionador que cualquier físico pueda imaginarse construir. La gravedad era rugiente, con su poderoso (pero aún mal conocido) influjo en esta escala microscópica.

Tras este comienzo fantástico, vinieron la expansión y el enfriamiento. A medida que el universo se enfriaba, las colisiones eran menos violentas. Los quarks, en contacto íntimo los unos con los otros como partes del denso grumo que era el universo infantil, empezaron a coagularse en protones, neutrones y los demás hadrones. Antes, esas uniones se habrían descompuesto en las inmediatas y violentas colisiones, pero el enfriamiento no cesaba; aumentaba con la expansión y las colisiones eran cada vez más suaves.

A los tres minutos de edad, las temperaturas habían caído lo bastante como para que pudiesen combinarse los protones y los neutrones, y se formaran núcleos estables. Este fue el periodo de nucleosíntesis, y como se sabe lo suficiente de física nuclear se pueden calcular las abundancias relativas de los elementos químicos que se formaron. Son los núcleos de elementos muy ligeros; los más pesados requieren de una “cocción” lenta en las estrellas.

Claro que, los átomos (núcleos más electrones) no se formaron hasta que la temperatura no cayó lo suficiente como para que los electrones se organizaran alrededor de los núcleos, lo que ocurrió 300.000 años después, más o menos. Así que, en cuanto se formaron los átomos neutros, los fotones pudieron moverse libremente, y ésta es la razón de que tengamos una información de fotones de microondas todavía.

La nucleosíntesis fue un éxito: las abundancias calculadas y las medidas coincidían. Como los cálculos son una mezcla íntima de física nuclear, reacciones de interacción débil y condiciones del universo primitivo, esa coincidencia es un apoyo muy fuerte para la teoría del Big Bang.

En realidad, el universo primitivo no era más que un laboratorio de acelerador con un presupuesto ilimitado. Nuestros astrofísicos tenían que saberlo todo acerca de los quarks y los leptones y las fuerzas para construir un modelo de evolución del universo. Los físicos de partículas reciben datos de su experimento grande y único. Por supuesto, para los tiempos anteriores a los 10-13 segundos, están mucho menos seguros de las leyes de la física. Así que, los astrofísicos azuzan a los teóricos de partículas para que se remanguen y contribuyan al torrente de artículos que los físicos teóricos lanzan al mundo con sus ideas: Higgs, unificación de cuerdas vibrantes, compuestos (qué hay dentro de los quarks) y un enjambre de teorías especulativas que se aventuran más allá del modelo estándar para construir un puente que nos lleve a la descripción perfecta del universo, de la Naturaleza. ¿Será posible algún día?

Esperemos a ver qué pasa con la historia que comenzaron Grabielle Veneziano, John Schwartz, André Neveu, Pierre Ramond, Jeff Harvey, Joel Sheik, Michael Green, David Gross y un dotado flautista de Hamelin que responde al nombre de Edward Witten.

La teoría de cuerdas es una teoría que nos habla de un lugar muy distante. Según Leon Lederman… “casi tan distante como Oz o la Atlántida”. Estamos hablando del dominio de Planck, ese lugar al que nadie ha podido llegar nunca. No hay forma de que podamos imaginar datos experimentales en ese tiempo tan lejano; las energías necesarias (las de la masa de Planck) no están a nuestro alcance.

Y, a todo esto, tenemos que comprender que todo, absolutamente todo lo que anteriormente habéis leído más arriba, es lo que creemos que sabemos y que, de ninguna manera, tiene que reflejar la realidad que…, de momento y a ciencia cierta, desconocemos.

emilio silvera

Totales: 71.141.602

Totales: 71.141.602 Conectados: 33

Conectados: 33