Feb

27

Desde la materia “inerte”… ¡Hasta los pensamientos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Mente - Filosofía ~

Clasificado en La Mente - Filosofía ~

Comments (0)

Comments (0)

Tales de Mileto (c. 624-546 a.C.), considerado el primer filósofo de la historia, propuso que el agua es el arjé (principio u origen) de todas las cosas. Observó que lo húmedo es esencial para la vida, la nutrición y la generación de semillas, concluyendo que la tierra flota sobre agua.

Lo mismo que desconocemos la auténtica naturaleza de la Luz, que según creo encierra muchos secretos que tenemos que desvelar para conocer la realidad de la Naturaleza y del Universo, de la misma manera, tenemos que llegar a desvelar los secretos que se encierra en esa esencial y sencilla sustancia que llamamos agua, ya Tales de Mileto nos hablaba de la importancia que esa sustancia tenía para la vida.

Según todos los indicios:

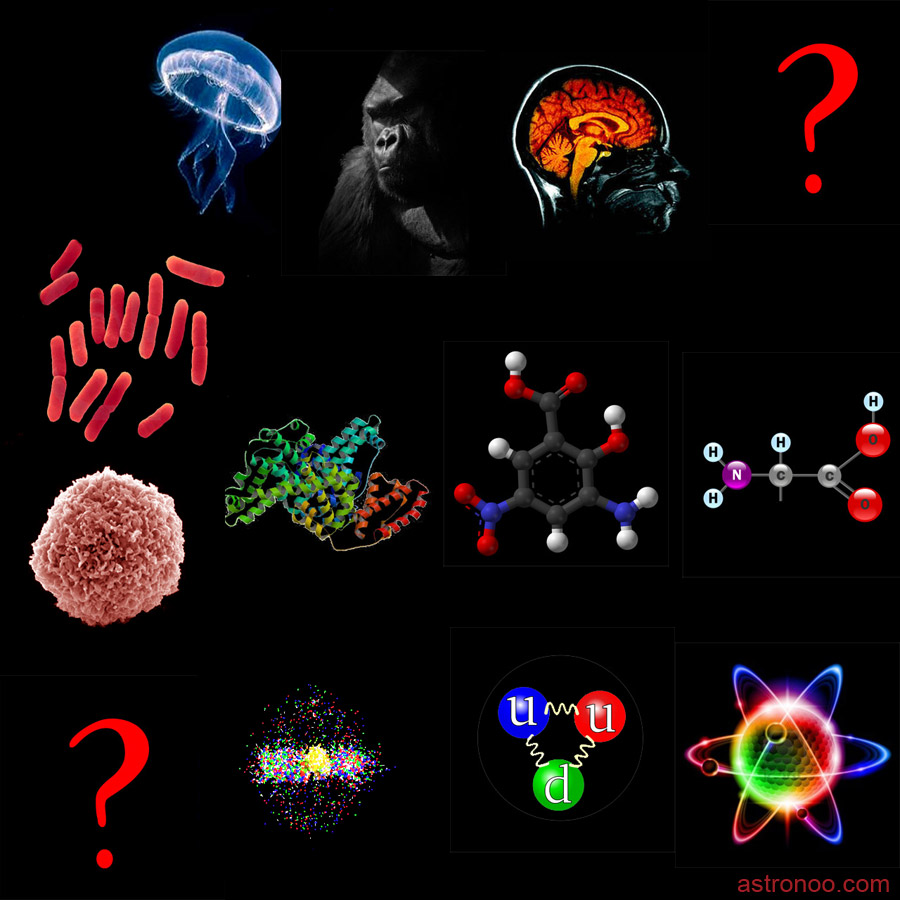

La vida surgió de la materia inerte a través de un proceso evolutivo de complejidad creciente, conocido como abiogénesis, donde las moléculas inorgánicas simples se combinaron para formar estructuras orgánicas complejas y funcionales. Este fenómeno químico-físico permitió que, bajo condiciones primitivas, la materia se autoorganizara, interactuara y desarrollara metabolismo, evolucionando hacia células y organismos complejos.

¿Cómo es posible que, a partir de la materia “inerte”, hayan podido surgir seres vivos e incluso, algunos que, como nosotros puedan pensar? Rememoramos el pasado y conjeturamos sobre el futuro. Que cosa mágica se pudo producir en el corazón de las estrellas para que, materiales sencillos como el Hidrógeno se convirtieran a miles de millones de grados de calor en otros que, como el Carbono, Oxigeno y Nitrógeno…, muchos miles de millones de años más tardes, en mundos perdidos en sistemas planetarios como el nuestro, dieran lugar a la formación de Protoplasma vivo del que surgieron aquellos infinitesimales seres que llamamos bacterias y que, posibilitaron la evolución hacia formas de vida superiores?

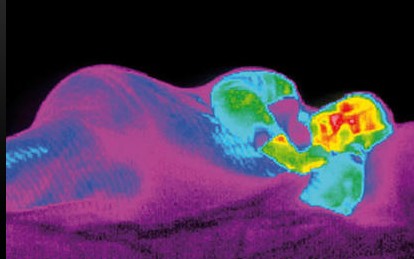

Los sentidos: las herramientas que utiliza el cerebro para estar comunicado con el exterior

La percepción, los sentidos y los pensamientos… Para poder entender la conciencia como proceso es preciso que entendamos cómo funciona nuestro cerebro, su arquitectura y desarrollo con sus funciones dinámicas. Lo que no está claro es que la conciencia se encuentre causalmente asociada a ciertos procesos cerebrales pero no a otros.

El cerebro humano ¿es especial?, su conectividad, su dinámica, su forma de funcionamiento, su relación con el cuerpo y con el mundo exterior, no se parece a nada que la ciencia conozca. Tiene un carácter único y ofrecer una imagen fidedigna del cerebro no resulta nada fácil; es un reto tan extraordinario que no estamos preparados para cumplir en este momento. Estamos lejos de ofrecer esa imagen completa, y sólo podemos dar resultados parciales de esta enorme maravilla de la Naturaleza. No deja de evolucionar y, algún día, trascenderá hacia estadios superiores mentales que ahora, ni podemos imaginar.

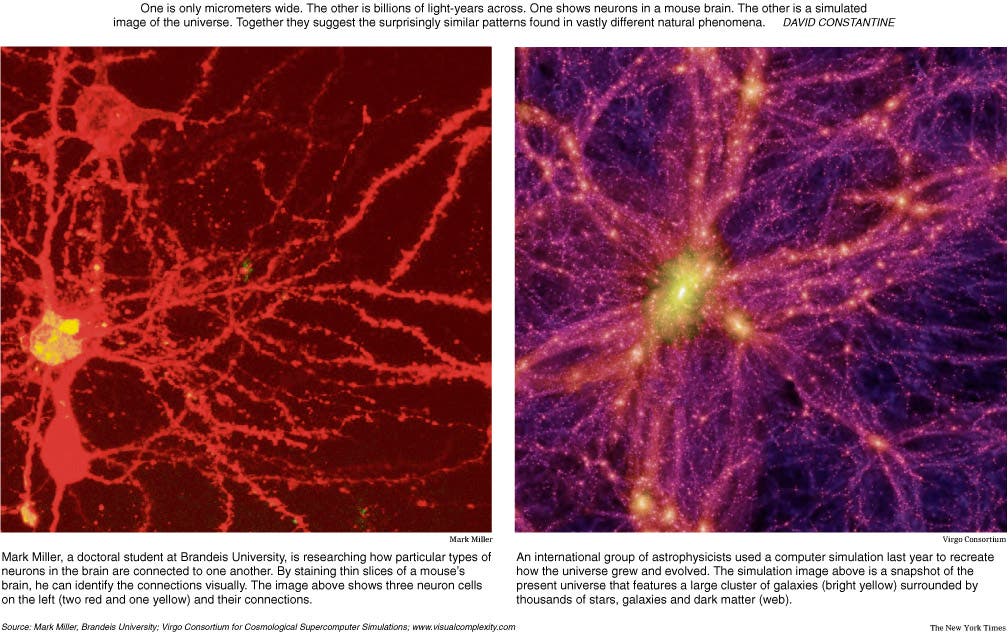

Aquí se fraguan los pensamientos como en las galaxias lo hacen las estrellas

Nuestro cerebro adulto, con poco más de 1,5 Kg de peso, contiene unos cien mil millones de células nerviosas o neuronas. La parte o capa ondulada más exterior o corteza cerebral, que es la parte del cerebro de evolución más reciente, contiene alrededor de treinta millones de neuronas y un billón de conexiones o sinapsis. Si contáramos una sinapsis cada segundo, tardaríamos 32 millones de años en acabar el recuento. Si consideramos el número posible de circuitos neuronales, tendremos que habérnoslas con cifras hiper-astronómicas. Un 10 seguido de, al menos, un millón de ceros (en comparación, el número de partículas del universo conocido asciende a “tan sólo” un 10 seguido de 79 ceros). ¡A que va a resultar que no somos tan insignificantes!

El suministro de datos que llega en forma de multitud de mensajes procede de los sentidos, que detectan el entorno interno y externo, y luego envía el resultado a los músculos para dirigir lo que hacemos y decimos. Así pues, el cerebro es como un enorme ordenador que realiza una serie de tareas basadas en la información que le llega de los sentidos. Pero, a diferencia de un ordenador, la cantidad de material que entra y sale parece poca cosa en comparación con la actividad interna. Seguimos pensando, sintiendo y procesando información incluso cuando cerramos los ojos y descansamos.

En las horas de sueño. Muchos grupos neuronales se mantienen activos y producen impulsos nerviosos, por lo que durante el sueño se mantiene una importante actividad mental, en forma de sueños o en otras maneras que no podemos recordar más tarde al despertar.

Con tan enorme cantidad de circuitos neuronales, ¿Cómo no vamos a ser capaces de descifrar todos los secretos de nuestro universo? ¿De qué seremos capaces cuando podamos disponer de un rendimiento cerebral del 80 ó 90 por ciento? Algunas veces hemos oído comentar: “Sólo utilizamos un diez por ciento del cerebro…” En realidad, la frase no indica la realidad, se refiere al hecho de que, aunque utilizamos el cerebro en su totalidad, se estima que está al diez por ciento de su capacidad real que, será una realidad a medida que evolucione y, en el futuro, esa capacidad de hoy será un 90 por ciento mayor.

Aún no conocemos bien la direccionalidad de los circuitos neuronales

El límite de lo que podremos conseguir tiene un horizonte muy lejano. Y, llega un momento en el cual, se puede llegar a pensar que no existen limites en lo que podemos conseguir: Desde hablar sin palabras sonoras a la auto-transportación. Si -como pienso- somos pura energía pensante, no habrá límite alguno; el cuerpo que ahora nos lleva de un lugar a otro, ya no será necesario, y como los fotones que no tienen masa, podremos desplazarnos a velocidades lumínicas.

Claro que ya podemos teletransportar átomos

Creo que estoy corriendo demasiado en el tiempo, volvamos a la realidad. A veces mi mente se dispara. Lo mismo visito mundos extraordinarios con mares luminosos de neón líquido poblados por seres transparentes, que viajo a galaxias muy lejanas pobladas de estrellas de fusión fría circundadas por nubes doradas compuestas de antimateria en la que, los positrones medio congelados, se mueven lentamente formando un calidoscopio de figuras alucinantes de mil colores. ¡La mente, qué tesoro!

Alguna vez me pregunté: ¿Es más grande el cerebro que el Universo en algún sentido? Bueno, la respuesta a esa pregunta la dejaría a la imaginación… ¿ilimitada? No, todo tiene un límite en nuestro universo.

No lo sabemos ¿tendrá nuestra presencia en el Universo algún sentido?

“Durante siglos el hombre ha intentado responder a una de las más complicadas inquietudes: ¿Es el cerebro humano más grande que el universo? Y si bien la respuesta aún no ha llegado, muchos expertos a lo largo de los años han intentado esbozar sus teorías.

Precisamente, con el fin de poder acercar una somera respuesta a esta gigantesco interrogante, el periodista Robert Krulwich ha publicado recientemente en la página web NPR.org una completa compilación de este gran e interminable. Una compilación que incluye teorías de ambos bandos, y entre las cuales existen muchas que son realmente convincentes.”

Mirando ambas imágenes… ¿Quién podría decir, si no se les explicara, que son “mundos” diferentes”

La unidad a partir de la cual se configuran todas las fabulosas actividades del cerebro es una célula del mismo, la neurona. Las neuronas son unas células fantásticamente ramificadas y extendidas, pero diminutas que, sin embargo y en sentido figurado, podríamos decir que son tan grandes como el universo mismo.

Cuando seamos capaces de convertir en realidad todo aquello en lo que podamos pensar, entonces, habremos alcanzado la meta. Para que eso pueda llegar a ocurrir, aún falta mucho tiempo. Sin embargo, si el Universo no lo impide y nuestro transcurrir continúa, todo lo que podamos imaginar… podrá ser posible. Incluso imposibilidades físicas de hoy, dejarán de existir mañana y, ¡la Mente! posiblemente (al igual que hoy ordena a las distintas partes del cuerpo que realice esta o aquella función), se encargará de que todo funcione bien, erradicará cualquier enfermedad que nos pueda atacar y, tendrá el conjunto del “sistema” en perfectas condiciones de salud, lo cual me lleva a pensar que, para cuando eso llegue, los médicos serán un recuerdo del pasado.

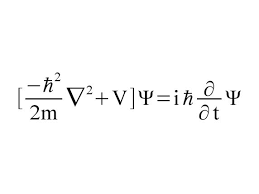

Veamos, por ejemplo, la Ecuación de Schrödinger

¿Qué dice?

La ecuación modela la materia no como una partícula, sino como una onda, y describe cómo estas ondas se propagan.

¿Por qué es importante?

La ecuación de Schrödinger es fundamental para la mecánica cuántica, que junto con la relatividad general constituyen en la actualidad las teorías más efectivas del universo físico.

¿Qué provocó?

Una revisión radical de la física del mundo a escalas muy pequeñas, en las cuales cada objeto tiene una «función de onda» que describe una nube de probabilidad de posibles estados. A este nivel el mundo es incierto intrínsecamente. Intentos de relacionar el mundo microscópico cuántico con nuestro mundo macroscópico clásico llevaron a temas filosóficos que todavía tienen eco. Pero experimentalmente, la teoría cuántica funciona maravillosamente bien y los láseres y chips de los ordenadores actuales no funcionarían sin ella.

Es curioso y sorprendente la evolución alcanzada por la Mente Humana. El mundo físico se representa gobernado de acuerdo a leyes matemáticas. Desde este punto de vista, todo lo que hay en el universo físico está realmente gobernado en todos sus detalles por principios matemáticos, quizá por ecuaciones tales que aún no hemos podido llegar a comprender y, ni que sabemos que puedan existir.

Lo más seguro es que la descripción real del mundo físico esté pendiente de matemáticas futuras, aún por descubrir, fundamentalmente distintas de las que ahora tenemos. Llegarán nuevos Gauss, Riemann, Euler, o, Ramanujan… que, con sus nuevas ideas transformarán el pensamiento matemático para hacer posible que podamos, al fin, comprender lo que realmente somos. Una cosa es cierta, cuando las palabras no son suficiente para explicar la realidad, los científicos echan mano de las matemáticas que de manera exacta pueden describir lo que ocurre en la Naturaleza, en el Universo.

Son nuestras Mentes, productos de la evolución del Universo que, a partir de la materia “inerte”, ha podido alcanzar el estadio bio-químico de la consciencia y, al ser conscientes, hemos podido descubrir que existen “números misteriosos” dentro de los cuales subyacen mensajes que tenemos que desvelar.

Antes tendremos que haber descifrado las funciones modulares de los cuadernos perdidos de Ramanujan, o por ejemplo, el verdadero significado del número 137, ése número puro adimensional que encierra los misterios del electrón (e) – electromagnetismo -, de la constante de Planck (h) – el cuando te acción – y de la luz (c) – la relatividad -.

Y, mientras tanto, nuestras mentes siguen su camino, siempre queriendo ir más allá y siempre profundizando en los secretos de la Naturaleza de lo que tenemos muchos ejemplos, tales como nuestras consideraciones sobre los dos aspectos de la relatividad general de Einstein, a saber, el principio de la relatividad, que nos dice que las leyes de la física son ciegas a la distinción entre reposo y movimiento uniforme; y el principio de equivalencia, que nos dice de qué forma sutil deben modificarse estas ideas para englobar el campo gravitatorio.

Lo incomprensible es que podamos haber llegado a comprender, al menos, parte del Universo que contiene todo lo que existe, es el recipiente mayor, ahí residen por orden de volumen, primero las galaxias cuajadas de estrellas y Nebulosas, cuásares y Mundos y, en muchos de ellos, probablemente, criaturas inteligentes se estarán planteando las mismas preguntas que nosotros: ¿Qué es la materia? ¿Cómo pudimos llegar aquí? ¿Comprenderemos alguna vez?

Mediante la combinación de diversas observaciones de telescopios, y la ayuda del trabajo de modelación avanzada, el equipo de Emanuele Farina, de la Universidad de Insubria en la provincia de Como, Italia, y Michele Fumagalli del Instituto Carnegie de Ciencia, en Washington, D.C., Estados Unidos, fue capaz de captar como tal el trío de quásares, llamado QQQ J1519+0627. La luz de esos quásares ha viajado 9.000 millones de años-luz para llegar hasta nosotros, lo que significa que dicha luz fue emitida cuando el universo tenía sólo un tercio de su edad actual.

llegar hasta nosotros, lo que significa que dicha luz fue emitida cuando el universo tenía sólo un tercio de su edad actual.

Todo es finito, es decir, que tiene un fin, y la velocidad de la luz no podía ser una excepción

Un ramillete de cuantos de luz (fotones) que se desplazan a 299.792.458 metros por segundo

Ahora hay que hablar del tercer ingrediente fundamental de la teoría de Einstein, que está relacionada con la finitud de la velocidad de la luz. Es un hecho notable que estos tres ingredientes básicos puedan remontarse a Galileo; en efecto, parece que fue también Galileo el primero que tuvo una expectativa clara de que la luz debería viajar con velocidad finita, hasta el punto de que intentó medir dicha velocidad. El método que propuso (1.638), que implica la sincronización de destellos de linternas entre colinas distantes, era, como sabemos hoy, demasiado tosco (otro ejemplo de la evolución que, con el tiempo, se produce en nuestras mentes). Él no tenía forma alguna de anticipar la extraordinaria velocidad de la luz.

Parece que tanto Galileo como Newton tenían poderosas sospechas respecto a un profundo papel que conecta la naturaleza de la luz con las fuerzas que mantienen la materia unida y, si consideramos que esa fuerza que hace posible la unión de la materia reside en el corazón de los átomos (en sus núcleos), podemos hacernos una clara idea de lo ilimitado que puede ser el pensamiento humano que, ya en aquellos tiempos -en realidad mucho antes- pudo llegar a intuir las fuerzas que están presentes en nuestro Universo.

Los Gluones (intermediarios de la fuerza nuclear fuerte), impiden que los Quarks se separen

En los núcleos atómicos reside la fuerza (nuclear fuerte) que hace posible la existencia de la materia que comienza por los átomos que, al juntarse y formar células, hace posible que éstas se junten y formen moléculas que a su vez, se reúnen para formar sustancias y cuerpos.

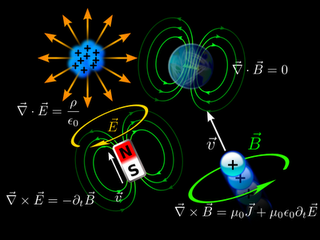

Pero la comprensión adecuada de estas ideas tuvo que esperar hasta el siglo XX, cuando se reveló la verdadera naturaleza de las fuerzas químicas y de las fuerzas que mantienen unidos los átomos individuales. Ahora sabemos que tales fuerzas tienen un origen fundamentalmente electromagnético (que vincula y concierne a la implicación del campo electromagnético con partículas cargadas) y que la teoría del electromagnetismo es también la teoría de la luz.

Para entender los átomos y la química se necesitan otros ingredientes procedentes de la teoría cuántica, pero las ecuaciones básicas que describen el electromagnetismo y la luz fueron propuestas en 1.865 por el físico escocés James Clark Maxwell, que había sido inspirado por los magníficos descubrimientos experimentales de Michael Faraday unos treinta años antes y que él plasmó en una maravillosa teoría.

entender los átomos y la química se necesitan otros ingredientes procedentes de la teoría cuántica, pero las ecuaciones básicas que describen el electromagnetismo y la luz fueron propuestas en 1.865 por el físico escocés James Clark Maxwell, que había sido inspirado por los magníficos descubrimientos experimentales de Michael Faraday unos treinta años antes y que él plasmó en una maravillosa teoría.

El electromagnetismo es una rama de la Física que estudia y unifica los fenómenos eléctricos y magnéticos en una sola teoría. El electromagnetismo es una teoría de campos; es decir, las explicaciones y predicciones que provee se basan en magnitudes físicas vectoriales dependientes de la posición en el espacio y del tiempo.

Esta teoría del electromagnetismo de Maxwell tenía la particularidad de que requería que la velocidad de la luz tuviera un valor fijo y definido, que normalmente se conoce como c, y que en unidades ordinarias es aproximadamente 3 × 108 metros por segundo. Maxwell, guiado por los experimentos de Faraday, hizo posible un hecho que cambió la historia de la humanidad para siempre. Un hecho de la misma importancia que el descubrimiento del fuego, la rueda o los metales. El matemático y poeta escocés unificó los campos eléctrico y magnético a través de unas pocas ecuaciones que describen como estos campos se entretejen y actúan sobre la materia.

teoría del electromagnetismo de Maxwell tenía la particularidad de que requería que la velocidad de la luz tuviera un valor fijo y definido, que normalmente se conoce como c, y que en unidades ordinarias es aproximadamente 3 × 108 metros por segundo. Maxwell, guiado por los experimentos de Faraday, hizo posible un hecho que cambió la historia de la humanidad para siempre. Un hecho de la misma importancia que el descubrimiento del fuego, la rueda o los metales. El matemático y poeta escocés unificó los campos eléctrico y magnético a través de unas pocas ecuaciones que describen como estos campos se entretejen y actúan sobre la materia.

La interminable escalera que tenemos que subir en busca del conocimiento que, nunca podremos tener

Claro que, estos importantísimos avances han sido simples escalones de la “infinita” escalera que tenemos que subir y, la misma relatividad de Einstein no ha sido (después de un siglo) aún comprendido en su plenitud y muchos de sus mensajes están escondidos en lo más profundo de nuestras mentes que, ha sabido parcialmente descubrir el mensaje de Einstein, pero seguimos buscando.

Sin embargo, esto nos presenta un enigma si queremos conservar el principio de relatividad. El sentido común nos diría que si se mide que la velocidad de la luz toma el valor concreto c en el sistema de referencia del observador, entonces un segundo observador que se mueva a una velocidad muy alta con respecto al primero medirá que la luz viaja a una velocidad diferente, aumentada o disminuida, según sea el movimiento del segundo observador.

Estaría bueno que, al final se descubriera que alfa (α) tuviera un papel importante en la compleja teoría de cuerdas, ¿Por qué no? En realidad alfa, la constante de estructura fina, nos habla del magnetismo, de la constante de Planck y de la relatividad especial, es decir, la velocidad de la luz y, todo eso, según parece, emergen en las ecuaciones topológicas de la moderna teoría de cuerdas. ¡Ya veremos!

Pero el principio de relatividad exigiría que las leyes físicas del segundo observador (que definen en particular la velocidad de la luz que percibe el segundo observador) deberían ser idénticas a las del primer observador. Esta aparente contradicción entre la constancia de la velocidad de la luz y el principio de relatividad condujo a Einstein (como de hecho, había llevado previamente al físico holandés Hendrick Antón Lorentz y muy en especial al matemático francés Henri Poincaré) a un punto de vista notable por el que el principio de relatividad del movimiento puede hacerse compatible con la constancia de una velocidad finita de la luz.

¿Cómo funciona esto? Sería normal que cualquier persona creyera en la existencia de un conflicto irresoluble entre los requisitos de una teoría como la de Maxwell, en la que existe una velocidad absoluta de la luz, y un principio de relatividad según el cual las leyes físicas parecen las mismas con independencia de la velocidad del sistema de referencia utilizado para su descripción.

¿No podría hacerse que el sistema de referencia se moviera con una velocidad que se acercara o incluso superara a la de la luz? Y según este sistema, ¿no es cierto que la velocidad aparente de la luz no podría seguir siendo la misma que era antes? Esta indudable paradoja no aparece en una teoría, tal como la originalmente preferida por Newton (y parece que también por Galileo), en la que la luz se comporta como partículas cuya velocidad depende de la velocidad de la fuente. En consecuencia, Galileo y Newton podrían seguir viviendo cómodamente con un principio de relatividad.

La velocidad de la luz en el vacío es una constante de la Naturaleza y, cuando cientos de miles de millones de millones salen disparados de esta galaxia hacia el vacío espacial, su velocidad de 299.792.450 metros por segundo, es constante independientemente de la fuente que pueda emitir los fotones y de si ésta está en reposo o en movimiento.

Así que, la antigua imagen de la naturaleza de la luz entró en conflicto a lo largo de los años, como era el caso de observaciones de estrellas dobles lejanas que mostraban que la velocidad de la luz era independiente de la de su fuente. Por el contrario, la teoría de Maxwell había ganado fuerza, no sólo por el poderoso apoyo que obtuvo de la observación (muy especialmente en los experimentos de Heinrich Hertz en 1.888), sino también por la naturaleza convincente y unificadora de la propia teoría, por la que las leyes que gobiernan los campos eléctricos, los campos magnéticos y la luz están todos subsumidos en un esquema matemático de notable elegancia y simplicidad.

Las ondas luminosas como las sonoras, actúan de una u otra manera dependiendo del medio en el que se propagan.

En la teoría de Maxwell, la luz toma forma de ondas, no de partículas, y debemos enfrentarnos al hecho de que en esta teoría hay realmente una velocidad fija a la que deben viajar las ondas luminosas.

El punto de vista geométrico-espaciotemporal nos proporciona una ruta particularmente clara hacia la solución de la paradoja que presenta el conflicto entre la teoría de Maxwell y el principio derelatividad.

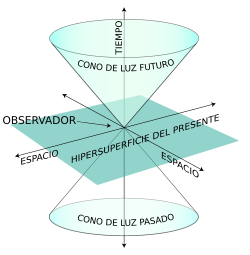

Noción del Espacio Tiempo

Este punto de vista espaciotemporal no fue el que Einstein adoptó originalmente (ni fue el punto de vista de Lorentz, ni siquiera, al parecer, de Poincaré), pero, mirando en retrospectiva, podemos ver la potencia de este enfoque. Por el momento, ignoremos la gravedad y las sutilezas y complicaciones asociadas que proporciona el principio de equivalencia y otras complejas cuestiones, que estimo aburrirían al lector no especialista, hablando de que en el espacio-tiempo se pueden concebir grupos de todos los diferentes rayos de luz que pasan a ser familias de líneas de universo.

Baste saber que, como quedó demostrado por Einstein, la luz, independientemente de su fuente y de la velocidad con que ésta se pueda mover, tendrá siempre la misma velocidad en el vacío, c, o 299.792.458 metros por segundo. Cuando la luz atraviesa un medio material, su velocidad se reduce. Precisamente, es la velocidad c el límite alcanzable de la velocidad más alta del universo. Es una constante Universal y, como hemos dicho, es independiente de la velocidad del observador y de la fuente emisora.

El Universo está dentro de nuestras Mentes

¡La Mente! Qué caminos puede recorrer y, sobre todo ¿Quien la guía? Comencé este trabajo con la imagen del ojo humano y hablando de los sentidos y de la consciencia y mira donde he finalizado…Sí, nos falta mucho camino por recorrer para llegar a desvelar los misterios de la Mente que, en realidad, es la muestra más alta que el Universo nos puede mostrar de lo que puede surgir a partir de la sencillez de los átomos de hidrógeno que, evolucionados, primero en las entrañas de las estrellas y después en los circuitos de nuestras mentes, llega hasta los pensamientos y la imaginación que…son palabras mayores de cuyo alcance, aún no tenemos una idea que realmente refleje su realidad.

con la imagen del ojo humano y hablando de los sentidos y de la consciencia y mira donde he finalizado…Sí, nos falta mucho camino por recorrer para llegar a desvelar los misterios de la Mente que, en realidad, es la muestra más alta que el Universo nos puede mostrar de lo que puede surgir a partir de la sencillez de los átomos de hidrógeno que, evolucionados, primero en las entrañas de las estrellas y después en los circuitos de nuestras mentes, llega hasta los pensamientos y la imaginación que…son palabras mayores de cuyo alcance, aún no tenemos una idea que realmente refleje su realidad.

Pero, ¿existe alguna realidad?, o, por el contrario todo es siempre cambiante y lo que hoy es mañana no existirá, si “realmente” es así, ocurre igual que con el tiempo. La evolución es algo que camina siempre hacia adelante, es inexorable, nunca se para y, aunque como el tiempo pueda ralentizarse, finalmente sigue su camino hacia esos lugares que ahora, sólo podemos imaginar y que, seguramente, nuestros pensamientos no puedan (por falta de conocimientos) plasmar en lo que será esa realidad futura.

En una increíble maraña de nervios y conexiones sin fin…. ¡surgen los pensamientos!

Es curioso y sorprendente la evolución alcanzada por la Mente Humana. El mundo físico se representa gobernado de acuerdo a leyes matemáticas. Desde este punto de vista, todo lo que hay en el universo físico está realmente gobernado en todos sus detalles por principios matemáticos, quizá por ecuaciones tales que aún no hemos podido llegar a comprender y, ni que sabemos que puedan existir (como antes decía).

¡Es todo tan complejo! ¡Sabemos tan poco!

Emilio Silvera V.

Feb

27

Noticias NASA

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias NASA ~

Clasificado en Noticias NASA ~

Comments (0)

Comments (0)

El Sistema Solar y Más Allá Está Repleto de Agua

Según investigaciones respaldadas por la NASA y observaciones de sus telescopios (Hubble, James Webb, SOFIA), el agua es un elemento sorprendentemente común, no solo en nuestro Sistema Solar, sino en todo el universo.

10.04.15.- A medida que las misiones de la NASA exploran nuestro sistema solar y buscan nuevos mundos, están encontrando agua en lugares sorprendentes. El agua es una pieza fundamental en nuestra búsqueda de planetas habitables y vida más allá de la Tierra que vincula de forma sorprendente mundos aparentemente dispares.

“Las actividades científicas de la NASA han proporcionado en los últimos años una ola de descubrimientos asombrosos relacionados con el agua que nos inspiran para continuar investigando nuestros orígenes y las fascinantes posibilidades de vida en el Universo”, dijo Ellen Stofan, científico jefe de la agencia.”Podríamos estar cerca de responder finalmente a la pregunta de si estamos solos en nuestro sistema solar y más allá.”

(En este punto la emoción le pudo y se dejó llevar -pienso yo-)

Los elementos químicos que componen el agua, hidrógeno y oxígeno, son algunos de los más abundantes en el universo. Los astrónomos detectan la firma del agua en nubes moleculares gigantescas en el espacio interestelar, en los discos de materia de los que nacen nuevos sistemas planetarios, y en las atmósferas de planetas gigantes orbitando otras estrellas.

Existen muchos mundos que se piensa que tienen agua líquida debajo de su superficie, y muchos otros que tienen agua en forma de hielo o vapor. El agua se encuentra en cuerpos primitivos tales como cometas y asteroides, y en planetas enanos como Ceres. Las atmósferas y el interior de los cuatro planetas gigantes – Júpiter, Saturno, Urano y Neptuno – se cree que contienen enormes cantidades de materia líquida, y sus lunas y anillos tienen cantidades sustanciales de hielo de agua.

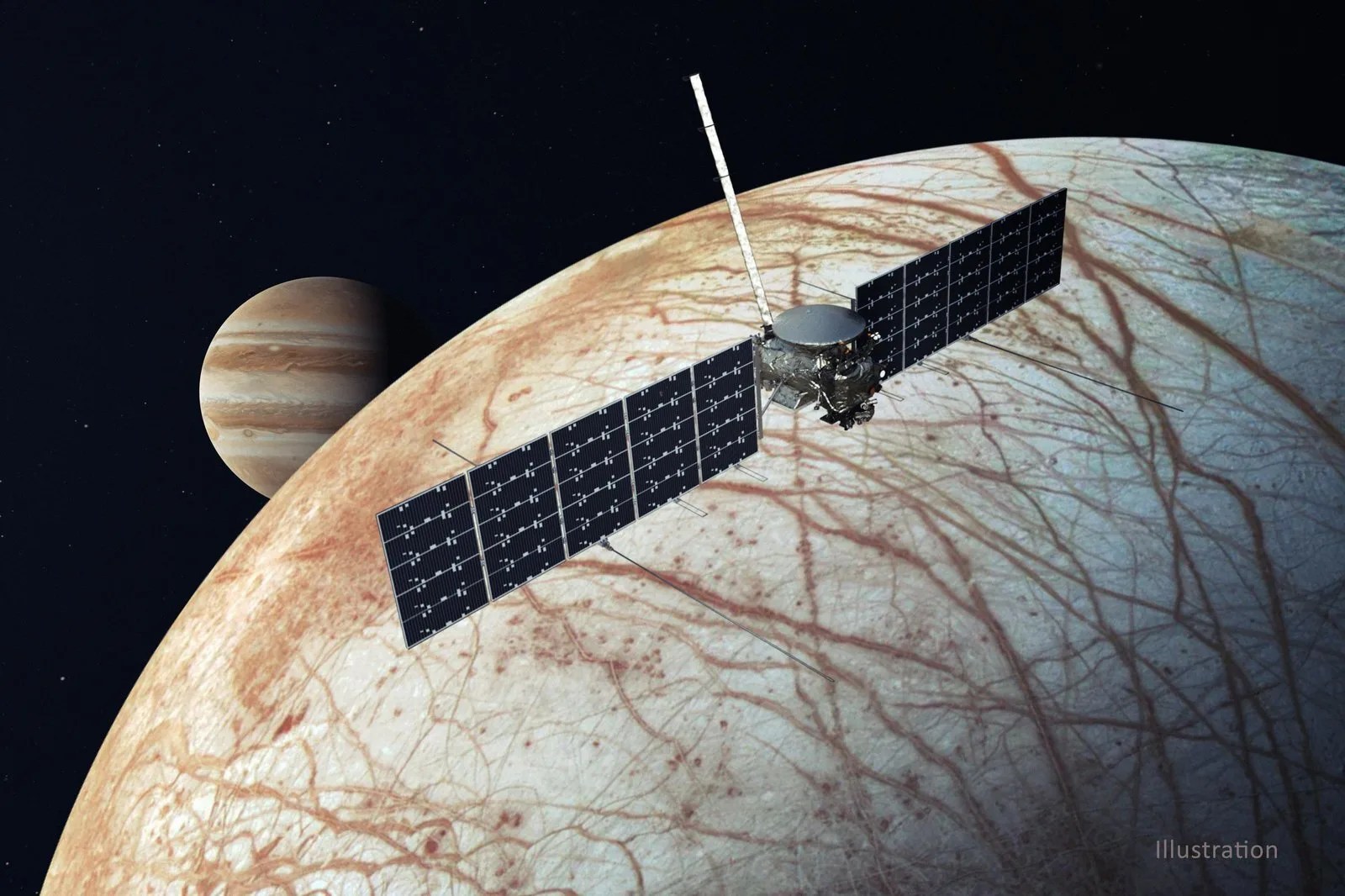

Tal vez los mundos oceánicos más sorprendentes son las cinco lunas heladas de Júpiter y Saturno que presentan fuertes evidencias de océanos debajo de sus superficies: Ganímedes, Europa y Calisto en Júpiter, y Encélado y Titán de Saturno.

El Telescopio Espacial Hubble proporcionó recientemente poderosas evidencias de que Ganímedes posee un océano de agua salada bajo su superficie, probablemente localizado entre dos capas de hielo.

| La NASA está explorando nuestro Sistema Solar y más allá para comprender el funcionamiento del Universo, buscando agua y vida entre las estrellas. Image Credit: NASA

|

Europa y Encelado se cree que tienen un océano de agua líquida bajo su superficie, en contacto con rocas ricas en minerales, y podrían tener los tres ingredientes necesarios para la vida tal y como la conocemos: agua líquida, elementos químicos esenciales para los procesos biológicos, y fuentes de energía que podrían ser usadas por los seres vivos. La misión Cassini de la NASA ha revelado que Encelado es un mundo activo con géiseres de hielo. Investigaciones recientes sugieren que podría haber actividad hidrotermal en su suelo oceánico, un ambiente potencialmente adecuado para los organismos vivos.

Naves de la NASA también han encontrado indicios de agua en los cráteres en sombra permanente sobre Mercurio y la Luna, que mantienen un registro de impactos de hielo a través del tiempo como recuerdos criogénicos.

Mientras que por un lado nuestro Sistema Solar parece estar anegado en agua en algunos lugares, otros parecen haber perdido grandes cantidades de agua.

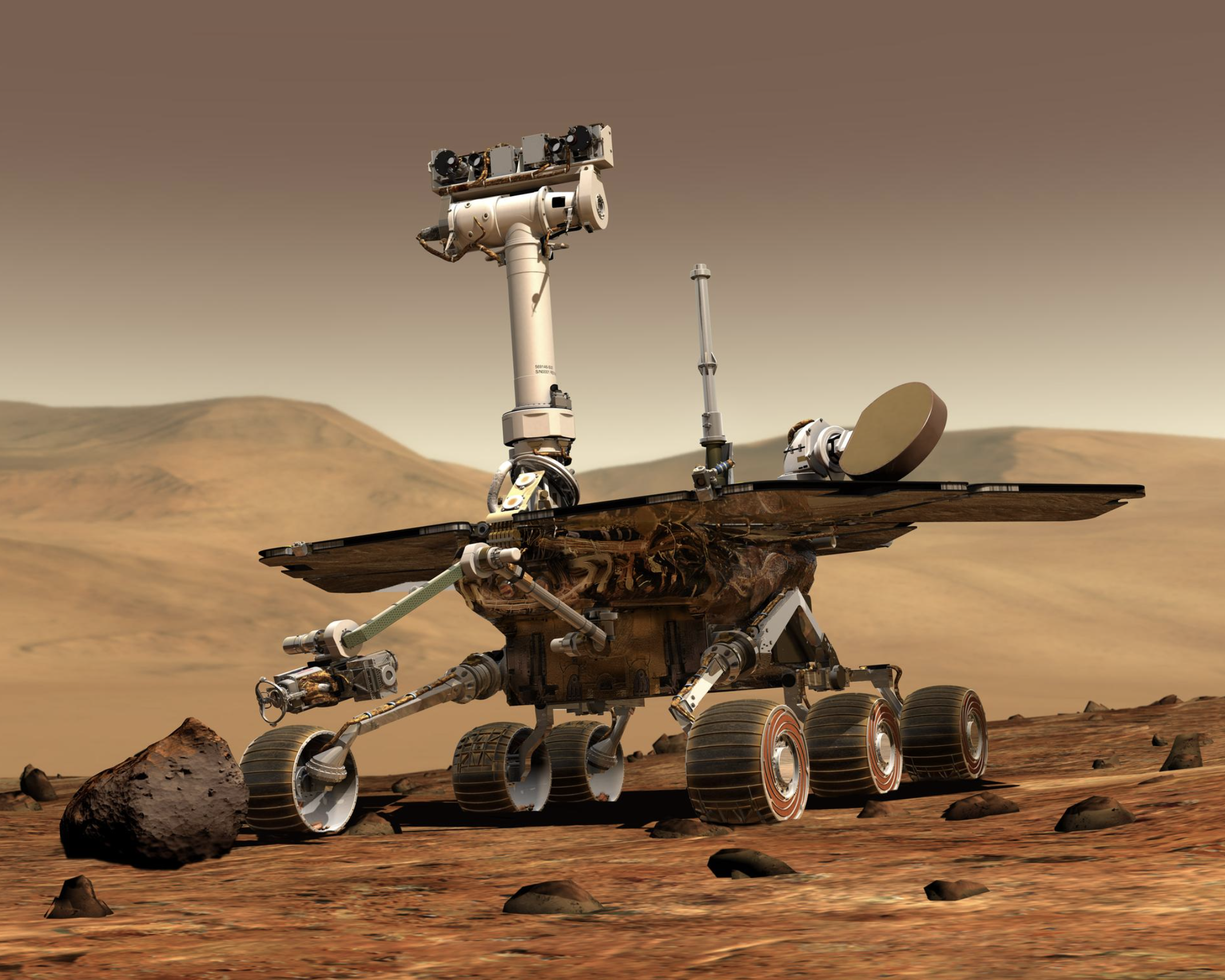

En Marte, las misiones de NASA han encontrado claras evidencias de que el Planeta Rojo habría tenido agua en su superficie durante largos periodos de tiempo en el pasado. El rover Curiosisty descubrió un antiguo lecho del río que existía en medio de condiciones favorables para la vida tal como la conocemos.

Más recientemente, los científicos de la NASA utilizando telescopios terrestres, fueron capaces de estimar la cantidad de agua de Marte que se ha perdido con el paso de los eones. Llegaron a la conclusión de que el planeta una vez tuvo agua líquida suficiente para formar un océano que ocupó casi la mitad del hemisferio norte de Marte, en algunas regiones alcanzando profundidades de más de 1,6 kilómetros. Pero, ¿Dónde está el agua?

Está claro para algunos de que está en los casquetes polares de Marte y por debajo de la superficie. También parece que gran parte de la atmósfera primitiva de Marte fue despojada por el viento de partículas cargadas que fluyen del Sol, haciendo que el planeta se seque. La misión MAVEN de la NASA está trabajando en órbita alrededor de Marte para esclarecerlo.

La historia de cómo Marte se secó está íntimamente ligada a la forma en que la atmósfera del Planeta Rojo interactúa con el viento solar. Los datos de las misiones solares de la agencia – incluyendo STEREO, Observatorio de Dinámica Solar, SDO, y la planificada Solar Probe Plus – son vitales para ayudar a entender mejor lo que sucedió.

Comprender la distribución del agua en nuestro sistema solar es de gran importancia para comprender cómo se formaron los planetas, las lunas, cometas y otros objetos hace unos 4.500 millones de años a partir del disco de gas y polvo que rodeaba nuestro Sol.

Feb

27

La Geotectónica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Geotectónica ~

Clasificado en La Geotectónica ~

Comments (0)

Comments (0)

La tectónica de placas explica que la superficie terrestre está dividida en fragmentos rígidos de litosfera (corteza y parte superior del manto) llamados placas tectónicas. Estas placas flotan y se desplazan sobre la astenosfera (una capa más plástica y caliente del manto) a velocidades de centímetros por año.

La tectónica de placas explica que la superficie terrestre está dividida en fragmentos rígidos de litosfera (corteza y parte superior del manto) llamados placas tectónicas. Estas placas flotan y se desplazan sobre la astenosfera (una capa más plástica y caliente del manto) a velocidades de centímetros por año.

Los grandes accidentes de la superficie terrestre (el fondo marino, los continentes y sus cordilleras) han sido generados por el imparable movimiento de los rígidos bloques de la litosfera. Las grandes placas oceánicas divergen en las crestas dorsales oceánicas, donde surge el magma creando nueva corteza basáltica, que se desliza a lo largo de fallas hasta que finalmente chocan con los bordes continentales donde se hunden en profundas fosas, zonas de subducción, para ser recicladas en el manto. Aunque el recorrido entre la dorsal y la fosa se completa en 107 años, algunas zonas continentales permanecen muy estables, estando cubiertas por rocas cuya edad es casi veinte veces la edad de las más antiguas cortezas marinas, que a su vez, datan de unos doscientos millones de años.

Dondequiera que choquen las relativamente rápidas placas tectónicas oceánicas con las enormes placas continentales, se forman cadenas montañosas en continua elevación. Los ejemplos más espectaculares se subducción y formación montañosa son, respectivamente, la placa del Pacífico sumergiéndose en las profundas fosas del Asia oriental, y el Himalaya, que se eleva por el choque de las placas índica y euroasiática.

En otras zonas de la litosfera, la afloración de rocas calientes del mando debilita inicialmente y agrietan posteriormente la corteza continental, hasta que finalmente, formando nueva corteza oceánica, separan los continentes. Ejemplos de diversos estadios de este proceso son el Mar Rojo, el golfo de Adén y las fracturas del Valle del Rift, en el este de África.

El movimiento de la placa africana es hacia el Norte a unos 2,15 centímetros cada año, lo cual la llevará a unirse al extremo sur de España dentro de 650.000 años, separando el mar Mediterráneo del océano Atlántico.

Este proceso de separación continental parece ser bastante regular. Se observan periodos de formación montañosa por compresión en el intervalo de cuatrocientos a quinientos millones de años, a los que sigue, unos cien millones de años más tarde, un resurgir de la rotura. Esta secuencia se repite en un ciclo super-continental en el que se alterna la separación de grandes zonas continentales con su agrupamiento.

Imagen de la isla de Hawái desde satélite

Las plumas de magma que perforan la litosfera también crean focos calientes duraderos que están asociados a los volcanes. Las islas Hawai y la cadena de montañas oceánicas que se extienden desde ellas hasta Kamchatka constituyen la manifestación más espectacular de focos calientes que surgen en medio de la veloz placa del Pacífico, entre los que actualmente se encuentran los ríos continuos de lava del volcán Kilauea y la lenta creación de la futura isla hawaiana de Loihi.

Las enormes plumas de magma que afloran desde las capas profundas del manto han dado origen a grandes superficies de lava, la mayor de las cuales es la meseta oceánica de Ontong Java, que cubre dos millones de kilómetros cuadrados, y la meseta del Decán y la siberiana, que son las mayores formaciones basálticas continentales. La generación de estas extensas formaciones afecta de manera importante a la composición de la atmósfera debido a las grandes emisiones de CO2 y SO2 que las acompañan, y que causan elevaciones de la temperatura troposférica y lluvias ácidas, con los consiguientes efectos cruciales en la biota.

Los procesos energéticos de la geotectónica terrestre son complejos. Incluso resulta todavía incierta la contribución relativa de las fuerzas involucradas en el movimiento de las placas tectónicas. Las dos fuerzas más importantes están asociadas a la convección del material caliente del manto y al hundimiento de las zonas frías, con flotabilidad negativa, de la litosfera oceánica en las zonas de subducción. Este último proceso es debido a diferencias de densidad, máxima a una profundidad de doscientos o trescientos kilómetros, que generan un momento de fuerzas en el manto viscoso responsable de la principal fuerza convectiva.

Las velocidades de las placas, al ser estudiadas, se observa que las que cuentan con una mayor proporción de sus bordes en zonas de subducción se mueven a velocidades de 60 a 90 kilómetros por millón de años, mientras que la velocidad de las placas en las que no hay hundimiento de bloques es inferior a 40 kilómetros por millón de años.

Sin embargo, la contribución de la emisión de material del manto no es despreciable, ya que la considerable energía potencial gravitatoria de extensas zonas de rocas calientes hace que se genere nueva corteza marina en las dorsales oceánicas con una velocidad que es, al menos, tres veces superior a la velocidad con que se genera en los planos abisales.

La combinación de ese “tirar” a lo largo de las zonas de subducción y de “empujar” en las dorsales da lugar a velocidades, para las placas más rápidas, de aproximadamente 20 cm/año durante cortos periodos de tiempo. Entre estas placas que se mueven rápidamente se encuentran no sólo los pequeños bloques como Nazca y Cocos, sino también la enorme placa del Pacífico, lo cual indica que la fuerza de arrastre del manto, proporcional al área y a la velocidad, debe ser relativamente pequeña.

La mayor parte del flujo de calor que se ha medido en la Tierra debe atribuirse a la formación de nueva litosfera oceánica.

Es mucho lo que nos queda por aprender de nuestra propia “casa”.

Emilio Silvera V.

Feb

27

Algunas consideraciones sobre la Luz

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (2)

Comments (2)

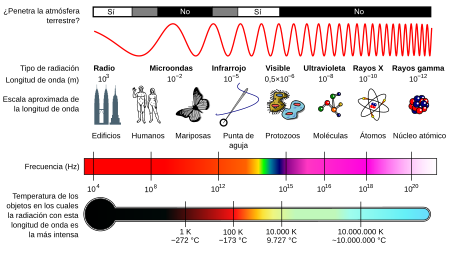

Está claro que, los estudiosos de la época antigua estaban por completo a oscuras acerca de la naturaleza de la luz. Especulaban sobre que consistía en partículas emitidas por objetos relucientes o tal vez por el mismo ojo. Establecieron el hecho de que la luz viajaba en línea recta, que se reflejaba en un espejo con un ángulo igual a aquel con el que el rayo choca con el espejo, y que un rayo de luz se inclina (se refracta) cuando pasa del aire al cristal, al agua o a cualquier otra sustancia transparente.

Cuando la luz entra en un cristal, o en alguna sustancia transparente, de una forma oblicua (es decir, en un ángulo respecto de la vertical), siempre se refracta en una dirección que forma un ángulo menor respecto de la vertical. La exacta relación entre el ángulo original y el ángulo reflejado fue elaborada por primera vez en 1621 por el físico neerlandés Willerbrord Snell. No publicó sus hallazgos y el filósofo francés René Descartes descubrió la ley, independientemente, en 1637.

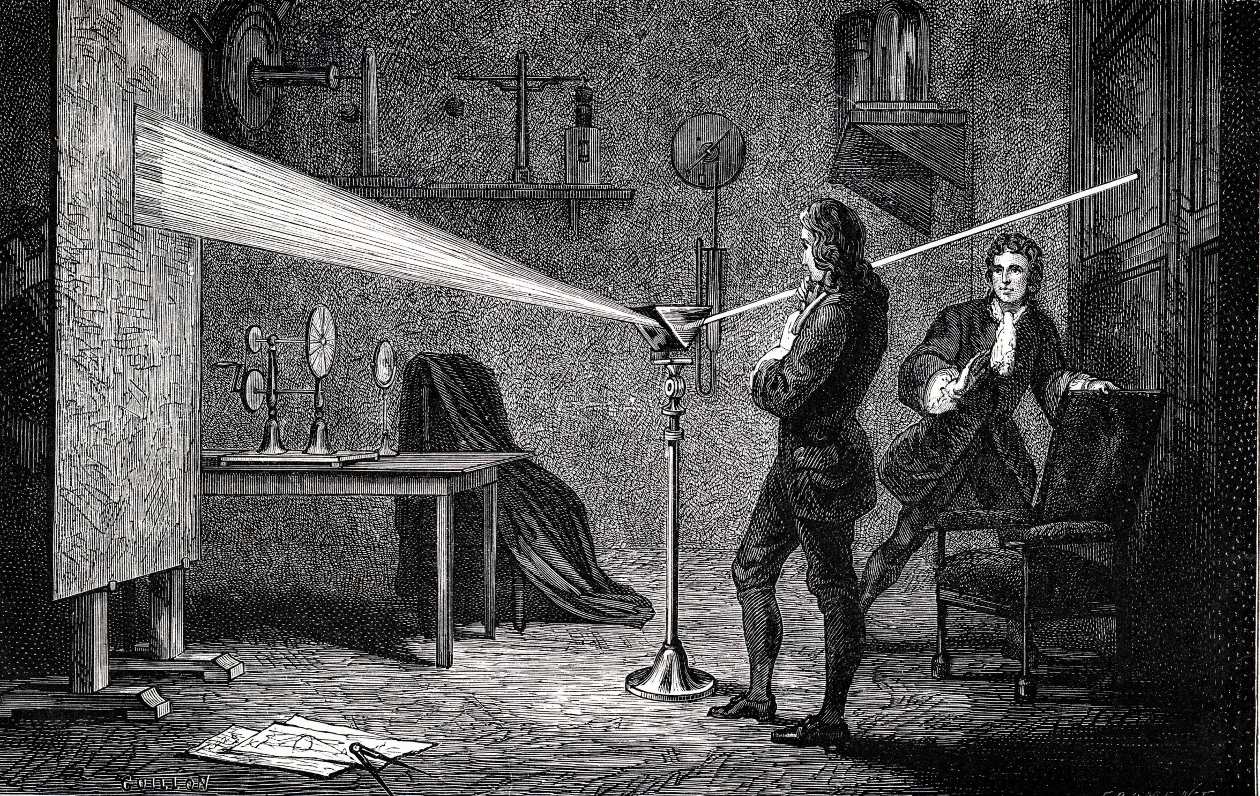

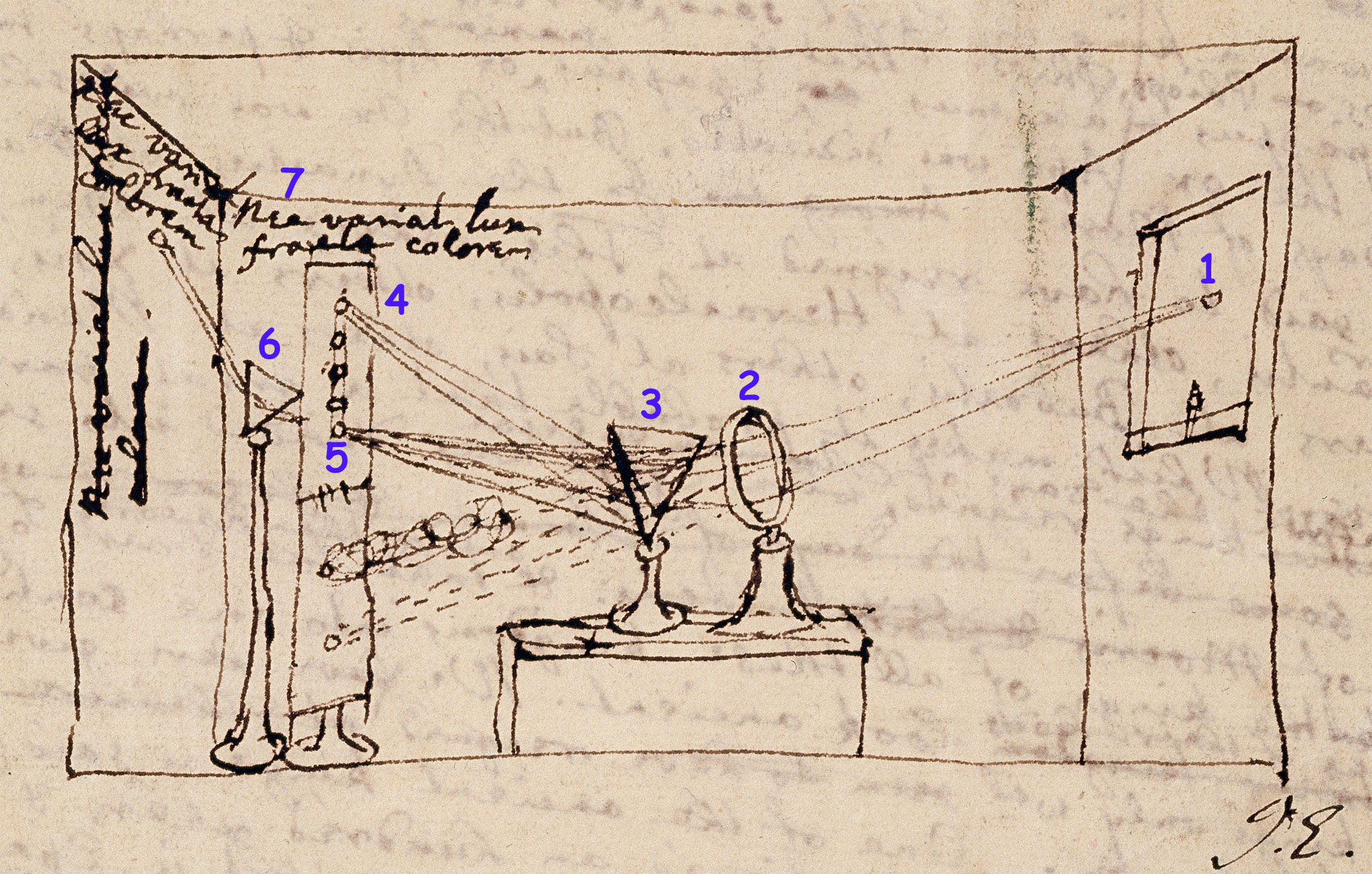

Los primeros experimentos importantes acerca de la naturaleza de la luz fueron llevados a cabo por Isaac Newton en 1666, al permitir que un rayo de luz entrase en una habitación oscura a través de una grieta e las persianas, cayendo oblicuamente sobre una cara de un prisma de cristal triangular. El rayo se refracta cuando entra en el cristal y se refracta aún más en la misma dirección cuando sale por una segunda cara del prisma. (Las dos refracciones en la misma dirección se originan por que los dos lados del prisma de se encuentran en ángulo en vez de en forma paralela, como sería el caso en una lámina ordinaria de cristal.)

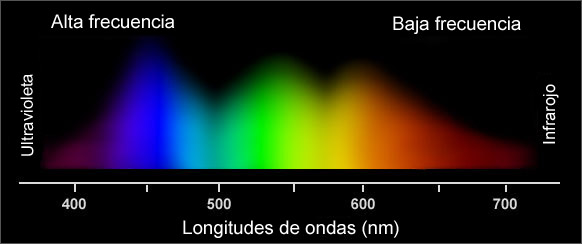

Newton atrapó el rayo emergente sobre una pantalla blanca para ver el efecto de la refracción reforzada. Descubrió que, en vez de formar una mancha de luz blanca, el rayo se extendía en una gama de colores: rojo, anaranjado, amarillo, verde, azul, y violeta, en este orden.

Newton dedujo de ello que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos para producir las diversas sensaciones de colores. La amplia banda de sus componentes se denominó spectrum (palabra latina que significa “espectro” “fantasma!.

Newton llegó a la conclusión de que la luz se componía de diminutas partículas (“corpúsculos”), que viajaban a enormes velocidades.

Le surgieron y se planteó algunas inquietudes cuestiones. ¿Por qué se refractaban las partículas de luz verde más que los de luz amarilla? ¿Cómo se explicaba que dos rayos de luz se cruzaran sin perturbase mutuamente, es decir, sin que se produjeran colisiones entre partículas?

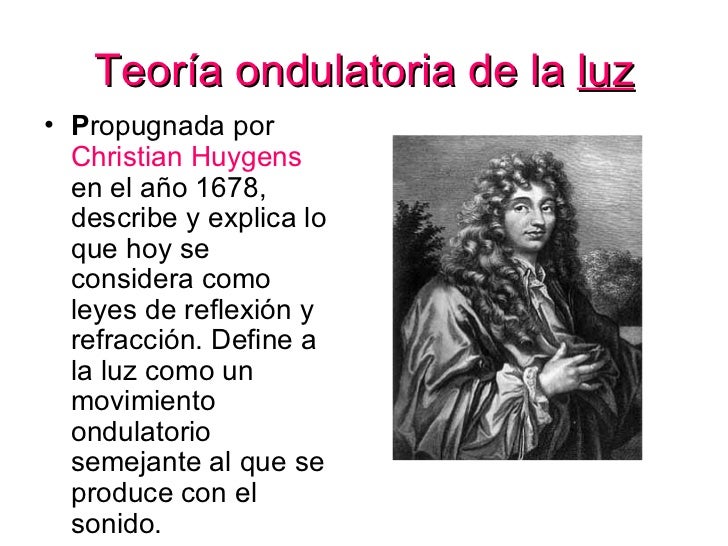

En 1678, el físico neerlandés Christian Huyghens (un científico polifacético que había construido el primer reloj de péndulo y realizado importantes trabajos astronómicos) propuso una teoría opuesta: la de que la luz se componía de minúsculas ondas. Y si sus componentes fueran ondas, no sería difícil explicar los diversos difracciones de los diferentes tipos de luz a través de un medio refractante, siempre y cuando se aceptara que la luz se movía más despacio en ese medio refractante que en el aire. La cantidad de refracción variaría con la longitud de las ondas: cuanto más corta fuese tal longitud, tanto mayor sería la refracción. Ello significaba que la luz violeta (la más sensible a este fenómeno) debía de tener una longitud de onda mas corta que la luz azul, ésta, más corta que la verde, y así sucesivamente.

Lo que permitía al ojo distinguir los colores eran esas diferencias entre longitudes de onda. Y, como es natural, si la luz estaba integrada por ondas, dos rayos podrían cruzarse sin dificultad alguna. (Las ondas sonoras y las del agua se cruzan continuamente sin perder sus respectivas identidades.)

Peor la teoría de Huyqhens sobre las ondas tampoco fue muy satisfactoria. No explicaba por qué se movían en línea recta los rayos luminosos; ni por qué proyectaban sobras recortadas; ni aclaraba por qué las ondas luminosas no podían rodear los obstáculos, del mismo modo que pueden hacerlo las ondas sonoras y de agua. Por añadidura, se objetaba que si la luz consistía en ondas, ¿cómo podía viajar por el vacío, ya que cruzaba el espacio desde el Sol y las Estrellas? ¿cuál era esa mecánica ondulatoria?

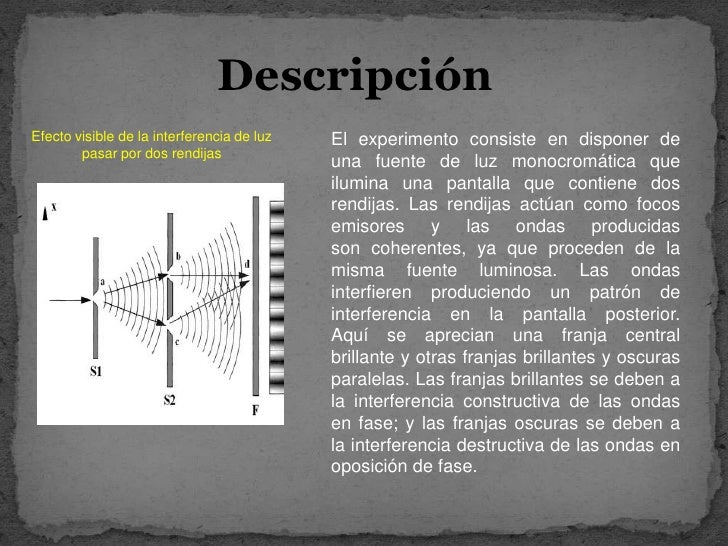

Aproximadamente durante un siglo, contendieron entre sí estas teorías. La teoría corpuscular, de Newton, fue, con mucho, la más popular, en parte, porque la respaldó el famoso nombre de su autor. Pero hacia 1801, un físico y médico ingles, de nombre Thomas Young, llevó a cabo un experimento que arrastró la opinión pública al campo opuesto. Proyectó un fino rayo luminoso sobre una pantalla, haciéndolo pasar antes por dos orificios casi juntos. Si la luz estuviera compuesta por partículas, cuando los dos rayos emergieran de ambos orificios, formarían presuntamente en la pantalla una región más luminosa donde se superpusieran, y regiones menos brillantes, donde no se diera tal superposición. Pero no fue esto lo que descubrió Young. La pantalla mostró una serie de bandas luminosas, separadas entre sí por bandas oscuras. Pareció incluso que, en esos intervalos de sombra, la luz de ambos rayos contribuía a intensificar la oscuridad.

Sería fácil explicarlo mediante la teoría ondulatoria. La banda luminosa representaba el refuerzo presado por las ondas de un rayo a las ondas del otro. Dicho de otra manera: Entraba “en fase” dos trenes de ondas, es decir, ambos nodos, al unirse, se fortalecían el uno al otro. Por otra parte, las bandas oscuras representaban puntos en que las ondas estaban “desfasadas” porque el vientre de una neutralizaba el nodo de la otra. En vez de aunar sus fuerzas, las ondas se interferían mutuamente, reduciendo la energía luminosa neta a las proximidades del punto cero.

Considerando la anchura de las bandas y la distancia entre los dos edificios por los que surgen ambos rayos, se pudo calcular la longitud de las ondas luminosas, por ejemplo, de la luz roja a la violeta o los colores intermedios. Las longitudes de onda resultaron ser muy pequeñas. Así, la de la luz roja era de unos 0’000075 cm. (Hoy se expresan las longitudes de las ondas luminosas mediante una unidad muy práctica ideada por Angströn. Esta unidad, denominada, en honor a su autor Ángstrom (Á), es la cienmillonésima parte de un centímetro. Así, pues, la longitud de onda de la luz roja equivale más o menos a 7.500 Á, y la de la luz violeta, a 3.900 Å, mientras que las de colores visibles en el espectro oscilan entre ambas cifras.)

La cortedad de estas ondas es muy importante. La razón de que las ondas luminosas se desplacen en línea recta y proyecten sombras recortadas se debe a que todas son incomparablemente más pequeñas que cualquier objeto; pueden contornear un obstáculo sólo si éste no es mucho mayor que la longitud de onda. Hasta las bacterias, por ejemplo, tienen un volumen muy superior de una onda luminosa y, por tanto, la luz puede definir claramente sus contornos bajo el microscopio. Sólo los objetos cuyas dimensiones se asemejan a la longitud de la onda luminosa (por ejemplo, los virus y otras partículas submicroscópicas) son lo suficientemente pequeños como para que puedan ser contorneados por las ondas luminosas.

Thomas Young Augustin Fresnel

Un físico francés, Augustin-Jean Fresnel, fue quien demostró por vez primera, en 1818, que si un objeto es lo suficientemente pequeño, la onda luminosa lo contorneará sin dificultad. En tal caso, la luz determina el llamado fenómeno de “difracción”. Por ejemplo, las finísimas líneas paralelas de una “reja de disfracción” actúan como una serie de minúsculos obtáculos, que se refuerzan entre si. Puesto que la magnitud de la difracción va asociada a la longitud de onda, se produce el espectro. A la inversa, se puede calcular la longitud de onda midiendo la difracción de cualquier color o porción del espectro, así como la separación de las marcas sobre el cristal.

Espectro solar con las líneas de Fraunhofer como aparecen visualmente.

Fraunhofer exploró dicha reja de difracción con objeto de averiguar sus finalidades prácticas, progreso que suele olvidarse, pues queda eclipsado por su descubrimiento más famoso: los rayos espectrales. El físico americano Henry Augustus Rowlane ideó la reja cóncava y desarrolló técnicas para regularlas de acuerdo con 20.000 líneas por pulgada. Ello hizo posible la sustitución del prisma por el espectroscopio.

Ante tales hallazgos experimentales, más el desarrollo metódico y matemático del movimiento ondulatorio, debido a Fresnel, pareció que la teoría ondulatoria de la luz había arraigado definitivamente, desplazando y relegando para siempre a la teoría corpuscular.

No sólo se aceptó las existencias de ondas luminosas, sino que también se midió su longitud con una precisión cada vez mayor. Hacia 1.827, el físico francés Jacques Babinet sugirió que se empleara la longitud de onda luminosa (una cantidad física inalterable) como unidad para medir tales longitudes, en vez de las muy diversas unidades ideadas y empleadas por el hombre. Sin embargo, tal sugerencia no se llevó a la práctica hasta 1.880 cuando el físico germano-americano Albert Abraham Michelson inventó un instrumento, denominado “interferómetro”, que podía medir las longitudes de ondas luminosas con una exactitud sin precedentes. En 1893, Michelson midió la onda de la raya roja en el espectro del cadmio y determinó que su longitud era de 1/1.553.164 m.

Pero la incertidumbre reapareció al descubrirse que los elementos estaban compuestos por isótopos diferentes, cada uno de los cuáles aportaba una raya cuya longitud de onda difería ligeramente de las restantes. En la década de 1.930 se midieron las rayas del criptón 86. Como quiera que este isótopo fuera gaseoso, se podía abordar con bajas temperaturas, para frenar el movimiento atómico y reducir el consecutivo engrosamiento de la raya.

En 1960, el Comité Internacional de Pesos y Medidas adoptó la raya del criptón 86 como unidad fundamental de longitud. Entonces se restableció la longitud de metro como 1.650.763’73 veces la longitud de onda de dicha raya espectral. Ello aumento mil veces la precisión de las medidas de longitud. Hasta entonces se había medido el antiguo metro patrón con un margen de error equivalente a una millonésima, mientras que en lo sucesivo se pudo medir la longitud de onda con un margen de error equivalente a una milmillonésima.

Ahora, después de todo esto, sabemos algo más sobre la luz.

Pero ¿Qué pasa con su velocidad?

¡Veámoslo!

LA VELOCIDAD DE LA LUZ

Está claro que, la luz se desplaza a enormes velocidades. Si pulsamos el interruptor de apagado de la lámpara de nuestro salón, todo queda a oscuras de manera instantánea.

La velocidad del sonido es más lenta, por ejemplo, si vemos a un leñador que está cortando leña en un lugar alejado de nosotros, sólo oiremos los golpes momentos después de que caiga el hacha. Así, pues, el sonido tarda cierto tiempo en llegar a nuestros oídos. En realidad es fácil medir la velocidad de su desplazamiento: unos 1.206 km/h en el aire y a nivel del mar.

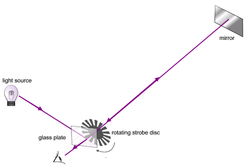

Poca seguridad podía dar aquel rústico medio

Galileo fue el primero en intentar medir la velocidad de la luz. Se colocó en lo alto de una colina, mientras que su ayudante, se situaba en otro lugar alto de la colina vecina; luego sacó una linterna encendida: tan pronto como su ayudante vió la luz, hizo una señal con otra linterna. Galileo repitió el experimento a distancias cada vez mayores, suponiendo que el tiempo requerido por su ayudante para responder mantendría una uniformidad constante, por lo cual, el intervalo entre la señal de su propia linterna y la de su ayudante representaría el tiempo empleado por la luz para recorrer cada distancia. Aunque la idea era lógica, la luz viajaba demasiado aprisa como para que Galileo pudiera percibir las sutiles diferencias con un método tan rudimentario.

Esta es la distancia que recorre la luz desde el Sol hasta la Tierra… ¡150.000.000 Km.!

En 1676, el astrónomo danés Olau Roemer logró cronometrar la velocidad de la luz a escala de distancias astronómicas. Estudiando los eclipses de Júpiter en sus cuatro grandes satélites, Roemer observó que el intervalo entre eclipses consecutivos era más largo cuando la Tierra se alejaba de Júpiter, y más corto cuado se movía en su órbita hacía dicho astro. Al parecer, la diferencia entre las duraciones del eclipse reflejaba la diferencia de distancias entre la Tierra y Júpiter. Y trataba, pues, de medir la distancia partiendo del tiempo empleado por la luz para trasladarse desde Júpiter hasta la Tierra. Calculando aproximadamente el tamaño de la órbita terrestre y observando la máxima discrepancia en las duraciones del eclipse que, según Roemer, representaba el tiempo que necesitaba la luz para atravesar el eje de al órbita terrestre, dicho astrónomo computó la velocidad de la luz. Su resultado, de 225.000 km/s., parece excelente si se considera que fue el primer intento, y resultó bastante asombroso como para provocar la incredulidad de sus coetáneos.

Sin embargo, medio siglo después se confirmaron los cálculos de Roemer en un campo totalmente distinto. Allá por 1728, el astrónomo británico James Bradley descubrió que las estrellas parecían cambiar de posición con los movimientos terrestres; y no por el paralaje, sino porque la traslación terrestre alrededor del Sol era una fracción mensurable (aunque pequeña) de la velocidad de la luz. La analogía empleada usualmente es la de un hombre que camina con el paraguas abierto bajo un temporal. Aun cuando las gotas caigan verticalmente, el hombre debe inclinar hacia delante el paraguas, porque ha de abrirse paso entre las gotas.

Cuanto más acelere su paso, tanto más deberá inclinar el paraguas. De manera semejante la Tierra avanza entre los ligeros rayos que caen desde las estrellas, y el astrónomo debe inclinar un poco su telescopio y hacerlo en varias direcciones, de acuerdo con los cambios de la trayectoria terrestre (no olvidemos que nuestro planeta Tierra, es como una enorme nave espacial que nos lleva en un viaje eterno, alrededor del Sol, a la velocidad de 30 km/s. + -) Mediante ese desvío aparente de los astros (“aberración de la luz”), Bradley pudo evaluar la velocidad de la luz y calcularla con gran precisión.

Sus cálculos fueron de 285.000 km/s, bastante más exacto que los de Roemer, pero aún un 5’5% más bajos.

Poco a poco, con medios tecnológicos más sofisticados y más conocimientos matemáticos, los científicos fueron obteniendo medidas más exactas aún, conforme se fue perfeccionando la idea original de Galileo y sus sucesores.

En 1849, el físico francés Armand-Hippolyte-Louis Eizeau ideó un artificio mediante el cual se proyectaba la luz sobre un espejo situado a 8 km de distancia, que devolvía el reflejo al observador. El tiempo empleado por la luz en su viaje de ida y vuelta no rebasó apenas la 1/20.000 de segundo, por Fizeau logró medirlo colocando una rueda dentada giratoria en la trayectoria del rayo luminoso. Cuando dicha rueda giraba a cierta velocidad, regulada, la luz pasaba entre los dientes y se proyectaba contra el siguiente, al ser devuelta por el espejo; así, Fizeau, colocado tras la rueda, no pudo verla. Entonces se dio más velocidad a la rueda, y el reflejo pasó por la siguiente muesca entre los dientes, sin intercepción alguna. De esa forma, regulando y midiendo la velocidad de la rueda giratoria, Fizeau pudo calcular el tiempo transcurrido y, por consiguiente, la velocidad a que se movía el rayo de luz.

Animación del Péndulo de Foucault oscilando en el hemisferio sur

Un año más tarde, Jean Foucault (quien realizaría poco después su experimento con los péndulos) precisó más estas medidas empleando un espejo giratorio en ve de una rueda dentada. Entonces se midió el tiempo transcurrido desviando ligeramente el ángulo de reflexión mediante el veloz espejo giratorio. Foucault obtuvo un valor de la velocidad de la luz de 300.883 km/s. También, el físico francés utilizó su método para determinar la velocidad de la luz a través de varios líquidos. Averiguó que era notablemente inferior a la alcanzada en el aire. Esto concordaba también con la teoría ondulatoria de Huyghens.

Interferómetro de Michelson:

A – Fuente de luz monocromática

B – Espejo semi-reflectante

C – Espejos

D – Diferencia de camino.

Michelson fue más preciso aún en sus medidas. Este autor, durante cuarenta años largos, a partir de 1879, fue aplicando el sistema Fizeau-Foucault cada vez con mayor refinamiento, para medir la velocidad de la luz. Cuando se creyó lo suficientemente informado, proyectó la luz a través de vacío, en vez de hacerlo a través del aire, pues este frena ligeramente su velocidad, y, empleó para ello tuberías de acero cuya longitud era superior a 1’5 km. Según sus medidas, la velocidad de la luz en el vacío era de 299.730 km(seg. (sólo un 0’006% más bajo). Demostraría también que todas las longitudes de ondas luminosas viajan a la misma velocidad en el vacío.

Desde Galileo con sus lámparas, cada vez se han utilizado aparatos más sofisticados para medir la velocidad de la luz, y, finalmente, se consiguió medirla …

En 1972, un equipo de investigadores bajo la dirección de Kenneth M. Eveson efectuó unas mediciones aún más exactas y vio que la velocidad de la luz era de 299.727’74 km/seg. Una vez se conoció la velocidad de la luz con semejante precisión, se hizo posible usar la luz, o por lo menos formas de ella, para medir distancias.

Aunque para algunos resulte alto tedioso el tema anterior, no he podido resistirme a la tentación de exponerlo, así podrá saber algo más sobre la luz y, habrán conocido a personajes que hicieron posible el que ahora nosotros, la conozcamos mejor.

La luz es tan importante para todos como el aire y el agua

Podría continuar, hasta el final de este trabajo, hablando de la luz y sus distintas formas o aplicaciones: ondas de luz a través del espacio, de cómo se transmite la luz en el “vacío”, nos llega a través del espacio desde Galaxias situadas a miles de millones de años luz; las líneas de fuerzas electromagnéticas de Faraday y Maxwell de campos eléctricos y magnéticos cambiantes (todo ello explicado en un simple conjunto de cuatro ecuaciones, que describían casi todos los fenómenos referentes a esta materia electromagnética), o de los enigmas aún por descubrir (aunque predichos).

Este comentario ya se hizo algo largo y, desde luego, mi último deseo es aburrir al lector, así que dejaremos para otro día una continuación sobre lo que es la luz, aunque, eso sí, no me quiero despedir sin dejar claro que, también todos nosotros somos… ¡LUZ!

Emilio Silvera V.

Feb

26

¿Qué es el Amor?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

El irrefrenable deseo de fusión con el Ser amado

El inexplicable sentimiento que tiene más fuerza que un huracán. Cuando llega no sabe de clases, ni de fronteras. Recuerdo aquella metáfora que plasmaba en uno de mis escritos que, para significar que cuando llega el Amor verdadero, nada impide que se produzca el acercamiento, y, contaba que una mitocondria se había enamorado de una célula eucariota.

¿Empezaría allí todo?

Si unos seres inteligentes de otro mundo nos estuviera observando… ¿Qué diría de nuestro comportamiento? En el Amor y en otros ámbitos de la Vida que, a veces, pueden resultar totalmente irracionales.

¡Cómo somos! La Humanidad… ¿Quién la entiende? Somos más de 7.000 millones y las diferencias de pensamiento a la vista están.

Me gustaría saber en qué desembocará todo esto… ¿Nos destruiremos a nosotros mismos?

Yo creo que, el Amor, es lo que nos hace mejores, y pienso que, ¡sufrir por algo que vale la pena es una alegría!

¿Qué no harías por el Ser amado, por un hijo, por la familia?

Emilio Silvera V.

Totales: 85.797.138

Totales: 85.797.138 Conectados: 17

Conectados: 17