Oct

22

El universo de lo muy pequeño

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

“Adentrarse en el universo de las partículas que componen los elementos de la tabla periódica, y en definitiva, la materia conocida, es verdaderamente fantástico”.

Tan pronto como los Joliot-Curie crearon el primer isótopo radiactivo artificial, los físicos se lanzaron en tropel a producir tribus enteras de ellas. En realidad, las variedades radiactivas de cada elemento en la tabla periódica son producto de laboratorio. En la moderna tabla periódica, cada elemento es una familia con miembros estables e inestables, algunos procedentes de la naturaleza, otros sólo del laboratorio. Por ejemplo, el hidrógeno presenta tres variedades: en primer lugar, el corriente, que tienen un solo protón. En 1932, el químico Harold Urey logró aislar el segundo. Lo consiguió sometiendo a lenta evaporación una gran cantidad de agua, de acuerdo con la teoría de que los residuos representarían una concentración de la forma más pesada del hidrógeno que se conocía, y, en efecto, cuando se examinaron al espectroscopio las últimas gotas de agua no evaporadas, se descubrió en el espectro una leve línea cuya posición matemática revelaba la presencia de hidrógeno pesado.

El núcleo de hidrógeno pesado está constituido por un protón y un neutrón. Como tiene un número másico de 2, el isótopo es hidrógeno. Urey llamó a este átomo deuterio (de la voz griega deutoros, “segundo”), y el núcleo deuterón. Una molécula de agua que contenga deuterio se denomina agua pesada, que tiene puntos de ebullición y congelación superiores al agua ordinaria, ya que la masa del deuterio es dos veces mayor que la del hidrógeno corriente. Mientras que ésta hierve a 100º C y se congela a 0º C, el agua pesada hierve a 101’42º C y se congela a 3’79º C. El punto de ebullición del deuterio es de -23’7º K, frente a los 20’4º K del hidrógeno corriente. El deuterio se presenta en la naturaleza en la proporción de una parte por cada 6.000 partes de hidrógeno corriente. En 1934 se otorgó a Urey el premio Nobel de Química por su descubrimiento del deuterio. El deuterio resultó ser una partícula muy valiosa para bombardear los núcleos. En 1934, el físico australiano Marcus Lawrence Edwin Oliphant y el austriaco P. Harteck atacaron el deuterio con deuterones y produjeron una tercera forma de hidrógeno, constituido por un protón y dos neutrones. La reacción se planteó así:

El deuterio resultó ser una partícula muy valiosa para bombardear los núcleos. En 1934, el físico australiano Marcus Lawrence Edwin Oliphant y el austriaco P. Harteck atacaron el deuterio con deuterones y produjeron una tercera forma de hidrógeno, constituido por un protón y dos neutrones. La reacción se planteó así:

hidrógeno 2 + hidrógeno 2 = hidrógeno 3 + hidrógeno 1

Este nuevo hidrógeno superpesado se denominó tritio (del griego tritos, “tercero”); su ebullición a 25º K y su fusión a 20’5º K.

Oct

21

El placer de Descubrir: Aventurarse por nuevos caminos.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

La molécula de agua es polar en virtud principalmente de su geometría angular

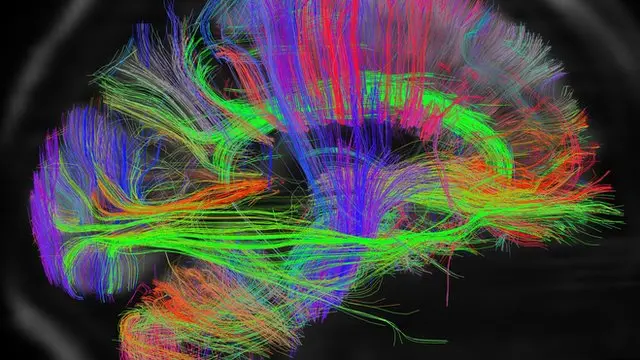

Los organismos vivos somos sistemas extremadamente complejos, formados por un elevado número de elementos interrelacionados que deben mantener sus características a lo largo del tiempo, de una generación a otra. Esto supone que debe existir algún mecanismo para que cada elemento de los organismos se elabore de acuerdo a un “plan”, a un modelo de organización establecido, y que ese modelo pueda ser transmitido de una célula a sus descendientes. Esta necesidad de los seres vivos nos acerca a la noción de información genética.

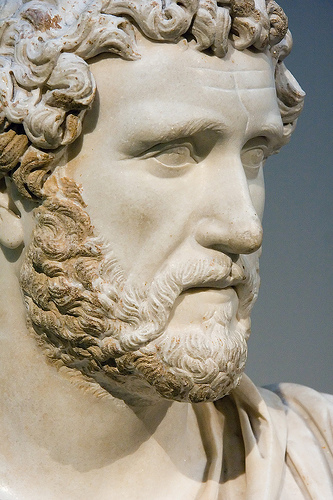

“Quien ha visto las cosas presentes ha visto todo, todo lo ocurrido desde la eternidad y todo lo que ocurrirá en el tiempo sin fin; pues todas las cosas son de la misma clase y la misma ”.

Marco Aurelio

Claro que él, quería significar que todo, desde el comienzo del mundo, ha sido igual, sigue unos patrones que se repiten una y otra vez a lo largo del transcurso de los tiempos: el día y la noche, las estaciones, el frío y el calor, el río muerto por la sequía o aquel que, cantarino y rumoroso ve correr sus aguas cristalinas hasta que desembocan en el océano. La Bondad y la maldad… Y, también, el Hombre y la Mujer. Así ha sido desde que podemos recordar y, así continuará siendo.

Para fugarnos de la tierra

un libro es el mejor bajel;

y se viaja mejor en el poema

que en más brioso corcel.

Whitman

El mañana siempre será incierto, lo único que sabemos es que el Presente es la semilla del Futuro

“Todo presente de una sustancia simple es naturalmente una consecuencia de su estado anterior, de modo que su presente está cargado de su futuro.”

Leibniz

¿Cuál es el camino? No hay ningún camino – Soñé que subía la escalera al infinito

Está claro el mensaje que tal pregunta y tal respuesta nos quiere hacer llegar, el camino, tendremos que hacerlo nosotros mediante la exploración hacia el futuro en el que está lo que deseamos encontrar. Hay que explorar y arriesgarse para tenemos que ir más allá de las regiones habituales y conocidas que nos tienen estancados siempre en el mismo lugar. ¡Arriesguémonos!

Homero nos contó como Ulises de Ítaca se arriesgó a oír el canto de las sirenas amarrado al palo de la vela mayor de su embarcación. Él no que´ria ser atraído por aquellas fuerzas malignas pero quería sentir los efectos de aquella llamada en lugar seguro. Eso nos lleva a pensar que hay un mensaje en el pasaje de Homero: Arriesgarse… ¡Sí! Pero con las precauciones necesarias. Así que, cuidado con los Robots, con los experimentos científicos de todo tipo, y, sobre todo, no debemos creer que lo sabemos todo. Tenemos que ser conscientes de que, el peligro nos acecha por todas partes.

,type=downsize)

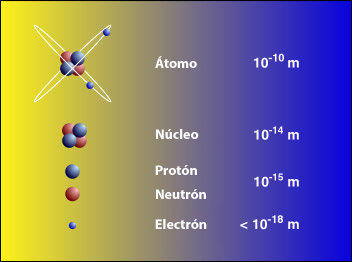

Pero, no cabe duda alguna de que, el acto de exploración modifica la perspectiva del explorador; Ulises, Marco Polo y Colón habían cambiado cuando volvieron a sus lugares de partida . Lo mismo ha sucedido en la investigación científica de los extremos en las escalas, desde la grandiosa extensión del espacio cosmológico hasta el mundo minúsculo y enloquecido de las partículas subatómicas.

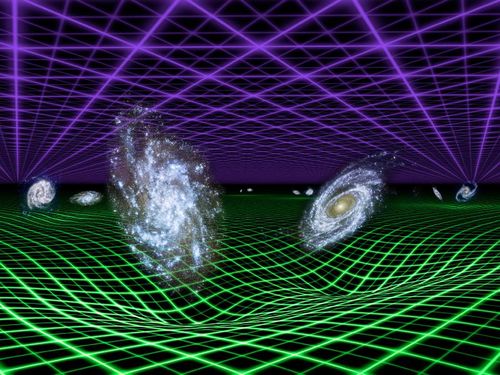

La galaxia conocida por el nombre de Bella Durmiente

Una bella galaxia espiral de cien mil años-luz de diámetro que podemos comparar con…¡Un átomo! El tema de las medidas es relativo y todo se supedita a su ámbito natural, cada cosa tiene la medida que requiere su funciòn en el Universo, desde un átomo hasta una galaxia.

En ambos “universos” existe una descomunal diferencia en los extremos de las escalas. Sin embargo, la inmensa galaxia de arriba no sería posible sin la existencia de infinitesimal átomo de abajo. ¡Todo lo grande está hecho de cosas pequeñas!

Así que, cuando hacemos esos viajes, irremediablemente nos cambian, y, desde luego, desafían muchas de las concepciones científicas y filosóficas que, hasta ese momento, más valorábamos. Algunas tienen que ser desechadas, como el bagaje que se deja atrás en una larga travesía por el desierto. Otras tienen que ser modificadas y reconstruidas hasta quedar casi irreconocibles, ya que, lo que hemos podido ver en esos viajes, lo que hemos descubierto, nos han cambiado por completo el concepto y la perspectiva que del mundo teníamos, conocemos y sabemos.

La exploración del ámbito de las galaxias extendió el alcance de la visión humana en un factor de 1026 veces mayor que la escala humana, y produjo la revolución que identificamos con la relatividad, la cual reveló que la concepción newtoniana del mundo sólo era un parroquianismo en un universo más vasto donde el espacio es curvo y el tiempo se hace flexible.

La exploración del dominio subatómico nos llevó lejos en el ámbito de lo muy pequeño, a 10-15 de la escala humana, y también significó una revolución. fue la Física cuántica que, transformó todo lo que abordó.

La teoría cuántica nació en 1900, Max Planck comprendió que sólo podía explicar lo que llamaba la curva del cuerpo negro -el espectro de energía que genera un objeto de radiación perfecta- si abandonaba el supuesto clásico de que la emisión de energía es continua, y lo reemplazó por la hipotesis sin precedentes de que la energía se emite en unidades discretas. Planck llamó cuantos a estas unidades.

1) Figura animada que representa un rayo de luz incidiendo sobre un cuerpo negro hasta su total absorción. 2) En la gráfica se representa la intensidad de la radiación emitida por el cuerpo negro en función de la longitud de onda a diferentes temperaturas. El máximo de la curva aumenta al ir hacia menores longitudes de onda (Ley de Wien). Se compara con el modelo clásico de Rayleigh-Jeans a altas temperaturas (5000 K) comprobándose la llamada catástrofe del ultravioleta

La constante de Planck es una constante física que desempeña un papel central en la teoría de la mecánica cuántica y recibe su nombre de su descubridor, Max Plancc, uno de los padres de dicha teoría. Denotada como  , es la constante que frecuentemente se define como el cuanto elemental de acción. Planck la denominaría precisamente «cuanto de acción»

, es la constante que frecuentemente se define como el cuanto elemental de acción. Planck la denominaría precisamente «cuanto de acción»

Fue inicialmente propuesta como la constante de proporcionalidad entre la energía  de un fotón y la frecuencia

de un fotón y la frecuencia  de su onda electromagnética asociada. Esta relación entre la energía y la frecuencia se denomina «relación de Planck»:

de su onda electromagnética asociada. Esta relación entre la energía y la frecuencia se denomina «relación de Planck»:

Dado que la frecuencia  , la longitud de onda

, la longitud de onda  lambda” />, y la velocidad de la luz

lambda” />, y la velocidad de la luz  cumplen

cumplen  lambda . f = c ” />, la relación de Planck se puede expresar como:

lambda . f = c ” />, la relación de Planck se puede expresar como:

Otra ecuación fundamental en la que interviene la constante de Planck es la que relaciona el momento lineal  de una partícula con la longitud de onda de De Broglie λ de la misma:

de una partícula con la longitud de onda de De Broglie λ de la misma:

En aplicaciones donde la frecuencia viene expresada en términos de radianes por segundo o frecuencia angular, es útil incluir el factor 1/2 dentro de la constante de Planck. La constante resultante, «constante de Planck reducida» o «constante de Dirac», se expresa como ħ (“h barra“):

De esta forma la energía de un fotón con frecuencia angular  omega” />, donde

omega” />, donde  omega = 2 \pi . f

omega = 2 \pi . f

Por otro lado, la constante de Planck reducida es el cuanto del momento angular en mecánica cuántica.

Planck definió a “sus” cuantos en términos del “cuanto de acción”, simbolizado por la letra h que ahora, se ha convertido en el símbolo de una constante, la constante de Planck, h. Planck no era ningún revolucionario – a la edad de cuarenta y dos años era un viejo, juzgado por patrones de la ciencia matemática y, además, un pilar de la elevada cultura alemana del siglo XIX-, pero se percató fácilmente de que el principio cuántico echaría abajo buena de la física clásica a la que había dedicado la mayor parte de su carrera. “Cuanto mayores sean las dificultades -escribió-…tanto más importante será finalmente para la ampliación y profundización de nuestros conocimientos en la física.”

Sus palabras fueron proféticas: cambiando y desarrollándose constantemente, modificando su coloración de manera tan impredecible como una reflexión en una burbuja de , la física cuántica pronto se expandió practicamente a todo el ámbito de la física, y el cuanto de acción de Planck, h llegó a ser considerado una constante de la Naturaleza tan fundamental como la velocidad de la luz, c, de Einstein.

Dos buenos amigos, dos genios

Max Planck es uno de los científicos a los que más veces se le han reconocido sus méritos y, su , está por todas partes: La Constante de Planc, las Unidades de Planck, El cuanto de Planck, la Radiación de Planck, El Tiempo de Planck, la masa de Planck, la Energía de Planck, la Longitud de Planck… ¡Todo merecido!

El Tiempo de Planck se considera como el intervalo temporal más pequeño que puede ser medido. El tiempo de Planck representa el tiempo que tarda un fotón viajando a la velocidad de la luz en atravesar una distancia igual a la longitud de Planck.

Confinados en nuestro pequeño mundo, una mota de polvo en la inmensidad de una Galaxia grandiosa que, a su vez, forma parte de un universo “infinito”, hemos podido darnos traza para poder saber, a pesar de las enormes distancias, sobre lo que existe en regiones remotas del Universo. Un Universo formado por Supercúmulos de galaxias que formadas en grupos conforman la materia visible, y, dentro de cada una de esas galaxias, como si de universos se tratara, se reproducen todos los objetos y fenómenos que en el Universo son.

https://youtu.be/uaGEjrADGPA

Sigamos con la escala del Universo conocido y hagamos un pequeño esquema que lo refleje: El Universo Observable, la mayor escala que abarca más de 100 mil trillones de kilómetros (según nos cuenta Timothy Ferris:

Radio en metros Objetos característicos

1026 Universo observable

1024 Supercúmulos de Galaxias

1023 Cúmulos de Galaxias

1022 Grupo de Galaxias (por ejemplo el Grupo Local)

1021 Galaxia La Vía Láctea

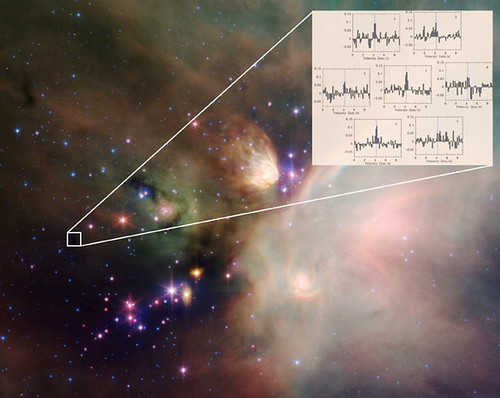

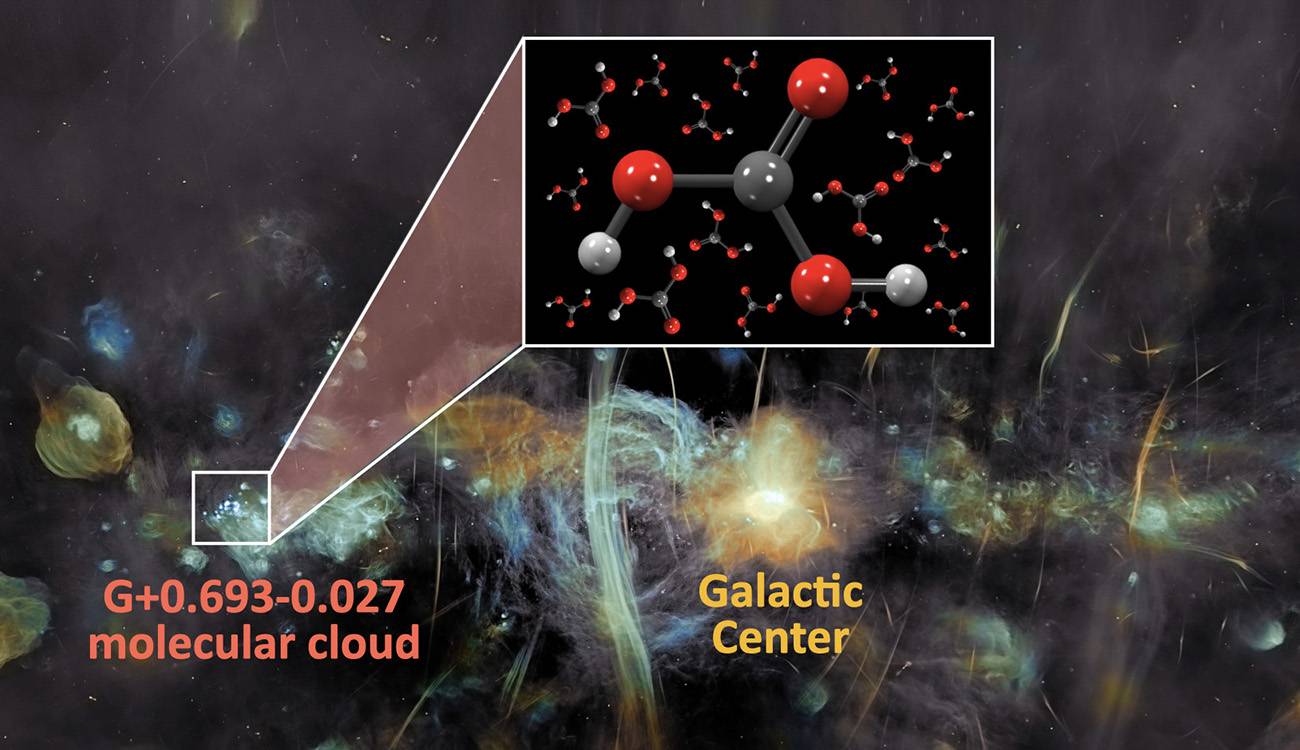

Nube Molecular gigante muy masiva, de gas y polvo compuesta fundamentalmente de moléculas con diámetro típico de 100 a.l. Tienen masa de diez millones de masas solares (moléculas de Hidrógeno (H2) el 73% en masa), átomos de Helio (He, 25%), partículas de polvo (1%), Hidrógeno atómico neutro (H I, del 1%) y, un rico coctel de moléculas interestelares. En nuestra galaxia existen al menos unas 3000 Nubes Moleculares Gigantes, estando las más masivas situadas cerca de la radiofuente Sagitario B en el centro Galáctico.

1018 Nebulosas Gigantes, Nubes Moleculares

1012 Sistema Solar

1011 Atmósfera externa de las Gigantes rojas

Aunque a una Unidad Astronómica de distancia (150 millones de Kilómetros de la Tierra), el Sol caliente el planeta y nos da la vida

109 El Sol

108 Planetas Gigantes Júpiter

107 Estrellas enanas, planetas similares a la Tierra

105 Asteroides, núcleos de cometas

104 Estrellas de Neutrones

Los seres humanos son parte del Universo que tratan de descubrir

1 Seres Humanos

10-2 Molécula de ADN (eje largo)

10-5 Células vivas

Células vivas

10-9 Molécula de ADN (eje corto)

10-10 Átomos

10-14 Núcleos de átomos pesados

10-15 Protones y Neutrones

10-35 Longitud de Planck: cuanto de espacio; radio de partículas sin dimensiones = la cuerda.

Es la escala de longitud a la que la descripción clásica de la Gravedad cesa de ser válida y debe ser tenida en la mecánica cuántica. Está dada por la ecuación de arriba, donde G es la constante gravitacional, ħ es la constante de Planck racionalizada y c es la velocidad de la luz. El valor de la longitud de Planck es del orden de 10-35 m (veinte órdenes de magnitud menorque el tamaño del protón 10-15 m).

Me llama la atención y me fascina la indeterminación que está inmersa en el mundo cuántico. La indeterminación cuántica no depende del aparato experimental empleado investigar el mundo subatómico. Se trata, en la medida de nuestro conocimiento, de una limitación absoluta, que los más destacados sabios de una civilización extraterrestre avanzada compartirían con los más humildes físicos de la Tierra.

Por muy avanzados que pudieran estar, ellos también estarían supeditados al Principio de Incertidumbre o Indeterminación cuántica, y, como nosotros, cuando trataran de encontrar (sea cual fuese las matemáticas o sistemas que emplearan para hallarlo) el resultado de la constante de estructura fina, la respuesta sería la misma: 137, puro y adimensional.

Todo esto nos ha llevado a la más firme convicción definir la visión del mundo de la física que nos revelaba que no sólo la materia y la energía sino que también el conocimiento están cuantizados. Cuando un fotón choca con un átomo, haciendo saltar un electrón a una órbita más elevada, el electrón se mueve de la órbita inferior a la superior instantáneamente, sin tener que atravesar el espacio intermedio. Los mismos radios orbitales están cuantizados, y el electrón simplemente deja de existir en un punto para aparecer simultáneamente en otro. Este es el famoso “salto cuántico” que tanto desconcierta, y no es un mero problema filosófico, es una realidad que, de , no hemos llegado a comprender.

No, esto no es un salto cuántico. Simplemente le tocó la Lotería

Pero, ¿quién sabe? Quizás un día lejano aún en el tiempo, cuando descubramos el secreto que salto cuántico nos esconde, poderemos aprovechar la misma técnica que emplea la Naturaleza con los electrones hacer posible que se transporten de un lugar a otro sin tener que recorrer las distancias que separan ambos destinos.

Estaría bien poder trasladarse las estrellas por ese medio

Bueno, pongamos los pies en el suelo, volvamos a la realidad. La revolución cuántica ha sido penosa, pero podemos agradecerle que, nos haya librado de muchas ilusiones que afectaban a la visión clásica del mundo. Una de ellas era que el hombre es un ser aparte, separado de la naturaleza a la que en realidad, no es que esté supeditado, sino que es, ella. ¡Somos Naturaleza!

Está claro, como nos decía Immanuel Kant que:

“La infinitud de la creación es suficientemente grande como para que un mundo, o una Vía Láctea de mundos, parezca, en comparación con ella, lo que una flor o un insecto en comparación con la Tierra.”

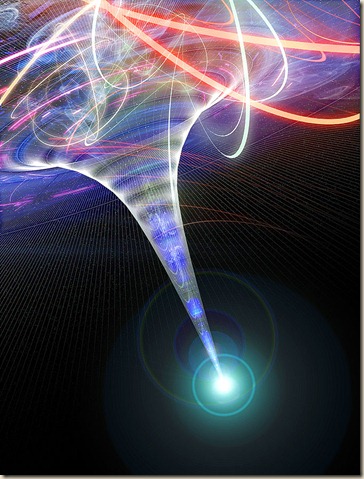

Algún día podríamos desaparecer en una especie de plasma como ese de la imagen y salir al “otro lado” que bien (¡Por qué no) podría ser otra galaxias lejana. Creo que la imaginación se nos ha dado para algo y, si todo lo que podemos imaginar se realizar, la conclusión lógica es que sólo necesitamos ¡Tiempo!

Sí, amigos míos, la Naturaleza vive en constante movimiento, y, nosotros, que formamos parte de ella…También vivimos en una constante evolución física y del conocimiento. Tenemos que llegar a conocerla.

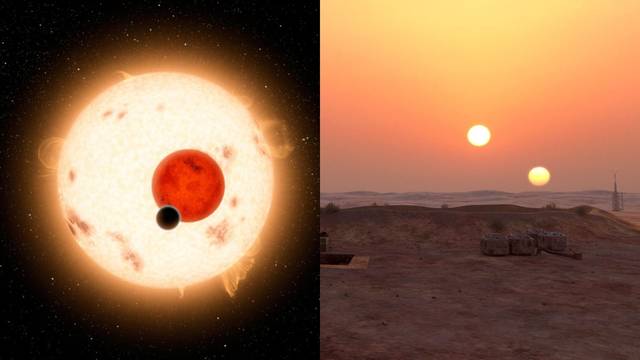

Existen muchos mundos con dos soles, ¿Cómo será vivir en uno de ellos?

En tiempos y lugares totalmente inciertos,

Los átomos dejaron su camino celeste,

Y mediante abrazos fortuitos,

Engendraron todo lo que existe.

Maxwell

Doy las gracias a Timothy Ferris de cuyo libro, La Aventura del Universo, he podido obtener bellos pasajes que aquí quedan incluidos.

Emilio Silvera Vázquez

Oct

20

Espacio-tiempo curvo y los secretos del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Agujeros negros ~

Clasificado en Agujeros negros ~

Comments (0)

Comments (0)

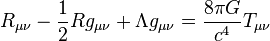

La densidad de energía-momentum en la teoría de la relatividad se representa por cuadritensor energía-impulso. La relación entre la presencia de materia y la curvatura debida a dicha materia viene dada por la ecuación de campo de Einstein. Esta sencilla ecuación es la demostración irrebatible de la grandeza de la mente humana que, con unos pocos signos nos puede decir tánto. De las ecuaciones de campo de Einstein, se pudieron deducir muchas cosas, tales como que el espacio se curva en presencia de grandes masas, como mundos, estrellas y galaxias para configurar la geometría del espacio.

Los vientos estelares emitidos por las estrellas jóvenes, distorsionan el material presente en las Nebulosas, y, de la misma manera, en presencia de masa se distorsiona el espacio-tiempo. En estos lugares que, como océanos de gas y polvo ionizado por la radiación de las estrellas masivas más jóvenes, existen moléculas complejas que, en algún caso, son esenciales para la existencia de la vida.

La teoría cuántica de campos en espacio-tiempo curvo es una extensión de la teoría cuántica de campos estándar en la que se contempla la posibilidad de que el espacio-tiempo por el cual se propaga el campo no sea necesariamente plano (descrito por la métrica de Minkouski). Una predicción genérica de esta teoría es que pueden generarse partículas debido a campos gravitacionales dependientes del tiempo, o a la presencia de horizontes.

La teoría cuántica de campos en espacio-tiempo curvo puede considerarse como una primera aproximación de gravedad cuántica. El paso siguiente consiste en una gravedad semi-clásica, en la que se tendrían en cuenta las correcciones cuánticas, debidas a la presencia de materia, sobre el espacio-tiempo.

En un espacio euclideo convencional un objeto físico finito está contenido dentro de un ortoedro mínimo, cuyas dimensiones se llaman ancho, largo y profundidad o altura. El espacio físico a nuestro alrededor es tridimensional a simple vista. Sin embargo, cuando se consideran fenómenos físicos la gravedad, la teoría de la relatividad nos lleva a que el universo es un ente tetra-dimensional que incluye tanto dimensiones espaciales como el tiempo como otra dimensión. Diferentes observadores percibirán diferentes “secciones espaciales” de este espacio-tiempo por lo que el espacio físico es algo más complejo que un espacio euclídeo tri-dimensional.

En las teorías actuales no existe una razón clara para que el de dimensiones espaciales sean tres. Aunque existen ciertas intuiciones sobre ello: Ehrenfest (aquel gran físico nunca reconocido) señaló que en cuatro o más dimensiones las órbitas planetarias cerradas, por ejemplo, no serían estables (y por ende, parece difícil que en un universo así existiera vida inteligente preguntándose por la tridimensionalidad espacial del universo).

Es cierto que en nuestro mundo tridimensional y mental existen cosas misteriosas. A veces me pregunto que importancia puede tener un . (“¿Qué hay en un nombre? Lo que llamamos rosa, / con cualquier otro nombre tendría el mismo dulce aroma”? (-Shakespeare, Romeo y Julieta-) – La rosa da sustento a muchos otros tópicos literarios: se marchita como símbolo de la fugacidad del tiempo y lo efímero de la vida humana; y provoca la prisa de la doncella recogerla mientras pueda. Por otro lado, le advierte de que hay que tener cuidado: no hay rosa sin espinas.

También el mundo de la poesía es un tanto misterioso y dicen, que… “Los poetas hablan consigo mismo y el mundo les oye por casualidad.” Tópicos ascéticos, metafísicos o existenciales: Quiénes somos, de dónde venimos, a dónde vamos, las llamadas preguntas trascendentales, propias de la cosmología, la antropología y la metafísica. Los poetas siempre han buscado un mundo irreal y han idealizado el enaltecido mucho más allá de este mundo.

Como siempre me pasa, me desvío del tema que en este trabajo nos ocupa: El espacio-tiempo.

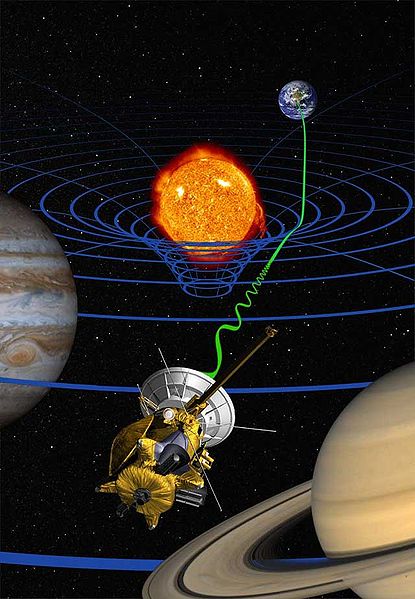

Estamos inmersos en el espacio-tiempo curvo y tetradimensional de nuestro Universo. Hay que entender que el espacio–tiempo es la descripción en cuatro dimensiones del universo en la que la posición de un objeto se especifica por tres coordenadas en el espacio y una en el tiempo. De acuerdo con la relatividad especial, no existe un tiempo absoluto que pueda ser medido con independencia del observador, de manera que eventos simultáneos para un observador ocurren en instantes diferentes vistos desde otro lugar. El tiempo puede ser medido, por tanto, de manera relativa, como lo son las posiciones en el espacio (Euclides) tridimensional, y esto puede conseguirse mediante el concepto de espacio–tiempo. La trayectoria de un objeto en el espacio–tiempo se denomina por el de línea de universo. La relatividad general nos explica lo que es un espacio–tiempo curvo con las posiciones y movimientos de las partículas de materia.

La introducción por parte de Minkouski de la idea espaciotemporal resultó tan importante es porque permitió a Einstein utilizar la idea de geometría espaciotemporal para formular su teoría de la relatividad general que describe la Gravedad que se genera en presencia de grandes masas y cómo ésta curva el espacio y distorsiona el tiempo. En presencia de grandes masas de materia, tales como planetas, estrellas y galaxias, está presente el fenómeno descrito por Einstein en su teoría de la relatividad general, la curvatura del espacio–tiempo, eso que conocemos como gravedad, una fuerza de atracción que actúa todos los cuerpos y cuya intensidad depende de las masas y de las distancias que los separan; la fuerza gravitacional disminuye con el cuadrado. Hemos llegado a comprender que es la materia, la que determina la geometría del espacio-tiempo.

En la imagen, dos partículas en reposo relativo, en un espacio-tiempo llano y Se representan en este esquema dos partículas que se acercan entre sí siguiendo un movimiento acelerado. La interpretación newtoniana supone que el espacio-tiempo es llano y que lo que provoca la curvatura de las líneas de universo es la fuerza de interacción gravitatoria entre ambas partículas. Por el contrario, la interpretación einsteiniana supone que las líneas de universo de estas partículas son geodésicas (“rectas”), y que es la propia curvatura del espacio tiempo lo que provoca su aproximación progresiva.

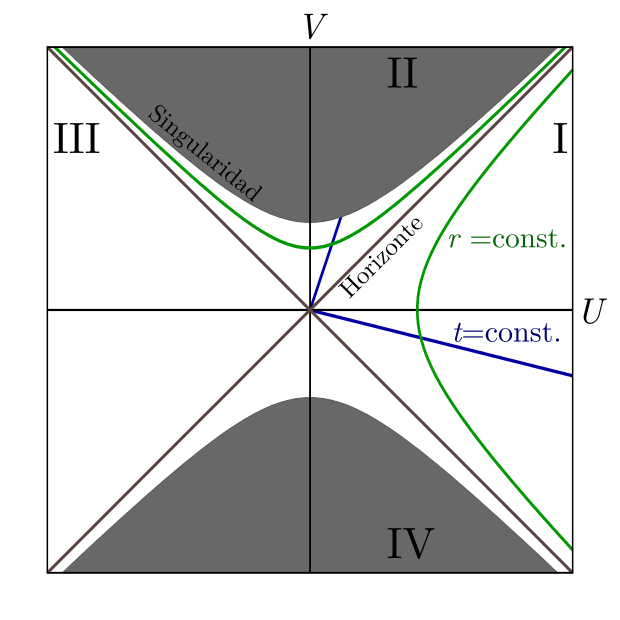

El máximo exponente conocido del espacio-tiempo curvo, se podría decir que se da en la formación de los agujeros negros, donde la masa queda comprimida a tal densidad que se conforma en una singularidad, ese objeto de energía y densidad “infinitsas” en el que, el espacio y el tiempo desaparecen de nuestra vista y parece que entran en “otro mund” para nosotros desconocidos.

Los agujeros negros, cuya existencia se dedujo por Schwarzschild en 1.916 a partir de las ecuaciones de campo de Einstein de la relatividad general, son objetos supermasivos, invisibles a nuestra vista (de ahí su nombre) del que no escapa ni la luz; tal es la fuerza gravitatoria que generan que incluso engullen la materia de sus vecinas, objetos estelares como estrellas que osan traspasar el cinturón de seguridad que llamamos horizonte de sucesos.

Desde siempre hemos tenido la tendencia de querer representar las cosas y a medida que pudimos descubrir conocimientos nuevos, también le dimos a esos nuevos saberes sus símbolos y ecuaciones matemáticas que representaban lo que creíamos saber. Mecánica cuántica, relatividad, átomos, el genoma, agujeros negros, la constante cosmológica, la constante de Planck racionalizada…

Wheeler decía allá por el año 1957, que el punto final de la compresión de la materia -la propia singularidad– debía estar gobernada por la unión, o matrimonio, de las leyes de la mecánica cuántica y las de la distorsión espaciotemporal. Esto debe ser así, puesto que la distorsión espaguetiza el espacio a escalas tan extraordinariamente microscópicas que están profundamente influenciadas por el principio de incertidumbre.

Las leyes unificadas de la distorsión espaciotemporal y la mecánica cuántica se denominan “leyes de la gravedad cuántica”, y han sido un “santo grial” para todos los físicos desde los años cincuenta. A principios de los sesenta los que estudiaban física con Wheeler, pensaban que esas leyes de la gravedad cuántica eran tan difíciles de comprender que nunca las podrían descubrir durante sus vidas. Sin embargo, el tiempo inexorable no deja de transcurrir, mientras que, el Universo y nuestras mentes también, se expanden. De tal manera evolucionan nuestros conocimientos que, poco a poco, vamos pudiendo conquistar saberes que eran profundos secretos escondidos de la Naturaleza y, con la Teoría de cuerdas (aún en desarrollo), parece que por fín, podremos tener una teoría cuántica de la gravedad.

Una cosa sí sabemos: Las singularidades dentro de los agujeros negros no son de mucha utilidad puesto que no podemos contemplarla desde fuera, alejados del horizonte de sucesos que marca la línea infranqueable del irás y no volverás. Si alguna vez alguien pudiera llegar a ver la singularidad, no podría regresar para contarlo. Parece que la única singularidad que podríamos “contemplar” sin llegar a morir sería aquella del Big Bang, es decir, el lugar a partir del cual pudo surgir el universo y, cuando nuestros ingenios tecnológicos lo permitan, serán las ondas gravitacionales las que nos “enseñarán” esa singularidad.

Esta pretende ser la imagen de un extraño objeto masivo, un quásar que sería una evidencia vital del Universo primordial. Es un objeto muy raro que nos ayudará a entender cómo crecieron los agujeros negros súper-masivos unos pocos cientos de millones de años después del Big Bang (ESO).

Representación artística del aspecto que debió tener 770 millones después del Big Bang el quásar más distante descubierto hasta la fecha (Imagen ESO). Estas observaciones del quásar brindan una imagen de nuestro universo tal como era durante su infancia, solo 750 millones de años después de producirse la explosión inicial que creó al universo. El análisis del espectro de la luz del quásar no ha aportado evidencias de elementos pesados en la nube gaseosa circundante, un hallazgo que sugiere que el quásar data de una era cercana al nacimiento de las primeras estrellas del universo.

Basándose en numerosos modelos teóricos, la mayoría de los científicos está de acuerdo sobre la secuencia de sucesos que debió acontecer durante el desarrollo inicial del universo: Hace cerca de 14.000 millones de años, una explosión colosal, ahora conocida como el Big Bang, produjo cantidades inmensas de materia y energía, creando un universo que se expandía con suma rapidez. En los primeros minutos después de la explosión, protones y neutrones colisionaron en reacciones de fusión nuclear, formando así hidrógeno y helio.

… y, surgió la materia

Finalmente, el universo se enfrió hasta un punto en que la fusión dejó de generar estos elementos básicos, dejando al hidrógeno como el elemento predominante en el universo. En líneas generales, los elementos más pesados que el hidrógeno y el helio, como por ejemplo el carbono y el oxígeno, no se formaron hasta que aparecieron las primeras estrellas. Los astrónomos han intentado identificar el momento en el que nacieron las primeras estrellas, analizando a tal fin la luz de cuerpos muy distantes. (Cuanto más lejos está un objeto en el espacio, más antigua es la imagen que de él recibimos, en luz visible y otras longitudes de onda del espectro electromagnético.) Hasta ahora, los científicos sólo habían podido observar objetos que tienen menos de unos 11.000 millones de años. Todos estos objetos presentan elementos pesados, lo cual sugiere que las estrellas ya eran abundantes, o por lo menos estaban bien establecidas, en ese momento de la historia del universo.

Supernova 1987 A

El Big Bang produjo tres tipos de radiación: electromagnética (fotones), radiación de neutrinos y ondas gravitatorias. Se estima que durante sus primeros 100.000 años de vida, el universo estaba tan caliente y denso que los fotones no podían propagarse; eran creados, dispersados y absorbidos antes de que apenas pudieran recorrer ínfimas distancias. Finalmente, a los cien mil años de edad, el universo se había expandido y enfriado lo suficiente para que los fotones sobrevivieran, y ellos comenzaron su viaje hacia la Tierra que aún no existía. Hoy los podemos ver como un “fondo cósmico de microondas”, que llega de todas las direcciones y llevan gravada en ellos una imagen del universo cuando sólo tenía esa edad de cien mil años.

Se dice que al principio sólo había una sola fuerza, la Gravedad que contenía a las otras tres que más tarde se desgajaron de ella y “caminaron” por sí mismas para hacer de nuestro universo el que ahora conocemos. En Cosmología, la fuerza de gravedad es muy importante, es ella la que mantiene unidos los sistemas planetarios, las estrellas en las galaxias y a las galaxias en los cúmulos. La Gravedad existe a partir de la materia que la genera para curvar el espacio-tiempo y dibujar la geometría del universo.

Los telescopios de la NASA han captado la imagen de un agujero negro en el centro de una galaxia golpeando otra vecina hasta el punto de desviarla y de …”robarle su masa” que, finalmente se irá engullendo poco a poco el monstruo estelar.

Un agujero negro es lo definitivo en distorsión espaciotemporal, según las ecuaciones de Einstein: está hecho única y exclusivamente a partir de dicha distorsión. Su enorme distorsión está causada por una inmensa cantidad de energía compactada: energía que reside no en la materia, sino en la propia distorsión. La distorsión genera más distorsión sin la ayuda de la materia. es la esencia del agujero negro.

Lo cierto es que los físicos relativistas se han sentido muy frustrados desde que Einstein publicó su Teoría de la relatividad general y se desprendieron de ellas mensajes asombroso como el de la existencia de agujeros negros que predecían sus ecuaciones de campo. Así que, se dirigieron a los astrónomos para que ellos confirmaran o refutaran su existencia mediante la observación del universo profundo. Sin embargo y, a pesar de su enorme esfuerzo, los astrónomos npo han podido obtener medidas cuantitativas de ninguna distorsión espaciotemporal de agujeros negros. Sus grandes triunfos han consistido en varios descubrimientos casi incontrovertibles de la existencia de agujeros negros en el universo, pero han sido incapaces de cartografiar, ni siquiera de forma ruda, esa distorsión espaciotemporal alrededor de los agujeros negros descubiertos. No tenemos la técnica para ello y somos conscientes de lo mucho que nos queda por aprender y descubrir.

Imaginar cómo podría escapar una nave que cayera cerca del remolino central… ¡Produce escalofríos!

Las matemáticas siempre van por delante de esa realidad que incansables buscamos. Ellas nos dicen que en un agujero negro, además de la curvatura y el frenado y ralentización del tiempo, hay un tercer aspecto en la distorsión espaciotemporal de un agujero negro: un torbellino similar a un enorme tornado de espacio y tiempo que da vueltas y vueltas alrededor del horizonte del agujero. Así como el torbellino es muy lento lejos del corazón del tornado, también el torbellino. Más cerca del núcleo o del horizonte el torbellino es más rápido y, cuando nos acercamos hacia el centro ese torbellino espaciotemporal es tan rápido e intenso que arrastra a todos los objetos (materia) que ahí se aventuren a estar presentes y, por muy potentes que pudieran ser los motores de una nave espacial… ¡nunca podrían hacerla salir de esa inmensa fuerza que la atraería hacia sí! Su destino sería la singularidad del agujero negro donde la materia comprimida hasta límites inimaginables, no sabemos en qué se habrá podido convertir.

Espacio-Tiempo curvo

Todos conocemos la teoría de Einstein y lo que nos dice que ocurre cuando grandes masas, como planetas, están presentes: Curvan el espacio que lo circundan en función de la masa. El exponente máximo de dicha curvatura y distorsión temporal es el agujero negro que, comprime la masa hasta hacerla “desaparecer” y el tiempo, en la singularidad formada, deja de existir. En ese punto, la relatividad general deja de ser válida y tenemos que acudir a la mecánica cuántica para seguir comprendiendo lo que allí está pasando.

Einstein no se preocupaba por la existencia de este extraño universo dentro del agujero negro porque la comunicación con él era imposible. Cualquier aparato o sonda enviada al centro de un agujero negro encontraría una curvatura infinita; es decir, el campo gravitatorio sería infinito y, como ya se explica anteriormente, nada puede salir de un agujero negro, con lo cual, el mensaje nunca llegará al exterior. Allí dentro, cualquier objeto material sería literalmente pulverizado, los electrones serían separados de los átomos, e incluso los protones y los neutrones dentro de los propios núcleos serían desgajados. De todas las maneras tenemos que reconocer que este universo especular es matemáticamente necesario para poder ir comprendiendo cómo es, en realidad, nuestro universo.

Con todo esto, nunca hemos dejado de fantasear. Ahí tenemos el famoso puente de Einstein-Rosen que conecta dos universos y que fue considerado un artificio matemático. De todo esto se ha escrito hasta la extenuación:

“Pero la factibilidad de poder trasladarse de un punto a otro del Universo recurriendo a la ayuda de un agujero de gusano es tan sólo el principio de las posibilidades. Otra posibilidad sería la de poder viajar al pasado o de poder viajar al futuro. Con un túnel conectando dos regiones diferentes del espacio-tiempo, conectando el “pasado” con el “futuro”, un habitante del “futuro” podría trasladarse sin problema alguno hacia el “pasado” Einstein—Rosen—Podolsky), para poder estar físicamente presente en dicho pasado con la capacidad de alterar lo que está ocurriendo en el “ahora”. Y un habitante del “pasado” podría trasladarse hacia el “futuro” para conocer a su descendencia mil generaciones después, si la hubo.“

El puente de Einstein-Rosen conecta universos diferentes. Einstein creía que cualquier cohete que entrara en el puente sería aplastado, haciendo así imposible la comunicación Posteriormente, los puentes de Einstein-Rosen se encontraron pronto en otras soluciones de las ecuaciones gravitatorias, tales como la solución de Reisner-Nordstrom que describe un agujero eléctricamente cargado. Sin embargo, el puente de Einstein-Rosen siguió siendo una nota a pie de página curiosa pero olvidada en el saber de la relatividad.

Lo cierto es que algunas veces, tengo la sensación de que aún no hemos llegado a comprender esa fuerza misteriosa que es la Gravedad, la que no se quiere juntar con las otras tres fuerzas de la Naturaleza. Ella campa solitaria y aunque es la más débil de las cuatro, esa debidad resulta engañosa poreque llega a todas partes y, además, como algunos de los antiguos filósofos naturales, algunos piensan que es la única fuerza del universo y, de ella, se desgajaron las otras tres cuando el Universo comenzó a enfriarse.

¡El Universo! Es todo lo que existe y es mucho para que nosotros, unos recien llegados, podamos llegar a comprenderlo en toda su inmensidad. Muchos son los secretos que esconde y, como siempre digo, son muchas más las preguntas que las respuestas. Sin embargo, estamos en el camino y… Como dijo el sabio: ¡Todos los grandes viajes comenzaron con un primer paso!

En el Universo todo es fruto de dos fuerzas contrapuestas: El hombre y la mujer dos que son uno. El átomo se equilibra por la fuerza eléctrica positiva del protón y la negativa del electrón.

Por ejemplo, las estrellas son estables por el hecho de que, la energía de fusión tiende a expandir la estrella y, la fuerza de Gravedad generada por su ingente masa, la hace contraerse. De esa manera, las dos fuerzas se contrarrestan y consiguen estabilizar a la estrella que vive miles de años. Cuando se agota el combustible nuclear de fusión, la estrella queda a merced de la Gravedad y se contrae (implosiona) bajo el peso de su propia masa, la gravedad la aplasta más y más hasta convertirla en una estrella de neutrones y un agujero negro si es una estrella masiva.

En el átomo, el equilibrio se alcanza como consecuencia de que, los protones (los nucleones que forman el núcleo), están cargados positivamente, y, los electrones que orbitan a su alrededor, están cargadas eléctricamente con cargas negativas equivalentes, con lo cual, el equilibrio queda servido y se alcanza la estabilidad.

Diagrama de Kruskal-Szekeres para un agujero negro. Las rectas azules son superficies de tiempo constante. Las curvas verdes son superficies de radio constante. -Las regiones I y II (sólo la parte blanca) son el exterior y el interior de un agujero negro. -La región III es una región exterior al agujero negro “paralela”. -La región IV (sólo la parte blanca) es un agujero blanco. Las zonas grises adyacentes a las regiones II y IV son las singularidades.

El agujero Blanco, al contrario del Agujero negro, en lugar de engullir materia la eyectaría hacia fuera

El agujero negro de Schwarzschild es descrito como una singularidad en la cual una geodésica puede sólo ingresar, tal tipo de agujero negro incluye dos tipos de horizonte: un horizonte “futuro” (es decir, una región de la cual no se puede salir una vez que se ha ingresado en ella, y en la cual el tiempo -con el espacio- son curvados hacia el futuro), y un horizonte “pasado”, el horizonte pasado tiene por definición la de una región donde es imposible la estancia y de la cual sólo se puede salir; el horizonte futuro entonces ya correspondería a un agujero blanco.

… La cuántica, universos paralelos…

Así, nos encontramos con el hecho cierto de que, en el Universo, todo es equilibrio y estabilidad: el resultado de dos fuerzas contrapuestas.

Emilio Silvera Vázquez

Oct

19

¡La misteriosa luna Titán!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en ¿qué sorpresa nos dará? ~

Clasificado en ¿qué sorpresa nos dará? ~

Comments (0)

Comments (0)

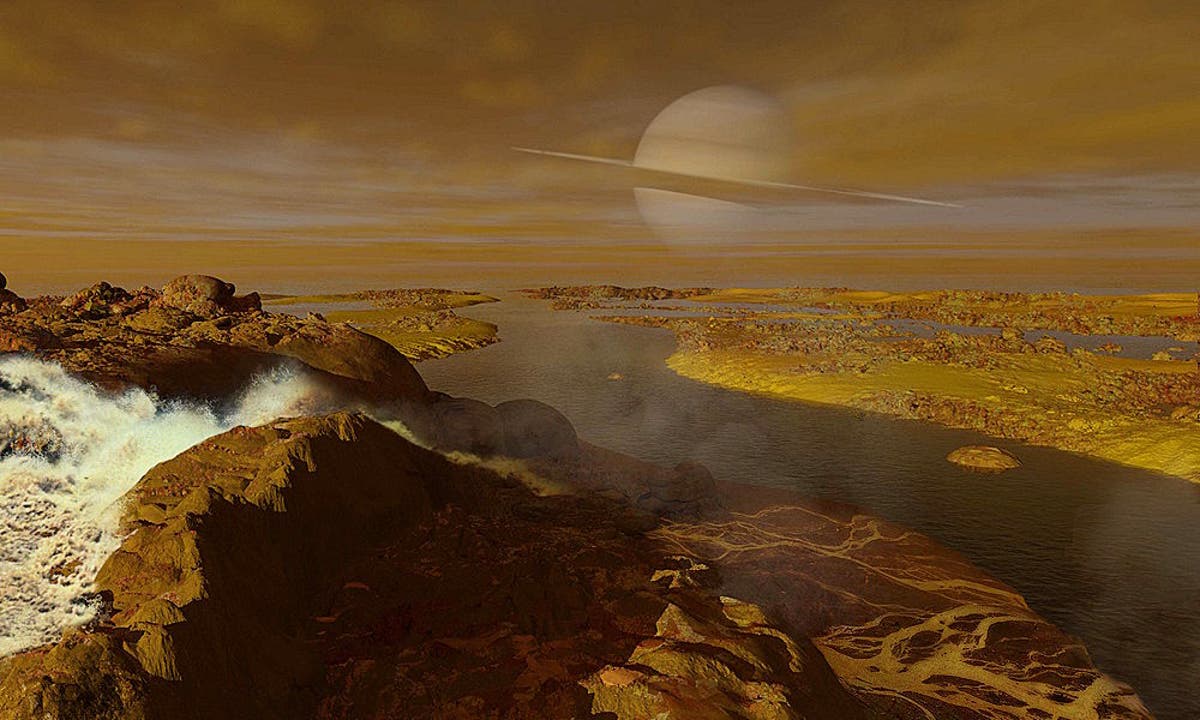

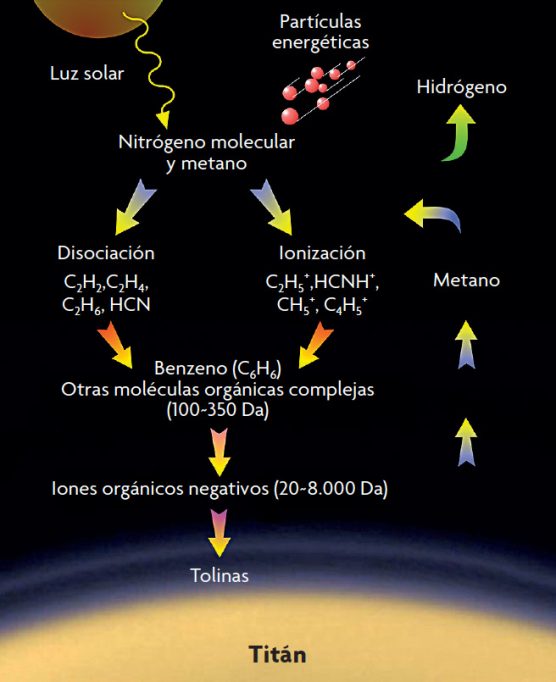

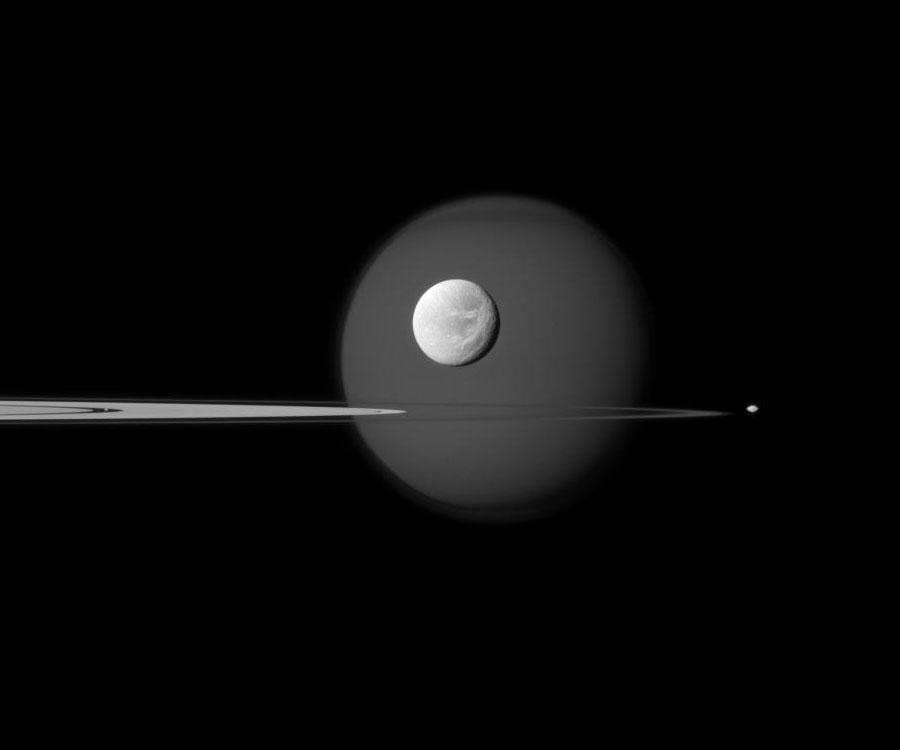

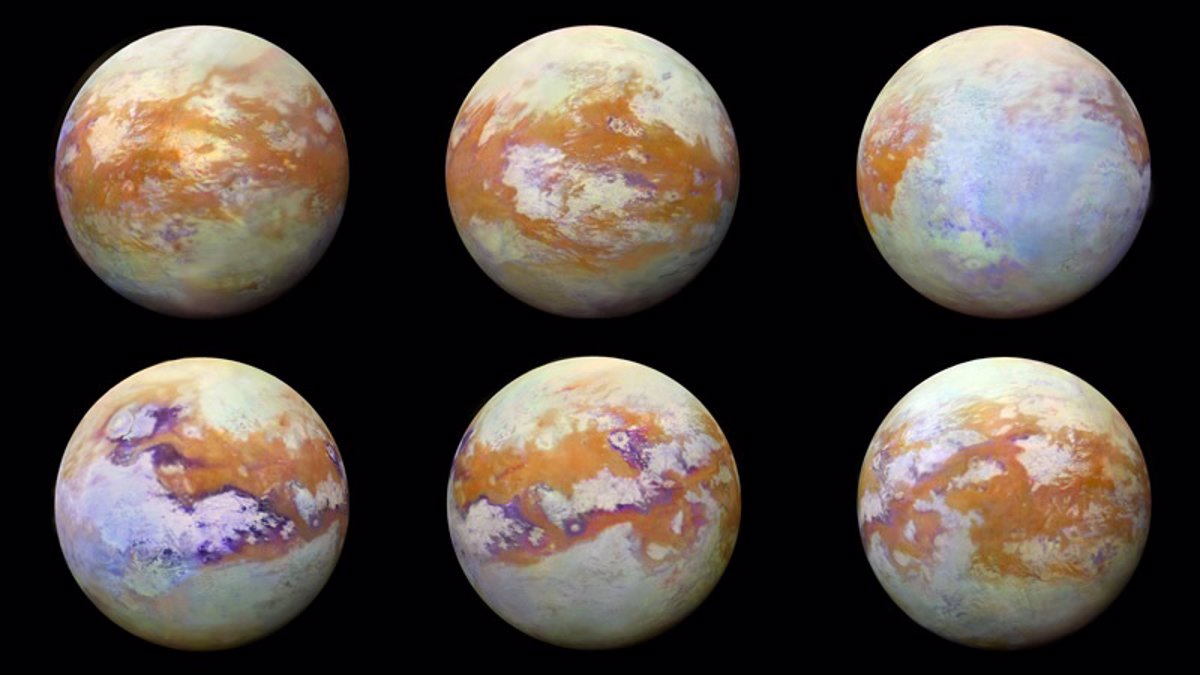

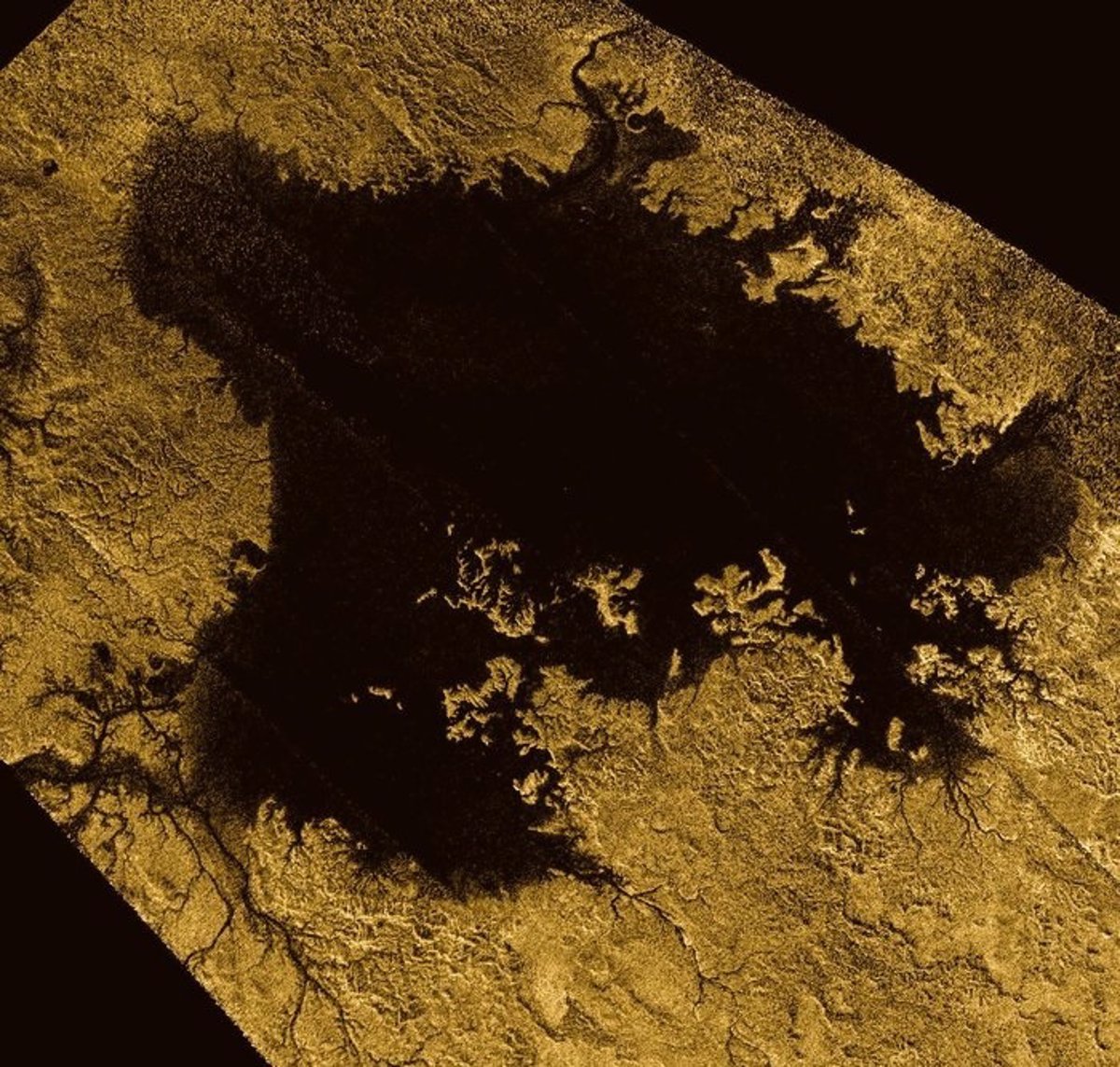

Titán, la luna de Saturno, esconde muchos secretos que debemos desvelar y, entre otros, aparte de los últimos resultados obtenidos que dicen que también, posee un océano interior, los más recientes estudios nos hablan de algo más sensacional.

¿Quién está respirando el Oxígeno de Titán?

Con esta pregunta se publicaba un reportaje en la prensa Podrían ser las primeras pruebas fiables de una forma de vida extraterrestre. Una muy diferente de la nuestra, basada en el metano y que estaría en pleno desarrollo sobre la superficie de Titán, la enigmática luna de Saturno. O por lo menos eso es lo que sugieren dos nuevos estudios realizados a partir de los últimos datos obtenidos sobre el terreno por la sonda Cassini, de la NASA.

La química orgánica de Titán es parecida a la de la Tierra hace millones de años

Esta luna es un enigma en sí mismo ya que es la única luna del Sistema Solar que tiene una atmósfera densa. Los lagos de hidrocarburos líquidos en su superficie y un ciclo del metano activo se asemejan al ciclo del agua de la Tierra.

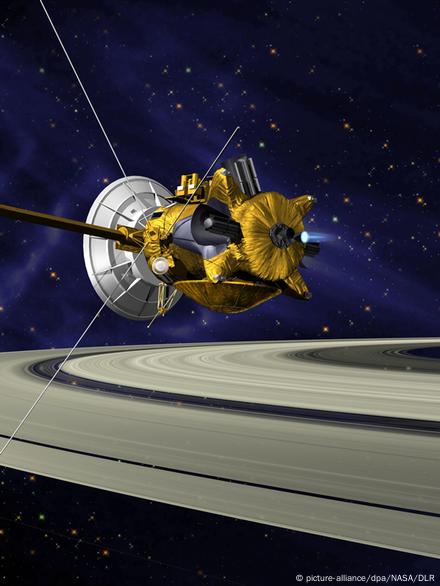

Cassini, la sonda, ha estado en órbita alrededor de Saturno desde 2004 y se encuentra ahora en su segunda fase de extensión de la misión, la misión Cassini Solsticio de Misión, que se prolongará hasta 2017.

La atmósfera de Titán contiene una molécula inédita basada en carbono

“Sugerimos que algo está consumiendo el hidrógeno porque es el gas más obvio para ser consumido por una forma de vida en Titán, de la misma forma en que se consume oxígeno en la Tierra”, asegura Chris McKay, astro-biólogo de la NASA en el centro espacial Ames. “Si estos indicios confirman la presencia de vida, será doblemente excitante, ya que sería una forma nuevas de vida, independiente de la basada en el agua que existe en la Terra”.

Las tormentas de moléculas orgánicas de Titán que sorprenden a los biólogos

Oct

19

Nuevos vestigios de vida primigenia

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Artículo de Prensa ~

Clasificado en Artículo de Prensa ~

Comments (0)

Comments (0)

GEOLOGÍA

Fósiles descubiertos en la región de Labrador

Rocas canadienses de hace 3.950 millones de años ¿la huella de vida terrestre más antigua?

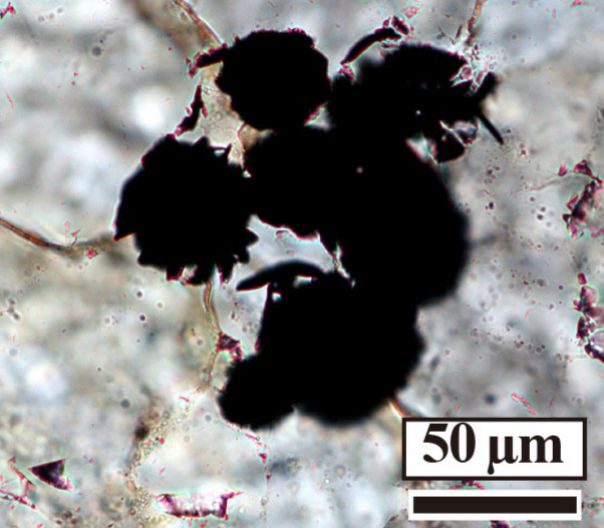

Detalle al microscopio de una de las muestras de rocas estudiadas T. TASHIRO

Encuentran grafito biogénico, es decir, producido por organismos vivos, en rocas de Labrador. Son unos 250 millones de años más antiguas que otras rocas de Groenlandia en las que se encontró ese material.

Detalle del fósil hallado en Groenlandia, de 3.700 millones de años de antigüedad. ALLEN NUTMAN

La Tierra se formó hace unos 4.538 millones de año y la vida debió surgir varios cientos de millones de años después. Se cree que los primeros organismos posiblemente se originaron hace unos 4.200 millones de años. Encontrarlos es improbable si no imposible, pero los científicos sí están siendo capaces de hallar en rocas muy antiguas pruebas de lo que podría ser actividad microbiana. Y decimos podría porque estos hallazgos no están exentos de polémica científica, ya que esos elementos que indicarían de forma indirecta la presencia de vida también podrían haberse formado por otros procesos.

Cinturón de rocas verdes

Tubos de hematita encontrados en el Cinturón Nuvvuagittuq, en Quebec, Canadá.

Esta semana la revista Nature publica una investigación que describe el descubrimiento en Canadá de las que, según sostiene Tsuyoshi Komiya, autor principal del estudio, serían las huellas de vida terrestre más antiguas, pues se han hallado en rocas de hace 3.950 millones de años. En concreto, los investigadores de la Universidad de Tokio estudiaron rocas sedimentarias de Saglek Block, en el norte de la región de Labrador. Hicieron un detallado análisis geológico y midieron las concentraciones y composiciones isotópicas de grafito y carbonato que, según aseguran, reveló que se trataba de grafito biogénico.

En rocas sedimentarias de hace entre 3.800 y 3.700 millones de años halladas en el suroeste de Groenlandia, recuerda Komiya, se encontraron granos de grafito que también podría ser biogénico, es decir, producido por organismos vivos. Las suyas, serían, por tanto entre 250 y 150 millones de años más antiguas.

Organismos marinos

Los organismos que dejaron esas huellas, explica Komiya a EL MUNDO, habrían vivido hace 3.950 millones de años en el océano y todo el material se habría depositado en el fondo oceánico. Su estudio, asegura, descartó que la presencia de ese grafito se debiera a una posterior contaminación de esas rocas. “Todo el material es autóctono”, asegura. Según detalla, para realizar esta investigación hicieron un mapa geológico de esa zona de Canadá, una tarea que les llevó tres años, y recogieron más de 4.000 muestras.

Detectan restos de posibles primeros organismos de la Tierra

“El grafito biogénico es el que está relacionado inequívocamente con la vida. En mi opinión, a pesar de la importancia de este estudio en relación con las condiciones de habitabilidad de la Tierra primitiva, las pruebas isotópicas y estructurales (Raman) que aportan no terminan de ser claras e inequívocas en este sentido”, explica a este diario Jesús Martínez-Frías, jefe del grupo de Investigación del CSIC de Meteoritos y Geociencias Planetarias en el IGEO (CSIC-UCM), sin vinculación con este trabajo.

Vista al microscopio de una de las rocas analizadas T. TASHIRO

No obstante, Martínez-Frías, considera que “se trata de un estudio muy interesante que incide en aspectos geoquímicos para concluir acerca de las huellas de vida antigua en la Tierra. Pero, no hay que confundir estos resultados con la existencia de biomarcadores claros e inequívocos“.

Un biomarcador, explica, es un compuesto orgánico que procede o está relacionado inequívocamente con la actividad metabólica de un organismo y según Martínez-Frías, lo que se describe en el trabajo “son geomarcadores que evidencian la posibilidad de un origen biogénico, pero no indicadores inequívocos de la presencia de vida”.

LAS PRIMERAS FORMAS DE VIDA

Determinar cuándo aparecieron las primeras formas de vida en la Tierra, dice Komiya: “Es una cuestión difícil porque para ello hay que demostrar que la vida no existía antes de esa fecha. Y en ciencia es un muy difícil probar la ausencia de algo”, reflexiona. Debido a que la edad mínima de la vida en la Tierra es de entre 3.950 y 3.800 millones de años, añade, debió aparecer antes: “Yo, personalmente, pienso que la vida surgió relativamente pronto en la historia de la Tierra”, afirma. Por eso considera que es posible que se originara hace 4.200 millones de años, como sostienen algunas teorías, debido a cómo estaba ya configurado nuestro planeta.

“Personalmente, sí pienso que tal vez la vida comenzó en la Tierra antes de lo que se pensaba en un principio. Y paulatinamente se van detectando más evidencias de habitabilidad indicando que esto pudo ser así “, apunta, por su parte, Jesús Martínez-Frías. “Pero, dicho esto, también hay que ser rigurosos. Como decía Carl Sagan, afirmaciones extraordinarias requieren evidencias extraordinarias”.

Artículo de Prensa.

Totales: 71.141.601

Totales: 71.141.601 Conectados: 32

Conectados: 32