Feb

21

Las interacciones fundamentales

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (2)

Comments (2)

Como pueden haber deducido, me estoy refiriendo a cualquiera de los cuatro tipos diferentes de interacciones que pueden ocurrir entre los cuerpos. Estas interacciones pueden tener lugar incluso cuando los cuerpos no están en contacto físico y juntas pueden explicar todas las fuerzas que se observan en el universo.

Viene de lejos el deseo de muchos físicos que han tratado de unificar en una teoría o modelo a las cuatro fuerzas, que pudieran expresarse mediante un conjunto de ecuaciones. Einstein se pasó los últimos años de su vida intentándolo, pero igual que otros antes y después de él, aún no se ha conseguido dicha teoría unificadora de los cuatro interacciones fundamentales del universo. Se han hecho progresos en la unificación de interacciones electromagnéticas y débiles.

Figuras

Estos diagramas son una concepción artística de los procesos físicos. No son exactos y no están hechos a escala. Las áreas sombreadas con verde representan la nube de gluones o bien el campo del gluón, las líneas rojas son las trayectorias de los quarks.

En el texto del recuadro dice: Un neutrón decae en un protón, un electrón y un antineutrino, a través de un bosón virtual (mediador). Este es el decaimiento beta del neutrón.

![]()

En el texto del recuadro dice: Una colisión electrón – positrón (antielectrón) a alta energía puede aniquilarlos para producir mesones B0 y Bbarra0 a través de un bosón Z virtual o de un fotón virtual.

El texto del recuadro dice: Dos protones que colisionan a alta energía pueden producir varios hadrones más partículas de masa muy grande tales como los bosones Z. Este tipo de suceso es raro pero puede darnos claves cruciales sobre cómo es la estructura de la materia.

Aunque no pueda dar esa sensación, todo está relacionado con las interacciones fundamentales de la materia en el entorno del espacio-tiempo en el que se mueven y conforman objetos de las más variadas estructuras que en el Universo podemos contemplar, desde una hormiga a una estrella, un mundo o una galaxia. Las fuerzas fundamentales de la Naturaleza siempre están presentes y de alguna manera, afecta a todo y a todos.

Cuando hablamos de la relatividad general, todos pensamos en la fuerza gravitatoria que es unas 1040 veces más débil que la fuerza electromagnética. Es la más débil de todas las fuerzas y sólo actúa entre los cuerpos que tienen masa. Es siempre atractiva y pierde intensidad a medida que las distancias entre los cuerpos se agrandan. Como ya se ha dicho, su cuanto de gravitación, el gravitón, es también un concepto útil en algunos contextos. En la escala atómica, esta fuerza es despreciablemente débil, pero a escala cosmológica, donde las masas son enormes, es inmensamente importante para mantener a los componentes del universo juntos. De hecho, sin esta fuerza no existiría el Sistema Solar ni las galaxias, y seguramente, nosotros tampoco estaríamos aquí. Es la fuerza que tira de nuestros pies y los mantiene firmemente asentados a la superficie del planeta. Aunque la teoría clásica de la gravedad fue la que nos dejó Isaac Newton, la teoría macroscópica bien definida y sin fisuras de la gravitación universal es la relatividad general deEinstein, mucho más completa y profunda.

Lo grande y lo muy pequeño juntos

Nadie ha podido lograr, hasta el momento, formular una teoría coherente de la Gravedad Cuántica que unifique las dos teorías. Claro que, la cosa no será nada fácil, ya que, mientras que aquella nos habla del macrocosmos, ésta otra nos lleva al microcosmos, son dos fuerzas antagónicas que nos empeñamos en casar.

Seguimos empeñados en buscar esa teoría que una lo muy grande con lo muy pequeño y la Gravedad, hasta el momento no da el sí

Por el momento, no hay una teoría cuántica de la interacción gravitatoria satisfactoria. Es posible que la teoría de supercuerdas pueda dar una teoría cuántica de la gravitación consistente, además de unificar la gravedad con los demás interacciones fundamentales sin que surjan los dichosos e indeseados infinitos.

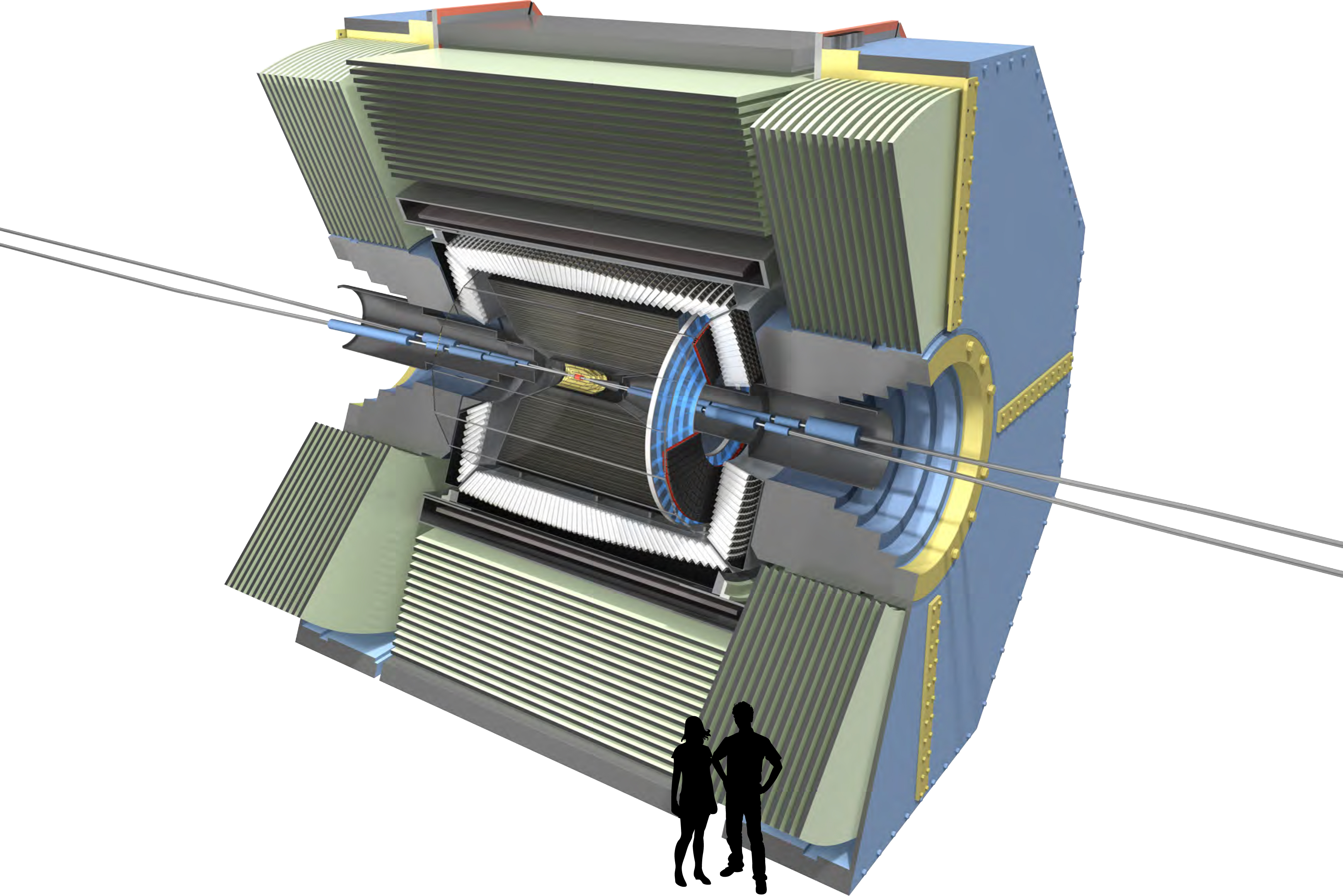

Las partículas colisionan ente sí y se producen cambios y transiciones de fase

Algunos han puesto en duda la realidad del Modelo Estándar que, como se ha dicho aquí en otros trabajos, está construído con el contenido de una veintena de parámetros aleatorios (entre ellos el Bos´çon de Higgs) que no son nada satisfactorios para dar una conformidad a todo su entramado que, aunque hasta el momento ha sido una eficaz herramienta de la física, también es posible que sea la única herramienta que hemos sabido construir pero que no es ¡la herramient!

Es posible que sola sea cuestión de tiempo y de más investigación y experimento. En el sentido de la insatisfacción reinante entre algunos sectores, se encuentran los físicos del experimento de alta energía BaBar, en el SLAC, un acelerador lineal situado en Stanford (California). Según ellos, la desintegración de un tipo de partículas llamado «B to D-star-tau-nu» es mucho más frecuente de lo predicho por el modelo estándar. Puede que no sea importante y puede que, hasta la existencia del Bosón de Higgs esté en peligro a pesar de que en el LHC digan que se ha encontrado.

Esquema del decaimiento Beta y una sencilla explicación de la interacción débil

La fuerza débil recibe su nombre porque a la escala de sus interacciones es la más débil dentro del modelo estándar. Pero ojo, esto no incluye la gravedad, puesto que la gravedad no pertenece al modelo estándar por el momento. La interacción débil ocurre a una escala de metros, es decir, la centésima parte del diámetro de un protón y en una escala de tiempos muy variada, desde segundos hasta unos 5 minutos. Para hacernos una idea, esta diferencia de órdenes de magnitud es la misma que hay entre 1 segundo y 30 millones de años.

La interacción débil, que es unas 1010 veces menor que la interacción electromagnética, ocurre entre leptones y en la desintegración de los hadrones. Es responsable de la desintegración beta de las partículas y núcleos. En el modelo actual, la interacción débil se entiende como una fuerza mediada por el intercambio de partículas virtuales, llamadas bosones vectoriales intermediarios, que para esta fuerza son las partículas W+, W– y Z0. Las interacciones débiles son descritas por la teoría electrodébil, que las unifica con las interacciones electromagnéticas.

Propiedades de los Bosones mediadores intermediarios de la fuerza débil

La teoría electrodébil es una teoría gauge de éxito que fue propuesta en 1.967 por Steven Weinberg y Abdus Salam, conocida como modelo WS. También Sheldon Glashow, propuso otra similar.

La interacción electromagnética es la responsable de las fuerzas que controlan la estructura atómica, reacciones químicas y todos los fenómenos electromagnéticos. Puede explicar las fuerzas entre las partículas cargadas, pero al contrario que las interacciones gravitacionales, pueden ser tanto atractivas como repulsivas. Algunas partículas neutras se desintegran por interacciones electromagnéticas. La interacción se puede interpretar tanto como un modelo clásico de fuerzas (ley de Coulomb) como por el intercambio de unos fotones virtuales. Igual que en las interacciones gravitatorias, el hecho de que las interacciones electromagnéticas sean de largo alcance significa que tiene una teoría clásica bien definida dadas por las ecuaciones de Maxwell. La teoría cuántica de las interacciones electromagnéticas se describe con la electrodinámica cuántica, que es una forma sencilla de teoría gauge.

El electromagnetismo está presente por todo el Universo

La interacción fuerte es unas 102 veces mayor que la interacción electromagnética y, como ya se dijo antes, aparece sólo entre los hadrones y es la responsable de las fuerzas entre nucleones que confiere a los núcleos de los átomos su gran estabilidad. Actúa a muy corta distancia dentro del núcleo (10-15 metros) y se puede interpretar como una interacción mediada por el intercambio de mesones virtuales llamados Gluones. Está descrita por una teoría gauge llamada Cromodinámica cuántica.

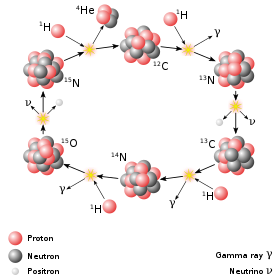

La interacción fuerte, también conocida como interacción nuclear fuerte, es la interacción que permite unirse a los quarks para formar hadrones. A pesar de su fuerte intensidad, su efecto sólo se aprecia a distancias muy cortas del orden del radio atómico. Según el Modelo estándar, la partícula mediadora de esta fuerza es el Gluón. La teoría que describe a esta interacción es la cromodinámica cuántica (QCD) y fue propuesta por David Politzer, Frank Wilczek y David Gross en la década de 1980 y por lo que recibieron el Nobel 30 años más tarde cuando el experimento conformó su teoría.

La interacción fuerte, como se ha explicado muchas veces, es la más fuerte de todas las fuerzas fundamentales de la Naturaleza, es la responsable de mantener unidos los protones y neutrones en el núcleo del átomo. Como los protones y neutrones están compuestos de Quarks, éstos dentro de dichos bariones, están sometidos o confinados en aquel recinto, y, no se pueden separar por impedirlo los gluones que ejercen la fuerza fuerte, es decir, esta fuerza, al contrario que las demás, cuando más se alejan los quarks los unos de los otros más fuerte es. Aumenta con la distancia.

En la incipiente teoría del campo electromagnético sugerida por Faraday, desaparecía la distinción esencial entre fuerza y materia, introduciendo la hipótesis de que las fuerzas constituyen la única sustancia física.

Las características de las fuerzas eran:

-

Cada punto de fuerza actúa directamente sólo sobre los puntos vecinos.

-

La propagación de cualquier cambio de la intensidad de la fuerza requiere un tiempo finito.

-

Todas las fuerzas son básicamente de la misma clase; no hay en el fondo fuerzas eléctricas, magnéticas ni gravitatorias, sino sólo variaciones (probablemente geométricas) de un sólo tipo de fuerza subyacente.

Lo importante al considerar la influencia de la metafísica de Faraday en sus investigaciones, es su suposición de que la teoría de campos ofrece una explicación última a todos los fenómenos. Los cuerpos sólidos, los campos eléctricos y la masa de los objetos son, de alguna forma, sólo apariencias. La realidad subyacente es el campo, y el problema de Faraday era encontrar un lazo de unión entre las apariencias y la supuesta realidad subyacente

Estaría bueno que al final del camino se descubriera que todas son una sola fuerza

El concepto de campo de Faraday ha dado mucho juego en Física, es un concepto ideal para explicar cierttos fenómenos que se han podido observar en las investigaciones de las fuerzas fundamentales y otros. El campo no se ve, sin embargo, está ahí, rodea los cuerpos como, por ejemplo, un electrón o el planeta Tierra que emite su campo electromagnético a su alrededor y que tan útil nos resulta para evitar problemas.

Me he referido a una teoría gauge que son teorías cuánticas de campo creadas para explicar las interacciones fundamentales. Una teoría gauge requiere un grupo de simetría para los campos y las potenciales (el grupo gauge). En el caso de la electrodinámica, el grupo es abeliano, mientras que las teorías gauge para las interacciones fuertes y débiles utilizan grupos no abelianos. Las teorías gauge no abelianas son conocidas como teorías de Yang–Mills. Esta diferencia explica por qué la electrodinámica cuántica es una teoría mucho más simple que la cromodinámica cuántica, que describe las interacciones fuertes, y la teoría electrodébil que unifica la fuerza débil con la electromagnética. En el caso de la gravedad cuántica, el grupo gauge es mucho más complicado que los anteriores necesarios para la fuerza fuerte y electrodébil.

En las teorías gauge, las interacciones entre partículas se pueden explicar por el intercambio de partículas (bosones vectoriales intermediarios o bosones gante), como los gluones, fotones y los W y Z.

El físico Enrico Fermi, refiriéndose al gran número de partículas existentes, dijo: “Si tuviera que saber el nombre de todas las partículas, me habría hecho botánico.” Por todo lo antes expuesto, es preciso conocer los grupos o familias más importantes de partículas, lógicamente “el espacio tiempo” nos limita y, me remitiré a las más comunes, importantes y conocidas como:

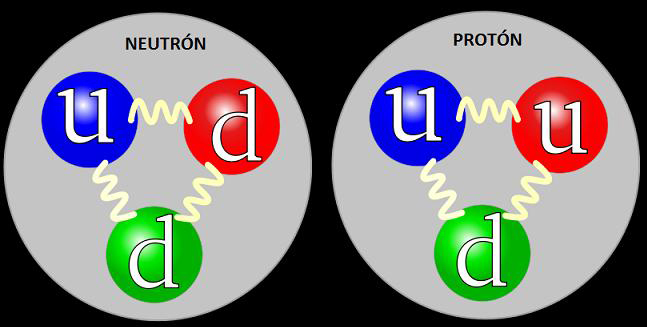

– Protón, que es una partícula elemental estable que tiene una carga positiva igual en magnitud a la del electrón y posee una masa de 1’672614×10-27 Kg, que es 1836,12 veces la del electrón. El protón aparece en los núcleos atómicos, por eso es un nucleón que estáformado por partículas más simples, los Quarks. Es decir, un protón está formado por dos quarks up y un quark down.

– Neutrón, que es un hadrón como el protón pero con carga neutra y también permanece en el núcleo, pero que se desintegra en un protón, un electrón y un antineutrino con una vida media de 12 minutos fuera del núcleo. Su masa es ligeramente mayor que la del protón (símbolo mn), siendo de 1’6749286(10)×10-27 kg. Los neutrones aparecen en todos los núcleos atómicos excepto en el del hidrógeno que está formado por un solo protón. Su existencia fue descubierta y anunciada por primera vez en 1.932 por James Chadwick (1891-1974. El protón está formado por tres quarks, dos quarks down y un quark up. Fijáos en la diferencia entre las dos partículas: la aparentemente minúscula diferencia hace que las dos partículas “hermanas” se comporten de formas muy distintas: la carga del protón es +2/3 +2/3 -1/3 = +1. Pero como el neutrón tiene up/down/down su carga es +2/3 -1/3 -1/3 = 0. ¡No tiene carga! No porque no haya nada con carga en él, sino porque las cargas que hay en su interior se anulan.

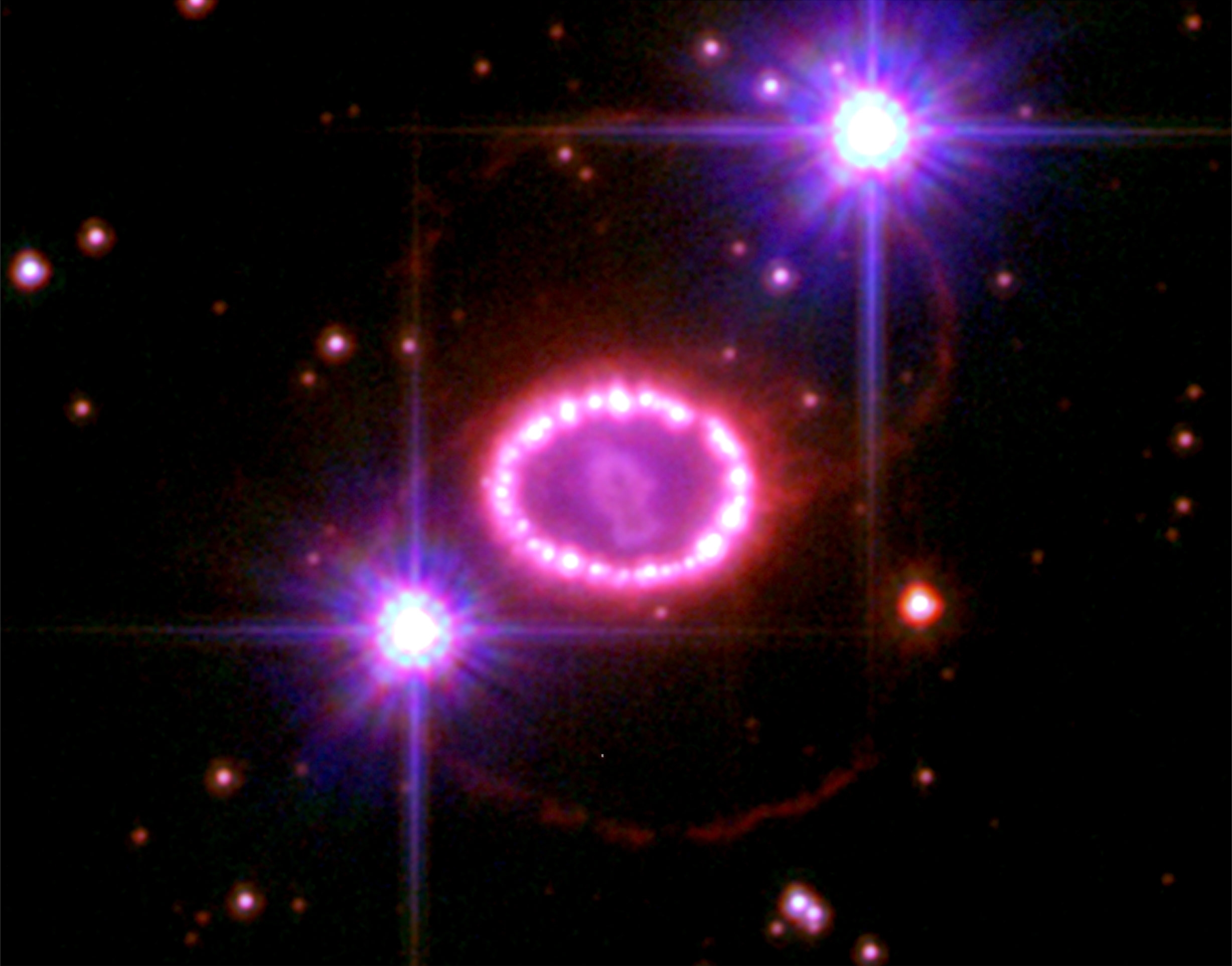

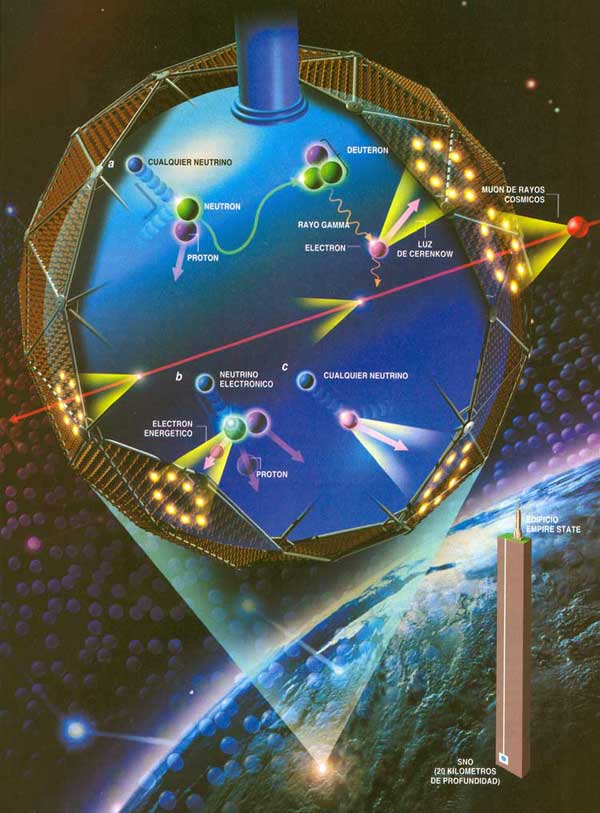

Andamos a la caza de los neutrinos

Los neutrinos, se cree que no tienen masa o, muy poca, y, su localización es difícil. Se han imaginado grandes recipientes llenos de agua pesada que, enterrados a mucha profundidad en las entrañas de la Tierra, en Minas abandonadas, captan los neutrinos provenientes del Sol y otros objetos celestes, explosiones supernovas, etc.

– Neutrino, que es un leptón que existe en tres formas exactas pero (se cree que) con distintas masas. Tenemos el ve (neutrino electrónico) que acompaña al electrón, vμ (neutrino muónico) que acompaña al muón, y vt (neutrino tau) que acompaña a la partícula tau, la más pesada de las tres. Cada forma de neutrino tiene su propia antipartícula.

El neutrino fue postulado en 1.931 para explicar la “energía perdida” en la desintegración beta. Fue identificado de forma tentativa en 1.953 y definitivamente en 1.956. Los neutrinos no tienen carga y se piensa que tienen masa en reposo nula y viajan a la velocidad de la luz, como el fotón. Hay teorías de gran unificación que predicen neutrinos con masa no nula, pero no hay evidencia concluyente.

Se ha conseguido fotografíar a un electrón. Poder filmar y fotografiar un electrón no es fácil por dos razones: primero, gira alrededor del núcleo atómico cada 0,000000000000000140 segundos , y, segundo, porque para fotografiar un electrón es necesario bombardearlo con partículas de luz (y cualquier que haya intentado sacarle una foto a un electrón sabe que hay que hacerlo sin flash).

– Electrón, que es una partícula elemental clasificada como leptón, con una carga de 9’109 3897 (54)×10-31Kg y una carga negativa de 1´602 177 33 (49) x 10-19 culombios. Los electrones están presentes en todos los átomos en agrupamientos llamados capas alrededor están presentes en todos los átomos en agrupamientos llamados capas alrededor del núcleo; cuando son arrancados del átomo se llaman electrones libres. Su antipartícula es el positrón, predicha por Paul Dirac.

El núcleo del átomo constituye el 99% de la masa

En los átomos existen el mismo número de protones que el de electrones, y, las cargas positivas de los protones son iguales que las negativas de los electrones, y, de esa manera, se consigue la estabilidad del átomo al equilibrarse las dos fuerzas contrapuestas. El electrón fue descubierto en 1.897 por el físico británico Joseph John Thomson (1.856 – 1940). El problema de la estructura (si la hay) del electrón no está resuelto. Si el electrón se considera como una carga puntual, su autoenergía es infinita y surgen dificultades en la ecuación conocida como de Lorente–Dirac.

Es posible dar al electrón un tamaño no nulo con un radio ro, llamado radio clásico del electrón, dado por e2/(mc2) = 2’82×10-13cm, donde e y m son la carga y la masa, respectivamente, del electrón y c es la velocidad de la luz. Este modelo también tiene problemas, como la necesidad de postular las tensiones de Poincaré.

Muchas son las partículas de las que aquí podríamos hablar, sin embargo, me he limitado a las que componen la materia, es decir Quarks y Leptones que conforman Protones y Neutrones, los nucleaones del átomo que son rodeados por los electrones. El Modelo Estándar es la herramienta con la ue los físicos trabajan (de momento) hasta que surjan nuevas y más avanzadas teorías que permitan un modelo más eficaz y realista. De Wikipedia he cogido el cuadro comparativo de las fuerzas.

Tabla comparativa

| Interacción7 | Teoría descriptiva | Mediadores | Fuerza relativa | Comportamiento con la distancia (r) | Alcance (m) |

|---|---|---|---|---|---|

| Fuerte | Cromodinámica cuántica (QCD) | gluones | 1038 |  |

10-15 |

| Electromagnética | Electrodinámica cuántica (QED) | fotones | 1036 |  |

|

| Débil | Teoría electrodébil | bosones W y Z | 1025 |  |

10-18 |

| Gravitatoria | Gravedad cuántica | gravitones (hipotéticos) | 1 |  |

|

La teoría cuántica de campos es el marco general dentro del cual se inscriben la cromodinámica cuántica, la teoría electrodébil y la electrodinámica cuántica. Por otra parte la “gravedad cuántica” actualmente no consiste en un marco general único sino un conjunto de propuestas que tratan de unificar la teoría cuántica de campos y la relatividad general.

Van surgiendo por ahí nuevas conjeturas como, por ejemplo, las de Maldacena.

“Las consecuencias de esta conjetura son muy importantes, pues existe la posibilidad de que el resto de interacciones (electromagnéticas y nucleares) sean tan sólo una ilusión, el reflejo sobre el cristal de un escaparate del contenido de la tienda. Así, podría ser que el electromagnetismo tan sólo sea la imagen proyectada de la interacción de algunas cuerdas en un supuesto interior del espacio-tiempo. De la misma manera, la necesidad de compactificar las dimensiones adicionales desaparece en cierto modo si consideramos que, quizás, nuestro mundo sea solamente la frontera; siendo el interior del espacio-tiempo inaccesible.”

Que gran sorpresa sería si al final del camino se descubriera que en realidad solo existe una sola fuerza: La Gravedad, de la que se derivan las otras tres que hemos podido conocer en sus ámbitos particulares y que, ¿por qué no? podrían surgir a partir de aquella primera y única fuerza existente en los principios o comienzos del Universo: ¡La Gravedad! Que no acabamos de comprender.

emilio silvera

Feb

21

Antimateria y otros enigmas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Antimateria ~

Clasificado en Antimateria ~

Comments (0)

Comments (0)

En cualquier sitio que busquemos datos para saber sobre la antimateria, nos podemos encontrar con explicaciones como ésta:

“En física de partículas, la antimateria es la extensión del concepto de antipartícula a la materia. Así, la antimateria está compuesta de antipartículas, mientras que la materia ordinaria está compuesta de partículas. Por ejemplo, un antielectrón (un electrón con carga positiva, también llamado positrón) y un antiprotón (un protón con carga negativa) podrían formar un átomo de antimateria, de la misma manera que un electrón y un protón forman un átomo de hidrógeno. El contacto de materia y antimateria llevaría a la aniquilación de ambas, dando lugar a fotones de alta energía (rayos gamma) y otros pares partícula-antipartícula.”

Lo cierto es que solo vemos materia

“La desconcertante prevalencia de la materia sobre la antimateria en el universo podría estar relacionado con un extraño estiramiento del espacio-tiempo causado por el giro de nuestra galaxia, según un nuevo estudio”.

De tonterias como esa están las revistas científicas llenas. Ya no saben lo que hacer por llamar la atención y, en cualquier mente lógica medianamente “leída”, se puede llegar a la conclusión de que, como en el Universo todo es cuestión de equilibrios entre fuerzas contrapuestas, mejor sería pensar en la existencia de un universo paralelo de antimateria.

La antimateria es el pariente primo de la materia. Por cada partícula de materia se cree que existe su pareja de antimateria, con la misma masa, pero de carga opuesta. Cuando la materia y la antimateria se encuentran, se aniquilan, y de la conversión de su masa en energía resulta una poderosa explosión.

Aunque hoy en día, los científicos siguen sin entender por qué en el universo predomina, casi completamente la materia. De hecho, aunque la han buscado con insistencia, la antimateria del universo primordial…no aparece por ninguna parte.

Baryogenesis es el término aplicado al proceso teórico en la cosmología moderna que condujo a un desequilibrio entre baryons y anti-baryons en el universo temprano. Este desequilibrio, conocido como asimetría bariónica, es uno de los misterios más profundos de la cosmología moderna.

Según todos los estudios de experimentos y observaciones que han sido llevados a la práctica por Equipos de estudiosos en todo el Mundo, parece ser que, los motivos por los que no se han encontrado grandes estructuras de antimateria en nuestro Universo, y, el hecho de que la Materia supere a la antimateria, es denominado como “Bariogénesis”, es decir, la Materia Bariónica que es la que observamos y emite radiación (Planetas, estrellas, galaxias, etc.) es la que, finalmente, ha quedado predominando en este Universo nuestro (dejando a un lado esa otra clase de materia que llamamos Oscura y que, de ser cierto que existe, debió crearse antes que la Bariónica, sería la primera clase de materia que hizo acto de presencia en el Universo y, la Fuerza de Gravedad que generaba, hizo posible que, a pesar de la expansión de Hubble, se formaran las estrellas y las galaxias.

¿Por qué en el comienzo del Universo podría la materia Bariónica superar a la antimateria?

–Pequeño exceso de materia tras el Bib Bang: Especula con que la materia que forma actualmente el universo podría ser el resultado de una ligera asimetría en las proporciones iniciales de ambas.

–Asimetría CP. Un reciente experimento en el acelerador KEK de Japón sugiere que esto quizás sea cierto, y que por tanto no es necesario un exceso de materia en el Big Bang: simplemente las leyes físicas que rigen el universo favorecen la supervivencia de la materia frente a la antimateria.

–Existencia de galaxias de antimateria ligada por antigravedad: Muy pocos científicos confían en esta posibilidad, pero todavía no ha podido ser completamente descartada. Esta tercera opción plantea la hipótesis de que pueda haber regiones del universo compuestas de antimateria. Hasta la fecha no existe forma de distinguir entre materia y antimateria a largas distancias, pues su comportamiento y propiedades son indistinguibles. (Esta opción parece poco probable).

La ecuación de Dirac, formulada en en 1928, predijo la existencia de antipartículas además de las partículas de materia ordinarias. Desde entonces, se han ido detectando experimentalmente muchas de dichas antipartículas: Carl D. Anderson, en el Caltech, descubrió el positrón en 1932. Veintitrés años después, en 1955, Emilio Sègre y Owen Chamberlain, en la universidad de Berkeley, el antiprotón y antineutrón.

Pero la primera vez que se pudo hablar propiamente de antimateria, es decir, de “materia” compuesta por antipartículas, fue en 1965, cuando dos equipos consiguieron crear un antideuterón, una antipartícula compuesta por un antiprotóny un antineutrón. La antipartícula fue lograda en el Acelerador Protón Sincrotrón del CERN, a cargo de Antonio Zichichi, y paralelamente por Leon Lederman en el acelerador AGS (Alternating Gradient Synchrotron) del Laboratorio Nacional de Brookhaven, en Nueva York.

En 1995, el CERN anunció la creación de nueve átomos de antihidrógeno en el experimento PS210, liderado por Walter Oelert y Mario Macri, y el Fermilab confirmó el hecho, anunciando poco después la creación a su vez de 100 átomos de antihidrógeno.

El 14 de Diciembre de 2.009, científicos de la NASA con la ayuda del telescopio espacial de rayos gamma Fermi, descubrieron rayos de antimateria producidos encima de tormentas eléctricas. El fenómeno es causado por ráfagas de rayos gamma terrestres (TGF) generadas al interior de las tormentas eléctricas y asociados directamente con los relámpagos.

La antimateria es un término que se ha hecho muy común y familiar en los últimos años, y, han sido muchos los que han tratado de buscarla en los confines del Universo. No parece que el resultado obtenido sea muy alentador.

Si la antimateria realmente existiera en su forma natural, no habría que buscarla en los confines del Universo, estaría, como es lógico pensar, por todas partes. Así que, lo mejor será hacernos a la idea de que en aquellos comienzos el exceso de materia bariónica prevaleció y fue la única que quedó para formar los objetos que ahora podemos ver repartidos por todo el Cosmos en forma de estrellas, de mundos, galaxias, y otros de múltiples formas y fases.

Se ha logrado capturar partículas de antimateria en los Aceleradores de partículas y, con ellas, se han realizado pruebas que han venido a confirmar que, cuanto la Materia se encuentra con la antimateria, la destrucción está asegurada. El resultado de dicha colisión podrían ser muchas de las grandes fuentes de energía Gamma que se han detectado en algunas regiones del Universo.

He aquí la primera imagen jamás obtenida de antimateria, específicamente un “anti-átomo” de anti-hidrógeno. Este experimento se realizó en el Aparato ALPHA de CERN, en donde los anti-átomos fueron retenidos por un récord de 170 milisegundos (se atraparon el 0.005% de los anti-átomos generados).

Producir antipartículas es relativamente “fácil”. De hecho ocurre habitualmente en la naturaleza, en un tipo de desintegración radioactiva denominada “desintegración beta”. También se producen con los rayos cósmicos, que son partículas de altas energías que llegan a la atmósfera y al interaccionar con ella se producen cascadas de partículas.

Pero producir antiátomos es mucho muy difícil, y almacenarlos todavía más. Generar estructuras más complejas, como una mesa de antimateria, actualmente es imposible y de momento no conocemos ninguna forma para poderlo hacer en el futuro.

A finales de 2009 años fuimos testigos de la explosión más grande jamás registrada: una estrella supergigante en el límite posible de la masa permitida, muchas veces más grande que el Sol completamente destruida por reacciones termonucleares increiblemente veloces provocada por la producción de antimateria de rayos gamma. La explosión resultante fue visible durante meses, ya que desató una nube de material radiactivo más de cincuenta veces el tamaño de nuestra propia estrella, dándole un resplandor visible a partir de la fisión nuclear y a pesar de la distancia a la que se hallaba situada la galaxia portadora de la estrella.

Una explosión Gamma captada por la NASA

Desde nuestra madre Tierra, el cielo nocturno puede parecer tranquilo e inmutable, pero el universo visto en rayos gamma es un lugar de violencia repentina y caótica. Utilizando telescopios sensibles a los rayos gamma, los astrónomos son testigo de explosiones breves pero tremendamente intensas, llamadas explosiones de rayos gamma. No existe nada más potente. Cuando se produce encuentros entre Marteria y Anti-materia, aparecen las fuentes de energías más potentes conocidas en el Universo.

Si cuando se produjo el Big Bang, la creación de materia y antimateria hubiera sido simétrico, ahora, la materia bariónica que forman los objetos que podemos contemplar, no existiría y se habría destruido mediante la interacción de ambos tipos de materia. Sin embargo, al parecer, en el reparto que hizo la Naturaleza, la mayor parte le tocó a la Materia y, de ahí que, cuando se destruyó toda la materia y antimateria que suponía la misma proporción, quedó el exceso existente de Materia que es, precisamente, la que forma las estrellas y los mundos.

“Desafortunadamente, el uso de anti-materia podría ser objeto de abuso por usarlo como un arma para disparar reacciones de fusión nuclear. Fuerza Aérea de los Estados, sin embargo, se ha interesado en el uso militar – incluyendo aplicaciones destructivas – antimateria desde la Guerra Fría, cuando comenzó a financiar la investigación de la física de la antimateria. Las principales ventajas teóricas de este tipo de armas es que la antimateria y la materia se cumplen convertir la mayoría de las armas de destrucción masiva en explosión de energía mucho más grande que las reacciones de fusión nuclear. El comportamiento frente a los aspectos fundamentales como el ingeniero que prioriza el bienestar de las personas.”

Acelerador AGS (Alternating Gradient Synchrotron) del Laboratorio Nacional de Brookhaven.

Aquí se buiscó la anti-materia y, desde luego, como sabemos que su contacto con la materia crea o da como resultado la dustrucción de ambas en forma de energía pura… ¿qué intenciones tenían en buscarla?

Nunca, por uno u otro Organismo, se ha dejado de buscar la antimateria en el Universo, y, los escasos resultados obtenidos hasta el momento son, hasta cierto punto comprensibles, toda vez que, si como se cree, la mayor parte fue eliminada al encontrarse con la materia, los residuos que puedan estar ahí, teniendo en cuenta las dimensiones del Universo, no serán fáciles de encontrar.

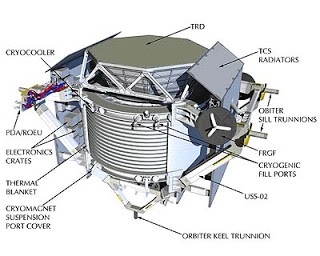

El Premio Nobel de Física en 1976 Samuel Ting ha expresado su esperanza de que el experimento que lleva a cabo el laboratorio europeo de partículas Cern y su proyecto de enviar un gran imán al espacio permitan descubrir donde se esconde la antimateria en el universo. El gran colisionador de hadrones (LHC) del Cern, ha logrado en sus experimentos reproducir en laboratorio un mini Big-Bang similar al que podría haber dado origen al Universo hace unos 13.700 millones de años, a base de iones de plomo, lo que ha generado una especie de sopa o plasma de quarks y gluones que ahora los científicos tratan de analizar.

Ting, que colabora con el Cern, lideró por su parte una iniciativa para colocar en órbita el espectómetro magnético Alfa (AMS, de sus siglas en inglés), un gran imán que sería situado en órbita espacial con el objetivo de detectar la presencia de antimateria en otras galaxias. “Encontrar antimateria sería muy importante porque permitiría destruir muchas de las teorías actuales”, dijo el investigador estadounidense, que ha sido invitado por el programa ConCiencia de la Universidad de Santiago de Compostela (USC) a una serie de conferencia y actos de divulgación científica. En una conferencia de prensa, Ting aseguró que “el tiempo no es importante” para descubrir dónde se encuentra la antimateria producto de la explosión al origen del Universo, aunque precisó que el AMS estará “durante 20 años” analizando su presencia entre las cien millones de galaxias que calcula que lo integran.”

Bueno, de todas las maneras, esperemos que, si algún día encontramos abundancia de antimateria en el Universo, no sea utilizada para prácticas militares. Por otra parte, como la antimateria es exactamente igual que la materia a excepción de las cargas que son opuestas (electrón-positrón), esperemos que no existan mundos de antimateria con seres que lo pueblen, ya que, si alguna vez nos encontramos con alguno, lo mejor será no saludarlo con un apretón de manos.

Físicos de Estados Unidos y Canadá, propusieron una nueva partícula que podría resolver dos importantes misterios de la física moderna: ¿Qué es la materia oscura y por qué hay mucha más materia que antimateria en el universo?

La aún por descubrir “partícula X”, se espera que decaiga mayormente en materia normal, mientras que su antipartícula se espera que decaiga mayormente en antimateria “oculta”. El equipo afirma que su existencia en los inicios del universo podría explicar por qué hay más materia que antimateria en el universo – y que la materia oscura es, de hecho, antimateria oculta.

Como podreis ver, por teorizar, especular, lanzar hipótesis y exponer cuestiones imaginativas…Que no quede. Todos tenemos nuestras propias ideas y, desde luego, no siempre van encaminadas en la dirección correcta. ¿Partícula X? ¿Qué está pasando? ¿De qué estamos hablando?

Lo cierto es que el Universo sabe muy bien como tenernos entretenidos.

emilio silvera

Totales: 77.732.870

Totales: 77.732.870 Conectados: 51

Conectados: 51