Ene

4

¡Nuestra curiosidad! ¿Nos pasará lo que le pasó al gato?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en De lo pequeño a lo grande ~

Clasificado en De lo pequeño a lo grande ~

Comments (3)

Comments (3)

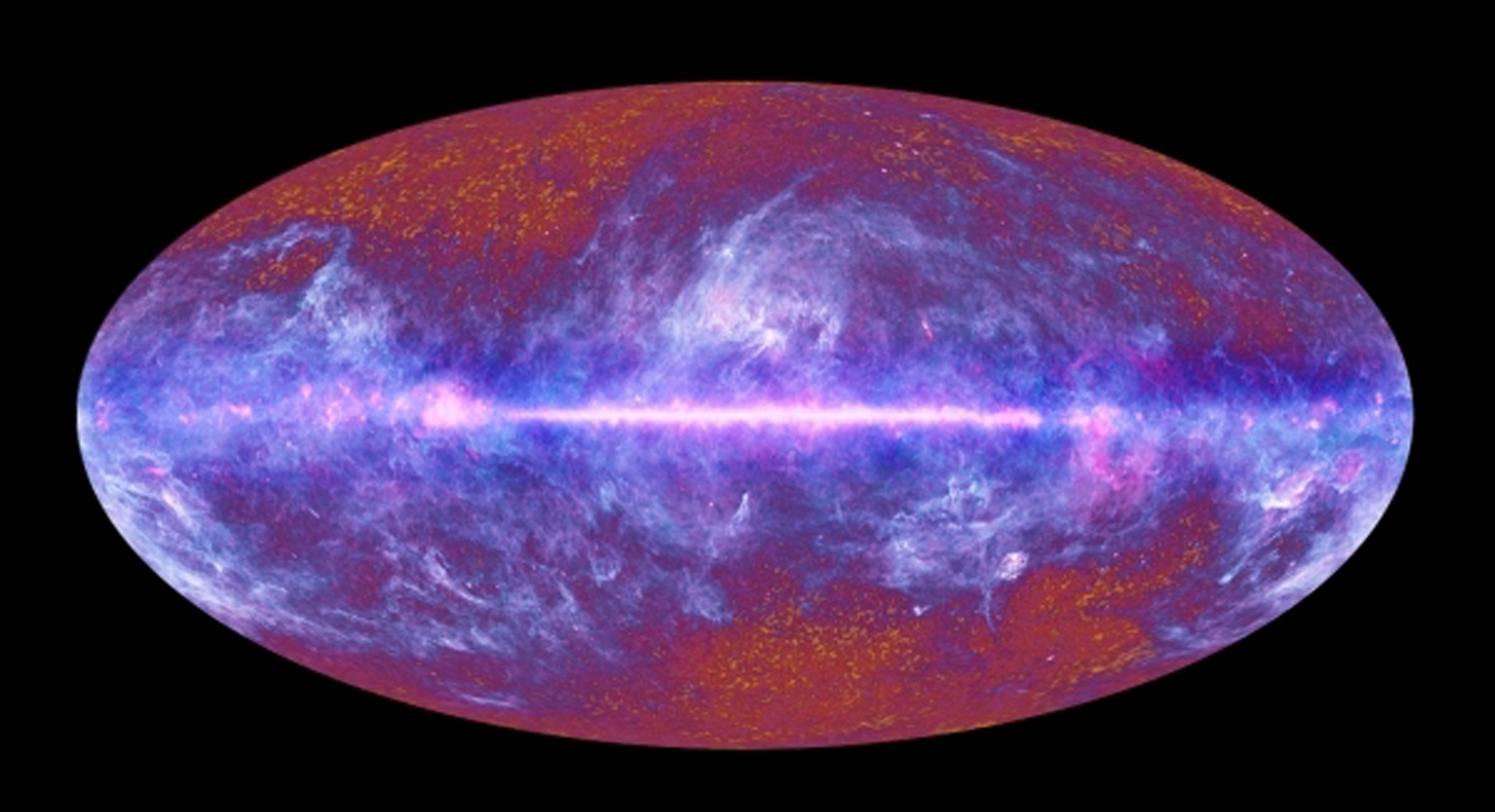

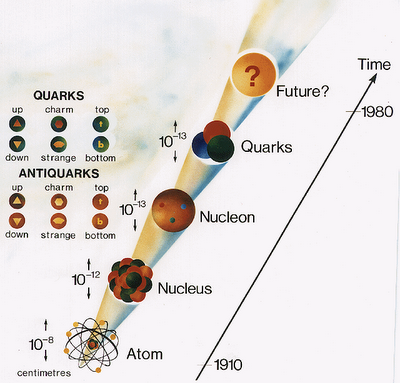

Hemos llegado a poder discernir la relación directa que vincula el tamaño, la energía de unión y la edad de las estructuras fundamentales de la Naturaleza. Ahora, hemos llegado a comprender muchas de las cosas que, hasta bien poco tiempo, eran auténticos secretos que, el Universo, celosamente se guardaba, y, esa comprensión, nos llevará más lejos y nos permitirá realizar un largo camino hacia el corazón mismo de la materia, donde según parece, pueden resider infinitesimales objetos más pequeños que los Quarks, en esa distancia inalcanzable ahora que hemos llamado, el Límite de Planck.

Una molécula es mayor y más fácil de desmembrar que un átomo; lo mismo podemos decir de un átomo respecto al núcleo atómico, y de un núcleo con respecto a los quarks que contiene. Sion embargo, nos queda la duda de: ¿qué podrá haber más allá de los Quarks?

¿estructura fundamental?… (¿)

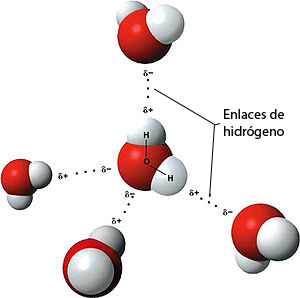

La cosmología sugiere que esta relación resulta del curso de la historia cósmica, que los quarks se unieron primero, en la energía extrema del big bang original, y que a medida que el Universo se expandió, los protones y neutrones compuestos de quarks se unieron para formar núcleos de átomos, los cuales, cargados positivamente, atrajeron a los electrones cargados con electricidad negativa estableciéndose así como átomos completos, que al unirse formaron moléculas.

Molécula H2O

Si es así, cuanto más íntimamente examinemos la Naturaleza, tanto más lejos hacia atrás vamos en el tiempo. Alguna vez he puesto el ejemplo de mirar algo que no es familiar, el dorso de la mano, por ejemplo, e imaginemos que podemos observarlo con cualquier aumento deseado.

Con un aumento relativamente pequeño, podemos ver las células de la piel, cada una con un aspecto tan grande y complejo como una ciudad, y con sus límites delineados por la pared celular. Si elevamos el aumento, veremos dentro de la célula una maraña de ribosomas serpenteando y mitocondrias ondulantes, lisosomas esféricos y centríolos, cuyos alrededores están llenos de complejos órganos dedicados a las funciones respiratorias, sanitarias y de producción de energía que mantienen a la célula.

Ya ahí tenemos pruebas de historia. Aunque esta célula particular solo tiene unos pocos años de antigüedad, su arquitectura se remonta a más de mil millones de años, a la época en que aparecieron en la Tierra las células eucariota o eucarióticas como la que hemos examinado.

Para determinar dónde obtuvo la célula es esquema que le indicó como formarse, pasemos al núcleo y contemplemos los delgados contornos de las macromoléculas de ADN segregadas dentro de sus genes. Cada una contiene una rica información genética acumulada en el curso de unos cuatro mil millones de años de evolución.

Macromolécula

Almacenado en un alfabeto de nucleótidos de cuatro “letras”- hecho de moléculas de azúcar y fosfatos, y llenos de signos de puntuación, reiteraciones para precaver contra el error, y cosas superfluas acumuladas en los callejones sin salida de la historia evolutiva-, su mensaje dice exactamente cómo hacer un ser humano, desde la piel y los huesos hasta las células cerebrales.

célula cerebral

Si elevamos más el aumento veremos que la molécula de ADN está compuesta de muchos átomos, con sus capas electrónicas externas entrelazadas y festoneadas en una milagrosa variedad de formas, desde relojes de arena hasta espirales ascendentes como largos muelles y elipses grandes como escudos y fibras delgadas como puros. Algunos de esos electrones son recién llegados, recientemente arrancados átomos vecinos; otros se incorporaron junto a sus núcleos atómicos hace más de cinco mil millones de años, en la nebulosa de la cual se formó la Tierra.

Molécula de ADN

Si elevamos el aumento cien mil veces, el núcleo de un átomo de carbono se hinchará hasta llenar el campo de visión. Tales núcleos átomos se formaron dentro de una estrella que estalló mucho antes de que naciera el Sol. Si podemos aumentar aún más, veremos los tríos de quarks que constituyen protones y neutrones.

Átomo de Carbono

Los quarks han estado unidos desde que el Universo sólo tenía unos pocos segundos de edad. Una vez que fueron eliminados los antiquarks, se unieron en tripletes para formar protones y neutrones que, al formar un núcleo cargado positivamente, atrayeron a los electrones que dieron lugar a formar los átomos que más tarde, conformaron la materia que podemos ver en nuestro unioverso.

Al llegar a escalas cada vez menores, también hemos entrado en ámbitos de energías de unión cada vez mayores. Un átomo puede ser desposeído de su electrón aplicando sólo unos miles de electrón-voltios de energía. Sin embargo, para dispersar los nucleones que forman el núcleo atómico se requieren varios millones de electrón-voltios, y para liberar los quarks que constituyen cada nucleón se necesitaría cientos de veces más energía aún.

Los Quarks dentro del núcleo están sometidos a la Interacción fuerte, es decir, la más potente de las cuatro fuerzas fundamentales del Universo, la que mantiene a los Quarks confinados dentro del núcleo atómico por medio de los Gluones.

Introduciendo el eje de la historia, esta relación da testimonio del pasado de las partículas: las estructuras más pequeñas, más fundamentales están ligadas por niveles de energía mayores porque las estructuras mismas fueron forjadas en el calor del big bang.

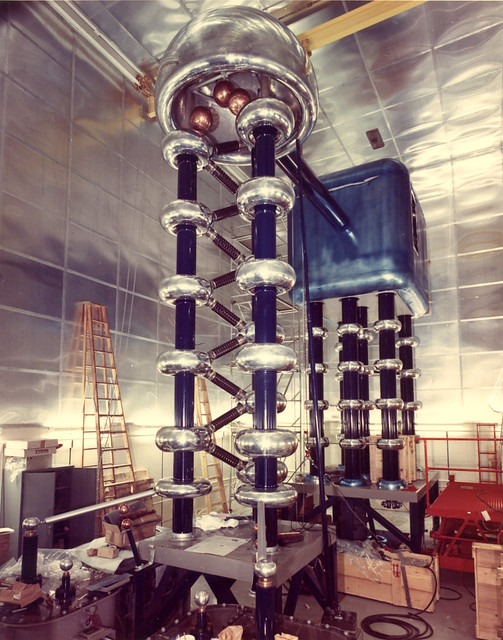

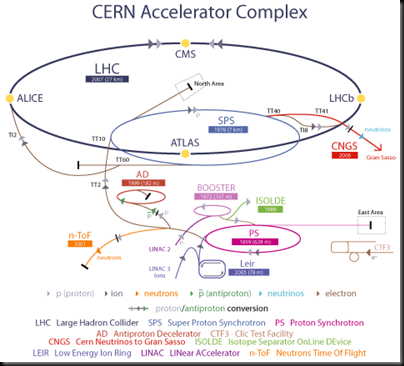

Esto implica que los aceleradores de partículas, como los telescopios, funcionen como máquinas del tiempo. Un telescopio penetra en el pasado en virtud del tiempo que tarda la luz en desplazarse entre las estrellas; un acelerador recrea, aunque sea fugazmente, las condiciones que prevalecían en el Universo primitivo.

El acelerador de 200 kev diseñado en los años veinte por Cockroft y Walton reproducía algunos de los sucesos que ocurrieron alrededor de un día después del comienzo del big bang.

Aquel acelerador nada tenía que ver con el LHC de ahora, casi un siglo los separa

Los aceleradores construidos en los años cuarenta y cincuenta llegaron hasta la marca de un segundo. El Tevatrón del Fermilab llevó el límite a menos de una milmillonésima de segundo después del comienzo del Tiempo. El nuevo supercolisionador superconductor proporcionara un atisbo del medio cósmico cuando el Universo tenía menos de una billonésima de segundo de edad.

El Tevatrón del Fermilab ya estaba en el camino de la modernidad en los avances de la Física

Esta es una edad bastante temprana: una diez billonésima de segundo es menos que un pestañeo con los párpados en toda la historia humana registrada. A pesar de ello, extrañamente, la investigación de la evolución del Universo recién nacido indica que ocurrieron muchas cosas aún antes, durante la primera ínfima fracción de un segundo.

Todos los teóricos han tratado de elaborar una explicación coherente de los primeros momentos de la historia cósmica. Por supuesto, sus ideas fueron esquemáticas e incompletas, muchas de sus conjeturas, sin duda, se juzgaran deformadas o sencillamente erróneas, pero constituyeron una crónica mucho más aclaradora del Universo primitivo que la que teníamos antes.

Recreación del Universo primitivo

Bueno amigos, el trabajo era algo más extenso y entrábamos a explicar otros aspectos y parámetros implicados en todo este complejo laberinto que abarca desde lo muy grande hasta la muy pequeño, esos dos mundos que, no por ser tan dispares, resultan ser antagónicos, porque el uno sin el otro no podría exisitir. Otro día (quedan muchos por delante en este año que comienza), seguiremos abundando en el tema apasionante que aquí tratamos.

emilio silvera

Ene

4

¿Será verdad todo lo que nos cuentan que es… el Universo?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo ~

Clasificado en El Universo ~

Comments (2)

Comments (2)

Como nos dice la filosofía, nada es como se ve a primera vista, todo depende del punto de vista desde el que miremos las cosas, de la perspectiva que nos permita nuestra posición física y, la intelectual también. No todos podemos ver las cosas de la misma manera. La imagen de abajo que es una Nebulosa como otras tantas, ¿qué te dice a tí? ¿qués es lo que ahí puedes ver? ¿qué deduces de los componentes de la nebulosa? ¿qué puede surgir de ahí y de otros lugares como este de abajo? ¿Cómo llegó a formarse tal conglomerado de gas y polvo?

La estabilidad del espacio-tiempo, de la materia y de la energía tal como los conocemos sería imposible y, a la postre, tampoco sería posible la belleza que esta estabilidad posibilita así como la propia inteligencia y armonía que, en cierta forma, subyace en todo el Universo.

“Lo primero que hay que comprender sobre los universos paralelos… es que no son paralelos. Es importante comprender que ni siquiera son, estrictamente hablando, universos, pero es más fácil si uno lo intenta y lo comprende un poco más tarde, después de haber comprendido que todo lo que he comprendido hasta ese momento no es verdadero.”

Douglas Adams

¿Qué vamos a hacer con esta idea antrópica fuerte? ¿Puede ser algo más que una nueva presentación del aserto de que nuestra forma de vida compleja es muy sensible a cambios pequeños en los valores de las constantes de la naturaleza? ¿Y cuáles son estos “cambios”? ¿Cuáles son estos “otros mundos” en donde las constantes son diferentes y la vida no puede existir?

Ene

4

¡Qué tiempos! ¡Que personaje! Vesalio

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del Saber ~

Clasificado en Rumores del Saber ~

Comments (1)

Comments (1)

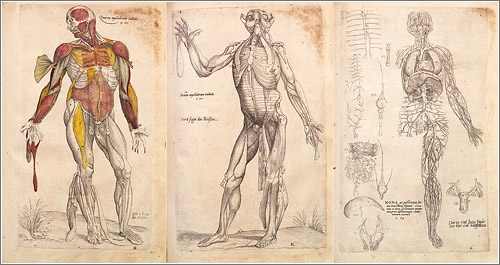

Andreas Vesalio (1514-1564), sin ser un genio universal, no dejo que nada le hiciera olvidar su principal interés. Nació junto a las murallas de la ciudad de Bruselas, desde donde se divisaba el monte en el que los criminales condenados eran torturados y ejecutados. De niño seguramente vio con frecuencia los cuerpos, que permanecían colgados hasta que las aves de presa dejaban los huesos limpios. Su padre era boticario del emperador Carlos V y la familia era bien conocida entre la profesión médica. A diferencia de Paracelso, Vesalio recibió la mejor educación médica que se podía obtener en su época. Se matriculó en la universidad de Lovaina en 1530, luego fue a la universidad de París, donde estudió con el profesor Silvio, renombrado defensor de Galeno. Cuando estalló la guerra entre Francia y el Sacro Imperio Romano, Vesalio, un extranjero enemigo, fue expulsado de París y hubo de regresar a Lovaina. Allí se licenció en medicina en el año 1537; luego se marchó a Papua, donde estaba la escuela de medicina de más prestigio en Europa. En Papua se sometió a dos días de exámenes y recibió el título de doctor en medicina magna cum laude. Debía de ser muy versado en el saber convencional, pues, a los veintitrés años, dos días después de pasar el examen, trabajaba ya en la cátedra de cirugía de aquella universidad.

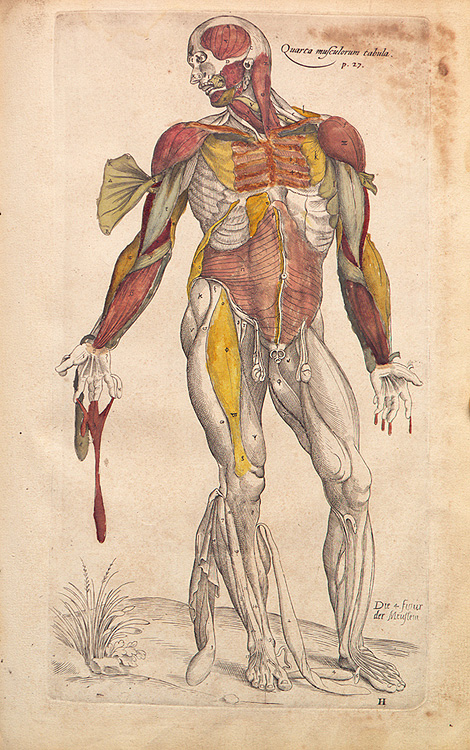

Vesalio en el examen de Padua

Cuando Vesalio tomó posesión de su cargo de profesión, dio un significado nuevo a la cirugía y la anatomía. Ya no consideraba que su principal deber era interpretar los textos de Galeno. Al dirigir la “anatomía“ (que en griego significa “cortar“ ) de rigor, él se apartaba de la tradición. A diferencia de los profesores que le habían precedido, Vesalio no permanecía sentado en su alta cátedra profesional mientras el barbero-cirujano extraía los órganos del cadáver con manos ensangrentadas. El propio Vesalio manipulaba el cuerpo y disecaba los órganos. Para ayudar a sus discípulos, preparó elementos didácticos auxiliares en la forma de cuatro gráficos anatómicos, lo suficientemente detallados como para mostrar a los alumnos el cuerpo humano cuando no se disponía de un cadáver. Cada parte estaba señalada con su nombre técnico. Un glosario anexo contenía una lista alfabética de todos los nombres de las partes del cuerpo en griego, latín, árabe y hebreo.

La utilización de gráficos fue una gran novedad. Durante la Edad Media apenas habían existido en Europa dibujos que sirvieran para los fines de la anatomía. En el siglo XVI, cuando se redescubrieron los textos de Galeno y fueron escrupulosamente editados, traducidos de nuevo e impresos, todavía no iban acompañados de ilustraciones. Algunos de los principales profesores de anatomía, entre los cuales estaba el respetado maestro de Vesalio, Silvio, se declararon en contra del uso de figuras y diagramas. ¡Los alumnos sólo debían leer el texto auténtico!

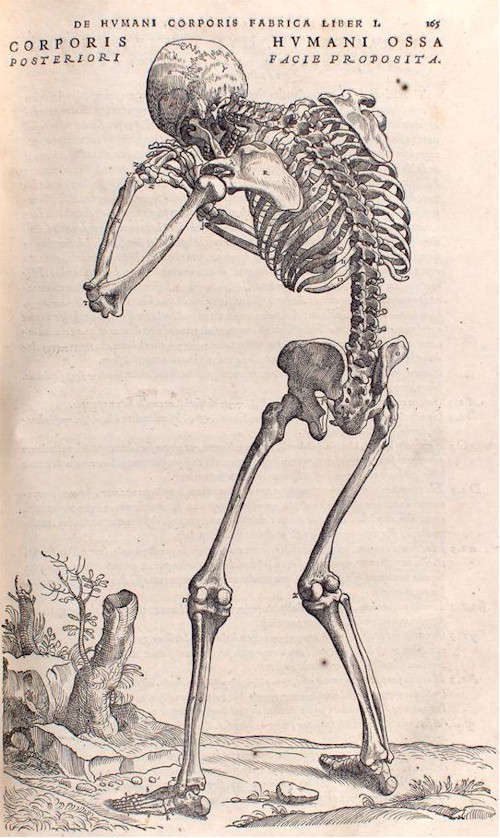

Las seis tablas anatómicas de Vesalio (Tabulae Anatomicae Sex, Venecia, 1538) constituyeron el primer esfuerzo por otorgar un contenido visual total a las enseñanzas de Galeno. Si en aquel tiempo no hubiera existido la imprenta, quizá Vesalio no hubiera sentido la tentación de publicar los gráficos que había preparado para sus discípulos. Pero cuando le plagiaron un gráfico y pensó que los demás podían correr la misma suerte, los publicó todos. Tres de ellos eran dibujos de esqueletos realizados por el discípulo holandés de Ticiano, Juan Esteban de Calcar, “desde los tres aspectos normales“ conocidos por todos los estudiantes de arte de la Edad Media. Las otras tres “tablas“ eran totalmente distintas en concepto: eran dibujos del propio Vesalio de las venas, las arterias y el sistema nervioso. Su novedad no residía tanto en aquello que representaban como en la forma en que lo hacían. Con estas “tablas “ anatómicas, Vesalio introdujo el método gráfico en anatomía. En la actualidad resulta sorprendente que hubiera que inventar algo tan evidente, pero si reflexionamos sobre ello no es tan sorprendente. Durante siglos, aunque los estudios de medicina de las mejores escuelas de Europa incluían algo de anatomía, las oportunidades de ver el interior de un cuerpo humano habían sido pocas y espaciadas.

No sólo los dogmas “humorales“, que eran el blanco especial de Paracelso, sino también la harto practicada astrología médica, pasaban por alto los detalles anatómicos. Los populares diagramas del “ hombre zodiacal “ simplemente mostraban la relación de cada parte del cuerpo con el correspondiente signo del zodíaco para indicar las temporadas mejores y las peores para determinadas curas. El término inglés influenza es una reliquia de esta relación. Cuando Vesalio estudió medicina, los doctores eruditos todavía usaban la palabra (tomada del italiano, que significa “influencia “ ) para describir los efectos médicos de una “influencia “ astral desafortunada. Al principio se refería a la declaración de una enfermedad epidémica y fue sinónimo de epidemia hasta que en el siglo XVIII comenzó a dársele el uso actual, es decir, para denominar un catarro o gripe y, en general, una afección respiratoria.

Después de las seis tablas anatómicas, a Vesalio todavía le quedaba mucho camino por recorrer, ya que en sus tablas, siguiendo a Galeno, una y otra vez saltaban en silencio de la anatomía animal a la humana. Por ejemplo, mostraban una rete mirabile, una “red maravillosa “, en la base del cerebro humano en la cual, según Galeno, el “espíritu vital “ del hombre se transformaba en “ espíritu animal “. Pero esta red, que se da en los animales ungulados. Sus dibujos de la forma del corazón, las ramificaciones del cayado de la aorta, la situación de los riñones y la forma del hígado, correspondían, como en el texto de Galeno, no a un hombre sino a un mono.

Sólo en raras ocasiones se examinaba el interior de un cuerpo Humano. Por ejemplo, el Emperador Federico II (1194-1250), famoso en toda Europa por sus variados talentos, quiso satisfacer su curiosidad respecto al proceso de la digestión humana. Un cronista informó que “dio una excelente comida a dos hombres, tras lo cual ordenó a uno que se echara a dormir y al otro que se fuera a cazar. La noche siguiente ordenó que se vaciaran sus estómagos en su presencia para ver cual había diferido mejor la comida, los cirujanos decidieron que el que se había ido a dormir era el que había hecho una mejor digestión. En 1.238, el emperador ordenó a la escuela de Medicina de Salerno que realizara una disección pública cada cinco años.

Durante las cruzadas se presentó una macabra oportunidad para estudiar el esqueleto humano: los cuerpos de los que morían eran descuartizados y hervidos para que sus huesos fueran enviados a su país de origen y ser enterrados debidamente. Esta costumbre estaba tan extendida que el Papa Bonifacio VIII prohibió su práctica en 1299 mediante una bula. Aunque muchos clérigos se oponían a la disección del cuerpo humano, parece que el papa nunca manifestó tal oposición.

Las disecciones, sin embargo, todavía parecían contrarias a la naturaleza y a la voluntad de Dios. También se llamaba “anatomizar” el provocar un parto mediante cesárea. En ocasiones, los Tribunales de Justicia ordenaban una autopsia para determinar si las heridas del fallecido habían sido la causa real de su muerte.

Cuando estaba en juego la salud de la comunidad, se toleraban e incluso se exigían las autopsias. Después de la peste negra de 1348, del Departamento de Salud Pública de Papua determinó que cuando una persona muriera por causas desconocidas, el cuerpo no podía ser enterrado sin el certificado de un médico que hubiera examinado el cadáver y hubiera determinado que no había indicios de la peste. Para descubrir los ganglios linfáticos inflamados, que constituían los síntomas de la enfermedad, era preciso practicar la disección del cuerpo, y los estudiantes de medicina de Papua aprendían de estos casos.

En ocasiones, las autopsias practicadas a personalidades cuya muerte hubiera despertado una inquietud generalizada añadían nuevos datos a la ciencia médica

Dado que los cuerpos de criminales ejecutados constituían la principal fuente de las autopsias, los cadáveres femeninos eran particularmente escasos, lo cual añadía otro obstáculo más al estudio de los procesos de la procreación y la gestación.

Muy lentamente la anatomía dejó de significar la abertura ocasional de un cuerpo para responder a alguna pregunta concreta y se fue convirtiendo en el estudio sistemático del cuerpo. Un compendio de anatomía elaborado por Mondito de Luzzi de Bolonia, 1316, que incorporaba algunas indicaciones de las autoridades árabes a Galeno, dominó la enseñanza de la anatomía galénica durante doscientos años. El orden de exposición de Mondito todavía era consecuencia de las urgencias de la época y describía primero los órganos de la cavidad abdominal, que eran los más perecederos y por tanto se dedicaban en primer lugar, continuando luego con los huesos, la espina dorsal y las extremidades. Mondito repitió los errores de siempre, ocasionados por la copia de la anatomía animal, y no añadió ningún elemento visual nuevo.

Como hemos visto, numerosos obstáculos prácticos se oponían al escrutinio sistemático del interior del cuerpo humano. La inexistencia de refrigeración hacía necesario que las anatomías se realizaran a toda prisa por motivos obvios. Incluso en las mejores Universidades sólo se llevaban a cabo estas operaciones una o dos veces al año, y, durante cuatro días y sus mal iluminadas noches que duraban estas raras operaciones, la muchedumbre de estudiantes de medicina, con los ojos hinchados, apenas tenían tiempo de hacer preguntas, de reflexionar o de mirar dos veces. Vesalio lo explicó de esa manera y repudiaba el sistema mediante el cual uno diseccionaba el cuerpo mientras otro explicaba.

La contribución de Vesalio al conocimiento del cuerpo humano no tiene precio

Durante siglos, los únicos cuerpos que eran diseccionados eran los pertenecientes a criminales, los cuales, en raras ocasiones estaban intactos. En Inglaterra con la horca, en Venecia y otros lugares era corriente la decapitación.

Los profesores ingeniosos aprovechaban cualquier oportunidad para hacerse con pedazos y partes de cuerpos humanos, con las consecuencias más desagradables imaginables. El eminente maestro de Vesalio, Jacobo Silvio, según cuenta uno de sus alumnos, tenía métodos propios.

“Le he visto llevarse en la manga, ya que ha vivido toda la vida sin criado, ora el muslo, ora el brazo de alguien que hubiera muerto ahorcado para disecarlo y anatomizarlo. Olían tan mal que algunos de sus oyentes hubieran vomitado si se hubieran atrevido; pero el pendenciero individuo de la cabeza picarda se hubiera irritado tan violentamente que hubiera amenazado con no regresar en una semana, y por eso todos guardaban silencio.”

Vesalio aprovechaba la oportunidad que se le presentaba, legal o ilegal, para recoger especimenes. Así lo relata el mismo en una de sus cartas en 1.536 que, no reproduzco aquí para no hacerlo más pesado, toda vez que el motivo del presente comentario está centrado, principalmente, en que todos los lectores se hagan una idea fidedigna de lo que pasaron los estudiosos de la ciencia del cuerpo humano por aquellos tiempos.

Vesalio había observado tantos ejemplos, mientras enseñaba a partir del texto de Galeno, de descripciones hechas por éste que no pertenecían al cuerpo humano, que muy pronto se dio cuenta de que la anatomía supuestamente “humana” de Galeno no era más que un compendio de afirmaciones sobre los animales en general.

“Consideré cuidadosamente –señaló Vesalio como una revelación, en 1539- la posibilidad de que la disección anatómica se utilizara para comprobar la especulación”. Entonces decidió elaborar un nuevo manual de anatomía basado por completo en sus propias observaciones del cuerpo humano. Para la anatomía Pública que realizó en Bolonia en 1540, Vesalio había armado dos esqueletos, uno de un mono y otro de un hombre, a fin de demostrar que el apéndice que según Galeno se extendía desde las vértebras hasta la cadera sólo aparecía en el mono.

Consideró esa discrepancia tan significativa que la ilustró de un modo especial en su Fábrica. En sus demostraciones anatómicas Vesalio insistía en que sus estudiantes vieran, tocaran y decidieran por sí mismos. A los alumnos que preguntaban si las arterias seguían realmente el movimiento del corazón, Vesalio respondía: “No quiero dar mi opinión, toquen ustedes con sus propias manos y confíen en ellas.

Los estudios de anatomía de Vesalio culminaron con el libro que le valió la fama a medida que se difundía por Europa. La Estructura del Cuerpo Humano (De humanis corporis fabrica), llamado comúnmente la Fabrica, un volumen de tamaño folio de 663 páginas muy bien impreso que, apareció en el año 1.543, el mismo año de Revolutionibus de Copérnico. Destinado a ser en anatomía lo que la obra de Copérnico fue para la Astronomía, hubiera justificado el trabajo de toda una vida, pero su autor lo terminó en algún momento entre su vigésimo sexto y su vigésimo octavo cumpleaños.

Hasta aquí, un resumen de la pequeña historia que he recogido de Vesalio, un personaje que, como todos comprenderéis, no ha sido valorado en la justa medida de lo que hizo, y, la Ciencia en general y la anatomía en particular, está en deuda con él y, desde aquí, le rendimos este humilde homenaje a un trabajo difícil, bien hecho y en condiciones deplorables.

emilio silvera

Ene

3

El vacío superconductor – La máquina de Higgs-Kibble

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

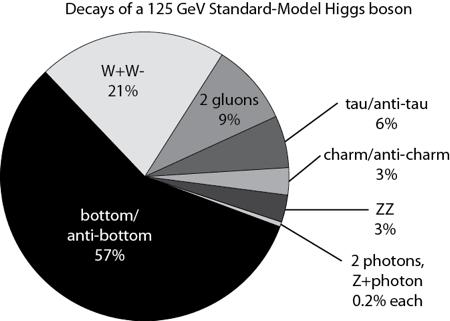

¿Los campos de Higgs? Hablemos un poco del tema Higgs.

Por su parte, el científico británico Peter Higgs, de 80 años, que dio su nombre a la llamada “partícula divina” (de Lederman), afirmó creer que su Bosón sería hallado gracias al Gran Colisionador. “Creo que es bastante probable” dijo pocas horas después de que entrara en funcionamiento el gigantesco acelerador. Y, según parece (al menos eso afirman algunos), se está saliendo con la suya.

De todas las maneras, estaría bien saber, a ciencia cierta, cómo es el campo de Higgs del que toman la masa todas las partículas, y conocer, mediante que sistema se transfieren la masa, o, si cuando las partículas entran en el campo de Higgs e interaccionan con él, es el efecto frenado el que les otorga la masa.

Claro que, esa, como otras conjeturas sobre los Océanos de Higgs y su dichosa Partícula “repartidora de masa”, no son más que conjeturas que, más adelante, debemos ir comprobando para poder escribirlas con letras de oro en el Libro de la Física, o, por el contrario, desecharlas como se ha hecho con tántas otras ideas y teorías frustradas que nunca llegaron a ninguna parte.

¡Los fotones de Yang-Mills adquieren su masa y el proncipio gauge se sigue cimpliendo! Al principio esta visión no mereció la atención que merecía. Por una parte, la gente penso que el modelo era feo. El principio gauge estaba ahí, pero ya no era el tema central. El “Campo de Higgs” había sido puesto ahí “a propósito” y la “partícula de Higgs”, en sí misma, no era una “partícula gauge”. Si se admitía esto, ¿por qué no introducir más partículas y campos arbitrarios? Estas ideas se consideraron como simples modelos con los que jugart, sin mucho significado fundamental al que ahora se quiere llegar con el LHC pretendiendo hacer bueno todo aquello y, al menos los físicos, insisten en que, el campo y la partícula están ahí…¡ya veremos en qué queda todo esto! Son muchos los cabos sueltos y las cosas sin explicar.

En segundo lugar estaba lo que se llamó “teorema de Goldstone”. Ya se habían priducido antes modelos de partículas con “rotura espontánea de simetría”, pero para la mayoría de esos modelos, Jeoffrey Goldstone habia probado que siempre contenían partículas sin masa y sin espín. Muchos investigadores, por lo tanto, pensaron que la teoría de Higgs también debía contener esa partícula de Goldstone, sin masa y que esto era un inconveniente porque entre las partículas conocidas no había ninguna partícula de Goldstone. Incluso el propio Goldstone había advertido que el Modelo de Higgs no satisfaccía las condiciones para su demostración, así que no tenía que ser válido para este caso, pero todo el mundo estaba tan impresionado con las matemáticas del teorema que el Modelo de Huggs-Kibble no tuvo éxito durante mucho tiempo.

El bosón de Higgs pretende ser una parte integral de nuestra comprensión de la Naturaleza. Se trata de una partícula que es una excitación de lo que se llama el campo de Higgs. El campo de Higgs impregna todo el espacio y cuando algunas de las partículas fundamentales que viajan a través de este campo adquieren masa (al interaccionar con el Campo dónde, probablemente, ve frenada su marcha y su desplazamiento es más lento debido al medio por el que discurre su viaje). La cantidad de masa que adquieren depende de la fuerza en que interactúan con el campo de Higgs. Algunas particulas, como el electrón adquieren una pequeña masa, mientras que otras adquieren una masa mucho mayor.

Y así, el teorema de Goldstone se utilizó como un “teorema de imposibilidad”: si el espacio vacío no es simétrico, entonces no se puede evitar la presencia de partículas sin masa y sin espín. Ahora sabemos que, en nuestro caso, la letra pequeña invalida el teorema; las partículas de Goldstone se hacen incisibles debido a la invariancia gauge y no son más que las “partículas fantasmas” que encontró Feynman en sus cáculos. Además, debemos recordar que el Mecanismo Higgs no es una auténtica rotura de simetría.

Ingenios que quieren entrar en los campos de Higgs

Un aspecto peculiar de esto es que este campo de Higgs que impregna en todo el espacio es parte de lo que llamamos espacio vacío o el vacío. Es sólo su impacto sobre las partículas que viajan a través de él y el bosón de Higgs que podemos observar en el laboratorio. El bosón de Higgs vive por un lapso muy corto de tiempo, así que no lo observan directamente, sino que más bien se observa que las partículas se descompone en y tienen que inferir su existencia a partir de eso. En la teoría actual que tenemos para comprender la naturaleza podemos hacer afirmaciones precisas acerca de qué fracción del tiempo que se desintegra en dos fotones en comparación con dos quarks abajo.

Claro que, algunos, me piden más profundidad en las explicaciones y, no se conforman con pasar por encima de las cuestiones, hay que entrar más en materia y dejar sentados algunos de los parámetros maemáticos que en todo esto están presente, y, para ellos…

Los físicos han buscado al bosón de Higgs por cerca de 50 años porque su descubrimiento completaría el Modelo Estándar de la física de partículas. El bosón de Higgs y su campo asociado explican cómo la simetría electrodébil se rompió justo después del Big Bang, lo que le dio a ciertas partículas elementales la propiedad de la masa. Sin embargo del Modelo Estándar no predice la masa de Higgs, y varios programas experimentales en el LEP del CERN, en el Tevatron de Fermilab y ahora el LHC del CERN habían intentado medir la masa de la partícula.

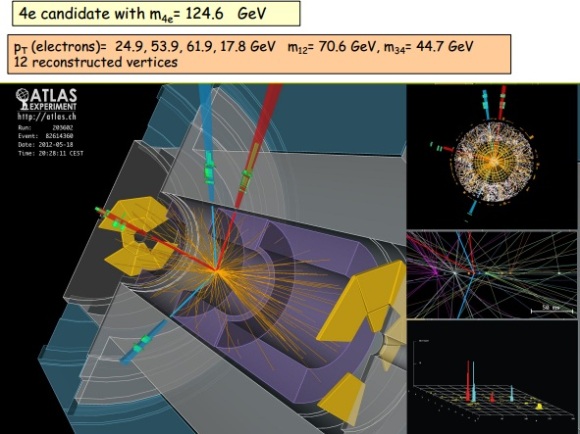

En el seminario llevado a cabo hoy en CERN como preludio a la mayor conferencia de física de partículas de este año, el ICHEP2012 en Melbourne, los experimentos ATLAS y CMS presentaron sus resultados preliminares en la búsqueda del Bosón de Higgs. Ambos experimentos observaron una nueva partícula en la región de masa entre 125-126 GeV.

“Observamos en nuestros datos claras señales de una nueva partícula, al nivel de 5 sigma, en la región de masa alrededor de 126 GeV. El impresionante rendimiento del LHC y ATLAS y el gran esfuerzo de mucha gente nos trajo a esta excitante etapa”, dijo la presentadora del experimento ATLAS Fabiola Gianotti, “pero se necesita más tiempo para preparar estos resultados para su publicación”

“Los resultados son preliminares pero la señal 5 sigma alrededor de 125 Gev que estamos viendo es dramática. Ésta es de hecho una nueva partícula. Sabemos que tiene que ser un bosón y es el bosón más pesado que hemos encontrado hasta ahora,” dijo el presentador del experimento CMS Joe Incandela. “Las implicaciones son muy significantes y es precisamente por esta razón que debemos ser extremadamente diligentes en todos nuestros estudios.”

¿Donde aparece el Higgs en todo esto?

Pues pasemos a hablar de teoría cuántica de campos, en ese tendremos unas densidades lagrangianas que dependerán del campo de cada partícula, dependiendo de su spin será un lagrangiano o otro, por ejemplo para N (a = 1,….N) campos escalares . Al buscar el mínimo del potencial (en realidad un extremal de la acción, pero para lo que nos interesa a nosotros serán mínimos) resulta que hay varios posibles (con el mismo valor) pero para que la energía se minimice hace falta fijar un vacío (debido a que el Hamiltoniano depende del potencial y de unos términos positivos que van con las derivadas del campo). Ahora bien, inicialmente nuestra acción podría tener una simetría gauge global, es decir que al efectuar una transformación de un grupo

sobre los campos la acción no cambia, al fijar el vacío la simetría se reduce a un subgrupo

y algunos campos obtienen masa (originalmente ninguno tiene masa), pues bien el teorema de Goldstone lo que dice es que

campos se quedan sin masa, estos son los bosones de Goldstone.

¿Y el higgs? ¬¬

Ya llegamos, en el apartado anterior hemos considerado transformaciones globales, pero por ejemplo en electromagnetismo tenemos transformaciones locales, así que hay que mirar lo que pasa en las transformaciones locales. Lo primero que pasa es que la derivada parcial no preserva los vectores (lo que hemos llamado antes

) igual que pasa en relatividad general, al hacer una transformación que depende de las coordenadas la derivada ya no es covariante, así que hay que buscar una covariante para seguir con lo que sabemos (en este caso la transformación se debe a un grupo gauge arbitrario, que no tiene porque ser el de difeomorfismos como en relatividad general. En este contexto aparecen los campos gauge que jugaran un papel similar al de la conexión en relatividad general y en el caso del electromagnetismo el campo gauge es el potencial electromagnético). Ahora al ser transformaciones locales, aparecen campos gauge que por similitud con el electromagnetismo escribiremos el lagrangiano de Yang-Mills

igual que en el electromagnetismo F depende de los campos gauge, pero debido a que

no es abeliano hay un termino extra que tiene que ver con las constantes de estructura del álgebra de Lie,

. Ahora ya vien lo bueno, aparte del lagrangiano de la partícula también tenemos el de Yang-Mills, resulta que debido a la simetría local:

- Los bosones de Goldstone desaparecen, es decir no son partículas físicas.

campos gauge obtienen masa

Pues eso es el efecto Higgs. Ahora para llegar ya al famoso bosón, en el modelo estandar no se pueden construir terminos de masa para las partículas debido a que no se pueden acoplar adecuadamente para ese propósito los campos de Yang-Mills y las partículas, debido a las simetrías que deben satisfacer (en general el famoso aunque cada campo tendrá una simetría concreta) y ahí es donde entra el bosón de Higgs, ya que el modelo más sencillo para añadir masa es justamente ese, añadir un doblete de campos escalares complejos y al romper la simetría …….. Higgs !!!!

Dos prestigiosos investigadores habían sugerido de forma independiente que se podían construir modelos realistas dde partículas en los cuales, el sistema de Yang-Mills fuera responsable de la interacción débil y el mecanismo de Higgs-Kibble la causa de su corto alcance. Uno de ellos era el paquistaní Abdus Salam que estaba buscando modelos estéticos de partículas y pensó que la belleza de la idea de Yan-Mills era razón suficiente para intentar construir con ella un modelo de interacción débil. La partícula mediadora de la interacción débil tenía que ser un fotón de Yang-Mills y el mecanismo de Higgs-Kibble la única explicación aceptable para que esta partícula tuviera una cierta cantidad de masa en reposo.

Una simetría puede ser perfecta en el plano de las ecuaciones y resultar rota en el plano de las soluciones. Como decía Weinberg: «Aunque una teoría postule un alto grado de simetría, no es necesario que los estados de las partículas muestren la simetría. Nada me parece tan halagüeño en física como la idea de que una teoría puede tener un alto grado de simetría que se nos oculta en la vida ordinaria».

La teoría que unifica las interacciones electromagnéticas y débil se debe a Glashow, Salam y Weinberg que obtuvieron por ella el Premio Nobel de física de 1979. La dificultad esencial de esta teoría es que los bosones del estado inicial simétrico debían ser de masa nula (masa nula de los bosones de interacción origina una fuerza a gran distancia), mientras que se necesitan bosones intermedios (partículas que originan la fuerza) muy masivos para justificar la interacción débil (corto alcance) . El mecanismo de Higgs, permite resolver esa dificultad, mediante la ruptura espontánea de simetría hace masivos los bosones W y Z (interacción débil) y mantiene nula la masa del fotón (interacción electromagnética).

Los famosos diagramas de Feynaman, nos explican algunos mecanismos de los que se pueden producir (de hecho se producen) en ese misterioso campo de las partículas elementales cuando están presentes en cuertos lugares y se juntas con otros individuos de la especie.

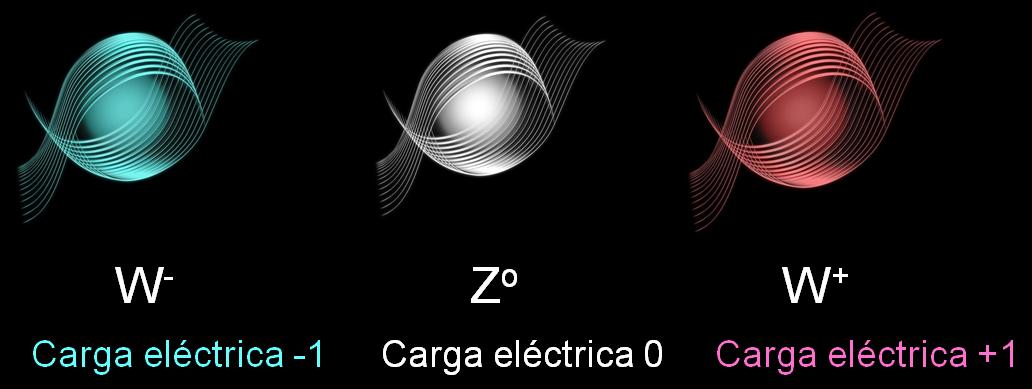

Salam que estaba muy cerca de poder alcanzar la gloria…no llegaba a poder explicar y aplicar las reglas de Feynman y tuvo quer admitir que la teoría parecía estar llena de partículas fantasmas que estaban a punto de estropearlo todo. En estas, llegó el otro investigador, Steven Weinberg, que supo dar un paso más al formular con mucho más detalle un modelo sencillo en el cual indicaba con precisión los campos que existían y cómo podían interactuar. Pero se limitó a los leptones. Weinberg comprendió que, junto al fotón ordinario tenía que haber tres fotones de Yang-Mills pesados::

– Uno cargado positivamente.

– Otro cargado negativamente.

– Otro Neutro.

La carga de la W+ se nos puerde a la derecha de la imagen pero, como rodos habeis supuesto, es carga + 1

En lo que se refiere a los fotones cargados, todo el mundo estaba de acuerdo en que estos se necesitarían para describir la interacción débil: serían los famoso bosones vectoriales intermediarios, W+ y W–. De acuierdo con Weinberg, sus masas tenían que ser mayores de 60.000 MeV. Pero solos, estos bosones, vectoriales cargados eran suficientes para explicar todos los procesos de interacción débil que conocían en aquella época. Que aparte de ellos y del fotón ordinario, y, también se necesita otro componente neutro (Weinberg le llamó Zº) no era evidente en absoluto. Se encontró que la masa del Zº tenía que ser un poco mayor que la de los bosones cargados.

De todo aquello surgió una tería para las interacciones débiles en las cuales jugaban un papel dominante distintos diagramas de Feynman, de los que se podían plasmar un número infinito para mostrar, de manera gráfica, los sucesos que acontecían en aquellos fenómenos de la radiación producida en la interacción débil. Pasado el tiempo y mirado con una mejor perspectiva, es fácil comprender todo aquello pero, en aquellos momentos en que se estaba gestando, las cosas no resultaban tan fáciles.

Después de todo aquello, se prestó más atención al mecanismo Higgs-Kibble y, algunos, como Veltman fueron muy escépticos con aquellas ideas, y, desde luego, no fue fácil converlo de que pudiéramos llamar vacío a algo lleno de partículas invisibles. ¿No delatarían dijo, su presencia por sus campos gravitatorios? La teoría puede ser formulada de tal manera que esos campos gravitatorios se compensen exactamente con otras partículas invibles o por una contribución misteriosa del propio espacio vacío.

Cómo consigue la Naturaleza enmascarar tan exacta y eficientemente esos factores de la gravedad que no podemos notar nada, es un misterio que continua siendo muy debatido hoy en día. Claro que, todo esto dejará de ser un misterio cuando un día (lejos aún en el futuro), podamos comprender la Gravedad Cuántica.

Miehntras todo esto sucede… ¡Dejémos volar nuestra imaginación! con ideas y teorías como la de los ¡Campos de Higgs! ¡Bosones que, generosos ellos, regalan masas a otras partículas! ¡Materia que no podemos ver pero que, dem manera acérrima, nos empeñamos en que sí está! ¡Fluctiaciones de vacío que rasgan el espacio-tiempo, y, que de vez en cuando, hace surgir nuevos universos! ¡Universos paralelos que nacieron sin vida! ¡Ciclos eternos en el que las cosas se repetin una y otra vez hasta el infinito! ¡Nuevos Big Bangs después del nuestro! ¡Agujeros negros en nuestro universo y, blancos al otro lado, en otro universo. Aquí recoge materia y, allú, la expulsa por el contrario, un Agujero Blanco! ¡Agujeros de Gusano que nos podrían llevar a otras galaxias! ¡El sueño de vencer (mejor burlar) a la velocidad de la luz, ese muro que nos tiene confinados en nuestro pequeño mundo, el Sistema Solar!

Después de leer todo esto, ¿por qué no dedicais aunque sólo sea una hora para pensar sobre ello?

emilio silvera

Ene

3

¿Qué son los rayos Gamma?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

En los últimos cuarenta años la visión que teníamos del universo ha venido sufriendo cambios sustanciales como consecuencia del uso de nuevas tecnologías observacionales, las cuales nos han permitido detectar fenómenos que antes nos eran desconocidos. Lo que nos parecía algo tranquilo, sólo sometido a cambios lentos o incluso inmutables, las nuevas técnicas nos ha sorprendido al mostrarnos una serie de eventos cósmicos nuevos y, en algunos casos, extremadamente violentos.

La mayoría de las explosiones Gamma se pueden dividir en dos tipos: Primero están aquellas que se producen en regiones de abundante y densa formación estelar y están asociadas a Supernovas -que lógicamente generaría una explosión sostenida de energía. La definición técnica de una duración de largo estallido de rayos gamma es la que tiene más de dos segundoa de duración, pero las que durán más de un minuto no son inusuales.

Estas grandes explosiones de rayos gamma se piensa que son generadas por colisiones fantásticas entre estrellas de Neutrones y Agujeros Negros, los objetos más densos y energéticos del Universo. Algunos han llegado a sugerir que son las radiaiciones surgidas de la creación de nuevos universos.

Muchos de esos cambios paradigmáticos que hemos tenido que asumir del universo tienen que ver con la participación de «extremas energías» que se han visto operando en él, al poderse observar hoy día, con instrumental de tecnología de punta, objetos astronómicos en otras longitudes de onda antes inaccesibles. Cuando se iniciaron las observaciones en ondas de radio ya ellas nos otorgaron la confirmación del fenómeno de cómo se generó el universo, o sea, de la Gran Explosión o Big Bang. Ahora, con los detectores con que se cuenta hoy de rayos X, gamma o gamma de altísima energía VHE, hemos podido detectar que hay una innumerable cantidad de objetos en nuestro entorno cósmico que sufren procesos extremadamente violentos, los cuales podrían producir fuertes estallidos de rayos gamma (g). Por ello, en esta sección, vamos intentar describir sucintamente qué son los rayos gamma, para luego introducirnos en por qué se podrían dar en esos objetos.

Un agujero negro podría haber creado esta burbuja gigante de rayos Gamma en nuestra propia Vía Láctea.

Los rayos gamma son un tipo de radiación electromagnética cuya altísima energía que comporta sus fotones viaja y se esparce. Los materiales radiactivos (algunos naturales y otros hechos por el hombre en plantas nucleares) son fuentes de emisión de rayos gamma. Los grandes aceleradores de partículas que los científicos usan para estudiar la composición de la materia pueden, a veces, generar rayos gamma. Pero el mayor productor de rayos gamma con una multiplicidad de posibles maneras para generarlos es el universo. En cierto sentido, las radiaciones gamma son el humo que señala los fuegos cósmicos subyacentes. La mayoría de los rayos gamma caen en el extremo inferior de su gama y son emitidos como elementos de desintegración radiactiva o cuando los electrones interactúan con otra materia. Pero una fracción pertenece al extremo alto del espectro: cuanto más alta la energía, más raro el fotón. La mayor parte de estos fotones parecen ser el producto secundario de colisiones entre rayos cósmicos y otras partículas. Puesto que las diversas partículas cósmicas ceden rayos gamma de energías variables, los astrónomos pueden, examinando el espectro de los rayos gamma recibidos, inferir qué fenómeno los produjo. Por ejemplo, los electrones que chocan con los fotones de baja energía de la luz estelar o pasan a través de nubes de gas ceden fotones por debajo de los 50 MeV.

Totales: 85.824.182

Totales: 85.824.182 Conectados: 48

Conectados: 48