Ene

10

¡La Luz! Esa maravilla de la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Grandes pensadores quisieron explicar la naturaleza de la luz

Está claro que, los estudiosos de la época antigua y medieval estaban por completo a oscuras acerca de la naturaleza de la luz. Especulaban sobre que consistía en partículas emitidas por objetos relucientes o tal vez por el mismo ojo. Establecieron el hecho de que la luz viajaba en línea recta, que se reflejaba en un espejo con un ángulo igual a aquel con el que el rayo choca con el espejo, y que un rayo de luz se inclina (se refracta) cuando pasa del aire al cristal, al agua o a cualquier otra sustancia transparente.

Cuando la luz entra en un cristal, o en alguna sustancia transparente, de una forma oblicua (es decir, en un ángulo respecto de la vertical), siempre se refracta en una dirección que forma un ángulo menor respecto de la vertical. La exacta relación entre el ángulo original y el ángulo reflejado fue elaborada por primera vez en 1.621 por el físico neerlandés Willerbrord Snell. No publicó sus hallazgos y el filósofo francés René Descartes descubrió la ley, independientemente, en 1.637.

Siempre nos gustó hacer experimentos con la luz

Los primeros experimentos importantes acerca de la naturaleza de la luz fueron llevados a cabo por Isaac Newton en 1.666, al permitir que un rayo de luz entrase en una habitación oscura a través de una grieta e las persianas, cayendo oblicuamente sobre una cara de un prisma de cristal triangular. El rayo se refracta cuando entra en el cristal y se refracta aún más en la misma dirección cuando sale por una segunda cara del prisma. (Las dos refracciones en la misma dirección se originan por que los dos lados del prisma de se encuentran en ángulo en vez de en forma paralela, como sería el caso en una lámina ordinaria de cristal.)

Newton atrapó el rayo emergente sobre una pantalla blanca para ver el efecto de la refracción reforzada. Descubrió que, en vez de formar una mancha de luz blanca, el rayo se extendía en una gama de colores: rojo, anaranjado, amarillo, verde, azul, y violeta, en este orden.

Newton dedujo de ello que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos para producir las diversas sensaciones de colores. La amplia banda de sus componentes se denominó spectrum (palabra latina que significa “espectro”, “fantasma”).

Newton llegó a la conclusión de que la luz se componía de diminutas partículas (“corpúsculos”), que viajaban a enormes velocidades.

Le surgieron y se planteó algunas inquietudes cuestiones. ¿Por qué se refractaban las partículas de luz verde más que los de luz amarilla? ¿Cómo se explicaba que dos rayos de luz se cruzaran sin perturbase mutuamente, es decir, sin que se produjeran colisiones entre partículas?

Titán, la luna de Saturno, contempla la sonda que lleva su nombre

En 1.678, el físico neerlandés Christian Huyghens (un científico polifacético que había construido el primer reloj de péndulo y realizado importantes trabajos astronómicos) propuso una teoría opuesta: la de que la luz se componía de minúsculas ondas. Y si sus componentes fueran ondas, no sería difícil explicar los diversos difracciones de los diferentes tipos de luz a través de un medio refractante, siempre y cuando se aceptara que la luz se movía más despacio en ese medio refractante que en el aire. La cantidad de refracción variaría con la longitud de las ondas: cuanto más corta fuese tal longitud, tanto mayor sería la refracción. Ello significaba que la luz violeta (la más sensible a este fenómeno) debía de tener una longitud de onda mas corta que la luz azul, ésta, más corta que la verde, y así sucesivamente.

Lo que permitía al ojo distinguir los colores eran esas diferencias entre longitudes de onda. Y, como es natural, si la luz estaba integrada por ondas, dos rayos podrían cruzarse sin dificultad alguna. (Las ondas sonoras y las del agua se cruzan continuamente sin perder sus respectivas identidades.)

Peor la teoría de Huyqhens sobre las ondas tampoco fue muy satisfactoria. No explicaba por qué se movían en línea recta los rayos luminosos; ni por qué proyectaban sombras recortadas; ni aclaraba por qué las ondas luminosas no podían rodear los obstáculos, del mismo modo que pueden hacerlo las ondas sonoras y de agua. Por añadidura, se objetaba que si la luz consistía en ondas, ¿cómo podía viajar por el vacío, ya que cruzaba el espacio desde el Sol y las Estrellas? ¿cuál era esa mecánica ondulatoria?

Interferencia: Sonido más sonido en algunos casos puede producir silencio. Esto sucede cuando dos ondas de sonido se superponen destructivamente, igual como se observa en las zonas nodales de una cuerda en vibración. ¿Será posible que en algún caso luz más luz produzca oscuridad? La respuesta es afirmativa. Quien lo demostrara en 1803, en un famoso experimento, fue Thomas Young (1773-1829). Éste consistió en hacer llegar un haz de luz simultáneamente a dos rendijas muy delgadas y muy cercanas, según se ilustra en el siguiente esquema.

Aproximadamente durante un siglo, contendieron entre sí estas teorías. La teoría corpuscular, de Newton, fue, con mucho, la más popular, en parte, porque la respaldó el famoso nombre de su autor. Pero hacia 1.801, un físico y médico ingles, de nombre Thomas Young, llevó a cabo un experimento que arrastró la opinión pública al campo opuesto. Proyectó un fino rayo luminoso sobre una pantalla, haciéndolo pasar antes por dos orificios casi juntos. Si la luz estuviera compuesta por partículas, cuando los dos rayos emergieran de ambos orificios, formarían presuntamente en la pantalla una región más luminosa donde se superpusieran, y regiones menos brillantes, donde no se diera tal superposición. Pero no fue esto lo que descubrió Young. La pantalla mostró una serie de bandas luminosas, separadas entre sí por bandas oscuras. Pareció incluso que, en esos intervalos de sombra, la luz de ambos rayos contribuía a intensificar la oscuridad.

Sería fácil explicarlo mediante la teoría ondulatoria. La banda luminosa representaba el refuerzo presado por las ondas de un rayo a las ondas del otro. Dicho de otra manera: Entraba “en fase” dos trenes de ondas, es decir, ambos nodos, al unirse, se fortalecían el uno al otro. Por otra parte, las bandas oscuras representaban puntos en que las ondas estaban “desfasadas” porque el vientre de una neutralizaba el nodo de la otra. En vez de aunar sus fuerzas, las ondas se interferían mutuamente, reduciendo la energía luminosa neta a las proximidades del punto cero.

Considerando la anchura de las bandas y la distancia entre los dos edificios por los que surgen ambos rayos, se pudo calcular la longitud de las ondas luminosas, por ejemplo, de la luz roja a la violeta o los colores intermedios. Las longitudes de onda resultaron ser muy pequeñas. Así, la de la luz roja era de unos 0’000075 cm. (Hoy se expresan las longitudes de las ondas luminosas mediante una unidad muy práctica ideada por Angströn. Esta unidad, denominada, en honor a su autor Ángstrom (Á), es la cienmillonésima parte de un centímetro. Así, pues, la longitud de onda de la luz roja equivale más o menos a 7.500 Á, y la de la luz violeta, a 3.900 Å, mientras que las de colores visibles en el espectro oscilan entre ambas cifras.)

La cortedad de estas ondas es muy importante. La razón de que las ondas luminosas se desplacen en línea recta y proyecten sombras recortadas se debe a que todas son incomparablemente más pequeñas que cualquier objeto; pueden contornear un obstáculo sólo si éste no es mucho mayor que la longitud de onda. Hasta las bacterias, por ejemplo, tienen un volumen muy superior de una onda luminosa y, por tanto, la luz puede definir claramente sus contornos bajo el microscopio. Sólo los objetos cuyas dimensiones se asemejan a la longitud de la onda luminosa (por ejemplo, los virus y otras partículas submicroscópicas) son lo suficientemente pequeños como para que puedan ser contorneados por las ondas luminosas.

Augustin Jean Fresnel (1788 – 1827)

Photo: German Museum Munich

Un físico francés, Augustin-Jean Fresnel, fue quien demostró por vez primera, en 1.818, que si un objeto es lo suficientemente pequeño, la onda luminosa lo contorneará sin dificultad. En tal caso, la luz determina el llamado fenómeno de “difracción”. Por ejemplo, las finísimas líneas paralelas de una “reja de disfracción” actúan como una serie de minúsculos obtáculos, que se refuerzan entre si. Puesto que la magnitud de la difracción va asociada a la longitud de onda, se produce el espectro. A la inversa, se puede calcular la longitud de onda midiendo la difracción de cualquier color o porción del espectro, así como la separación de las marcas sobre el cristal.

Fraunhofer exploró dicha reja de difracción con objeto de averiguar sus finalidades prácticas, progreso que suele olvidarse, pues queda eclipsado por su descubrimiento más famoso: los rayos espectrales. El físico americano Henry Augustus Rowlane ideó la reja cóncava y desarrolló técnicas para regularlas de acuerdo con 20.000 líneas por pulgada. Ello hizo posible la sustitución del prisma por el espectroscopio.

Ante tales hallazgos experimentales, más el desarrollo metódico y matemático del movimiento ondulatorio, debido a Fresnel, pareció que la teoría ondulatoria de la luz había arraigado definitivamente, desplazando y relegando para siempre a la teoría corpuscular.

Jacques Babinet

No sólo se aceptó las existencias de ondas luminosas, sino que también se midió su longitud con una precisión cada vez mayor. Hacia 1.827, el físico francés Jacques Babinet sugirió que se empleara la longitud de onda luminosa (una cantidad física inalterable) como unidad para medir tales longitudes, en vez de las muy diversas unidades ideadas y empleadas por el hombre. Sin embargo, tal sugerencia no se llevó a la práctica hasta 1.880 cuando el físico germano-americano Albert Abraham Michelson inventó un instrumento, denominado “interferómetro”, que podía medir las longitudes de ondas luminosas con una exactitud sin precedentes. En 1.893, Michelson midió la onda de la raya roja en el espectro del cadmio y determinó que su longitud era de 1/1.553.164 m.

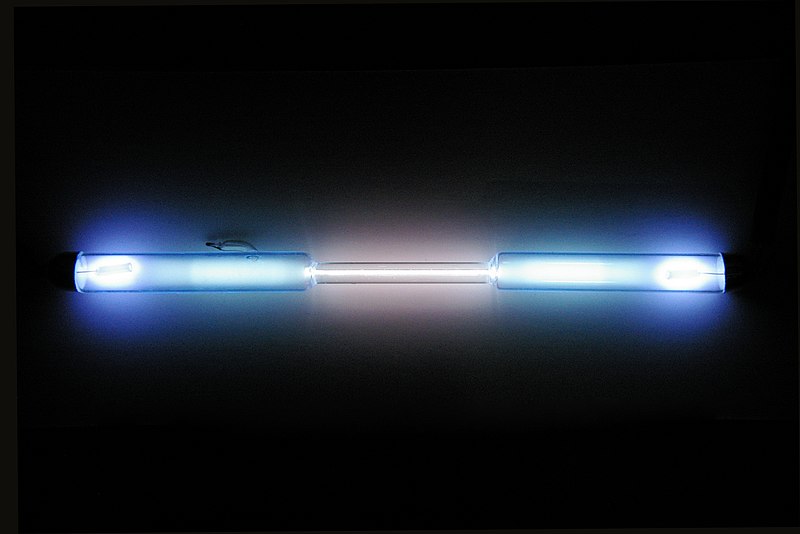

Pero la incertidumbre reapareció al descubrirse que los elementos estaban compuestos por isótopos diferentes, cada uno de los cuáles aportaba una raya cuya longitud de onda difería ligeramente de las restantes. En la década de 1.930 se midieron las rayas del criptón 86. Como quiera que este isótopo fuera gaseoso, se podía abordar con bajas temperaturas, para frenar el movimiento atómico y reducir el consecutivo engrosamiento de la raya.

Tubo de descarga lleno de kriptón puro

En 1.960, el Comité Internacional de Pesos y Medidas adoptó la raya del criptón 86 como unidad fundamental de longitud. Entonces se restableció la longitud de metro como 1.650.763’73 veces la longitud de onda de dicha raya espectral. Ello aumento mil veces la precisión de las medidas de longitud. Hasta entonces se había medido el antiguo metro patrón con un margen de error equivalente a una millonésima, mientras que en lo sucesivo se pudo medir la longitud de onda con un margen de error equivalente a una milmillonésima.

Ahora, después de todo esto, sabemos algo más sobre la luz. Pero…, ¿qué pasa con su velocidad?

¡Veámoslo!

La velocidad de la luz, desde hace mucho tiempo, fue un misterio que los estudiosos de la física de la Naturaleza querían desvelar

Está claro que, la luz se desplaza a enormes velocidades. Si pulsamos el interruptor de apagado de la lámpara de nuestro salón, todo queda a oscuras de manera instantánea y, de la misma manera e inmediata, todo se inunda de luz si con una potente linterna encendida, apuntamos hacia un rincón oscuro.

La velocidad del sonido es más lenta, por ejemplo, si vemos a un leñador que está cortando leña en un lugar alejado de nosotros, sólo oiremos los golpes momentos después de que caiga el hacha. Así, pues, el sonido tarda cierto tiempo en llegar a nuestros oídos. En realidad es fácil medir la velocidad de su desplazamiento: unos 1.206 km/h en el aire y a nivel del mar.

Galileo fue el primero en intentar medir la velocidad de la luz. Se colocó en lo alto de una colina, mientras que su ayudante, se situaba en otro lugar alto de la colina vecina; luego sacó una linterna encendida: tan pronto como su ayudante vió la luz, hizo una señal con otra linterna. Galileo repitió el experimento a distancias cada vez mayores, suponiendo que el tiempo requerido por su ayudante para responder mantendría una uniformidad constante, por lo cual, el intervalo entre la señal de su propia linterna y la de su ayudante representaría el tiempo empleado por la luz para recorrer cada distancia. Aunque la idea era lógica, la luz viajaba demasiado aprisa como para que Galileo pudiera percibir las sutiles diferencias con un método tan rudimentario.

En 1.676, el astrónomo danés Olau Roemer logró cronometrar la velocidad de la luz a escala de distancias astronómicas. Estudiando los eclipses de Júpiter en sus cuatro grandes satélites, Roemer observó que el intervalo entre eclipses consecutivos era más largo cuando la Tierra se alejaba de Júpiter, y más corto cuado se movía en su órbita hacía dicho astro. Al parecer, la diferencia entre las duraciones del eclipse reflejaba la diferencia de distancias entre la Tierra y Júpiter. Y trataba, pues, de medir la distancia partiendo del tiempo empleado por la luz para trasladarse desde Júpiter hasta la Tierra. Calculando aproximadamente el tamaño de la órbita terrestre y observando la máxima discrepancia en las duraciones del eclipse que, según Roemer, representaba el tiempo que necesitaba la luz para atravesar el eje de al órbita terrestre, dicho astrónomo computó la velocidad de la luz. Su resultado, de 225.000 km/s., parece excelente si se considera que fue el primer intento, y resultó bastante asombroso como para provocar la incredulidad de sus coetáneos.

Sin embargo, medio siglo después se confirmaron los cálculos de Roemer en un campo totalmente distinto. Allá por 1.728, el astrónomo británico James Bradley descubrió que las estrellas parecían cambiar de posición con los movimientos terrestres; y no por el paralaje, sino porque la traslación terrestre alrededor del Sol era una fracción mensurable (aunque pequeña) de la velocidad de la luz. La analogía empleada usualmente es la de un hombre que camina con el paraguas abierto bajo un temporal. Aun cuando las gotas caigan verticalmente, el hombre debe inclinar hacia delante el paraguas, porque ha de abrirse paso entre las gotas.

James Bradley descubrió la aberración estelar

Cuanto más acelere su paso, tanto más deberá inclinar el paraguas. De manera semejante la Tierra avanza entre los ligeros rayos que caen desde las estrellas, y el astrónomo debe inclinar un poco su telescopio y hacerlo en varias direcciones, de acuerdo con los cambios de la trayectoria terrestre (no olvidemos que nuestro planeta Tierra, es como una enorme nave espacial que nos lleva en un viaje eterno, alrededor del Sol, a la velocidad de 30 km/s. + -) Mediante ese desvío aparente de los astros (“aberración de la luz”), Bradley pudo evaluar la velocidad de la luz y calcularla con gran precisión.

Sus cálculos fueron de 285.000 km/s, bastante más exacto que los de Roemer, pero aún un 5’5% más bajos. Poco a poco, con medios tecnológicos más sofisticados y más conocimientos matemáticos, los científicos fueron obteniendo medidas más exactas aún, conforme se fue perfeccionando la idea original de Galileo y sus sucesores.

En 1.849, el físico francés Armand-Hippolyte-Louis Eizeau ideó un artificio mediante el cual se proyectaba la luz sobre un espejo situado a 8 km de distancia, que devolvía el reflejo al observador. El tiempo empleado por la luz en su viaje de ida y vuelta no rebasó apenas la 1/20.000 de segundo, por Fizeau logró medirlo colocando una rueda dentada giratoria en la trayectoria del rayo luminoso. Cuando dicha rueda giraba a cierta velocidad, regulada, la luz pasaba entre los dientes y se proyectaba contra el siguiente, al ser devuelta por el espejo; así, Fizeau, colocado tras la rueda, no pudo verla. Entonces se dio más velocidad a la rueda, y el reflejo pasó por la siguiente muesca entre los dientes, sin intercepción alguna. De esa forma, regulando y midiendo la velocidad de la rueda giratoria, Fizeau pudo calcular el tiempo transcurrido y, por consiguiente, la velocidad a que se movía el rayo de luz.

Un año más tarde, Jean Foucault (quien realizaría poco después su experimento con los péndulos) precisó más estas medidas empleando un espejo giratorio en ve de una rueda dentada. Entonces se midió el tiempo transcurrido desviando ligeramente el ángulo de reflexión mediante el veloz espejo giratorio. Foucault obtuvo un valor de la velocidad de la luz de 300.883 km/s. También, el físico francés utilizó su método para determinar la velocidad de la luz a través de varios líquidos. Averiguó que era notablemente inferior a la alcanzada en el aire. Esto concordaba también con la teoría ondulatoria de Huyghens.

Michelson fue más preciso aún en sus medidas. Este autor, durante cuarenta años largos, a partir de 1.879, fue aplicando el sistema Fizeau-Foucault cada vez con mayor refinamiento, para medir la velocidad de la luz. Cuando se creyó lo suficientemente informado, proyectó la luz a través de vacío, en vez de hacerlo a través del aire, pues este frena ligeramente su velocidad, y, empleó para ello tuberías de acero cuya longitud era superior a 1’5 km. Según sus medidas, la velocidad de la luz en el vacío era de 299.730 km(seg. (sólo un 0’006% más bajo). Demostraría también que todas las longitudes de ondas luminosas viajan a la misma velocidad en el vacío.

En 1.972, un equipo de investigadores bajo la dirección de Kenneth M. Eveson efectuó unas mediciones aún más exactas y vio que la velocidad de la luz era de 299.727’74 km/seg. Una vez se conoció la velocidad de la luz con semejante precisión, se hizo posible usar la luz, o por lo menos formas de ella, para medir distancias.

Aunque para algunos resulte alto tedioso el tema anterior, no he podido resistirme a la tentación de exponerlo, así podrá saber algo más sobre la luz y, habrán conocido a personajes que hicieron posible el que ahora nosotros, la conozcamos mejor.

Podría continuar, hasta el final de este trabajo, hablando de la luz y sus distintas formas o aplicaciones: ondas de luz a través del espacio, de cómo se transmite la luz en el “vacío”, nos llega a través del espacio desde Galaxias situadas a miles de millones de años luz; las líneas de fuerzas electromagnéticas de Faraday y Maxwell de campos eléctricos y magnéticos cambiantes (todo ello explicado en un simple conjunto de cuatro ecuaciones, que describían casi todos los fenómenos referentes a esta materia electromagnética), o de los enigmas aún por descubrir (aunque predichos).

Ahora, en Física, se dice que la luz es una forma de radiación electromagnética a la que el ojo humano es sensible y sobre la cual depende nuestra consciencia visual del universo y sus contenidos.

Aparte de todo lo que antes hemos explicado, no sería justo finalizar el trabajo sin exponer aquí que, en 1905, Albert Einstein, inspirado en el cuanto de Planck, realizó un importante avance en el conocimiento de lo que es la luz. Demostró que el Efecto fotoeléstrico sólo podía ser explicado con la hipótesis de que la luz consiste en un chorro de fotones de energía electromagnética discretos. Aquello le valió el Nobel de Física y… ¡Le hurtaron otros dos por las dos partes de su teoría de la relatividad! Una revolución que lo cambió todo y que nunca podremos pagarle.

El conflicto entre la teoría ondulatoria y corpuscular de la luz fue resuelto con la evolución de la teoría cuántica y la mecánica ondulatoria que ha dejado claro que, los electrones y las otras partículas elementales tienen propiedades duales de partículas y onda.

sería mucho más largo, pero creo que está bien con lo dicho.

emilio silvera

Ene

10

Razones de peso para que las galaxias no pudieran existir

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La formación de las galaxias ~

Clasificado en La formación de las galaxias ~

Comments (11)

Comments (11)

En los temas que estos días hemos tratado, ha sido la protagonista la “hipotética” materia oscura que, según algunos modelos supone el 90% de la materia que compone el universo. El tema ha dado pie a opininiones y algún debate que principalmente han llevado adelante Kike y Fandila que, con sus indudables conocimientos y formas de aplicar la lógica, nos llevan de la mano, con alguna metáfora incluída, a que podamos comprender mejor como son las cosas que, no siempre, coinciden con la realidad que algunos nos dibujan. Y, nuestra obligación, aunque el dibujo sea hermoso, armonioso y hasta placentero, debemos desconfiar, y, tomarlo, tan sólo como algo posible, algo que podría ser pero que de momento no es. Acordaos de aquel sabio que nos dijo: Todas las cosas son”. Con aquella simple frase, elevó a las “cosas” a la categoría de ser. Claro que las cosas a las que se refería estaban allí y podíamos contemplarlas. Por el contrario, la “materia oscura” nadie la vio nunca, es algo imaginario y supuesto que, al parecer, nos señalan algunos indicios observados, por lo demás, nada podemos concretar de ella.

Nuestro Universo es tan complejo que, seguramente, todo lo que hemos podido saber de él, es sólo una pequeñísima parte de lo que es. Quizá el inmenso trabajo y esfuerzo, el ingenio de muchos, la intuición de algunos, la genialidad de unos pocos, el avance, costoso avance en el campo de las matemáticas, todo ello unido como un todo, nos ha traído hasta aquí, un momento en el que, se podría decir sin temor a equivocarnos que estamos en la línea de partida para comenzar el camino hacia más grandes logros. Creerse más que eso, sería engañarnos a nosotros mismos, dado que, la cruda realidad es que sabemos menos de lo que creemos y decimos que sabemos.

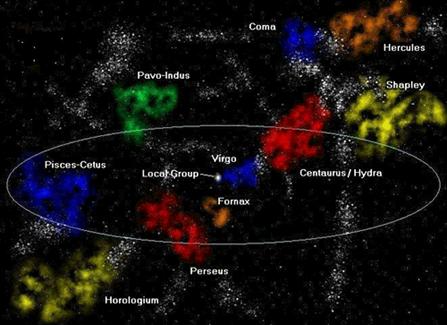

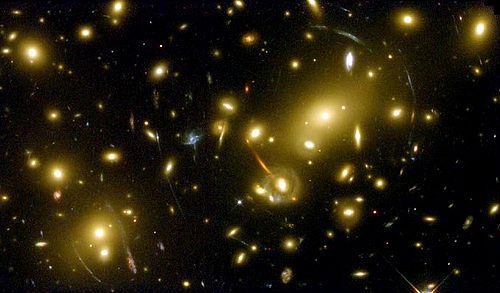

Arriba contemplamos la conocida y familiar imagen de una Galaxia y, si alguien nos preguntara como pudieron formarse las galaxias, la verdad sería que, no tendríamos contestación para esa pregunta. ¿Cómo es posible eso a estas alturas? Pués porque lo que podemos resumir de la moderno visión del universo se podría limitar a dos breves afirmaciones: Primera; el universo ha estado expandiéndose desde que se formó, y en el proceso ha evolucionado desde las estructuras simples a las complejas. Segunda: la materia visible en el universo está organizada jerárquicamente: las estrellas agrupadas en galaxias, las galaxias en cúmulos y los cúmulos en supercúmulos. El problema al que nos enfrentamos por tanto, es comprender como un universo cuya evolución está dominada por la primera afirmación, puede llegar a tener la estructura descrita en la segunda afirmación.

El problema de es explicar la existencia de la galaxias ha resultado ser uno de los más espinosos de la cosmología. Con todo derecho no deberían estar ahí y, sin embargo, ahí están. Es difícil comunicarl el abismo de frustración que este simple hecho produce entre los científicos. Una y otra vez han surgido nuevas revelaciones y ha parecido que el problema estaba resuelto. Cada vez la solución se debilitaba, aparecían nuevas dificultades que nos transportaban al punto de partida.

Cada pocos años, la American Physical Society, la Asociación Profesional de físicos, tienen una sesión en una de sus reuniones en la que los Astrofísicos hablan de los más nuevos métodos de afrontar el problema de las galaxias. Si te molestar en asistir a varias de esas reuniones, dos son las sensaciones contradictorias que te embargan: Por una parte sientes un gran respeto por la ingenuidad de algunas propuestas que son hechas “de corazón” y, desde luego, la otra sensación es la de un profundo excepticismo hacia las ideas que proponían, al escuchar alguna explicación de cómo las turbulencias de los agujeros negros, las explosiones durante la formación de galaxias, los neutrinos pesados y la materia oscura fría resolvía todos aquellos problemas.

Lo cierto es que, a pesar de lo que se pueda leer en la prensa en comunicados oficiales, todavía no tenemos ese “bálsamo milagroso” que nos permita responder a una pregunta simple: ¿Por qué está el cielo lleno de galaxias?

Es cierto, el cielo está lleno de cúmulos de galaxias y nosotros, tratándo de saber de su presencia allí, hemos llegado a conseguir eliminar muchas de las respuestas equivocadas. Podemos estar ahora mucho más cerca de la verdad de lo que lo estábamos antes. Pero, de ninguna manera sería bueno que nos dejémos adormecer por la credulidad de los postulados modernos que parecen “sacados de la manga” del jugador cosmológico, para que la partida salga redonda. Claro que, una cierta dosis de excepticismo no implica que no podamos aceptar como probables y ciertas, algunas de las ideas generales implícitas en las soluciones propuestas que podrían, al final de todo el camino, ser parte de la solución que buscamos.

Formalmente podríamos exponer aquí al menos cinco razones para tratar de justificar el por qué, las galaxias, no deberían estar ahí presentes.

1º) Las Galaxias no pueden haberse formado antes que los átomos. No es un asunto trivial. Durante muchisimos años se estuvo tratando de entender este proceso, comezando con ideas magicas, hasta que a principios del siglo 19 se empezo a a comprender como funcionan las estrellas y el Universo.

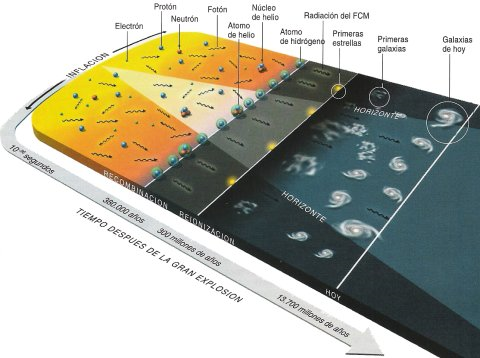

Es un proceso algo complicado, por eso se tardo tanto en reconocerlo. En este momento la mejor teoria que explica el Universo es que comenzo con el Big-Bang, la explosion inicial que dio origen a todo. En la explosion, de origen todavia incierto, habia pura energia, y al expandirse se fue enfriando, como lo haria cualquier gas. Al llegar a un nivel de energia un poco mas bajo del inicial, se pudieron condensar de la energia las primeras particulas elementales (protones, neutrones, etc). Esto ocurrio en los primeros minutos. La famosa ecuacion de Einstein E = mc al cuadrado, implica que se puede transformar materia en energia, como en un reactor nuclear, y tambien la energia puede condensarse en materia, como en este caso. A los 300 mil años, el nivel de energia fue lo suficientemente bajo como para permitir la formacion de los primeros atomos.

La existencia protones, electrones y neutrones dispersos, que cuando se juntaron fue para formar los elementos quimicos mas elementales: Hidrogeno, Helio y algo de litio. Nada mas se formo, en la proporcion de 75% de hidrogeno, casi 25% de helio, y trazas de los otros elementos.

Aquella primera “sopa de plasma primordial” posibilitó que se juntaran protones y neutrones para formar el elemento más simple del Universo: El Hidrógeno,

Así, podemos partir de la base cierta de que, hasta donde sabemos, podemos pensar en el Universo durante aquellas primeras etapas de la expansión de Hubble estaba formado por dos únicos constituyentes: materia y radiación. La materia sufrió una serie de congelaciones al construir gradualmente estructuras más y más complejas. A medida que tienen lugar estos cambios en la formación de la materia, la manera en que interaccionan, materia y radiación cambian radicalmente. Esto, a su vez, desempeña un papel fundamental en la formación de galaxias.

La luz y otros tipos de radiación interaccionan fuertemente con partículas libres eléctricamente cargadas, del tipo de las que existían en el plasma que constituía el universo antes de que los átomos se formara. A causa de esta interacción, cuando la radiación se mueve por este plasma, colisiona con partículas, rebotando y ejerciendo una presión del mismo modo que las moléculas de aire, al rebotar sobre las paredes de un neumático, mantienen el neumático inflado. Si se diese el caso de que una conglomeración de materia del tamaño de una galaxia tratase de formarse antes de la congelación de los átomos, la radiación que traspasaría el material habría destruído el conglomerado, y, la radiación tendería a quedar atrapada dentro de la materia. Si tratase de salir, sufriría colisiones y rebotaría.

2º) Las galaxias no tuvieron tiempo de formarse. La Gravedad es la gran fuerza desestabilizadora del Universo, Nunca lo abandona del todo; siempre está actuando tratando de unir trazos de materia, En cierto sentido, la historia entera del Universo se puede pensar como un último y futil intento de superar la Gravedad.

Sería asombroso, dada la naturaleza universal de la fuerza gravitatoria, que no hubiera desempeñado un papel importante en la formación de las galaxias. Escribir sobre este apartado nos llevaría a tener que explicar muchas implicaciones que están presentes en la dinámica del universo en relación a la materia. De todas las maneras que la queramos mirar, la sensación que percibimnos es la de que, en aquellos primeros momentos, podía existir “algo” (no sabemos qué) que generaba también, como la materia bariónica normal, fuerza gravitatoria.

Inmensas turbulencias que generaban fuerzas eléctricas y moldeaba la materia y todo el entorno

3º) La turbulencia tampoco nos vale. El Impulso a travgés de la turbulencia es una idea simple, cuyas primeras versiones fueron aireadas alrededor de 1950. El postulado es: cualquier proceso tan violento y caótico como las primeras etapas del Big Bang no será como un río profundo y plácido, sino como una corriente de montaña, llena de espuma y turbulencias. En este flujo caótico podemos esperar encontrar remolinos y vórtices de gas. Lo cierto es que, en este maremagnun, era de todo punto imposible que las galaxias se pudieran formar.

4º) Las Galaxias no han tenido tiempo para formar cúmulos. Quizá estamos encontrando dificultades porque consideramos el problema de las galaxias desde un punto de vista muy estrecho. Quizá lo que deberíamos hacer es ver las cosas en una escala más grande y esperar que si entendemos como se forman los cúmulos de galaxias, la génesis de las galaxias individuales, se resolverá por sí misma. La idea nos conduce naturalmente a la cuestión de cómo se pueden haber formado concentraciones muy grandes de masa al comienzo de la vida del universo. Una de las ideas más sencillas sobre como puede haber sido el universo cuando los átomos se estaban formando es que no importa lo que estuviese pasando, la temperatura era la misma en todas partes. Este se llama modelo isotérmico.

Explicar aquí las implicaciones matemáticas a que nos llevaría explicar el modelo isotérmico, estaría bien pero, no parece imprescindible para finalizar este trabajo que, de manera sencilla, sólo trata de explicar que, las galaxias no se pudieron formar conforme a lo que hemos observado y sabemos del Universo, algo nos falta por saber y, alguna fuerza “oculta” debería haber estado allí presente para evitar que, la materia se dispersara con la expansión de Hubble y las galaxias se pudieran formar.

5º) Si la radiación marcha junto con la materia y la materia con las galaxias, la radiación de microondas cósmicas sería contradictoria. Si la radiación no se hubiera dispersado uniformemente, con independencia de la materia del universo, ¿dónde hubiera estado? siguiendo el procedimiento normal de la física teórica, consideraremos a continuación la tesis opuesta.

Supongamos que en el comienzo del universo materia y radiación estaban unidas. Si era así, allí donde se encontrara una concentración de masa, también habría una concentración de radiación. En la jerga de la Física se dice que esta situación es “adiabática”. Aparece siempre que tienen lugar en las distribuciones del gas cambios tan rápidos que la energía no puede transferirse fácilmente de un punto al siguiente.

Sabemos que, para hacer galaxias, la materia del universo tuvo que estar muy bien distribuída en agregados cuando se formaron los átomos. Pero, todo este resultado choca con uno de los hechos más notables del universo que conocemos. Si consideramos la radiación de microondas, que llega hasta nosotros desde la dirección del Polo Norte de la Tierra, y luego nos volvemos y miramos la radiación que viene del Polo Sur, encontramos que son casi completamente idénticas. De esta notable uniformidad se deduce que cuando la radiación se despareja de la materia deberá de estar muy uniformemente distribuida por todo el universo.

El resultado final es este: lo que el proceso de formación de galaxcias requiere del entorno de microondas y lo que observamos de su uniformidad son cosas diametralmente opuestas. Lo primero requiere radiación para ser reunida con la materia; así, si la materia estuviera agrupada cuando los átomos se formaron, habría trazas de esa agrupación en el fondo cósmico de microondas de hoy.

Por otra parte, la uniformidad observada en el entorno de microondas implica que la radiación nunca podría haber estado tan agrupada; si lo hubiera estado, hoy no sería uniforme. Cuando se hacen detallados cálculos núméricos, los astrofísicos encuentran que es imposible conciliar estas dos exigencias en conflicto. La radiación de microondas no puede ser uniforme y no uniforme al mismo tiempo.

Todos los razonamientos anteriores nos llevan a pensar y demuestran muy claramente que, no podemos dar por supuesto un universo lleno de galaxias y, si de hecho lo está, debemos buscar la causa real que lo hizo posible. Explicar ese universo ha sido mucho más difícil de lo que muchos llegaron a pensar y, como se dice en el título de este trabajo, no tenemos una explicación, ni las razones de peso que justifiquen la presencia de las galaxias.

¿Qué había y estaba presente en el comienzo del Universo, que nosotros desconocemos pero que, hizo posible que las galaxias se pudieran formar?

Yo no lo se.

Estamos de nuevo en el punto de siempre: Nuestros conocimientos son limitados. Nuestra ignorancia…

Infinita!

emilio silvera

Ene

10

¡Nos queda tanto por aprender!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo ~

Clasificado en El Universo ~

Comments (0)

Comments (0)

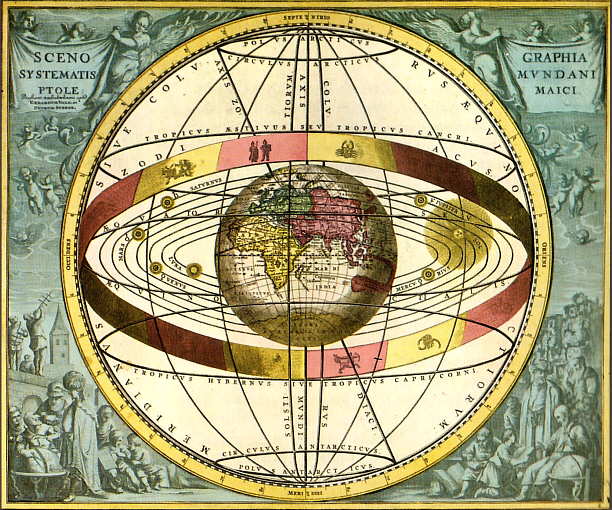

Desde Ptolomeo con su modelo del universo de esferas cristalinas, hasta el más reciente modelo de los universos burbujas. Desde los modelos geocéntrico, estacionario, infinito, inflacionario… Siempre hemos tenido modelos de universos que nuestras mentes han creado según nos han ido dictando los siempre escasos conocimientos que del universo hemos tenido y, a medida que estos conocimientos fueron avanzando, el modelo se hizo mejor pero…, no definitivo.

Precisamente por eso me choca ver y escuchar como pretendidos “expertos” en la materia, dicen que ellos conocen lo que es el Universo, o, lo que pasó en los primeros tres minutos a partir del supuesto Big Bang. Hablan con desparpajo y “seguridad” de todo ello a la audiciencia que, no siempre en posesión del conocimiento requerido para ello, es receptora de las palabras que pretenden ser esa verdad que, en realidad, nadie ha tenido nunca. Lo cierto es que, se están refiriendo a que tienen un modelo del Universo temprano, y que este modelo encaja con los resultados que hasta el momento han obtenido mediante observaciones y diversas comprobaciones.

Está claro que el modelo de universo de los sumerios, babilónios y otros pueblos antiguos, era muy diferente al que ya nos dibujó Copérnico, Tycho Brahe o el mismo Einstein. Los modelos han ido evolucionando y, de la misma manera, el modelo que hoy tenemos y que denominamos Big Bang, será mejorado a medida que nuevos descubrimientos y nuevos conocimientos incrementen nuestro saber del mundo y, para ello, creamos esos modelos que nos ayudan para poder alcanzar ese saber que incansables perseguimos.

Los Modelos empíricos: Se sustentan en la identificación de relaciones estadísticamente significativas entre ciertas variables que se asumen como esenciales y suficientes para modelar el comportamiento del sistema. Con tal motivo, debe disponerse previamente de una base de datos de tamaño adecuado. Pueden subdividirse en tres categorías diferentes:

De Caja Negra: Sólo se analizan los datos de entrada y de salida del modelo.

De Caja Gris: Se explican algunos detalles del conocimiento existente sobre el comportamiento del sistema.

De Caja Blanca: Se conocen y explican todos los detalles del comportamiento del Sistema.

ii. ESTOCÁSTICOS: Consisten en la generación de series de datos sintéticas a partir de las propiedades estadísticas de las poblaciones de datos existentes. Son muy útiles con objeto de generar secuencias de datos que alimenten a modelos empíricos o a los basados sobre leyes físicas, cuando tan sólo se dispone de información recogida durante periodos de observación breves.

iii. DE SOPORTE FÍSICO: Elaborados con ecuaciones matemáticas al objeto de describir los procesos involucrados en el modelo, teniendo en cuenta las leyes de conservación de masas y energía, etc.

iii. DIGITALES: Modelos estocásticos, de soporte físico, etc. Basados en el uso de ordenadores digitales capaces de procesar una gran cantidad de datos que desembocan en la recreación de Sistema que tratamos de descubrir [JJI].

Hoy podemos crear modelos para todo

No siempre los modelos científicos son una fiel imagen de la realidad. Los átomos y las moléculas que componen el aire que respiramos, por ejemplo, se pueden describir en términos de un modelo en el que imaginamos cada partícula como si fuera una pequeña esfera perfectamente elástica, con todas las pequeñas esferas rebotando unas contra otras y contra las paredes del recipiente que las contiene.

Esa es la imagen mental, pero es sólo la mitad del modelo; lo que lo hace modelo científico es describir el modo como se mueven las esferas y rebotan unas contra otras mediante un grupo de leyes físicas, escritas en términos de ecuaciones matemáticas. En este caso, éstas son esencialmente las leyes del movimiento descubiertas por Newton hace más de trescientos años. Utilizando estas leyes matemáticas es posible predecir, por ejemplo, que le pasará a la presión ejercida por un gas si se aplasta hasta la mitad de su volumen inicial. Si hacemos el experimento, y, el resultado que se obtiene encaja con la predicción del modelo, este será un buen modelo.

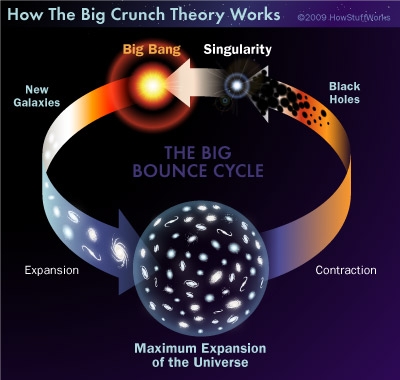

En la década de 1930, los físicos teóricos, en particular, Einstein, consideró la posibilidad de un modelo cíclico para el universo como una alternativa a la del Big Bang. Sin embargo, el trabajo de Richard Tolman reveló que estos primeros intentos fracasaron debido al problema que la entropía encumbra, que según la mecánica estadística, ésta aumenta debido a la segunda ley de la termodinámica. Esto implica que en sucesivos ciclos el universo crece más y más en cada ciclo. Y extrapolando hacia atrás en el tiempo, los ciclos antes de convertirse en el presente ciclo eran menores y más cortos, y en un punto hubo un ciclo iniciado por un Big Bang, no pudiendo eliminarlo de la teoría cíclica. Esta situación siguió siendo desconcertante para muchos, hasta las primeras décadas del siglo 21 cuando la recién descubierta energía oscura sembró una nueva esperanza para la cosmología cíclica.

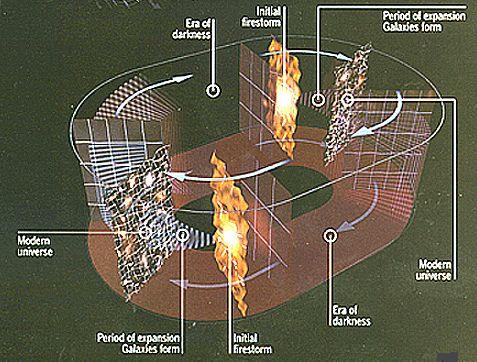

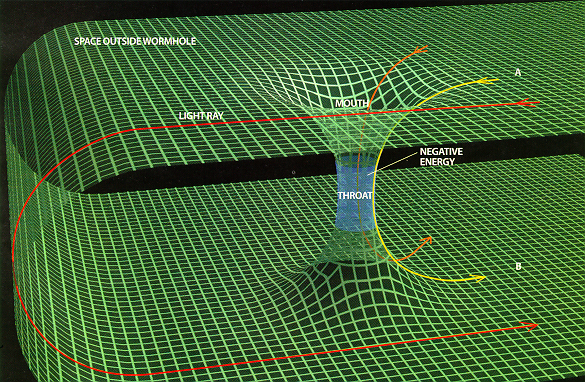

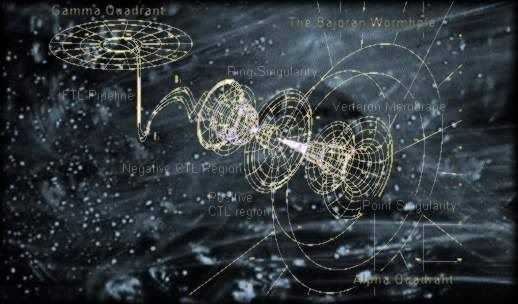

Un nuevo modelo cíclico es el modelo basado en la cosmología de branas sobre la formación del universo, derivado del anterior modelo ecpirótico. Se propuso en 2001 por Paul Steinhardt de la Universidad de Princeton y Neil Turok de la Universidad de Cambridge. La teoría describe un universo emergiendo hacia la existencia no sólo una vez, sino en repetidas ocasiones a través del tiempo. La teoría podría explicar por qué una misteriosa forma repulsiva de energía conocida como la “constante cosmológica” está acelerando la expansión del universo, que es de varios órdenes de magnitud menor que la predicha por el modelo estándar del Big Bang.

El modelo Steinhardt–Turok

En este modelo cíclico basado en la cosmología de branas, rival del modelo inflacionario, dos láminas tridimensionales o 3-branas colisionan periódicamente. Según esta teoría la parte visible del universo de cuatro dimensiones representa una de esas branas, quedando la otra brana oculta a todas las fuerzas de la naturaleza excepto la gravedad. Cada ciclo consiste en que cada una de las branas dentro de un espacio-tiempo tetradimensional y separadas por una dimensión espacial muy corta y seis enrolladas chocan con cierta periodicidad creando condiciones parecidas a las del big bang del modelo inflacionario.

Según la teoría, después de millones de años, al aproximarse el final de cada ciclo la materia y la radiación se diluyen a casi cero debido a una expansión acelerada del universo alisando las dos branas pero con pequeños rizos o fluctuaciones cuánticas aún presentes que imprimirán en el próximo choque con no uniformidades que crearán grumos o cúmulos que generarán estrellas y galaxias.

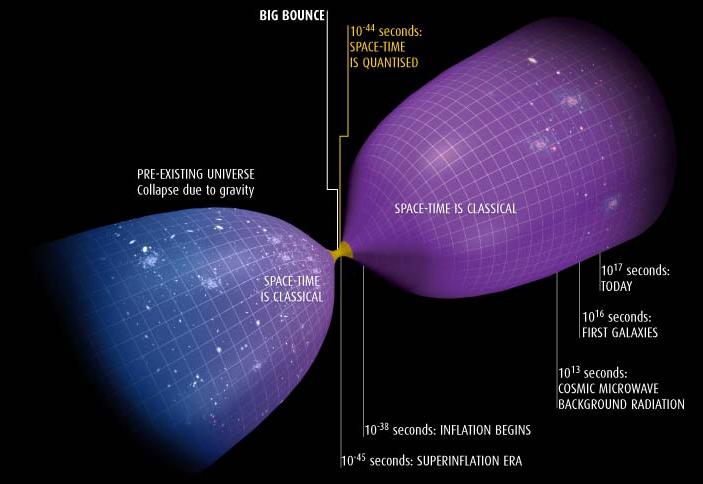

Otro modelo: El Big Bounce ( gran rebote) es un modelo científico teórico relacionado con la formación del Universo conocido. Se deriva del modelo cíclico o Universo oscilante e interpreta el Big Bang como el primer evento cosmológico resultado del colapso de un universo anterior.

Según algunos teóricos de Universo oscilante, el Big Bang fue simplemente el comienzo de un período de expansión que siguió a un período de contracción. Desde este punto de vista, se podría hablar de un Big Crunch seguido por un Big Bang, o, más sencillamente, un Big Bounce. Esto sugiere que podría se estar viviendo en el primero de todos los universos, pero se tiene la misma probabilidad de estar viviendo en el universo 2 mil millones (o cualquier otro de una secuencia infinita de otros universos).

La idea principal detrás de la teoría cuántica del “gran rebote” es que, a medida que se acerca la densidad a lo infinito, el comportamiento de la espuma cuántica cambia. Todas las llamadas constantes físicas fundamentales, incluida la velocidad de la luz en el vacío, no eran tan constantes durante el Big Crunch, especialmente en el intervalo de estiramiento 10-43 segundos antes y después del punto de inflexión. (Una unidad de Tiempo de Planck es de aproximadamente 10-43 segundos.)

Si las constantes físicas fundamentales se determinaron en un quantum de forma mecánica durante el Big Crunch, entonces sus valores aparentemente inexplicables en este universo no serían tan sorprendentes, entendiendo que aquí un universo es lo que existe entre un Big Bang y su Big Crunch. Como podeis comprobar, por falta de modelos no podemos quejarnos. Sin embargo, todo esto nos lleva a plantear una pregunta: ¿Será alguno de estos modelos el que refleje la realidad?

La respuesta a la pregunta anterior es ¡NO! De hecho, todos los modelos científicos tienen aplicabilidad limitada. Ninguno de ellos es “la verdad”. Cuando un científico afirma, por ejemplo, que el núcleo de un átomo está compuesto por partículas denominadas protones y neutrones, lo que en realidad debería decir es que el núcleo de un átomo se comporta, bajo determinadas circunstancias, como si estuviera formado de protones y neutrones. Los mejores científicos toman el “como sí “, pero entienden que sus modelos son, efectivamente, sólo modelos; científicos menores a menudo olvidan esta diferencia crucial.

Los científicos menores, y muchos no-científicos, tienen otra idea equivocada. A menudo piensan que el papel de los científicos hoy en día es llevar a cabo experimentos que probarán la exactitud de sus modelos con una precisión cada vez mayor (hacia posiciones con más y más decimales). ¡En absoluto! La razón para llevar a cabo experimentos que demuestren predicciones previas no comprobadas es descubrir dónde fallan los modelos. Encontrar defectos en sus modelos es la esperanza abrigada por los mejores científicos, porque esos defectos destacarán los lugares donde necesitamos una nueva comprensión, con modelos mejores, para progresar.

El arquetípico ejemplo de esto es la gravedad. La ley de la gravedad de Isaac Newton se consideró la pieza clave de la física durante más de doscientos años, desde la década de 1680 hasta comienzos del siglo XX. Pero había unas pocas, aparentemente insignificantes, cosas que el modelo newtoniano no podía explicar o predecir, referente a la órbita del planeta mercurio y al modo como la luz se curva cuando pasa cerca del Sol. El modelo de gravedad de Albert Einstein, basado en su teoría general explica lo mismo que el modelo de Newton pero también explica esos detalles sutiles de órbitas planetarias y curvatura de la luz. En ese sentido, es un modelo mejor que el anterior, y hace predicciones correctas (en particular, sobre el Universo en general) que el viejo modelo no hace. Pero el modelo de Newton todavía es todo lo que se necesita si se está calculando el vuelo de una sonda espacial desde la Tierra a la Luna.

¿SABEMOS COMO COMENZÓ EL UNIVERSO?

Está ahora ampliamente aceptado -de manera provisional- que el Universo donde habitamos surgió a partir de una singularidad con densidad y energía “infinitas” que dio lugar a una bola de fuego caliente y densa a la que llamamos Big Bang. En los años veinte y treinta, los astrónomos descubrieron por primera vez que nuestra Galaxia es simplemente una isla de estrellas dispersa entre muchas galaxias similares, y que grupos de estas galaxias se están apartando las unas de las otras a medida que el espacio se expande. Esta idea del Universo en expansión fue realmente predicha por la teoría general de la relatividad de Einstein, terminada en 1916 pero no se tomó en serio hasta que los observadores hicieron sus descubrimientos. Cuando se tomó en serio los matemáticos descubrieron que las ecuaciones describían exactamente el tipo de expansión que observamos, con la implicación de que si las galaxias se van alejando con el tiempo entonces deberían haber estado más juntas en el pasado, y hace mucho tiempo toda la materia en el Universo debería estar acumulada en una densa bola de fuego.

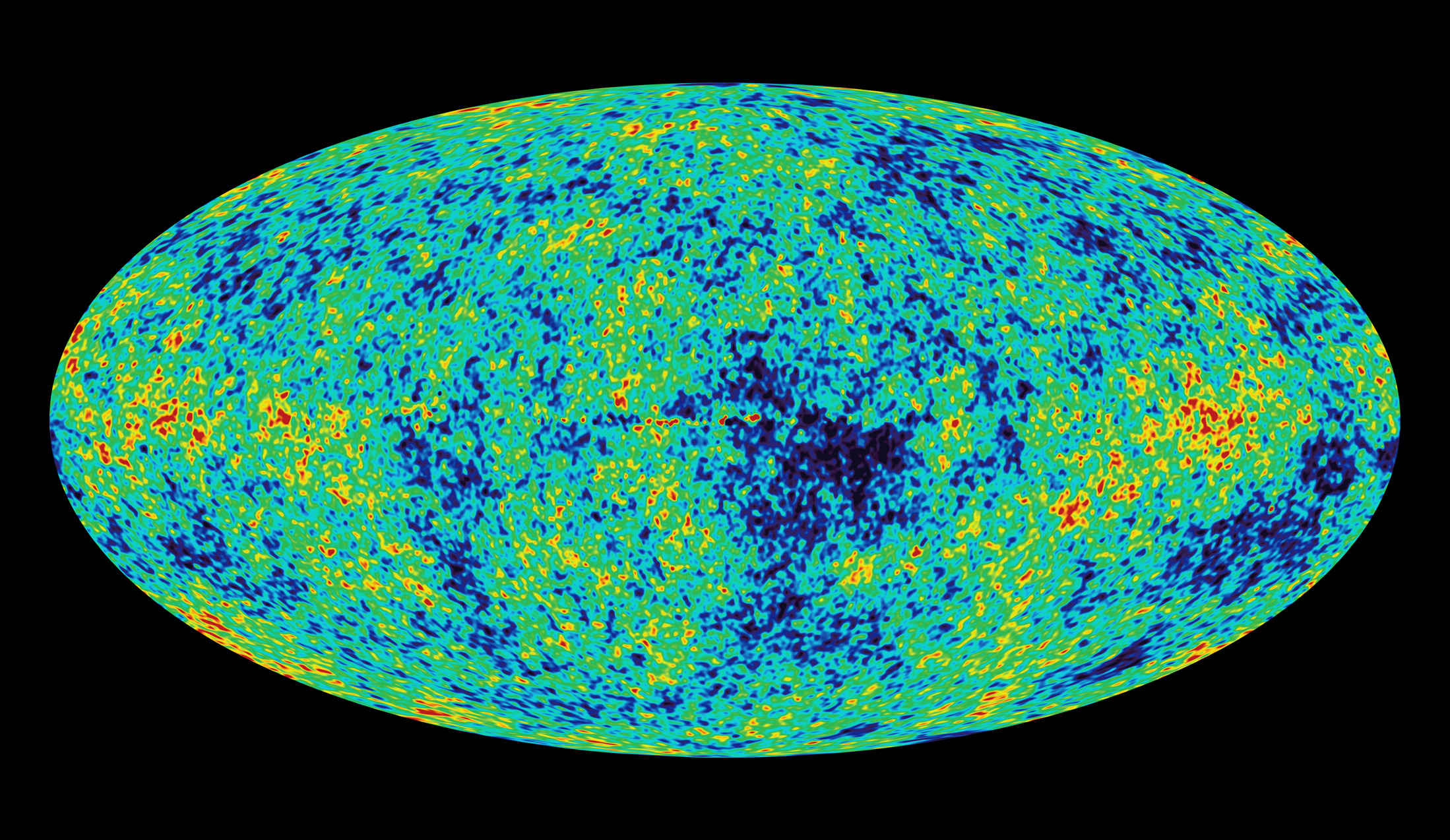

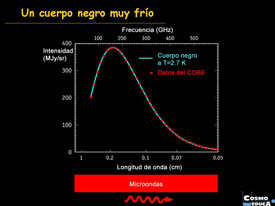

Es la combinación de la teoría y de la observación la que hace que la idea del Big Bang sea tan convincente; en los años sesenta llegó una clara evidencia, con el descubrimiento de un siseo débil de ruído de radio, la radiación cósmica de fondo, que viene de todas las direcciones del espacio y se interpreta como la radiación restante del mismo Big-Bang.

El descubrimiento de la radiación cósmica de fondo (RCF) por Penzias y Wilson en 1965 fue definitivo para “probar” el origen caliente del universo. Sin embargo, después de estas mediciones aun permanecían algunas dudas por resolver. Si la radiación detectada por Penzias y Wilson proviene realmente del universo recién formado hace 14 mil millones de años, ésta debe mostrar ciertas características. Para poder afirmar con certeza que el origen de la RCF es cósmico se deben verificar las siguientes observaciones:

Como la expansión del Universo, la existencia de esta radiación de fondo fue predicha por la teoría antes de ser observada experimentalmente. A finales del siglo XX, la combinación de teoría y observaciones había establecido que el tiempo que ha pasado desde el Big Bang es de unos 14 mil millones de años, y que existen cientos de miles de millones de galaxias como la nuestra dispersas de un extremo al otro del Universo en expansión.

La pregunta a la que se están enfrentando ahora los cosmólogos es ¿cómo empezó el mismo Big Bang?

El punto de partida para enfrentarnos a esta pregunta es el modelo estándar propio de los cosmólogos, que combina todo lo que han aprendido de las observaciones del universo en expansión con el entendimiento teórico del espacio y el tiempo incorporado a la teoría general de Einstein. El establecimiento de este modelo se ha visto favorecido por el hecho de que cuanto más lejos miramos del Universo, más tiempo atrás vemos. Debido a que la luz viaja a una velocidad finita, cuando miramos galaxias alejadas millones de años luz, la vemos como si estuvieran presentes como eran millones de años antes, cuando salió la luz que llega ahora a nuestros telescopios.

Con telescopios potentes, los astrónomos pueden ver qué aspecto tenía el Universo cuando era más joven (y la radiación cósmica de fondo nos permite “ver”-con radiotelescopios- la última etapa de la bola de fuego que fue el Big bang).

Lo más atrás que hemos visto, el origen de la radiación de fondo corresponde a un tiempo unos pocos cientos de miles de años después del momento del Big Bang, cuando todo el Universo estaba lleno de gas caliente (conocido técnicamente como plasma) a aproximadamente la misma temperatura que la que tiene la superficie del Sol hoy en día, unos pocos miles de grados Celsius. En ese momento, lo que ahora es el Universo visible entero era solo una milésima parte de su tamaño actual y no había objetos individuales en la escala de las estrellas o galaxias en el remolino de material caliente.

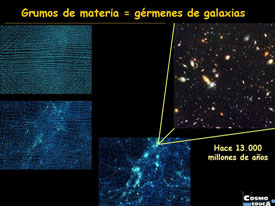

Moviéndonos hacia delante en el tiempo, las irregularidades observadas en la radiación de fondo son justamente del tamaño y estructura correctos que podrían explicar el origen de las galaxias y de los grupos de galaxias, pudieran ser las semillas a partir de las cuáles creció la estructura que vemos en el Universo hoy.

Yendo hacia atrás en el tiempo, la estructura de las pequeñas irregularidades vistas en la radiación de fondo nos habla sobre el tipo de irregularidades que había en el Universo cuando era incluso más joven, justo hasta ese momento atrás en que la teoría general por sí misma se rompe y, no nos deja pasar más allá del Tiempo de Planck.

Lo primero, y más importante, que hay que decir sobre estas irregularidades en la radiación de fondo es que son diminutas. Son tan pequeñas que al principio era imposible medirlas, y la radiación parecía que viniera perfectamente uniforme desde todas las direcciones en el espacio (isotropía). Si la radiación fuera perfectamente uniforme, todo el modelo estándar del Universo se desbarataría, ya que si no hubiera habido irregularidades en la bola de fuego del Big Bang no habría habido semillas desde donde las galaxias pudieran crecer, y nosotros al no haberse formado las estrellas y fabricado en sus núcleos los materiales complejos de los que estamos hechos, no estaríamos aquí. El hecho de que los científicos estén tratando de resolver estas preguntas han convencido a los astrónomos de que debería haber irregularidades en la radiación de fondo, sólo había que desarrollar instrumentos sensibles para medirlas.

En este sentido podríamos citar el satélite de la NASA COBE que fue capaz de hacer medidas suficientemente sensibles para demostrar que había efectivamente minúsculas ondulaciones en la radiación de fondo. Las dos preguntas clave derivadas del descubrimiento son: ¿por qué la radiación de fondo es casi lisa?, ¿Qué crea las ondulaciones?

La primera pregunta es más profunda de lo que se pueda pensar, porque incluso hoy, 14 mil millones de años después, el Universo es todavía casi liso. Esto no es obvio si contrastamos la luminosidad de una galaxia como nuestra Vía Láctea con la oscuridad del espacio entre las galaxias pero enseguida se hace evidente a mayores escalas. El Universo no es exactamente uniforme, pero incluso en términos de distribución de las galaxias es uniforme en cierto sentido. Si tomamos una fotografía de las galaxias vistas en una pequeña zona del cielo se parecerá mucho a otra fotografía de una zona del mismo tamaño de otra parte del cielo. La radiación de fondo es incluso más uniforme, y parece exactamente la misma desde todos los puntos del espacio dentro de una fracción del 1 por ciento. La profundidad de esta observación descansa en el hecho de que no ha pasado el tiempo suficiente desde el Big Bang para que todas las diferentes partes del Universo interactúen unas con otras y deje de ser liso.

Esta homogeneidad está relacionada con otra característica extraña del Universo denominada subplanitud. La teoría general de la relatividad nos dice que el espacio (en sentido estricto, el espacio-tiempo) se puede curvar y deformar por la presencia de materia. Localmente, cerca de un objeto como el Sol o la Tierra, esta deformación del espacio-tiempo produce el efecto que llamamos gravedad. Cósmicamente, en el espacio entre las estrellas y las galaxias el efecto combinado de toda la materia en el universo puede producir una curva gradual en el espacio en uno de los dos sentidos.

Aquí tendríamos que continuar hablando de la densidad crítica y de la clase de universo que tendríamos en función de la cantidad de materia que este contenga. Sin embargo, dejaremos ese punto del universo cerrado, abierto o plano, ya que, en uno de los comentarios muy recientes de esta colaboración ya quedaron explicados de manera suficiente.

El explorador Planck fue una misión propuesta por la ESA que se puso en órbita en el año 2007 y operando en las bandas infrarroja y submilimétrica, tomó imágenes de las anisotropías de la radiación cósmica de fondo en todo el cielo con resolución y sensibilidad excepcionales.

Estudios cada vez más sofisticados de la radiación de fondo, que culminaron con las observaciones hechas por el satélite WAP de la NASA a principios de éste siglo XXI y del Planck Explorer de ESA un poco más tarde, mostraron que el Universo efectivamente está indistinguiblemente cerca de la plenitud, de modo que su densidad debería estar indistinguiblemente cerca de la Densidad crítica. Esto dio lugar al rompecabezas de donde estaba la masa “desaparecida” (esa que llamamos materia oscura que, nunca se ha visto, ni produce radiación, ni sabemos como se pudo formar, de qué clase de partículas está conformada -si es que son partículas- y, un sin fin de interrogantes más que, de momento, no sabemos contestar).

En realidad, la teoría de la inflación es todavía un trabajo en progreso, y, como en el caso de la GUT, existen diferentes variaciones o modelos sobre el tema. Lo que está claro de todo esto es que, no se puede negar, ni el esfuerzo realizado, ni el éxito alcanzado que, sin ser aún lo que se desea, sí es un paso importante en el conocimiento del Cosmos. Ahora sabemos de él muchísimo más que se sabía en los tiempos de Galileo, y, tanto la técnica, como las matemáticas y la física, han desarrollado la Astronomía y la Astrofísica, hasta unos niveles encomiables, teniendo en cuenta que estamos estudiando una cosa muy, muy grande y cuyos objetos están muy, muy lejos.

Estas galaxias están a más de 13.000 Millones de años-luz de nosotros

Sin embargo, podemos obtener imágenes de galaxias lejanas y de nebulosas que se encuentran a miles y miles de millones de años-luz de la Tierra y, mediante técnicas del estudio del espectro, saber, de que materiales están formados esos objetos cosmológicos que pueblan nuestro universo en regiones tan remotas que nuestras mentes, no pueden asimilar.

Es aún muy grande el espacio oscuro que tenemos que alumbrar para conocer en plenitud nuestro vasto Universo, son muchas las zonas que están en la penumbra, y, debemos y tenemos la obligación de continuar profundizando en el saber del Universo que nos acoge.

Yo, que me considero un simple aficionado -eso sí-, muy enamorado del Universo y apasionado de todas las maravillas que encierra y que producen en mi esa fascinación que me inunda de asombro y, también, de maravilla. A veces pienso que todo el vasto Universo podría haber surgido de una fluctuación cuántica del “vacío”, ese lugar misterioso que resulta estar lleno a rebosar y que, gracias a la combinación de inflación y a una curiosa propiedad de la gravedad, dio lugar a la creación de un nuevo universo de los muchos que podrían ser.

Esta curiosa propiedad de la gravedad es que guarda energía negativa. Cuando algo (¡cualquier cosa!) cae hacia debajo de un campo gravitacional (como el agua que se precipita desde la montaña) la energía es liberada………Pero eso, será otra historia que ya contaremos. Ahora, para no cerrar en falso el comentario, diré que, no existe ningún límite, en principio, en cuanta masa (en sentido estricto masa-energía, teniendo en mente E=mc2) puede tener una fluctuación cuántica, aunque cuanto más masiva sea una fluctuación, menos probable es que suceda.

Las ondas de luz normalmente tienen una densidad de energía positiva o cero en diferentes puntos del espacio (arriba). Pero en un estado comprimido, la densidad de la energía, en un instante determinado en el tiempo, puede llegar a ser negativa en algunos lugares (abajo). Para compensar esto, el pico de densidad positiva debe aumentar.

¡Son tántas, las cosas que no sabemos!

El cosmólogo americano Ed Tyron señaló que en principio una fluctuación cuántica que contiene la masa-energía de todo el Universo visible podría salir de la “nada”, y que aunque la masa-energía de tal fluctuación sería enorme, en las circunstancias correctas la energía gravitacional negativa del campo gravitacional asociado a toda esta masa equilibraría perfectamente esto, de modo que la energía total de la fluctuación sería cero.

La implicación, naturalmente, es que nuestro Universo nació (o brotó) de este modo desde el espacio-tiempo de otro universo, y que no hubo principio y no habrá final. Sólo un mar infinito de universos burbujas interconectados como han propùestos algunos.

emilio silvera

Totales: 67.182.439

Totales: 67.182.439 Conectados: 59

Conectados: 59