Dic

31

Conocer mejor el planeta Tierra

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Tierra y su energía ~

Clasificado en La Tierra y su energía ~

Comments (1)

Comments (1)

Esta es nuestra casa y, debemos procurar mantenerla limpia, no por si viene una visita sino que, es vital para nosotros y para vida en general. No siempre somos conscientes del daño que muchas de nuestras actividades pueden hacer al planeta que nos cobija. Pero veámos algunos detalles que definen a este planeta único en nuestro entorno espacial.

Las fuerzas que actúan sobre la Tierra, como planeta en el espacio, tiene profundas implicaciones energéticas. La gravitación ordena y orienta, y obstaculiza y facilita los flujos de energía cinética. La rotación genera la fuerza centrífuga y la de Coriolis: la primera achata el planeta por los polos ensanchándolo por el ecuador, y la segunda desvía los vientos y las corrientes de los océanos (a la derecha del hemisferio norte y a la izquierda en el hemisferio sur). La rotación es también la causa de los ritmos diarios de las plantas y animales, y de la desaceleración de la Tierra, que alarga el día un promedio de 1’5 ms cada siglo, lo que representa una pérdida de tres teravatios por fricción de mareas.

Pero ni la gravitación ni la rotación (fricción) hacen de la Tierra un planeta único entre los cuerpos celestes de nuestro entorno. Su exclusividad procede de sus propiedades térmicas internas, que causan los ciclos geotectónicos que modifican la superficie, y de su atmósfera, océanos y plantas que transforman la radiación solar que reciben. Los orígenes de estos procesos no están claros.

Podemos fijar la edad de la Tierra en algo más de los 4.000 millones de años por la desintegración de los isótopos radiactivos, pero poco podemos asegurar sobre la formación del planeta o sobre la energética de la Tierra primitiva. Sobre el tema circulan varias teorías, y es muy plausible que el origen del Sistema Solar planetario fuera una nube interestelar densa en la que el Sol se formó por una inestabilidad gravitatoria y que la posterior aglomeración del resto de esta materia dispersa, que giraba a distintas distancias, a su alrededor, diera lugar a los planetas. No está claro si al principio la Tierra estaba extremadamente caliente o relativamente fría. Me inclino por lo primero y estimo que el enfriamiento fue gradual con los cambios de atmósferas y la creación de los océanos.

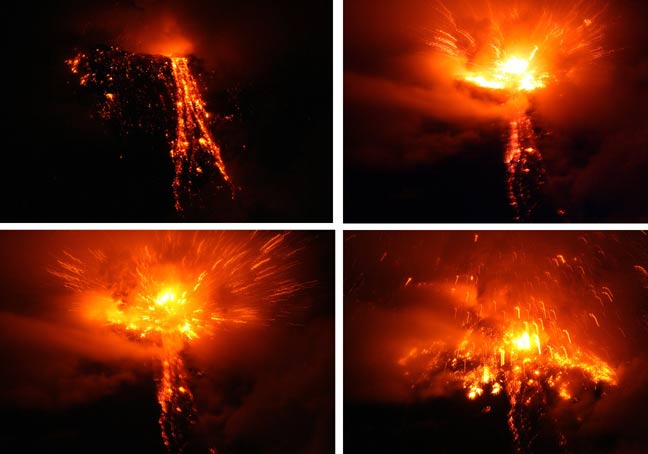

Esta de arriba podría ser una imagen cotidiana en la Tierra primitiva

Las incertidumbres geológicas básicas se extienden hasta el presente. Diferentes respuestas a cuestiones como la cantidad de 40K en el núcleo terrestre o sobre la convección del magma en el manto (hay una o dos celdas) dan lugar a diferentes explicaciones para el flujo de calor y la geotectónica de la Tierra. Lo que sí está claro es que el flujo interno de calor, menos de 100 mW/m2, tiene un efecto pequeño comparado con la reflexión, absorción y emisión de la radiación solar.

El balance de la radiación terrestre (Rp) en la capa alta de la atmósfera es la suma de la radiancia extraterrestre (la constante sola Q0) reducida por el albedo planetario y el flujo saliente de larga longitud de onda (Qi): Rp = Q0(1-ap) + Qi = 0. El flujo emitido es igual a la suma de la radiación atmosférica y la terrestre: Qi = Qea + Qes. Los balances de la radiación en la atmósfera (Ra) y en la superficie de la Tierra (Rs) son iguales, respectivamente, a la diferencia entre la correspondiente absorción y emisión: Ra = Qaa + Qea y Rs = Qas + Qes, de manera que Rp = Ra + Rs = 0. Hay que continuar explicando la radiación saliente con los flujos irradiados y emitidos por la superficie terrestre, el flujo de radiación medio absorbida, etc., etc., etc., con una ingente reseña de símbolos y tedioso esquemas que, a mi parecer, no son legibles para el lector normal y no versado en estos conocimientos. Así que, aunque sea mutilar el trabajo, desisto de continuar por ese camino y prosigo por senderos más amenos y sugestivos para el lector.

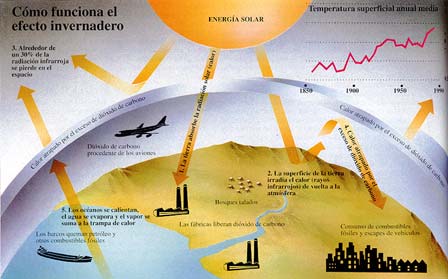

El impacto de la radiación solar en la atmósfera terrestre, en una gran tormenta solar de 2003. (Crédito: NASA / Goddard

La fuente más importante del calentamiento atmosférico proviene de la radiación terrestre de longitud de onda larga, porque el flujo de calor latente es una contribución secundaria y el flujo de calor sensible sólo es importante en las regiones áridas donde no hay suficiente agua para la evaporación. Los océanos y los continentes también reciben indirectamente, irradiadas por la atmósfera, la mayor parte de su calor en forma de emisiones de longitudes de onda larga (4 – 50 μm). En este flujo de radiación reenviado hacia la superficie terrestre por los gases invernadero, domina a la radiación del vapor de agua, que con una concentración variable, emite entre 150 y 300 W/m2, y al que también contribuye el CO2 con unos 75 W/m2.

El intercambio de radiación de longitud de onda larga entre la superficie y la atmósfera sólo retrasa temporalmente las emisiones de calor terrestre, pero controla la temperatura de la biosfera. Su máximo es casi 400 W/m2 en los trópicos nubosos, pero es importante en todas las estaciones y presenta significativas variaciones diarias. El simple paso de una nube puede aumentar el flujo en 25 W/m2. Las mayores emisiones antropogénicas de gases invernadero han aumentado este flujo en cerca de un 2’5 W/m2 desde finales del siglo XIX.

Como era de esperar, las observaciones de los satélites confirman que el balance de energía de la Tierra está en fase con la radiación solar incidente (Q0), pero la radiación media saliente (Qi) está desfasada con la irradiancia, alcanzando el máximo durante el verano en el hemisferio norte. La distribución asimétrica de los continentes y el mar explica este fenómeno. En el hemisferio norte, debido a la mayor proporción de masa terrestre, se experimentan mayores cambios estacionales que dominan el flujo global de la radiación saliente.

Quizás el resultado más sorprendente que se deriva de las observaciones por satélite sea que, estacionalmente, se observan cierto déficit y superávit de radiación y el balance de la radiación en el planeta no es igual a cero, pero sin embargo, en cada hemisferio la radiación anual está en equilibrio con el espacio exterior. Además, la contribución atmosférica por transporte de energía hacia los polos es asimétrica respecto al ecuador con valores extremos de unos 3 PW cerca de los 45º N, y -3 PW cerca de 40º S.

Podría continuar hablando sobre los vientos, los terremotos, las lluvias y otros fenómenos atmosféricos, sin embargo, no creo que, por ser estos fenómenos naturales muy conocidos de todos, pudieran tener gran interés. Pasemos pues a comentar sobre los océanos.

El agua de la vida

Agua, mejor que Tierra, habría sido el nombre adecuado para el tercer planeta, puesto que los océanos cubren más del 70 por ciento de la superficie terrestre, con una profundidad media de 3’8 Km. Debido a las especiales propiedades térmicas del agua, éstas constituyen un extraordinario regulador del balance energético del planeta.

Este líquido tiene cinco ventajas termodinámicas importantes: un punto de ebullición inusualmente alto, debido a su capacidad para formar enlaces de hidrógeno intermoleculares; un calor específico de 2’5 a 3’3 veces más elevado que el del suelo; una capacidad calorífica (calor específico por unidad de volumen) aproximadamente seis veces mayor que la tierra seca; un altísimo calor de vaporización que le permite transportar una gran cantidad de calor latente; y su relativamente baja viscosidad, que le convierte en un eficiente transportador de calor en los océanos mediante miríadas de remolinos y caudalosas corrientes.

Los océanos de la Tierra vistos desde el espacio

No es sorprendente, pues, que los océanos, que tienen cerca del 94 por ciento de toda el agua, sean determinantes en el balance energético del planeta. Cuatro quintas partes de la radiación solar que llega a la Tierra entra en la atmósfera que cubre los océanos, los cuales con un albedo superior al 6% absorben la energía con una tasa cercana a 65 PW, casi el doble de la absorción atmosférica total y cuatro veces mayor que la continental. Inevitablemente, los océanos también absorben la mayor parte, casi dos tercios, del calor rerradioirradiado hacia abajo por la atmósfera elevando su ritmo de calentamiento a los 175 PW.

Salvo en los océanos menos profundos, la interacción aire-mar no afecta directamente a las aguas profundas. Las oscuras y frías aguas de las profundidades marinas están aisladas de la atmósfera por la capa mixta, una capa de poca profundidad que va de pocos metros a pocos cientos de metros y que está afectada por los vientos y el oleaje.

A pesar de que el alto calor específico del agua limita el rango de variación, las temperaturas de esta capa sufren importantes fluctuaciones diarias y estacionales. Sin embargo, variaciones relativamente pequeñas de la temperatura de la superficie de los océanos tienen importantes consecuencias climáticas: quizás el mejor ejemplo de esta teleconexión climática sea el fenómeno del Niño, que consiste en una extensión en forma de lengua de las aguas superficiales calientes hacia el este, cuyos efectos se extienden desde Canadá hasta África del sur.

En esta “coreografía” acuática, también tiene un papel significativo el Estrecho de Dinamarca, que se alimentan de las aguas más profundas de la AMOC y las devuelve al sur a través de brechas en la cordillera de Groenlandia y Escocia. En este sentido, los científicos explican que, durante años, se ha pensado que el estrecho danés, que ha aumentado considerablemente su capacidad como consecuencia del deshielo, se abastecía de una corriente adyacente a Groenlandia.

Debido a que la conductividad térmica del agua es muy baja, la transferencia de energía de la capa mixta hacia las profundidades se realiza fundamentalmente mediante corrientes convectivas. Estas corrientes compensan la extremadamente baja fuerza ascensional de las aguas profundas, más calientes, que son desplazadas por el movimiento hacia el ecuador de las corrientes frías provenientes de los polos. En contraste con el gradual ascenso general de las aguas oceánicas, la convección hacia abajo se produce en corrientes bien delimitadas que forman gigantescas cataratas oceánicas. Seguramente la mayor es la que fluye hacia el sur bajo el estrecho de Dinamarca, entre Islandia y Groenlandia, y se sumerge unos 3’5 Km transportando 5 millones de m3/s, un caudal veinte veces mayor que el del Amazonas.

Miríadas de corrientes oceánicas, que a menudo viajan cientos de kilómetros a diferentes profundidades, transportan considerables cantidades de energía y sal. Quizás el ejemplo más importante de estas combinaciones de transportes sea la corriente de agua caliente y salada que sale del Mediterráneo a través del estrecho de Gibraltar. Este flujo caliente pero denso desciende sobre la pendiente de la plataforma continental hasta alcanzar el equilibrio entre el peso y el empuje ascensional a unos mil metros de profundidad. Aquí se separa en dos celdas lenticulares que se mueven durante siete años hacia el este y hacia el sur, respectivamente, hasta que decaen o chocan contra alguna elevación marina.

Si el Estrecho de Gibraltar pudiera contar su historia…

Un mapa global de los flujos de calor desde la superficie oceánica hasta las capas profundas muestra claramente máximos longitudinales a lo largo del ecuador y a lo largo de aproximadamente 45º S en los océanos Atlántico e Índico. Esta transferencia es también importante en algunas áreas costeras donde se producen intensos flujos convectivos ascendentes que intercambian calor entre las aguas superficiales y las profundas, como ocurre en la costa de California y al oeste de África. Un flujo en dirección contraria, que calienta la atmósfera, se produce en las dos mayores corrientes oceánicas calientes, la corriente del Golfo en el Atlántico y la de Kuroshio en el Pacífico oriental.

Todas la regiones donde se produce este ascenso de aguas calientes (a lo largo de las costas del continente americano, África, India y la zona ecuatorial del Pacífico occidental) se distinguen fácilmente por los elevados niveles de producción de fitoplancton, causados por un importante enriquecimiento de nutrientes, comparados con los que, de otra manera, corresponderían normalmente a las aguas superficiales oligotrópicas.

La radiación transporta la mayor parte (casi 4/5) de la energía que fluye desde la capa mixta hasta la atmósfera, y el resto del flujo calorífico se produce por calor latente en forma de vapor de agua y lluvias.

Océano Atrlántico

Aún no se ha realizado una valoración cuantitativa del transporte total para cada latitud, pero en el océano Atlántico hay transferencia de calor hacia el norte a lo largo de toda su extensión, alcanzando en el trópico un valor aproximado de 1 PW, flujo equivalente al que se produce en el Pacífico norte. En el Pacífico sur, el flujo de calor hacia el polo a través del trópico es de 0’2 PW. La parte occidental del Pacífico sur puede constituir la mayor reserva de calor del Atlántico sur, de igual modo que es probable que el océano Índico sur constituya una reserva del Pacífico.

Ahora tocaría comentar algo sobre los ríos del planeta, sin embargo, lo obvio y me dirijo directamente a comentar sobre el calor de la Tierra.

Aunque la Tierra se formara inicialmente a partir de materia fría (material cósmico) que se contrajo por acción de la gravedad, durante la formación posterior del núcleo líquido y en los periodos de intensa actividad volcánica se ha liberado una enorme cantidad de calor. Los frecuentes impactos de objetos pesados también han contribuido al calentamiento de la superficie. Hay mucha incertidumbre sobre la historia térmica de la Tierra de los últimos 3.000 millones de años, durante los cuales el planeta se ha ido enfriando y una gran parte de este flujo de calor ha alimentado los movimientos geotectónicos globales, creando nueva corteza en las dorsales oceánicas; un proceso que ha ido acompañado de terremotos recurrentes y erupciones volcánicas de lava, cenizas y agua caliente.

Solamente hay dos posibles fuentes de calor terrestre, pero la importancia relativa de las respectivas contribuciones no está aún muy clara. El calor basal, liberado por un lento enfriamiento del núcleo terrestre debe representar una gran parte del flujo total, si bien cálculos basados en la desintegración radiactiva del U235, U238, Th232 y K40 sugieren que éste representa al menos la mitad y quizás hasta nueve décimos del flujo total de calor del planeta. Esta disparidad obedece a la incertidumbre en la concentración de K40 en la corteza terrestre. Pero sea cual sea la proporción, el flujo total, basado en miles de medidas realizadas desde los años cincuenta, está próximo a los 40 TW.

Aunque inicialmente se pensó que los flujos continentales y oceánicos eran aproximadamente iguales, en realidad difieren de forma sustancial. Las regiones del fondo oceánico más recientes contribuyen con más de 250 mW/m2, cantidad que supera hasta tres veces las zonas continentales más recientes. El flujo medio para todo el fondo marino es aproximadamente igual a 95 mW/m2, lo que representa un 70% más que el correspondiente a la corteza continental. El flujo medio global es de 80 mW/m2, unos tres órdenes de magnitud inferior al valor medio del flujo de calor de la radiación solar global.

Publica: emilio silvera

La fuente del presente trabajo, aunque variada en texto e imágenes, en su mayor parte está en una guía ilustrada de la biosfera y la civilización de Vaclav Smil.

Dic

30

¡Objetos misteriosos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Agujeros negros ~

Clasificado en Agujeros negros ~

Comments (1)

Comments (1)

Kip Thorne, especialista en Agujeros Negros nos cuenta en uno de sus libros, cómo algunos científicos especializados como él, pudieron despejar muchas de las incógnitas escondidas en los misteriosos objetos. La idea de que Agujeros negros gigantes podían activar los cuásares y las radiogalaxias fue concebida por Edwin Salpeter y Yakov Borisovich Zel´dovich en 1964. Esta idea era una aplicación obvia del descubrimiento de dichos personajes de que las corrientes de gas, cayendo hacia un agujero negro, colisionarían y radiarían.

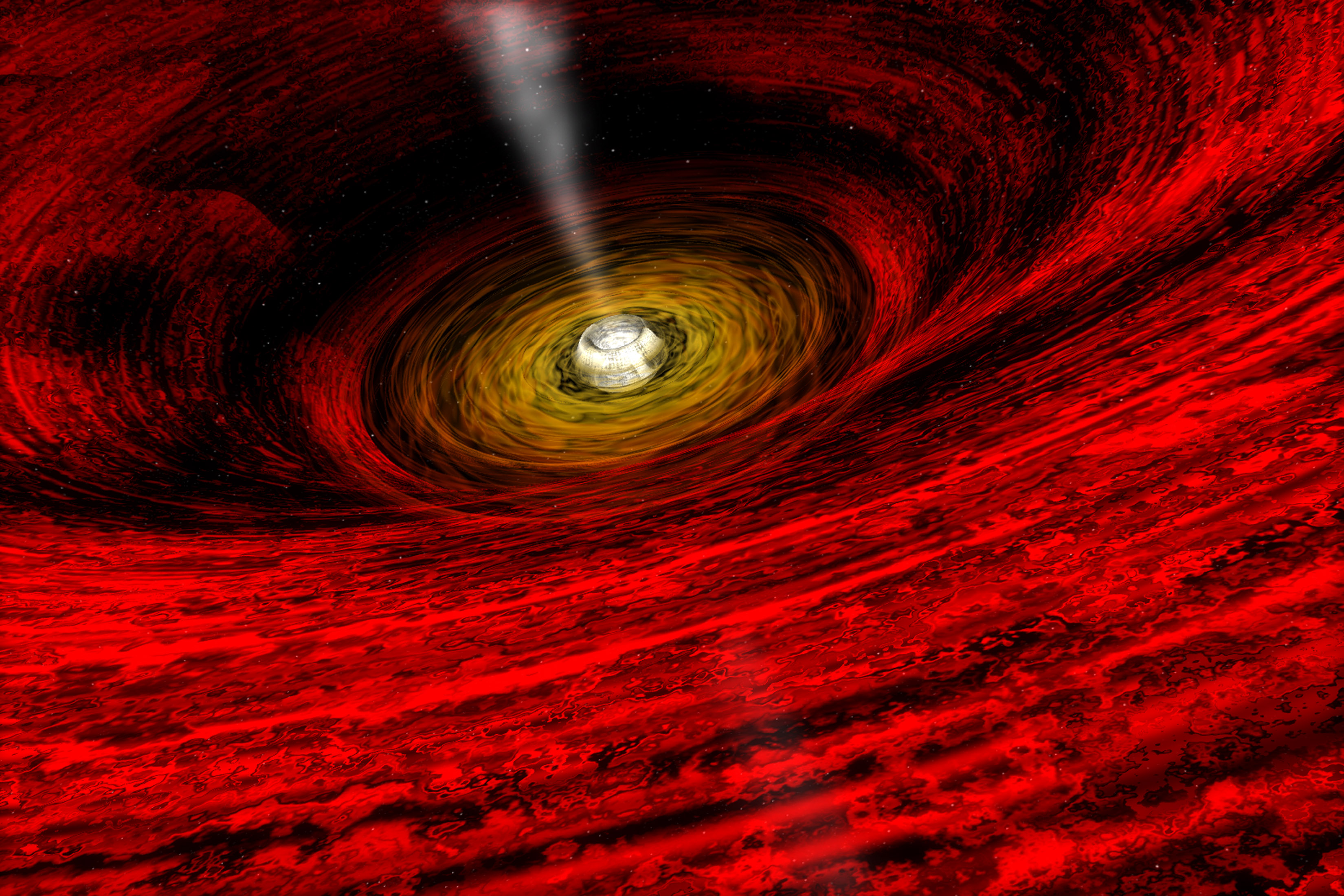

Una descripción más completa y realista de la caída de corriente de gas hacia un agujero negro fue imaginada en 1969 por Donald Lynden-Bell, un astrofísico británico en Cambridge. Él argumentó convincentemente, que tras la colisión de las corrientes de gas, estas se fundirían, y entonces las fuerzas centrífugas las harían moverse en espiral dando muchas vueltas en torno al agujero antes de caer dentro; y a medida que se movieran en espiral, formarían un objeto en forma de disco, muy parecidos a los anillos que rodean el planeta Saturno: Un disco de Acreción lo llamó Lynden-Bell puesto que el agujero está acreciendo (todos hemos visto la recreación de figuras de agujeros negros con su disco de acreción).

En Cygnus X-1, en el centro galáctico, tenemos un Agujero Negro modesto que, sin embargo, nos envía sus ondas electromagnéticas de rayos X. En el disco de acreción, las corrientes de gas adyacentes rozarán entre sí, y la intensa fricción de dicho roce calentará el disco a altas temperaturas.

En los años ochenta, los astrofísicos advirtieron que el objeto emisor de luz brillante en el centro de 3C273, el objeto de un tamaño de 1 mes-luz o menor, era probablemente el disco de acreción calentado por la fricción de Lynden-Bell.

Fue en 1963 cuando M. Schmidt identificó por primera vez al quasar 3C 273

Normalmente pensamos que la fricción es una pobre fuente de calor. Sin embargo, puesto que la energía gravitatoria es enorme, mucho mayor que la energía nuclear, la fricción puede realizar fácilmente la tarea de calentar el disco y hacer que brille con un brillo 100 veces mayor que la galaxia más luminosa.

¿Cómo puede un agujero negro actuar como un giróscopo? James Bardeen y Jacobus Petterson de la Universidad de Yale comprendieron la respuesta en 1975: si el agujero negro gira rápidamente, entonces se comporta precisamente como un giróscopo. La dirección del eje del giro permanece siempre firme fijo e inalterado, y el remolino creado por el giro en el espacio próximo al agujero permanece siempre firmemente orientado en la misma dirección.

Bardeen y Petterson demostraron mediante un cálculo matemático que este remolino en el espacio próximo al agujero debe agarrar la parte interna del disco de acreción y mantenerlo firmemente en el plano ecuatorial del agujero; y debe hacerlo así independientemente de cómo esté orientado el disco lejos del agujero.

A medida que se captura nuevo gas del espacio interestelar en la parte del disco distante del agujero, el gas puede cambiar la dirección del disco en dicha región, pero nunca puede cambiar la orientación del disco cerca del agujero. La acción giroscópica del agujero lo impide. Cerca del agujero el disco sigue y permanece siempre en el plano ecuatorial del mismo.

Sin la solución de Kerr a la ecuación de campo de Einstein, esta acción giroscópica hubiera sido desconocida y habría sido imposible explicar los cuásares. Con la solución de Kerr a mano, los astrofísicos de mitad de los años setenta estaban llegando a una explicación clara y elegante. Por primera vez, el concepto de un agujero negro como un cuerpo dinámico, más que un simple “agujero en el espacio”, estaba jugando un papel central en la explicación de las observaciones de los astrónomos.

¿Qué intensidad tendrá el remolino del espacio cerca de un agujero gigante? En otras palabras, ¿cuál es la velocidad de rotación de los agujeros gigantes? James Bardeen dedujo la respuesta: demostró matemáticamente que la acreción de gas por el agujero debería hacer que el agujero girase cada vez más rápido. Cuando el agujero hubiera engullido suficiente gas en espiral para duplicar su masa, el agujero debería estar girando casi a su velocidad máxima posible, la velocidad más allá de la cual las fuerzas centrífugas impiden cualquier aceleración adicional. De este modo, los agujeros negros gigantes deberían tener típicamente momentos angulares próximos a su valor máximo.

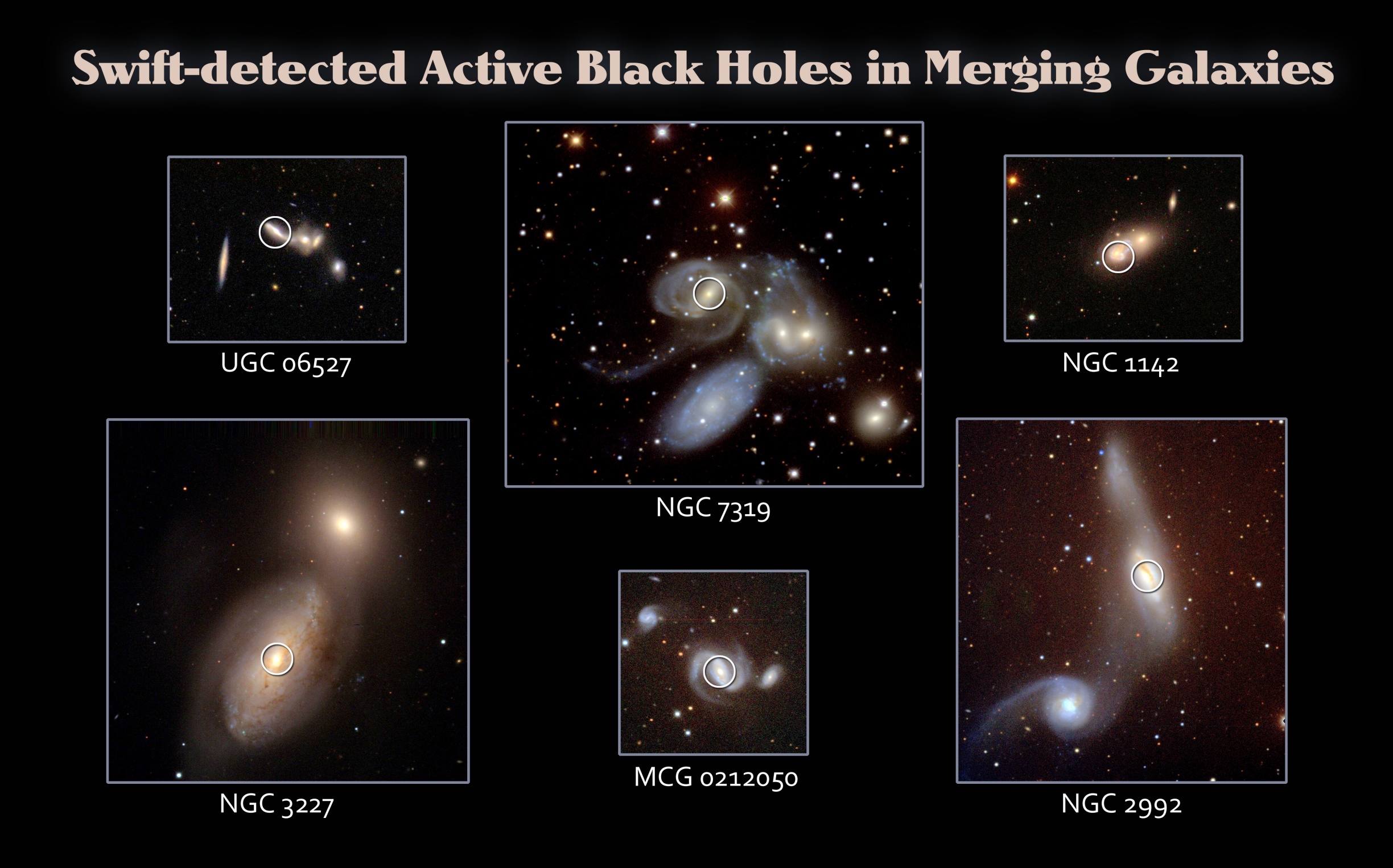

En las imágenes podemos contemplar galaxias que se fusionarán y, sus agujeros negros centrales se harán gigantes

¿Cómo puede un agujero negro y su Disco dar lugar a dos chorros que apuntan en direcciones opuestas? De una forma sorprendentemente fácil, reconocieron Blandford, Rees y Lynden-Bell en la Universidad de Cambridge a mediados de los setenta. Hay cuatro formas posibles de producir chorros; cualquiera de ellas funcionaria, y, aquí, donde se explica para el no versado en estos objetos cosmológicos, sólo explicaré el cuarto método por ser el más interesante:

El Agujero es atravesado por la línea de campo magnético. Cuando el agujero gira, arrastra líneas de campo que le rodean, haciendo que desvíen el plasma hacia arriba y hacia abajo. Los chorros apuntan a lo largo del eje de giro del agujero y su dirección está así firmemente anclada a la rotación giroscópica del agujero. El método fue concebido por Blandford poco después de que recibiera el doctorado de física en Cambridge, junto con un estudiante graduado de Cambridge, Roman Znajek, y es por ello llamado el proceso Blandford-Znajet.

Algunos dicen que en los agujeros negros está la puerta hacia la quinta dimensión

Este proceso es muy interesante porque la energía que va a los chorros procede de la enorme energía rotacional del agujero (esto debería parecer obvio porque es la rotación del agujero la que provoca el remolino en el espacio, y es el remolino del espacio el que provoca la rotación de las líneas de campo y, a su vez, es la rotación de las líneas de campo la que desvía el plasma hacia fuera.)

¿Cómo es posible, en este proceso Blandford-Znajet, que el horizonte del agujero sea atravesado por líneas de campo magnético? tales líneas de campo serían una forma de “pelo” que puede convertirse en radiación electromagnética y radiada hacia fuera, y por consiguiente, según el teorema de Price, deben ser radiadas hacia fuera. En realidad, el teorema de Price solo es correcto si el agujero está aislado, lejos de cualquier otro objeto.

Pero el agujero que estamos discutiendo no está aislado, está rodeado de un disco de acreción. Así que las líneas de campo que surgen del agujero, del hemisferio norte y las que salen del hemisferio sur se doblarán para empalmarse y ser una continuación una de otra, y la única forma de que estas líneas puedan entonces escapar es abriendo su camino a través del gas caliente del disco de acreción. Pero el gas caliente no permitirá que las líneas de campo lo atraviesen; las confina firmemente en la región del espacio en la cara interna del disco, y puesto que la mayor parte de dicha región está ocupada por el agujero, la mayoría de las líneas de campo confinadas atravesarán el agujero.

¿De donde proceden esas líneas de campo magnético? Del propio disco.

Cualquier gas en el Universo está magnetizado, al menos un poco, y el gas del disco no es una excepción. Conforme el agujero acrece, poco a poco, gas del disco, el gas lleva con él líneas de campo magnético. Cada pequeña cantidad de gas que se aproxima al agujero arrastra sus líneas de campo magnético y, al cruzar el horizonte, deja las líneas de campo detrás, sobresaliendo del horizonte y enroscándose. Estas líneas de campo enroscadas, firmemente confinadas por el disco circundante, extraerían entonces la energía rotacional del agujero mediante el proceso de Blandford-Znajet.

Los métodos de producir chorros (orificios en una nube de gas, viento de un embudo, líneas de campo arremolinadas ancladas en el disco, y el proceso Blandford-Znajet) actúan probablemente, en grados diversos, en los cuásares, en las radiogalaxias y en los núcleos característicos de algunos otros tipos de galaxias (núcleos que se denominan núcleos galácticos activos).

Si los cuásares y las radiogalaxias están activados por el mismo tipo de máquina de agujero negro, ¿qué hace que parezcan tan diferentes? ¿Por qué la luz de un cuásar aparece como si procediera de un objeto similar a una estrella, intensamente luminoso y de un tamaño de 1 mes-luz o menos, mientras que la luz de radiogalaxias procede de un agregado de estrellas similar a la Vía Láctea, de un tamaño de 100.000 años-luz?

Parece casi seguro que los cuásares no son diferentes de las radiogalaxias; sus máquinas centrales también están rodeadas de una galaxia se estrellas de un tamaño de 100.000 a.l. Sin embargo, en un cuásar el agujero negro central está alimentado a un ritmo especialmente elevado por el gas de acreción y, consiguientemente, el calentamiento friccional del disco es también elevado. Este calentamiento del disco hace que brille tan fuertemente que su brillo óptico es cientos o miles de veces que el de todas las estrellas de la galaxia circundante juntas.

Los astrónomos, cegados por el brillo del disco, no pueden ver las estrellas de la galaxia, y por ello el objeto parece “cuasi estelar” (es decir, similar a una estrella; como un minúsculo punto luminoso intenso) en lugar de parecer una galaxia.

La región más interna del disco es tan caliente que emite rayos X; un poco más lejos el disco está más frío y emite radiación ultravioleta; aún más lejos está más frío todavía y emite radiación óptica (luz); en su región mas externa está incluso más frío y emite radiación infrarroja. La región emisora de luz tiene típicamente un tamaño de aproximadamente un año-luz, aunque en algunos casos, tales como 3C273, puede ser de un mes luz o más pequeña.

Estas explicaciones para los cuásares y las radiogalaxias basadas en agujeros negros son tan satisfactorias que es tentador asegurar que deben ser correctas.

Está claro que hemos podido acceder a muchos conocimientos que no hace mucho tiempo eran impensables pero, las teorías de Einstein y Planck, deben ser sobrepasadas y debemos ir mucho más lejos, allí donde residen esas respuestas que hasta el momento nadie ha sabido dar y que responderán a preguntas que fueron posibles formular, gracias a Einstein y Planck, ya que, sin los conocimientos que ellos nos hicieron llegar, no podríamos intuir que hay muchas cosas que están más allá de sus postulados.

emilio silvera

Dic

30

Os hablaré de REMS, una estación meteorológica especial

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en exploración del espacio ~

Clasificado en exploración del espacio ~

Comments (0)

Comments (0)

Javier Gómez-Elvira, investigador del CAB (INTA-CSIC): “REMS registrará seis parámetros atmosféricos distintos”

23/11/2011

(infoespacial.com) Madrid.- Javier Gómez-Elvira, ingeniero en robótica del Centro de Astrobiología (CAB) del INTA-CSIC, e investigador principal del REMS (Rover Environmental Monitoring Station), explica que el instrumento desarrollado en España para Curiosity registrará seis parámetros atmosféricos: dirección y velocidad del viento, presión, humedad relativa, temperatura del aire, temperatura del terreno y radiación ultravioleta. (por cierto, se ha detectado que la atmósfera de Marte está saturada de vapor de agua?

Todos los sensores están localizados en torno a tres elementos: dos brazos unidos al Mástil de Teledetección (RSM), el sensor ultravioleta (UVS) situado en la cubierta superior del rover, y la Unidad de Control de Instrumentos (ICU) integrada dentro del vehículo.

“Los brazos son de aproximadamente de 1.5 metros por encima del nivel del suelo. La longitud de los mismos es similar al diámetro del RSM, y por lo tanto, la perturbación del flujo de viento por el RSM puede alcanzar la punta del brazo donde está ubicado el sensor de viento”, señala el investigador.

El Rover Environmental Monitoring Station (REMS) es un instrumento desarrollado en el Centro de Astrobiología (INTA-CSIC) para explorar el medio ambiente en la superficie de Marte a borde del Mars SciencieLaboratory (MSL) de la Agencia Espacial de los EE UU (NASA). El MSL bautizado para el gran público como Curiosity es un vehículo que estudiará la habitabilidad del planeta y valorará si Marte fue o es todavía entorno adecuado para poder sostener la vida microbiana.

En su operación nominal a lo largo de un período mínimo de dos años terrestres (un año marciano, aproximadamente), REMS registrará durante un intervalo de cinco minutos cada hora, la temperatura del aire, la presión, la humedad relativa, la temperatura del suelo, la velocidad y dirección del viento y la radiación ultravioleta (UV).

El registro sistemático de dichas variables medioambientales permitirá caracterizar, entre otros fenómenos, la dinámica de capa límite de la atmósfera marciana, ciclos del agua y del polvo, y los niveles de radiación UV, contribuyendo de este modo a los objetivos fundamentales de la misión MSL.

La construcción, calibrado y prueba del instrumento REMS ha sido dirigida por el Centro de Astrobiología /CAB, CSIC-INTA), en colaboración con la Empresa EADS/Crisa, la Universidad Politécnica de Cataluña, el Instituto Meteorológico Finlandés (FMI), la Universidad de Alcalá de Henares y diversas instituciones norteamericanas.

Curiosity con REMS a bordo , fue lanzado con éxito por un cohete Atlas V el pasado 26 de noviembre de 2011 desde Kennedy Space Center, en Cabo Cañaveral (cerca de Orlando, Florida, USA). En la actualidad viaja sin mayor novedad hacia Marte, donde se espera que llegue en Agosto de este mismo año. Todas las pruebas hechas después del lanzamiento han confirmado que todos los sistemas (incluyendo REMS), funcionan según lo esperado.

A lo largo de la Historia de la exploración espacial, las Agencias de la Unión Soviética, Estados Unidos, Europa y Japón, han enviado a Marte varias decenas de plataformas espaciales. El motor de esta búsqueda es el afán de alcanzar nuevas fronteras del conocimiento, explorar entornos desconocidos y superar desafíos tecnológicos. Aproximadamente dos terceras partes de estas misiones, han fallado de una u otra manera antes del comienzo de la misión.

La mayor parte de las misiones científicas de exploración de Marte se han desarrollado en satélites que orbitan alrededor del planeta y utilizan técnicas de detección remota (teledetección) para caracterizar la superficie y el subsuelo del planeta, la geología y la mineralogía, Actualmente continúan en operación, investigando la superficie y la atmósfera de Marte, los orbitadores:

Mars Reconnaissance Orbiter (desde 2006)

Mars Express (de la ESA, desde 2003), y

Mars Odyssei (desde 2001),

Y como vehículo de superficie, de los Mars Exploratión Rovers (MER)…el

Recientemente ha llegado a su fin con éxito dos misiones muy fructíferas, un orbitador, el Mars GlobalSurveyor (1997-2006)

y el otro vehículo de los MER, el Spirit rover (2004-2010).

Las técnicas de detección remota han sido explotadas hasta la fecha con gran éxito. Se han utilizado: espectrómetros (tanto en rango visible, como en el infrarrojo o en el ultravioleta), cámaras con capacidad para tomar imágenes de alta resolución, rádares para el estudio del subsuelo, detectores de campo magnético, detectores de neutrones, etc. No obstante la detección remota tiene ciertas limitaciones a la hora de caracterizar los fenómenos de superficie. Por un lado cada punto del planeta es observado a distintas horas del día y en distintas estaciones por lo que no es posible adquirir una secuencia sistemática de procesos locales que varíen en escalas de tiempos pequeñas.

En fin, que todas las misiones encaminadas a explorar el exterior, siempre resultarán muy complejas y, Marte, es como una pieza de toque, un laboratorio en el que ensayar para mayores proyectos.

Esperemos que, ahora que está bien asentada en aquel planeta, Curiosity nos pueda enviar buenas nuevas y buenas noticias. Imágenes ya nos facilita algunas pero… ¡queremos más! Además… ¡De la vida ni rastro!

emilio silvera

Dic

29

¡La curiosidad! que está con nosotros

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo, ¡La Curiosidad! ~

Clasificado en El Universo, ¡La Curiosidad! ~

Comments (6)

Comments (6)

Me ha venido a la memoria escenas y hechos que, en la última charla que pude dar en un Centro Educativo, en el apartado de Ciencia, para chavales de 2º de Bachillerato, comencé la sesión ilustrándola con la Imagen de arriba, de la que di una breve explicación antes de entrar en materia que, en realidad era: Nacimiento, Vida y Muerte de las estrellas y, de lo que hacían durante eseos largos períodos de tiempo y, en qué se convertían al final de sus vidas como estrellas.

El caso fue que, comencé con las explicaciones y, de entre el auditorio de jóvenes llenos de energía y revoltosos, algunos, no prestaban atención y, además, con sus bromas y risas, no dejaban que los demás, se pudieran interesar en lo que allí se trataba.

Aquella actitud de algunos, me obligó a parar la esposición y, mirándo seriamente a los alborotadores, les dije: Chicos, si el tema no os interesa, y queréis salir de aquí siendo un poco más “burros”, sois libres de hacerlo. Sin embargo, os ruego que, si finalmente decidías seguir con nosotros, y al final ser un poco mñás “sabios”, dejéis de alborotar.

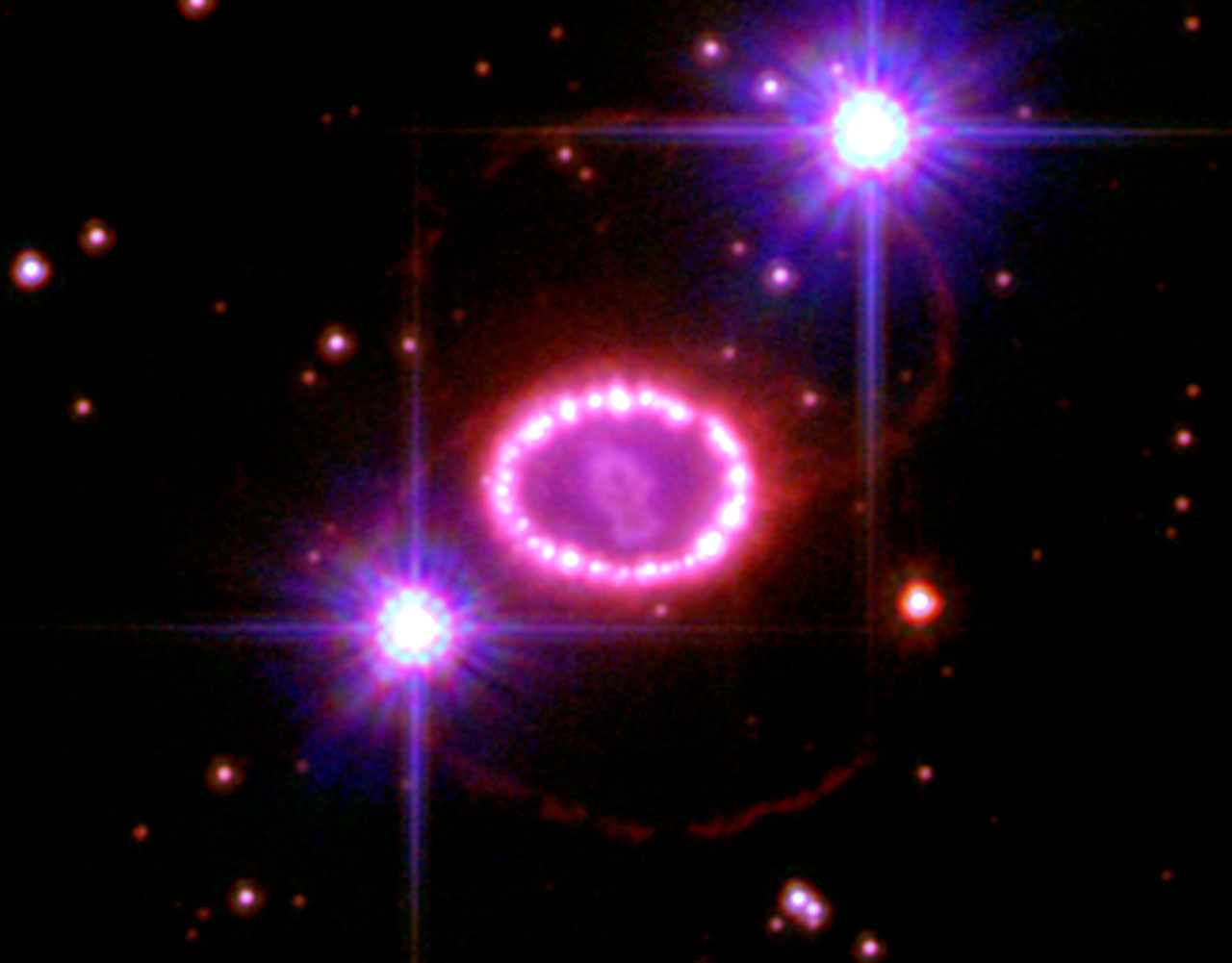

Como ya son “hombrecitos y mujeres”, la repimenda tuvo su efecto y, a partir de aquel momento, todos estuvieron atentos a mis palabras con las que fui desgranan, despacio y con palabras sencillas, lo que era una explosión de supernova y cómo dejaba regada una amplia región del espacio interestelar por una hermosa e inmensa nebulosa de cuyos materiales, vuelven a nacer nuevas estrellas y nuevos mundos.

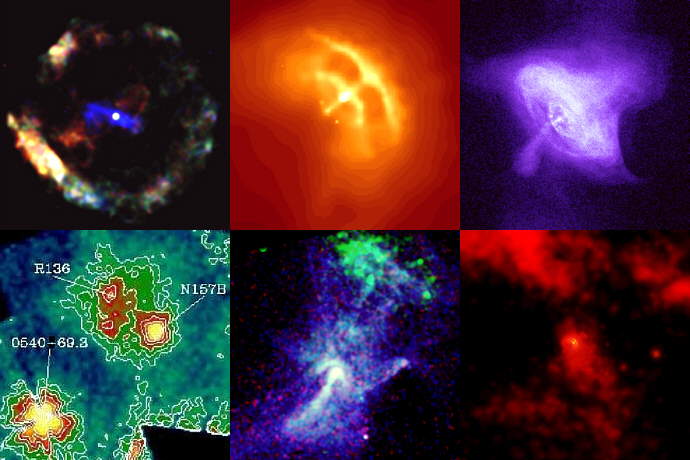

Apoyaba mis palabras con imágenes como la de arriba. La fotografía combina diferentes radiaciones, como rayos X, infrarojos o luz visible, y genera una amalgama de colores que aportan información importante para entender cómo llega una estrella a ser una estrella. Esta imagen ofrece una interesante mirada hacia el interior de la región activa de estrellas en ciernes llamada NGC 346. Los científicos responsables del telescopio aseguran que revela información nueva sobre cómo se forman las estrellas en el Universo.

La NASA publicó un video (1/09/2011) donde se aprecia el proceso de nacimiento estelar. Con grandes chorros de gas incandescente nacen las estrellas a millones de años luz, algo que ahora está al alcance del ojo humano a través de un vídeo reconstruido con imágenes fijas tomadas por el telescopio Hubble. El vídeo, publicado en la página web de la agencia espacial estadounidense (NASA), ofrecía nuevos detalles sobre el proceso de nacimiento estelar, en el que se pueden apreciar los chorros de gas que expulsan las estrellas jóvenes con un detalle hasta ahora nunca visto.

A medida que las explicaciones avanzaban, pude notar como el interés de los chicos crecía. Ya no bromeaba nadie, la sala estaba en silencio y todos, sin excepción, se veían interesados e incluso, algunos, tenían la boca abierta por asombro. Allí, lo que al principio era una simple charla para alumnos, se fue convirtiendo en un auditoriun donde, profesores y alumnos de otras clases llegaban y se unián a los ya presentes.

Les pude explicar con todo detalle y de la manera más sencilla posible, como se formaban los elementos en las estrellas a partir del Hidrogeno, el elemento más sencillo de la Naturaleza.

Les expliqué el proceso protón-protón que convertía Hidrógeno en Helio y el proceso triple Alfa que convertía Helio en Carbono, el material químicamente más idóneo para la vida -al menos aquí en la Tierra- y, se hizo un largo recorrido por la transmutación que se producía en todos los elementos, a medida que transcurría el tiempo y la estrella evolucionaba.

Pude darles una buena noción de las clases de estrellas que existen y de que, no todas tienen las mismas masas y que, como consecuencia de ello, cada una de esas estrellas, viven más o menos tiempo y que, cuando al final mueren, lo hacen de muy diferentes maneras. Ya que, estrellas medianas como nuestro Sol, terminan creando una Nebulosa planetaria al convertirse en Gigante roja y, terminan sus días como enanas blancas de una gran densidad. Les expliqué el proceso que hacían hasta llegar a tal estado y los parámetros que, como ekl principio de exclusión de Pauli, estaban allí presentes. De la misma manera, les expliqué que, estrellas más masivas terminaban como estrellas de neutrones y más masivas aún, como agujeros negros.

El recorrido fue algo largo (más de lo esperado), ya que, vista la gran atención que todos ponían en las explicaciones y en las imágenes que se ivan poniendo en cada fasa del proceso explicativo, procuraba que el tema tratado lo fuera en profundidad y amplitud y, de esa manera, la cosa resultó, además de más amena, mucho más completa y, sobre todo, comprensible.

Cuando al final di la charla por finalizada, pregunté si alguien quería alguna explicación sobre algún aspecxto delo que habíamos tratado, y, las manos que se levantaban presagiaban un largo, muy largo debate. Y, así fue. Los jóvenes se interesaban por todo y, de entre todo lo explicado, las cosas que más llamaron su atención fueron, por ejemplo:

Que nuestro Sol, cada segundo, pueda fusionar 4.654000 toneladas de Hidrógeno en 4.650.000 toneladas de Helio. Y, un observador inquisitivo, me preguntaba: ¿dónde están las 4.000 Tn que se han perdido? Bueno, le expliqé que habían sido lanzadas al espacio interestelar en forma de luz y de calor y, una pequeña fracción, llegaba a la Tierra para permitir la fotosíntesis y la vida.

Otra de las cuestiones que les llamó más la atención fue, cómo era posible que estrellas supergigantes, pudieran tener una vida más corta cuando tenían a su disposición mucho más material. Y, cuando les expliqué que, esas estrellas, no consumen sino que devoran literalmente el material nuclaer de fusión, comprendieron el por qué de sus cortas vidas.

Y, preguntaban cómo no todas las estrellas tenían el mismo colo, amarillas como nuestro Sol. La exlicación, como sabemos, está en el hecho de que no todas están formadas por el mismo material: Hay estrellas de Carbono, otras son de Oxígeno, Litio, manganeso…, la diversidad es enorme.

Mostraron mucha curiosidad y más intewrés aún, al saber -no todos conocían tal hecho- que, los elementos para hacer posible, la bio-química de la vida, se fabrica en las estrellas, es allí, en sus hornos nucleares donde se producen los elementos que conforma la materia del Universo, su diversidad que, bajo ciertas condiciones y, en los mundos adecuados situados en las zonas habitables de sus estrellas, pueden hacer surgir formas de vida que, a veces, llegan incluso a ser conscientes, como ha pasado aquí, en la Tierra.

Los remanentes de supernovas y de cómo en esas inmensas explosiones se producían oro y platino, también fue uno de los temas que llamó la atención del personal. Todos querían hablar al mismo tiempo y todos -era un auténtico gozo- tenían preguntas que plantear. Al final, el tiempo pasaba sin sentir y tuve que dar por finalizado el evento que, al contrario de lo que parecía al principio, fue todo un exito, sobre todo, al comprobar que aquellos jóvenes al terminar la charla y el coloquio, eran un poco “más sabios” que antes de empezar.

Claro que, no siempre las cosas salen tan bien paradas. Recuerdo aquel Asilo de Ancianos al que hace tiempo fuí a dar una charla de astronomía y, antes de terminar, estaban todos, prácticamewnte dormidos. La curiosidad y el interés, les había abandonado y, ese fue un día triste para mí.

emilio silvera

Dic

22

¡Púlsares! Estrellas de neutrones pulsantes a velocidades increíbles

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en ¡Maravillas del Universo! ~

Clasificado en ¡Maravillas del Universo! ~

Comments (4)

Comments (4)

En el verano de 1967 Anthony Hewish y sus colaboradores de la Universidad de Cambridge detectaron, por accidente, emisiones de radio en los cielos que en nada se parecían a las que se habían detectado hasta entonces. Llegaban en impulsos muy regulares a intervalos de sólo 1 1/3 segundos. Para ser exactos, a intervalos de 1,33730109 segundos. La fuente emisora recibió el nombre de “estrella pulsante” o “pulsar”.

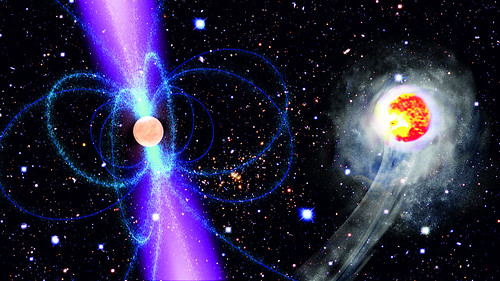

Esta es la imagen que de un púlsar tenemos pero…

¿QUE SON LOS PÚLSARES?

Un púlsar es una fuente de radio desde la que se recibe un tren de pulsos altamente regular. Han sido catalogados cerca de un millar de púlsares desde que se descubriera el primero en 1967. Los Púlsares son Estrellas de Neutrones en rápida rotación, con un diámetro de 20-30 Km. Las estrellas se hallan altamente magnetizadas (alrededor de 10 exp.8 tesla), con el eje magnético inclinado con respecto al eje de rotación.

La emisión de radio se cree que surge por la aceleración de partículas cargadas por encima de los polos magnéticos. A medida que rota la estrella, un haz de ondas de radio barre la Tierra, siendo entonces observado el pulso, de forma similar a la luz de un faro. Los períodos de los pulsos son típicamente de 1 s pero varían desde los 1,56 ms (púlsares de milisegundo) hasta los 4’3 s

Los períodos de los pulsos se alargan gradualmente a medida que las estrellas de neutrones pierden energía rotacional, aunque unos pocos púlsares jóvenes son propensos a súbitas perturbaciones conocidas como ráfagas. Las medidas precisas de tiempos en los púlsares han revelado la presencia de púlsares binarios, y un púlsar, PSR 1257+12, se ha demostrado que está acompañado por objetos de masa planetaria. Han sido detectados destellos ópticos procedentes de unos pocos púlsares, notablemente los Púlsares del Cangrejo y Vela.

La mayoría de los púlsares se piensa que se crean en explosiones de supernova por el colapso del núcleo de una estrella supergigante, aunque en la actualidad hay considerables evidencias de que al menos algunos de ellos se originan a partir de enanas blancas que han colapsado en estrellas de neutrones después de una acreción de masa de una estrella compañera. (Púlsar reciclado).

La gran mayoría de los púlsares conocidos se encuentran en la Vía Láctea y están concentrados en el plano galáctico. Se estima que hay unos 100.000 púlsares en la Galaxia. Las observaciones de la dispersión interestelar y del efecto Faraday en los púlsares suministran información sobre la distribución de electrones libres y de los campos magnéticos de la Vía Láctea.

Cuando un púlsar está en órbita con otra estrella, estamos hablando de un púlsar binario, cuya existencia es revelada por un cambio cíclico en el período de pulsación a medida que las dos estrellas orbitan la una en torno a la otra. Se conocen alrededor de 50 púlsares binarios, con períodos orbitales que varían entre menos de 1 hora y varios años, y períodos de pulsión entre 1,6 ms y más de 1 s.

Imagen más aclaratorio del PSR 1913+16

El primer púlsar binario conocido, PSR 1913+16, fue descubierto en 1974. Consiste en un púlsar que tiene 17 pulsaciones por segundo, en una órbita altamente excéntrica con un período de 7,75 horas alrededor de una segunda estrella de neutrones en la que no se han observado pulsaciones. Cada estrella tiene unas 1,4 masas solares, próxima al límite de Chandrasekhar, y el período orbital se está acortando gradualmente debido a la pérdida de energía a través de radiación gravitacional.

El primer púlsar binario conocido, PSR 1913+16, fue descubierto en 1974. Consiste en un púlsar que tiene 17 pulsaciones por segundo, en una órbita altamente excéntrica con un período de 7,75 horas alrededor de una segunda estrella de neutrones en la que no se han observado pulsaciones. Cada estrella tiene unas 1,4 masas solares, próxima al límite de Chandrasekhar, y el período orbital se está acortando gradualmente debido a la pérdida de energía a través de radiación gravitacional.

Otro púlsar binario destacable es PSR 1957 + 20, llamado en ocasiones púlsar de la viuda negra, en el que la intensa radiación procedente del pulsar está evaporando su pequeña estrella compañera. Algunos púlsares binarios se saben ahora que son púlsares reciclados que han adquirido altas velocidades de rotación debido a la acreción de gas procedente del compañero.

El púlsar del milisegundo brilla cada pocas milésimas de segundo. El primero en ser descubierto, PSR 1937 + 21, tiene un período de 1,56 ms, siendo aún el del período más corto conocido y próximo al mínimo teórico para una estrella de neutrones en rotación. Han sido descubiertos más de 60 púlsares con períodos de menos de 20 milisegundos, muchos de ellos en cúmulos globulares. Los púlsares de milisegundo poseen una rotación extremadamente estable y mantiene una regularidad mayor que la de los relojes atómicos.

También está el púlsar de rayos X. Aquí estamos hablando de una binaria de rayos X que tiene una variabilidad regular, en la que la pulsación está asociada al período de rotación de la compañera compacta, una estrella de neutrones magnetizada.

Los períodos varían desde unos pocos segundos hasta unos pocos minutos. Estas pulsaciones se piensa que están provocadas por el campo magnético que canaliza el gas en acreción hacia los polos de la estrella produciendo “manchas calientes” localizadas que se hacen visibles o no a medida que rota la estrella. Un ejemplo de dicho sistema es Hércules X-1.

La mayoría de los púlsares se piensa que se crean en explosiones de supernova por el colapso del núcleo de una estrella supergigante, aunque en la actualidad hay considerables evidencias de que al menos algunos de ellos se originan a partir de enanas blancas que han colapsado en estrellas de neutrones después de una acreción de masa de una estrella compañera. (Púlsar reciclado).

Otro tipo de púlsar es el llamado óptico que sufre pulsaciones en la parte visible del espectro, además de en longitudes de onda de radio y de otros tipos. El primer púlsar cuyas pulsaciones ópticas fueron descubiertas fue el Púlsar del Cangrejo, en 1969, seguido del Púlsar Vela en 1977.

El púlsar denominado “reciclado” es un púlsar con un campo magnético inusualmente bajo (1-100 tesla), un ritmo de frenado pequeño y un período de pulsos frecuentemente muy bajo, encontrándose a menudo en sistemas binarios.

Se cree que los púlsares reciclados son púlsares ordinarios que han perdido energía y se han debilitado, y que luego se han puesto a girar de nuevo por acreción del gas de la estrella compañera. Existe una alta proporción de púlsares reciclados en los núcleos de los cúmulos globulares, donde la alta densidad de estrellas hace más probable la captura de una vieja estrella de neutrones en un sistema binario. Los primeros púlsares reciclados en ser descubiertos tenían períodos de pulsos muy cortos y se conocen como “púlsares de milisegundo”, aunque más tarde se descubrieron otros con períodos mucho más largo.

Para poder llegar a estrella de neutrones, la estrella original que implosiona es más masiva que nuestro Sol. La estrella de Neutrones es muy densa, tan densa como el núcleo de un átomo y, cuando colapsa se convierte en un púlsar giratorio que es el resultado de una explosión de supernova como la presenciada en 1054.

emilio silvera

Totales: 67.229.486

Totales: 67.229.486 Conectados: 58

Conectados: 58