Jun

7

Todos tenemos tendencia a interesarnos por alguna cosa

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Como cada mañana, trabajando en la oficina en cuestiones jurídicas y tributarias, me llega el correo y, de entre todos los documentos recibidos, destaca (como no), la Revista de Física que me envía de manera periódica la Real Sociedad Española de Física, y, en la portada, aparece la imagen de un agujero negro.

De inmediato, sin poder contener mis deseos de ver los contenidos, la abro y miro en el interior donde me encuentro con trabajos como los siguientes:

Pulsos e Impulsos

| Revista Española de Física 29(2): 4-8 (2015) | |

| Resumen: | A principios de febrero de este año la misión Planck de la ESA hizo públicos los resultados cosmológicos correspondientes al análisis de los datos que, durante más de 5 años (desde agosto de 2009 hasta octubre de 2013), ha estado recogiendo este satélite. Planck ha observado la bóveda celeste en nueve frecuencias diferentes en el rango de las microondas, siendo su objetivo principal el estudio de las anisotropías del Fondo Cósmico de Microondas (FCM). El FCM es una radiación electromagnética producida cuando el universo contaba con unos 380.000 años, y que, desde su descubrimiento en 1964 por Arno Penzias y Robert Wilson, ha sido, sin lugar a dudas, uno de los pilares más importantes sobre los que se ha establecido el modelo cosmológico estándar. Dichas anisotropías se corresponden con pequeñas desviaciones (de 1 parte en 100.000) en la temperatura de cuerpo negro que caracteriza esta radiación electromagnética primigenia. Estas fluctuaciones, que de alguna manera trazan cómo era la distribución de materia en aquel momento de la historia del universo, tienen su origen en unas perturbaciones. |

Sobre la distinguibilidad experimental entre la mecánica cuántica estándar y la mecánica de Bohm. Le sigue el trabajo titulado “Mecánica bohmiana: ¿Una teoría de las variables ocultas?

“Durante más de 60 años la “teoría de variables ocultas” propuesta por David Bohm en 1952, conocida actualmente como mecánica bohmiana, ha sido fuente de controversia y debate dentro del campo y los fundamentos de la mecánica cuántica.

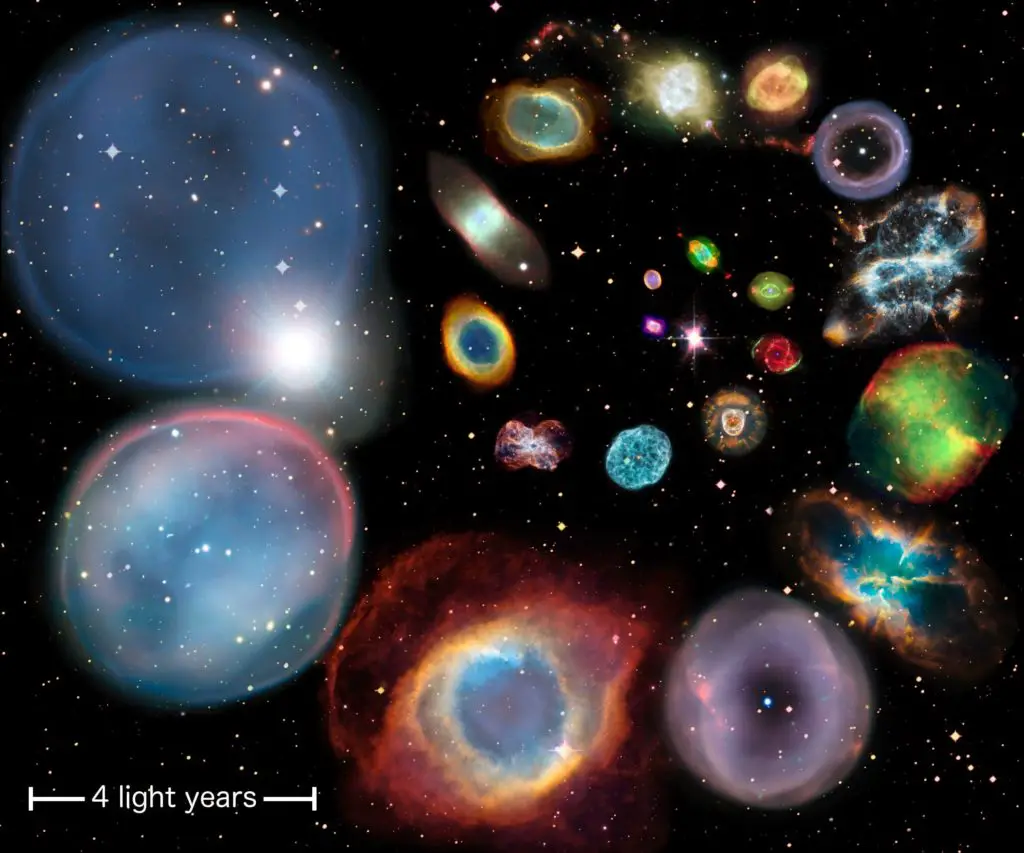

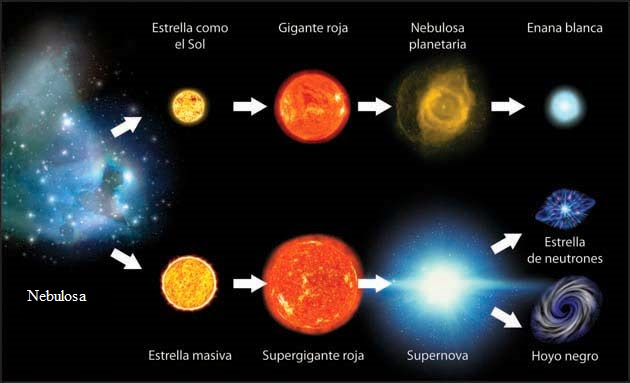

Las estrellas también mueren

En este apartado nos hablan de cómo mueren las estrellas una vez que han agotado su combustible nuclear de fusión, y, en qué se convierten dependiendo de sus masas. Estrellas como el Sol tendrán una primera transición de fase a Gigante roja y más tarde Nebulosa Planetaria con la estrella enana blanca en el centro.

Cuando las estrellas sobrepasan las 5 masas solares, su destino final está en convertirse en estrellas de neutrones, y, si es supermasiva en agujero negro. En ncada uno de los casos actúan fuerzas y principios diferentes como sería el caso del Principio de exclusión de Pauli que incide en los fermiones para las enanas blancas y las estrellas de neutrones.

Además de todos estos temas se habla de otros de interés

Dispersión de la Luz en un prisma

Reacción nentre el Sodio y el Agua

¿Cómo construir cámaras de niebla con utensilios de cocina?

Además de otros muchos artículos y demostraciones prácticas que nos llevan de la mano a conocer hechos muy normales en la Naturaleza y que a nosotros (que casi siempre estamos al margen de ella), nos parecen maravillas.

Lo dicho, nunca es tarde para aprender cosas nuevas y, si le prestas el debido interés… ¿Las conocerás!

emilio silvera

Jun

7

La partícula Beta, el neutrino, la luz…

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Los físicos se vieron durante mucho tiempo turbados por el hecho de que a menudo, la partícula beta emitida en una desintegración del núcleo no alberga energía suficiente para compensar la masa perdida por el núcleo. En realidad, los electrones no eran igualmente deficitarios. Emergían con un amplio espectro de energías, y el máximo (conseguido por muy pocos electrones), era casi correcto, pero todos los demás no llegaban a alcanzarlo en mayor o menor grado. Las partículas alfa emitidas por un nucleido particular poseían iguales energías en cantidades inesperadas. En ese caso, ¿qué era errónea en la emisión de partículas beta? ¿Qué había sucedido con la energía perdida?

En 1922, Lise Maitner se hizo por primera vez esta pregunta, y, hacia 1.930, Niels Bohr estaba dispuesto a abandonar el gran principio de conservación de la energía, al menos en lo concerniente a partículas subatómicas. En 1931, Wolfgang Pauli sugirió una solución para el enigma de la energía desaparecida.

Tal solución era muy simple: junto con la partícula beta del núcleo se desprendía otra, que se llevaba la energía desaparecida. Esa misteriosa segunda partícula tenía propiedades bastante extrañas. No poseía carga ni masa. Lo único que llevaba mientras se movía a la velocidad de la luz era cierta cantidad de energía. A decir verdad, aquello parecía un cuerpo ficticio creado exclusivamente para equilibrar el contraste de energías.

Sin embargo, tan pronto como se propuso la posibilidad de su existencia, los físicos creyeron en ella ciegamente. Y esta certeza se incrementó al descubrirse el neutrón y al saberse que se desintegraba en un protón y se liberaba un electrón, que, como en la decadencia beta, portaba insuficientes cantidades de energía. Enrico Fermi dio a esta partícula putativa el nombre de “neutrino”, palabra italiana que significa “pequeño neutro”.

El neutrón dio a los físicos otra prueba palpable de la existencia del neutrino. Como ya he comentado en otra página de este trabajo, casi todas las partículas describen un movimiento rotatorio. Esta rotación se expresa, más o menos, en múltiples de una mitad según la dirección del giro. Ahora bien, el protón, el neutrón y el electrón tienen rotación de una mitad. Por tanto, si el neutrón con rotación de una mitad origina un protón y un electrón, cada uno con rotación de una mitad, ¿qué sucede con la ley sobre conservación del momento angular? Aquí hay algún error. El protón y el electrón totalizan una mitad con sus rotaciones (si ambas rotaciones siguen la misma dirección) o cero (si sus rotaciones son opuestas); pero sus rotaciones no pueden sumar jamás una mitad. Sin embargo, por otra parte, el neutrino viene a solventar la cuestión.

Supongamos que la rotación del neutrón sea +½. Y admitamos también que la rotación del protón sea +½ y la del electrón -½, para dar un resultado neto de o. Demos ahora al neutrino una rotación de +½, y la balanza quedará equilibrada.

+½(n)=+½(p)-½(e)+½(neutrino)

Pero aun queda algo por equilibrar. Una sola partícula (el neutrón) ha formado dos partículas (el protón y el electrón), y, si incluimos el neutrino, tres partículas. Parece más razonable suponer que el neutrón se convierte en dos partículas y una antipartícula. En otras palabras: lo que realmente necesitamos equilibrar no es un neutrino, sino un antineutrino.

El propio neutrino surgiría de la conversación de un protón en un neutrón. Así, pues, los productos serían un neutrón (partícula), un positrón (antipartícula) y un neutrino (partícula). Esto también equilibra la balanza.

En otras palabras, la existencia de neutrinos y antineutrinos debería salvar no una, sino tres, importantes leyes de conservación: la conservación de la energía, la de conservación del espín y la de conservación de partícula/antipartícula.

Es importante conservar esas leyes puesto que parece estar presentes en toda clase de reacciones nucleares que no impliquen electrones o positrones, y sería muy útil si también se hallasen presentes en reacciones que incluyesen esas partículas.

Las más importantes conversiones protón-neutrón son las relaciones con las reacciones nucleares que se desarrollan en el Sol y en los astros. Por consiguiente, las estrellas emiten radiaciones rápidas de neutrinos, y se calcula que tal vez pierdan a causa de esto el 6 u 8 % de su energía. Pero eso, sería meternos en otra historia y, por mi parte, con la anterior explicación solo trataba de dar una muestra del ingenio del hombre que, como habréis visto, no es poco.

Desde que puedo recordar, he sido un amante de la Física. Me asombran cuestiones como la luz, su naturaleza de un conglomerado de colores, ondas y partículas, su velocidad que nos marca el límite del máximo que podemos correr en nuestro Universo, y en fin, muchos otros misterios que encierra esa cosa tan cotidiana que nos rodea y lo inunda todo haciendo posible que podamos ver por donde vamos, que las plantas vivan y emitan oxígeno o que nos calentemos. Realmente, sin luz, nuestra vida no sería posible.

Entonces, ¿qué es realmente la luz?

Muchos (casi todos) opinan que es algo inmaterial. Los objetos materiales, grandes o muy pequeños como las galaxias o los electrones, son materia. La luz, sin embargo, se cree que es inmaterial, dos rayos de luz se cruzan sin afectarse el uno al otro.

Sin embargo, yo que, desde luego, no soy un experto, opino en cambio que la luz, es simplemente una forma de energía lumínica, otra forma en la que se puede presentar la materia. Nosotros mismos, en última instancia, somos luz.

Está claro que, los estudiosos de la época antigua y medieval estaban por completo a oscuras acerca de la naturaleza de la luz. Especulaban sobre que consistía en partículas emitidas por objetos relucientes o tal vez por el mismo ojo. Establecieron el hecho de que la luz viajaba en línea recta, que se reflejaba en un espejo con un ángulo igual a aquel con el que el rayo choca con el espejo, y que un rayo de luz se inclina (se refracta) cuando pasa del aire al cristal, al agua o a cualquier otra sustancia transparente.

Cuando la luz entra en un cristal, o en alguna sustancia transparente, de una forma oblicua (es decir, en un ángulo respecto de la vertical), siempre se refracta en una dirección que forma un ángulo menor respecto de la vertical. La exacta relación entre el ángulo original y el ángulo reflejado fue elaborada por primera vez en 1.621 por el físico neerlandés Willerbrord Snell. No publicó sus hallazgos y el filósofo francés René Descartes descubrió la ley, independientemente, en 1637.

Los primeros experimentos importantes acerca de la naturaleza de la luz fueron llevados a cabo por Isaac Newton en 1666, al permitir que un rayo de luz entrase en una habitación oscura a través de una grieta e las persianas, cayendo oblicuamente sobre una cara de un prisma de cristal triangular. El rayo se refracta cuando entra en el cristal y se refracta aún más en la misma dirección cuando sale por una segunda cara del prisma. (Las dos refracciones en la misma dirección se originan por que los dos lados del prisma de se encuentran en ángulo en vez de en forma paralela, como sería el caso en una lámina ordinaria de cristal.)

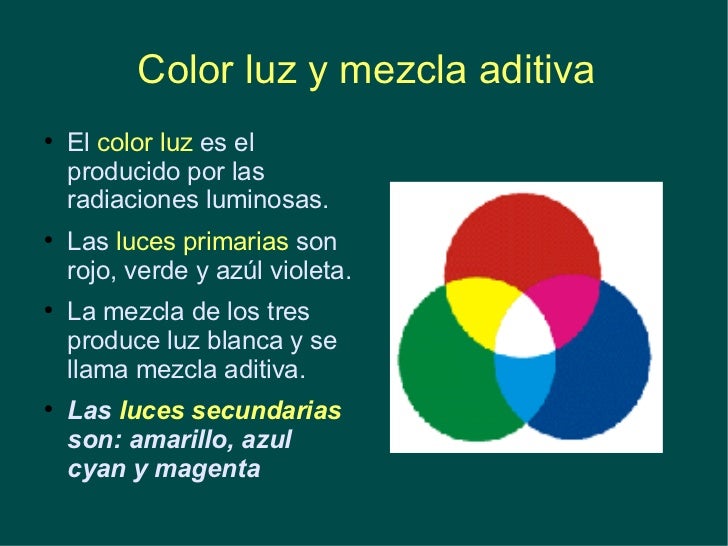

Newton atrapó el rayo emergente sobre una pantalla blanca para ver el efecto de la refracción reforzada. Descubrió que, en vez de formar una mancha de luz blanca, el rayo se extendía en una gama de colores: rojo, anaranjado, amarillo, verde, azul, y violeta, en este orden.

Newton dedujo de ello que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos para producir las diversas sensaciones de colores. La amplia banda de sus componentes se denominó spectrum (palabra latina que significa “espectro” fantasma).

Newton llegó a la conclusión de que la luz se componía de diminutas partículas (“corpúsculos”), que viajaban a enormes velocidades.

Le surgieron y se planteó algunas inquietudes cuestiones. ¿Por qué se refractaban las partículas de luz verde más que los de luz amarilla? ¿Cómo se explicaba que dos rayos de luz se cruzaran sin perturbase mutuamente, es decir, sin que se produjeran colisiones entre partículas?

En 1678, el físico neerlandés Christian Huyghens (un científico polifacético que había construido el primer reloj de péndulo y realizado importantes trabajos astronómicos) propuso una teoría opuesta: la de que la luz se componía de minúsculas ondas. Y si sus componentes fueran ondas, no sería difícil explicar los diversos difracciones de los diferentes tipos de luz a través de un medio refractante, siempre y cuando se aceptara que la luz se movía más despacio en ese medio refractante que en el aire. La cantidad de refracción variaría con la longitud de las ondas: cuanto más corta fuese tal longitud, tanto mayor sería la refracción. Ello significaba que la luz violeta (la más sensible a este fenómeno) debía de tener una longitud de onda mas corta que la luz azul, ésta, más corta que la verde, y así sucesivamente.

La longitud de ondas permite al ojo distinguir los colores

Lo que permitía al ojo distinguir los colores eran esas diferencias entre longitudes de onda. Y, como es natural, si la luz estaba integrada por ondas, dos rayos podrían cruzarse sin dificultad alguna. (Las ondas sonoras y las del agua se cruzan continuamente sin perder sus respectivas identidades.)

Pero la teoría de Huyqhens sobre las ondas tampoco fue muy satisfactoria. No explicaba por qué se movían en línea recta los rayos luminosos; ni por qué proyectaban sobras recortadas; ni aclaraba por qué las ondas luminosas no podían rodear los obstáculos, del mismo modo que pueden hacerlo las ondas sonoras y de agua. Por añadidura, se objetaba que si la luz consistía en ondas, ¿cómo podía viajar por el vacío, ya que cruzaba el espacio desde el Sol y las Estrellas? ¿Cuál era esa mecánica ondulatoria?

emilio silvera

Jun

7

Las estrellas cuando dejan de brillar

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Implosión de una estrella ~

Clasificado en Implosión de una estrella ~

Comments (0)

Comments (0)

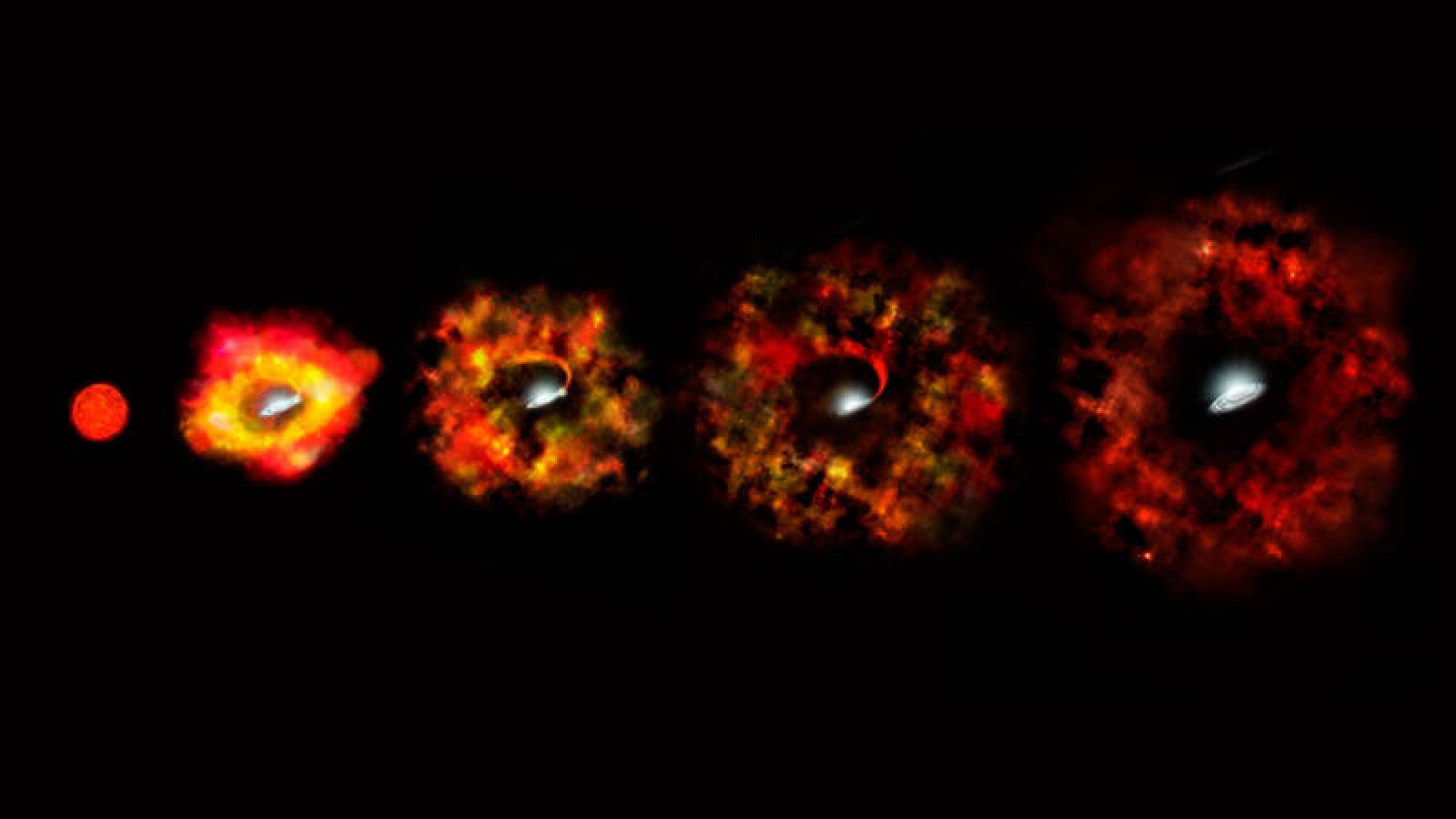

Sobre la Implosión de una estrella

En la secuencia principal la estrella fusiona elementos y tiende a expandirse, se estabiliza por la Gravedad pero, cuando agota el combustible nuclear de fusión, queda a merced de esta e implosiona, es decir, es aplastada bajo su propio peso

Especialmente intrigante es la apariencia de una estrella en implosión observada desde un sistema de referencia externo estático, es decir, vista por observadores exteriores a la estrella que permanecen siempre en la misma circunferencia fija en lugar de moverse hacia adentro con la materia de la estrella en implosión. La estrella, vista desde un sistema externo estático, empieza su implosión en la forma en que uno esperaría. Al igual que una pesada piedra arrojada desde las alturas, la superficie de la estrella cae hacia abajo (se contrae hacia adentro), lentamente al principio y luego cada vez más rápidamente. Si las leyes de gravedad de Newton hubieran sido correctas, esta aceleración de la implosión continuaría inexorablemente hasta que la estrella, libre de cualquier presión interna, fuera aplastada en un punto de alta velocidad. Pero no era así según las fórmulas relativistas de Oppenheimer y Snyder. En lugar de ello, a medida que la estrella se acerca a su circunferencia crítica su contracción se frena hasta hacerse a paso lento. Cuanto más pequeña se hace la estrella, más lentamente implosiona, hasta que se congela exactamente en la circunferencia crítica.

Por mucho tiempo que uno espere, si uno está en reposo fuera de la estrella (es decir, en reposo en el sistema de referencia externo estático), uno nunca podrá ver que la estrella implosiona a través de la circunferencia crítica. Este era el mensaje inequívoco de Oppenheimer y Snyder.

¿Se debe esta congelación de la implosión a alguna fuerza inesperada de la relatividad general en el interior de la estrella? No, en absoluto, advirtieron Oppenheimer y Snyder. Más bien se debe a la dilatación gravitatoria del tiempo (el frenado del flujo del tiempo) cerca de la circunferencia crítica. Tal como lo ven los observadores estáticos, el tiempo en la superficie de la estrella en implosión debe fluir cada vez más lentamente cuando la estrella se aproxima a la circunferencia crítica; y, consiguientemente, cualquier cosa que ocurre sobre o en el interior de la estrella, incluyendo su implosión, debe aparecer como si el movimiento se frenara poco a poco hasta congelarse.

Por extraño que esto pueda parecer, aún había otra predicción más extrañas de las fórmulas de Oppenheimer y Snyder: si bien es cierto que vista por observadores externos estáticos la implosión se congela en la circunferencia crítica, no se congela en absoluto vista por los observadores que se mueven hacia adentro con la superficie de la estrella. Si la estrella tiene una masa de algunas masas solares y empieza con un tamaño aproximado al del Sol, entonces vista desde su propia superficie implosiona hacia la circunferencia crítica en aproximadamente una hora, y luego sigue implosionando más allá de la criticalidad hacia circunferencias más pequeñas.

Allá por el año 1939, cuando Oppenheimer y Snyder descubrieron estas cosas, los físicos ya se habían acostumbrados al hecho de que el tiempo es relativo; el flujo del tiempo es diferente medido en diferentes sistemas de referencia que se mueven de diferentes formas a través del Universo. Claro que, nunca antes había encontrado nadie una diferencia tan extrema entre sistemas de referencia. Que la implosión se congele para siempre medida en el sistema externo estático, pero continúe avanzando rápidamente superando al punto de congelación medida en el sistema desde la superficie de la estrella era extraordinariamente difícil de comprender. Nadie que estudiara las matemáticas de Oppenheimer y Snyder se sentía cómodo con semejante distorsión extrema del tiempo. Pero ahí estaba, en sus fórmulas. Algunos podían agitar sus brazos con explicaciones heurísticas, pero ninguna explicación parecía muy satisfactoria. No sería completamente entendido hasta finales de los cincuenta.

Fue Wheeler el que discrepó del trabajo de Oppenheimer y Snyder, alegando, con toda la razón que, cuando ellos habían realizado su trabajo, habría sido imposible calcular los detalles de la implosión con una presión realista (presión térmica, presión de degeneración y presión producida por la fuerza nuclear), y con reacciones nucleares, ondas de choque, calor, radiación y expulsión de masa. Sin embargo, los trabajos desde las armas nucleares de los veinte años posteriores proporcionaron justamente las herramientas necesarias.

Presión, reacciones nucleares, ondas de choque, calor radiación y expulsión de masa eran todas ellas características fundamentales de una bomba de hidrógeno; sin ellas, una bomba no explosionaría. A finales de los años cincuenta, Stirling Colgate quedó fascinado por el problema de la implosión estelar. Con el apoyo de Edward Teller, y en colaboración con Richard White y posteriormente Michael May, Colgate se propuso simular semejante implosión en un ordenador. Sin embargo, cometieron un error, mantuvieron algunas de las simplificaciones de Oppenheimer al insistir desde el principio en que la estrella fuera esférica y sin rotación, y, aunque tuvieron en cuenta todos los argumentos que preocupaban a Wheeler, aquello no quedó perfeccionado hasta después de varios años de esfuerzo y, a comienzo de los años sesenta ya estaban funcionando correctamente.

Un día a principio de los años sesenta, John Wheeler entró corriendo en la clase de relatividad de la Universidad de Princeton. Llegaba un poco tarde, pero sonreía con placer. Acababa de regresar de una visita a Livermore donde había visto los resultados de las simulaciones recientes de Colgate y su equipo. Con excitación en su voz dibujó en la pizarra un diagrama tras otro explicando lo que sus amigos de Livermore habían aprendido.

Cuando la estrella en implosión tenía una masa pequeña, desencadenaba una implosión de supernova y formaba una estrella de neutrones precisamente en la forma que Fritz Wicky había especulado treinta años antes. Sin embargo, si la estrella original era más masiva lo que allí se producía (aparte de la explosión supernova) era un agujero negro notablemente similar al altamente simplificado modelo que veinticinco años calcularon Oppenheimer y Snyder. Vista desde fuera, la implosión se frenaba y se quedaba congelada en la circunferencia crítica, pero vista por alguien en la superficie de la estrella, la implosión no se congelaba en absoluto. La superficie de la estrella se contraía a través de la circunferencia crítica y seguía hacia adentro sin vacilación.

Lo cierto fue que allí, por primera vez, se consiguió simular por ordenador la implosión que debía producir agujeros negros. Está claro que la historia de todo esto es mucho más larga y contiene muchos más detalles que me he saltado para no hacer largo el trabajo que, en realidad, sólo persigue explicar a ustedes de la manera más simple posible, el trabajo que cuesta obtener los conocimientos que no llegan (casi nunca) a través de ideas luminosas, sino que, son el resultado del trabajo de muchos.

Hoy, sabemos mucho más de cómo finaliza sus días una estrella y, dependiendo de su masa, podemos decir de manera precisa que clase de Nebulosa formará, que clase de explosión (si la hay) se producirá, y, finalmente, si el resultado de todo ello será una estrella enana blanca que encuentra su estabilidad final por medio del Principio de exclusión de Pauli (en mecánica cuántica)que se aplica a los fermiones pero no a los Bosones (son fermiones los quarks, electrones, protones y neutrones), en virtud del cual dos partículas idénticas en un sistema, como los electrones en un átomo o quarks en un hadrón (protón o neutrón, por ejemplo), no pueden poseer un conjunto idéntico de números cuánticos.

A partir de ese principio, sabemos que, cuando una estrella como nuestro Sol deja de fusionar Hidrógeno en Helio que hace que la estrella deje de expandirse y quede a merced de la Gravedad, ésta implosionará bajo el peso de su propia masa, es decir, se contraerá sobre sí misma por la fuerza gravitatoria pero, llegará un momento en el cual, los electrones, debido a ese principio de exclusión de Pauli que les impide estar juntos, se degeneran y se moverán de manera aleatoria con velocidades relativista hasta el punto de ser capaces de frenar la fuerza provocada por la gravedad, y, de esa manera, quedará estabilizada finalmente una estrella enana blanca. Si la estrella original es más masiva, la degeneración de los electrones no será suficiente para frenar la fuerza gravitatoria y, los electrones se fusionaran con los protones para convertirse en neutrones que, bajo el mismo principio de exclusión sufrirán la degeneración que frenará la fuerza de gravedad quedando entonces una estrella de neutrones. Por último, si la estrella es, aún más masiva, ni la degeneración de los neutrones será suficiente para frenar la inmensa fuerza gravitatoria generada por la masa de la estrella que, continuará la implosión contrayéndose cada vez más hasta desaparecer de nuestra vista convertida en un agujero negro del que ya hemos hablado estos días ampliamente.

emilio silvera

Jun

7

La tecnología de vacío en la simulación espacial

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El hombre en el Universo ~

Clasificado en El hombre en el Universo ~

Comments (0)

Comments (0)

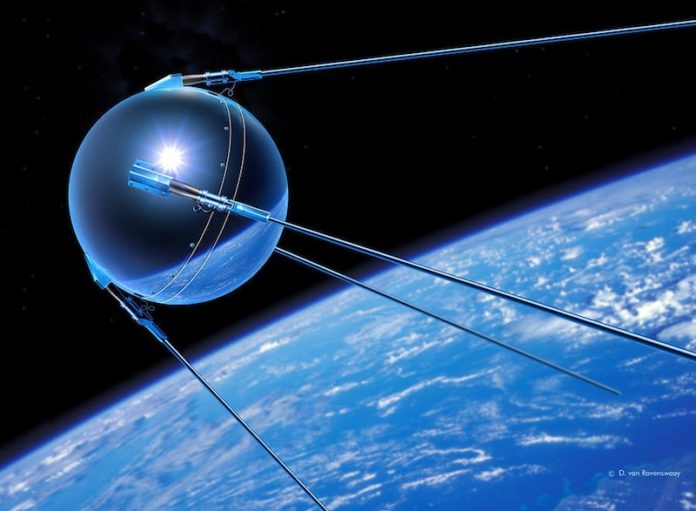

Con el lanzamiento del primer satélite artificial, el Sputnik, comenzó una nueva tecnología que ha permitido a la Humanidad explorar el Universo físicamente.

Hemos sobrepasado el 40 aniversario de la llegada del hombre a la Luna.

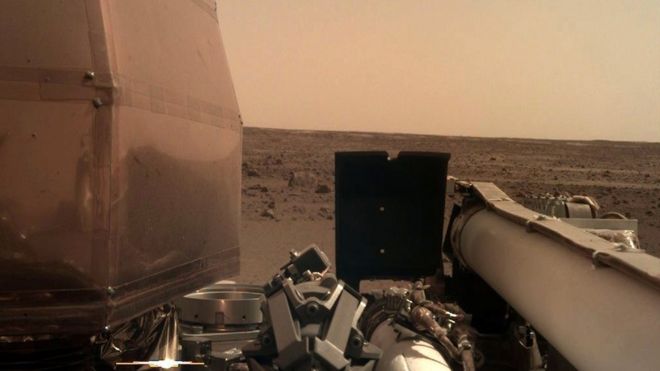

“Hay una belleza tranquila aquí”, tuiteó la NASA para compartir la segunda imagen de InSight desde Marte. La misión tardó siete minutos entre la entrada a la atmósfera hasta tocar la superficie del planeta.

De todos los esfuerzos realizados en ese empeño de conquistar el espacio exterior, como fue el primer amartizaje por la sonda Viking,

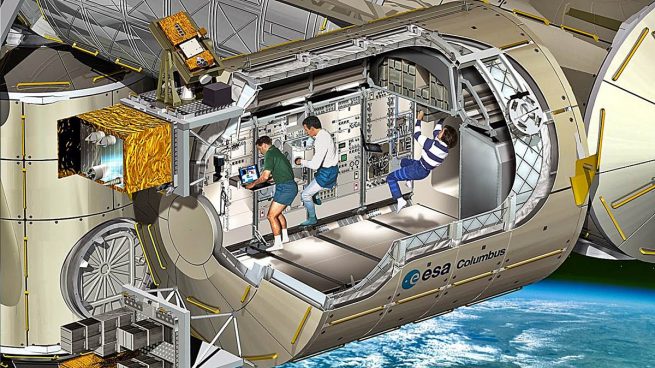

o la puesta en marcha del proyecto internacional común para la construcción de la Estación Espacial Internacional,

o la puesta en orbita del Telescopio Espacial Hubble,

el envio de los ingenios robotizados al sistema de Saturno de la Cassini y la Huygens (entre otros muchos), ha posibilitado que al dia de hoy, sepamos mucho mas de nuestro entorno, del Universo que nos acoge y de los objetos que lo pueblan y, cada dia que pasa, las esperanzas de colonizar otras Tierras crecen en posibilidades reales al mismo tiempo que crece el conocimiento de lo que por ahí fuera existe.

La ventana abierta hacia el espacio nos acerca al conocimiento que tenemos sobre nosotros mismos y hemos podido llegar a comprender que, estamos hechos del material fabricado en las estrellas. No olvidamos que formamos parte del Sistema Solar en el planeta Tierra y que estamos, por tanto, rodeados de vació, en medio de fuerzas gravitatorias y electromagnéticas, que convierten nuestro planeta en una maravillosa perla azul inmersa en un vasto territorio negro.

Buscar otros mundos que en el futuro nos puedan acoger

Fruto de las necesidades de conocimiento sobre el espacio exterior que nos rodea y aquel otro mas profundo y lejano, hace surgir la necesidad y el planteamiento de buscar nuevas formas de conocerlo, El espacio esta esencialmente “vacío”. Parece por tanto evidente, que los avanzados sistemas de vació actuales puedan ayudarnos a comprender mejor los procesos y sucesos que ocurren fuera de la atmósfera terrestre. No solo en el espacio interestelar, sino también sobre la superficie de muchos de los planetas y objetos celestes en los que su presión atmosférica sea menor que la terrestre. Así, un sistema de vació puede ser un entorno adecuado donde recrear diferentes ambientes espaciales, controlando algunos de los parámetros físicos del sistema para poder aprender sin necesidad de desplazarnos materialmente.

Todos sabemos la enorme complejidad que presentan las misiones espaciales y el elevado numero de inconvenientes que conllevan, sobre todo su elevado coste y, la no fiabilidad sobre la garantía del éxito de la misión que, al tener que desarrollarse en un ambiente hostil y en condiciones, casi siempre precarias donde pueden surgir agentes no deseados, hace imposible la seguridad de la misión y de su resultado final.

Siete astronautas perecieron a bordo del transbordador espacial Challenger de la NASA el 28 de enero de 1986. Un cuarto de siglo después, el accidente ocurrido a escasos 73 segundos del despegue,…

Todo lo anterior viene a colación de que la NASA, ha tardado 20 años en volver a mostrar interés por Marte, este es el periodo de tiempo que hay entre la sonda Viking y el Mars Pathfinder (MPf). Durante este tiempo los científicos han estudiado las 57.000 imágenes de la Viking, que ha permitido conocer la geología del planeta rojo con bastante exactitud. Sin lugar a dudas no hay planeta del Sistema solar con mejores condiciones para albergar la vida, extinta o actual, que Marte. Se parece a la Tierra en muchos aspectos: El proceso de formación, la historia climática de sus primeros tiempos, sus reservas de agua y fenómenos geológicos como los volcanes y otras.

Pequeño Rover descubre agua en Marte

Las misiones desde MPf tienen un carácter de exploración física y ambiental del entorno, para lo cual la exploración no solo se realiza con satélites y sondas como la Viking, sino también con Rovers (pequeños vehículos todoterrenos) que son capaces de recorrer la no pocas veces intrincada superficie marciana, cada vez con mayor autonomía. En las futuras misiones a Marte, no solo por la NASA sino también por la ESA, se desea caracterizar la climatología, así como la búsqueda de la vida primigenia, en la que mediante una tecnología basada en biosensores, se puedan analizar muestras in situ y de enviar los resultados a la Tierra en tiempo real.

Para que las futuras misiones a Marte tengan mayor garantía, se ha diseñado y fabricado La cámara de simulación de MARTE, esta especialmente diseñada para estudiar condiciones marcianas e introducir muestras electrónicas reales. Para ello, se puede modificar la temperatura en el portamuestras en un rango entre 80 K y 450 K, y además es capaz de modificar la temperatura ambiental entre 200 K y 400 K y de generar “tormentas de polvo” en su interior. El principal objetivo de esta cámara es la de probar nuevos dispositivos electrónicos “sensores”, por lo que su ámbito de aplicación se destina principalmente a la calibración de sensores e instrumentación ambiental que serán enviados al espacio en futuras misiones espaciales…

El principal reto, esta en poder combinar rangos de temperatura en el portamuestras distintos a los de la atmósfera, y cruzar estos con cambios bruscos de presión, mientras se mantiene la composición gaseosa de Marte. El portamuestras de MARTE, esta diseñado para poder soportar dispositivos electromecánicos de grandes dimensiones usando la misma geometría de las mesas ópticas, y pudiendo ser enfriado y calentado desde el interior. En cuanto a la atmósfera el interior, de MARTE cuenta con unos anillos refrigeradores de nitrógeno líquido que en función de la presión y la composición de la atmósfera permite enfriar la misma no solo por radiación sino también por conducción y conveccion.

Además la cámara, esta diseñada para poder generar tormentas de polvo en su interior mediante un ingenioso sistema de deposición, que mediante la combinación de un tamiz vibratorio, la gravedad y la diferencia de presiones es capaz de producir una niebla de polvo de partículas de hierro, similar a las de Marte. Sobre todo este conjunto de posibilidades también hay unos pasamuros, en los que se pueden adaptar fuentes de luz halógenas y de xenón, siguiendo el esquema de movimiento del Sol en el hemisferio norte de Marte, de ese modo se simula la incidencia de luz solar en función de la dependencia angular.

Todos estos complejos sistemas han sido desarrollados para testear los sensores de la estación meteorológica REMS de la misión MSL de la NASA, así como otros proyectos para la ESA, como ExoMars. No cabe duda alguna de que, con proyectos como este de la Cámara MARTE, nuestros conocimientos avanzaran, no solo ya sobre el planeta Marte en particular, sino que, también lo hará sobre el espacio y el vació en general.

El avance de la tecnología del vació, dado por la consecución de presiones cada vez menores, es debido no solo a las mejoras de las bombas, sino también al avance en materiales contenedores de vació, “cámaras”, con presiones de vapor y permeabilidades cada vez mas bajas.

La experiencia ha demostrado que la simulación no es solo un recurso de innovación tecnológica, sino también una herramienta útil, que permite validar la responsabilidad de las misiones espaciales, que debido al alto coste de las mismas condicionan su propia viabilidad. Del fruto de la simulación de algo tan complejo y tan vasto como es un sistema climático, en el que una mínima variación de un parámetro condiciona el comportamiento global del sistema. Así que, de todas estas experiencias de la simulación se están obteniendo grandes provechos tecnológicos, que nos permitían en un futuro cada vez mas cercano verificar nuestros propios resultados, y realizarnos preguntas sobre fenómenos que ni siquiera podemos conocer.

Resumen de un articulo de los Fisicos Sres. Sobrado y Martin Gago publicado en la Revista de la RSEF.

Totales: 77.775.539

Totales: 77.775.539 Conectados: 31

Conectados: 31