Abr

22

¿Las estrellas? Sin ellas no estaríamos aquí

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Estrellas ~

Clasificado en Estrellas ~

Comments (1)

Comments (1)

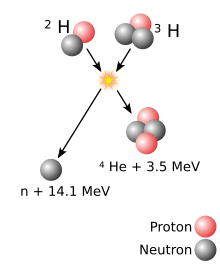

Es cierto que cuando vemos las cosas con cierta asiduidad y de forma permanente, esa cotidianidad nos hace perder la perspectiva y no pensamos en lo que realmente esas cosas pueden ser y, con las estrellas nos ocurre algo similar, ya que son algo más, mucho más, que simples puntitos luminosos que brillan en la oscuridad de la noche. Una estrella es una gran bola de gas luminoso que, en alguna etapa de su vida, produce energía por la fusión nuclear del hidrógeno para formar helio. El término estrella por tanto, no sólo incluye estrellas como nuestro Sol, que están en la actualidad quemando hidrógeno, sino también protoestrellas, aún no lo suficientemente calientes como para que dicha combustión haya comenzado, y varios tipos de objetos evolucionados como estrellas gigantes y supergigantes, que están quemando otros combustibles nucleares, o las enanas blancas y las estrellas nucleares, que están formadas por combustible nuclear gastado.

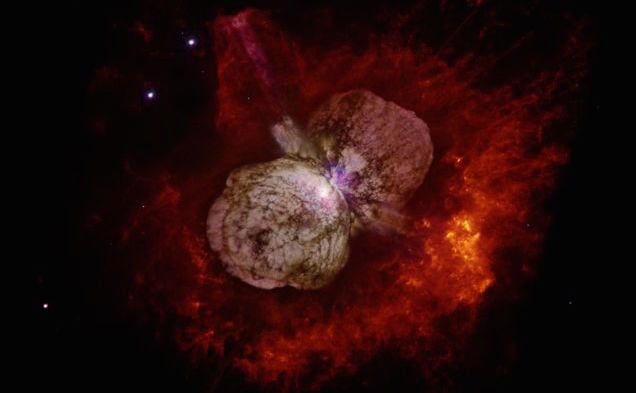

Eta Carinae una estrella masiva que arroja masa para no morir

Muchos son los ejemplos de estrellas masivas (más de 100 masas solares) que, para no morir, eyectan material al espacio interestelar y siguen viviendo.

Estrellas masivas que expulsan gases, ya que, cuando la masa es muy grande, su propia radiación las puede destruir y, de esta manera, descongestionan la tensión y evitan un final anticipado. Arriba teneis una estrella supermasiva que ha expulsado gases formando una nebulosa para evitar su muerte, Eta Carinae ha hecho lo mismo. Estas son estrellas que estám congestionadas y, sólo la expulsión de material la puede aliviar y conseguir que siga brillando como estrella evitando explotar como supernova.

Se calcula que la masa máxima de una estrella es de unas 120 masas solares, por encima de la cual sería destruida por su propia radiación. La masa mínima es de 0,08 masas solares; por debajo de ella, los objetos no serían lo suficientemente calientes en sus núcleos como para que comience la combustión del hidrógeno, y se convertirían en enanas marrones.

De la misma forma que al calentar una pieza de metal cambia de color, al principio rojo, luego amarillo hasta llegar al blanco, el color de una estrella varia según su temperatura superficial. Las estrellas más frías son las rojas, y las mas calientes las azules. Estos colores suelen percibirse a simple vista, como por ejemplo Antares (la estrella principal de Scorpius) que es de color rojo, o Rigel (en Orion) de color azul. En astronomía se utiliza la escala Kelvin para indicar temperaturas, donde el cero absoluto es -273 grados Celsius.

El diagrama de Hertzsprung-Russell proporcionó a los astrónomos un registro congelado de la evolución de las estrerllas, el equivalente astrofísico del registro fósil que los geólogos estudian en los estratos rocosos. Presumiblemente, las estrellas evolucinan de algún modo, pasan la mayor parte de su tiempo en la serie principal (la mayoría de las estrellas en la actualidad, en el brevísimo tiempo que tenemos para observar, se encuentran allí), pero empiezan y terminan su vida en alguna otra parte, entre las ramas o en el mantillo. Por supuesto, no podemos esperar para ver que esto sucede, pues el tiempo de vida, aún de estrellas de vida corta, se mide en millones de años. Hallar la respuesta exigirá conocer la física del funcionamiento estelar.

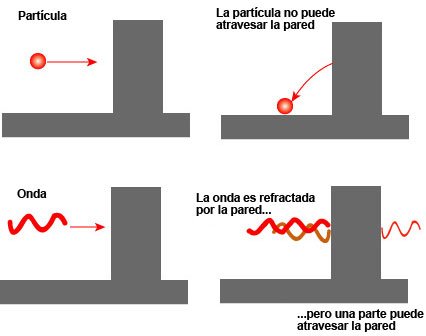

El progreso en física, mientras tanto, estaba bloqueado por una barrera aparentemente insuperable. Esto era literal: el agente responsable era conocido como la Barrera de Coulomb, y por un tiempo frustró los esfuerzos de los físicos teóricos para comprender cómo la fusión nuclear podía producir energía en las estrellas.

“La barrera de Coulomb, denominado a partir de la ley de Coulomb, nombrada así del físico Charles-Augustin de Coulomb (1736–1806), es la barrera de energía debida a la interacción electrostática que el núcleo atómico debe superar para experimentar una reacción nuclear. Esta barrera de energía es proporcionada por la energía potencial electrostática:

donde:

- k es la constante de Coulomb = 8.9876×109 N m² C−2;

- ε0 es la permeabilidad en el vacío;

- q1, q2 son las cargas de las partículas que interactúan;

- r es el radio de interacción.”

Un valor positivo de U es debido a una fuerza de repulsión, así que las partículas que interactúan están a mayores niveles de energía cuando se acercan. Un valor negativo de la energía potencial U indica un estado de ligadura, debido a una fuerza atractiva. La linea de razonamiento que conducía a esta barrera era impecable. Las estrellas están formadas en su mayor parte por hidrógeno. Esto se hace evidente en el estudio de sus espectros.) El núcleo del átomo de hidrógeno consiste en un sólo protón, y el protón contiene casi toda la masa del átomo. (Sabemos esto por los experimentos de Rutherford explicados aquí en otra ocasión). Por tanto, el protón también debe contener casi toda la energía latente del átomo de hidrógeno.

(Recordemos que la masa es igual a la Energía: E = mc2. (En el calor de una estrella los protones son esparcidos a altas velocidades -el calor significa que las partículas involucradas se mueven rápidamente- y, como hay muchos protones que se apiñan en el núcleo denso de una estrella, deben de tener muchísimos choques. En resumen, la energía del Sol y las estrellas, puede suponerse razonablemente, implica las interacciones de los protones. esta era la base de conjetura de Eddintong de que la fuente de la energía estelar “difícilmente puede ser otra cosa que energía subatómica, la cual, como se sabe, existe en abundancia en toda la materia”.

Hasta ese punto, todo iba bien, la ciencia estaba cerca de identificar la fusión termonuclear como el secreto de la energía solar. Pero aquí era donde intervenía la Barrera de Coulomb. Los protones están cargados positivamente; las partículas de igual carga se repelen entre sí; y este obstáculo parecía demasiado grande para ser superado, aun a la elevada velocidad a la que los protones se agitaban en el intenso calor del centro de las estrellas. De acuerdo con la física clásica, muy raras veces podían dos protones de una estrella ir con la rapidez suficiente para romper las murallas de sus campos de fuerza electromágnéticos y fundirse en un sólo núcleo. Los cálculos decían que la tasa de colisión de protones no podía bastar para mantener las reacciones de fusión. Sin embargo, allí estaba el Sol, con su rostro radiante y sonriente al ver el esfuerzo y las ecuaciones que decían que no podía brillar.

Dejemos aquí este proceso y digamos que, realmente, la mayoría de las veces el protón rebotará en la Barrera de Coulomb, pero de cuando en cuando la atravesará. Este es el “Efecto Túnel Cuántico”; que permite brillar a las estrellas. George Gamow, ansioso de explotar las conexiones entre la astronomía y la nueva física exótica a la que era adepto, aplicó las probabilidades cuánticas a la cuestión de la fusión nuclear en las estrellas y descubrió que los protones pueden superar la Barrera de Coulomb, o casi. El efecto túnel cuántico se hizo cargo de los cálculos de la desalentadora predicción clásica, que establecia la fusión de los protones a sólo una milésima de la tasa necesaria para explicar la energía liberada por el Sol, y la elevó a una décima de la tasa necesaria. Luego se tardó menos de un año para dar cuenta del deficit restante: la solución fue completada en 1929, cuando Robert Atkinson y Fritz Houterman combinaron los hallazgos de Gamow con lo que se ha llamado teoría maxwelliana de la distribución de velocidades. En la distribución maxwelliana hay siempre unas pocas partículas que se mueven mucho más rápidamente que la media y, Robert Atkinson y Fritz Houterman hallaron que estas pocas partículas veloces bastqaban para compensar la diferencia. Finalmente se hizo claro como podía romperse la Barrera de Coulomb suficientemente a menudo para que la fusión nuclear se produjese en las estrellas.

Pero la figura clave en todos estos desarrollos fue Hans Bhete, un refugiado de la Alemania nazi que había estudiado con Fermi en Roma y fue a enseñar en Cornell en EE. UU. Como su amigo Gamow, el joven Bhete era un pensador efervescente y vivaz, con tanto talento que parecía hacer su trabajo como si de un juego se tratara. Aunque no preparado en Astronomía, Bhete era un estudioso de legendaria rapidez. En 1938 ayudó al discipulo de Gamow y Edward Teller, C.L. Critchfield, a calcular una reacción que empezase con la colisión de dos protones podía generar aproximadamente la energía irradiada por el Sol, 3,86 x 1033 ergios por segundo. Así, en un lapso de menos de cuarenta años, la humanidad había progresado de la ignorancia de la existencia misma de los átomos a la comprensión del proceso de fusión termonuclear primaria que suministra energía al Sol.

Pero la reacción protón. protón no era bastante energética para explicar la luminosidad muy superior de estrellas mucho más grandes que el Sol, estrellas como las supergigantes azules de las Pléyades, que ocupan las regiones más altas del diagrama de Herptzsprung-Russell. Bhete puso remedio a esto antes de que terminase aquel el año 1938.

En abril de 1938, Bhete asistió a una conferencia organizada por Gamow y Teller que tenía el objeto de que físicos y astrónomos trabajaran juntos en la cuestión de la generación de energía en las estrellas. “Allí, los astrofísicos nos dijeron a los físicos todo que sabían sobre la constitución interna de las estrellas -recordoba Bhete-. esto era mucho (aunque) habían obtenido todos los resultados sin conocimiento de la fuente específica de energía.” De vuelta a Cornell, Bhete abordó el problema con celeridad y, en cuestión de semanas logró identificar el ciclo del Carbono, la reacción de fusión crítica que da energía a las estrellas que tiene más de una vez y media la masa del Sol.

Bhete que estaba falto de dinero, retiró el artículo que escribió sobre sus hallazgos y que ya tenía entragado en la Revista Physical Review, para entregarlo en un Concurso postulado por la Academía de Ciencias de Nueva York sobre la producción de energía en las estrellas. Por supuesto, Bhete ganó el primer Premio uy se llevó los 500 dolares que le sirvieron para que su madre pudiera emigrar a EE UU. Después lo volvió a llevar a la Revista que lo publicó y, finalmente, se lo publicaron y tal publicación le hizo ganar el Nobel. Por un tiempo, Bhete había sido el único humano que sabía por qué brillan las estrellas.

Cuando miramos al cielo y podemos contemplar extasiados esas maravillas que ahí arriba, en el espacio interestelar están brillando, y, nos da la sensación de que están haciéndonos guiños, como si quisieran mandarnos un mensaje, decirnos algo y nosotros, no pensamos en todo lo que ahí, en esos “puntitos brillantes” se está fraguando. De lo que allí ocurre, depende que los mundos tengan los materiales que en ellos están presentes y, de entre esos materiales, se destacan aquellos que por su química biológica, permiten que se pueda formar la vida a partir de unos elementos que se hicieron en los hornos nucleares de las estrellas.

Y sí, es curioso que, mirando en la oscura noche como brillan las estrellas del cielo, nos atrae su titilar engañoso (es la atmósfera terrestre la que hace que lo parezca) y su brillo, Sin embargo, pocos llegan a pensar en lo que verdaderamente está allí ocurriendo. Las transformaciones de fase por fusión no cesan. Esta transformación de materia en energía es consecuencia de la equivalencia materia-energía, enunciada por Albert Einstein en su famosa fórmula E=mc2; donde E es la energía resultante, m es la masa transformada en energía, y c es la velocidad de la luz (300 000 kilómetros por segundo). La cantidad de energía que se libera en los procesos de fusión termonuclear es fabulosa. Un gramo de materia transformado íntegramente en energía bastaría para satisfacer los requerimientos energéticos de una familia mediana durante miles de años.

Es un gran triunfo del ingenio humano el saber de qué, están confomadas las estrellas y qué materiales se están forjando allí, al inmenso calor de sus núcleos. Recuerdo aquí a aquel Presidente de la Real Society de Londres que, en una reunión multitudinaria, llegó a decir:

“Una cosa está clara, nunca podremos saber de qué están hechas las estrellas”.

El hombre se vistió de gloria con la (desde entonces) famosa frase. Creo que nada, con tiempo por delante, será imposible para nosotros.

A nuestro planeta sólo llega una ínfima fracción del calor que se genera en el Sol y, sin embargo, es más que suficiente para mantener aquí la vida. El Sol tiene materia que supone la misma que tendrían 300.000 Tierras. Nuestra estrella madre está situada a una UA (150 millones de kilómetros de nosotros) y, todas esas circunstancias y otras muchas, hacen que todo sea tal como lo vemos a nuestro alrededor. Si cualquiera de esos parámetros fuera diferente o variara tan sólo unas fracciones, seguramente la Tierra sería un planeta muerto y, nosotros, no estaríamos aquí. Sin embargo… ¡Estamos! y, gracias a ello, se pueden producir descubrimientos como los que más arriba hemos relatado y han podido y pueden existir personajes de cuyas mentes surgen ideas creadoras que nos llevan a saber cómo son las cosas.

Lo cierto es que, cada día sabemos mejor como funciona ma Naturaleza que, al fin y al cabo, es la que tiene todas las respuestas que necesitamos conocer.

emilio silvera

Abr

21

Nanofotónica: luz + nanopartículas = Futuro tecnológico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Nanotecnología ~

Clasificado en Nanotecnología ~

Comments (0)

Comments (0)

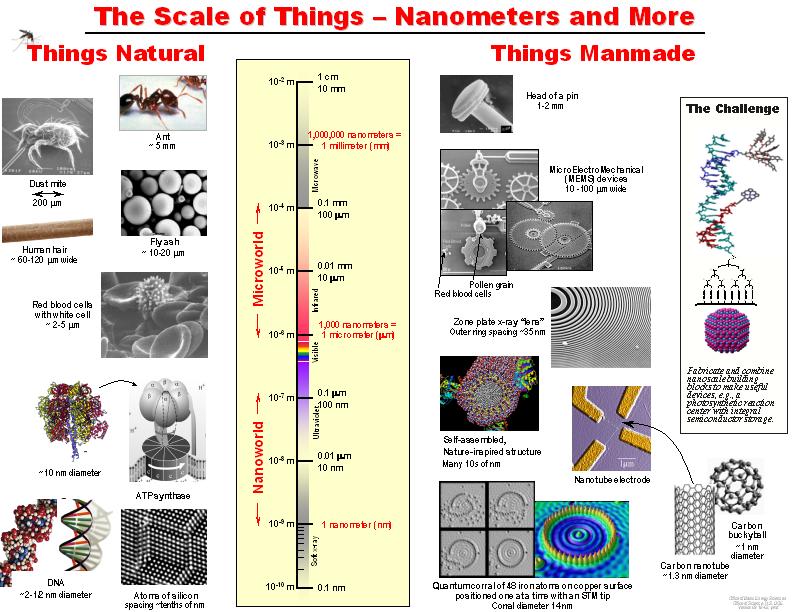

Han pasado ya cincuenta años que Richard Feynman dictara su famosa charla: There is plenty of room at the bottom: An invitation to enter a new field of physics (Hay suficiente espacio en el fondo: Una invitación a entrar en un campo en la Física). En ella estableció que las leyes de la Física no impiden manipular las cosas átomo a átomo; –“es algo que no se ha hecho debido a que somos demasiado grandes para hacerlo”-. Eso ha quedado atrás y, en la actualidad, sí que se manipulan los átomos.

Desde entonces se ha buscando la manera de poder diseñar los materiales átomo a átomo. De hecho, los materiales nanoestructurados ya han sido utilizados en aplicaciones prácticas, siendo importantes en nuestra vida diaria. El color rojo de los vitrales en las catedrales góticas de Europa se obtenía utilizando nanopartículas de oro; la película fotográfica utiliza nanopartículas de plata; los bloqueadores solares utilizan nanopartículas de dióxido de titanio y de zinc como parte activa.

El resultado más vistoso de estas nanoestructuras es la capacidad para poder sintonizar la longitud de onda o color de la emisión.

El primer caso es una aplicación del efecto nano del oro y es quizás la primera aplicación de la nanotecnología. Quizás el mayor desarrollo de las nanoestructuras se dio con el descubrimiento de la microscopia de fuerza atómica ya que con esta se podía manipular a los átomos o partículas muy pequeñas. Hoy día, la investigación en el campo de los materiales nanoestructurados se ha multiplicado y sus aplicaciones abarcan todas las disciplinas convirtiendo a la nanotecnología en un campo interdisciplinario. Muchos países han implementado programas especiales para la investigación en este campo invirtiendo grandes cantidades de dinero. La apuesta puede ser de alto riesgo, pero el premio promete ser enorme.

Richard Feynman

Hoy día se estima el mercado de la nanotecnología en cientos de miles de millones de dólares. Nuestro país también ha apoyado la iniciativa aunque en menor proporción. De hecho la nanotecnología no es una prioridad dentro de nuestro sistema de investigación, no hay programas especiales de apoyo económico en este tópico y se compite por igual con todas las áreas. Con pocos recursos económicos se poca infraestructura y en general grupos pequeños lo que dificulta la capacidad para competir. Aún con estas limitaciones, se han obtenido excelentes resultados y hay grupos en nuestro país que cuentan con reconocimiento internacional.

Materiales nanoestructurados y nanotecnología

Los materiales nanoestructurados (NEMs, por siglas en inglés) han despertado rápidamente un gran interés debido a la diversidad de sus aplicaciones. De acuerdo a la definición más aceptada, los materiales nanoestructurados son aquellos en los que por lo una de sus dimensiones se encuentra en el rango de 1-100 nm. Es decir, los NEMs son tres órdenes de magnitud más pequeños que los MEMS (sistemas microelectromecánicos, por sus siglas en inglés), e incluyen nanopartículas, nanocristales, nanoalambres, nanobarras, nanotubos, nanofibras, nanoespumas, etc. Los NEMs pueden ser semiconductores, dieléctricos, metales, orgánicos, inorgánicos, aleaciones, biomateriales, biomoléculas, oligómeros, polímeros, etc.

Los cristales fotónicos son materiales microestructurados en los que la luz se comporta como los electrones en un semiconductor, produciendo una estructura … Nos sorprendería saber en qué lugares están presentes los cristales fotónicos con las nuevas técnicas alcanzadas en la nanotecnología

Aunque existen sistemas nanoestructurados de dimensiones mayores son los cristales fotónicos. En el rango de nanómetros, los materiales presentan propiedades ópticas, eléctricas, magnéticas y mecánicas únicas y totalmente diferentes de los materiales en el rango de los micrómetros o milímetros llamados materiales en bulto.

tener una idea de que tan pequeño es un nanómetro podemos mencionar que un milímetro tiene un millón de nanómetros; el diámetro del cabello humano mide 10,000 y 50,000 nanómetros; los glóbulos rojos y blancos miden 2 y 5 nanómetros mientras que el ADN mide 2.5 nanómetros.

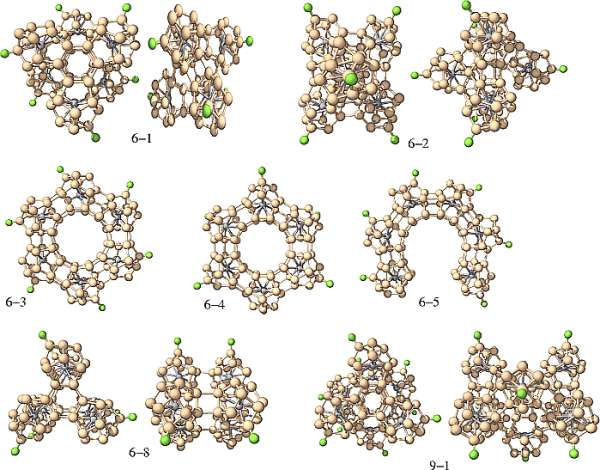

Los superátomos de silicio pueden formar, por ejemplo, nanotubos. Además, se les agregar un metal de transición con el objetivo de cambiar sus propiedades eléctricas, lo que se denomina dopaje. el superátomo es de anión ( carga eléctrica negativa, le sobran electrones), “se le dopa con un metal alcalino, el potasio”, que tiene un electrón en su nivel energético más externo. Del mismo modo, cuando son cationes (con carga negativa, al perder electrones) se les dopa con un metal halógeno, que necesita un electrón más completar su último nivel energético.

Las propiedades de los NEMs son dominadas por los efectos de superficie mientras que las de los materiales en bulto son debidas a un efecto de volumen. La tecnología su producción y uso se ha convirtiendo en una industria muy poderosa: la nanotecnología. La nanotecnología es la ciencia e ingeniería de producir materiales o estructuras funcionales de cuantos nanómetros. Es la tecnología del futuro con la cual se desarrollarán los nuevos materiales y dispositivos. Las aplicaciones son sorprendentes así como variadas, por ejemplo, la industria optoelectrónica y fotónica, biomedicina, sensores, celdas solares y de combustible, catálisis, memorias ópticas, procesadores de computadoras, fotodetectores, herramientas de corte, industria aeronáutica, moduladores e interruptores, cosméticos, etc. Aunque todas las aplicaciones son de gran interés, sin duda alguna las aplicaciones en sistemas biológicos son las más sobresalientes. Especialmente las aplicaciones de las propiedades ópticas de los sistemas nanoestructurados.

La Tecnología fundamental del siglo XXI: Nano Tecnología

Uno de sus apartados es la Nanofotónica

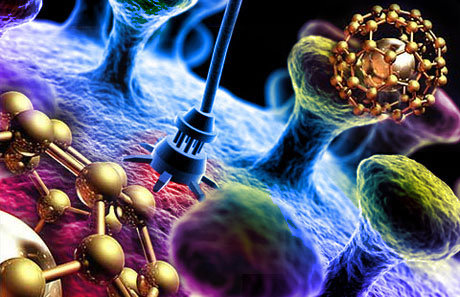

Esas nuevas formas, la nanotecnología, entrará en el “universo” de la mecánica cuántica, en el mundo infinitesimal, y, se lograrán cosas que , serían impensables. Posiblemente, la primera visita que hagamos a un mundo habitado por otros seres, estará tripulada por seres nanotecnológicos que, al igual que la misma nave, tengan medidas tan pequeñas que serán imposibles de observar y, sin embargo, estarán dotadas de adelantos tales que, podrán medir, evaluar, estudiar, captar imágenes, enviar por medios desconocidos, y, en fin, serán las avanzadillas de lo que irá después, la visita de humanos a otros mundos.

La nanofotónica es la fusión de la nanotecnología y la fotónica. Es un campo multidisciplinario que estudia las propiedades ópticas de los sistemas nanoestructurados y la interacción luzmateria a nivel nanoscópico. Ya mencionamos que las propiedades ópticas de las nanopartículas son dominadas por los efectos de superficie. Así, controlando el tamaño de las nanopartículas o nanoestructuras podemos controlar o amplificar ciertas propiedades de los sistemas bajo estudio. En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas.

La Nanotecnología marcará nuestro futuro. De ella partirán las nuevas ideas e instrumentos, los nuevos modos de construir lo que queda por venir, nuevas maneras de sondear el espacio “infinito”, de curar enfermedades, de sustituir órganos vitales, de construir robots.

Curiosamente, existe una creencia bastante arraigada en amplios sectores de la comunidad científica de que la fotónica (conjunto de tecnologías relacionadas con la luz) es un campo que cae fuera del universo de la nanotecnología. La creencia se apoya en el clásico criterio de Rayleigh de que la resolución espacial de un sistema óptico está limitada por la longitud de onda de la luz (≈ 500 nm), y por ello es próxima al micrómetro, muy lejos de los requisitos de la nanotecnología.

Yo, por mi , estimo que división es sin duda errónea, y hoy en día la fotónica está íntimamente implicada con la nanotecnología, e incluso se hablar propiamente de nanofotónica, de igual manera que se hablar de nanoelectrónica o de nanomagnetismo.

Cuando sepamos conectar de manera conveniente todas las disciplinas del sabe Humano… ¡Las cosas cambiaran!

Decía que: “En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas”. una de ellas produce fenómenos de especial interés interactúan con una señal óptica, pudiendo así ser aplicadas en diferentes campos. Un campo de especial interés es la biología.

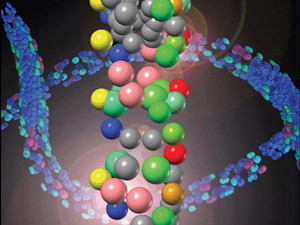

El estudio de las propiedades luminiscentes de sistemas nanoestructurados en sistemas biológicos es el campo de estudio de la bionanofotónica. Especialmente trata sobre el estudio de sistemas nanoestructurados en aplicaciones biomédicas. Diferentes nanopartículas han sido propuestas ser utilizadas en la detección de bajas concentraciones de diferentes elementos como células cancerigenas, virus, ADN, ARN, proteínas, etc. También han sido utilizadas para la entrega de medicamentos en dirigida y controlada así como para la destrucción de tumores cancerigenos. En la última década, los avances han sido sorprendentes pero aún hay mucho por . En el CIO, durante los últimos 6 años hemos trabajando en la síntesis de nanopartículas y estudiado sus propiedades ópticas a fin de poder ser utilizadas en distintas aplicaciones.

Las propiedades luminescentes de nuestras nanopartículas son muy interesantes y prometen grandes oportunidades de aplicación en diferentes áreas.

Nanopartículas semiconductoras o puntos cuánticos. Cuando el tamaño de estos semiconductores se reduce a unos pocos nanómetros (típicamente entre 1 y 10 nm), se produce una modificación de su estructura …

Los nanocristales semiconductores llamados puntos cuánticos son nanoestructuras a base de materiales semiconductores inorgánicos y representan el grupo donde el efecto del tamaño es más evidente. El tamaño nano da lugar a lo que se conoce confinamiento cuántico, que no es más que la localización de los electrones en un espacio definido, es poner un electrón en una caja. Mientras que tamaños mayores los electrones están no localizados. El confinamiento produce un ensanchamiento de la banda de energía prohibida del semiconductor así la aparición de sub-bandas discretas en la banda de valencia y de conducción. Las dimensiones típicas oscilan uno y diez nanómetros.

Con frecuencia se les describe átomos artificiales debido a que los electrones están dimensionalmente confinados como en un átomo y sólo se tiene niveles de energía discretos. las nanoestructuras más estudiadas se encuentran las de CdSe/ZnS, CdSe/CdS, InP/ZnSe, CdTe/CdSe, entre otras. El resultado más vistoso de estas nanoestructuras es la capacidad poder sintonizar la longitud de onda o color de la emisión.

Así, con un solo material y variando el tamaño de la nanopartícula es posible obtener múltiples colores o longitudes de onda de la señal emitida. Las aplicaciones son impresionantes y apuntan en todas las direcciones. Por ejemplo, podrían ser utilizados como colorantes inorgánicos sin problemas de degradación a diferencia de los colorantes orgánicos. También podrían ser utilizados en el diseño de los nuevos amplificadores ópticos de amplio ancho de banda tan importantes en los sistemas de comunicación óptica; en caso nanopartícula con un diámetro determinado funcionaría como un amplificador, así el ancho de banda se determina con la selección adecuada de los diámetros de las partículas. O bien la producción de fuentes de luz blanca mediante excitación con un LED u OLED o por electroluminiscencia.

Quizás una de las aplicaciones que mayor atención ha recibido es en su uso como etiquetas fluorescentes con emisión en la región visible del espectro, la detección de una gran variedad de compuestos entre ellas células cancerigenas. Las técnicas actuales no detectan bajas concentraciones de células cancerigenas o compuestos de interés, por lo que la técnica de detección de fluorescencia de nanopartículas es una gran promesa para la detección temprana de este mal, para así incrementar el éxito en el tratamiento. Dado el tamaño tan pequeño de los puntos cuánticos actualmente se intenta desarrollar nanoestructuras más complejas formadas por puntos cuánticos o nanocristales acomplejados con diferentes componentes que desempeñan distintas funciones, detección, entrega de medicamento dirigido, efecto de la terapia, etc. Es decir, se busca una nanoestructura inteligente con múltiples funciones. El problema que presentan los puntos cuánticos es que son poco estables ya que tienden a aglomerarse, además de que se excitan con una fuente de luz UV donde la mayoría de los compuestos que se pueden encontrar en interior del cuerpo humano emiten luz lo que significa pérdida de contraste en la imagen de la célula deseada.

Los plasmones producen en la interfase un campo eléctrico intensificado que a su vez intensifica varios procesos ópticos lineales y no lineales. El campo eléctrico producido es utilizado como una interfase sensible a las interacciones ópticas y se convierte en una poderosa herramienta para el monitoreo óptico y para la formación de imágenes ópticas

localizadas. Una de las aplicaciones bien establecidas es la espectroscopia Raman de superficie mejorada (SERS por sus siglas en inglés). En este caso el espectro Raman de un componente cercano a la superficie metálica se ve fuertemente amplificado. Se ha demostrado que es posible amplificar el campo hasta 11 000 veces más cuando las partículas presentan cierta aglomeración. Otros fenómenos que presentan amplificación son la espectroscopia infrarroja de superficie mejorada, espectroscopia de fluorescencia

y la espectroscopia de resonancia de plasmones de superficie. Todas estas técnicas son complementarias y son utilizadas en la detección de componentes químicos y bioquímicos a nivel de trazas.

No tarderemos mucho en asombrarnos de los logros alcanzados por la Nanofotónica en diversos apartados de la tecnología del futuro. Estamos en la linea de salida hacia horizontes futuristas en todos los campos del saber. La tecnología del mañana nos asombraría hoy, y, simplemente tenemos que fijarnos en el presente y compararlo con aquel tiempo pasado de hace sólo unos cien años, cuando los ordenadores, los teléfonos móviles y las comunicaciones tal como hoy laos conocemos, eran un sueño irrealizable.

Nanopartículas dieléctricas o nanocristales

Los nanocristales dieléctricos son óxidos que presentan una banda de energía prohibida muy ancha y consecuencia requieren altas energías de bombeo o luz en el UV obtener emisión que en general es débil, aunque se combina en adecuadacon diversos componentes son excelentes emisores de luz debido a su eficiencia y alta estabilidad. Son excelentes matrices soportar iones de tierras raras que son muy buenos emisores de luz. En caso no se observan efectos de confinamiento debido a que los electrones se encuentran localizados en orbitales atómicos del ion activo. Sin embargo, la dinámica de los iones emisores de luz se ve afectada por la interacción a nivel nanoscópico lo que producir una mejora en la eficiencia de emisión.

los nanocristales mas estudiados se encuentran algunos silicatos Y2SiO5, la combinación nY2O3 + mAl2O3 que comprende puramente el óxido de itria, puramente el óxido de aluminio, se combinan con n=3 y m=5 da lugar a la estructura cristalina mas utilizada en óptica producir láseres conocida como YAG, o YAP la combinación n=m=1 que corresponde a uno de los cristales mas sensibles a laradiación ionizante y que es utilizado la detección de rayos X o rayos gama. El óxido de titanio (TiO2) y el óxido de zinc (ZnO) que se utilizan en los bloqueadores solares además de ser excelentes para los procesos de fotocatálisis, útiles en la reducción de contaminantes, para celdas solares y como bactericida.

Recientemente, hemos demostrado que el óxido de zirconio (ZrO2) combinado con otros elementos bloquea el rango completo de la luz ultravioleta, especialmente aquella región que produce el . mismo nanocristal presenta excelente respuesta en la detección de radiación ionizante, UV, rayos X, gama, beta y alfa, tanto en tiempo real como en acumulada lo que sugiere buenas oportunidades para su uso en el diseño de dosímetros para la cuantificación de dosis recibidas.

Además, es excelente soporte para iones de tierras raras, con las cuales hemos obtenido luz visible (azul, verde y rojo) excitando con una fuente en el cercano infrarrojo. Ya que con fuente se excitan los nanocristales no hay emisión de fondo lo que mejora el contraste de las imágenes obtenidas. Estas características convierten a estos nanocristales en excelentes candidatos en aplicaciones biomédicas para la detección de diversos elementos a concentraciones bajas. La fabricación de estos nanocristales implica un tratamiento térmico para el proceso de oxidación lo que induce un tamaño de partícula grande. Se han reportado tamaños de partícula 10 a 90 nm.

Lo curioso es que en todo esto como en la Naturaleza, siempre está la Luz presente

Muchas veces se obtienen cristales muy pequeños con poca eficiencia de emisión, el reto es obtener mayor eficiencia de emisión sin incrementar demasiado el diámetro de las nanopartículas. Tamaños promedios con los que se han obtenido excelente eficiencia de emisión son 40 y 60 nm.

Nano partículas metálicas, plasmones.

El estudio de las propiedades luminiscentes de sistemas nanoestructurados en sistemas biológicos es el campo de estudio de la bionanofotónica.

Las nanopartículas metálicas tienen la habilidad de esparcir y absorber la luz incidente. En caso, los efectos en las propiedades ópticas respecto a su contraparte en bulto se derivan de los efectos electrodinámicos y de la modificación del ambiente dieléctrico. A escala nanométrica la frontera metaldieléctrico produce cambios considerables en las propiedades ópticas.

resultado de la interacción la nanopartícula metálica y la señal óptica se obtiene la oscilación colectiva de electrones de superficie lo que genera bandas de resonancia conocidas plasmones localizados o plasmones de superficie localizados. La longitud de onda o color a la que se obtiene dicha resonancia se le conoce como banda de absorción del plasmón que depende tanto del tamaño como de la de la nanopartícula y es lo que da lugar a la diferente coloración observada. Las nanoestructuras metálicas más conocidas son partículas esféricas, barras y películas con núcleo dieléctrico. Aunque más recientemente se han reportado otras estructuras como cubos, triángulos, estrellas y ovoides. En todos los casos, la banda de resonancia se recorre hacia el cercano infrarrojo en comparación con las nanopartículas esféricas cuya banda centrada en la región verde del espectro.

Los plasmones producen en la interfase un campo eléctrico intensificado que a su vez intensifica varios procesos ópticos lineales y no lineales. El campo eléctrico producido es utilizado una interfase sensible a las interacciones ópticas y se convierte en una poderosa herramienta el monitoreo óptico y la formación de imágenes ópticas

localizadas. Una de las aplicaciones establecidas es de superficie mejorada (SERS por sus siglas en inglés). En caso el espectro Raman de un componente cercano a la superficie metálica se ve fuertemente amplificado. Se ha demostrado que es posible amplificar el campo 11 000 veces más las partículas presentan cierta aglomeración. Otros fenómenos que presentan amplificación son la espectroscopia infrarroja de superficie mejorada, espectroscopia de fluorescencia

y la espectroscopia de resonancia de plasmones de superficie. Todas estas técnicas son complementarias y son utilizadas en la detección de componentes químicos y bioquímicos a nivel de trazas.

Quizás un proyecto más ambicioso es el de poder detectar células cancerigenas a temprana edad de lo cual ya se han reportado importantes avances. En el CIO trabajamos con nanopartículas de oro y plata a fin de desarrollar sensores ópticos la detección de diferentes compuestos a nivel de trazas y estamos aplicado exitosamente nanopartículas deoro en la detección de células cancerigenas.

En resumen, las nanoestructuras presentan propiedades ópticas únicas que no presentan su contraparte en bulto o de escala mayor. Éstas están siendo utilizadas el desarrollo de la nueva generación de dispositivos optoelectrónicos y/o fotónicos. Las aplicaciones son muy variadas y abarcan muchos campos haciendo de la nanociencia y nanotecnología una área

multidisciplinaria. Especial atención recibe el uso de dichas propiedades en aplicaciones biomédicas para la detección a nivel de trazas de diversos agentes patógenos. El estudio de las propiedades ópticas de las nanoestructuras ha definido una nueva área conocida como nanofotónica.

¡Eso que llamamos futuro… ya está aquí!

Y, siendo testigo de todos estos adelantos y de como la Humanidad corre hacia el futuro, no puedo dejar de preguntarme: ¿Qué será de los seres humanos dentro de 10.000 años? ¿Estaremos aquí todavía? ¿Habremos logrado viajar a las estrellas? Son tantas las respuestas que me gustaría tener que, a veces, me siento algo frustrado por las inmensas limitaciones a las que estamos sometidos los humanos?

emilio silvera

Abr

21

Todo el Universo es una maravilla

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

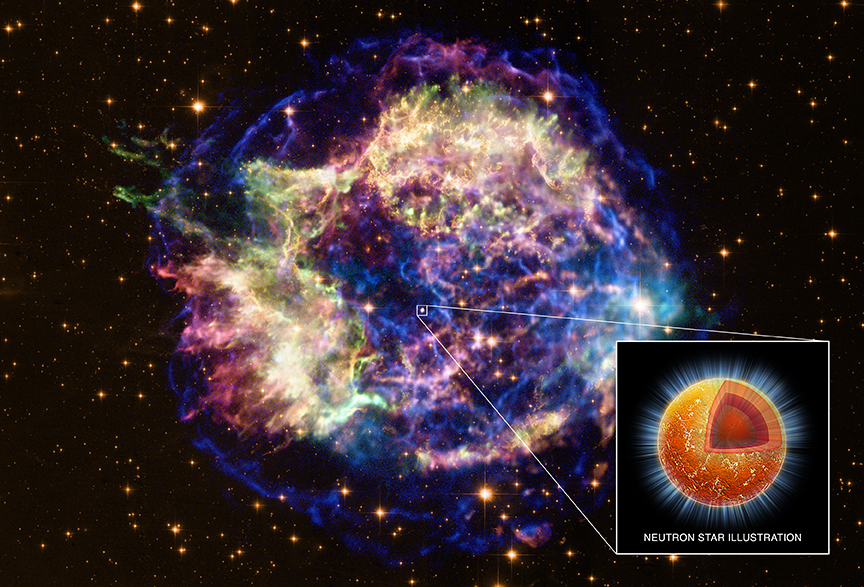

La remanente de supernova Cassiopeia A que se encuentra a 11.000 años luz de distancia. La luz de la supernova Cass A, que es la muerte explosiva de una estrella masiva, alcanzó la Tierra por primera vez hace sólo 330 años. de desechos en expansión ocupa ahora unos 15 años luz en esta composición de rayos X y luz visible, mientras que la brillante fuente cerca del centro es una estrella de neutrones, los restos colapsados increíblemente densos del núcleo estelar. Aunque está suficientemente caliente emitir rayos X, la estrella de neutrones de Cass A se está enfriando. De hecho, los 10 de observación del observatorio de rayos X Chandra averiguó que la estrella de neutrones se enfrió tan rápido que los investigadores sospechan que gran del núcleo de dicha estrella está formando un superfluido de neutrones sin fricción. Los resultados del Chandra representan la primera evidencia observacional para este extraño estado de la materia. ( : X-ray: NASA/CXC /UNAM / Ioffe /.

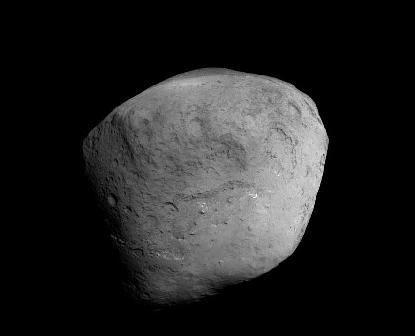

El Cometa Tempel 1 desde la Sonda Stardust-NeXT

Ningún cometa se ha visitado antes dos veces. Por tanto, el paso sin precedente de la sonda Stardust-NeXT cerca del Cometa Tempel 1 hace algún tiempo ya, nos proporcionó a los humanos una oportunidad única de ver cómo cambia el núcleo de un cometa a lo largo del tiempo. Los cambios en el núcleo del Cometa Tempel 1 eran de particular interés porque el cometa fue golpeado por un objeto cuando pasaba la sonda Deep Impact en 2005. La fotografía superior es una imagen digitalmente ensalzada del Cometa Tempel 1 cerca de su máxima aproximación a la Stardust-NeXT. Se pueden ver muchas características retratadas en 2005, como cráteres, grietas, y también áreas muy suaves. Sólo se pueden sacar unas pocas conclusiones, pero en los próximos años los astrónomos especializados en cometas y en el entendimiento del Sistema Solar se servirán de estas imágenes para buscar nuevas pistas de la composición del Cometa Tempel 1, como se encuentra el lugar del impacto del 2005, y como han evolucionado los principales accidentes del mismo.

Créditos: NASA, JPL-Caltech, Cornell

Se trata de estrellas contra montañas de gas en NGC 2174, y las estrellas van ganando. Más en concreto, la luz energética y los vientos las estrellas masivas de formación reciente están evaporando y dispersando las oscuras guarderías estelares en que se formaron. Las estructuras de NGC 2174 son en realidad mucho menos densas que el aire, y sólo aparecen como montañas debido a cantidades relativamente pequeñas de polvo opaco interestelar. NGC 2174 es una vista poco conocida en la constelación de Orión, que puede encontrarse con binoculares cerca de la cabeza del cazador celestial. Está a unos 6.400 años luz de distancia, y la brillante nube cósmica entera cubre una zona más grande que la de la Luna llena, además de rodear diversos cúmulos abiertos de estrellas jóvenes. La imagen superior tomada desde el Telescopio Espacial Hubble, muestra una densa región interior que extiende apenas unos tres años luz adoptando una gasma de colores que muestra las emisiones de otra rojas del hidrógeno en tonos verdosos y resalta la emisión del azufre en rojo y el oxígeno en azul. En unos pocos millones de años, las estrellas probablemente ganarán de forma definitiva y toda la montaña de polvo será dispersada.

Como un barco surcando los mares cósmicos, la estrella fugitiva Zeta Ophiuchi produce el arco de onda o choque interestelar que se ve en este impresionante retrato infrarrojo la nave espacial WISE. En la vista en falso color, la azulada Zeta Oph, una estrella unas 20 veces más masiva que el sol, aparece cerca del centro de la imagen, moviéndose hacia la parte superior a 24 kilómetros por segundo. Su fuerte viento estelar la precede, comprimiento y calentando el polvoriento material interestelar y formando el frente de choque curvado. Alrededor hay nubes de material relativamente no afectado. ¿Qué mantiene a esta estrella en movimiento? Seguramente, Zeta Oph fue una vez miembro de un sistema estelar y su estrella compañera sería más masiva y por tanto de vida más corta. Cuando la compañera explotó como supernova catastróficamente, perdiendo masa, Zeta Oph fue arrjada fuera del sistema. Situada a unos 460 años luz de distancia, Zeta Oph es unas 65.000 veces más luminosa que el sol y podría ser una de las estrellas más brillantes del cielo si no estuviese rodeada de polvo oscuro. La imagen de la WISE abarca sobre 1,5 grados o 12 años luz a la distancia estimada de Zeta Ophiuchi.

Créditos: NASA, JPL-Caltech,WISE Team

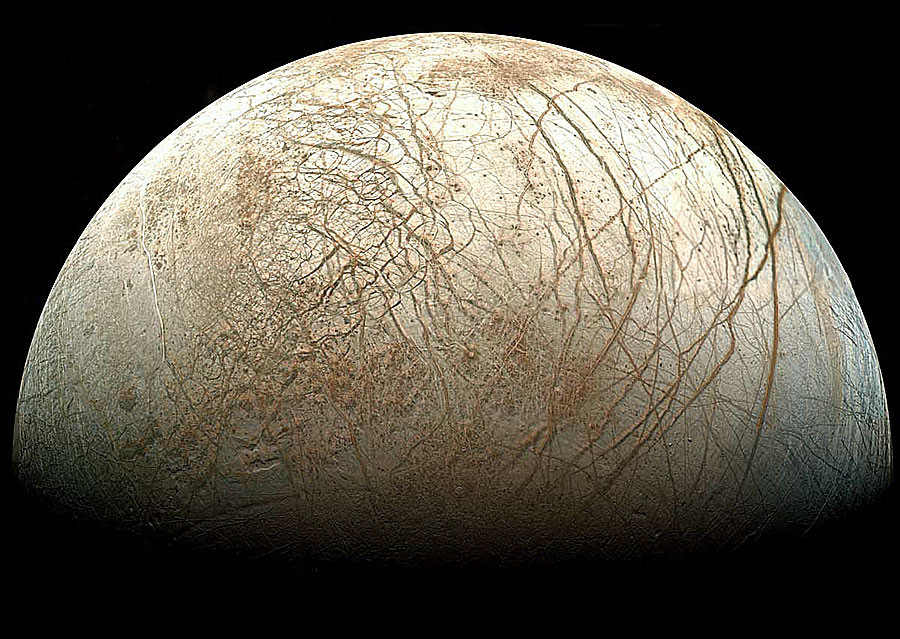

Aunque la fase de esta luna podría parecernos familiar, la luna como tal no lo es. De hecho, esta fase gibosa muestra parte de la luna de Júpiter llamada Europa. La sonda robótica Galileo capturó esta Imagen en mosaico durante su misión orbital en Júpiter entre 1995 y 2003. Se pueden ver planicies de hielo brillante, grietas que llegan hasta el horizonte, y oscuros boquetes que probablemente contentan tanto hielo como suciedad. El terreno elevado es casi un hecho cerca del terminador, donde empieza la sombra. Europa es casi del mismo tamaño que nuestra luna, pero mucho menos abrupta, mostrando muy pocas altiplanicies o cráteres de impacto. Pruebas e imágenes de la sonda Galileo indican que pueden existir océanos océanos líquidos debajo de su helada superficie. Para poder especular de que estos mares pudieran contener alguna de vida, la ESA ha empezado ya el desarrollo de la Jovian Europa Orbitert, una sonda que orbitará Europa. Si la capa helada es suficientemente delgada, una misión en el futuro podría soltar hidro robots en los océanos para buscar vida.

Créditos: Galileo Project,JPL,NASA;reprocessed by Ted Stryk

M78 no se está escondiendo realmente en el cielo nocturno del planeta Tierra. Situada a unos 1.600 años luz de distancia y ubicada en la rica en nebulosas constelación de Orión, la grande y brillante nebulosa de reflexión, es bien conocida para los observadores del cielo con telescopio. Pero esta espléndida imagen de M78 fue seleccionada como ganadora de la competición de astrofotografía Tesoros ocultos 2010. Celebrada por el European Southern Observatory (ESO), la competición retó a astrónomos aficionados a procesar del archivo astronómico del ESO para buscar gemas cósmicas ocultas. La Imagen ganadora muestra increíbles detalles dentro de la azulada M78 (centro) abrazada por nubes de polvo oscuras, junto con otra nebulosa de reflexión más pequeña de la región, NGC 2071 (arriba). La recientemente descubierta Nebulosa McNeil, amarillenta e incluso más compacta, llama la atención en la parte inferior a la derecha del centro. Basada en datos de la cámara WFI del ESO y el telescopio de 2,2 metros de La Silla en Chile, esta imagen se extiende alrededor de apenas 0,5 grados en el cielo. Eso se corresponde con 15 años luz a la distancia estimada de M78.

Créditos: ESO /Igor Chekalin

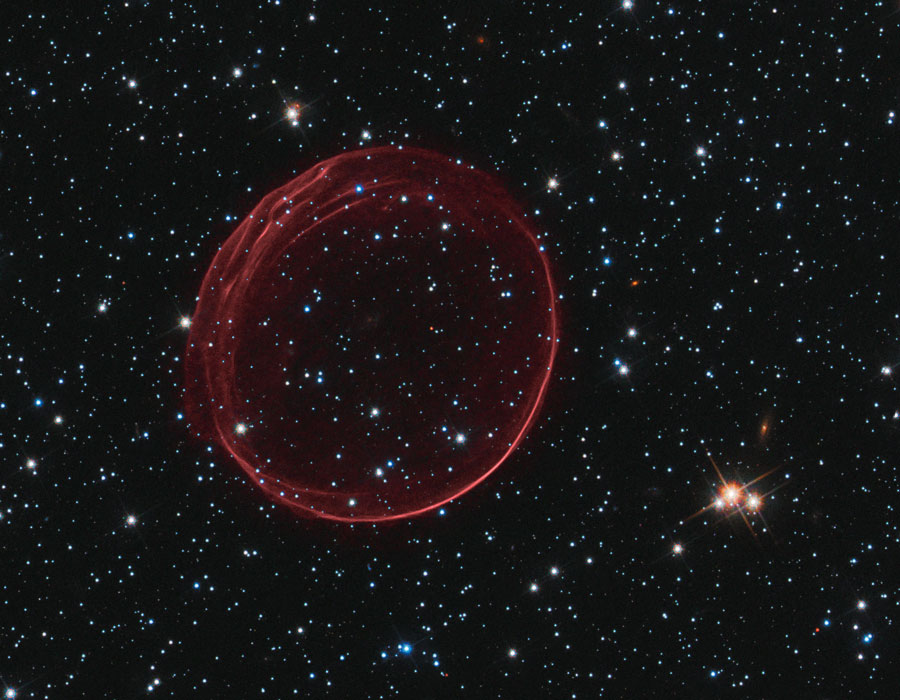

¿Qué está causando las pintorescas ondas del remanente de supernova SNR 0509-67.5? Las ondas, así la más grande nebulosa, fueron captadas con un detalle sin precedentes por el Telescopio Espacial Hubble en 2006 y otra vez a finales del año pasado. El color rojo fue recodificado por un un filtro del Hubble que dejó solamente la luz emitida por hidrógeno energético. La razón específica de las ondas sigue siendo desconocida, con dos hipótesis consideradas para su origen que las relacionan con porciones relativamente densas de gas expulsado o impactado. La razón del anillo brillante rojo más ancho está más clara, su velocidad de expansión y ecos de luz lo relacionan con una clásica explosión de supernova del Ia que ha debido ocurrir hace unos 400 años. SNR 0509 se extiende actualmente unos 23 años luz y se encuentra a unos 160.000 años luz de distancia hacia la constelación del Dorado-delfin (Dorado) en la Gran Nube de Magallanes. Sin embargo, el anillo en expansión tiene también otro gran misterio: ¿Por qué su supernova no fue vista hace 400 años, cuando la luz del estallido inicial debió alcanzar la Tierra?

Créditos: NASA,ESA, y theHubble Heritage Team(STScI/AURA); Acknowledgment: J. Hughes(Rutgers U.

Alnitak, Alnilam y Mintaka son las brillantes estrellas azuladas desde el este al oeste (izquierda a derecha) a lo largo de la diagonal de esta maravillosa vista cósmica. Conocidas también como el Cinturón de Orión, estas tres estrellas supergigantes azules son más calientes y mucho más masivas que el Sol. Se encuentran a alrededor de 1.500 años luz de distancia, nacidas de las bien estudiadas nubles interestelares de Orión. De hecho, las nubes de gas y polvo a la deriva en esta región tienen curiosas y algo sorprendentemente familiares apariencias, como la oscura nebulosa Cabeza de Caballoy la nebulosa de la Llama, cerca de Alnitak en la parte inferior izquierda. La propia famosa nebulosa de Orión se sitúa fuera de la parte inferior de este colorido campo estelar. Grabado el pasado Diciembre con una cámara digital SLR modificada y un pequeño telescopio, el bien planeado mosaico de dos fotogramas se extiende alrededor de 4 en el cielo.

Créditos.

Alrededor de estas estrellas siempre surgieron muchas historias: “Todo comienza en la constelación de Orión que posee entre sus más importantes estrellas a Betelgeuse, Rigel, Bellatriz, Almitak, Almilan, Mintaka, Saiph, Meissa, Tabit, Atiza y Eta Orionis; siendo Betelgeuse el lugar de partida de la historia. Betelgeuse esta situada en lo que llamaríamos el hombro derecho de Orión. Posee un diámetro aproximado de 450 millones de kilómetros. Si la colocáramos en el centro de nuestro sol, su radio abarcaría a Mercurio, Venus y la Tierra. Se encuentra a 310 años luz de nuestro sistema y está en vía de extinción convirtiéndose poco a poco en una estrella súpergigante roja. Ella posee 33 planetas de alta vibración y ellos se manejan muchos designios que ocurren en el orden de los pléyades. Sus habitantes son amorosos, bondadosos, pero igualmente guerreros y en uno de esos planetas habita el señor EO disfrutando de todo el amor de la creación compuesto por la luz, la energía, y la fuerza.

En esta hermosa naturaleza “muerta” celeste compuesta con un pincel cósmico, la nebulosa polvorienta NGC 2170 brilla en la parte superior izquierda. Reflejando la luz de las cercanas estrellas calientes, NGC 2170 está unida a otras nebulosas de reflexión azuladas, una región compacta de emisión roja y serpentinas de polvo oscuro contra un telón de fondo de estrellas. Al igual que los pintores de naturalezas muertashabituales en el hogar a menudo escogen sus temas, las nubes de gas, el polvo y las estrellas calientes fotografiadas aquí son también comúnmente encontradas en este escenario; una masiva nubes moleculares de formación estelar en la constelación Monoceros. molecular gigante gigante, Mon R2, está impresionantemente cercana, estimándose en solo 2 400 años luz de distancia más o menos. A esa distancia, este lienzo tendría 15 años luz de diámetro.

En lo único que difiero de la traducción que han hecho es, en la calificación de “naturaleza muerta”, ya que, nunca podríamos contemplar nada más “vivo” que lo que arriba se nos muestra. Siempre cambiante y en actividad lograr los elementos complejos de la vida.

Una de las galaxias más brillantes en el cielo del planeta Tierra y de un tamaño semejante a la Vía Láctea, la espiral M81, grande y hermosa, se encuentra a 11,8 millones de años luz de distancia en la constelación meridional de Ursa Major (Osa Mayor). Esta imagen intensa de la zona revela detalles del brillante núcleo amarillo, pero al mismo tiempo sigue características más tenues a lo largo de los espléndidos brazos espirales azules y los corredores que barren el polvo. También sigue el detalle en arco, de gran extensión, denominado bucle de Arp, que parece elevarse el disco galáctico, a la derecha. Estudiado en los 60 del siglo pasado, se ha pensado que el bucle de Arp era una cola de marea material retirado de M81 por la interacción gravitacional con su gran galaxia vecina M82. Pero una investigación reciente demuestra que gran parte del bucle de Arp posiblemente se encuentra en nuestra propia galaxia. Los colores del bucle en luz visible e infrarroja coinciden con los colores de las nubes de polvo dominantes, cirros galácticos relativamente inexplorados solo unos pocos centenares de años luz por encima del plano de la Vía Láctea. Junto con las estrellas de la Vía Láctea, las nubes de polvo se localizan en el primer plano de esta destacada imagen. La galaxia enana compañera de M81, Holmberg IX, puede ser vista justo por encima y a la izquierda de la gran espiral.

Objetos el que arriba podemos contemplar, galaxias espirales, son como entes vivos y generan entropía negativa que hace posible la regeneración del Universo a través de los sistemas dinámicos de destrucción-construcción, es decir, algo muere que algo surja a la vida. Esa es la Ley que impera en todo nuestro Universo.

¿Qué veríamos si fuésemos directo un Agujero Negro? Lo cierto es que, como nadie estuvo nunca en tal situación, lo único que podemos hacer es especular y hacer una y otra vez las ecuaciones de los distintos momentos que se podrían producir en un viaje de tal calibre en el que, a medida que nos acercamos al agujero y pasamos esa línea prohíbida del horizonte de suscesos, en algún momento tendríamos la sensación de que el tiempo se detendría, y, también sentiríamos que nuestros cuerpos sufrirían el efecto spaghetti, es decir, a medida que vamos hacia la singularidad, la masa de nuestros cuerpos se verán estiradas hacia ese lugar del que no se vuelve. Algunos ilusos, hablan de que, si la nave atravieda el agujero por el mismo centro, se saldría por otro “universo”, es decir, sería un viaje alucinante hacia lo desconocido.

La preguntita para finalizar el reportaje, tiene su guasa, y, desde luego, considerando que el agujero negro contiene el más denso estado de la materia que en el Universo pueda existir, la respuesta no resulta nada fácil, toda vez que, aunque nadie estuvo allí nunca para poder regresar y contarnos sus impresiones, lo cierto es que, según todos los indicios, la irresistible fuerza de Gravedad que emana del Agujero Negro, tiraría de nosotros con tal fuerza que nos espaguetizaría primero y pulverizaría después.

Mejor no pasarse por allí, por si acaso.

emilio silvera

Abr

20

Surgieron pensamientos… ¡Que nunca dejaran de asombrarnos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Ludwig Boltzmann será el protagonista de hoy

Hay ecuaciones que son aparentemente insignificantes por su reducido número de exponentes que, sin embargo, ¡dicen tántas cosas…! En la mente de todos están las sencillas ecuaciones de Einstein y de Planck sobre la energía-masa y la radiación de cuerpo negro. Esa es la belleza de la que hablan los físicos cuando se refieren a “ecuaciones bellas”.

Maxwell

Las ecuaciones de Maxwell…, “y se hizo la luz”

La identidad de Euler: Algunos dijeron de su ecuación: “la expresión matemática más profunda jamás escrita”, “misteriosa y sublime”, “llena de belleza cósmica”, “una explosión cerebral”.

Newton y su segunda ley que, aunque no funcione cuando nos acercamos a velocidades relativistas, rompió la marcha hacia la Gravedad.

Pitágoras y “su” teorema, también debe estar presente como lo está su teorema en las construcciones de todo el mundo y… mucho más.

Schrödinger y su función de onda que tampoco se queda atrás (aunque como la ecuación de Newton, si hablamos de velocidades relativistas…)

Bueno, E = mc2, nos lleva a profundidades de la materia antes jamás vistas y nos permite sacar conclusiones como que, en un gramo de materia está encerrada toda la energía consumida por la Humanidad durante un minuto. ¡Masa y Energía son la misma cosa!

Einstein, con esa ecuación de arriba de la relatividad general, vino a cambiar el mundo y, a partir de entonces, nació la verdadera cosmología. ¡Nos habla de tántas cosas!

¿Qué decir de la maravillosa fórmula de la entropía de Boltzman?

S = k log W

Creo que hoy, hablaremos de ella. Boltzman con su trabajo e ingenio, le dio a la Humanidad la herramienta para que pudiera seguir avanzando en el difícil laberinto de la Cienca, fue, sin duda, uno de los físicos más ilustres del siglo XIX.

El trabajo científico desarrollado por Boltzmann en su época crítica de transición que puso el colofón a la física “clásica” –cuya culminación podríamos situar en Maxwell– y antecedió (en pocos años) a la “nueva” física, que podemos decir que comenzó con Max Planck y Einstein. Aunque ciertamente no de la importancia de los dos últimos, la labor científica de Boltzmann tiene una gran relevancia, tanto por sus aportaciones directas (creador junto con “su amigo” Maxwell y Gibbs de la mecánica estadística, aunque sea el formulismo de éste último el que finalmente haya prevalecido; esclarecedor del significado de la entropía, etc.) como por la considerable influencia que tuvo en ilustres físicos posteriores a los que sus trabajos dieron la inspiración, como es el caso de los dos mencionados, Planck y Einstein.

Boltzmann fue un defensor a ultranza del atomismo, polemizando sobre todo con Mach y Ostwald, antiatomistas partidarios de la energética y claros exponentes de la corriente idealista de la física alemana. Tuvo que abandonar su ambiciosa idea de explicar exactamente la irreversibilidad en términos estrictamente mecánicos; pero esta “derrota”, no ocultaré que dolorosa desde el punto de vista personal, le fue finalmente muy productiva, pues de alguna manera fue lo que le llevó al concepto probabilista de la entropía. Estas primeras ideas de Boltzmann fueron reivindicadas y extendidas, en el contexto de la teoría de los sistemas dinámicos inestables, sobre todo por la escuela de Prigogine, a partir de la década de 1970.

La personalidad de Boltzmann era bastante compleja. Su estado de ánimo podía pasar de un desbordante optimismo al más negro pesimismo en cuestión de unas pocas horas. Era muy inquieto; él decía – medio en serio, medio en broma – que eso se debía a haber nacido en las bulliciosas horas finales de los alegres bailes del Martes de Carnaval, previas a los “duelos y quebrantos” (entonces) del Miércoles de Ceniza.

Ludwig Boltzmann and co-workers in Graz, 1887. (standing, from the left) Nernst, Streintz, Arrhenius, Hiecke, (sitting, from the left) Aulinger, Ettingshausen, Boltzmann, Klemenčič, Hausmanninger

Su lamentable final, su suicidio en Duino (Trieste) el 5 de septiembre de 1906, muy probablemente no fue ajeno a esa retorcida personalidad, aunque su precaria salud física fue seguramente determinante a la hora de dar el trágico paso hacia el lado oscuro.

Uno de los problemas conceptuales más importantes de la física es cómo hacer compatible la evolución irreversible de los sistemas macroscópicos (el segundo principio de la termodinámica) con la mecánica reversible (las ecuaciones de Hamilton o la ecuación de Schrödinger) de las partículas (átomos o moléculas) que las constituyen. Desde que Boltzmann dedujo su ecuación en 1872, este problema ha dado lugar a muy amplios debates, y el origen de la irreversibilidad es, aún hoy en día, controvertido.

En una de sus primeras publicaciones, Boltzmann obtuvo en 1866 una expresión de la entropía, que había sido definida un año antes por Clausius, basado en conceptos mecánicos. Las limitaciones de este trabajo eran que su aplicación se restringía al estudio de los gases y que el sistema era periódico en el tiempo. Además, Boltzmann no pudo deducir de su definición de entropía la irreversibilidad del segundo principio de la termodinámica de Clausius. En 1868, basándose en las ideas probabilísticas de Maxwell, obtuvo la distribución de equilibrio de un gas de partículas puntuales bajo la acción de una fuerza que deriva de un potencial (distribución de Maxwell-Boltzmann).

En el Universo, considerado como sistema cerrado, la entropía crece y…

En 1.872 publicó la denominada ecuación de Boltzmann para cuya deducción se basó, aparentemente, en ideas mecánicas. Esta ecuación contiene, sin embargo, una hipótesis no mecánica (estadística) o hipótesis del caos molecular, que Boltzmann no apreció como tal, y cuya mayor consecuencia es que, cualquiera que sea la distribución inicial de velocidad de un gas homogéneo diluido fuera del equilibrio, ésta evoluciona irreversiblemente hacia la distribución de velocidad de Maxwell. A raíz de las críticas de Loschmidt (paradoja de la reversibilidad) y Zermelo (paradoja de la recurrencia), Boltzmann acabó reconociendo el carácter estadístico de su hipótesis, y en 1877 propuso una relación entre la entropía S de un sistema de energía constante y el número de estados dinámicos W accesibles al sistema en su espacio de fases; esto es, la conocida ecuación S = kB ln W, donde kB es la constante de Boltzmann. En esta nota, se hace una breve descripción de la ecuación de Boltzmann y de la hipótesis del caos molecular.

El comportamiento de los gases siempre dio a los físicos en qué pensar

La ecuación de Boltzmann describe la evolución temporal de un gas diluido de N partículas puntuales de masa m contenidas en un volumen V que interaccionan a través de un potencial de par central repulsivo V(r) de corto alcance a. Como simplificación adicional, considérese que sobre las partículas no actúan campos externos. Si f1(r,v,t) indica la densidad de partículas que en el tiempo t tienen un vector de posición r y velocidad v, que está normalizada en forma:

∫dr ∫dvƒ1(r,v,t) = N

Su evolución temporal es la suma de dos contribuciones. En ausencia de interacción, las partículas que en el tiempo t tienen vector de posición r y velocidad v se encuentran, después de un intervalo de tiempo Δt, en r + v Δt y tiene la misma velocidad. Como

f1(r + vΔt,v,t + Δt) = f1(r,v,t)

en el límite Δt → 0 (2) se escribe:

∂1 f1(r,v,t) = – v∂r f1(r,v,t)

Que es una ecuación invariante bajo el cambio t → – t y v → – v. La evolución es, por tanto, mecánica.

Se cumplieron más de cien años desde la muerte de Boltzmann y su trabajo sigue siendo recordado. No pienso que Boltzmann creyera en la existencia real de los átomos, pero sí en su utilidad e incluso en su necesidad para comprender las leyes macroscópicas y la evolución irreversible de los fenómenos macroscópicos desde una base más fundamental que el nivel fenomenológico. Pero había quien (con autoridad) no creía ni en la existencia ni en su utilidad. Este debate no era ajeno a las tendencias ideológicas, religiosas y usos sociales de aquella época porque, en general, la ciencia es parte de la cultura y depende del momento histórico que viven los científicos, al fin y al cabo, seres humanos como los demás, influenciables por su entorno en una gran medida.

Por el siglo XIX, e incluso antes, ya se hablaba de “átomos”* y una rudimentaria teoría cinética de los gases gozaba de aceptación y utilidad científica (recordemos los trabajos de Benoulli, Dalton, Laplace, Poisson, Cauchy, Clausius, Krönig… y Maxwell). Pero fue Boltzmann quien definitivamente profundizó en la cuestión, para el estudio del equilibrio y, sobre todo, intentando explicar mecánicamente (mecano-estadísticamente) la evolución termodinámica irreversible y la descripción de los procesos de transporte ligados a ella. Y, nuevamente (por su enorme importancia) no podemos dejar de mencionar la muy singular labor que hicieron Gibbs, Einstein, Planck, Fermi y otros. Sin la motivación ideológica de Boltzmann, Gibbs elaboró una bellísima, útil y hoy dominante formulación (cuerpo de doctrina) de la termodinámica y física estadística.

Lorentz

Fue Lorentz quien primero utilizó la ecuación de Boltzmann y lo hizo para describir la corriente eléctrica en sólidos dando un paso significativo por encima del pionero Drude. Lorentz introdujo un modelo opuesto al browniano donde partículas ligeras como viento (electrones) se mueven chocando entre sí y con árboles gordos (tales como iones en una red cristalina); un modelo del que se han hecho estudios de interés tanto físico como matemático. Enskog (inspirándose en Hilbert) y Chapman (inspirándose en Maxwell) enseñaron cómo integrar la ecuación de Boltzmann, abriendo vías a otras diversas aplicaciones (hidrodinámica, propagación del sonido, difusión másica, calor, fricción viscosa, termoelectricidad, etc.). Recordemos que Boltzmann encontró como solución de equilibrio de su ecuación una distribución de velocidades antes descubierta por Maxwell (hoy, como reseñé anteriormente, de Maxwell-Boltzmann), por lo que concluyó que así daba base microscópica mecánica (teorema H mecano-estadístico) al segundo principio de la termodinámica (estrictamente, evolución de un sistema aislado hacia su “desorden” máximo).

El físico austríaco Ludwig Boltzmann sentó las bases estadísticas de la entropía, su trabajo fue tan importante que el gran físico Max Planck sugirió que su versión de la fórmula de Boltzmann fuera grabada en la lápida de Boltzmann de Viena.

Está claro que ningún físico que se precie de serlo puede visitar Viena sin visitar el parque Zentralfriedhof para ver la tumba de Boltzmann. Yo sí me pasé por allí. Me senté junto a la tumba; el lugar estaba desierto, y cerrando los ojos traté de conectar con la conciencia del genio. La sensación, extraña y agradable, seguramente fue creada por mi imaginación, pero creo que charlé con él en el interior de mi mente – la fuerza más potente del universo– y aquellos sentimientos, aquel momento, compensaron el esfuerzo del viaje.

En la tumba, sobre una gran lápida de mármol de color blanco con los nombres Ludwig Boltzmann y de los familiares enterrados con él, sobre el busto de Boltzmann, se puede leer la inscripción, a modo de epitafio:

En esta breve ecuación se encierra la conexión entre el micromundo y el macromundo, y por ella se reconoce a Boltzmann como el padre de la rama de la física conocida como mecánica estadística. Esta sencilla ecuación es la mayor aportación de Boltzmann y una de las ecuaciones más importantes de la física. El significado de las tres letras que aparecen (aparte la notación del logaritmo) es el siguiente:

- S es la entropía de un sistema.

- W es el número de microestados posibles de sus partículas elementales.

- k es una constante de proporcionalidad que hoy recibe el nombre de Constante de Boltzmann, de valor 1’3805 × 10-23 J/K (si el logaritmo se toma en la base natural).

En definitiva, la ecuación describe la estrecha relación entre la entropía (S) y las miles de formas de partículas que en un sistema se pueden arreglar (k log W). La última parte es difícil. K es la constante de Boltzmann y W es el número de elementos microscópicos de un sistema (por ejemplo, el impulso y la posición de los átomos individuales de gas) en un sistema macroscópico en un estado de equilibrio (por ejemplo, el gas de sellado en una botella). Parece que la naturaleza ama el caos cuando empuja a los sistemas hacia el desequilibrio y Boltzmann le llamó entropía a este fenómeno.

Cuando profundizamos un poco en lo que el cerebro humano ha sido capaz de generar, los pensamientpos que ha llegado a generar bien sea en forma de ecuaciones matemáticas o expresados con palabras, no podemos dejar de sorprendernos y maravillarnos al ver que, ¡todo el universo parece estar dentro de nuestras mentes! ¿Qué secretos se encierran allí? ¿Cómo nos lleva a estos pensamientos tan profundos?

Como todas las ecuaciones sencilla de gran trascendencia en la física (como la famosa E = mc2), hay un antes y un después de su formulación: sus consecuencias son de un calado tan profundo que cambiaron la forma de entender el mundo, y en particular, de hacer física a partir de ellas. De hecho, la sutileza de la ecuación es tal que hoy, cien años después de la muerte de su creador, se siguen investigando sus nada triviales consecuencias. Creo que lo mismo ocurrirá con α = 2πe2/ħc que, en tan reducido espacio y con tan pocos símbolos, encierra los misterios del electromagnetismo (el electrón), de la constante de Planck (la mecánica cuántica), y de la luz (la relatividad de Einstein), todo ello enterrado profundamente en las entrañas de un número: 137.

Bueno, a pesar de todo lo anterior, Schrödinger nos decía:

“La actitud científica ha de ser reconstruida, la ciencia ha de rehacerse de nuevo”

¡Lo grande y lo pequeño! ¡Son tantos los secretos de la Naturaleza!

Siempre hemos tenido consciencia de que en física, había que buscar nuevos paradigmas, nuevos caminos que nos llevaran más lejos. Es bien conocida la anécdota de que a finales del siglo XIX un destacado físico de la época William Thomson (1824-1907) conocido como Lord Kelvin, se atrevió a decir que solo dos pequeñas “nubecillas” arrojaban sombras sobre el majestuoso panorama de conocimiento que había construido la física clásica desde Galileo y Newton hasta ese momento: el resultado del experimento de Michelson-Morley, el cual había fallado en detectar la existencia del supuesto éter luminífero; y la radiación del cuerpo negro, i.e la incapacidad de la teoría electromagnética clásica de predecir la distribución de la energía radiante emitida a diferentes frecuencias emitidas por un radiador idealizado llamado cuerpo negro. Lo que Lord Kelvin no puedo predecir es que al tratar de disipar esas dos “nubecillas”, la física se vería irremediablemente arrastrada a una nueva física: la física moderna fundada sobre dos revoluciones en ciernes: la revolución relativista y la revolución cuántica con dos científicos como protagonistas: Planck y Albert Einstein. Sin embargo, ha pasado un siglo y seguimos con esas dos únicas guías para continuar el camino y, resultan insuficientes para llegar a la meta que… ¡Está tan lejos!

emilio silvera

Abr

20

Entrevista

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

David Gross, Premio Nobel de Física en 2004

“Las ondas gravitacionales han marcado un antes y un después”

David Gross, durante su visita a Madrid. SERGIO GONZÁLEZ VALERO

De alguna manera, David Gross (Washington D.C., 1941) cerró el puzzle del modelo sobre el que descansa la Física actual. Su hallazgo en 1973, junto con Franck Wilczek y David Politzer, de la interacción nuclear fuerte, la última de las cuatro fuerzas que dirigen el Universo (junto con la gravedad, el electromagnetismo y la interacción nuclear débil), le valió el Premio Nobel de Física en 2004. Pero Gross no se ha quedado anclado en el actual Modelo Estándar. Desde hace cerca de 40 años trabaja en el desarrollo de la Teoría de Cuerdas, una de las posibles candidatas a explicar de qué forma se dan la mano la gravedad y la mecánica cuántica. Acaba de visitar Madrid para pronunciar la conferencia El perdurable legado de Albert Einstein, organizada por la Real Sociedad Española de Física conjuntamente con la Fundación Ramón Areces.

¿Hasta qué punto es importante Einstein en nuestra vida diaria?

Depende de con quién estés hablando. Las ideas de Einstein son muy importantes para los científicos, así que en la vida de un científico tendrá una gran importancia. Si me preguntas cómo nos afectan sus descubrimientos en nuestro día a día, la Relatividad General hoy en día tiene una aplicación de la que la gente está muy orgullosa, y tiene que ver con los GPS. Tu reloj funciona de una forma diferente en la primera planta de un edificio que en la última de un rascacielos, donde irá un poco más lento. Esa desigualdad, que es muy pequeña, supone una gran diferencia para los GPS. Los relojes de los satélites anotan el tiempo de llegada de las ondas electromagnéticas que llegan desde tu iPhone y usan ese tiempo para medir distancias y hacerse una idea de dónde estás. Incluso diminutos cambios en cómo el tiempo se mueve en la curvatura del espacio-tiempo que Einstein describió en su teoría de la Relatividad General afectan a los cálculos. Cuando se inventó el GPS, ya se sabía que estas correcciones se tenían que tener en cuenta. Si no hubiera sido así, tu GPS no funcionaría bien y tu posición podría estar 50 o 100 metros más allá.

¿Las recién encontradas ondas gravitacionales son la última pieza del puzzle de Einstein?

No (se ríe), el puzzle de Einstein sólo acaba de empezar… Bueno, esta ha sido la observación directa de las ondas gravitacionales, porque ya habían sido observadas indirectamente antes e incluso ese trabajo fue galardonado con el Premio Nobel. Ha sido realmente la primera vez que hemos visto la onda y es un inmenso logro experimental.

¿Será el próximo premio Nobel de Física?

Desde luego ganará el Nobel, pero no será este año, porque el hallazgo fue muy tarde en la temporada… pero el próximo año, probablemente. Es increíble que se haya podido medir con esta precisión una distancia que es un millón de veces menor que el tamaño de un protón. A lo largo de la historia, ha habido muchas dudas acerca de las ondas gravitacionales. El propio Einstein llegó a pensar en algún momento que no debían existir.

¿Para qué servirán?

El principal uso de las ondas gravitacionales será en las próximas décadas para explorar objetos astronómicos. Entre ellos los agujeros negros, así que habrá un antes y un después. Es un nuevo fenómeno que es invisible a través de la luz. Ahora podremos estudiar agujeros negros. Hay un enorme futuro para la Astrofísica usando ondas gravitacionales. Einstein sólo abrió la puerta.

Es emocionante pensar que un solo hombre ideara esta colección de teorías que han resistido el paso ya de un siglo…

Es una historia extraordinaria. Einstein era un hombre singular en muchos aspectos, pero la Relatividad General es un caso especial. Si Einstein hubiera tenido un accidente pongamos en 1905, la teoría habría emergido en algún lugar 10 años después.

¿Y quién hubiera llegado a ella?

Cualquiera. Había muchos buenos físicos en esa época. Y el problema estaba claro. Einstein era un físico enorme y muy constante, y tuvo la intuición de mantenerse por el buen camino para hacer la teoría de Newton de la gravedad congruente con la Relatividad especial que Einstein propuso en 1905. Había una incoherencia en las formulaciones y tenía que ser explicada. Era un reto intelectual obvio sin resolver y mucha gente lo sabía igual que Einstein. Él sólo fue el más exitoso.

Los últimos grandes descubrimientos en Física han venido de la mano de grandes instalaciones experimentales internacionales… ¿Es el fin de la era de los grandes súper genios solitarios como Einstein?

Pero Einstein no era un físico aislado y solitario. No. Einstein vivió en el centro mundial de la Física, que en aquel momento era Berlín, rodeado por el mejor grupo de físicos del mundo con el que estaba en constante y permanente contacto. Obviamente no había las comunicaciones actuales por teléfono o email, pero él escribía cinco o seis cartas postales cada día. Se acaba de reunir en una obra toda su correspondencia y son como 50 volúmenes.

Quizá sea la nueva era de las grandes instalaciones internacionales como el CERN…

El CERN o el experimento LIGO que descubrió las ondas gravitacionales son instalaciones experimentales, que han cambiado de forma dramática. Pero la física teórica ha seguido el mismo camino que en tiempos de Einstein, con la diferencia de que la comunicación entre ellos se ha multiplicado por 100. Pero a principios de siglo no había científicos solitarios, estaban todos conectados. Había algunas estrellas brillantes en medio de toda una constelación de excelentes físicos.

Totales: 67.316.181

Totales: 67.316.181 Conectados: 40

Conectados: 40