Abr

18

Siempre aprendiendo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El saber: ¡Ese viaje interminable! ~

Clasificado en El saber: ¡Ese viaje interminable! ~

Comments (0)

Comments (0)

¡NO! Así no podemos avanzar, que nos dejen libres para pensar, para poder “ver”. La creatividad del pensamiento tiene que estar sólo supeditada al libre albedrío de cada cual. Así ha estado avanzando el mundo desde que…tenemos noticias de todas aquellas civilizaciones que fueron y que, expresaron sus para que nosotros, muchos años más tarde, las pudiéramos desarrollar. Sin aquellos conocimientos no serían posibles éstos.

Qué verdad es, nunca te acostarás sin algo nuevo. Aquí, en este mismo lugar, ocurre eso con frecuencia y, de vuestros comentarios he obtenido a veces conclusiones en las que, por mí mismo, no habría pensado. Como se suele decir, cuatro ojos ven más que dos.

Por ejemplo, en el trabajo que denominé ¿Qué haríamos sin la Física?, aparte de otras muchas intervenciones, me llamó la atención la de Fandila (14.2.1) en la que se refiere a la fotónica y la cuántica y llega a preguntarse si no debería llamarse “cuantónica”. Kike (14.2.1.1) que entabla el diálogo con él, lleva la conversación al del avance de la Ciencia a la que compara con la evolución de las especies. Ambos llevan su parte de razón.

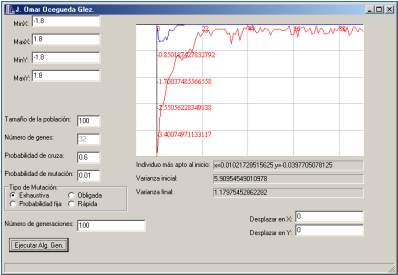

Muchos de los problemas que surgen en de la Física moderna han sido abordados mediante su modelado e implementación en ordenadores, donde hay aplicaciones que requieren una enorme capacidad de cálculo. Prácticamente en todas las disciplinas de la Física se requiere obtener soluciones a problemas que consisten en la optimización de funciones en un determinado espacio de búsqueda. En otras palabras, muchas aplicaciones en Física consisten en solucionar problemas de optimización, que en numerosas ocasiones no se pueden abordar con herramientas matemáticas clásicas, debido a la complejidad del espacio de búsqueda, o de la función objetivo, o ambas cosas a la vez.

Algoritmos genéticos

para la optimización de funciones no tan sencillas.

Nos dice el Autor del programa: “En este programa incluí algunas mejoras para “optimización de funciones sencillas”, la función que viene implementada está dada por: f(x,y)=x^2+2*y^2-0.3*cos(3*PI*x)-0.4*cos(4*PI*y)+0.7

Este hecho fue constatado prácticamente desde el advenimiento de los ordenadores como herramienta fundamental en la ciencia moderna. Así, ya en los años 60 surgieron diversas herramientas para solucionar problemas de optimización no abordables con técnicas clásicas, entre ellas algoritmos que imitiban comportamientos de la naturaleza. Específicamente, se comprobó que el paradigma de la selección natural y supervivencia del más fuerte (pieza clave de las teorías Darwinianas sobre la evolución de las especies) podía ser fácilmente reproducible en un ordenador, y aplicable a la resolución de estos problemas de optimización difíciles.

Siempre hemos sabido soluciones

Está claro que, ante la adversidad, la mente humana siempre se ha crecido y, en este caso de la computación no podía ser de otra manera, así que, cuando se llegó a un nivel de imposible resolución por los métodos clásicos, surgió la necesidad de un nuevo paradigma de computación, que proddujo la generación de algoritmos capaces de obtener soluciones de buena calidad en estos casos de optimización difíciles. Diversos investigadores se concentraron en la imitación de sistemas naturales para resolver estos problemas, generando los diversos algoritmos que forman parte de la computación evolutiva.

Pongamos un ejemplo:

Hallá por el mes de febrero de 2009, pude asistir a un Seminario que tuvo lugar en la Universidad III donde mi hijo Isat Estudiaba Derecho ADE, y con el Título de Computación Evolutiva y Algoritmos basados en las hormigas para la inteligencia artificial, pude disfrutar de un tiempo mágico que me transportó al futuro. La reseña que salió fue la siguiente:

“La Inteligencia Artificial (IA) vive una segunda juventud, según lo visto en el Seminario Internacional sobre el tema celebrado en la Universisdad Carlos III de Madris, donde han presentado nuevas técnicas de computación evolutiva, algoritmos basados en hormigas para, el manejo de robots, o, posibles de la IA a la economía, los juegos, y la fusión de datos.

El campo de la Inteligencia Artificial ha cambiado mucho desde los años setenta, cuando se aspiraba a encontrar el “solucionador general de problemas”, un algoritmo, programa o sistema que permitiera resolver de formar autónoma cualquier problema. “A día de hoy se piensa que no existe y que lo que tenemos es un conjunto de algoritmos y sistemas que en su conjunto denominamos técnicas de Inteligencia Artificial”, explica el José Manuel Molina, organizador del Segundo Seminario Internacional sobre Nuevas Cuestiones en Inteligencia Artificial promovido por los cuatro grupos de Inteligencia Artificial del departamento de Informática, celebrado del 2 al 6 de febrero en la Universidad Carlos III de Madrid (UC3M).

Entre Darwin y hormigas inteligentes

Son mucho más inteligentes de lo que creemos, juzgar por el tamaño… no sería aconsejable.

Allí han presentado sus trabajos algunos expertos internacionales en la materia, que cada vez encuentra relaciones y aplicaciones más sorprendentes. La Teoría de la Evolución de Charles Darwin, por ejemplo, podría aplicarse a la resolución de problemas con ordenadores. En eso trabaja el investigador del Centro de Investigación y de Estudios Avanzados del Instituto Politécnico Nacional (Méjico), Carlos Coello, un especialista en técnicas de optimización multiobjetivo de procesos complejos en ingeniería mediante técnicas genéticas. Otro invitado al seminario, Silvano Cincotti, de la Universidad de Genova (Italia) explicó cómo se pueden estas técnicas a la economía actual y fundamentalmente cómo modelar la realidad utilizando agentes inteligentes.

¿Computación Evolutiva? Hasta dónde llegaremos?

La presencia de la naturaleza en la Inteligencia Artificial no acaba en la denominada computación evolutiva. Otro científico de la Universidad Libre de Bruselas (Bélgica) que impartió un seminario en esta reunión, Dorigo, presentó el algoritmo de optimización basado en colonias de hormigas que inventó, que consiste en una técnica probabilística para resolver determinados problemas de computación. Este algoritmo, que puede utilizarse para manejar pequeños grupos de robots, forma parte de la ” Swarm Intelligence ” (inteligencia basada en enjambres), famosa a raíz del Presa del recientemente fallecido Michael Crichton. Esta especialidad busca el desarrollo de comportamientos complejos a partir de la interacción de un conjunto de agentes que tienen unas reglas de actuación muy sencillas. La unión hace la fuerza.

La conclusión más importante que se ha podido extraer del seminario celebrado en la UC3M es que la Inteligencia Artificial es un área que no tiene un único objetivo, si no que ha incorporado muchas técnicas diferentes para conseguir dotar de cierta inteligencia algunas soluciones. “La técnica es una función del problema y así hay técnicas para que las máquinas puedan de la experiencia, que identifiquen a las personas, que interpreten el entorno, que razonen las acciones más prometed oras, etc”, explica Molina, que dirige el grupo de investigación de Inteligencia Artificial Aplicada de la UC3M. El mayor reto, explica, es que las máquinas sean capaces de realizar tareas que no estén preprogramadas, para que puedan elaborar una estrategia que va más allá de lo pensado en un principio.

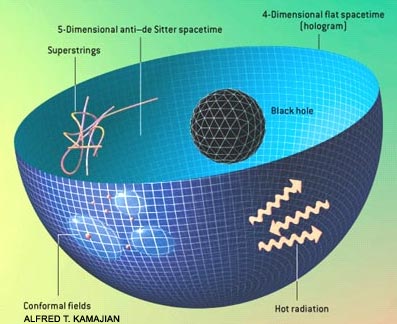

La , aunque no refleje la realidad exacta…, se acerca bastante

Está claro que, pretendemos imitar la naturaleza y , la Inteligencia Artificial evolucione como lo hicimos nosotros mismos, y, si eso se consigue…¿Qué podrá pasar en el futuro?

El mayor problema al que se enfrentan los científicos en este área es la necesidad de sistematizar toda la investigación que se está llevando a cabo en Inteligencia Artificial en todo el mundo para poder unificar las diferentes técnicas que se desarrollan. “La idea es una integración y sinergias que permitan ver ese conjunto de técnicas como un todo”, explica el profesor Molina, aunque aclara que la percepción que se tiene sobre este tema a nivel social es bastante diferente porque se espera mucho de la IA, tal vez por lo que se ve en las películas de ciencia ficción. “La gente ya espera ver a R2D2 por la calle y todavía queda mucho para eso”, concluye.”

Tendremos que esperar un poco

A partir de todo esto quise profundizar un poco en el y, me leí múltiples trabajos de autores especializados que me posibilitaron tener una idea más clara y profunda de hasta donde podemos llegar en el futuro que, de seguir por el camino emprendido, pocos límites tendrá eso que llaman la Inteligencia artificial Evolutiva.

Por otra parte, desde hace algunos años, existe la convicción de que buena parte del desarrollo tecnológico del futuro dependerá de nuestra capacidad para fabricar dispositivos con un tamaño comprendido entre el de los átomos (< 1 nm) y el de los dispositivos actuales (≈ 100 nm). Con estas dimensiones la materia presenta comportamientos peculiares, en muchos casos de origen cuántico, que no resultan de una extrapolación de sus propiedades macroscópicas (mecánicas, electrónicas, magnéticas, químicas y ópticas) y que, por ello, son a menudo sorprendentes.

Modelo de la estructura molecular de un ribosoma

Estas dimensiones corresponden al territorio límite entre la química molecular y supremolecular y la física del estado sólido para unas pocas celdas unidad. El estudio de la materia a escala nanométrica y su utilización para la fabricación de componentes y dispositivos con prestaciones avanzadas y novedosas reciben el nombre respectivamente de nanociencia y nanotecnología.

Nano alude a la nanómetro, una unidad de longitud que equivale a la millonésima parte de un milímetro. Por ende, entonces, este prefijo indica el estudio de las diversas disciplinas a nivel atómico y molecular. Pero… ¿cuántos átomos equivalen a un nanómetro? Tan solo entre tres y cinco.

En este sentido, estamos en de comenzar a distinguir algunos de los conceptos que enumeramos anteriormente. Por un lado, la nanociencia se encarga del estudio de las propiedades y los fenómenos a escala nanométrica. La nanotecnología, por su parte, sería la encargada de la manipulación y producción de materiales, estructuras y sistemas a tal escala. Sin embargo, el límite entre nanociencia y nanotecnología resulta cada vez menos tangible. En simples palabras, se puede decir que la nanotecnología utiliza el conocimiento científico prop orcionado por la nanociencia para la manipulación y producción de diversos materiales (por medio de complejas tecnologías). Por esta razón, es posible la utilización de tales conceptos de forma equivalente (aunque no por eso sea correcta).

orcionado por la nanociencia para la manipulación y producción de diversos materiales (por medio de complejas tecnologías). Por esta razón, es posible la utilización de tales conceptos de forma equivalente (aunque no por eso sea correcta).

Es por esto que muchos de los avances que hoy se encuadran bajo el nombre de “nanotecnología” no son más que nanociencia, porque sientan las bases para el futuro desarrollo de una tecnología que permita la manipulación de átomos y moléculas. Sin embargo, sería incorrecto decir que en la actualidad no hay ningún desarrollo nanotecnológico (aunque sí se puede afirmar que sus aplicaciones son reducidas, teniendo en cuenta lo mucho que se espera de las mismas), porque entre ellos se pueden mencionar el térmico (desarrollado en 2004 por Aspen Aeogels), los colchones que repelen sudor y polvo, los cosméticos personales ajustados a edad, raza, sexo, tipo de piel y actividad física, y los vestidos que impiden las infecciones en heridos y quemados, entre algunos otros.

Curiosamente, existe una creencia arraigada en amplios sectores de la comunidad cinetífica de que la Fotónica (conjuntos de tecnologías relacionadas con la Luz) es un campo que cae fuera del universo de la nanotecnología. La creencia se apoya en el clásico criterio de Rayleigh de que la resolución espacial de un óptico está limitada por la olongitud de onda de luz (≈ 500 nm) y por ello es próxima al micrómetro, muy lejos de los requisitos de la nanotecnología. Esta visión es sin duda errónea y hoy en día la fotónica está íntimamente implicada con la nanotecnología e incluso se puede hablar propiamente de nanofotónica, de un modo similar a como se habla de nonoelectrónica o nanomagnetismo.

Como antecedente de esta sinergia recordemos que la espectroscópica óptica constituyó una herramienta fundamental en el descubriomiento de la estructura atómica de la materia y de la física cuántica. Desde una perspectiva más aplicada y espectacular cabe mencionar la utilización de nanopartículas metálicas para colorear el vidrio en tiempos de los romanos (como la famosa vasija de Ligurco del siglo IV) Esta técnica se volvió a recuperar a finales de la Edad Media y se , por ejemplo, para colorear las vidrieras de las Catedrales.

La invisibilidad ya es un hecho del pasado que no pertence unicamente a la ficción con la realización de materiales en tres dimensiones que permiten hacer desaparecer objetos y no precisamente es magia, sino que son capaces de desviar la luz visible. Se han realizado experimentos con nano objetos es decir con 1 millonesima de milímetro, y segun los resultados, nada impide el mismo principio para hacer invisible a una persona, un tanque o un incluso un petrolero. Estos metamateriales (Que desvian la luz) deben inclinar la luz alrededor del objeto, de manera que lo envuelva y después recupere su forma original. El observador ya no ve la perturbación en la luz y de esta manera el objeto desaparece a a su vista. Aunque una de las más inmediatas de estos metamateriales podría ser la construcción de lentillas especiales que permitan ver hasta un virus o las moléculas del ADN, lo que excita más la imaginación tiene que ver con la invisibilidad descrita por autores como H.G. Wells “El hombre invisible”.

Se ha construído el microscopio electrónico más potente del mundo mediante la captación de las ondas evanescentes de luz con bolas de vidrio que es la base de esa tecnología. El uso de la luz visible, para observar los objetos de ese diminuto tamaño, rompe en cierto modo las reglas lumínicas, donde existe una propiedad física llamada límite de difracción que establece lo más pequeño que el ojo puede captar. Las ondas de luz se expanden hacia fuera de forma natural e inevitable por lo que limitan el en que pueden ser enfocadas, y por ende, el tamaño del objeto que pueden reflejar.

Los métodos de campo cercano permiten examinar y resolver patrones de iluminación de dimensiones nanométricas con técnicas ópticas. Esto es posible con la utilización de las ondas evanescentes en la vecindad del patrón. A larga distancia (región de Franhoufer) estas ondas desaparecen y peredemos información clave del objeto, la asociada a las componentes periodicas de alta frecuencia espacial o pequeño período. Naturalmente que para introducirse en la zona de ondas evanescentes y detectarlas se hace preciso a las técnicas de micro y nano-mecánica de forma que podamos físicamente a ellas.

¿Qúe no podremos hacer cuando conozcamos la naturaleza real del átomo y de la luz? El fotón, ese cuánto de luz que parece tan insignificante, nos tiene que dar muchas satisfacciones y, en él, están escondidos secretos que, cuando sean revelados, cambiará el mundo.

Concretamente, la microscópica óptica de barrido de cuerpo cercano, se ha desarrollado utulizando diferentes configuraciones para obetener con una resolución espacial de unas decenas de nanómetros. La tecnología necesaria para el posicionamiento a escala nanométrica estaba ya disponible desde la invención del microscopio electrónico de barrido por efecto túnel.

Lo primero que hay que mencionar es que hablamos de poder manipular los átomos y las moléculas de forma individual, colocándolos en posiciones concretas y fabricando elementos o engranajes. Por ejemplo, la empresa Nanorex vende sistemas de diseño para esta tecnología, pudiendo apreciarse en las distintos engranajes diseñados con moléculas

Esta manipulación se ha podido realizar gracias al descubrimiento y uso del microscopio electrónico de efecto túnel. Lo que nos lleva a la realidad de que, la Física es la que hace avanzar la técnica y la tecnología, así como también es la “” del descubrimiento de nuesvos materiales y técnicas que nos llevan de manera directa hacia el futuro.

La luz ejerce una cierta fuerza sobre la materia, que es insignificante para objetos macroscópicos, pero es si hablamos de nanopartículas. Por ello, con las técnicas ópticas, no solamente somos capaces de observar objetos de tamaño nanométrico o inferiores, sino que además podemos desplazarlos, manipularlos y atraparlos.

Micrografía (50X) con microscopía electrónica de barrido (SEM) de las capas de la piel con una grándula en el centro…

Las fuerzas electromagnéticas son mismo capaces de frenar o enfriar átomos así como de atraparlos. En el caso del enfriamiento se utiliza la fuerza de scattering causada por un haz láser que se propaga en dirección opuesta al movimiento del átomo. El momento lineal del fotón es transferido íntegramente al átomo. Para que la fuerza sea significativa el láser se sincroniza a una frecuencia próxima (y ligeramente inferior para compesnar el corrimiento debido al efecto ) a la resonancia de una transición atómica con el fin de incrementar significativamente la sección eficaz de absorción. Como la posterior reemisión del fotón es isótropa no se pierde el momento lineal atómico ganado en el proceso de absorción.

Microfotografías del microscopio electrónico de barrido de la membrana nuclear. Oservénse los complejos proteicos que forman los poros nucleares. Esta maravilla que nos lleva a saber y comprender más sobre la naturaleza de las cosas, hubiera sido imposible sin la utilización de la luz.

El tema en el que hemos desembocado nos podría llevar horas y días hablando de la Manipulación óptica de átomos, moléculas y nanopartículas, de las propiedades ópticas de losnanomateriales, de los efectos del confinamiento cuántico, de los diodos luminiscentes y láseres, de la realidad de la fotónica que hace posible la espectroscopía de moléculas individuales e interviene en mil maravillas que, la gente corriente ni puede imaginar y que será, sin duda alguna (junto a otras técnicas nuevas) lo que nos llevará al futura de la informática y de la Inteligencia Artificial, a la que por cierto, habrá que vigialar de cerca.

¡¡ Cuidado!!

La Inteligencia Artificial ha despertado un gran interés por sus diversas en nuestro mundo cotidiano, facilitándonos y automatizando las tareas intelectuales, siendo potencialmente útil en cualquier ámbito de la actividad intelectual humana. También, dentro de esta área de trabajo que es la Inteligencia Artificial, encontramos las redes neuronales, que tienen la capacidad de “” mediante complejos ajustes en las relaciones que existen entre los nodos o , permitiendo reconocer y clasificar formas o patrones. Por otro lado, están los algoritmos genéticos, que se basan en la tan reconocida teoría de la Evolución Genética, y en la idea de la supervivencia del más apto, reduciendo aun más la posibilidad del error, como decíamos al principio.

Aunque sumergido en todas estas complejidades que, pareciendo del futuro son de hoy, me pasó el tiempo volando y, con la intención de llevar a todos ustedes algunas de las cosas quen están actualmente en frenética efervescencia en laboratorios de todo el mundo, para así, poder comentar sobre lo que nos parece y, hasta donde nos llevará todo esto que, siendo bueno en un principio, podría desembocar en un escenario no deseado si, por nuestra ambición de sin tasa, damos más prerrogativas de las que serían racionales, a seres artificiales que podrían, con el tiempo, convertirse en nuestros dueños.

emilio silvera

Totales: 77.896.324

Totales: 77.896.324 Conectados: 22

Conectados: 22