Mar

29

Nanofotónica: luz + nanopartículas = Futuro tecnológico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Hacia el futuro ~

Clasificado en Hacia el futuro ~

Comments (1)

Comments (1)

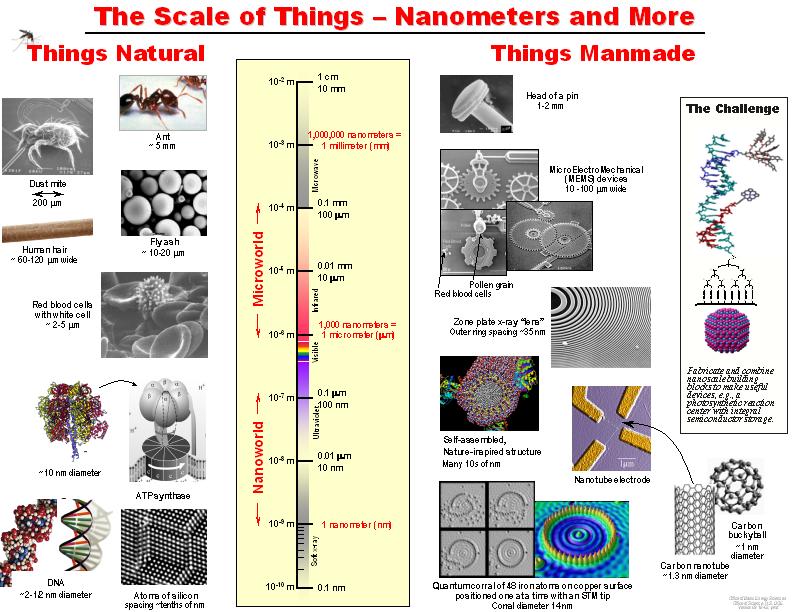

Han pasado ya cincuenta años desde que Richard Feynman dictara su famosa charla: There is plenty of room at the bottom: An invitation to enter a new field of physics (Hay suficiente espacio en el fondo: Una invitación a entrar en un campo en la Física). En ella estableció que las leyes de la Física no impiden manipular las cosas átomo a átomo; –es algo que se pero no se ha hecho debido a que somos demasiado grandes hacerlo-.

Desde entonces se ha estado buscando la manera de poder diseñar los materiales átomo a átomo. De hecho, los materiales nanoestructurados ya han sido utilizados en aplicaciones prácticas, siendo importantes en nuestra vida diaria. El color rojo de los vitrales en las catedrales góticas de Europa se obtenía utilizando nanopartículas de oro; la película fotográfica utiliza nanopartículas de plata; los bloqueadores solares utilizan nanopartículas de dióxido de titanio y de zinc como parte activa. El primer caso es una aplicación del efecto nano del oro y es quizás la primera aplicación de la nanotecnología. Quizás el mayor desarrollo de las nanoestructuras se dio con el descubrimiento de la microscopia de fuerza atómica ya que con esta se podía manipular a los átomos o partículas muy pequeñas. Hoy día, la investigación en el campo de los materiales nanoestructurados se ha multiplicado y sus aplicaciones abarcan todas las disciplinas convirtiendo a la nanotecnología en un campo interdisciplinario. Muchos países han implementado programas especiales para la investigación en este campo invirtiendo grandes cantidades de dinero. La apuesta puede ser de alto riesgo, pero el premio promete ser enorme.

Richard Feynman

Hoy día se estima el mercado de la nanotecnología en cientos de miles de millones de dólares. Nuestro país también ha apoyado la iniciativa aunque en menor proporción. De hecho la nanotecnología no es una prioridad dentro de nuestro sistema de investigación, no hay programas especiales de apoyo económico en este tópico y se compite por igual con todas las áreas. Con pocos recursos económicos se tiene poca infraestructura y en general grupos pequeños lo que dificulta la capacidad para competir. Aún con estas limitaciones, se han obtenido excelentes resultados y hay grupos en nuestro país que cuentan con reconocimiento internacional.

Materiales nanoestructurados y nanotecnología

Los materiales nanoestructurados (NEMs, por siglas en inglés) han despertado rápidamente un gran interés debido a la diversidad de sus aplicaciones. De acuerdo a la definición más aceptada, los materiales nanoestructurados son aquellos en los que por lo una de sus dimensiones se encuentra en el rango de 1-100 nm. Es decir, los NEMs son tres órdenes de magnitud más pequeños que los MEMS (sistemas microelectromecánicos, por sus siglas en inglés), e incluyen nanopartículas, nanocristales, nanoalambres, nanobarras, nanotubos, nanofibras, nanoespumas, etc. Los NEMs pueden ser semiconductores, dieléctricos, metales, orgánicos, inorgánicos, aleaciones, biomateriales, biomoléculas, oligómeros, polímeros, etc.

Nos sorprendería saber en qué lugares están presentes los cristales fotónicos con las nuevas técnicas alcanzadas en la nanotecnología

Aunque existen sistemas nanoestructurados de dimensiones mayores son los cristales fotónicos. En el rango de nanómetros, los materiales presentan propiedades ópticas, eléctricas, magnéticas y mecánicas únicas y totalmente diferentes de los materiales en el rango de los micrómetros o milímetros llamados también materiales en bulto.

tener una idea de que tan pequeño es un nanómetro podemos mencionar que un milímetro tiene un millón de nanómetros; el diámetro del cabello humano mide 10,000 y 50,000 nanómetros; los glóbulos rojos y blancos miden entre 2 y 5 nanómetros mientras que el ADN mide 2.5 nanómetros.

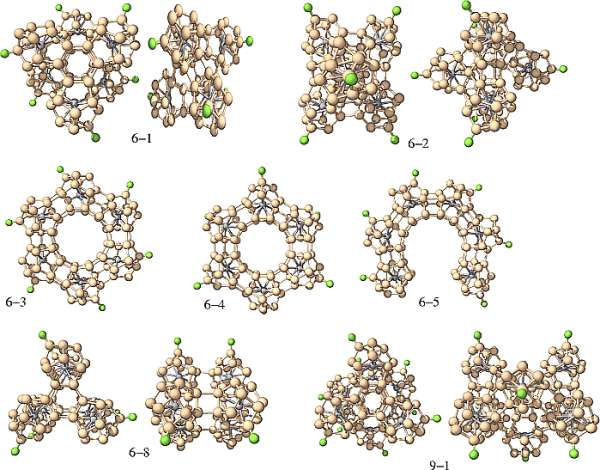

Los superátomos de silicio pueden formar, por ejemplo, nanotubos. Además, se les agregar un metal de transición con el objetivo de cambiar sus propiedades eléctricas, lo que se denomina dopaje. Cuando el superátomo es de anión (tiene carga eléctrica negativa, le sobran electrones), “se le dopa con un metal alcalino, como el potasio”, que tiene un electrón en su nivel energético más externo. Del mismo modo, cuando son cationes (con carga negativa, al perder electrones) se les dopa con un metal halógeno, que necesita un electrón más completar su último nivel energético.

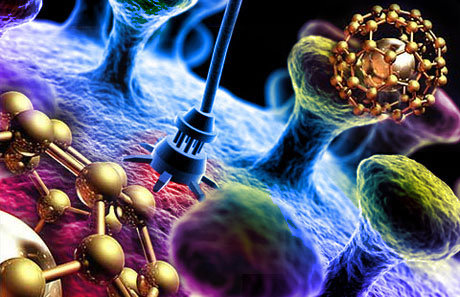

Las propiedades de los NEMs son dominadas por los efectos de superficie mientras que las de los materiales en bulto son debidas a un efecto de volumen. La tecnología su producción y uso se ha convirtiendo en una industria muy poderosa: la nanotecnología. La nanotecnología es la ciencia e ingeniería de producir materiales o estructuras funcionales de unos cuantos nanómetros. Es la tecnología del futuro con la cual se desarrollarán los nuevos materiales y dispositivos. Las aplicaciones son sorprendentes así como variadas, por ejemplo, la industria optoelectrónica y fotónica, biomedicina, sensores, celdas solares y de combustible, catálisis, memorias ópticas, procesadores de computadoras, fotodetectores, herramientas de corte, industria aeronáutica, moduladores e interruptores, cosméticos, etc. Aunque todas las aplicaciones son de gran interés, sin duda alguna las aplicaciones en sistemas biológicos son las más sobresalientes. Especialmente las aplicaciones de las propiedades ópticas de los sistemas nanoestructurados.

La Tecnología fundamental del siglo XXI: Nano Tecnología

Uno de sus apartados es la Nanofotónica

Esas nuevas formas, la nanotecnología, entrará en el “universo” de la mecánica cuántica, en el mundo infinitesimal, y, se lograrán cosas que , serían impensables. Posiblemente, la primera visita que hagamos a un mundo habitado por otros seres, estará tripulada por seres nanotecnológicos que, al igual que la misma nave, tengan medidas tan pequeñas que serán imposibles de observar y, sin embargo, estarán dotadas de adelantos tales que, podrán medir, evaluar, estudiar, captar imágenes, enviar por medios desconocidos, y, en fin, serán las avanzadillas de lo que irá después, la visita de humanos a otros mundos.

La nanofotónica es la fusión de la nanotecnología y la fotónica. Es un campo multidisciplinario que estudia las propiedades ópticas de los sistemas nanoestructurados y la interacción luzmateria a nivel nanoscópico. Ya mencionamos que las propiedades ópticas de las nanopartículas son dominadas por los efectos de superficie. Así, controlando el tamaño de las nanopartículas o nanoestructuras podemos controlar o amplificar ciertas propiedades de los sistemas bajo estudio. En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas.

La Nanotecnología marcará nuestro futuro. De ella partirán las nuevas ideas e instrumentos, los nuevos modos de construir lo que queda por venir, nuevas maneras de sondear el espacio “infinito”, de curar enfermedades, de sustituir órganos vitales, de construir robots.

Curiosamente, existe una creencia bastante arraigada en amplios sectores de la comunidad científica de que la fotónica (conjunto de tecnologías relacionadas con la luz) es un campo que cae fuera del universo de la nanotecnología. La creencia se apoya en el clásico criterio de Rayleigh de que la resolución espacial de un sistema óptico está limitada por la longitud de onda de la luz (≈ 500 nm), y por ello es próxima al micrómetro, muy lejos de los requisitos de la nanotecnología.

Yo, por mi , estimo que división es sin duda errónea, y hoy en día la fotónica está íntimamente implicada con la nanotecnología, e incluso se hablar propiamente de nanofotónica, de igual manera que se hablar de nanoelectrónica o de nanomagnetismo.

sepamos conectar de manera conveniente todas las disciplinas del sabe Humano… ¡Las cosas cambiaran!

Decía que: “En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas”. una de ellas produce fenómenos de especial interés interactúan con una señal óptica, pudiendo así ser aplicadas en diferentes campos. Un campo de especial interés es la biología.

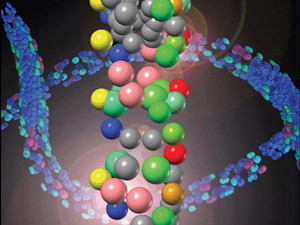

El estudio de las propiedades luminiscentes de sistemas nanoestructurados en sistemas biológicos es el campo de estudio de la bionanofotónica. Especialmente trata sobre el estudio de sistemas nanoestructurados en aplicaciones biomédicas. Diferentes nanopartículas han sido propuestas para ser utilizadas en la detección de bajas concentraciones de diferentes elementos como células cancerigenas, virus, ADN, ARN, proteínas, etc. También han sido utilizadas para la entrega de medicamentos en dirigida y controlada así como para la destrucción de tumores cancerigenos. En la última década, los avances han sido sorprendentes pero aún hay mucho por hacer. En el CIO, durante los últimos 6 años hemos trabajando en la síntesis de nanopartículas y estudiado sus propiedades ópticas a fin de poder ser utilizadas en distintas aplicaciones.

Las propiedades luminescentes de nuestras nanopartículas son muy interesantes y prometen grandes oportunidades de aplicación en diferentes áreas.

Nanopartículas semiconductoras o puntos cuánticos

Los nanocristales semiconductores también llamados puntos cuánticos son nanoestructuras a base de materiales semiconductores inorgánicos y representan el grupo donde el efecto del tamaño es más evidente. El tamaño nano da lugar a lo que se conoce confinamiento cuántico, que no es más que la localización de los electrones en un espacio bien definido, es poner un electrón en una caja. Mientras que tamaños mayores los electrones están no localizados. El confinamiento produce un ensanchamiento de la banda de energía prohibida del semiconductor así la aparición de sub-bandas discretas en la banda de valencia y de conducción. Las dimensiones típicas oscilan uno y diez nanómetros.

Con frecuencia se les describe como átomos artificiales debido a que los electrones están dimensionalmente confinados como en un átomo y sólo se tiene niveles de energía discretos. las nanoestructuras más estudiadas se encuentran las de CdSe/ZnS, CdSe/CdS, InP/ZnSe, CdTe/CdSe, entre otras. El resultado más vistoso de estas nanoestructuras es la capacidad poder sintonizar la longitud de onda o color de la emisión.

Así, con un solo material y variando el tamaño de la nanopartícula es posible obtener múltiples colores o longitudes de onda de la señal emitida. Las aplicaciones son impresionantes y apuntan en todas las direcciones. Por ejemplo, podrían ser utilizados como colorantes inorgánicos sin problemas de degradación a diferencia de los colorantes orgánicos. También podrían ser utilizados en el diseño de los nuevos amplificadores ópticos de amplio ancho de banda tan importantes en los sistemas de comunicación óptica; en este caso nanopartícula con un diámetro determinado funcionaría como un amplificador, así el ancho de banda se determina con la selección adecuada de los diámetros de las partículas. O bien la producción de fuentes de luz blanca mediante excitación con un LED u OLED o por electroluminiscencia.

Quizás una de las aplicaciones que mayor atención ha recibido es en su uso como etiquetas fluorescentes con emisión en la región visible del espectro, para la detección de una gran variedad de compuestos entre ellas células cancerigenas. Las técnicas actuales no detectan bajas concentraciones de células cancerigenas o compuestos de interés, por lo que la técnica de detección de fluorescencia de nanopartículas es una gran promesa para la detección temprana de este mal, para así incrementar el éxito en el tratamiento. Dado el tamaño tan pequeño de los puntos cuánticos actualmente se intenta desarrollar nanoestructuras más complejas formadas por puntos cuánticos o nanocristales acomplejados con diferentes componentes que desempeñan distintas funciones, detección, entrega de medicamento dirigido, efecto de la terapia, etc. Es decir, se busca una nanoestructura inteligente con múltiples funciones. El problema que presentan los puntos cuánticos es que son poco estables ya que tienden a aglomerarse, además de que se excitan con una fuente de luz UV donde la mayoría de los compuestos que se pueden encontrar en interior del cuerpo humano emiten luz lo que significa pérdida de contraste en la imagen de la célula deseada.

Nanopartículas dieléctricas o nanocristales

Los nanocristales dieléctricos son óxidos que presentan una banda de energía prohibida muy ancha y como consecuencia requieren altas energías de bombeo o luz en el UV obtener emisión que en general es débil, aunque cuando se combina en adecuadacon diversos componentes son excelentes emisores de luz debido a su eficiencia y alta estabilidad. Son excelentes matrices soportar iones de tierras raras que son muy buenos emisores de luz. En este caso no se observan efectos de confinamiento debido a que los electrones se encuentran localizados en orbitales atómicos del ion activo. Sin embargo, la dinámica de los iones emisores de luz se ve afectada por la interacción a nivel nanoscópico lo que producir una mejora en la eficiencia de emisión.

los nanocristales mas estudiados se encuentran algunos silicatos como Y2SiO5, la combinación nY2O3 + mAl2O3 que comprende puramente el óxido de itria, puramente el óxido de aluminio, cuando se combinan con n=3 y m=5 da lugar a la estructura cristalina mas utilizada en óptica producir láseres conocida como YAG, o YAP la combinación n=m=1 que corresponde a uno de los cristales mas sensibles a laradiación ionizante y que es utilizado para la detección de rayos X o rayos gama. El óxido de titanio (TiO2) y el óxido de zinc (ZnO) que se utilizan en los bloqueadores solares además de ser excelentes para los procesos de fotocatálisis, útiles en la reducción de contaminantes, para celdas solares y como bactericida.

Recientemente, hemos demostrado que el óxido de zirconio (ZrO2) combinado con otros elementos bloquea el rango completo de la luz ultravioleta, especialmente aquella región que produce el . Este mismo nanocristal presenta excelente respuesta en la detección de radiación ionizante, UV, rayos X, gama, beta y alfa, tanto en tiempo real como en acumulada lo que sugiere buenas oportunidades para su uso en el diseño de dosímetros para la cuantificación de dosis recibidas.

Además, es excelente soporte para iones de tierras raras, con las cuales hemos obtenido luz visible (azul, verde y rojo) excitando con una fuente en el cercano infrarrojo. Ya que con fuente solo se excitan los nanocristales no hay emisión de fondo lo que mejora el contraste de las imágenes obtenidas. Estas características convierten a estos nanocristales en excelentes candidatos en aplicaciones biomédicas para la detección de diversos elementos a concentraciones bajas. La fabricación de estos nanocristales implica un tratamiento térmico para el proceso de oxidación lo que induce un tamaño de partícula grande. Se han reportado tamaños de partícula 10 a 90 nm.

Lo curioso es que en todo, siempre está la Luz presente

Muchas veces se obtienen cristales muy pequeños pero con poca eficiencia de emisión, el reto es obtener mayor eficiencia de emisión sin incrementar demasiado el diámetro de las nanopartículas. Tamaños promedios con los que se han obtenido excelente eficiencia de emisión son 40 y 60 nm.

Nano partículas metálicas, plasmones.

Las nanopartículas metálicas tienen la habilidad de esparcir y absorber la luz incidente. En caso, los efectos en las propiedades ópticas respecto a su contraparte en bulto se derivan de los efectos electrodinámicos y de la modificación del ambiente dieléctrico. A escala nanométrica la frontera metaldieléctrico produce cambios considerables en las propiedades ópticas.

resultado de la interacción la nanopartícula metálica y la señal óptica se obtiene la oscilación colectiva de electrones de superficie lo que genera bandas de resonancia conocidas como plasmones localizados o plasmones de superficie localizados. La longitud de onda o color a la que se obtiene dicha resonancia se le conoce como banda de absorción del plasmón que depende tanto del tamaño como de la de la nanopartícula y es lo que da lugar a la diferente coloración observada. Las nanoestructuras metálicas más conocidas son partículas esféricas, barras y películas con núcleo dieléctrico. Aunque más recientemente se han reportado otras estructuras como cubos, triángulos, estrellas y ovoides. En todos los casos, la banda de resonancia se recorre hacia el cercano infrarrojo en comparación con las nanopartículas esféricas cuya banda centrada en la región verde del espectro.

Los plasmones producen en la interfase un campo eléctrico intensificado que a su vez intensifica varios procesos ópticos lineales y no lineales. El campo eléctrico producido es utilizado como una interfase sensible a las interacciones ópticas y se convierte en una poderosa herramienta el monitoreo óptico y para la formación de imágenes ópticas

localizadas. Una de las aplicaciones establecidas es de superficie mejorada (SERS por sus siglas en inglés). En este caso el espectro Raman de un componente cercano a la superficie metálica se ve fuertemente amplificado. Se ha demostrado que es posible amplificar el campo 11 000 veces más cuando las partículas presentan cierta aglomeración. Otros fenómenos que presentan amplificación son la espectroscopia infrarroja de superficie mejorada, espectroscopia de fluorescencia

y la espectroscopia de resonancia de plasmones de superficie. Todas estas técnicas son complementarias y son utilizadas en la detección de componentes químicos y bioquímicos a nivel de trazas.

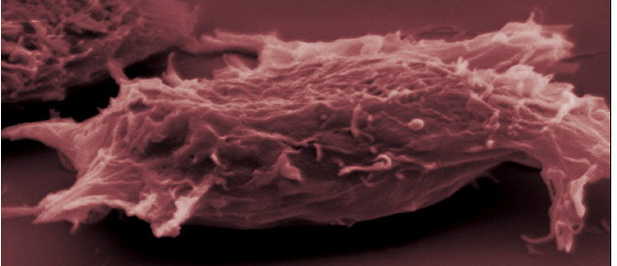

Células modificadas y célula cancerigena que la nanofotónica podrá modificar e incluso regenerar en el fiuturo.

Quizás un proyecto más ambicioso es el de poder detectar células cancerigenas a temprana edad de lo cual ya se han reportado importantes avances. En el CIO trabajamos con nanopartículas de oro y plata a fin de desarrollar sensores ópticos la detección de diferentes compuestos a nivel de trazas y estamos aplicado exitosamente nanopartículas deoro en la detección de células cancerigenas.

En resumen, las nanoestructuras presentan propiedades ópticas únicas que no presentan su contraparte en bulto o de escala mayor. Éstas están siendo utilizadas para el desarrollo de la nueva generación de dispositivos optoelectrónicos y/o fotónicos. Las aplicaciones son muy variadas y abarcan muchos campos haciendo de la nanociencia y nanotecnología una área

multidisciplinaria. Especial atención recibe el uso de dichas propiedades en aplicaciones biomédicas para la detección a nivel de trazas de diversos agentes patógenos. El estudio de las propiedades ópticas de las nanoestructuras ha definido una nueva área conocida como nanofotónica.

¡El futuro está aquí!

emilio silvera

Mar

28

¡Aquella Huelva de mi Juventud!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Mi Tierra ~

Clasificado en Mi Tierra ~

Comments (0)

Comments (0)

Yo Nací en Huelva, hace ya algunas décadas, cuando estaban construyendo el Ayuntamiento y el Edificio de Hacienda, entonces tenía yo unos 8 años y, en aquellas obras hacía novillos jugando con los albañiles que trabajaban en aquellas construcciones. Entonces todo era muy direferente. La ciudad además de ser más pequeña y familiar, más acogedora y menos fría, también guardaba algunos restos de lo que fue. Tierra marinera por excelencia. Su puerto ubicado en el la ría del Odiel, daba acogida al Puerto Pesquero al Puente del Tinto y a la salida hacia mar abierto, camino del Océano Atlántico, y de las Américas como un día hizo Colón, aunque él creía que iba a otro lugar.

Esta misma Iglesia de antigua historia, también se ve en la fotografía anterior por un costado

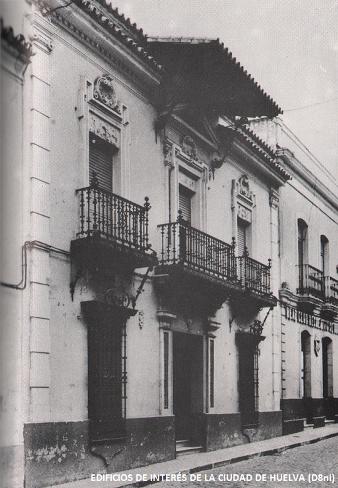

La Cánovas de la Huelva antigua

La calle Palacios, en la que, a los 16 años, entre a en Ofiteme de Don Manuel Dominguez, Catedrático de Contabilidad y Economista. Un hombre sabio de mucho de prestigio. Profesor de la Universidad, Director de la Escuela Pericial de Comercio y mi mentor. con sus consejos y ayuda pude cambiar el ritmo de mi vida. Espero que allí donde esté, nos mire sontiendo al ver que acertó con sus predicciones sobre Europa.

En Huelva tenemos algunos ejemplos de calles cuyo nombre es recuerdo de actividades pasadas, como por ejemplo: la Calle del Puerto, la Calle la Fuente, la Calle Rico (supongo que porque vivirían personas adineradas), la Calle de Palacio (por el palacio de los duques que se encontraba allí), la Plaza de las Monjas (por el convento cercano), la Calle Tendaleras (porque se construyó sobre la zona donde se tendían y tejían las redes). Todas ellas, me resultan entrañables y, algunas hoy, son irreconocibles.

El antiguo Mercado del Carmen (ya desaparecido) dejó a un moderno Edificio de hoy en día

En este pequeño café-Bar, se podían comprar para llevar a casa o bien otmarlos allí, los chocos y pescaditos fritos del lugar. Era una maravilla de lo natural hecho sencillez. Alimentos sanos sin aditivos. Como veréis, el nombre es orientativo: ¡En la Esquinita te espero! Así quedaban los amigos para tomar la cerveza y la razón de chocos fritos calentitos y recien salidos.

¿Cómo podían faltar las carretas que salían cada año para el Rocio -todavía salen-, haciendo un recorrido por algunos lugares de la para que la gente las vieran, mientras los rocieros, cantando y bebiendo, se preparaban para tres días de juerga que, ellos, llamaban de “devoción”.

El Edificio de la Izquierda es la Iglesia de la Concepción, a la que mi Abuela Manuela, regaló un enorme que exhiben entrando a la derecha y coge una enorme pared por sus grandes dimensiones. Mi abuela, que se dedicaba al trapicheo de cambiar cosas, cuando le caía en las manos alguna Obra como esa, se le regalaba a la Iglesia o, la vendía en Madrid, pero siempre, asesorado por el Profesor Don Manuel Siurot, una leyenda de Huelva.

Caserón de estilo neo-renacentista que se ubicaba en el 8 de la antigua calle Hospital, hoy Méndez Núñez. Se trata de un ejemplo de los “revivals” propios de principios del siglo XX (1917 exactamente) como reacción al modernismo de la época. Este caso reinterpreta el renacentismo, con características formales bien digeridas e interpretadas que lo relacionan con casas del siglo XVIII, como el alerón de tejas sobre el balcón central. Su autor, José María Perez Carasa.

¿Qué arreglo de fachada se podría hacer hoy de esta rústica ?

Situada en la esquina de la calle Cardenal Cisneros, muy de la última casa antigua de Huelva que queda en pie. Esta casa tenía la particularidad de tener una hornacina al estilo de la que hablábamos hace unos días (Cristo de la Calle Enmedio), pero dedicada a la Virgen de los Dolores. En la fotografía se distingue también un azulejo. Estos retablos populares son frecuentes en los pueblos y ciudades Andaluzas y Huelva también tuvo algunos de . Hoy día están todos desaparecidos, a excepción de los de nueva construcción.

Como somos tan listos, la antigua casa de los Garrochos, fue demolida para dar a la modernidad y eliminamos las pruebas viviente4s de tiempos inolvidables y hechos que hicieron nuestra hitoria pequeña.

Una de la casa de los Garrochos Emblema heráldico de los Garrocho

Muelle de Huelva hacia 1860. El edificio de la izquierda es el cuartel de carabineros (: Huelva Información). Aquella era una Huelva más primitiva y marinera, fiel a sus comienzos. En esta época la ciudad tenía como mayor actividad la pesaca y, todavía ni en Lepe, Cartaya, Palos de la Frontera, Rociana, o, Lucena del Puerto, no se explotaban las fresas que ahora, son una potencia en el mundo.

En Huelva tenemos grandes plantaciones de fresas y Franbuesas, de hecho, la Cooperativa Agrícola Hortofrutícola de Cartaya, S.C.A. (que tengo el honor de Asesorar Fiscalmente), es la primera expoertadora para Europa de estos productos de la tierra. También en Huelva (como andaluces que somos), celebran la Semana Santa que con muchos debotos

Como no queremos carecer de nada, también cuando llega el Carnaval, los onubenses salen a la calles de la y se disfrazan y forman jolgorios que, cada vez son más tristes por la erosión económica en la que estamos inmersos.

Una actuación de jóvenes onubenses en el que, como en Cádiz, también hacen sus pinitos de cancioncillas carnavaleras en estas fechas señaladas que, en realidad, traen recuerdos del pasado.

El Alcalde, con los brazos abiertos y, como buen político, repartiendo abrazos a todo el mundo mientras pasan las carretas del Carnaval. ¡Cómo son políticos! No se cómo se las arregla, el bueno de Perico Rodri para tener siempre, la sonrisa en la boca. Yo no sabría hacerlo, los estados de ánimo no siempre lo permiten.

Todo, como nosotros mismos, va y lo que fue ya no es. La evolución es imparable

Esta es la fuente que tiene la Casa Col´çon en sus Jardines interiores y cuyas de bronce, fueron hechas por mi abuelo, maestro fundidor de Riotinto una Empresa minera con mucha historia en Huelva.

más os podría contar sobre mi ciudad pero, como muestrario creo que está bien para que todos los amigos del Blog, sepan, por los lugares que me he movido desde niño hasta la hora presente (viajes aparte), este ha sido mi ámbito local junto con los pueblos limítrofes y portugal. De todas las maneras, no importa lo grande o lo pequeño del lugar del mundo donde puedas haber habitado, siempre será lo mismo y ocurrirán las mismas cosas alrededor de nuestras vidas: La enseñanza escolar, el trabajo, la familia… Es una sucesión de hechos que se repiten mientras la vida rueda.

emilio silvera

PD.

Agradecer a mi amigo Antonio José Martinez Navarro las y algunos trozos de la historia.

Mar

27

Sí, es mucho lo que nos queda por saber

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Vida ~

Clasificado en El Universo y la Vida ~

Comments (0)

Comments (0)

Arriba la Nebulosa de Caballo en Orión

De estas moléculas, ochenta y tres contienen carbono, entre las que se encuentran el ácido cianhídrico HCN, el amoníaco NH3 y el formaldehído H2CO. Moléculas precursoras que generalmente conducen a los aminoácidos. Para verificar que la síntesis de aminoácidos en las del medio interestelar es posible, una mezcla de hielo de agua, amoníaco, metanol, monóxido y dióxido de carbono ha sido irradiada en el Laboratorio de Astrofísica de Leyde en Holanda, en condiciones que imitan a las del medio interestelar (vacío impulsado de 10-7 mbar, y de -261°C).

A todo esto, ahora podemos contemplar nuestro propio planeta visto desde el espacio y, la belleza de la nos lleva a pensar que, en realidad, es la uténtica joya del Sistema solar. Ninguno de los planetas o lunas, conforman un conjunto similar de belleza física en la que se juntan una serie de parámetros espaciales que la hacen singular. De hecho, tan singular es que, la vida consciente está ahí presente. A veces, como nuestra imaginación es inquieta, y pensamos -es inevitable- en la existencia de otros mundos habitados, nos podemos preguntar:

Pero, ¿es fácil localizar planetas como la Tierra?

Por sorprendente que pueda parecer, especialmente después de ver las de la Tierra tomadas desde el espacio, en las cuales ésta aparece como una brillante bola azul y blanca sobre un fondo oscuro, la luz visible no ofrece las mejores perspectivas para detectar directamente otros planetas similares a la Tierra. Esto es así por dos razones:

En primer lugar, la luz visible que se recibe desde un planeta como la Tierra es en esencia el reflejo de la luz procedente de su estrella progenitora, por lo que no sólo es relativamente débil, sino que resulta muy difícil de captar a distancias astronómicas sobre el iluminado por el resplandor de dicha estrella.

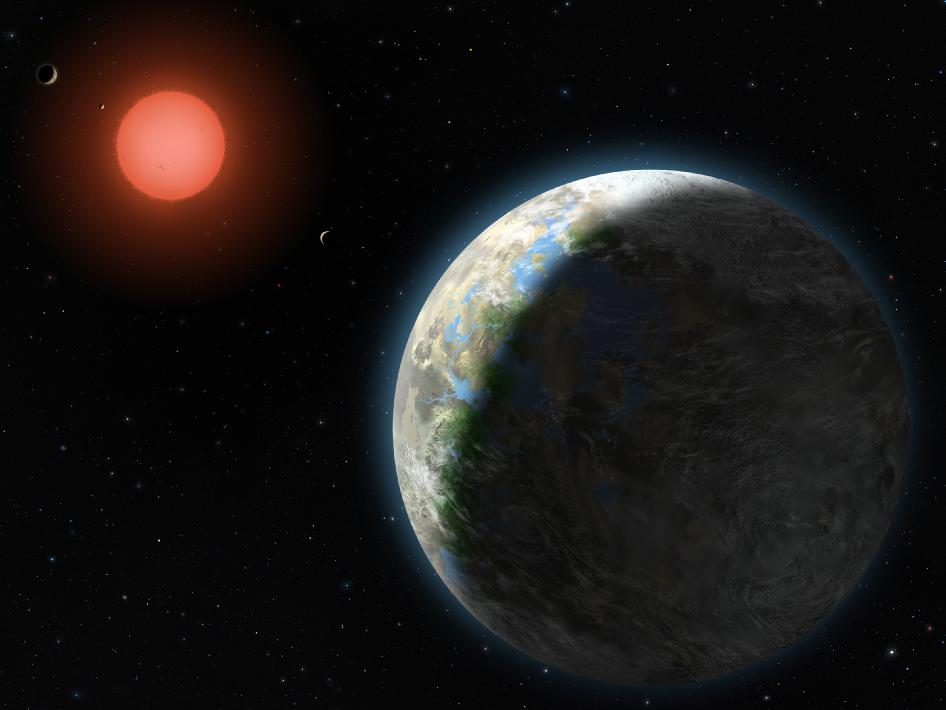

A pesar de todo, hemos conseguido encontrar…¿otras Tierras? que como Gliese 581 g, nos podrían dar alguna sorpresa. Pero sigamos…

En segundo lugar, del tipo de la Tierra alcanzan en realidad su brillo máximo en la parte de rayos infrarrojos del espectro electromagnético, por el modo en que la energía absorbida procedente del Sol vuelve a irradiarse en la zona de infrarrojos de dicho espectro, con longitudes de onda más largas que las de la luz visible.

En una longitud de onda de unas pocas micras, la Tierra es el planeta más brillante del Sistema solar y destacaría como un objeto impactante si se utilaza cualquier telescopio de infrarrojos suficientemente sensible situado en nuestra proximidad estelar. El problema es que, dado que la radiación de infrarrojos es absorbida por los propios gases de la atmósfera terrestre, como el dióxido de carbono y el vapor de agua, que son lo que nos interesa descubrir, el telescopio que se utilice para otros planetas como la Tierra tendrá que ser colocado en las profundidades del espacio, lejos de cualquier fuente potencial de contaminación. También tendrá que ser muy sensible, lo que significa muy grande. De ahí que estemos hablando de un proyecto internacional muy caro que tardará décadas en llevarse a buen puerto haciéndolo una realidad, y, mientras tanto, en la exploración espacial nos encontramos con extraños objetos y figuras como los de la imagen siguiente:

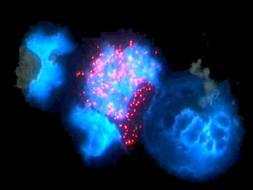

Anillos gigantes espaciales: Los anillos parecen de joyas pero son de agujeros negros. Esta conjunta de Arp 147, una pareja de galaxias interactuando localizada a unos 430 millones de años luz de la Tierra mostrada en rayos X desde el observatorio Chandra de la NASA (en rosa), y los ópticos del Telescopio Espacial Hubble (rojo, verde, azul). Lo ha producido el Instituto de Ciencias del Telescopio Espacial en Baltimore. Arp 147 contiene remanente de una galaxia espiral (derecha) que chocó con la galaxia elíptica (izquierda).

La explosión produjo una enorme onda expansiva de estelar que se muestra como un gran anillo azul que contiene abundancia de estrellas masivas jóvenes que, en pocos millones de años, explotarán en supernovas dejando atrás estrellas de neutrones y agujeros negros que, con su enormes masas, tirarán del material de las estrellas compañeras ahí presentes.

La sola presencia de gases como el dióxido de carbono y el vapor de agua no es suficiente como un signo de vida, pero sí de la existencia de planetas del tipo de la Tierra en el sentido de que tendrían una atmósfera como Venus y Marte, mientras que, en particular, la presencia de agua indicaría la probabilidad de que existiera un lugar adecuado para la vida.

Hasta hoy, se han identificado más de 1000 planetas extrasolares gigantes. A principios de del 2007 se detectó por primera vez vapor de agua en la atmósfera de un exoplaneta (HD209458b). También en abril del 2007, el VLT (Telescopio Muy Grande) en Chile detectó un planeta con un tamaño 5 veces el de la Tierra próximo a la estrella enana Gliese 581 -el que antes os mostraba-, donde se garantiza una temperatura de entre 0 y 40º Centígrados, ¡lo que permite la presencia de agua!. ¡Sólo está a 20,5 años luz!.

Un pequeño de exoplanetas han sido descubiertos con la ayuda del método de los tránsitos, que consiste en detectar la sombra de un planeta cuando en su órbita pasa por delante de su estrella y provoca un minieclipse. Medimos entonces la débil y pasajera ocultación de la estrella provocada por el paso del planeta.

La de vida en los planetas extrasolares puede hacerse sólo por el análisis espectral de sus manifestaciones, singularidades en la atmósfera y/o un mensaje electromagnético “inteligente” de una civilización avanzada extraterrena. La atmósfera terrestre alberga un 21 % de oxígeno mientras que las atmósferas de otros planetas del solar presentan sólo rastros. El oxígeno en la atmósfera terrestre es una singularidad por dos motivos: Es superabundante con relación a la corteza terrestre y debería normalmente desaparecer por recombinación con los minerales. Su presencia permanente está ligada a la existencia de vida intensa en la superficie de la tierra y no dejaría de llamar la atención a cualquier extraterrestre que observara la Tierra en busca de vida.

La presencia de grandes cantidades de oxígeno atmosférico se revelaría por la raya característica del oxígeno a 760 nm con la ayuda de un espectrofotometro en espectro visible del planeta. Por razones prácticas, es más fácil la firma del ozono O3, en el espectro infrarrojo a 9,6 μm. En la hipótesis, extremadamente seductora, de que el oxígeno atmosférico extraterreno sería puesto en evidencia, los escépticos no dejarían de hacer ver que el oxígeno puede ser producido por mecanismos químicos no biológicos. Sea lo que sea, la presencia simultánea de ozono (oxígeno, al fin y al cabo), de vapor de agua y de dióxido de carbono aparece hoy como una firma convincente de una vida planetaria que explota ampliamente la fotosíntesis. Dos proyectos actuales de estudio, se refieren a la búsqueda de exoplanetas de tipo terrestre. El proyecto americano TPF (Terrestrial Planet Finder, -buscador de planetas terrestres) y el proyecto europeo Darwin / IRSI (Infrared Space Interferometer,-Interferómetro espacial infrarrojo).

Este último consiste en colocar una flota de seis telescopios espaciales que serán acoplados en el espacio para analizar las atmósferas planetarias por interferometría y desde allí las singularidades debidas una actividad biológica.

En realidad, cuando se estudian de forma detenida y pormenorizada los mecanismos del Universo, podemos ver la profunda sencillez sobre la que este se asienta. Los objetos más complejos del Universo conocido son los seres vivos, como, por ejemplo, nosotros mismos. Sin embargo, el origen de todo que comenzó en las estrellas, sigue su en las Nebulosas donde ya están presentes los materiales de la vida.

Se muestran las emisiones del azufre (rojo ), el hidrógeno el (verde), y el oxígeno (azul).

La Nebulosa Rosetta es difusa con un 1º de longitud situada en Monoceros, en torno a un cúmulo de estrellas de magnitud 5, NGC 2244. La Nebulosa se llama así porque se asemeja a un rosetón. Las más brillantes de la Nebulosa tienen sus propios números NGC: 2237, 2238, 2239 y 2246. El cúmulo de estrellas asociado, consistente en estrellas de magnitud 6 y más débiles, se extiende sobre aproximadamente un 1/2º. La Nebulosa y el cúmulo se encuentran a 5 500 a.l. Todas las Nebulosas pertenecen a una Galaxia en la que se hayan todos los sistemas complejos.

Estos sistemas complejos están hechos de las materias primas más comunes que existen en Galaxias como la Vía Láctea o cualquier otra. En forma de aminoácidos estas materias primas se ensamblan de manera natural, dando lugar a sistemas autoorganizadores donde unas causas subyacentes muy sencillas pueden producir complejidad en la superficie, como en el caso del tigre y sus manchas. Finalmente, con el fin de detectar la presencia de esta complejidad máxima de unos sistemas universales no necesitamos ninguna sofisticada para distinguir la materia viva de la materia “inerte”, si no únicamente las técnicas más sencillas (aunque asistidas por tecnologías altamente avanzadas) para identificar la presencia de uno de los compuestos más simples del universo: El oxígeno.

Caos y Conplejidad que nos llevan hacia la vida

El caos y la complejidad se combinan para hacer del universo un lugar muy ordenado que es justo el entorno adecuado para formas vivas como mismos. Como dijo Stuart Kauffman, “en el universo estamos en nuestra propia casa”. Sin embargo, no es que el universo se haya diseñado así para beneficiarnos a nosotros, simplemente es que (según creo), la vida en el Universo es inevitable y la materia evolucionada en su más alto nos lleva a ella.

Planteémonos una simple : Dadas las condiciones que imperaban en la Tierra hace cuatro mil millones de años, ¿qué probabilidades había de que surgiera la vida?

No basta con responder que “la vida era inevitable, puesto que nosotros estamos aquí “. Obviamente, la vida sí se inició: nuestra existencia lo demuestra. Pero ¿tenía que iniciarse? En otras palabras, ¿era inevitable que emergiera la vida a partir de un combinado químico y radiado por la energía interestelar y después de millones de años?

El Origen de la Vida.

En los trabajos que venimos dejando aquí, nos va quedando claro que las dudas, son más grandes que las certezas.

Nadie conoce una respuesta exacta a esta pregunta del origen de la vida, según todos los indicios y con los que hoy contamos, parece ser un accidente químico con una alta probabilidad de reproducirse en otros lugares del Universo que sean poseedores de las condiciones especiales o parecidas a las que están presentes en nuestro planeta.

Pero la vida, no consiste solo en ADN, genes y replicación. Es cierto que, en un sentido biológico estricto, la vida está simplemente ocupada en replicar genes. Pero el ADN es inútil por sí sólo. Debe construir una célula, con todas sus sustancias químicas especializadas, para llevar a cabo realmente el proceso de replicación. En las denominadas formas de vida superior debe construir un organismo para que tenga todos los requisitos exigidos para que pueda replicarse. Desde la perspectiva de un genoma, un organismo es una manera indirecta de copiar ADN.

Es probable que, como ocurre aquí en la Tierra, las formas de vida más abundantes en el espacio exterior, sean las Bacterias y demás dominios del mundo microscópico de la vida, y, más difícil será seres inteligentes como nosotros…sin descartar su existencia. Simplemente se trata de hacer unas sencillas cuentas. La vida en la Tierra está presente desde hace unos 4.000 millones de años pero, nosotros, sólo tenemos una antigüedad de unos escasos tres millones de años. La Evolución es lenta y se ha necesitado mucho tiempo para que podamos estar aquí, de la misma manera, ocurrirá en esos mundos perdidos por el espacio y, si están en sus fases primeras, la posible vida existente en ellos…será bacteriana.

El mar Precámbrico. El mar en el que posiblemente vivieron hace 3.500 millones de años las primeras bacterias era un lugar desértico en el que durante muchos millones de años sólo proliferaron arqueas y bacterias. de ellas dejaron rastros fósiles en forma de estromatolitos, unas formaciones en las que las bacterias provocaban la concreción de carbonatos y a la vez quedaban englobadas en ellos. Para comparar esta recreación de un mar de la época.

El genético de una célula viva.

Sería muy laborioso y complejo explicar aquí de manera completa todos y cada uno de los pasos necesarios y códigos que deben estar presentes para formar cualquier de vida. Sin embargo, es necesario dejar constancia aquí de que los elementos necesarios para el surgir de la vida sólo se pueden fabricar en el núcleo de las estrellas (ya se mencionó antes) y en las explosiones de supernovas que pueblan el universo para formar nebulosas que son los semilleros de nuevas estrellas y planetas y también de la vida.

El surgir de la vida en nuestro Universo puede ser menos especial de lo que nosotros pensamos, y, en cualquier lugar o región del Cosmos pueden estar presentes formas de vida en que para nosotros podría ser como las del infierno.

¿Qué seres podrían vivir en un planeta que estuviera tan de una Gigante Roja?

Hace varias décadas, los biólogos quedaron sorprendidos al descubrir bacterias que vivían confortablemente a temperaturas de setenta grados Celsius. Estos microbios peculiares se encontraban en pilas de abonos orgánicos, silos e inclusos en sistemas domésticos de agua caliente y fueron bautizados como termófilos.

Resultados de la búsqueda

El término termófilo se aplica a organismos vivos que pueden soportar temperaturas imposibles y vivir en lugares de aguas calientes y sulfurosas, en terrenos de alto índice de salinidad o de Ph no apto para seres vivos, así como en lugares y situaciones que, se podrían, sin lugar a ninguna duda, comparar con otros existentes en el exterior, planetas y lunas sin atmósfera o de atmósfera reducida o demasiado densas.

Resultó que esto era sólo el principio. A finales de los años setenta la nave sumergible Alvin, perteneciente al Woods Hole Océano Graphic Institute, fue utilizada para explorar el fondo del mar a lo largo de la Grieta de las Galápagos en el océano Pacífico. Este accidente geológico, a unos dos kilómetros y medio bajo la superficie, tiene para los geólogos como un ejemplo primordial de las chimeneas volcánicas submarinas conocidas como “húmeros negros “. Cerca de un humero negro, el agua del mar puede alcanzar temperaturas tan altas como trescientos cincuenta grados Celsius, muy por encima del punto de ebullición normal. Esto es posible debido a la inmensa presión que hay en dicha profundidad.

Fumarola negra descubierta en el Caribe

Lugares como este permitieron la proliferación de pequeños seres vivos que, al calor de sus emisiones de gases tóxicos (de los que se alimentaban) salieron adelante y se expandieron de una manera bastante prolífica. Se cree que en lugares como este pudieron surgir especímes que evolucionaron hacia otros niveles.

Una expedición dirigida por científicos del Centro Nacional de Oceanografía en Southampton (Reino Unido) ha descubierto las chimeneas volcánicas submarinas más profundas del mundo, conocidas como ‘fumarolas negras’, de unos 5,000 metros de profundidad en la de Cayman, en el Caribe, revela un artículo publicado en Sciencie.com

Los investigadores utilizaron un controlado por control remoto de inmersión profunda y descubrieron delgadas espirales de minerales de cobre y hierro en el manto marino, erupciones de agua lo suficientemente calientes para derretir el plomo y unos 800 metros más profundas que las observadas con anterioridad.

Para asombro de los científicos implicados en el proyecto Alvin la región en torno a los húmeros negros de las Galápagos y otros lugares de las profundidades marinas resultó estar rebosante de vida. Entre los moradores más exóticos de las profundidades había cangrejos y gusanos tubulares gigantes. También había bacterias termófilas ya familiares en la periferia de los húmeros negros. Lo más notable de todo, sin embargo, eran algunos microbios hasta entonces desconocidos que vivían muy de las aguas abrasadoras a temperaturas de hasta ciento diez grados Celsius. Ningún científico había imaginado nunca seriamente que una forma de vida pudiera soportar calor tan extremo.

Las lombrices tubulares gigantes, o como les llama la wikipedia gusanos de tubo gigantes son unas bonitas lombrices que viven en los fondos del Océano Pacífico y cuyo nombre científico es Riftia Pachyptila, suena bien.

Estos interesantes invertebrados suelen vivir a una profundidad de 5000 pies (1500 metros), lo cual es una barbaridad. Su tamaño puede llegar hasta de 3 metros, por eso las llaman gigantes. Imaginen ir a pescar con una lombriz de este tamaño…

¿Que comen estos bichos?

Esta parte es la más interesante. Las lombrices tubulares gigantes viven en auténticos hornos submarinos. Se situan justo en chimeneas submarinas por las que salen a temperaturas altísimas, gases y minerales de muy alta toxicidad para la mayoría de las especies. Digamos que viven encima de pequeños volcanes.

La favorita de estas lombrices es el azufre, no necesita oxígeno para nada. Se basta, en concreto, con el sulfuro de hidrógeno que sale de las chimeneas termales. Sale hirviendo así que las lombrices tienen que sorber con cuidado. Usan esas plumas rojas para captar el sulfuro. Las plumas, tienen ese color debido a la hemoglobina, esa sustancia que tambien nosotros tenemos en la sangre y nos ayuda a transportar el oxígeno. A ellas les ayuda a transportar azufre, lo cual nos mataría a nosotros enseguida.

Igualmente se han encontrado formas de vida en lugares de gélidas temperaturas y en las profundidades de la tierra. Así mismo, la NASA ha estado en Riotinto, un pueblo de Huelva (España) para estudiar aguas con un PH imposible para la vida y cargada de metales pesados que, sin embargo, estaba rebosante de vida. El proyecto de estos se denomina P-TINTO, ya que, las aguas a las que nos referimos son precisamente las del Río Tinto, invadidas por los denominados extremófilos.

Una recreación imaginaria de las de la Tierra primigenia al sergir la vida (Fuente: The Seven Sense)

Algunas de estas bacterias (Sulfolobus) obtienen la energía oxidando azufre, por lo que son bacterias quimiosintéticas. Extremófilos del tipo termófilo producen algunos de los vistosos colores de la fuente termal Grand Prismatic Spring, en el Yellowstone National Park. ¿Por qué, viendo todo lo que vemos aquí mismo en nuestro planeta, nos podemos sorprender de que existan formas de vida en otros planetas?

Los extremófilos suelen ser procariotas como las bacterias, que son los seres con vida independiente más simples, pero también pueden ser eucariotas. De estos pequeños seres podríamos muchísimas cosas que nos serían de gran valor para conocer, qué podríamos hacer en especiales circunstancias. La Naturaleza que tiene todas las respuestas nos la ofrece y, por nuestra parte, sólo podemos prestar atención.

Variedad increíble

Hay extremófilos para casi cualquier situación adversa del entorno: los acidófilosson aquellos que viven en entornos altamente ácidos, mientras que los alcalófilosson los que viven en lugares con un alto pH.

La reseña viene a confirmarla enorme posibilidad de la existencia de vida en cualquier parte del universo que está regido por mecanismos iguales en cualquiera de sus regiones, por muchos años luz que nos separen de ellas. En comentarios anteriores dejamos claro que las Galaxias son lugares de autorregulación, y, podríamos considerarlos como organismos vivos que se regeneran así mismos de manera automática luchando contra la entropía del caos de donde vuelve a resurgir los materiales básicos para el nacimiento de nuevas estrellas y planetas donde surgirá alguna de vida.

En el desierto de Chihuahua (el más extenso de América del Norte), La Selaginella lepidophylla es una planta que pertenece a la familia de las Selaginellaceae resiste a la sequía desecándose en un 95% para volverse a hidratar cuando las son propicias.

La idea de que la vida puede tener una historia se remonta a poco más de dos siglos. Anteriormente, se consideraba que las especies habían sido creadas de una vez para siempre. La vida no tenía más historia que el Universo. Sólo nosotros, los seres humanos, teníamos una historia. Todo lo demás, el Sol y las estrellas, continentes y océanos, plantas y animales, formaban la infraestructura inmutable creada para servir como y soporte de la aventura humana. Los fósiles fueron los primeros en sugerir que esta idea podía estar equivocada.

Durante de tres mil millones de años, la vida habría sido visible sólo a través de sus efectos en el ambiente y, a veces , por la presencia de colonias, tales como los extremófilos que asociaban billones de individuos microscópicos en formaciones que podrían haber pasado por rocas si no fuera por su superficie pegajosa y por sus colores cambiantes.

El arbol de la vida esta formada por tres dominios: Bacteria : pertenecen las cianobacterias, bacterias aerobias, Archae: carecen de núcleo celular son PROCARIOTAS, y Eukarya: tiene nucleo definido (EUCARIOTAS) a el pertenecen los hongos, y animales.

Toda la panoplia de plantas, hongos y animales que en la actualidad cubre el globo terrestre con su esplendor no existía. Sólo había organismos unicelulares, que empezaron con casi toda seguridad con bacterias. Esa , “bacteria”, para la mayoría de nosotros evoca espectros de peste, enfermedades, difteria y tuberculosis, además de todos los azotes del pasado hasta que llegó Pasteur. Sin embargo, las bacterias patógenas son sólo una pequeña minoría, el resto, colabora con nosotros en llevar la vida hacia delante, y, de hecho, sin ellas, no podríamos vivir. Ellas, reciclan el mundo de las plantas y animales muertos y aseguran que se renueve el carbono, el nitrógeno y otros elementos bioquímicos.

Por todas estas razones, podemos esperar que, en mundos que creemos muertos y carentes de vida, ellas (las bacterias) estén allí. Están relacionadas con las primeras formas de vida, las bacterias han estado ahí desde hace de 4.000 millones de años, y, durante gran parte de ese tiempo, no fueron acompañadas por ninguna otra forma de vida.

¡La Vida! Tendrá tántas maneras de expresarse…, que ni imaginar

Pero, ¿No estamos hablando del Universo? ¡Claro que sí! Hablamos del Universo y, ahora, de la forma más evolucionada que en él existe: Los seres pensantes y conscientes de SER, nosotros los humanos que, de momento, somos los únicos seres inteligentes conocidos del Inmenso Universo. Sin embargo, pensar que estamos solos, sería un terrible y lamentable que, seguramente, nos traería consecuencias de difícil solución.

Tenemos que pensar seriamente en la posibilidad de la vida extraterrestre que, incluso en nuestra propia Galaxia, podría ser muy abundante. Es cierto que no será fácil -por el momento- encontrarla y mucho menos poder contactar con aquella que sea inteligente, no tenemos los medios para ello. Sin embargo, ese tantas veces imaginado , pòdría producirse por parte de “ellos” y, tal posibilidad, nos produce temor.

Necesitamos tiempo para poder avanzar en el conocimiento que nos lleve, a otras formas de “viajar” hacia los mundos lejanos en los que, de seguro, encontraremos muchas de las cosas que imaginamos y que allí, serán realidad. Se necesitan nuevas formas de energías, nuevas maneras de entender la física, nuevas tecnologías más avanzadas que trasciendan hacia niveles más profundos y nos puedan llevar, realmente, al Espacio, visitar físicamente esos lugares tántas veces soñados y que, por lo que sabemos, están ahí, esperando nuestra visita.

Nuestra imaginación que es, casi tan grande como el Universo mismo,podrá lograr muchos de esos sueños que a través de los tiempos nuestras mentes crearon y que, a medida que nuestros conocimientos evolucionan, se acercan más y más a la posibilidad de hacerlos una realidad. En todo el Universo siempre es lo mismo, rigen las mismas leyes, las mismas fuerzas que tantas veces hemos explicado aquí, e, igualmente, en todas está presente la misma materia que lo conforma todo…¡desde el más sencillo átomo de hidrógeno, hasta la Vida misma!

¡Quarks y Leptones! que forman los átomos y la materia que, junto a las fuerzas fundamentales conforman todo el universo. Todo es mucho más de lo que nuestras mentes puedan imaginar. Son muchas las preguntas que están pendientes de contestar y, aunque no dejamos de avanzar, lo cierto es que nos queda mucho que y muchos secretos por desvelar. Lo que se dice saber, saber… ¡No sabemos! Son muchos los secretos de la Naturaleza que perduran y, mientras tanto nosotros no sepamos sobre algunos de ellos… Por ejemplo, ¿Qué es la luz? tendremos que seguir ese camino hace miles de años emprendido en busca de las respuestas.

Al final todo consiste en

| Nucleones |

| Núcleos |

| Átomos |

| Moléculas |

| Sustancias |

| Cuerpos |

| Planetas (Vida) |

| Estrellas |

| Galaxias |

| Cúmulos de galaxias |

Claro que, también están los Pensamientos y los Sentimientos.

emilio silvera

Mar

26

¿Que es el principio de exclusión de Pauli?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (5)

Comments (5)

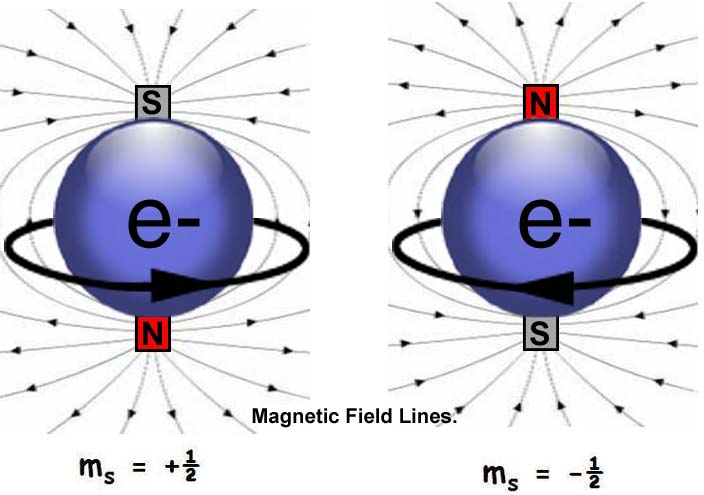

El principio de exclusión de Pauli es un principio cuántico enunciado por Wolfgang Ernst Pauli en 1925. Establece que no puede haber dos fermiones con todos sus números cuánticos idénticos (esto es, en el mismo estado cuántico de partícula individual) en el mismo cuántico ligado.1 Formulado inicialmente como principio, posteriormente se comprobó que era derivable de supuestos más generales: de hecho, es una consecuencia del teorema de la estadística del spin.

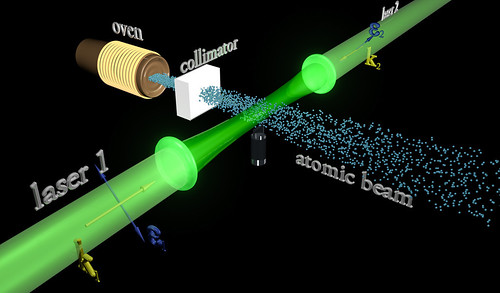

Debido al principio de exclusión de Pauli, es imposible que dos fermiones ocupen el mismo cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental para explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del de 2×10-7 K) se puede formar un condensado de Bose-Einstein, en el que miles de átomos dorman una única entidad (un superátomo). Este efecto ha sido observado con átomos de rubidio y litio.

Condensado de Bose-Einstein

Como ha habréis podido suponer, la condensación Bose-Einstein es llamada en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un momento angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosones idénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría para explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de . Con unas pocas suposiciones y unos ajustes ad-hoc, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas.

El magnético de las estrellas de neutrones

Si nos fijamos en todo lo que estamos hablando aquí, es fácil comprender cómo un magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma que lo haría si el hierro no estuviese magnetizado. El magnetismo delneutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un magnético cuando gira la partícula.

Particularmente creo que, si el neutrón tiene masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Sea fuere, la rotación del neutrón nos da la a esas preguntas:

¿Qué es el antineutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos.

Es indudable que las antipartículas pueden combinarse formar la antimateria, de la misma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un antideuterón. entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros antinúcleos más complicados aún si se abordara el problema con más .

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, tratar de alguna actividad inusual que delate interacciones materia-antimateria.

La verdad es que, el momento, el éxito ha nulo y la antimateria, si existió alguna vez, quedó destruída en esos primeros momentos del Big Bang y, desapareció debido a que, la materia bariónica era algo mayor que la antimateria, es decir, había más protones que antiprotones.

Los físicos hablan de antipartícula y se están refiriendo a una partícula subatómica que tiene la misma masa que otra partícula y valores iguales pero opuestos de otra propiedad o propiedades. Por ejemplo, la antipartícula del electrón es el positrón, que tiene una carga positiva igual en módulo a la carga negativa del electrón. El antiprotón tiene una carga negativa igual al módulo de la carga positiva del protón. El neutrón y el antineutrón tienen momentos magnéticos con signos opuestos en con sus espines. La existencia de antipartículas es predicha por la mecánica cuántica relativista.

Cuando una partícula y su antipartícula colisionan ocurre la aniquilación. La antimateria consiste en materia hecha de antipartículas. Por ejemplo, el antihidrógeno consiste en un antiprotón con un positrón orbitando. El antihidrógeno ha creado artificialmente en laboratorio. El espectro del antihidrógeno debería ser idéntico al del hidrógeno y, precisamente por eso, es tan difícil para los astrónomos localizar antimateria (si es que la hay).

Parece que el Universo está formado mayoritariamente de materia (ordinaria) y la explicación de la ausencia de grandes cantidades de antimateria debe ser incorporada en cosmológicos que requieren el uso de teorías de gran unificación de las partículas elementales.

Y, a todo esto, no debemos olvidarnos de la otra materia, esa que llamamos oscura y que, en realidad, deja al descubierto nuestra inmensa ignorancia, ya que, todo el Universo está empapado de ella, y, sin embargo, aún no hemos capaces de discernir lo que dicha materia oscura pueda ser, como se formó, o de qué está hecha y cómo se generó en el Universo, en verdad es un gran misterio qur todos los Astrónomos del mundo persiguen incansables.

Ahora se habla de otras dimensiones, y, nuestro cerebro está conformado en tres espaciales y una temporal ( la relatividad especial) y, desde luego, nos cuesta “ver” dimensiones más altas y no podemops crear en nuestras mentes que nos lleven a 5, 10, 11 o cualquier de dimensiones que están fuera de nuestro alcance mental pero, las matemáticas nos dicen que podrían muy bien existir y, para ello, han ideado una hermosa Teoría del Todo que llaman de supercuerdas o Teoría M.

Por mucho que esforzamos nuestra imaginación, visualizar esas dimensiones extra… ¡No será nada fácil! Nuestro muntro es tridimensional más el Tiempo que, desde Einstein, es la cuarta dimensión, Sin embargo, aunque con la numerología se trabaja con más dimensiones, y, los físicos de cuerdas logran que la Cuántica y la Relatividad (lo pequeño y lño grande) se junten sin alborotos, en la realidad cotidiana, donde las matemáticas quedan fuera, esas dimensiones más altas… ¡No se ven por ninguna parte!

Según los físicos, si es verdad que dichas dimensiones están ahí, ¿no podría esa materia y energía oscura estar alojada en alguna de ellas? Tengo un registrado en la Sociedad de Autores científicos que, precisamente se refiere a eso, a que la materia oscura pueda estar fuera de nuestra visión y que no la podamos detectar precisamente por no tenerla a la , y, mediante fluctuaciones del vacío, esa cantidad ingente de materia oscura deja pasar a los gravitones, los bosones intermediarios de la fuerza de Gravedad, que llegan a nuestro propio , a nuestras dimensiones, y, se deja sentir haciendo que las galaxias se alejen las unas de las otras a mayor velociodad de lo que lo harían si la única materia presente fuese la Bariónica.

En fin, amigos, es tanto lo que no sabemos que, mejor será la de éste y de otros misterios que, como el de la masa de las partículas, aún se nos escapa y tenemos que construir maravillas como el LHC para tratar de que responda a nuestras preguntas.

Una máquina gigantesca que quiere viajar hasta las cuerdas vibrantes

Pero, una cosa es cierta, nuestra osadía que nos lleva a comentar sobre cosas que no llegamos a comprender y, como por ejemplo, los taquiones, son simplemente objetos creados en nuestra inagotable imaginación. Los taquiones, si lo recordais, son partículas hipotéticas que viajan a mayor que la de la luz y, según la teoría electromagnética, una partícula cargada que viaja a través de un medio con velocidad mayor que la de la luz en ese medio emite radiación Cerenkov y, un taquión cargado emitirá radiación Cerenkov incluso en el vacío.

Claro que, por el momento no se han detectado partículas con esas caracterísiticas y, si llegan a hacer acto de presencia, ¿qué hacemos con la relatividad de Einstein que nos dice que nada en nuestro Universo podrá ir a más que la luz?

¡Es un serio problema! Mejor que el dichoso Taquión no aparezca.

Por otra parte, nunca podremos dejar de sorprendernos cuando nos sumergimos en el “universo” de la mecánica cuántica y en el mundo subatómico de las partículas. El 18 2012, investigadores del Instituto Kavli de TU Delft y de la Fundación FOM han logrado una primera detección de partículas Majorana. Etore Majorana fue un brillante físico italiano que llevó a cabo sus investigaciones en los años treinta del siglo pasado, ahondando en la teoría cuántica y como una partícula especial que podría existir, una partícula que sería en sí misma su propia antipartícula: el fermion de Majorana. Eso sitúa a partícula en la frontera entre materia y antimateria.

¿Será cierto aquello de que, todo lo que podamos imaginar se puede convertir en realidad… ¡con el del tiempo!

emilio silvera

Mar

24

La NASA nos habla de una estrella muy resistente

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias ~

Clasificado en Noticias ~

Comments (0)

Comments (0)

!Estrella Resistente Sobrevive a una Explosión Supernova!

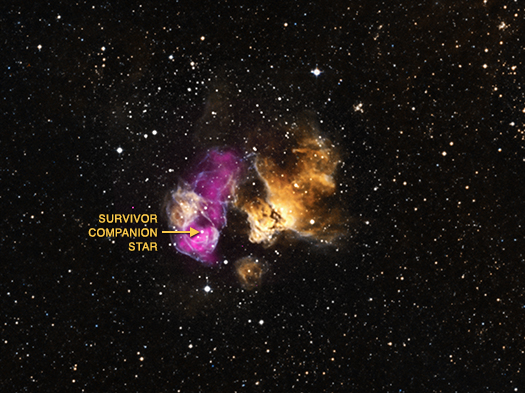

“20.03.14.- Cuando una estrella masiva se queda sin combustible, se colapsa y explota como una supernova. Aunque estas explosiones son extremadamente poderosas, es posible para una estrella compañera soportar la explosión. Un equipo de astrónomos utilizando el Observatorio de Rayos X Chandra de la NASA y otros telescopios han encontrado pruebas de una de estas supervivientes.

Esta resistente estrella está en el campo de escombros de la explosión estelar – también llamado remanente de supernova – situado en una región HII llamada DEM L241. Una región HII (se pronuncia “H-dos”) se crea cuando la radiación de estrellas jóvenes y calientes se despoja de los electrones de los átomos de hidrógeno neutro (HI) para formar nubes de hidrógeno ionizado (HII). Esta región HII se encuentra en la Gran Nube de Magallanes, una pequeña galaxia compañera de la Vía Láctea.

Región H II en la G. N. de Magallanes

Una nueva imagen compuesta de DEM L241 contiene datos del Chandra (púrpura) que describen el remanente de supernova. El remanente se mantiene caliente y por lo tanto, brillante en rayos X durante miles de años después de que ocurriese la explosión original. También se incluyen en esta imagen los datos ópticos de la Línea de Emisión de la Nube de Magallanes (MCELS), tomados desde telescopios terrestres en Chile (amarillo y cian), que traza la emisión HII producida por DEM L241. También se incluyen los datos ópticos adicionales del Digitized Sky Survey (blanco), que muestra las estrellas en el campo.

Los últimos datos del Chandra revelaron la presencia de una fuente de rayos X puntual en el mismo lugar como una joven estrella masiva dentro del remanente de supernova de DEM L241.

|

| Imagen de la estrella resistente a la explosión supernova. Image Credit: NASA/Chandra |

Los astrónomos pueden mirar los detalles de los datos del Chandra para recoger pistas importantes sobre la naturaleza de la fuente de rayos X. Por ejemplo, cómo es el brillo de los rayos X, cómo cambian con el tiempo y la forma en que se distribuyen en todo el rango de energía que observa el Chandra.

En este caso, los datos sugieren que la fuente puntual es un componente de un sistema estelar binario. En un par tan celestial, una estrella de neutrones o un agujero negro (que se forma cuando la estrella se convierte en supernova) está en órbita con una estrella mucho más grande que nuestro Sol. A medida que orbitan entre sí, la densa estrella de neutrones o un agujero negro tira del material lejos de su estrella compañera a través del viento de partículas que fluye lejos de su superficie. Si se confirma este resultado, DEM L241 sería sólo el tercer binario que contiene una estrella masiva y una estrella de neutrones o un agujero negro encontrado como secuela de una supernova.

De remanentes de Supernovas, como el de la Nebulosa del Cangrejo, con sus filamentos de plasma, está lleno el Espacio Interestelar, en el que, periódicamente “muere” alguna estrella masiva eyectando a ese entonro sus capas exteriores para formar una Nebulosa. La estrella se contrae sobre sí misma y queda convertida en un objeto diferente en función de su masa.

Los datos de rayos X del Chandra también muestran que el interior del remanente de supernova es rico en oxígeno, neón y magnesio. Este enriquecimiento y la presencia de la estrella masiva implican que la estrella que explotó tenía una masa superior a 25 veces, o quizás hasta 40 veces, la del Sol. Observaciones ópticas con el telescopio de 1,9 metros del Observatorio Astronómico de Sudáfrica muestran que la velocidad de la estrella masiva está cambiando y que orbita alrededor de la estrella de neutrones o agujero negro con un período de decenas de días. Una medición detallada de la variación de la velocidad de la estrella compañera masiva debería proporcionar una prueba definitiva de si el binario contiene o no un agujero negro.

Ya existen pruebas indirectas de que otros remanentes de supernovas se formaron por el colapso de una estrella para formar un agujero negro. Sin embargo, si la estrella colapsada en DEM L241 resulta ser un agujero negro, esto proporcionaría la evidencia más fuerte hasta ahora para un acontecimiento tan catastrófico.

¿Qué depara el futuro para este sistema? Si el último pensamiento es correcto, la estrella masiva superviviente será destruida en una explosión de supernova dentro de algunos millones de años a partir de ahora. Cuando lo haga, es posible que se forme un sistema binario que contenga dos estrellas de neutrones o una estrella de neutrones y un agujero negro, o incluso un sistema con dos agujeros negros.

Fuente: Noticias NASA

Totales: 67.239.171

Totales: 67.239.171 Conectados: 62

Conectados: 62