Dic

1

Más allá del Modelo Estándar ¿Qué habrá?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

SupersimetríaLa Ciencia de la Mula Francis – WordPress.comEl más allá del modelo estándar de las partículas elementales sin la supersimetría | Francis (th)E mule Science’s NewsCon el paso del tiempo, y merced a un gran número de experimentos, el Modelo Estándar se ha asentado como una teoría con gran soporte experimental. A pesar de ello, sin embargo, el modelo tiene algunas limitaciones: una de las mayores quizá sea que no permite describir la materia oscura y la energía oscura, que conjuntamente forman el 95% de la energía del universo. Tampoco parece compatible con la teoría de la Relatividad General de Einstein, es decir, el aparataje matemático del Modelo Estándar no es suficiente para describir la gravitación tal y como la conocemos a nivel subatómico, en el mundo cuántico. Un tercer problema es que el Modelo Estándar por sí solo no protege la masa del bosón de Higgs, lo cual significa que si existen partículas más pesadas que las que conocemos –y tenemos razones para pensar que es así– entonces esas partículas se pueden acoplar al Higgs y “tirar” de su masa hacia arriba, haciéndolo mucho más pesado de lo que los experimentos nos dicen.

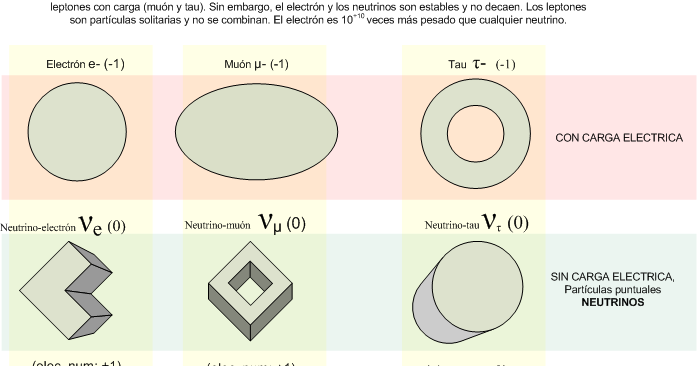

“… el Modelo Estándar es, en la historia, la más sofisticada teoría matemática sobre la naturaleza. A pesar de la palabra “modelo” en su nombre, el Modelo Estándar es una teoría comprensiva que identifica las partículas básicas y especifica cómo interactúan. Todo lo que pasa en nuestro mundo (excepto los efectos de la gravedad) es resultado de las partículas del Modelo Estándar interactuando de acuerdo con sus reglas y ecuaciones.”De acuerdo con el Modelo Estándar, leptones y quarks son partículas verdaderamente elementales, en el sentido de que no poseen estructura interna. Las partículas que tienen estructura interna se llaman hadrones; están constituidas por quarks: bariones cuando están formadas por tres quarks o tres antiquarks, o mesones cuando están constituidas por un quark y un anti-quark.

Pero ¿Cómo se da la interacción? ¿Quién “transmite el mensaje” de la fuerza entre las partículas que interactúan? Eso nos lleva a las partículas mediadoras o partículas de fuerza o, también, partículas virtuales.

El modelo estándar es una poderosa herramienta pero no cumple todas las expectativas; no es un modelo perfecto. En primer lugar, podríamos empezar por criticar que el modelo tiene casi veinte constantes que no se pueden calcular. Desde luego, se han sugerido numerosas ideas para explicar el origen de todos estos parámetros o números inexplicables y sus valores, pero el problema de todas estas teorías es que los argumentos que dan nunca han sido enteramente convincentes. ¿Por qué se iba a preocupar la naturaleza de una fórmula mágica si en ausencia de tal fórmula no hubiera contradicciones? Lo que realmente necesitamos es algún principio fundamental nuevo, tal como el principio de la relatividad, pero no queremos abandonar todos los demás principios que ya conocemos. Ésos, después de todo, han sido enormemente útiles en el descubrimiento del modelo estándar. El mejor lugar para buscar un nuevo principio es precisamente donde se encuentran los puntos débiles de la presente teoría y, construimos máquinas como el LHC para que nos diga lo que no sabemos.

Una regla universal en la física de partículas es que para partículas con energías cada vez mayores, los efectos de las colisiones están determinados por estructuras cada vez más pequeñas en el espacio y en el tiempo. El modelo estándar es una construcción matemática que predice sin ambigüedad cómo debe ser el mundo de las estructuras aún más pequeñas. Pero existen varias razones para sospechar que sus predicciones pueden, finalmente (cuando podamos emplear más energía en un nivel más alto), resultar equivocadas.

Vistas a través del microscopio, las constantes de la naturaleza parecen estar cuidadosamente ajustadas sin ninguna otra razón aparente que hacer que las partículas parezcan lo que son. Hay algo muy erróneo aquí. Desde un punto de vista matemático no hay nada que objetar, pero la credibilidad del modelo estándar se desploma cuando se mira a escalas de tiempo y longitud extremadamente pequeñas, o lo que es lo mismo, si calculamos lo que pasaría cuando las partículas colisionan con energías extremadamente altas. ¿Y por qué debería ser el modelo válido hasta aquí? Podrían existir muchas clases de partículas súper pesadas que no han nacido porque se necesitan energías aún inalcanzables. ¿Dónde está la partícula de Higgs? ¿Cómo se esconde de nosotros el gravitón?

Parece que el Modelo estándar no admite la cuarta fuerza y tendremos que buscar más profundamente, en otras teorías que nos hablen y describan además de las partículas conocidas de otras nuevas que están por nacer y que no excluya la Gravedad. Ese es el Modelo que necesitamos para conocer mejor la Naturaleza.

Claro que las cosas no son tan sencilla y si deseamos evitar la necesidad de un delicado ajuste de las constantes de la naturaleza, creamos un nuevo problema: ¿Cómo podemos modificar el modelo estándar de tal manera que el ajuste fino no sea necesario? Está claro que las modificaciones son necesarias, lo que implica que muy probablemente haya un límite más allá del cual el modelo tal como está deja de ser válido. El modelo estándar no será nada más que una aproximación matemática que hemos sido capaces de crear, de forma que todos los fenómenos que hemos observado hasta el presente están reflejados en él, pero cada vez que se pone en marcha un aparato más poderoso, tenemos que estar dispuestos a admitir que puedan ser necesarias algunas modificaciones del modelo para incluir nuevos datos que antes ignorábamos.

Más allá del modelo estándar habrá otras respuestas que nos lleven a poder hacer otras preguntas que en este momento, no sabemos ni plantear por falta de conocimientos. Si no conociéramos que los protones están formados por Quarks, ¿cómo nos podríamos preguntar si habrá algo más allá de los Quarks?

El gobierno de Estados Unidos, después de llevar gastados miles de millones de dólares, suspendió la construcción del supercolisionador superconductor de partículas asestando un duro golpe a la física de altas energías, y se esfumó la oportunidad para obtener nuevos datos de vital importancia para el avance de este modelo, que de momento es lo mejor que tenemos.

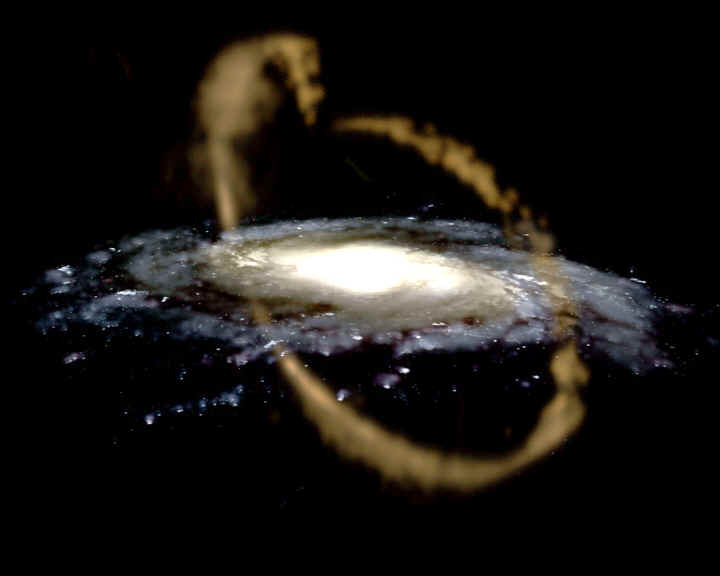

Se han estado inventando nuevas ideas, como la supersimetría y el technicolor. Los astrofísicos estarán interesados en tales ideas porque predicen una gran cantidad de nuevas partículas superpesadas, y también varios tipos de partículas que interaccionan ultradébilmente, los technipiones. Éstas podrían ser las WIMP’s (Weakly Interacting Massive Particles, o Partículas Masivas Débilmente Interactivas) que pueblan los huecos entre las galaxias, y serían así las responsables de la masa perdida que los astrofísicos siguen buscando y llaman “materia oscura”.

Que aparezcan “cosas” nuevas y además, imaginarlas antes, no es fácil. Recordemos cómo Paul Dirac se sintió muy incómodo cuando en 1931 dedujo, a partir de su ecuación del electrón, que debería existir una partícula con carga eléctrica opuesta. Esa partícula no había sido descubierta y le daba reparo perturbar la paz reinante en la comunidad científica con una idea tan revolucionaria, así que disfrazó un poco la noticia: “Quizá esta partícula cargada positivamente, tan extraña, sea simplemente el protón”, sugirió. Cuando poco después se identificó la auténtica antipartícula del electrón (el positrón) se sorprendió tanto que exclamó: “¡Mi ecuación es más inteligente que su inventor!”. Este último comentario es para poner un ejemplo de cómo los físicos trabajan y buscan caminos matemáticos mediante ecuaciones de las que, en cualquier momento (si están bien planteadas), surgen nuevas ideas y descubrimientos que ni se podían pensar. Así pasó también con las ecuaciones de Einstein de la relatividad general, donde Schwarzschild dedujo la existencia de los agujeros negros.

Se piensa que al principio del comienzo del tiempo, cuando surgió el Big Bang, las energías eran tan altas que allí reinaba la simetría total; sólo había una sola fuerza que todo lo englobaba. Más tarde, a medida que el universo se fue expandiendo y enfriando, surgieron las cuatro fuerzas que ahora conocemos y que todo lo rigen. Tenemos los medios, en los super-colisionadores de partículas, para viajar comenzando por 1.000 MeV, hasta finalizar en cerca de 1019 MeV, que corresponde a una escala de longitudes de aproximadamente 10–30 cm. Howard Georgi, Helen Quin y Steven Weinberg descubrieron que ésta es la región donde las tres constantes de acoplamiento gauge se hacen iguales (U(1), SU(2) y SU(3)); resultan ser lo mismo. ¿Es una coincidencia que las tres se hagan iguales simultáneamente? ¿Es también una coincidencia que esto suceda precisamente en esa escala de longitud? Faltan sólo tres ceros más para alcanzar un punto de retorno. Howard Georgi y Sheldon Glashow descubrieron un modelo genuinamente unificado en el dominio de energías de 1019 MeV tal que, cuando se regresa de allí, espontáneamente surgen las tres fuerzas gauge tal como las conocemos. De hecho, ellos encontraron el modelo; la fórmula sería SU(5), que significa que el multiplote más pequeño debe tener cinco miembros.

Materia y Energía Oscura… Un Misterio…Sin resolver.

Y, a todo esto, ¿Dónde está esa energía oculta? ¿Y donde la materia? Podemos suponer que la primera materia que se creo en el Universo fue la que llamamos (algún nombre había que ponerle) “Materia Oscura”, esa clase de Ylem o sustancia primera del Universo que mejor sería llamarla invisible, ya que, de no ser así, difícil sería explicar cómo se pudieron formar las primeras estrellas y galaxias de nuestro Universo, ¿Dónde está el origen de la fuerza de Gravedad que lo hizo posible, sino en esa materia escondida?

¡Lo dicho! Necesitamos saber, y, deseo que de una vez por todas, se cumpla lo que dejó dicho Hilbert en su tumba de Gotinga (Alemania): “Tenemos que saber, ¡sabremos!. Pero…

¡Que sea pronto!

emilio silvera

Totales: 85.261.044

Totales: 85.261.044 Conectados: 107

Conectados: 107