May

24

¿El Universo y la Mente? ¡Estrecha relación!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Mente ~

Clasificado en El Universo y la Mente ~

Comments (1)

Comments (1)

Bueno, en realidad, la Mente, “las Mentes” esparcidas por todos los mundos situados en los cientos de miles de galaxias que son, es esa parte del Universo que ha conseguido hacer llegar a la materia a su grado o nivel de evolución “casi” más alto. En ese estado de la materia, se llegan a crear pensamientos que rememoran el pasado, y, estando en el presente, son capaces de configurar un futuro.

Es verdaderamente admirable constatar cómo ha ido evolucionando nuestro entendimiento del mundo que nos rodea, de la Naturaleza, del Universo. Hubo un tiempo en el que, los individuos de nuestra especie deambulaban por est eplaneta pero, no sabían comprender el “mundo” ni podían pensar siquiera en el misterio que representaban los fenómenos naturales que a su alrededor se sucedían. Pasado el tiempo, pudieron mirar hacia arriba y, la presencia de aquellos puntitos brillantes en la oscura y misteriosa oscuridad de la noche, despertó su curiosidad consciente y se pudieron hacer algunas preguntas. Muchas decenas de miles de años más tarde, nuestro deambular por el planeta, las experiencias y la observación de la Naturaleza, nos llevó a comprender, algunas de las cosas que antes no tenían explicación. Pensadores del pasado dejaron la huella de sus inquietudes y los llamados filósofos naturales, hicieron el ejercicio de dibujar el “mundo” según ellos lo veían. Nos hablaron de “elementos” de “átomos” y, aunque no era el concepto que de esas palabras podamos tener, ya denotaba una gran intuición en el pensamiento humano que trataba de entender la Naturaleza y cómo estaban hechas las cosas que nos rodeaban. Ellos, a la materia primigenia la llamaron “Ylem” la sustancia cósmica.

Es cierto que siempre hemos quertido abarcar más de lo que nuestra “sabiduría” nos podía permitir. , en el presente, las cosas no han cambiado y tratamos de explicar lo que no sabemos, y, para ello, si hay que inventarse la “materia oscura”, las “fluctuaciones de vacío”, los “universos paralelos”, los “agujeros de gusano”, o, cualesquiera otros conceptos o fenómenos inexistentes en el mundo material o experimental… ¡qué más da! Lo importante es exponer las ideas que nos pasen por la cabeza que, de alguna manera, pasando el tiempo, se harán realidad. Nuestras mentes, como digo, siempre fueron por delante de nosotros mismos y ha dejado al descubierto esa intuición que nos caracteriza y que, de alguna manera, nos habla de esos hilos invisibles que, de alguna manera, nos conecta con el resto del Universo del que, al fin y al cabo, formamos .

Ahora, que hemos podido realizar un cierto avance en el “conocimiento del mundo que nos rodea”, no le damos la verdadera importancia que tienen algunos pensamientos del pasado que, en realidad, son los responsables de que ahora, nos encontremos en el nivel de conocimiento que hemos podido conquistar. Tales de Mileto, uno de los siete sabios de Grecia, fue el primero que dejó a un lado la mitología utilizar la lógica y, entre otras muchas cosas, indicó la importancia que tenía el agua para la existencia de la vida. Empédocles nos habló de los elementos y Demócrito del a-tomo o átomo., Arquitas de Tarento (filósofo, soldado y músico), el amigo de Platón y seguidor de Pitágoras, ya se preguntaba: ¿Es el Universo infinito?

Arquitas se preguntaba por el final del Universo

Él mismo se contestaba diciendo que todo tenía un límite y, pensaba en el final que lindaba con el “vacío”, allí donde nada impedía que su espada, lanzada con fuerza en el borde del universo, siguiera su camino sin fin, ninguna fuerza podría pararla y con ninguna clase de materia podría chocar.Así, con esos pensamientos surgidos de la mente humana, podemos constatar que, siempre, hemos tratado de saber de qué están hechas las cosas, cómo funciona la Naturaleza y de qué manera funciona el universo que tratamos de comprender.

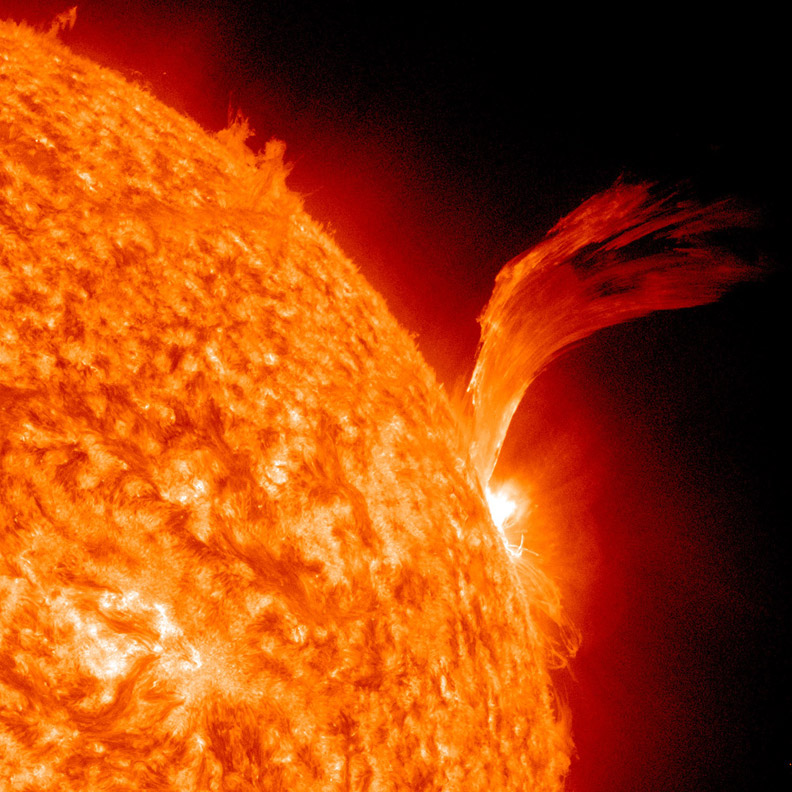

El Universo se expande y nuestras mentes también. Eso que llamamos Tiempo siguió su transcurrir inexorable, los pensamientos de los grandes pensadores se fueron acumulando en un sin fin de conjeturas y teorías que, poco a poco, pudimos ir comprobando mediante la observación, el estudio y la experimentación hasta que, pudimos llegar a saber de qué estaban hechas las estrellas y cómo la materia se transmutaba en sus nucleares para crear elementos que hicieron posible el suregir de la vida en los mundos (no creo que la vida esté supeditada a este mundo nuestro).

El conocimiento que creemos que tenemos sobre cómo está conformada la materia y las fuerzas fundamentales que con ella interaccionan, nos ha llevado a escenificar un Universo algo más comprensible que aquel, que nuestros ancestros imaginaron con la presencia de dioses y divinidades que eran los que, creaban los “mundos” o, el universo mismo, cada vez que soñaban. Es asombroso que hayamos podido llegar hasta la consciencia siendo la línea de salida la “materia inerte”. Sin embargo, el recorrido ha sido árduo y muy largo…, ¡diez mil millones de años han necesitado las estrellas poder solidificar los elementos de la vida para crear, en algunos de los muchos mundos presentes en las galaxias, el protoplasma vivo que dierqa lugar a esa primera célula replicante que comenzara la fascinante aventura de la vida llegar a los pensamientos.

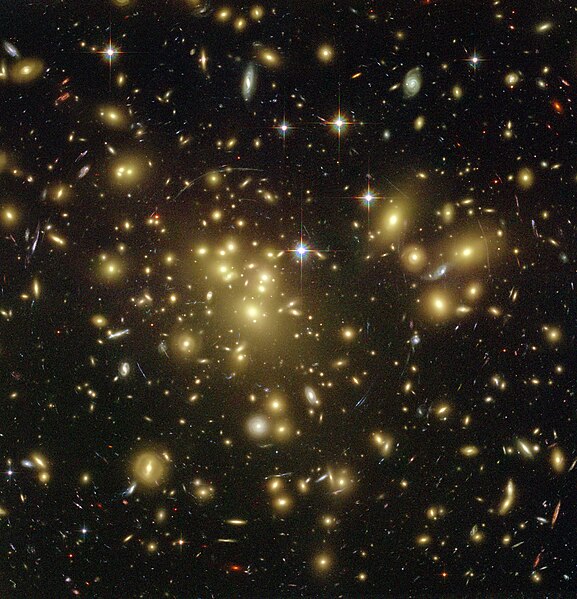

El Universo se contempla a través de nuestros ojos y de otros muchos que en los mundos están observando su evolución

Si nos preguntaran: ¿Es consciente el Universo? Tendríamos que contestar de manera afirmativa, toda vez que, al menos una , ¡la que piensa!, representada por seres vivos y que forman parte de ese inmenso universo, Sí que lo es. La vida es la consecuencia de la materia evolucionada hasta su más alto nivel y, a partir de ella, ha podido surgir eso que llamamos cerebro del que surge el concepto de mente, ese ente inmaterial y superior que trasciende y va más allá, lo que los filósofos llamaron Ser y quisieron explicar mediante la metafísica. Todavía, no sabemos lo que la vida es y tampoco, podemos explicar lo que es la energía, o, por exponer algún concepto de los muchos que denota nuestra ignorancia, tampoco podemos contestar a una simple pregunta: ¿Qué es el Tiempo? ¿Existe en realidad o simplemente es una abstracción de la mente?

Lo cierto es que nuestra especie ha dejado profundas huellas de su deambular por el mundo. Muchos de sus “tesoros y obras” quedaron enterrados en las profundidades del tiempo o inundados por los diluvios que las distintas civilizaciones que fueron nos contaron con sus maravillosas leyendas que, en realidad, trataban de explicar algo que sucedió y que no llegaban a comprender y, para ello, inventaban bonitas historias en las que, narraban hechos que quedaron difuminados por la fantasía el punto de no saber, en el presente, hasta que punto eran ciertas o no las bonitas “historias” que nos contaron.

Lo cierto es que, con frecuencia sucede que, cuando surgen ideas nuevas que tienden a querer explicar científicamente lo que es la Naturaleza, aparecen viejos datos que relacionan esas nuevas ideas con aquellos viejos problemas. Tenemos que admitir que todavía “no sabemos” cómo es la realidad del mundo y que, nuestra realidad, no que coincidir con la verdadera realidad que incansables buscamos.

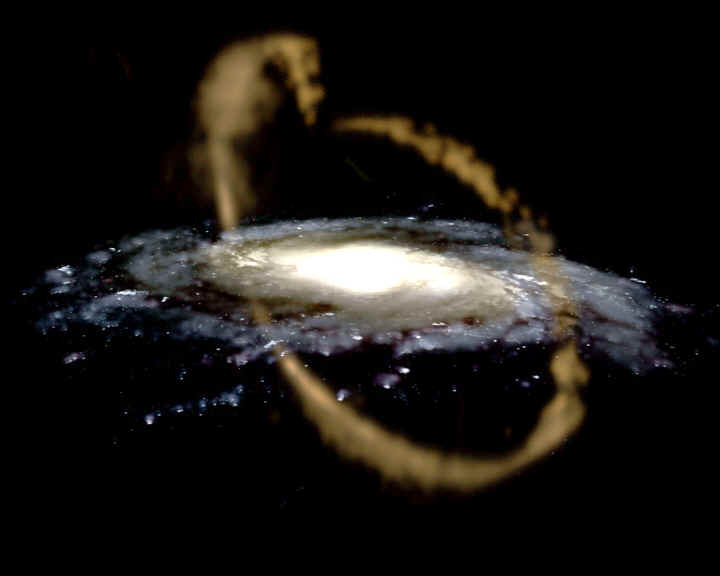

De hecho, no sabemos explicar ni cómo se pudieron formar las galaxias, y, a pesar de ello, no tenemos empacho de hablar de singularidades y agujeros de gusano o de universos paralelos. ¡La imaginación!, creo que sin ella, no habríamos podido llegar hasta aquí. La imaginación unida a la curiosidad ha sido siempre, el motor que nos llevó hacia el futuro.

Si en realidad existe “el infinito”, seguro que está en nuestras mentes, o, posinlemente en otras que, como las nuestras, han imaginado cómo ensanchar el mundo y universo de los pensamientos sin límite alguno, el único límite que existe, amigos míos, es el de nuestra ignorancia llegar a comprender lo que la Naturaleza es.

En la Naturaleza están todas las respuestas a las preguntas que planteamos y que nadie sabe contestar. En ella, en la Naturaleza, buscan nuestros ingenios esas respuestas y, para poder encontrarlas hemos inventado los aceleradores de partículas, los microscopios y telescopios que nos llevan a ese “otro universo” que el ojo desnudo no puede ver pero que, no deja de ser nuestro propio mundo, y, al ser conscientes de ello, también lo somos de nuestras limitaciones. En realidad, la única manera de avanzar es ser consciente de que no sabemos, toda vez que, creyéramos que ya lo sabiamos todo… ¿para qué seguir buscando?

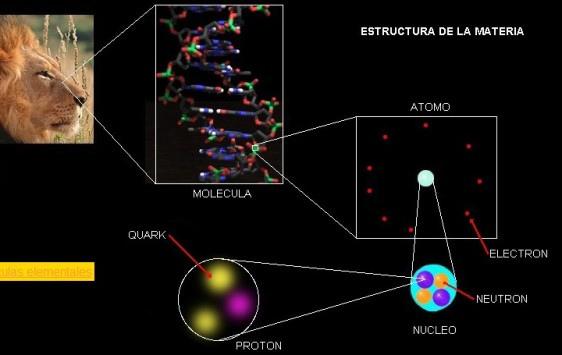

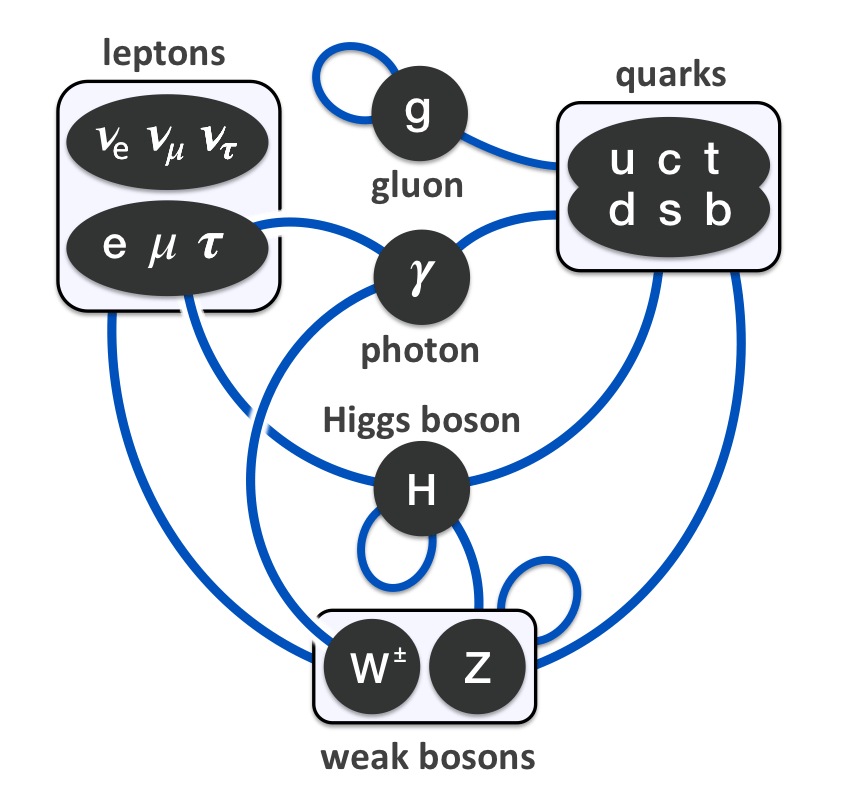

Todo está hecho de Quarks y Leptones. una Galaxia hasta el fiero león que habita en la selva

El pensamiento filosófico es un “mundo” que ensanchó los límites de la mente humana, nos llevó hasta la Ciencia, en un mundo en el que, las semillas de Quarks y Leptones se constituían en un universo material en el que, unas fuerzas fundamentales interaccionaban hacer posible el ritmo de todo lo que podemos observar, de todo lo que existe y que llegó, a crear el espaciotiempo y dentro de toda esa inmensidad, ¡los pensamientos y la imaginación! de objetos complejos que llamamos cerebro y transportan mentes creadoras de ideas como la de universos en la sombra, cuerdas cósmicas y otros muchos fantásticos fenómenos que pueblan un paisaje inmenso de “cosas” en constante ebullición que se transforman para crear otras diferentes. Para que eso sea posible, a veces podemos contemplar lugares violentos donde impera un Caos aparente pero, necesario para la creación.

Siempre habrá un camino para llegar a donde quieras ir

“Todas las cosas son”

Con esas sencillas palabras, el sabio, elevó a todas las cosas a la categoría de SER. ¿Tendrá memoria la materia? ¿Será posible que eso que llamamos materia “inerte”, no sea en realidad tan inocua ni tan insensible como imaginamos? Es posible que cada de la materia sea un paso necesario para poder llegar hasta su estado de consciencia que, en este mundo, se ha revelado en nosotros.

¿De qué estarán hechos los pensamientos… ¡Y los sentimientos!

Todo, no importa la forma que pueda adoptar, está hecho de la misma cosa y sólo varía la proporción y las energías que estén allí presentes, qué sucesos iniciaron aquel escenario o conformaron aqul objeto. Desde un simple átomo a más grande de los océanos, la montaña más alta, la estrella más fulgurante o la galaxia más bella, todo está hecho de Quarks y Leptones.

emilio silvera

May

23

¡La filosofía! Y, lo que creemos que sabemos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y los pensamientos ~

Clasificado en El Universo y los pensamientos ~

Comments (23)

Comments (23)

- Moritz Schlick

- Rudolf Carnap

- Otto Neurath

- Herbert Feigl

- Philipp Frank

- Friedrich Waismann

- Hans Hahn

- Hans Reichenbach

- Kurt Gödel

- Alfred Tarski

- A. J. Ayer

- Charles Morris

- Felix Kaufmann

- Victor Kraft

- Sigmund Freud

- Otto Weininger

- Carl Hempel

- Karl Popper

Podemos considerar como precursores del Círculo de Viena a los siguientes autores.

- Auguste Comte

- Einstein

- Gottlob Frege

- John Locke

- David Hume

- Ernst Mach

- Bertrand Russell

- Ludwig Wittgenstein

- Hans Kelsen

La Avenida del Ring

Existen cuatro tesis que definen el círculo:

- La posibilidad de verificar un hecho diferencia al conocimiento científico o ciencia, del resto de conocimientos

- Una observación se dice que es científica si pueden ser expresada con símbolos y relacionarse a traves de ellos.

- Todo enunciado científico se identifica dentro de un mismo área de la realidad, no existen distintas partes.

- Todo estudio científico se compone de fases de observación, procesamiento y conclusiones finales (o leyes generalistas). Una observación puntual puede arrojar resultados que no sean los esperados por lo que en muchos casos se hace uso de la probabilidad.

“El nacimiento y desarrollo de la ciencia experimental a partir del siglo XVII ha estado frecuentemente acompañado de polémicas filosóficas, y no pocas posturas filosóficas de la época moderna han representado, en parte, intentos diversos de solucionar esas polémicas”.

Resolver las diferentes polémicas filosóficas han hecho que en la época reciente se constituyese “la filosofía de la ciencia como disciplina autónoma, que ha dado lugar a la aparición de un nuevo tipo de dedicación profesional”.

Karl Popper

La aparición de este nuevo tipo de filósofo suele estar ligada a las actividades del círculo de Viena “que contribuyeron decisivamente a la consolidación de la filosofía de la ciencia como disciplina autónoma”. Desde esas actividades surgieron nuevas figuras que, ancladas en las consideraciones iniciales de la filosofía neopositivista del Círculo intenta responder a la cuestión de qué es la actividad científica y cual es su racionalidad propia. Heredan de la visión positivista que la ciencia es el paradigma de la objetividad y de la racionalidad.

Junto a la postura neopositivista crecen las figuras de otros pensadores. Entre esos nuevos filósofos se encuentra Karl Popper, cuya filosofía es también un intento de explicar el método científico y la racionalidad propia de la ciencia. Se convierte, tras alguno de los miembros del Círculo, en uno de los principales artífices de la consolidación de esta disciplina. A su sombra crecieron los principales filósofos de la ciencia del siglo XX y sus ideas constituyen siempre un paradigma, ya sea para seguirlas, ya sea para criticarlas.

Disolución del Círculo de Viena

La guerra, de Otto Dix. Dresde, Alemania, Gemaldegalerie, Neue Meister

En 1936 Schlick fue asesinado por un antiguo estudiante que era nazi, Hahn había muerto dos años antes, y casi todos los miembros del Círculo eran judíos. Esto produjo, con el advenimiento de los nazis, una diáspora que llevó a su disolución. Feigl se fue a Estados Unidos junto con Carnap, seguidos de Gödel y Ziegel; Neurath se exilió a Inglaterra; y, en 1938, las publicaciones del Círculo de Viena fueron prohibidas en Alemania. En 1939 Carnap, Neurath y Morris publicaron la Enciclopedia internacional de la ciencia unificada, que se puede considerar la última obra del Círculo de Viena.

Los procesos de la Ciencia, en todos sus ámbitos, siempre ha sido unificador del saber

“El proceso de la ciencia es el descubrimiento a cada paso de un nuevo orden que dé unidad a lo que desde hacía tiempo parecía desunirlo.”

Es lo que hizo Faraday cuando cerró el vínculo que unió la electricidad y el magnetismo. Es lo que hizo Clerk Maxwell cuando unió aquélla y éste con la luz. Y la ciencia siguió avanzando de manera que, nuevos paradigmas se implantaron en la física que comenzó a trastocarlo todo.

Él decía:

“Todos somos ignorantes, nadie sabe, ni las mismas ni todas cosas”.

Einstein unió el tiempo y el espacio, la masa a la energía y relacionó las grandes masas cosmológicas con la curvatura y la distorsión del tiempo y el espacio para traernos la gravedad en un teoría moderna; y dedicó los últimos años de su vida al intento de añadir a estas similitudes otra manera nueva y más avanzada, que instaurara un orden nuevo e imaginativo entre las ecuaciones de Maxwell y su propia geometría de la gravitación.

Cuando Coleridge intentaba definir la belleza, volvía siempre a un pensamiento profundo: la belleza, decía, es la “unidad de la variedad”.

“La ciencia no es otra cosa que la empresa de descubrir la unidad en la variedad desaforada de la naturaleza, o más exactamente, en la variedad de nuestra experiencia que está limitada por nuestra ignorancia.”

Hay muchas cosas que no podemos controlar, sin embargo, algo dentro de nosotros, nos envía mensajes sobre lo que podría ser importante para que nos fijemos mejor y continuemos profundizando. Algo dentro de nuestras mentes nos grita: ¡Fijaos en la Naturaleza, ella tiene todas las respuestas!

De los Quarks a las Galaxias

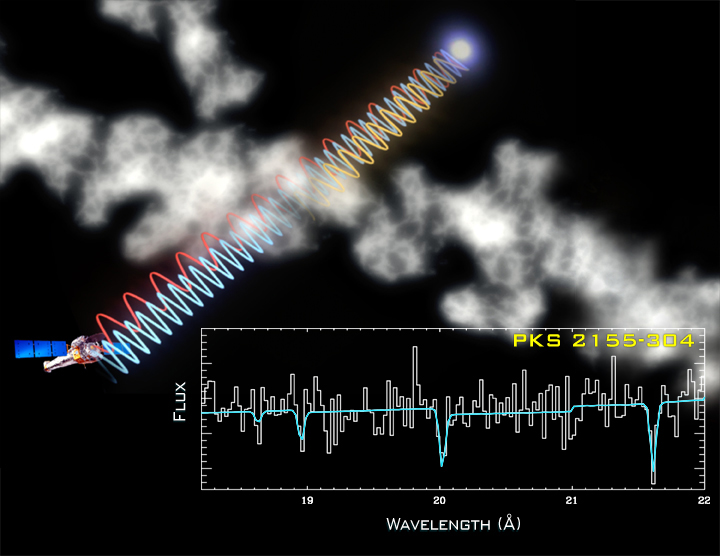

Para comprender mejor el panorama, hagamos una excursión hasta la astrofísica; hay que explicar por qué la física de partículas y la Astronomía se han fundido no hace muchos años, en un nivel nuevo de intimidad, al que alguien llamó la conexión espacio interior/espacio exterior.

Mientras los expertos del espacio interior construían aceleradores, microscopios cada vez más potentes para ver qué pasaba en el dominio subnuclear, los colegas del espacio exterior sintetizaban los datos que tomaban unos telescopios cada vez más potentes, equipados con nuevas técnicas cuyo objeto era aumentar su sensibilidad y la capacidad de ver detalles finos. Otro gran avance fueron los observatorios establecidos en el espacio, con sus instrumentos para detectar infrarrojos, ultravioletas, rayos X y rayos gamma; en pocas palabras, toda la extensión del espectro electromagnético, muy buena parte del cual era bloqueado por nuestra atmósfera opaca y distorsionadora.

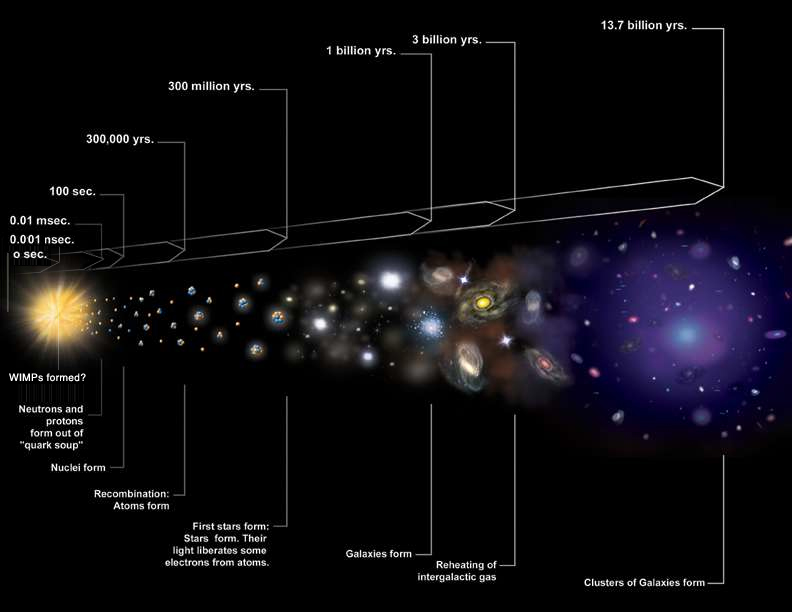

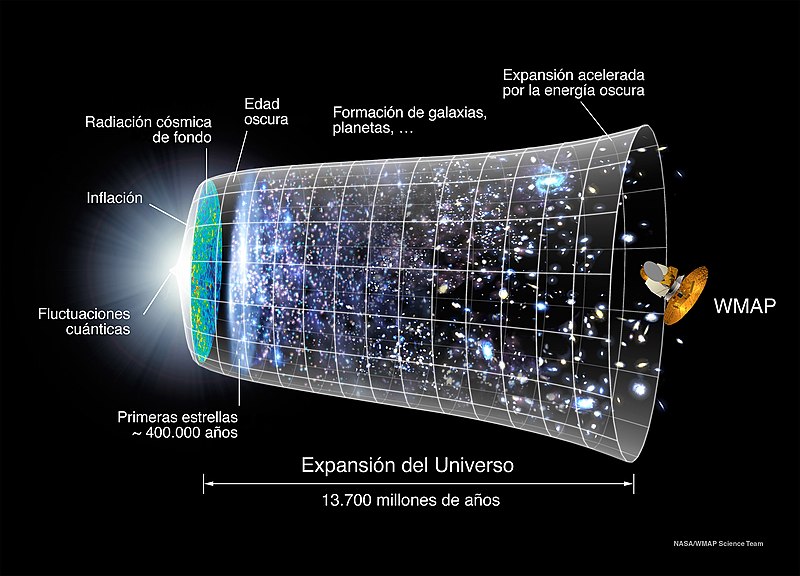

La síntesis de la cosmología de los últimos cien años es el modelo cosmológico estándar. Sostiene que el universo empezó en forma de un estado caliente, denso, compacto, hace unos 15.000 millones de años. El universo era entonces infinitamente, o casi infinitamente, denso; infinita, o casi infinitamente, caliente. La descripción “infinito” es incómoda para los físicos; los modificadores son el resultado de la influencia difuminadota de la teoría cuántica. Por razones que quizá no conozcamos nunca, el universo estalló, y desde entonces ha estado expandiéndose y enfriándose.

Ahora bien, ¿cómo se han enterado de eso los cosmólogos? El modelo de la Gran Explosión (Big Bang) nació en los años treinta tras el descubrimiento de que las galaxias (conjuntos de 100.000 millones de estrellas, aproximadamente) se estaban separando entre sí, descubrimiento hecho por Edwin Hubble, que andaba midiendo sus velocidades en 1.929.

Hubble tenía que recoger de las galaxias lejanas una cantidad de luz que le permitiera resolver las líneas espectrales y compararlas con las líneas de los mismos elementos de la Tierra. Cayó en la cuenta de que todas las líneas se desplazaban sistemáticamente hacia el rojo. Se sabía que una fuente de luz que se aparta de un observador hace justo eso. El desplazamiento hacia el rojo era, de hecho, una medida de la velocidad relativa de la fuente y del observador.

Más tarde, Hubble halló que las galaxias se alejaban de él en todas las direcciones; esto era una manifestación de la expansión del espacio. Como el espacio expande las distancias entre todas las galaxias, la astrónoma Hedwina Kubble, que observase desde el planeta Penunbrio en Andrómeda, vería el mismo efecto o fenómeno: las galaxias se apartaría de ella.

Cuanto más distante sea el objeto, más deprisa se mueve. Esta es la esencia de la ley de Hubble. Su consecuencia es que, si se proyecta la película hacia atrás, las galaxias más lejanas, que se mueven más deprisa, se acercarán a los objetos más próximos, y todo el lío acabará juntándose y se acumulará en un volumen muy, muy pequeño, como, según se calcula actualmente, ocurría hace 13.700 millones de años.

La más famosa de las metáforas científicas te pide que imagines que eres una criatura bidimensional, un habitante del Plano. Conoces el este y el oeste, el norte y el sur, pero arriba y abajo no existen; sacaos el arriba y debajo de vuestras mentes. Vivís en la superficie de un globo que se expande. Por toda la superficie hay residencias de observadores, planetas y estrellas que se acumulan en galaxias por toda la esfera; todo bidimensional. Desde cualquier atalaya, todos los objetos se apartan a medida que la superficie se expande sin cesar. La distancia entre dos puntos cualesquiera de este universo crece. Eso es lo que pasa, precisamente, en nuestro mundo tridimensional. La otra virtud de esta metáfora es que, en nuestro universo, no hay ningún lugar especial. Todos los sitios o puntos de la superficie sin democráticamente iguales a todos los demás. No hay centro; no hay borde. No hay peligro de caerse del universo. Como nuestra metáfora del universo en expansión (la superficie del globo) es lo único que conocemos, no es que las estrellas se precipiten dentro del espacio. Lo que se expande es que espacio que lleva toda la barahúnda. No es fácil visualizar una expansión que ocurre en todo el universo. No hay un exterior, no hay un interior. Sólo hay este universo, que se expande. ¿En qué se expande? Pensad otra vez en vuestra vida como habitante del Plano, de la superficie del globo: en nuestra metáfora no existe nada más que la superficie.

Dos consecuencias adicionales de gran importancia que tiene la teoría del Big Bang acabaron por acallar la oposición, y ahora “reina un considerable consenso” -obligado o forzado por la ignorancia de no saber explicar lo que pudo pasar, de otra manera distinta a la del B.B.-. Una es la predicción de que la luz de la incandescencia original (presuponiendo que fue muy caliente) todavía está a nuestro alrededor, en forma de radiación remanente. Recordad que la luz está constituida por fotones, y que la energía de los fotonesestá en relación inversa con la longitud de onda. Una consecuencia de la expansión del universo es que todas las longitudes se expanden. Se predijo, pues, que las longitudes de onda, originalmente infinitesimales, como correspondía a unos fotones de gran energía, han crecido hasta pertenecer ahora a la región de las microondas, en la que las longitudes son unos pocos milímetros.

En 1.965 se descubrieron los rescoldos del Big Bang, es decir, la radiación de fondo de microondas. Esos fotones bañan el universo entero, y se mueven en todas las direcciones posibles. Los fotones que emprendieron viaje hace miles de millones de años cuando el universo era más pequeño y caliente, fueron descubiertos por una antena de los laboratorios Bell en Nueva Jersey.

Así que el descubrimiento hizo imprescindible medir la distribución de las longitudes de onda, y se hizo. Por medio de la ecuación de Planck, esta medición de la temperatura media de lo que quiera (el espacio, las estrellas, polvo, un satélite, los pitidos de un satélite que se hubiese colado ocasionalmente) que haya estado bañándose en esos fotones.

COBE de la NASA lanzado en 1989

Las mediciones últimas efectuadas por la NASA con el satélite COBE dieron un resultado de 2’73 grados sobre el cero absoluto (2’73 ºK). Esta radiación remanente es una prueba muy potente a favor de la teoría del Big Bang caliente.

Los astrofísicos pueden hablar tan categóricamente porque han calculado qué distancias separaban a dos regiones del cielo en el momento en que se emitió la radiación de microondas observadas por el COBE. Ese momento ocurrió 300.000 años después del Big Bang, no tan pronto como sería deseable, pero sí lo más cerca del principio que podemos.

Resulta que temperaturas iguales en regiones separadas del espacio que nunca habían estado en contacto y cuyas separaciones eran tan grandes que ni siquiera a la velocidad de la luz daba tiempo para que las dos regiones se comunicasen, y sin embargo, sí tenían la misma temperatura. La teoría del Big Bang no podía explicarlo; ¿un fallo?, ¿un milagro? Se dio en llamar a eso la crisis de la causalidad, o de la isotropía.

Mapa del Universo por WMAP en 23-94 GHz demuestra la isotropía del Universo temprano.

De la causalidad porque parecía que había una conexión causal entre distintas regiones del cielo que nunca debieran haber estado en contacto; de la isotropía porque donde quiera que mires a gran escala verás prácticamente el mismo patrón de estrellas, galaxias, cúmulos y polvo estelar. Se podría sobrellevar esto en un modelo del Big Bang diciendo que la similitud de las miles de millones de piezas del universo que nunca estuvieron en contacto es puro accidente. Pero no nos gustan los “accidentes”: los milagros están estupendamente si jugamos a la lotería, pero no en la ciencia. Cuando se ve uno, los científicos sospechan que algo más importante se nos mueve entre bastidores. Me parece que mi inclinación científica me hace poco receptivo a los milagros. Si algo para habrá que buscar la causa.

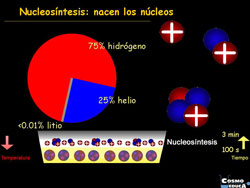

El segundo éxito de gran importancia del modelo del Big Bang tiene que ver con la composición de nuestro universo. Puede parecer que el mundo está hecho de aire, tierra, agua y fuego, pero si echamos un vistazo arriba y medimos con nuestros telescopios espectroscópicos, apenas sí encontramos algo más que hidrógeno, y luego helio. Entre ambos suman el 98% del universo que podemos ver. El resto se compone de los otros noventa elementos. Sabemos gracias a nuestros telescopios espectroscópicos las cantidades relativas de los elementos ligero, y hete aquí que los teóricos del Big Bang dicen que esas abundancias son precisamente las que cabría esperar. Lo sabemos así.

El universo prenatal tenía en sí toda la materia del universo que hoy observamos, es decir, unos cien mil millones de galaxias, cada una con cien mil millones de soles. Todo lo que hoy podemos ver estaba comprimido en un volumen muchísimos menos que la cabeza de un alfiler. La temperatura era alta, unos 1032 grados Kelvin, mucho más caliente que nuestros 273 ºK actuales. Y en consecuencia la materia estaba descompuesta en sus componentes primordiales.

Una imagen aceptable de aquello es la de una “sopa caliente”, o plasma, de quarks y leptones (o lo que haya dentro, si es que hay algo) en la que chocan unos contra otros con energías del orden de 1018 GeV, o un billón de veces la energía del mayor colisionador que cualquier físico pueda imaginarse construir. La gravedad era rugiente, con su poderoso (pero aún mal conocido) influjo en esta escala microscópica.

Tras este comienzo fantástico, vinieron la expansión y el enfriamiento. A medida que el universo se enfriaba, las colisiones eran menos violentas. Los quarks, en contacto íntimo los unos con los otros como partes del denso grumo que era el universo infantil, empezaron a coagularse en protones, neutrones y los demás hadrones. Antes, esas uniones se habrían descompuesto en las inmediatas y violentas colisiones, pero el enfriamiento no cesaba; aumentaba con la expansión y las colisiones eran cada vez más suaves.

A los tres minutos de edad, las temperaturas habían caído lo bastante como para que pudiesen combinarse los protones y los neutrones, y se formaran núcleos estables. Este fue el periodo de nucleosíntesis, y como se sabe lo suficiente de física nuclear se pueden calcular las abundancias relativas de los elementos químicos que se formaron. Son los núcleos de elementos muy ligeros; los más pesados requieren de una “cocción” lenta en las estrellas.

Claro que, los átomos (núcleos más electrones) no se formaron hasta que la temperatura no cayó lo suficiente como para que los electrones se organizaran alrededor de los núcleos, lo que ocurrió 300.000 años después, más o menos. Así que, en cuanto se formaron los átomos neutros, los fotones pudieron moverse libremente, y ésta es la razón de que tengamos una información de fotones de microondas todavía.

La nucleosíntesis fue un éxito: las abundancias calculadas y las medidas coincidían. Como los cálculos son una mezcla íntima de física nuclear, reacciones de interacción débil y condiciones del universo primitivo, esa coincidencia es un apoyo muy fuerte para la teoría del Big Bang.

En realidad, el universo primitivo no era más que un laboratorio de acelerador con un presupuesto ilimitado. Nuestros astrofísicos tenían que saberlo todo acerca de los quarks y los leptones y las fuerzas para construir un modelo de evolución del universo. Los físicos de partículas reciben datos de su experimento grande y único. Por supuesto, para los tiempos anteriores a los 10-13 segundos, están mucho menos seguros de las leyes de la física. Así que, los astrofísicos azuzan a los teóricos de partículas para que se remanguen y contribuyan al torrente de artículos que los físicos teóricos lanzan al mundo con sus ideas: Higgs, unificación de cuerdas vibrantes, compuestos (qué hay dentro de los quarks) y un enjambre de teorías especulativas que se aventuran más allá del modelo estándar para construir un puente que nos lleve a la descripción perfecta del universo, de la Naturaleza. ¿Será posible algún día?

Esperemos a ver qué pasa con la historia que comenzaron Grabielle Veneziano, John Schwartz, André Neveu, Pierre Ramond, Jeff Harvey, Joel Sheik, Michael Green, David Gross y un dotado flautista de Hamelin que responde al nombre de Edward Witten.

La teoría de cuerdas es una teoría que nos habla de un lugar muy distante. Según Leon Lederman… “casi tan distante como Oz o la Atlántida”. Estamos hablando del dominio de Planck, ese lugar al que nadie ha podido llegar nunca. No hay forma de que podamos imaginar datos experimentales en ese tiempo tan lejano; las energías necesarias (las de la masa de Planck) no están a nuestro alcance.

Y, a todo esto, tenemos que comprender que todo, absolutamente todo lo que anteriormente habéis leído más arriba, es lo que creemos que sabemos y que, de ninguna manera, tiene que reflejar la realidad que…, de momento y a ciencia cierta, desconocemos.

emilio silvera

May

23

¿Habéis pensado por qué hay vida en el Universo?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Vida ~

Clasificado en El Universo y la Vida ~

Comments (0)

Comments (0)

“Toda clase de vida en la Tierra (como en cualquier otros mundos) requiere de elementos químicos hidrógeno, oxígeno, nitrógeno, azufre, fósforo, así como de otros muchos en menores cantidades, como ciertos minerales; requiere además de agua como solvente en el cual las reacciones tienen lugar. Cantidad suficiente de carbono y demás elementos constituyentes de la vida, junto con el agua, harían posible la formación de organismos vivientes en otros planetas con una química, presión y temperatura similares a la Tierra. Como la Tierra y otros planetas están hechos de “polvo estelar”, es muy probable que otros planetas se hayan formado con semejante composición de elementos químicos que los terrestres. La combinación de carbono y agua en la forma de carbohidratos, como el azúcar, puede ser una fuente de energía química de la que depende la vida, mientras que a la vez provee elementos de estructura y codificación genética[cita requerida]. El agua pura es útil, pues tiene un pH neutro debido a la continuada disociación entre sus iones de hidronio e hidróxido. Como resultado, puede disolver ambos tipos de iones, positivos (metálicos) y negativos (no metálicos) con igual habilidad.

¿Quién puede decir lo que habrá en otros mundos, en otros ecosistemas?

“Debido a su relativa abundancia y utilidad en el sostenimiento de la vida, muchos han conjeturado que todas las formas de vida, donde quiera que se produzcan, se valdrían también de estos materiales básicos. Aun así, otros elementos y solventes pueden proveer una cierta base de vida. Se ha señalado al silicio como una alternativa posible al carbono; basadas en este elemento, se han propuesto formas de vida con una morfología cristalina, teóricamente capaces de existir en condiciones de alta temperatura, como en planetas que orbiten muy cercanos a su estrella.

También se han sugerido formas de vida basadas en el otros solventes, pues existen compuestos químicos capaces de mantener su estado líquido en diferentes rangos de temperatura, ampliando así las zonas habitables consideradas viables. Así por ejemplo, se estudia el amoníaco como solvente alternativo al agua. La vida en un océano de amoníaco podría aparecer en un planeta mucho más lejano a su estrella.1

Técnicamente, la vida es básicamente una reacción que se replica a sí misma, por lo que bajo esta simple premisa podría surgir la vida bajo una amplia gama de condiciones e ingredientes diferentes, si bien la vía carbono-oxígeno parece la más óptima y conductiva. Existen incluso teorías sobre reacciones autorreplicantes que podrían ocurrir en el plasma de una estrella, aunque éste sería un tipo de vida altamente extremo y nada convencional.”

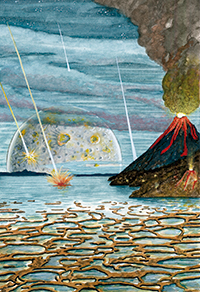

Mucho tiempo ha pasado que esta imagen era el presente, y, sin embargo, para el Universo supone una ínfima fracción marcada por el Tic Tac cósmico de las estrellas y galaxias que conforman la materia de la que provenimos. Es un gran misterio para nosotros que sean las estrellas las que fabrican los materiales que, más tarde, llegan a conformar a seres vivos que, en algunos caso, tienen consciencia. Planck decía:

“La ciencia no puede resolver el misterio final de la Naturaleza. Y esto se debe a que, en el último análisis, nosotros somos parte del misterio que estamos tratando de resolver”.

Nos queda mucho por decubrir y aún no tenemos ni los medios ni los conocimientos para hacerlo

“La creciente distancia entre la imagen del mundo físico y el mundo de los sentidos no significa otra cosa que una aproximación progresiva al mundo real.” Nos decía Planck. Su intuición le llevaba a comprender que, con el paso del tiempo, nosotros estaríamos adquiriendo por medio de pequeñas mutaciones, más amplitud en nuestros sentidos, de manera tal que, sin que nos diéramos cuenta nos estábamos acercando más y más al mundo real.”

Veámos otros temas.

Aquí cada día, elegimos una cuestión distinta que se relaciona, de alguna manera, con la ciencia que está repartida en niveles del saber denominados: Matemáticas, Física, Química,Astronomía, Astrofísica, Biología, Cosmología… y, de vez en cuando, nos preguntamos por el misterio de la vida, el poder de nuestras mentes evolucionadas y hasta dónde podremos llegar en nuestro camino, y, repasamos hechos del pretérito que nos trajeron hasta aquí.

Robert Henry Dicke (6 de mayo de 1916 – 4 de marzo de 1997) fue un físico experimental estadounidense, que hizo importantes contribuciones en astrofísica, física atómica, cosmología y gravitación. Hombre inquieto, muy activo y, sobre todo, curioso por saber todo aquello que tuviera alguna señal de misterio.

Me referiré ahora aquí al extraño personaje que arriba podeis ver. Se sentía igualmente cómodo como matemático, como físico experimental, como destilador de toda clase de ideas que le llevara a descubrir los misterios de la Naturaleza.

Paul Adrien Maurice Dirac (8 de agosto de 1902 – 20 de octubre de 1984) fue un físico teórico británico que contribuyó de forma fundamental al desarrollo de la mecánica cuántica y la electrodinámica cuántica. Sus trabajos sobre el electrón, en nada tiene que envidiar a los de Einstein.

Dirac, que predijo la existencia del positrón, le dedicó un estudio a la Gravedad al hilo de una serie de números y teorías propuestas por Eddintong en aquellos tiempos y decidió abandonar la constancia de la constante de gravitación de Newton, G. Sugirió que estaba decreciendo en proporción directa a la edad del universo en escalas de tiempo cósmicas. Es decir, la Gravedad en el pasado era mucho más potente y se debilitaba con el paso del tiempo.

Así pues, en el pasado G era mayor y en el futuro será menor que lo que mide hoy. Veremos que la enorme magnitud de los tres grandes números (1040, 1080 y 10120) es una consecuencia de la gran edad del universo: todas aumentan con el paso del tiempo.

La propuesta de Dirac provocó un revuelo un grupo de científicos vociferantes que inundaron las páginas de las revistas especializadas de cartas y artículos a favor y en contra. Dirac, mientras tanto, mantenía su calma y sus tranquilas costumbres, escribió sobre su creencia en los grandes números cuya importancia encerraba la comprensión del universo con palabras que podrían haber sido de Eddington, pues reflejan muy estrechamente la filosofía de la fracasada “teoría fundamental”.

Siempre hemos estado obsesionados con algunos números en los que creímos ver significados ocultos

“¿No cabría la posibilidad de que todos los grandes sucesos presentes correspondan a propiedades del Gran 1040 y, generalizando aún más, que la historia entera del universo corresponda a propiedades de la serie entera de los números naturales…? Hay así una posibilidad de que el viejo sueño de los filósofos de conectar la naturaleza con las propiedades de los números enteros se realice algún día”.

La propuesta de Dirac levantó controversias entre los físicos, y Edward Teller en 1.948, demostró que si en el pasado la gravedad hubiera sido como dice Dirac, la emisión de la energía del Sol habría cambiado y la Tierra habría mucho más caliente en el pasado de lo que se suponía normalmente, los océanos habrían estado hirviendo en la era precámbrica, hace doscientos o trescientos millones de años, y la vida tal como la conocemos no habría sobrevivido, pese a que la evidencia geológica entonces disponible demostraba que la vida había existido hace al menos quinientos millones de años.

Las constantes de la Naturaleza han sido medida de mil maneras

Dicke, ya podéis imaginar que fue uno de los que de inmediato se puso manos a la obra para dilucidar si la Naturaleza encerraba el secreto de una G variable como decía Dirac.

A lo largo del Siglo XX se observó que algunas de las cifras que se dan en la naturaleza coinciden de manera sorprendente, y más extraño aún resultó el hecho de que se refieren a ámbitos físicos aparentemente independientes. Otro elemento insólito consistía en que todas ellas giraban alrededor de unos números (1040, 1080 y 10120).

“El problema del gran tamaño de estos números es ahora fácil de explicar… Hay un único número adimensional grande que tiene su origen estático. Este es el número de partículas del Universo. La edad del Universo “ahora” no es aleatoria sino que está condicionada por factores biológicos… [porque cambio en los valores de grandes números] impedirían la existencia del hombre para considerar el problema”.

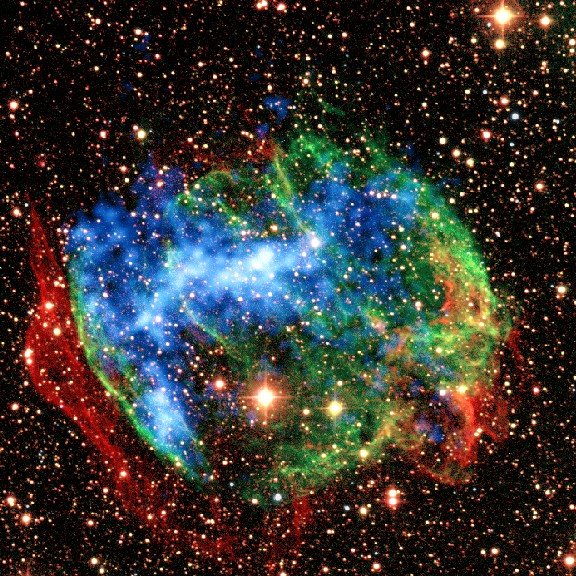

La Alquimia estelar está presente en “infinitos” lugares del universo

La evolución del Universo, sus transiciones de fases, la construcción natural de elementos pesados y más complejos en el seno de las estrellas y en las explosiones supernovas, todo ello, nos llevó a que la materia pudiera adquirir la capacidad químico biológica necesaria para la vida.

Dicke, cuatro años más tarde desarrolló esta importante intuición con más detalle, con especial referencia a las coincidencias de los Grandes Números de Dirac, en una breve carta que se publicó en la revista Nature. Dicke argumentaba que formas de vidas bioquímicas como nosotros mismos deben su propia base química a elementos tales como el carbono, nitrógeno, el oxígeno y el fósforo que son sintetizados tras miles de millones de años de evolución estelar en la secuencia principal. (El argumento se aplica con la misma fuerza o cualquier forma de vida basada en cualesquiera elementos atómicos más pesados que el helio.) Cuando las estrellas mueren, las explosiones que constituyen las supernovas dispersan estos elementos biológicos “pesados” por todo el espacio, de donde son incorporados en granos, planetesimales, planetas, moléculas “inteligentes” auto replicantes como ADN y, finalmente, en nosotros mismos que, en realidad, estamos hechos de polvo de estrellas.

El polvo de las estrellas, ahí se guarda el secreto de la vida y de la energía del Universo

Esta escala temporal está controlada por el hecho de que las constantes fundamentales de la Naturaleza sean:

t(estrellas) ≈ (Gmpr 2/ћc)-1 ћ/mprc2 ≈ 1040 ×10-23 segundos≈ 10.000 millones de años (se necesita ese tiempo de evolución en las estrellas para que, la vida, pueda aparecer en el Universo). No esperaríamos estar observando el Universo en tiempos significativamente mayores que t (estrellas), puesto que todas las estrellas estables se habrían expandido, enfriado y muerto. Tampoco seríamos capaces de ver el Universo en tiempos muchas menores que t (estrellas) porque no podríamos existir. No había estrellas ni elementos pesados como el carbono. Parece que estamos amarrados por los hechos de la vida biológica para mirar el Universo y desarrollar teorías cosmológicas una vez que haya transcurrido un tiempo t (estrellas) desde el Big Bang.

Creo que las constantes de la Naturaleza permiten la presencia de la Vida en el Universo

Cadenas de ADN en el Universo

Como antes se explicaba, todos los procesos de la Naturaleza, requieren su tiempo. Desde un ambarazo a la evolución de las estrellast(estrellas) ≈ (Gmp2 / hc)-1 h/mpc2 ≈ 1040 ×10-23 segundos ≈ 10.000 millones de No esperaríamos estar observando el universo en tiempos significativamente mayores que t(estrellas), puesto que todas las estrellas estables se habrían expandido, enfriado y muerto. Tampoco seríamos capaces de ver el universo en tiempos mucho menores que t(estrellas) porque no podríamos existir; no había estrellas ni elementos pesados como el carbono. Parece que estamos amarrados por los hechos de la vida biológica para mirar el universo y desarrollar teorías cosmológicas una vez que haya transcurrido un tiempo t(estrellas) Big Bang.

“Los astrónomos han utilizado al observatorio ALMA para capturar una imagen de una frágil burbuja de material expelido en torno a la exótica estrella roja U Antliae. Estas observaciones ayudarán a los astrónomos a entender mejor cómo evolucionan las estrellas en las últimas fases de sus ciclos de vida.”

La escena de una estrella moribunda fue necesaria para que los materiales biológicos que nos conformaron a los seres vivos, pudieran estar presentes en el Universo. Sin que llegara a producirse tal acontecimiento, no existirían en el universo los elementos necesarios para la vida. Así no pocas veces hemos oido decir que estamos hechos de polvo de estrellas y, aunque no literal, si es una buena metáfora de lo que somos. Es fácil suponer que la vida pulula por todo el Universo. Pero, siempre se nos viene una pregunta a la mente: ¿Por qué no hemos contactado ya con otros seres inteligentes de otros planetas?

Claro que los procesos de la alquimia estelar necesitan tiempo: miles de millones de años de tiempo. Y debido a que nuestro universo se está expandiendo, tiene que tener un tamaño de miles de millones de años-luz para que durante ese periodo de tiempo necesario pudiera haber fabricado los componentes y elementos complejos para la vida. Un universo que fuera sólo del tamaño de nuestra Vía Láctea, con sus cien mil millones de estrellas resultaría insuficiente, su tamaño sería sólo de un mes de crecimiento-expansión y no habría producido esos elementos básicos para la vida.

El Sol se convertirá en una gigante roja y ésta en una enana blanca dejando en la región una Nebulosa planetaria.

Los procesos siguen, las cosas cambian, el Tiempo inexorable transcurre, si hay vida vendrá la muerte, lo que es hoy mañana no será. De la materia inerte surgirá la vida mediante procesos inevitables que son normales en las reglas que el Universo impone, en su ritmo y en sus constantes que hacen posible, al fin, la presencia de una bioquímica que permite la diversidad de seres vivos que a lo largo de la historia de la Tierra estuvieron aquí, los que están ahora en el presente y, los que, posiblemente, estarán mañana… ¡En ese futuro que no conocemos! Pero sabemos que…

El universo visible contiene sólo:

1 Estrella por (103 años luz)3

1 “Universo” por (1010 años luz)3

El cuadro expresa la densidad de materia del universo de varias maneras diferentes que muestran el alejamiento que cabría esperar entre las galaxias y lo difícil que será que podamos, algún día, conocer a seres de otras galaxias cada vez más lejos de nosotros. Sin embargo, en nuestra Vía Láctea existen miles de millones de mundos y, siendo así (que lo es), no podemos perder la esperanza de que algún día… podamos ir a otros mundos habitados, o, recibir, una inesperada visita.

May

22

La Física al servicio de la Salud

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física... ¡Y mucho más! ~

Clasificado en Física... ¡Y mucho más! ~

Comments (1)

Comments (1)

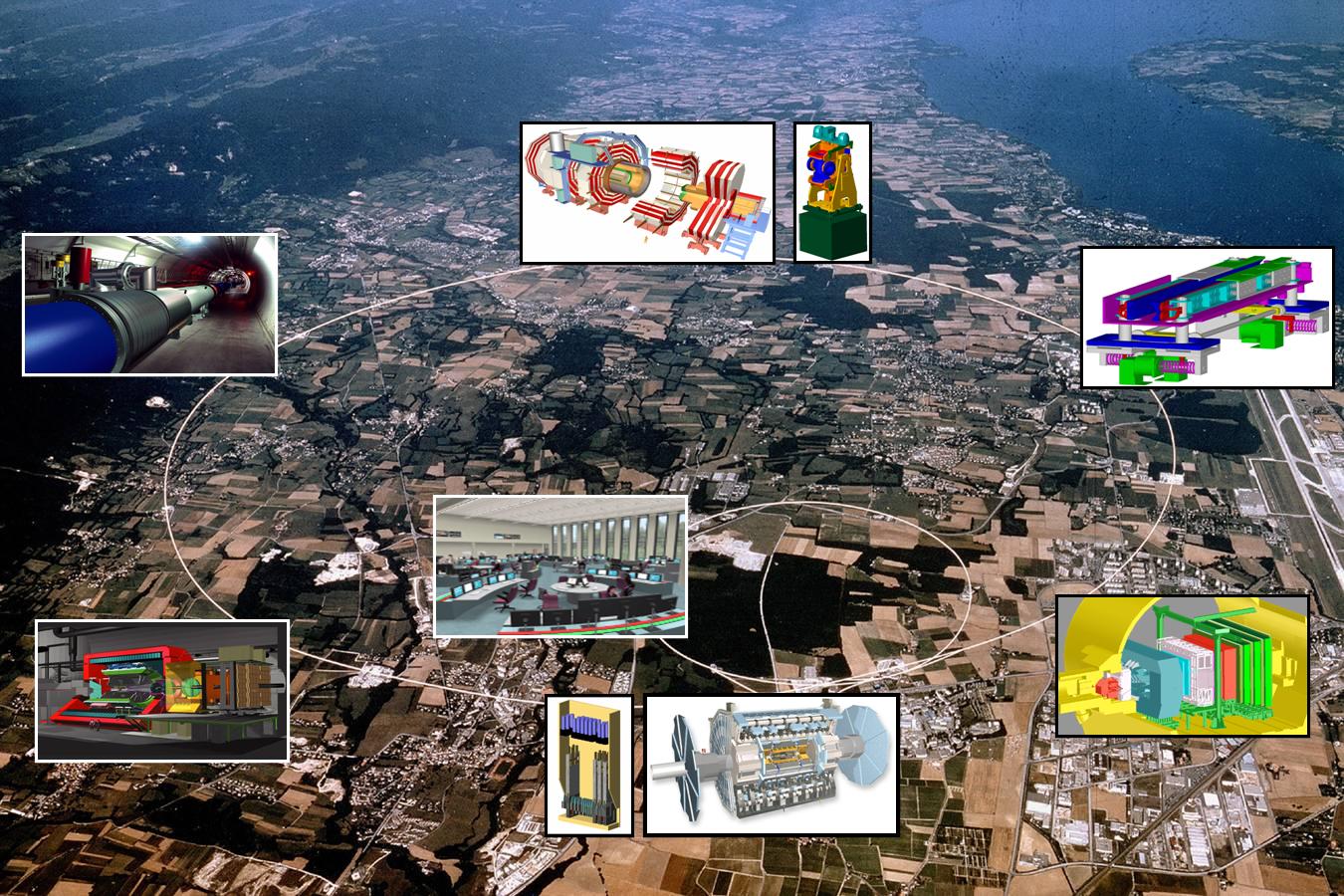

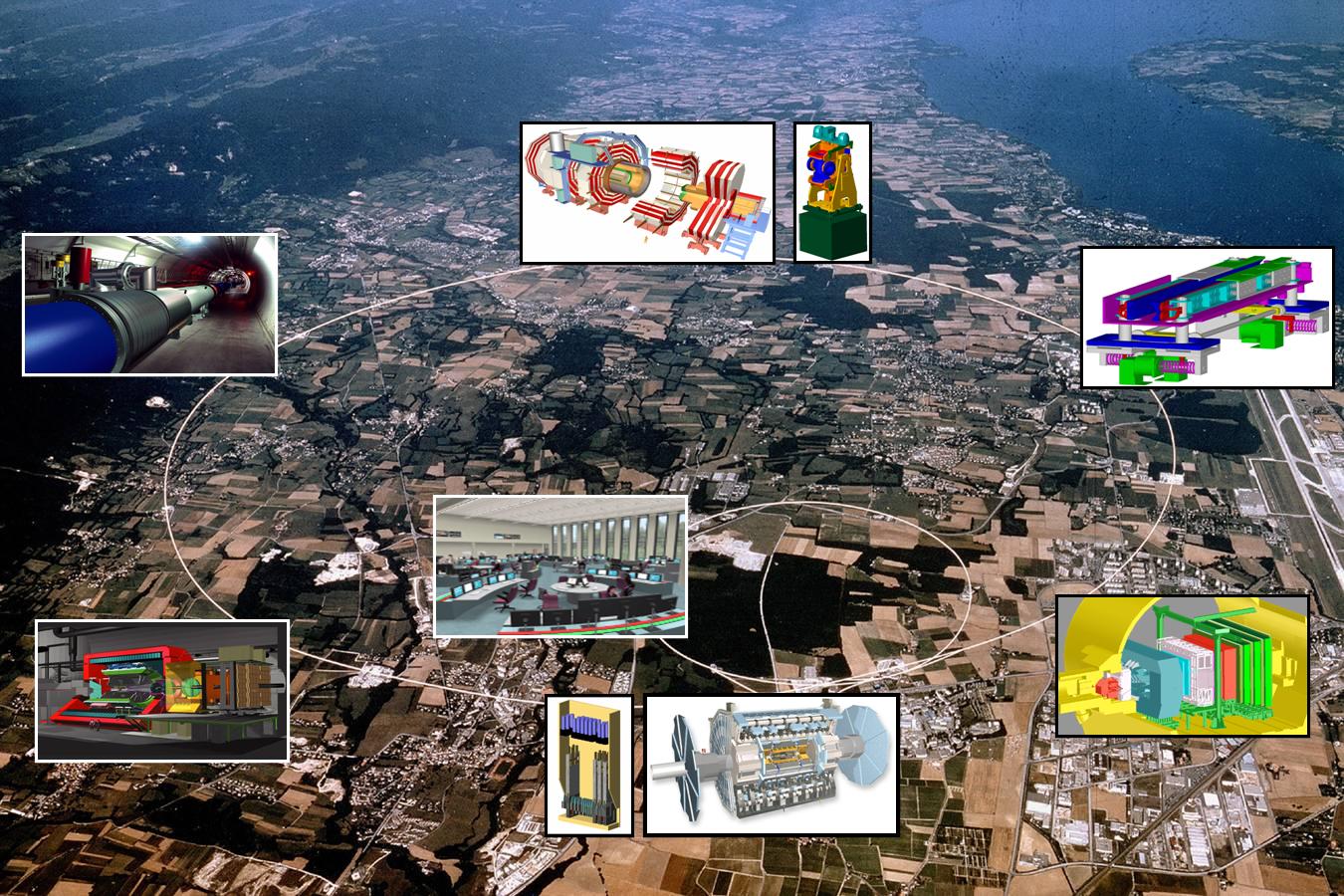

Transferencias tecnológicas del CERN a la Biomedicina

Partículas y mucho más

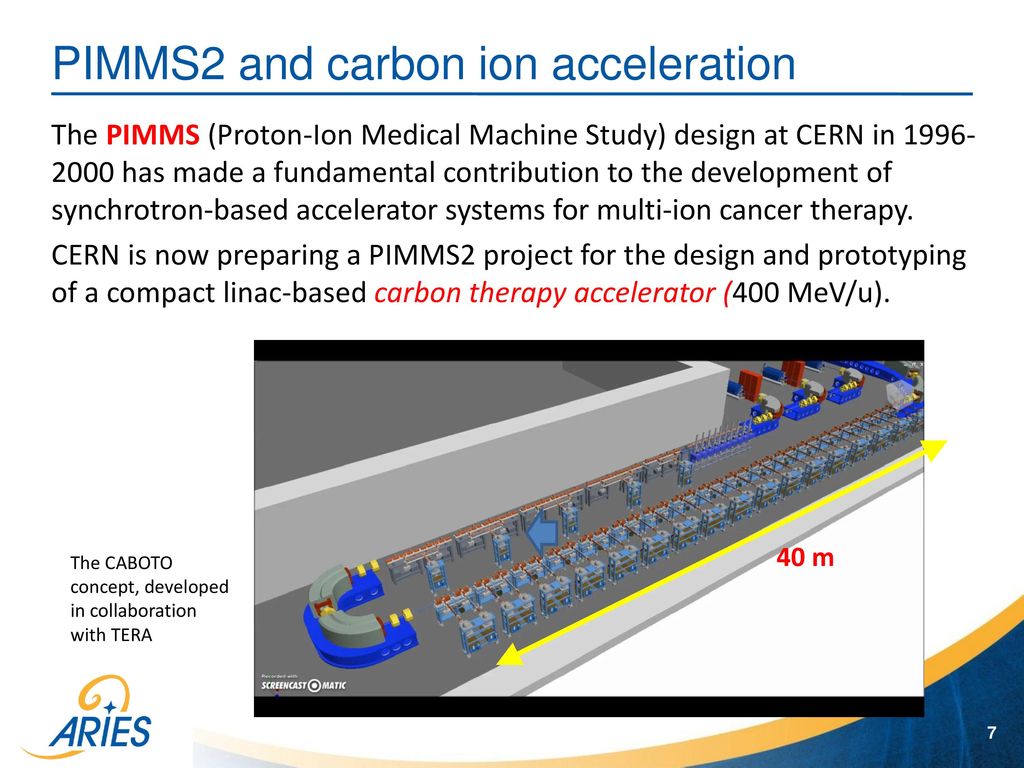

Seguramente la mayoría de los lectores de la Revista Española de Física han oído más de una vez hablar del CERN. Fundado en 1954, constituye el mayor laboratorio de física de partículas del mundo, con veinte países miembros y un personal de unas 3.000 personas entre físicos, ingenieros y personal técnico y administrativo de todo tipo. Seguramente están también al tanto de los grandes experimentos que se están preparando en este centro como el Large Hadron Collider (LHC), situado en un túnel circular de 27 km de longitud, destinado a elucidar el origen de la llamada ruptura de la simetría electrodébil y en última instancia el origen de las masas de las partículas elementales (no de la masa del protón o del neutrón como erróneamente se dice a veces en los medios de comunicación), o del proyecto CERN Neutrino Gran Sasso (CNGS), que consiste en enviar un haz de neutrinos de alta energía desde el CERN al laboratorio subterráneo italiano del Gran Sasso que se encuentra a 730 km, para estudiar las oscilaciones de estas huidizas partículas.

También es muy probable que muchos lectores asocien de manera natural la palabra acelerador de partículas a los instrumentos que utilizan los físicos modernos para estudiar y comprender mejor la estructura y el comportamiento de la materia a pequeñas escalas. Sin embargo, de los 17.000 aceleradores de partículas que se estima existen en la actualidad en todo el mundo, aproximadamente la mitad de ellos se usan en medicina y sólo una parte muy pequeña se usan para investigación fundamental. Por este y otros motivos que se discutirán más adelante, en este número especial de la Revista Española de Física dedicado a la física y las ciencias de la vida, ha parecido conveniente incluir un artículo en el que, al menos brevemente, se describieran algunas de las transferencias tecnológicas (spinoffs) importantes que la actividad del CERN aporta a dichas ciencias.

Mucho de lo que aquí se descubre, se aplica a nuestra Salud

Es bastante razonable que, como ocurre con las ciencias del espacio, mucha gente se pregunte cuál es la utilidad social de la física de partículas más allá de la adquisición de conocimientos fundamentales de la naturaleza. Sin embargo, es preciso señalar que los aceleradores y detectores de partículas del CERN y otros laboratorios similares requieren el uso, y muchas veces el desarrollo, de tecnologías de punta que obligan a una estrecha colaboración con la industria que redunda en beneficio de ambas partes. Las transferencias tecnológicas que se producen en este proceso se incorporan inmediatamente a nuestra vida diaria en áreas tales como la electrónica, procesamiento industrial y médico de imágenes, manejo y usos de la radiación , metrología, nuevos materiales, tecnologías de la computación y la información, tratamiento del cáncer, etc. En este artículo se pondrá el énfasis en aquellas actividades del CERN que han redundado de una forma más clara en beneficio de las ciencias biomédicas.

PET/TC o más allá de los rayos X

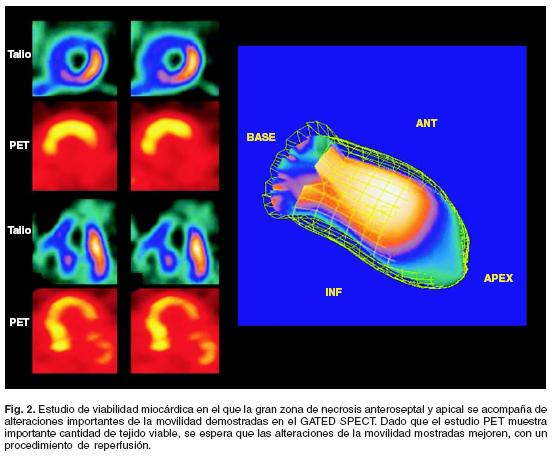

En el ámbito de la medicina los aceleradores de partículas se utilizan con dos finalidades; una para la formación de imágenes con propósitos diagnósticos y otra, para terapia, principalmente oncológica. Desde el descubrimiento de los rayos X por Röntgen en 1895, este tipo de radiación electromagnética ha proporcionado una información de valor incalculable y aún sigue proporcionándola. Sin embargo, mucho más recientemente, se han desarrollado otras técnicas complementarias de diagnóstico basadas en los llamados radiofármacos. Estas sustancias radiactivas presentan idealmente la propiedad de poder ser inyectadas en el organismo humano de forma segura y de fijarse exclusivamente a determinados tejidos. Posteriormente, a medida que van desintegrándose, emiten ciertas partículas que pueden ser detectadas y analizadas produciendo de esta forma imágenes estáticas o incluso dinámicas de los órganos en los que se depositaron los radiofármacos y, en definitiva, proporcionando información no solamente sobre la morfología de aquellos, sino también, en muchos casos, sobre su función y metabolismo.Los radiofármacos se producen utilizando haces de protones de alta intensidad y, como tienen una vida media muy baja, deben utilizarse cerca de donde se han creado. Se calcula que unos 20 millones de personas son diagnosticadas cada año mediante el uso de este tipo de sustancias.

Son técnicas no invasivas que dejan al descubierto lo que interesa ver y eliminar.

Una de las técnicas de este tipo más utilizada en la actualidad es la Positron Emission Tomography (PET). En su aplicación se utiliza normalmente un ciclotrón para irradiar alguna sustancia que se convierte en radiactiva por desintegración beta positiva (emisora de positrones). Esta sustancia se une por ejemplo a la glucosa y se inyecta al paciente. Los positrones producidos se aniquilan con los electrones circundantes dando lugar a dos fotones de energía muy bien definida, emitidos en direcciones opuestas. Estos fotonesinteraccionan con un material escintilador dando lugar a la emisión de otros fotones que pueden ser detectados por fotomultiplicadores o fotodiodos para formar la imagen de los tejidos que se pretenden estudiar en función de la distribución de la glucosa radiactiva. Por ejemplo, en el caso del diagnóstico del cáncer las células cancerosas suelen consumir más glucosa que las células sanas debido a su mayor vascularización y a su mayor actividad metabólica y reproductiva, produciendo por tanto una mayor emisión de fotones. Por el contrario, las zonas donde el tejido presente mayor número de células muertas brillarán menos debido a la menor concentración de glucosa radioactiva, lo cual puede ser muy útil para el diagnóstico de infartos y otras lesiones.

Tecnologías que llegan más allá

De acuerdo con David Townsend, uno de los pioneros en el desarrollo de la tecnología PET, aunque ésta no fue inventada en el CERN, una cantidad esencial e inicial de trabajo desarrollado en el CERN a partir de 1977 contribuyó de forma significativa al desarrollo del PET 3D. La tecnología PET alcanza su grado más alto de utilidad diagnóstica cuando se combina con la Computed Tomography (CT). La CT es un método de formación de imágenes tridimensionales a partir del procesamiento digital de un gran número de imágenes bidimensionales de rayos X. Inicialmente, las diferentes imágenes se obtenían alrededor de un solo eje de rotación y de ahí su nombre original de Computed Axial Tomography (CAT).

La técnica combinada PET/CT es uno de los desarrollos más excitantes de la medicina nuclear y la radiología modernas. Las reconstrucciones de imágenes CT permiten el diagnóstico precoz de tumores basándose en sus características morfológicas, mientras que la tecnología PET es capaz de diferenciar con grane eficiencia los tejidos malignos de los benignos. La fusión PET/CT permite ahora integrar las imágenes morfológica y fisiológica en una única imagen. El prototipo del scanner ART, el Partial Ring Tomograph (PRT), fue desarrollado en el CERN en 1980 y 1990 por David Townsend, Martín Wensveen y Henri Tochon-Danguy, y evaluado clínicamente en el departamento de medicina nuclear del Hospital Cantonal de Ginebra. ART puede considerarse como el precursor de la parte PET del moderno scanner PET/CT, que ha producido un impacto extraordinario en la tecnología de imágenes con fines médicos. Además, el CERN continua hoy en día contribuyendo a este campo fundamental de la medicina moderna mediante proyectos como Clear PET, Clear PEM, HPD PET etc.

Sin embargo, la importancia del CERN en el desarrollo de las tecnologías PET o CT, y en general de todo tipo de scanner, va mucho más allá. En efecto, todo este tipo de dispositivos se basa, de una forma u otra, en los detectores desarrollados a finales de los sesenta en el CERN por George Charpak. Su trabajo fue reconocido en 1992 con la concesión del Premio Nobel de Física por su invención y desarrollo de detectores de partículas, en particular de la cámara proporcional multihilos, que produjo una revolución en la técnica de exploración de las partes más íntimas de la materia. Los detectores desarrollados por Charpak se usan aún para todo tipo de investigaciones médicas y biológicas y podrían eventualmente sustituir completamente a las placas fotográficas en la radio-biología aplicada. La velocidad creciente con la que permiten registrar las imágenes en radio medicina conducen a una menor tiempo de exposición y a menores dosis de radiación indeseada recibida por los pacientes.

Hadronterapia, o las partículas contra el cáncer

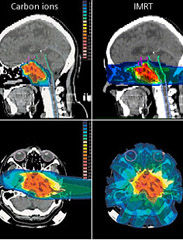

Como es bien sabido, una de las herramientas terapéuticas esenciales en el campo de la oncología es la radioterapia. Dicho tratamiento se aplica hoy en día aproximadamente a la mitad de los pacientes de cáncer. En cierto modo se puede considerar como una forma sutil de cirugía donde el bisturí es reemplazado por un haz colimado de partículas capaz de esterilizar las células malignas mediante la inactivación de su ADN, impidiendo así su reproducción. Tradicionalmente, la radioterapia se ha basado en el uso de rayos X (fotones), electrones y, más recientemente, hadrones, es decir, partículas capaces de interaccionar fuerte o nuclearmente, si bien no es ésta la propiedad más interesante de estas partículas para las aplicaciones radioterapeúticas. Los haces de rayos X y los electrones se obtienen normalmente a partir de aceleradores lineales como los del CERN, aunque mucho más pequeños, y se apuntan hacia los tumores con la energía, dirección y colimación apropiadas para optimizar su efecto destructivo sobre los mismos. Por su parte, los neutrones pierden energía en el interior del organismo de una forma diferente, lo cual les hace más indicados para el tratamiento de ciertos tipos especiales de tumores. Se obtienen a partir de las colisiones de protones, previamente acelerados en un ciclotrón, con núcleos de berilio. Este hecho hace que esta terapia sea bastante más cara que las anteriores, pero a cambio el ciclotrón puede ser usado también para la producción de radiofármacos.

Cintíficos del CERN aplican antimateria contra el Cáncer

El estudio de las posibilidades de utilización de haces de hadrones en la terapia del cáncer tuvo su origen en el trabajo seminal de R.R Wilson titulado Radiological Use of Fast Protons (Radiology 47, 1946). En dicho artículo se ponía de manifiesto que los protones, así como otras partículas cargadas pesadas, presentan la propiedad única de que al penetrar en el cuerpo humano depositan la mayor parte de su energía a una preofundidad que depende de su energía inicial. Este hecho permite seleccionar cuidadosamente el área que se quiere irradiar, preservando de dicha radiación al tejido sano que pudiera encontrarse a menor profundidad. Además, como las partículas se detienen a una distancia de la superficie bien definida por la energía del haz, tampoco resultarían dañadas las células situadas detrás del blanco seleccionado.

Sin embargo, la importancia del CERN en el desarrollo de las tecnologías PET o CT, y en general de todo tipo de scanner, va mucho más allá.

En contraste, la energía depositada por los rayos X alcanza su máximo cerca de la superficie de entrada y decae exponencialmente hasta que abandona el cuerpo humano en el lado opuesto, haciendo por tanto muy difícil seleccionar la zona que quiere irradiarse sin dañar otras áreas de células sanas. El trabajo de Wilson de 1946 condujo a toda una nueva línea de investigación experimental, principalmente en el Lawrence Berkeley Laboratory, que ha dado lugar al desarrollo de una nueva clase de terapias antitumorales basadas en la irradiación con protones y más recientemente con iones de carbono. Estas técnicas han sido aplicadas en más de 40 centros de todo el mundo, y de ellas se han beneficiado hasta la fecha más de 50.000 pacientes. No obstante, continúan investigándose nuevas formas de intentar mejorar el ratio entre la energía depositada en las células tumorales y en el tejido sano.

En la actualidad, el CERN se encuentra involucrado en diversos proyectos relacionados con la hadronterapia. Por ejemplo, en el diseño de un acelerador de protones e iones de carbono dedicado exclusivamente a usos médicos conocido como Proton Ion Medical Machine Study (PIMMS). Otro proyecto interesante es la realización de las pruebas del Linear Booster ( LIBO), capaz de acelerar una haz de protones hasta 200 Mev (los hospitales habiualmente utilizan energías en torno a los 65 MeV) y que estaría especializado en el tartamiento de tumores profundos.

Finalmente, y situándonos en un plano de investigación a un nivel más básico, es interesante señalar que en octubre de 2006 se presentaron los primeros resultados de un experimento llevado a cabo en el CERN con potencial para futuras aplicaciones en la terapia del cáncer. Se trataba del Antiproton Cell Experiment (ACE), que constituye la primera investigación realizada hasta la fecha sobre efectos biológicos de los antiprotones. Los antiprotones se comportan como los protones cuando entran en el organismo, pero generan mucha más energía en el blanco seleccionado debido a du aniquilación con los protones existentes en los núcleos de los átomos de las células, y además depositan esta energía de una forma biológicamente más efectiva.

Se busca antimateria contra el Cáncer. Los resultados muestran que los antiprotones son cuatro veces más efectivos que los protones para destruir células vivas. (Foto: Especial CERN )

Evaluando la fracción de células supervivientes después de la irradiación con el haz de antiprotones, el experimento ACE ha encontrado que a eficiencia de éstos es unas cuatro veces mayor que la de los protones, mientras que el daño producido a las células situadas antes del blanco era básicamente el mismo. De acuerdo con Michael Holzscheiter, portavoz del experimento ACE, este hecho podría ser extremadamente importante para el tratamiento de casos de cáncer recurrente, donde este tipo de propiedad es vital. La tecnología desarrollada previamente en el CERN para la obtención de haces de antiprotones de buena calidad a la energía apropiada es esencial para este prometedor experimento, que difícilmente podría haberse realizado en ningún otro laboratorio. Éste es por tanto un magnífico ejemplo de cómo la investigación en física de partículas desarrollada en el CERN puede generar soluciones innovadores con excelentes beneficios médicos potenciales.

Los investigadores de ACE, en colaboración con otras instituciones de todo el mundo, están realizando en la actualidad nuevos tests para comprobar la eficacia de este método en el caso de tumores situados a mayor profundidad, y comparando sus resultados con los de otros métodos más convencionales como la irradiación mediante iones de carbono. Si todo sale como se espera, los beneficios clínicos de esta nueva técnica podrían empezar a producirse dentro de la próxima década.

Otro ejemplo importante de tecnología creada en el CERN con aplicaciones a la terapia del cáncer es el Neutron Driven Element Trasmuter. Se trata de un sistema de producción de radioisótopos específicos específicos a partir de un acelerador de protones cuyo desarrollo fue liderado por Carlo Rubbia, Premio Nobel de Física en 1984 por el descubrimiento de los bosones W y Z y ex director general del CERN. La idea es utilizar el haz de protones para producir neutrones los cuales provocan reacciones en un ambiente apropiado donde ciertos elementos son convertidos en los isótopos deseados.

La diferencia principal entre este método, seguro y barato, y el método más tradicional de utilizar los neutrones provenientes de un reactor nuclear, es que no requiere el uso de material fisionable ni funciona críticamente, es decir las reacciones se detienen en el momento en el que el acelerador es apagado. Más aún, el método tiene la ventaja de que sólo se producen los isótopos requeridos, lo que redunda en una importante reducción de impacto ambiental. Normalmente, el blanco utilizado es plomo, elemento idóneo por presentar el menor ritmo de captura de neutrones. Los neutrones se producen por espalación a partir del haz de protones y permanecen en el interior del blanco de plomo, que está rodeado de un deflector de grafito, hasta que su espectro se suaviza suficientemente para cubrir un gran rango de energías que permiten su utilización para la transmutación de los elementos necesarios para la obtención de los isótopos deseados.

El Neutron Driven Element Trasmuter ha permitido, entre otras cosas, la producción de radioisótopos beta emisores como el 166Ho, 186 Re o el 188Re que son de gran importancia en braquiterapia. Dicha técnica, muy utilizada en el tratamiento de cánceres ginecológicos y en el de cáncer de próstata, es un tipo de radioterapia de proximidad donde la fuente radiactiva se sitúa dentro o muy cerca de los tejidos que requieren irradiación. Típicamente, la fuente radiactiva, de alta actividad y corta vida media, se encapsula en una semilla, filamento o tubo y se implanta en quirófano en la zona deseada. Las diferentes dosis requeridas en cada caso hacen que sea fundamental disponer del mayor muestrario posible de radioisótopos con la actividad y vida media apropiadas, lo cual convierte al Neutron Driven Element Trasmuter en una herramienta valiosísima para el futuro de este tipo de técnica terapéutica.

Información y computación sin fronteras

CERN, … where the web was born; éste es uno de los reclamos publicitarios que suelen utilizarse para hacer ver al público la importancia de los retornos tecnológicos que en este laboratorio tienen lugar. Y en efecto, fue a finales de los ochenta cuando Tim Berners-Lee desarrolló estándar de Hyper Text Transfer Protocol (HTTP) e implementó los primeros servidores web en el CERN. Su esfuerzo permitió la comunicación fácil y segura y el intercambio de todo tipo de información entre todos los ordenadores del mundo conectados a internet, dando lugar de esta forma a una de las revoluciones tecnológicas más importantes de las últimas décadas. Las repercusiones científicas, tecnológicas, culturales, comerciales y de ocio de la web son ya tan conocidas que apenas merecen comentario alguno.

El término Grid fue acuñado por Ian Foster and Carl Kesselman en su libro The Grid, Blueprint for new Computing Infraestructure (Morgan Kaufman, 1998), aunque las ideas básicas habían sido consideradas con anterioridad. No existe un acuerdo general sobre cual debería ser la definición precisa de las tecnologías Grid, pero hay un amplio concenso en que esta debería contener elementos tales como recursos compartidos, virtualización, abstracción del acceso a los recursos y estandarización. La filosofía Grid consistiría, no sólo en compartir información entre diferentes usuarios, sino también recursos, como por ejemplo, procesadores, tiempo de CPU, unidades de almacenamiento, así como otros aparatos e instrumentos, de tal forma que eventualmente cada usuario tendría acceso virtual, por ejemplo, a la capacidad de cálculo de todos los demás usuarios de esa Grid. En los primeros tiempos de esta tecnología de la información se llegó a hablar de la Grid, refiriéndose a la posibilidad de existencia de una única World Wide Grid.

Todo surgió del CERN

Hasta el momento,, sin embargo, este concepto no es una realidad y más bien lo que se encuentra es que diferentes grupos de proyectos crean su propia Grid usando sus propias implementaciones, estándares y protocolos y dando acceso restringido solamente a una cierta comunidad de usuarios autorizados. Así, aunque se siguen realizando importantes esfuerzos en cuanto a la estandarización de los protocolos, no está claro cual será el camino que este tipo de tecnología seguirá en el futuro en lo que se refiere a la futura existencia de un única Grid.

En cualquier caso es importante resaltar que una vez más el CERN ha sido pionero en este tipo de tecnología. Los detectores que se están instalando (a estas alturas, todos instalados y en marcha) en el LHC (ATLAS, CMS, ALICE, LHCb, SUSY, etc.), son tan complejos, que han requerido cada uno de ellos el concurso de muchas instituciones de todo el mundo para su construcción, y lo seguirán requiriendo para su mantenimiento cuando el acelerador empiece a funcionar (ya está en marcha), y, como no, para el análisis de los datos que se obtengan. Para hacerse una idea de la dimensión y complejidad de estos análisis baste mencionar que el compact Muon Selenoid (CMS), una vez pasado su primer filtro, deberá almacenar información sobre el resultado de las colisiones producidas en su interior a un ritmo del orden de 100 a 200 MB por segundo durante un tiempo esperado de unos cien días por año. Resulta obvio que sólo una tecnología tipo Grid puede afrontar con posibilidades de éxito un reto semejante y de hecho el CERN ha inspirado varios proyectos Grid multinacionales por este motivo. Posiblemente, el más grande de ellos hasta la fecha sea el EGEE (Enablinbg Grids for E-Science), que conecta más de 150 paises y ofrece 20 000 CPUs y más de 10 Petabytes de memoria.

De manera análoga a como ocurrió con las tecnologías de la detección y aceleración, las tecnologías Grid tendrán, y de hecho ya empiezan a tener, un fuerte impacto en las ciencias de la vida y de la salud. En este sentido, uno de los campos obvios de aplicación es la bioinformática. Gracias a los espectaculares avances llevados a cabo en los últimos años en el campo de la biología molecular, se dispone hoy en día de cantidades crecientes de información genética de diferentes especies e individuos. Dicha información codificada en el ADN en forma de secuencia de tripletes o codones de ácidos nucleicos, que constituyen los genes que contienen la estructura primaria de las diferentes proteínas, ha sido y está siendo obtenida por centenares de grupos diferentes distribuidos por todo el mundo y debe almacenarse en gigantescas bases de datos de forma eficiente para su compartición, contrastación y análisis.

Ejemplos típicos serían la búsqueda de determinadas secuencias, comparaciones, búsqueda de determinadas mutaciones o alelos, etc. Resulta evidente que esta ingente labor puede verse enormemente beneficiada por el uso de tecnologías Grid. De hecho, la Bioinformática, y en particular sus aplicaciones biomédicas, han sido una parte importante del proyecto EGEE desde el comienzo del mismo.

Finalmente, y como última muestra de cómo puede revertir en la sociedad las tecnologías de la información y la computación provenientes de la física de partículas, es interesante mencionar el Proyecto Mammogrid y su continuación Mammogrid Plus. Liderado por el CERN, dicho proyecto de la UE utiliza la tecnología Grid para crear una base de datos de mamografías que pueda ser usada para investigar un gran conjunto de datos e imágenes que, aparte de otras aplicaciones sanitarias, sea útil para estudiar el potencial de esta tecnología para servir de soporte a la colaboración entre los profesionales de la salud de la UE.

Ciencia, Tecnología y Sociedad

A estas alturas debería haber quedado claro que los centros científicos de élite internacionales como el CERN, no sólo nos proporcionan un conocimiento más profundo de la naturaleza, sino que las tecnologías de punta que en ellos se desarrollan acaban permeando a la Sociedad y se incorporan a nuestras vidas cotidianas. El autor del artículo, Antonio Dobado, del Departamento de Física Teórica I de la Universidad Complutense de Madrid, ha pretendido ilustrar el hecho innegable de la conexión existente entre temas tan aparentemente dispares como el de la Física de Partículas y la Biomedicina, pero ejemplos semejantes podrían haberse encontrado en prácticamente cualquier área de la actividad humana.

La Sociedad no puede permanecer por más tiempo ajena a la Ciencia y a todo lo que trae consigo. Precisamente por eso la RSEF dedica un gran esfuerzo a la difícil tarea de convencer al público de la importancia de la Física como valor científico, cultural y social, como una forma rigurosa y profunda del acercamiento al conocimiento de la naturaleza, y a la vez como generadora de nuevas tecnologías. En este sentido, es una espléndida noticia la inminente creación de un nuevo Grupo especializado en el seno de la RSEF denominado Física Médica. Y, desde aquí, aprovechamos la oportunidad para darles la bienvenida y desearles el mayor éxito en sus futuras andaduras en la búsqueda de la verdad científica.

Fuente: Revista Española de FÍSICA.

Publicada por la RSEF con el Nº 3 Volumen 21 de 2007

La presente transcripción es de: Emilio Silvera

Miembro numerario de la RSEF y adscrito a los Grupos Especializados de Física Teórica y Astrofísica.

May

22

¿Qué habrá más allá del Modelo Estándar de la Física de Partículas?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

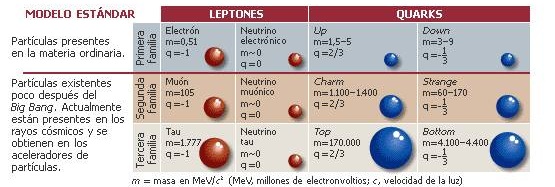

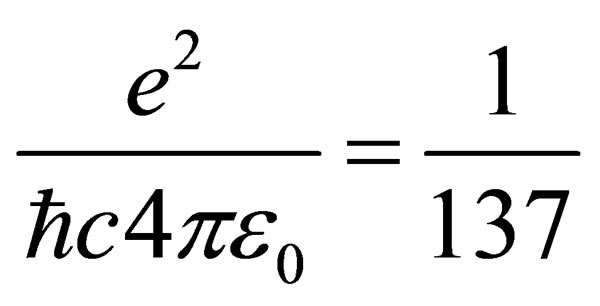

“Inicialmente, se presenta, de modo simplificado, el Modelo Estándar como una teoría sofisticada que identifica las partículas elementales y sus interacciones. Después, en el ámbito de esa teoría, se enfocan aspectos –el vacuo no es vacío; partículas desnudas y vestidas; materia oscura y viento oscuro; materia y antimateria; el campo y el bosón de Higgs; neutrinos oscilantes– que pueden ser motivadores desde el punto de vista de la enseñanza y del aprendizaje de la Física. Finalmente, se discute la probable superación de esa teoría por otra más completa.”

“… el Modelo Estándar es, en la historia, la más sofisticada teoría matemática sobre la naturaleza. A pesar de la palabra “modelo” en su nombre, el Modelo Estándar es una teoría comprensiva que identifica las partículas básicas y especifica cómo interactúan. Todo lo que pasa en nuestro mundo (excepto los efectos de la gravedad) es resultado de las partículas del Modelo Estándar interactuando de acuerdo con sus reglas y ecuaciones.”

“La teoría de cuerdas es un intento por unificar estos dos mundos en un modelo matemático que funcione en todas las escalas. Pero ocurrió algo no muy deseable. En un breve espacio de tiempo surgieron 5 versiones distintas del modelo, lo que le restó credibilidad. La Teoría-M es una nueva proposición postulada por Edward Witten que unifica esas cinco teorías de las Supercuerdas. Cada una de las versiones de la teoría de cuerdas serían una proyección del del modelo M, del mismo modo que un cilindro proyecta sombras de diferentes formas dependiendo de la dirección de la luz (perdiendo una dimensión).”

La Física actual busca una teoría más amplia que el modelo estándar . Una teoría que dé una descripción completa, unificada y consistente de la estructura fundamental del universo. ¿Será la compleja Teoría de cuerdas,que integra también la interacción gravitatoria?

El modelo estándar es una poderosa herramienta pero no cumple todas las expectativas; no es un modelo perfecto. En primer lugar, podríamos empezar por criticar que el modelo tiene casi veinte constantes que no se pueden calcular. Desde luego, se han sugerido numerosas ideas para explicar el origen de todos estos parámetros o números inexplicables y sus valores, pero el problema de todas estas teorías es que los argumentos que dan nunca han sido enteramente convincentes. ¿Por qué se iba a preocupar la naturaleza de una fórmula mágica si en ausencia de tal fórmula no hubiera contradicciones? Lo que realmente necesitamos es algún principio fundamental nuevo, tal como el principio de la relatividad, pero no queremos abandonar todos los demás principios que ya conocemos. Ésos, después de todo, han sido enormemente útiles en el descubrimiento del modelo estándar. El mejor lugar para buscar un nuevo principio es precisamente donde se encuentran los puntos débiles de la presente teoría y, construímos máquinas como el LHC para que nos diga lo que no sabemos.

Solo en máquinas inmensas se puede llegar a desentrañar los secretos de la materia

Una regla universal en la física de partículas es que para partículas con energías cada vez mayores, los efectos de las colisiones están determinados por estructuras cada vez más pequeñas en el espacio y en el tiempo. El modelo estándar es una construcción matemática que predice sin ambigüedad cómo debe ser el mundo de las estructuras aún más pequeñas. Pero existen varias razones para sospechar que sus predicciones pueden, finalmente (cuando podamos emplear más energía en un nivel más alto), resultar equivocadas.

Vistas a través del microscopio, las constantes de la naturaleza parecen estar cuidadosamente ajustadas sin ninguna otra razón aparente que hacer que las partículas parezcan lo que son. Hay algo muy erróneo aquí. Desde un punto de vista matemático no hay nada que objetar, pero la credibilidad del modelo estándar se desploma cuando se mira a escalas de tiempo y longitud extremadamente pequeñas, o lo que es lo mismo, si calculamos lo que pasaría cuando las partículas colisionan con energías extremadamente altas. ¿Y por qué debería ser el modelo válido hasta aquí? Podrían existir muchas clases de partículas súper pesadas que no han nacido porque se necesitan energías aún inalcanzables. ¿Dónde está la partícula de Higgs? ¿Cómo se esconde de nosotros el gravitón?

Parece que el Modelo estándar no admite la cuarta fuerza y tendremos que buscar más profundamente, en otras teorías que nos hablen y describan además de las partículas conocidas de otras nuevas que están por nacer y que no excluya la Gravedad. Ese es el Modelo que necesitamos para conocer mejor la Naturaleza.

Claro que las cosas no son tan sencilla y si deseamos evitar la necesidad de un delicado ajuste de las constantes de la naturaleza, creamos un nuevo problema: ¿cómo podemos modificar el modelo estándar de tal manera que el ajuste fino no sea necesario? Está claro que las modificaciones son necesarias, lo que implica que muy probablemente haya un límite más allá del cual el modelo tal como está deja de ser válido. El modelo estándar no será nada más que una aproximación matemática que hemos sido capaces de crear, de forma que todos los fenómenos que hemos observado hasta el presente están reflejados en él, pero cada vez que se pone en marcha un aparato más poderoso, tenemos que estar dispuestos a admitir que puedan ser necesarias algunas modificaciones del modelo para incluir nuevos datos que antes ignorábamos.

Más allá del modelo estándar habrá otras respuestas que nos lleven a poder hacer otras preguntas que en este momento, no sabemos ni plantear por falta de conocimientos. Si no conociéramos que los protonesestán formados por Quarks, ¿cómo nos podríamos preguntar si habrá algo más allá de los Quarks?

El gobierno de Estados Unidos, después de llevar gastados miles de millones de dólares, suspendió la construcción del supercolisionador superconductor de partículas asestando un duro golpe a la física de altas energías, y se esfumó la oportunidad para obtener nuevos datos de vital importancia para el avance de este modelo, que de momento es lo mejor que tenemos.

Se han estado inventando nuevas ideas, como la supersimetría y el technicolor. Los astrofísicos estarán interesados en tales ideas porque predicen una gran cantidad de nuevas partículas superpesadas, y también varios tipos de partículas que interaccionan ultradébilmente, los technipiones. Éstas podrían ser las WIMP’s (Weakly Interacting Massive Particles, o Partículas Masivas Débilmente Interactivas) que pueblan los huecos entre las galaxias, y serían así las responsables de la masa perdida que los astrofísicos siguen buscando y llaman “materia oscura”.

Que aparezcan “cosas” nuevas y además, imaginarlas antes, no es fácil. Recordemos cómo Paul Dirac se sintió muy incómodo cuando en 1931 dedujo, a partir de su ecuación del electrón, que debería existir una partícula con carga eléctrica opuesta. Esa partícula no había sido descubierta y le daba reparo perturbar la paz reinante en la comunidad científica con una idea tan revolucionaria, así que disfrazó un poco la noticia: “Quizá esta partícula cargada positivamente, tan extraña, sea simplemente el protón”, sugirió. Cuando poco después se identificó la auténtica antipartícula del electrón (el positrón) se sorprendió tanto que exclamó: “¡Mi ecuación es más inteligente que su inventor!”. Este último comentario es para poner un ejemplo de cómo los físicos trabajan y buscan caminos matemáticos mediante ecuaciones de las que, en cualquier momento (si están bien planteadas), surgen nuevas ideas y descubrimientos que ni se podían pensar. Así pasó también con las ecuaciones de Einstein de la relatividad general, donde Schwarzschild dedujo la existencia de los agujeros negros.

Se piensa que al principio del comienzo del tiempo, cuando surgió el Big Bang, las energías eran tan altas que allí reinaba la simetría total; sólo había una sola fuerza que todo lo englobaba. Más tarde, a medida que el universo se fue expandiendo y enfriando, surgieron las cuatro fuerzas que ahora conocemos y que todo lo rigen. Tenemos los medios, en los supercolisionadores de partículas, para viajar comenzando por 1.000 MeV, hasta finalizar en cerca de 1019 MeV, que corresponde a una escala de longitudes de aproximadamente 10–30 cm. Howard Georgi, Helen Quinn y Steven Weinberg descubrieron que ésta es la región donde las tres constantes de acoplamiento gauge se hacen iguales (U(1), SU(2) y SU(3)); resultan ser lo mismo. ¿Es una coincidencia que las tres se hagan iguales simultáneamente? ¿Es también una coincidencia que esto suceda precisamente en esa escala de longitud? Faltan sólo tres ceros más para alcanzar un punto de retorno. Howard Georgi y Sheldon Glashow descubrieron un modelo genuinamente unificado en el dominio de energías de 1019 MeV tal que, cuando se regresa de allí, espontáneamente surgen las tres fuerzas gauge tal como las conocemos. De hecho, ellos encontraron el modelo; la fórmula sería SU(5), que significa que el multiplote más pequeño debe tener cinco miembros.

Materia y Energía Oscura… Un Misterio…Sin resolver.

Y, a todo esto, ¿dónde está esa energía oculta? ¿Y donde la materia? Podemos suponer que la primera materia que se creo en el Universo fue la que llamamos (algún nom,bre había que ponerle) “Materia Oscura”, esa clase de Ilem o sustancia primera del Universo que mejor sería llamarla invisible, ya que, de no ser así, difícil sería explicar cómo se pudieron formar las primeras estrellas y galaxias de nuestro Universo, ¿dónde está el origen de la fuerza de Gravedad que lo hizo posible, sino en esa materia escondida?

¡Lo dicho! Necesitamos saber, y, deseo que de una vez por todas, se cumpla lo que dejó dicho Hilbert en su tumba de Gotinga (Alemania): “Tenemos que saber, ¡sabremos!. Pero…

¡Que sea pronto!

emilio silvera