Situación de los continentes a finales del Cretácico. El cráter de Chicxulub está señalado en el centro de la imagen. Los fantásticos dinasaurios que, si no tuviéramos la evidencia fósil

La teoría más extendida de todas las que intentan explicar la extinción del 65% de las especies que habitaban la Tierra hace 65 millones de años, se refiere al impacto de un gran meteorito en Chicxulub que formó un cráter de 180 kilómetros de diámetro. La prueba esgrimida como definitiva fue el hallazgo de esférulas derivadas del impacto inmediatamente debajo del límite estratigráfico entre el Cretácico y el Terciario, junto con la detección de una anomalía de iridio coincidente con la extinción masiva de foraminíferos marinos, y el descubrimiento y datación del propio cráter de Chicxulub.

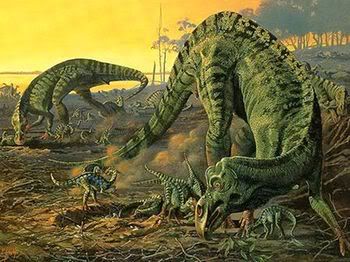

Pero para entender de qué hablamos señalemos cuestiones sencillas que todos entendemos como, por ejemplo, la muerte de los dinosaurios que se extinguieron (según todos los indicios) hace ahora 65 millones de años, como parte de una extinción masiva de la vida en la Tierra, algo tan claramente reflejado en el registro fósil que se utiliza para marcar el final de un período de tiempo geológico, el cretáceo, y el comienzo de otro, el terciario.

La huella dejada por aquel acontecimiento en el todo el mundo, no deja lugar a dudas para los geólogos. La señal, les habla del pasado.

Puesto que la “C” ya se ha utilizado como inicial en un contexto similar en relación con el período Cámbrico, este marcador se suele denominar Frontera K-T, con una “K” de Kreide, que es el nombre del Cretáceo en alemán. No fueron sólos los dinosaurios los que resultaron afectados (aunque por sus características son los que siempre aparecen con mayor protagonismo en el suceso). Alrededor del 70 por ciento de todas las especies que vivían en la Tierra a finales del Cretáceo habían desaparecido al principio del Terciario, lo cual nos indica que se trató realmente de una “extinción en masa” y explica por qué los geólogos y los paleontólogos utilizan la frontera K – T como un marcador importante en el registro fósil.

Dadas las dificultades que plantean unas pruebas de tiempos tan remotos, y la lentitud con la que se acumulan los estratos geológicos, todo lo que podemos decir sobre la velocidad a la que se priodujo aquella extinción es que sucedió en menos de unas pocas decenas de miles de años o en unos cien mil años; sin embargo, esto se considera un cambio brusco en relación con la escala de tiempo utilizada en geología.

La hipótesis propone que un asteroide de 15 kilómetros de diámetro impactó en algún lugar de la Tierra (después se identificó con un cráter en las inmediaciones de la península del Yucatán, el llamado cráter de Chicxulub), levantando millones de toneladas de corteza continental volatilizada a la atmósfera. Posteriormente, tras unas prospecciones petrolíferas se encontró la posible huella del evento buscado, como se puede observar en la siguiente imagen:

El impacto que creó un cráter de 180 kilómetros de diámetro ocasionó que millones de toneladas de plataforma continental fueran volatilizadas y enviadas a decenas de kilómetros de altura ocasionando una nube de polvo muy densa que persistió durante años llevando al mundo a un enfriamiento global siendo aquel el mayor invierno nuclear que ha visto la Tierra, que sepamos.

Las preguntas obvias que todo esto planteason las mismas que surgen tras un gran terremoto: ¿por qué sucedió? ¿podría suceder de nuevo? y, en ese caso, ¿cuándo? En el caso del suceso K – T, tenemos un candidato muy cualificado para que fuera el desencadenante que hizo que aquella extinción se produjera hacer 65 millones de años, en vez de suceder por ejemplo, hace 60 o 55 millones de años. Los restos de ese enorme cráter de arriba que data justo de entonces ha sido descubierto bajo lo que actualmente es la península de Jucatán, en Mejico, y por todo el mundo se ha encontrado estratos de hace 65 millones de años que contienen restos de Iridio, un metal abundante en el centro de la Tierra pero, muy escaso en la superficie, del que sabemos que es un componente de los meteoritos de cierto tipo.

Si alguno de estos cayera sobre la Tierra, la Historia se podría repetir y, en algún caso, ni sería seguro que algo vivo pudiera seguir existiendo con la caida de un enorme “monstruo” pétro venido del espacio interestelar a velocidades alucinantes que no podríamos frenar ni destruir. La Tierra, a pesar de su mucha y avanzada tecnología, no está preparada para solucionar estos problemas.

Un enorme meteoro provocó el cráter de Chicxulub, en México

No es difícil explicar por qué pudo suceder todo aquello que provocó el enorme impacto. La energía cinética contenida en tal impacto sería equivalente a la explosión de mil millones de megatoneladas de TNT y arrojaría al espacio unos detritos en forma de grandes bloques que se desplazarina siguiendo trayectorias balísticas (como las de los misiles intercontinentales) y volverían a entrar en la atmósfera por todo el globo terráqueo, difundiendo calor y aumentando la temperaturta de todas las zonas. Se produciría un efecto de calentamiento de 10 kilowatios por cada metro cuadrado de la superficie de la Tierra durante varias horas, un fenímeno que ha sido descrito gráficamente por especialistas.

A continuación, unas diminutas partículas de polvo lanzadas al interior de la parte superior de la atmósfera se extendería alrededor del todo el planeta y, combinadas con el humo de todos los incendios desencadenado por el “asado a la parrilla”, bloquearían el paso de la luz de del Sol, causando la muerte de todas las plantas que depend´çian de la fotosíntesis y congelando temporalmente el planeta.

Claro que no estamos a salvo, mirad arriba

Esta vez estuvimos cerca de nuevo

Se llama 2005 YU55 y no es la primera vez que tenemos noticias de él. Este asteroide de 400 metros de diámetro (el tamaño de un portaaviones) calificado en su día como potencialmente peligroso para la Tierra, se acercó el pasado 8 de noviembre a 324.600 kilómetros de nuestro planeta, una distancia inferior a la que está la Luna. En términos astronómicos, significa una arriesgada caricia en la cara. Observatorios de todo el mundo no perdieron detalle de la visita. En concreto, científicos de la NASA siguieron la trayectoria de la roca espacial desde radiotelescopios de Goldstone, California, y Arecibo, en Puerto Rico. Ante la sensación que causó la cercanía del cometa Elenin, la agencia espacial ha querido adelantarse a los más aprensivos: “el asteroide no ejercerá ninguna influencia sobre las placas tectónicas o la gravedad de la Tierra. No se notará efecto alguno.”

La trayectoria del 2005 YU55, descubierto en 2005 por astrónomos de la Universidad de Arizona, es bien conocida. En su punto máximo de aproximación llegará a 324.600 kilómetros de la Tierra (0,85 de la distancia a la Luna). Aunque 2005 YU55 visita regularmente la vecindad de la Tierra, Venus y Marte, debido a su trayectoria, el encuentro de 2011 fue el más cercano que esta roca espacial ha realizado durante los últimos 200 años. ¿Quién nos garantiza que la próxima vez será el viaje tan pacífico? Cualquier suceso podría variar su trauectoria con resultados funestos para nosotros.

El suceso K – T es en realidad sólo una entre cinco catástrofes similares (en la medida en que afectó en aquella época a la vida de la Tierra) a las que los geólogos denominan en conjunto “las cinco grandes” -y no es en absoluto la mayor-. Cada una de ellas se utiliza como marcadores entre períodos geológicos y todas han sucedido durante los últimos 600 millones de años. La razón por la que nos centramos en este pasado geológico relativamente reciente es que fue en esa época cuando los seres vivos desarrolloron por primera vez algunas características, tales como las conchas, que podían focilizarse fácilmente, ejando rastros que pueden reconocerse en los estratos que se estudian en la actualidad.

Antes de aquella época (durante la larga era feológica conocida como Precambrico) había florecido la vida en los océanos durante casi cuatro mil millones de años en forma de criaturas de una sola célula que no ha dejado rastro alguno al diluirse con el medio y desaparecer cualquier vestigio de su existencia. Sin embargo, hace alrededor de 600-590 millones de años, al comienzo del período geológico conocido como cámbrico, hubo una explosión de vida que dio lugar a diferentes variedades de formas multicelulares, y luego a criaturas vivas poco más evolucionadas. Obviamente, cuanto más nos acercamos a la actualidad, conocemos cada vez más sobre las pautas cambiantes de la Tierra, y el tipo de conocimiento que nos interesa aquí, que abarca grandes extinciones de vida, no empieza a verse claro hasta después de concluir el Precámbrico.

Tomándolas cronológicamente, las cinco grandes extinciones se produjeron hace unos 440 millones de años (que marcaron la frontera entre los períodos …

Tomándolas cronológicamente, las cinco grandes extinciones se produjeron hace unos 440 millones de años (que marcaron la frontera entre los períodos ordovícico y silúrico), hace 360 millones de años (entre el devónico y el carbonífero), 250 millones de años (entre el pérmico y el triásico), 215 millones de años (en la frontera entre el triásico y el jurásico) y 65 millones de años (en la frontera K – T).

Lógicamente han habido muchas otras extinciones en el registro fósil, y también se utilizan a menudo como marcadores en el “calendario geológico” -por ejemplo, la frontera entre el jurásico y el cretácico, hace 145 millones de años, se define también mediante una extinción.

Pero las cinco extinciones que hemos mencionado son las más importantes. La más espectacular de todas ellas fue el suceso que tuvo lugar hace unos 250 millones de años, al final del pérmico. Barrió al menos el 80 por ciento y muy posiblemente hasta el 95 por ciento , de todas las especies que vivían en nuestro planeta en aquellos tiempos, tanto en la Tierra como en los océanos, y lo hizo durante un intervalo de menos de 10.000 años. En conjunto se calcula que más de un tercio de todas las especies que han vivido siempre en la Tierra han desaparecido en extinciones masivas. Sin embargo, dado que también se calcula que el 99 por ciento de todas las especies que han vivido en la Tierra se han extinguido, esto significa que son el doble las que han desaparecido en sucesos de “menor importancia”, o, al menos, menos llamativos.

La cuestión que nos intriga es si las extinciones en masa son en realidad acontecimientos especiales, de carácter diferente al de las extinciones de “menor importancia” y que, según todos los datos en la mano, tienen en su haber más muertes que aquellas que más han sonado en la Historia de la Tierra. ¿Son acaso las extinciones de vida en la Tierra unos hechos cuya naturaleza es independiente de su magnitud, como los terremotos causados (entre otras causas) por los movimientos de las placas tectónicas como las erupciones volcánicas y todos los demás fenómenos sabemos ocurren periódicamente en nuestro planeta.

Y, a todo ello, no no dejaría atrás, ni perdería de vista, el resultado que tendría aquí en la Tierra, la explosión supernova de alguna que otra estrella más o menos cercana a nuestro Sistema Solar y que, según creo, podría ser devastador y de consecuencias incalculables en bienes y vidas. Y, digo esto porque, bien pensado, no parece que podamos adjudicar todas esas extinciones a la caída de grandes meteoritos provenientes del espacio sobre nuestro planeta. Lo que parece estar diciéndonos el registro fósil es que las extinciones se producen en todas las escalas, todos los tiempos, y que, (como el caso de los terremotos) puede producir una extinción de cualquier magnitud y en cualquier época, sucesos impredecibles para los que, nosotros, aún no estamos preparados ni podemos evitar.

Hace 444 millones de años, en la transición entre los períodos Ordovícico y Silúrico, ocurrieron dos extinciones masivas llamadas extinciones masivas del Ordovícico-Silúrico. Su causa probable fue el período glaciar. El primer evento ocurrió cuando los hábitats marinos cambiaron drásticamente al descender el nivel del mar. El segundo ocurrió entre quinientos mil y un millón de años más tarde, al crecer el nivel del mar rápidamente.

Como decíamos antes, hace 65 millones de años en la extinción masiva del Cretácico-Terciario, desaparecieron cerca del 50% de todas las especies, incluyendo los dinosaurios.

Durante el cretácico tardío, el nivel del mar subió en todo el mundo, inundando casi un tercio de la superficie terrestre actual.

Así, el calor del sol pudo distribuirse más hacia el norte gracias a las corrientes marinas, dando lugar a un clima global cálido y suave, con polos sin casquete de hielo y una temperatura en las aguas del Ártico de 14° C o más.

En un clima así, los reptiles de sangre fría podían proliferar incluso en latitudes boreales, mientras que los fósiles de helechos y cicas encontrados en rocas del cretácico a latitudes árticas son similares a las plantas de hoy en los bosques húmedos subtropicales.

A finales del cretácico, la flora había adoptado ya una apariencia moderna e incluía muchos de los géneros actuales de árboles, como el roble, el haya y el arce.

A pesar de la benignidad de las condiciones ambientales a finales del periodo se produjeron varias extinciones en masa.

Se extinguieron cinco grandes grupos de reptiles —dinosaurios, pterosaurios, ictiosaurios, plesiosaurios y mosasaurios— que hasta entonces habían sido dominantes.

Una teoría reciente señala que su extinción se debió a la colisión de la Tierra con un cometa o un pequeño asteroide, que lanzó polvo a la atmósfera como para bloquear parte de la radiación solar incidente y reducir la temperatura en todo el mundo, produciendo efectos devastadores sobre las algas, la vegetación y los pequeños animales de los que dependían los grandes reptiles para alimentarse.

Seguirá…

emilio silvera

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Catástrofes Naturales ~

Clasificado en Catástrofes Naturales ~

Comments (0)

Comments (0)

A pesar de la benignidad de las condiciones ambientales a finales del periodo se produjeron varias extinciones en masa.

A pesar de la benignidad de las condiciones ambientales a finales del periodo se produjeron varias extinciones en masa.

Totales: 67.214.899

Totales: 67.214.899 Conectados: 40

Conectados: 40