Oct

30

A la caza de vida en Encédalo, la luna de Saturno

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias ~

Clasificado en Noticias ~

Comments (0)

Comments (0)

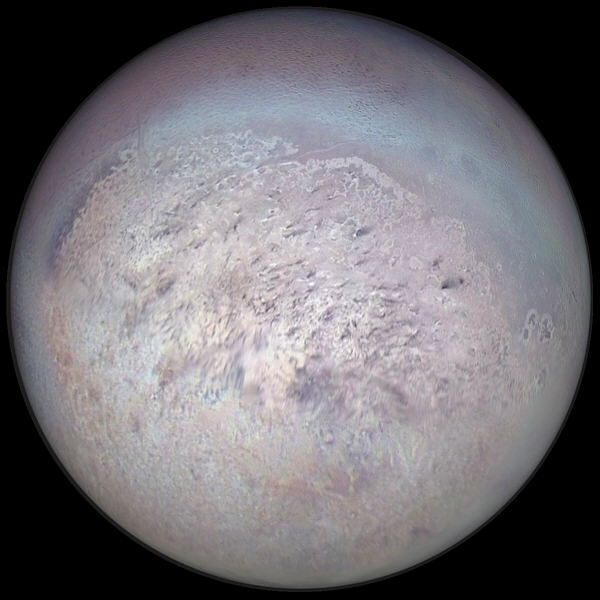

La sonda Cassini realiza un acercamiento histórico al situarse a 49 kilómetros, un hito clave para conocer si hay alguna forma de vida

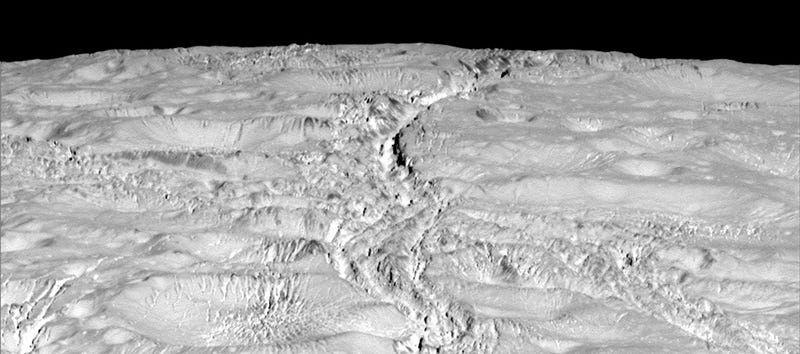

Rugosa y agrietada superficie de Encelado

El pasado día 14 de octubre, la sonda Cassini que explora Saturno ha pasado a solo 1.839 kilómetros de Encélado. En el camino nos ha dejado unas preciosas imágenes de esta misteriosa luna, las más cercanas que hemos visto hasta ahora.

A 1.600 millones de km. de la Tierra, la misión Cassini, que desde 2004 estudia el sistema de Saturno y sus satélites, se situó ayer a apenas 49 km. de la superficie de Encélado, una de las lunas más enigmáticas y prometedoras del gigante anillado. Y lo hizo justo sobre su polo sur, con objeto de «sumergirse» en los chorros de vapor de agua que varios enormes géiseres lanzan desde esa zona a gran altura.

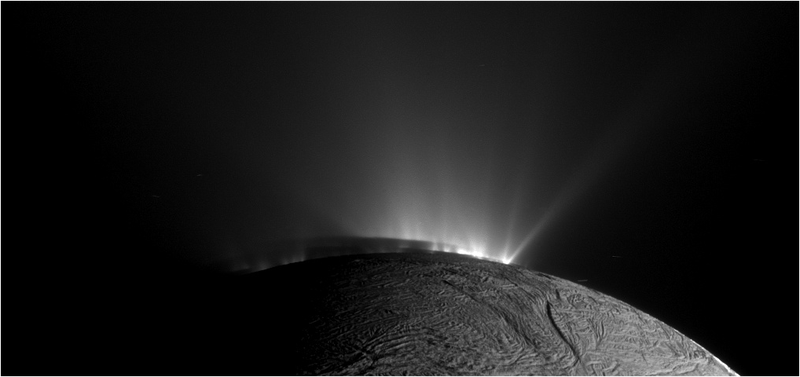

Fueron precisamente esos géiseres los que, ya en 2005, revelaron la presencia de una gran cantidad agua líquida bajo la capa de hielo que cubre el satélite. Aunque no se sabía cuánta, ni tampoco si esa reserva de agua se extendía más allá del propio polo sur. Hace apenas unas semanas, sin embargo, y tras largos años de estudio, la NASA hizo pública la noticia de que bajo los hielos de Encélado se esconde un único e inmenso océano subterráneo global. Lo que hace crecer las expectativas de los investigadores de encontrar allí alguna forma de vida.

No es la primera «pasada» de la Cassini por Encélado. Ni tampoco la que más se ha acercado a su superficie. De hecho, la sonda ha realizado ya una docena de aproximaciones y en la del 9 de octubre de 2008 la Cassini llegó a pasar a solo 25 km. de altura sobre Encelado. Pero esta vez es diferente, porque ahora los científicos de la NASA saben muy bien lo que andan buscando. Esta «pasada», además, será única porque es la que más se ha acercado al Polo Sur del satélite y la primera que atraviesa de parte a parte la nube de partículas heladas que emanan directamente del océno subterráneo. En palabras de Linda Spilker, directora científica de la misión, «vamos a explorar in situ una región de la columna de vapor que la Cassini nunca había muestreado antes. Es algo muy emocionante para mí».

Por desgracia, hace dos décadas, cuando se diseñó la Cassini, b uscar vida no formaba parte de los objetivos de la misión. Así que la nave no cuenta con ningún instrumento capaz de detectar directamente alguna forma de vida. Por eso, la NASA se ha esforzado en aclarar que esta aproximación «no busca encontrar vida, sino proveer información sobre cómo de habitable es el océano de Encélado». Y para ello tratará de averiguar qué cantidad de actividad hidrotermal se da en el océano global.

La Sonda Cassini y Enceladus son viejos amigos

Bastará con recolectar una gota de agua para descubrirlo. De hecho, una simple gota es la cantidad de agua que la Cassini fue capaz de recoger al atravesar la nube de vapor a más de 30.000 km. por hora. Más que suficiente, sin embargo, para arrancar a Encélado algunos de sus secretos mejor guardados.

«La confirmación de la presencia de hidrógeno molecular en la nube sería una prueba de que hay actividad hidrotermal en el océano de Encélado», afirma Hunter Waite, miembro de la misión. Aquí, en la Tierra, alrededor de chimeneas hidrotermales a miles de metros de profundidad bajo los océanos habitan prósperas comunidades de numerosas especies animales. Y en Encélado podría estar sucediendo lo mismo. Para Waite, «la cantidad de hidrógeno detectada revelará cuánta actividad hidrotermal hay» en las profundidades del océano global del satélite de Saturno.

«Es un paso muy grande en una nueva era de exploración de mundos oceánicos en nuestro Sistema Solar -asegura Curt Niebur, científico de la misión-. Mundos con un gran potencial para proporcionar oasis para la vida».

Con sus 500 km. de diámetro, Encelado es la sexta mayor luna de Saturno. Su paisaje helado e inhóspito está lleno de profundos cañones, conocidos como las «rayas de tigre» y que , típicamente, tienen unos 130 km. de longitud, 2 km. de ancho y unos 500 metros de profundidad. Pero bajo la capa de hielo externa se agita un océano subterráneo global, una inmensa masa de agua que consigue permanecer líquida gracias a la energía proporcionada por las fuerzas de marea del gigantesco Saturno. La temperatura del agua que emana de los géiseres, en efecto, puede superar los 90 grados centígrados. Y la presión a la que sale revela que debe de haber mucha más bajo la capa de hielo.

Más de 100 geéiseres han sido descubiertos en ésta luna de Saturno y nos habla del océano interior

Por eso, precisamente, los géiseres son tan importantes. Y es que el océano global subterráneo de Encelado podría ser efervescente y estar lleno de gas. Cuando ese gas, mezclado con las partículas de hielo, llega a la superficie, es expulsado con fuerza hasta muchos km. de altura. Para Linda Spilker, el proceso es similar al de «sacudir una botella de refresco; el gas no tiene otro sitio donde ir más que hacia arriba y hacia fuera».

Pero los chorros de vapor son mucho más que gas y agua. De hecho, contienen la mayor parte de los compuestos orgánicos que resultan esenciales para la vida en la Tierra. Y eso abre la excitante posibilidad de que bajo las aguas de Encélado y cerca de eventuales respiraderos volcánicos (chimeneas hidrotermales) prosperen organismos similares a los que se dan en nuestro planeta en las mismas condiciones. Y aunque aún es pronto para saber si en esa lejana luna de Saturno se ha desarrollado vida compleja, los científicos creen que la posibilidad de que allí exista, por lo menos, vida microbiana, es tremendamente real.

Durante los próximos años y con la información de esta «pasada» de la Cassini en la mano, la NASA enviará una nueva misión hasta allí, y esta vez con todo lo necesario para buscar e identificar alguna forma de vida, incluido un módulo de aterrizaje que, según Spilker «podría tomar muestras desde el borde mismo de una de las rayas de tigre». Lo cual garantizaría que cualquier microbio que fuera expulsado al exterior por el chorro de vapor pudiera ser recogido y analizado con facilidad.

Hasta ese momento, sin embargo, la mejor herramienta disponible son aproximaciones como la de ayer. Y antes de tomar ninguna decisión para el futuro, la NASA tendrá que esperar a que se analicen a conciencia todos los datos recogidos por la Cassini.

Oct

30

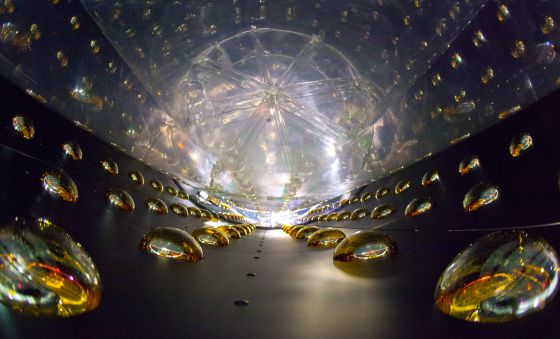

¿Debemos nuestra existencia a los Neutrinos?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Publicado: El País

Con solo tres tipos de partículas diferentes: el electrón y los dos quarks que forman los protones y neutrones, tenemos los ladrillos necesarios para construir y describir toda la materia que nos rodea, desde las estrellas hasta los animales y plantas de la Tierra. Sin embargo, hay un cuarto tipo de partícula elemental con propiedades muy diferentes a las anteriores: el neutrino.

Su nombre viene del italiano “neutron bambino” y ya nos da idea de qué le distingue de las otras partículas elementales. Es neutro, sin carga eléctrica y con interacciones extremadamente débiles con el resto de la materia. También es increíblemente ligero. De hecho, la masa de los neutrinos es tan pequeña que no ha podido medirse directamente aún. Sólo sabemos que debe ser menor que una millonésima parte de la masa del electrón, la siguiente partícula más ligera que conocemos. Estas dos propiedades hacen que los neutrinos sean más de mil millones de veces más numerosos que todos los átomos del Universo pero que, al mismo tiempo, apenas podamos detectar su presencia.

El premio Nobel de física 2015 ha sido concedido a Takaaki Kajita y Arthur McDonald por “el descubrimiento de las oscilaciones de neutrinos que demuestran que los neutrinos tienen masa”.

Los neutrinos existen en tres “sabores” o especies que determinan sus interacciones con el resto de partículas. La “oscilación de neutrinos” es un fenómeno mediante el cual estos tres “sabores” de neutrino se transforman unos en otros simplemente en vuelo, “oscilando” entre los tres tipos. Los neutrinos, como el resto de las partículas en el contexto de la física cuántica, son descritos como ondas. Y como las ondas en el agua, se pueden superponer unas con otras, dando lugar a nuevas combinaciones. Pues bien, estos tres “sabores” de neutrinos corresponden a tres superposiciones diferentes de ondas.

Si estas ondas viajaran todas igual, simultáneamente, la superposición nunca cambiaría y no habría oscilaciones. Pero si los neutrinos asociados a estas ondas tienen masa, y sus masas son diferentes, cada onda se propaga con velocidad diferente y la superposición entre ellas, el “sabor”, cambia con el vuelo del neutrino. Por eso, la observación de la oscilación de los sabores de neutrinos implica que éstos deben tener masa, aunque sea tan pequeña que aún no la hemos podido determinar de forma directa.

El simple hecho de que estas partículas tengan masa nos obliga a replantear nuestro entendimiento de la física con la que explicamos y describimos la materia, que solo predecía neutrinos sin masa. Aunque el resto de partículas también son masivas, y con masas mucho mayores, el carácter especial de los neutrinos de nuevo podría esconder sorpresas. Por ejemplo, su carácter neutro, hace que la línea que distingue partículas de antipartículas, materia de antimateria, se desdibuje para los neutrinos.

Las antipartículas son partículas producidas en laboratorios y de forma natural en la atmósfera terrestre, idénticas en todo a su partícula asociada, excepto en su carga, que es opuesta. Así el positrón, la antipartícula del electrón, es idéntica a éste pero con carga positiva en vez de negativa.

Los neutrinos son más de mil millones de veces más numerosos que todos los átomos del Universo pero, al mismo tiempo, apenas podemos detectar su presencia

Aún es un misterio el por qué nuestro Universo está formado por materia si partículas y antipartículas se producen y destruyen juntas en la mayoría de procesos conocidos. En algún momento se debió crear un exceso de materia sobre antimateria para poder crear galaxias, estrellas, planetas y personas. Pero quizá los neutrinos tengan la respuesta. Al no tener carga, sería posible que, igual que los neutrinos oscilan entre “sabores”, su masa también permitiera a neutrinos oscilar en antineutrinos, rompiendo la barrera entre partículas y antipartículas y plantando la semilla del exceso de materia en el Universo al que, a la postre, debemos nuestra existencia. ¿Quizá un futuro premio Nobel nos de la respuesta?

Enrique Fernández es investigador Ramón y Cajal del departamento de Física Teórica de la UAM y miembro del Instituto de Física Teórica UAM-CSIC.

Oct

27

Rumores del pasado

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del Saber ~

Clasificado en Rumores del Saber ~

Comments (0)

Comments (0)

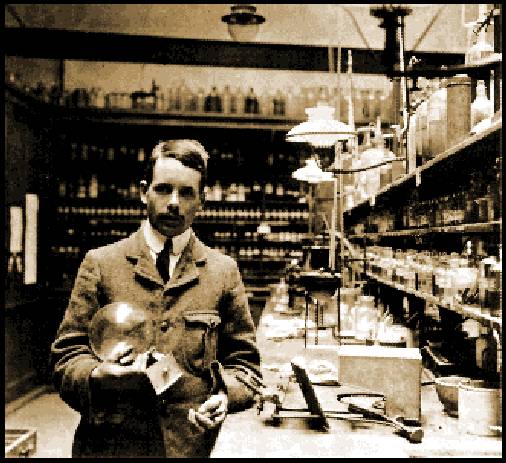

Faraday dando una charla sobre sus trabajos y explicándo al público lo que era la luz y la electricidad

En su juventud, Michael Faraday tuvo unos humildes comienzos como repartidor de periódicos y aprendiz de encuadernador. Sin embargo, su afición al experimento y la investigación le llevó a descubrir algunos de los secretos más guardados de la Naturaleza. De hecho, el concepto de “Campo” que tanto hoy manejan los físicos, es debido a él. Gracias a sus trabajos y los resultados obtenidos en sus miles de experimentos, pudo Maxwell (un gran físico y matemático), crear su teoría de la luz y el electromagnetismo mediante sus famosas ecuaciones vectoriales.

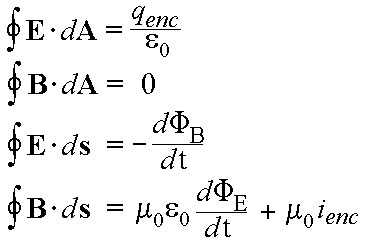

James Clark Maxwell

El trabajo más importante de Maxwell se efectuó entre 1864 y 1873, cuando dio forma matemática a las especulaciones de Faraday respecto a las líneas de fuerza magnéticas. Al hacerlo, Maxwell, pudo conseguir unas cuantas ecuaciones simples que expresaban todos los fenómenos variados de electricidad y magnetismo y las unió de un modo indisoluble. Su teoría demostraba que la electricidad y el magnetismo no podían existir aisladamente, donde esta una allí estaba el otro, por tanto, se hace referencia a su obra, generalmente, como la teoría del electromagnetismo.

La “profesionalización” e “institución” de la ciencia, entendiendo por tal que la práctica de la investigación científica se convirtiese en una profesión cada vez más abierta a personas sin medios económicos propios, que se ganaban la vida a través de la ciencia y que llegasen a atraer la atención de gobiernos e industrias, tuvo su explosión a lo largo de 1.800, y muy especialmente gracias al desarrollo de dos disciplinas, la química orgánica y el electromagnetismo. Estas disciplinas, junto a las matemáticas, la biología y las ciencias naturales (sin las cuales sería una necedad pretender que se entiende la naturaleza, pero con menos repercusiones socio-económicas), experimentaron un gran desarrollo entonces, tanto en nuevas ideas como en el número de científicos importantes: Faraday, Maxwell, Lyell, Darwin y Pasteur, son un ejemplo. Sin olvidar a otros como Mendel, Helmholtz, Koch, Virchow, Lister o Kelvin, o la matemática de Cauchy, de Gauss, Galois, Fourier, Lobachevski, Riemann, Klein, Cantor, Russell, Hilbert o Poincaré. Pero vamos a pararnos un momento en Faraday y Maxwell.

Las ecuaciones de Maxwell, por dar una simple explicación de lo que significan, hace posible que tengamos una información fidedigna de cómo se transmite la información para la televisión, Internet y la telefonía en general, cuánto tarda en llegarnos la luz de las estrellas, cuál es la base del funcionamiento de las neuronas o como funciona cualquier central de electricidad, aparte de otros miles de fenómenos que podemos estar experimentando en nuestras vidas cotidianas que están relacionados con la luz, la electricidad y el magnetismo. Y, todo ello, se explica con esas cuatro “sencillas ecuaciones”.

Para la electricidad, magnetismo y óptica, fenómenos conocidos desde la antigüedad, no hubo mejor época que el siglo XIX. El núcleo principal de los avances que se produjeron en esa rama de la física (de los que tanto se benefició la sociedad -comunicaciones telegráficas, iluminación, tranvías y metros, etc.-) se encuentra en que, frente a lo que se suponía con anterioridad, se descubrió que la electricidad y el magnetismo no eran fenómenos separados.

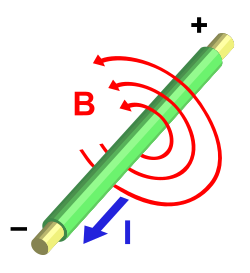

Estatua de Hans Christian Ørsted en Ørstedsparken, Copenhague, Dinamarca. Hans Christian Orsted físico y químico danés, que descubrió en 1819 que la aguja imantada de una brújula se desviaba cuando se encontraba próxima a un cable conductor por el cual fluía una corriente eléctrica. Esta desviación implica la existencia de un campo magnético en la región vecina al conductor. Asi se demostraba la existencia de un campo magnético en torno a todo conductor por el que fluye una corriente eléctrica, este descubrimiento fue crucial ya que puso en evidencia la relación existente entre la electricidad y el magnetismo.

Así que, el punto de partida para llegar a este resultado crucial fue el descubrimiento realizado en 1.820 por el danés Hans Christian Oersted (1777 – 1851) de que la electricidad produce efectos magnéticos: observó que una corriente eléctrica desvía una aguja imanada. La noticia del hallazgo del profesor danés se difundió rápidamente, y en París André-Marie Ampère (1775 – 1836) demostró experimentalmente que dos hilos paralelos por los que circulan corrientes eléctricas de igual sentido, se atraen, repeliéndose en el caso de que los sentidos sean opuestos.

La expresión diferencial

∇×H ≡ J (“Ley de Ampère“)

conocida como “Ley de Ampère“, muestra la relación que existe entre el campo H y la fuente J cuando las corrientes y los campos no cambian el tiempo, pero falla cuando los fenómenos no son estacionarios. La contribución de Maxwell se resume en haber agregado a J, el sumando ∂D/∂t correspondiente a la corriente de desplazamiento en los fenómenos no estacionarios, algo que nadie había medido y que no resultaba intuitivo. La falta de ese término deja fuera los casos dinámicos, muchos casos tan importantes como por ejemplo las Ondas Electromagnéticas !

Con esta formulación, Ampère avanzaba la expresión matemática que representaba aquellas fuerzas. Su propósito era dar una teoría de la electricidad sin más que introducir esa fuerza (para él “a distancia”).

Pero el mundo de la electricidad y el magnetismo resultó ser demasiado complejo como para que se pudiera simplificar en un gráfico sencillo, como se encargó de demostrar uno de los grandes nombres de la historia de la ciencia: Michael Faraday (1791 – 1867), un aprendiz de encuadernador que ascendió de ayudante de Humphry Davy (1778 – 1829) en la Royal Intitution londinense.

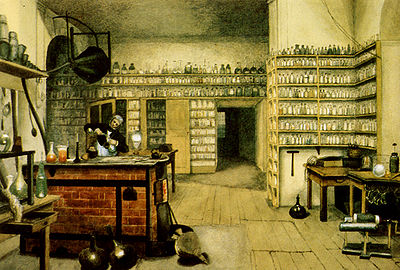

En este humilde rinconcillo trabajaba Faraday

En 1.821, poco después de saber de los trabajos de Oersted, Faraday, que también dejó su impronta en la química, demostró que un hilo por el que pasaba una corriente eléctrica podía girar de manera continua alrededor de un imán, con lo que vio que era posible obtener efectos mecánicos (movimiento) de una corriente que interacciona con un imán. Sin pretenderlo, había sentado el principio del motor eléctrico, cuyo primer prototipo sería construido en 1.831 por el físico estadounidense Joseph Henry (1797 – 1878).

Lo que le interesaba a Faraday no eran necesariamente las aplicaciones prácticas, sino principalmente los principios que gobiernan el comportamiento de la naturaleza, y en particular las relaciones mutuas entre fuerzas, de entrada, diferentes. En este sentido, dio otro paso importante al descubrir, en 1.831, la inducción electromagnética, un fenómeno que liga en general los movimientos mecánicos y el magnetismo con la producción de corriente eléctrica.

Este fenómeno, que llevaría a la dinamo, representaba el efecto recíproco al descubierto por Oersted; ahora el magnetismo producía electricidad , lo que reforzó la idea de que un lugar de hablar de electricidad y magnetismo como entes separados, sería más preciso referirse al electromagnetismo.

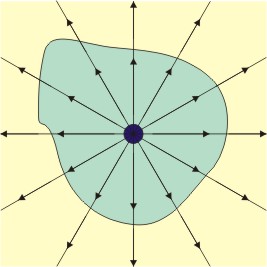

La intuición natural y la habilidad experimental de Faraday hicieron avanzar enormemente el estudio de todos los fenómenos electromagnéticos. De él es, precisamente, el concepto de campo que tanto juego ha dado a la física.

Sin embargo, para desarrollar una teoría consistente del electromagnetismo se necesitaba un científico distinto: Faraday era hábil experimentador con enorme intuición, pero no sabía expresar matemáticamente lo que descubría, y se limitaba a contarlo. No hubo que esperar mucho, ni salir de Gran Bretaña para que un científico adecuado, un escocés de nombre James Clerk Maxwell (1831 – 1879), hiciera acto de presencia.

Las ecuaciones de Maxwell cumplieron 150 años el pasado día 14 abril 2014. Publicado por Augusto en Divulgación, Historia de la Física. Las ecuaciones de Maxwell son un conjunto de cuatro ecuaciones (originalmente 20 ecuaciones) que describen por completo los fenómenos electromagnéticos. La gran contribución de James Clerk Maxwell fue reunir en estas ecuaciones largos años de resultados experimentales, debidos a Coulomb, Gauss, Ampere, Faraday y otros, introduciendo los conceptos de campo y corriente de desplazamiento, y unificando los campos eléctricos y magnéticos en un solo concepto: El Campo Electromagnético.

Las cuatro ecuaciones de Maxwell describen todos los fenómenos electromagnéticos, aquí se muestra la inducción magnética por medio de una corriente eléctrica en la figura situada en primer lugar. En la segunda se quiere escenificar el Flujo eléctrico de una carga puntualen una superficie cerrada. En la tercera imagen, quedan escenificadas las líneas de campo magnético que comienzan y terminan en el mismo lugar, por lo que no existe un monopolo magnético.

Maxwell desarrolló las matemáticas para expresar una teoría del magnetismo-electricidad (o al revés) que sentó las bases físicas de aquel fenómeno y contestaba a todas las preguntas de los dos aspectos de aquella misma cosa, el electromagnetismo. En sus ecuaciones vectoriales estaban todos los experimentos de Faraday, que le escribió una carta pidiéndole que le explicara, con palabras sencillas, aquellos números y letras que no podía entender.

Pero además, Maxwell también contribuyó a la física estadística y fue el primer director del Laboratorio Cavendish, unido de manera indisoluble a la física de los siglos XIX y XX (y también al de biología molecular) con sede en Cambridge.

Su conjunto de ecuaciones de, o en, derivadas parciales rigen el comportamiento de un medio (el campo electromagnético) que él supuso “transportaba” las fuerzas eléctricas y magnéticas; ecuaciones que hoy se denominan “de Maxwell”. Con su teoría de campo electromagnético, o electrodinámica, Maxwell logró, además, unir electricidad, magnetismo y óptica. Las dos primeras, como manifestaciones de un mismo substrato físico, electromagnético, que se comporta como una onda, y la luz, que es ella misma, una onda electromagnética, lo que, en su tiempo, resultó sorprendente.

Más de ciento treinta años después, todavía se podía o se puede apreciar la excitación que sintió Maxwell cuando escribió en el artículo Sobre las líneas físicas de la fuerza, 1861 – 62, en el que presentó esta idea: “Difícilmente podemos evitar la inferencia de que la luz consiste de ondulaciones transversales del mismo medio que es la causa de los fenómenos eléctricos y magnéticos.”

Todo aquello fue posible gracias a las bases sentadas por otros y a los trabajos de Faraday como experimentador infatigable, que publicaba sus resultados en artículos y los divulgaba en conferencias en la sede de la Royal Institution londinense. Todos estos artículos y conferencias fueron finalmente publicados en el libro que llamaron Philosophical transactions de la Royal Society, y Experimental researches in chemistry and physics (Richard Taylor y William Francis, Londres, 1859; dos grandes científicos unidos por la historia de la ciencia que nos abrieron puertas cerradas que nos dejaron entrar al futuro).

Claro que, si miramos hacia atrás en el tiempo, ¿cuántas historias como ésta podemos encontrar? Para cualquiera de las cosas que ahora sabemos, casi siempre, ha sido necesario aunar los pensamientos dispersos de muchos que, aunados en un sólo y completo pensamiento, ha podido formar la teoría final que nos explicaron el funcionamiento de la Naturaleza. Así ha ocurrido siempre y seguirá pasando. Einstein se tuvo que vales de ideas dispersas de Mach, Maxwell, Riemann, Lorentz y algunos otros para poder formular su bella Teoría de la Relatividad.

Faraday fue el prototipo de expèrimentador de los fenómenos físicos

A finales del siglo XIX, poca gente sabía con exactitud a qué se dedicaban los “físicos”. El término mismo era relativamente nuevo. En Cambridge, la física se enseñaba como del grado de matemáticas. En este sistema no había espacio la investigación: se consideraba que la física era una rama de las matemáticas y lo que se le enseñaba a los estudiantes era como resolver problemas.

En la década de 1.870, la competencia económica que mantenían Alemania, Francia, Estados Unidos, y Gran Bretaña se intensificó. Las Universidades se ampliaron y se construyó un Laboratorio de física experimental en Berlín.

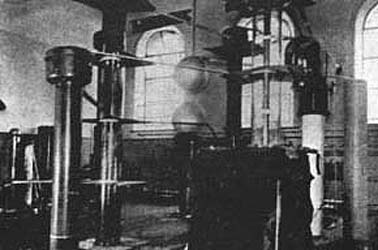

Cambridge sufrió una reorganización. William Cavendish, el séptimo duque de Devonshire, un terrateniente y un industrial, cuyo antepasado Henry Cavendish había sido una temprana autoridad en teoría de la gravitación, accedió a financiar un Laboratorio si la Universidad prometía fundar una cátedra de física experimental. Cuando el laboratorio abrió, el duque recibió una carta en la que se le informaba (en un elegante latín) que el Laboratorio llevaría su .

Primer profesor J. J. Thomson director del laboratorio

Tras intentar conseguir sin éxito atraer primero a William Thomson, más tarde a lord Kelvin (quien otras cosas, concibió la idea del cero absoluto y contribuyó a la segunda ley de la termodinámica) y después a Hermann von Helmohltz, de Alemania (entre cuyas decenas de ideas y descubrimientos destaca una noción pionera del cuanto), finalmente se ofreció la dirección del centro a James Clerk Maxwell, un escocés graduado en Cambridge. Este fue un hecho fortuito, pero Maxwell terminaría convirtiéndose en lo que por lo general se considera el físico más destacado entre Newton y Einstein. Su principal aportación fue, por encima de todo, las ecuaciones matemáticas que permiten entender perfectamente la electricidad y el magnetismo. Estas explicaban la naturaleza de la luz, pero también condujeron al físico alemán Heinrich Hertz a identificar en 1.887, en Karlsruhe, las ondas electromagnéticas que hoy conocemos ondas de radio.

En el Laboratorio Cavendish de la Universidad de Cambridge, Cockcroft y Walton construyeron este acelerador de 500 kilovolts en 1932. Si lo comparamos con el LHC del CERN nos podemos dar de cómo la Ciencia ha ido avanzando en relativamente tan poco tiempo y, desde entonces hemos alcanzado un nivel que nos permite trabajar con 14 TeV, una energía de todo punto imposible e impensable en aquellos primeros tiempos.

Maxwell también creó un programa de investigación en Cavendish con el propósito de idear un estándar preciso de medición eléctrica, en particular la unidad de resistencia eléctrica, el ohmio. Esta era una cuestión de importancia internacional debido a la enorme expansión que había experimentado la telegrafía en la década de 1.850 y 1.860, y la iniciativa de Maxwell no solo puso a Gran Bretaña a la vanguardia de este campo, sino que también consolidó la reputación del Laboratorio Cavendish como un centro en el que se trataban problemas prácticos y se ideaban nuevos instrumentos.

Tubo de vacío usado por JJ Thomson en uno de los experimentos realizados para el electrón. Expuesto en el museo del laboratorio Cavendish. Aquellos físicos primeros que abrieron el camino a lo que más tarde sería la física moderna, tuvieron un gran mérito al poder avanzar hacia el conocimientos de las cosas, de la Naturaleza, con pocas herramientas y mucha imaginación.

A este hecho es posible atribuir del crucial papel que el laboratorio iba a desempeñar en la edad dorada de la Física, entre 1.897 y 1.933. Los científicos de Cavendish, se decía, tenían “sus cerebros en la punta de los dedos.”

Maxwell murió en 1.879 y le sucedió lord Rayleigh, quien continuó su labor, pero se retiró después de cinco años y, de manera inesperada, la dirección pasó a un joven de veintiocho años, Joseph John Thomson, que a pesar de su juventud ya se había labrado una reputación en Cambridge como un estupendo físico-matemático. Conocido universalmente como J.J., puede decirse que Thomson fue quien dio comienzo a la segunda revolución científica que creó el mundo que conocemos.

Ernest Rutherford otro experimentador

Se dedicó al estudio de las partículas radioactivas y logró clasificarlas en alfaa (α), beta (β) y gamma (γ). Halló que la radiactividad iba acompañada por una desintegración de los elementos, lo que le valió ganar el Premio Nobel de Química de 1908. Se le debe un modelo atómico con el que probó la existencia de núcleol en los átomos, en el que se reúne toda la carga positiva y casi toda la masa del átomo. Consiguió la primera transmutación artificial con la colaboración de su discípulo Frederick Soddy.

Henry Cavendish en su Laboratorio

La primera revolución científica comenzó con los descubrimientos de Copérnico, divulgados en 1.543, y los de Isaac Newton en 1.687 con su Gravedad y su obra de incomparable valor Principia Matemática, a todo esto siguió los nuevos hallazgos en la Física, la biología y la psicología.

Pero fue la Física la que abrió el camino. Disciplina en permanente cambio, debido principalmente a la de entender el átomo (esa sustancia elemental, invisible, indivisible que Demócrito expuso en la Grecia antigua).

John Dalton

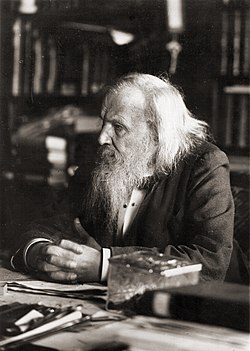

En estos primeras décadas del siglo XIX, químicos como John Dalton se habían visto forzados a aceptar la teoría de los átomos como las unidades mínimas de los elementos, con miras a explicar lo que ocurría en las reacciones químicas (por ejemplo, el hecho de que dos líquidos incoloros produjeran, al mezclarse, un precipitado blanco). De similar, fueron estas propiedades químicas y el hecho de que variaran de forma sistemática, combinada con sus pesos atómicos, lo que sugirió al ruso Dimitri Mendeleyev la organización de la Tabla Periódica de los elementos, que concibió jugando, con “paciencia química”, con sesenta y tres cartas en su finca de Tver, a unos trescientos kilómetros de Moscú.

Pero además, la Tabla Periódica, a la que se ha llamado “el alfabeto del Universo” (el lenguaje del Universo), insinuaba que existían todavía elementos por .

Dimitri Mendeléiev en 1897

La tabla de Mendeleyev encajaba a la perfección con los hallazgos de la Física de partículas, con lo que vinculaba física y química de racional: era el primer paso hacia la unificación de las ciencias que caracterizaría el siglo XX.

En Cavendish, en 1.873, Maxwell refinaría la idea de átomo al introducir la idea de campo electromagnético (idea que tomó prestada de Faraday), y sostuvo que éste campo “impregnaba el vacío” y la energía eléctrica y magnética se propagaba a través de él a la velocidad de la luz. Sin embargo, Maxwell aún pensaba en el átomo como algo sólido y duro y que, básicamente, obedecían a las leyes de la mecánica.

El problema estaba en el hecho de que, los átomos, si existían, eran demasiado pequeños ser observados con la tecnología entonces disponible.

Esa situación empezaría a cambiar con Max Planck, el físico alemán que, como de su investigación de doctorado, había estudiado los conductores de calor y la segunda ley termodinámica, establecida originalmente por Rudolf Clausius, un físico alemán nacido en Polonia, aunque lord Kelvin también había hecho algún aporte.

El joven Max Planck

Clausius había presentado su ley por primera vez en 1.850, y esta estipulaba algo que cualquiera podía observar, a saber, que cuando se realiza un la energía se disipaba convertida en calor y que ese calor no puede reorganizarse en una forma útil. Esta idea, que por lo demás parecería una anotación de sentido común, tenía consecuencias importantísimas.

Dado que el calor (energía) no podía recuperarse, reorganizarse y reutilizarse, el Universo estaba dirigiéndose gradualmente un desorden completo:

cántaro roto…

Una casa que se desmorona nunca se reconstruye así misma, una botella rota nunca se recompone por decisión propia. La palabra que Clausius empleó designar este fenómeno o desorden irreversible y creciente fue “entropía”: su conclusión era que, llegado el , el Universo moriría.

En su doctorado, Planck advirtió la relevancia de esta idea. La segunda ley de la termodinámica evidenciaba que el tiempo era en verdad una fundamental del Universo, de la física. Sea lo que sea, el tiempo es un componente básico del mundo que nos rodea y se relaciona con la materia de formas que todavía no entendemos.

La noción de tiempo implica que el Universo solo funciona en un sentido, hacia delante, nunca se está quieto ni funciona hacia atrás, la entropía lo impide, su discurrir no tiene marcha atrás. ¿No será nuestro discurrir lo que siempre marcha hacia delante, y, lo que tenemos por tiempo se limita a estar ahí?

En el Laboratorio Cavendish, me viene a la memoria que fue allí, donde Thomson, en 1.897, realizó el descubrimiento que vino a coronar anteriores ideas y trabajos de Benjanmin Franklin, Euge Goldstein, Wilhelm Röntgen, Henri Becquerel y otros. El descubrimiento del electrón convirtió a la física moderna en una de las aventuras intelectuales más fascinantes e importantes del mundo contemporáneo.

Joseph John Thomson

Los “corpúsculos”, como Thomson denominó inicialmente a estas partículas, hoy conocidas como electrones, condujo de directa al trascendental avance realizado una década después por Ernest Rutherford, quien concibió el átomo como una especie de “sistema solar” en miniatura, con los electrones diminutos orbitando alrededor de un núcleo masivo como hacen los planetas alrededor del Sol. Rutherford demostró experimentalmente lo que Einstein había descubierto en su cabeza y revelado en su famosa ecuación, E = mc2 (1905), esto es que la materia y la energía eran esencialmente lo mismo.

Todo aquello fue un gran paso en la búsqueda del conocimiento de la materia. El genio, la intuición y la experimentación han sido esenciales en la lucha del ser humano con los secretos, bien guardados, de la Naturaleza.

emilio silvera

Oct

26

El colapso del núcleo de las estrellas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (9)

Comments (9)

El vacío superconducto – La máquina de Higgs-Kibble

El vacío superconductor – La máquina de Higgs-Kibble II

Lo único que no resulta ser lo mismo cuando se mira a través a través del microscópico electrónico (o, en la jerca de la física teórica, cuando se realiza una transformación de escala) es la masa de la partícula. Esto se debe a que el alcance de la fuerza parece mayor a través del microscopìo y, por lo tanto, la masa de la partícula parece ser menor. Nótese que esta situación es la opuesta a la que se presenta en vida corriente donde un grano de arena parece mayor -¿más pesado, por lo tanto?- cuando se observa con un microscopio.

Granos de arena vistos al microscópico electrónico

Una consecuencia de todo esto es que en una teoría de Yang-Mills el termino de masa parece desaparecer se realiza una transformación de escala, lo que implica que a través del microscopio se recupera la invariancia gauge. Esto es lo que causa la dificultad con la que se enfrentó Veltman. ¿Se observar directamente el potencial vector de Yang-Mills? Parece que puede observa4rse en el mundo de las cosas grandes, no en el mundo de lo pequeño. Esto es una contradicción y es una raz´`on por la que ese esquema nunca ha podido funcionar adecuadamente.

En el mundo cuántico se pueden contemplar cosas más extrañas

Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, = 1’62 × 10-33 cm, es la escala de longitud por debajo de la cual es espacio, tal tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler, o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que la longitud de Planck-Wheeler, es decir, 2’61 × 10-66 cm2) juega un papel clave en la entropía de un agujero negro.

Poco tiempo después resultó evidente que existían otras subpartículas en el interior del átomo. Cuando Becquerel descubrió la radiactividad, identificó como emanaciones constituidas por electrones algunas de las radiaciones emitidas por sustancias radiactivas. Pero también quedaron al descubierto otras emisiones. Los Curie en Francia y Ernest Rutherford en Inglaterra detectaron una emisión bastante menos penetrante que el flujo electrónico. Rutherford la llamó rayos alfa, y denominó rayos beta a la emisión de electrones.

Pero el trabajo de hoy se titula: El colapso del núcleo de las estrellas

En la imagen podemos contemplar lo que se clasifica NGC 3603, es un cúmulo abierto de estrellas en una vasta zona estelar, rodeada de una región H II (una enorme nube de gas y plasma en el que constantemente están naciendo estrellas), situado en el brazo espiral Carina de la Vía Láctea, a unos 20.000 años-luz de distancia en la constelación de Carina. Es uno de los jóvenes cúmulos de estrellas más luminosas e impresionante en la Vía Láctea, y la concentración más densa de estrellas muy masivas conocidas en la galaxia. Se estima que se ha formado hace alrededor de un millón de años. Las estrellas azules calientes en el núcleo son responsables de la fuerte radiación ultravioleta y los vientos estelares, tallando una gran cavidad en el gas.

NGC 3603 alberga miles de estrellas de todo tipo: la mayoría tienen masas similares o menores a la de nuestro Sol, pero las más espectaculares son algunas de las estrellas muy masivas que están cerca del final de sus vidas. Ahí están presentes algunas estrellas supergigantes que se agolpan en un volumen de menos de un año luz cúbico, se han localizado en la misma zona a tres llamadas Wolf-Rayet, estrellas muy brillantes y masivas que expulsan grandes cantidades de material antes de convertirse en supernovas.

Una de estas estrellas (NGC 3603-A1), una estrella doble azul que orbita alrededor de la otra una vez cada 3,77 días, es la estrella más masiva conocida hasta en la Vía Láctea. La más masiva de estas dos estrellas tiene una masa estimada de 116 masas solares, mientras que su compañera tiene una masa de 89 masas solares. Hay que decir que la máxima máxima de las estrellas está calculada en 120 masas solares, ya que, a partir de ahí, su propia radiación las destruiría.

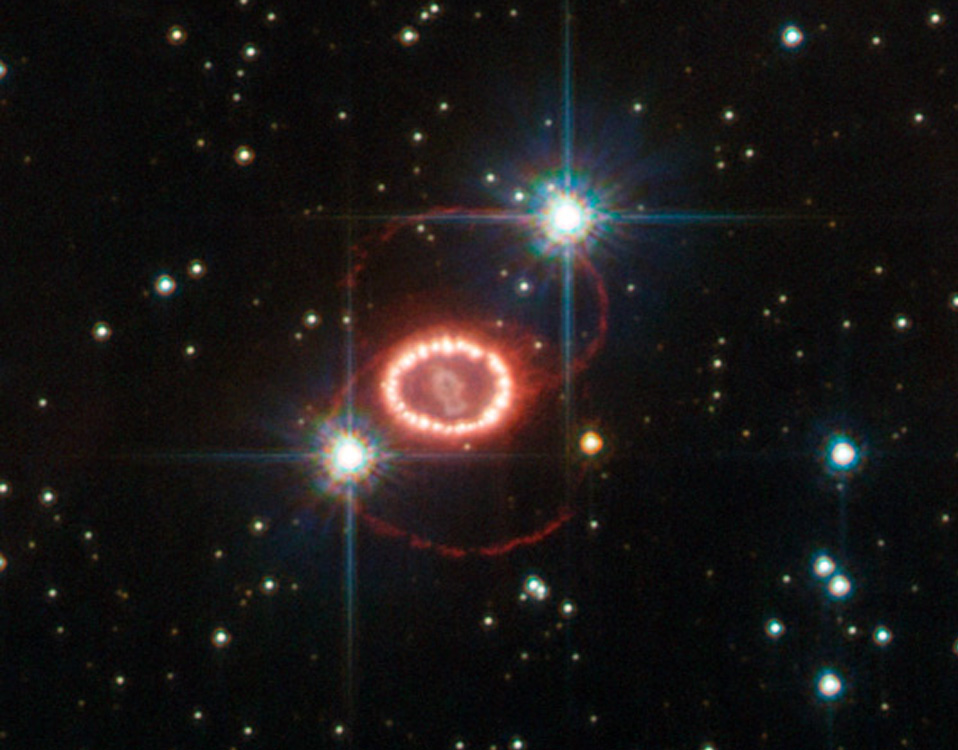

En el centro de la imagen podemos contemplar ese “collar de diamantes” que es el resultado evolucionado de aquella tremenda explosión estelar contemplada en 1987, cuando una estrella supermasiva, habiendo agotado todo su combustible nuclear de fusión, se contrae sobre sí misma al quedar sin defensa, en “manos” de la Gravedad que ya no se ve frenada por la inercia explosiva de la fusión que tendía a expandir la estrella.

Las capas exteriores son eyectadas al Espacio Interestelar con violencia para formar una nebulosa, mientras el grueso de la masa de la estrella se contrae más y más para formar una estrella de neutrones o un agujero negro dependiendo de su masa.

Las estrellas supermasivas cuando colapsan forman extrañas y, a veces, fantásticas imágenes que podemos captar por nuestros más sofisticados telescopios. Hace veinte años, los astrónomos fueron testigos de uno de los más brillantes explosiones estelares en más de 400 años. La supernova titánica, llamada SN 1987A, ardió con la fuerza de 100 millones de soles varios meses después de su descubrimiento el 23 de febrero de 1987.

Las observaciones de SN 1987A, hechas en los últimos 20 años por el Telescopio Espacial Hubble de NASA / ESA y muchos otros grandes telescopios terrestres y espaciales, han servido para cambiar la perspectiva que los astrónomos tenían de cómo las estrellas masivas terminan sus vidas.Estudiando estos sucesos sus comienzos se pueden ver los detalles más significativos del acontecimiento, cosa que, estuadinado los remanentes de supernovas muy antiguas no se podían ver.

Las estrellas supermasivas cuando colapsan forman extrañas y, a veces, fantásticas imágenes que podemos captar por nuestros más sofisticados telescopios. Arriba podemos contemplar observaciones realizadas en distintas fechas que nos muestran la evolución de los anillos de SN 1987 A. ¿Qué pudo causar los extraños anillos de esta Supernova.Hace 28 años se observó en la Gran Nube de Magallanes la supernova más brillante de la historia contemporánea.

El clúster abierto NGC 3603 contiene a Sher 25, una super gigante B1a que inevitablemente morirá en un masivo suceso supernova en los próximos 20,000 . ¡Esto emitirá una luz tan potente que competirá en el cielo con el planeta Venus! Un detalle muy emocionante es que Sher 25 presenta anillos similares a los que dejó la supernova SN 1987 A.

Cuando colapsa el núcleo de una estrella, ocurre en la formación de una estrella de neutrones, es preciso que la estrella esté evolucionada hasta el punto de que su núcleo esté compuesto completamente por hierro, que se niega a ser quemado en reacciones nucleares, no se puede producir la fusión y, por tanto, no produce la energía suficiente como soportar la inmensa fuerza de gravedad que propia masa de la estrella genera y que, solamente era frenada por la energía que produce la fusión nuclear que tiende a expandir la estrella, mientras que la gravedad tiende a contraerla.

El núcleo entonces se contrae, liberando energía potencial gravitatoria, se rompen los núcleos de los átomos de hierro en sus protones y sus neutrones constiituyentes. A medida que aumenta la densidad, los protones se combinan con los electrones para formar neutrones. El colapso sólo se detiene (a veces) con la presión de degeneración del gas de neutrones (Principio de exclusión de Pauli) compensa el empuje hacia adentro de la Gravedad. El proceso completo hasta que todo ese ingente material se transmuta en la estrella de neutrones dura muy poco tiempo, es un proceso vertiginoso.

Otra perspectiva del remanente de la supernova por colapso de núcleo SN 1987A.

Han sido muy variados los grupos de astrónomos investigadores que han realizado observaciones durante largos períodos de tiempo llevar a cabo la no fácil tarea de comprender cómo se forman las estrellas de neutrones y púlsares cuando estrellas masivas llegan al final de sus vidas y finalizan el proceso de la fusión nuclear, momento en el que -como explicaba antes- la estrella se contrae, implosiona sobre sí misma, se produce la explosión supernova y queda el remanente formado por material más complejo en forma de gases que han sido expulsados por la estrella en este proceso final en el que, las capas exteriores de la estrella, forman una nebulosa y la estrella en sí misma, al contraerse y hacerse más densa, es decir de 1017 kg/m3.

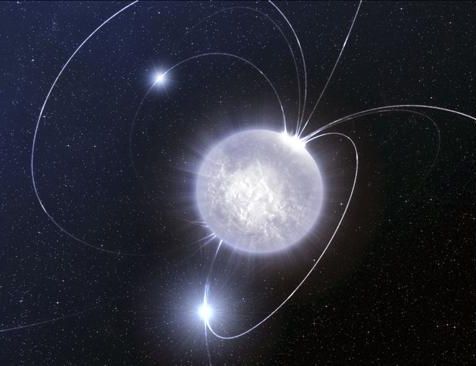

Se ha podido llegar a saber que las supernovas por colapso de núcleo suelen ocurrir en los brazos de galaxias espirales, así como también en las regiones HII, donde se concentran regiones de formación estelar. Una de las consecuencias de esto es que las estrellas, con masas a partir de 8 veces la masa del Sol, son las estrellas progenitoras de estos estos sucesos cósmicos. También es muy interesante y se está estudiando cómo se forman los inmensos campos magnéticos alreddor de estas estrellas de neutrones y púlsares que se conviertan en magnétares.

Cuando hace unos pocos años se descubrió la estrella de neutrones SGR0418, poco podían pensar los astrónomos que su funcionamiento alteraría todas las teorías existentes ahora acerca del funcionamiento de los magnétares. Sin embargo es así, ya que funciona como uno de éstos y no como sería propio de su condicción. Este hallazgo obliga a la ciencia a replantearse las teorías que se manejaban hasta ahora acerca del origen y evolución de los magnétares.

El “universo” de los procesos que siguen al colapso de los núcleos de las estrellas masivas es fascinante. Así, cuando se un púlsar que es una estrella de neutrones que gira sobre sí misma a una gran velocidad y tambien una fuente de ondas de radio que vibran con periodos regulares, este de estrellas tan extrañas son fruto -como antes decía- de una supernova o por consecuencías de la acreción de materia en estrellas enanas blancas en sistemas binarios. Una enana blanca que también es muy masiva, si tiene una estrella compañera cercana, genera mucha fuerza gravitatoria comienza a tirar del material de la estrella vecina y se lo queda hasta tal punto que, se transforma en una estrella de neutrones en una segunda etapa en la que se producen nuevos procesos de implosión.

La densidad de estas estrellas es increiblemente grande, tanto que un cubo de arena lleno del material de una estrella de neutrones tendría un peso parecido al de la montaña mas grande de la tierra, el monte . Los púlsares fueron descubiertos en 1970 y hasta solo se conece unas 300 estrellas de este tipo. Sin embargo, se calcula que sólo en nuestra Galaxia podrían ser un millón. La rápida rotación de los pùlsares los mantiene fuertemente magnetizados y sus rotaciones vertiginosas generan y son inmensas fuentes de electricidad. Llegan a producir mil millones de millones de voltios. Cuando nustros aparatos los observan y estudian detectan intensos haces de radiación en toda la gama del espectro (radio, luz, rayos X, Gamma).

Imagen de rayos-X en falso color de la región del cielo alrededor de SGR 1627-41 obtenida con XMM-Newton. La emisión indicada en rojo procede de los restos de una estrella masiva que estalló. Cubre una región más extendida de lo que se deducía anteriormente de las observaciones de radio, alrededor del SGR. Esto sugiere que la estrella que estalló fue el progenitor del magnetar. Crédito: ESA/XMM-Newton/EPIC (P. Esposito et al.)

Por ahora se conoce que de cada diez supernovas una se convierte en magnetar, si la supernova posee 6 y 12 masas solares, se convierte en una estrella de neutrones de no más de 10 a 20 km de diámetro. En el caso de las estrellas supermasivas de decenas de masas solares, el resultado es muy diferente y nos encontramos con los agujeros negros, esos monstruos del espacio devoradores de materia.

Cuando una estrella supermasiva muere, las consecuencias energéticas son inmensas. Ahí, en esa explosión se producen transiciones de fase que producen materiales pesados y complejos. En una supernova, en orden decreciente tenemos la secuencia de núcleos H, He, O, C, N, Fe, que coincide bastante bien con una ordenación en la tabla periódica de elementos.

Las estrellas mueren cuando dejan la secuenbcia principal, es decir, cuando no tienen material de fusión y quedan a merced de la fuerza de gravedad que hace comprimirse a la estrella más y más, en algunos casos, cuando son supermasivas, llegan a desaparecer de nuestra vista, y, su único destino es convertirse en temibles Agujeros Negros.

La explosión de una estrella gigante y supermasiva hace que brille más que la propia galaxia que la acoge y, en su ese tránsito de estrella a púlsar o agujero negro, se forman elementos que, el oro o el platino, se riegan por el espacio interestelar en las inmensas nebulosas de las que, más tarde, naceran nuevas estrellas y nuevos mundos.

Pero está claro que todo el proceso estelar evolutivo inorgánico nos condujo el simple gas y polvo cósmico a la formación de estrellas y nebulosas solares hasta los planetas, la Tierra en particular, en cuyo medio ígneo describimos la formación de las estructuras de los silicatos, desplegándose con ello una enorme diversidad de composiciones, formas y colores, asistiéndose, por primera vez en la historia de la materia, a unas manifestaciones que contrastan con las que hemos mencionado en relación al proceso de las estrellas. Porque, en última instancia, debemos ser conscientes de un hecho cierto: En las estrellas se ¡ “fabrican los materiales que darán lugar al surgir de la vida”!.

El remanente estelar después de la explosiòn puede ser muy variado

Es posible que lo que nosotros llamamos materia inerte, no lo sea tanto, y, puede que incluso tenga memoria que transmite por medios que no sabemos reconocer. Esta clase de materia, se alía con el tiempo y, en momento adopta una forma predeterminada y de esa manera sigue evolucionando hasta llegar a su máximo ciclo o nivel en el que, de “materia inerte” llega a la categoría de “materia viva”, y, por el camino, ocupará siempre el lugar que le corresponda. No olvidemos de aquel sabio que nos dijo: “todas las cosas son”. El hombre, con aquellas sencillas palabras, elevó a todas las cosas a la categoría de ¡SER!

¿No os pensar que nosotros estemos hechos, precisamente, de lo que llamamos materia inerte?

Claro que, el mundo inorgánico es sólo una del inmenso mundo molecular. El resto lo constituye el mundo orgánico, que es el de las moléculas que contienen carbono y otros átomos y del que quedan excluidos, por convenio y características especiales, los carbonatos, bicarbonatos y carburos metálicos, los cuales se incluyen en el mundo inorgánico.

Según expliqué muchas veces, los quarks u y d se hallan en el seno de los nucleones (protones y neutrones) y, por tanto, en los núcleos atómicos. Hoy día, éstos se consideran una subclase de los hadrones. La composición de los núcleos (lo que en química se llama análisis cualitativo) es extraordinariamente sencilla, ya que como es sabido, constan de neutrones y protones que se pueden considerar como unidades que dentro del núcleo mantienen su identidad. Tal simplicidad cualitativa recuerda, por ejemplo, el caso de las series orgánicas, siendo la de los hidrocarburos saturados la más conocida. Recordad que su fórmula general es CnH2n+2, lo que significa que una molécula de hidrocarburo contiene n átomos de carbono (símbolo C) y (2n+2) átomos de hidrógeno (símbolo H).

Bueno, otra vez, como tantas veces me pasa, me desvío del camino que al principio del me propuse seguir y me pierdo en las elucubraciones que imaginan mis pensamientos. Mejor lo dejamos aquí.

emilio silvera

Oct

25

El saber Sí ocupa un lugar en nuestras Mentes

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

¿El Misterio? Persistirá, ¡como el Tiempo!

Hay veces en las que nos cuentan cosas y hechos de los que nunca hemos tenido noticias y, resultan del máximo interés. Nuestra curiosidad nos llama a desentrañar los misterios y secretos que, tanto a nuestro alrededor, como en las regiones más lejanas del Universo, puedan haber ocurrido, puedan estar sucediendo ahora, o, en el futuro pusidieran tener lugar, ya que, de alguna manera, todas ellas tienen que ver con nosotros que, de alguna manera, somos parte de la Naturaleza, del Universo y, lo que sucedió, lo que sucede y lo que sucederá… ¡Nos importa!

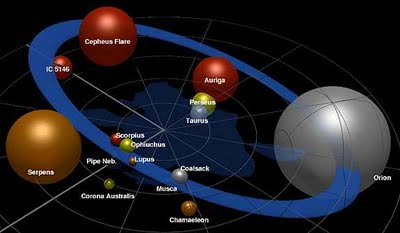

El Cinturón de Gould es un sector del Brazo de Orión. El Brazo de Orión es la primera gran estructura a la que pertenecemos; grande en sentido galáctico. Es un larguísimo arco estelar de 10.000 años-luz de longitud y 3.500 de ancho. Mucho más del 99% de lo que ven nuestros ojos a simple vista, en una noche normal, está aquí. Muchas personas de ciudad vivirán y morirán sin ver en persona nada más allá del Brazo de Orión.

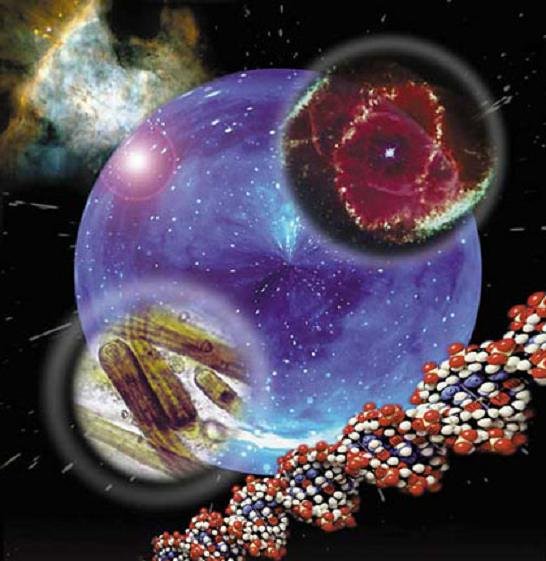

Se ha discutido, argumentado y teorizado sobre la vida durante siglos, quizás milenios. Lo que conocemos como vida es ni más ni menos que una estructura formada de átomos que se han organizado y que lograron crear mecanismos que les permiten mantener esa organización. Decir que los átomos “se han organizado” es una locura. En el mundo material no hay nada más básico que un átomo, y algo tan básico no es capaz de hacer algo tan complejo como “organizarse”.

¿O sí?

Una célula es un sistema muy complejo (célula animal)

La realidad es que sí. Los átomos, en cumplimiento de leyes físicas simples, se organizan en estructuras. La más sencilla es una molécula, que puede estar formada por algunos átomos, pero se llega a estructuras bastante complejas y ordenadas, como los cristales y fibras

naturales y maravillosas formas como las buckyballs.  Buckyballs es el nombre coloquial utilizado para describir un fullereno. Los avances logrados por la Humanidad, son tan grandes que, estando a nuestro alrededor, no somos conscientes de su verdadero alcance.

Buckyballs es el nombre coloquial utilizado para describir un fullereno. Los avances logrados por la Humanidad, son tan grandes que, estando a nuestro alrededor, no somos conscientes de su verdadero alcance.

Nanomateriales aplicados a dispositivos electrónicos y los tres tipos de geometrías de nanotubos de carbono

|

|

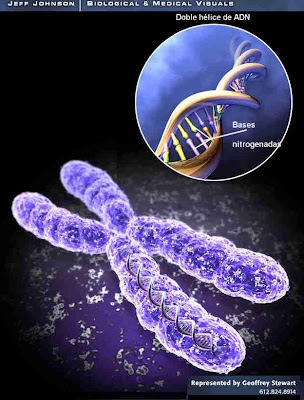

Los avances fueron de hecho tan espectaculares que hacia mediados del siglo XX ya se había dado respuesta a todas las cuestiones sencillas. Conceptos tales como la teoría general de la relatividad y la mecánica cuántica explicaron el funcionamiento global del universo a escalas muy grandes y muy pequeñas respectivamente, mientras el descubrimiento de la estructura del ADN y el modo en que éste se copia de una generación a otra hizo que la propia vida, así como la evolución, parecieran sencillas a nivel molecular. Sin embargo, persistió la complejidad del mundo a nivel humano –al nivel de la vida-. La cuestión más interesante de todas, la que planteaba cómo la vida pudo haber surgido a partir de la materia inerte, siguió sin respuesta.

Un descubrimiento así no podía dejar al mundo indiferente. En unos años el mundo científico se puso al día y la revolución genética cambió los paradigmas establecidos. Mucha gente aún no está preparada para aceptar el comienzo de una era poderosa en la que el ser humano tiene un control de sí mismo mayor al habitual. Había nacido la Ingeniería genética. No debe extrañarnos que sea precisamente a escala humana donde se den las características más complejas del universo.

Claro que nada de esto se aproxima al nivel de organización que implica la vida. Recordemos ahora la parte de la frase sobre los átomos que dice “lograron crear mecanismos”, lo cual jamás puede ser cierto… al menos no en la forma directa que uno se imagina al primer momento. Un virus, por ejemplo, es una especie de “máquina” capaz de propagarse. No de reproducirse, al menos no en el sentido que se le da a la palabra en biología, pero sí de activar un mecanismo que permite obtener copias de sí mismo.

Los virus infectan tanto células como bacterias porque no pueden multiplicarse por sí mismos. Al hacerlo, usan las moléculas y enzimas de su desafortunado hospedero para replicar su genoma y construir sus cápsulas virales, las cuales son muy parecidas a unas sondas espaciales pero que, en este caso, sólo transportan ADN o ARN con el único fin de repetir el ciclo en otra víctima.

Antes de seguir quiero hacer una salvedad: todo lo que diga encontrará alguien para discutirlo. Los conceptos básicos que se aplican a la vida aún no están del todo definidos. Por ejemplo, sé que hay corrientes de pensamiento para las cuales los virus no son seres vivos. De acuerdo, sólo es cuestión de definiciones, y no es necesario —ni posible— discutirlas aquí. Yo prefiero incluir a los virus en este análisis porque son algo así como el primer nivel de estructura a discutir (sí, sé que existen estructuras menores, pero no con tanta entidad).

Siguiendo en la línea que venía, la cuestión es que parece haber una barrera entre el nivel de organización que pueden alcanzar los átomos por leyes simples de la física y la estructura que presenta la vida. ¿Es esto cierto? Da para discutir mucho, pero creo, en base a muchas líneas de investigación y descubrimientos que se vienen presentando, que no. La estructuración de la vida es gradual. De un evento físico no surge una célula ni, mucho menos, un ratón, pero la realidad es que cada uno de los pasos intermedios que llevan desde un amasijo de átomos a una de estas formas de vida son dados por fenómenos que tienen que ver con la física, la química y… la propia orientación de lo que es la vida. Digamos que la vida, una vez aparecida, crea un entorno de leyes propias que impulsan su desarrollo. ¿Cómo y por qué se crean estas leyes, en base a qué voluntad? Ninguna. (Y aquí surgirán de nuevo las discusiones.) Simplemente, no puede existir la vida sin esas leyes. El hecho de que estemos en un planeta que tenga vida por doquier, y muy desarrollada, es porque la vida, cuando existe, sigue estas reglas que le permiten desarrollarse, y si no las sigue desaparece. Es como decir que hay leyes físicas, leyes básicas del universo, que han sido puestas especialmente para la vida. De hecho, considerando la vida una forma de la materia, creo que es así. Es decir, la vida —cumpliendo los requisitos— sería algo inevitable en el Universo…

Kepler A y Kepler B son dos astros con el 69% y el 20% de la masa del Sol respectivamente, mientras que Kepler-16b es un exosaturno que tiene 0,33 veces la masa de Júpiter. Posee un periodo de 229 días y se halla situado a 105 millones de kilómetros del par binario, la misma distancia que separa a Venus del Sol en nuestro Sistema Solar. Pero debido a que Kepler-16 AB son dos estrellas relativamente frías, la temperatura “superficial” de este gigante gaseoso ronda unos gélidos 170-200 K dependiendo de la posición orbital. Es decir, nada que ver con el infierno de Venus. Otros mundos, más parecidos a nuestra Tierra, ¿por qué no tendrían formas de vida? Lo lógico es pensar que sí, que albergue la vida más o menos inteligente y conforme se haya producido su evolución.

Me estoy extendiendo fuera del tema. No pretendo estudiarlo filosóficamente, sino usar un poco de lógica para llegar a una respuesta para una pregunta que se hacen los científicos, y que nos hacemos todos, excepto aquellos que quieren creer en entidades superiores que se ocuparon de ello (lo cual es, simplemente, pasar el problema a otro nivel, sin resolverlo): ¿Cómo es que la vida evolucionó desde átomos, moléculas, células, seres simples, a una especie como la nuestra, tan tremendamente compleja y capaz de, como lo estoy haciendo yo, reflexionar sobre sí misma, transmitirlo y, además, cambiar el mundo como lo estamos cambiando?

Lo estamos cambiando de muchas maneras. Estuve pensando que, si se prueba que es cierta, esta teoría de los georreactores planetarios se debe aplicar a todos los cuerpos planetarios del universo. Estoy seguro de que ustedes deben conocer la ecuación de Drake que intenta estimar el número de inteligencias que podrían existir en el universo, algo que se tiene en gran consideración en el SETI. ¿Se debería agregar un nuevo valor a esta fórmula que represente el tiempo esperado de vida del georreactor en un planeta tipo Tierra? Quizá en el núcleo de los planetas que forman ese escudo magnético a su alrededor, esté el secreto del surgir de la vida en ellos.

Yo creo en una cosa, y esto puede desatar miles de discusiones: llegar desde materiales básicos a la creación del ser humano se basó en juntar los materiales (átomos), tener las leyes físicas actuando y a la casualidad (o azar). ¿Qué quiero decir con “casualidad”? Que la existencia de la vida está ligada a un sorteo permanente. Que hay una enormidad de cosas que son necesarias para que pueda haber vida (es innegable que se han dado en este planeta) y para que pueda continuar una vez producida. Que fue necesario un transcurso determinado de hechos y situaciones para que los microorganismos aparecieran, se propagaran, compitieran y se fueran haciendo más y más complejos. Que se debieron dar infinidad de circunstancias para que estos organismos se convirtieran en estructuras multicelulares y para que estas estructuras se organizaran en órganos ubicados dentro de seres complejos. Y que se necesitaron enormidad de coincidencias y hechos casuales para que las condiciones llevaran a algunos de estos seres terrestres, vertebrados, pequeños mamíferos (por los cuales durante una enormidad de tiempo ningún juez cósmico hubiese apostado), a evolucionar para convertirse en los animales que más influimos en este mundo: nosotros.

La cantidad de circunstancias, situaciones y condiciones en juego es enorme. En un libro muy interesante de Carl Sagan, anterior a Cosmos, llamado Vida inteligente en el Cosmos (junto a I. S. Shklovskii), se plantea muy bien este tema. Se puede encontrar allí una enumeración de las condiciones que requiere la vida y una especie como la nuestra para existir. Desde las características de nuestra galaxia, su edad, composición, situación, forma; a las de nuestro Sol, su sistema de planetas, la ubicación de la Tierra, su tamaño, su rotación, su inclinación, su composición, los vecinos que tiene… y mucho más.

Llegar a esta red compleja que es nuestra mente, ha costado, más de diez mil millones de años, el tiempo que necesitaron las estrellas para fabricar esos elementos de los que estamos hechos. El suministro de datos que llega en forma de multitud de mensajes procede de los sentidos, que detectan el entorno interno y externo, y luego envía el resultado a los músculos para dirigir lo que hacemos y decimos. Así pues, el cerebro es como un enorme ordenador que realiza una serie de tareas basadas en la información que le llega de los sentidos. Pero, a diferencia de un ordenador, la cantidad de material que entra y sale parece poca cosa en comparación con la actividad interna. Seguimos pensando, sintiendo y procesando información incluso cuando cerramos los ojos y descansamos. Pero sigamos.

Yo voy a agregar algunas cosas que me parecen significativas, que han surgido de los últimos descubrimientos y observaciones. Enumero algunas, aunque ya verán que hay más. Extinciones y cambios físicos producidos por impactos de asteroides; influencia de estrellas cercanas, fijas y viajeras; el “clima” interestelar; el “clima” galáctico; las circunstancias que han sufrido los otros planetas; nuestras circunstancias, nada comunes…

Extinciones

Grandes rocas errantes pululan por el Sistema Solar. Los asteroides no son ni cosa del pasado ni riesgos de muy baja probabilidad. Hay pruebas muy concretas sobre diversos impactos de consideración sobre nuestro mundo y, no hace mucho, tuvimos un ejemplo de ello. Encima, hasta parecen tener una regularidad. No es sólo que tenemos la suerte de que en los últimos 10 millones de años no haya caído un gran asteroide en la Tierra, lo que nos hubiese hecho desaparecer incluso antes de que apareciéramos, sino que tenemos la suerte de que antes de eso sí cayeron de esos asteroides, y de que cambiaran las cosas a nuestro favor. ¿Estaríamos aquí si no hubiese impactado un cuerpo de unos 10 km de diámetro en el Caribe, más precisamente sobre el borde de la península de Yucatán, y hubiese producido una hecatombe para quienes reinaban en el mundo en esa época, los dinosaurios? ¿Quién puede saberlo? ¿Y si no hubiesen ocurrido las extinciones anteriores, fueran por las causas que fueran, estaríamos aquí? Quizás un día se sepa lo suficiente como para simular en computadoras una ecología planetaria entera y ver qué hubiera pasado. Será muy interesante.

Los asteroides cayeron, es un hecho. Y forman parte de las condiciones necesarias —algunos discutirán que no— para que estemos aquí… Veamos algunas nuevas informaciones:

Los Amonites fueron contemporáneos de los Dinosaurios. Los amonites eran una de las clases de moluscos cefalópodos que existieron en las eras del Devónico hasta el Cretácico. Hay de diferentes tipologías según la profundidad en la que estaban inmersos, dependiente las distintas zonas de todo el mundo. Al ser un fósil, poco se puede saber de las partes blandas de este organismo marino, suponiéndose que fueron similares a los actuales nautilos, cuyo cuerpo constaba de una corona de tentáculos en la cabeza que asoman por la abertura de la llamada concha. El fósil encontrado en las cercanías de El Chaltén pertenecería al cretácico inferior del estrato llamado Río MAYER, con una antigüedad de unos 500 millones de años.

Vivieron en la Tierra como duelo y selñores más de 150 millones de años.

Hace 380 millones de años se produjo una importante extinción entre los animales que poblaban el mar, en especial de los amonites, unos moluscos emparentados con los pulpos y calamares pero cubiertos con una concha espiralada y de tamaños a veces gigantescos. Nunco se supo por qué fue. Ahora surgen pistas de que esta mortalidad estuvo relacionada —igual que hace 65 millones de años, en el momento en que los dinosaurios dominaban nuestro mundo— con el impacto de un cuerpo extraterrestre.

Algunos geólogos dicen que hace unos 380 millones de años, un asteroide llegado desde el espacio golpeó contra la Tierra. Creen que el impacto eliminó una importante fracción de los seres vivos. Esta idea puede fortalecer la discutida conexión entre las extinciones masivas y los impactos. Hasta ahora, el único candidato para hacer esta relación era el meteoro que habría causado el exterminio de los dinosaurios, caído en la península de Yucatán, en México.

Brooks Ellwood, de Louisiana State University en Baton Rouge, Estados Unidos, dice que los signos de una antigua catátrofe coinciden con la desaparición de muchas especies animales. “Esto no quiere decir que el impacto en sí mismo haya matado a los animales; la sugerencia es que tuvo algo que ver.” Y agregó que hoy, aunque no se puedan encontrar rastros del cráter de una roca del espacio, se puede saber dónde ha caído.

Otros investigadores coinciden en que hubo un impacto más o menos en esa época, pero creen que la evidencia de que produjo una extinción masiva es muy débil. Claro que, tal valoración no está avalada por hechos y, si tenemos en cuenta el tiempos transcurrido desde los hechos, buscar pruebas materiales…no es nada fácil

El equipo de Ellwood descubrió rocas en Marruecos que fueron enterradas alrededor de 380 millones de años atrás bajo una capa de sedimento que parece formada por restos de una explosión cataclísmica. El sedimento tiene propiedades magnéticas inusuales y contiene granos de cuarzo que parecen haber experimentado tensiones extremas.

Más o menos para esa época se produjo la desaparición del registro fósil de alrededor del 40% de los grupos de animales marinos.

El geólogo Paul Wignall, de la Leeds University, Reino Unido, dice que hay una fuerte evidencia del impacto. Si se lo pudiese relacionar con una extinción masiva sería un gran hallazgo. Si fuera cierto, el potencial letal de los impactos crecería enormemente.

Pero no está claro cuántas desapariciones se produjeron en la época del impacto. Wignall dice que la mortalidad puede haber sido mucho menor que lo que sugiere el equipo de Ellwood. Él piensa que los paleontólogos deberían buscar las pistas que les den una mejor imagen de lo que pasó en aquella época.

El paleontólogo Norman MacLeod, que estudia las extinciones masivas en el Natural History Museum de Londres, coincide en que aunque 40% es el valor correcto para aquel período de la historia de la Tierra, no es una extinción masiva, sino parte de una serie de sucesos mucha más extensa. MacLeod duda de que las extinciones masivas sean resultado de intervenciones extraterrestres. “Los impactos son un fenómeno bastante común”, dice. “Pero no coinciden significativamente con los picos de extinción.”

Las estrellas vecinas

Aunque nuestro entorno es inmenso, hemos llegado a conocer muy bien nuestra vecindad

Nuestro vecindario galáctico es muy humilde. Nada de supergigantes o exóticas estrellas de neutrones. La mayoría de estrellas vecinas -unas 41- son simples enanas rojas (estrellas de tipo espectral M), las estrellas más comunes del Universo. Cinco son estrellas de tipo K, dos de tipo solar (tipo G, Alfa Centauri A y Tau Ceti), una de tipo F (Procyon) y una de tipo A (Sirio). Los tipos espectrales se ordenan según la secuencia OBAFGKM, siendo las estrellas más calientes (y grandes) las de tipo O y las más pequeñas y frías las de tipo M (siempre y cuando estén en la secuencia principal, claro). Además tenemos tres enanas blancas y tres candidatas a enanas marrones. Como vemos, no nos podemos quejar. Hay toda una multitud de posibles objetivos para nuestra primera misión interestelar. ¿Cuál elegir?

El llamado Grupo Local de galaxias al que pertenecemos es, afortunadamente, una agrupación muy poco poblada, sino podríamos ser, en cualquier momento (o haber sido aún antes de existir como especie) destruidos en catástrofes cósmicas como las que ocurren en los grupos con gran población de galaxias. Los astrónomos comprenden cada vez más el porqué de las formas de las galaxias, y parece que muchas (incluso la nuestra) han sufrido impactos contra otras para llegar a tener la figura que tienen. Gracias al telescopio espacial Hubble se están viendo en los últimos tiempos muy buenas imágenes de colisiones entre galaxias.

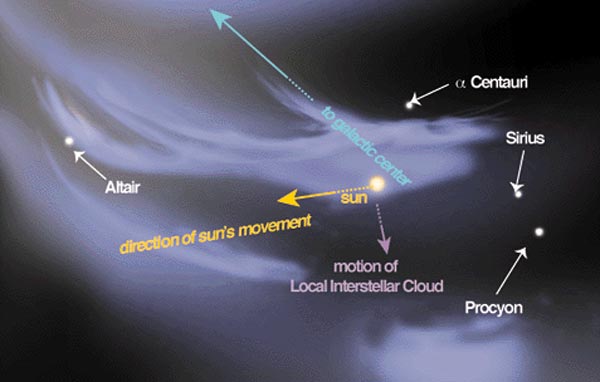

El “clima” interestelar

La Nube Interestelar Local se encuentra dentro de una estructura mayor: la Burbuja Local. La Burbuja Local es una acumulación de materia aún mayor, procedente de la explosión de una o varias supernovas que estallaron hace entre dos y cuatro millones de años. Pero aunque estemos atravesando ahora mismo la Nube Interestelar y la Burbuja locales, nuestra materia no procede de ellas. Sólo estamos pasando por ahí en este momento de la historia del universo. Entramos hace unos cinco millones de años, y saldremos dentro de otros tantos. Nuestro sistema solar –y la materia que contiene, incluyéndonos a ti y a mí– se formó mucho antes que eso, hace más de 4.500 millones de años.

“Banda de estrellas calientes y brillantes que forman un círculo alrededor del cielo. Representa una estructura local de estrellas jóvenes y material interestelar inclinada unos 16º con respecto al plano galáctico. Entre los componentes más prominentes del cinturón se encuentran las estrellas brillantes de Orión, Can mayor, constelación de la Popa, Carina, Centauro y Escorpio, incluyendo la asociación Sco-Cen. El cinturón tiene el diámetro de unos 3.000 años luz (alrededor de una décima parte del radio de la Galaxia), hallándose el Sol en él. Visto desde la Tierra, el Cinturón de Gould se proyecta por debajo del plano de nuestra Galaxia desde el borde inferior del Brazo de Orión, y por encima en la dirección opuesta. El cinturón se estima que tiene unos 50 millones de años de antigüedad, aunque su origen es desconocido. Su nombre proviene del astrónomo Benjamin Apthorp Gould, quien lo identificó durante la década de 1879.”

Al parecer, la Vía Láctea, nuestra galaxia, reside dentro de una “burbuja local” en una red de cavidades en el medio interestelar que probablemente fue esculpida por estrellas masivas que explotaron hace millones de años. Se le llama Medio Interestelar a la materia que existe en el espacio y que se encuentra situada entre los sistemas estelares. Esta materia está conformada por gas en forma de iones, átomos y moléculas, además de gas y rayos cósmicos.

Nuestra Burbuja Local forma a su vez parte del Cinturón de Gould que presentamos más arriba. El Cinturón de Gould es ya una estructura mucho más compleja y mayor. Es un anillo parcial de estrellas, de unos 3.000 años luz de extensión. ¿Recuerdas aquella nave espacial tan rápida que utilizamos antes? Pues con ella, tardaríamos 12.800.000 años en atravesarlo por completo. Vaya, esto empieza a ser mucho tiempo.

La Burbuja Local es una cavidad en el medio interestelar en el Brazo de Orión de la Vía Láctea. Tiene al menos un diámetro de 300 años luz. El gas caliente y difuso en la Burbuja Local emite rayos X.

|

|

Vivimos dentro de una burbuja. El planeta, el Sistema Solar, nuestro grupo local. El estallido de una supernova ha dejado un resto fósil en nuestro entorno: creó una enorme burbuja en el medio interestelar y nosotros nos encontramos dentro de ella. Los astrónomos la llaman “Burbuja local”. Tiene forma de maní, mide unos trescientos años luz de longitud y está prácticamente vacía. El gas dentro de la burbuja es muy tenue (0,001 átomos por centímetro cúbico) y muy caliente (un millón de grados), es decir, mil veces menos denso y entre cien y cien mil veces más caliente que el medio interestelar ordinario. Esta situación tiene influencia sobre nosotros, porque estamos inmersos dentro. ¿Qué pasaría si nos hubiese tocado estar dentro de una burbuja de gases ardientes resultantes de una explosión más reciente o de otro suceso catastrófico? ¿O si estuviésemos en una zona mucho más fría del espacio? No estaríamos aquí.

En algunos lugares de la Tierra, podemos ir viajando por caminos y carreteras y encontrarnos de frente con imágenes que, por su magnificencia, ¡asustan! Nuestra galaxia está en movimiento constante. No es una excepción en relación con el resto del universo. La Tierra se mueve alrededor del Sol, este último gira en torno a la Vía Láctea, y la gran mancha blanca a su vez forma parte de súper cúmulos que se mueven en relación a la radiación remanente de la gran explosión inicial. Pero hablemos del…

”Clima” galáctico

Dado que la Vía Láctea se está moviendo hacia la constelación de Hydra con una velocidad de 550 km / s, la velocidad del sol es de 370 km / s, …

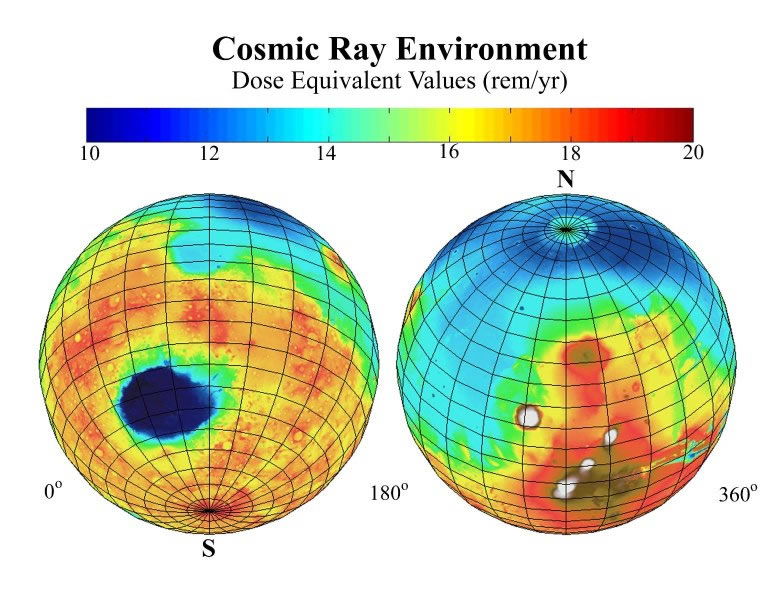

La galaxia en que vivimos podría tener una mayor influencia en nuestro clima que lo que se pensaba hasta ahora. Un reciente estudio, controvertido aún, asegura que el impacto de los rayos cósmicos sobre nuestro clima puede ser mayor que el del efecto invernadero que produce el dióxido de carbono.

|

|

Según uno de los autores de este estudio, el físico Nir Shaviv de la Universidad Hebrea de Jerusalén, en Israel, el dióxido de carbono no es tan “mal muchacho” como dice la gente. Shaviv y el climatólogo Ján Veizer de la Universidad Ruhr, de Alemania, estiman que el clima terrestre, que exhibe subas y bajas de temperatura global que al graficarse forman una figura de dientes de sierra, está relacionado con los brazos espirales de nuestra galaxia. Cada 150 millones de años, el planeta se enfría a causa del impacto de rayos cósmicos, cuando pasa por ciertas regiones de la galaxia con diferente cantidad de polvo interestelar.

Los rayos de todo tipo se nos vienen encima desde todos los rincones del Universo, y, algunos no llegan a la superficie de nuestro planeta gracias al escudo protector que salvaguarda nuestra integridad física.

Los rayos cósmicos provenientes de las estrellas moribundas que hay en los brazos de la Vía Láctea, ricos en polvo, incrementan la cantidad de partículas cargadas en nuestra atmósfera. Hay algunas evidencias de que esto ayuda a la formación de nubes bajas, que enfrían la Tierra.

Shaviv y Veizer crearon un modelo matemático del impacto de rayos cósmicos en nuestra atmósfera. Compararon sus predicciones con las estimaciones de otros investigadores sobre las temperaturas globales y los niveles de dióxido de carbono a lo largo de los últimos 500 millones de años, y llegaron a la conclusión de que los rayos cósmicos por sí solos pueden ser causa del 75% de los cambios del clima global durante ese período y que menos de la mitad del calentamiento global que se observa desde el comienzo del siglo veinte es debido al efecto invernadero.

La teoría, como es normal en la ciencia, no es del todo aceptada. Los expertos en clima mundial están a la espectativa, considerando que algunas de las conexiones que se han establecido son débiles. Se debe tener en cuenta, dicen los paleontólogos, que se trata de una correlación entre la temperatura, que es inferida de los registros sedimentarios, de la cantidad de dióxido de carbono, que se deduce del análisis de conchas marinas fosilizadas, y de la cantidad de rayos cósmicos, que se calculan a partir de los meteoritos. Las tres técnicas están abiertas a interpretaciones. Además, uno de los períodos fríos de la reconstrucción matemática es, en la realidad, una época que los geólogos consideran caliente. De todos modos, también hay muchos otros que están muy interesados e intrigados.

La variabilidad solar afecta la cantidad de rayos cósmicos que impactan a nuestro planeta. El Sol produce radiaciones similares a los rayos cósmicos, especialmente en el período más caliente, llamado máximo solar (maximum), de su ciclo de 11 años. Estudios anteriores no pudieron separar el impacto climático de esta radiación, de los rayos cósmicos que llegan desde la galaxia y de la mayor radiación calórica que llega desde el Sol.

Los otros planetas y la Luna

Recientemente, se ha anunciado el hallazgo de un sistema planetario que podría ser similar al nuestro. En realidad no se ha logrado aún una observación tan directa que permita afirmarlo, sino que se deduce como posibilidad. Este sistema presenta un planeta gaseoso gigante similar a nuestro Júpiter, ubicado a una distancia orbital similar a la que tiene Júpiter en nuestro sistema. El sol es similar al nuestro, lo que deja lugar a que haya allí planetas ubicados en las órbitas interiores, dentro de la franja de habitabilidad en la que la radiación solar es suficiente para sostener la vida y no es excesiva como para impedirla.

Si nuestro sistema no tuviese las características que posee, la vida en la Tierra tendría problemas. Por ejemplo, podría haber planetas, planetoides o grandes asteroides (de hecho algo hay) que giraran en planos diferentes y con órbitas excéntricas y deformes. Cuerpos así podrían producir variaciones cíclicas que hicieran imposible —o difícil— la vida. Venus parece haber sufrido un impacto que le cambió el sentido de rotación sobre sí mismo. Es posible que este impacto también haya desbaratado su atmósfera y su clima. Podría habernos pasado a nosotros, y de hecho parecería que nos ocurrió, sólo que fue durante el génesis del sistema planetario y además (otra gran casualidad y premio cósmico) nos dejó a la Luna, excelente compañera para facilitar la vida.

¿Características especiales de nuestro mundo?

|

|

La cosa no acaba aquí: si el calor del reactor es el que produce la circulación de hierro fundido (por convección) que genera el campo magnético terrestre, entonces los planetas que no tienen su reactor natural no tendrían un campo magnético (magnetósfera) que los proteja de las radiaciones de su sol —como Marte y la Luna— lo que hace que difícilmente puedan sostener vida.

Pero ésta es sólo una teoría. Lo que está más en firme es que nuestro mundo y su luna forman un sistema muy particular, mucho más estable que si se tratara de un planeta solitario. Gracias a esto —a nuestra Luna— tenemos un clima más o menos estable, conservamos la atmósfera que tenemos y la velocidad y el ángulo de nuestro giro son los que son. Si no estuviese la Luna, el planeta se vería sujeto a cambios en su eje de rotación muy graves para los seres vivos.

emilio silvera

Totales: 67.079.421

Totales: 67.079.421 Conectados: 39

Conectados: 39