Nov

26

MISIÓN MARTE 2020

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Marte ~

Clasificado en Marte ~

Comments (0)

Comments (0)

Tratarán de convertir el CO2 en Oxígeno

El próximo proyecto de la NASA en el planeta rojo, será la Misión Marte 2020, en la que destaca la intención de investigar la manera de transformar el CO2 en oxígeno. Desde aquellos lejanos tiempos de en los que algunos creyeron ver “los Canales de Marte”, nuestra imaginación nunca ha dejado de elucubrar fantasías sobre aquel planeta hermano que… ¡Tan cerca y tan lejos está!

Europa Press | Madrid | Actualizado el 03/08/2014 a las 23:05 horas

El próximo rover que la NASA enviará a Marte en 2020 llevará siete instrumentos cuidadosamente seleccionados para investigaciones sin precedente en el Planeta Rojo. El más llamativo persigue convertir en oxígeno dióxido de carbono de la atmósfera marciana.

La NASA ha escogido sobre 58 propuestas recibidas en enero de investigadores e ingenieros de todo el mundo. Las propuestas recibidas fueron el doble del número habitual en este tipo de convocatorias, un indicador de lo extraordinario interés por la comunidad científica en la exploración de Marte.

La Misión Marte 2020 se basa en el diseño del exitoso Curiosity, que aterrizó hace casi dos años, y actualmente está operando en Marte. El nuevo rover llevará hardware más sofisticado y nuevos instrumentos para realizar evaluaciones geológicas del sitio de aterrizaje, determinar la habitabilidad potencial del medio ambiente, y buscar directamente signos de la antigua vida marciana, según informa la NASA.

“La exploración de Marte será el legado de esta generación, y el rover Marte 2020 será otro paso crítico en el camino de los seres humanos al Planeta Rojo”, dijo el administrador de la NASA, Charles Bolden.

Los científicos utilizarán el vehículo para identificar y seleccionar una colección de muestras de roca y suelo que almacenará para su posible regreso a la Tierra de una futura misión.

El rover de Marte 2020 también ayudará a avanzar en nuestro conocimiento de cómo los futuros exploradores humanos podrían utilizar los recursos naturales disponibles en la superficie del planeta rojo. La capacidad de vivir de la tierra marciana transformaría la futura exploración del planeta. Los diseñadores de las futuras expediciones humanas pueden utilizar esta misión para entender los peligros planteados por el polvo marciano y demostrar la tecnología para procesar el dióxido de carbono de la atmósfera para producir oxígeno.

Las propuestas seleccionadas son:

– MastCam-Z: un sistema de cámara avanzada con capacidad estereoscópica de imágenes panorámicas y con capacidad de zoom. El instrumento también determinará la mineralogía de la superficie marciana y ayudará en las operaciones del rover. El investigador principal es James Bell, de la Universidad Estatal de Arizona en Tempe.

– SuperCam, un instrumento que puede proporcionar imágenes, análisis de la composición química, y la mineralogía. El instrumento también será capaz de detectar la presencia de compuestos orgánicos en rocas y regolito a distancia. El investigador principal es Roger Wiens, del Laboratorio Nacional de Los Alamos, Nuevo México.

– Instrumento Planetario para Litoquímica en Rayos X (PIXL), un espectrómetro de fluorescencia de rayos X, que también contendrá un reproductor de imágenes de alta resolución para determinar la composición elemental a escala fina de materiales de la superficie de Marte. PIXL proporcionará capacidades que permitan la detección y análisis más detallados de elementos químicos que nunca. La investigadora principal es Abigail Allwood, el Laboratorio de Propulsión a Chorro de la NASA en Pasadena, California.

– Escaneo de Entornos Habitables con Raman y Luminiscencia para Productos Orgánicos y Químicos (SHERLOC), un espectrómetro que proporcionará imágenes a escala fina y utiliza una luz ultravioleta de láser para determinar la mineralogía a escala fina y detectar compuestos orgánicos. El investigador principal es Luther Beegle, DEL JPL.

– Experimento ISRU de Oxígeno en Marte, una investigación de tecnología de exploración que va a producir oxígeno a partir del dióxido de carbono atmosférico marciano. El investigador principal es Michael Hecht, Institute of Technology, Cambridge, Massachusetts.

– Analizador de Dinámicas Ambientales en Marte, un conjunto de sensores que permitirá la medición de temperatura, velocidad y dirección del viento, presión, humedad relativa y el tamaño y la forma de polvo. El investigador principal es José Rodríguez-Manfredi, del Centro de Astrobiología, Instituto Nacional de Tecnica Aeroespacial, España.

– Radar de Imagen para la Exploración del Subsuelo de Marte, un radar de penetración de tierra que proporcionará resolución de centímetro en la estructura geológica del subsuelo. El investigador principal es Svein-Erik Hamran, del Forsvarets forskning Institute, Noruega.

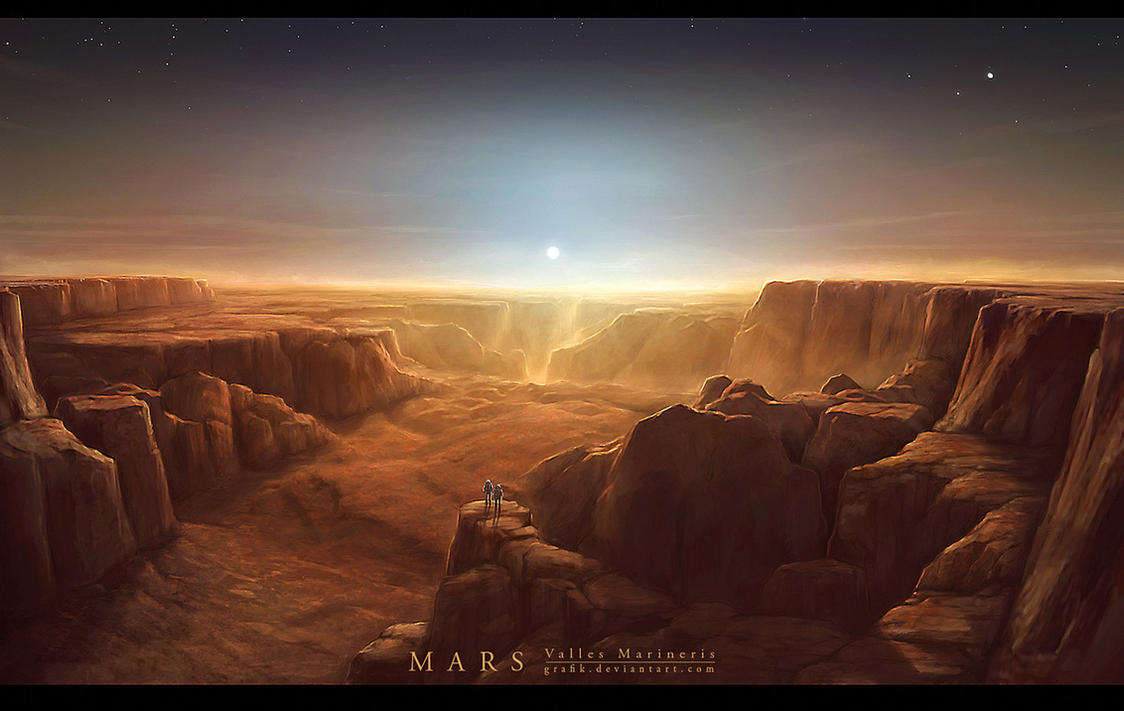

Arriba podemos contemplar Valles Marineris, un accidente geográfico de cuatro mil kilómetros de longitud, 200 de ancho y 10 de profundidad. Marte tiene rincones que debemos descubrir y, sobre todo, me intrigan esos huecos o grutas naturales que bajo la superficie fueron hechos por la pasada actividad volcánica del planeta en el pasado. Allí, a más profundidad y más alta temperatura, a salvo de la radiación nosiva del exterior… ¡Pudiera estar presente el agua líquida! Y, si eso es así… ¡La Vida andará muy cerca.

Como podéis ver por la noticia de la NASA, no dejamos de dar pequeños pasos hacia nuevos “pequeños” logros en aquel planeta que, algún día (lejano aún ene l futuro), podremos visitar.

emilio silvera

Nov

21

Y el autómata se hizo humano

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias ~

Clasificado en Noticias ~

Comments (1)

Comments (1)

Congreso humanoids 2014. Edición: INMACULADA COBO / Información: EVA MOSQUERA RODRÍGUEZ / Foto: AFP

“Imagínese un mundo compartido por robots humanoides y personas. No piense en Blade Runner, ni en Terminator, ni en Matrix. Piense en un mundo en el que la tecnología se alía con usted para hacerle la vida más fácil. Ahora deje de imaginar y abra los ojos, porque ese mundo ya está aquí. Los robots están integrados en nuestros hogares, en nuestras oficinas, en los hospitales y en los laboratorios. Y es en estos últimos donde se trabaja duro para que los humanoides lleguen también a la vida cotidiana.

Asimov lo imaginó y la innovación quiere convertir sus sueños en ciencia. El Congreso Humanoids 2014 que se ha celebrado esta semana en Madrid, es un claro ejemplo de que la tecnología puede ayudar al ser humano en gran cantidad de escenarios. Durante el que se considera el evento más importante del mundo en el campo de la robótica, más de 30 países han mostrado las capacidades de sus humanoides. A la cita no han faltado los ingenieros españoles. Empresas como Pal Robotics y Juguetrónica han demostrado como sus modelos caminan, mantienen el equilibrio y tienen gran libertad de movimiento. Incluso pueden hablar.

El robot DARwIn-OP, de robotis. INMACULADA COBO

El robot DARwIn-OP, de robotis. INMACULADA COBO

El autómata más popular de Humanoids ha sido Nao, un pequeño robot de aspecto amigable que, por su sencilla programación, puede ser usado incluso por niños de seis años. El CEO de Juguetrónica, Daniel Bayón, explica que «Nao ya está en miles de laboratorios para mejorar la inteligencia artificial, pero se puede utilizar para cantidad de aplicaciones. Incluso llegará a ser un robot doméstico». Nao, al igual que el famoso humanoide japonés Asimo, es extranjero. Ha nacido en una empresa francesa pero es políglota y ya se comercializa por todo el mundo.

España va a la carrera. La Universidad Carlos III de Madrid (UC3M), con su Robotics Lab, y la Universidad Politécnica de Madrid (UPM) -asociada con el Centro Superior (CSIC), con su Centro de Automática y Robótica (CAR)- se han convertido en las apuestas más fuertes para el avance de esta tecnología en nuestro país.

El robot Teo, del ‘Robotics Lab’ de la UC3M. INMACULADA COBO

El robot estrella del Robotics Lab es Teo, presentado por primera vez en sociedad en este evento. «A excepción de un par de piezas, es de fabricación 100% española», explica Miguel González-Fierro, investigador de este centro. «Nuestro objetivo es ayudar a la gente. Queremos hacerle la vida más fácil a las personas, pero sobre todo nos gustaría mejorar la calidad de vida de ancianos y discapacitados. Los humanoides podrían hacer todas las tareas que ellos no pueden hacer», concluye González-Fierro.

El CAR también pretende ser de ayuda al mundo. Sus campos de investigación pasan desde «la percepción artificial hasta la locomoción para personas de movilidad reducida y rehabilitación», cuenta Manuel Armada, director de este centro mixto.

Además, otro de sus grupos se dedica a la telemanipulación, es decir, el manejo de tecnologías a distancia. «Un ingeniero podría sentir el objeto que está manipulando a distancia como si estuviese allí mismo. Esto es útil para zonas sin atmósfera, como el espacio, o espacios difíciles de acceder o nocivos para el ser humano, como lo sería Fukushima después de su catástrofe nuclear», explica Jose Breñosa, investigador en este ámbito.

Lo dijo Steve Jobs y lo recordó el presidente de la Comunidad de Madrid, Ignacio González, durante la inauguración de Humanoids: «La tecnología no es nada. Lo realmente importante es que tengas fe en la gente, en que todos somos buenos e inteligentes, y que si le damos herramientas, harán cosas maravillosas con ellas».”

Nov

21

Buscando la Gravedad cuántica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Quién sabe cómo nos veremos nosotros dentro de unos cientos de años

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”. Lo cierto es que, para que las dos teorías, cuántica y relativista se reúnan sin que surjan los dichosos infinitos, se tiene que plantear dentro de una teoría de dimensiones extra. Esas teorías de más dimensiones, requieren de complejas formulaciones que no todos, podemos entender.

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado!

¿Quién puede ir a la longitud de Planck para verla?

Ni vemos la longitud de Planck ni las dimensiones extra

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

Nuestro es tridimensional y no podemos ver otro más allá… ¡si existe!

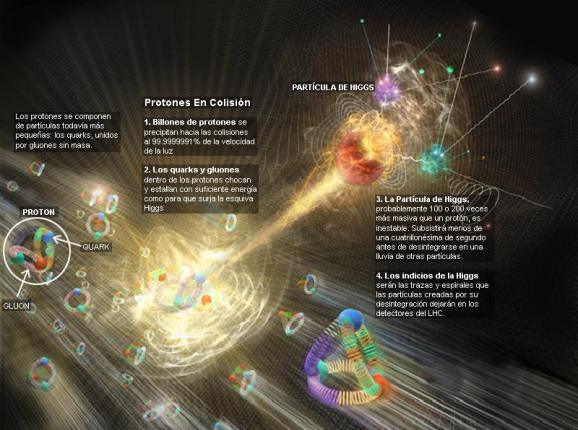

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC que con sus 14 TeV no llegaría ni siquiera a vislumbrar esas cuerdas vibrantes de las que tanto se habla.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías.

Con sus 20 parámetros aleatorios (parece que uno de ellos ha sido hallado -el bosón de Higgs-), el Modelo estándar de la física de partículas que incluye sólo tres de las interacicones fundamentales -las fuerzas nucleares débil y fuerte y el electromagnetismo-, ha dado un buen resultado y a permitido a los físicos trabajar ampliamente en el conocimiento del mundo, de la Naturaleza, del Universo. Sin embargo, deja muchas preguntas sin contestar y, lo cierto es que, se necesitan nuevas maneras, nuevas formas, nuevas teorías que nos lleven más allá.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las partículas que conocemos y están incluidas en el Modelo estándar, se nos ha dicho que ha sido encontrada pero, nada se ha dicho de cómo ésta partícula transmite la masa a las demás. Faltan algunas explicaciones.

El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

Los del LHC dicen haber encontrado el Bosón de Higgs pero, no he podido leer ni oir, alguna explicación clara y precisa de cómo le dá masa a las demás partículas. Espero que, el Nobel se justifique y que expongan con detalle lo que pasa en los llamados “océanos de Higgs” por el que las partículas circulan para adquirir sus masas que les “proporciona” el recien “hallado” bosón.

¿Cómo llegamos aquí? Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes. Es decir, que si miramos a las estrellas en una noche clara estamos mirando el campo de Higgs. Las partículas influidas por este campo, toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado, del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquiriría energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra.

Como E=mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del Sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein. La masa, m, tiene en realidad dos partes. Una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Peor la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más

apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas. Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC). Pero el problema es irritante: ¿por qué sólo esas masas –Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

No dejamos de experimentar para saber ccómo es nuestro mundo, la Naturaleza, el Universo que nos acoge

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa –los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que Gerard ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

En esta última dirección ha publicado numerosos libros y artículos, donde aborda la asignatura pendiente de la unificación de la mecánica cuántica y la teoría del campo gravitatorio. El camino que ha seguido Penrose es encontrar una base común a ambas.

Para ello ha introducido dos modelos: los “spin networks” y los “twistors”, el primero discreto, con una métrica intrínseca, no relativista, previo al concepto de espacio, el segundo continuo, con una métrica extrínseca, relativista e inmerso en un espacio-tiempo dado.

Claro que son varias las corrientes que quieren abrirse camino hacia otras físicas nuevas.

La teoría de supercuerdas tiene tantas sorpresas fantásticas que cualquiera que investigue en el tema reconoce que está llena de magia. Es algo que funciona con tanta belleza… Cuando cosas que no encajan juntas e incluso se repelen, si se acerca la una a la otra alguien es capaz de formular un camino mediante el cual, no sólo no se rechazan, sino que encajan a la perfección dentro de ese sistema, como ocurre ahora con la teoría M que acoge con naturalidad la teoría de la relatividad general y la teoría mecánico-cuántica; ahí, cuando eso se produce, está presente la belleza.

Lo que hace que la teoría de supercuerdas sea tan interesante es que el marco estándar mediante el cual conocemos la mayor parte de la física es la teoría cuántica y resulta que ella hace imposible la gravedad. La relatividad general de Einstein, que es el modelo de la gravedad, no funciona con la teoría cuántica. Sin embargo, las supercuerdas modifican la teoría cuántica estándar de tal manera que la gravedad no sólo se convierte en posible, sino que forma parte natural del sistema; es inevitable para que éste sea completo.

¿Por qué es tan importante encajar la gravedad y la teoría cuántica? Porque no podemos admitir una teoría que explique las fuerzas de la naturaleza y deje fuera a una de esas fuerzas. Así ocurre con el Modelo Estándar que deja aparte y no incluye a la fuerza gravitatoria que está ahí, en la Naturaleza.

La teoría de supercuerdas se perfila como la teoría que tiene implicaciones si tratamos con las cosas muy pequeñas, en el microcosmos; toda la teoría de partículas elementales cambia con las supercuerdas que penetra mucho más; llega mucho más allá de lo que ahora es posible.

La topología es, el estudio de aquellas propiedades de los cuerpos geométricos que permanecen inalteradas por transformaciones continuas. La topología es probablemente la más joven de las ramas clásicas de las matemáticas. En contraste con el álgebra, la geometría y la teoría de los números, cuyas genealogías datan de tiempos antiguos, la topología aparece en el siglo diecisiete, con el nombre de analysis situs, ésto es, análisis de la posición.

De manera informal, la topología se ocupa de aquellas propiedades de las figuras que permanecen invariantes, cuando dichas figuras son plegadas, dilatadas, contraídas o deformadas, de modo que no aparezcan nuevos puntos, o se hagan coincidir puntos diferentes. La transformación permitida presupone, en otras palabras, que hay una correspondencia biunívoca entre los puntos de la figura original y los de la transformada, y que la deformación hace corresponder puntos próximos a puntos próximos. Esta última propiedad se llama continuidad, y lo que se requiere es que la transformación y su inversa sean ambas continuas: así, trabajarnos con homeomorfismos.

En cuanto a nuestra comprensión del universo a gran escala (supercúmulos de galaxias, ondas gravitacionales, posibles estrellas de Quarks-Gluones… el propio Big Bang…), creo que afectará a nuestra idea presente, al esquema que hoy rige y, como la nueva teoría, el horizonte se ampliará enormemente; el cosmos se presentará ante nosotros como un todo, con un comienzo muy bien definido y un final muy bien determinado. El Tiempo y la Entropía tienen mucho que decir en todo eso y, por el camino hacia el conocimiento pleno, tendremos que comprender, de manera completa y exacta que es la Luz, la Gravedad y… ¡tántas cosas!

Para cuando eso llegue, sabremos lo que es, como se genera y dónde están situados los orígenes de esa “fuerza”, “materia”, o, “energía” que ahora no sabemos ver para explicar el movimiento de las galaxias o la expansión del espacio mismo, la posible existencia de otros universos…

emilio silvera

Nov

20

¡Celebración!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Celebraciones ~

Clasificado en Celebraciones ~

Comments (0)

Comments (0)

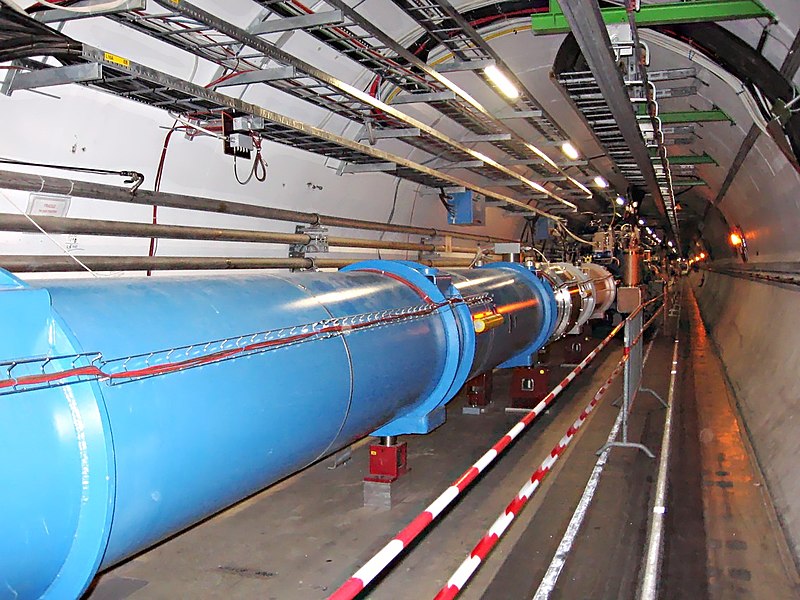

El 29 de septiembre de 1954 entró en vigor la Convención del CERN, estableciendo oficialmente la Organización Europea para la Investigación Nuclear con 12 estados miembros de Europa. Convertido ahora en el mayor laboratorio del mundo de física de partículas, el CERN celebra ’60 años de ciencia para la paz’ con una ceremonia oficial y varios eventos públicos que tienen lugar durante el mes de septiembre.

El punto culminante de este mes de aniversario será la ceremonia oficial del 29 de septiembre, a la que asistirán representantes de los Estados miembros del CERN (entre los que está España), Estados asociados y Observadores. Los periodistas pueden asistir a este evento, para lo cual deben obtener acreditación antes del 18 de Septiembre mediante un registro en esta página web.

“Con sus descubrimientos e innovaciones, el CERN ha unido el mundo a través de la ciencia durante 60 años. Nos gustaría celebrar este importante aniversario con nuestros amigos y vecinos”, dijo Rolf Heuer, Director General del CERN.

El CERN también invita al público a varios eventos culturales que conmemoran su aniversario: conciertos, películas, actuaciones y conferencias que acercarán la ciencia a los ciudadanos.

- Viernes, 19 de septiembre, 18:30 horas, en el CERN: Concierto a cargo de la Orquesta de las Naciones Unidas. Entrada libre con reserva a través de la web www.cern.ch/voisins

- Sábado, 20 de septiembre, 19 horas, en el CERN: proyección del documental Particle Fever (en español, Locos por las partículas) y Noche de Comedia (monólogos científicos). Entrada libre con reserva a través de la web www.cern.ch/voisins

- Miércoles, 24 de septiembre: segunda edición del TEDXCERN

- Viernes, 26 de septiembre: Noche los investigadores en el CERN, con varias actividades entre ellas un preestreno de Origins, un montaje innovador que mezcla teatro con nuevas tecnologías y hologramas, y un café científico con Fabiola Gianotti, Etienne Klein, Hubert Reeves y Michel Mayor. Detalles en www.cern.ch/voisins

- Jueves, 30 de septiembre: Concierto del Coro del CERN, dirigido por Gonzalo Martínez, celebra su 40 aniversario. Más información en www.cern.ch/voisins

Se puede encontrar más información sobre el 60 aniversario del CERN en la web www.cern.ch/cern60

Aunque cin atraso… ¡¡Felicidades!!

Nov

19

¿Cómo se formaron las galaxias?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo cambiante ~

Clasificado en El Universo cambiante ~

Comments (0)

Comments (0)

Todavía, en la segunda década del siglo XXI, los cosmólogos no saben dar una explicación convincente de cómo se pudieron formar las galaxias.

Lo cierto es que las galaxias no han tenido tiempo para formar cúmulos. Es posible que no consigamos llegar al entendimiento de cómo se pudieron formar las galaxias porque lo estamos mirando desde una perspectiva, o, desde un punto de vista muy estrecho. Es posible que el problema resida en que deberíamos mirar las cosas desde una escala mayor para así, poder entender cómo pudieron suceder las cosas, cómo se formaron los grandes cúmulos de galaxias.

La génesis de las galaxias individuales se podría resolver por sí misma si pudiéramos entender bien la formación de los cúmulos. La idea nos conduce naturalmente a la cuestión de cómo se pueden haber formado concentraciones tan grandes de masa al comienzo de la vida del universo. Una de las ideas más sencillas sobre cómo puede haber sido el universo cuando los átomos se estaban formando es que, no importa lo que estuviese pasando, la temperatura era la misma en todas partes. Este se llama “Modelo Isotérmico”. Corresponde a la suposición de que la radiación en los comienzos del universo estaba diseminada iniformemente, estuviera o no agrupada la materia.

La formación de galaxias es una de las áreas de investigación más activas de la astrofísica, y en cierto sentido, esto también se aplica a la evolución de las galaxias. Sin embargo, hay algunas ideas que ya están ampliamente aceptadas. Actualmente, se piensa que la formación de galaxias procede directamente de las teorías de formación de estructuras, formadas como resultado de las débiles fluctuaciones cuánticas en el despertar del Big Bang. Las simulaciones de N-cuerpos también han podido conjeturar sobre los tipos de estructuras, las morfologías y la distribución de galaxias que observamos hoy en nuestro Universo actual y, examinando las galaxias distantes, en el Universo primigenio. Nuestra Galaxia, la Vía Láctea puede contener algo más de cien mil millones de estrellas, otras más pequeñas sólo tienen mil millones y, algunas macrogalaxias pueden llegar a tener 600.000 mil millones de estrellas. Lo cierto es que hemos podido localizar galaxias situadas a más de 11.000 años-luz de la Tierra.

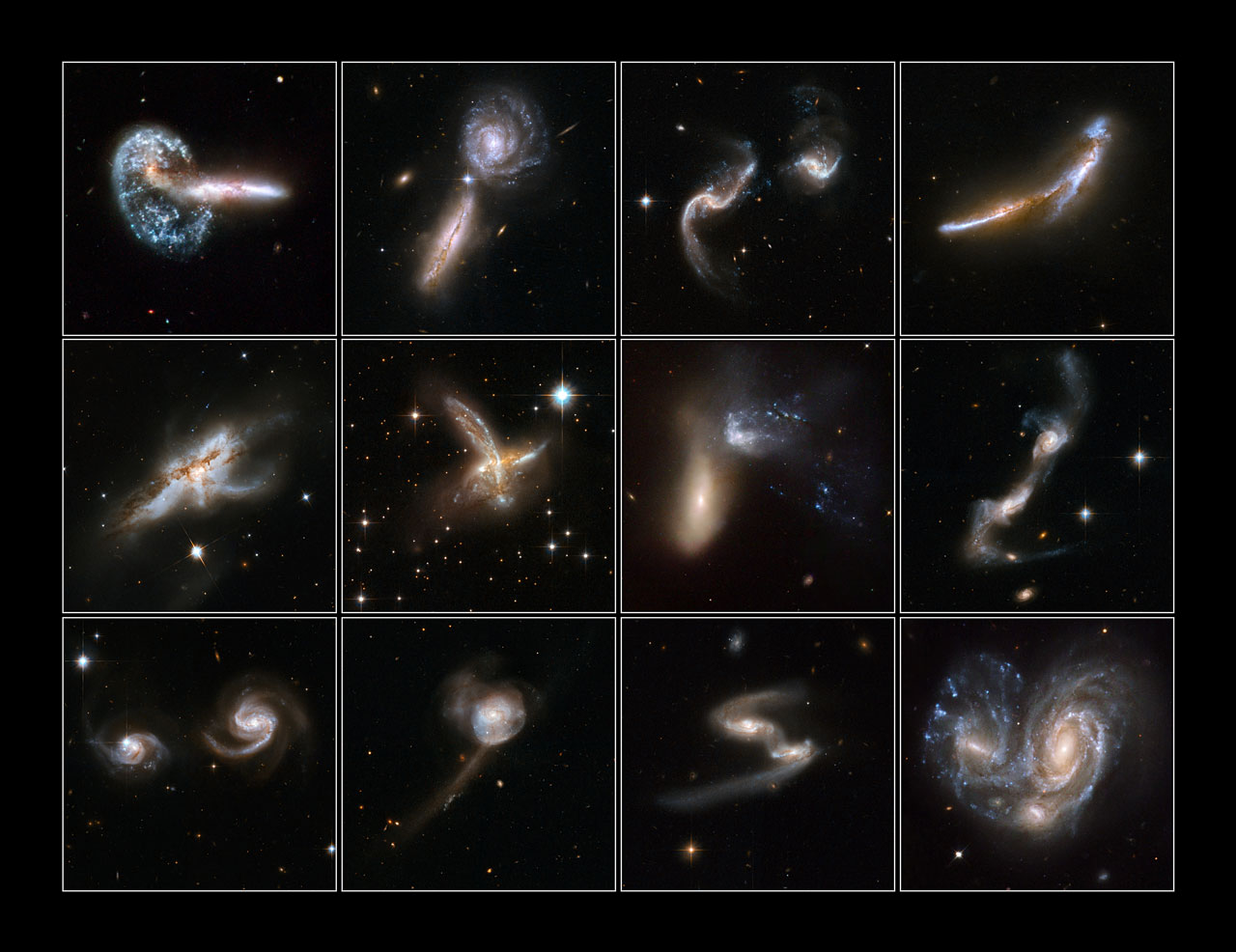

En ese (para nosotros) tan inconmensurable espacio de tiempo, las galaxias han tenido mucho para evolucionar y, gracias a nuestros modernos ingenios, las hemos podido localizar de todo tipo y en algunas de sus más extrañas configuraciones al fusionarse unas con otras por efecto de la Gravedad que, segú todos los indicios, es el destino que el Universo tiene adjudicado para Andrómeda y la Vía Láctea dentro de algunos miles de millones de años.

Si desarrollamos las consecuencias matemáticas del Modelo Isotérmico, podremos encontrar que los tipos de concentreaciones de masa se podrían haber formado en la infancia del universo y que, de esa manera, son muy fáciles de describir. Con la misma temperatura en todas partes, las fluctuaciones aleatorias ordinarias producirían concentraciones de masa de todos los tamaños, si quisieran encontrar una concentración del tamaño de un planeta, la habría. Lo mismo sucedería con concentraciones de masa del tamaño de estrellas y de galaxias, cúmulos, etc. En la jerga del astrofísico, las concentraciones de masa aparecerían a todas las escalas.

Así, de esa manera, la materia esparcida por todo el espacio y situada a lo largo y lo ancho de él, pudieron formar toda clase de objetos grandes y pequeños configurando galaxias que, como pequeños universos, lo contenían todo y, eran como universos en miniatura con sus mundos y estrellas y sustancia primigenia dispuesta para interaccionar con la radiación, el electromagnetismo y la Gravedad que serían responsables de la formación de nuevas estrellas y nuevas galaxias.

Claro que, el modelo isotérmico sólo podemos encontrar una solución particularmente simple del problema de las galaxias, porque las concentraciones de masa más pequeñas crecen más rápido que las más grandes. Los primeros objetos que aumentarían serían cosas relativamente pequeñas llamadas protogalaxias, que contendrían quizá un millón de estrellas cada una. Estas protogalaxias se agruparían luego bajo influencias de la Gravedad para formar galaxias con todas las de la ley, que se reunirían a su vez para formar cúmulos y supercúmulos. el universo en este modelo se construiría “desde abajo”

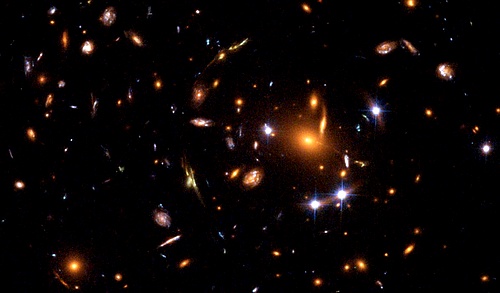

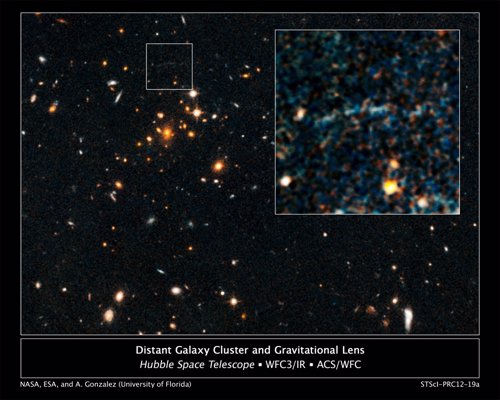

Este cúmulo de galaxias es uno de los objetos más masivos del Universo visible. En esta fotogrrafía de la cámara avanzada para sondeos del Telescopio Espacial Hubble, se ve como Abell 1.689 curva el espacio tal como predijo la teoría de la gravedad de Einstein (las galaxias que hay detrás del cúmulo desvían la luz y producen múltiples imágenes curvadas).

Claro que, en todo esto nos encontramos con un gran inconveniente: ¡No ha habido tiempo para que ese placentero agrupamiento bajo la influencia de la Gravedad haya podido tener lugar lugar desde el momento de la creación, es decir, desde lo que entendemos por Big Bang! Sin embargo y a pesar de ello, ahí las tenemos y podemos contemplarlas en toda su belleza y esplendor pero, ¿cómo pudieron llegar aquí? En realidad, nadie lo sabe.

Hay algunas colecciones de galaxias muy grandes y complejas en el cielo. Nos vemos forzados a concluir que el universo no puede haber tenido una temperatura constante durante el desparejamiento. Es decir, no quiero decir nada contra la existencia de las galaxias, simplemente hago notar que las galaxias no pueden existir si suponemos que la radiación estaba unida y uniformemente distribuida en la infancia del universo. Claro que:

¡Si la radiación marcha junto con la materia y la materia con las galaxias, la radiación de microondas cósmica sería contradictoria!

Si la radiación no se hubiera dispersado uniformemente, con independencia de la materia del universo, ¿dónde hubiera estado? Siguiendo el procedimiento normal de la física teórica, consideraremos a continuación la tesis opuesta. Suponemos que en el comienzo del Universo la materia y la radiación estaban unidas. Si era así, allí donde se encontrara una concentración de masa, también habría una concentración de radiación. En la jerga de la física se dice que esta situación es “adiabática”. Aparece siempre que tienen lugar en las distribuciones del gas cambios tan rápidos que la energía no puede transferirse fácilmente de un punto al siguiente.

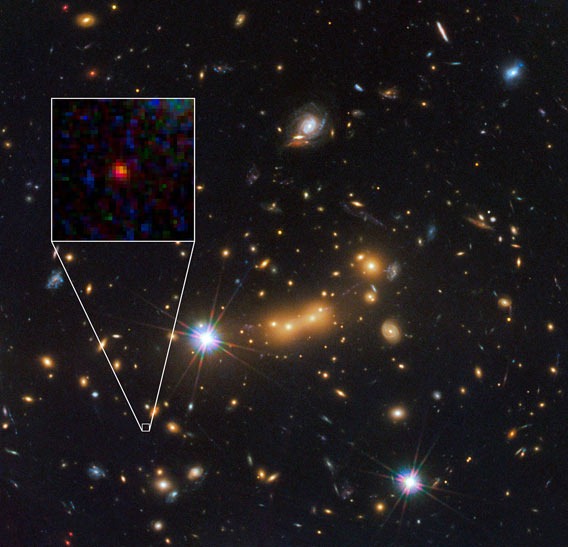

En esta imagen obtenida con el Hubble, se observa una lejana proto-galaxia. Una proto-galaxia, es un objeto que dará una galaxia como resultado de su evolución; una galaxia naciente o en formación. Una galaxia muy lejana, es vista muy joven ya que su luz tarda en llegar a nosotros, por eso se dice que “vemos el pasado”. MACS0647-JD, es una galaxia hecha y derecha, pero tan lejana que la vemos como era hace mucho tiempo atrás. Está a 13 mil millones de años luz de casa. Como ese es el tiempo que tarda su luz en llegar a nosotros, la vemos como era hace ese tiempo atrás. Si tenemos en que el Universo se formó hace casi unos 14 mil millones de años (aproximadamente), eso convierte a este objeto en una galaxia de las primeras en formarse. Al verla como un agalaxia naciente, debería estar llena de estrellas brillantes y calientes.

Sabemos que, para hacer galaxias, la materia del universo tuvo que estar muy bien distribuida en agregados cuando se formaron los átomos. Llamaremos a esto “darle un empukon al proceso”. Un corolario necesario es que en condiciones adiabáticas, la radiación debe de haber comenzado siendo agrupada también.

Aquí se pretende representar el pasado y el futuro del universo que, se expandió primero de manera muy rápida, después más lenta, y de nuevo la velocidad aumentó, de manera tal que el recorrido represrenta una especie de S que nos habla del pasado y del futuro.

Entre los otros muchos procesos en marcha en aquellos primeros momentos del nacimiento del universo, en aquel tiempo, uno de los principales parámetros a tener en es el de la rápida expansión, ese proceso que ha venido a ser conocido como inflación. Es la presencia de la inflación la que nos conduce a la predicción de que el universo tiene que ser plano.

Se pudieron formar los núcleos y los átomos de la materia

El proceso mediante el cual la fuerza fuerte se congela es un ejemplo de un cambio de fase, similar en muchos aspectos a la congelación del agua. Cuando el agua se convierte en hielo, se expande; todos hemos podido ver una botella de líquido explotar si alcanzanda la congelación, el contenido se expande y el recipiente no puede contenerlo. No debería sert demasiado sorprendente que el universo se expanda del mismo modo al cambiar de fase.

Claro que no es fácil explicar cómo a medida que el espacio crece debido a esa expansión, se hace más y más voluminoso cada vez y también, cada vez menos denso y más frío. Lo que realmente sorprende es la inmensa magnitud de la expansión. El tamaño del Universo aumentó en un factor no menor de 1060 longitudes de Planck. Acordáos de aquellos números que en aquel trabajo que titulé, ¿Es viejo el Universo?, os dejaba allí expuestos unos interesantes sobre nuestro universo. Volvamos a verlos:

– La edad actual del universo visible ≈ 1060 tiempos de Planck

– Tamaño actual del Universo visible ≈ 1060 longitudes de Planck

– La masa actual del Universo visible ≈ 1060 masas de Planck

– Vemos así que la bajísima densidad de materia en el universo es un reflejo del hecho de que:

– Densidad actual del universo visible ≈10-120 de la densidad de Planck

– Y la temperatura del espacio, a 3 grados sobre el cero absoluto es, por tanto

– Temperatura actual del Universo visible ≈ 10-30 de la Planck

Estos números extraordinariamente grandes y estas fracciones extraordinariamente pequeñas nos muestran inmediatamente que el universo está estructurado en una escala sobrehumana de proporciones asombrosas cuando la sopesamos en los balances de su propia construcción. Lo cierto es que, son tan grandes y tan pequeñas esos números y fracciones que, para nosotros, no tienen significación consciente, no las podemos asimilar al tratarse, como se dice más arriba, de medidas sobrehumanas. Si un átomo aumentara en esa proporción de 1060 no tendría canbida en el Universo, el átomo sería mayor.

Decíamos que en 10-35 segundos, el universo pasó de algo con un radio de curvatura mucho menor que la partícula elemental más pequeña a algo con el tamaño de una naranja. No debe sorprendernos pués, que el inflación esté ligado a este proceso. Es cierto que cuando oímos por primera vez este proceso inflacionista, podamos tener alguna dificultad con el índice de inflación que se expone sucedió en el pasado. Nos puede llevar, en un primer momento, a la idea equivocada de que se han violado, con un crecimiento tan rápido, las reglas de Einstein que impiden viajar más veloz que la luz, y, si un cuerpo material viajó la línea de partida que señalan los 10-35 segundos aquella otra que marca la dimensión de una naranja…¡su velocidad excedió a la de la luz!

Claro que la respuesta a que algo sobrepasara la velocidad de la luz, c, es sencilla: NO, nada ha sido en nuestro universo más rápido que la luz viajando, y la explicación está en el hecho cierto de que no se trata de algo pudiera ir tan rápido, sino que, por el contrario, en lugar de que un objeto matrerial vciajara por el espacio, lo que ocurrió es que fue el espacio mismo el que se infló -acordáos de la masa de pan que crece llevando las pasas como adorno-, y, , esa expansión hace que las galaxias -las pasas de la masa-, se alejen cada vez más las unas de las otras, haciendo el universo más grande y frío cada vez.

Así que, con la expansión o inflación, ningún cuerpo material se movió a grandes velocidades en el espacio, ya que, fue el espacio mismo el que creció y, de alguna manera, su tremenda expansión, incidió sobre los objetos que contenía que, de esa manera, pasaron de estar muy juntos a estar muy separados. Las reglas contra el viaje a velocidades superiores a la de la luz sólo se aplican al movimiento al movimiento dentro del espacio, no al movimiento del espacio. Así no hay contradicción, aunque a primera vista pudiera parecerlo.

Empleamos todos los medios a nuestro alcance e ideamos nuevos ingenios para poder asomarnos a las escalas más extremas del universo, con los telescopios queremos llegar las primeras gaalxias y, con los aceleradores de partículas nos queremos asomar a ese momento primero en el que se formó la materia.

A los cien millones de años el comienzo del tiempo, aún no se habían formado las estrellas, si acaso, algunas más precoces. Aparte de sus escasas y humeantes almenaras, el Universo era una sopa oscura de gas hidrógeno y helio, arremolinándose aquí y allá para formar protogalaxias.

A la edad de mil millones de años, el Universo tiene un aspecto muy diferente. El núcleo de la joven Vía Láctea arde brillantemente, arrojando las sobras de cumulonimbos galácticos a través del oscuro disco; en su centro billa un quásar blancoazulado. El disco, aún en proceso de formación, es confuso y está lleno de polvo y gas; divide en dos partes un halo esférico que será oscuro en nuestros días, pero a la sazón corona la galaxia con un brillante conjunto de estrellas calientes de primera generación.

Nuestras galaxias vecinas del supercúmulo de Virgo están relativamente cerca; la expansión del Universo aún no ha tenido tiempo de alejarlas a las distancias-unas decenas de millones de años-luz a las que las encontraremos . El Universo es aún altamente radiactivo. Torrentes de rayos cósmicos llueven a través de nosotros en cada milisegundo, y si hay vida en ese tiempo, probablemente está en rápida mutación.

Hay algo que es conocido por el término técnico de desacoplamiento de fotones, en ese momento, la oscuridad es reemplazada por una deslumbrante luz blanca, se cree que ocurrió cuando el Universo tenía un millón de años. El ubicuo gas cósmico en aquel momento se había enrarecido los suficientes como permitir que partículas ligeras –los fotones– atraviesen distancias grandes sin chocar con partículas de materia y ser reabsorbidas.

(Hay gran cantidad de fotones en reserva, porque el Universo es rico en partículas cargadas eléctricamente, que generan energía electromagnética, cuyo cuanto es el fotón.) Es esa gran efusión de luz, muy corrida al rojo y enrarecida por la expansión del Universo, la que los seres humanos, miles de millones de años después, detectaran con radiotelescopios y la llamaran la radiación cósmica de fondo de microondas. Esta época de “sea la luz” tiene un importante efecto sobre la estructura de la materia. Los electrones, aliviados del constante acoso de los fotones, son libres de establecerse en órbita alrededor de los núcleos, formando átomos de hidrógeno y de helio.

Sí, de todo eso hemos podido saber pero, ¿cómo se pudieron formar las galaxias a pesar de la expansión del universo? ¿por qué la matería se pudo agrupar y no salió despedida y se dispersó impidiendo esa formación? Lo cierto es que nadie sabe contestar esa pregunta y, se estima, se cree, se piensa que, allí podría haber estado presente una especie de “materia” o “sustancia” cósmica que no emitía radiación y que, generando gravedad, podría haber retenido la materia de manera suficiente para que se pudieran formar las galaxias.

¡Es todo tan complejo!

emilio silvera

Totales: 85.974.741

Totales: 85.974.741 Conectados: 33

Conectados: 33