Ago

3

El Universo: siempre misterioso

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo ~

Clasificado en El Universo ~

Comments (0)

Comments (0)

Los cosmólogos llaman Omega (Ω) a la cantidad de materia que existe en el Universo y, Omega Negro referido a esa materia “invisible” que algunas llaman oscura pero que, en realidad, nadie sabe lo que es ni de qué puede estar formada y, llevando la cuestión al límite, si ni siquiera existe y, los efectos observados de expansión del Universo, pueden tener su fuente en otro lugar que aún no hemos sabido comprender.

|

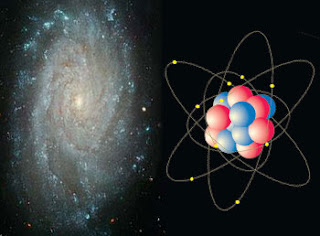

Hemos podido saber que el Universo es todo lo que existe, desde el más insignificante grano de arena de la más lejana playa, hasta la más inmensa galaxia perdida en los confines del esapacio-tiempo. Esa materia interactúa con las cuatro fuerzas fundamentales de la Naturaleza y, según hemos podido llegar a comprender, está compuesta por átomos que se juntan para formar moléculas y éstas, a su vez, lo hacen para formar cuerpos grandes o pequeños pero que, finalmente y sin excepción, todos están compuestos por esos átomos que formados por partículas infinitesimales, son las que conforman el mundo material que nos rodea.

A nivel cercano o local, el mundo es irregular y diverso. Si miramos para esa región nos parecerá distinta de aquella otra. Sin embargo, el Universo contemplado en una perspectiva muy amplia, resulta ser muy homogéneo y todo está distribuido de manera uniforme, de manera tal que, tal como hacen los átomos, que se juntan para formar moléculas y estas cuerpos, así se comportan las galaxias que se juntan para formar cúmulos y éstos, a su vez, supercúmulos que son las grantes estructuras del Universo que, se hallan inmersas en “infinitos” espacios vacíos. Habiendo podido observar todo eso, los cosmólogos y los astrónomos han contabilidado esa materia percibida y han podido constatar que, el Universo, tiene una densidad inferior (en cerca del 1%) a la Densidad Crítica que resulta ser, algo mayor que la que se observa.

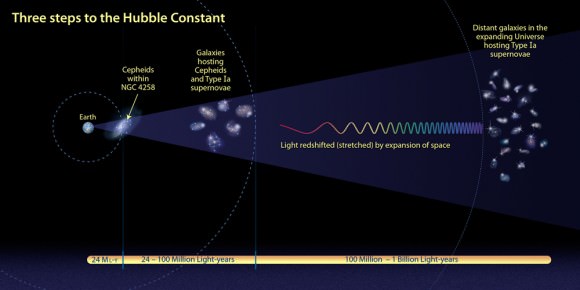

En mi trabajo expuesto aquí en otra ocasión, insertaba ésta imagen que venía a significar la constante de Hubble en función de la Densidad Crítica. Y, lo cierto es que, no acabamos de obtener una información fiable de la materia existente en el Universo, ya que, según parece, puede que exista una clase de materia que no podemos percibir y que, en cambio, se deja sentir en algunos aspectos que inciden en el comportamiento de Universo mismo que, como hemos llegado a comprender, es complejo y para nosotros, en algunos casos “infinito”.

Algunos números que definen nuestro Universo:

- El número de fotones por protón

- La razón entre densidades de Materia Oscura y Luminosa.

- La Anisotropía de la Expansión.

- La falta de homogeneidad del Universo.

- La Constante Cosmológica.

- La desviación de la expansión respecto al valor crítico.

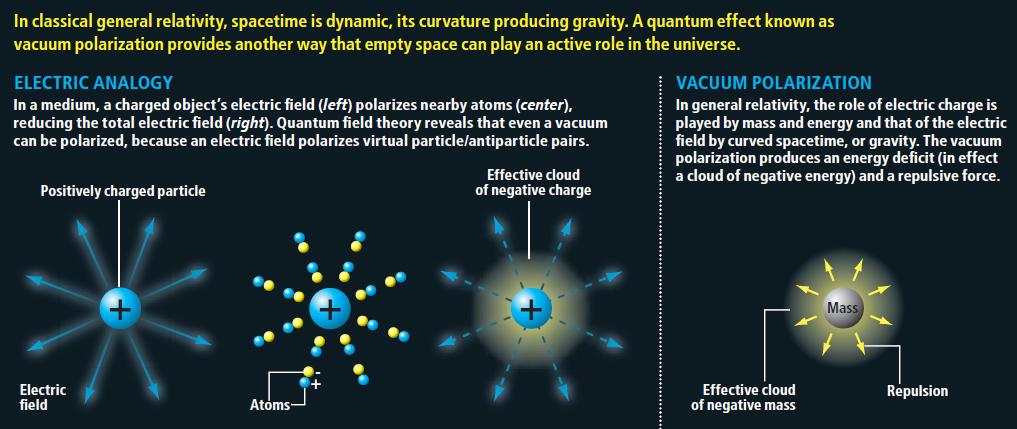

- Fluctuaciones de vacío y sus consecuencias.

- ¿Otras Dimensiones?

En las últimas medidas realizadas, la Densidad crítica que es la densidad necesaria para que la curvatura del universo sea cero, ha dado el resultado siguiente: r0 = 3H02/8pG = 1.879 h2 10-29 g/cm3, que corresponde a una densidad tan baja como la de la masa de 2 a 3 átomos de hidrógeno por metro cúbico (siempre, por supuesto obviando la incertidumbre en la constante de Hubble).

Hay una teoría que nos dice que, la Densidad crítica está referida a la densidad media de materia requerida para que la Fuerza de Gravedad detenga la expansión del nuestro Universo. Así que si la densidad es baja se expandirá para siempre, mientras que una densidad muy alta colapsará finalmente. Si tiene exactamente la densidad crítica ideal, de alrededor de 10-29 g/cm3, es descrito por el modelo de Einstein-de Sitter, que se encuentra en la línea divisoria de estos dos extremos. La densidad media de materia que puede ser observada directamente en nuestro Universono hacen que las cuentas cuadren y, se necesitaría alguna clase de materia que no podemos detectar, para que todo lo que ocurre tenga una explicación plausible.

Claro que el hecho de que la materia luminosa medida esté tan cercana al valor crítico pero, que no lo sea exactamente, puede simplemente deberse a un accidente cósmico; las cosas simplemente “resultan” de ese modo. Me cuesta mucho aceptar una explicación (y supongo que a otros también), que venga a decirnos que una masa perdida que se llama “oscura” es la que completa el cuadro. Es tentador decir que el Universo tiene, en realidad, la masa crítica, pero que de algún modo no conseguimos verla toda.

Como resultado de esta suposición, los astrónomos comenzaron a hablar de la “masa perdida” con lo que aludían a la materia que habría llenado la diferencia entre densidades observadas y crítica. Tales teorías de “masa perdida”, “invisible” o, finalmente “oscura”, nunca me ha gustado, toda vez que, hablamos y hablamos de ella, damos por supuesta su existencia sin haberla visto ni saber, exactamente qué es, y, en ese plano, parece como si la Ciencia se pasara al ámbito religioso, la fe de creer en lo que no podemos ver ni tocar y, la Ciencia, amigos míos, es otra cosa.

Comparación entre un modelo de expansión desacelerada (arriba) y uno en expansión acelerada (abajo). La esfera de referencia es proporcional al factor de escala. El universo observable aumenta proporcionalmente al tiempo. En un universo acelerado el universo observable aumenta más rápidamente que el factor de escala con lo que cada vez podemos ver mayor parte del universo. En cambio, en un universo en expansión acelerada (abajo), la escala aumenta de manera exponencial mientras el universo observable aumenta de la misma manera que en el caso anterior. La cantidad de objetos que podemos ver disminuye con el tiempo y el observador termina por quedar aislado del resto del universo.

Conforme a lo antes dicho, la densidad media de materia está referida al hecho de distribuir de manera uniforme toda la materia contenida en las galaxias a lo largo de todo el Universo. Aunque las estrellas y los planetas son más densos que el agua (alrededor de 1 g/cm3), la densidad media cosmológica es extremadamente baja, como se dijo antes, unos 10-29 g/cm3, o 10-5 átomos/cm, ya que el Universo está formado casi exclusivamente de espacios vacíos, virtualmente vacíos, entre las Galaxias. La densidad media es la que determinará si el Universo se expandirá o no para siempre.

Conforme a lo antes dicho, la densidad media de materia está referida al hecho de distribuir de manera uniforme toda la materia contenida en las galaxias a lo largo de todo el Universo. Aunque las estrellas y los planetas son más densos que el agua (alrededor de 1 g/cm3), la densidad media cosmológica es extremadamente baja, como se dijo antes, unos 10-29 g/cm3, o 10-5 átomos/cm, ya que el Universo está formado casi exclusivamente de espacios vacíos, virtualmente vacíos, entre las Galaxias. La densidad media es la que determinará si el Universo se expandirá o no para siempre.

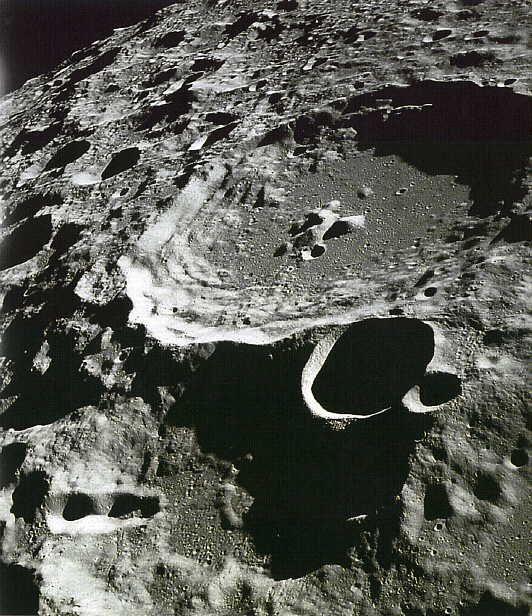

En presencia de grandes masas de materia, tales como planetas, estrellas y Galaxias, está presente el fenómeno descrito por Einstein en su teoría de la relatividad general, la curvatura del espacio-tiempo, eso que conocemos como Gravedad, una fuerza de atracción que actúa entre todos los cuerpos y cuya intensidad depende de las masas y de las distancias que los separan; la fuerza gravitacional disminuye con el cuadrado. La Gravitación es la más débil de las cuatro fuerzas fundamentales de la naturaleza. Isaac Newton formuló las leyes de la atracción gravitacional y mostró que un cuerpo se comporta gravitacionalmente como si toda su masa estuviera concentrada en su centro de Gravedad. Así, pues, la fuerza gravitacional actúa a lo largo de la línea que une los centros de Gravedad de las dos masas (como la Tierra y la Luna, por ejemplo).

En la teoría de la relatividad general, la gravitación se interpreta como una distorsión del espacio que se forma alrededor de la masa que provoca dicha distorsión, cuya importancia iría en función de la importancia de la masa que distorsiona el espacio que, en el caso de estrellas con gran volumen y densidad, tendrán una importancia considerable, igualmente, la fuerza de Gravedad de planetas, satélites y grandes objetos cosmológicos, es importante.

Esta fuerza es la responsable de tener cohexionado a todo el Universo, de hacer posible que existan las Galaxias, los sistemas solares y que, nosotros mismos, tengamos bien asentados los pies a la superficie de nuestro planeta, la Tierra, cuya gravedad, tira de nosotros para que así sea.

No obstante, a escala atómica la fuerza gravitacional resulta ser unos 1040 veces más débil que la fuerza de atracción electromagnética, muy potente en el ámbito de la mecánica cuántica donde las masas de las partículas son tan enormemente pequeñas que la gravedad es despreciable. Así que la relatividad general es la Ley que rige en los ámbitos de lo muy grande y, la mecánica cuántica, lo hace en los ámbitos de lo muy pequeño.

La Gravitación cuántica es la teoría en la que las interacciones gravitacionales entre los cuerpos son descritas por el intercambio de partículas elementales hipotéticas denominadas gravitones. El Gravitón es el cuanto del campo gravitacional. Los gravitones no han sido observados, aunque se presume que existen por analogía a los fotones de luz.

La teoría cuántica es un ejemplo de talento que debemos al Físico alemán Max Planck (1.858-1.947) que, en el año 1.900 para explicar la emisión de radiación de cuerpo negro, de cuerpos calientes, dijo que la energía se emite en cuantos, cada uno de los cuales tiene una energía igual a hv, donde h es la constante de Planck (E=hv o ħ=h/2л) y v es la frecuencia de la radiación.

Esta teoría condujo a la teoría moderna de la interacción entre materia y radiación conocida como mecánica cuántica, que generaliza y reemplaza a la mecánica clásica y a la teoría electromagnética de Maxwell. En la teoría cuántica no relativista se supone que las partículas no son creadas ni destruidas, que se mueven despacio con respecto a la velocidad de la luz y que tienen una masa que no cambia con la velocidad. Estas suposiciones se aplican a los fenómenos atómicos y moleculares y a algunos aspectos de la física nuclear. La teoría cuántica relativista se aplica a partículas que viajan cerca de la velocidad de la luz, como por ejemplo, el fotón.

Por haberlo mencionado antes me veo obligado a explicar brevemente el significado de “cuerpo negro”. Que está referido a un cuerpo hipotético que absorbe toda la radiación que incide sobre él. Tiene, por tanto, una absortancia y una emisividad de 1. Mientras que un auténtico cuerpo negro es un concepto imaginario, un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica.

La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la distribución de energía sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumento de temperaturas (ley de desplazamiento de Wien).

Un cuerpo negro absorbe todas las frecuencias y emite también todas las frecuencias de radiación

Finalmente, resulta que todo lo grande está hecho de cosas pequeñas (las galaxias, las estrellas y los mundos -nosotros también-, somos átomos que, a su vez, están conformados por Quarks y Leptones, partículas elementales de ínfima presencia y de “infinita” importancia) y, también todo, lo que en el Universo existe, está sometido a sus leyes y constantes que hacen posible que nuestro univewrso sea tal como lo podemos observar y, también, hace posible que existan observadores que, como nosotros mismos, nos interesamos por estos hechos para poderlos contar.

Todo esto ha podido ser comprendido con el paso del tiempo y a medida que se sumaban los descubrimientos y los pensamientos de unos y otros, y, por ejemplo, Einstein también concluyó que si un cuerpo pierde una energía L, su masa disminuye en L/c2. Einstein generalizó esta conclusión al importante postulado de que la masa de un cuerpo es una medida de su contenido en energía, de acuerdo con la ecuación m=E/c2 ( o la más popular E=mc2).

Otras de las conclusiones de la teoría de Einstein en su modelo especial, está en el hecho de que para quien viaje a velocidades cercanas a c (la velocidad de la luz en el vacío), el tiempo transcurrirá más lento. Dicha afirmación también ha sido experimentalmente comprobada.

Todos estos conceptos, por nuevos y revolucionarios, no fueron aceptados por las buenas y en un primer momento, algunos físicos no estaban preparados para comprender cambios tan radicales que barrían de un plumazo, conceptos largamente arraigados.

Y, de la misma manera, ahora mismo la Ciencia está necesitada de nuevos paradigmas, nuevas teorías que nos traigan esas nuevas reglas con las que poder vislumbrar nuevos caminos que vayan mucho más allá de lo que lo ha hecho la relatividad y la mecánica cuántica. Ha pasado un siglo y seguimos anclados en esas dos teorías que, habiendo dado un inmenso resultado y aportado unos grandes beneficios para el conocimiento que la Humanidad tiene del “mundo” que le rodea, no son, sin embargo suficientes para hacer frente a ese futuro que se nos viene encima, inexorable como el tiempo mismo y que, nos pondrá ante dilemas que, de no remediarlo alguien, no sabremos resolver.

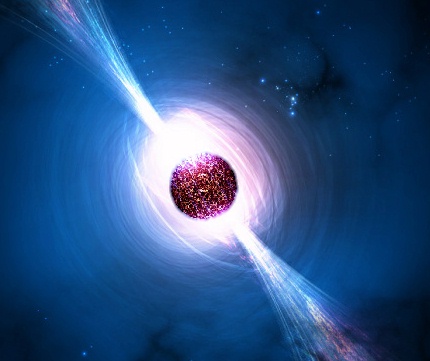

De hecho, no sabemos ni explicar esos fenómenos que están relacionados con los agujeros negros y que, a ciencia cierta sabemos que, inciden en el comportamiento de algunas estrellas y en la propia materia y también, en el espacio-tiempo circundante debido a la inmensa fuerza de gravedad que genera y, a eso que llamamos singularidad y que, en realidad, no podemos dar una explicación…, muy clara.

Creemos que sabemos y, ¡de pronto! hacemos el descubrimiento de que, la atmósfera de Marte, está sobresaturada de vapor de agua. Así lo determina un nuevo análisis de los datos enviados por el espectrómetro SPICAM a bordo de la nave Mars Express de ESA. Y, tal descubrimiento, después de tanto tiempo estudiando aquel planeta y tántos ingenios como lo han visitado, ha sorprendido a propios y extraños. Las implicaciones pueden ser grandes.

Ahora resulta, según un artículo publicado en The Physics Ar Xiu Blog, que la forma en que la gravedad afecta a las partículas cuánticas demuestra que no puede ser un fenómeno emergente. Una de las ideas más interesantes de la física moderna es que la gravedad no es una fuerza tradicional, al igual que las fuerzas electromagnéticas o nucleares. Por el contrario, es un fenómeno emergente que simplemente tiene el aspecto de una fuerza tradicional.

Mientras tanto, nuestra vecina Andrómeda, a una velocidad considerable, se nos acerca imparable y, dentro de unos 3.000 millones de años, tendrá lugar el encuentro con la Vía Láctea. Sí, ya se que no estaremos aquí y que eso queda lejos. Sin embargo, nuestra obligación es saber y descubrir para dejar abierto todos los caminos posibles a los que vengan detrás -si para entonces, nuestra especie aún pervive-

Lo cierto es que, después del paseo que nos hemos dado por algunos aspectos que están implicados en nuestro conocimiento del Universo, podemos concluir que, no sabemos tanto como creemos que sabemos.

emilio silvera

Ago

2

Alquimia estelar y… ¿Protoplasma vivo?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Alquimia estelar ~

Clasificado en Alquimia estelar ~

Comments (5)

Comments (5)

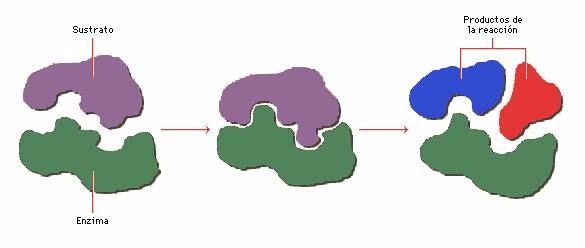

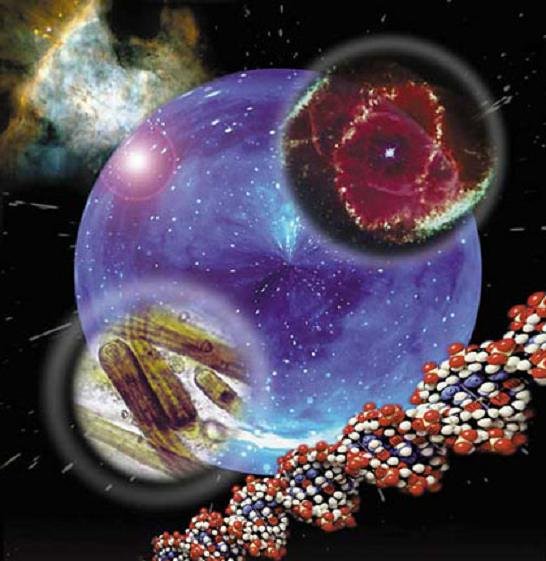

Estructuración del protoplasma de la Vida con unas notables facultades para hacer cosas nuevas a partir de otras viejas.

El protoplasma para mantener su forma debe renovar sus moléculas de materia. El recambio de sustancias es lo que se conoce globalmente como metabolismo. Corresponde a reacciones sencillas de oxidación, reducción, hidrólisis, condensación, etc. Estas reacciones se van modificando y perfeccionando, en los casos más optimistas, hasta llegar a diferenciarse procesos idénticos en alguna o algunas reacciones, A. Baj. Palladin estudiaron la respiración, con todas sus reacciones y catalizadas por su fermento específico. S. Kostichev, A. Liebedev estudiaron la química de la fermentación.

Michurin estudió la relación del organismo y el medio. Los fermentos de las estructuras protoplasmáticas determinaban sus reacciones por la velocidad y la dirección, estableciendo una relación con el medio. Se establecía un círculo de fenómenos relacionados y ordenados regularmente. Se producían asimilaciones y desasimilaciones de sustancias orgánicas con el fin de autoconservación y autorenovación del protoplasma.

En la base de la organización de todo individuo está la célula, y en la célula el protoplasma, en cuya compleja estructura morfológica y química reside el principio de todas las funciones vitales. Inicialmente la organización morfológica de la célula sólo se conocía a través de los medios ópticos. Dentro de los límites de su poder resolutivo; con la introducción del microscopio electrónico amplió notablemente los conocimientos sobre la estructura celular, al conseguirse aumentos hasta 200 veces superior a los obtenidos por los medios ópticos.

Muchas son las veces que aquí, en este lugar dedicado a distintas disciplinas de la Ciencia, hemos hablado de la Vida. Sin embargo, nunca nos hemos parado a explicar la cuestión del proceso del origen de la vida, conociendo antes, aunque sea de manera sencilla y sin profundidad, aquellos principios básicos de la estructura del protoplasma, ese sustrato material que será la base de todos los seres vivos, sin excepción.

A finales del siglo XIX y principios del XX, había científicos que creían que los organismos sólo eran “máquinas vivientes” especiales, de estructuras muy complejas y, aseguraban que la estructura del protoplasma era algo así como una máquina, construido conforme a un determinado plan y que estaba formado por “vigas” y “tirantes” como si de un puente se tratara y que, de manera similar a éste, los lazos de unión tenían unida toda la estructura que, de esta manera, se mantenía firme, y, esa estructura de tan estricto orden en la colocación recíproca de las distintas partes del protoplasma, era precisamente, según ellos, la causa específica de la vida. Y, a todo ello, sin olvidarse del Carbono, la base de todo signo de vida que conocemos.

Pero el estudio concreto del protoplasma desmintió esta teoría mecanicista. Fue probado que no existía ninguna estructura parecida a una máquina ni siquiera a las de máxima precisión, en el interior del protoplasma.

Es bien conocido que la masa básica del protoplasma es líquida; nos hallamos ante un coacervado complejo, constituido por una gran cantidad de sustancias orgánicas de un peso molecular considerable, entre estas destacan las proteínas y los lipoides. Por esta razón, se encuentran flotando a su libre albedrío en esa sustancia coacervática fundamental, partículas filamentosas coloides, quizás enormes moléculas proteínicas sueltas, y muy probablemente, auténticos enjambres de esas moléculas. El tamaño de las partículas es tan diminuto que no se distinguen ni a través de los microscopios actuales más sofisticados. Pero encontramos otros elementos visibles en el interior del protoplasma. Cuando las moléculas proteínicas y de otras sustancias se unen formando conglomerados, destacan en la masa protoplasmática en forma de pequeñas gotas, captadas a través del microscopio, o en forma de coágulos, con una determina estructura denominados elementos morfológicos. El núcleo, las plastídulas, las mitocondrias, etcétera.

Estos elementos protoplasmáticos, observables a través del microscopio, son, esencialmente, una manifestación aparente y externa de determinadas relaciones de solubilidad, enormemente complejas, de las distintas sustancias que conforman el protoplasma y que se ha podido comprobar que tiene, un papel determinante, en el curso del proceso de la vida, que no se puede comparar de ningún modo con el papel que desempeña una máquina en su trabajo específico. Esto queda totalmente justificado por la sencilla razón de que una máquina y el protoplasma son dos sistemas distintos y contrarios.

Sin duda, lo que caracteriza la función de una máquina es el desplazamiento mecánico de sus diferentes partes en el espacio. Por esa razón hay que insistir que el elemento más importante de la estructura de una máquina es, precisamente, la colocación de sus piezas; mientras que el proceso vital tiene un carácter totalmente distinto. Se manifiesta esencialmente con el recambio de sustancias, o sea, con la interacción química de las diferentes partes que conforman el protoplasma. Por esto deducimos que el elemento primordial en toda la estructuración del protoplasma es el orden concreto que siguen los procesos químicos en el tiempo, la forma tan armónica en que se combinan, siempre con tendencia a conservar en su conjunto el sistema vital.

Es de vital importancia para la formación del protoplasma que exista una estructura interna determinada. Pero otro factor no menos decisivo es la organización en el tiempo, o sea, que los procesos que se dan en el protoplasma lo hagan en armonía. Cualquier organismo, tanto animal, planta o microbio, vive únicamente mientras pasen por él, de forma continuada y constante, nuevas partículas de sustancias, cargadas de energía. Distintos cuerpos químicos pasan del medio ambiente al organismo; y cuando están dentro, sufren unos determinados y esenciales trastornos, mediante los cuales acaban convirtiéndose en sustancias del propio organismo invadido y serán iguales que aquellos cuerpos químicos que antes formaban parte del ser vivo. Este proceso se conoce con el nombre de asimilación. Sin embargo, de forma paralela a este proceso se da la desasimilación, que se trata precisamente del proceso contrario, es decir, las distintas sustancias que forman la parte del organismo vivo son sensibles a los cambios del propio organismo, se desintegran a menor o mayor velocidad, y son sustituidas por los cuerpos asimilados. De esta forma, los productos de la desintegración se echan al medio envolvente.

Por otra parte, en todo esto debemos tener en cuenta un gente que, siendo ineludible para la vida, está siempre presente en todo lo que a ella concierne. El Agua.

El agua pura es un líquido inodoro e insípido. Tiene un matiz azul, que sólo puede detectarse en capas de gran profundidad. A la presión atmosférica (760 mm de mercurio), el punto de congelación del agua es de 0 °C y su punto de ebullición de 100 °C. El agua alcanza su densidad máxima a una temperatura de 4 °C y se expande al congelarse. Como muchos otros líquidos, el agua puede existir en estado sobreenfriado, es decir, que puede permanecer en estado líquido aunque su temperatura esté por debajo de su punto de congelación.

El agua pura es un líquido inodoro e insípido. Tiene un matiz azul, que sólo puede detectarse en capas de gran profundidad. A la presión atmosférica (760 mm de mercurio), el punto de congelación del agua es de 0 °C y su punto de ebullición de 100 °C. El agua alcanza su densidad máxima a una temperatura de 4 °C y se expande al congelarse. Como muchos otros líquidos, el agua puede existir en estado sobreenfriado, es decir, que puede permanecer en estado líquido aunque su temperatura esté por debajo de su punto de congelación.

Es muy cierto que la sustancia del organismo vivo siempre se encuentra en movimiento, desintegrándose y volviendo a formarse de manera continua en virtud de la gran cantidad de reacciones de desintegración y síntesis, que se dan guardando una fuerte relación entre ellas. Ya Heráclito, aquel gran dialéctico de la antigua Grecia, nos decía: “nuestros cuerpos fluyen como un arroyo, y de la misma manera que el agua de éste, la materia se renueva en ellos.” Está claro que una corriente o un chorro de agua pueden mantener su forma, su aspecto externo, durante un tiempo, pero su aspecto sólo es la manifestación exterior de ese proceso continuo y constante del movimiento de las partículas del agua. Incluso la misma existencia de este sistema depende, naturalmente, de que las renovadas moléculas de materia pasen constantemente, y a una velocidad determinada por el chorro de agua. Pero si interrumpimos este proceso, el chorro dejará de existir como tal. Lo mismo sucede en todos los sistemas conocidos como dinámicos, los cuales tienen un proceso concreto.

Es un hecho concreto e innegable que los seres vivos también son sistemas dinámicos. Igual que el chorro de agua al que antes hacíamos referencia, su forma y su estructura sólo forman parte de la expresión externa y aparente de un equilibrio, muy competente, formado por procesos que se dan en el ser vivo en sucesión permanente a lo largo de toda su vida. Sin embargo, el carácter de estos procesos es totalmente diferente a los que ocurre en los sistemas dinámicos de la naturaleza orgánica.

Las moléculas de agua llegan al chorro, ya como moléculas de agua, y lo atraviesan sin que se produzca ningún cambio. Pues el organismo toma del medio ambiente sustancias ajenas y desconocidas para él, pero a continuación, mediante procesos químicos muy complejos, son convertidos en sustancias del propio organismo, muy parecidas a los materiales que forman su cuerpo.

Precisamente esto es lo que hace posible las condiciones que mantienen constantemente la composición y estructura del organismo, ignorando este proceso continuo e ininterrumpido de desasimilación que se da en todos los organismos vivos.

Así pues, desde una perspectiva puramente química, el recambio de sustancias, también llamado metabolismo, es un conjunto enorme de reacciones más o menos sencillas, de oxidación, reducción, hidrólisis, condensación, etcétera. Lo que lo hace diferente del protoplasma, es que en el metabolismo, estas reacciones se encuentran organizadas en el tiempo de de cierto modo, las cuales se combinan para poder crear un sistema integral. Dichas reacciones no surgen por casualidad, y de forma caótica, sino que se dan en estricta sucesión, y en un orden armónico concreto.

Ese orden será la base de todos los fenómenos vitales conocidos. En la fermentación alcohólica, por ejemplo, el azúcar proveniente del líquido, que es fermentable, penetra en la célula de la levadura, sufriendo determinados trastornos químicos. O sea, primero se le incorpora el ácido fosfórico y luego se divide en dos partes.

Una de las cuales experimentará un proceso de reducción, mientras que la otra se oxidará, quedando convertida, finalmente, en ácido pirúvico, que más tarde se descompondrá en anhídrido carbónico y acetaldehído. Este último se reducirá, quedando transformado después en alcohol etílico. Como resultado, podemos observar que el azúcar queda convertido en alcohol y anhídrido carbónico.

Esto nos demuestra que en la célula de la levadura, lo que determina la producción de estas sustancias es el extraordinario rigor con que se dan todas estas reacciones, las cuales se suceden de forma muy ordenada. Sólo con que sustituyésemos en esta cadena de transmutaciones un único eslabón o si alterásemos en lo más mínimo el orden de dichas transmutaciones ya no tendríamos como resultado alcohol etílico, sino cualquier otra sustancia. En efecto, en las bacterias de la fermentación de la leche, el azúcar, al principio sufría los mismos cambios en la levadura, pero cuando se llega a la fermentación del ácido pirúvico, éste ya no se descompone, todo lo contrario, se reduce al instante. Esto explica que en las bacterias de la fermentación láctica el azúcar no se transforme en alcohol etílico, sino en ácido láctico.

Las encimas

La enzimología, al igual que las disciplinas experimentales que han surgido como ramas del tronco común que es la biología, tiene una historia propia construida a través de observaciones, experiencias, pruebas y teorías.

La enzimología, al igual que las disciplinas experimentales que han surgido como ramas del tronco común que es la biología, tiene una historia propia construida a través de observaciones, experiencias, pruebas y teorías.

Se inició con el estudio de los procesos de fermentación y de putrefacción y Antoine-Laurente Lavoisier fue el primero en plantear sobre bases cuantitativas el proceso de la fermentación alcohólica, al observar una relación entre cantidad de azúcar presente y productos formados durante el proceso.

Un estudio de la síntesis de distintas sustancias en el protoplasma demuestra que éstas no se crean de repente, y no provienen de un acto químico especial, sino que son el resultado de una cadena larguísima de trastornos químicos.

No puede constituirse un cuerpo químico complejo, propio de un ser vivo en concreto, sin que se produzcan centenares o miles de reacciones en un orden regular, constante, y ya previsto con rigurosidad, lo cual constituirá la base de la existencia del protoplasma.

La Biología Físico-Química

La bioquímica, es la rama de la Química y de la Biología que tiene por objetivo principal el conocimiento de la estructura y comportamiento de las moléculas biológicas, que son compuestos de Carbono que forman las diversas partes de la célula y llevan a cabo las reacciones químicas las que le permiten crecer, alimentarse, reproducirse y usar y almacenar energía.

Porque cuanto más compleja es la sustancia, más reacciones intervienen en su formación dentro del protoplasma y estas reacciones deben coordinarse entre sí con mayor rigor y exactitud. En efecto, investigaciones bastante recientes han demostrado que en la síntesis de las proteínas a partir de los aminoácidos toman parte gran cantidad de reacciones que se producen en una sucesión muy ordenada. Únicamente como consecuencia de esta rigurosa armonía, de esta sucesión ordenada de las reacciones, se da en el protoplasma vivo ese ritmo estructural, esa regularidad en la sucesión de los distintos aminoácidos que también podemos apreciar en las proteínas actuales.

Por consiguiente, las moléculas proteínicas, así originadas y con una estructura determinada se agrupan entre sí, y ciertas leyes las hacen tender a la formación de auténticos conglomerados moleculares que se acaban separando de la masa protoplasmática y se distinguen como elementos morfológicos, visibles a través del microscopio, como formas protoplasmáticas características por su gran movilidad. De esta manera, la composición química propia del protoplasma, como su estructura, son la manifestación del orden en que se producen estos procesos químicos que se dan de forma continua y permanente en la materia viva.

Hidrógeno

En el siglo XVI se observó que cuando el ácido sulfúrico actuaba sobre el hierro se desprendía un gas combustible. En 1766 Henry Cavendish demostró que dicho gas era una sustancia distinta a otros gases también combustibles, confundiendo el gas obtenido, al que llamo <<aire inflamable>>. Provenía del hierro y no del ácido sulfúrico, también demostró que el gas en el aire y en el oxígeno se formaba Agua

La Atmósfera

Es la capa de gas que rodea a un cuerpo celeste que tenga la suficiente masa como para atraer ese gas. Los gases son atraídos por la gravedad del cuerpo, y se mantienen en ella si la gravedad es suficiente y la temperatura de la atmósfera es baja. Algunos planetas están formados principalmente por gases, con lo que tienen atmósferas muy profundas. Si no se dan ciertos parámetros, el protoplasma de la vida, nunca habría hecho acto de presencia.

– Nitrógeno (78%) y

– Oxígeno (21%)

– El 1% restante lo forman el argón (0,9%), el dióxido de Carbono (0,03%), y distintas proporciones de vapor de agua, y trazas de hidrógeno, ozono, metano, monóxido de Carbono, helio, neón, kriptón y xenón.

– El 1% restante lo forman el argón (0,9%), el dióxido de Carbono (0,03%), y distintas proporciones de vapor de agua, y trazas de hidrógeno, ozono, metano, monóxido de Carbono, helio, neón, kriptón y xenón.

Ozonosfera y sodiosfera

Desde 15 hasta 60 kilómetros de altitud, el ozono, que en las zonas próximas al suelo se encuentra sólo en pequeñas cantidades, aparece en porcentajes más sensibles y forma la ozonosfera. Este ozono absorbe la radiación ultravioleta procedente del Sol, haciendo posible de es modo la existencia de vida en la Tierra.

Pues bien, debemos preguntarnos de qué depende ese orden, propio de la organización del protoplasma, y cuáles son sus causas inmediatas. Un estudio minucioso sobre esta cuestión dejará demostrado que el orden indicado no es simplemente algo externo, que queda al margen de la materia viva, teoría defendida por los idealistas; en cambio, hoy día, sabemos perfectamente que la velocidad, la dirección y el encadenamiento de las diferentes reacciones, todo lo que forma el orden que estamos viendo, depende totalmente de las relaciones físicas y químicas que se establecen en el protoplasma vivo.

Las propiedades químicas de las sustancias integradoras del protoplasma, en primer lugar, y también las de las sustancias orgánicas que intervienen son las que constituyen la base de todo ello. Dichas sustancias orgánicas poseen enormes posibilidades químicas y pueden generar gran variedad de reacciones. Pero, aprovechan estas posibilidades con mucha “pereza”, lentamente, a veces a una velocidad ínfima. En muchas ocasiones, se necesitan meses e incluso años, para que llegue a producirse alguna de las reacciones efectuadas entre las mismas sustancias orgánicas. Por esto, los químicos, para acelerar el proceso de las reacciones entre las sustancias orgánicas, usan a menudo en su trabajo diferentes sustancias de acción enérgica-ácidos y álcalis fuertes, etcétera.

Para conseguir tal aceleramiento cada vez con más frecuencia, los químicos recurren a la utilización de los catalizadores. Hace ya mucho tiempo que habían notado que sólo con añadir una pequeña dosis de algún catalizador a la mezcla donde se estaba realizando una reacción, se producía un gran aceleramiento de ésta. Además, otra propiedad propia e los catalizadores es que no se destruyen durante el proceso de la reacción, y cuando esta finaliza, comprobamos que queda exactamente la misma cantidad de catalizador que añadimos a la mezcla al principio. Así que, cantidades insignificantes de catalizador son suficientes, muchas veces, pata provocar la rápida transmutación de masas considerables de diferentes sustancias. Esta cualidad, hoy día, es de gran utilidad para la industria química, que usa como catalizadores distintos metales, sus óxidos, sus sales y otros cuerpos orgánicos o inorgánicos. Las reacciones químicas dadas en animales y vegetales entre las distintas sustancias orgánicas se suceden a gran velocidad. De lo contrario, la Vida no pasaría tan rápida como en realidad pasa. Se sabe que la gran velocidad de las reacciones químicas producidas en el protoplasma es debida a la presencia constante de catalizadores biológicos especiales llamados fermentos.

Hace tiempo que estos fermentos fueron descubiertos, y ya con anterioridad, los científicos se habían fijado en ellos. Pues resultó que los fenómenos se podían extraer del protoplasma vivo y así separarse en forma de solución acuosa o como polvo seco de fácil solubilidad. Esto me hace pensar en lo que ocurre en las Nebulosas. No hace mucho se consiguieron fermentos en forma cristalina y se resolvió su composición química. Estos resultaron ser proteínas, y muchas veces, en combinación con otras sustancias de distinta naturaleza. Estos fermentos, por el carácter de su acción, se asemejan a los catalizadores inorgánicos. Sin embargo, se diferencian de ellos por la increíble intensidad de sus efectos.

En este sentido, los fermentos superan a los catalizadores inorgánicos de acción en centenares de miles, y en ocasiones hasta en millones de veces. Así que en los fermentos de naturaleza proteínica se da un mecanismo increíblemente perfecto y racional que hace posible acelerar las reacciones químicas entre las distintas sustancias orgánicas. Los fermentos también se caracterizan por la excepcional especifidad de su acción.

La Teoría Celular

Llegados a este punto debemos profundizar un poco más en la constitución de los seres vivos. Para ello debemos saber la teoría celular, enunciada por Matthias Schleiden (1804-1881) y Theodor Schwann (1810-1882).

La teoría celular de Schleiden y Schwann señala un rasgo común para todos los seres vivos: todos están compuestos por células y por productos elaborados por ellas. Aunque la idea de que la célula es el “átomo” de la vida nos parezca evidente, su importancia y la dificultad de su descubrimiento son parejas a la dificultad del descubrimiento de la existencia de átomos en química, y marca un cambio de paradigma en la manera de concebir la vida.

La teoría celular se basó en los adelantos realizados mediante los aparatos de observación debidos inicialmente a Robert Hooke (1635-1703) y a Anton Van Leeuwenhoek (1632-1723). Hooke construyó cientos de microscopios. Los más avanzados estaban formados por dos lupas combinadas como ocular y objetivo (microscopio compuesto).

Aunque con ellos llegó a alcanzar 250 aumentos, eran preferibles los de una sola lente, como los que construyó  van Leeuwenhoek, ya que presentaban menos aberración cromática. Con esos instrumentos consiguieron descubrir infusorios (aquellas células o microorganismos que tienen cilios u otras estructuras de motilidad para su locomoción en un medio líquido), bacterias, la existencia de capilares en la membrana interdigital de las ranas.

van Leeuwenhoek, ya que presentaban menos aberración cromática. Con esos instrumentos consiguieron descubrir infusorios (aquellas células o microorganismos que tienen cilios u otras estructuras de motilidad para su locomoción en un medio líquido), bacterias, la existencia de capilares en la membrana interdigital de las ranas.

Ahora sabemos que tanto los paramecios como los organismos superiores están formados por una o más células, almacenan y transportan la energía, duplican su material genético y utilizan la información que ese material contiene para sintetizar proteínas siempre de la misma forma. Todos estos procesos, que están presentes en todas las células, son los que forman la maquinaria de la vida.

Por supuesto, esto es a causa de las particularidades del efecto catalítico de las proteínas; pues la sustancia orgánica (el sustrato) que sufre alteraciones en el transcurso del proceso metabólico, forma ya al principio, una unión bastante compleja aunque de corta duración, con la correspondiente proteína-fermento. Esta fusión tan completa, no es estable, pues sufre distintos trastornos con mucha rapidez: el sustrato sufre las transformaciones correspondientes y el fermento se regenera, para poder unirse de nuevo a otras porciones del sustrato.

Entonces, para que las sustancias integradoras del protoplasma vivo puedan participar realmente con el metabolismo, debe combinarse con una proteína y constituir con ella un enlace complejo. De no ser así, sus posibilidades químicas se producirán muy lentamente y entonces perderán toda su importancia en el impetuoso proceso vital. Por esta razón el cómo se modifique una sustancia orgánica en el transcurso del metabolismo, depende, además de la estructura molecular de esta sustancia, y de las posibilidades químicas de la misma, también de la acción de fermentación de las proteínas protoplasmáticas, las cuales se encargan de llevar esa sustancia al proceso metabólico general.

Los fermentos, además de ser un poderoso acelerador de los procesos químicos sufridos por la materia viva; son también un mecanismo químico interno, el cual se encarga de que esos procesos sean conducidos por un cauce muy concreto. La gran especificidad de las proteínas-fermentos consigue que cada una de ellas forme enlaces complejos sólo con determinadas sustancias y catalice solamente algunas reacciones. Por esto, cuando se produce éste o el otro proceso vital, y con más motivo, cuando se verificas todo el proceso metabólico, actúan miles de proteínas-fermento de distintas clases. Cada una de estas proteínas puede catalizar de forma específica una sola reacción, y sólo el conjunto de acciones de todas ellas, en muy precisa combinación, hará posible ese orden regular de los fenómenos que entendemos como base del metabolismo.

Con el uso de los distintos fermentos específicos que se obtienen a partir del organismo vivo, en el laboratorio, pueden reproducirse de forma aislada cada una de las reacciones químicas, y todos los eslabones que forman el proceso metabólico. Así desenredamos el ovillo tan sumamente complicado de las transmutaciones químicas producidas durante el metabolismo, donde miles de reacciones individuales se mezclan. Por este mismo procedimiento se puede descomponer el proceso metabólico en sus diferentes etapas químicas, se puede analizar las sustancias integradora de la materia viva, y además los distintos procesos realizados en ella.

De esa manera se demostró que la respiración funciona a partir de una serie de reacciones como la oxidación o la reducción, dichas reacciones se dan con muchísimo rigor en un orden estricto y cada una de éstas es catalizada por un fermento específico (S.Kóstichev, A. Liédev y otros autores).

En 1878 el biólogo alemán Walter Fleming descubrió que se podían teñir unas estructuras existentes en el interior del núcleo y llamo cromatina a la materia que las formaban.

Como las células de la preparación morían al teñirse, y en una preparación existían células en muy diferentes etapas de crecimiento y división, Fleming pudo estudiar estas etapas y comprender cómo evolucionaba la vida de la célula.

Al comenzar el proceso de división celular la cromatina forma una especie de hilos que se denominan, con mucha lógica, cromosomas (cuerpos coloreados) y Fleming llamó al proceso de división celular mitosis, una palabra griega que significa hilo.

En 1887 el biólogo belga Edouart van Beneden contó el número de cromosomas de células de diferentes especies y llegó a la conclusión de que el número de cromosomas es una característica de la especie. Todas las células humanas tienen 46 cromosomas.

También descubrió que los espermatozoides y los óvulos tenían la mitad de los cromosomas de las células normales, y dedujo que al unirse conservaban todos sus cromosomas, con lo que recuperaban el número característico de la especie.

Tanto Fleming como van Beneden comprendieron que eran los cromosomas del huevo los que determinaban las características del animal que se iba a formar, pero no podían saber el mecanismo por el que lo hacían.

Por entonces se empezó a llamar citoplasma al conjunto de protoplasma y orgánulos que están comprendidos entre el núcleo y la pared o membrana celular, y se empezaron a estudiar estos orgánulos.

Así, en 1898 el biólogo alemán Carl Benda descubrió las mitocondrias, que en griego significa hilos de cartílago. Ahora sabemos que son los órganos que se encargan de la obtención de energía a partir de azúcar y oxígeno. Ese mismo año Golgi descubrió el complejo que lleva su nombre.

Hoy día, ya hemos dado el salto del análisis de los procesos vitales a su reproducción, a su síntesis. De esta forma, combinando de manera precisa en una solución acuosa de azúcar, una veintena de fermentos distintos, obtenidos a partir de seres vivos, pueden reproducirse los fenómenos propios de la fermentación alcohólica. En este líquido, donde gran cantidad de proteínas distintas se hallan disueltas, los trastornos que sufre el azúcar son verificados en el mismo orden regular que siguen en la levadura viva, aunque aquí no existe ninguna estructura celular.

Todos estos procesos son, en realidad, terriblemente complejos y están expuestos a que, cualquier alteración del medio incida de manera directa en su devenir. Pero, por otra parte y en las circunstancias adecuadas, no existe ningún factor físico o químico, ni sustancia orgánica o sal inorgánica que, de alguna manera, puedan alterar el curso de las reacciones fermentativas. Cualquier aumento o disminución de la temperatura, alguna modificación de la acidez del medio, del potencial oxidativo y de la composición salina o de la presión osmótica, alterará la correlación entre las velocidades de las distintas reacciones de fermentación, y de esta forma cambia su sucesión temporal. Es aquí donde se asientan todas las premisas de esa unidad entre el organismo y el medio, tan característica de la vida.

Esta organización tan especial de la sustancia viva influye en gran manera, en las células de los organismos actuales, en el orden y la dirección de las reacciones fermentativas, las cuales son la base del proceso metabólico. Cuando se agrupan las proteínas entre sí pueden quedar aisladas de la solución general y conseguir diferentes estructuras protoplasmáticas de muy ágil movimiento. Con total seguridad, sobre la superficie de estas estructuras se encuentran concentrados gran cantidad de fermentos.

Está claro que el orden característico de la organización del protoplasma está basado en las distintas propiedades químicas de las sustancias integradoras de la materia viva.

emilio silvera

Ago

2

Enanas Blancas, estrellas misteriosas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astrofísica ~

Clasificado en Astrofísica ~

Comments (1)

Comments (1)

Una enana blanca es una pequeña y densa estrella que es el resultado final de la evolución de todas las estrellas (por el ejmplo el Sol), excepto las muy masivas. Según todos los estudios y observaciones, cálculos, midelos de simulación, etc., estas estrellas se forman cuando, al funal de la vida de las estrellas medianas, al final de sus vidas, cuando agotan el combustible de fusión nuclear, se produce el colapso de sus núcleos estelares, y quedan expuestas cuando las partes exteriores de la estrella son expulsadas al espacio interestelar para formar una Nebulosa Planetaria.

El Núcleo se contrae bajo su propia gravedad hasta que, habiendo alcanzado un tamaño similar al de la Tierra , se ha vuelto tan densa (5 x 108 Kg/m3) que sólo evista su propio colapso por la preseión de degeneración de los electrones (como sabeis los electrones son fermiones que estando sometidos al Principio de exclusión de pauli, no pueden ocupar niguno de ellos el mismo lugar de otro al tener el mismo número cuántico y, siendo así, cuando se cjuntan demasiado, se degeneran y comienzan una frenética carrera que, en su intensidad, puede, incluso frenar la implosión de una estrella -como es el caso de las enanas blancas).

Las enanas blancas se forman con muy altas temperaturas superficiales (por encima de los 10 000 K) debido al calor atrapados en ellas, y liberado por combustiones nucleares previas y por la intensa atracción gravitacional que sólo se ve frenada por la degeneración de los electrones que, finalmente, la estabilizan como estrella enana blanca.

Este tipo de estrellas, con el paso del tiempo, se enfrían gradualmente, volviéndose más débiles y rojas. Las enanas blancas pueden constituir el 30 por ciento de las estrellas de la vecindad solar, aunque debido a sus bajas luminosidades de 10-3 – 10-4 veces la del Sol, pasan desapercibidas. La máxima máxima posible de una enana blanca es de 1,44 masas solares, el límite de Shandrasekhar. Un objeto de masa mayor se contraería aún más y se convertiría en una estrella de neutrones o, de tener muha masa, en un agujero negro

Visión artística de una enana blanca, Sirio B – Crédito: NASA, ESA y G. Bacon (STScl)

Las enanas blancas son estrellas calientes y pequeñas, generalmente como del tamaño de la Tierra, por lo que su luminosidad es muy baja. Se cree que las enanas blancas son los residuos presentes en el centro de las nebulosas planetarias. Dicho de otra manera, las enanas blancas son el núcleo de las estrellas de baja masa que quedan después de que la envoltura se ha convertido en una nebulosa planetaria.

El núcleo de una enana blanca consiste de material de electrones degenerados. Sin la posibilidad de tener nuevas reacciones nucleares, y probablemente después de haber perdido sus capas externas debido al viento solar y la expulsión de una nebulosa planetaria, la enana blanca se contrae debido a la fuerza de gravedad. La contracción hace que la densidad en el núcleo aumente hasta que se den las condiciones necesarias para tener un material de electrones degenerados. Este material genera presión de degeneración, el cual contrarresta la contracción gravitacional.

Al ser estudiadas más a fondo las propiedades de las enanas blancas se encontró que al aumentar su masa, su disminuye. A partir de esto es que se encuentra que hay un límite superior para la masa de una enana blanca, el cual se encuentra alrededor de 1.4 masas solares (MS). Si la masa es superior a 1.4 MS la presión de degeneración del núcleo no es suficiente para detener la contracción gravitacional. Este se llama el límite de Chandrasekhar.

Debido a la existencia de este límite es que las estrellas de entre 1.4 MS y 11 MS deben perder masa para poder convertirse en enanas blancas. Ya explicamos que dos medios de pérdida de masa son los vientos estelares y la expulsión de nebulosas planetarias.

A esto puede dar lugar la unión de dos enanas blancas

Después de que una estrella se ha convertido en enana blanca, lo más probable es que su destino sea enfriarse y perder brillo. Debido a que las enanas blancas tienen una baja luminosidad, pierden energía lentamente, por lo que pueden permanecer en esta etapa en el orden de años. Una vez que se enfrían, se vuelven rocas que se quedan vagando por el Universo. Este es el triste destino de nuestro Sol.

La detección de enanas blancas es difícil, ya que son objetos con un brillo muy débil. Por otro lado, hay ciertas diferencias en las enanas blancas según su masa. Las enanas blancas menos masivas sólo alcanzan a quemar hidrógeno en helio. Es decir, el núcleo de la estrella nunca se comprime lo suficiente como para alcanzar la temperatura necesaria para quemar helio en carbono. Las enanas blancas más masivas sí llevan a cabo reacciones nucleares de elementos más pesados, es decir, en su núcleo podemos encontrar carbono y oxígeno.

Comparación de tamaños entre la enana blanca IK Pegasi B (centro abajo), su compañera de clase espectral A IK Pegasi A (izquierda) y el Sol (derecha). Esta enana blanca tiene una temperatura en la superficie de 35.500 K.

Allá por el año 1908, siendo Chandraskhar un avanzado estudiante de física, vivía en Madrás, en la Bahía de Bengala (En cuyo Puerto trabajó Ramanujan), y, estando en la aquella ciudad el célebre científico Arnold Sommerfeld, le pidió audiciencia y se pudo entrevistar con él que, le vino a decir que la física que estudiaba estaba pasada, que ahora se estaban estudiando nuevos caminos de la física y, sobre todo, uno a cuya teoría se la llamaba mecánica cuántica que podía explicar el comportamiento de lo muy pequeño.

Chandrasekhar

Cuando se despidieron Sommerfeld dio a Chandrasekhar la prueba de imprenta de un artículo técnico que acaba de escribir. Contenía una derivación de las leyes mecanocuánticas que gobiernan grandes conjuntos de electrones comprimidos en volúmenes pequeños, por ejemplo (para este caso) en una estrella enana blanca.

A partir de aquel artículo, Chandrasekhar buscó más información y estudió estos fenómenos estelares que desembocaban en enanas blancas. Este tipo de estrella habían descuibiertas por las astrónomos a través de sus telescopios. Lo misterioso de las enanas blancas era su densidad extraordinariamente alta de la materia en su interior, una densidad muchísimo mayor que la decualquier otra cosa que los seres humanos hubieran encontrado antes. Chandrasekhar no tenía forma de saberlo cuando abrió un libro de Eddintong que versaba sobre la materia, pero la lucha por desvelar el misterio de e4sta alta densidad le obligaría fibnalmente a él y a Eddintong a afrontar la posibilidad de que las estrellas masivas, cuando mueren, pudieran contraerse para formar agujeros negros.

De las enanas blancas más conocidas y cercanas, tenemos a Sirio B. Sirio A y Sirio B son la sexta y la seéptima estrellas en orden de proxomidad a la Tierra, a 8,6 años-luz de distancia, y Sirio es la estrella más brillante en nuestro cielo. Sirio B orbita en torno a Sirio de la misma manera que lo hace la Tierra alrededor del Sol, pero Sirio B tarde 50 años en completar una órbita a Serio y la Tierra 1 año al Sol.

Eddintong describía como habían estimado los astrónomos, a partir de observaciones con telescopios, la masa y la circunferencia de Sirio B. La masa era de 0,85 veces la masa del Sol; la circunferencia media 118.000 km. Esto significaba que la densidad media de Sirio B era de 61.000 gramos por centímetro cúbico, es decirm 61.000 veces mayor que la densidad del agua. “Este argumento se conoce ya desde hace algunos añis -nos decía Eddintong-” Sin embargo, la mayoría de los astróniomos de aquel tiempo, no se tomaban en serio tal densidad, Sin embargo, si hubieran conocido la vrdad que ahora conocemos: (Una masa de 1,05 soles, una circunferencia de 31.000 km y una densidad de 4 millones de gramos por cm3), la habrían considerado aún más absurda.

Arriba la famosa Nebuliosa planetaria ojo de Gato que, en su centro luce una estrella enana blanca de energéticas radiaciones en el ultravioleta y que, a medida que se vaya enfriando, serán de rayos C y radio hasta que, dentro de unos 100 millones de añosm vieja y fria, será más rojiza y se habrá convertido en eun cadáver estelar.

Aquellos trabajos de Chandraskar y Eddintong desembocaron en un profundo conocimiento de las estrellas de neutrones y, se llego a saber el por qué conseguian el equilibrio que las estabilizaba a través de la salvación que, finalmente encontraban, en la mecánica cuántica, cuando los electrones degenerados por causa del Principio de esclusión de Pauli, no dejaban que la fuerza gravitatoria continuara el proceso de contracción de la estrella y así, quedaba estabilizada como estrella de neutrones.

De la misma manera, se repetía el proceso para estrellas más masivas que, no pudiendo ser frenadas en su implosión gravitatoria por la degeneración de los electrones, sí que podia frenarse la Gravedad, mediante la degeneración de los Neutrones. Cuando esa estrella más masiva se contraía más y más, el Principio de exclusión de pauli que impide que los fermiones estén juntos, comenzaba su trabajo e impedía que los neutrones (que son fermiones), se juntaran más, entonces, como antes los electrones, se degeneraban y comenzaban a moverse con velocidades relativistas y, tan hecho, impedía, por sí mismo que la Gravedad consiguiera comprimir más la masa de la estrella que, de esta manera, quedaba convertida, finalmente, en una Estrella de Neutrones.

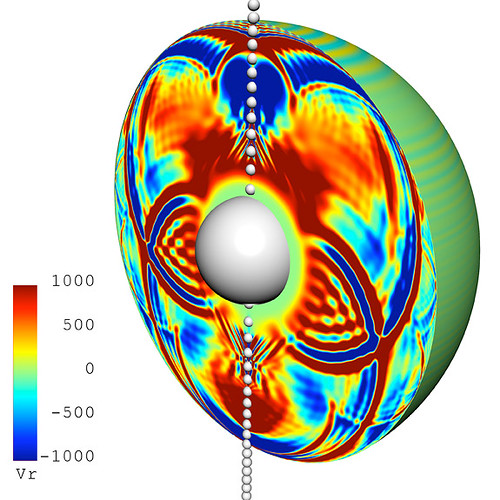

Al formarse la estrella de neutrones la estrella se colapsa hasta formar una esfera perfecta con un radio de tan solo unos 10 kilómetros. En este punto la presión neutrónica de Fermi resultante compensa la fuerza gravitatoria y estabiliza la estrella de neutrones. Apenas una cucharilla del material que conforma una estrella de neutrones tendría una masa superior a 5 x 1012 kilogramos.

Los modelos de estrellas de neutrones que se han logrado construir utilizando las leyes físicas presentan varias capas. Las estrella de neutrones presentarían una corteza de hierro muy liso de, aproximadamente, un metro de espesor. Debajo de esta corteza, prácticamente todo el material está compuesto por núcleos y partículas atómicas fuertemente comprimidos formando un “cristal” sólido de materia nucleica.

Son objetos extremadamente pequeños u densos que surgen cuando estrellas masivas sufren una explosión supernova del tipo II, el núculeo se colapsa bajo su propia gravedad y puede llegar hasta una densidad de 1017 Kg/m3. Los electrones y los protones que están muy juntos se fusionan y forman neutrones. El resultado final consiste solo en neutrones, cuyo material, conforma la estrella del mismo nombre. Con una masa poco mayor que la del Sol, tendría un diámetro de sólo 30 Km, y una densidad mucho mayor que la que habría en un terón de azúcar con una masa igual a la de toda la humkanidad. Cuanto mayor es la masa de una estrella de neutrones, menor será su diámetro. Está compuesta por un interior de neutrones superfluidos (es decir, neutrones que se comportan como un fluido de viscosidad cero), rodeado por más o menos una corteza sólida de 1 km de grosos compuesta de elementos como el hierro. Los púlsares son estrellas de neutrones magnetizadas en rotación. Las binarias de rayos X masivas tambioén se piensan que contienen estrellas de neutrones.

Todos aquellos argumentos sobre el comportamiento de las enanas blancas vinieron a desembocar en la paradoja de Edddintong que, en realidad, fue resulta por el Joven Chandrasekhar en el año 1925 al leer un artículo de R.H. Fowler “Sobre la materia densa”. La solución residía en el fallo de las leyes de la física que utilizaba Eddintong. Dcihas leyes debían ser reemplazadas por la nueva mecánica cuántica, que describía la presión en el interior de Sirio B y otras enenas blancas como debida no al calor sino a un fenómeno mecanocuántico nuevo: los movimientos degenerados de los electrones, también llamado degeneración electrónica.

La degeneración electrónica es algo muy parecido a la claustrofia humana. Cuando la materia es comprimida hasta hasta una densidad 10.000 veces mayor que la de una roca, la nube de electrones en torno a cada uno de sus núcleos atómicos se hace 10.000 veces más condensada, Así, cada electrón queda confinado en una “celda” con un volumen 10.000 veces menor que el volumen en el que previamente podía moverse. Con tan poco espacio disponible, el electrón, como nos pasaría a cualquiera de nosotros, se siente incómodo, siente claustrofobia y comienza a agitarse de manera incontrolada, golpeando con enorme fuerza las paredes de las celdas adyacentes. Nada puede deternerlo, el electrón está obligado a ello por las leyes de la mecánica cuántica. Esto está producido por el Primncipio de esclusión de Pauli que impide que dos fermiones estén juntos, así que, esta fuerza es, la que finalmente posibilita que la estrella que se comprime más y más, quede finalmente, constiruida estable como una enana blanca.

emilio silvera

Ago

2

¡Las Matemáticas! ¿Dónde radica su origen?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Origen de las cosas ~

Clasificado en El Origen de las cosas ~

Comments (5)

Comments (5)

Nuestro patrimonio matemático y nuestro orgullo occidentales depende irremediablemente de los logros de la antigua Grecia. Dichos logros se han exagerado tanto que a menudo resulta difícil distinguir qué parte de la matemática moderno procede de los griegos y cuál es la que tiene su origen en los babilonios, los egipcios, los hindúes, los chinos, los árabes, etc. Las matemáticas de los griegos eran muy imaginativas y es grande la deuda que tenemos con ellos.

Sin duda alguna la obra cumbre de la Matemática griega, que aún hoy levanta pasiones entre los matemáticos y científicos en general es sin duda Los Elementos de Euclides. Generalmente se cree, erróneamente, que los Los Elementos de Euclides contienen únicamente un

resumen sumario y exhaustivo de toda la Geometríia griega. En realidad los Los Elementos supusieron la gran síntesis no sólo de la producción geométrica griega hasta el siglo III a. C. sino también de un compendio, usando el lenguaje geométrico, de toda la Matemática elemental: Geometría plana y espacial, Aritmética y Álgebra.

resumen sumario y exhaustivo de toda la Geometríia griega. En realidad los Los Elementos supusieron la gran síntesis no sólo de la producción geométrica griega hasta el siglo III a. C. sino también de un compendio, usando el lenguaje geométrico, de toda la Matemática elemental: Geometría plana y espacial, Aritmética y Álgebra.

A este respecto escribió Proclos: «Son singularmente admirales sus Elementos de Geometría (de Euclides) por el orden que reina en ellos, la selección de los teoremas y problemas tomados como elementos y también la variedad de los razonamientos desarrollados de todas las maneras y que conducen a la convicción» y más adelante expresa «Los Elementos son una guía segura y completa para la consideración científica de los objetos geométricos».

Sin embargo, si nuestras matemáticas actuales se basaran exclusivamente en Pitágoras, Euclides, Demócrito, Arquímes y otros griegos, sería una disciplina muy deficiente. Claro que, la realidad es que la historia de las matemáticas en occidente no se puede remontar a ninguna escuela y a ningún período que sean anteriores a la etapa de los griegos jónicos.

Ago

2

Plasma, Nebulosas, Gases, elementos, moléculas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo ~

Clasificado en El Universo ~

Comments (2)

Comments (2)

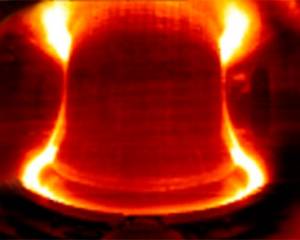

El plasma no se encuentra en la Tierra en estado natural, su ámbito está en el espacio, en las estrellas y en otros objetos energéticos que suponen la máxima energía que imaginarnos podamos: Estrellas, Esplosiones supernovas y sus remanentes, púlsares y estrellas de neutrones corrientes, magnétares y, si me apurais mucho, incluso en los discos de acreción de los agujeros negros está presente el plasma que es, el estado más abundante de la materia.

El Plasma, ese otro estado de la Materia (el cuarto dicen) que, según sabemos, resulta ser el más abundante del Universo. Todos desde pequeños aprendimos aquellos tres estados de la amteria que cantábamos en el patio del centro educativo durante el recreo, donde todos a una gritábamos como papagayos: “Sólido, líquido y gaseoso”. Nada nos decían del Plasma, ese estado que, en realidad, cubre el 99% del estado de la materia en nuestro Universo (bueno, hablamos de la materia conocida, esa que llamamos bariónica y está formada por átomos de Quarks y Leptones).

Según la energía de us partículas, los plasmas (como digo) constituyen el cuarto estado de agregación de la materia, tras los sólidos, liquidos y gases. Parqa cambiar de uno al otro, es necesario que se le aporte energía que aumente la temperatura. Si aumentamos de manera conasiderable la temperatura de un gas, sus átomos o moléculas adquieren energía suficiente para ionizarse al chocar entre sí. de modo que a ~ 20.000 K muchos gases presentan una ionización elevada. Sin embargo, átomos y moléculas pueden ionizarse también por impacto electrónico, obsorción de fotones, reacciones químicas o nucleares y otros procesos.

Aquí podemos contemplar una enorme región ionizada en la Nebulosa del Pelícano. Estrellas nuevas emiten potente radiación ultravioleta que ataca el espesor de la Nebulosa molecular y hace que, el gas se ionice fuertemente creando una luminosidad que “viste” de azul claro todo el contorno que circunda el radio de acción de las estrellas.

Un plasma es un gas muy ionizado, con igual número de cargas negativas y negativas.Las cargas otorgan al Plasma un comportamiento colectivo, por las fuerzas de largo alcance existente entre ellas. En un gas, cada partícula, independientemente de las demás, sigue una trayectoria rectilinea, hasta chocar con otra o con las grandes paredes que la confinan. En un plasma, las cargas se desvían atraídas o repelidas por otras cargas o campos electromagnéticos externos, ejecutando trayectorias curvilineas entre choque y choque. Los gases son buenos aislantes eléctricos, y los plasmas, buenos conductores.

En la Tierra, los plasmas no suelen existir en la naturaleza, salvo en los relámpagos, que son trayectorias estrechas a lo largo de las cuales las moléculas de aire están ionizadas aproximadamente en un 20%, y en algunas zonas de las llamas. Los electrones libres de un metal también pueden ser considerados como un plasma. La mayor parte del Universo está formado por materia en estado de plasma. La ionización está causada por las elevadas temperaturas, como ocurre en el Sol y las demás estrellas, o por la radiación, como sucede en los gases interestelares o en las capas superiores de la atmósfera (ver trabajo más abajo), donde produce el fenómeno denominado aurora.

Así que, aunque escasos en la Tierra, el Plasma constituye la materia conocida más abundante del Universo, más del 99%. Abarcan desde altísimos valores de presión y temperatura, como en los núcleos estelares, hasta otros asombrosamente bajos en ciertas regiones del espacio. Uno de sus mayores atractivos es que emiten luz visible, con espectros bien definidos, particulares en cada especie. Algunos objetos radiantes, como un filamento incandescente, con espectro continuo similar al cuerpo negro, o ciertas reacciones químicas productoras de especies excitadas, no son plasmas, sin embargo, lo son la mayoría de los cuerpos luminosos.

Bombilla de incandescencia

Los Plasmas se clasifican según la energía media (o temperatura) de sus partículas pesadas (iones y especies neutras). Un primer tipo son los Plasmas calientes, prácticamente ionizados en su totalidad, y con sus electrones en equilibrio térmico con las partículas más pesadas. Su caso extremo son los Plasmas de Fusión, que alcanzan hasta 108 K, lo que permite a los núcleos chocar entre sí, superándo las enormes fuerzas repulsivas internucleares, y lñograr su fusión. Puede producirse a presiones desde 1017 Pa, como en los núcleos estelares, hasta un Pa, como en los reactores experimentales de fusión.

Los reactores de fusión nuclear prácticos están ahora un poco más cerca de la realidad gracias a nuevos experimentos con el reactor experimental Alcator C-Mod del MIT. Este reactor es, de entre todos los de fusión nuclear ubicados en universidades, el de mayor rendimiento en el mundo.

Los nuevos experimentos han revelado un conjunto de parámetros de funcionamiento del reactor, lo que se denomina “modo” de operación, que podría proporcionar una solución a un viejo problema de funcionamiento: cómo mantener el calor firmemente confinado en el gas caliente cargado (llamado plasma) dentro del reactor, y a la vez permitir que las partículas contaminantes, las cuales pueden interferir en la reacción de fusión, escapen y puedan ser retiradas de la cámara.

Otros Plasmas son los llamados térmicos, con e ~lectrones y especies pesadas en equilibrio, pero a menor temperatura ~ 103 – 104 K, y grados de ionización intermedios, son por ejemplo los rayos de las tormentas o las descargas en arcos usadas en iluminación o para soldadura, que ocurren entre 105 y ~ 102 Pa. Otro tipo de Plasma muy diferente es el de los Plasmas fríos, que suelen darse a bajas presiones ( < 102 Pa), y presentan grados de ionización mucho menores ~ 10-4 – 10-6. En ellos, los electrones pueden alcanzar temperaturas ~ 105 K, mientras iones y neutros se hallan a temperatura ambiente. Algunos ejemplos son las lámparas de bajo consumo y los Plasmas generados en multitud de reactores industriales para producción de películas delgadas y tratamientos superficiales.

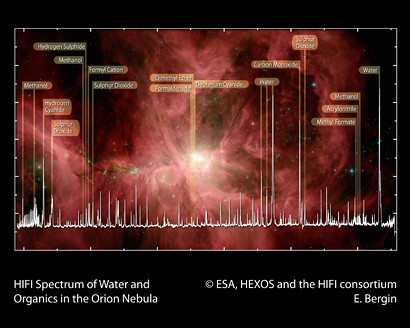

El Observatorio Espacial Herschel de la ESA ha puesto de manifiesto las moléculas orgánicas que son la llave para la vida en la Nebulosa de Orión, una de las regiones más espectaculares de formación estelar en nuestra Vía Láctea. Este detallado espectro, obtenido con el Instrumento Heterodino para el Infrarrojo Lejano (Heterodyne Instrument for the Far Infrared, HIFI) es una primera ilustración del enorme potencial de Herschel-HIFI para desvelar los mecanismos de formación de moléculas orgánicas en el espacio. Y, para que todo eso sea posible, los Plasmas tienen que andar muy cerca.

En los Plasmas calientes de precursores moleculares, cuanto mayor es la ionización del gas, más elevado es el grado de disociación molecular, hasta poder constar solo de electrones y especies atómicas neutras o cargadas; en cambio, los Plasmas fríos procedentes de especies moleculares contienen gran proporción de moléculas y una pequeña parte de iones y radicales, que son justamente quienes proporcionan al Plasma su característica más importante: su altísima reactividad química, pese a la baja temperatura.

En la Naturaleza existen Plasmas fríos moleculares, por ejemplo, en ciertas regiones de las nubes interestelares y en las ionosfera de la Tierra y otros planetas o satélites. Pero también son producidos actualmente por el ser humano en gran variedad para investigación y multitud de aplicaciones.

En un número de la Revista Española de Física dedicado al vacío, el tema resulta muy apropiado pues no pudieron generarse Plasmas estables en descargas eléctricas hasta no disponer de la tecnología necesaria para mantener presiones suficientemente bajas; y en el Universo, aparecen Plasmas fríos hasta presiones de 10 ⁻ ¹⁰ Pa, inalcanzable por el hombre.

Lo que ocurre en las Nubes moleculares es tan fantástico que, llegan a conseguir los elementos necesarios para la vida prebiótica que, tras los parámetros adecuados dan lugar al surgir de la vida.

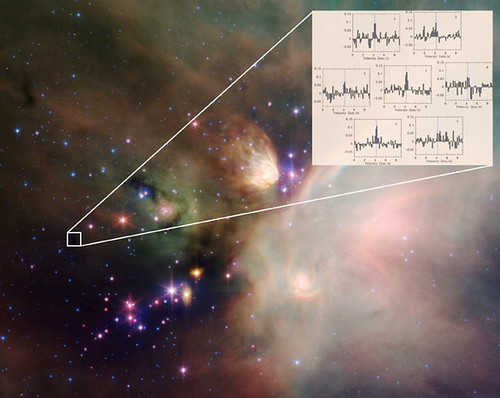

El papel de las moléculas en Astronomía se ha convertido en un área importante desde el descubrimiento de las primeras especies poliatómicas en el medio interestelar. Durante más de 30 años, han sido descubiertas más de 150 especies moleculares en el medio interestelar y gracias al análisis espectral de la radiación. Muchas resultan muy exóticas para estándares terrestres (iones, radicales) pero buena parte de estas pueden reproducirse en Plasma de Laboratorio. Aparte del interés intrínseco y riqueza de procesos químicos que implican, estas especies influyen en la aparición de nuevas estrellas por su capacidad de absorber y radiar la energía resultante del colapso gravitatorio, y de facilitar la neutralización global de cargas, mucho más eficientemente que los átomos.

Su formación en el espacio comienza con la eyección de materia al medio interestelar por estrellas en sus últimas fases de evolución y la transformación de éstas por radiación ultravioleta, rayos cósmicos y colisiones; acabando con su incorporación a nuevas estrellas y Sistemas planetarios, en un proceso cíclico de miles de millones de años.

En las explosiones supernovas se producen importantes transformaciones en la materia que, de simple se transforma en compleja y dan lugar a todas esas nuevas especies de moléculas que nutren los nuevos mundos.

El H₂ y otras moléculas diatómicas homonucleares carecen de espectro rotacional. Detectando las débiles emisiones cuadrupolares del H₂ en infrarrojo, se ha estimado una proporción de H₂ frente a H abrumadoramente alto ( ~ 104) en Nubes Interestelares con densidades típicas de ~ 104 partículas /cm3; pero dada la insuficiente asociación radiativa del H para formar H2, ya mencionada, el H2 debe producirse en las superficies de granos de polvo interestelar de Carbono y Silicio, con diámetros ~ 1 nm — μm, relativamente abundantes en estas nubes.

Experimentos muy recientes de desorción programada sobre silicatos ultrafríos, demuestran que tal recombinación ocurren realmente vía el mecanismo de Langmuir-Hinshelwood, si bien los modelos que expliquen las concentraciones de H2 aún deben ser mejorados.

Por otro lado, ciertas regiones de las nubes en etapas libres de condensación estelar presentan grados de ionización ~ 10-8 – 10-7 a temperaturas de ~ 10 K. La ionización inicial corresponde principalmente al H2 para formar H2 +, que reacciona eficientemente con H2, dando H3 + + H (k = 2• 10-9 cm3 • s-1.

El H3, de estructura triangular, no reacciona con H2 y resulta por ello muy “estable” y abundante en esas regiones de Nebulosas intelestelares, donde ha sido detectado mediante sus absorciones infrarrojas caracterizadas por primera vez en 1980 en descargas de H2 en Laboratorio.

La constelación de Orión contiene mucho más de lo que se puede ver, ahí están presentes los elementos que como el H2 que venimos mencionando, tras procesos complejos y naturales llegan a conseguir otras formaciones y dan lugar a la parición de moléculas significativas como el H2O o HCN y una gran variedad de Hidrocarburos, que podrían contribuir a explicar en un futuro próximo, hasta el origen de la vida.

La detección por espectroscopia infrarroja de COH+ y N2H+, formados en reacciones con H3 + a partir de CO y N2, permite estimar la proporción de N2/CO existente en esas regiones, ya que el N2 no emite infrarrojos. Descargas de H2 a baja presión con trazas de las otras especies en Laboratorio conducen casi instantáneamente a la aprición de tales iones y moléculas, y su caracterización puede contribuir a la comprensión de este tipo de procesos.

Así amigos míos, hemos llegado a conocer (al menos en parte), algunos de los procesos asombrosos que se producen continuamente en el Espacio Interestelar, en esa Nebulosas que, captadas por el Hubble u otros telescopios, miramos asombrados maravilándonos de sus colores que, en realidad, llevan mensajes que nos están diciendo el por qué se producen y que elementos son los causantes de que brillen deslumbrantes cuando la radiación estelar choca de lleno en esas nubes en la que nacen las estrellas y los nuevos mundos…y, si me apurais un poco, también la vida.

¡Que me gustaría saber para comprender…lo que el Universo es!

emilio silvera

Totales: 83.731.154

Totales: 83.731.154 Conectados: 63

Conectados: 63