Ago

20

¡La Ciencia! ¿Por qué no dejamos que vuele hacia el futuro?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en ¡La Ciencia! esa maravilla ~

Clasificado en ¡La Ciencia! esa maravilla ~

Comments (4)

Comments (4)

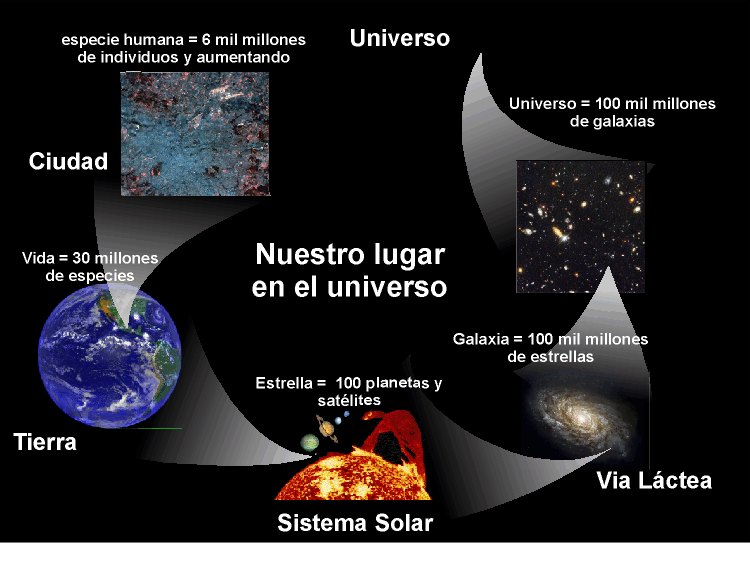

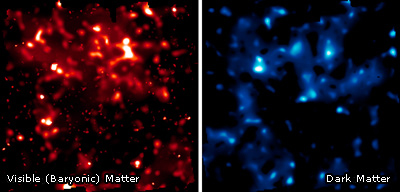

Los cosmólogos nos dicen que, aproximadamente, sólo el 5 por 100 de la masa del Universo es del tipo de material del que estamos hechos nosotros, los seres humanos -“materia bariónica” (moléculas, átomos, protones, neutrones, electrones y demás). Que aproximadamente el 35 por 100 está en alguna forma desconocida de “materia oscura fría”, que (como la materia bariónica) puede ser atraída por la gravedad para formar halos alrededor de las galaxias, y también podría formar “galaxias” “estrellas” y “planetas” de materia oscura que no emiten luz. En lo que se refiere al 60 por 100 restante de la masa del universo; está en alguna forma igualmente desconocida de “energía oscura” (como la llaman ellos, los cosmólogos) que impregna el universo entero y posee una enorme tensión ¿Es su tensión mayor que su densidad de energía? ¿Pudiera entonces ser el tipo de material exótico necesario que algunos postulan para poder mantener abiertos los agujeros de gusano que nos llevarían a otros lugares muy lejanos?

Como veréis, todo parece una gran estructura compuesta por una inmensa cadena de especulaciones y, la mayoría de las cuestiones que exponemos están basadas en ellas, no tenemos el certificado de certeza que la ciencia exige para dar por buena una teoría.

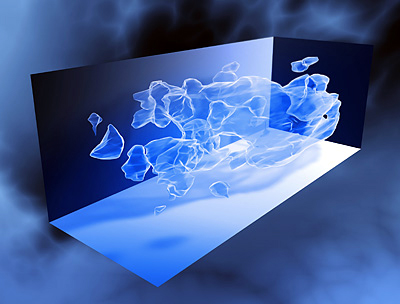

Diagrama de un agujero de gusano en un espaciotiempo de dos dimensiones

¿Por qué es “curva” la geometría del espaciotiempo? Una razón por la que la introducción por parte de Minkowski de la idea de geometría espaciotemporal resultaba tan importante es que permitió a Einstein utilizar la idea de geometría espaciotemporal curva para describir la gravedad. La propia frase “espaciotiempo curvo” tiene una imaginería tan mística que demasiado a menudo se rechaza como incomprensible. Al menos en un sentido, sin embargo, el argumento de que la gravedqad curva el esapciotiempo no sólo es comprensible, sino que es obligado.

Dos importantes predicciones derivadas de la Teoría General de la Relatividad de Einstein fueron confirmadas con una precisión sin precedentes gracias a una sonda espacial que fue diseñada precisamente con el ese objetivo. La Gravity Probe-B, una misión de la NASA, fue lanzada en 2004 y, con cuatro giroscopios ultraprecisos, estuvo midiendo el efecto de la curvatura del espacio-tiempo y el llamado efecto de arrastre de marco, en el que un cuerpo en rotación -la Tierra- arrastra el espacio-tiempo. “Imagine que la Tierra están inmersa en una sustancia viscosa como la miel, a medida que el planeta rota, la miel a su alrededor hará un remolino. Eso mismo sucede con el espacio tiempo”. “La Gravity Probe-B ha confirmado dos de las predicciones más profundas del universo de Einstein”. La sonda dejó de funcionar y los científicos publicaron los resultados de sus experimentos en la revista Physical Review Letters.

Esa sí es la manera admisible de proceder para la Ciencia, comprobar en todo momento lo que realmente ocurre con lo que predicen las teorías para, si son ciertas sus predicciones, otorgarles el certificado de credibilidad y, si no lo son, postergarlas y proseguir la búsqueda de otras que sí, coincidan con la realidad de lo que la Naturaleza es.

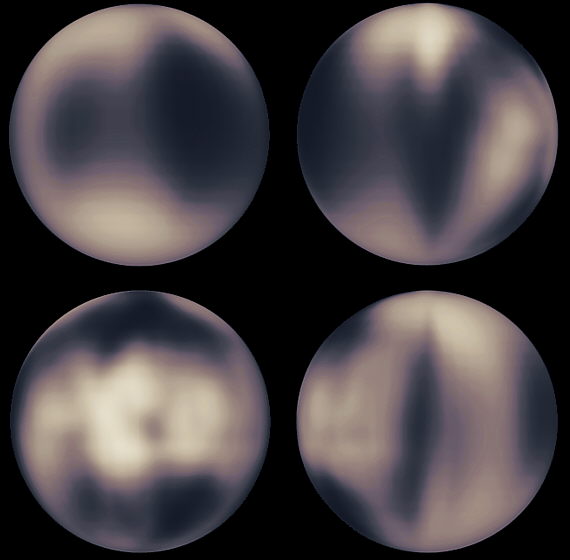

1) Distribución en 3D de la materia oscura en la zona del Universo estudiada. Foto: ESA. 2) Comparación de distribución de materia normal (izquierda) y materia oscura (derecha) en la misma zona del Universo estudiada. Foto: ESA.

Pero, los científicos tienen que vivir, los presupuestos y subvenciones tienen que ser justificados y, como podeis ver en lo que arriba contemplamos y las explicaciones que nos ofrecen de dichas imágines…¡la cosa no tiene remedio! Se realizan observaciones y se hacen estudios de los que se obtienen datos que no sabemos descifrar y, para justificar tanto esfuerzo y dinero, se lanzan al mundo explicaciones tan peregrinas como alñs que debajo de las imágenes podemos leer. Es pintar de manera que, la imagen resultante nos muestre lo que queremos ver. Todo esto me recuerda (salvando las distancdias) a los astrónomos de la antigüedad en China que, sin excepción, adaptaban las predicciones de las observaciones del Universo a las conveniencias del Emperador de turno.

Claro que, la Ciencia es joven. La empresa científica lleva en marcha menos de los 1.000 años que Alfred North Whitehead estimaba necesarios para que un n uevo modo de pensamiento penetre en el corazón de una cultura. Pese a todo, la Ciencia ya ha transformado profundamente el mundo, al menos de tres maneras: tecnológica, intelectual y también políticamente. Bastante culpa de los atrasos que podamos sufrir en el avance científico, no pocas veces, se debe al status establecido que no dejan que las cosas cambien, ellos están muy confortablemente situados en esta situación y, los nuevos paradigmas científicos, no les convienen.

Por muchas vueltas que podamos dar alrededor de una misma cosa…, nunca podremos avanzar, siempre estaremos situados en el mismo sitio. Así, el conjunto de prácticas que definen una disciplina científica durante un período específico de tiempo, como todo en nuestro Universo, no debe ser inamovible y, nuevas ideas, nuevos cambios y nuevas normas deben venir a suplir a las actuales que, como por otra parte es comprensible, deben ser renovadas con los nuevos conocimientos que de nuestro entorno, de la Naturaleza vamos adquiriendo.

Si eso es así (que lo es), un paradigma científico establece aquello que se debe observar; el tipo de interrogantes que hay que formular para hallar las respuestas en relación al objetivo; cómo deben estructurarse dicho interrogantes; y cómo deben interpretarse los resultados de la investigación.

Cuando un paradigma ya no puede satisfacer las necesidades de una Ciencia (por ejemplo, ante nuevos descubrimientos que invalidan los conocimientos prevuios), es sucedido por otro. Se dice que un cambio de paradigma es algo dramático para la ciencia, ya que éstas aparecen como estables y maduras y, por eso precisamente cuesta tanto admitir nuevos paradigmas que nos traeran, en este caso, la nueva ciencia y otras maneras y formas de interpretar lo que observamos a nuestro alrededor. Llevamos ya mucho tiempo estancados en las teorías de la relatividad general y la cuántica, se necesitan nuevos caminos que recorrer y otras ideas nuevas y atrevidas que, como la teoría de cuerdas (por ejemplo), nos transporte a otros universos, otras maneras de “ver”.

Los logros tecnológicos de la Ciencia han hecho al mundo desarrollado más rico en ideas y, los avances en todos los ámbitos del saber humano (sobre todo en la Física), han posiblitado incluso mejoras en el mundo de la salud con sus contribucones que abarcarían una larga lista que hace posible que ahora, nuestras medias de vida, estén en los 80 años. Claro que, tanto adelanto, también ha venido a elevar nuestro nivel de ansiedad. Parte de esa ansiedad surge de la razonable aprensión de que el poder tecnológico, como todo poder, tiene sus peligros. Claro quer, algo de ello tiene que ver con el hecho de que muchas personas se encuentran rodeadas (y, a veces amenazadas) por máquinas cuyo funcionamiento no entienden, y tras las que hay una actividad científica que tampoco entienden. Acordaos de la que se formó cuando se puso en marcha el LHC.

Ahora observamos el espacio interestelar y, más o menos, con mucha aproximación, podemos interpretar casi todo lo que vemos. Intelectualmente, la Ciencia nos ha traído una nueva forma de pensar en la que no hay sitio para el miedo, la supertición o la obediencia ciega a la autoridad que han sido reemplazadas por una forma de indagación y de experimento para poder llegar a la verdad de las cosas y poder contestar a tántos por qués que surgen en nuestro camino. Como resultado, los que tienen la suerte de tener una formación científica se ven ahora engranados en una madeja de vida de la que han brotado, pasajeros a bordo de uno de los miles de millones de planetas en un universo en expansiòn de extensión desconocida y quizá infinita.

Para algunos, esa nueva visión es excitante y estimulante, pero para otros es vagamente amenazadora (lo que no se comprende da miedo). Estos últimos retiran la vista del Telescopio para preguntar: “¿No hace todo esto que sientas onsignificante, ante tánta grandeza?” Quizá un término más preciso sea “inseguro”. La Ciencia amenaza no sólo las viejas concepciones sobre nosotros mismos (como aquella absurda idea de que ocupábamos el centro del Universo) sino también las viejas maneras de pensar (por ejemplo, que nuestra profunda sensación de que algo debe ser verdadero tiene relación con la cuestión de si realmente puede demostrarse que es verdadero). Esta amenzaza es real en ambos aspectos, debería ser reconocida como tal por los que se dedican a divulgar la ciencia (yo, al menos así lo reconozco), aunque también somos libres, si nos sentimos cómodos viviendo con tales “peligros”, para explicar como son, realmente las cosas.

Por una crianza antiautoritaria de nuestras hijas e hijos

La Ciencia es intrínsecamente antiautoritaria: reemplaza los sistemas de arriba-abajo de pensamiento político que Thomas Paine agrupaba bajo el término “despotismo”, por un sistema de abajo-arriba, en el que cualquiwera capaz de hacer observaciones competentes y realizar experimentos controlados puede ser acertadamente considerado como una fuente potencial de autoridad -una autoridad que r3eside, no en el individuo sino en los resultados.

La Ciencia nos anima -en realidad, nos obliga- a vivir con la duda y la ambigüedad, y a apreciar la vastedad de nuestra propia ignorancia. Estos hábitos mentales han calado, hasta cierto punto, en el dominio de los asuntos políticos tanto como los científicos. Como decía Richard Feyman, “El Gobierno de los Estados Unidos se desarrolló bajo la idea de que nadie sabía cómo formar un Gobierno, o cómo gobernar. El resultado es la invención de un sistema para gobernar cuando no se saber cómo hacerlo. Y la forma de conseguirlo es permitir un sistema, como el que nosotros tenemos, en el que nuevas ideas puedan desarrollarse, ensayarse y desecharse”.

Claro que, Richard Feyman hablaba de otra cosa. Él quería que los físicos pudioeran desarrolar sus ideas sin travas y con ,os medios necesarios para poder llegar a esas verdades que incansables buscamos.

La práctica de la Investigación Científica exige y requiere libertad de expresión y asociación, Ya es suficientemente difícil hacer física sin que te digan también que no puedes ir a la mitad de las conferencias relevantes, y que tus ideas ¡deben adecuarse a la filosofía oficial! para que no te quedes fuera de juego, es decir, sentado en el banquillo mirando como otros sí pueden jugar al ser más maleables y adaptativos.

Es una lástima que, aún hoy día, pasada la primera década del siglo XXI, las cosas continúen siendo así. Los físicos, como cualesquiera otros científicos, no pueden estar confinados de esa manera que les impida expresarse con libertad y puedan exponer sus ideas, estén éstas cercanas o no al establemint establecido en el momento.

La Ciencia, amigos míos, necesita libertad de expresión, de exponer libremente sus ideas y de, sin ninguna traba, poder publicar sus descubrimientos sean o no convenientes para el poder erstablecido. Si no dejamos que la Ciencia surja y siga su camino…¡apaga y vamonos!

emilio silvera

Ago

20

Es bueno hacerse preguntas y, tratar de contestarlas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Gaia ~

Clasificado en Gaia ~

Comments (2)

Comments (2)

¿Qué le sucedería a todo el Oxígeno altamente reactivo de la atmósfera terrestre sino no fuera renovado constantemente por la acción de los seres vivos que pueblan el planeta Tierra? Si elimináramos toda la vida que hay en el planeta, en muy poco tiempo la totalidad del Oxñigeno quedaría bloqueado dentro de compuestos químicos estables, tales como los nitratos, el dióxido de Carbono, el agua, los óxidos de hierro y las rocas siliceas. Dicho de una forma más precisa, sin la intervención de la vida, todo el Oxígeno de la atmósfera quedaría bloquedo en menos de 10 millones de años. Esto indica lo sensible que es el entorno físico aparentemente estable de nuestro planeta a la presencia (0 ausencia) de la vida.

El tema no resulta demasiado preocupante a una escala de Tiempo Humana -el mito pipular según el cual, si mañana desapareciera la Selva Amazónica, nos asfixiaríamos todos, está lejos de ser verdad- pero diez millones de años representan sólo alrededor del 0,2 por ciento de la antigüedad de la Tierra hasta el momento presente.

Si un Astrónomo que está observando un planeta como la Tierra constata que dicho planeta posee una atmósfera rica en Oxígeno, esto significa que, o bien está siendo testigo de un suceso raro y transitorio qque por razones desconocidas tiene lugar en ese planeta, o que la atmósfera se mantiene en un estado que se encuentra lejos del equilibrio.

La Vida es parte de la Tierra y ésta, es como es, porque en ella está la Vida.

La idea de que la Vida puede formar parte de un sistema autoregulador que determina la naturaleza física de la superficie actual de la Tierra (al menos en la “zona de la vida” una fina capa que va desde el fondo del océano hasta la parte más alta de la troposfera, es decir, hasta unos 15 kilómetros por encima de nuestras cabezas) fue recibido inicialmente de manera hostíl por los biólogos, y aún hoy continúa teniendo algunos oponentes.

Bueno, como de todo tiene que haber, también existen algunos movimientos místicos, cercanos a una especie de religión, a favor de Gaia (que por cierto, irritaron a Lovelock como lo hizo la Tolkien Society para J.R.R. Tolkien), que se fundamenta en una mala interpretación de lo que Lovelock y sus colegas decían. La misma Enciclopedía Británica (una copia en CD) -que debería estar mejor documentada- me dice que: “La hipótesis e Gaia es muy discutible porque da a entender que cualesquiera especies (por ejemplo, las antiguas bacterias anaerobias) podrían sacrificarse así mismas en beneficio de todos los seres vivientes”

¡Desde luego eso no es así! Esta afirmación tiene la misma lógica que decir que la teoría de Darwin es muy discutible porque sugiere que los conejos se sacrifican así mismo en beneficio de los zorros. Quizá os tenga que explocar que Lovelock no dijop nunca que Gaia sea una especie de dios, ni que la Madre Tierra cuide de nosotros, ni que una especie haga sacrificio en el bien de todos.

La verdad de todo esto es que Lovelock encontró una manera simple de describir todos los procesos relativos a la Vida que tienen lugar en la Tierra, incluídos muchos que tradicionalmente se han considerado procesos físicos no relacionados con la vida, como parte de una compleja red de interacciones, un sistema autoregulador (o autoorganizador), que ha evolucionado hasta llegar a un estado interesante, pero crítico, en el cual se puede mantener el equilibrio durante períodos de tiempo que resultan muy largos con rspecto a los estándares humanos, pero en el que pueden ocurrir unas fluctuaciones repentinas que lo aparten del equilibrio (análogo al equilibrio discontinuo de la evolución biológica).

Lo que Lovelock nos dice es que, el comportamiento de la Vida en la Tierra altera el paisaje físico (en el término “físico” incluye cuestiones tales como la composición de la atmósfera) y también el paisaje biológico, y que ambos cambios afectan de manera global al paisaje adaptativo, siendo la retroalimentación un componente clave de las interacciones.

El conjunto Sol-Tierra-Vida forman el mejor triplete

No creo que sea necesario contar ahora toda la historia completa de cómo Gaia llegó a ser ciencia respetable, pero, si miramos retrospectivamente, podríamos tomar dos ejemplos del funcionamiento de esta teoría: Uno de ellos sería un modelo teórico y el otro sería tomado del mundo real, que muestran de qué modo se produce la autorregulación a partir de la interacción entre los componentes biológicos y físicos de un planeta vivo.

El primero, un modelo llamado “Daisywold” (“Un mundo de margaritas”), es especialmente apropiado ya que se construye directamente a partir de un enigma que Sagan planteó a Lovelock poco después de que éste tuviera su ráfaga de inspiración en el JPL, y además, el modelo resuelve este enigma; es también un claro ejemplo del surgimiento de la vida, considerando que el total es mayor que la suma de las partes. Y Lovelock dice que es “el invento del que me siento más orgulloso”.

El enigma que el mundo de margaritas resuelve se conoce entre los astrónomos como la “paradoja del joven Sol que palidece”, aunque en realidad sólo era un enigma, no una paradoja, y, gracias a Lovelock, ahora ya ni siquiera es un enigma. El enigma procede del hecho de que los astrónomos pueden decir que el Sol emitía mucho menos calor cuando era joven que en el momento actual.

Han llegado a saber esto combinando informaciones relativas a interacciones nucleares obtenidas en experimentos realizados en la Tïerra, simulando mediante ordenador las condiciones existentes en el interior de las estrellas, y comparando los resultados de sus cálculos con informaciones sobre emisión de energía y la composición de estrellas de diferentes tamaños y edades, obtenidas mediante espectroscopia. Este es uno de los grandes logros de la F´siica del siglo XX (en gran medida no conocido por el público, aunque en éstas páginas os he hablado con fecuencia de Franhoufer…). Bueno, para lo que nos interesa ahora, lo importante es que podemos decir con seguridad que, cuando el Sistema solar era joven, el Sol estaba entre un 25 y un 30 por ciento más frío que en la actualidad -o, por decdirlo de otra manera, desde que se asentó como una estrella estable, la emisión de energía procedente del Sol ha crecido entre un 33 y un 43 por ciento-.

El Sistema solar se estabilizó en lo que es más o menos su configuración actual hace aproximadamente unos 4.500 millones de años y sabemos, por las pruebas que aportan los fósiles hallados en las rocas más antiguas que se encuentran en la superficie terrestre, que el agua en estado líquido y la vida existían ambas en la superficie de nuestro planeta hace 4.000 millones de años.

El enigma es por qué el aumento de emisión de calor procedente del Sol, aproximadamente un 40 por ciento durante 4.000 millones de años, no hizo hervir el agua de la superficie terrestre, secándola y dejándola sin rastro de vida.

No hay problema alguna para explicar por qué la Tierra nmo era una bola de hielo cuando el Sol estaba más bien frío, Sabemos ahora que en la atmósfera de Venus, como en la de Marte, predonina el dióxido de Carbono, y este compuesto, junto con el vapor de agua, es una parte importante de los gases liberados por la actividad volcánica. No hay razón alguna para pensar que la atmósfera de la Tierra en los primeros tiempos fuera, de algún modo, diferente de las atmósferas de sus dos vecinos planetarios más próximos, y una atmósfera rica en dióxido de Carbono sería buena para captar el calor procedente del Sol en las proximidades de la superficie del planeta, manteniendola caliente por el llamado efecto invernadero.

Un astrónomo que se pudiera en la superficie de Marte, provisto de un buen telecopio y un espectrómetro de sensibilidades adecuadas, podría asegurar, midiendo la radiación infrarroja característica, que había un rastro de dióxido de Carbono en la atmósfera de la Tierra, de la misma manera que equipos aquí, en la Tierra, lo han detectado en la atmósfera de Marte. Pero la proporción del dióxido de Carbono en la Tierra es mucho menor que en la de Marte,

La potencia del efecto invernadero se puede ver contrastando la temperatura media que se da en la actualidad en la superficie terrestre con la de la Luna, que no tiene aire, aunque está prácticamente a la misma distancia del Sol que nosotros.

En realidad es bastante sencillo imaginar diversos modos en los que la temperatura del planeta ha podido mantenerse constante gracias a cambios en la composición de la atmósfera; científicos como Carl Sagan formuló varios razonamientos al respecto antes de que Lovelock presentara su concepto de Gaia, pero, ¿quer proceso natural podía conducir a la estabilidad? Nadie lo sabía. Entonces, ¿era sólo cuestión de suerte?. Sea lo que sea lo cierto es que, debemos procurar, a medida que la Tierra envejece, tratar de reducir de manera continuada, la emisión de gases que provoquen un efecto invernadero desmesurado y nosivo para la vida.

Las primeras formas de vida terrestre basadas en la fotosíntesis (aquellas antiguas bacterias anaerobias) habrían tomado dióxido de Carbono del aire y lo habrían utilizado para formar sus cuerpos, pero habrían emitido metano al aire, con lo que el dióxido quedaría sustituido por otro gas, también de efecto invernadero, pero con unas propiedades de absorción de infrarrojos distintas de las del dióxido de Carbono. Cuando estas bacterias son más activas, el equilibrio se descompensan a favor del metano; cuando son menos activas, el equilibrio se decanta a favor del dióxido de Carbono.

La clave para empezar a comprender como podía funcionar todo esto en la Naturaleza fue la introducción de una percepción retrsoectiva en los cálculos. Con un sencillo modelo que tenía en cuenta la creciente producción de calor del Sol. Lovelock pudo demostrar que, si se permite que las bacterias aumenten a una velocidad máxima cuando la temperatura es de 25 ºC, pero con menos rapidez a temperaturas superiores o inferiores y, en ningún caso, cuando las temperaturas bajan de 0 ºC o superar los 50 ºC, se podría mantener la temperatura constante durante más o menos los primeros mil millones de años de la historia de la Tierra.

Entonces se pondrían en marcha otros procesos, principalmente el surgimiento de formas de vida que emitían oxígeno al aire, donde este elemento reaccionaria con el metano para eliminar de la red este componente, y también la disminución gradual de las concentraciones de dióxido de Carbono a través de los tiempos. Se puede hacer funcionar todo ello de una manera plausible, Sin embargo, el sistema (¿cómo no?) recibió algunas críticas. Y, aquí fue precisamente donde entró en escena Daisyworld.

Inicialmente Daisyworld fue un modelo desarrollado por Lovelock y sus colegas a principios de la década de los 80 y, desde entonces, ha cobrado vida por sí mismo (quizá adecuadamente), con variaciones sobre el tema que han sido desarrolladas por varios científicos, e incluso, en la década de 1990, se ha integrado en un juego de ordenador llamado SimEaurth.

Daisyworld comienza como un planeta igual que la Tierra, pero sin vida, que recorre una órbita alrededor del Sol, a la misma distancia que lo hace la Tierra. En las versiones más sencillas del modelo, la superficie del planeta es principalmente tierra firme, con el fin de ofrecer un lugar donde puedan crecer las margaritas, y la composición de la atmósfera se mantiene constante, por lo que hay un efecto invernadero constante. Las margaritas se presentan en dos colores, blancas o negras, y crecen cuando la temperatura es de 20 ºC. Les va proporcionalmente peor cuando la temperatura desciende por debajo de este valor óptimo, y no pueden crecer por debajo de 5 ºC; también les va peor en proporción cuando la temperatura asciende por encima del valor óptimo, y no consigue crecer por encima de 40 ºC.

El modelo se pone a funcionar cuando la temperatura del Sol virtual aumenta lentamente del mismo modo que lo hacía el Sol real en su juventud. Una vez que la temperatura en el ecuador de la Tierra del modelo alcanza los 5 ºC, se diseminan semillas de margarita de ambas variedades por la superficie y se deja que actúen por su cuenta -con la condición de que se reproduzcan de verdad, de tal modo que las margaritas blancas tengan siempre descendencia blanca y las margaritas negras produzcan siempre otas también negras.

Como ya sabe cualquiera que haya subido a un coche negro que ha estado aparcado al Sol en verano, los objetos de colores oscuros absorben el calor del Sol con mayor eficacia que los objetos de colores blancos. Por lo tanto, un macizo de margaritas negras absorberá calor y calentará la pequeña superficie en la que se encuentre, mientras que un macizo de margaritas blancas reflejará el calor y refrescará la tierra sobre la que está plantado.

Mientras Daisyworld está freco, las margaritas negras tienen una ventaja, ya que calientan su entorno, llevando la temperatura a un valor cercano al óptimo, y crecen. En las generaciones siguientes, las margaritas negras se propagan por la superficie del planeta a expensas de las blancas, de tal modo que todo el planeta se vuelve más eficaz para absorber el calor procedente del Sol, y su temperatura asciende aún más rápidamente que si lo hiciera sólo como resultado del aumento de la temperatura del Sol. Sin embargo, una vez la temperatura supera los 20 ºC en cualquier lugar de la superficie terrestre del modelo, son las margaritas blancas las que tienen ventaja, porque al refrescar la superficie hacen que la situación vuelva a tender a la temperatura óptima.

Aunque la temperatura del Sol continúe aumentando, dado que ahora las margaritas blancas se propagan a expensas de las negras, la temperatura del planeta ha quedado rondando los 20 ºC hasta que toda la superficie planetaria queda cubierta de margaritas blancas. Entonces, como la temperatura del Sol sigue aumentando, las margaritas lo tienen cada vez más difícil, hasta que la temperatura alcanza los 40 ºC y mueren todas. La gama total de producción de energía solar que cubre esta versión del modelo va desde el 60 por ciento hasta el 140 por ciento de la producción actual de energía de nuestro Sol.

El efecto global es que durante un largo período de tiempo, aunque la producción de calor del sol del modelo aumenta, la temperatura de la Tierra del modelo no sólo permanece constante, sino que se mantiene en la temperatura óptima para la vida -sin que las margaritas hagan ninguna planificación consciente, y sin indicios de que otra clase de margaritas “se esté sacrificando así misma” en beneficio de todos los seres vivos-. Ambas variedades actuan sólo en su propio interés. Pero, ¿puede un sistema muy sencillo, como éste, ser realmente representativo del modo en que la Naturaleza actúa en realidad?

Bueno, unas de las cosas que no me gustan de este modelo es que no permite que las margarites evolucionen y que, por ejemplo, unas margaritas incolaras aparecieran por mutación y pudieran incadir todo el planeta en detrimento de las otras dos especies…Hay otras muchas posibilidades que el modelo deja fuera.

Esto es largo y, nos llevaría todo el día pero, lo que vengo a significar es que, el equilibrio Tierra-Vida es una fina línea que, en cualquier momento podemos romper y, si no andamos con cuidado podríamos ser los causantes de que, la simbiosis actual que existe entre la vida y el planeta se rompa y todo se vaya al traste…¿Qué pasó en Marte? La verdad es que nadie lo saber pero, si antes era como la Tierra y ahora, es como lo podemos ver…algo pasaría y, lo mejor es que no ocurra aquí lo mismo.

emilio silvera

Ago

20

Los Misterios de la Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (4)

Comments (4)

¿Quién no ha oído la palabra Bosón en los últimos tiempos? Pero, ¿Qué es un Bosón?

Bueno, un Bosón es una partícula elemental con espín entero, es decir, una partícula que obedece a la estadística de Bose-Einstein de la cual deriva su nombre, y, cuando hablamos de estadística cuántica nos estamos refiriendo a la descripción estadística de un sistema de partículas que obedece a las reglas de la mecánica cuántica en vez de las de la mecánica clásica. En estadística cuántica, los estados de energía se considera que están cuantizados.

La estadística de Bose-Einstein se aplica si cualquier número de partículas pueden ocupar un estado cuántico dado. Dichas partículas se llaman Bosones. Los bosones tienen momento angular nh/2π, donde n es cero o un entero y h es la constante de Planck. Para Bosones idénticos, la función de onda es siempre simétrica. Si sólo una partícula puede ocupar un estado cuántico, se aplica la estadística de Fermi-Dirac y las partículas se llaman fermiones. Los fermiones tienen momento angular (n + ½) h/2π y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La relación entre el espín y la estadística de las partículas está demostrada por el teorema espín-estadística.

En un espacio de dos dimensiones es posible que haya partículas (o cuasi partículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el nombre de aniones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de +1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Ago

19

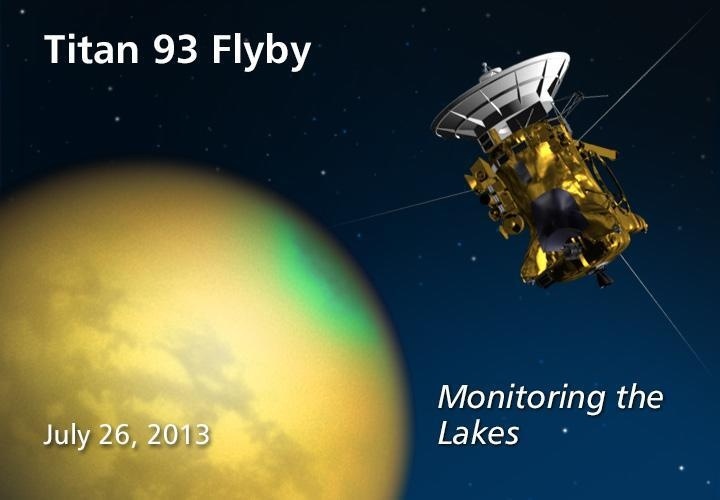

¡¡Titán!! ¿Qué sorpresas nos espera?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias ~

Clasificado en Noticias ~

Comments (0)

Comments (0)

El misterio de las olas perdidas en Titán

22 de julio de 2013: Uno de los descubrimientos más sorprendentes de los últimos 10 años es lo mucho que se parece el paisaje de la luna Titán, del planeta Saturno, a nuestro planeta Tierra. Al igual que nuestro planeta azul, la superficie de Titán está salpicada con lagos y mares, tiene canales de ríos, islas, lodo, nubes de lluvia y, tal vez, hasta arcoíris. La gigantesca luna es indudablemente húmeda.

El “agua” de Titán, sin embargo, no es H2O. Con una temperatura en la superficie que está por debajo de los 143o C (290o F) bajo cero, Titán es demasiado fría como para tener agua líquida. En cambio, los investigadores creen que el líquido que esculpe a Titán es una mezcla desconocida de metano, etano y otros hidrocarburos difíciles de congelar.

La idea de que Titán es un mundo húmedo, con “agua” alienígena que le es propia, está ampliamente aceptada por los científicos planetarios. No hay otro modo de explicar las observaciones: la sonda Cassini, de la NASA, ha sobrevolado a Titán más de noventa veces desde el año 2004, enviándole pulsos de radar y construyendo mapas de sus lagos y mares. La sonda Huygens, de la Agencia Espacial Europea, se posó sobre la superficie de Titán usando un paracaídas en el año 2005; descendió a través de nubes húmedas y cayó de hecho sobre suelo mojado.

Sin embargo, algo sigue inquietando a Alex Hayes, quien es un científico planetario del equipo de radar de la misión Cassini, en la Universidad Cornell.

“Pero si Titán es tan húmeda”, se pregunta, “¿dónde están las olas?”

Aquí en la Tierra, los cuerpos de agua raramente están quietos. La brisa que sopla sobre sus superficies causa la formación de olas, que se levantan y rompen; las gotas de lluvia que caen sobre la superficie de los mares también proveen oleaje. Y, sin embargo, de acuerdo con los datos proporcionados por la sonda Cassini, en Titán los lagos están bizarramente quietos, sin acción del oleaje notoria hasta escalas milimétricas.

“Sabemos que hay viento en Titán”, dice Hayes. “Las magníficas dunas de arena en la luna son la prueba”.

Añada a esto la baja gravedad de Titán (apenas un séptimo de la de la Tierra) que ofrece muy poca resistencia al movimiento de las olas, y entonces se tiene un verdadero rompecabezas.

Los investigadores han jugado con varias posibles explicaciones. Tal vez los lagos están congelados. Hayes piensa, sin embargo, que esto es poco probable “debido a que hemos visto evidencia de precipitaciones pluviales y temperaturas en la superficie, las cuales se encuentran muy por encima del punto de fusión del metano”. O tal vez los lagos están cubiertos por una sustancia parecida a la brea, que apacigua el oleaje. “No podemos descartar eso todavía”, añade.

La respuesta podría estar en los resultados de un estudio que Hayes y sus colaboradores publicaron en la edición electrónica, de julio de 2013, de la revista científica Icarus. Teniendo en cuenta la gravedad de Titán, la baja viscosidad de los hidrocarburos líquidos, la densidad de la atmósfera de Titán y otros factores, ellos calcularon qué tan rápidamente debería soplar el viento en Titán para levantar olas: el resultado es que una brisa muy leve, de apenas 1,7 a 3,5 km por hora (1 a 2 millas por hora) podría ser suficiente.

Y esto es lo que sugiere una tercera posibilidad: los vientos no han soplado lo suficientemente fuerte. Desde que Cassini llegó a Saturno, en 2004, el hemisferio norte de Titán (donde se encuentran la mayoría de los lagos) ha estado bajo el yugo del invierno. El aire frío y pesado apenas se mueve, así que mucho menos alcanza el umbral necesario para formar olas.

Pero ahora viene el cambio de estación. En agosto del año 2009, el Sol cruzó el ecuador de Titán, moviéndose hacia el norte. Ya se aproxima el verano, trayendo consigo luz, calor y vientos a la zona de los lagos de Titán.

“De acuerdo con los modelos climáticos, los vientos deberán incrementarse conforme se aproxime el solsticio, en 2017, y deberían ser lo suficientemente fuertes como para levantar olas”, dice el científico.

Si las olas aparecen, la sonda Cassini deberá ser capaz de detectarlas. Los pulsos reflejados de radar que provienen de superficies con oleaje pueden decir muchas cosas a los investigadores. Las dimensiones de las olas, por ejemplo, podrían revelar la viscosidad del líquido que yace a mayor profundidad y, por lo tanto, su composición química. También, la rapidez de las olas podría ayudar a dar seguimiento a los cambios de velocidad de los vientos que soplan sobre ellas, dando de esta manera una medición independiente de los modelos climáticos de Titán.

Fuente: NASA

Ago

19

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (3)

Comments (3)

Lo cierto es que, en su momento, ya desde el inicio del año 2.009 en el que se celebró el Año Internacional de la Astronomía, en muchos de mis artículos publicados en la colaboración que con la Organización Internacioón tuve el honor de prestar, se hablaba de todos esos interesantes temas que, el universo nos presenta y que, inciden en el saber de la Naturaleza y del Mundo que nos acoge que, como nosotros… ¡También es Universo!

LA QUÍMICA DE LAS ESTRELLAS

Los cambios se estaban produciendo a una velocidad cada vez mayor. Al siglo de Newton también pertenecieron, entre otros, el matemático Fermat; Römer, quien midió la velocidad de la luz; Grimaldi, que estudió la difracción; Torricelli, que demostró la existencia del vacío; Pascal y Boyle, que definieron la física de los fluidos…La precisión de los telescopios y los relojes aumentó notablemente, y con ella el número de astrónomos deseosos de establecer con exactitud la posición de las estrellas y compilar catálogos estelares cada vez más completos para comprender la Vía Láctea.

La naturaleza de los cuerpos celestes quedaba fuera de su interés: aunque se pudiera determinar la forma, la distancia, las dimensiones y los movimientos de los objetos celestes, comprender su composición no estaba a su alcance. A principios del siglo XIX, William Herschel (1738-1822), dedujo la forma de la Galaxia, construyó el mayor telescopio del mundo y descubrió Urano. Creía firmemente que el Sol estaba habitado.

Hasta llegar a conocer nuestra situación astronómica…

Al cabo de pocos años, nacía la Astrofísica, que a diferencia de la Astronomía (ya llamada -“clásica o de posición”-), se basaba en pruebas de laboratorio. Comparando la luz emitida por sustancias incandescentes con la recogida de las estrellas se sentaban las bases de lo imposible: descubrir la composición química y la estructura y el funcionamiento de los cuerpos celestes. Estaba mal vista por los astrónomos “serios” y se desarrolló gracias a físicos y químicos que inventaron nuevos instrumentos de análisis a partir de las demostraciones de Newton sobre la estructura de la luz.

En 1814, Joseph Fraunhofer (1787-1826) realizó observaciones básicas sobre las líneas que Wollaston había visto en el espectro solar: sumaban más de 600 y eran iguales a las de los espectros de la Luna y de los planetas; también los espectros de Póux, Capella y Porción son muy similares, mientras que los de Sirio y Cástor no lo son. Al perfeccionar el espectroscopio con la invención de la retícula de difracción (más potente y versátil que el prisma de cristal), Fraunhofer observó en el espectro solar las dos líneas del sodio: así se inició el análisis espectral de las fuentes celestes.

Mientras, en el laboratorio, John Herschel observó por primera vez la equivalencia entre los cuerpos y las sustancias que los producen, Anders J. Anhström (1814-1868) describía el espectro de los gases incandescentes y los espectros de absorción y Jean Foucault (1819-1874) comparó los espectros de laboratorio y los de fuentes celestes. Gustav Kirchhoff (1824-1887) formalizó las observaciones en una sencilla ley que cambió la forma de estudiar el cielo; “La relación entre el poder de emisión y de absorción para una longitud de onda igual es constante en todos los cuerpos que se hallan a la misma temperatura”. En 1859, esta ley empírica, que relacionaba la exploración del cielo con la física atómica, permitía penetrar en la química y la estructura de los cuerpos celestes y las estrellas. De hecho, basta el espectro de una estrella para conocer su composición. Y, con la espectroscopia, Kirchhoff y Robert Bunsen (1811-1899) demostraron que en el Sol había muchos metales.

La observación del Sol obsesionó a la mayoría de los Astrofísicos. A veces, resultaba difícil identificar algunas líneas y ello condujo a descubrir un nuevo elemento químico; se empezó a sospechar que el Sol poseía una temperatura mucho más elevada de lo imaginado. La línea de emisión de los espectros de estrellas y nebulosas demostraron que casi un tercio de los objetos estudiados eran gaseosos. Además, gracias al trabajo de Johan Doppler (1803-1853) y de Armand H. Fizeau (1819-1896), que demostró que el alejamiento o el acercamiento respecto al observador de una fuente de señal sonora o luminosa provoca el aumento o disminución de la longitud de onda de dicha señal, empezó a precisarse la forma de objetos lejanos. El cielo volvía a cambiar y hasta las “estrellas fijas” se movían.

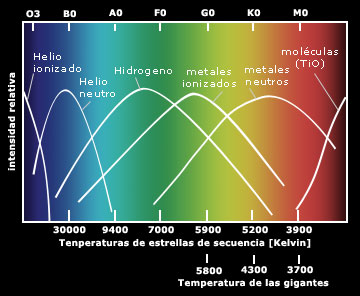

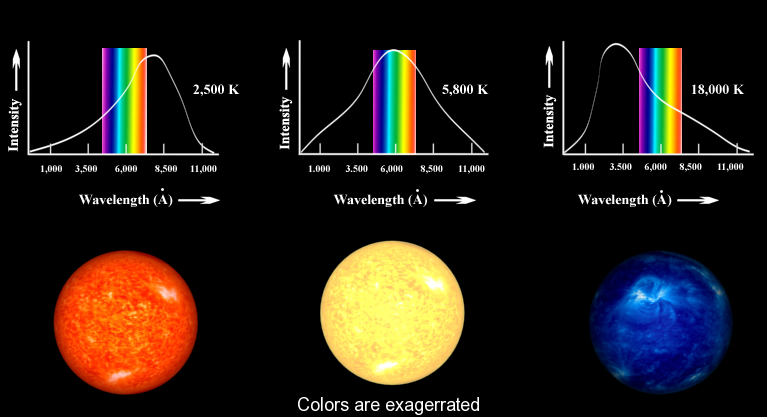

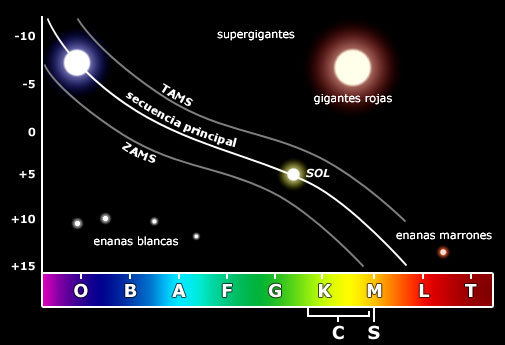

EL DIAGRAMA HR: EL CAMINO HACIA EL FUTURO

El padre Ángelo Secchi (1818-1878) fue el primero en afirmar que muchos espectros estelares poseen características comunes, una afirmación refrendada hoy día con abundantes datos. Secchi clasificó las estrellas en cinco tipos, en función del aspecto general de los espectros. La teoría elegida era correcta: el paso del color blanco azulado al rojo oscuro indica una progresiva disminución de la temperatura, y la temperatura es el parámetro principal que determina la apariencia de un espectro estelar.

Más tarde, otros descubrimientos permitieron avanzar en Astrofísica: Johan Balmer (1825-1898) demostró que la regularidad en las longitudes de onda de las líneas del espectro del hidrógeno podía resumirse en una sencilla expresión matemática; Pieter Zeeman (1865-1943) descubrió que un campo magnético de intensidad relativa influye en las líneas espectrales de una fuente subdividiéndolas en un número de líneas proporcional a su intensidad, parámetro que nos permite medir los campos magnéticos de las estrellas.

En otros descubrimientos empíricos la teoría surgió tras comprender la estructura del átomo, del núcleo atómico y de las partículas elementales. Los datos recogidos se acumularon hasta que la física y la química dispusieron de instrumentos suficientes para elaborar hipótesis y teorías exhaustivas. Gracias a dichos progresos pudimos asistir a asociaciones como Faraday y su concepto de “campo” como “estado” del espacio en torno a una “fuente”; Mendeleiev y su tabla de elementos químicos; Maxwell y su teoría electromagnética; Becquerel y su descubrimiento de la radiactividad; las investigaciones de Pierre y Marie Curie; Rutherford y Soddy y sus experimentos con los rayos Alfa, Beta y Gamma; y los estudios sobre el cuerpo negro que condujeron a Planck a determinar su constante universal; Einstein y su trabajo sobre la cuantización de la energía para explicar el efecto fotoeléctrico, Bohr y su modelo cuántico del átomo; la teoría de la relatividad especial de Einstein que relaciona la masa con la energía en una ecuación simple…Todos fueron descubrimientos que permitieron explicar la energía estelar y la vida de las estrellas, elaborar una escala de tiempos mucho más amplia de lo que jamás se había imaginado y elaborar hipótesis sobre la evolución del Universo.

En 1911, Ejnar Hertzsprung (1873-1967) realizó un gráfico en el que comparaba el “color” con las “magnitudes absolutas” de las estrellas y dedujo la relación entre ambos parámetros. En 1913, Henry Russell (1877-1957) realizó otro gráfico usando la clase espectral en lugar del color y llegó a idénticas conclusiones.

El Diagrama de Hertzsprung-Russell (diagrama HR) indica que el color, es decir, la temperatura, y el espectro están relacionados, así como el tipo espectral está ligado a la luminosidad. Y debido a que esta también depende de las dimensiones de la estrella, a partir de los espectros puede extraerse información precisa sobre las dimensiones reales de las estrellas observadas. Ya solo faltaba una explicación de causa-efecto que relacionara las observaciones entre si en un cuadro general de las leyes.

El progreso de la física y de la química resolvió esta situación, pues, entre otros avances, los cálculos del modelo atómico de Bohr reprodujeron las frecuencias de las líneas del hidrógeno de Balmer. Por fin, la Astrofísica había dado con la clave interpretativa de los espectros, y las energías de unión atómica podían explicar el origen de la radiación estelar, así como la razón de la enorme energía producida por el Sol.

Las líneas espectrales dependen del número de átomos que las generan, de la temperatura del gas, su presión, la composición química y el estado de ionización. De esta forma pueden determinarse la presencia relativa de los elementos en las atmósferas estelares, método que hoy también permite hallar diferencias químicas muy pequeñas, relacionadas con las edades de las estrellas. Así, se descubrió que la composición química de las estrellas era casi uniforme: 90 por ciento de hidrógeno y 9 por ciento de helio (en masa, 71% y 27%, respectivamente). El resto se compone de todos los elementos conocidos en la Tierra.

Así mismo, el desarrollo de la Física ha permitido perfeccionar los modelos teóricos y explicare de forma coherente que es y como funciona una estrella. Dichos modelos sugirieron nuevas observaciones con las que se descubrieron tipos de estrellas desconocidas: las novas, las supernovas, los púlsares con periodos o tiempos que separan los pulsos, muy breves…También se descubrió que las estrellas evolucionan, que se forman grupos que luego se disgregan por las fuerzas de marea galácticas.

La Radioastronomía, una nueva rama de la Astronomía, aportó más datos sobre nuestra Galaxia, permitió reconstruir la estructura de la Vía Láctea y superar los límites de la Astronomía óptica.

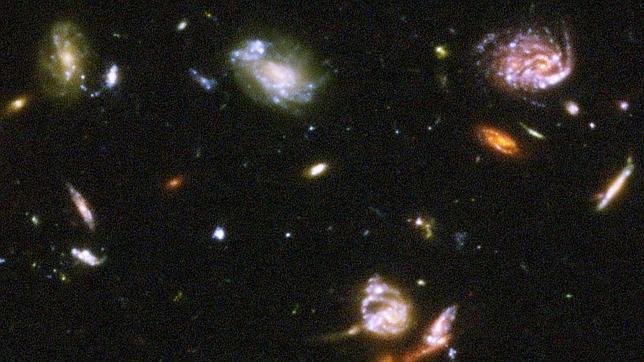

Se estaban abriendo nuevos campos de estudio: los cuerpos galácticos, los cúmulos globulares, las nebulosas, los movimientos de la galaxia y sus características se estudiaron con ayuda de instrumentos cada vez más sofisticados. Y cuanto más se observaba más numerosos eran los objetos desconocidos descubiertos y más profusas las preguntas. Se descubrieron nuevos y distintos tipos de galaxias fuera de la nuestra; examinando el efecto Doppler, se supo que todas se alejaban de nosotros y, lo que es más, que cuanto más lejanas están más rápidamente se alejan.

El Telescopio Hubble nos muestra esta imagen del Universo Profundo

Acabábamos de descubrir que el Universo no terminaba en los límites de la Vía Láctea, sino que se había ampliado hasta el “infinito”, con galaxias y objetos cada vez más extraños. Sólo en el horizonte del Hubble se contabilizan 500 millones de galaxias. Y los descubrimientos continúan: desde el centro galáctico se observa un chorro de materia que se eleva más de 3.000 a.l. perpendicular al plano galáctico; se observan objetos como Alfa Cygni, que emite una energía radial equivalente a diez millones de veces la emitida por una galaxia como Andrómeda; se estudian los cuásares, que a veces parecen mas cercanos de lo que sugieren las mediciones del efecto Doppler; se habla de efectos de perspectiva que podrían falsear las conclusiones… Y nos asalta una batería de hipótesis, observaciones, nuevas hipótesis, nuevas observaciones, dudas…

Todavía no se ha hallado una respuesta cierta y global. Un número cada vez mayor de investigadores está buscándola en miles de direcciones. De esta forma se elaboran nuevos modelos de estrellas, galaxias y objetos celestes que quizá sólo la fantasía matemática de los investigadores consiga concretar: nacen los agujeros negros, los universos de espuma, las cadenas…

Encontrsar Grafeno en el espacio ya no es una sorpresa, toparnos de bruces con océanos de metano… ¡tampoco!, hallar colonias de bacterias vivienda a muchos kilómetros de altura no es una niovedad, saber que en las estrellas se fabrican los materiales aptos para hacer posible la química de la vida… nos maravilla pero ya, no es causa de asombro. Cada día damos un paso más hacia el saber del “mundo”, de la Naturaleza, del Universo en fin.

En la actualidad, el número de investigadores centrados en problemas relacionados con la evolución estelar, la Astrofísica y las teorías cosmogenéticas es tan elevado que ya no tiene sentido hablar de uno en particular, ni de un único hilo de investigación. Al igual que ocurre con otras ramas científicas las Astronomía se ha convertido en un trabajo de equipo a escala internacional que avanza sin cesar en una concatenación de innovaciones, inventos, nuevos instrumentos, interpretaciones cada vez más elaboradas y, a menudo más difíciles de entender incluso para los investigadores que avanzan con infinidad de caminos paralelos. Es una situación que ya vaticinaba Bacon en tiempos de Galileo.

Hasta la Astronomía se ha hiperespecializado y, por ejemplo, quienes estudian problemas particulares de la física de las estrellas pueden desconocerlo todo sobre planetas y galaxias. También el lenguaje es cada vez más técnico, y los términos, capaces de resumir itinerarios de investigación, son complejos de traducir al lenguaje común. Así, mientras la divulgación avanza a duras penas entre una jungla de similitudes y silogismos, las informaciones que proceden de otras disciplinas son aceptadas por los científicos y los resultados de cada cual se convierten en instrumentos para todos.

La observación del Sol obsesionó a la mayoría de los Astrofísicos. A veces, resultaba difícil identificar algunas líneas y ello condujo a descubrir un nuevo elemento químico; se empezó a sospechar que el Sol poseía una temperatura mucho más elevada de lo imaginado. La línea de emisión de los espectros de estrellas y nebulosas demostraron que casi un tercio de los objetos estudiados eran gaseosos. Además, gracias al trabajo de Johan Doppler (1803-1853) y de Armand H. Fizeau (1819-1896), que demostró que el alejamiento o el acercamiento respecto al observador de una fuente de señal sonora o luminosa provoca el aumento o disminución de la longitud de onda de dicha señal, empezó a precisarse la forma de objetos lejanos. El cielo volvía a cambiar y hasta las “estrellas fijas” se movían.

Las investigaciones sobre planetas, estrellas, materia interestelar, galaxias y Universo van paralelas, como si fueran disciplinas independientes, pero en continua osmosis. Y mientras la información sobre el Sol y los cuerpos del Sistema solar es más completa, detallada y fiable, y las hipótesis sobre nuestra Galaxia hallan confirmación, el Universo que empezamos a distinguir más allá de nuestros limites no se pareced a lo que hace un siglo se daba por sentado. Y mientras los modelos matemáticos dibujan uno o mil universos cada más abstractos y complejos, que tienen más que ver con la filosofía que con la observación, vale la pena recordar como empezó nuestro conocimiento hace miles de años.

Otros nos indicaron la dirección a seguir pero, la dureza del camino…, esa, la tuvimos que hacer nosotros. Es decir, en cada época y lugar, los que estuvieron, miraron hacia atrás para ver lo que hicieron sus ancestros y, con aquellas enseñanzas, tener la guía del camino a seguir, o, por el contrario, si los resultados no fueron biuenos, rechazarlos. Lo cierto es que, al igual que nosotros, los que vengan detrás partirán con alguna ventaja aunque tengan que hacer su propio recorrido que, ni mucho menos tienen el camino despejado y, la niebla d ela ignorancia sigue siendo espesa, auunque algo más suave que la que nosotros nos encontramos.

Ahora, amigos, después de este breve repaso por una pequeña parte de la Historia de la Astronomía, al menos tendréis una idea más cercana del recorrido que, la Humanidad, ha tenido que realizar para conocer mejor el Universo.

Los datos aquí reseñados tienen su origen en diversas fuentes que, de aquí y de allá, han sido tomadas para recomponer un mensaje que les lleve a todos algunos mensajes de como ocurrieron los acontecimientos en el pasado para que fuera posible nuestro presente.

emilio silvera

Totales: 83.700.341

Totales: 83.700.341 Conectados: 42

Conectados: 42