Ene

20

Un viaje: desde los átomos hasta las estrellas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

Pues yo he sido a veces un muchacho y una chica,

Un matorral y un pájaro y un pez en las olas saladas.

Esto nos decía Empédocles, el padre de aquellos primitivos elementos formados por Agua, tierra, aire y fuego que, mezclados en la debida proporción, formaban todas las cosas que podemos ver a nuestro alrededor. Claro que, él no podía llegar a imaginar donde pudimos llegar después en la comprensión de la materia a partir del descubrimiento de las partículas “elementales” que formaban el átomo.

Sí, hay cosas malas y buenas pero, todas deben ser conocidas poder, en el primer caso aprovecharlas y en el segundo prevenirlas.

Pero demos un salto en el tiempo y viajémos hasta los albores del siglo XX cuando se hacía vez más ervidente que alguna clase de energía atómica era responsable de la potencia del Sol y del resto de las estrellas que más lejos, brillaban en la noche oscura. Ya en 1898, sólo dos años despuès del descubrimiento de la radiactividad por Becquerel, el geólogo americano Thomas Chrowder Chamberlin especulaba que los átomos eran “complejas organizaciones y centros de eneromes energías”, y que “las extraordinarias que hay en el centro del Sol pueden…liberar una parte de su energía”. Claro que, por aquel entonces, nadie sabía cual era el mecanismo y cómo podía operar, hasta que no llegamos a saber mucho más, sobre los átomos y las estrellas.

El intento de lograr tal comprensión exigió una colaboración cada vez mayor los astrónomos y los físicos nucleares. Su llevaría, no sólo a resolver la cuestión de la energía estelar, sino también al descubrimiento de una trenza dorada en la que la evolución cósmica se entrelaza en la historia atómica y la estelar.

La Clave: Fue comprender la estructura del átomo. Que el átomo tenía una estructura interna podía inferirse de varias líneas de investigación, entre ellas, el estudio de la radiactividad: para que los átomos emitiesen partículas, como se había hallado que lo hacían en los laboratorios de Becquerel y los Curie, y para que esas emisiones los transformasen de unos elementos en otros, como habían demostrado Rutherford y el químico inglés Frederick Soddy, los átomos debían ser algo más que simples unidades indivisibles, como implicaba su (de la voz griega que significa “imposible de cortar”).

El átomo de Demócrito era mucho más de lo que él, en un principio intuyó que sería. Hoy sabemos que está conformado por diversaspartículas de familias diferentes: unas son bariones que en el seno del átomo llamamos necleones, otras son leptones que gitan alrededor del núcleo para darle estabilidad de cargas, y, otras, de la familia de los Quarks, construyen los bariones del núcleo y, todo ello, está, además, vigilado por otras partículas llamadas bosones intermedios de la fuerza nuclear fuerte, los Gluones que, procuran mantener confinados a los Quarks.

Pero no corramos tanto, la física atómica aún debería recorrer un largo camino llegar a comprender la estructura que acabamos de reseñar. De los trs principales componentes del átomo -el protón, el neutrón y el electrón-, sólo el electrón había sido identificado (por J.J. Thomson, en los últimos años del siglo XIX). Nadie hablaba de energía “nuclear” pues ni siquiera se había demostrado la existencia de un núcleo atómico, y mucho menos de sus partículas constituyentes, el protón y el neutrón, que serían identificados, respectivamente, por Thomson en 1913 y James Chawick en 1932.

De importancia capital resultó conocer la existencia del núcleo y que éste, era 1/100.000 del total del átomo, es decir, casi todo el átomo estaba compuesto de espacios “vacíos” y, la materia así considerada, era una fracción inifintesimal del total atómico.

Rutherford, Hans Geiger y Ernest Marsden se encontraban los Estrabones y Tolomeos de la cartografía atómica, en Manchester , de 1909 a 1911, sonderaron el átomo lanzando corrientes de “partículas alfa” subatómicas -núcleos de helio- contra delgadas laminillas de oro, plata, estaño y otros metales. La mayoría de partículas Alfa se escapaban a través de las laminillas, pero, sombro de los experimentadores, algunas rebotaban hacia atrás. Rutherford pensó durante largo tiempo e intensamente en este extraño resultado; era tan sorprendente, señalaba, como si una bala rebotase sobre un pañuelo de papel. Finalmente, en una cena en su casa en 1911, anunció a unos pocos amigos que había dado con una explicación: que la mayoría de la masa de un átomo reside en un diminuto núcleo masivo. Ruthertford pudo calcular la carga y el diámetro máximo del nucleo atómico. Así se supo que los elementos pesados eran más pesados que los elementos ligeros porque los núcleos de sus átomos tienen mayor masa.

Todos sabemos , la función que desarrollan los electrones en el atomo. Pero el ámbito de los electrones para poder llegar a la comprensión completa, tuvo que ser explorado, entre otros, por el físico danés Niels Bohr, quien demostró que ocupaban órbitas, o capas, discretas que rodean al núcleo. (Durante un tiempo Bohr consideró el átomo como un diminuto sistema solar, pero ese análisis, pronto demostró ser inadecuado; el átomo no está rígido por la mecánica newtoniana sino por la mecánica cuántica.)

Entre sus muchos otros éxitos, el modelo de Bohr revelaba la base física de la espectroscopia. El de electrones de un átomo está determinado por la carga eléctrica del núcleo, la que a su vez se debe al de protones del núcleo, que es la clave de la identidad química del átomo. Cuando un electrón cae de una órbita externa a una órbita interior emite un fotón. La longitud de onda de este fotón está determinada por las órbitas particulares entre las que el electrón efectúa la transición. E esta es la razón de que un espectro que registra las longitudes de onda de los fotones, revele los elementos químicos que forman las estrellas u otros objetos que sean estudiados por el espectroscopista. En palabras de Max Planck, el fundador de la física cuántica, el modelo de Bohr del átomo nos proporciona “la llave largamente buscada de la puerta de entrada al maravilloso mundo de la espectroscopia, que desde el descubrimiento del análisis espectral (por Fraunhoufer) había desafiado obtinadamente todos los intentos de conocerlo”.

Es curioso que, mirando en la oscura noche como brillan las estrellas del cielo, nos atrae su titilar engañoso (es la atmósfera terrestre la que hace que lo parezca) y su brillo, Sin embargo, pocos llegan a pensar en lo que verdaderamente está allí ocurriendo. Las transformaciones de fase por fusión no cesan. transformación de materia en energía es consecuencia de la equivalencia materia-energía, enunciada por Albert Einstein en su famosa fórmula E=mc2; donde E es la energía resultante, m es la masa transformada en energía, y c es la velocidad de la luz (300 000 kilómetros por segundo). La cantidad de energía que se libera en los procesos de fusión termonuclear es fabulosa. Un gramo de materia transformado íntegramente en energía bastaría satisfacer los requerimientos energéticos de una familia mediana durante miles de años.

Es un gran triunfo del ingenio humano el saber de qué, están confomadas las estrellas, de qué materiales están hechas. Recuerdo aquí a aquel Presidente de la Real Society de Londres que, en una reunión multitudinaria, llegó a decir: “Una cosa está clara, nunca podremos saber de qué están hechas las estrellas”. El hombre se vistió de gloria con la, entonces, famosa frase. Creo que nada, con tiempo por delante, será imposible para nosotros.

Pero, por maravilloso que nos pueda parecer el haber llegado a la comprensión de que los espectros revelan saltos y tumbos de los electrones en sus órbitas de Bohr, aún nadie podía hallar en los espectros de las estrellas las claves significativas sobre lo que las hace brillar. En ausencia de una teoría convincente, se abandonó este campo a los taxonomistas, a los que seguían obstinadamente registrando y catalogando espectros de estrellas, aunque no sabían hacia donde los conduciría esto.

En el Laboratorio de la Universidad de Harvard, uno de los principales centros de la monótona pero prometedora tarea de la taxonomía estelar, las placas fotográficas que mostraban los colores y espectros de decenas de miles de estrellas se apilaban delante de “calculadoras”, mujeres en su mayoría y, de entre ellas, Henrietta Leavitt, la investigadora pionera de las estrellas variables Cefeidas que tan útiles serían a Shapley y Hubble.

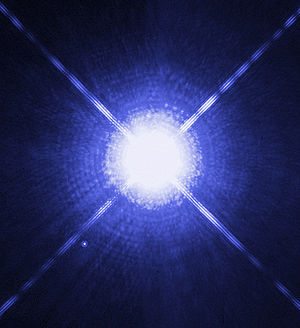

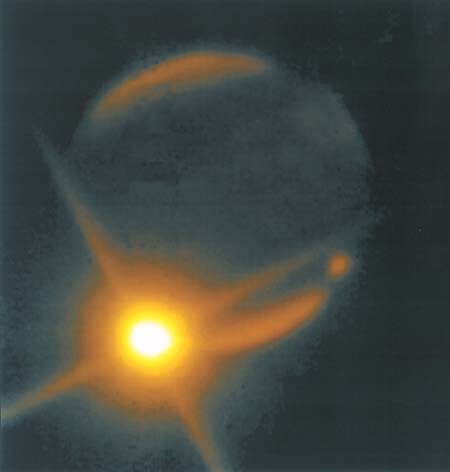

Imagen de Sirio A (estrella grande) y Sirio B (estrella pequeña abajo a la izquierda) tomadas por el Telescopio Hubble (Créd. NASA). Sirio es la quinta estrella más cercana y tiene una edad de 300, millones de años. Es una estrella blanca de la secuencia principal de espectral A1V con temperatura superficial de 10 000 K y situada a 8,6 años luz de la Tierra. Es una estrella binaria y, de ella, podríamos contar muchas historias. La estrella fue importante en las vidas de Civilizaciones pasadas como, por ejemplo, la egipcia.

Fue Cannon quien, en 1915, empezó a discernir la forma en una totalidad de estrellas en las que estaba presente la diversidad, cuando descubrió que en una mayoría, las estrellas, pertenecían a una de media docena de clases espectrales distintas. Su sistema de clasificación, generalizado en la astronomía estelar, ordena los espectros por el color, desde las estrellas O blancoazuladas, pasando por las estrellas G amarillas como el Sol, hasta estrellas rojas M. Era un rasgo de simplicidad denajo de la asombrosa variedad de las estrellas.

Pronto se descubrió un orden más profundo, en 1911, cuando el ingeniero y astrónomo autodidacta danés Ejnar Hertzsprung analizó los de Cannon y Maury de las estrellas de dos cúmulos, las Híades y las Pléyades. Los cúmulos como estos son genuinos conjuntos de estrellas y no meras alineaciones al azar; hasta un observador inexperimentado salta entusiamado cuando recorre con el telecopio las Pléyades, con sus estrellas color azul verdoso enredadas en telarañas de polvo de diamante, o las Híades, cuyas estrellas varían en color desde el blanco mate hasta un amarillo apagado.

Híades

Hertzsprung utilizó los cúmulos como muestras de laboratorio con las que podía buscar una relación entre los colores y los brillos intrínsecos de las estrellas. Halló tal relación: la mayoría de las estrellas de ambos cúmulos caían en dos líneas suavemente curvadas. Esto, en de gráfico, fue el primer esbozo de un árbol de estrellas que desde entonces ha sido llamado diagrama Hertzsprung-Russell.

El progreso en física, mientras tanto, estaba bloquedado por una barrera aparentemente insuperable. Esto era literal: el agente responsable era conocido como barrera de Coulomb, y por un tiempo frustó los esfuerzos de las físicos teóricos para copmprender como la fusión nuclear podía producir energía en las estrellas.

La línea de razonamiento que conducía a esa barrera era impecable. Las estrellas están formadas en su mayor por hidrógeno. (Esto se hace evidente en el estudio de sus espectros.) El núcleo del átomo de Hidrógeno consiste en un solo protón, y el protón contiene casi toda la masa del átomo. (Sabemos esto por los experimentos de Rutherford). Por tanto, el protón también debe contener casi toda la energía latente del átomo de hidrógeno. (Recordemos que la masa es igual a la energía: E = mc2.) En el calor de una estrella, los protones son esparcidos a altas velocidades -el calor intenso significa que las partículas involucradas se mueven a enormes velocidades- y, como hay muchos protones que se apiñan en el núcleo denso de una estrella, deben tener muchísimos choques. En resumen, la energía del Sol y las estrellas, puede suponerse razonablemente, implica las interacciones de los protones. era la base de la conjetura de Eddintong de que la fuente de la energía estelar “difícilmente puede ser otra que la energía subatómica, la cual, como se sabe, existe en abundancia en toda materia”.

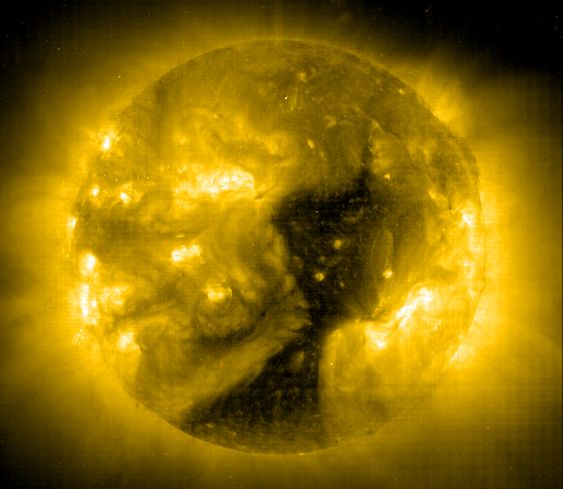

Plasma en ebullición en la superficie del Sol

Hasta el momento todo lo que hemos repasado está bien pero, ¿que pasa con la Barrera de Coulomb? Los protones están cargados positivamente; las partículasd de igual carga se repelen sí; y este obstáculo parecía demasiado grande para ser superado, aun a la elevada velocidad a la que los protones se agitaban en el intenso calor del interior de las estrellas. De acuerdo con la física clásica, muy raras veces podían dos protones de una estrella ir con la rapidez suficiente para romper las murallas de sus campos de fuerza electromagnéticos y fundirse en un solo núcleo. Los cálculos decían que la tasa de colisión de protones no podía bastar para mantener las reacciones de fusión. Sin embargo, allí estaba el Sol, con el rostro radiante, riéndose de las ecuaciones que afirmaban que no podía brillar.

Afortunadamente, en el ámbito nuclear, las reglas de la Naturaleza no se rigen por las de la mecánica de la física clásica, que tienen validez para grandes objetos, como guijarros y planetas, pero pierden esa validez en el reino de lo muy pequeño. En la escala nuclear, rigen las reglas de la indeterminación cuántica. La mecánica cuántica demuestra que el futuro del protón sólo puede predecirse en términos de probabilidades: la mayoría de las veces el protón rebotará en la Barrera de Coulomb, pero de cuando en cuando, la atravesará. Este es el “efecto túnel cuántico”; que permite brillar a las estrellas.

George Gamow, ansioso de explotar las conexiones la astronomía y la nueva física exótica a la que era adepto, aplicó las probabilidades cuánticas a la cuestión de la fusión nuclear en las estrellas y descubrió que los protones pueden superar la Barrera de Coulomb. Esta historia es mucho más extensa y nos llevaría hasta los trabajos de Hans Bethe, Edward Teller y otros, así como, al famoso Fred Hoyle y su efecto Triple Alfa y otras maravillas que, nos cuentan la historia que existe los átomos a las estrellas del cielo.

emilio silvera

Oct

29

¡La Astronomía! Esa actividad tan vieja de la Humanidad

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

La astronomía es el estudio de los cuerpos celestes , sus movimientos, los fenómenos ligados a ellos, y es, sin duda, la ciencia más antigua . Puede decirse que nació con el hombre y que está íntimamente ligada a su naturaleza de ser pensante, a su deseo de medir el tiempo, de poner orden en las cosas conocidas ( o que cree conocer ), a su necesidad de hallar una dirección, de orientarse en sus viajes, de organizar las labores agrícolas o de dominar la naturaleza y las estaciones y planificar el futuro.

Stonehenge

Los hallazgos arqueológicos más antiguos muestran sorprendentes contenidos astronómicos. Stonehenge se construyó sobre conocimientos astronómicos muy precisos. También se desprende una función astronómica de la disposición de los crómlech y monolitos bretones, los trilitos ingleses, las piedras y túmulos irlandeses, la medicine Wheel de los indios norteamericanos, o la Casa Rinconada de los indios anasazi. Es evidente la importancia astronómico-religiosa de los yacimientos mayas de Uaxactun, Copán y Caracol, de las construcciones incas de Cuzco o de Machu Picchu, así como la función exquisitamente científica de antiguos observatorios astronómicos indios, árabes o chinos.

Uaxactun

Cuanto más avanzan los estudios arqueoastronómicos más numerosas son las pruebas de los conocimientos astronómicos de nuestros antepasados y más retrocede la fecha en que estos comenzaron. El último indicio relaciona el estudio del cielo con las pinturas rupestres de Lascaux. Tanto si este descubrimiento es válido como si no, es indudable que la contemplación del cielo nocturno ha suscitado admiración, temor e interrogantes desde la noche de los tiempos ¿ Cuál es la naturaleza de los cuerpos celestes?¿ Por qué se mueven ? ¿ Cómo se mueven ? ¿ Interaccionan entre sí ? Pero,sobre todo, ¿influyen en la Tierra y en el destino de sus habitantes? ¿ Podemos prever dichos efectos y leer el futuro en el movimiento de los planetas? Todas las civilizaciones de todas las épocas han hallado sus propias respuestas a estas preguntas y a otras similares, y a menudo se ha tratado de respuestas relacionadas con complejos mitos cosmológicos.

Ruinas de Chichén ltzá

Muchos monumentos relacionados con la Astronomía se instalaron en Mesoamérica, alrededor del 3000 a. C., en las tierras altas de Guatemala, luego en las tierras bajas de Guatemala y Chiapas en México. Las ciudades más importantes del período clásico fueron Uaxactún y Tikal (aproximadamente en el 1800 a.C.). En la etapa posclásica, se destacaron las ciudades de Chichén ltzá, Mayapan o Uxamal, en la península de Yucatán.

La cultura Maya se desarrolló en una extensa área, desde el centro – sur de México hasta Guatemala y Honduras. Esta área se compone de tres diferentes regiones: las montañas o Tierras Altas, la selva tropical o Tierras Bajas y las tierras bajas del Golfo de México y península de Yucatán, cada una con recursos propios y diferenciados. La actividad de los mayas durante el Período Clásico se centró en las Tierras Altas y Bajas, cuyos centros más importantes fueron Tikal y Kaminaljuyú, respectivamente.

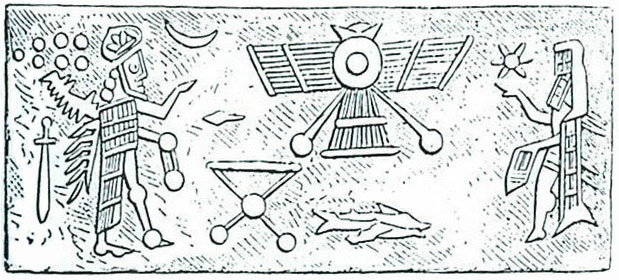

Anotaciones de astrónomos sumerios

Pero, vayamos por parte. Los primeros astrónomos fueron los sumerios, quienes dejaron constancia escrita de su historia en tablillas de arcilla. Pero no fueron los primeros que apreciaron que ciertos puntos luminosos de la bóveda celestese desplazaban con el paso del tiempo, mientras que otros permanecían fijos.

En la actualidad la distinción que hicieron entre ” estrellas fijas ” y ” estrellas errantes ” ( en griego se llamarían ” planetas ” ) puede parecer banal, pero hace 6.000 o 8.000 años este descubrimiento fue un acontecimiento muy significativo.

Distinguir a simple vista, sin la ayuda de instrumentos, un planeta de una estrella y reconocerlo cada vez que, transcurrida ciertas horas, vuelve a aparecer en el cielo no es ninguna nimiedad. Los incrédulos pueden comprobarlo: sin sabe nada de astronomía , sin ningún instrumento, bajo un cielo repleto de estrellas como esos que ya sólo se ven en lugares aislados o en mitad del mar, no es fácil distinguir Marte de Júpiter o de Saturno.

Admitamos que se consigue. Ahora, noche tras noche, hay que encontrar esa misma lucecita en movimiento, seguir su recorrido y volver a identificarla cada vez que reaparezca tras una larga ausencia. En el mejor de los casos, se necesitará mucho tiempo y paciencia antes de empezar a tomar conciencia de la orientación, y es muy probable que la mayoría no lo consiga.

A pesar de esas dificultades evidentes, todos los pueblos, por antiguos que fueran conocían muy bien los movimientos de los astros, tan regulares que espontáneamente hablaron de ” mecánica celeste ” cuando empezaron a usar las matemáticas para describirlos. Si los sumerios fueron los primeros en medir con exactitud los movimientos planetarios y en prever los eclipses de Luna organizando un calendario perfecto, los que mejor usaron la imaginación para llegar a las explicaciones teóricas que no dependieran sólo de la tecnología fueron los griegos.

En el siglo VI a.C., tras milenios en los que la obra de un dios bastaba para explicarlo todo, se empezó a buscar una lógica en el orden natural que relacionara los fenómenos. Los filósofos naturalistas fueron los pioneros en afirmar la posibilidad del hombre de comprender y describir la naturaleza usando la mente. Era, en verdad, una idea innovadora.

Los primeros ” científicos ” se reunieron en Mileto. Tales, Anaximandro y Anaxímenes hicieron observaciones astronómicas con el gnomon, siseñaron cartas naúticas, plantearon hipótesis más o menos relacionadas con los hechos observados referidas a la estructura de la Tierra, la naturaleza de los planetas y las estrellas, las leyes seguidas por los astros en sus movimientos. En Mileto, la ciencia, entendida como interpretación racional de las observaciones, dio lso primeros pasos.

Por supuesto, la mayor parte de la humanidad continuaba creyendo en dioses y espíritus ..como ahora. A pesar de que esta nueva actitud filosófica frente al mundo sólo fuera entendida durante siglos por una élite de pensadores, la investigación racional de la naturaleza ya no se detendría jamás.

En el siglo VI se constituyó la escuela pitagórica. En un ambiente de secta, Pitágoras y otros filósofos creyeron que el mundo estaba ordenado por dos principios antagónicos: lo finito ( el bien, el cosmos y el orden ) y lo infinito ( el mal, el caos y el desorden). Sus estudios matemáticos tenían un valor mágico y simbólico: Pitágoras descubrió relaciones numéricas enteras tras cada armonía formal y musical y, dado que la música es armonía de los números, la astronomía era armonía de las formas geométricas.

Incluso Aristóteles ( 384-322 a.C.), considerado en la Edad Media el máximo referente del saber, no sólo se apropió de esta idea de perfección celeste, sino que encontró una ” explicación ” de por qué ” las cosas debían ser así. La Tierra, lugar ” de lo bajo ” donde convergen tierra y agua ( dos de los cinco elementos que formaban el universo), sólo podía hallarse en el centro del Universo. El aire y el fuego quedaban ” arriba “, sus lugares naturales. El éter, el quinto elemento desconocido para los hombres , formaba los cuerpos celestes, que por naturaleza se movían en círculo, transportados por un sistema de 55 esferas concéntricas constituidas de un cristal especial, incorruptible y eterno. En torno a la Tierra inmóvil giraban la Luna, Mercurio, Venus, el Sol, Marte, Júpiter, Saturno y la última esfera de las estrellas fijas, mantenida en movimiento por el amor del ” divino motor inmóvil “. Esta última esfera es la que establecía el ritmo del sía y la noche y transmitía un movimiento uniforme y circular a todo el sistema de esferas. Según la teoría, a medida que nos aproximamos a la Tierra el movimiento se degrada y, por debajo de la esfera de la Luna, los movimientos son rectilíneos. Aquí la mezcla continua de los cuatro elementos fundamentales daba origen a todas sustancias conocidas. Era una explicación que convenció durante mucho tiempo y que armonizaba misticismo y física, mecánica celeste y fantasía.

El prestigio y la fama que Aristóteles conquistó en otros campos ( filosofía, política, economía, física, metafísica y ciencias naturales ) contribuyó al éxito de esta idea geocéntrica del universo. No cabe duda de que en el siglo IV a.C. ya se sabía que para explicar los movimientos de los astros había que utilizar al menos dos tipos de sistemas geocéntricos y un sistema heliocéntrico. Para obtener la información necesaria para gobernantes , agricultores o navegantes bastaba con poder ” prever ” los fenómenos celestes e identificar las configuraciones astrales hallando los planetas en su órbita. Las hipótesis sobre las causas de todo lo que se observaba eran investigaciones filosóficas, carentes de pruebas concretas. Así, muchos expertos lanzaron hipótesis sobre el universo, su estructura y sus mecanismos…A veces eran fantasías, pero otras fueron intuiciones correctas.

Hubo quien incluso decidió medir. Aristarco de Samos ( 310-230 a.C. ) fue el primer astrónomo genuino de la historia. No sólo sus convicciones eran lógicas y correctas , como se demostró más tarde , sino que fue el primero en usar instrumentos matemáticos para investigar el cosmos. Estaba convencido de que la Tierra giraba alrededor del Sol permanecía inmóvil en el centro de la esfera estelar y que esta también era inmóvil. Dado que no conseguía observar efectos de paralajes estelares, dedujo que las estrellas se encontraban a una distancia enorme de la Tierra. Entonces intentó medir la enormidad de dicho espacio estableciendo la distancia Tierra-Sol en función de la Tierra-Luna y, para ello, se basó en la medida de los ángulos y en simples cálculos geométricos. Descubrió que la Luna se halla a 30 diámetros terrestres de nuestro planeta y que el Sol está 19 veces más lejos ( 1.140 diámetros terrestres ). Ahora sabemos que son datos erróneos a causa de leves inexactitudes de las medidas ” a ojo “, pero esta diferencia no respeta un ápice a la importancia conceptual y filosófica del enfoque. Era la primera vez en la historia que alguien intentaba aumentar sus conocimientos sobre el Universo de forma experimental, es decir, usando la lógica, las leyes matemáticas y geométricas conocidas, observando y midiendo. Es un enfoque moderno de un complejo problema astronómico.

Aristarco de Samos (Óleo de Domenico Fetti)

Erastóstenes de Cirene ( 276-194 a.C. ) procedió de forma semejante. Con un sencillo y genial cálculo matemático halló las dimensiones de nuestro planeta: el meridiano terrestre equivale a, unos 39.400 km ( un valor sorprendentemente cercano al valor medio, establecido en 40.009 km).

Hiparlo ( 188-125 a.C.) también fue un atento e inteligente observador. Compiló un catálogo de 1.080 posiciones estelares y comparó sus observaciones con las realizadas 154 años antes por Timocaris. Así descubrió la precisión de los de equinoccios y cuantificó este lentísimo desfase de la eclíptica respecto al ecuador en unos 47 minutos al año ( un valor muy parecido al calculado hoy: 50,1 minutos).

Y si la Tierra era inmensa, el Sol debía de serlo aún más. Así, el espacio asumió dimensiones incalculables. Pocos escogidos eran capaces de asimilar y aceptar estas afirmaciones revolucionarias. Quizá por ello, después de Hiparlo no sucedió nada más durante 300 años. Resultaba más sencillo dar por válidas las teorías del gran Aristóteles.

Arquitas de Tarento perteneció a los Pitagóricos, alumno de la escuela de Filolao de Crotona. Fue amigo de Platón, al que conoció durante el primer viaje que éste realizó al sur de Italia y a Sicilia en 388/7 a. C., tras la muerte de Sócrates. En su Carta Séptima, Platón asegura que Arquitas trató de rescatarlo en sus dificultades con Dionisio II de Siracusa, mediante una carta de recomenación y enviando un barco a Sicilia en 361 a.C. Para algunos autores fue el maestro pitagórico de Platón y para otros su discípulo.

Enseñó matemáticas a Euxodo de Cnidos, siendo a su vez maestro de Menecmo. Fue la primera persona en lograr una buena aproximación al problema de laDuplicación del Cubo, y uno de los primeros que, tras Pitágoras, trabajó en el conocimiento conjunto de la Aritmética, Geometría, Astronomía y Músuca,el Quadrivium, así como de la Acústica, acotando las matemáticas a disciplinas técnicas, con la cuales se cree haya inventado la polea, el tornillo (aunque no se lo que diría Arquímedes de eso) y una especie de mecanismo articulado con alas con el que, aunque sin éxito, intentó volar. Influenció a Euclides.

Bueno, podríamos finalizar diciendo que, en el siglo VI a. C. se desarrolló al este del mediterráneo el futuro germen de la investigación científica moderna, gracias al impulso que los antiguos griegos dieron al desarrollo del pensamiento abstracto que ellos supieron recopilar, ampliar y conservar a partir de culturas y civilizaciones anteriores que ya, en aquellos tiempos remotos, sentían la necesidad de saber.

emilio silvera

Oct

22

Recordemos la Misión Cassini Huygens

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (13)

Comments (13)

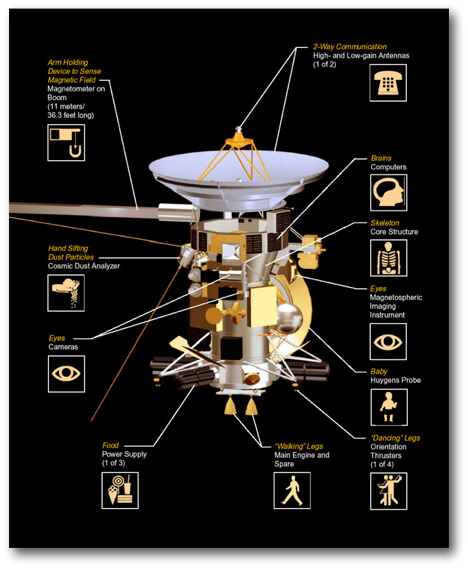

La misión Cassini servirá (ha servido) para responder a preguntas fundamentales sobre la evolución de los planetas a través de un amplio estudio de Saturno, su famoso sistema de anillos, su magnetosfera, de Titán y otras lunas heladas.

El sistema de Saturno representa un laboratorio sin igual en donde los científicos pueden buscar respuestas a muchas de las preguntas fundamentales sobre la física, química y evolución de los planetas, así como las condiciones en las que tuvo lugar el nacimiento de la vida.

Diseño de la misión Cassini-Huygens-Crédito: ESA

Saturno puede contener una buena parte de la nube de gases primordiales no atrapados por el Sol. Con 31 lunas conocidas y un sistema de anillos que apenas podría caber entre la Tierra y la Luna, Saturno puede considerarse el equivalente a un sistema solar en miniatura. Se piensa que su mayor satélite natural, Titán, puede poseer compuestos orgánicos, los cuales podrían ser importantes para la química que dio lugar a la vida en la Tierra. Aunque es muy fría para poder albergar la vida, Titán puede ser un congelador que nos muestre cómo la Tierra podría haber sido en el pasado.

Oct

15

¡La Física! Siempre nos sorprende

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (2)

Comments (2)

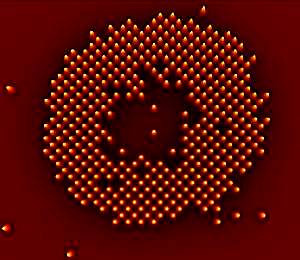

Las veloces computadoras cuánticas hechas con átomos atrapados por haces de luz pueden estar un poco más cerca, gracias a las primeras imágenes de átomos individuales obtenidas en una de estas grillas.

La velocidad de las computadoras cuánticas tiene que ver con el hecho de que sus componentes pueden ocupar una serie de estados en lugar de sólo dos como ocurre en una computadora binaria. Ciertos algoritmos especiales podrían explotar estos estados cuánticos para resolver problemas que derrotarían a una computadora convencional.

Una candidata a computadora de este tipo es la llamada “rejilla óptica”, en la que haces de rayos láser estratégicamente ubicados hacen que los átomos ultrafríos se coloquen en forma de grilla, como si fueran huevos en su envase de cartón. Pero antes de que uno pudiera leer o escribir sobre estos átomos, algo indispensable si la rejilla fuera a actuar como una computadora cuántica, haría falta determinar las posiciones exactas de los mismos.

Ahora dos equipos de investigadores, uno conducido por Stefan Kuhr del Instituto Max Planck de Óptica Cuántica de Garching, Alemania, y el otro por Markus Greiner de la Universidad de Harvard, han dado el primer paso al obtener imágenes de átomos individuales de rubidio en una rejilla óptica. Este es un reto no sólo porque los átomos son pequeños, sino también porque los fotones de los átomos cercanos pueden interferir unos con otros, enturbiando cualquier patrón.

Para superar esto, los equipos estudiaron el patrón de luz de un solo átomo. Luego crearon un algoritmo capaz de generar una combinación de este patrón a partir de diferentes disposiciones de una grilla de átomos. Cotejando estas simulaciones con el modelo real observado, el algoritmo podía determinar cuál era la distribución de los átomos.

Cada átomo en la grilla actúa como un bit cuántico. Kuhr dice que la rejilla óptica tiene muchos más de estos “qubits” que otros sistemas enfocados en la computación cuántica, por lo que puede ofrecer mayor velocidad.

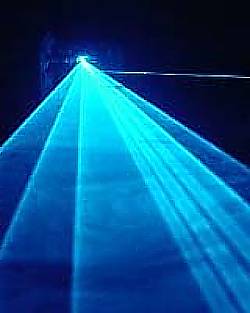

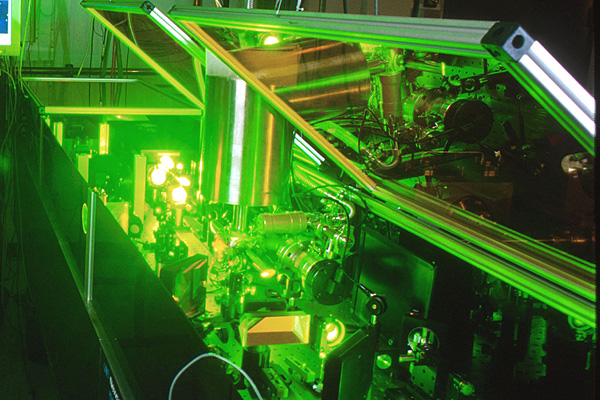

Los láseres pueden volver reales las partículas virtuales. Los láseres de última generación tienen el poder de crear materia por medio de la captura de partículas fantasmales que, de acuerdo a la mecánica cuántica, permean el espacio aparentemente vacío

El principio de incertidumbre de la mecánica cuántica implica que el espacio nunca puede estar realmente vacío. En cambio, las fluctuaciones aleatorias causan el nacimiento de un caldero hirviente de partículas, como electrones y sus homólogos de antimateria, los positrones.

Las llamadas “partículas virtuales” normalmente se aniquilan entre sí demasiado rápido para que las veamos. Pero los físicos predijeron en los años 30 que un campo eléctrico muy fuerte transformaría las partículas virtuales en reales, y entonces las podríamos observar. El campo las impulsa en direcciones opuestas, porque tienen cargas eléctricas que se oponen, y las separándolos de modo que no puede destruirse mutuamente.

Los láseres son ideales para esta tarea, porque su luz posee campos eléctricos fuertes. En 1997, los físicos del Stanford Linear Accelerator Center (SLAC), en Menlo Park, California, utilizaron luz láser para crear unas pocas parejas de electrón-positrón. Ahora, nuevos cálculos indican que los láser de nueva generación serán capaces de crear pares por millones.

Reacción en cadena

En el experimento de SLAC, sólo se creó un par electrón-positrón a la vez. Pero con los láseres más potentes, es probable que se produzca una reacción en cadena.

El primer par es acelerado a gran velocidad por el láser, haciendo que emita luz. Esta luz, junto con la del láser, genera aún más pares, dice Alexander Fedotov de la Dirección Nacional de Investigaciones Nucleares de la Universidad de Moscú y sus colegas en un estudio que aparecerá en Physical Review Letters.

“Surgirá una gran cantidad de partículas del vacío”, dice John Kirk del Instituto Max Planck de Física Nuclear en Heidelberg, Alemania, que no participó en el estudio.

En los láseres que pueden concentrar cerca de 1026 vatios en un centímetro cuadrado, esta reacción desatada debería convertir de manera eficiente la luz del láser en millones de pares de electrones positrones, calcula el equipo.

Fábrica de antimateria

Ese nivel de intensidad lo podría alcanzar un láser que será construido por el proyecto Extreme Light Infrastructure en Europa. La primera versión del láser se podría construir en 2015, pero podría llevar un año más completar las actualizaciones necesarias para llegar a 1026 vatios por centímetro cuadrado, dice el coautor del estudio Georg Korn del Instituto Max Planck de Óptica Cuántica en Garching , Alemania.

La capacidad de generar una gran cantidad de positrones podría ser útil para los colisionadores de partículas, como el propuesto del Colisionador Lineal Internacional, que impactará electrones y positrones, dice Kirk McDonald de la Universidad de Princeton en Nueva Jersey.

Pero Pisin Chen, de la Universidad Nacional de Taiwan en Taipei, dice que el costo de los poderosos láseres puede hacer que este método sea más caro que el alternativo. En la actualidad, la manera estándar de crear una gran cantidad de positrones es disparar un haz de electrones de alta energía a una pieza de metal, para producir pares electrón-positrón.

La materia supera a la antimateria en un experimento que imita a la creación

El desequilibrio en el acelerador de partículas de Illinois podría presagiar grandes avances en Física

Menos de una billonésima de segundo después del Big Bang ocurrió otro evento tumultuoso. Aunque el Cosmos nació con partes iguales de materia y antimateria, que se destruyeron una a la otra al entrar en contacto, de alguna forma la materia comenzó a predominar. Los físicos han descubierto una nueva pista sobre la causa de este desequilibrio fortuito, que condujo a la existencia de galaxias, planetas y personas.

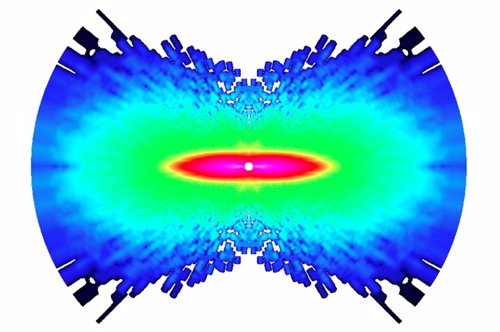

Circunferencia de 4 kilómetros de diámetro del Acelerador de Partículas del Laboratorio Fermi de Chicago

El nuevo hallazgo se basa en ocho años de estudio de la desintegración de partículas de vida corta, llamadas mesones B, que se produce durante las colisiones de alta energía en el acelerador de partículas Tevatrón del Laboratorio Fermi (Fermilab), ubicado en Batavia, Illinois. Los científicos del experimento DZero del Tevatrón han descubierto que los mesones B, cuando se desintegran, producen cerca del 1 % más de pares de muones (una versión pesada del electrón) que de pares de sus antipartículas, los antimuones. Los físicos se refieren a este fenómeno como una violación CP.

El desequilibrio, reportado el 14 de mayo en un seminario del Fermilab y publicado en Internet el 18 de mayo, podría servir para entender cómo fue que la materia superó a la antimateria en el Universo. También aumenta las posibilidades de que el hadrones” target=”_blank”>Gran Colisionador de Hadrones, el acelerador de Suiza que sustituyó al Tevatrón como el colisionador de partículas más poderoso del mundo, encuentre nuevas partículas elementales o una nueva física.

“Aunque pequeño, este excedente del 1 % es 50 veces más grande que la asimetría entre materia y antimateria prevista para la desintegración de mesones B por el modelo estándar de la Física de Partículas”, señala el portavoz del DZero, Stefan Söldner-Rembold, de la Universidad de Manchester en Inglaterra.

“Se nos puso la piel de gallina”, cuenta Söldner-Rembold acerca del momento en el que él y los 500 colaboradores del DZero comprendieron lo que habían descubierto. “Estábamos muy contentos porque significa que hay una nueva Física más allá del modelo estándar que tiene que estar a nuestro alcance para que la asimetría sea tan grande”.

“Aunque hay una probabilidad de menos del 0,1 % de que los resultados del DZero sean una casualidad, de acuerdo con las normas de la Física de Partículas hay que considerarlos como indicios aún por confirmar”, advierte el teórico Yuval Grossman de la Universidad de Cornell. Söldner-Rembold señala que los hallazgos del DZero son similares a una asimetría en la producción de materia-antimateria descubierta hace un año por otro experimento llevado a cabo en el Tevatrón, el CDF, pero los nuevos resultados tienen una precisión mayor.

“Las teorías que podrían explicar las observaciones del DZero incluyen la supersimetría, que supone que cada partícula elemental en el modelo estándar de la Física de Partículas tiene una superpareja más pesada todavía por descubrir”, explica la teórica del Fermilab Marcela Carena, que no pertenece al equipo descubridor. “Otras teorías posibles incluyen un modelo en el que la gravedad y otras fuerzas operan en otras dimensiones ocultas, y la noción de que hay una cuarta familia de quarks más allá de las tres generaciones (arriba y abajo, encanto y extraño, y cima y fondo) que sirven como bloques de construcción de los núcleos atómicos y otras partículas.

“En los modelos que consideran una cuarta familia de quarks, la presencia de quarks nuevos y pesados y su interacción con las tres familias conocidas podrían dar lugar a un desequilibrio mayor entre materia y antimateria que el que se encuentra en el modelo estándar”, señala Carena. Y agrega: “En la teoría de la supersimetría, las superparejas pesadas jugarían un rol similar al de los quarks pesados, creando interacciones que podrían favorecer la producción de materia sobre la antimateria”.

No siempre la física lo puede explicar todo. Sin embargo… ¡Lo va consiguiendo!

En la teoría de las dimensiones extra, nuevas partículas mensajeras (portadoras de fuerzas previamente desconocidas) se moverían en dimensiones ocultas. Estas partículas transportadoras podrían alterar la carga y otra propiedad, llamada “sabor”, de las partículas elementales, causando el desequilibrio adicional entre materia y antimateria.

Carena añade: “Sin embargo, es difícil encontrar una teoría que pueda explicar esta asimetría sin contradecir otros resultados experimentales”.

La materia superó a la antimateria en el comienzo

Ulrich Nierste, de la Universidad de Karlsruhe en Alemania, advierte: “La conexión del resultado del DZero con el excedente de materia que existe en el Universo es vaga. Si bien el hallazgo insinúa una nueva fuente de asimetría en las propiedades del mesón B y de su antipartícula, el proceso que creó más partículas que antipartículas en el Universo primitivo podría involucrar un mecanismo físico muy diferente”.

“Sin embargo”, dice Carena, “hace falta alguna nueva fuente de asimetría para explicar el desequilibrio que hay entre la materia y la antimateria en el Universo, y, por lo tanto, nuestra existencia”. En cualquiera de los modelos propuestos “el Gran Colisionador de Hadrones debería ser la ventana directa para observar nuevas partículas”.

Uno de los experimentos más pequeños del Colisionador, diseñado para estudiar los mesones B, podría confirmar los hallazgos del DZero dentro de uno o dos años”, dice Yuval Grossman. Y agrega: “Los experimentos más grandes podrían entonces buscar nuevas partículas que serían el origen del desequilibrio cósmico entre materia y antimateria y determinar sus masas”.

El experimento Beauty (Belleza) es la matriz de investigación para la creación de antimateria. El choque de dos protones contra otro a la velocidad de la luz, ha tenido como resultado una partícula con 5 veces más masa que sus protones originales. A esa exótica partícula se le ha llamado B+ y está compuesta por un quark b-anti y un quark u. La partícula B+ se desintegra a una altísima velocidad pero le da tiempo a recorrer ¡¡2 mm!! antes de desintegrarse en dos partículas, el mesón J / ? y el Kaon K+. Esta distancia, comparada con los minúsculos tamaños que estamos tratando, es una auténtica pasada. Hemos tenido antimateria pura moviéndose a lo largo de dos extensos milímetros de “nuestro” espacio. Impresionante.

Lo revolucionario sin embargo es que de esta forma, los investigadores habrían demostrado la teoría de Albert Einstein. “Sí, podemos crear masa a partir de energía usando la famosa fórmula de Einstein, E=mc2, dicen los responsables del CERN. Aunque también hay que destacar que la confirmación de que existe la antimateria plantea muchas preguntas de difícil resolución puesto que esa sustancia no existe en nuestro universo. “Ya que la desaparición de antimateria primordial no puede ser explicada por el modelo tradicional, tendremos que comenzar a pensar en algo nuevo”, afirman los investigadores. “Los científicos están evaluando diferentes posibilidades pero, dado que sólo podemos observar un 4% de la energía y materia total del universo, podemos inferir que la respuesta al misterio de la antimateria se encuentra en la parte desconocida del mismo”, concluyen.

Como podéis ver, las preguntas son muchas y, las respuestas, son más escasas. Sin embargo, no dejamos de insistir y buscar con todos medios a nuestro alcance para saber sobre la Naturaleza no ya de la materia y la antimateria, sino sobre los muchos enigmas que tenemos planteados y a los que no sabemos dar una adecuada explicación. Parece que a lo lejos vemos una luz cegadora que nos inyecta la esperanza necesaria para seguir la búsqueda y tratar de llegar al corazón de todos esos secretos que el Universo esconde.

Hay cosas que… más que sorprendentes son… ¡Inclreibles! He leído por ahí que…

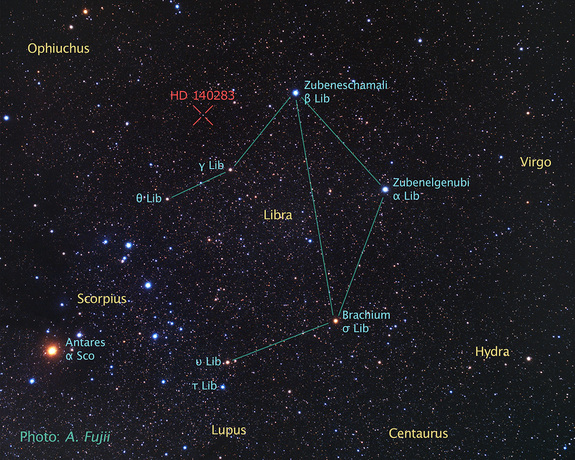

“Un grupo de astrónomos, usando datos del telescopio espacial Hubble, ha determinado la edad de la que es la estrella más vieja cuya edad puede medirse con precisión. El resultado ha sido que la edad de la estrella es de 14.500 ± 800 millones de años, mayor que la estimación de la edad del universo, unos 13.800 millones de años. La estrella en cuestión (HD 140283), también llamada “estrella Matusalén,” una gigante roja que se encuentra a una distancia de 190,1 años luz en la constelación de Libra (distancia medida con precisión mediante la técnica de paralaje). En el año 2000 se dató su edad en 16.000 millones de años. Sin embargo, existen algunas cuestiones que podrían aclarar la extrema edad de esta estrella. Nuevos modelos sobre la difusión de helio en el núcleo indican que la penetración del mismo podría ser mayor de la que se piensa, lo que provocaría un menor ritmo de combustión. También la relación oxígeno-hierro en esta estrella es anómala, demasiado grande, por lo que se cree que futuras observaciones que puedan determinar con mayor grado de precisión la abundancia de oxígeno podrían reducir nuevamente la estimación de la edad de la estrella.”

Oct

5

¡La Vida! ¿En cuántos planetas estará instalada?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica, El Universo y la Vida ~

Clasificado en Astronomía y Astrofísica, El Universo y la Vida ~

Comments (29)

Comments (29)

Si lo normal es que, cada estrella esté acompañada de algunos planetas formando sistemas planetarios como el nuestro. Si entre la préyade de planetas y lunas de esos sistemas, todo se comporta como ordenan las leyes de la Naturaleza. Si como es de esperar, algún que otro planeta o, incluso luna, pueden estar situados emn la zona habitable. Si todo eso es posible (que lo es), ¿qué puede impedir que la vida prolifere por todo el Univero?

El astrónomo estadounidense Frank Drake apuntó en 1960 un telescopio en el condado de Pocahontas hacia las estrellas Tau Ceti y Épsilon Eridani en busca de señales de radio de otros mundos. ¡Era tanta la ilusión volcada en aquel proyecto! y, sin embargo, nada se pudo aclarar…aunque, el ániomo no decayó nunca.

Tau Ceti, en la Constelación de la Ballena (Cetus), es una estrella muy parecida a nuestro Sol. Tiene una clase espectral G8 -la del Sol es G2- y un tamaño ligeramente inferior. Después de Alfa Centauri A es una de las estrellas que más se parecen al Sol y, algunos, como Carl Sagan y Shklovskii, abogaban por el hecho de que albergaban planetas con las condiciones aptas para la vida. Si tiene algún planeta situado a la distancia adecuada, como lo está la Tierra del Sol, pudiera haberse desarrollado un escenario natural propicio para la existencia de seres vivos.

Totales: 85.291.989

Totales: 85.291.989 Conectados: 122

Conectados: 122