Nov

17

¿La masa perdida? ¿O no entendemos nada?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

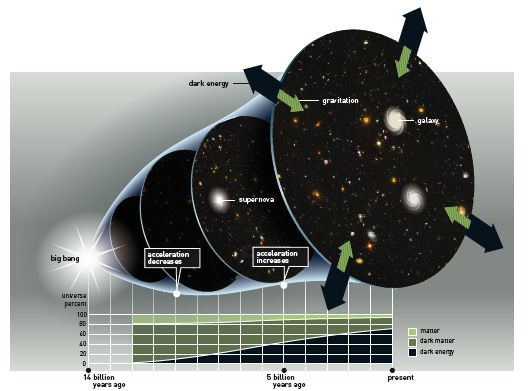

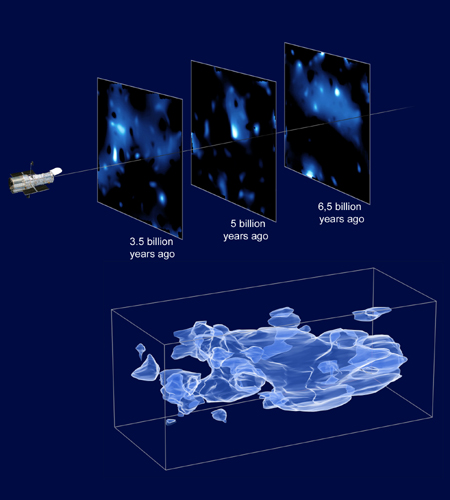

Recreación artística del WHIM en la Pared del Escultor. Fuente: NASA.

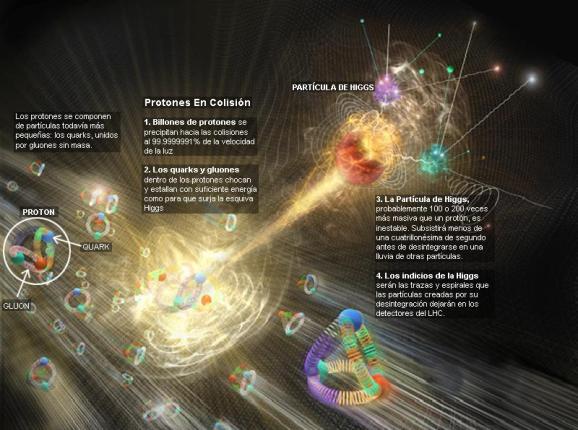

La idea de la masa perdida se introdujo porque la densidad observada de la materia en el universo está cerca del valor crítico (10-29 g/cm3). Sin embargo, hasta comienzo de los ochenta, no hubo una razón teórica firme para suponer que el universo tenía efectivamente la masa crítica. En 1981, Alan Guth, publicó la primera versión de una teoría que desde entonces se ha conocido como “universo inflacionista”. desde entonces la teoría ha sufrido cierto número de modificaciones técnicas, pero los puntos centrales no han cambiado. Lo cierto es que la idea del universo inflacionista, estableció por primera vez una fuerte presunción de que la masa del universo tenía realmente el valor crítico.

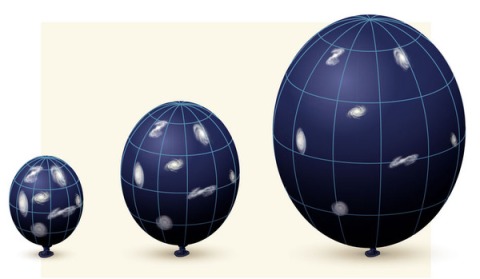

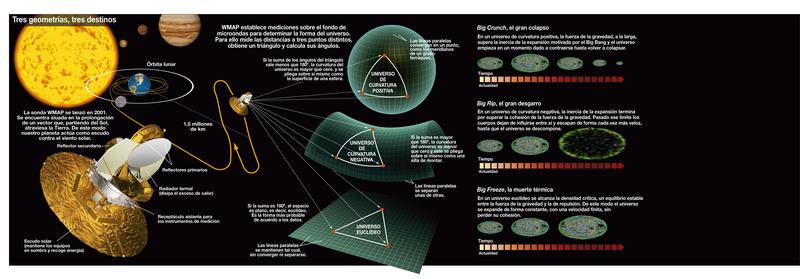

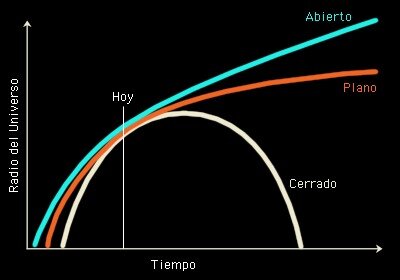

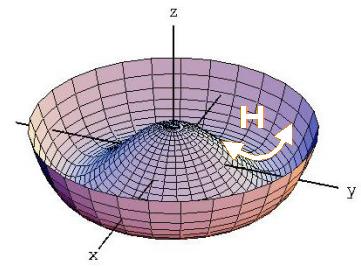

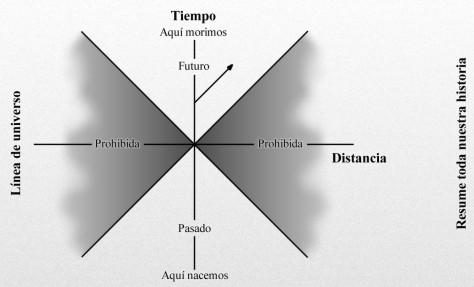

Diagrama de las tres posibles geometrías del universo: cerrado, abierto y plano, correspondiendo a valores del parámetro de densidad Ω0 mayores que, menores que o iguales a 1 respectivamente. En el universo cerrado si se viaja en línea recta se llega al mismo punto, en los otros dos no. ( Ω es lo que los cosmólogos llaman el Omega Negro, es decir, la cantidad de materia que hay en el Universo).

La predicción de Guht viene de las teorías que describen la congelación de la fuerza fuerte en el segundo 10-35 del Big Bang. Entre los muchos otros procesos en marcha en ese tiempo estaba una rápida expansión del universo, un proceso que vino a ser conocido como inflación. Es la presencia de la inflación la que nos lleva a la predicción de que el universo tiene que ser plano.

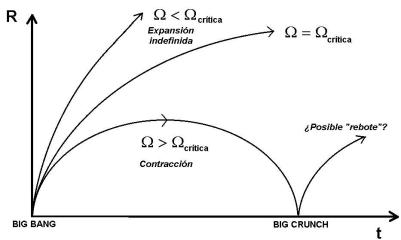

Se ha tratado de medir la Densidad Crítica del Universo par apoder saber en qué calse de universo estamos y, parece que es plano

Universo cerrado

Si Ω>1, entonces la geometría del espacio sería cerrada como la superficie de una esfera. La suma de los ángulos de un triángulo exceden 180 grados y no habría líneas paralelas. Al final, todas las líneas se encontrarían. La geometría del universo es, al menos en una escala muy grande, elíptico.

En un universo cerrado carente del efecto repulsivo de la energía oscura, la gravedad acabará por detener la expansión del universo, después de lo que empezará a contraerse hasta que toda la materia en el universo se colapse en un punto. Entonces existirá una singularidad final llamada el Big Crunch, por analogía con el Big Bang. Sin embargo, si el universo tiene una gran suma de energía oscura (como sugieren los hallazgos recientes), entonces la expansión será grande.

Universo abierto

Si Ω<1, la geometría del espacio es abierta, p.ej., negativamente curvada como la superficie de una silla de montar. Los ángulos de un triángulo suman menos de 180 grados (llamada primera fase) y las líneas paralelas no se encuentran nunca equidistantes, tienen un punto de menor distancia y otro de mayor. La geometría del universo sería hiperbólica.

Incluso sin energía oscura, un universo negativamente curvado se expandirá para siempre, con la gravedad apenas ralentizando la tasa de expansión. Con energía oscura, la expansión no sólo continúa sino que se acelera. El destino final de un universo abierto es, o la muerte térmica” o “Big Freeze” o “Big Rip”, dónde la aceleración causada por la energía oscura terminará siendo tan fuerte que aplastará completamente los efectos de las fuerzas gravitacionales, electromagnéticas y los enlaces débiles.

Universo plano

Si la densidad media del universo es exactamente igual a la densidad crítica tal que Ω=1, entonces la geometría del universo es plana: como en la geometría ecuclidiana, la suma de los ángulos de un triángulo es 180 grados y las líneas paralelas nunca se encuentran.

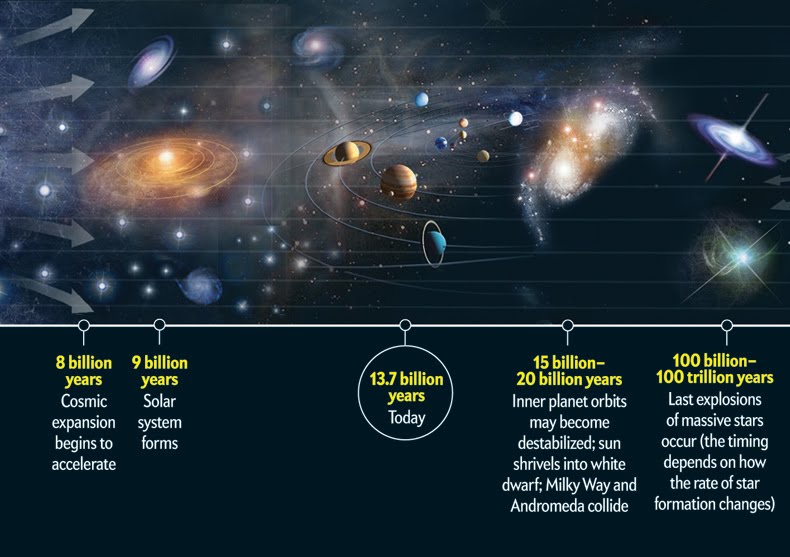

Sin energía oscura, un universo plano se expande para siempre pero a una tasa continuamente desacelerada: la tasa de expansión se aproxima asintóticamentre a cero. Con energía oscura, la tasa de expansión del universo es inicialmente baja, debido al efecto de la gravedad, pero finalmente se incrementa. El destino final del universo es el mismo que en un universo abierto, la muerte caliente del universo, el “Big Freeze” o el “Big Rip”. En 2005, se propuso la teoría del destino del universo Fermión-Bosón, proponiendo que gran parte del universo estaría finalmente ocupada por condensado de Bose-Einstein y la quasipartícula análoga al fermión, tal vez resultando una implosión. Muchos datos astrofísicos hasta la fecha son consistentes con un universo plano.

La teoría del Big Crunch es un punto de vista simétrico del destino final del Universo. Justo con el Big Bang empezó una expansión cosmológica, esta teoría postula que la densidad media del Universo es suficiente para parar su expansión y empezar la contracción. De ser así, se vería cómo las estrellas tienden a ultravioleta, por efecto Doppler. El resultado final es desconocido; una simple extrapolación sería que toda la materia y el espacio-tiempo en el Universo se colapsaría en una singularidad espaciotemporal adimensional, pero a estas escalas se desconocen los efectos cuánticos necesarios para ser considerados -se aconseja mirar en Gravedad-Cuántica-..

Este escenario permite que el Big Bang esté precedido inmediatamente por el Big Crunch de un Universo precedente. Si esto ocurre repetidamente, se tiene un universo oscilante. El Universo podría consistir en una secuencia infinita de Universos finitos, cada Universo finito terminando con un Big Crunch que es también el Big Bang del siguiente Universo. Teóricamente, el Universo oscilante no podría reconciliarse con la segunda ley de la termodinámica:

la entropía aumentaría de oscilación en oscilación y causaría la muerte caliente. Otras medidas sugieren que el Universo no es cerrado. Estos argumentos indujeron a los cosmólogos a abandonar el modelo del Universo oscilante. Una idea similar es adoptada por el modelo cíclico, pero esta idea evade la muerte caliente porque de una expansión de branas se diluye la entropía acumulada en el ciclo anterior.

Como podéis comprobar por todo lo anteriormente leído, siempre estamos tratando de saber en qué universo estamos y pretendemos explicar lo que pudo pasar desde aquel primer momento que no hemos podido comprender de manera exacta y científicamente autosuficiente para que sea una ley inamovible del nacimiento del universo. Simplemente hemos creado modelos que se acercan de la mejor manera a lo que pudo ser y a lo que podría ser.

Nov

16

Hay que recorrer un largo camino para saber

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (1)

Comments (1)

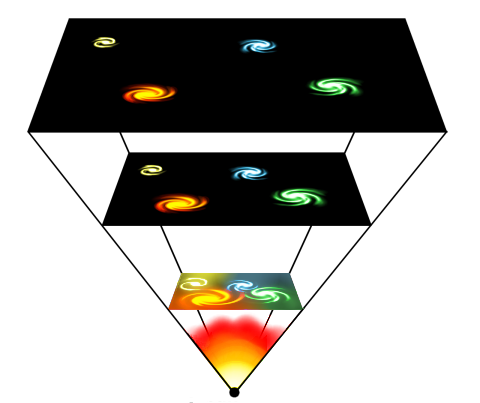

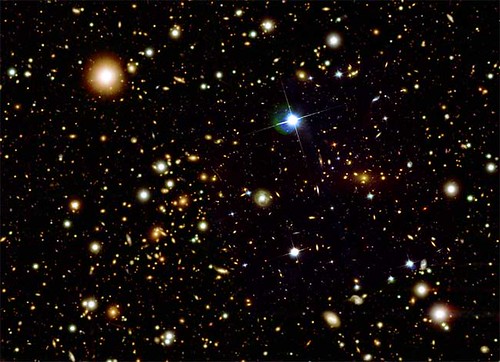

El Universo: Cometa lleno de Galaxias

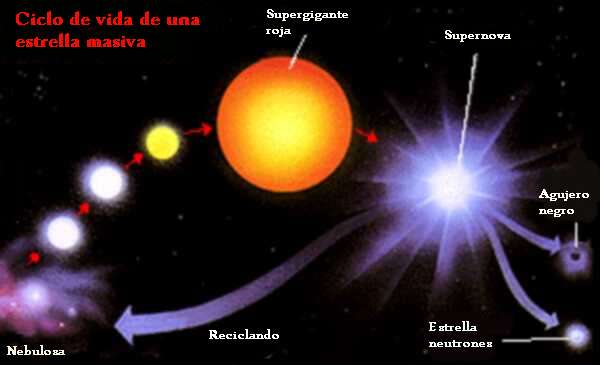

“La masa con la que nace una estrella determina su historia y, sobre todo, la duración de su vida. Llamamos estrellas masivas a todas aquellas estrellas aisladas que explotan como supernovas al final de su existencia debido al colapso gravitatorio. Para que exploten como supernovas deben tener un mínimo de alrededor de ocho masas solares. Estrellas con menos masa pueden explotar, pero no por sí mismas (deben darse otras condiciones). Y hay parámetros secundarios que pueden introducir cambios, pero la masa es determinante.”

“En cuanto al máximo, el límite está en lo que la naturaleza sea capaz de producir. Hasta hace poco se creía que este límite estaba en torno a monstruos de 150 masas solares, aunque recientes trabajos lo elevan hasta 300. No obstante, no es un dato seguro ya que, cuanto más masiva es una estrella, menos vive, con lo cual estrellas más grandes serían difíciles de observar.”

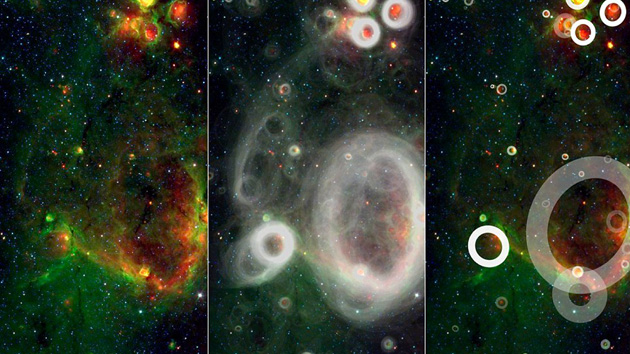

Verdaderamente si pudiéramos contemplar de cerca, el comportamiento de una estrella cuando llega el final de su vida, veríamos como es, especialmente intrigante las transiciones de fase de una estrella en implosión observada desde un sistema de referencia externo estático, es decir, vista por observadores exteriores a la estrella que permanecen siempre en la misma circunferencia fija en lugar de moverse hacia adentro con la materia de la estrella en implosión. La estrella, vista desde un sistema externo estático, empieza su implosión en la forma en que uno esperaría. Al igual que una pesada piedra arrojada desde las alturas, la superficie de la estrella cae hacia abajo (se contrae hacia adentro), lentamente al principio y luego cada vez más rápidamente. Si las leyes de gravedad de Newton hubieran sido correctas, esta aceleración de la implosión continuaría inexorablemente hasta que la estrella, libre de cualquier presión interna, fuera aplastada en un punto de alta velocidad. Pero no era así según las fórmulas relativistas que aplicaron Oppenheimer y Snyder. En lugar de ello, a medida que la estrella se acerca a su circunferencia crítica su contracción se frena hasta hacerse a paso lento. Cuanto más pequeña se hace la estrella, más lentamente implosiona, hasta que se congela exactamente en la circunferencia crítica y, dependiendo de su masa, explosiona como supernova para formar una inmensa nebulosa o, se tranforma en nebulosa planetaria, más pequeña.

Ahí podemos observar a una estrella muy joven, de dos o tres millones de años que, en un futuro lejano será una gran Supernova. Los procesos que podríamos observar al final de la vida de una estrella gigante… ¡Son fascinantes!

En la escena que antes explicabámos, por mucho tiempo que nos quedemos esperando y comtemplando el suceso, si uno está en reposo fuera de la estrella (es decir, en reposo en el sistema de referencia externo estático), uno nunca podrá ver que la estrella implosiona a través de la circunferencia crítica. Ese fue el mensaje inequívoco que Oppenheimer y Snyder nos enviaron. Para poder ver eso, habría que estar dentro de la estrella, instalado en la materia que está sufriendo la contracción y, no sabemos porque eso es así.

¿Se debe esta congelación de la implosión a alguna fuerza inesperada de la relatividad general en el interior de la estrella? No, en absoluto, advirtieron Oppenheimer y Snyder. Más bien se debe a la dilatación gravitatoria del tiempo (el frenado del flujo del tiempo) cerca de la circunferencia crítica. Tal como lo ven los observadores estáticos, el tiempo en la superficie de la estrella en implosión debe fluir cada vez más lentamente cuando la estrella se aproxima a la circunferencia crítica; y, consiguientemente, cualquier cosa que ocurre sobre o en el interior de la estrella, incluyendo su implosión, debe aparecer como si el movimiento se frenara poco a poco hasta congelarse.

Por extraño que esto pueda parecer, aún había otra predicción más extrañas de las fórmulas de Oppenheimer y Snyder: si bien es cierto que vista por observadores externos estáticos la implosión se congela en la circunferencia crítica, no se congela en absoluto vista por los observadores que se mueven hacia adentro con la superficie de la estrella. Si la estrella tiene una masa de algunas masas solares y empieza con un tamaño aproximado al del Sol, entonces vista desde su propia superficie implosiona hacia la circunferencia crítica en aproximadamente una hora, y luego sigue implosionando más allá de la criticalidad hacia circunferencias más pequeñas.

Allá por el año 1939, cuando Oppenheimer y Snyder descubrieron estas cosas, los físicos ya se habían acostumbrados al hecho de que el tiempo es relativo; el flujo del tiempo es diferente medido en diferentes sistemas de referencia que se mueven de diferentes formas a través del Universo. Claro que, nunca antes había encontrado nadie una diferencia tan extrema entre sistemas de referencia. Que la implosión se congele para siempre medida en el sistema externo estático, pero continúe avanzando rápidamente superando al punto de congelación medida en el sistema desde la superficie de la estrella era extraordinariamente difícil de comprender. Nadie que estudiara las matemáticas de Oppenheimer y Snyder se sentía cómodo con semejante distorsión extrema del tiempo. Pero ahí estaba, en sus fórmulas. Algunos podían agitar sus brazos con explicaciones heurísticas, pero ninguna explicación parecía muy satisfactoria. No sería completamente entendido hasta finales de los cincuenta.

Fue Wheeler el que discrepó del trabajo de Oppenheimer y Snyder, alegando, con toda la razón que, cuando ellos habían realizado su trabajo, habría sido imposible calcular los detalles de la implosión con una presión realista (presión térmica, presión de degeneración y presión producida por la fuerza nuclear), y con reacciones nucleares, ondas de choque, calor, radiación y expulsión de masa. Sin embargo, los trabajos desde las armas nucleares de los veinte años posteriores proporcionaron justamente las herramientas necesarias.

Presión, reacciones nucleares, ondas de choque, calor radiación y expulsión de masa eran todas ellas características fundamentales de una bomba de hidrógeno; sin ellas, una bomba no explosionaría. A finales de los años cincuenta, Stirling Colgate quedó fascinado por el problema de la implosión estelar. Con el apoyo de Edward Teller, y en colaboración con Richard White y posteriormente Michael May, Colgate se propuso simular semejante implosión en un ordenador. Sin embargo, cometieron un error, mantuvieron algunas de las simplificaciones de Oppenheimer al insistir desde el principio en que la estrella fuera esférica y sin rotación, y, aunque tuvieron en cuenta todos los argumentos que preocupaban a Wheeler, aquello no quedó perfeccionado hasta después de varios años de esfuerzo y, a comienzo de los años sesenta ya estaban funcionando correctamente.

Un día a principio de los años sesenta, John Wheeler entró corriendo en la clase de relatividad de la Universidad de Princeton. Llegaba un poco tarde, pero sonreía con placer. Acababa de regresar de una visita a Livermore donde había visto los resultados de las simulaciones recientes de Colgate y su equipo. Con excitación en su voz dibujó en la pizarra un diagrama tras otro explicando lo que sus amigos de Livermore habían aprendido.

Cuando la estrella en implosión tenía una masa pequeña, desencadenaba una implosión de supernova y formaba una estrella de neutrones precisamente en la forma que Fritz Wicky había especulado treinta años antes. Sin embargo, si la estrella original era más masiva lo que allí se producía (aparte de la explosión supernova) era un agujero negro notablemente similar al altamente simplificado modelo que veinticinco años calcularon Oppenheimer y Snyder. Vista desde fuera, la implosión se frenaba y se quedaba congelada en la circunferencia crítica, pero vista por alguien en la superficie de la estrella, la implosión no se congelaba en absoluto. La superficie de la estrella se contraía a través de la circunferencia crítica y seguía hacia adentro sin vacilación.

Lo cierto fue que allí, por primera vez, se consiguió simular por ordenador la implosión que debía producir agujeros negros. Está claro que la historia de todo esto es mucho más larga y contiene muchos más detalles que me he saltado para no hacer largo el trabajo que, en realidad, sólo persigue explicar a ustedes de la manera más simple posible, el trabajo que cuesta obtener los conocimientos que no llegan (casi nunca) a través de ideas luminosas, sino que, son el resultado del trabajo de muchos.

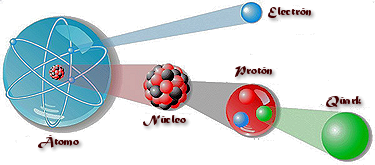

Hoy, sabemos mucho más de cómo finaliza sus días una estrella y, dependiendo de su masa, podemos decir de manera precisa que clase de Nebulosa formará, que clase de explosión (si la hay) se producirá, y, finalmente, si el resultado de todo ello será una estrella enana blanca que encuentra su estabilidad final por medio del Principio de exclusión de Pauli (en mecánica cuántica)que se aplica a los fermiones pero no a los Bosones (son fermiones los quarks, electrones, protones y neutrones), en virtud del cual dos partículas idénticas en un sistema, como los electrones en un átomo o quarks en un hadrón (protón o neutrón, por ejemplo), no pueden poseer un conjunto idéntico de números cuánticos.

La estrella azul cerca del centro de esta imagen es Zeta Ophiuchi. Cuando se ve en luz visible aparece como una estrella roja relativamente débil rodeada de otras estrellas tenues y sin polvo. Sin embargo, en esta imagen infrarroja tomada con campo amplio por el Explorador Infrared Survey de la NASA, o WISE, un punto de vista completamente diferente emerge. Zeta Ophiuchi es en realidad una muy masiva y caliente estrella azul, brillante que traza su camino a través de una gran nube de polvo y gas interestelar.

Una estrella masiva alejándose de su antiguo compañero se manifiesta haciendo un imponente surco a través de polvo espacial, como si se tratase de la proa de un barco. La estrella, llamada Zeta Ophiuchi, es enorme, con una masa de cerca de 20 veces la de nuestro Sol. En esta imagen, en los que se ha traducido la luz infrarroja a colores visibles que vemos con nuestros ojos, la estrella aparece como el punto azul en el interior del arco de choque. Zeta Ophiuchi orbitó una vez alrededor de una estrella aún más grande. Pero cuando la estrella explotó en una supernova, Zeta Ophiuchi se disparó como una bala. Viaja a la friolera velocidad de 24 kilómetros por segundo arrastrando con ella un conglomerado de polvo que distorsiona la región por la que pasa.

Mientras la estrella se mueve través del espacio, sus poderosos vientos empujan el gas y el polvo a lo largo de su camino en lo que se llama un arco de choque. El material en el arco de choque está tan comprimido que brilla con luz infrarroja que WISE puede captar. El efecto es similar a lo que ocurre cuando un barco cobra velocidad a través del agua, impulsando una ola delante de él. Esta onda de choque queda completamente oculta a la luz visible. Las imágenes infrarrojas como esta son importantes para arrojar nueva luz sobre lo que ocurre en situaciones similares.

Pero, siguiendo con el tema de las implosiones de las estrellas, ¿cuál es la razón por la que la materia no se colapsa, totalmente, sobre sí misma? El mismo principio que impide que las estrellas de neutrones y las estrellas enanas blancas implosionen totalmente y que, llegado un momento, en las primeras se degeneran los neutrones y en las segundas los electrones, y, de esa manera, se frena la compresión que producía la gravedad y quedan estabilizadas gracias a un principio natural que hace que la materia normal sea en su mayor parte espacio vacio también permite la existencia de los seres vivos. El nombre técnico es: El Principio de Exclusión de Pauli y dice que dos fermiones (un tipo de partículas fundamentales) idénticos y con la misma orientación no pueden ocupar simultáneamente el mismo lugar en el espacio. Por el contrario, los bosones (otro tipo de partículas, el fotón, por ejemplo) no se comportan así, tal y como se ha demostrado recientemente por medio de la creación en el laboratorio de los condensados de Bose-Einstein.

¿Cuál es la diferencia?

Los bosones son sociables; les gusta estar juntos. Como regla general, cualquier átomo con un número par de electrones+protones+neutrones es un bosón. Así, por ejemplo, los átomos del sodio ordinario son bosones, y pueden unirse para formar condensados Bose-Einstein.

Los bosones son sociables; les gusta estar juntos. Como regla general, cualquier átomo con un número par de electrones+protones+neutrones es un bosón. Así, por ejemplo, los átomos del sodio ordinario son bosones, y pueden unirse para formar condensados Bose-Einstein.

Izquierda: Los bosones son sociables; los fermiones son antisociales.

Los fermiones, por otro lado, son antisociales. No pueden juntarse en el mismo estado cuántico (por el Principio de Exclusión de Pauli de la mecánica cuántica). Cualquier átomo con un número impar de electrones+protones+neutrones, como el potasio-40, es un fermión.

Pero, estábamos diciendo: “…no pueden poseer un conjunto idéntico de números cuánticos.” A partir de ese principio, sabemos que, cuando una estrella como nuestro Sol deja de fusionar Hidrógeno en Helio que hace que la estrella deje de expandirse y quede a merced de la Gravedad, ésta implosionará bajo el peso de su propia masa, es decir, se contraerá sobre sí misma por la fuerza gravitatoria pero, llegará un momento en el cual, los electrones, debido a ese principio de exclusión de Pauli que les impide estar juntos, se degeneran y se moverán de manera aleatoria con velocidades relativista hasta el punto de ser capaces de frenar la fuerza provocada por la gravedad, y, de esa manera, quedará estabilizada finalmente una estrella enana blanca.

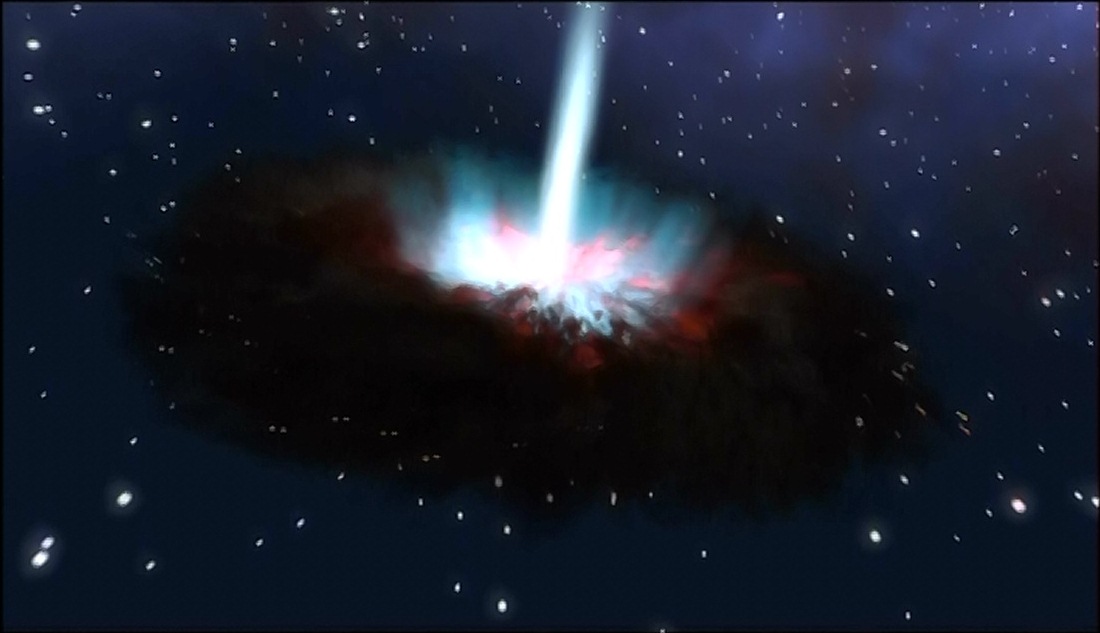

Si hablamos de una estrella supermasiva, su produce la implosión arrojando las capas externas al espacio interestelar mientras que el grueso de la estrella se comprime más y más sin que nada la pueda frenar, aquí no sirve el Principipo de exclusión de Pauli para los fermiones y, es tal la fuerza gravitatoria que se desencadena como consecuencia de que la estrella supergigante no puede seguir fusionando y queda a merce4d de una sola fiuerza: La Gravedad, que ésta, la comprime hasta lo inimaginable para convertir toda aquella ingente masa en una singularidad, es decir, un punto de densidad y energía “infinitas” que ni la luz puede escapar de allí, y, el tiempo se ralentiza y el espacio se curva a su alrededor.

Si la estrella original es más masiva, la degeneración de los electrones no será suficiente para frenar la fuerza gravitatoria y, los electrones se fusionaran con los protones para convertirse en neutrones que, bajo el mismo principio de exclusión sufrirán la degeneración que frenará la fuerza de gravedad quedando entonces una estrella de neutrones. Por último, si la estrella es, aún más masiva, ni la degeneración de los neutrones será suficiente para frenar la inmensa fuerza gravitatoria generada por la masa de la estrella que, continuará la implosión contrayéndose cada vez más hasta desaparecer de nuestra vista convertida en un agujero negro.

¿Qué forma adoptará, qué transición de fase se produce en la materia dentro de una Singularidad?

¡Resulta todo tan complejo!

emilio silvera

Nov

16

Nuestra Imaginación es mucho más rçapida que la luz

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

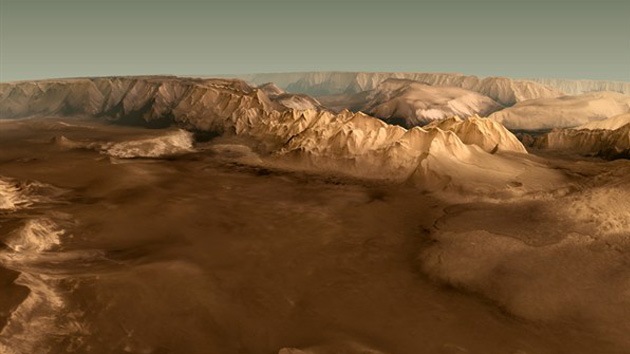

¿Cuantas veces habré “visitado” Marte con la Imaginación?

Pero bajemos hasta la realidad y pongamos los pies en el suelo, veámos que cosas pasan por aquí, en nuestro mundo real que, a veces, también resultan tan fantásticas como viajar a Marte con el pensamiento.

Satélite Gravity Probe B. Dedicado a medir la curvatura del campo gravitatorio terrestre debido a la teoría de la relatividad de Einstein. La gravedad ha sido medida y comprobada de muchas maneras pero… ¡Gravedad cuántica! ¿qué es eso? La imaginación anda más rápida que los conocimientos. Sin embargo, así hemos ido avanzando en el transcurrir del Tiempo. Hace algunos miles de años algunos imaginaron la existencia del átomo y de los elementos y, ya sabéis lo que de esas cuestiones sabemos hoy.

La llamada gravedad cuántica trata de fundir en una sola las dos teorías físicas más soberbias con las que contamos, la relatividad general y la mecánica cuántica, que en el estado actual de nuestro conocimiento parecen incompatibles. Su estudio, ahora mismo, es en algunos aspectos análogo a la física de hace cien años, cuando se creía en los átomos, pero se ignaraban los detalles de su estructura.

Desde aquel día en que Kaluza, le escribió a Einstein una carta con su teoría de las cinco dimensiones, en la que unía la Gravedad con el Electromagnetismo, la puerta de las dimensiones más altas quedó abierta y a los teóricos se les regaló una herramienta maravillosa: el hiperespacio; todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí sí es posible encontrar esa soñada teoría de la gravedad cuántica.

Así que las teorías se han embarcado a la búsqueda de un objeto audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos; una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

Claro que saber, lo que el universo es, leyendo una ecuación, por muy ingeniosa que ésta sea y por mucho que la misma pueda abarcar… Parece poco probable. ¿Dónde radica el problema? El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC, la máquina más potente del mundo hasta el momento.

La verdad es que la teoría que ahora tenemos, el modelo estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías. ¡Necesitamos algo más avanzado!

A pesar de su grandeza, se queda corto para que nos pueda decir, lo que necesitamos saber: Si nos habló del Bosón de Higgs, por el momento no está nada mal, y, ahora, en su nueva etapa, seguramente nos dará alguna sorpresa y nos puede desvelar algún que otro secreto de la materia, del universo que presentimos y no podemos ver.

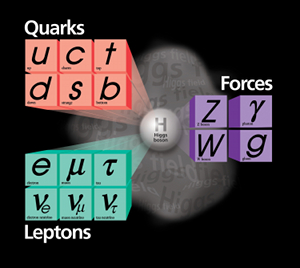

Se dijo que la función de la partícula de Higgs era la de dar masa a las partículas que carecen de ella, disfrazando así la verdadera simetría del mundo. Cuando su autor lanzó la idea a la comunidad científica, resultó además de nueva, muy extraña. El secreto de todo radica en conseguir la simplicidad: el átomo resultó ser complejo, lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, y, el núcleo, una parte entre cien mil del total del átomo, resultó ser de una complejidad asombrosa. Allí los nucleones (protones y neutrones) resultaron estar hechos por tripletes de Quarks que, confinados por la fuerza nuclear fuerte, eran rtenidos por los Gluones, los Bosones transmisores de esa fuerza de la naturaleza. Así que un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo, cuando fue descubierto en todo su contenido, fue motivo de un gran asombro entre la comunidad científica. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún; los quarks que estaban instalados en nubes de otras partículas llamadas gluones, y ahora queremos continuar profundizando, sospechando que después de los quarks puede haber algo más.

Nos dicen que existen lugares que llaman los Océanos de Higgs, y, por ellos, circula libremente el dichoso Bosón que, también según nos dicen, proporciona la masa al resto de las partículas. Todo el Universo está permeado por esa especie de sustancia -como el viejo éter- que los griegos llamaban Ilem cósmico y que, a medida que el tiempo avanza, le vamos cambiando el nombre. Pues bien, ahí, en ese “océano” dicen que está el Bosón dador de masas que según parece, descubrieron hace un par de años.

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes, es decir, que si miramos a las estrellas en una noche clara, estamos mirando el campo de Higgs. Las partículas influidas por este campo toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado otras veces, tales como: del campo gravitatorio o del electromagnético.

Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquirirá energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra. Como E = mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein: la masa, m, tiene en realidad dos partes; una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) en los aceleradores, o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Pero la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas. Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan estas al campo de Higgs cuando interaccionan con él.

La influencia de Higgs en las masas de los quarks y de los leptones nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de qué reglas controlan los incrementos de masa generados por Higgs (de ahí la expectación creada -en su momento- por el nuevo acelerador de partículas LHC), pero el problema es irritante: ¿por qué sólo esas masas - las masas de los W+, W–, Z0, y el up, down, encanto, extraño, top y bottom, así como los leptones – que no forman ningún patrón obvio?

Las masas van desde la del electrón (0’0005 GeV) a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-Salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnética y débil. En la unidad hay cuatro partículas mensajeras sin masa – los W+, W–, Z0 y el fotón – que llevan la fuerza electrodébil. Además está el campo de Higgs, y rápidamente, los W y Z absorben la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos), y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen las teorías. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

“En la actualidad, prácticamente todos los fenómenos subatómicos conocidos son explicados mediante el modelo estándar, una teoría ampliamente aceptada sobre las partículas elementales y las fuerzas entre ellas. Sin embargo, en la década de 1960, cuando dicho modelo aún se estaba desarrollando, se observaba una contradicción aparente entre dos fenómenos. Por un lado, la fuerza nuclear débil entre partículas subatómicas podía explicarse mediante leyes similares a las del electromagnetismo (en su versión cuántica). Dichas leyes implican que las partículas que actúen como intermediarias de la interacción, como el fotón en el caso del electromagnetismo y las partículas W y Z en el caso de la fuerza débil, deben ser no masivas. Sin embargo, sobre la base de los datos experimentales, los bosones W y Z, que entonces sólo eran una hipótesis, debían ser masivos.

En 1964, tres grupos de físicos publicaron de manera independiente una solución a este problema, que reconciliaba dichas leyes con la presencia de la masa. Esta solución, denominada posteriormente mecanismo de Higgs, explica la masa como el resultado de la interacción de las partículas con un campo que permea el vacío, denominado campo de Higgs. El modelo estándar quedó finalmente constituido haciendo uso de este mecanismo.”

Tampoco el Higgs es una partícula especial porque sea una excitación del del campo de Higgs que nos permita explorar sus propiedades, porque en las teorías sin Higgs o con Higgs compuesto también hay excitaciones del vacío que nos permiten explorar el campo.” Eso nos dicen en el magnifico Blog de Francis (th)E mule Science’s News.

| Partícula | Símbolo | Masa (en GeV/c2) | Carga eléctrica | Espín | Interacción |

|---|---|---|---|---|---|

| Fotón |  |

0 | 0 | 1 | electromagnética |

| Bosón W | W± | 80,4 | ± 1 | 1 | débil |

| Bosón Z | Z0 | 91,187 | 0 | 1 | débil |

| Gluón | g | 0 | 0 | 1 | fuerte |

Las masas de los W y Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil, y las relajadas sonrisas de los físicos teóricos nos recuerdan que Hooft y Veltman dejaron sentado que la teoría entera está libre de infinitos.

Todos los intentos y los esfuerzos por hallar una pista de cuál era el origen de la masa fallaron. Feynman escribió su famosa pregunta: “¿por qué pesa el muón?”. Ahora, por lo menos, tenemos una respuesta parcial, en absoluto completa. Una voz potente y segura nos dice “¡Higgs!”. Durante más de sesenta años los físicos experimentadores se rompieron la cabeza con el origen de la masa, y ahora el campo de Higgs presenta el problema en un contexto nuevo; no se trata sólo del muón. Proporciona, por lo menos, una fuente común para todas las masas. La nueva pregunta feynmaniana podría ser: ¿cómo determina el campo de Higgs la secuencia de masas, aparentemente sin patrón, que da a las partículas de la materia?

La variación de la masa con el estado de movimiento, el cambio de masa con la configuración del sistema y el que algunas partículas (el fotón seguramente, y los neutrinos posiblemente) tengan masa en reposo nula son tres hechos que ponen en entredicho que el concepto de masa sea un atributo fundamental de la materia. Habrá que recordar aquel cálculo de la masa que daba infinito y nunca pudimos resolver; los físicos sólo se deshicieron de él “renormalizándolo”, ese truco matemático que empleam cuando no saben hacerlo bien.

¿Sabremos alguna vez cómo adquieren masa las partículas?

Ese es el problema de trasfondo con el que tenemos que encarar el problema de los quarks, los leptones y los vehículos de las fuerzas, que se diferencian por sus masas. Hace que la historia de Higgs se tenga en pie: la masa no es una propiedad intrínseca de las partículas, sino una propiedad adquirida por la interacción de las partículas y su entorno.

La idea de que la masa no es intrínseca como la carga o el espín resulta aún más plausible por la idílica idea de que todos los quarks y fotones tendrían masa cero. En ese caso, obedecerían a una simetría satisfactoria, la quiral, en la que los espines estarían asociados para siempre con su dirección de movimiento. Pero ese idilio queda oculto por el fenómeno de Higgs.

Una cosa más; hemos hablado de los bosones gauge y de su espín de una unidad. Hemos comentado también las partículas fermiónicas de la materia (espín de media unidad). ¿Cuál es el pelaje de Higgs? Es un bosón de espín cero. El espín supone una direccionalidad en el espacio, pero el campo de Higgs da masa a los objetos donde quiera que estén y sin direccionalidad. Al Higgs se le llama a veces “bosón escalar” (sin dirección) por esa razón.

La interacción débil, recordaréis, fue inventada por E. Fermi para describir la desintegración radiactiva de los núcleos, que era básicamente un fenómeno de poca energía, y a medida que la teoría de Fermi se desarrolló, llegó a ser muy precisa a la hora de predecir un enorme número de procesos en el dominio de energía de los 100 MeV. Así que ahora, con las nuevas tecnologías y energías del LHC, las esperanzas son enormes para, por fin, encontrar nuevas partículas que puedan despejar algunos interrogantes.

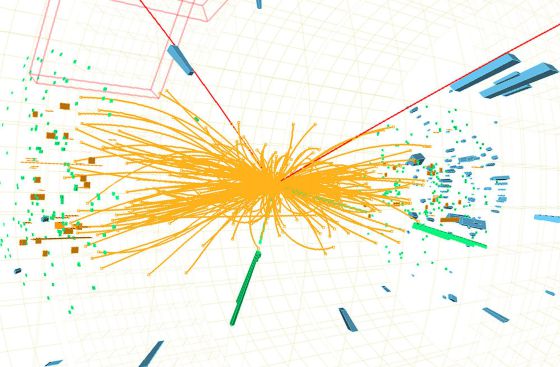

Recuerdo cuando andaban a la caza del Bosón de Higgs y decían “Pero todavía hay que responder montones de preguntas: ¿cuáles son las propiedades de las partículas de Higgs? y, lo que es más importante, ¿cuál es su masa? (Bueno, parece que, en el último experimento apareció se localizó un bosón con ~125 GeV que, según parece, podría ser el esquivo Hihhs)¿Cómo reconoceremos una si nos la encontramos en una colisión del LHC? ¿Cuántos tipos hay? ¿Genera el Higgs todas las masas o sólo las hace incrementarse? ¿Cómo podemos saber más al respecto? Cómo es su partícula, nos cabe esperar que la veremos ahora después de gastar más de 50.000 millones de euros en los elementos necesarios para ello.”

También a los cosmólogos les fascina la idea de Higgs, pues casi se dieron de bruces con la necesidad de tener campos escalares que participasen en el complejo proceso de la expansión del universo, añadiendo pues, un peso más a la carga que ha de soportar el Higgs.

El campo de Higgs, tal como se lo concibe ahora, se puede destruir con una energía grande, o temperaturas altas. Éstas generan fluctuaciones cuánticas que neutralizan el campo de Higgs. Por lo tanto, el cuado que las partículas y la cosmología pintan juntas de un universo primitivo puro y de resplandeciente simetría es demasiado caliente para Higgs. Pero cuando la temperatura cae bajo los 10-5 grados Kelvin o 100 GeV, el Higgs empieza a actuar y hace su generación de masas. Así, por ejemplo, antes del Higgs teníamos unos W, Z y fotones sin masa y la fuerza electrodébil unificada.

No, esto no es el Higgs, es, simplemente, una burbuja multicolor

El universo se expande y se enfría, y entonces viene el Higgs (que “engorda” los W y Z, y por alguna razón ignora el fotón) y de ello resulta que la simetría electrodébil se rompe. Tenemos entonces una interacción débil, transportada por los vehículos de la fuerza W+, W–, Z0, y por otra parte una interacción electromagnética, llevada por los fotones. Es como si para algunas partículas del campo de Higgs fuera una especie de aceite pesado a través del que se moviera con dificultad y que les hiciera parecer que tienen mucha masa. Para otras partículas, el Higgs es como el agua, y para otras, los fotones y quizá los neutrinos, es invisible.

De todas formas, es tanta la ignorancia que tenemos sobre el origen de la masa que nos agarramos como a un clavo ardiendo, en este caso, a la partícula de Higgs, que algunos han llegado a llamar “la partícula divina”. Lo mismo nos pasa con la dichosa “materia oscura” para ocultar lo que no sabemos sobre la expansión del Universo.

¡Ya veremos en qué termina todo esto!

Arrina tenemos nada más y nada menos que: a John Mather, Carlo Rubbia, Martinus Veltman, Gerardus ‘t Hooft at the Lindau Nobel Meetings 2010. Si científicos como ellos no vienen a nuestro rescate, y nos sacan del atolladero en el que estamos inmerso y hasta el cuelo de ignorancia…¡Mal hirán las cosas!

Peter Higgs, de la Universidad de Edimburgo, introdujo la idea en la física de partículas. La utilizaron los teóricos Steven Weinberg y Abdus Salam, que trabajaban por separado, para comprender cómo se convertía la unificada y simétrica fuerza electrodébil, transmitida por una feliz familia de cuatro partículas mensajeras de masa nula, en dos fuerzas muy diferentes: la QED con un fotón carente de masa y la interacción débil con sus W+, W– y Z0 de masa grande. Weinberg y Salam se apoyaron en los trabajos previos de Sheldon Glashow, quien, tras los pasos de Julian Schwinger, sabía sólo que había una teoría electrodébil unificada, coherente, pero no unió todos los detalles. Y estaban Jeffrey Goldstone y Martinus Veltman y Gerard’t Hooft. También hay otros a los que habría que mencionar, pero lo que siempre pasa, quedan en el olvido de manera injusta. Además, ¿cuántos teóricos hacen falta para encender una bombilla? La verdad es que, casi siempre, han hecho falta muchos. Recordemos el largo recorrido de los múltiples detalles sueltos y físicos que prepararon el terreno para que llegara Einstein y pudiera, uniéndolo todo, exponer su teoría relativista.

Lo cierto es que (al menos de momento), la materia y energía oscura, las supercuerdas, y el bosón de Higss, sí son la alfonbra que decía Veltman, aquel físico serío y Premio Nobel que, no confesaba con ciertas ruedas de molino. Él, quería hablar de cosas tamgibles y, tampoco le gustaban las partículas virtuales.

Sobre la idea de Peter Higgs, Veltman, uno de sus arquitectos, dice que es una alfombra bajo la que barremos nuestra ignorancia. Glashow es menos amable y lo llamó retrete donde echamos las incoherencias de nuestras teorías actuales. La objeción principal: que no tenemos la menor prueba experimental. Ahora, por fin, la tendremos con el LHC. El modelo estándar es lo bastante fuerte para decirnos que la partícula de Higgs de menor masa (podría haber muchas) debe “pesar” menor de 1 TeV, ¿por qué?; si tiene más de 1 TeV el modelo estándar se vuelve incoherente y tenemos la crisis de la unitariedad.

Después de todo esto, podríamos llegar a la conclusión de que el campo de Higgs, el modelo estándar y nuestra idea de cómo surgió el universo dependían de que se pudiera encontrar el bosón de Higgs.Así, hace dos años, utilizando la energía de 7 TeV, por fín dijeron haber encontrado la partícula dadora de masa y, tendrían que explicar un poco más extensamente sus mecanismos y funciones para que, la gente sencilla, llegara a comprender cómo se produce ese “milagro” de que las particulas adquieran su masa al interaccionar con ese campo. El contertulio Ramón Márques nos dice que es el “Efecto Frenado” el que produce el “milagro”, cuando las partículas deambulan por el campo de Higgs y se frenan con el roce adquiriendo la masa.

emilio silvera

Nov

14

Espaciotiempo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

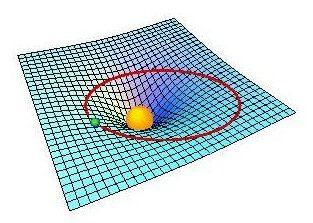

Curvatura del Espacio-Tiempo

Hay que entender que el espaciotiempo es la descripción en cuatro dimensiones del universo en la que la posición de un objeto se especifica por tres coordenadas en el espacio y una en el tiempo.

De acuerdo con la relatividad especial, no existe un tiempo absoluto que pueda ser medido con independencia del observador, de manera que eventos simultáneos para un observador ocurren en instantes diferentes vistos desde otro lugar. El tiempo puede ser medido, por tanto, de manera relativa, como lo son las posiciones en el espacio (Euclides) tridimensional, y esto puede conseguirse mediante el concepto de espaciotiempo. La trayectoria de un objeto en el espaciotiempo se denomina por el nombre de línea de universo. La relatividad general nos explica lo que es un espaciotiempo curvo con las posiciones y movimientos de las partículas de materia. La relatividad especial nos explica otras cosas, complementando así, una teoría completa y precisa de la Naturaleza del Universo.

Nuestra línea de universo resume toda nuestra historia, desde que nacemos hasta que morimos. Cuanto más rápido nos movemos más se inclina la línea de Universo. Sin embargo, la velocidad más rápida a la que podemos viajar es la velocidad de la luz. Por consiguiente, una parte de este diagrama espacio – temporal está “prohibida”; es decir, tendríamos que ir a mayor velocidad que la luz para entrar en esta zona prohibida por la relatividad especial de Einstein que, nos dice que nada en nuestro Universo puede viajar a velocidades superiores a C.

La curvatura del espaciotiempo es la propiedad del espaciotiempo en la que las leyes familiares de la geometría no son aplicables en regiones donde los campos gravitatorios son intensos. La relatividad general de Einstein, nos explica y demuestra que el espaciotiempo está íntimamente relacionado con la distribución de materia en el universo, y nos dice que el espacio se curva en presencia de masas considerables como planetas, estrellas o galaxias (entre otros).

Einstein lo dedujo en una fórmula matemática que relaciona la geometría del espaciotiempo con la distribución de masa y energía: esta fórmula se conoce como ecuación de Einstein y es el centro medular de la teoría de la relatividad general.

La equivalencia aceleración-gravitación llevó a Einstein, de forma genial, a la concepción de la fuerza de la gravedad como una curvatura del espaciotiempo. La visualización de este hecho la podemos observar en la figura: una superficie elástica (semejante al espaciotiempo) se curva bajo la acción de objetos pesados (las grandes masas, de intensos campos gravitatorios), de forma que las trayectorias (geodésicas) que pueden seguir los objetos pequeños cuando están cerca de los grandes se acercan a los mismos. Einstein formuló una ecuación que muestra el grado de curvatura del espaciotiempo en función de la cantidad de masa, relaciona masa con curvatura: materia (o energía) con deformación del espaciotiempo.

Así, en un espacio de sólo dos dimensiones, como una lámina de goma plana, la geometría de Euclides se aplica de manera que la suma de los ángulos internos de un triángulo en la lámina es de 180°. Si colocamos un objeto masivo sobre la lámina de goma, la lámina se distorsionará y los caminos de los objetos que se muevan sobre ella se curvaran. Esto es, en esencia, lo que ocurre en relatividad general.

En los modelos cosmológicos más sencillos basados en los modelos de Friedmann, la curvatura de espaciotiempo está relacionada simplemente con la densidad media de la materia, y se describe por una función matemática denominada métrica de Robertson-Walker. Si un universo tiene una densidad mayor que la densidad crítica, se dice que tiene curvatura positiva, queriendo decir que el espaciotiempo está curvado sobre sí mismo, como la superficie de una esfera; la suma de los ángulos de un triángulo que se dibuje sobre la esfera es entonces mayor que 180°. Dicho universo sería infinito y se expandiría para siempre, es el universo abierto. Un universo de Einstein-de Sitter tiene densidad crítica exacta y es, por consiguiente, espacialmente plano (euclideo) infinito en el espacio y en el tiempo.

- universo de Einstein-de Sitter Wm= 1, Wl= 0

- Universo cerrado Wm= 2, Wl= 0

- modelo favorito actualmente con Wl= 0.75, Wm= 0.25

- Wl= 0, Wm= 0

- universo de de Sitter sin Big Bang Wl= 1, Wm= 0

Representación gráfica de los espacios que dan lugar a los tres posibles formas de universo antes referida en función de la densidad crítica que hará un universo plano, un universo abierto o un universo curvo y cerrado.

Hemos mencionado antes la relatividad del tiempo que para el mismo suceso será distinto en función de quién sea el que cronometre; por ejemplo, el tiempo transcurre más despacio para el astronauta que en nave espacial viaja a velocidades próximas a c, la velocidad de la luz. Según la teoría de la relatividad especial de Einstein, en el caso antes señalado, el tiempo del astronauta viajero avanza más lentamente en un factor que denotamos con la ecuación , cuando lo mide un sistema de referencia que viaja a una velocidad v relativa al otro sistema de referencia; c es la velocidad de la luz. Este principio ha sido verificado de muchas maneras; por ejemplo, comparando las vidas medias de los muones rápidos, que aumentan con la velocidad de las partículas en una cantidad predicha en este factor de la anterior ecuación.

Un ejemplo sencillo de la dilatación del tiempo es la conocida paradoja de los gemelos. Uno viaja al espacio y el otro lo espera en la Tierra. El primero hace un viaje a la velocidad de la luz hasta Alfa de Centauri y regresa. Cuando baja de la nave espacial, tiene 8’6 años más que cuando partió de la Tierra. Sin embargo, el segundo gemelo que esperó en el planeta Tierra, al regreso de su hermano, era ya un viejo jubilado. El tiempo transcurrido había pasado más lento para el gemelo viajero.

Otra curiosidad de la relatividad especial es la que expresó Einstein mediante su famosa fórmula de E = mc2, que nos viene a decir que masa y energía son dos aspectos de una misma cosa. Podríamos considerar que la masa (materia), es energía congelada. La bomba atómica demuestra la certeza de esta ecuación.

Uno de los gráficos anteriores, que es una muestra de las tres posibles maneras en que puede estar conformado nuestro universo, dependerá finalmente, de la densidad critica, es decir, de la masa que realmente contenga el universo. Claro que, según dicen, hay por ahí una materia desconocida que denominamos “oscura” y que, al parecer, confroma la mayor parte de la materia del universo.

“Es un tipo de masa invisible que posee gran atracción gravitatoria. El descubrimiento lo realizó, por medios de rayos X, el laboratorio Chandra perteneciente a la NASA. (Pongamos en cuarentena lo de “descubrimiento”).

Los astrónomos dicen que han encontrado las mejores pruebas hasta la fecha sobre la “Materia Oscura”, la misteriosa sustancia invisible que se cree constituye la mayor parte de la masa del universo. En la imagen de arriba han querido significar, diferenciándola en colores, las dos clases de materia, la bariónica y la oscura que, en este caso, sería la azulada -según dicen-. Sin embargo, la imagen no refleja la proporción que dicen existe entre la una y la otra.

En el Universo, como ocurre en los átomos, casi todo son espacios vacíos

La densidad crítica está referida a la densidad media de materia requerida para que la gravedad detenga la expansión de nuestro universo. Así que si la densidad es baja se expandirá para siempre, mientras que una densidad muy alta colapsará finalmente. Si tiene exactamente la densidad crítica ideal, de alrededor de 10-29 g/cm3, es descrito por el modelo al que antes nos referimos conocido como de Einstein-de Sitter, que se encuentra en la línea divisoria de estos dos extremos. La densidad media de materia que puede ser observada directamente en nuestro universo representa sólo el 20% del valor crítico. Puede haber, sin embargo, una gran cantidad de materia oscura que elevaría la densidad hasta el valor crítico. Las teorías de universo inflacionario predicen que la densidad presente debería ser muy aproximada a la densidad crítica; estas teorías requieren la existencia de materia oscura.

Conforme a lo antes dicho, la densidad media de materia está referida al hecho de distribuir de manera uniforme toda la materia contenida en las galaxias a lo largo de todo el universo. Aunque las estrellas y los planetas son más densos que el agua (alrededor de 1 g/cm3), la densidad media cosmológica es extremadamente baja, como se dijo antes, unos 10-29 g/cm3, o 10-5 átomos/cm3, ya que el universo está formado casi exclusivamente de espacios vacíos, virtualmente vacíos, entre las galaxias. La densidad media es la que determinará si el universo se expandirá o no para siempre.

Arriba tenemos uan visión del enorme cúmulo de galaxias Abell 2218, ubicado en la constelación de Draco a unos dos mil millones de años-luz de la Tierra.

En presencia de grandes masas de materia, tales como planetas, estrellas y galaxias y supercúmulos de galaxias, está presente el fenómeno descrito por Einstein en su teoría de la relatividad general, la curvatura del espaciotiempo, eso que conocemos como gravedad, una fuerza de atracción que actúa entre todos los cuerpos y cuya intensidad depende de las masas y de las distancias que los separan; la fuerza gravitacional disminuye con el cuadrado. La gravitación es la más débil de las cuatro fuerzas fundamentales de la naturaleza. Isaac Newton formuló las leyes de la atracción gravitacional y mostró que un cuerpo se comporta gravitacionalmente como si toda su masa estuviera concentrada en su centro de gravedad. Así, pues, la fuerza gravitacional actúa a lo largo de la línea que une los centros de gravedad de las dos masas (como la Tierra y la Luna, por ejemplo).

En la teoría de la relatividad general, la gravitación se interpreta como una distorsión del espacio que se forma alrededor de la masa que provoca dicha distorsión, cuya importancia iría en función de la importancia de la masa que distorsiona el espacio que, en el caso de estrellas con gran volumen y densidad, tendrán una importancia considerable, igualmente, la fuerza de gravedad de planetas, satélites y grandes objetos cosmológicos, es importante.

Esta fuerza es la responsable de tener cohexionado a todo el universo, de hacer posible que existan las galaxias, los sistemas solares y que nosotros mismos tengamos bien asentados los pies a la superficie de nuestro planeta Tierra, cuya gravedad tira de nosotros para que así sea.

La fuerza de gravedad hace posible la cohexión del Sistema Solar

No obstante, a escala atómica la fuerza gravitacional resulta ser unos 1040 veces más débil que la fuerza de atracción electromagnética, muy potente en el ámbito de la mecánica cuántica donde las masas de las partículas son tan enormemente pequeñas que la gravedad es despreciable.

La gravitación cuántica es la teoría en la que las interacciones gravitacionales entre los cuerpos son descritas por el intercambio de partículas elementales hipotéticas denominadas gravitones. El gravitón es el cuanto del campo gravitacional. Los gravitones no han sido observados, aunque se presume que existen por analogía a los fotones de luz.

Tener en nuestras manos la Gravitación Cuántica, es cosa del futuro

La teoría cuántica es un ejemplo de talento que debemos al físico alemán Max Planck (1.858 – 1.947) que, en el año 1.900 para explicar la emisión de radiación de cuerpo negro de cuerpos calientes, dijo que la energía se emite en cuantos, cada uno de los cuales tiene una energía igual a hv, donde h es la constante de Planck (E = hv o ħ = h/2π) y v es la frecuencia de la radiación. Esta teoría condujo a la teoría moderna de la interacción entre materia y radiación conocida como mecánica cuántica, que generaliza y reemplaza a la mecánica clásica y a la teoría electromagnética de Maxwell. En la teoría cuántica no relativista se supone que las partículas no son creadas ni destruidas, que se mueven despacio con respecto a la velocidad de la luz y que tienen una masa que no cambia con la velocidad. Estas suposiciones se aplican a los fenómenos atómicos y moleculares y a algunos aspectos de la física nuclear. La teoría cuántica relativista se aplica a partículas que viajan cerca de la velocidad de la luz, como por ejemplo, el fotón

De todas las maneras, los misterios cuánticos serán desvelados por nuestras mentes poderosas de la misma manera que hemos podido traspasar otras barreras del saber. Llegará ese tiempo futuro en el cual, dejará de ser un misterio esa compleja unión de la Gravedad de Eintein con la Cuántica de Planck. Claro que, como decía por alguna parte, el futuro estará cargado de nuestro presente y, si no hacemos ahora lo que debemos…mal pintarán las cosas.

emilio silvera

Nov

14

¿Las estrellas? Sí, son mucho más… ¡que simples puntitos...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Estrellas ~

Clasificado en Estrellas ~

Comments (0)

Comments (0)

Es cierto que cuando vemos las cosas con cierta asiduidad y de forma permanente, esa cotidianidad nos hace perder la perspectiva y no pensamos en lo que realmente esas cosas pueden ser y, con las estrellas nos ocurre algo similar, ya que son algo más, mucho más, que simples puntitos luminosos que brillan en la oscuridad de la noche. Una estrella es una gran bola de gas luminoso que, en alguna etapa de su vida, produce energía por la fusión nuclear del hidrógeno para formar helio. El término estrella por tanto, no sólo incluye estrellas como nuestro Sol, que están en la actualidad quemando hidrógeno, sino también protoestrellas, aún no lo suficientemente calientes como para que dicha combustión haya comenzado, y varios tipos de objetos evolucionados como estrellas gigantes y supergigantes, que están quemando otros combustibles nucleares, o las enanas blancas y las estrellas nucleares, que están formadas por combustible nuclear gastado.

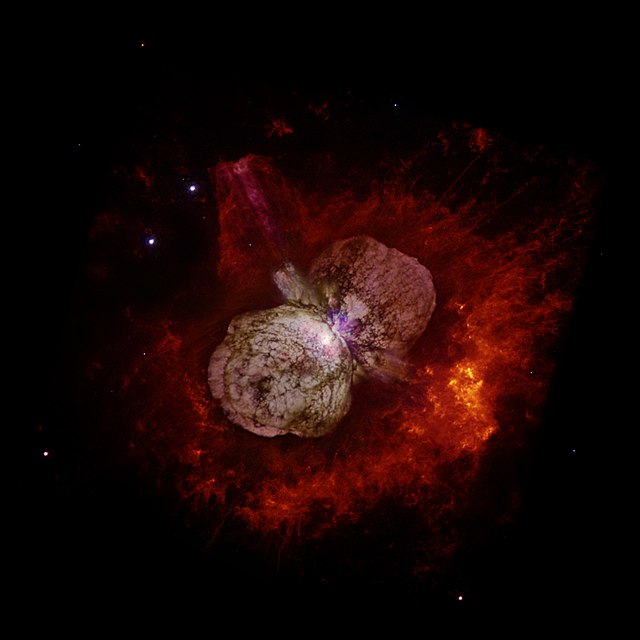

En esta imagen del Telescopio Espacial Hubble se pueden apreciar a la estrella Eta Carinæ y los restos de erupciones antiguas que forman la La Nebulosa del Homúnculo alrededor de la estrella. La nebulosa fue creada por una erupción de Eta Carinae cuya luz alcanzó la Tierra en 1.843. Eta Carinae aparece como un parche blanco en el centro de la imagen, donde los dos lóbulos de la nebulosa Homúnculo convergen. Como su masa está calculada entre las 100/150 masas solares, su propia radiación la podría destruir y, la única defensa que tiene es, la de eyectar marterial al Espacio Interestelar para descongestionarse y seguir viviendo.

Estrellas masivas que expulsan gases, ya que, cuando la masa es muy grande, su propia radiación las puede destruir y, de esta manera, descongestionan la tensión y evitan un final anticipado. Arriba teneis una estrella supermasiva que ha expulsado gases formando una nebulosa para evitar su muerte, Eta Carinae es un buen ejemplo de cómo actúan este tipo de estrellas masivas para evitar la muerte. Estas son estrellas que estám congestionadas y, sólo la expulsión de material la puede aliviar y conseguir que siga brillando como estrella evitando explotar como supernova.

Se calcula que la masa máxima de una estrella es de unas 120 masas solares, por encima de la cual sería destruida por su propia radiación. La masa mínima es de 0,08 masas solares; por debajo de ella, los objetos no serían lo suficientemente calientes en sus núcleos como para que comience la combustión del hidrógeno, y se convertirían en enanas marrones.

De la misma forma que al calentar una pieza de metal cambia de color, al principio rojo, luego amarillo hasta llegar al blanco, el color de una estrella varia según su temperatura superficial. Las estrellas más frías son las rojas, y las mas calientes las azules. Estos colores suelen percibirse a simple vista, como por ejemplo Antares (la estrella principal de Scorpius) que es de color rojo, o Rigel (en Orion) de color azul. En astronomía se utiliza la escala Kelvin para indicar temperaturas, donde el cero absoluto es -273 grados Celsius.

El Diagrama de Hertzsprung-Russell (arriba) proporcionó a los astrónomos un registro congelado de la evolución de las estrerllas, el equivalente astrofísico del registro fósil que los geólogos estudian en los estratos rocosos. Presumiblemente, las estrellas evolucinan de algún modo, pasan la mayor parte de su tiempo en la serie principal (la mayoría de las estrellas en la actualidad, en el brevísimo tiempo que tenemos para observar, se encuentran allí), pero empiezan y terminan su vida en alguna otra parte, entre las ramas o en el mantillo. Por supuesto, no podemos esperar para ver que esto sucede, pues el tiempo de vida, aún de estrellas de vida corta, se mide en millones de años. Hallar la respuesta exigirá conocer la física del funcionamiento estelar.

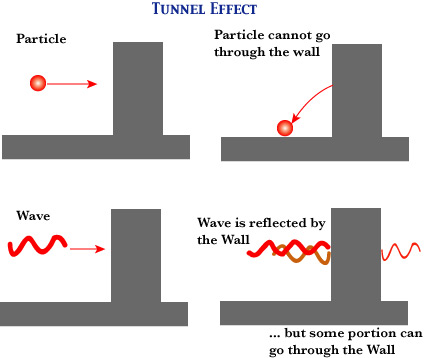

El progreso en física, mientras tanto, estaba bloqueado por una barrera aparentemente insuperable. Esto era literal: el agente responsable era conocido como la Barrera de Coulomb, y por un tiempo frustró los esfuerzos de los físicos teóricos para comprender cómo la fusión nuclear podía producir energía en las estrellas.

La barrera de Coulomb, denominado a partir de la ley de Coulomb, nombrada así del físico Charles-Augustin de Coulomb (1736–1806), es la barrera de energía debida a la interacción electrostática que el núcleo atómico debe superar para experimentar una reacción nuclear. Esta barrera de energía es proporcionada por la energía potencial electrostática:

donde:

- k es la constante de Coulomb = 8.9876×109 N m² C−2;

- ε0 es la permeabilidad en el vacío;

- q1, q2 son las cargas de las partículas que interactúan;

- r es el radio de interacción.

Un valor positivo de U es debido a una fuerza de repulsión, así que las partículas que interactúan están a mayores niveles de energía cuando se acercan. Un valor negativo de la energía potencial U indica un estado de ligadura, debido a una fuerza atractiva. La linea de razonamiento que conducía a esta barrera era impecable. Las estrellas están formadas en su mayor parte por hidrógeno. Esto se hace evidente en el estudio de sus espectros.) El núcleo del átomo de hidrógeno consiste en un sólo protón, y el protón contiene casi toda la masa del átomo. (Sabemos esto por los experimentos de Rutherford explicados aquí en otra ocasión). Por tanto, el protón también debe contener casi toda la energía latente del átomo de hidrógeno.

(Recordemos que la masa es igual a la Energía: E = mc2. (En el calor de una estrella los protones son esparcidos a altas velocidades -el calor significa que las partículas involucradas se mueven rápidamente- y, como hay muchos protones que se apiñam en el núcleo denso de una estrella, deben de tener muchísimos choques. En resumen, la energía del Sol y las estrellas, puede suponerse razonablemente, implica las interacciones de los protones. esta era la base de conjetura de Eddintong de que la fuente de la energía estelar “difícilmente puede ser otra cosa que energía subatómica, la cual, como se sabe, existe en abundancia en toda la materia”.

A ese punto, todo iba bien, la ciencia estaba cerca de identificar la fusión termonuclear como el secreto de la energía solar. Pero aquí era donde intervenía la Barrera de Coulomb. Los protones están cargados positivamente; las partículas de igual carga se repelen entre sí; y este obstáculo parecía demasiado grande para ser superado, aun a la elevada velocidad a la que los protones se agitaban en el intenso calor del centro de las estrellas. De acuerdo con la física clásica, muy raras veces podían dos protones de una estrella ir con la rapidez suficiente para romper las murallas de sus campos de fuerza electromágnéticos y fundirse en un sólo núcleo. Los cálculos decían que la tasa de colisión de protones no podía bastar para mantener las reacciones de fusión. Sin embargo, allí estaba el Sol, con su rostro radiante y sonriente al ver el esfuerzo y las ecuaciones que decían que no podía brillar.

Dejemos aquí este proceso y digamos que, realmente, la mayoría de las veces el protón rebotará en la Barrera de Coulomb, pero de cuando en cuando la atravesará. Este es el “Efecto Túnel Cuántico”; que permite brillar a las estrellas. George Gamow, ansioso de explotar las conexiones entre la astronomía y la nueva física exótica a la que era adepto, aplicó las probabilidades cuánticas a la cuestión de la fusión nuclear en las estrellas y descubrió que los protones pueden superar la Barrera de Coulomb, o casi.

El efecto túnel cuántico se hizo cargo de los cálculos de la desalentadora predicción clásica, que establecia la fusión de los protones a sólo una milésima de la tasa necesaria para explicar la energía liberada por el Sol, y la elevó a una décima de la tasa necesaria. Luego se tardó menos de un año para dar cuenta del deficit restante: la solución fue completada en 1929, cuando Robert Atkinson y Fritz Houterman combinaron los hallazgos de Gamow con lo que se ha llamado teoría maxwelliana de la distribución de velocidades. En la distribución maxwelliana hay siempre unas pocas partículas que se mueven mucho más rápidamente que la media y, Robert Atkinson y Fritz Houterman hallaron que estas pocas partículas veloces bastqaban para compensar la diferencia. Finalmente se hizo claro como podía romperse la Barrera de Coulomb suficientemente a menudo para que la fusión nuclear se produjese en las estrellas.

Pero la figura clave en todos estos desarrollos fue Hans Bhete, un refugiado de la Alemania nazi que había estudiado con Fermi en Roma y fue a enseñar en Cornell en EE. UU. Como su amigo Gamow, el joven Bhete era un pensador efervescente y vivaz, con tanto talento que parecía hacer su trabajo como si de un juego se tratara. Aunque no preparado en Astronomía, Bhete era un estudioso de legendaria rapidez. En 1938 ayudó al discipulo de Gamow y Edward Teller, C.L. Critchfield, a calcular una reacción que empezase con la colisión de dos protones podía generar aproximadamente la energía irradiada por el Sol, 3,86 x 1033 ergios por segundo. Así, en un lapso de menos de cuarenta años, la humanidad había progresado de la ignorancia de la existencia misma de los átomos a la comprensión del proceso de fusión termonuclear primaria que suministra energía al Sol.

Pero la reacción protón. protón no era bastante energética para explicar la luminosidad muy superior de estrellas mucho más grandes que el Sol, estrellas como las supergigantes azules de las Pléyades, que ocupan las regiones más altas del diagrama de Herptzsprung-Russell. Bhete puso remedio a esto antes de que terminase aquel el año 1938.

En abril de 1938, Bhete asistió a una conferencia organizada por Gamow y Teller que tenía el objeto de que físicos y astrónomos trabajaran juntos en la cuestión de la generación de energía en las estrellas. “Allí, los astrofísicos nos dijeron a los físicos todo que sabían sobre la constitución interna de las estrellas -recordoba Bhete-. esto era mucho (aunque) habían obtenido todos los resultados sin conocimiento de la fuente específica de energía.” De vuelta a Cornell, Bhete abordó el problema con celeridad y, en cuestión de semanas logró identificar el ciclo del Carbono, la reacción de fusión crítica que da energía a las estrellas que tiene más de una vez y media la masa del Sol.

Bhete que estaba falto de dinero, retiró el artículo que escribió sobre sus hallazgos y que ya tenía entragado en la Revista Physical Review, para entregarlo en un Concurso postulado por la Academía de Ciencias de Nueva York sobre la producción de energía en las estrellas. Por supuesto, Bhete ganó el primer Premio uy se llevó los 500 dolares que le sirvieron para que su madre pudiera emigrar a EE UU. Después lo volvió a llevar a la Revista que lo publicó y, finalmente, se lo publicaron y tal publicación le hizo ganar el Nobel. Por un tiempo, Bhete había sido el único humano que sabía por qué brillan las estrellas.

Cuando miramos al cielo y podemos contemplar extasiados esas maravillas que ahí arriba, en el espacio interestelar están brillando, y, nos da la sensación de que están hacièndonos guiños, como si quisieran mandarnos un mensaje, decirnos algo y nosotros, no pensamos en todo lo que ahí, en esos “puntitos brillantes” se está fraguando. De lo que allí ocurre, depende que los mundos tengan los materiales que en ellos están presentes y, de entre esos materiales, se destacan aquellos que por su química biológica, permiten que se pueda formar la vida a partir de unos elementos que se hiceron en los hornos nucleares de las estrellas.

Con la excepción del Sol, las estrellas están tan lejos de nosotros que, aún mirando a través de un telescopio, aparecen como un pequeño punto de luz en el espacio. Cuando observamos las estrellas, la turbulencia en la atmósfera refracta la luz que emana de ésta en direcciones diferentes. Esto hace que las estrellas parezcan estar cambiando de iluminación y de posición, lo que le da ese efecto titilante.

Y sí, es curioso que, mirando en la oscura noche como brillan las estrellas del cielo, nos atrae su titilar engañoso (es la atmósfera terrestre la que hace que lo parezca) y su brillo, Sin embargo, pocos llegan a pensar en lo que verdaderamente está allí ocurriendo. Las transformaciones de fase por fusión no cesan. Esta transformación de materia en energía es consecuencia de la equivalencia materia-energía, enunciada por Albert Einstein en su famosa fórmula E=mc2; donde E es la energía resultante, m es la masa transformada en energía, y c es la velocidad de la luz (300 000 kilómetros por segundo). La cantidad de energía que se libera en los procesos de fusión termonuclear es fabulosa.

Un gramo de materia transformado íntegramente en energía bastaría para satisfacer los requerimientos energéticos de una familia mediana durante miles de años. Sería impensable hoy, que pudiéramos vivir en una casa sin iluminación artificial para que nos suministre toda la energía que necesitamos para las diferentes actividades que, durante la jornada desarrollamos.

Es un gran triunfo del ingenio humano el saber de qué, están confomadas las estrellas y qué materiales se están forjando allí, al inmenso calor de sus núcleos. Recuerdo aquí a aquel Presidente de la Real Society de Londres que, en una reunión multitudinaria, llegó a decir: “Una cosa está clara, nunca podremos saber de qué están hechas las estrellas”. El hombre se vistió de gloria con la, desde entonces, famosa frase. Creo que nada, con tiempo por delante, será imposible para nosotros.

El Sol se comporta prácticamente como un cuerpo negro, el cual emite energía siguiendo la ley de Planck a la temperatura media de 6.000 K. La radiación solar se distribuye desde el infrarrojo hasta el ultravioleta. No toda la radiación alcanza la superficie de laTierra, porque las ondas ultravioletas más cortas son absorbidas por los gases de la atmósfera. La magnitud que mide la radiación solar que llega a la Tierra es la irradiancia, que mide la potencia que por unidad de superficie alcanza a la Tierra. Su unidad es el W/m2 (vatio por metro cuadrado).

A nuestro planeta sólo llega una ínfima fracción del calor que se genera en el Sol y, sin embargo, es más que suficiente para mantener aquí la vida. El Sol tiene materia que supone la misma que tendrían 300.000 Tierras. Nuestra estrella madre está situada a una UA (150 millones de kilómetros de nosotros) y, todas esas circunstancias y otras muchas, hacen que todo sea tal como lo vemos a nuestro alrededor. Si cualquiera de esos parámetros fuera diferente o variara tan sólo unas fracciones, seguramente la Tierra sería un planeta muerto y, nosotros, no estaríamos aquí. Sin embargo… ¡Estamos! y, gracias a ello, se pueden producir descubrimientos como los que más arriba hemos relatado y han podido y pueden existir personajes de cuyas mentes surgen ideas creadoras que nos llevan a saber cómo son las cosas.

Lo cierto es que, cada día sabemos mejor como funciona ma Naturaleza que, al fin y al cabo, es la que tiene todas las respuestas que necesitamos conocer.

emilio silvera

Totales: 67.400.429

Totales: 67.400.429 Conectados: 25

Conectados: 25