Jul

2

Hay que recorrer un largo camino para saber

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El saber: ¡Ese viaje interminable! ~

Clasificado en El saber: ¡Ese viaje interminable! ~

Comments (0)

Comments (0)

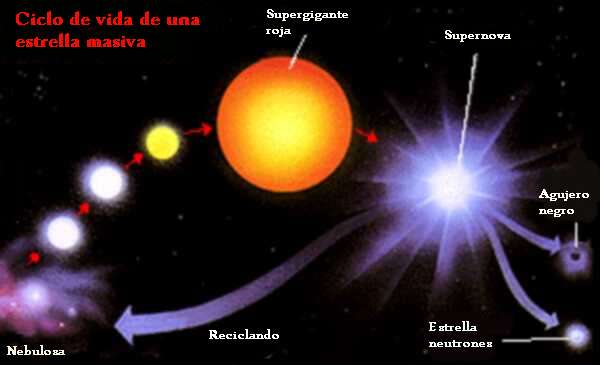

“La masa con la que nace una estrella determina su historia y, sobre todo, la duración de su vida. Llamamos estrellas masivas a todas aquellas estrellas aisladas que explotan como supernovas al final de su existencia debido al colapso gravitatorio. Para que exploten como supernovas deben tener un mínimo de alrededor de ocho masas solares. Estrellas con menos masa pueden explotar, pero no por sí mismas (deben darse otras condiciones). Y hay parámetros secundarios que pueden introducir cambios, pero la masa es determinante.”

“En cuanto al máximo, el límite está en lo que la naturaleza sea capaz de producir. Hasta hace poco se creía que este límite estaba en torno a monstruos de 150 masas solares, aunque recientes trabajos lo elevan hasta 300. No obstante, no es un dato seguro ya que, cuanto más masiva es una estrella, menos vive, con lo cual estrellas más grandes serían difíciles de observar.”

Verdaderamente si pudiéramos contemplar de cerca, el comportamiento de una estrella cuando llega el final de su vida, veríamos como es, especialmente intrigante las transiciones de fase de una estrella en implosión observada desde un sistema de referencia externo estático, es decir, vista por observadores exteriores a la estrella que permanecen siempre en la misma circunferencia fija en lugar de moverse hacia adentro con la materia de la estrella en implosión. La estrella, vista desde un sistema externo estático, empieza su implosión en la forma en que uno esperaría. Al igual que una pesada piedra arrojada desde las alturas, la superficie de la estrella cae hacia abajo (se contrae hacia adentro), lentamente al principio y luego cada vez más rápidamente. Si las leyes de gravedad de Newton hubieran sido correctas, esta aceleración de la implosión continuaría inexorablemente hasta que la estrella, libre de cualquier presión interna, fuera aplastada en un punto de alta velocidad. Pero no era así según las fórmulas relativistas que aplicaron Oppenheimer y Snyder. En lugar de ello, a medida que la estrella se acerca a su circunferencia crítica su contracción se frena hasta hacerse a paso lento. Cuanto más pequeña se hace la estrella, más lentamente implosiona, hasta que se congela exactamente en la circunferencia crítica y, dependiendo de su masa, explosiona como supernova para formar una inmensa nebulosa o, se tranforma en nebulosa planetaria, más pequeña.

Ahí podemos observar a una estrella muy joven, de dos o tres millones de años que, en un futuro lejano será una gran Supernova. Los procesos que podríamos observar al final de la vida de una estrella gigante… ¡Son fascinantes!

En la escena que antes explicabámos, por mucho tiempo que nos quedemos esperando y comtemplando el suceso, si uno está en reposo fuera de la estrella (es decir, en reposo en el sistema de referencia externo estático), uno nunca podrá ver que la estrella implosiona a través de la circunferencia crítica. Ese fue el mensaje inequívoco que Oppenheimer y Snyder nos enviaron. Para poder ver eso, habría que estar dentro de la estrella, instalado en la materia que está sufriendo la contracción y, no sabemos porque eso es así.

¿Se debe esta congelación de la implosión a alguna fuerza inesperada de la relatividad general en el interior de la estrella? No, en absoluto, advirtieron Oppenheimer y Snyder. Más bien se debe a la dilatación gravitatoria del tiempo (el frenado del flujo del tiempo) cerca de la circunferencia crítica. Tal como lo ven los observadores estáticos, el tiempo en la superficie de la estrella en implosión debe fluir cada vez más lentamente cuando la estrella se aproxima a la circunferencia crítica; y, consiguientemente, cualquier cosa que ocurre sobre o en el interior de la estrella, incluyendo su implosión, debe aparecer como si el movimiento se frenara poco a poco hasta congelarse.

Por extraño que esto pueda parecer, aún había otra predicción más extrañas de las fórmulas de Oppenheimer y Snyder: si bien es cierto que vista por observadores externos estáticos la implosión se congela en la circunferencia crítica, no se congela en absoluto vista por los observadores que se mueven hacia adentro con la superficie de la estrella. Si la estrella tiene una masa de algunas masas solares y empieza con un tamaño aproximado al del Sol, entonces vista desde su propia superficie implosiona hacia la circunferencia crítica en aproximadamente una hora, y luego sigue implosionando más allá de la criticalidad hacia circunferencias más pequeñas.

Allá por el año 1939, cuando Oppenheimer y Snyder descubrieron estas cosas, los físicos ya se habían acostumbrados al hecho de que el tiempo es relativo; el flujo del tiempo es diferente medido en diferentes sistemas de referencia que se mueven de diferentes formas a través del Universo. Claro que, nunca antes había encontrado nadie una diferencia tan extrema entre sistemas de referencia. Que la implosión se congele para siempre medida en el sistema externo estático, pero continúe avanzando rápidamente superando al punto de congelación medida en el sistema desde la superficie de la estrella era extraordinariamente difícil de comprender. Nadie que estudiara las matemáticas de Oppenheimer y Snyder se sentía cómodo con semejante distorsión extrema del tiempo. Pero ahí estaba, en sus fórmulas. Algunos podían agitar sus brazos con explicaciones heurísticas, pero ninguna explicación parecía muy satisfactoria. No sería completamente entendido hasta finales de los cincuenta.

Fue Wheeler el que discrepó del trabajo de Oppenheimer y Snyder, alegando, con toda la razón que, cuando ellos habían realizado su trabajo, habría sido imposible calcular los detalles de la implosión con una presión realista (presión térmica, presión de degeneración y presión producida por la fuerza nuclear), y con reacciones nucleares, ondas de choque, calor, radiación y expulsión de masa. Sin embargo, los trabajos desde las armas nucleares de los veinte años posteriores proporcionaron justamente las herramientas necesarias.

Presión, reacciones nucleares, ondas de choque, calor radiación y expulsión de masa eran todas ellas características fundamentales de una bomba de hidrógeno; sin ellas, una bomba no explosionaría. A finales de los años cincuenta, Stirling Colgate quedó fascinado por el problema de la implosión estelar. Con el apoyo de Edward Teller, y en colaboración con Richard White y posteriormente Michael May, Colgate se propuso simular semejante implosión en un ordenador. Sin embargo, cometieron un error, mantuvieron algunas de las simplificaciones de Oppenheimer al insistir desde el principio en que la estrella fuera esférica y sin rotación, y, aunque tuvieron en cuenta todos los argumentos que preocupaban a Wheeler, aquello no quedó perfeccionado hasta después de varios años de esfuerzo y, a comienzo de los años sesenta ya estaban funcionando correctamente.

Un día a principio de los años sesenta, John Wheeler entró corriendo en la clase de relatividad de la Universidad de Princeton. Llegaba un poco tarde, pero sonreía con placer. Acababa de regresar de una visita a Livermore donde había visto los resultados de las simulaciones recientes de Colgate y su equipo. Con excitación en su voz dibujó en la pizarra un diagrama tras otro explicando lo que sus amigos de Livermore habían aprendido.

Cuando la estrella en implosión tenía una masa pequeña, desencadenaba una implosión de supernova y formaba una estrella de neutrones precisamente en la forma que Fritz Wicky había especulado treinta años antes. Sin embargo, si la estrella original era más masiva lo que allí se producía (aparte de la explosión supernova) era un agujero negro notablemente similar al altamente simplificado modelo que veinticinco años calcularon Oppenheimer y Snyder. Vista desde fuera, la implosión se frenaba y se quedaba congelada en la circunferencia crítica, pero vista por alguien en la superficie de la estrella, la implosión no se congelaba en absoluto. La superficie de la estrella se contraía a través de la circunferencia crítica y seguía hacia adentro sin vacilación.

Lo cierto fue que allí, por primera vez, se consiguió simular por ordenador la implosión que debía producir agujeros negros. Está claro que la historia de todo esto es mucho más larga y contiene muchos más detalles que me he saltado para no hacer largo el trabajo que, en realidad, sólo persigue explicar a ustedes de la manera más simple posible, el trabajo que cuesta obtener los conocimientos que no llegan (casi nunca) a través de ideas luminosas, sino que, son el resultado del trabajo de muchos.

Hoy, sabemos mucho más de cómo finaliza sus días una estrella y, dependiendo de su masa, podemos decir de manera precisa que clase de Nebulosa formará, que clase de explosión (si la hay) se producirá, y, finalmente, si el resultado de todo ello será una estrella enana blanca que encuentra su estabilidad final por medio del Principio de exclusión de Pauli (en mecánica cuántica)que se aplica a los fermiones pero no a los Bosones (son fermiones los quarks, electrones, protones y neutrones), en virtud del cual dos partículas idénticas en un sistema, como los electrones en un átomo o quarks en un hadrón (protón o neutrón, por ejemplo), no pueden poseer un conjunto idéntico de números cuánticos.

La estrella azul cerca del centro de esta imagen es Zeta Ophiuchi. Cuando se ve en luz visible aparece como una estrella roja relativamente débil rodeada de otras estrellas tenues y sin polvo. Sin embargo, en esta imagen infrarroja tomada con campo amplio por el Explorador Infrared Survey de la NASA, o WISE, un punto de vista completamente diferente emerge. Zeta Ophiuchi es en realidad una muy masiva y caliente estrella azul, brillante que traza su camino a través de una gran nube de polvo y gas interestelar.

Una estrella masiva alejándose de su antiguo compañero se manifiesta haciendo un imponente surco a través de polvo espacial, como si se tratase de la proa de un barco. La estrella, llamada Zeta Ophiuchi, es enorme, con una masa de cerca de 20 veces la de nuestro Sol. En esta imagen, en los que se ha traducido la luz infrarroja a colores visibles que vemos con nuestros ojos, la estrella aparece como el punto azul en el interior del arco de choque. Zeta Ophiuchi orbitó una vez alrededor de una estrella aún más grande. Pero cuando la estrella explotó en una supernova, Zeta Ophiuchi se disparó como una bala. Viaja a la friolera velocidad de 24 kilómetros por segundo arrastrando con ella un conglomerado de polvo que distorsiona la región por la que pasa.

Mientras la estrella se mueve través del espacio, sus poderosos vientos empujan el gas y el polvo a lo largo de su camino en lo que se llama un arco de choque. El material en el arco de choque está tan comprimido que brilla con luz infrarroja que WISE puede captar. El efecto es similar a lo que ocurre cuando un barco cobra velocidad a través del agua, impulsando una ola delante de él. Esta onda de choque queda completamente oculta a la luz visible. Las imágenes infrarrojas como esta son importantes para arrojar nueva luz sobre lo que ocurre en situaciones similares.

Pero, siguiendo con el tema de las implosiones de las estrellas, ¿cuál es la razón por la que la materia no se colapsa, totalmente, sobre sí misma? El mismo principio que impide que las estrellas de neutrones y las estrellas enanas blancas implosionen totalmente y que, llegado un momento, en las primeras se degeneran los neutrones y en las segundas los electrones, y, de esa manera, se frena la compresión que producía la gravedad y quedan estabilizadas gracias a un principio natural que hace que la materia normal sea en su mayor parte espacio vacio también permite la existencia de los seres vivos. El nombre técnico es: El Principio de Exclusión de Pauli y dice que dos fermiones (un tipo de partículas fundamentales) idénticos y con la misma orientación no pueden ocupar simultáneamente el mismo lugar en el espacio. Por el contrario, los bosones (otro tipo de partículas, el fotón, por ejemplo) no se comportan así, tal y como se ha demostrado recientemente por medio de la creación en el laboratorio de los condensados de Bose-Einstein.

¿Cuál es la diferencia?

Los bosones son sociables; les gusta estar juntos. Como regla general, cualquier átomo con un número par de electrones+protones+neutrones es un bosón. Así, por ejemplo, los átomos del sodio ordinario son bosones, y pueden unirse para formar condensados Bose-Einstein.

Los bosones son sociables; les gusta estar juntos. Como regla general, cualquier átomo con un número par de electrones+protones+neutrones es un bosón. Así, por ejemplo, los átomos del sodio ordinario son bosones, y pueden unirse para formar condensados Bose-Einstein.

Izquierda: Los bosones son sociables; los fermiones son antisociales.

Los fermiones, por otro lado, son antisociales. No pueden juntarse en el mismo estado cuántico (por el Principio de Exclusión de Pauli de la mecánica cuántica). Cualquier átomo con un número impar de electrones+protones+neutrones, como el potasio-40, es un fermión.

Pero, estábamos diciendo: “…no pueden poseer un conjunto idéntico de números cuánticos.” A partir de ese principio, sabemos que, cuando una estrella como nuestro Sol deja de fusionar Hidrógeno en Helio que hace que la estrella deje de expandirse y quede a merced de la Gravedad, ésta implosionará bajo el peso de su propia masa, es decir, se contraerá sobre sí misma por la fuerza gravitatoria pero, llegará un momento en el cual, los electrones, debido a ese principio de exclusión de Pauli que les impide estar juntos, se degeneran y se moverán de manera aleatoria con velocidades relativista hasta el punto de ser capaces de frenar la fuerza provocada por la gravedad, y, de esa manera, quedará estabilizada finalmente una estrella enana blanca.

Si hablamos de una estrella supermasiva, su produce la implosión arrojando las capas externas al espacio interestelar mientras que el grueso de la estrella se comprime más y más sin que nada la pueda frenar, aquí no sirve el Principipo de exclusión de Pauli para los fermiones y, es tal la fuerza gravitatoria que se desencadena como consecuencia de que la estrella supergigante no puede seguir fusionando y queda a merce4d de una sola fiuerza: La Gravedad, que ésta, la comprime hasta lo inimaginable para convertir toda aquella ingente masa en una singularidad, es decir, un punto de densidad y energía “infinitas” que ni la luz puede escapar de allí, y, el tiempo se ralentiza y el espacio se curva a su alrededor.

Si la estrella original es más masiva, la degeneración de los electrones no será suficiente para frenar la fuerza gravitatoria y, los electrones se fusionaran con los protones para convertirse en neutrones que, bajo el mismo principio de exclusión sufrirán la degeneración que frenará la fuerza de gravedad quedando entonces una estrella de neutrones. Por último, si la estrella es, aún más masiva, ni la degeneración de los neutrones será suficiente para frenar la inmensa fuerza gravitatoria generada por la masa de la estrella que, continuará la implosión contrayéndose cada vez más hasta desaparecer de nuestra vista convertida en un agujero negro.

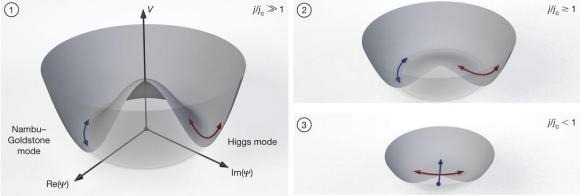

¿Qué forma adoptará, qué transición de fase se produce en la materia dentro de una Singularidad?

¡Resulta todo tan complejo!

emilio silvera

Jul

2

Cosas de la Fisica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

- Noticias

Mecánica cuántica

Las propiedades de los bosones y el misterio del helio líquido

Hallan una nueva explicación de por qué el helio no solidifica.

Physical Review Letters

Como es bien sabido, cualquier líquido se congela sí se enfría lo suficiente. Por debajo de cierta temperatura los átomos apenas vibran, por lo que acaban formando un empaquetamiento denso en el que cada átomo ocupa una posición casi fija en el espacio. Esta regla solo conoce una excepción: el helio. A menos que se comprima, el helio 4 permanece en fase líquida incluso a cero grados Kelvin.

- A temperaturas cercanas al cero absoluto, el helio se vuelve superfluido: un líquido de viscosidad nula que se desliza sin fricción sobre cualquier superficie. Sin embargo, no solidifica. [VUERQEX]

Hasta hoy se pensaba que esa propiedad se debía a la «energía del punto cero». Debido a las leyes de incertidumbre cuánticas, ningún sistema físico puede alcanzar un estado de energía nula; en el caso del helio, se pensaba que dicha energía mínima sería tan elevada que impediría que sus átomos adoptasen una disposición cristalina. Ahora, sin embargo, un artículo publicado en Physical Review Letters acaba de echar por tierra esta explicación. Según los autores, la verdadera razón para que el helio no solidifique se debe al carácter bosónico de sus átomos.

El helio 4 es un átomo «casi perfecto» cuyo núcleo y corteza muestran simetría esférica. Su núcleo posee espín total igual a cero, por lo que es un bosón, al igual que el átomo neutro. Al contrario que los fermiones, los bosones se caracterizan porque muchos de ellos pueden ocupar a la vez un mismo estado cuántico. Ello se debe que dos bosones son partículas completamente indistinguibles desde cualquier punto de vista: la función de onda de dos bosones permanece idéntica cuando se intercambian uno y otro, mientras que la de dos fermiones cambia de signo.

En la práctica ello implica que los átomos de helio continuarán entremezclándose con gran facilidad (es decir, casi sin ningún coste energético) incluso a temperaturas muy bajas, lo cual impedirá que la sustancia cristalice. El caso del helio 4 es el más obvio, pero el trabajo de Massimo Boninsegni, de la Universidad de Alberta, y sus colaboradores va más alla, pues ilustra la importancia general que ejerce la estadística de Bose-Einstein en el diagrama de fases de una sustancia.

Más información en Physical Review Letters. Artículo técnico disponible en arXiv.

Jul

1

¡La Física! Siempre presente

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (3)

Comments (3)

Si tratamos de saber… Alejamos de nosotros la ihgnorancia y el asombro

Todo comienza siendo una cosa y con el tiempo, se transforma en otra diferente: Evolución por la energía. En el universo en que vivimos, nada desaparece; con el tiempo se cumplen los ciclos de las cosas y se convierten en otra distinta, es un proceso irreversible que podemos contemplar a nuestro alrededor con el paso del tiempo se van cumpliendo las fases, y, no necesarimente siempre son de desgaste y envejecimiento, sino que, otras son de creación y resurgimiento. Cuando las estrellas masivas viejas esplotan en Supernovas, el espacio interetelar queda ocupado, en grandes regiones, por una nube enorme que, a veces, abarca varios años luz. El tiempo transcurre y, de esos restos de estrella “muerta”, con ayuda de la gravedad, nacen nuevas estrellas. Es la entropía negativa que lucha contra aquella otra que todo lo quiere destruir. Nosotros, de alguna manera, hacemos lo mismo con la descendencia.

El gas y el polvo se transforma en una brillante estrella que vive diez mil millones de años y termina en Nebulosa planeta con una enana blanca en el centro. Entonces la estrella que tenía un diámetro de 1.500 km, se reduce hasta unas pocas decenas, 20 0 30 Km y, su densidad, es inmensa, emitiendo radiación ultravioleta durante mucjho tiempo hasta que se enfría y se convierte en un cadáver estelar.

En lo concerniente a cambios y transformaciones, el que más me ha llamado siempre la atención es el de las estrellas que se forman a partir de gas y polvo cósmico. Nubes enormes de gas y polvo se van juntando. Sus moléculas cada vez más apretadas se rozan, se ionizan y se calientan hasta que en el núcleo central de esa bola de gas caliente, la temperatura alcanza millones de grados. La enorme temperatura posible la fusión de los protones y, en ese instante, nace la estrella que brillará miles de millones de años y dará luz y calor. Su ciclo de vida estará supeditado a su masa. Si la estrella es supermasiva, varias masas solares, su vida será más corta, ya que consumirá el combustible nuclear de fusión (hidrógeno, helio, litio, oxígeno, etc) con más voracidad que una estrella mediana como nuestro Sol, de vida más duradera.

Una estrella, como todo en el universo, está sostenida por el equilibrio de dos fuerzas contrapuestas; en caso, la fuerza que tiende a expandir la estrella (la energía termonuclear de la fusión) y la fuerza que tiende a contraerla (la fuerza gravitatoria de su propia masa). Cuando finalmente el proceso de fusión se detiene por agotamiento del combustible de fusión, la estrella pierde la fuerza de expansión y queda a merced de la fuerza de gravedad; se hunde bajo el peso de su propia masa, se contrae más y más, y en el caso de estrellas súper masivas, se convierten en una singularidad, una masa que se ha comprimido a tal extremo que acaba poseyendo una fuerza de gravedad de una magnitud difícil de imaginar el común de los mortales.

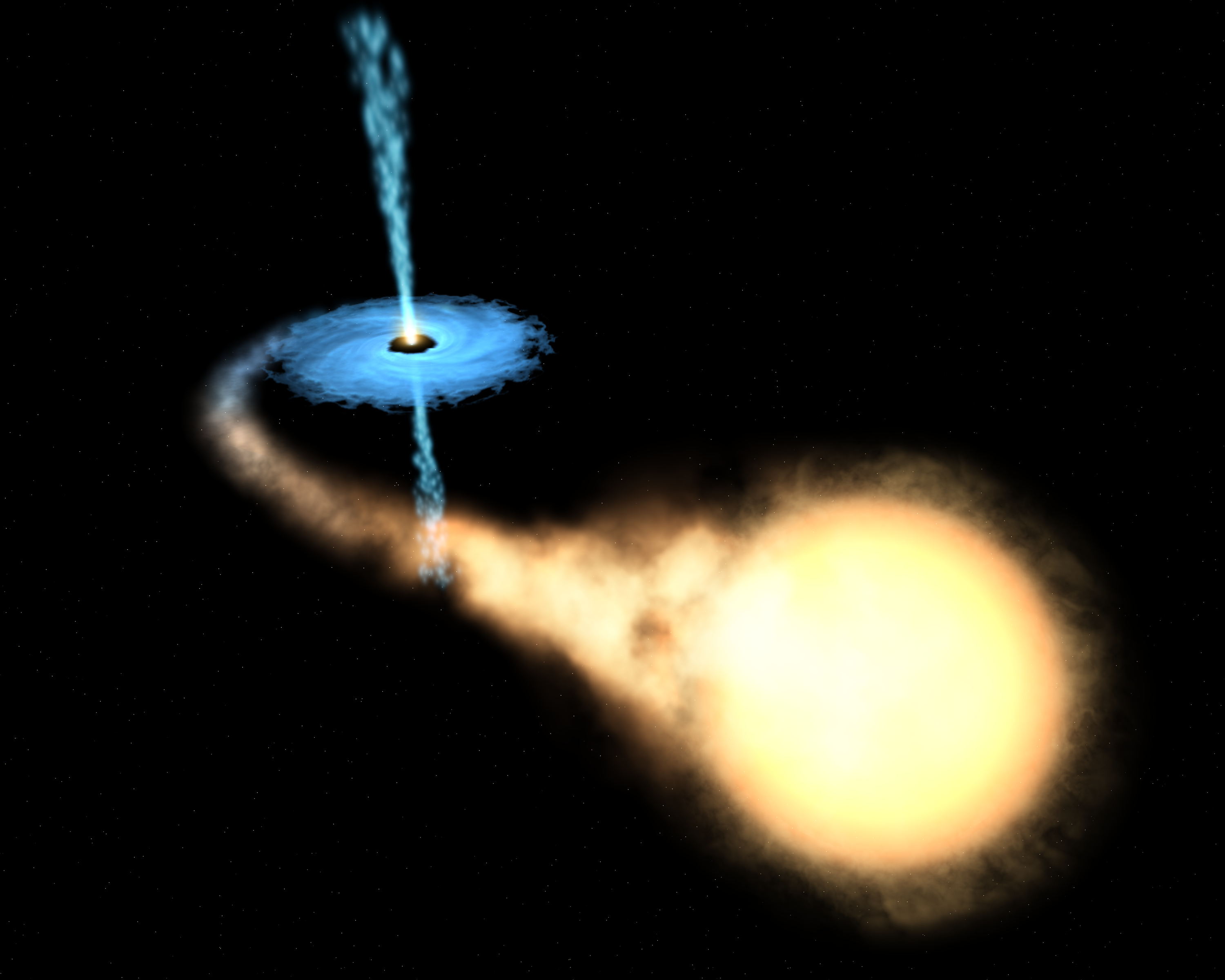

La singularidad con su inmensa fuerza gravitatoria atrae a la estrella vecina

La Tierra, un objeto minúsculo en comparación con esos objetos súper masivos estelares, genera una fuerza de gravedad que, para escapar de ella, una nave o cohete espacial tiene que salir disparado la superficie terrestre a una velocidad de 11’18 km/s; el sol exige 617’3 km/s. Es lo que se conoce como velocidad de escape, que es la velocidad mínima requerida escapar de un campo gravitacional que, lógicamente, aumenta en función de la masa del objeto que la produce. El objeto que escapa puede ser una cosa cualquiera, desde una molécula de gas a una nave espacial. La velocidad de escape de un cuerpo está dada por , donde G es la constante gravitacional, M es la masa del cuerpo y R es la distancia del objeto que escapa del centro del cuerpo. Un objeto que se mueva con una velocidad menor que la de escape entra en una órbita elíptica; si se mueve a una velocidad exactamente igual a la de escape, sigue una órbita , y si el objeto supera la velocidad de escape, se mueve en una trayectoria hiperbólica y rompe la atadura en que la mantenía sujeto al planeta, la estrella o el objeto que emite la fuerza gravitatoria.

La mayor velocidad que es posible alcanzar en nuestro universo es la de la luz, c, velocidad que la luz alcanza en el vacío y que es de 299.793’458 km/s.

Sí, se pudo confirmar que los neutrinos respetan la supremacía el fotón, y la luz, sigue siendo la más rápida del Universo. Y sin embargo, no escapar de la atracción de un A.N.

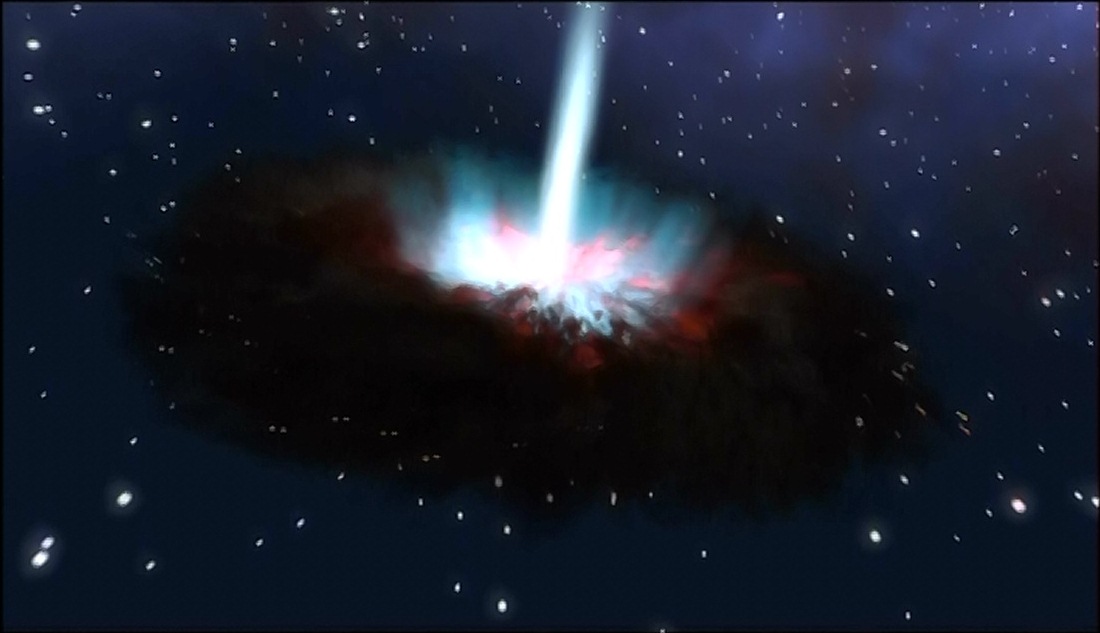

Pues bien, es tal la fuerza de gravedad de un agujero negro que ni la luz puede escapar de allí; la singularidad la absorbe, la luz desaparece en su interior, de ahí su nombre de , agujero negro, la estrella supermasiva se contrae, llega a un punto que desaparece de nuestra vista. De acuerdo con la relatividad general, cabe la posibilidad de que una masa se comprima y reduzca sin límites su tamaño y se auto confine en un espacio infinitamente pequeño que encierre una densidad y una energía infinitos. Allí, el espacio y el tiempo dejan de existir.

Las singularidades ocurren en el Big Bang, en los agujeros negros y en el Big Crunch (que se podría considerar una reunión de todos los agujeros negros generados por el paso del tiempo en el universo y que nos llevará a un fin que será el comienzo).

Las singularidades de los agujeros negros están rodeados por una circunferencia invisible a su alrededor que marca el límite de su influencia. El objeto que traspasa ese límite es atraído, irremisiblemente, la singularidad que lo engulle, sea una estrella, una nube de gas o cualquier otro objeto cósmico que ose traspasar la línea que se conoce como horizonte de sucesos del agujero negro.

La existencia de los agujeros negros fue deducida por Schwarzschild, en el año 1.916, a partir de las ecuaciones de Einstein de la relatividad general. Este astrónomo alemán predijo su existencia, pero el de agujero negro se debe a Wehleer.

Señalamos la singularidad del Big Bang pero… ¿fue así?

Así, el conocimiento de la singularidad está dado por las matemáticas de Einstein y más tarde por la observación de las señales que la presencia del agujero generan. Es una fuente emisora de rayos X que se producen al engullir materia que traspasa el horizonte de sucesos y es atrapada la singularidad, donde desaparece siempre sumándose a la masa del agujero cada vez mayor.

En el centro de nuestra galaxia, la Vía Láctea, ha sido detectado un enorme agujero negro, ya muy famoso, llamado Cygnus X-1.

Después de todo, la velocidad de la luz, la máxima del universo, no vencer la fuerza de gravedad del agujero negro que la tiene confinada para siempre.

En nuestra galaxia, con cien mil años luz de diámetro y unos doscientos mil millones de estrellas, ¿cuántos agujeros negros habrá?

Para mí, la cosa está clara: el tiempo es imparable, el reloj cósmico sigue y sigue andando sin que nada lo pare, miles o cientos de miles, millones y millones de estrellas súper masivas explotarán en brillantes supernovas para convertirse en temibles agujeros negros.

Llegará un momento que el de agujeros negros en las galaxias será de tal magnitud que comenzarán a fusionarse unos con otros que todo el universo se convierta en un inmenso agujero negro, una enorme singularidad, lo único que allí estará presente: la gravedad.

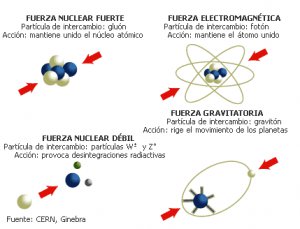

Esa fuerza de la naturaleza que está sola, no se puede juntar con las otras fuerzas que, como se ha dicho, tienen sus dominios en la mecánica cuántica, mientras que la gravitación residen en la inmensidad del cosmos; las unas ejercen su dominio en los confines microscópicos del átomo, mientras que la otra sólo aparece de manera significativa en presencia de grandes masas estelares. Allí, a su alrededor, se aposenta curvando el espacio y distorsionando el tiempo.

Esa reunión final de agujeros negros será la causa de que la Densidad Crítica sea superior a la ideal. La gravedad generada por el inmenso agujero negro que se irá formando en cada galaxia tendrá la consecuencia de parar la expansión actual del universo. Todas las galaxias que ahora están separándose las unas de las otras se irán frenando parar y, despacio al principio pero más rápido después, comenzarán a recorrer el camino hacia atrás. Finalmente, toda la materia será encontrada en un punto común donde chocará violentamente formando una enorme bola de fuego, el Big Crunch, que como sabéis, es sólo una de las variadas teorías del final del universo.

Claro que, antes de que eso llegue, tendremos que resolver el primer problema: La visita de Andrómeda, la salida de la Tierra de la Zona habitable, o, la muerte del Sol que se convertirá en una gigante roja primero y en una nebulosa planetaria con una estrella enana blanca en el centro después.

Los científicos se han preguntado a veces qué sucederá eventualmente a los átomos de nuestros cuerpos mucho tiempo después de que hayamos muerto. La posibilidad más probable es que nuestras moléculas vuelvan al Sol. En páginas anteriores he explicado el destino del Sol: se agotará su combustible de hidrógeno y fusionará helio; se hinchará en gigante roja y su órbita es probable que sobrepase la Tierra y la calcine; las moléculas que hoy constituyen nuestros cuerpos serán consumidas por la atmósfera solar.

Carl Sagan pinta el cuadro siguiente:

“Dentro de miles de millones de años a partir de , habrá un último día perfecto en la Tierra… Las capas de hielo Ártica y Antártica se fundirán, inundando las costas del mundo. Las altas temperaturas oceánicas liberarán más vapor de agua al aire, incrementando la nubosidad y escondiendo a la Tierra de la luz solar retrasando el final. Pero la evolución solar es inexorable. Finalmente los océanos hervirán, la atmósfera se evaporará en el espacio y nuestro planeta será destruido por una catástrofe de proporciones que ni podemos imaginar.”

En una escala de tiempo de varios miles de millones de años, debemos enfrentarnos al hecho de que la Vía Láctea, en la que vivimos, morirá. Más exactamente, vivimos en el brazo espiral Orión de la Vía Láctea. miramos al cielo nocturno y nos sentimos reducidos, empequeñecidos por la inmensidad de las luces celestes que puntúan en el cielo, estamos mirando realmente una minúscula porción de las estrellas localizadas en el brazo de Orión. El resto de los 200 mil millones de estrellas de la Vía Láctea están tan lejanas que apenas pueden ser vistas como una cinta lechosa que cruza el cielo nocturno.

Aproximadamente a dos millones de años luz de la Vía Láctea está nuestra galaxia vecina más cercana, la gran galaxia Andrómeda, dos o tres veces mayor que nuestra galaxia. Las dos galaxias se están aproximando a unos 500 km/s, y chocarán en un periodo de entre 3 y 4 mil millones de años. Como ha dicho el astrónomo Lars Hernquist de la California en Santa Cruz, esta colisión será “parecida a un asalto. Nuestra galaxia será literalmente consumida y destruida“. Aunque, lo cierto es que aunque en el choque algo se detruya, lo cierto es que todo quedará en forma de una galaxia mucho mayor.

Así las cosas, no parece que la Humanidad del futuro lo tenga nada fácil. Primero tendrá que escapar, dentro de unos 4.000 millones de años del gigante rojo en que se convertirá el Sol que calcinará al planeta Tierra. Segundo, en unos 10.000 millones de años, la escapada tendrá que ser aún más lejana; la destrucción será de la propia galaxia que se fusionará con otra mayor sembrando el caos cósmico del que difícilmente se podría escapar quedándonos aquí. Por último, el final anunciado, aunque más largo tiempo, es el del propio universo que, por congelación o fuego, tiene los eones contados.

Por todas estas catástrofes anunciadas por la ciencia, científicos como Kip S. Thorne y Stephen Hawking sugieren a otros universos paralelos a través de agujeros de gusano en el hiperespacio. Sería la única puerta de salida para que la Humanidad no se destruyera.

Si lo alcanzaremos o no, es imposible de contestar, no tenemos los necesarios para ello. Incluso se podría decir que aparte de estas catástrofes futuras que sabemos a ciencia cierta que ocurrirán, seguramente existan otras que están ahí latentes en la incertidumbre de si finalmente ocurren o no, sólo pendiente de decidir lo uno o lo otro por parámetros ocultos que no sabemos ni que puedan existir.

En esta situación de impotencia, de incapacidad física e intelectual, nos tenemos que dar y admitir que, verdaderamente, comparados con el universo y las fuerzas que lo rigen, somos insignificantes, menos que una mota de polvo flotando en el haz de luz que entra, imparable, por la ventana entre-abierta de la habitación.

Sin embargo, tampoco es así. Que se sepa, no existe ningún otro grupo inteligente que esté capacitado tratar de todas estas cuestiones. Que la especie humana sea consciente de dónde vino y hacia dónde va, en verdad tiene bastante mérito, y más, si consideramos que nuestro origen está a partir de materia inerte evolucionada y compleja que, un día, hace probablemente miles de millones de años, se fraguó en estrellas muy lejanas.

A finales de los 60, un joven físico italiano, Gabriele Veneziano, buscaba un grupo de ecuaciones que explicara la fuerza nuclear fuerte. Este pegamento tan fuerte que mantenía unidos los protones y neutrones del núcleo de cada átomo. Parece ser que por casualidad se encontró con un libro antiguo de matemáticas y en su interior encontró una ecuación de más de 200 años de antigüedad creada por un matemático suizo llamado Leonhard Euler. Veneziano descubrió con asombro que las ecuaciones de Euler, consideradas desde siempre una simple curiosidad matemática, parecían describir la fuerza nuclear fuerte. Después de un año de de profundos estudios, experimentos, intuición e imaginación, se podría decir que elaboraron la Teoría de Cuerdas de manera fortuita.

Tras circular entre compañeros, la ecuación de Euler acabó escrita frente a Leonard Susskind, quien se retiro a su ático para investigar. Creía que aquella antigua fórmula describía matemáticamente la fuerza nuclear fuerte, pero descubrió algo nuevo. Lo primero que descubrió fue que describía una especie de partícula con una estructura interna que vibraba y que mostraba un comportamiento que no se limitaba al de una partícula puntual. Dedujo que se trataba de una cuerda, un hilo elástico, como una goma cortada por la mitad. Esta cuerda se estiraba y contraía además de ondear y coincidía exactamente con la fórmula. Susskind redactó un artículo donde explicaba el descubrimiento de las cuerdas, pero nunca llegó a publicarse.

Muchos buscaron la 5ª dimensión… ¡sin fortuna! Aquí sólo hay tres y el espacio.

Claro que, ya he comentado otras veces que la teoría de cuerdas tiene un origen real en las ecuaciones de Einstein en las que se inspiro Kaluza para añadir la quinta dimensión y perfeccionó Klein (teoría Kaluza-Klein). La teoría de cuerdas surgió a partir de su descubrimiento accidental por Veneziano y , y a partir de ahí, la versión de más éxito es la creada por los físicos de Princeton David Gross, Emil Martinec, Jeffrey Harvey y Ryan Rohm; ellos son conocidos en ese mundillo de la física teórica como “el cuarteto de cuerdas”. Ellos han propuesto la cuerda heterótica (híbrida) y están seguros de que la teoría de cuerdas resuelve el problema de “construir la propia materia a partir de la pura geometría: eso es lo que en cierto sentido hace la teoría de cuerdas, especialmente en su versión de cuerda heterótica, que es inherentemente una teoría de la gravedad en la que las partículas de materia, tanto las otras fuerzas de la naturaleza, emergen del mismo modo que la gravedad emerge de la geometría“.

La Gravedad cuántica está en algunas mentes , ¿Estará en la Naturaleza?

La característica más notable de la teoría de cuerdas ( ya he señalado), es que la teoría de la gravedad de Einstein está contenida automáticamente en ella. De hecho, el gravitón (el cuanto de gravedad) emerge como la vibración más pequeña de la cuerda cerrada, es más, si simplemente abandonamos la teoría de la gravedad de Einstein como una vibración de la cuerda, entonces la teoría se vuelve inconsistente e inútil. , de hecho, es la razón por la que Witten se sintió inicialmente atraído hacia la teoría de cuerdas.

Witten está plenamente convencido de que “todas las ideas realmente grandes en la física, están incluidas en la teoría de cuerdas“.

No entro aquí a describir el modelo de la teoría de cuerdas que está referido a la “cuerda heterótica”, ya que su complejidad y profundidad de detalles podría confundir al lector no iniciado. Sin embargo, parece justo que deje constancia de que consiste en una cuerda cerrada que tiene dos tipos de vibraciones, en el sentido de las agujas del reloj y en el sentido contrario, que son tratadas de diferente.

Las vibraciones en el sentido de las agujas de reloj viven en un espacio de diez dimensiones. Las vibraciones de sentido contrario viven en un espacio de veintiséis dimensiones, de las que dieciséis han sido compactificadas (recordemos que en la teoría pentadimensional Kaluza-Klein, la quinta dimensión se compactificaba curvándose en un circulo). La cuerda heterótica debe su al hecho de que las vibraciones en el sentido de las agujas de reloj y en el sentido contrario viven en dos dimensiones diferentes pero se combinan para producir una sola teoría de supercuerdas. Esta es la razón de que se denomine según la palabra griega heterosis, que significa “vigor híbrido”.

En conclusión, las simetrías que vemos a nuestro alrededor, el arcoiris a las flores y a los cristales, pueden considerarse en última instancia como manifestaciones de fragmentos de la teoría decadimensional original. Riemann y Einstein habían confiado en llegar a una comprensión geométrica de por qué las fuerzas pueden determinar el movimiento y la naturaleza de la materia.

La teoría de cuerdas, a partir del descubrimiento Veneziano-Suzuki, estaba evolucionando atrás buscando las huellas de Faraday, Riemann, Maxwell y Einstein poder construir una teoría de campos de cuerdas. De hecho, toda la física de partículas estaba basada en teoría de campos. La única teoría no basada en teoría de campos era la teoría de cuerdas.

De la teoría de cuerdas combinada con la supersimetría dio lugar a la teoría de supercuerdas. La cuerda es un objeto unidimensional que en nueva teoría se utiliza remplazando la idea de la partícula puntual de la teoría cuántica de campos. La cuerda se utiliza en la teoría de partículas elementales y en cosmología y se representa por una línea o lazo (una cuerda cerrada). Los estados de una partícula pueden ser producidos por ondas estacionarias a lo largo de esta cuerda.

En teoría se trata de unificar a todas las fuerzas fundamentales incorporando simetría y en la que los objetos básicos son objetos unidimensionales que tienen una escala de 10-35 metros y, como distancias muy cortas están asociadas a energías muy altas, este caso la escala de energía requerida es del orden de 1019 GeV, que está muy por encima de la que hoy en día pueda alcanzar cualquier acelerador de partículas.

antes expliqué, las cuerdas asociadas con los bosones sólo son consistentes como teorías cuánticas en un espacio-tiempo de 26 dimensiones; aquella asociadas con los fermiones sólo lo son en un espacio tiempo de 10 dimensiones. Ya se ha explicado que las dimensiones extras, además de las normales que podemos constatar, tres de espacio y una de tiempo, como la teoría de Kaluza-Klein, están enrolladas en una distancia de Planck. De , inalcanzables.

Una de las características más atractivas de la teoría de supercuerdas es que dan lugar a partículas de espín 2, que son identificadas con los gravitones (las partículas que transportan la gravedad y que aún no se han podido localizar). Por tanto, una teoría de supercuerdas automáticamente contiene una teoría cuántica de la interacción gravitacional. Se piensa que las supercuerdas, al contrario que ocurre con otras teorías ( ellas el Modelo Estándar), están libres de infinitos que no pueden ser eliminados por renormalización, que plagan todos los intentos de construir una teoría cuántica de campos que incorpore la gravedad. Hay algunas evidencias de que la teoría de supercuerdas está libre de infinitos, pero se está a la búsqueda de la prueba definitiva.

Aunque no hay evidencia directa de las supercuerdas, algunas características de las supercuerdas son compatibles con los hechos experimentales observados en las partículas elementales, como la posibilidad de que las partículas no respeten paridad, lo que en efecto ocurre en las interacciones débiles.

Extrañas configuraciones a las que, algunos físicos le quieren sacar lo que seguramente no se encuentra en ellas

Estoy convencido de que la teoría de supercuerdas será finalmente corroborada por los hechos y, ello, se necesitará algún tiempo; no se puede aún comprobar ciertos parámetros teóricos que esas complejas matemáticas a las que llaman topología nos dicen que son así.

Habrá que tener siempre a mano las ecuaciones de Einstein, las funciones modulares de Ramanujan y el Supertensor métrico de ese genio matemático que, al igual que Ramanujan, fue un visionario llamado Riemann.

Las historias de estos dos personajes, en cierto modo, son muy parecidas. Tanto Riemann como Ramanujan murieron antes de cumplir los 40 años y, también en ambos casos, en difíciles. Estos personajes desarrollaron una actividad matemática sólo comparable al trabajo de toda la vida de muchos buenos matemáticos.

¿Cómo es posible que, para proteger la simetría conforme original por su destrucción por la teoría cuántica, deben ser milagrosamente satisfechas cierto de identidades matemáticas, que precisamente son las identidades de la función modular de Ramanujan?

En este he expresado que las leyes de la naturaleza se simplifican cuando se expresan en dimensiones más altas. Sin embargo, a la luz de la teoría cuántica, debo corregir algo esta afirmación, y para decirlo correctamente debería decir: las leyes de la naturaleza se simplifican cuando se expresan coherentemente en dimensiones más altas. Al añadir la palabra coherentemente hemos señalado un punto crucial. ligadura nos obliga a utilizar las funciones modulares de Ramanujan, que fijan en diez de dimensiones del espacio-tiempo. Esto a su vez, puede facilitarnos la clave decisiva para explicar el origen del universo.

emilio silvera

Jul

1

Hablemos de Alejandría

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del Saber ~

Clasificado en Rumores del Saber ~

Comments (1)

Comments (1)

![[I] Las 7 Maravillas del Mundo Antiguo](http://lh4.ggpht.com/_0_XWhqXM2VQ/S5KzPr5Ph7I/AAAAAAAAJs8/tYOgGOOTr7w/1692387141_5f1bab9da9_thumb4.jpg?imgmax=800)

La construcción del Faro de Alejandría consistía en una amplia base cuadrada y una torre octogonal de unos 100 metros de altura. En la parte superior ardía leña y resina; ésa luz servía de aviso y señal a los navegantes. Para los marineros, significó un guía seguro para sus retornos al gran puerto. Para los arquitectos, significó aún más; era el edificio más alto sobre la tierra y para los científicos era lo misterioso; poseía un espejo que los fascinó. El espejo daba un reflejo que podría ser visto a más de 50 Km., fuera de la costa. Su ubicación se sitúa sobre la antigua Isla de Faros, un promontorio dentro de la ciudad de Alejandría.

La ciudad de Alejandría, en Egipto, una ciudad situada entre Oriente y Occidente, que fue durante varios siglos el centro del saber, “un centro de cálculo”, “un lugar paradigmático”. Fundada por Alejandro Magno en 331 a.C., en por su deseo de acercar Egipto al mundo griego y en parte porque quería un puerto que no se viera afectado por las inundaciones del Nilo.

Alejandría fue pensada desde el principio como una “megalópolis”, construida en de chlamys, una capa militar Macedonia, y provista de murallas que se extenderían “sin cesar” en la distancia, con las calles tan amplias como nunca se había visto, basada en el diseño aristotélico de la ciudad ideal (una cuadrícula dispuesta de tal manera que se beneficiara de las brisas marinas, pero proporcionara refugio frente al viento).

Un tercio de la ciudad era “territorio real”, y ésta constituía un centro de comercio convenientemente situado en el extremo oriental del Mediterráneo, cerca del lugar en el que el Nilo y el mar Rojo conforman un cruce de caminos internacional, y donde muchas caravanas procedentes del interior de África y de Asia convergían en la costa.

Disponía de dos puertos, uno de los cuales ostentaba el famoso faro de casi cuarenta y cinco metro de alto (otros historiadores dicen que cien), una de las maravillas del mundo antiguo, que podía ser visto una distancia de más de cincuenta kilómetros.

Tras la muerte de Alejandro, sus generales se pelearon entre sí, lo que finalizó con una división del imperio en la que Selenco se hizo con el control de la parte septentrional, incluidos Israel y Siria, mientras que los territorios egipcios quedaron bajo el control de Ptolomeo I, al menos desde el año 306 a.C.

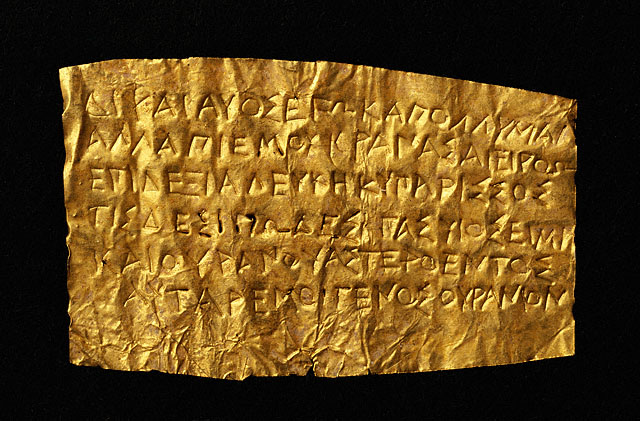

Con todo, Alejandría era principalmente famosa como centro de conocimiento. Según la tradición, el mismo Alejandro, cuando hubo decidido cuál era el lugar ideal su nueva ciudad, ordenó también la construcción en ella de una gran Biblioteca dedicada a las musas.

La idea no era nueva: en Babilonia se habían reunido diversas bibliotecas y otras habían surgido en diversos lugares del Mediterráneo, en particular en Pérgamo y Efeso. No obstante, el principio la ambición era mayor en Alejandría que en cualquier otro lugar y, en palabras de un estudioso, lo que se organizó allí fue una verdadera “fuente del conocimiento”. Ya en 283 a.C. había un sínodo, una comunidad de entre treinta y cincuenta hombres instruidos (sólo hombres), vinculado a la biblioteca y dotado de especiales privilegios: los estudiosos estaban exentos del pago de impuestos y podían abastecerse y hospedarse gratis en el sector real de la ciudad.

La biblioteca estaba dirigida por un erudito-bibliotecario, nombrado por el rey y quien además ocupaba el cargo de tutor real. Esta biblioteca tenía varias alas, con filas de anaqueles, o thaike, dispuestos a lo largo de paseos cubiertos y provistos de nichos, en los que se guardaban las distintas categorías del saber. Había y un jardín botánico.

El primer bibliotecario fue Demetrio y para la época del poeta Calímaco, uno de sus sucesores más famosos, en el siglo III a. de C., la biblioteca poseía más de 400.000 rollos múltiples y noventa mil rollos únicos. Posteriormente, el Serapeo, la biblioteca hija de la de Alejandría, alojada en el templo de Serapis, un culto greco-egipcio, acaso basado en el de Hades, el dios griego de los muertos, llegó a reunir otros 40.000 rollos.

Calímaco creó el primer catálogo temático del mundo, el Pinakes, uno de cuyos efectos fue que para el siglo IV d.C., hasta cien estudiosos acudían a la vez a la biblioteca para consultar sus libros y discutir los textos unos con otros. distinguida comunidad existió durante unos setecientos años. Los estudiosos escribían sobre papiro, material sobre el que Alejandría mantuvo un monopolio durante cierto tiempo, y luego sobre pergamino, cuando el rey dejó de exportar papiro en un intento de impedir la construcción de bibliotecas rivales en otros lugares, en especial en Pérgamo.

Los libros de pergamino y papiro se escribían en rollos (su longitud era más o menos equivalentes a la de uno de nuestros capítulos) y se almacenaban en fundas de cuero o lino y se colocaban en estantes. la época de los romanos, no todos los libros eran ya rollos: se habían introducido los códices que se almacenaban en cajas de madera.

La biblioteca también contaba con muchos charakitai, “amanuenses” se los denominaba, y que eran de hecho traductores.

A los reyes de Alejandría, los Ptolomeos, les encantaba adquirir copias de todos los libros que aún no poseían, en un esfuerzo por reunir toda la sabiduría de Grecia, Babilonia, la India y demás lugares. En particular, Ptolomeo III Evergetes encargó a agentes que registraran todo el Mediterráneo en busca de textos y él mismo escribió a todos los soberanos del mundo conocido pidiéndoles que le prestaran sus libros para copiarlos.

Cuando le fueron prestadas las obras de Eurípides, Esquilo y Sófocles, conservó los originales y devolvió las copias que habían hecho, renunciando a la fianza que había pagado. De igual , todas las embarcaciones que pasaban por Alejandría estaban obligadas a depositar todos sus libros (los que transportaran) en la biblioteca, donde se los copiaba y catalogaba como “de las naves”. En su mayoría, lo que se devolvía a las naves eran las copias de los libros confiscados.

Una de aquellas bibliotecas de la antigüedad

Así, la riqueza de saber y cultura que acumuló aquella biblioteca del pasado fue incalculable e hizo que desempeñara un papel primordial en el mundo civilizado de la antigüedad. Entre los famosos estudiosos que se hicieron en Alejandría se encuentran Euclídes, quien pudo haber escrito sus Elementos durante el reinado de Ptolomeo I (323-285 a.C.), Aristarco, que propuso una descripción heliocéntrica del sistema planetario, y Apolunio de Perga, “el gran geómetra”, que escribió su influyente libro sobre las secciones cósmicas en la ciudad. Apolunio de Rodas fue el autor de la epopeya El de los argonautas (c. 270 a.C.) y quien presento a Arquímedes de Siracusa, que durante un tiempo se dedico a estudiar las crecidas del Nilo e inventó el tornillo que lo haría famoso. Arquímedes también inició la hidrostática y esbozó su método para calcular el área y el volumen que, mil ochocientos años después, conformaría las bases del cálculo.

Un bibliotecario posterior, Eratóstenes (276-196 a.C.), fue geógrafo y matemático. Gran amigo de Arquímedes, creía que todos los océanos de la Tierra estaban conectados entre sí, que algún día sería posible circunnavegar África y que podría llegarse a la India “navegando en dirección oeste España”.

Fue Eratóstenes quien calculó la duración correcta del año, quien propuso la idea de que la Tierra es redonda y quien calculó su diámetro con un error de 80 km.

Eratóstenes también dio origen a la ciencia de la cronología al establecer con mucho cuidado las fechas de la caída de Troya (1.184 a.C.), la primera olimpiada (776 a.C.) y el estallido de la guerra de peloponeso (432 a.C.). Asimismo, ideó el calendario que finalmente establecería Julio Cesar y diseño un método identificar los números primos.

los estudiosos se le conocía como “Beta” (Platón era “Alfa”).

Los Elementos de Euclides es un texto reconocido por lo general como el más influyente de todos los tiempos. Escrito hacia el año 300 a. C., de él se han hecho muchísimas copias de ediciones que, lo convierta en el libro más reeditado en el mundo después de la Biblia (sus contenidos, más de 2.000 años después, aún se enseñan en las escuelas de secundarias).

Es posible que Euclides (ev significa “bueno” y kleis significa “llave”) estudiara en la Academia de Platón, incluso con el gran maestro en persona (nació en Atenas hacia el año 330 a.C.); aunque no produjo ninguna nueva idea en sí, sus Elementos (Stoichia) se consideran una historia completa de la matemática griega hasta ese .

El libro comienza con una serie de definiciones, como la del punto (“lo que no tiene ”) o la línea (“una longitud sin amplitud”), describe diversos ángulos y planos, sigue después con cinco postulados (como el de que “puede trazarse una línea de un punto cualquiera a otro punto cualquiera”) y cinco axiomas, como el de que” todas las cosas iguales a la misma cosa son iguales entre sí”. Los trece libros, o capítulos, que siguen exploran la geometría del plano, la geometría de los sólidos, la teoría de los números, las proporciones y su famoso método de “agotamiento”. En este Euclides muestra cómo “agotar” el área de un círculo inscribiendo polígonos en él.

Dadme una palanca y moveré el mundo

Los famosos espejos de Arquímedes quemaban las velas de las embarcaciones enemigas.

También es digno de mención aquí un personaje singular como Arquímedes de Siracusa (287-219 a.C.), el más versátil de los matemáticos helénicos. Al parecer estudió en Alejandría durante un tiempo, con discípulos de Euclides, y aunque vivió principalmente en Siracusa, donde murió, estuvo en constante con los investigadores de esta ciudad.

Durante la segunda guerra púnica, Siracusa fue arrastrada por el conflicto entre Roma y Cartago y, unida a este último bando, fue sitiada por los romanos entre 214 y 212 a.C. Durante esta guerra, nos dice Plutarco en su vida del general romano Marcelo, Arquímedes inventó un gran de ingeniosas armas para defenderse del enemigo, incluidas catapultas y espejos capaces de prender fuego a las embarcaciones romanas. Pese a todo, sus esfuerzos resultaron inútiles y la ciudad cayó. Pese a que Marcelo había ordenado que respetaran la vida de Arquímedes, un soldado romano le mató con su espada mientras dibujaba una figura geométrica en la arena.

Arquímedes fue un innovador con sus ideas de extraordinario valor sobre las palancas, en su obra sobre el equilibrio de los planos, y sobre hidrostática, en sobre los cuerpos flotantes. En este último encontramos su famosa idea de que “cualquier sólido menos pesado que un fluido se hundirá, al ser colocado en él, el punto en el que el peso del fluído desplazado sea igual al peso del sólido”.

También exploró los números grandes, una preocupación que siglos después conduciría a la invención de los logaritmos, y consiguió el cálculo más acertado de p.

Mapa mundi de Claudio Ptolomeo

El último de los grandes matemáticos helénicos de Alejandría fue Claudio Ptolomeo, activo de 127 d.C.a 151 d.C. Su gran obra denominada inicialmente como Sintaxis matemática, compuesta por trece libros o capítulos, terminó conociéndose como Megiste, “la más grande”. Posteriormente, en el mundo musulmán, surgió la costumbre de llamar a libro por su equivalente árabe: Almagesto

Así es conocido entonces. Es fundamentalmente una obra de trigonometría, la rama de las matemáticas referente a los triángulos que estudia las relaciones entre sus ángulos y las longitudes de sus lados y cómo todo ello está relacionada con los círculos que los abarcan. A su vez, estos están relacionados con las órbitas de los cuerpos celestes y los ángulos de los planetas respecto de quien los observa desde la Tierra. Los libros siete y ocho de Almagesto ofrecen un catálogo de más de un millar de estrellas, dispuestas en cuarenta y ocho constelaciones.

A mediados del siglo III a. C. Aristarco de Samos había propuesto que la Tierra giraba alrededor del Sol. La mayoría de los astrónomos, Ptolomeo incluido, rechazaban tal idea y el tiempo pasó sin que su predicción fuese comprobada y, muchos años más tarde, llegó Copérnico para apropiarse de su idea y ganar la fama.

Aristarco de Samos

Quiero significar aquí que Alejandría fue por mucho tiempo el centro de las matemáticas griegas: Menéalo, Hezón, Diofanto, Pappo y Proclo de Alejandría contribuyeron todos a ampliar y desarrollar las ideas de Euclides, Arquímedes, Apolunio y Ptolomeo. No debemos olvidar que la gran era de la ciencia y la matemática griegas se prolongó desde el siglo VI a.C. hasta los comienzos del siglo VI d.c., más de un milenio de gran productividad. Ninguna otra civilización ha aportado tanto un periodo de tiempo tan largo. En aquel movimiento cultural también estuvo presente alguna mujer que todos tenemos en la mente.

Sin embargo, en Alejandría, las matemáticas o, al , los números tuvieron otro aspecto muy importante, y también muy diferente. Se trata de los denominados “misterios órficos” y su énfasis místico.

Según Marsilio Ficino, autor del siglo XV d.C., hay seis grandes teólogos de la antigüedad que forman una linea sucesoria. Zoroastro fue “el principal referente de los Magos”; el segundo era Hermes Trismegisto, el líder de los sacerdotes egipcios; Orfeo fue el sucesor de Trismegisto y a él le siguió Aglaofemo, que fue el encargado de a Pitágoras en los secretos, quien a su vez los confió a Platón. En Alejandría, Platón fue desarrollado culturalmente por Clemente y Filón, para crear lo que se conocería como neoplatonismo.

Tres ideas conforman los cimientos de los misterios órficos. Una es el poder místico de los números. La existencia de los números, su cualidad abstracta y su comportamiento, tan vinculado el del Universo, ejercieron una permanente fascinación sobre los antiguos, que veían en ellos la explicación de lo que percibían como armonía celestial.

La naturaleza abstracta de los números contribuyó a reforzar la idea de un alma abstracta, en la que estaba implícita la idea (trascendental en este contexto) de la salvación: la creencia de que habrá un futuro de éxtasis, al que es posible llegar a través de la trasmigración o reencarnación.

Por último, estaba el principio de emanación, esto es, que existe un bien eterno, una unidad o “monada”, de la que brotaba toda la creación. Como el , esta era considerada una entidad básicamente abstracta. El alma ocupada una posición intermedia entre la monada y el mundo material, entre la mente, abstracta en su totalidad, y los sentidos.

Según los órficos, la monada enviaba (“emanaba”) proyecciones de sí misma al mundo material y la tarea del alma era aprender usando los sentidos. De esta , a través de sucesivas reencarnaciones, el alma evolucionaba hasta el punto en el que ya no eran necesarias más reencarnaciones y se alcanzaba el momento de profunda iluminación que daba lugar a una forma conocida como gnosis, allí la mente esta fundida con lo que percibe. Es posible reconocer que esta idea, original de Zoroastro, subyace en muchas de las regiones principales del mundo, con distintas variantes o matices que, en esencia, viene a ser los mismos.

Pitágoras, en particular, creía que el estudio de los números y la armonía conducían a la gnosis. Para los pitagóricos, el número uno no era un número en realidad, sino la “esencia” del número, de la cual surge todo el sistema numérico. Su división en dos creaba un triángulo, una trinidad, la forma armónica más básica, idea de la que encontramos ecos en santísimas religiones.

Platón, en su versión más mítica, estaba convencido de que existía un “alma mundial”, también fundada en la armonía y el , y de la cual brotaba toda la creación. Pero añadió un importante refinamiento al considerar que la dialéctica, el examen crítico de las opiniones era el método para acceder a la gnosis.

La tradición sostiene que el cristianismo llegó a Alejandría a mediados del siglo I d.C., cuando Marcos el evangelista llegó a la ciudad predicar la nueva religión.

Las similitudes espirituales entre el platonismo y el cristianismo fueron advertidas de muy clara por Clemente de Alejandría (150-215 d.C.), pero fue Filón el indio quien primero desarrolló esta nueva fusión. En Alejandría habían existido escuelas pitagóricas y platónicas desde hacía un largo tiempo, y los judíos cultos conocían los paralelos entre las ideas judías y las tradiciones Geténicas, hasta el punto de que para muchos de ellos el orfismo no era otra cosa que “una emanación de la Torá de la que no había quedado constancia”.

El filósofo judio Filón de Alejandría

Filón era el típico alejandrino que “nunca confiaba en el sentido literal de las cosas y siempre estaba a la búsqueda de interpretaciones músticas y alegóricas”. Pensaba que podía “conectar” con Dios a través de ideas divinas, que las ideas eran “los pensamientos de Dios” porque ponían orden a la “materia informe”. Al igual que Platón, tenía una noción dualista de la Humanidad:

“De las almas puras que habitan el espacio etéreo, aquellas más cercanas a la tierra resultan atraídas por los seres sensibles y descienden a sus cuerpos”.

Las almas son el lado divino del hombre, se decía por aquel entonces.

Es interesante reparar en los hechos pasados y la evolución del pensamiento humano que, en distintos lugares del mundo y bajo distintas formas, todos iban en realidad a desembocar en el mismo mar del pensamiento. Siempre hemos querido saber, siempre hemos imaginado sobre lo que habrá más allá, en ese “universo” de lo inmaterial de la metafísica que nuestras mentes han ideado para explicar lo que no tiene explicación.

Más allá de nosotros… ¡están las estrellas!

La naturaleza humana y el orden universal, el primero unido a un alto concepto cuasi divino, el Alma, el segundo regido por la energía cósmica de las fuerzas naturales creadoras de la materia y, todo esto, desarrollado de una u otra manera por los grandes pensadores de todos los tiempos que hicieron posible la evolución del saber tomar posesión de profundos conocimiento que, en un futuro, nos podrán permitir alcanzar metas, que aún hoy, serían negadas por muchos.

Para mí, el mirar los hechos pasados y estudiar los logros alcanzados en todos los campos del saber, es una auténtica aventura que profundiza y lleva al conocimiento del ser humano que, según la historia, es capaz de lo mejor y de lo , sin embargo, nadie podrá negarle grandeza ni imaginación.

emilio silvera

Totales: 84.932.399

Totales: 84.932.399 Conectados: 55

Conectados: 55