Oct

23

La masa del universo, la inflación, el tamaño…II

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo dinámico ~

Clasificado en El Universo dinámico ~

Comments (0)

Comments (0)

¡El Universo! Que trataba de explicar en la parte I de este trabajo, en el que, sin quererlo, me remonté a aquellos primeros momentos, cuando nacieron el espacio y el tiempo y se fraguó, la materia misma que podemos ver y de la que todo está hecho, desde el objeto más diminuto hasta la más inmensa galaxia.

Antes de alrededor de un minuto y cuarenta segundos desde el comienzo del tiempo, se supone que no había núcleos atómicos estables. El nivel de energía en el ambiente es mayor que la energía de unión nuclear. Por consiguiente, todos los núcleos que se forman, se destruyen de nuevo rápidamente.

Alrededor de un segundo desde el comienzo del tiempo, llegamos a la época de desacoplamiento de los neutrinos. Aunque en esa época el Universo es extremadamente denso (y tan caliente como la explosión de una bomba de hidrógeno), ya ha empezado a parecer vacío a los neutrinos. Puesto que los neutrinos sólo reaccionan a la fuerza débil, que tiene un alcance extremadamente corto, ahora pueden escapar de sus garras y volar indefinidamente sin experimentar ninguna otra interacción.

Así, emancipados, en lo sucesivo son libres de vagar por el Universo a su manera indiferente, volando a través de la mayor parte de la materia como si no existiese. (Diez trillones de neutrinos atravesarán sin causar daños el cerebro y el cuerpo de cada uno de ustedes en el tiempo que os lleve leer esta página. Y en el tiempo en que hayan leído esta frase estarán más lejos que la Luna).

En menos de un siglo, el neutrino pasó de una partícula fantasma – propuesta en 1930 por el físico austríaco Wolfgang Pauli (1900-1958) a explicar el balance de energía en una forma de radioactividad, el llamado decaimiento beta, en una sonda capaz de escrutar el interior de estrellas y de la propia Tierra.

De esa manera, oleadas de neutrinos liberados en un segundo después del big bang persiste aún después, formando una radiación cósmica de fondo de neutrinos semejante a la radiación de fondo de microondas producida por el desacoplamiento de los fotones.

Si los neutrinos “cósmicos” -como se los llama para diferenciarlos de los neutrinos liberados más tarde por las supernovas- pudiesen ser observador por un telescopio de neutrinos de alguna clase, proporcionarían una visión directa del Universo cuando sólo tenía un segundo. A medida que retrocedemos en el tiempo, el Universo se vuelve más denso y más caliente, y el nivel de estructura que puede existir se hace cada vez más rudimentario.

Por supuesto, en ese tiempo, no hay moléculas, ni átomos, ni núcleos atómicos, y, a 10-6 (0.000001) de segundo después del comienzo del tiempo, tampoco hay neutrones ni protones. El Universo es un océano de quarks libres y otras partículas elementales.

Si nos tomamos el trabajo de contarlos, hallaremos que por cada mil millones de antiquarks existen mil millones y un quark. Esta asimetría es importante. Los pocos quarks en exceso destinados a sobrevivir a la aniquilación general quark-antiquark formaran todos los átomos de materia del Universo del último día. Se desconoce el origen de la desigualdad; presumiblemente obedezca a la ruptura de una simetría materia antimateria en alguna etapa anterior. Nada hemos podido saber de lo que pasó antes del Tiempo de Planck.

Nos aproximamos a un tiempo en que las estructuras básicas de las leyes naturales, y no sólo las de las partículas y campos cuya conducta dictaban, cambiaron a medida que evolucionó el Universo. La primera transición semejante se produjo en los 10-11 de segundo después del comienzo del tiempo, cuando las funciones de las fuerzas débiles y electromagnéticas se regían por una sola fuerza, la electrodébil. Ahora hay bastante energía ambiente para permitir la creación y el mantenimiento de gran número de bosones w y z.

Debajo de este bonito conjunto que es el CERN, está el famoso acelerador LHC que intenta llegar a ese pasado que aquí estamos descibirendo ahora. Aquellos primeros momentos, cuando el Tiempo y el espacio hicieron su aparición para dar cobijo a la materia

Así que estas partículas, los bosones w y z –las mismas cuya aparición en el acelerador del CERN verificó la teoría electrodébil– son las mediadoras intercambiables en las interacciones de fuerzas electromagnéticas y débiles, lo que las hace indistinguibles. En ese tiempo, el Universo está gobernando sólo por tres fuerzas: la gravedad, la interacción nuclear fuerte y la electrodébil.

Más atrás de ese tiempo nos quedamos en el misterio y envueltos en una gran nebulosa de ignorancia. Cada uno se despacha a su gusto para lanzar conjeturas y teorizar sobre lo que pudo haber sido. Seguramente, es posible que en el futuro, sea la teoría M (de supercuerdas) la que contestará esas preguntas sin respuestas ahora.

En los 10-35 de segundo desde el comienzo del tiempo, entramos en un ámbito en el que las condiciones cósmicas son aún menos conocidas. Si las grandes teorías unificadas son correctas, se produjo una ruptura de la simetría por la que la fuerza electronuclear unificada se escindió en las fuerzas electrodébil y las fuertes. Si es correcta la teoría de la supersimetría, la transición puede haberse producido antes, había involucrado a la gravitación.

Aún no había Carbono que se produciría mucho más tarde, en las estrellas, mediante el efecto triple alfa

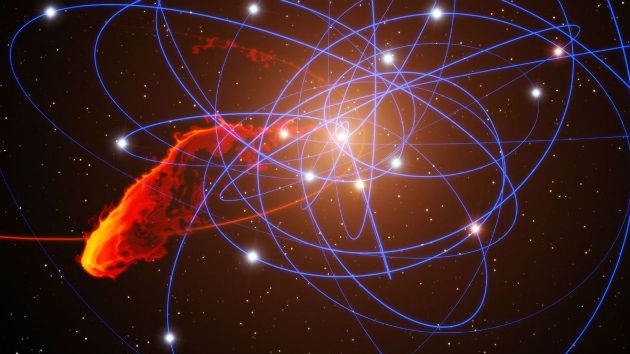

En el universo tempranop la primera materia (hidrógeno y Helio) era llevada por la fuerza de gravedad a conformarse en grandes conglomerados de gas y polvo que interacioban, producían calor y formaron las primeras estrellas.

Elaborar una teoría totalmente unificada es tratar de comprender lo que ocurrió en ese tiempo remoto que, según los últimos estudios está situado entre 13.700 y 15.000 millones de años, cuando la perfecta simetría -que se pensaba, caracterizó el Universo-, se hizo añicos para dar lugar a las simetrías rotas que hallamos a nuestro alrededor y que nos trajo las fuerzas y constantes Universales que, paradójicamente, hicieron posible nuestra aparición para que ahora, sea posible que, alguien como yo esté contando lo que pasó.

Realmente, carecemos de una teoría que nos explique lo que pasó en aquellos primeros momenmtos y, hasta que no tengamos tal teoría no podemos esperar comprender lo que realmente ocurrió en ese Universo niño. Los límites de nuestras conjeturas actuales cuando la edad del Universo sólo es de 10-43 de segundo, nos da la única respuesta de encontrarnos ante una puerta cerrada. Del otro lado de esa puerta está la época de Plank, un tiempo en que la atracción gravitatoria ejercida por cada partícula era comparable en intensidad a la fuerza nuclear fuerte.

Así que, llegados a este punto podemos decir que la clave teórica que podría abrir esa puerta sería una teoría unificada que incluyese la gravitación, es decir, una teoría cuántica-gravitatoria que uniese, de una vez por todas, a Planck y Einsteins que, aunque eran muy amigos, no parecen que sus teorías (la Mecánica Cuántica) y (la Relatividad General) se lleven de maravilla.

emilio silvera

Oct

23

¡El Núcleo Atómico! Y mucho más

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

El propio Rutherford empezó a vislumbrar la respuesta a la pregunta que arriba hacemos. Entre 1.906 y 1.908 (hace más de un siglo) realizó constantes experimentos disparando partículas alfa contra una lámina sutil de metal (como oro o platino), para analizar sus átomos. La mayor parte de los proyectiles atravesaron la barrera sin desviarse (como balas a través de las hojas de un árbol), pero no todos.

En la placa fotográfica que le sirvió de blanco tras el metal, Rutherford descubrió varios impactos dispersos e insospechados alrededor del punto central. Comprobó que algunas partículas habían rebotado. Era como si en vez de atravesar las hojas, algunos proyectiles hubiesen chocado contra algo más sólido. Rutherford supuso que aquella “balas” habían chocado contra una especie de núcleo denso, que ocupaba sólo una parte mínima del volumen atómico y ese núcleo de intensa densidad desviaban los proyectiles que acertaban a chocar contra él. Ello ocurría en muy raras ocasiones, lo cual demostraba que los núcleos atómicos debían ser realmente ínfimos, porque un proyectil había de encontrar por fuerza muchos millones de átomos al atravesar la lámina metálica

Era lógico suponer, pues, que los protones constituían ese núcleo duro. Rutherford representó los protones atómicos como elementos apiñados alrededor de un minúsculo “núcleo atómico” que servía de centro (después de todo eso, hemos podido saber que el diámetro de ese núcleo equivale a algo más de una cienmilésima del volumen total del átomo).

En 1.908 se concedió a Rutherford el premio Nobel de Química por su extraordinaria labor de investigación sobre la naturaleza de la materia. Él fue el responsable de importantes descubrimientos que permitieron conocer la estructura de los átomos en esa primera avanzadilla.

Átomo de hidrógeno, núcleo y electrón.

Desde entonces se pueden describir con términos más concretos los átomos específicos y sus diversos comportamientos. Por ejemplo, el átomo de hidrógeno posee un solo electrón. Si se elimina, el protón restante se asocia inmediatamente a alguna molécula vecina; y cuando el núcleo desnudo de hidrógeno no encuentra por este medio un electrón que participe, actúa como un protón (es decir, una partícula subatómica), lo cual le permite penetrar en la materia y reaccionar con otros núcleos si conserva la suficiente energía.

El helio, que posee dos electrones, no cede uno con tanta facilidad. Sus dos electrones forman un caparazón hermético, por lo cual el átomo es inerte. No obstante, si se despoja al helio de ambos electrones, se convierte en una partícula alfa, es decir, una partícula subatómica portadora de dos unidades de carga positiva.

Hay un tercer elemento, el litio, cuyo átomo tiene tres electrones. Si se despoja de uno o dos, se transforma en ión, y si pierde los tres, queda reducida a un núcleo desnudo, con una carga positiva de tres unidades.

Las unidades de carga positiva en el núcleo atómico deben ser numéricamente idénticas a los electrones que contiene por norma, pues el átomo suele ser un cuerpo neutro, y esta igualdad de lo positivo con lo negativo es el equilibrio. De hecho, los números atómicos de sus elementos se basan en sus unidades de carga positiva, no en las de carga negativa, porque resulta fácil hacer variar el número de electrones atómicos dentro de la formación iónica, pero en cambio se encuentran grandes dificultades si se desea alterar el número de sus protones.

Apenas esbozado este esquema de la construcción atómica, surgieron nuevos enigmas. El número de unidades con carga positiva en un núcleo no equilibró, en ningún caso, el peso nuclear ni la masa, exceptuando el caso del átomo de hidrógeno. Para citar un ejemplo, se averiguó que el núcleo de helio tenía una carga positiva dos veces mayor que la del núcleo de hidrógeno; pero como ya se sabía, su masa era cuatro veces mayor que la de este último. Y la situación empeoró progresivamente a medida que se descendía por la tabla de elementos, e incluso cuando se alcanzó el uranio, se encontró un núcleo con una masa igual a 238 protones, pero una carga que equivalía sólo a 92.

¿Cómo era posible que un núcleo que contenía cuatro protones (según se suponía el núcleo de helio) tuviera sólo dos unidades de carga positiva? Según la más simple y primera conjetura emitida, la presencia en el núcleo de partículas cargadas negativamente y con peso despreciable neutralizaba dos unidades de carga. Como es natural, se pensó también en el electrón. Se podría componer el rompecabezas si se suponía que en núcleo de helio estaba integrado por cuatro protones y dos electrones neutralizadores, lo cual deja libre una carga positiva neta de dos, y así sucesivamente, hasta llegar al uranio, cuyo núcleo tendría, pues, 238 protones y 146 electrones, con 92 unidades libres de carga positiva. El hecho de que los núcleos radiactivos emitieran electrones (según se había comprobado ya, por ejemplo, en el caso de las partículas beta), reforzó esta idea general. Dicha teoría prevaleció durante más de una década, hasta que por caminos indirectos, llegó una respuesta mejor como resultado de otras investigaciones.

Pero entre tanto se habían presentado algunas objeciones rigurosas contra dicha hipótesis. Por lo pronto, si el núcleo estaba constituido esencialmente de protones, mientras que los ligeros electrones no aportaban prácticamente ninguna contribución a la masa, ¿cómo se explicaba que las masas relativas de varios núcleos no estuvieran representadas por número enteros? Según los pesos atómicos conocidos, el núcleo del átomo cloro, por ejemplo, tenía una masa 35’5 veces mayor que la del núcleo de hidrógeno. ¿Acaso significaba esto que contenía 35’5 protones? Ningún científico (ni entonces ni ahora) podía aceptar la existencia de medio protón.

Este singular interrogante encontró una respuesta incluso antes de solventar el problema principal, y ello dio lugar a una interesante historia.

Los tres isótopos naturales del carbono: carbono-12 (6 protones y 6 neutrones), carbono-13 (6 protones y 7 neutrones) y carbono-14 (6 protones y 8 neutrones). En los tres casos es carbono, tiene el aspecto de carbono y se comporta químicamente como carbono, por tener seis protones (y forma parte de nuestro organismo, por ejemplo). Sin embargo, sus propiedades físicas varían. Por ejemplo, mientras que el carbono-12 y el carbono-13 son estables, el carbono-14 es inestable y radioactivo: emite radiación beta, uno de sus neutrones “extras” se transforma así en un protón y el núcleo se convierte en nitrógeno-14 (que tiene 7 protones y 7 neutrones), con el aspecto y las propiedades del nitrógeno (por tener 7 protones). Dado que la mitad de la masa del carbono-14 pasa a ser nitrógeno-14 cada 5.730 años aproximadamente (más o menos lo que llevamos de civilización humana), la presencia de este isótopo natural resulta especialmente útil para la datación precisa de objetos históricos.

Isótopos; construcción de bloques uniformes

Allá por 1.816, el físico inglés William Prout había insinuado ya que el átomo de hidrógeno debía entrar en la constitución de todos los átomos. Con el tiempo se fueron desvelando los pesos atómicos, y la teoría de Prout quedó arrinconada, pues se comprobó que muchos elementos tenían pesos fraccionarios (para lo cual se tomó el oxígeno, tipificado al 16). El cloro, según dije antes, tiene un peso atómico aproximado de 35’5, o para ser exactos, 35’457. otros ejemplos son el antimonio, con un peso atómico de 121’75, el galio con 137’34, el boro con 10’811 y el cadmio con 112’40.

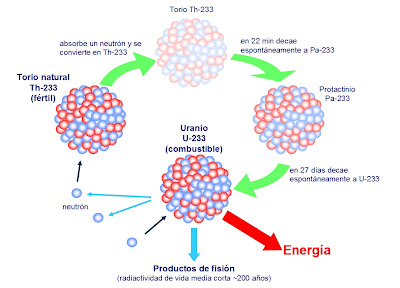

El Uranio 235 que es el único que de manera natural es apto para la fisión nuclear, es escaso, sólo el 7 por 1.000 es uranio 235, el resto, es uranio 238 que, no es combustible nuclear y, como la madera mojada, no arde. Sin embargo, si se bombardea con neutrones lentos del uranio 235, resulta que se convierte en Plutonio 239 que sí, es combustible nuclear válido. ¡Qué no idearemos para conseguir los objetivos!

El Uranio es muy radiactivo y si está enriquecido… ¡Ya sabemos las consecuencias!

Hacia principios de siglo se hizo una serie de observaciones desconcertantes, que condujeron al esclarecimiento. El inglés William Crookes (el del tubo Crookes) logró disociar del uranio una sustancia cuya ínfima cantidad resultó ser mucho más radiactiva que el propio uranio. Apoyándose en su experimento, afirmó que el uranio no tenía radiactividad, y que ésta procedía exclusivamente de dicha impureza, que él denominó uranio X. Por otra parte, Henri Becquerel descubrió que el uranio purificado y ligeramente radiactivo adquiría mayor radiactividad con el tiempo, por causas desconocidas. Si se deja reposar durante algún tiempo, se podía extraer de él repetidas veces uranio activo X. Para decirlo de otra manera, por su propia radiactividad, el uranio se convertía en el uranio X, más radiactivo aún.

Por entonces, Rutherford, a su vez, separó del torio un torio X muy radiactivo, y comprobó también que el torio seguía produciendo más torio X. Hacia aquellas fechas se sabía ya que el más famoso de los elementos radiactivos, el radio, emitía un gas radiactivo, denominado radón. Por tanto, Rutherford y su ayudante, el químico Frederick Soddy, dedujeron que durante la emisión de sus partículas los átomos radiactivos se transformaron en otras variedades de átomos radiactivos.

El Radón, uno de los llamados gases nobles, es incoloro, inodoro e insípido, además de –para nuestro mal- radioactivo. Suele presentarse según el tipo de suelos de determinadas zonas y con la descomposición de uranio, concentrándose en la superficie y siendo “arrastrado” en y por el aire que respiramos, y es en grandes cantidades es un gas perjudicial para la salud… y que anticipa terremotos.

Varios químicos que investigaron tales transformaciones lograron obtener un surtido muy variado de nuevas sustancias, a las que dieron nombres tales como radio A, radio B, mesotorio I, mesotorio II y actinio C. Luego los agruparon todos en tres series, de acuerdo con sus historiales atómicos. Una serie se originó del uranio disociado; otra del torio, y la tercera del actinio (si bien más tarde se encontró un predecesor del actinio, llamado protactinio).

En total se identificaron unos cuarenta miembros de esas series, y cada uno se distinguió por su peculiar esquema de radiación. Pero los productos finales de las tres series fueron idénticos: en último término, todas las cadenas de sustancias conducían al mismo elemento, el plomo.

Ahora bien, esas cuarenta sustancias no podían ser, sin excepción, elementos disociados. Entre el uranio (92) y el plomo (82) había sólo diez lugares en la tabla periódica, y todos ellos, salvo dos, pertenecían a elementos conocidos.

En realidad, los químicos descubrieron que aunque las sustancias diferían entre sí por su radiactividad, algunas tenían propiedades químicas idénticas. Por ejemplo, ya en 1.907 los químicos americanos Herbert Newby McCoy y W. H. Ross descubrieron que el radiotorio (uno entre los varios productos de la desintegración del torio) mostraba el mismo comportamiento químico que el torio, y el radio D, el mismo que el plomo, tanto que a veces era llamado radioplomo. De todo lo cual se infirió que tales sustancias eran en realidad variedades de mismo elemento: el radiotorio, una forma de torio; el radioplomo, un miembro de una familia de plomos; y así sucesivamente.

En 1.913, Soddy esclareció esta idea y le dio más amplitud. Demostró que cuando un átomo emitía una partícula alfa, se transformaba en un elemento que ocupaba dos lugares más abajo en la lista de elementos, y que cuando emitía una partícula beta, ocupaba, después de su transformación, el lugar inmediatamente superior. Con arreglo a tal norma, el radiotorio descendía en la tabla hasta el lugar del torio, y lo mismo ocurría con las sustancias denominadas uranio X y uranio Y, es decir, que los tres serían variedades del elemento 90. Así mismo, el radio D, el radio B, el torio B y el actinio B compartirían el lugar del plomo como variedades del elemento 82.

Soddy dio el nombre de isótopos (del griego iso y topos, “el mismo lugar”) a todos los miembros de una familia de sustancias que ocupaban el mismo lugar en la tabla periódica. En 1.921 se le concedió el premio Nobel de Química.

El modelo protón-electrón del núcleo concordó perfectamente con la teoría de Soddy sobre los isótopos. Al retirar una partícula alfa de un núcleo, se reducía en dos unidades la carga positiva de dicho núcleo, exactamente lo que necesitaba para bajar dos lugares en la tabla periódica. Por otra parte, cuando el núcleo expulsaba un electrón (partícula beta), quedaba sin neutralizar un protón adicional, y ello incrementaba en una unidad la carga positiva del núcleo, lo cual era como agregar una unidad al número atómico, y por tanto, el elemento pasaba a ocupar la posición inmediatamente superior en la tabla periódica de los elementos. ¡Maravilloso!

¿Cómo se explica que cuando el torio se descompone en radiotorio después de sufrir no una, sino tres desintegraciones, el producto siga siendo torio? Pues bien, en este proceso el átomo de torio pierde una partícula alfa, luego una partícula beta, y más tarde una segunda partícula beta. Si aceptamos la teoría sobre el bloque constitutivo de los protones, ello significa que el átomo ha perdido cuatro electrones (dos de ellos contenidos presuntamente en la partícula alfa) y cuatro protones. (La situación actual difiere bastante de este cuadro, aunque en cierto modo, esto no afecta al resultado).

El núcleo de torio constaba inicialmente (según se suponía) de 232 protones y 142 electrones. Al haber perdido cuatro protones y otros cuatro electrones, quedaba reducido a 228 protones y 138 electrones. No obstante, conservaba todavía el número atómico 90, es decir, el mismo de antes.

Así pues, el radiotorio, a semejanza del torio, posee 90 electrones planetarios, que giran alrededor del núcleo. Puesto que las propiedades químicas de un átomo están sujetas al número de sus electrones planetarios, el torio y el radiotorio tienen el mismo comportamiento químico, sea cual fuere su diferencia en peso atómico (232 y 228 respectivamente).

Los isótopos de un elemento se identifican por su peso atómico, o número másico. Así, el torio corriente se denomina torio 232, y el radiotorio, torio 228. Los isótopos radiactivos del plomo se distinguen también por estas denominaciones: plomo 210 (radio D), plomo 214 (radio B), plomo 212 (torio B) y plomo 211 (actinio B).

Se descubrió que la noción de isótopo podía aplicarse indistintamente tanto a los elementos estables como a los radiactivos. Por ejemplo, se comprobó que las tres series radiactivas anteriormente mencionadas terminaban en tres formas distintas de plomo. La serie del uranio acababa en plomo 206, la del torio en plomo 208 y la del actinio en plomo 207. cada uno de estos era un isótopo estable y corriente del plomo, pero los tres plomos diferían por su peso atómico.

Mediante un dispositivo inventado por cierto ayudante de J. J. Thomson, llamado Francis William Aston, se demostró la existencia de los isótopos estables. En 1.919, Thomson, empleando la versión primitiva de aquel artilugio, demostró que el neón estaba constituido por dos variedades de átomos: una cuyo número de masa era 20, y otra con 22. El neón 20 era el isótopo común; el neón 22 lo acompañaba en la proporción de un átomo cada diez. Más tarde se descubrió un tercer isótopo, el neón 21, cuyo porcentaje en el neón atmosférico era de un átomo por cada 400.

Entonces fue posible, al fin, razonar el peso atómico fraccionario de los elementos. El peso atómico del neón (20, 183) representaba el peso conjunto de los tres isótopos, de pesos diferentes, que integraban el elemento en su estado natural. Cada átomo individual tenía un número másico entero, pero el promedio de sus masas (el peso atómico) era un número fraccionario.

Aston procedió a mostrar que varios elementos estables comunes eran, en realidad, mezclas de isótopos. Descubrió que el cloro, con un peso atómico fraccionario de 35’453, estaba constituido por el cloro 35 y el cloro 37, en la proporción de cuatro a uno. En 1.922 se le otorgó el premio Nobel de Química.

Sabiendo todo lo anteriormente explicado, hemos llegado a comprender cómo parte de la Astronomía que estudia las características físicas y químicas de los cuerpos celestes, la astrofísica es la parte más importante de la astronomía en la actualidad debido a que, al avanzar la física moderna: Efecto Doppler-Fizeau, el efecto Zeeman, las teorías cuánticas y las reacciones termonucleares aplicadas al estudio de los cuerpos celestes han permitido descubrir que el campo magnético solar, el estudio de las radiaciones estelares y sus procesos de fusión nuclear, y determinar la velocidad radial de las estrellas, etc . radiación electromagnética de los cuerpos celestes permite realizar análisis de los espectros que nos dicen de qué están hechas las estrellas y los demás cuerpos del espacio interestelar y, de esa manera, hemos ido conociendo la materia y sus secretos que, cada vez, van siendo menos.

emilio silvera

Oct

22

Todo es Universo… ¡También nosotros!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (8)

Comments (8)

El Universo lo es todo. El Espacio y el Tiempo, la Materia y las fuerzas que con ella interaccionan, las Constantes de la Naturaleza y todo ello, implica una serie de cuestiones de una complejidad inmensa que aún, no hemos podido resolver. La cantidad de teorías, de modelos, de experimentos y de posibilidades que están en marcha en los distintos campos del saber, son enormes, y, finalmente, todas deberán ser unidas en un solo y complementado conocimiento que nos lleve a ese entendimiento profundo de nuestro Universo como un todo que es, lo que podremos ver, trás unir las piuezas del rompecabezas con el que ahora estamos trabajando al dilucidar parcelas de esa inmensidad que no podemos abarcar con la vista y menos con el conocimiento, sólo la imaginación se acerca a ese todo que pretendemos construir.

No podemos tener una imagen del Universo completo, es demasiado grande para que eso sea posible y sólo, pequeñas regiones del mismo podemos captar con nuestros telescopios que nos enseñan regiones más o menos lejanas del inmenso Cosmos. En cualquir parte que podamos mirar y observar, nos daremos cuenta de que las cosas que allí puedan pasar, son las mismas que pasan en otros lugares, toda vez que, el Universo se rige por leyes que actúan en todas partes de la misma manera. Muchos, desde hace mucho tiempo, pensaron en todas esas cuestiones.

Tales nació en la ciudad de Mileto en el año 639 a. de C. Fue el primero de los 7 sabios de Grecia y era matemático, geógrafo, pensador, astrónomo y astrólogo. Hijo de Examio e Cleóbula. Se marchó a Egipto para formarse con los sacerdotes del faraón en Geometría, astrología y física, allí aprendió cosas tan útiles como medir las pirámides por la longitud de la sombra. Era experto en astrosofía (algo que unía astronomía con filosofía) y que le daba el título de rudito en el más alto nivel. Se cuenta de él que, un día caminaba, de noche, observando las estrellas y cayó en un socabon que había en el suelo. Él fue el primero en dar al Agua la importancia que tiene para la vida.

Hoy trataré de dejar aquí una insignificante brizna de toda esa búsqueda, desesperada, por ese saber incansablemente perseguido por la especie humana que,deseosa de conocer todos aquellos misterios encerrados dentro de esa burbuja que llamamos Universo, no ha dejado, desde que Tales de Mileto desterró la mitología para emplear la lógica, de buscar el por qué del mundo, de los cielos y, en fin, de la Naturaleza. Claro que, desde aquel entonces hasta ahora, mucho es lo que nuestra curiosidad nos ha podido dar de ese saber que buscamos y del que no todos, hanestado siempre seguros de lograr.

Por ejemplo:

No olvidemos que, en el siglo XIX, algunos científicos declararon que la composición de las estrellas estaría siempre fuera del alcance del experimento, y, que la única manera que tendríamos de conocerlas sería la de mirar al cielo y verlas allí, inalcanzables como puntos de luz brillantes y lejanos en la oscuridad del vacío del cosmos.Sin embargo, podemos decir hoy, recien cumplida la primera década del siglo XXI, , que no solo podemos saber la composición de las estrellas, sino también como nacen, “viven” y mueren, las distancias que las separan de nosotros y un sin fin de datos más que el estudio y la investigación nos ha posibilitado descubrir.

Las estrellas del cielo, ¡tan lejanas! ¡tan misteriosas! que en las noches oscuras nos envían guiños de complicidad, como si trataran de decirnos alguna cosa, como si nos estuvieran llamando. Fue tanto el misterio que en nuestras mentes sembraron las estrellas que, no hemos parado ni un momento por saber, no sólo de qué estaban hechas, sino como surgen a la vida, como se desarrollan sus mecanismos, como mueren y en qué se convierten después. Sabemos que las estrellas son importantes en nuestras vidas hasta el punto de que, sin ellas, no podríamos estar aquí. Una de ellas, a la que llamamos Sol, nos envía su luz y su calor haciendo posible la vida en el planeta Tierra, otra antes que el Sol, hace seguramente muchos miles de millones de años, regó el espacio con su materia estelar y, pasado el tiempo, se condenso (ayudada por la Fuerza de Gravedad) en lo que hoy conocemos como el Sistema Solar.

Nada más cierto que lo que quiere simbolizar esa enorme imagen del Pensador. Es un fiel reflejo de lo que, a través de los tiempos, ha sido el SER Humano. Nunca hemos dejado ni dejaremos de pensar, en ello está nuestro futuro. A las pruebas de la Historia me remito.

Particularmente creo que el ser humano es capaz de realizar todo aquello en lo que piensa dentro de unos limites racionales.Podremos, en un futuro no muy lejano, alargar de manera considerable la media de vida.Podremos colonizar otros planetas (terraformarlos) y explotar recurso mineros en las lunas de nuestro sistema solar (las grandes compañias petroleras estarían encantadas en Titán), los turistas irán al planeta Marte o a las lunas Ganímedes o Europa.Los transportes de hoy serán reliquias del pasado y nos trasladaremos mediantes sistemas de transportes aéreos más limpios, rápidos y exentos de colisiones, sus modernos censores lo impedirán.Tendremos computadoras de cifrado cuántico que harán más seguras las comunicaciones y el intercambio de datos será realmente el de la velocidad de c, y así en todos los campos del saber humano.

En el nombre “Internet del Futuro” se asocian una serie de conceptos y tecnologías que abarcan desde la infraestructura de red, dispositivos e interfaces, software y aplicaciones que compondrán el que en unos años conformará el panorama de las Tecnologías de Información y Comunicaciones.

Entre estos temas, aparece la red de redes de gran velocidad y llegando a todas partes, mediante nuevos dispositivos, con nuevas formas de interaccionar con el mundo digital, acceso fácil e inteligente los diferentes tipos de contenidos con mención especial a 3D, y todo ello soportado por innovadores modelos de negocio adaptados a este nuevo panorama.

A los jóvenes no hay que convencerles de que Internet es imprescindible. El futuro para ellos es ya hoy. Una reciente encuesta pone de relieve la enorme vocación juvenil de tomar la red como bandera generacional. De hecho ellos, los jóvenes lo van a construir y modelar a su gusto y, probablemente, el Internet del futuro poco se parecerá al Internet que conocemos hoy. Alguien ha dicho: “Hoy, Internet está en su Prehistoria”. Lleva toda la razón

Estamos inmersos en un avance exponencial, imparable.

Se podría decir que, gracias a los Aceleradores de Partículas, podemos jugar con los átomos para mirar en su interior y saber, de qué está hecha la Materia que nos confroma a nosotros, a las estrellas y a los mundos de las galaxias del Universo.

Otro ejemplo de una idea “inverificable” la tenemos en la existencia del átomo.En el siglo XIX, la hipótesis atómica se reveló como el paso decisivo en la comprensión de las leyes de la química y la termodinámica.Sin embargo, muchos físicos se negaban a creer que los átomos existieran realmente, los aceptaban como un concepto o herramienta matemática para operar en su trabajo que, por accidente, daba la descripción correcta del mundo.Hoy somos todavía incapaces de tomar imágenes directas del átomo debido al principio de incertidumbre de Heisemberg, aunque ahora existen métodos indirectos.En 1.905, Einstein proporcionó la evidencia más convincente, aunque indirecta, de la existencia de átomos cuando demostró que el movimiento browniano (es decir, el movimiento aleatorio de partículas de polvo suspendidas en un líquido) puede ser explicado como colisiones aleatorias entre las partículas y los átomos del líquido.

Ejemplo en el que se observa la variación de los valores de la dimensión de masa y de la dimensión del contorno calculada por el método del compás en los siguientes DLA.

Otra posibilidad de crecimiento DLA es el vertical. Las partículas se lanzan desde lo alto y las partículas fijas se sitúan en el fondo del recipiente. Se puede observar en la siguiente figura como cuando una formación sobresale, las de sus lados dejan de crecer. Esto es debido a que las más grandes absorben los recursos de las más pequeñas e impiden su crecimiento, fenómenoque se da en la naturaleza cuando un árbol grande impide que crezcan los que están a su alrededor quitándoles los recursos de luz, agua…

Por analogía, podríamos esperar la confirmación experimental de la física de la décima dimensión utilizando métodos indirectos que aún ni se han inventado o descubierto.En lugar de fotografiar el objeto que deseamos, quizá nos conformaríamos, de momento, con fotografiar la “sombra” del mismo.

Bueno, con la imagen de la sombra podemos tener una idea, bastante acertada de la imagen original, el movimiento lo delata

También la existencia de los neutrinos, propuestos por Wolfgang Pauli en 1.930, para dar cuenta de la energía perdida en ciertos experimentos sobre radiactividad que parecían violar la conservación de la materia y la energía, también digo, era inverificable (en aquel momento).Pauli comprendió que los neutrinos serían casi imposibles de observar experimentalmente, porque interaccionarían muy débilmente y, por consiguiente muy raramente con la materia.La materia, toda la materia, si profundizamos en ella a niveles microscópicos, podremos comprobar el hecho de que, en un 99% está constituida de espacios vacíos y, siendo así, los neutrinos pueden atravesarla sin rozar siquiera sus átomos, de hecho, pueden atravesar la Tierra como si ni siquiera existiera y, al mismo tiempo, también nosotros somos atravesados continuamente por billones de neutrinos emitidos por el sol, incluso por la noche.

Unos quieren pesar planetas y otros neutrinos pero, todos quieren saber sobre los misterios del Universo

Hablando de neutrinos recuerdo cuando el experimento Opera de los neutrinos pusiera en tela de juicio la teoría de Einstein, la medición de la luz proveniente de las galaxias confirmaron por primera vez a escala cósmica la teoría de la relatividad del genio físico.Sin embargo, no en una, sino en varias ocasiones han querido quitarle al bueno de Einstein el honor de haber marcado el límite de velocidad en nuestro Universo

Pauli admitió: ”He cometido el pecado más grave, he predicho la existencia de una partícula que nunca puede ser observada”. Él predijo la existencia del neutrino para explicar “la masa perdida” en procesos de desintegración.

Pero incluso Pauli, con todos sus enormes conocimientos, se equivocaba, y el neutrino ha sido comprobado mediante distintos métodos que no dejan dudas de su existencia. Incluso producimos regularmente haces de neutrinos en colisionadores de átomos, realizamos experimentos con los neutrinos emitidos por reactores nucleares y, detectamos su presencia en enormes depósitos de agua pesada colocados en profundas minas abandonadas en las entrañas de la Tierra. Cuando una espectacular supernova de iluminó en el cielo del hemisferio sur en 1.987, los físicos registraron una ráfaga de neutrinos que atravesaron sus detectores situados, precisamente, en profundas minas.

El Enorme recipiente lleno de agua pesada (SNOLSB), delatará a los neutrinos que lo atraviesen.

Dentro de una antigua mina de Sudbury (Ontario, Canadá) está ubicado el complejo de investigación astrofísica SNOLAB. Una de sus instalaciones es el Observatorio de Neutrinos (ONS, en la imagen). Los neutrinos son partículas subatómicas con una masa tan ínfima —se ha calculado que menos de una milmillonésima parte de la masa de un átomo de hidrógeno— que pueden atravesar la materia ordinaria sin apenas perturbarla. La materia está “compuesta” en su mayor parte de vacío aunque nuestros ojos y nuestro cerebro (en primera instancia) no lo interpreten así.

Para evitar la interferencia de otras partículas cósmicas este peculiar observatorio no está situado en la superfície, sino nada menos que a dos kilómetros de profundidad en el interior de la corteza terrestre. La instalación ONS es básicamente un “cazador de neutrinos” capaz de detectar estas partículas producidas por las reacciones de fusión en el interior Sol y así poder analizar la composición del núcleo de nuestra estrella. La cubierta acrílica del ONS contiene un kilotón (1.000 toneladas) de agua pesada (D2O) que al reaccionar con los neutrinos hacen que se produzcan unos azulados destellos de radiación o luz Cherenkov, llamada así en honor del destacado miembro de la Academia de Ciencias de la Unión Soviética Pável Alekséyevich Cherenkov (1904-1990), Premio Nobel de Física de 1958 por el descubrimiento e interpretación de este fenómeno. El primer detector orbital de partículas de estas características —Detector Cherenkov— fue uno de los equipos científicos instalados en el satélite Sputnik-3, lanzado por la URSS el mismo año en que Cherenkov recibiera el Nobel.

Si hablamos de la masa de Planck, lo hacemos de la masa de una partícula cuya longitud de onda Compton es igual a la Longitud de Planck, está dada por la ecuación de arriba, donde tenemos la constante de Planck racionalizada (la h cortada con ese palito arriba), c que es la velocidad de la luz y G la constante gravitacional, la descripción de una partícula elemental de esta masa.o partículas que interacionan con energías por partículas equivalentes a ellas a través de E = mc2, requiere una teoría cuántica de la Gravedad. Como la masa de Planck es del orden de 10-8 kg (equivalente a una energía de 1019 GeV) y, por ejemplo, la masa del protón es del ordende 10-27 Kg y las mayores energías alcanzables en nuestros aceleradores de partículas actuales son de un orden (aún pequeño) los efectos de gravitación cuántica no aparecen en los laboratorios de física de partículas. Sin embargo, en el universo primitivo se cree quen las partículas tenían ejnergías del orden de la energía de Planck (representada en la ecuación de abajo) que sería la energía necesaria para llegar hasta las cuerdas.

![[energia_de_Planck.png]](http://4.bp.blogspot.com/_js6wgtUcfdQ/SoRBCBYB-xI/AAAAAAAAG4Y/xVWzNgLGads/s1600/energia_de_Planck.png)

Echando una larga mirada a la historia de la ciencia, creo que existen motivos para un moderado optimismo. Witten está convencido de que la ciencia sería algún día capaz de sondear hasta las energías de Planck.

E. Witten, padre de la versión más avanzada de la teoría de supercuerdas, la teoría M, dice:

“No siempre es tan fácil decir cuáles son las preguntas fáciles y cuáles las difíciles.En el S.XIX, la pregunta de por qué el agua hierve a 100 grados era desesperadamente inaccesible.Si usted hubiera dicho a un físico del siglo XIX que hacia elS. XX sería capaz de calcularlo, le habría parecido un cuento de hadas…. La teoría cuántica de campos es tan difícil que nadie la creyó completamente durante veinticinco años.”

Lo mismo que otros muchos, no creo que tengamos que esperar un siglo antes de que nuestro ingenio y nuestras máquinas puedan sondear de manera indirecta la décima dimensión, alguien sabrá, durante ese periodo de tiempo, resolver esa teoría de campos de cuerdas o alguna otra formula no perturbativa.El problema es teórico, no experimental.Necesitamos alguien con el ingenio y la inteligencia necesaria (además de un enorme índice de observación), para saber “ver” lo que probablemente tenemos ante nuestras narices, utilizando para ello todos los datos e indicios existentes de gente como Einstein, Kaluza y Klein, Veneziano y Suzuki, el cuarteto de cuerdas de Princeton, Michio Kaku, Witten…, y tantos otros.

Suponiendo que algún físico brillante resuelva la teoría de campos de cuerdas y derive las propiedades conocidas de nuestro Universo, sigue existiendo el problema practico de cuándo seríamos capaces de aprovechar el poder de la teoría del hiperespacio.Existen dos posibilidades:

- Esperar que nuestra civilización alcance la capacidad para dominar energías millones de veces mayores que las de hoy.

- Encontrar civilizaciones extraterrestres que, más avanzadas, hayan dominado el arte de manipular el Hiperespacio.

Pero, si no son como esta…¡Mejor!

Antes de que Edison y sus colaboradores aprovecharan los descubrimientos de Faraday y las ecuaciones de Maxwell, sobre la electricidad y el magnetismo, para explotarlos de manera práctica, pasaron unos setenta años.

La civilización moderna depende crucialmente del aprovechamiento de esta fuerza.La fuerza nuclear fue descubierta casi con el cambio de siglo, pasó todo el siglo XX y estamos en la primera década del XXI, han pasado 100 años, y, sin embargo, todavía no tenemos medios de aprovecharla con éxito en reactores de fusión, la energía limpia que produce el Sol.

El próximo paso, el aprovechar la potencia de la teoría de campo unificado, requiere un salto mucho mayor en nuestra tecnología, aunque sea un salto que probablemente tendrá implicaciones muchísimo más importantes.

El problema reside en que obligamos a la teoría de supercuerdas a responder preguntas sobre energías cotidianas, cuando su “ámbito natural” está en la energía de Planck.Energía que sólo fue liberada en el propio instante de la creación.Es decir, la teoría de supercuerdas es una teoría de la propia creación, así nos puede explicar todas las partículas y la materia, las fuerzas fundamentales y el espacio-tiempo, es decir, es la teoría del propio Universo.

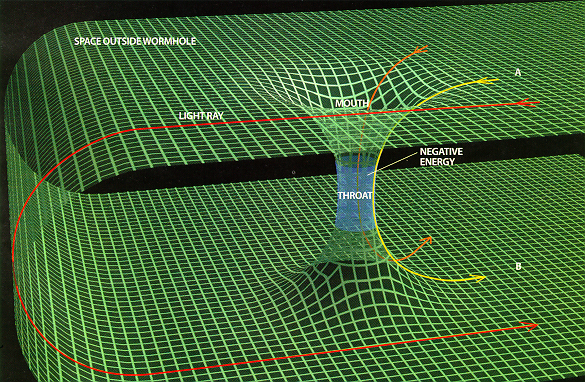

El dolor de cabezas que nos causa pensar en el espacio-tiempo y en el cómo podemos desplazarnos por él a grandes distancias de tiempo y también de espacio. ¿Se conseguirá alguna vez? ¿Será cierto que existen los Agujeros de Gusano? ¿Podremos alguna vez construir naves que surquen el Hiperespacio hacia otras galaxias y otros mundos?

Durante estos comentarios, frecuentemente he reseñado la palabra “espacio-tiempo” refiriéndome a una geometría que incluye las tres dimensiones espaciales y una cuarta dimensión temporal.En la física newtoniana, el espacio y el tiempo se consideraban como entidades separadas y el que los sucesos fueran simultáneos o no era una materia que se consideraba como obvia para cualquier observador capacitado.

En el concepto de Einstein del universo físico, basado en el sistema de geometría inventada por H. Minkowski (1864-1909), el espacio y el tiempo estaban considerados como enlazados, de manera que dos observadores en movimiento relativo podían estar en desacuerdo sobre la simultaneidad de sucesos distantes.En la Geometría de Minkowski (inspirada a partir de la teoría de la relatividad especial de Einstein), un suceso se consideraba como un punto de universo en un continuo de cuatro dimensiones.

Pero volvamos a las supercuerdas.El problema fundamental al que se enfrenta esta teoría es este: de los millones de universos posibles que pueden ser generados matemáticamente por la teoría de supercuerdas, ¿cuál es el correcto? Como ha dicho David Gross:

“Existen millones y millones de soluciones con tres dimensiones espaciales. Existe una enorme abundancia de soluciones clásicas posibles… Esta abundancia de riqueza era originalmente muy satisfactoria porque proporcionaba evidencia de que una teoría como la de la cuerda heterótica podía tener un aspecto muy parecido al mundo real. Estas soluciones, además de tener cuatro dimensiones espacio-temporales, tenían otras muchas propiedades que se asemejaban a nuestro mundo: el tipo correcto de partículas tales como quarks y Leptones, y el tiempo correcto de interacciones… Esto constituyó una fuente de excitación en su momento.”

Es difícil escenificar lo que las supercuerdas son, nunca nadie pudo ver ninguna.

Gross, sin embargo, advierte que aunque alguna de estas soluciones están muy próximas al modelo estándar, otras dan lugar a propiedades físicas muy embarazosas e indeseables, lo que finalmente se traduce en una auténtica incomodidad o problema, ya que tenemos muchas soluciones pero ninguna forma aceptable de escoger entre ellas.Además algunas tienen propiedades deseadas y otras potencialmente desastrosas.

Un profano, al oir esto por primera vez, puede quedar intrigado para preguntar: ¿por qué no calcular simplemente que solución se adapta o prefiere la cuerda? Puesto que la teoría de cuerdas es una teoría bien definida, parece enigmático que los físicos no puedan calcular la respuesta.

Lo único seguro es que los físicos seguirán trabajando a la búsqueda de la solución que, más pronto o más tarde, llegará.

Efecto túnel a través del espacio y del tiempo

¡Extraña mecánica cuántica!

Estaría bien poder saber como un electrón, cuando absorbe un fotón, desaparece del lugar que ocupa y, de manera instántanea, aparece en otro lugar más ener´getico sin haber recorrido la distancia que separa ambos lugares, es el efecto túnel o salto cuántico. ¿Cuánto podríamos ganar si aprendiéramos como se hacer eso?

En definitiva, estamos planteando la misma cuestión propuesta por Kaluza, cuando en 1.919, escribió una carta a Einstein proponiéndole su teoría de la quinta dimensión para unificar el electromagnetismo de James Clark Maxwell y la propia teoría de la relatividad general. ¿Dónde está la quinta dimensión?, pero ahora en un nivel mucho más alto.Como Klein señaló en 1.926, la respuesta a esta cuestión tiene que ver con la teoría cuántica.Quizá el fenómeno más extraordinario (y complejo) de la teoría cuántica es el efecto túnel.

El efecto túnel se refiere al hecho de que los electrones son capaces de atravesar una barrera al parecer infranqueable hacia una región que estaría prohibida si los electrones fuesen tratados como partículas clásicas.El que haya una probabilidad finita de que un electrón haga un túnel entre una región clásicamente permitida a otra que no lo está, surge como consecuencia de la mecánica cuántica.El efecto es usado en el diodo túnel.La desintegración alfa es un ejemplo de proceso de efecto túnel.

Antes preguntábamos, en relación a la teoría de Kaluza – Klein, el destino o el lugar en el que se encontraba la quinta dimensión.

El profesor Teodor Kaluza nos hablaba de la Quinta Dimensión que unificaba la Relatividad de Einstein con la Teoría de Maxwell. Todo en cinco dimensiones…Ahí comenzó toda la historia que después, desembocaron enm las supersimetrías, supergravedad, cuerdas y supercuerdas, cuerda heteráotica y teoría M…¿Qué vendrá después?

La respuesta de Klein a esta pregunta fue ingeniosa al decir que estaba enrollada o compactada en la distancia o límite de Planck, ya que, cuando comenzó el Big Bang, el Universo se expandió sólo en las cuatro dimensiones conocidas de espacio y una de tiempo, pero esta dimensión no fue afectada por la expansión y continua compactada en Lp=√(Għ/c3),cuyo valor es del orden de 10-35 metros, distancia que no podemos ni tenemos medios de alcanzar, es 20 ordenes de magnitud menor que el protón que está en 10 con exponente -15 metro.

Pues las dimensiones que nos faltan en la teoría decadimensional, como en la de Kaluza – Klein, también están compactada en una recta o en un círculo en esa distancia o límite de Planck que, al menos por el momento, no tenemos medios de comprobar dada su enorme pequeñez menor que un protón.

¿Cómo pueden estar enrolladas unas dimensiones?

Bueno, igual que para explicar de manera sencilla la gravedad mediante el ejemplo de una sábana estirada por los 4 extremos, en la que ponemos un enorme peso en su centro y se forma una especie de hondonada que distorsiona la superficie antes lisa de la sábana, al igual que un planeta distorsiona el espacio a su alrededor, de manera tal que cualquier objeto que se acerca a la masa del objeto pesado, se ve atraído hacia él.Pues bien, en las dimensiones de espacio enrolladas, utilizamos el símil de la sábana con bandas elásticas en las esquinas.

La sábana que tenemos es pequeña y la cama es grande.Con esfuerzo logramos encajar las cuatro esquinas, pero la tensión es demasiado grande; una de las bandas elásticas salta de una esquina, y la sábana se enrolla. Este proceso se llama ruptura de simetría.La sábana uniformemente estirada posee un alto grado de simetría.La sábana se enrolla.Se puede girar la cama 180º alrededor de cualquier eje y la sábana permanece igual.Este estado altamente simétrico se denomina falso vacío.Aunque el falso vacío aparece muy simétrico, no es estable. La sábana no quiere estar en esta condición estirada. Hay demasiada tensión y la energía es demasiado alta.Pero, la sábana elástica salta y se enrolla.La simetría se rompe, y la sábana pasa a un estado de energía más baja con menor simetría. Si notamos la sábana enrollada 180º alrededor de un eje ya no volvemos a tener la misma sábana.

Reemplacemos ahora la sábana por el espacio-tiempo decadimensional, es espacio-tiempo de simetría definitiva.En el comienzo del tiempo, el universo era perfectamente simétrico.Si alguien hubiera estado allí en ese instante, podría moverse libremente y sin problemas por cualquiera de las diez dimensiones. En esa época la Gravedad y las fuerzas débiles y fuertes y electromagnéticas estaban todas ellas unificadas por la supercuerda.Sin embargo, esta simetría no podía durar.El Universo decadimensional, aunque perfectamente simétrico, era inestable, la energía existente muy alta, exactamente igual que la sábana, estaba en un falso vacío. Por lo tanto, el paso por efecto túnel hacia un estado de menor energía era inevitable. Cuando finalmente ocurrió el efecto túnel, tuvo lugar una transición de fase y se perdió la simetría.

La imaginación no tiene límites y, la Naturaleza tampoco

Puesto que el Universo empezó a dividirse en un Universo de cuatro y otro de seis dimensiones, el universo ya no era simétrico. Seis dimensiones se habían enrollado (como la sábana elástica).Pero nótese que la sábana puede enrollarse de cuatro maneras, dependiendo de qué esquina haya saltado.Para el universo decadimensional, sin embargo, existen aparentemente millones de modos de enrollarse.Para calcular que estado prefiere el Universo decadimensional, necesitamos resolver la teoría de campos de cuerdas utilizando la teoría de transiciones de fase, el problema más difícil en la teoría cuántica.

Las transiciones de fase no son nada nuevo. Trasladémoslo a nuestras propias vidas.En un libro llamado PASAJES, el autor, Gail Sheehy destaca que la vida no es un flujo continuo de experiencias, como parece, sino que realmente pasa por varios estadios, caracterizados por conflictos específicos que debemos resolver y por objetivos que debemos cumplir.

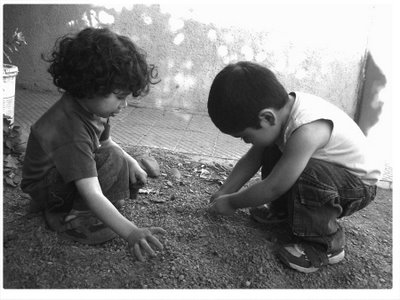

El psicólogo Eric Ericsson llegó a proponer una teoría de estadios psicológicos del desarrollo.Un conflicto fundamental caracteriza cada fase.Si este conflicto no queda resuelto, puede enconarse e incluso provocar una regresión a un periodo anterior.Análogamente, el psicólogo Jean Piaget demostró que el desarrollo mental de la primera infancia tampoco es un desarrollo continuo de aprendizaje, sino que está realmente caracterizado por estadios discontinuos en la capacidad de conceptualización de un niño.Con un mes de edad, un niño puede dejar de buscar una pelota una vez que ha rodado fuera de su campo de visión.Sin comprender que la pelota existe aunque no la vea.Al mes siguiente, esto resultará obvio para el niño.

¡Siempre aprendiendo! Jugando comenzamos a conocer cómo es el mundo.

Esta es la esencia de la dialéctica.Según esta filosofía, todos los objetos (personas, gases, estrellas, el propio Universo) pasan por una serie de estadios.Cada estadio está caracterizado por un conflicto entre dos fuerzas opuestas.La naturaleza de dicho conflicto determina, de hecho, la naturaleza del estadio.Cuando el conflicto se resuelve, el objeto pasa a un objetivo o estadio superior, llamado síntesis, donde empieza una nueva contradicción, y el proceso pasa de nuevo a un nivel superior.

Los filósofos llaman a esto transición de la “cantidad” a la “cualidad”.Pequeños cambios cuantitativos se acumulan hasta que, eventualmente, se produce una ruptura cualitativa con el pasado.Esta teoría se aplica también a las sociedades o culturas.Las tensiones en una sociedad pueden crecer espectacularmente, como la hicieron en Francia a finales del siglo XVIII.Los campesinos se enfrenaban al hambre, se produjeron motines espontáneos y la aristocracia se retiró a sus fortalezas.Cuando las tensiones alcanzaron su punto de ruptura, ocurrió una transición de fase de lo cuantitativo a los cualitativo: los campesinos tomaron las armas, tomaron Paris y asaltaron la Bastilla.

Parece que el “vacio” está bastante lleno de cosas…que no llegamos a comprender.

Las transiciones de fases pueden ser también asuntos bastante explosivos.Por ejemplo, pensemos en un río que ha sido represado.Tras la presa se forma rápidamente un embalse con agua a enorme presión Puesto que es inestable, el embalse está en el falso vacío.El agua preferiría estar en su verdadero vacío, significando esto que preferiría reventar la presa y correr aguas abajo, hacia un estado de menor energía.Así pues, una transición de fase implicaría un estallido de la presa, que tendría consecuencias desastrosas.

También podría poner aquí el ejemplo más explosivo de una bomba atómica, donde el falso vacío corresponde al núcleo inestable de uranio donde residen atrapadas enormes energías explosivas que son un millón de veces más poderosas, para masas iguales, que para un explosivo químico.De vez en cuando, el núcleo pasa por efecto túnel a un estado más bajo, lo que significa que el núcleo se rompe espontáneamente.Esto se denomina desintegración radiactiva.Sin embargo, disparando neutrones contra los núcleos de uranio, es posible liberar de golpe esta energía encerrada según la formula de Einstein E=mc2, por supuesto, dicha liberación, es una explosión atómica ¡menuda transición de fase!

Una transición de fase que perseguimos, es dominar la Galaxia, poder moldearla con nuestras manos, y, si eso llega a ser posible alguna vez, seremos los señores del Hiperespacio.Para entonces, los misteriosos agujeros negros no tendrán secretos para nosotros, las energías perdidas tampoco y…los viajes en el tiempo, serán cosa cotidiana. ¿Será realidad algún día ese pensamiento?

Las nuevas características descubiertas por los científicos en las transiciones de fases es que normalmente van acompañadas de una ruptura de simetría.Al premio Nobel Abdus Salam le gusta la ilustración siguiente: consideremos una mesa de banquete circular, donde todos los comensales están sentados con una copa de champán a cada lado.Aquí existe simetría.Mirando la mesa del banquete reflejada en un espejo, vemos lo mismo: cada comensal sentado en torno a la mesa, con copas de champán a cada lado.Asimismo, podemos girar la mesa de banquete circular y la disposición sigue siendo la misma.

Rompamos ahora la simetría.Supongamos ahora que el primer comensal toma la copa que hay a su derecha.Siguiendo la pauta, todos los demás comensales tomaran la copa de champán de su derecha.Nótese que la imagen de la mesa del banquete vista en el espejo produce la situación opuesta.Cada comensal ha tomado la copa izquierda.De este modo, la simetría izquierda-derecha se ha roto.

Así pues, el estado de máxima simetría es con frecuencia también un estado inestable, y por lo tanto corresponde a un falso vacío.

Con respecto a la teoría de supercuerdas, los físicos suponen (aunque todavía no lo puedan demostrar) que el universo decadimensional original era inestable y pasó por efecto túnel a un universo de cuatro y otro de seis dimensiones.Así pues, el universo original estaba en un estado de falso vacío, el estado de máxima simetría, mientras que hoy estamos en el estado roto del verdadero vacío.

Al principio, cuando el Universo era simétrico, solo existía una sola fuerza que unificaba a todas las que ahora conocemos, la gravedad, las fuerzas electromagnéticas y las nucleares débil y fuerte, todas emergían de aquel plasma opaco de alta energía que lo inundaba todo.Más tarde, cuando el Universo comenzó a enfriarse, se hizo transparente y apareció la luz, las fuerzas se separaron en las cuatro conocidas, emergieron las primeras quarks para unirse y formar protones y neutrones, los primeros núcleos aparecieron para atraer a los electrones que formaron aquellos primeros átomos.Doscientos millones de años más tarde, se formaron las primeras estrellas y Galaxias. Con el paso del tiempo, las estrellas sintetizaron los elementos pesados de nuestros cuerpos, fabricados en supernovas que estallaron, incluso antes de que se formase el Sol.Podemos decir, sin temor a equivocarnos, que una supernova anónima explotó hace miles de millones de años y sembró la nube de gas que dio lugar a nuestro sistema solar, poniendo allí los materiales complejos y necesarios para que algunos miles de millones de años más tarde, tras la evolución, apareciéramos nosotros.

Las estrellas evolucionan desde que en su núcleo se comienza a fusionar Hidrógeno en Helio, de los elementos más ligeros a los más pesados.Avanza creando en el Horno termonuclear, cada vez, metales y elementos más pesados.Cuando llega al hierro y explosiona en la forma explosiva deuna super nova.Luego, cuando este material estelar es otra vez recogido en una nueva estrella rica en hidrógeno, al ser de segunda generación (como nuestro Sol), comienzo de nuevo el proceso de fusión llevando consigo materiales complejos de aquella supernova.

Puesto que el peso promedio de los protones en los productos de fisión, como el cesio y el kripton, es menor que el peso promedio de los protones de uranio, el exceso de masa se ha transformado en energía mediante E=mc2.Esta es la fuente de energía que subyace en la bomba atómica.

Restos de Hipernova que produce cambios hacia el futuro del Universo

Así pues, la curva de energía de enlace no solo explica el nacimiento y muerte de las estrellas y la creación de elementos complejos que también hicieron posible que nosotros estemos ahora aquí y, muy posiblemente, será también el factor determinante para que, lejos de aquí, en otros sistemas solares a muchos años – luz de distancia, puedan florecer otras especies inteligentes que, al igual que la especie humana, se pregunten por su origen y estudien los fenómenos de las fuerzas fundamentales del Universo, los componentes de la materia y, como nosotros, se interesen por el destino que nos espera en el futuro.

Cuando alguien oye por vez primera la historia de la vida de las estrellas, generalmente (lo sé por experiencia), no dice nada, pero su rostro refleja escepticismo. ¿Cómo puede vivir una estrella 10.000 millones de años? Después de todo, nadie ha vivido tanto tiempo como para ser testigo de su evolución.

Sin embargo, tenemos los medios técnicos y científicos para saber la edad que tiene, por ejemplo, el Sol.

El Sol que nos da la vida con su luz y su calor

Nuestro Sol, la estrella alrededor de la que giran todos los planetas de nuestro Sistema Solar (hay que eliminar a Plutón de la lista, ya que, en el último Congreso Internacional, han decidido, después de más de 20 años, que no tiene categoría para ser un planeta), la estrella más cercana a la Tierra (150 millones de km=UA), con un diámetro de 1.392.530 km, tiene una edad de 4.500 millones de años.

Es tal su densidad, es tal su enormidad que, como se explicó en otro ensayo anterior de este mismo trabajo, cada segundo, transforma por medio de fusión nuclear, 4.654.000 Toneladas de Hidrógeno en 4.650.000 Toneladas de Helio, las 4.000 toneladas restantes, son lanzadas al espacio exterior en forma de luz y calor de la que, una parte nos llega a la Tierra y hace posible la vida. Se calcula que al Sol le queda material de fusión para otros 4.500 millones de años.Cuando transcurra dicho periodo de tiempo, se convertirá en una gigante roja, eyectará sus materiales exteriores al espacioy se transformará finalmente en una estrella enana blanca.Para entonces, ya no podremos estar aquí.

Cuándo mentalmente me sumerjo en las profundidades inmensas del Universo que nos acoge, al ser consciente de su enormidad, veo con claridad meridiana lo insignificante que somos, en realidad, en relación al universo, como una colonia de bacterias que habitan en una manzana, allí tienen su mundo, lo más importante para ellas, y no se paran a pensar que puede llegar un niño que, de un simple puntapié, las envíe al infierno.

Sólo somos importantes a nivel local, pretendemos serlo a otros niveles pero, ¿será posible eso?

Igualmente, nosotros nos creemos importantes dentro de nuestro cerrado y limitado mundo en el que, de momento, estamos confinados.Podemos decir que hemos dado los primeros pasos para dar el salto hacia otros mundos, pero aún nos queda un largo recorrido por delante.

Tendremos que dominar la energía del Sol, ser capaces de fabricar naves espaciales que sean impenetrables a las partículas que a cientos de miles de trillones circulan por el espacio a la velocidad de la luz, poder inventar una manera de imitar la gravedad terrestre dentro de las naves para poder hacer la vida diaria y cotidiana dentro de la nave sin estar flotando todo el tiempo, y, desde luego, buscar un combustible que procure velocidades relativistas, cercanas a c, ya que, de otra manera, el traslado por los mundos cercanos se haría interminable.Finalmente, y para escapar del sistema solar, habría que buscar la manera de romper la barrera de la velocidad de la luz.

¿Viajar en el tiempo?

Nuestra imaginación sólo es comparable a la inmensidad del Universo. Ahí radica nuestra verdadera riqueza. La curiosidad del SER humano le empuja de manera irremediable hacia su destino en las estrellas.

emilio silvera

Oct

22

Recordemos la Misión Cassini Huygens

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (13)

Comments (13)

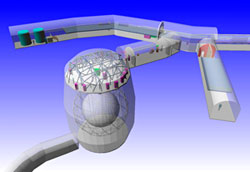

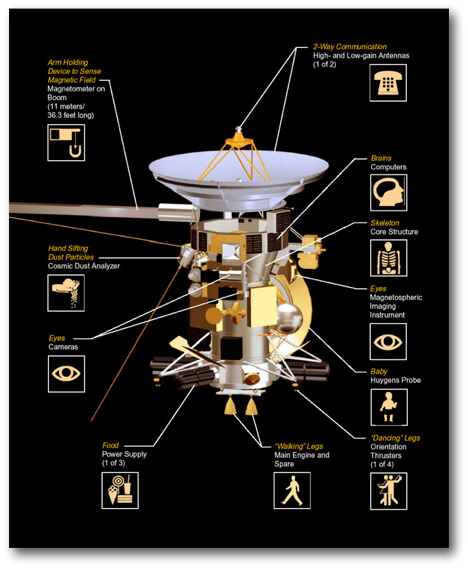

La misión Cassini servirá (ha servido) para responder a preguntas fundamentales sobre la evolución de los planetas a través de un amplio estudio de Saturno, su famoso sistema de anillos, su magnetosfera, de Titán y otras lunas heladas.

El sistema de Saturno representa un laboratorio sin igual en donde los científicos pueden buscar respuestas a muchas de las preguntas fundamentales sobre la física, química y evolución de los planetas, así como las condiciones en las que tuvo lugar el nacimiento de la vida.

Diseño de la misión Cassini-Huygens-Crédito: ESA

Saturno puede contener una buena parte de la nube de gases primordiales no atrapados por el Sol. Con 31 lunas conocidas y un sistema de anillos que apenas podría caber entre la Tierra y la Luna, Saturno puede considerarse el equivalente a un sistema solar en miniatura. Se piensa que su mayor satélite natural, Titán, puede poseer compuestos orgánicos, los cuales podrían ser importantes para la química que dio lugar a la vida en la Tierra. Aunque es muy fría para poder albergar la vida, Titán puede ser un congelador que nos muestre cómo la Tierra podría haber sido en el pasado.

Oct

22

Riemann y Euclides

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (26)

Comments (26)

La ruptura decisiva con la geometría euclidiana llegó cuando Gauss pidió a su discípulo Riemann que preparara una presentación oral sobre los “fundamentos de la geometría”. Gauss estaba muy interesado en ver si su discípulo podía desarrollar una alternativa a la geometría de Euclides.

Riemann desarrolló su teoría de dimensiones más altas.

Finalmente, cuando hizo su presentación oral en 1.854, la recepción fue entusiasta. Visto en retrospectiva, esta fue, sin discusión, una de las conferencias públicas más importantes en la historia de las matemáticas. Rápidamente se entendió por toda Europa la noticia de que Riemann había roto definitivamente los límites de la geometría de Euclides que había regido las matemáticas durante dos milenios.

Riemann creó su tensor métrico para que, a partir de ese momento, otros dispusieran de una poderosa herramienta que les hacía posible expresarse, a partir del famoso teorema de Pitágoras (uno de los grandes descubrimientos de los griegos en matemáticas que establece la relación entre las longitudes de los tres lados de un triángulo rectángulo: afirma que la suma de los cuadrados de los lados menores es igual al cuadrado del lado mayor, la hipotenusa; es decir, si a y b son los longitudes de los dos catetos, y c es la longitud de la hipotenusa, entonces a2 + b2 = c2. El teorema de Pitágoras, por supuesto, es la base de toda la arquitectura; toda estructura construida en este planeta está basada en él. Claro que, es una herramienta para utilizar en un mundo tridimensional).

Totales: 67.315.958

Totales: 67.315.958 Conectados: 35

Conectados: 35