Dic

11

¡Ese “universo” maravilloso, de lo muy pequeño!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en el futuro ~

Clasificado en el futuro ~

Comments (0)

Comments (0)

Richard Feynman

Alguna vez hemos hablado aquí de Nanotecnología pero, pocos saben que sus comienzos se remontan a 1959 cuando el físico y premio Nobel Richard Feynman pronunció en el Instituto de Tecnología de California su ahora famoso discurso (en el ámbito de la Física). Feynman trató en su conferencia del problema de la manipulación individual de objetos tan pequeños como átomos y moléculas y de las múltiples oportunidades tecnológicas que ofrecería dicha manipulación.

A él le hubiera gustado conocer la realidad actual sobre todo lo que vaticinó en aquella conferencia, ya que, al haberse cumplido todos sus pronósticos, estaría satisfecho al ver que llevaba razón y sus ideas estaban bien encaminadas. La Nanociencia y la Nanotecnología son hoy un conjunto de conocimientos teóricos y prácticos que permiten determinar como se comporta el denominado nanamundo (el ámbito en el que el tamño de los objetos tienen entre 1 y 100 nm). A partir de estos conocimientos se están haciendo continuamente interesantes y arriesgadas apuestas sobre nuevos procedimientos.

Pero los seres humanos no somos los primeros nanotecnólogos. Ese honor le corresponde a cualquier célula, sea esta una bacteria, un protozoo o un fibroblasto. Las células están continuamente realizando procesos nanotecnológicos para mantenerse vivas. Como siempre, los seres humanos estamos aprendiendo a copiar procesos que se llevan a cabo en la Naturaleza con la esperanza de mejorarlos y beneficiarnos de ellos.

La elaboración de materiales nanoestructurados tridimensionales – aquellos que tienen formas distintivas y estructuras a escalas de unas pocas millonésimas de un metro – se ha convertido en un área fértil de investigación, produciendo materiales útiles para dispositivos biomédicos, fotónica y electrónica.

Sin embargo, los métodos de elaboración de materiales han estado limitados en la complejidad 3D que pueden producir. Ahora, un equipo del MIT ha encontrado una manera para producir estructuras más complicadas utilizando una mezcla de enfoques Top-down y Bottom-up.

En aquel discurso de Feynman, no se pronunció, sin embargo, la palabra Nanotecnología. Dicho término no fue acuñado hasta 1974 por el profesor N. Taniguchi de la Universidad de las Ciencias de Tokio en un artículo titulado “On the Basic Concept of ´Nanotecnolgy´”. Se presentó en una conferencia de la Sociedad Japonesa de Ingenieria de Precisión. En este contexto, la Nanotecnología se presenta como la tecnología que nos permite separar, consolidar y deformar materiales átomo a átomo o molécula a molécula.

En la Nanotecnología suelen intervenir Ingenieros, Físicos, Químicos, Bioquímicos, Biólogos, Médicos y perfiles de todos aquellos campos dónde la nanotecnología tiene aplicación. La nanotecnología es un sector transversal. Un campo de las ciencias aplicadas a tecnologías que pueden ayudar a optimizar la cadena de valor de cualquier proceso de producción, permitiendo implementar el ratio de competitividad de las empresa. Es tecnología punta y, va estando presente en infinidad de máquinas y sofisticados aparatos que, tanto en la Tierra con el en Espacio, llevan a cabo cometidos de todo tipo con una garantía y seguridad que antes era imposible obtener.

Aquellas semillas sembradas por Feynman y regadas por Taniguchi, empezaron a germinar cuando E. Drexter publicó su libro titulado “Engines of Creation” en el que describe como será viable construir desde ordenadores hasta maquinaria pesada, ensamblando molécula a molécula, ladrillo a ladrillo, mediante nanorobots ensambladores, que funcionarán de un modo parecido a como lo hacen los ribosomas y otros agregados moleculares en las células de nuestro cuerpo (siempre copiando a la Naturaleza). Este conjunto de ideas -1960-1990-, han sido el punto de arranque de lo que hoy en día conocemos por Nanotecnología, el bagaje creciente de conocimientos teórico-prácticos que nos permitirán dominar la materia en la región de dimensiones comprendidas entre 1 y 100 nm, y que denominamos nanoescala que es el ámito de la Nanotecnología y la Nanociencia.

Si vamos ya a ejemplos concretos de interrelaciones entre estas tecnologías en desarrollo encontraremos una importante cantidad de trabajo dirigido al área de la salud, por ejemplo en el campo de los biosensores y técnicas de diagnóstico, en donde se unen principalmente herramientas nano y bio, siempre apoyadas por la tecnología de la información. Así mismo, aparecen los proyectos dirigidos a desarrollar tratamientos médicos localizados o al transporte y suministro local de fármacos. También en el campo de la salud, una imprescindible sinergia está ya establecida entre la bio y la info en lo que se llama la bioinformática, que permite por ejemplo diseñar fármacos computacionalmente, desarrollar terapias génicas o la ingeniería genética en los cultivos. Sobre las ciencias cognitivas, sus aplicaciones e interacciones con las otras tecnologías, también encontramos importantísimas áreas de trabajo ya en marcha, como es el caso del desarrollo de órganos artificiales o prótesis inteligentes, combinando los conocimientos de neurociencia, principalmente con tecnologías de la información y bio, y en muchos casos, con el área de nuevos materiales desarrollados gracias a la nanotecnología. De manera general, para entender mejor el funcionamiento del cerebro (ciencias cognitivas), tendremos que apoyarnos fuertemente en las herramientas que nos brinda la biotecnología y la tecnología de la información, que, a su vez aprovechará las conclusiones que se vayan obteniendo para proponer nuevas aplicaciones.

Si vamos ya a ejemplos concretos de interrelaciones entre estas tecnologías en desarrollo encontraremos una importante cantidad de trabajo dirigido al área de la salud, por ejemplo en el campo de los biosensores y técnicas de diagnóstico, en donde se unen principalmente herramientas nano y bio, siempre apoyadas por la tecnología de la información. Así mismo, aparecen los proyectos dirigidos a desarrollar tratamientos médicos localizados o al transporte y suministro local de fármacos. También en el campo de la salud, una imprescindible sinergia está ya establecida entre la bio y la info en lo que se llama la bioinformática, que permite por ejemplo diseñar fármacos computacionalmente, desarrollar terapias génicas o la ingeniería genética en los cultivos. Sobre las ciencias cognitivas, sus aplicaciones e interacciones con las otras tecnologías, también encontramos importantísimas áreas de trabajo ya en marcha, como es el caso del desarrollo de órganos artificiales o prótesis inteligentes, combinando los conocimientos de neurociencia, principalmente con tecnologías de la información y bio, y en muchos casos, con el área de nuevos materiales desarrollados gracias a la nanotecnología. De manera general, para entender mejor el funcionamiento del cerebro (ciencias cognitivas), tendremos que apoyarnos fuertemente en las herramientas que nos brinda la biotecnología y la tecnología de la información, que, a su vez aprovechará las conclusiones que se vayan obteniendo para proponer nuevas aplicaciones.

Claro que, trabajar con objetos tan pequeños entraña una gran dificultad, y de hecho fue prácticamente imposible hasta que se desarrollaron los microscopios de campo cercano (SPMs) a partir del miscroscopio de Efecto Túnel (STM que fue inventado por H. Rohrer y G. Binning a principio de la década de los 80, contribución por la que recibieron el premio Nobel en 1986. Las herramientas SPM permiten no sólo la visualización, sino también la manipulación de objetos de dimensiones nanométricas y de muy distinta naturaleza.

Aventurarse a predecir futuras aplicaciones del conocimiento científico siempre resulta una tarea arriesgada, y con más razón cuando se trata de un conocimiento tan joven como la Nanociencia. No obstante, a la luz del camino ya recorrido es posible adivinar algunas de las implicaciones futuras de este conocimiento. Los campos científicos y tecnológicos que podrían beneficiarse a medio o largo plazo son muchos y variados.

Sin ánimo de ser exhaustivos, podemos destacar algunas de las ramas del saber y de la técnica que pueden aplicar la Nanotecnología en un futuro no demasiado lejano.

Nanomateriales

A medio plazo podemos destacar las siguientes mejoras:

– Televisores y pantallas para presentar información. Se pretende aumentar el área útil de estos dispositivos, mejorando el brillo de los actuales TFT. Nanocristales de seleniuro de cinc o de sulfuro de cadmio con candidatos muy prometedores que, además, permitirían reducir el consumo energético.

– Aditivos en aditivos: Se ha comprobado que las nanopartículas de óxido de cerio permiten reducir el gasto de diesel.

– Baterias diesel:clara la necesidad de aumentar la capacidad de almacenamiento de energía de las baterías que se utilizan en dispositivos móviles (ordenadores portátiles, teléfonos). Se ha comprobado que los nanocristales sintetizados por técnicas sol-gel mejorar dicha capacidad debida a su estructura aerogel.

– Catálisis: La eficacia de este proceso depende fundamentalmente del área, y la razón área/volumen es mayor en partículas de pequeño tamaño.

Nanomateriales aplicados a dispositivos electrónicos y los tres tipos de geometrías de nanotubos de carbono

Las aplicaciones a largo plazo podrían ser:

- Composites de nanotubos de carbón, que deberían presentar unas excepcionales propiedades mecánicas (alta resistencia y poco peso).

- Lubruicantes: Se pretenden utilizar nanoesferas de materiales inorgánicos que actúen como pequeños rodamientos, reduciendo el desgaste de superficies sometidas a grandes tensiones mecánicas.

- Materiales mangnéticos: Los nanocristales de ytrio-samario-cobalto presentan grandes campos cohercitivos. Su uso mejoraría las prestaciones de ciertos instrumentos como aquellos utilizados en Resonancia Magnética Nuclear. Asimismo, podrían mejorar la capacidad de almacenamiento de información de los discos duros empleados por los ordenadores.

Electrónica

- Miniaturización de circuitos integrados: Esta objetivo sigue siendo esencial para el desarrollo de la electrónica tal y como la conocemos hoy día. Se cree que la tecnología de 22 nm estará disponible en unos 10 años.

- Cristales fotónicos, con mejores rendimientos para focalizar haces de luz, mejorando la eficiencia de las guías de luz. Por ejemplo, un típico cristal fotónico podría estar basado en redes de agujeros realizados en un dieléctrico, cada uno fabricado con una precisión inferior a los 10 nm. Las imperfecciones deben ser necesariamente pequeñas porque en caso contrario se degradan las bandas prohibidas de estos dispositivos.

- Computación Cuántica y criptografía cuántica: Los puntos cuánticos basados en semiconductores son candidatos ideales para fabricar dispositivos que permitan aplicar todas las teorías que ya existen sobre computación y criptografía cuánticas.

- Sensores: El sensor ideal es aquel de pequeño tamaño que resulte mínimamente invasivo. Para fabricar un dispositivo de 1 mm2 que contenga una fuente de alimentación, el sensor y el transmisor de la señal es indudable que se requiere una alta miniaturización.

Diferentes geometrías de cristales fotónicos

Biotecnología

- Nanofarmacología: El transporte de los fármacos a los lugares específicos del cuerpo donde son necesarios reduce la necesidad de ingesta alta dosis de los mismos y mejora su eficacia. Así, se especula que los nanocristales de plata podrían liberar iones de plata durante un largo intervalo de tiempo, actuando sobre un espectro de unos 150 agentes patógenos.

- Nanosensores: Al disminuir su tamaño resultan menos invasivos y por tanto más beneficiosos para el diagnóstico médico.

- ADN: Sus propiedades de carácter semiconductor cuando se ha eliminado el agua son muy prometedoras para su uso como nanohilos. Además, tiene unas cualidades muy atractivas para su aplicación en nanoelectrónica por su capacidad para auto-ensamblarse y duplicarse. Se alcanzaría así el objetivo de conseguir circuitos electrónicos con capacidad para auto-repararse.

Molécula de ADN

Todos estos conocimientos generados han desembocado en la puesta a punto de diferentes iniciativas (programas de investigación, nuevos centros y equipamientos, proyectos futuristas, ingenios espaciales, óptica, medicina, ingeniería, fotónica, computación, robótica, etc. Y, pocas dudas nos pueden caber a estas alturas de que, todo este nuevo “universo” de lo NANO, desembocará en un nuevo mundo de tecnología muy tangible y real en nuestro futuro próximo. La gran belleza de estos experimentos y nuevas técnicas, junto a las enormes e ilimitadas espectivas que de ellos se generan han conducido a la proliferación del prefijo “nano” (no pocas veces un tanto abusiva y con el simple objetivo de revalorizar el producto o la linea de investigación). Así podemos oir hablar de disciplinas como nanoquímica, nanoelectrónica, nanofotónica, nanomedicina o nanobiotecnología; o de objetos tales como nanopartículas, nanotubos, nanoimánes o nanomotores. Es decir, el colocar el prefijo “nano” delante de una palabra determinada nos indica que ese campo se va estudiar enfatizando aquellos aspectos del mismos relacionados con la nanoescala.

Los más fiables y sofisticados aparatos son empleados hoy para desarrollar estas tecnologías que, si buscamos un símil sencillo, el fundamento en que se baza gran parte de la tecnología actual se asemeja al trabajo realizado por un escultor, que cincela, pule y modela un bloque de material para obtener un objeto más pequeño con la forma deseada. Puesto que cada vez son más necesarias tecnologías de fabricación más precisas, es importante disponer de tamños de “cincel” cada vez más pequeños y, también, más precisos. Este planteamiento es conocido como tecnología de fabricación descendente o “top-down” (arriba y abajo, el nombre de los quarks que conforman a los protones y neutrones).

Se están consiguendo maravillas en el campo de la electrónica molecular. El potencial de las moléculas como componentes electrónicos manométricos. Variando la estructura de moléculas especialmente diseñadas que contienen átomos de metales de transición, como el cobalto en un caso y un par de átomos de vanadio en el otro ,se consigue obtener las características similares a de un transistor y establecer un flujo de corriente a través de un estado cuantico. El siguiente dibujo es una representación de un complejo cobalto-terpiridinil (cobalt-terpyridinyl) (a la izquierda) y de una molécula di vanadio(a la derecha) unidas ambas a electrodos de oro.

Investigadores de la universidad de Cornell y de la universidad de Harvard informaron sobre el desarrollo de este sistema de un solo átomo del cobalto en un caso y dos átomos del vanadio en el otro. Todo una hazaña increíblemente difícil de realizar, construir estos circuitos requirió la fabricación de “moléculas diseñadas” integradas por varios átomos dispuestos a modo de andamio en donde los átomos de cobalto o de vanadio se ubican en forma central.

Una pequeña molécula de 1 a 2 nm(nanómetro) de longitud se une a dos electrodos de oro, los cuales se depositan en una superficie de oxido de silicio.Infinidad de experimentos y funciones son objetos de los más variados proyectos

La Electrónica se hace molecular y la molécula Memoria

Por ejejmplo, una punta de cobalto sobre un colorante azul finamente fijada en una isla de cobalto emplatada en una base de cobre. Parece una receta de cocina de vanguardia, pero no, es molectrónica, electrónica molecular nanométrica. Un equipo de instituto tecnológico de Karlsruhe ha conseguido un detector magnético de un nanómetro de diámetro, basado en una molécula orgánica común (el azul de los bolis) y un fenómeno mecanocuántico la magnetorresistencia gigante. Rico, rico, veamos el sencillo fundamento.

Magnetorresistencia gigante mediante una única molécula de H2 ftalocianina. Electrónica molécular de espín. Representación del dispositivo compuesto por una isla base de cobalto sobre la que se deposita una sola molécula de ftalocianina, la punta a escala atómica de cobalto. La escala del dispositivo es realmente sorprendente, el diámetro de la molécula orgánica es de 0.6 nm de diámetro y la fila de diez átomos de cobalto (Co) es de unos 1.5 nm. De longitud.

La magnetoresistencia es la variación de la resistencia que ofrece un material cuando se aplica sobre él un campo magnético. La magnetorresistencia gigante es un fenómeno cuántico, a escalas pequeñas, se da en estructuras de finísimas capas ferromagnéticas separadas por un espaciador no magnético, un sandwidch don el pan conduce y la mortadela no. Cuando se aplica un campo magnético externo disminuye muchísimo la resistencia eléctrica al alinearse los espines de los electrones de todas capas.

La idea que subyace es utilizar la simple química de moléculas orgánicas comunes, como la utilizada en la tinta azul de los bolis y unirla a su peculiar física cuando se depositan como una capa monoatómica entre dos sustratos ferromagnéticos. Se aúna electrónica molecular, con la electrónica de espín ‘espintrónica’. Son las moléculas de hidrógeno ftalocianina las que actuarán como transistores, resistencias y unidades del circuito electrónico.

Científicos en Suiza han logrado visualizar hace una semanas los atomos que forman la molécula del pentaceno, representando un hito en el ámbito de la nanotecnología y la electrónica molecular. La molécula es el pentaceno (C22H14), consistente en cinco anillos de benceno enlazados formando una cadena aromática, que es candidato a ser utilizada en nuevos semiconductores orgánicos.

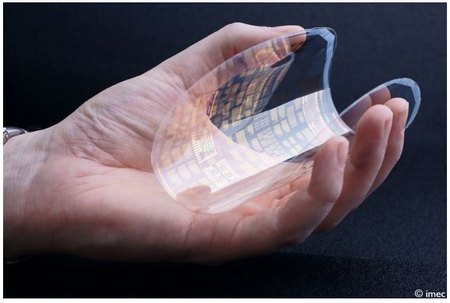

Investigadores europeos informaron en el Internacional Solid-State Circuits Conference de San Francisco, California, el desarrollo del primer microprocesador flexible orgánico. Los investigadores, especialistas en polímeros y electrónica molecular, son del Imec, un centro de investigación de nanotecnología de Belgica.

El mayor escollo para desarrollar esta tecnología, según el leader del equipo de investigadores, Jan Genoe, fue encontrar la forma de controlar los transistores orgánicos, pues cuando se habla de estructura, el silicio es mejor que las alternativas orgánicas pues su estructura monocristalina permite una reacción más consistente.

El costo de estos tipos de procesadores es mucho más baratos que los de silicio. Más o menos costaría producirlos solo el 10 % de lo que cuesta producir uno de silicio.

Según la fuente, este descubrimiento puede ser el inicio de un montón de aplicaciones que van desde poder registrar la presión del agua, cuando se lo coloca alrededor de una caño, hasta empaquetar alimentos y drogas de farmacia, ya que podría indicar el estado de la comida y avisar cuando nos olvidamos de tomar una medicina.

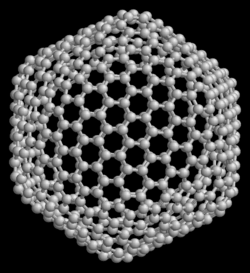

Fullereno C540.

Ampliamente hemos hablado aquí de los fullerenos y Nanotubos de carbono, Grafeno, Nanohilos y Nanopartículas y seguiremos hablando en el futuro, todos estos bocablos y palabras nuevas son las que están desceribiendo las tecnologías que nos llevarán hacia adelante y, si queremos estar al día, si deseamos no quedarnos atras, debemos estar pendientes de todo lo que se mueva en ese “nuievo” campo de la Ciencia que, de seguro, nos dará muchas alegrías.

¿Hasta dónde podremos llegar?

¿Qué límite nos impondrá la Naturaleza?

O, al ser también nosotros parte de ella, nos dejará acercarnos tanto que, podremos, finalmente, confundirnos con ella al llegar a entenderla tan profundamente que, nada se interpone para que, nos podamos fusionar en un abrazo final cuando, llegado el momento y, convertidos en pura luz de energía infinita, podamos vagar por las estrellas del Universo siendo parte, una importante parte, de todo ese complejo conglomerado que llamamos Universo.

emilio silvera

Dic

11

De flores y explosiones

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en No solo de pan vive el hombre ~

Clasificado en No solo de pan vive el hombre ~

Comments (0)

Comments (0)

El filósofo José Antonio Marina

Mis lecturas hace tiempo ya que se limitan a Revistas científicas y culturales, y, de vez en cuando, me paso la tarde repasando algunas que, por algún motivo, llamaron mi atención y me aconsejó guardarlas, contra la lógica protesta de mi santa mujer: ¡Pero hombre, ¿dónde van a caber tantas revistas y libros? ¿Te has empeñado en echarnos de casa? Bueno…¡lo de siempre!

Me encontré de pronto con un pequeño trabajo del Filósofo, ensayista y pedagogo toledano, José Antonio Marina Torres, y, por su agradable lectura y el cierto encanto poético que el escrito resuma, me ha parecido bien trasladarlo aquí, para que todos ustedes disfruten como lo hice yo cuando aquel lejano día de mayo de 2.005, lo pude leer por vez primera.

Diario de Un curioso

La capacidad poética de la inteligencia a través de formas plásticas, lengüisticas, musicales o matemáticas, la teoría de cuerdas y las paradojas del big bang son algunas de las cuestiones que aborda el filósofo José Antonio Marina.

En mi jardín han florecido los narcisos. Sus campánulas tienen unos coquetos bordes rizados. A veces la Naturaleza parece presumida. Algunos tulipanes son cartesianos y otros en cambio exhiben un tupé barroco. Las berzas que he inventado se povonean con grandes hojas ondulantes. Ya lo dijo Neruda en su versión poética de la huerta: “La col / se dedicó / a probarse faldas”. Estos rizos son rupturas espontáneas de simetría, y acabo de leer un artículo de Eran Sharon donde lo explica, aunque en realidad ya lo explicó Gauss con su teorema de la curvatura. Las tensiones del crecimiento resultan excesivas para integrarse en una métrica plana y buscan una línea de fuga.

¿Anula la belleza del narciso, o de las gloxinias, o de las escarolas, saber que sus ágiles líneas están dirigidas por una ecuación? En absoluto. La capacidad poética de la inteligencia puede recrear la realidad con muchos idiomas: plásticos matemáticos, musicales, lingüísticos.

Vuelvo a leer sobre la teoría de cuerdas, a la espera de que se acabe de construir en Suiza el Large Hadrón Collider, el mayor acelerador de partículas, para intentar una corroboración experimental. Esta teoría pretende dar una visión unificada de las cuatro fuerzas del Universo. En el fondo del fondo lo que hay son cuerdas que vibran en distintas frecuencias, como las de los instrumentos musicales. Las notas que producen son las partículas elementales: electrones, neutrinos, fotones, bosones, gluones, gravitones.

¡Si Pitágoras -que dijo que el último componente de la realidad eran el número y la música- levantara la cabeza! Hablo de estas cosas porque he estado en Santiago de Compostela hablando una vez más sobre la Universidad. Creo que un agregado de facultades y escuelas técnicas no es una Universidad, sino un desastrado cajón de sastre de organizaciones autónomas. Se convierte en Universidad cuando emerge de un proyecto humanista unificado.

Universidad de Santiago de Compostela

En el origen está la inteligencia humana que se despliega por múltiples caminos, y debemos mantener la referencia a esa fuente primordial para comprender lo que estamos haciendo. Les pondré un ejemplo. Las Universidades colaboran o compiten con las empreas privadas en temas de investigación. Pues bien, creo que son dos modos distintos de investigar. Un químico universitario y un químico empresarial usan la misma química, por supuesto, pero de distinta manera. El investigador universitario debe conocer su disciplina, pero además está obligado a tener un conocimiento reflexivo, humanista, de lo que está haciendo. Al fin y al cabo, la Universidad debería ser la conciencia reflesiva de la sociedad.

¡No podemos evitarlo! Nuestra tendencia es poner la mano en la Naturaleza misma

La ciencia me apasiona como una novela de intriga,sobre todo cuando parece toparse con paradojas insalvables. He leído un artículo, escrito por Charles Lineweaver y Tamara Davis, astrónomos del Observatorio de Monte Stromlo, en Camberra, sobre las paradojas del big bang. Hace 40 años se anunció un descubrimiento que probaba que el universo se había expandido desde un estado primordial caliente y denso: el fondo cósmico de microondas, rescoldo frío de la gran explosión. Pero ¿que se quiere decir cuando se afirma que el universo se está expandiendo? ¿Hacia dónde se expande? ¿Se expande también la Tierra? Para complicar más las cosas parece que esa expansión se acelera.

Todo esto resulta difícil de comprender, porque el universo no tiene bordes, no está en ningún lugar, que diría el viejo Aristóteles. ¿Cómo puede entonces expandirse? Las distancias a las galaxias remotas aumentan, pero eso no quiere decir que viajen a través del espacio. Es el espacio el que se expande entre las galaxias y nosotros. En este sentido, el universo se contiene así mismo, no requiere ni un centro desde el que dilatarse, ni un espacio vacío donde expandirse. La gran explosión no fue una explosión en el espacio, sino del espacio. Sucedió en todos los puntos a la vez. El centro está en todas partes.

Este relato cosmogónico, tan bello como el de Hesíodo, plantea algunos problemas. Edwin Hubble descubrió hace muchos años la constante que cuantífica la rapidez con que el universo se expande, y predice que a partir de una determinada distancia, llamada “distancia de Hubble”, cifrada en catorce mil millones de años-luz, las galaxias se alejan a una velocidad mayor que la de la luz.

Y como pasas en un pastel o lunares en un globo que se hincha, cuanto más distantes están las galaxias más deprisa se separan.

¿Contradice este hecho la teoría de la relatividad, que considera que la luz es el esprinter invencible del universo? Parece que no, porque la relatividad sólo se aplica a los movimientos en el espacio, no a la expansión del mismo espacio. Espacio y luz compiten en maratones diferentes. Estas historias me recuerdan una escena de Annie Hall. El alter-ego infantil de Woody Allen explica a su médico y su madre la razón de que no vaya al colegio: “El universo está en expansión… El universo lo es todo y si se expande sin parar algún día se romperá, ¡y eso será el final de todo!” A lo que su madre le replica muy sensatamente: “Pero tu está en Br00klyn, ¡y Brooklyn no está en expansión!”.

Para terminar, y dadas las fechas que se acercan, os dejo otro de los pensamientos de José Antonio Marina, el filófoso que pretende entrar en la mente de la Sociedad moderna para decirles: “Abrid bien los ojos, procurad ver lo que la realidad esconde”. Detrás de las cosas que creemos ver…¡siempre hay, algo más!

La Frase del El Mundo

“La Navidad es un símbolo religioso y me extraña que a nadie se le haya ocurrido quitarlo.”

Dic

10

¡Las estrellas! Que nos hablan de como evoluciona el Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en las estrellas y la Vida ~

Clasificado en las estrellas y la Vida ~

Comments (6)

Comments (6)

Hace algún tiempo que salió la noticia en los medios: “Un equipo de científicos europeos, entre ellos investigadores del Instituto de Astrofísica de Canarias (IAC), ha hecho públicos los resultados de 30 años de investigación sobre la estrella hipergigante HR 8752, que han revelado el eslabón perdido en la evolución de este tipo de astros.Concretamente, han descubierto que, la región inestable conocida como Vacío Evolutivo Amarillo, puede cambiar profundamente la evolución de una estrella ya que, en estas tres décadas, HR 8752 ha aumentado de forma espectacular su temperatura superficial en 3.000 Kelvin (K) a su paso por esta región.”

Los resultados obtenidos venían a desvelar algunos misterios que antes, no tenían explicación.

Aquí tenemos a R Leporis, una estrella de Carbono a la que se puso el nombre de la “Estrella Carmesí”, o, la “Gota de Sangre”.

R Leporis (R Lep / HD 31996 / HR 1607) es una estrella variable de la constelación de Lepus, cerca del límite con Eridanus. Visualmente es una estrella de un color rojo vívido, cuyo brillo varía entre magnitud aparente +5,5 y +11,7. Descubierta por John Russell Hind en 1845, es también conocida como Estrella carmesí de Hind.

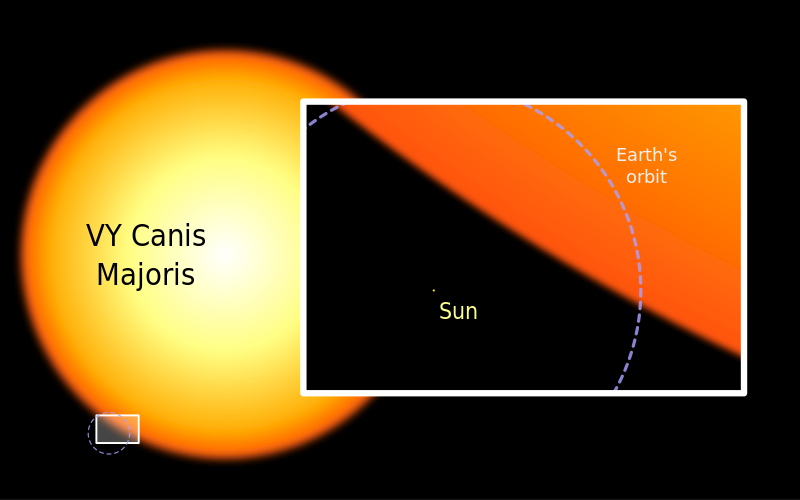

Del grupo destaca Antares, una supergigante M 1,5, 10 000 veces más luminosa que el Sol y con un diámetro que es probablemente más de 500 veces el del Sol. Nos contempla desde 520 a.l. de distancia y tiene una compañera enana. Su color es el rojo intenso.

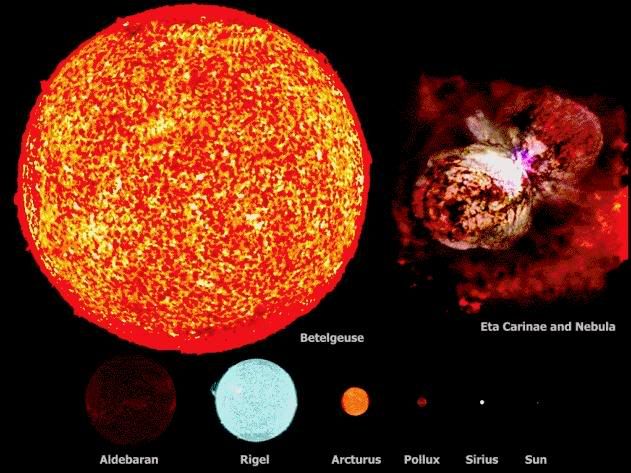

Aldebaran, la estrella Alfa Tauri, es una Gigante K5. Aparentemente forma parte del grupo de estrella de las Hyades, aunque en realidad sólo está a 60 a.l., aprpoximadamente la mitad de la distancia del cúmulo.

Betelgeuse, la estrella Alfa Orionis, la décima más brillante del cielo, es una gigante tipo M2 que es una variable semirregular. Se dice que está a unos 400 a.l. de la Tierra y su luminosidad es 5000 veces superior a la del Sol pero, si se encuentra a la misma distancia de la Asociación de Orión (como algunos postulan), la luminosidad verdadera sería de 50 000 veces la del Sol. Su diámetro es cientos de veces el del Sol. Su brillo varía a medida que se expande y contrae en tamaño.

Arthurus es la estrella Alfa Boötis, magnitu -o,o4, la estrella más brillante al norte del ecuador celeste y la cuarta más brillante de todo el cielo. Es una gigante K 1 situada a 35 a.l.

Rigel, la estrella Beta Orionis de magnitud o,12 es una gigante B 8 siatuada a 1 400 a.l., su luminosidad es de unas 150 000 veces la del Sol, tiene una compañera de magnitud 6,8, que es a su vez una binaria espectroscópica.

Al lado de estas gigantes, el Sol y otras estrellas resultan minúsculos como podemos ver en la imagen y, sin embargo, ya sabemos todos la importancia que nuestro Sol tiene para hacer posible la vida en la Tierra.

¡No por pequeño se es insignificante! Ya sabéis: ¡Todo lo grande está hecho de cosas pequeñas!

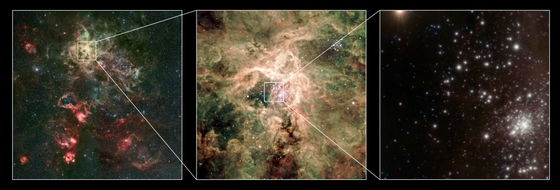

El grupo de tres estrellas gigantes Pismis 24-1 (CSIC).

Mucho antes de que Russell descubriera la estrella carmesí y Johannes Hevelius quedara fascinado por Mira, la estrella maravillosa, los astrónomos árabes se fijaron en una estrella de la constelación de Perseo que cambiaba de brillo cada tres días, con una pauta muy regular y acentuada. Los árabes escribieron una de las escasas páginas destacadas de la astronomía medieval, paliando de alguna manera la importante decadencia que sufrió esta ciencia en ese período en Europa y el Mediterráneo en el periodo comprendido entre Ptolomeo y Copérnico, que duró un milenio y medio.

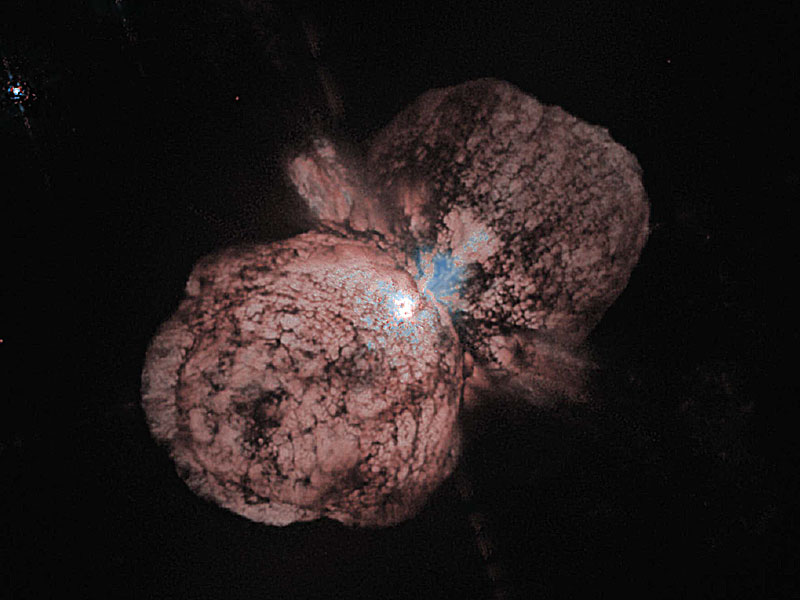

Bueno, hablar aquí de las estrellas que conocemos bien y de sus historias resulta entretenido y nos enseña un poco de la historia estelar en objetos individuales y determinados que, por una u otra razón tienen destacadas razones para que los astrónomos se fijaran en ellos. Por ejemplo, de Eta Carinae (antes mencionada y cuya imagen tenéis arriba), es una variable irregular hipergigante, que llegó a ser la segunda estrella más brillante del cielo. Es una variable azul luminosa con magnitud absoluta de -10, y es clasificada oficialmente como una estrella S Doradus. Se encuentra dentro de un cúmulo de estrellas masivas y una masa estimada en 100 masas solares, en tiempos se llegó a creer que era la estrella más masiva de la Galaxia. El único espectro visible es el de la Nebulosa del Homúnculo que la rodea. Eta Carinae es una intensa fuente infrarroja y su importante pérdida de masa (alrededor de 0,1 masas solares por año) tiene asociadas energías próximas a las de algunas supernovas y, teniéndola a unos 8000 años-luz, lo mejor será estar vigilante, ya que, aunque son distancias inmensas…Nunca se sabe lo que un monstruo de ese calibre nos podría enviar.

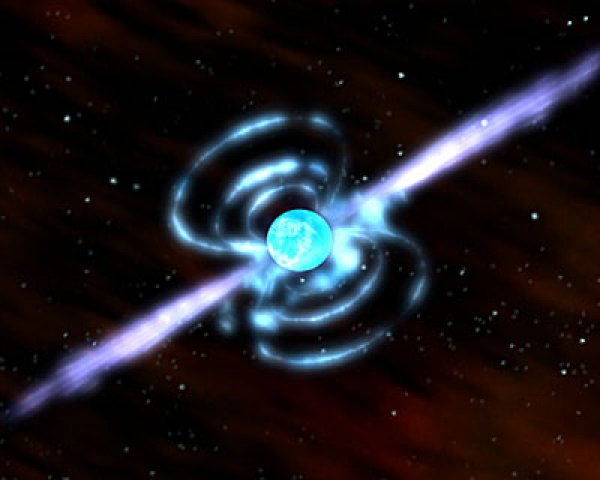

Estrellas masivas como Eta Carionae, Betegeuse, Arthurus, Antares y tantas otras que ahora sabemos que existen nos llevan a saber que, cuando mueren, se pueden convertir en otros objetos distintos como, por ejemplo:

Estrellas de Neutrones

Estrellas que se forman a partir de estrellas amasivas (2-3 masas solares) cuando al final de sus vidas, agotado el combustible nuclear de fusión, quedan a merced de la Gravedad que no se ve frenada por la fusión nuclear, y, en ese momento, la estrella comienza a contraerse bajo su propio peso, de forma tal que, los protones y electrones se funden y se convierten en neutrones que, al verse comprimidos tan violentamente, y, no pudiendo permitirlo por el principio de esclusión de Pauli, se degeneran y y hacen frente a la fuerza gravitatoria, consiguiendo así el equilibrio de lo que conocemos como estrella de nweutrones de intensom campo electromagnético y rápida rotación. Estos objetos, después de los Agujeros Negros, son los más densos que se conocen en el Universo, y, su masa podría pesar 1017 Kg/m3.

¿Estrella de Quarks?

Es hipotética, aún no se ha observado ninguna pero se cree que pueden estar por ahí, y, si es así, serían mucho más densas que las de neutrones, ya que, ni la degeneración de los neutrones podría parar la Fuerza de la Gravedad que sería frenada por los Quarks que también, son fermiones.

Si la estrella no es masiva, y tiene una masa como la del Sol, su final será la de convertirse en una ¡Estrella Enana Blanca!

Nuestro Sol es de esta clase de estrellas y, tampoco su densidad se queda corta, ya que, alcanzan 5 x 108 Kg/m3. Aquí, cuando la estrella implosiona y comienza a comprimirse bajo su propio peso por la fuerza de Gravedad, como ocurrió con la estrella de Neutrones, aparece el Principio de Exclusión de Pauli, el cual postula que los fermiones (los electrones son fermiones) no pueden ocupar el mismo lugar estando en posesión del mismo número cuántico, y, siendo así, se degeneran y hace que, la compresión de la estrella por la Gravedad se frene y vuelve el equilibrio que la convierte en estrellas enana blanca.

El fenómeno de convertirse en enana blanca ocurre cuando la estrella original tiene una mása máxima posible de 1,44 masas solares, el límite de Shandrashekar, si fuera mayor se convertiría en estrella de neutrones. Y, siendo mayor la masa de 3-4 masas solares, su destino sería un agujero negro.

Nos despediremos con estas bellas imágenes de sendas Nebulosas Planetarias como, un día lejano aun en el futuro, nos mostrará nuestro Sol al llegar al término de su vida. Ese será su final: Una bonita Nebulosa Planetaria con una estrella enana blanca en en el centro.

Claro que, tampoco ese será el final para el Universo en el que, nuevas estrellas seguirán naciendo para hacer posible que, mundos como la Tierra puedan, con su luz y su calor, hacer surgir formas de vida que, como la nuestra, pueda alcanzar la consciencia de Ser y, a partir de ahí… comenzará otra nueva aventura que será digna de contar.

emilio silvera

Dic

8

¡Los Límites de la infdormación! Y de nuestras teorías

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

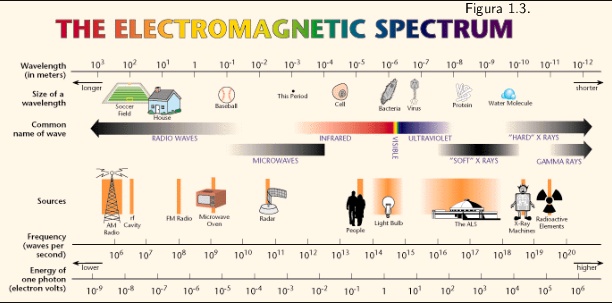

La emisión de electrones por metales iluminados con luz de determinada frecuencia fue observada a finales del siglo XIX por Hertz y Hallwachs. El proceso por el cual se liberan electrones de un material por la acción de la radiación se denomina efecto fotoeléctrico o emisión fotoeléctrica. Sus características esenciales son:

- Para cada sustancia hay una frecuencia mínima o umbral de la radiación electromagnética por debajo de la cual no se producen fotoelectrones por más intensa que sea la radiación.

- La emisión electrónica aumenta cuando se incrementa la intensidad de la radiación que incide sobre la superficie del metal, ya que hay más energía disponible para liberar electrones.

En los metales hay electrones que se mueven más o menos libremente, estos electrones no escapan del metal a temperaturas normales por que no tienen energía suficiente. Calentando el metal aumenta su energía y alguno puede escapar. Los electrones “evaporados” se denominan termoelectrones. Estudiando el efecto fotoeléctrico podemos ver que también se pueden liberar electrones (fotoelectrones) mediante la absorción por el metal de la energía de radiación electromagnética.

Einstein explicó las características del efecto fotoeléctrico, suponiendo que cada electrón absorbía un cuanto de radiación o fotón. La energía de un fotón se obtiene multiplicando la constante h de Planck por la frecuencia fde la radiación electromagnética.

E=hf

Si la energía del fotón E, es menor que la energía de arranque W , no hay emisión fotoeléctrica. En caso contrario, si hay emisión y el electrón sale del metal con una energía cinética Ec igual a E-W.

Mucha fue la constribución de Einstein por crear la imagen moderna de las leyes de la Naturaleza. Desempeñó un papel principal en la creación de la perspectiva correcta sobre el carácter atómico y cuántico del mundo material a pequeña escala, demostró que la velocidad de la luz introducía una relatividad en la visión del espacio de cada observador, y encontró por sí solo la teoría de la gravedad que sustituyó la imagen clásica creada por Isaac Newton más de dos siglos antes que él. Su famosa fórmula de E = mc2 es una fórmula milagrosa, es lo que los físicos definen como la auténtica belleza. Decir mucho con pocos signos y, desde luego, nunca ningún físico dijo tanto con tan poco. En esa reducida expresión de E = mc2, está contenido uno de los mensajes de mayor calado del universo: masa y energía, son la misma cosa.

Einstein siempre estuvo fascinado por el hecho de que algunas cosas deben parecer siempre iguales, independientemente de cómo se mueva el que las ve, como la luz en el vacío, c. Él nos dijo el límite con que podríamos recibir información en el universo, la velocidad de c.

La velocidad de la luz en el vacío es por definición una constante universal de valor 299.792.458 m/s2 3 (suele aproximarse a 3·108 m/s), o lo que es lo mismo 9,46·1015 m/año; la segunda cifra es la usada para definir al intervalo llamado año luz.

Él reveló todo el alcance de lo que Stoney y Planck simplemente habían supuesto: que la velocidad de la luz era una constante sobrehumana fundamental de la naturaleza. También sabía el maestro que, en el proceso de nuevas teorías, la búsqueda de la teoría final que incluyera a otras fuerzas de la naturaleza distintas de la gravedad, daría lugar a teorías nuevas y cada vez mejores que irían sustituyendo a las antiguas teorías. De hecho, él mismo la buscó durante los 30 últimos años de su vida pero, desgraciadamente, sin éxito. Ahora se ha llegado a la teoría de supercuerdas que sólo funciona en 10 y 26 dimensiones y es la teoría más prometedora para ser la candidata a esa teoría final de la que hablan los físicos.

El físico espera que las constantes de la naturaleza respondan en términos de números puros que pueda ser calculado con tanta precisión como uno quiera. En ese sentido se lo expresó Einstein a su amiga Ilse Rosenthal-Schneider, interesada en la ciencia y muy amiga de Planck y Einstein en la juventud.

Lo que Einstein explicó a su amiga por cartas es que existen algunas constantes aparentes que son debidas a nuestro hábito de medir las cosas en unidades particulares. La constante de Boltzmann es de este tipo. Es sólo un factor de conversión entre unidades de energía y temperatura, parecido a los factores de conversión entre las escalas de temperatura Fahrenheit y centígrada. Las verdaderas constantes tienen que ser números puros y no cantidades con “dimensiones”, como una velocidad, una masa o una longitud. Las cantidades con dimensiones siempre cambian sus valores numéricos si cambiamos las unidades en las que se expresan.

Stoney Planck

La interpretación de las unidades naturales de Stoney y Planck no era en absoluto obvia para los físicos. Aparte de ocasionarles algunos quebraderos de cabeza al tener que pensar en tan reducidas unidades, y sólo a finales de la década de 1.960 el estudio renovado de la cosmología llevó a una plena comprensión de estos patrones extraños. Uno de los curiosos problemas de la Física es que tiene dos teorías hermosamente efectivas (la mecánica cuántica y la relatividad general) pero gobiernan diferentes dominios de la naturaleza.

La mecánica cuántica domina en el micromundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es como una onda de agua. Se parece más a una ola delictiva o una ola de histeria: es una onda de información. Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

La gravedad (izquierda) y microgravedad (derecha) manifestada en la flama de un cerillo.

Por el contrario, la relatividad general era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la formación de agujeros negros. Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el espacio y distorsiona el tiempo.

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica. ¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad general de Einstein? Afortunadamente, hay una respuesta simple y las unidades de Planck nos dicen cuales son.

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de onda cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10–33 centímetros, más joven que el tiempo de Planck, 10-43 segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de aplicación de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido cerca del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “información” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele mostrar en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1.975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1.981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos. Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El número máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de información producida hasta ahora. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

emilio silvera

Dic

8

¿De dónde vino la materia que podemos ver? ¿Y la que no vemos?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo dinámico ~

Clasificado en El Universo dinámico ~

Comments (0)

Comments (0)

Un átomo simple de un mismo elemento constituye, a su vez, una molécula simple del propio elemento. El oxígeno (O), hidrógeno (H), cloro (Cl), sodio (Na), cobre (Cu), hierro (Fe), plata (Ag) y el oro (Au), por ejemplo, son átomos de elementos simples y constituyen, al mismo tiempo, moléculas de cada uno de esos mismos elementos..

Átomo de cloro (Cl), cuyo número atómico es 17, de acuerdo con la suma total de electrones que posee. en sus tres órbitas (2 + 8 + 7 = 17) y átomo de sodio (Na), de número atómico 11, de acuerdo también. con la suma de la cantidad de electrones que posee (2 + 8 + 1 = 11). Como se puede apreciar, el cloro. posee 7 electrones en su última órbita, por lo cual es más propenso a captar el electrón que le falta para. completar ocho, mientras que el sodio, al tener sólo 1 electrón, es más propenso a cederlo.

Cuando los átomos de Cl y Na interaccionan por aproximarse suficientemente sus nubes electrónicas, existe un reajuste de cargas, porque el núcleo de Cl atrae con más fuerza los electrones que el de Na, así uno pierde un electrón que gana el otro. El resultado es que la colectividad de átomos se transforma en colectividad de iones, positivos los de Na y negativos los de Cl. Las fuerzas electromagnéticas entre esos iones determinan su ordenación en un cristal, el Cl Na. Por consiguiente, en los nudos de la red existen, de manera alternativa, iones de Na e iones de Cl, resultando una red mucho más fuerte que en el caso de que las fuerzas actuantes fueran de Van der Waals. Por ello, las sales poseen puntos de fusión elevados en relación con los de las redes moleculares.

Fuerzas de van der Waals

Las moléculas de agua están formadas por un átomo de oxígeno y dos de hidrógeno separados 104,45° entre sí (H2O). Estas moléculas se unen a su vez mediante un enlace llamado “por puente de hidrógeno”, formando una red molecular más compleja.

Aclaración: los enlaces por puente de hidrógeno son susceptibles de darse cuándo en la molécula hay un átomo de hidrógeno unido covalentemente a un átomo electronegativo (como flúor, oxígeno o nitrógeno). Este atrae hacia sí mismo la nube electrónica del hidrógeno, descentralizándola y dejando a éste con una cierta carga positiva que a su vez atrae a un par de electrones libres de otro átomo cercano.

Hablemos de cuerpos.

Me referiré en primer lugar a los que constituyen nuestro entorno ordinario, que sería todo el entorno que abarca nuestro planeta. En segundo lugar considerare los demás cuerpos y objetos del universo. El análisis de muestras de esos diversos cuerpos ha puesto de manifiesto que, en función de la composición, los cuerpos pueden ser simples y compuestos. Los primeros son, precisamente, los llamados elementos químicos, a las que el insigne Lavoisier (conocido como padre de la química), consideró como el último término a que se llega mediante la aplicación del análisis químico.

Una gran diversidad de minerales

Hoy sabemos que son colectividades de átomos isotópicos. La mayoría de ellos son sólidos y se encuentran en la naturaleza (nuestro entorno terráqueo) en estado libre o en combinación química con otros elementos, formando los diversos minerales. La ordenación de los iones en las redes se manifiesta externamente en multitud de formas y colores. No obstante debo señalar que, aun siendo abundante esta variedad, no es tan rica como la que corresponde a los cuerpos vivos, tanto animales como vegetales. La explicación se basa en que el número de especímenes moleculares y su complejidad son mucho mayores que en el reino inorgánico.

Sería conveniente, salir al paso de una posible interpretación errónea. Me refiero a que pudiera pensarse que los reinos que acabamos de mencionar constituyen clases disyuntas, esto es, sin conexión mutua. Y no lo digo porque esté considerando el hecho de que el carbono forma compuestos inorgánicos y orgánicos (lo que también hace el silicio), sino porque haya existido, y aún pueda existir, una conclusión, mejor conexión evolutiva del mundo inorgánico y el viviente que no se puede descartar, de hecho yo particularmente estoy seguro de ello. Estamos totalmente conectados con los ríos, las montañas y los valles, con la tierra que pisamos, el aire que respiramos y con todo el resto del universo del que formamos parte.

Nosotros, la parte del Universo que piensa y ha podido llegar, mirando, experimentando, atendiendo a los cambios de fases de la Naturaleza, que todo cambia y todo lo que es hoy mañana no será. Claro que, en todo existen unas reglas y, la Naturaleza no sería una excepción, se comporta siguiente unos patrones predeterminados que nos han permitido llegar a saber sobre la materia y su comportamiento. Si miramos hacia atrás en el tiempo, veremos como a una infinidad de hechos dispersos y de profundos pensamientos que, nosotos, los seres humanos, siempre curiosos, pudimos llegar a saber y de ellos aprendimos procurando dejar un registro de esos rumores del saber del mundo del que de vez en cuando, hemos comentado aquí. Cuando hablamos de materia lo estamos haciendo de una cosa muy seria, tanto que, de ella están formadas las estrellas, los mundos y la vida. Hablar de la materia viviente, casi siempre nos lleva (al no saber cómo hacerlo), hacia el terreno metafísico de la filosofía y el Ser, es decir, la materia men su grado más alto…creo.

¡Es tan grande el Universo! Ni la mano más experta del pintor, ni los cinceles del diestros escultor, incluso ni nuestra “infinita” imaginación podrá nunca mostrar tanta belleza como en el Universo está presente. Es la Naturaleza, donde reside todo, donde todo podemos hallar, y, dónde, además, los misterios y secretos residen, y, precisamente por ello, en ella están las respuestas que tan insistentemente buscamos.

La teoría de Cairns Smith considera que el eslabón entre ambos mundos (orgánico e inorgánico) se halla localizado en los microcristales de arcilla. Mi teoría particular es que no hay eslabón perdido en dicha conexión, sino que es el tiempo el que pone en cada momento una u otra materia en uno u otro lugar. Ahora nos ha tocado estar aquí como ser complejo, pensante y sensitivo. El eón que viene nos puede colocar formando parte de un enorme árbol, de un monte, o simplemente estar reposando como fina arena en el lecho de un río. Sin dudarlo, y a pesar de todo, hay personas que formarán parte de un hermoso jardín perfumado y lleno de aromas que la brisa regalará a los que pasen cerca de allí.

El granito, por ejemplo, consiste básicamente en una mezcla de tres cuerpos compuestos: cuarzo, mica y feldespato. ¿Quién puede decir hoy lo que seremos mañana? o, a qué ámbito podremos pertenecer: ¿formaremos parte del lecho arenoso de un río de aguas claras y de discurrir rumoroso? o, ¿seremos parte de la superficie de una montaña?, o, ¿iremos a parar a una nueva estrella como aquella que formó los materiales a partir de los cuales pudimos surgir a la vida?

¿Qué será esa especie de sustancia de la que todo proviene?

Somos Naturaleza y debemos procurar la plena simbiosis con ella. Si vamos en la dirección que “ella” nos indica, todo irá bien pero, si queremos remar contra la corriente del “mundo”, nuestras fuerzas nunca podrán vencer tan inmensa grandeza y, sólo obtendremos resultados muy negativos. No juguemos a ser…lo que no somos.

En todos los cuerpos que hemos estado considerando hasta ahora, las moléculas, los átomos o los iones se hallan situados en los nudos de la correspondiente red, así que, los electrones de esos individuos se encuentran también localizados en el entorno inmediato de esos lugares. Podríamos decir que la densidad electrónica es una función periódica espacial, lo que significa que al recorrer la red siguiendo una determinada dirección irían apareciendo altibajos, es decir, crestas y valles de la densidad electrónica.

La estructura de los cuerpos metálicos, así como las aleaciones, merecen una consideración especial. La estructura de los metales y aleaciones difiere de la de los demás cuerpos en un aspecto muy importante que consideraré a continuación.

Me refiero a que en los cuerpos metálicos existe una deslocalización de los electrones que están menos fuertemente enlazados en los correspondientes núcleos, es decir, de los electrones de valencia.

Vamos a precisar un poco. Supongamos, para fijar las ideas, que tenemos un trozo de plata metálica pura. En los nudos de la red correspondientes los átomos han perdido su electrón de valencia, pero ocurre que cada uno de estos electrones forma una colectividad que se halla desparramada o dispersa por todo el sólido. Una primera imagen de esta situación fue establecida por el gran físico italiano Enrico Fermi, por lo que se habla de un gas electrónico, llamado también de Fermi, que llenaría los espacios libres, es decir, no ocupados por los iones metálicos.

Este gas electrónico es el responsable de las propiedades metálicas, tales como el brillo, conductibilidades eléctrica y térmica, etc. La aplicación de la mecánica cuántica a la descripción del estado metálico conduce a la obtención del mapa de la densidad electrónica, o como decía antes, a las características de la información correspondiente.

Sin entrar en detalles que desviarían nuestra atención hacia otros conceptos fuera de los límites de lo que ahora estoy pretendiendo, utilizaré el mismo lenguaje que para las estructuras de núcleos y átomos.

Recordemos que en la sociedad de los nucleones y electrones existen las relaciones verticales y las de estratificación, que se manifiestan en las capas y subcapas. En el caso de los metales tendríamos una colectividad de núcleos, arropados con sus capas cerradas, ocupando los nudos de la red; únicamente los electrones de valencia de cada átomo forman la colectividad del gas electrónico.

La pregunta que nos debemos hacer es: ¿estos electrones, en número igual por lo menos al de los átomos, se hallan estratificados? La respuesta es que sí. Existe una estratificación de estos electrones en las llamadas bandas. El concepto de banda energética resulta de la consideración simultánea de dos aspectos: la cuantización energética (o la estratificación de los niveles energéticos en los átomos) y el grandísimo número de electrones existentes. Este colectivo no podría ubicarse en un número finito y escaso de niveles. Esta dificultad queda soslayada si se admite que cada uno de esos niveles atómicos de los n átomos que forman el cuerpo se funde en otros tantos niveles de cierta anchura donde ya pueden alojarse los electrones disponibles.

Esa fusión de los niveles atómicos da lugar a las bandas. Esta imagen equivaldría a considerar un metal como un átomo gigante en el que los niveles energéticos poseyeran una anchura finita.

En cuanto a la información que puede soportar un metal, podríamos señalar que sería parecida a la del correspondiente átomo, pero mucha más extendida espacialmente. Una información puntual, la del átomo, daría paso a otra espacial, si bien vendría a ser una mera repetición periódica de aquella.

¿Y los cuerpos que pueblan el resto del universo?

Cuando un cuerpo sobrepasa unas determinadas dimensiones, aparece algo que conocemos como fuerza gravitatoria y que se deja sentir en la forma que todos conocemos y que da lugar primeramente a la fusión de los diversos materiales que forman los cuerpos.

Así, por ejemplo, en el cuerpo que llamamos Tierra, la presión crece con la profundidad, por lo que a partir de un determinado valor de ésta, aparece el estado líquido y con él una estratificación que trata de establecer el equilibrio hidrostático. Similar (en otro ámbito) al que ocurre en las estellas.

En un sentido general, puede afirmarse que una estrella es todo objeto astronómico que brilla con luz propia. Ahora bien, de un modo más técnico y preciso, podría decirse que se trata de una esfera de plasma, que mantiene su forma gracias a un equilibrio de fuerzas denominado equilibrio hidrostático. El equilibrio se produce esencialmente entre la fuerza de gravedad, que empuja la materia hacia el centro de la estrella, y la presión que hace el plasma hacia fuera, que tal como sucede en un gas, tiende a expandirlo. La presión hacia fuera depende de la temperatura, que en un caso típico como el Sol, se mantiene con el suministro de energía producida en el interior de la estrella. Por ello, el equilibrio se mantendrá esencialmente en las mismas condiciones, en la medida en que la estrella mantenga el ritmo de producción energética. Pero dicho ritmo, como se explica luego, cambia a lo largo del tiempo, generando variaciones en las propiedades físicas globales del astro, que se conocen como evolución de la estrella.

Dentro de nuestro sistema planetario se distinguen los planetas rocosos, hasta Marte y meteoritos inclusive, y el resto de ellos, desde Júpiter en adelante, incluido este. Estos últimos difieren esencialmente de los primeros en su composición. Recuérdese que la de Júpiter es mucho más simple que la de los planetas rocosos. Consta fundamentalmente de hidrógeno, helio, agua, amoniaco y metano, con un núcleo rocoso en su interior. El hidrógeno que rodea a este núcleo se encuentra en forma de hidrógeno atómico sólido.

Los gigantes gaseosos tienen muchas lunas, algunas mayores que Mercurio y Plutón, los dos planetas más pequeños. También tienen anillos, aunque éstos son muy tenues, excepto en Saturno, que se extienden 273.000 km., más de dos veces el diámetro del planeta. Se componen de millones de bloques de hielo, el mayor de los cuales tiene 10 metros de diámetro: el tamaño de una casa pequeña.

Los cuatro pequeños planetas interiores, Mercurio, Venus, Tierra y Marte, son básicamente rocosos. Entre Marte y Júpiter hay millones de asteroides girando en torno al Sol. El más grande, Ceres, sólo tiene 1.003 km. de diámetro.

También la composición del Sol (y todas las estrellas que brillan) es más simple que la de los planetas rocosos, su estado físico es el de plasma y su contenido está reducido (mayormente) a hidrógeno y helio. Más variedad de materiales existe en las estrellas supernovas, donde el primitivo hidrógeno ha evolucionado de la manera que expliqué en otra parte de este trabajo.

En cuanto a los derechos de la evolución estelar, enanas blancas, estrellas de neutrones y agujeros negros, señalaré que la composición de la primera es sencilla en cuanto al numero de “elementos” constituyentes; la segunda ya lo indica su propio nombre, constan de nucleones, particularmente neutrones que están fuertemente empaquetados (muy juntos) por la gravedad. Una estrella de neutrones puede tener una densidad superior a la del agua, en millones de veces y del mismo orden que la de los núcleos atómicos. El agujero negro es un fenómeno aparte, su inmensa fuerza gravitatoria es tal que ni la luz puede escapar de ella, es decir, su velocidad de escape es superior a 300.000 Km/s, y como según la relatividad nada es en nuestro universo superior en velocidad a la luz, resulta que nada podrá escapar de un agujero negro.

Comparación de tamaños entre la enana blanca IK Pegasi B (centro abajo), su compañera de clase espectral A IK Pegasi A (izquierda) y el Sol (derecha). Esta enana blanca tiene una temperatura en la superficie de 35.500 K.

Allí dentro, en el interior del agujero negro, no existen ni el tiempo ni el espacio; es como un objeto que estando en nuestro universo (deja sentir su fuerza gravitatoria y engulle estrellas), al mismo tiempo no está aquí para nuestros ojos. En verdad, un agujero negro, es un objeto extraño, no hemos podido llegar a comprenderlo bien y, de hecho, ni sabemos en qué se convierte aquella materia original de la estrella a partir de la que se formó. Cuando la Gravedad quedó como dueña y señora de la situación, comenzó a realizar su trabajo y contrajo la inmensa masa de la estrella más y más hasta hacerla desaparecer de nuestra vista, aquella materia primera, ¿qué será ahora? ¿qué estado será el suyo? Sabemos de los sólidos, líquidos, gaseosos, plasmas e incluso, materia de Quarks-Gluones pero, dentro de un Agujero Negro, ¿qué será la materia? Y, sobre todo, ¿en qué parte del universo está? sólo podemos sentir su presencia pero verla no.

¡Qué enigmas!

Espero que algún día, a medida que nuestros conocimientos evolucionen, a medida que nuestras tecnologías avancen, a medida que nosotros (también) avancemos en el proceso hace miles de años iniciado, podamos alguna vez, comprender lo que en realidad es un Agujero Negro en toda su magnitud, es decir, conocer completamente todos y cada uno de los interrogantes que ahora nos plantea.

¿La Materia? Bueno, esa es otra de nuestras asignaturas pendientes y debemos llegar a comprenderla para poder asimilar como, a partir de la “materia inerte” hemos podido evolucionar hasta la “materia -no ya viviente- sino pensante”.

Nubes moleculares en Orión que son los materiales primigenios para complejidades futuras

¡Qué misterios! ¡Es tan grande el Universo! Podríamos decir que dentro de él, todo puede ser posible…hasta que nosotros estemos aquí para hablar de todas estas cuestiones que, no siempre, llegamos a comprender.

emilio silvera

Totales: 67.588.283

Totales: 67.588.283 Conectados: 25

Conectados: 25