Oct

22

Si la respuesta es…¡El Universo! ¿Cuál es la pregunta?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo cambiante ~

Clasificado en El Universo cambiante ~

Comments (3)

Comments (3)

La pregunta es: ¿Dónde está todo lo que existe?

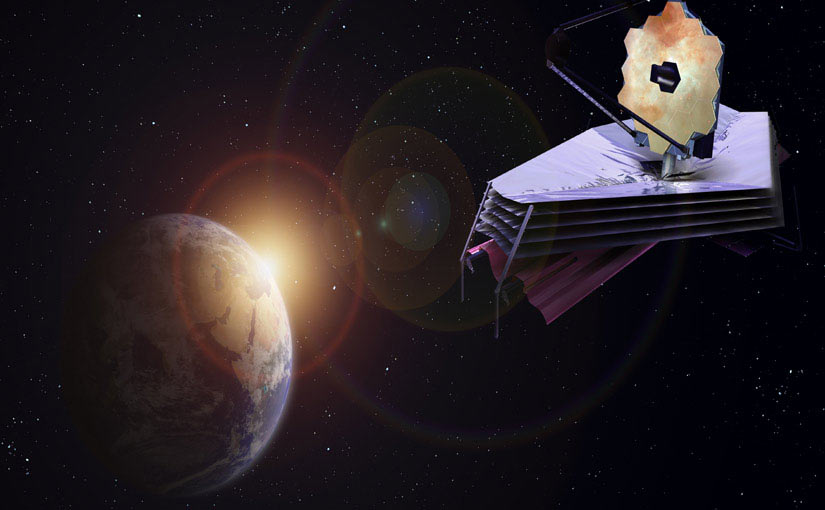

El pensamiento “generalizado” hoy en día en la mayoría de los astrónomos, astrofísicos y demás científicos afines a la ciencia del Universo, es que, pueden existir cientos de planetas habitados dentro de nuestra propia Galaxia, la Vía Láctea.

Ahora, 10 años de observaciones han dado sus resultados: los astrónomos estiman que en nuestra galaxia podría haber unos 300 millones de planetas potencialmente habitables, algunos de ellos, según los científicos, a una distancia de unos 30 años luz de nuestro sol.

Ahora sabemos que el Universo no conoce límite alguno ni en el espacio ni en el tiempo que, según todos los indicios, ha estado expandiéndose durante 13.700 millones de años que, es un período de tiempo más que suficiente para que las estrellas que han existido desde entonces, tuvieran el tiempo necesario para producir todos los elementos que conocemos y que hicieron posible el surgir de la vida aquí en la Tierra y…probablemente, en “otras Tierras” que en la Galaxia Vía Láctea estén, y, de la misma manera, en los miles de millones de galaxias que pueblan el vasto universo que hemos llegado a conocer.

Mientras que no se produzca ese primer encuentro… ¡Los imaginamos!

Más allá de la meta-galaxia, a la que pertenecen todos los sistemas galácticos que conocemos, tienen, necesariamente, que existir otros mundos que, como el nuestro, estén habitados por seres de toda índole y pelaje, inteligentes también. La meta-galaxia consta de hiper-galaxias, es decir, de grupos de sistemas galácticos.

¿Cuántos mundos habitables habrá en toda esta inmensidad de galaxias?

Un estudio dirigido por Brent Tully, astrónomo del Instituto de Astronomía de la Universidad de Hawaii, y publicado este mes en la revista Nature ha definido por primera vez la extensión del supercúmulo Laniakea. Hasta ahora, se consideraba al supercúmulo de Virgo como hogar del Grupo Local, el conjunto de las tres docenas de galaxias más cercanas a nosotros. El supercúmulo de Virgo ha pasado, entonces, a ser un apéndice de Laniakea. El supercúmulo de Laniakea contiene alrededor de 100 mil galaxias.

Posición de la Gran Nube de Magallanes en relación con la Vía Láctea

Nuestro sistema galáctico consta cuenta con dos “satélites”: la Gran Nebulosa de Magallanes, distante 38.000 Parsec de nosotros y la Pequeña Nebulosa de Magallanes, a 36.000 Parsecs. La Nebulosa de Andrómeda es un sistema compuesto por cinco galaxias. Por lo general existen “puentes” de estrellas entre galaxias que constituyen un grupo. Se podría decir que que los grupos de galaxias estarían unidos por hilos de estrellas de manera tal que, muchas veces, nos cuesta trabajo asegurar a qué galaxia pertenece una estrella determinada.

Tengo la suerte de que, Ken Crawford (Rancho Del Sol Obs.), me envíe regularmente imagines que obtiene en su Observatorio, y, en esta ocasión, recibí la imagen de la gran y bella galaxia espiral NGC 7331 que es a menudo vendida como una análoga a nuestra Vía Láctea. Está situada a 50 millones de años luz de distancia en la norteña constelación de Pegaso. En la imagen podemos vislumbrar otras galaxias que achican su imagen debido a que sus distancias están mucho más alejadas de nosotros.

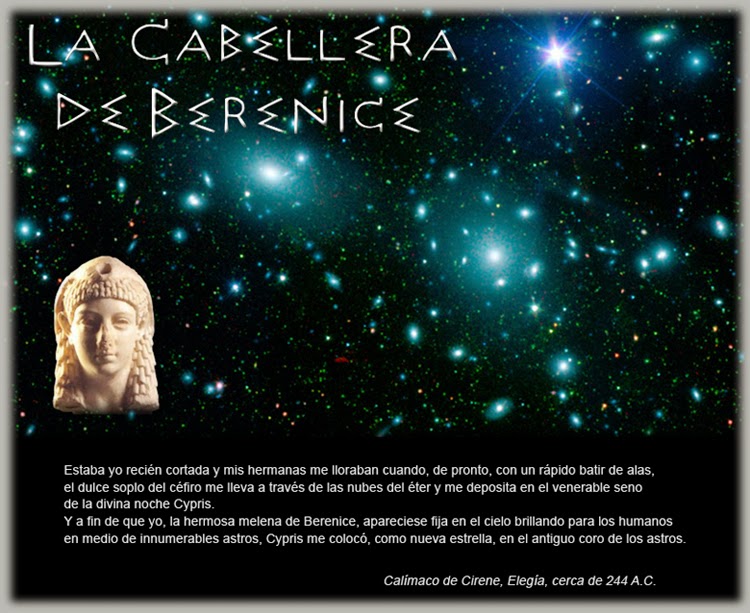

Las constelaciones dan origen o son causa de incontables historias sobre el Cosmos, con un despliegue de leyendas y mitologías sobre su nacimiento. A través de las figuras imaginarias que forman, observamos nuevas estrellas, planetas, galaxias y nebulosas.

La Constelación de Virgo cuenta con más de 3.000 galaxias, la Cabellera de Berenice con más de 10.000. Las supergalaxias tienen un diámetro de 30 o 40 mega-parsecs. No conocemos el número exacto de super-galaxias cuyos conjuntos constituyen las mega-galaxias. Y, sin embargo, la meta-galaxia es sólo una pequeña fracción del “universo infinito” de un universo que, para nuestro tiempo, se podría decir que existe desde la eternidad y que existirá también eternamente (aunque sabemos que no es así), al menos nos lo puede parecer.

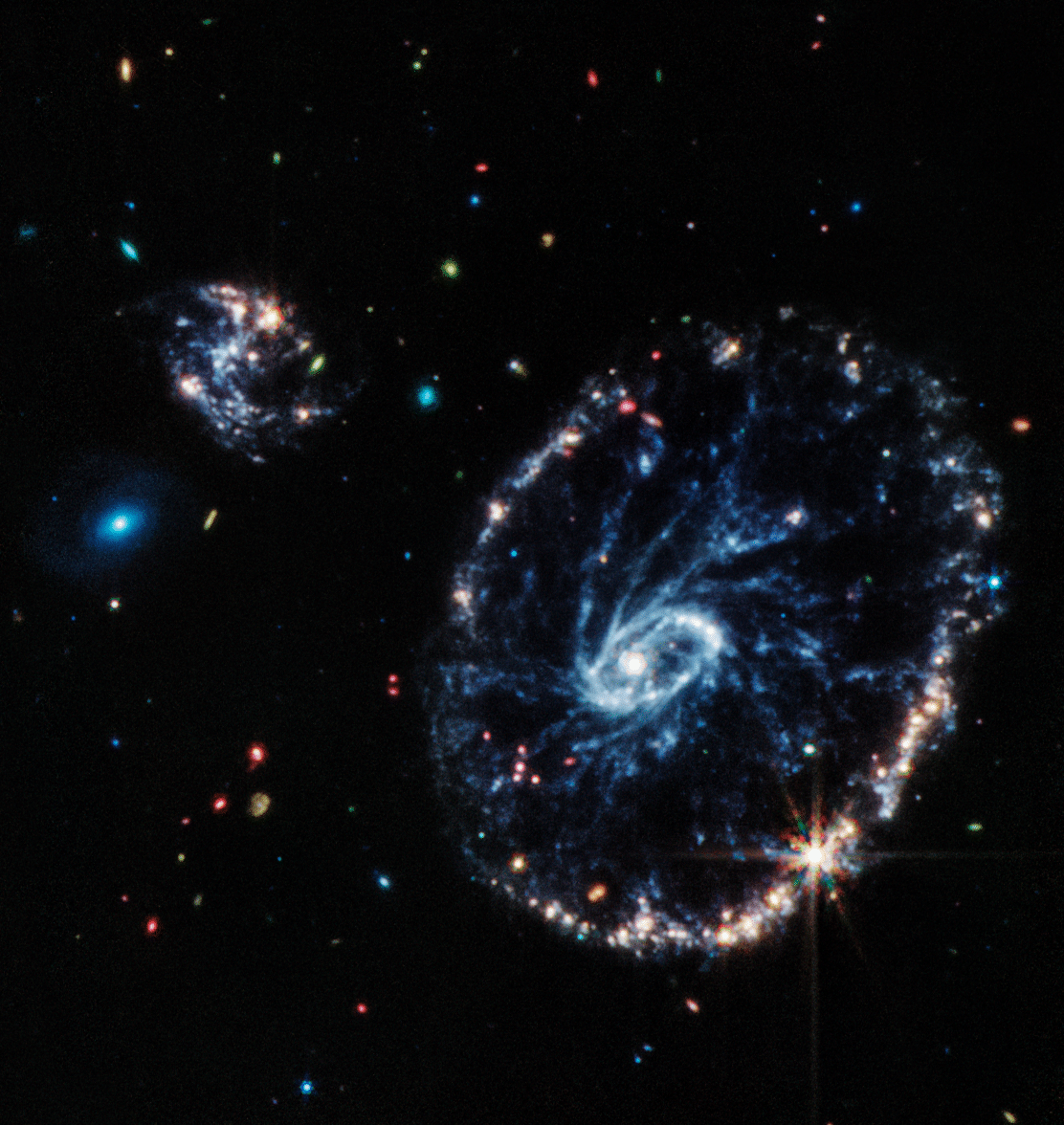

Nuestro Universo está cuajado de maravillas como ésta. La Galaxia de la rueda de la carreta (también conocido bajo el nombre de ESO 350-40) es una galaxia lenticular o anular situada a cerca de 500 millones de años luz de distancia en la constelación del escultor en el hemisferio meridional. Es rodeada de un anillo de 150 000 años de luz de diámetro, compuesto de estrellas jóvenes y brillantes. Esta galaxia era una galaxia idéntica a la Vía láctea antes de que sufra una colisión frontal con una galaxia vecina. Cuando galaxia vecina atravesó la Galaxia Cartwheel, la fuerza de la colisión causó una onda de choque poderosa sobre la galaxia, como una piedra echada en las tranquilas aguas de un estanque. Desplazándose a gran velocidad, este onda de choque barrió el gas y el polvo, creando así un halo alrededor de la parte central de la galaxia quedada indemne. Esto explica la nube azul alrededor del centro, la parte más brillante.

Observando la imagen con su collar de perlas azulado compuesto por brillantes y radiantes estrellas, nos hablan de una ingente producción de elementos complejos que, en el futuro, pasarán a formar parte de los mundos nuevos y, en ellos, con el tiempo, surgirá también la vida nueva de vaya usted a saber qué criaturas.

El Universo es una maravilla, y, cualquier objeto que podamos mirar nos podrá llevar al más alto grado de estasis A mí me pasó con la luna Titán que visto a contraluz por la nave Cassini en órbita alrededor de Saturno. La atmósfera dispersa la luz del Sol mostrando un anillo completo mientras se filtra por las capas más altas. En este pequeño mundo de ríos de metano y atmósfera imposible, se han puesto altas esperanzas de que, en un futuro, pudiera surgir allí la vida. Es similar a nuestra Tierra de hace algunos millones de años.

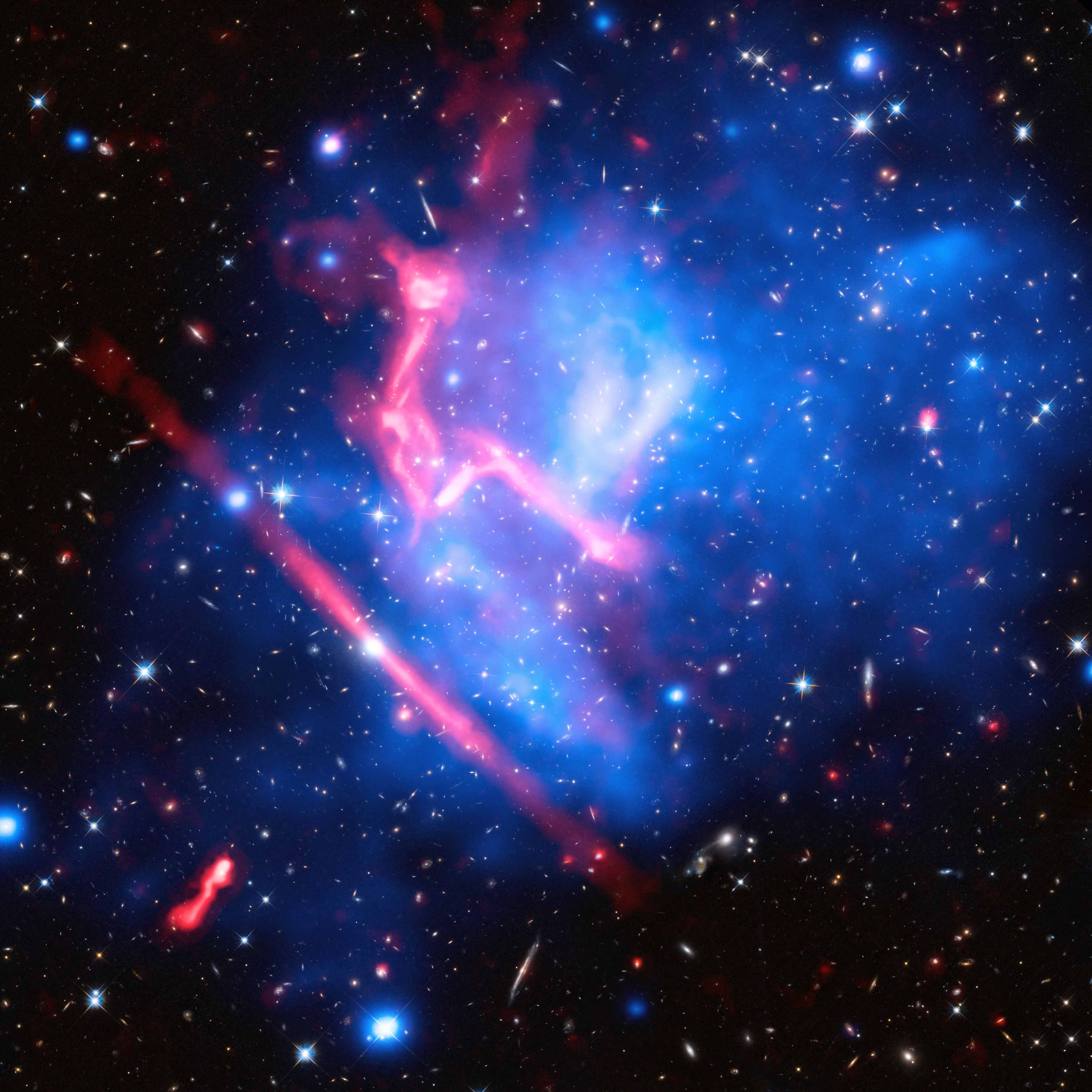

Cúmulo de galaxias MACS J0717

El cúmulo de galaxias MACS J0717 localizado a 5400 millones de años luz, en una imagen lograda combinando datos ópticos del Hubble y en rayos-x del Chandra, muestra a cuatro cúmulos colisionando. Si hemos podido llegar hasta aquí, una voz en nuestra mente pregunta: ¿Hasta dónde podremos llegar?

La galaxia NGC 55, fotografiada por el observatorio de La Silla utilizando el Wide Field Imagen del telescopio de 2.2 metros MPG/ESO. ¿Cuántos mundos estarán ahí presentes? y, ¿tendrá alguno presencia de vida?

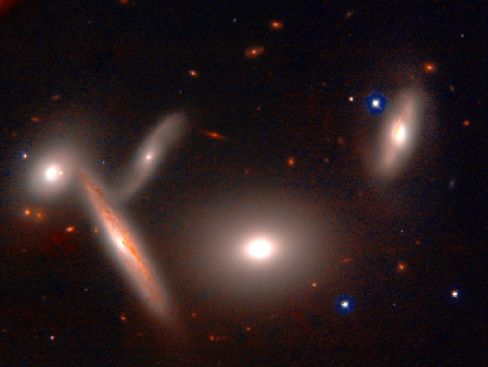

Arp 261, un par de galaxias localizadas a 70 millones de años luz, fotografiadas por el instrumento FORS2 del VLT en Cerro Paranal. La riqueza de la imagen nos puede llevar (mediante un estudio profundo) a saber lo mucho que en ella está presente, estrellas surgidas de inmensas nubes de gas interestelar, mundos nuevos llenos e promesas futuras y, otros, más viejos que, pudieran tener los vestigios de Civilizaciones perdidas.

NGC 4194, la Galaxia Medusa, el resultado de la colisión entre dos galaxias, mostrada con datos ópticos del Telescopio Hubble y datos en rayos-x del Telescopio Chandra. La imagen nos habla de vestigios que están en el universo y nos cuentan dramáticas historias de galaxias que dejaron de existir para convertirse en otra nueva que, conteniendo materiales más compkejos que aquellas primarias, hacen posible el surgir de estrellas cuyos materiales son más sofisticados que el simple hidrógeno, y, de esas estrellas descendientes de algunas generaciones anteriores…qué materiales podrán salir?

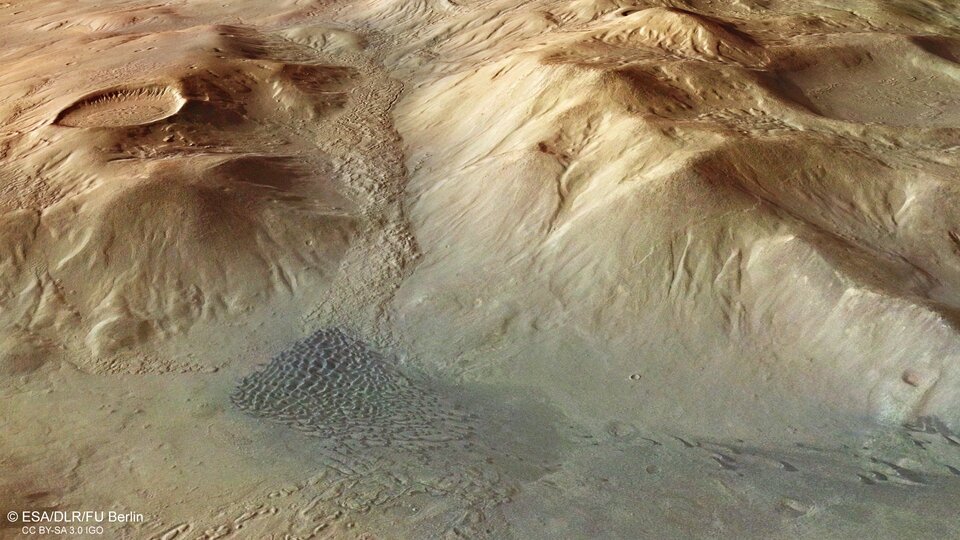

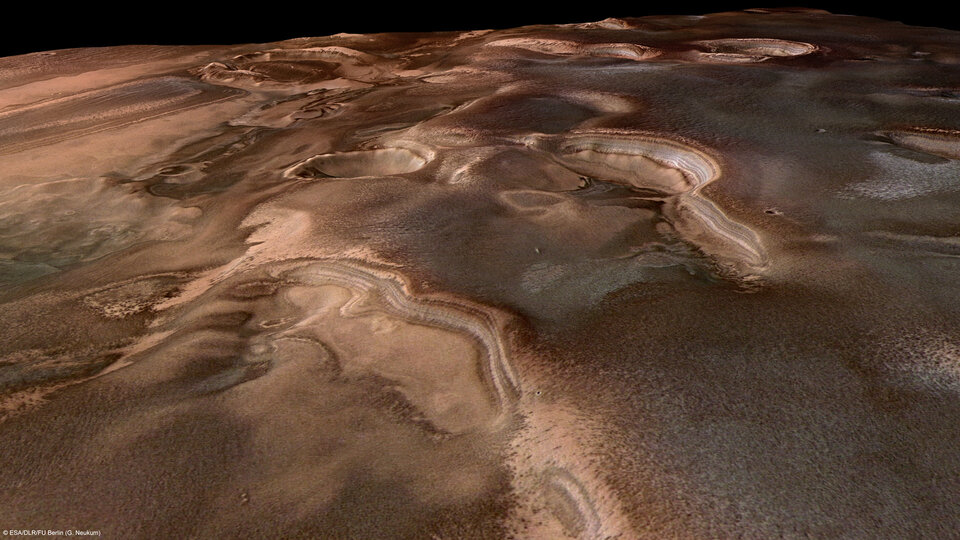

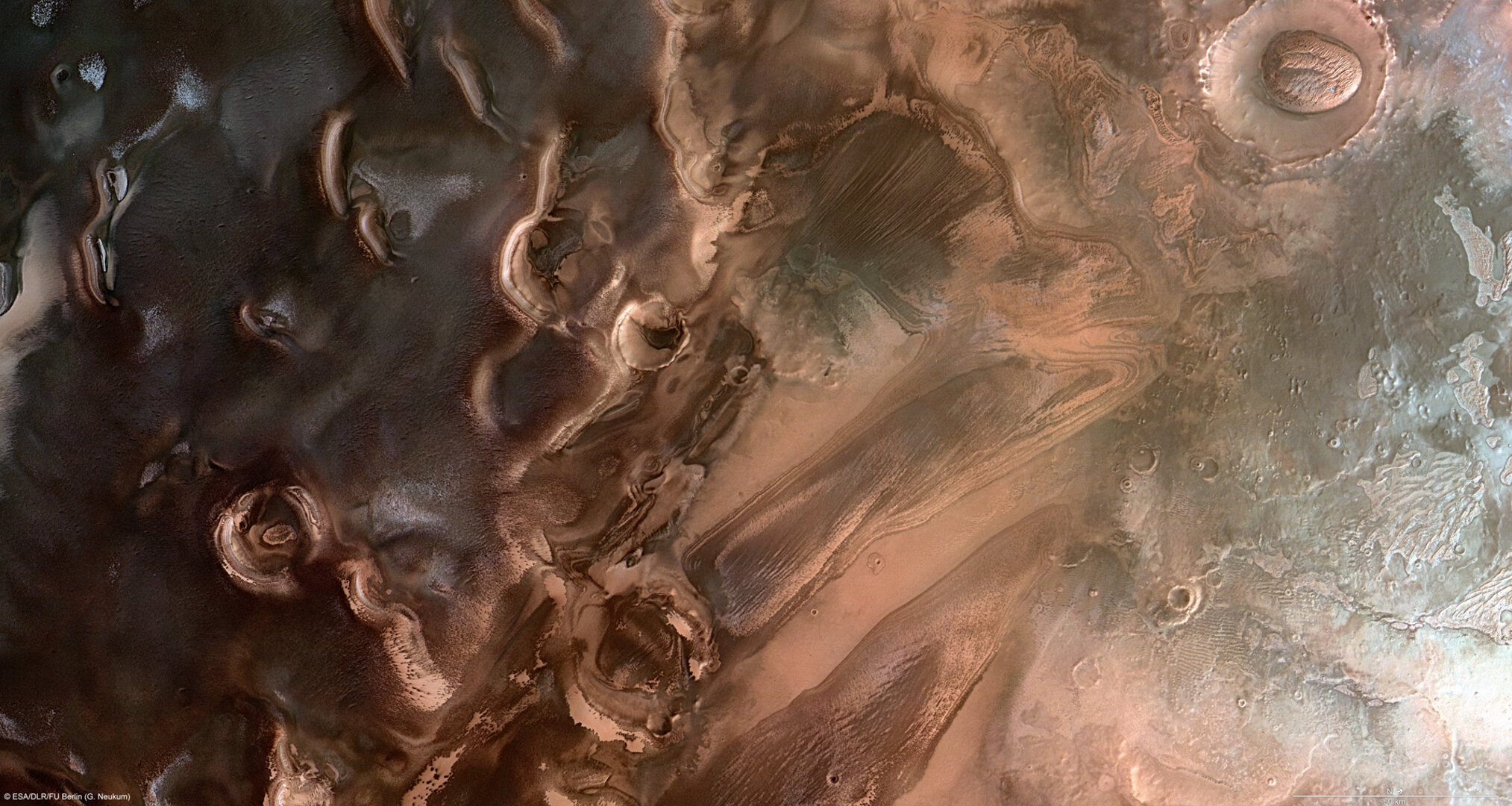

Hemos podido admirar, la región de Rupes Tenuis fotografiada por la Mars Express de la ESA, mostrando gran cantidad de nieve sobre el polo marciano. Marte, el planeta hermano, nos tiene que dar muchas sorpresas y, a no tardar mucho (menos de 30 años), podremos por fín cobrar la apuesta del café que hice con algunos amigos sobre si había o no alguna clase de vida en aquel mundo.

El grupo de galaxias Hickson 90, un grupo compacto localizado en la constelación de Piscis Austrinus a 100 millones de años luz del Sol. Fotografiado por el Telescopio Espacial Hubble. Viendo objetos como los de arriba, podríamos preguntarnos: ¿Cuándo dejará de sorprendernos el Universo? ¡Es tanta su riqueza!

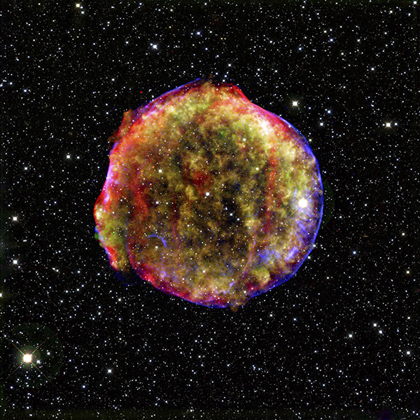

La supernova de Tycho, localizada en Cassiopeia y mostrada en una imagen tomada en rayos-x por el telescopio Chandra y en luz infrarroja por el telescopio Spitzer. No por haberla visto muchas veces deja de sorprendernos, esa masa inmensa que, como remanente de los restos de una estrella masiva, nos muestra los filamentos de plasma que crean campos magnéticos a su alrededor sin importar el tiempo transcurrido desde el suceso. En dicha explosión se produjeron miles de toneladas de oro y platino que regaron el espacio interestelar para formar parte, más tarde, de algún mundo perdido.

La Nebulosa Eta Carinae, NGC3372

La siempre fascinante Eta Carinae está escondida detrás de una de las nebulosas más grandes y brillantes del cielo en una imagen tomada desde La Silla utilizando el ESO/MPG de 2.2 metros. Aquí contemplamos parte de la Nebulosa, la estrella, una de las más grandes conocidas (unas 100 masas solares) parece que está a punto de explotar, y, sus consecuencias, podrían ser impredecibles.

La galaxia espiral M 101, localizada a 22 millones de años luz, en una imagen compuesta por datos del telescopio Chandra, el telescopio Hubble y el telescopio Spitzer. La bella y enorme galaxia está cuajada de estrellas nuevas y otras que no lo son tanto. El conjunto parece una luminaria de feria, la radiación que se expande por toda la galaxia no parece que sea un lugar muy segurio. Prefiero nuestra Vía Láctea.

Atípica y extraña Galaxia. Una nueva imagen del Telescopio Espacial Hubble revela finos detalles de la galaxia espiral NGC 4921 y los objetos circundantes de fondo. La diversidad en el Universo es la norma y, por mucho que podamos pensar en objetos extraños que puedan existir, ahí estarán.

Una imagen que combina luz visible y rayos-x muestra la actividad del agujero negro supermasivo en la galaxia Centaurus A. Los Agujeros Negros que pueden contener miles y millones de masas solares, son tan peligrosos que, nada de lo que deambule por sus alrededores estará seguro. Se engulle toda la materia que caiga en su radio de acción, su fuerza de gravedad es descomunal y, por mucho que queramos correr, nos atrapará. Ya sabéis, ni la luz es capaz de burlar su fuerza de atracción.

¡Increíble región de formación estelar! NGC 604, una zona formación estelar en la galaxia M 33. Imagen capturada en alta resolución por el telescopio espacial de rayos-x Chandra. No podéis ni imaginar la enorme cantidad de estrellas jóvenes y masivas que están ahí presentes, sus emisiones de radiación ultravioleta producen fuertes vientos solares que dibujan las formas de las nubes circundantes formando arabescas figuras de gas ionizado por el ultravioleta que tiñe de azul toda la región.

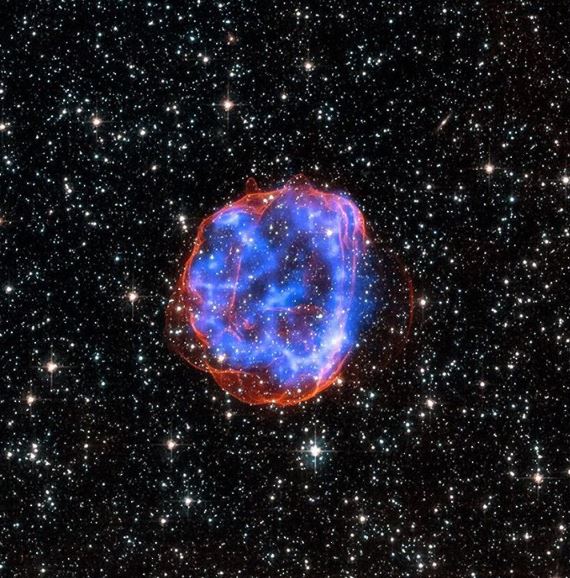

El remanente emite radiación ultravioleta que tiñe de azul y otros colores los elementos presentes

Otros remanentes están conformados por hilos de plasma

La variedad está servida, el prolífico Universo nos suministra de toda clase de objetos activos que, mediante transiciones de fase, pasen a convertirse en otros objetos distintos de lo que en un principio fueron. Nada permanece, todo se transforma. Es es la regla de oro que impone un Universo dinámico creador de materia en el espacio-tiempo infinito que nunca podremos dominar, y, si nos permite seguir en este maravilloso Sistema de Galaxias y mundos, podremos, en el futuro, conocer a nuestros hermanos inteligentes y, si las cosas salen como deberían salir, formaremos una Federación de mundos en la que, por fin, impere la igualdad para todos dentro de un clima de mutuo respeto y en el que, la sabiduría adquirida a través de muchas civilizaciones que fueron, nos habrá dado, ese algo del que ahora carecemos: Racionalidad y Temple, Sabiduría para poder discernir sobre lo que verdaderamente tiene valor y aquello que sólo es el falso brillo de la gloria y el poder que sólo puede traer destrucción y mal para muchos.

Esperemos que, observando el Universo y mirando dentro de nuestras Mentes, podamos llegar a comprender que, nuestro destino, no depende de nosotros pero sí, podremos mejorarlo si nuestro comportamiento contribuyen a que sea mejor. Y, sobre todo, convendría que fuéramos conscientes de que no lo sabemos todo, las preguntas son más que las respuestas, y, un poco de humildad nos vendría bien.

Emilio Silvera V.

Oct

22

¿El Misterio? Persistirá, ¡como el Tiempo!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Tras un largo y penoso caminar por el planeta Tierra …

Los habitantes de este mundo hemos, hemos conseguido construir un cuadro plausible del Universo, de la Naturaleza que tratamos de comprender. Hemos llegado a ser conscientes de que, en ella, en la Naturaleza, están todas las respuestas que buscamos y, nosotros mismos no hemos llegado a conocernos por ese mismo hecho de que, formando parte de la Naturaleza, también somos parte del enigma que tratamos de desvelar.

Formamos parte de toda esta grandeza

Parece que ahora estamos entrando en la edad adulta, quiero significar que después de siglos y milenios de esporádicos esfuerzos, finalmente hemos llegado a comprender algunos de los hechos fundamentales del Universo, conocimiento que, presumiblemente, es un requisito de la más modesta pretensión de nuestra madurez cosmológica.

Sabemos, por ejemplo, dónde estamos, que vivimos en un planeta que gira alrededor de una estrella situada en el borde de la Galaxia espiral a la que llamamos Vía Láctea, cuya posición ha sido determinada con respecto a varios cúmulos vecinos que, en conjunto, albergan a unas cuarenta mil galaxias extendidas a través de un billón de años-luz cúbicos de espacio.

También sabemos más o menos, cuando hemos entrado en escena, hace unos cinco mil millones de años que se formaron el Sol yn los planetas de nuestro Sistema Solar , en un Universo en expansión que probablemente tiene una edad entre dos y cuatro veces mayor. Hemos determinado los mecanismos básicos de la evolución de la Tierra, hallado prueba también de evolución química a escala cósmica y hemos podido aprender suficiente física como para comprender e investigar la Naturaleza en una amplia gama de escalas desde los Quarks saltarines en el “mundo” microscópico hasta el vals de las galaxias.

El Tiempo inexorable nunca dejó de fluir y mientras eso pasaba, nuestra especie evolucionaba, aprendía al observar los cielos y cómo y por qué pasaban las cosas. Hay realizaciones humanas de las que, en verdad, podemos sentirnos orgullosos. Aquellos habitantes de Sumer y Babilonia, de Egipto o China y también de la India y otros pueblos que dejaron una gran herencia de saber a los Griegos que pusieron al mundo occidental en el camino de la ciencia, nuestra medición del pasado se ha profundizado desde unos pocos miles de años a más de diez mil millones de años, y la del espacio se ha extendido desde un cielo de techo bajo no mucho mayor que la distancia que nos separa de la Luna hasta el radio de más de diez mil millones de años-luz del universo observable.

Tenemos razones para esperar que nuestra época sea recordada (si por ventura queda alguien para recordarlo) por sus contribuciones al supremo tesoro intelectual de toda la Humanidad unida al contexto del Universo en su conjunto por unos conocimientos que, aunque no suficiente, sí son los necesarios para saber dónde estamos y, ahora, debemos buscar la respuesta a esa pregunta: ¿Hacia dónde vamos?

Claro que, el futuro es incierto

Como en la física, en el mundo y en nuestras vidas, también está presente el Principio de Incertidumbre y, de ninguna manera, podemos saber del mañana. Sin embargo, cuanto más sabemos del universo, tanto más claramente comprendemos lo poco que sabemos de él.

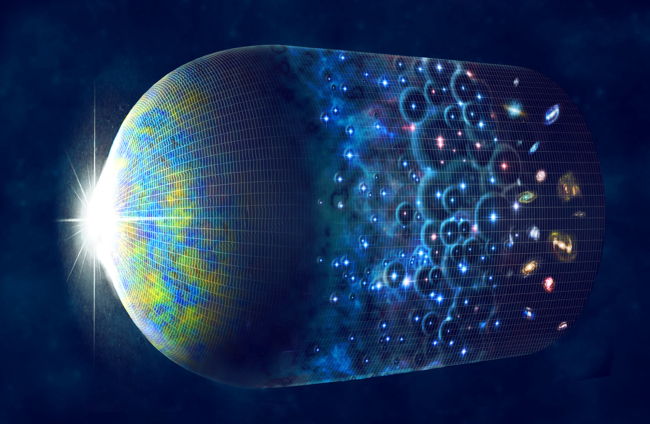

Si en verdad aquella gran explosión sucedió, no sabemos a ciencia cierta el momento exacto

La vastedad del Universo nos lleva a poder comprender algunas estructuras cósmicas y mecanismos que se producen y repiten como, el caso de la destrucción que nos lleva a la construcción. Es decir, una estrella masiva vieja explota y siembra el Caos y la destrucción y sus escombros siembra una extensa región del Espacio, y, es precisamente ese hecho el que posibilita que, nuevas estrellas y nuevos mundos surjan a la “vida”. Sin embargo, la grandeza, la lejanía, esa inmensidad que se nos escapa a nuestra comprensión terrestre, nunca nos dejará comprender el universo en detalle y, siendo así, siempre tendremos secretos que desvelar y misterios que resolver.

Si añadimos a todo eso que, si poseyésemos un atlas de nuestra propia Galaxia y que dedicase una sola página a cada sistema estelar de la Vía Láctea (de modo que el Sol y sus planetas estuviesen comprimidos en una página), tal atlas tendría más de diez mil millones de volúmenes de diez mil páginas cada uno.

Se necesitaría una biblioteca del tamaño de la de Harvard para alojar el Atlas, y solamente ojearlo al ritmo de una página por segundo nos llevaría más de diez mil años. Añádance los detalles de la cartografía planetaria, la potencial biología extraterrestre, las sutilezas de los principios científicos involucrados y las dimensiones históricas del cambio, y se nos hará claro que nunca aprenderemos más que una diminuta fracción de la historia de nuestra Galaxia solamente, y hay cien mil millones de galaxias más.

Sabiendo todo todo esto, siendo consciente de que, realmente, es así, tendremos que convenir con el físico Lewis Thomas cuando dijo:

“El mayor de todos los logros de la ciencia del siglo XX ha sido el descubrimiento de la ignorancia humana”.

La ignorancia, como todo en el Universo, es relativa. Nuestra ignorancia, por supuesto, siempre ha estado con nosotros, y siempre seguirá estando, es una compañera con la que cargamos toda nuestra vida y que nos pesa. Algunos procuramos que pese lo menos posible para hacer más llevadero el viaje. Lo nuevo está en nuestras consciencias y de ellas, ha surgido nuestro despertar al comprender de sus abismales dimensiones, y es eso más que otro cosa, lo que señala la madurez de nuestra especie. El espacio puede tener un horizonte y el tiempo un final pero la aventura del aprendizaje siempre será interminable y eterno, quizá (no me he parado a pensarlo) pueda ser esa la única forma de eternidad que pueda existir.

¿Dónde está el límite… ¡No hay límites! Sólo se necesita Tiempo para desvelar secretos

La dificultad de explicarlo todo no se debe a nuestra debilidad mental, sino a la estructura misma del universo. En los últimos siglos hemos descubierto que la trama del cosmos puede abordarse en varios niveles diferentes. Mientras no se descubre el siguiente nivel, lo que ocurre en el anterior no se puede explicar, sólo puede describirse. En consecuencia, para el último nivel que se conoce en cada momento nunca hay explicaciones, sólo puede haber descripciones.

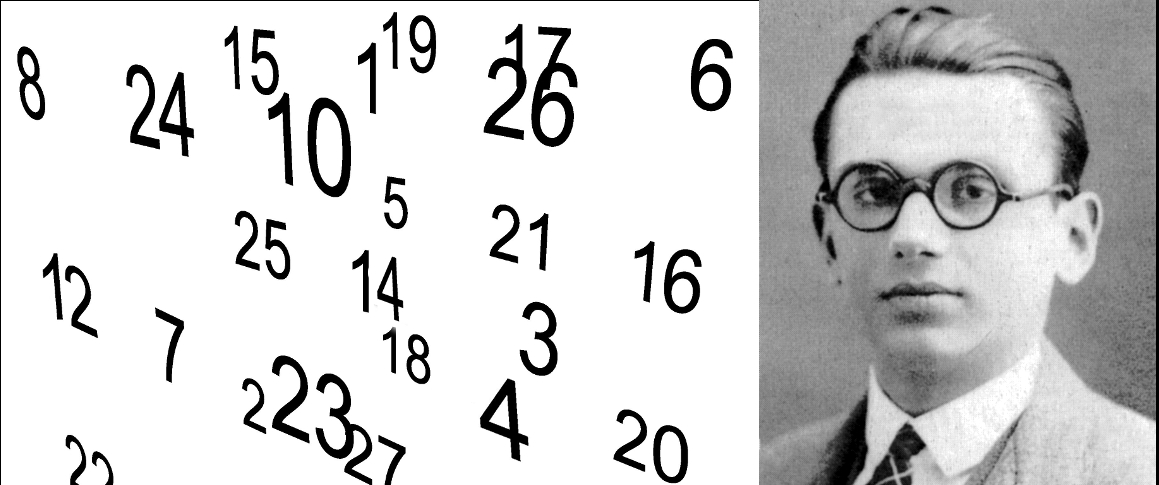

En 1931, un excéntrico joven matemático austriaco llamado Kurt Gödel (1906-1973) pudo probar que un sistema matemático necesariamente debe ser “incompleto”. En el ámbito académico fuera de las matemáticas, usualmente se habla de “el teorema de incompletitud” y muchos han conjeturado en torno a sus implicaciones. Usualmente muchas de sus aserciones son desacertadas.

“El Segundo Teorema de Incompletitud se enuncia como: en todo sistema deductivo que permita expresar funciones recursivas primitivas que sea consistente no es posible deducir en él la sentencia que anuncia la consistencia del propio sistema.”

“La ciencia, mi muchacho, está compuesta de errores, pero son errores que es útil cometer, porque conducen poco a poco a la verdad”

Julio Verne

La Ciencia es intrínsicamente abierta y exploratoria, y comete errores todos los días. En verdad, ese será siempre su destino, de acuerdo con la lógica esencial del segundo teorema de incompletitud de Kurt Gödel. El teorema demuestra que la plena validez de cualquier sistema, inclusive un sistema científico, no puede demostrarse dentro del sistema. Es decir, tiene que haber algo fuera del marco de cualquier teoría para poder comprobarla. La lección que podemos haber aprendido es que, no hay ni habrá nunca una descripción científica completa y comprensiva del universo cuya validez pueda demostrarse.

No es que pertenezcamos al Universo, formamos parte de él

Y, a todo esto, debemos alegrarnos de que así sea, de que no podamos comprender el Universo en toda su inmensa dimensión y diversidad. Nuestras mentes necesitan que así sea y, tendrán, de esa manera, el escenario perfecto para seguir creciendo a medida que busca todas esas respuestas que nos faltan y, lo bueno del caso es que, cada respuesta que encontramos, viene acompañada de un montón de nuevas preguntas y, de esa manera, esa historia interminable de nuestra aventura del saber…llegará hasta la eternidad de nuestro tiempo que, necesariamente, no tiene por que ser el tiempo del universo.

Emilio Silvera V.

Oct

22

¿La realidad? ¿Dónde estará?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

No una sino mil veces podemos haber podido hablar del “milagro griego”. La hipótesis es la siguiente: La Ciencia nació en la antigua Grecia alrededor del año 600 a. C. y floreció durante unos pocos cientos de años, aproximadamente hasta 146 a. C., cuando los griegos cedieron su primacía a los romanos y la ciencia se frenó en seco, permaneció en letargo hasta que resucitó en Europa durante el Renacimiento alrededor de 1500. Y, no pocos creen a pie juntillas que eso fue así y que, las personas que habitaron la India, Egipto, Mesopotamia, el África Subsahariana, China, el Continente americano y algún otro lugar con anterioridad al año 600 a. C. no dirigieron el desarrollo de la Ciencia. Cuando descubrieron el fuego, se quedaron esperando tranquilamente a que Tales de Mileto, Pitágoras, Demócrito y Aristóteles inventaran la Ciencia en el Egeo.

146 a. C., cuando los griegos cedieron su primacía a los romanos y la ciencia se frenó en seco, permaneció en letargo hasta que resucitó en Europa durante el Renacimiento alrededor de 1500. Y, no pocos creen a pie juntillas que eso fue así y que, las personas que habitaron la India, Egipto, Mesopotamia, el África Subsahariana, China, el Continente americano y algún otro lugar con anterioridad al año 600 a. C. no dirigieron el desarrollo de la Ciencia. Cuando descubrieron el fuego, se quedaron esperando tranquilamente a que Tales de Mileto, Pitágoras, Demócrito y Aristóteles inventaran la Ciencia en el Egeo.

Claro que, tal pensamiento es una auténtica barbaridad, pensar eso es un sin sentido. ¿Cómo durante más de mil quinientos años, desde el final del período griego hasta la época de Copérnico, no se produjo avance alguna en la Ciencia? Esto quiere decir que ninguna persona, en ninguna parte, demostró la capacidad o el interés necesario para proseguir insistiendo en las obras de Arquímedes, Euclides o Apolonio.

el final del período griego hasta la época de Copérnico, no se produjo avance alguna en la Ciencia? Esto quiere decir que ninguna persona, en ninguna parte, demostró la capacidad o el interés necesario para proseguir insistiendo en las obras de Arquímedes, Euclides o Apolonio.

Lo cierto es que da mucha pena comprobar como el paso del tiempo hace desaparecer aquellas culturas

Las primeras observaciones sobre fenómenos eléctricos se realizaron ya en la antigua Grecia, cuando el filósofo Tales de Mileto (640-546 a.C.) comprobó que, al frotar barras de ámbar contra pieles curtidas, se producía en ellas características de atracción que antes no poseían. Es el mismo experimento que ahora se puede hacer frotando una barra de plástico con un paño; acercándola luego a pequeños pedazos de papel, los atrae hacia sí, como es característico en los cuerpos electrizados.

se puede hacer frotando una barra de plástico con un paño; acercándola luego a pequeños pedazos de papel, los atrae hacia sí, como es característico en los cuerpos electrizados.

Sin embargo, fue el filósofo griego Theophrastus (374-287 a.C.) el primero, que en un tratado escrito tres siglos después, estableció que otras sustancias tienen este mismo poder, dejando así constancia del primer estudio científico sobre la electricidad. Comprobando que no todos los materiales pueden adquirir tal propiedad o adquirirla en igual medida. Se atraen, por ejemplo, una barra de vidrio y otra de ebonita. Se repelen, sin embargo, dos barras de vidrio o dos de ebonita.

mismo poder, dejando así constancia del primer estudio científico sobre la electricidad. Comprobando que no todos los materiales pueden adquirir tal propiedad o adquirirla en igual medida. Se atraen, por ejemplo, una barra de vidrio y otra de ebonita. Se repelen, sin embargo, dos barras de vidrio o dos de ebonita.

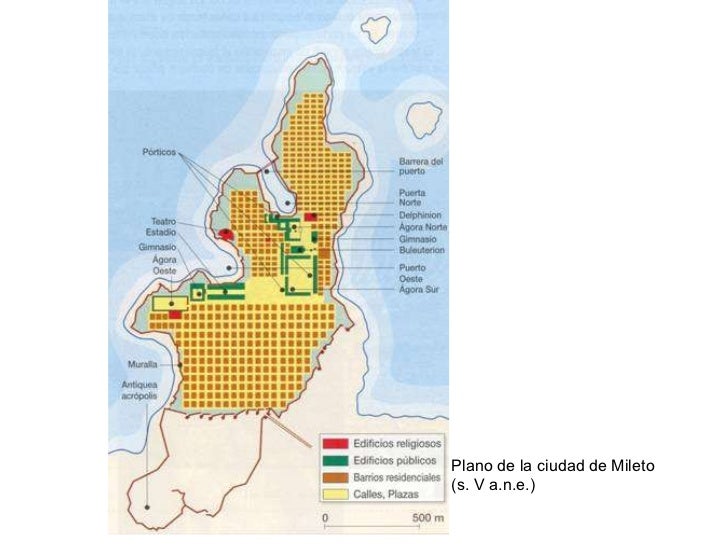

Gradas y restos del edificio de la escena del teatro de Mileto. Mileto (en cario: Anactoria; en hitita: Milawata o Millawanda; en griego antiguo Μίλητος Mílêtos; en turco: Milet) fue una antigua ciudad griega de la costa occidental de Anatolia (en la actual provincia de Aydın de Turquía), cerca de la desembocadura del río Meandro en la antigua Caria. El emplazamiento estuvo habitado desde la Edad del Bronce.

Aquellos ”científicos” se reunieron en Mileto. Tales, Anaximandro y Anaxímenes hicieron observaciones astronómicas con el gnomon, diseñaron cartas náuticas, plantearon hipótesis más o menos relacionadas con los hechos observados referidas a la estructura de la Tierra, la naturaleza de los planetas y las estrellas, las leyes seguidas por los astros en sus movimientos. En Mileto, la ciencia, entendida como interpretación racional de las observaciones, aparece que dio los primeros pasos

interpretación racional de las observaciones, aparece que dio los primeros pasos

Se planteaban preguntas y trataban de contestarlas

Claro que, las cosas nunca suelen ser tan sencillas. La hipótesis según la cual la ciencia surgió por generación espontánea en suelo griego y desaparecido después hasta el Renacimiento parece ridícula cuando se expresa de forma sucinta, sin más explicaciones. Es una idea que se formuló por primera vez en Alemania hace unos 150 años y que, poco a poco, ha ido calando, sutilmente en nuestras consciencias a través de la educación que, la única concesión que se hace a las culturas no europeas es la que se refiere al Islam. Esta teoría dice que los árabes conservaron viva la cultura griega, incluida la ciencia, durante toda la Edad Media. Ejercieron de escribas, traductores y guardianes, sin pensar, aparentemente, en crear su propia ciencia.

sucinta, sin más explicaciones. Es una idea que se formuló por primera vez en Alemania hace unos 150 años y que, poco a poco, ha ido calando, sutilmente en nuestras consciencias a través de la educación que, la única concesión que se hace a las culturas no europeas es la que se refiere al Islam. Esta teoría dice que los árabes conservaron viva la cultura griega, incluida la ciencia, durante toda la Edad Media. Ejercieron de escribas, traductores y guardianes, sin pensar, aparentemente, en crear su propia ciencia.

Estatua de Averroes en Córdoba

Al Sur de la puerta de Almodóvar de Córdoba, se levanta la estatua de Averroes. Jurista, médico, filósofo. El gran Averroes fue la máxima autoridad judicial de la época,(siglo XII). Fue acusado por los fundamentalistas de poner la razón humana por encima de la ley divina. La mirada del viejo filósofo se pierde entre las callejas mientras escucha el murmullo del agua del estanque junto al que reposa.

las callejas mientras escucha el murmullo del agua del estanque junto al que reposa.

Nada de eso es cierto. De hecho, los eruditos islámicos admiraron y preservaron las matemáticas y la ciencia griega y actuaron como el hilo conductor de la ciencia de muchas culturas no occidentales, además de construir un edifcio propio impresionante en el campo de las ciencias. Lo cierto es que, la ciencia occidental es lo que es porque se construyó acertadamente sobre las mejores ideas de los distintos pueblos, los mejores datos e incluso, los mejores aparatos procedentes de otras culturas. Por ejemplo, los babilonios desarrollaron el teorema de Pitágoras (la suma de los cuadrados de los dos lados perpendiculares de un triángulo rectángulo es igual al cuadrado de la hipotenusa) al menos mil quinientos años antes de que Pitágoras naciera.

e incluso, los mejores aparatos procedentes de otras culturas. Por ejemplo, los babilonios desarrollaron el teorema de Pitágoras (la suma de los cuadrados de los dos lados perpendiculares de un triángulo rectángulo es igual al cuadrado de la hipotenusa) al menos mil quinientos años antes de que Pitágoras naciera.

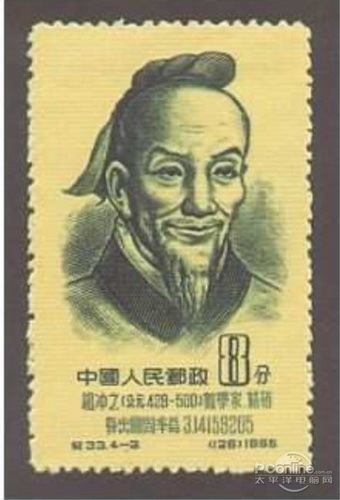

En el año 200 d. C., el matemático chino Liu Hui calculó para el número π un valor (3,1416) que se mantuvo como la estimación más precisa de dicho número durante unos mil años. Nuestras cifras del 0 al 9, se inventaron en la antigua India, siendo las cifras de Gwalior del año 500 d. C. casi indistinguibles de las cifras occidentales modernas. Álgebra es una palabra árabe que significa “obligación”, como cuando se obliga a que la incógnita x tome un valor numérico.

π un valor (3,1416) que se mantuvo como la estimación más precisa de dicho número durante unos mil años. Nuestras cifras del 0 al 9, se inventaron en la antigua India, siendo las cifras de Gwalior del año 500 d. C. casi indistinguibles de las cifras occidentales modernas. Álgebra es una palabra árabe que significa “obligación”, como cuando se obliga a que la incógnita x tome un valor numérico.

Arabia es una región de Oriente Medio del desierto comprendido entre el mar Rojo y el océano Índico. Desde el punto de vista histórico, esta región era conocida también como la cuna de una de las principales religiones del mundo, el Islam. Nacida en el siglo VII, esta religión había establecido importantes cambios en la configuración de mandato, los derechos económicos y principios culturales del mundo árabe. Sin embargo, pocos saben de su cultura y de la importante contribución que hicieron a la Ciencia (Astronomía, Medicina, Matemáticas…)

el punto de vista histórico, esta región era conocida también como la cuna de una de las principales religiones del mundo, el Islam. Nacida en el siglo VII, esta religión había establecido importantes cambios en la configuración de mandato, los derechos económicos y principios culturales del mundo árabe. Sin embargo, pocos saben de su cultura y de la importante contribución que hicieron a la Ciencia (Astronomía, Medicina, Matemáticas…)

China, Babilonia y también el Islam. El Califa árabe al-Mamun hizo construir la ciudad de la Sabiduría y un Observatorio para que los astrónomos pudieron observar las variantes de los parámetros astronómicos (obtenidos de los griegos) y las estrellas del cielo. Aportaron así la mayor contribución y uno de los valores más exactos de de la precesión de los equinoccios, la inclinación de la eclíptica y otros datos de este tipo. En el año 829 sus cuadrantes y sextantes eran mayores que los que construyó Tycho Brahe en Europa más de siete siglos después.

de este tipo. En el año 829 sus cuadrantes y sextantes eran mayores que los que construyó Tycho Brahe en Europa más de siete siglos después.

Como antes decía, en el siglo IX, el gran mecenas de la ciencia el califa abasí al-Mamun, reunió a varios astrónomos en Bagdad para crear la casa de la Sabiduría (Bait al-Hikmah). Allí los astrónomos llevaron a cabo observaciones del Sol y de la Luna, con el fin de determina la latitud y la longitud locales para fijar la gibla. Recopilaron algunos de los mejores resultados de un zij titulado “Lo Comprobado” (al-Mumtahan).

crear la casa de la Sabiduría (Bait al-Hikmah). Allí los astrónomos llevaron a cabo observaciones del Sol y de la Luna, con el fin de determina la latitud y la longitud locales para fijar la gibla. Recopilaron algunos de los mejores resultados de un zij titulado “Lo Comprobado” (al-Mumtahan).

Al-Biruni desarrolló técnicas para medir la Tierra y las distancias sobre ella utilizando la triangulación. Descubrió que el radio de la Tierra era 6.339,6 Kilómetros, un valor que no se obtuvo en Occidente hasta el siglo XVI. Uno de sus zijs contiene una tabla que da las coordenadas de seiscientos lugares, casi todos conocidos por él directamente.

En el año 499, Aryabhata escribió un pequeño volumen, Aryabhatuya, de 123 versos métricos, que se ocupaban de astronomía y (una tercera parte) de ganitapada o matemáticas. En la segunda mitad de esta obra, en la que habla del tiempo y la trigonometría esférica, Aryabhata utiliza una frase, en la que se refiere a los números empleados en el cálculo, “cada lugar es diez veces el lugar precedente”. El valor posicional había sido un componente esencial de la numeración babilónica, pero los babilonios no empleaban un sistema decimal.

lugar es diez veces el lugar precedente”. El valor posicional había sido un componente esencial de la numeración babilónica, pero los babilonios no empleaban un sistema decimal.

La fuerza de gravedad mantiene unidas las estrellas, estas a las galaxias, las galaxias entre

sí, y, los mundos a las estrellas que orbitan, mientras nosotros, nos sentidos atraídos por la gravedad que genera el mundo que habitamos que mantiene nuestros pies unidos a la superficie impidiendo que flotemos sin control. (Tengo la suerte de que, Ken Crawford (Rancho Del Sol Obs.), me envíe imágenes como

la de arriba).

Veinticinco siglos antes de Isaac Newton, el Rig-Veda hindú afirmaba que la gravitación hace que el universo se mantenga unido, aunque esta hipótesis era mucho menos rigurosa que la de Newton, en esencia, quería decir lo mismo que él dijo.

hipótesis era mucho menos rigurosa que la de Newton, en esencia, quería decir lo mismo que él dijo.

![Lea sobre el registro fósil | Ciencias para 6° a 8° grado [imprimible]](https://www.generationgenius.com/wp-content/uploads/2020/07/338-still-1-1024x576.jpg)

Los arios de lengua sánscrita suscribieron la idea de que la Tierra era redonda en una época en que los griegos creían que era plana. Los hindúes del siglo V d. C. calcularon de algún modo la edad de la Tierra, cifrándola en 4.300 millones de años; los científicos ingleses del siglo XIX estaban convencidos de que la Tierra tenía 100 millones de años. Algunos expertos chinos del siglo IV d. C. -como los árabes del s. XIII y los papúes de Nueva Guinea posteriormente- adoptaron la rutina de utilizar fósiles para estudiar la historia del planeta, sin embargo, en el siglo XVII algunos miembros de la Universidad de Oxford seguían enseñando que los fósiles eran “pistas falsas sembradas por el diablo” para engañar a los hombres.

estudiar la historia del planeta, sin embargo, en el siglo XVII algunos miembros de la Universidad de Oxford seguían enseñando que los fósiles eran “pistas falsas sembradas por el diablo” para engañar a los hombres.

¡Que cosas!

Con todo esto, os quiero decir amigos míos que, cuando oímos hablar de la primacía europea con respecto a las Ciencias…, debemos dejar el comentario en cuarentena y, dedicar un tiempo a profundizar más en cómo fueron las cosas en la realidad. No siempre las cosas son como parecen, o, como nos las quieren presentar.

parecen, o, como nos las quieren presentar.

Mucho antes de que llegaran los científicos modernos, en tiempos del pasado muy lejano, otras culturas de filósofos naturales ya hablaban del átomo y del vacío. Ellos supieron intuir que había una materia cósmica y que todo lo grande estaba hecho de pequeñas cosas. Los pensadores de aquellos lugares eran anacoretas encerrados en un misticismo que los unía a la Naturaleza y a ese otro mundo de los pensamientos que están situados más allá de lo material. Ellos ya se preguntaban por…:

¡Tantas cosas!

Claro que, si no fuera tan largo de contar, os diría que, en realidad, el Higgs se descubrió hace ya muchos siglos en la antigua India, con el nombre de maya, que sugiere la idea de un velo de ilusión para dar peso a los objetos del mundo material. Pocos conocen que, los hindúes fueron los que más se acercaron a las ideas modernas sobre el átomo, la física cuántica y otras teorías actuales. Ellos desarrollaron muy temprano sólidas teorías atomistas sobre la materia. Posiblemente, el pensamiento atomista griega recibió las influencias del pensamiento de los hindúes a través de las civilizaciones persas. El Rig-Veda, que data de alguna fecha situada entre el 2000 y el 1500 a. C., es el primer texto hindú en el que se exponen unas ideas que pueden considerarse leyes naturales universales. La ley cósmica está relacionada con la luz cósmica.

situada entre el 2000 y el 1500 a. C., es el primer texto hindú en el que se exponen unas ideas que pueden considerarse leyes naturales universales. La ley cósmica está relacionada con la luz cósmica.

El Rig-Veda, que data de alguna fecha situada el año 2000 y 1500 a. C., es el primer texto hundú en el cual se exponen unas ideas que pueden considerarse …

Anteriores a los primeros Upanishads tenemos en la India la creación de los Vedas, visiones poéticas y espirituales en las que la imaginación humana ve la Naturaleza y la expresa en creación poética, y después va avanzando unidades más intensamente reales que espirituales hasta llegar al Brahmán único de los Upanishads.

llegar al Brahmán único de los Upanishads.

la época de Buda (500 a, C.), los Upanishad, escritos durante un período de varios siglos, mencionaban el concepto de svabhava, definido “la naturaleza inherente de los distintos materiales”; es decir, su eficacia causal única, , tal como la combustión en el caso del fuego, o el hecho de fluir hacia

un período de varios siglos, mencionaban el concepto de svabhava, definido “la naturaleza inherente de los distintos materiales”; es decir, su eficacia causal única, , tal como la combustión en el caso del fuego, o el hecho de fluir hacia abajo en el caso dela agua. El pensador Jainí Bunaratna nos dijo: “Todo lo que existe ha llegado a existir por acción de la svabhava. Así… la tierra se transforma en una vasija y no en paño… A partir de los hilos se produce el paño y no la vasija”.

abajo en el caso dela agua. El pensador Jainí Bunaratna nos dijo: “Todo lo que existe ha llegado a existir por acción de la svabhava. Así… la tierra se transforma en una vasija y no en paño… A partir de los hilos se produce el paño y no la vasija”.

Tambiénm aquellos pensadores, manejaron el concepto de yadrccha, o azar desde tiempos muy remotos. Implicaba la falta de orden y la aleatoriedad de la causalidad. Ambos conceptos se sumaron a la afirmación del griego Demócrito medio siglo más tarde: “Todo lo que hay en el universo es fruto del azar y la necesidad”. El ejemplo que que dio Demócrito -similar al de los hilos del paño- fue que, toda la materia que existe, está formada por a-tomos o átomos.

tiempos muy remotos. Implicaba la falta de orden y la aleatoriedad de la causalidad. Ambos conceptos se sumaron a la afirmación del griego Demócrito medio siglo más tarde: “Todo lo que hay en el universo es fruto del azar y la necesidad”. El ejemplo que que dio Demócrito -similar al de los hilos del paño- fue que, toda la materia que existe, está formada por a-tomos o átomos.

Bueno, no lo puedo evitar, mi imaginación se desboca y corre rápida por los diversos pensamientos que por la mente pasan, de uno se traslada a otros y, al final, todo resulta un conglomerado de ideas que, en realidad, quieren explicar, dentro de esa diversidad, la misma cosa.

Mirar al pasado nos enseña de donde venimos y quiénes somos.

Emilio Silvera V.

Oct

22

¡Siempre persiguiendo sueños!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

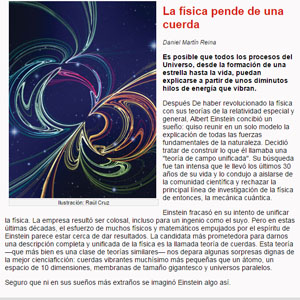

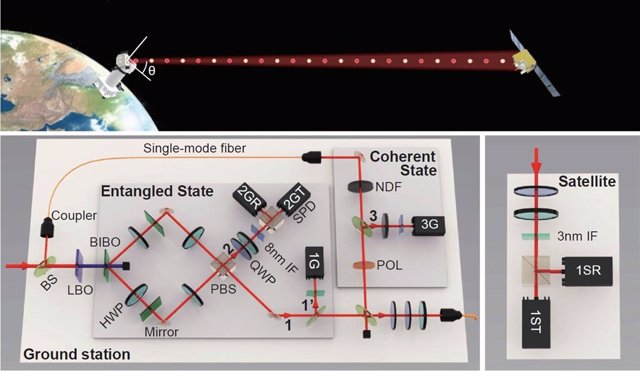

El puente entre mecánica cuántica y relatividad general aún es posible. Un equipo internacional de investigadores han desarrollado un marco unificado que explicaría este aparente desglose entre la física clásica y la física cuántica, y lo pusieron a prueba utilizando un satélite cuántico llamado Micius.

Leer más: https://www.europapress.es/ciencia/laboratorio/noticia-puente-mecanica-cuantica-relatividad-general-aun-posible-20190920102718.html

Satélite Gravity Probe B. Dedicado a medir la curvatura del campo gravitatorio terrestre, según la teoría de la relatividad de Einstein.

La mecánica cuántica y la teoría general de la relatividad forman la base de la comprensión actual de la física, aunque las dos teorías no parecen funcionar juntas. Se han construido toda clase de artilugios de última tecnología para tratar de medir ambas teorías unificándolas, sin que hasta la fecha, el resultado sea positivo.

“La gravedad cuántica es el campo de la física teórica que procura unificar la teoría cuántica de campos, que describe tres de las fuerzas fundamentales de la naturaleza, con la relatividad general, la teoría de la cuarta fuerza fundamental: la gravedad. La meta es lograr establecer una base matemática unificada que describa el comportamiento de todas las fuerzas de la Naturaleza, conocida como la teoría del campo unificado.”

Súper-Gravedad en dimensión 11

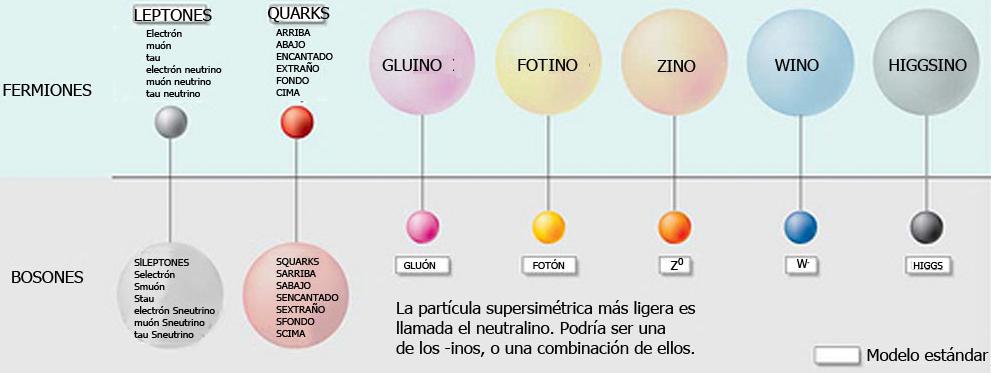

“En la física de partículas, la supersimetría es una simetría hipotética que podría relacionar las propiedades de los bosones y los fermiones. La supersimetría también es conocida por el acrónimo inglés SUSY. En una teoría super-simétrica cada partícula bosónica tendría un “compañera super-simétrico” de tipo fermiónico y viceversa.”

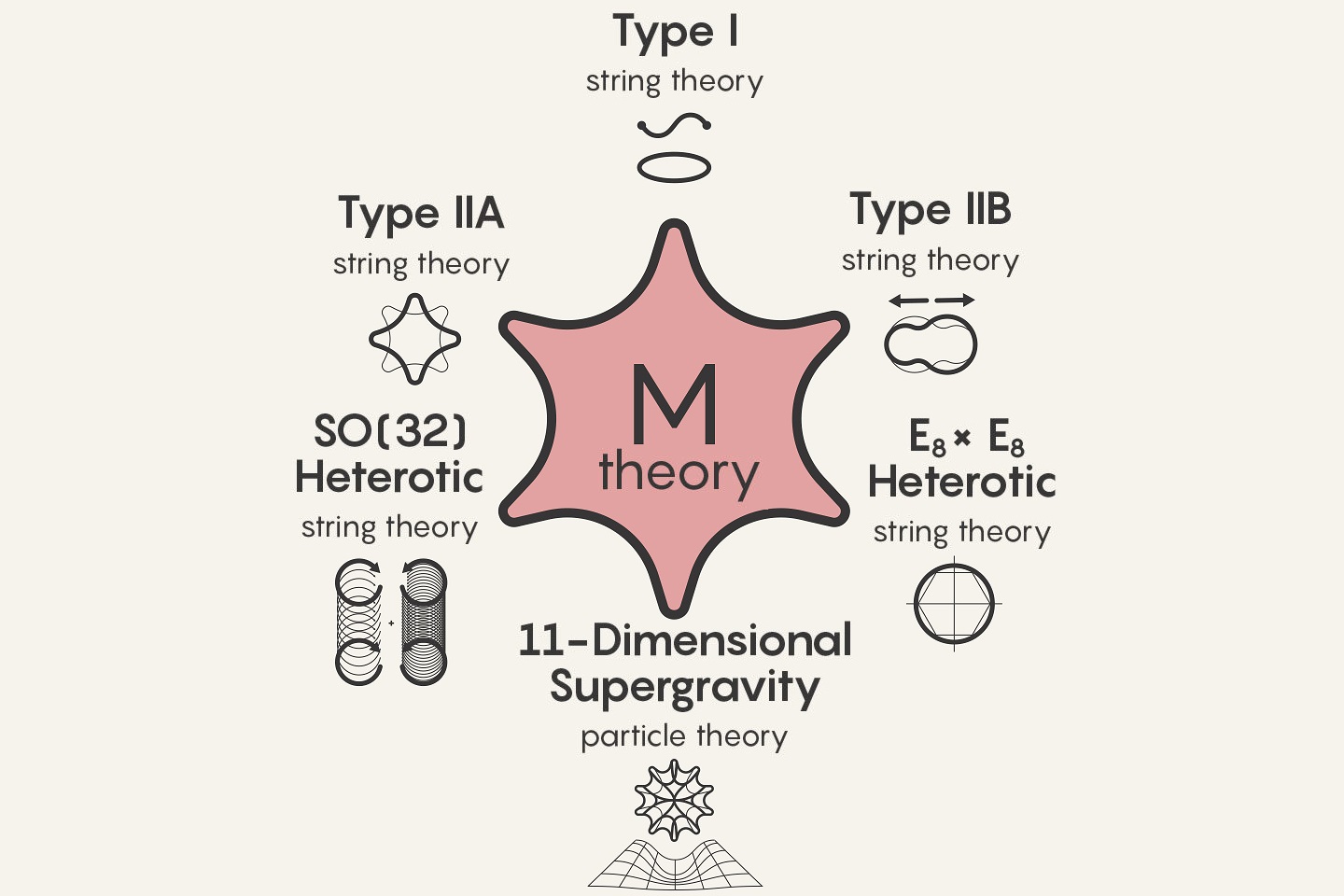

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “super-gravedad”, “súper-simetría”, “supercuerdas”, “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”.

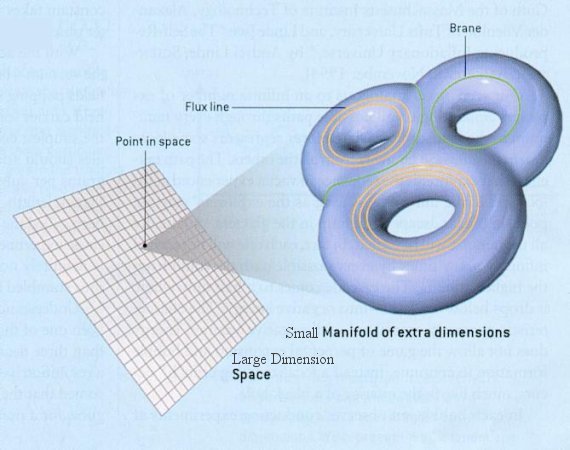

Representación de la variedad de Calabi-Yau uno de los candidatos para representar las dimensiones compactificadas asociadas a la teoría M, diferente de las cuatro dimensiones observables (no-compactificadas) del espacio-tiempo.

“La teoría M es una teoría física, propuesta como una “teoría del todo” que unifique las cuatro fuerzas fundamentales de la naturaleza. La teoría M fue esbozada inicialmente por Edward Witten, su propuesta combinaba las cinco teorías de supercuerdas y supergravedad en once dimensiones.”

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo. Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado!

¿Quién puede ir a la longitud de Planck para verlas?

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

Pendiendo de unas cuerdas

Lo cierto es que para llegar a las cuerdas que según dicen está más allá de los Quarks, se necesitaría una energía de Planck, es decir de 1019 GeV. Esa energ´ñia no está a nuestro alcance.

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC que, si acaso, por medio de SUSY, nos podrá enseñar la simetría unificadora si es capaz de encontrar alguna de esas partículas exóticas como los squarks y los fotinos. Algunos hablan del Neutralino como componente de la hipotética “materia oscura”.

Oct

21

Leyendo huellas del pasado…. ¡Será verdad lo que cuentan?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Leyendas que han llegado hasta nosotros, historias escritas en tablillas de arcilla sumeria

Como la historia de la vida (en relación a la Humanidad), no la conoce nadie, nos hacemos eco de leyendas que corren por ahí y que vienen de mitologías o sucesos de aquella Civilización Sumeria que construyeron las primeras ciudades, inventaron la rueda, domesticaron animales, comenzaron la agricultura….

¿No resulta raro que aquel pueblo avanzara tanto en aquellos tiempos?

Bueno, aquí nos cuentan una historia que es una conjetura de lo que pudo pasar, y, la imaginación desbocada nos llevan de la mano de hechos… ¿Fantásticos? Claro que en todas las historias subyace algo de verdad que, a medida que pasaba de una generación a otra, era objeto de adornos y retoques.

Que cada cual determine lo que quiere creer sobre lo que aquí nos cuentan.

Emilio Silvera V.

Totales: 85.038.098

Totales: 85.038.098 Conectados: 91

Conectados: 91