May

12

De lo pequeño a lo grande y, conocer la Naturaleza…¡No será...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

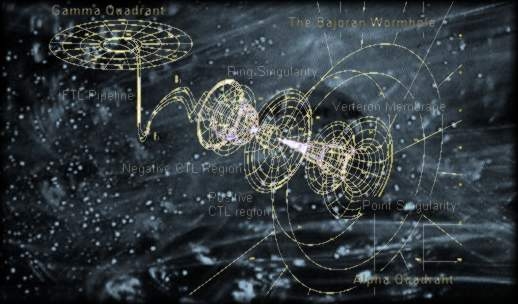

Una parte de la ciencia estudia la estructura y la evolución del Universo: La cosmología.

La cosmología observacional se ocupa de las propiedades físicas del Universo, como su composición física referida a la química, la velocidad de expansión y su densidad, además de la distribución de Galaxias y cúmulos de galaxias. La cosmología física intenta comprender estas propiedades aplicando las leyes conocidas de la física y de la astrofísica. La cosmología teórica construye modelos que dan una descripción matemática de las propiedades observadas del Universo basadas en esta comprensión física.

La cosmología también tiene aspectos filosóficos, o incluso teológicos, en el sentido de que trata de comprender por qué el Universo tiene las propiedades observadas. La cosmología teórica se basa en la teoría de la relatividad general, la teoría de Einstein de la gravitación. De todas las fuerzas de la naturaleza, la gravedad es la que tiene efectos más intensos a grandes escalas y domina el comportamiento del Universo en su conjunto.

El espacio-tiempo, la materia contenida en el Universo con la fuerza gravitatoria que genera, los posibles agujeros de gusano y, nuestras mentes que tienen conocimientos de que todo esto sucede o puede suceder. De manera que, nuestro consciente (sentimos, pensamos, queremos obrar con conocimiento de lo que hacemos), es el elemento racional de nuestra personalidad humana que controla y reprime los impulsos del inconsciente, para desarrollar la capacidad de adaptación al mundo exterior.

Al ser conscientes, entendemos y aplicamos nuestra razón natural para clasificar los conocimientos que adquirimos mediante la experiencia y el estudio que aplicamos a la realidad del mundo que nos rodea. Claro que, no todos podemos percibir la realidad de la misma manera, las posibilidades existentes de que el conocimiento de esa realidad, responda exactamente a lo que ésta es en sí, no parece fácil.

Pauli destacó por sus importantes contribuciones a la física teórica, principalmente en el área de la mecánica cuántica. Entre sus principales logros se encuentran la teoría de los números cuánticos, la exclusión de Pauli y la hipótesis de no-localidad. Sus contribuciones a la física moderna han sido inmensas y le valieron el Premio Nobel de Física en 1945.

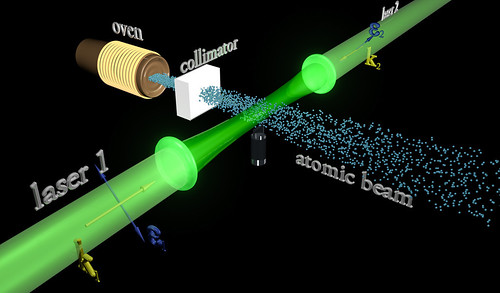

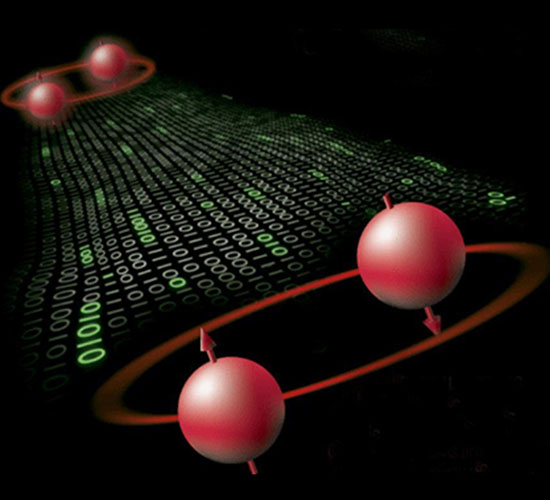

Debido al principio de exclusión de Pauli, es imposible que dos fermiones ocupen el mismo cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7º K) se formar un condensado de Bose-Einstein, en el que varios miles de átomos forman una única entidad (un super-átomo). efecto ha sido observado con átomos de rubidio y litio. Como ha habréis podido suponer, la condensación Bose-Einstein es llamada así en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Una de las maravillas del Universo ¿Qué está pasando en el diminuto núcleo del átomo?

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuántica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosonesidénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y ajustes ad-hoc, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas.

La relación el espín y la estadística de las partículas está demostrada por el teorema espín-estadística. En un espacio de dos dimensiones es posible que existan partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el de aiones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de+1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

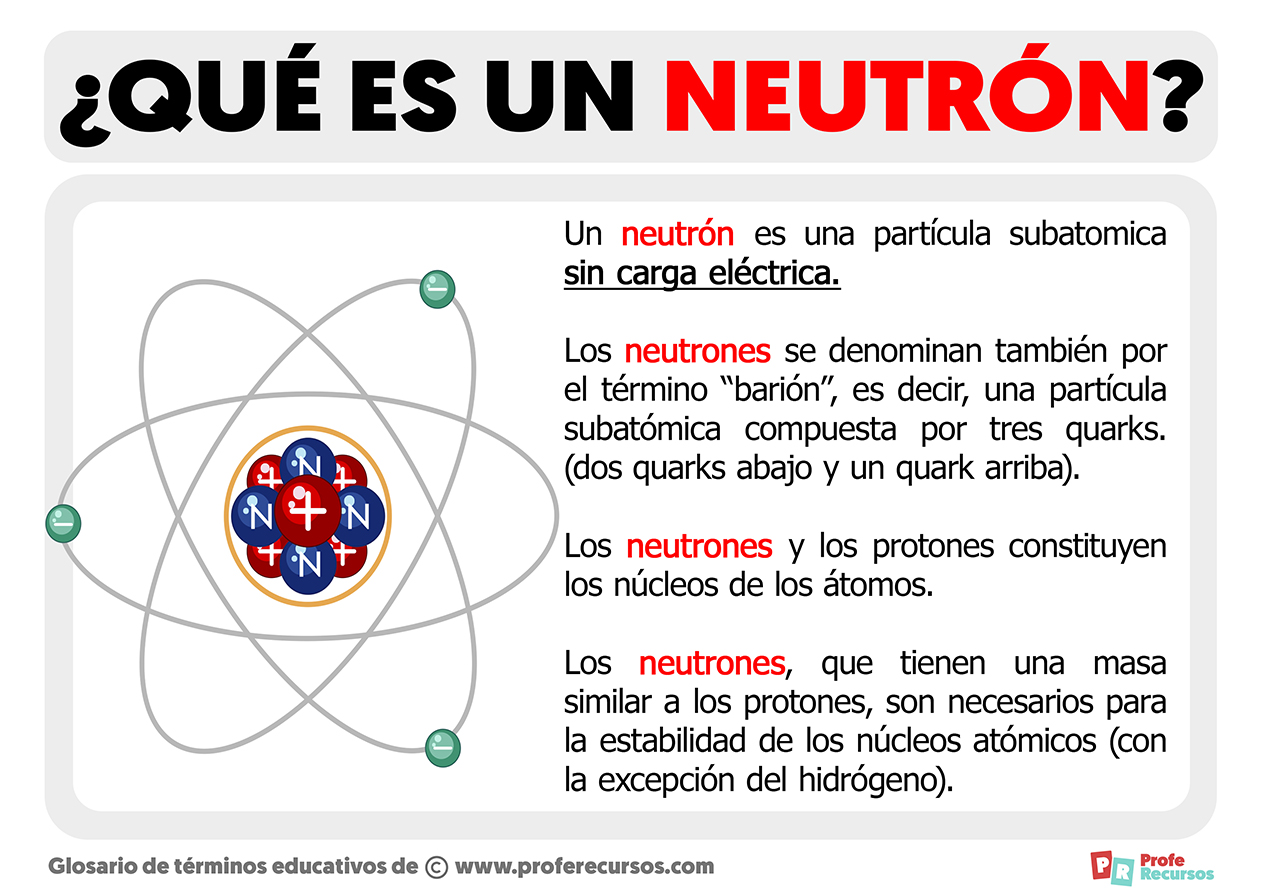

Resulta fácil comprender cómo un campo magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma forma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un campo magnético cuando gira la partícula.

Particularmente creo que, si el neutrón tiene masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Sea fuere, la rotación del neutrón nos da la respuesta a esas preguntas:

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965

¿Qué es el anti-neutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos. Es indudable que las antipartículas pueden combinarse para formar la antimateria, de la misma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un anti-deuterón. entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros anti-núcleos más complicados aún si se abordara el problema con más interés.

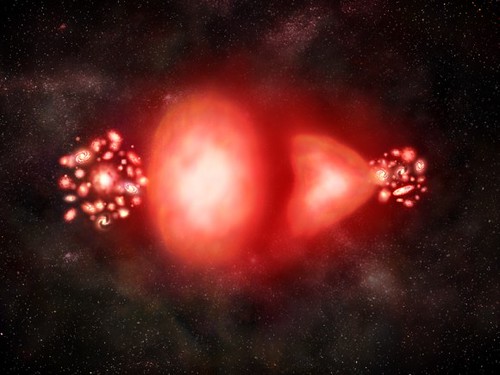

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, tratar de encontrar alguna actividad inusual que delate interacciones materia-antimateria.

…, ¿Hay masas de antimateria en el Universo? ¿Galaxias de antimateria?

Bueno, sabemos que no son las galaxias las que se alejan, sino que es el espacio el que se expande. Lo que no sabemos es encontrar antimateria en el espacio interestelar y, si la hay y está presente… ¡Aún no la hemos podido localizar! Algunos dicen que hay galaxias de antimateria y, yo digo que tengo un pariente en la galaxia Astrinia del cúmulo Ultramón a diez mil millones de años-luz de nuestra región.

No parece que dichas observaciones, al menos hasta el , hayan sido un éxito.

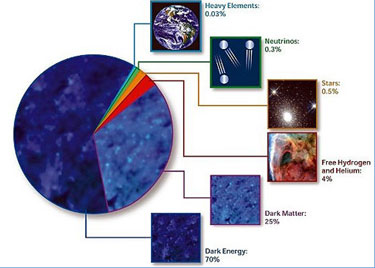

Según estimaciones recientes, resumidas en gráfico de la NASA, alrededor del 70% del contenido energético del Universo consiste en energía oscura, cuya presencia se infiere en su efecto sobre la expansión del Universo pero sobre cuya naturaleza última no se sabe casi nada.

¿Es posible que el Universo este formado casi enteramente por materia, con muy poca o ninguna antimateria? Y si es así, ¿por qué? dado que la materia y la antimateria son equivalentes en todos los aspectos, excepto en su oposición electromagnética, cualquier fuerza que crease una originaria la otra, y el Universo debería estar compuesta de iguales cantidades de la una y de la otra.

Este es el dilema. La teoría nos dice que debería haber allí antimateria, pero las observaciones lo niegan, no lo respaldan. ¿Es la observación la que falla? ¿Y qué ocurre con los núcleos de las galaxias activas, e incluso más aún, con los causares? ¿Deberían ser estos fenómenos energéticos el resultado de una aniquilación materia-antimateria? ¡No creo! Ni siquiera ese aniquilamiento parece ser suficiente, y los astrónomos prefieren aceptar la noción de colapso gravitatorio y fenómenos de agujeros negros como el único mecanismo conocido para producir la energía requerida.

Estábamos hablando de mecánica cuántica y me pasé, sin que me diera , al ámbito de la antimateria y el espacio del macro universo de las galaxias. Sin embargo, y aunque parezcan temas dispares, lo cierto es que, a medida que profundizamos en estas cuestiones, todas nos llevan, de una u otra manera, a relacionar el “mundo de lo muy pequeño” con el “mundo” de lo muy grande que, al fín y al cabo, está hecho de lo que existe en el primero, es decir, partículas infinitesimales de materia y… ¡de antimateria! para que todo quede compensado.

Sus dimensiones y masa le permiten ¡lo imposible! para nosotros. La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos fuerza de Van der Vaalls. esta fuerza tiene un alcance muy corto. para ser más precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente proporcional a 1/r7. Esto significa que si se reduce la distancia entre dos átomos a la mitad, la fuerza de Van der Vaalls con la que se atraen uno a otro se hace 2 x 2 x 2 x 2 x 2 x 2 x 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza.

La mecánica cuántica domina en el micro-mundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es como una onda de agua. Se parece más a una ola de histeria que se expande: es una onda de información. Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

Por el contrario, la relatividad general era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la formación de agujeros negros.

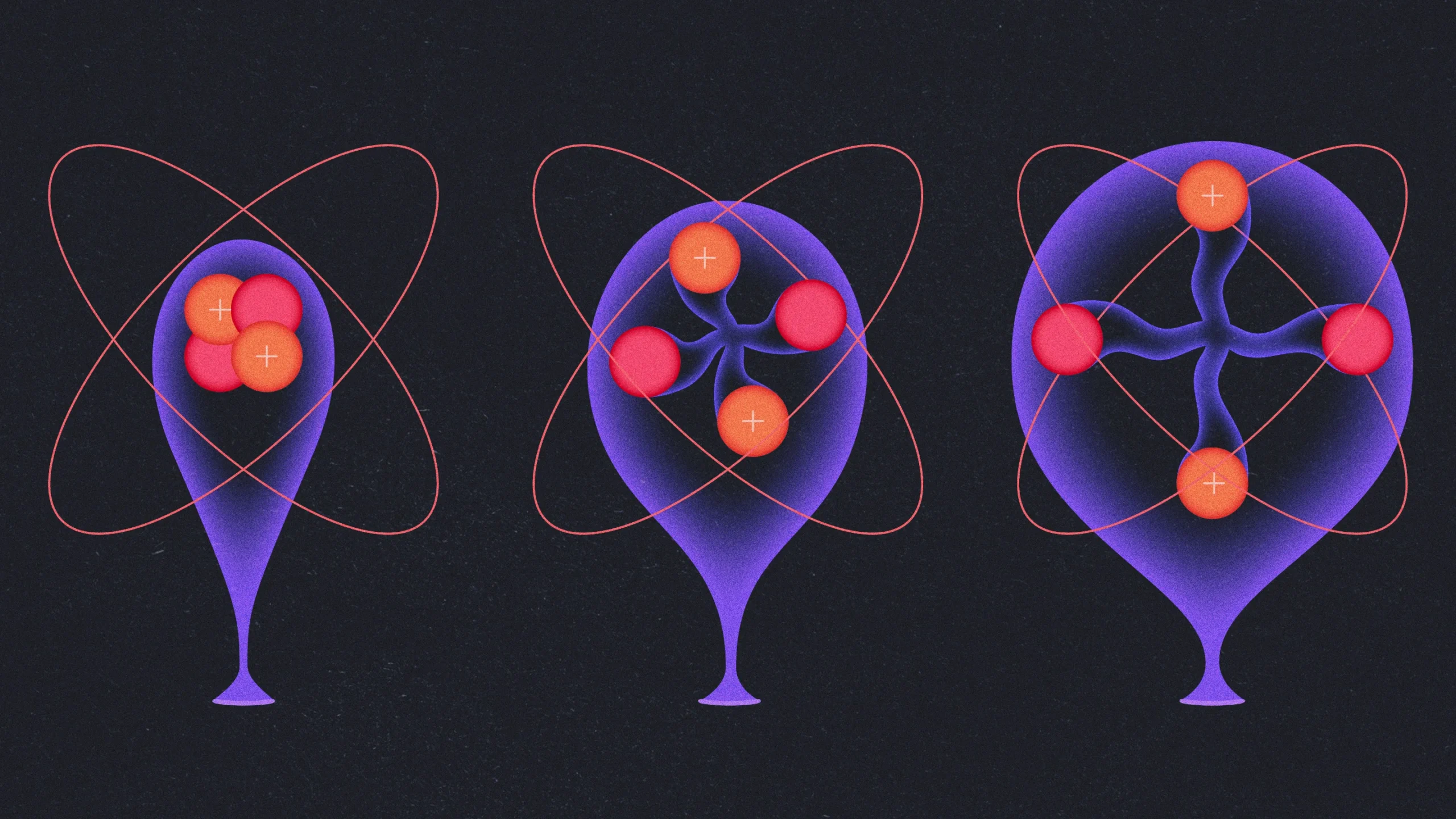

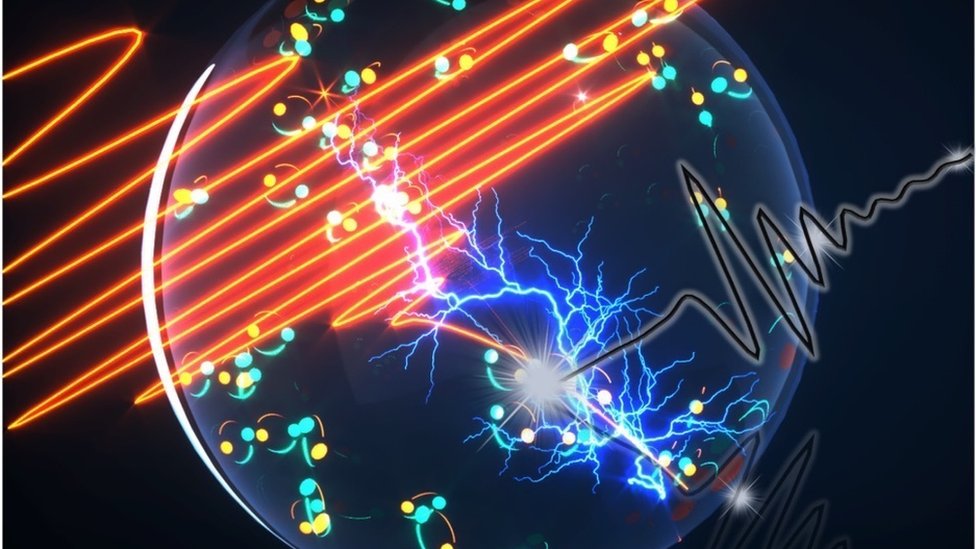

Los núcleos de helio excitados se inflan como globos, ofreciendo a los físicos la oportunidad de estudiar la fuerza nuclear fuerte, que une los protones y neutrones del núcleo. Fuente: Kristina Armitage / Quanta Magazine

“Al medir el núcleo de helio hinchado, los físicos han desafiado nuestra mejor comprensión de la fuerza que une los protones y los neutrones.

Un artículo de Katie McCormick. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.”

Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el espacio y distorsiona el tiempo.

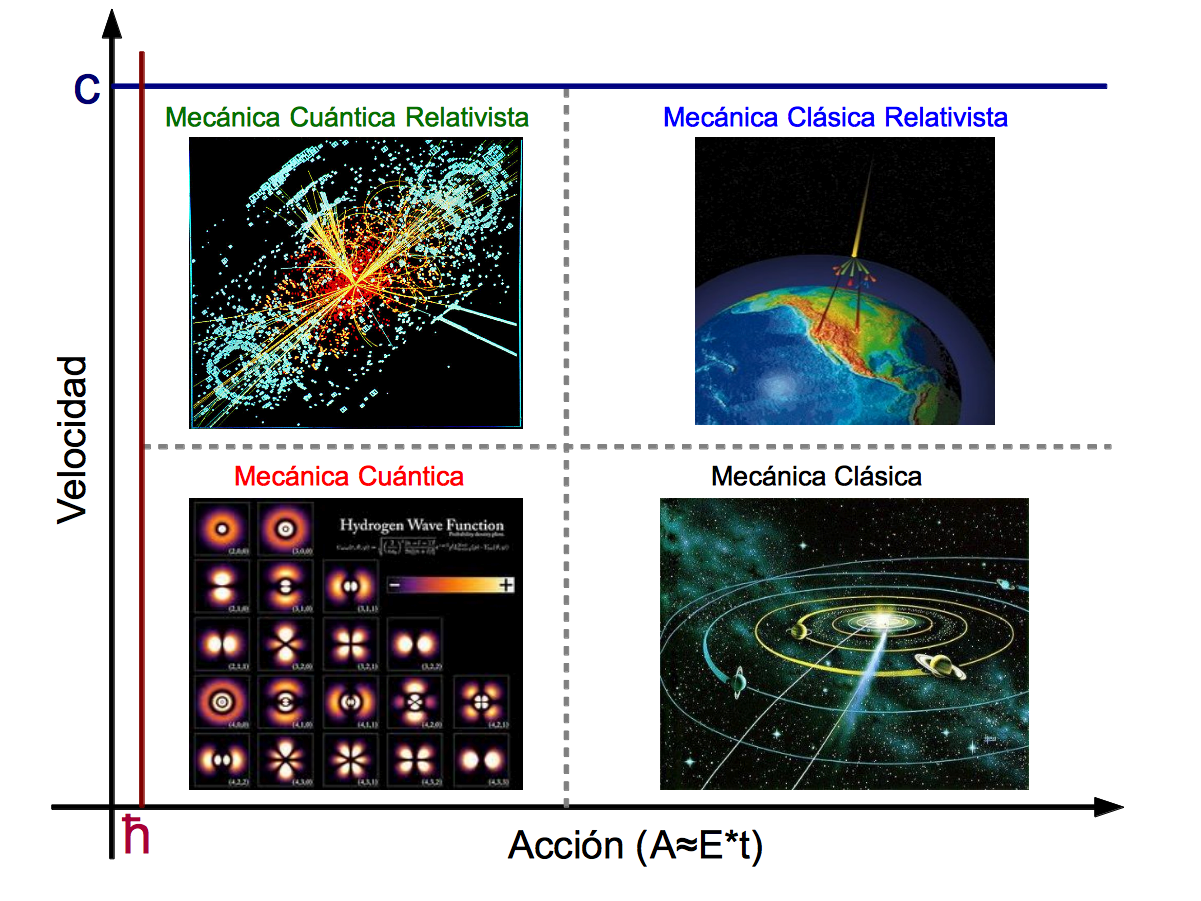

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica.

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad general de Einstein? Afortunadamente, hay una respuesta simple y las unidades de Planck nos dicen cuales son. En realidad, es la propia Naturaleza la que marca esos límites que Stoney-Planck, supieron plasmar en ecuaciones que los marcan.

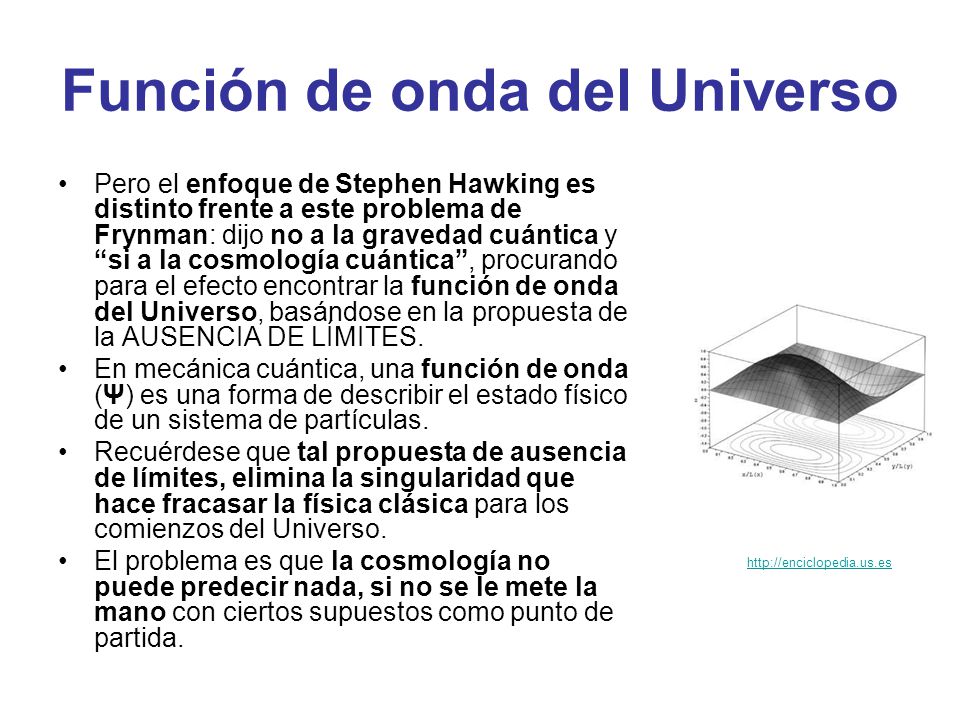

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de onda cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 de centímetros, más joven que el tiempo de Planck, 10-43 segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de aplicación de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido cerca del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “información” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele mostrar en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1.975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

Siempre hemos tratado de buscar información del Universo para saber de nuestro entorno, de nuestro Sistema solar, de nuestra Galaxias, de las galaxias lejanas, y, de las mismas estrellas que alumbran los mundos y permite la vida con su luz y su calor. Hemos llegado a saber que somos “polvo de estrellas”, que los materiales que nos conforman están “fabricados” en sus “hornos nucleares”, la fusión crea elementos que, más tarde, forman parte de los mundos y de los seres vivos.

La velocidad de la luz en el vacío es por definición una constante universal de valor 299.792.458 m/s(suele aproximarse a 3·108 m/s), o lo que es lo mismo 9,46·1015 m/año; la segunda cifra es la usada para definir al intervalo llamado año luz. La información se transmitirá a esa velocidad como máximo, nuestro Universo, no permite mayor rapidéz, al menos, por los métodos convencionales.

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1.981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos.

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El número máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de información producida hasta ahora. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

Stoney Planck

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, desde el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un gráfico que recree la escala logarítmica de tamaño desde el átomo a las galaxias.

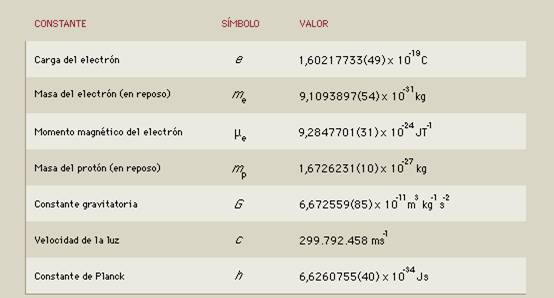

Todas las estructuras del universo existen porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón

“Tras medir alfa en unas 300 galaxias lejanas, vimos un patrón constante: este número, que nos dice la fuerza del electromagnetismo, no es igual en otras partes que en la Tierra, y parecer variar de forma continua a lo largo de un eje”. Algunos se empeñan en variar la constante de estructura fina y, si eso llegara a producirse… las consecuencias serían funestas para nosotros. Otros estudios nos dicen que esa constante, no ha variado a lo largo de los miles de millones de años del Universo y, así debe ser, o, si varió, lo hizo en una escala ínfima.

|

α = 2πe2 / hc ≈ 1/137 |

|

αG = (Gmp2)2 / hc ≈ 10-38 |

Si variaran algunas de las dos en sólo una diezmillonésima, muchas de las cosas que conforman el Universo serían imposible y, la consecuencia sería, la ausencia de vida. La identificación de constantes adimensionales de la naturaleza como a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

El número puro adimensional

“Todos los físicos del mundo, deberían tener un letrero en el lugar más visible de sus casas, para que al mirarlo, les recordara lo que no saben. En el cartel sólo pondría esto: 137. Ciento treinta y siete es el inverso de algo que lleva el nombre de constante de estructura fina”

Lederman

Este número guarda relación con la posibilidad de que un electrón emita un fotón o lo absorba. La constante de estructura fina responde también al nombre de “alfa” y sale de dividir el cuadrado de la carga del electrón, por el producto de la velocidad de la luz y la constante de Planck. Tanta palabrería y numerología no significan otra cosa sino que ese solo numero, 137, encierra los misterios del electromagnetismo (el electrón, e–), la relatividad (la velocidad de la luz, c), y la teoría cuántica (la constante de Planck, h).

Todo eso está relacionado: leyes fundamentales, constantes, materia y espacio tiempo… ¡nosotros! Es posible (digo posible), que finalmente no seamos ni tanto ni tan poco como a veces creemos. Dejemos en un término medio nuestra valía en el contexto del Universo, aunque, poder crear ideas y pensamientos… ¡No es cosa baladí!

Emilio Silvera Vázquez

May

11

La Mecanica cuantica y la Filosofia

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (27)

Comments (27)

La Causalidad, el determinismo, el mundo real, la mecánica cuántica.

Las cuestiones en que la Mecánica cuántica se aparta del realismo cotidiano, digamos, y que parecen paradójicas, son muchas, así que entresacamos unas cuantas, sin compromiso de completitud: No hay una causalidad estricta, pero si una cierta causalidad (la dirección y el momento de la Emision de una partícula alfa por u núcleo inestable no están determinados, pero si la vida media: un gramo de radio decae a medio en 1.500 años). No hay determinismo (las “orbitas” que el electrón describen en el átomo son inexistentes, pero hay electrones sujetos al átomo por fuerzas eléctricas y los niveles de energías se calculan a partir del planteamiento clásico del problema (Hamiltoniano). La componente del espin de plata en el experimento Stern-Gerlach (1922) no esta predeterminada, pero la medida da solo proyecciones máximas, ± ½ (ese resultado fue un rompecabezas en la cuántica antigua, anticipando que una medida produce solo el auto valor del observable).

Entrelazamiento cuántico

Los sistemas cuánticos extensos pueden aparecer como en todo, de modo que una medida en un extremo local presupone el resultado de la medida en otro, especialmente separado: hay inseparabilidad (wholeness) del sistema. Algunas propiedades predicables de un sistema no están objetivamente determinadas hasta que no se miden, entonces el resultado puede ser aleatorio: hay una relajación del realismo objetivo.

El electrón desaparece y reaparece en una órbita más energética ¿Por dónde hizo el camino?

Es interesante señalar que la desintegración radiactiva (Rutherford, 1902) y el salto del electrón de “orbita” a “orbita” con emisión de luz (Bohr, 1913) son puzles de la teoría cuántica (del atomismo diríamos) puestas de relieve ya antes de la cuántica1 moderna, y como tales ya fueron advertidas en su momento: Einstein se dio cuenta del carácter no causal de la caída radiactiva, lo que le produjo cierto malestar (Unbehagen), y Rutherford pregunto a Bohr como demonios sabia el electrón cuando y donde debe caer; Einstein se atormento por esa cuestión toda su vida (llego a hablar de libre albedrío del electrón). Aquí nos interesa resaltar que bajo una concepción atomista del mundo, y con la posibilidad de estados excitados de la materia, la causalidad estricta es imposible: la partícula alta tiene que emitirse, y salga por donde salga se rompe la simetría: el proceso ya no será causal estricto; la coexistencia del atomismo con la simetría rotacional implica la rotura espontánea de esta.

May

10

El “universo” cuántico y…, sus alrededores

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comentarios desactivados en El “universo” cuántico y…, sus alrededores

Comentarios desactivados en El “universo” cuántico y…, sus alrededores

Se cuenta que una vez Albert Einstein alagó al actor Charles Chaplin diciéndole:

“Lo que siempre he admirado de Usted es que su arte es universal, todo el mundo le comprende a admira”.

A esto Chaplin respondió a Einstein:

“Lo suyo es mucho más digno de respeto, todo el mundo le admira y prácticamente nadie le comprende”.

Es cierto lo que Chaplin decía, todos admiraban a Einstein y pocos comprendían sus postulados. De hecho, cuando estaba buscando la teoría de Todo, la gente se amontonaban, literalmente, ante los escaparates de la Quinta Avenida para ver las Ecuaciones que pocos entendían…¡Así somos los Humanos! Lo que no comprendemos nos produce temor o admiración, o, las dos cosas a la vez.

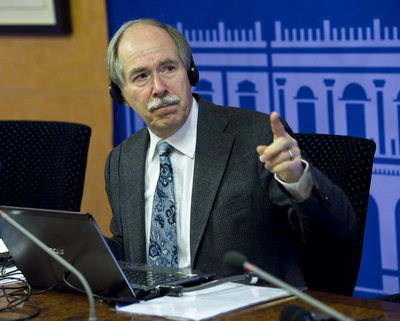

El premio Nobel Gerad ´t Hooft

Hace ya algún tiempo que me desplace a Madrid, invitado para asistir a una Conferencia que sobre el LHC y el Bosón de Higgs, la impartía el físico y premio Nobel de Física Gerad ´t Hooft.

La charla de ‘t Hooft se inscribía en el ciclo La ciencia y el cosmos, y, entre otras cosas nos decía a los presentes que, la física, en concreto la física de partículas, ha sido siempre su gran pasión. “Cuando era joven, la física estaba cambiando el mundo radicalmente: la Energía Nuclear, la Televisión, los Ordenadores, las primeras Misiones Espaciales….yo quería formar parte de todo eso”.

Y las partículas elementales “eran el mayor misterio de todos”, y añade:

“En cierto modo aún lo son, aunque ahora sabemos de ellas muchísimo más que entonces. Hoy los ordenadores siguen siendo emocionantes, la biología y el código del ADN, la astronomía y los vuelos espaciales… Sigue habiendo muchas cosas capaces de estimular la imaginación de jóvenes deseosos de aprender cosas nuevas impulsados por el deseo de estar ahí, en el momento en que se están haciendo los descubrimientos que cambian el mundo”.

Gerard ‘t Hooft explicó lo que significa, en los modelos teóricos, el famoso bosón: “El campo de la partícula de Higgs actúa como una especie de árbitro; proyectado contra otras partículas, este campo determina su comportamiento, si tienen carga o masa y hasta qué punto se diferencian de otras partículas. Si no encontramos el Higgs, si realmente no está, necesitaremos algo más que haga ese papel de árbitro”. Eso significaría, continuaba el Nobel, que “nuestras teorías ya no funcionan, y han funcionado tan bien hasta ahora que eso es difícil de imaginar”.

La espera fue enorme y todos esperaban las noticias sobre el dichoso Bosón

Cuando comenzó la búsqueda se decía:

Sí al LHC se le resiste el Bosón de Higgs…, bueno, si es que anda por ahí.

Fue en 1999 cuando ‘t Hooft recibió el premio Nobel de Física (junto con su colega y director de tesis Martinus Veltman), por “dilucidar la estructura cuántica de las interacciones electro-débiles” -según palabras de la Academia sueca- de la física de las partículas elementales.

Acerca del Gran Colisionador de Hadrones (el acelerador LHC situado en el Laboratorio Europeo de Física de partículas, CERN, junto a Ginebra), el científico holandés explica que se trata “de una máquina única en el mundo” y continúa: “Esperamos descubrir nuevas cosas con él y poner a prueba teorías que, hasta donde hemos podido comprobar hasta ahora, funcionan muy bien, pero necesitamos ir más allá”.

El descubrimiento de la partícula de Higgs, o bosón de Higgs, fue el objetivo número uno del LHC, y tras un largo período de funcionamiento del acelerador, los miles de físicos que trabajan en los detectores, han logrado acotar el terreno de búsqueda, aunque, insisten, seguramente necesitarán tomar muchos más datos para descubrirlo. O tal vez descubrir que no existe, lo que supondría una revolución en la física de partículas, al obligar a replantear el llamado Modelo Estándar, que describe todas las partículas elementales y sus interacciones, y que hasta ahora funciona con altísima precisión aunque, dicen los expertos, está incompleto.

Gerard ‘t Hooft, uno de los grandes físicos teóricos de partículas elementales, considera que será muy difícil desarrollar una teoría del todo, un cuerpo teórico capaz de explicar todas las fuerzas que actúan en la naturaleza aunando la Relatividad General de Einstein y la Mecánica Cuántica, tan eficaces por separado en la descripción del macrocosmos y el microcosmos, respectivamente. “Mi impresión es que esta teoría unificadora, una teoría del todo, aún requerirá el trabajo de muchas nuevas generaciones de investigadores jóvenes y listos”, afirma. “No llegaremos a ella de un momento a otro por la simple razón de que el universo es demasiado complejo para que una única teoría lo abarque todo. Vale, no digo que sea imposible, pero me parece muy improbable. Y mientras llega, queda mucho por descubrir, incluso hallazgos espectaculares”.

Muchas son las actividades desconocidas para el público que se desarrollan en el LHC, como la terapia de hadrones y otras

Por otra parte, el científico holandés ha señalado que el LHC realiza más actividades que intentar encontrar el bosón de Higgs. En este sentido, ha destacado que se buscan también partículas que podrían construir la materia oscura, un tipo de materia de la que los físicos tienen la certeza de que es cinco veces más abundante que el universo que la materia ‘normal’, pero que no absorbe, refleja ni emite luz, lo que hace muy difícil su detección y, por tanto, estudiar su naturaleza. Del mismo modo, también se está desarrollando una teoría capaz de unificar la teoría de la relatividad general de Einstein y la mecánica cuántica que, según ha explicado Hooft, “permitiría descubrir lo que ocurre dentro de los átomos”.

De vez en cuando lo consulto

Recuerdo un pasaje escrito por él al principio de su interesante e instructivo libro “Partículas Elemetales”, que decía:

“Mi intención es narrar los últimos 25 años de investigación sobre las partículas más pequeñas que constituyen la materia. Durante esos 25 años, yo empecé a ver la Naturaleza como un test de inteligencia para toda la Humanidad en su conjunto, como un gigantesco puzle con el que podemos jugar. Una y otra vez, nos tropezamos con nuevas piezas, grandes y pequeñas, que encajan maravillosamente con las que ya tenemos. Yo quiero compartir con ustedes la sensación de triunfo que sentimos en esos momentos.”

Tenía la intención (si se presentaba la oportunidad), de preguntarle sobre “su Principio Holográfico” pero, no pudo ser. Sólo pude saludarlo e intercambiar unas breves palabras junto con Ignacio Cirac presente también en el evento.

“En la década de los 90, los físicos Gerard ‘t Hooft, y Leonard Susskind postularon una hipótesis que sacudió por igual a la ciencia y a la opinión pública. Se la conoce como Principio Holográfico, y defiende la idea de que el universo puede ser interpretado como un holograma.”

Publicó el principio holográfico, el cual explica que la información de una dimensión extra es visible como una curvatura del espacio tiempo con una menos dimensiones. Por ejemplo, los hologramas son imágenes de 3 dimensiones colocadas en una superficie de 2 dimensiones, el cual da a la imagen una curvatura cuando el observador se mueve. Similarmente, en relatividad general, la cuarta dimensión esta manifestada en 3 dimensiones observables como la curvatura de un sendero de un movimiento de partícula (criterio) infinitesimal. Hooft ha especulado que la quinta dimensión es realmente la fábrica del espacio-tiempo.

Acordaos de que, a mediados del año 2,003 apareció la noticia de que la “información sería el componente fundamental de la naturaleza” postulada por un grupo de físicos entre los que se incluyen el Premio Nóbel danés Gerard t´Hooft y el físico de la Universidad de California Raphael Bousso, basadas en el “Principio Holográfico”. Esta teoría, por singular y chocante que pareciese en su momento ha tenido a lo largo de estos siete años una influencia notable tanto en la sociedad científica como en los círculos alternativos.

Personajes tan influyentes como Deepak Chopra sin ir más lejos habla del ámbito cuántico como el campo de información de donde parte todo lo conocido, materia, emociones, pensamientos. El controvertido joven físico Nassam Haramein defiende un universo basado en el holograma. Científicos japoneses -al igual que del resto del mundo- investigan con hologramas creando imágenes 3D o explican el funcionamiento del mundo físico basado en los campos de energía e información. Hay hasta “farmacología holográfica” a cargo de empresas farmacéuticas. El año pasado el físico Craig Hogan tras la detección de un extraño ruido en el detector de ondas gravitacionales el GEO 600, afirma que podría probar que, efectivamente, vivimos en un holograma.

La información sería el componente fundamental de la naturaleza. Es la que especifica el cuándo, dónde, cómo y cuánto del espacio, del tiempo y de la materia. El Big Bang que dio lugar al nacimiento del Universo tendría más que ver con una gigantesca “bajada” de bytes de información por parte de un superordenador, que con una explosión masiva de materia, según una nueva teoría que establece que en su origen la naturaleza está formada únicamente por pequeños paquetes de información pura que son los que especifican el cuándo, dónde, cómo y cuánto del espacio, del tiempo y de la materia.

Emilio Silvera Vázquez

May

8

Maravillas de la Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

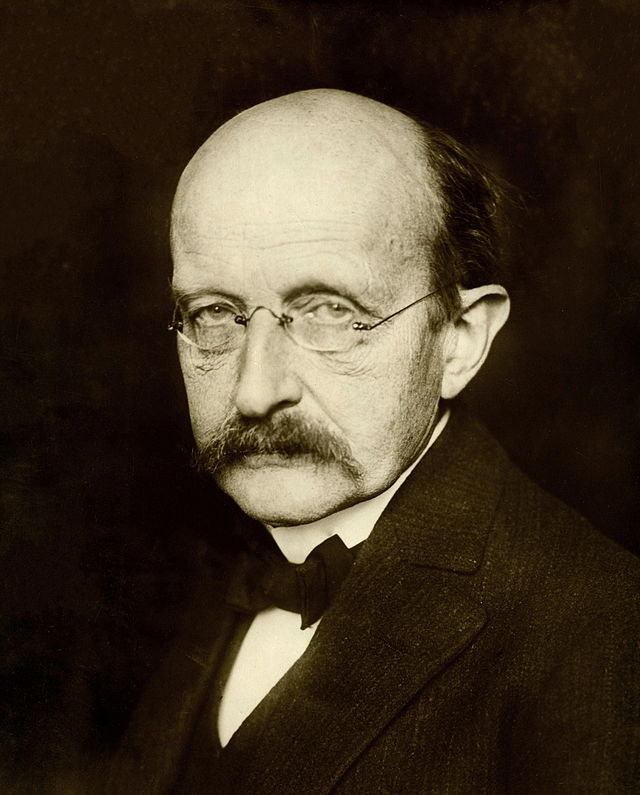

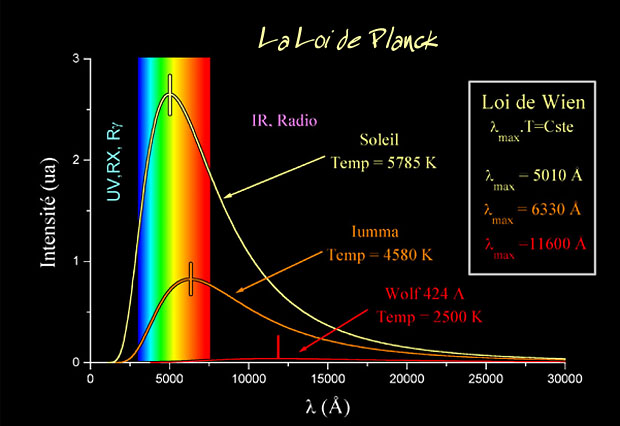

La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos. Planck escribió un artículo de ocho páginas y el resultado fue que cambió el mundo de la física y aquella páginas fueron la semilla de la futura ¡mecánica cuántica! que, algunos años más tardes, desarrollarían físicos como Einstein (Efecto fotoeléctrico), Heisenberg (Principio de Incertidumbre), Feynman, Bhor, Schrödinger, Dirac…

Todos ellos pasos cruciales para entender la Naturaleza, el comportamiento de las partículas, cómo funciona el Cosmos, o, la producción de Carbono en las estrellas, también la existencia de la anti-materia.

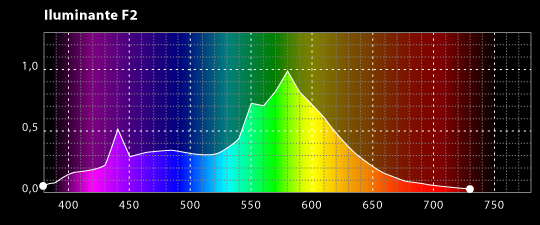

La expresión radiación se refiere a la emisión continua de energía de la superficie de todos los cuerpos. Los portadores de esta energía son las ondas electromagnéticas producidas por las vibraciones de las partículas cargadas que forman parte de los átomos y moléculas de la materia. La radiación electromagnética que se produce a causa del movimiento térmico de los átomos y moléculas de la sustancia se denomina radiación térmica o de temperatura.

Ley de Planck para cuerpos a diferentes temperaturas

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía.

Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico o una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a -273,15 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de la luz visible.

Acero al “rojo vivo”, el objeto está radiando en la zona de la luz visible.

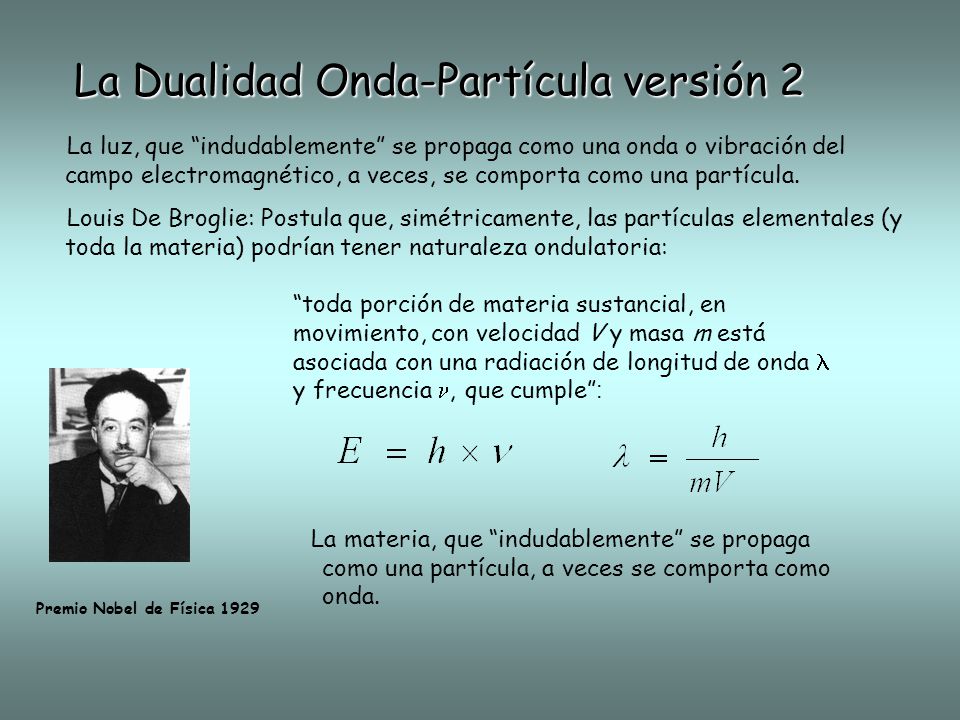

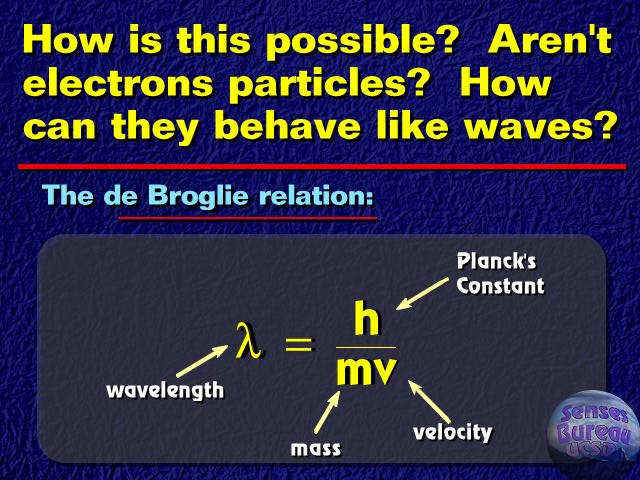

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

E = hv

Donde E es la energía del paquete, v es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck.

El príncipe francés Louis Victor de Broglie, dándole otra vuelta a la teoría, que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta dirección del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

Es curioso el comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Edwin Schrödinger descubrió como escribir la teoría ondulatoria de De Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar los cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de onda cuántica”.

No hay duda de que la Mecánica Cuántica funciona maravillosamente bien. Sin embargo, surge una pregunta muy formal: ¿qué significan realmente esas ecuaciones?, ¿qué es lo que están describiendo? Cuando Isaac Newton, allá por el año 1687, formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo lo que significaban sus ecuaciones: que los planetas están siempre en una posición bien definida en el espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades con el tiempo.

Pero para los electrones todo esto es muy diferente. Su comportamiento parece estar envuelto en la bruma. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de forma tal que con su explicación se pudo seguir trabajando y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la “interpretación de Copenhague” de la Mecánica Cuántica. En vez de decir que el electrón se encuentra en el punto x o en el punto y, nosotros hablamos del estado del electrón. Ahora no tenemos el estado “x” o el estado “y”, sino estados “parcialmente x” o “parcialmente y. Un único electrón puede encontrarse, por lo tanto, en varios lugares simultáneamente. Precisamente lo que nos dice la Mecánica Cuántica es como cambia el estado del electrón según transcurre el tiempo.

Un “detector” es un aparato con el cual se puede determinar si una partícula está o no presente en algún lugar pero, si una partícula se encuentra con el detector su estado se verá perturbado, de manera que sólo podemos utilizarlo si no queremos estudiar la evolución posterior del estado de la partícula. Si conocemos cuál es el estado, podemos calcular la probabilidad de que el detector registre la partícula en el punto x.

Las leyes de la Mecánica Cuántica se han formulado con mucha precisión. Sabemos exactamente como calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas simultáneamente. Por ejemplo, podemos determinar la velocidad de una partícula con mucha exactitud, pero entonces no sabremos exactamente dónde se encuentra; o, a la inversa. Si una partícula tiene “espín” (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar con sencillez de dónde viene esta incertidumbre, pero hay ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar.

¿Onda o partícula? ¡Ambas a la vez! ¿Cómo es eso?

Para que las reglas de la Mecánica Cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuanto más grande y más pesado es un objeto más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica.

Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por “holismo”, y que se podría definir como “el todo es más que la suma de las partes”.

Bien, si la Física nos ha enseñado algo, es justamente lo contrario: un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (las partículas): basta que uno sepa sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que yo entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes.

Por ejemplo, la constante de Planck, h = 6,626075…x 10-34 julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

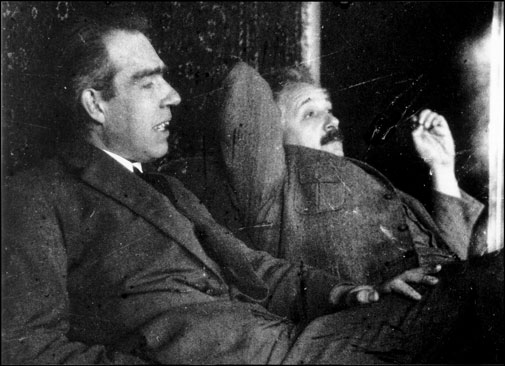

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisenberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros tales como Edwin Schrödinger, siempre presentaron serias objeciones a esta interpretación.

Quizá funcione bien, pero ¿dónde está exactamente el electrón, en el punto x o en el punto y? Em pocas palabras, ¿dónde está en realidad?, ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Hasta hoy, muchos investigadores coinciden con la actitud pragmática de Bohr. Los libros de historia dicen que Bohr demostró que Einstein estaba equivocado. Pero no son pocos, incluyéndome a mí, los que sospechamos que a largo plazo el punto de vista de Einstein volverá: que falta algo en la interpretación de Copenhague. Las objeciones originales de Einstein pueden superarse, pero aún surgen problemas cuando uno trata de formular la mecánica cuántica para todo el Universo (donde las medidas no se pueden repetir) y cuando se trata de reconciliar las leyes de la mecánica cuántica con las de la Gravitación… ¡Infinitos!

La mecánica cuántica y sus secretos han dado lugar a grandes controversias, y la cantidad de disparates que ha sugerido es tan grande que los físicos serios ni siquiera sabrían por donde empezar a refutarlos. Algunos dicen que “la vida sobre la Tierra comenzó con un salto cuántico”, que el “libre albedrío” y la “conciencia” se deben a la mecánica cuántica: incluso fenómenos paranormales han sido descritos como efectos mecano-cuánticos.

Yo sospecho que todo esto es un intento de atribuir fenómenos “ininteligibles” a causas también “ininteligibles” (como la mecánica cuántica) dónde el resultado de cualquier cálculo es siempre una probabilidad, nunca una certeza.

Claro que, ahí están esas teorías más avanzadas y modernas que vienen abriendo los nuevos caminos de la Física y que, a mi no me cabe la menor duda, más tarde o más temprano, podrá explicar con claridad esas zonas de oscuridad que ahora tienen algunas teorías y que Einstein señalaba con acierto.

¿No es curioso que, cuando se formula la moderna Teoría M, surjan, como por encanto, las ecuaciones de Einstein de la Relatividad General? ¿Por qué están ahí? ¿Quiere eso decir que la Teoría de Einstein y la Mecánica Cuántica podrán al fin unirse en pacifico matrimonio sin que aparezcan los dichosos infinitos?

Bueno, eso será el origen de otro trabajo que también, cualquier día de estos, dejaré aquí para todos ustedes. Esa Teoría que persiguen y llaman la Gravedad Cuántica.

Emilio Silvera Vázquez

May

8

Estructuras fundamentales del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Estructuras Fundamentales de la Naturaleza

Hemos llegado a poder discernir la relación directa que vincula el tamaño, la energía de unión y la edad de las estructuras fundamentales de la Naturaleza. Una molécula es mayor y más fácil de desmembrar que un átomo; lo mismo podemos decir de un átomo respecto al núcleo atómico, y de un núcleo con respecto a los quarks que contiene.

La cosmología sugiere que esta relación resulta del curso de la historia cósmica, que los quarks se unieron primero, en la energía extrema del big bang original, y que a medida que el Universo se expandió, los protones y neutrones compuestos de quarks se unieron para formar núcleos de átomos, los cuales, cargados positivamente, atrajeron a los electrones cargados con electricidad negativa estableciéndose así como átomos completos, que al unirse formaron moléculas y estas, a su vez, juntas en una inmensa proporción, forman los cuerpos que podemos ver a lo largo y lo ancho de todo el universo. Grandes estructuras y cúmulos y supercúmulos de galaxias que están hechos de la materia conocida como bariónica, es decir, de Quarks y Leptones (todo lo que existe está formado por estas dos partículas).

Si es así, cuanto más íntimamente examinemos la Naturaleza, tanto más lejos hacia atrás vamos en el tiempo. Alguna vez he puesto el ejemplo de mirar algo que nos es familiar, el dorso de la mano, por ejemplo, e imaginemos que podemos observarlo con cualquier aumento deseado.

Con un aumento relativamente pequeño, podemos ver las células de la piel, cada una con un aspecto tan grande y complejo como una ciudad, y con sus límites delineados por la pared celular. Si elevamos el aumento, veremos dentro de la célula una maraña de ribosomas serpenteando y mitocondrias ondulantes, lisosomas esféricos y centríolos, cuyos alrededores están llenos de complejos órganos dedicados a las funciones respiratorias, sanitarias y de producción de energía que mantienen a la célula.

Ya ahí tenemos pruebas de historia. Aunque esta célula particular solo tiene unos pocos años de antigüedad, su arquitectura se remonta a más de mil millones de años, a la época en que aparecieron en la Tierra las células eucariota o eucarióticas como la que hemos examinado.

Para determinar dónde obtuvo la célula el esquema que le indicó como formarse, pasemos al núcleo y contemplemos los delgados contornos de las macromoléculas de ADN segregadas dentro de sus genes. Cada una contiene una rica información genética acumulada en el curso de unos cuatro mil millones de años de evolución.

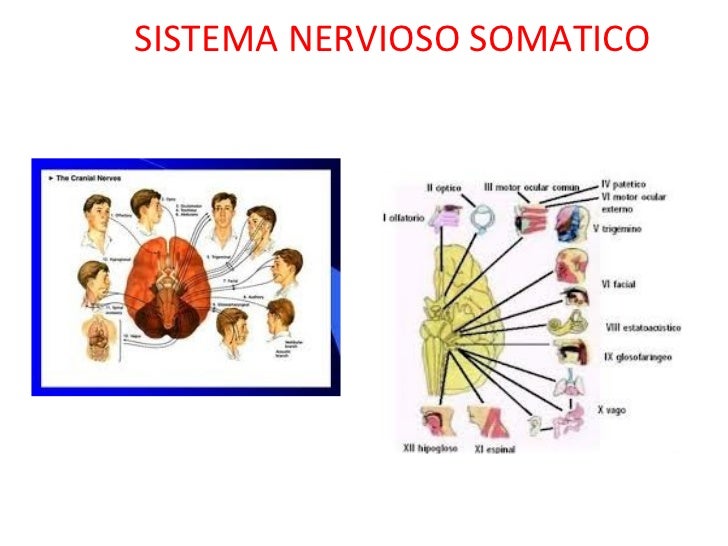

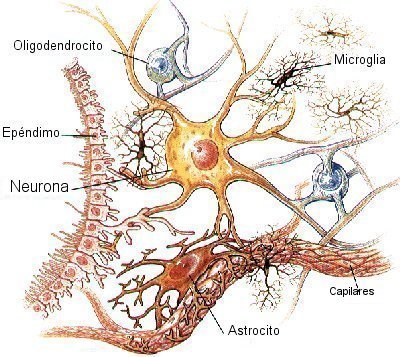

Sistema nervioso somático

Incluye grupos de neuronas que llevan información desde los órganos sensoriales (incluyendo toda la piel) hasta el sistema nervioso central (principalmente hasta el cordón espinal). A estos grupos de neuronas se les llama neuronas sensoriales o aferentes.

a. Las neuronas que recogen información directamente de los órganos sensoriales son neuronas especializadas con formas y sensibilidad particular. Por lo regular, estas neuronas tienen abundantes dendritas y axones cortos.

b. Por su parte, las neuronas que llevan información desde los órganos sensoriales hasta el sistema nervioso central suelen tener menos dendritas y axones largos. Grupos de estos axones forman lo que generalmente conocemos como nervios. Estos muestran un color blanco debido a la abundancia de capas de mielina, característico de los axones. A estos grupos de axones se les conoce como nervios sensoriales o aferentes.

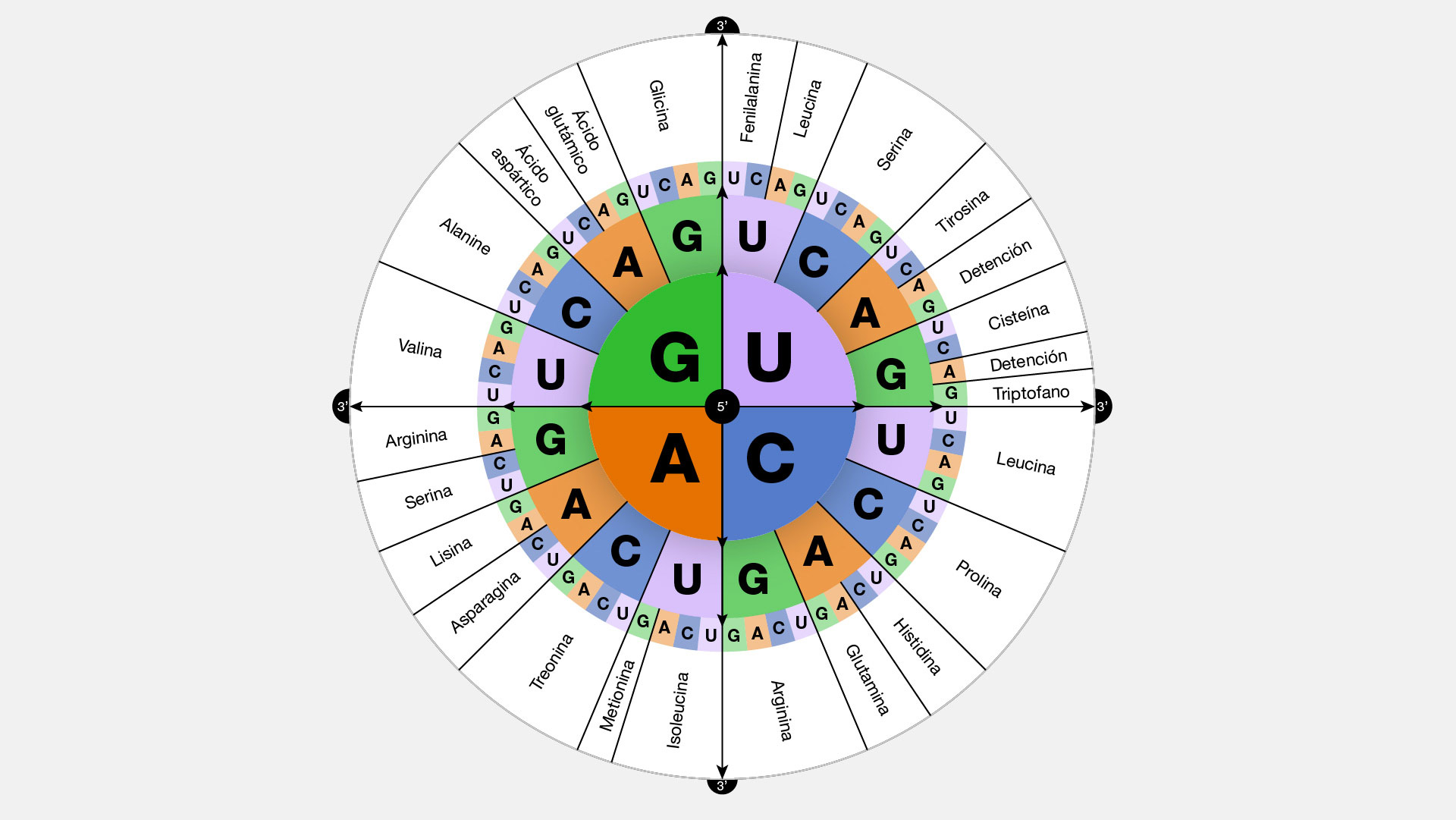

Almacenado en un alfabeto de nucleótidos de cuatro “letras”- hecho de moléculas de azúcar y fosfatos, y llenos de signos de puntuación, reiteraciones para precaver contra el error, y cosas superfluas acumuladas en los callejones sin salida de la historia evolutiva-, su mensaje dice exactamente cómo hacer un ser humano, desde la piel y los huesos hasta las células cerebrales.

Si elevamos más el aumento veremos que la molécula de ADN está compuesta de muchos átomos, con sus capas electrónicas externas entrelazadas y festoneadas en una milagrosa variedad de formas, desde relojes de arena hasta espirales ascendentes como largos muelles y elipses grandes como escudos y fibras delgadas como puros. Algunos de esos electrones son recién llegados, recientemente arrancados átomos vecinos; otros se incorporaron junto a sus núcleos atómicos hace más de cinco mil millones de años, en la nebulosa de la cual se formó la Tierra.

Si elevamos el aumento cien mil veces, el núcleo de un átomo de carbono se hinchará hasta llenar el campo de visión. Tales núcleos átomos se formaron dentro de una estrella que estalló mucho antes de que naciera el Sol. Si podemos aumentar aún más, veremos los tríos de quarks que constituyen protones y neutrones.

Los quarks han estado unidos desde que el Universo sólo tenía unos pocos segundos de edad

Al llegar a escalas cada vez menores, también hemos entrado en ámbitos de energías de unión cada vez mayores. Un átomo puede ser desposeído de su electrón aplicando sólo unos miles de electrón-voltios de energía. Sin embargo, para dispersar los nucleones que forman el núcleo atómico se requieren varios millones de electrón-voltios, y para liberar los quarks que constituyen cada nucleón se necesitaría cientos de veces más energía aún.

Introduciendo el eje de la historia, esta relación da testimonio del pasado de las partículas: las estructuras más pequeñas, más fundamentales están ligadas por niveles de energía mayores porque las estructuras mismas fueron forjadas en el calor del Big Bang.

Nos cuesta asimilar que la evolución de la materia se pudiera elevar (bajo un sin fin de parámetros y transmutaciones muy complejos), hasta alcanzar la consciencia y llegar a generar pensamientos. Parece como si el Universo hubiera sabido que nosotros (también otros seres similares e inteligentes en otros mundos del inmenso Cosmos), teníamos que venir y, para ello, creó sistemas idóneos para la vida como el planeta Tierra y muchos otros de su clase que ofrecen tal cobijo a criaturas vivas.

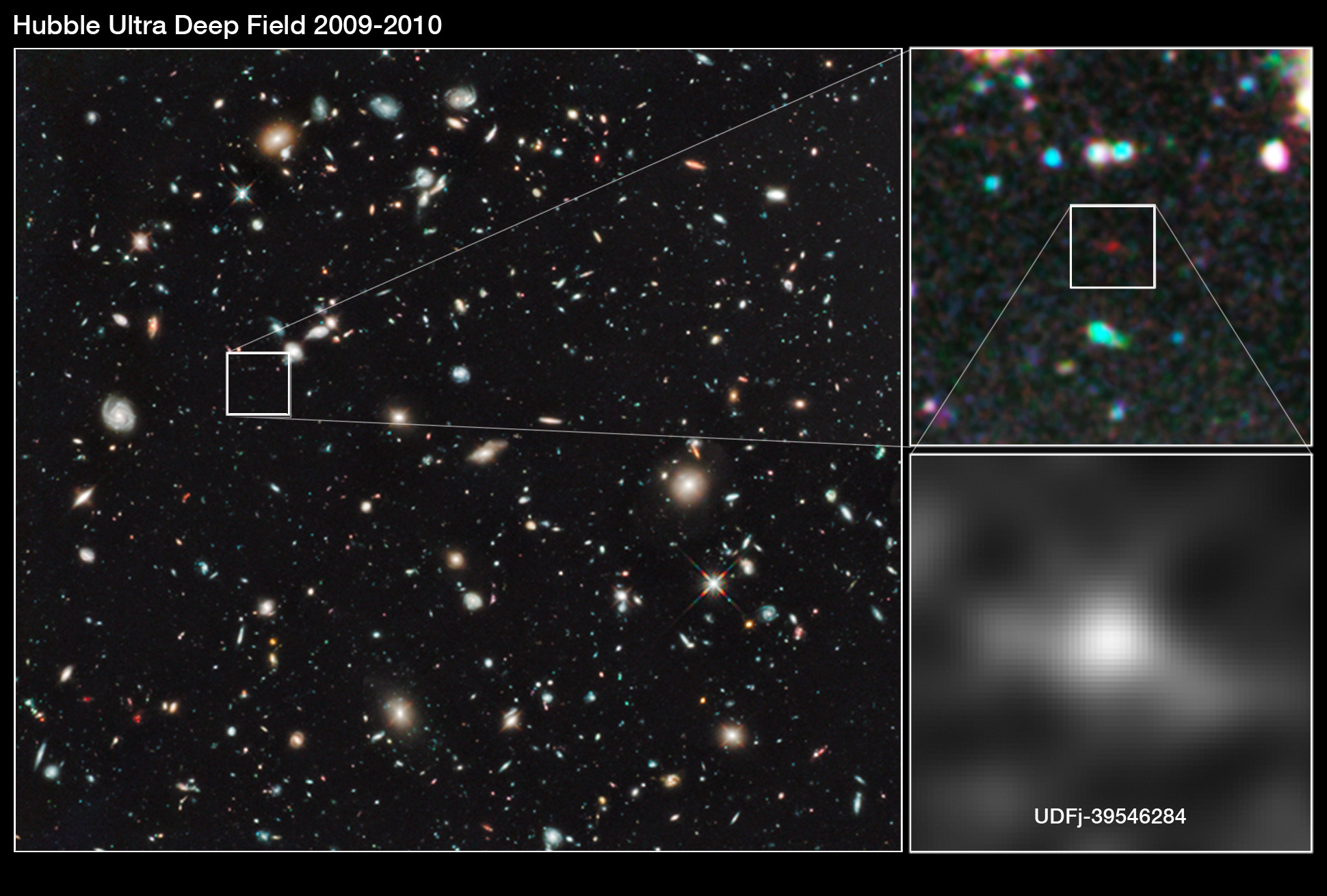

Los aceleradores de partículas, como los telescopios, funcionen como máquinas del tiempo. Un telescopio penetra en el pasado en virtud del tiempo que tarda la luz en desplazarse entre las estrellas; un acelerador recrea, aunque sea fugazmente, las condiciones que prevalecían en el Universo primitivo. En la imagen de arriba podemos ver como el Telescopio Espacial Hubble, poco a poco, ha podido ir avanzando hacia atrtás en el tiempo para enseñarnos las imágenes captadas cuando el Universo era muy joven. ¿Podremos algún día fabricar telescopios tan potentes que puedan captar imágenes del universo vecino?

Hemos llegado a dominar técnicas asombrosas que nos facilitan ver aquello que, prohibido para nuestro físico, sólo lo podemos alcanzar mediante sofisticados aparatos que bien nos introduce en el universo microscópico de los átomos, o, por el contrario nos llevan al Universo profundo y nos enseña galaxias situadas a cientos y miles de millones de años-luz de la Tierra.

Cuando vemos esos objetos cosmológicos lejanos, cuando estudiamos una galaxia situada a 100.000 mil años-luz de nosotros, sabemos que nuestros telescopios la pueden captar gracias a que, la luz de esa galaxia, viajando a 300.000 Km/s llegó a nosotros después de ese tiempo, y, muchas veces, no es extraño que el objeto que estamos viendo ya no exista o si existe, que su conformación sea diferente habiéndose transformado en diferentes transiciones de fase que la evolución en el tiempo ha producido.

Siempre hemos querido saber lo que hay más allá de lo que el ojo ve

En el ámbito de lo muy pequeño, vemos lo que está ahí en ese momento pero, como se explica más arriba, en realidad, también nos lleva al pasado, a los inicios de cómo todo aquello se formó y con qué componentes que, en definitiva, son los mismos de los que están formadas las galaxias, las estrellas y los planetas, una montaña y un árbol y, cualquiera de nosotros que, algo más evolucionado que todo lo demás, podemos contarlo aquí.

Estas y otras muchas maravillas son las que nos permitirán, en un futuro relativamente cercano, que podamos hacer realidad muchos sueños largamente dormidos en nuestras mentes.

Emilio Silvera Vázquez

Totales: 85.844.384

Totales: 85.844.384 Conectados: 35

Conectados: 35