May

15

El futuro de la física está en nuestra imaginación

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (3)

Comments (3)

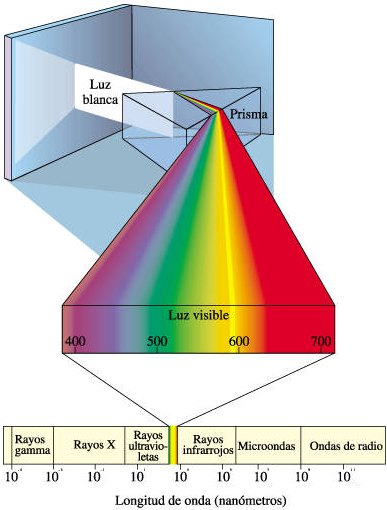

Diversidad de ideas

Me gusta escribir sin tener un objetivo predeterminado y repasar sobre cuestiones de la física. Escribo todo lo que estoy “viendo” -lo que sin llamarlo, acude a mi mente en cada instante-. Es un buen ejercicio de repaso de diversas cuestiones que recuerdas. Por ejemplo, ahora mismo me llega la idea de que desde la más remota antigüedad nos viene fascinando los fenómenos ópticos. De hecho, los estudios encaminados a desvelar la naturaleza de la luz han sido uno de los motores más fructíferos de la física. A ello se dedica la óptica, hoy día una de las áreas más activas de la física.

algunos pudieron asombrarse ante esta imágen de esplendorosa belleza natural, ¿qué produjo tal fenómeno? De nuevo, como es mi costumbre, me desvío del tema pero, me estaba regfiriendo al auge en el campo de la óptica…¿dónde radica el impulso de esa disciplina?

Buena prueba de ello es la rápida sucesión de Premios Nobel en ese campo en años recientes: 1.997, 2.001 y 2.005. En la luz se apreció por primera vez la naturaleza dual onda-partícula de los objetos cuánticos. El comportamiento ondulatorio de la luz sirvió de prueba experimental para la teoría electromagnética de Maxwell. La idea de la luz como un haz de fotones reapareció con Einstein en 1.905 para explicar el efecto fotoeléctrico (que le valió el Nobel de física). El dualismo onda-partícula de la luz, que De Broglie extendió a las partículas materiales, es contradictorio en el marco de la física clásica. Para reconciliar ambas imágenes hubo que desarrollar la física cuántica. No obstante, como señalaba Glauber en uno de sus artículos…

“la teoría cuántica ha tenido una influencia sobre la óptica que es sólo una fracción de la que históricamente ha tenido la óptica sobre la teoría cuántica”.

Premio Nobel de Física de 2.005. Roy J. Glauber, de la Universidad de Harvard, Theodor W. Hänsch, del Instituto Max Plack y John L. Hall, de la Universidad de Colorado, comparten el premio Nobel de Física 2005. Glauber lo recibe por su contribución a la teoría cuántica de la coherencia óptica, mientras que Hänsch y Hall por sus contribuciones a la espectroscopía de precisión basada en láser, incluyendo la técnica de barrido de frecuencia óptica.

Motivado por los experimentos de Hanbury-Brown y Twiss en 1.954-56, y por la invención del láser en 1.960, Glauber realizó una aplicación de la electrodinámica cuántica a problemas ópticos. Mientras que los experimentos previos habían usado interferencia de amplitudes y registraban intensidades con un solo detector, Hanbury-Brown y Twiss estudiaron correlaciones en las intensidades recibidas de una estrella por dos detectores separados, observando que los fotones térmicos parecen emitirse agrupados (bunched). ¿También los de un haz de láser? Esta y otras cuestiones llevaron a Glauber a desarrollar la teoría cuántica de la coherencia, basada en los estados coherentes y en la teoría cuántica de la fotodetección. Estudiando coincidencias retardadas en la detección de fotones por varios detectores, Glauber introdujo una sucesión de funciones de correlación que mostraban las características cuánticas de la radiación y permitían diferenciar entre haces de luz con la misma distribución espectral, pero diferente estadística de fotones.

En el universo temprano los fotones se convertían continuamente en pares

Particularmente relevantes han sido los estudios posteriores de “luz no clásica”, tales como resonancia-fluorescencia de un solo átomo, que muestra el llamado antibunching, luz cuyo ruido cuántico depende de la fase; y pares de fotones entrelazados.

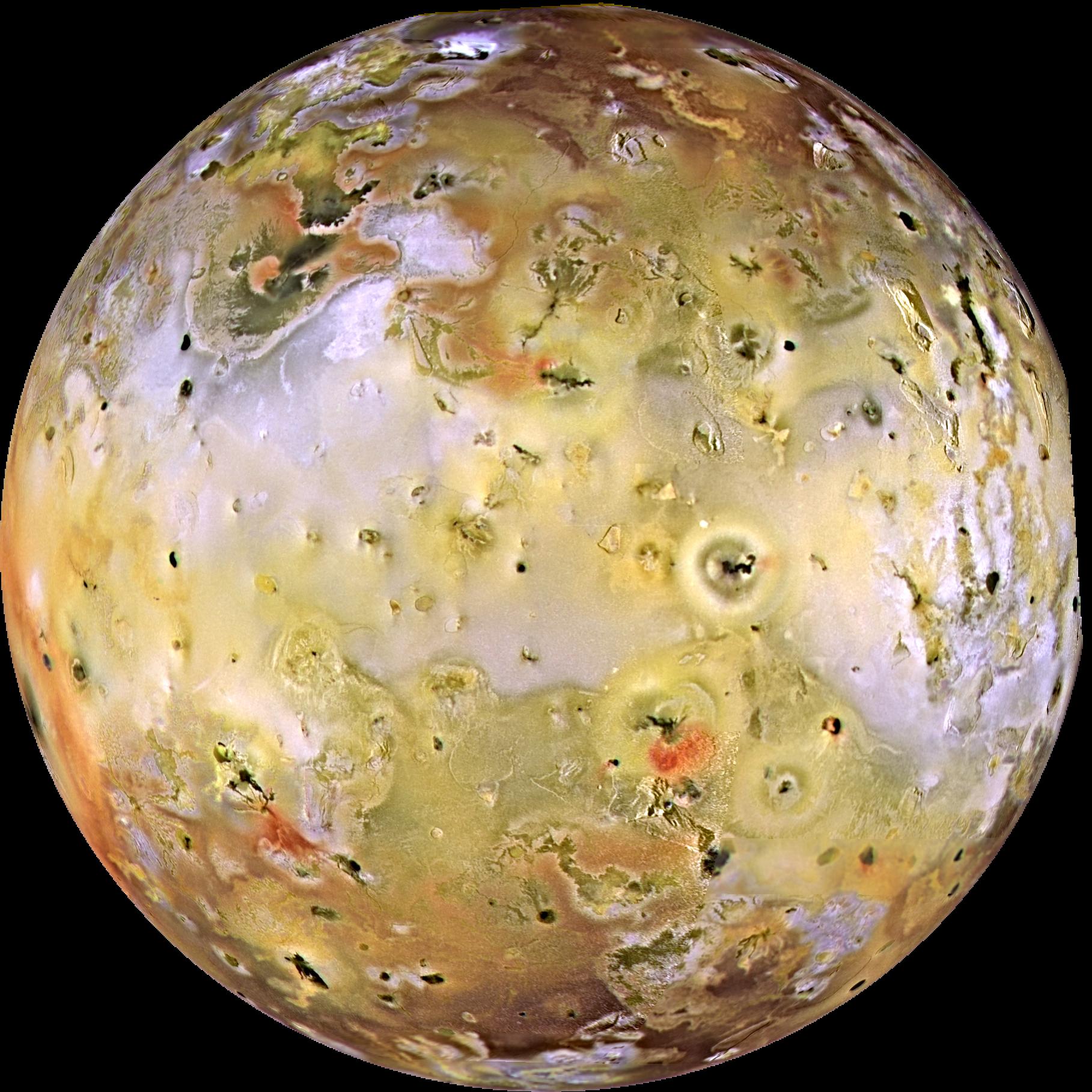

El estado más común de la materia en el universo, no es ni líquido, ni sólido, ni gaseoso, sino que es el plasma; el estado de la materia que conforman las estrellas. Sin embargo, particularmente apuesto por una idea que no se va de mi cabeza, el estado último de la materia es la luz.

La otra mitad del Premio Nobel se otorgó a partes iguales a John L. Hall, de la Universidad de Colorado, JILA y NIST, Boulder y a Theodor W. Hänsch, del Max Planck Instit für Quantenoptik, Garching, y de la Ludwig-Maximilians-Universität, Munich, “por sus contribuciones al desarrollo de métodos de espectroscopia láser de precisión, incluyendo la técnica de peines de frecuencias ópticas“.

espectroscopia de absorción atómica

A lo largo de toda la historia la ingeniería se ha convertido en unas de las fuentes de solución a todos los problemas de la humanidad, de la mano de las ciencias y la tecnología, la cual ha aportado tantos métodos de mayor exactitud como lo es el utilizado por la espectrofotometría de absorción atómica; ya que es una técnica capaz de detectar y determinar cuantitativamente la mayoría de los elementos del sistema periódico.

En espectroscopia se analiza la composición en frecuencias de la luz absorbida o emitida por la materia, lo cual proporciona información valiosa, por ejemplo, sobre la estructura cuántica de los átomos.

Los galardonados lideraron un proyecto espectacular en el desarrollo de métodos para producir y medir estas frecuencias ópticas, con una precisión actual de 15 cifras significativas y potencial de 18. De hecho, este tipo de medidas son de las de mayor precisión alcanzadas en física y permiten abordar cuestiones de gran interés básico, como la observación de la variación temporal de “constantes” fundamentales, como la estructura fina (α = 1/137, ó 2πe2/hc). Tienen también repercusión en el desarrollo de relojes atómicos ultraprecisos (con desajuste menor a una décima de segundo cada 100 años), útiles por ejemplo en sistemas GPS.

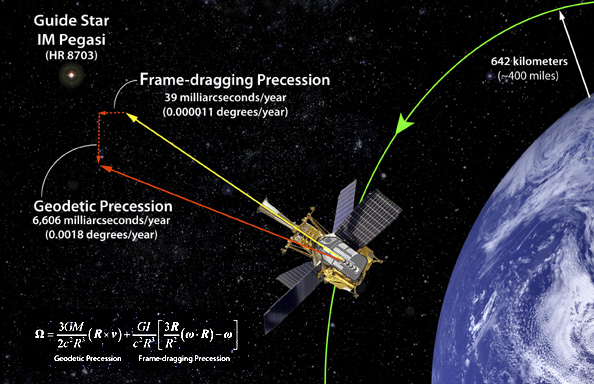

No dejamos de enviar ingenios al espacio para tratar de medir la Densidad Crítica y poder saber en qué clase de universo nos encontramos: Plano, cerrado o abierto. Pero, también mandamos satélirtes artificiales que, desde el cielo, dominan y controlan aspectos de la Tierra que nos son muy útiles en navegación, circulación víal, y otros muchos conceptos que, tanto en la vida cotidiana como en la investigación, nos sitúan en el más alto nivel de la tecnología…del futuro.

En espectroscopia óptica de precisión han de determinarse frecuencias de varios cientos de THz en términos de la definición del patrón de tiempo representado por desdoblamiento hiperfino del estado fundamental del cesio a 9’2 GHz. Hasta el año 2.000, esta tarea requería esfuerzos heroicos porque los detectores sólo permiten comparar directamente frecuencias separadas por algunas decenas de GHz. Se usaban por tanto complejas cadenas de generación de sucesivos armónicos de la frecuencia del cesio.

Esas cadenas eran costosas, delicadas, y de hecho, sólo algunos laboratorios las desarrollaron. El problema se ha simplificado enormemente con la introducción por Hall y Hänsch del llamado peine de frecuencias ópticas, formado por del orden de un millón de frecuencias equiespaciadas unos 100 MHz y cubriendo varios cientos de THz. De estas frecuencias pueden realizarse una medida absoluta con el patrón de cesio. Por tanto el peine sirve como una “regla” para determinar cualquier frecuencia óptica desconocida. Estos peines o sintetizadores de frecuencias, que ya se comercializan, usan láseres de femtosegundos y un nuevo tipo de fibra óptica microestructurada o de cristal fotónico…

¿Dónde estará el límite?

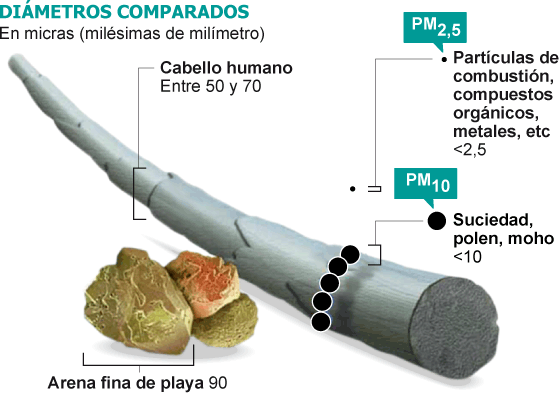

Han pasado ya unos cincuenta años desde que Richard Feynman dictara su famosa plática There is plenty of room at the bottom: An invitation to enter a new field of physics (Hay suficiente espacio en el fondo: Una invitación a entrar en un nuevo campo en la Física). En ella estableció que las leyes de la Física no impiden manipular las cosas átomo a átomo; –es algo que se puede hacer pero no se ha hecho debido a que somos demasiado grandes para hacerlo-. Desde entonces se ha estado buscando la manera de poder diseñar los materiales átomo a átomo. De hecho, los materiales nanoestructurados ya han sido utilizados en aplicaciones prácticas, siendo importantes en nuestra vida diaria. El color rojo de los vitrales en las catedrales góticas de Europa se obtenía utilizando nanopartículas de oro; la película fotográfica utiliza nanopartículas de plata; los bloqueadores solares utilizan nanopartículas de dióxido de titanio y de zinc como parte activa. El primer caso es una aplicación del efecto nano del oro y es quizás la primera aplicación de la nanotecnología. Quizás el mayor desarrollo de las nanoestructuras se dio con el descubrimiento de la microscopia de fuerza atómica ya que con esta se podía manipular a los átomos o partículas muy pequeñas. Hoy día, la investigación en el campo de los materiales nanoestructurados se ha multiplicado y sus aplicaciones abarcan todas las disciplinas convirtiendo a la nanotecnología en un campo interdisciplinario. Muchos países han implementado programas especiales para la investigación en este campo invirtiendo grandes cantidades de dinero. La apuesta puede ser de alto riesgo, pero el premio promete ser enorme.

Materiales nanoestructurados y nanotecnología

Los materiales nanoestructurados (NEMs, por siglas en inglés) han despertado rápidamente un gran interés debido a la diversidad de sus aplicaciones. De acuerdo a la definición más aceptada, los materiales nanoestructurados son aquellos en los que por lo menos una de sus dimensiones se encuentra en el rango de 1-100 nm. Es decir, los NEMs son tres órdenes de magnitud más pequeños que los MEMS (sistemas microelectromecánicos, por sus siglas en inglés), e incluyen nanopartículas, nanocristales, nanoalambres, nanobarras, nanotubos, nanofibras, nanoespumas, etc. Los NEMs pueden ser semiconductores, dieléctricos, metales, orgánicos, inorgánicos, aleaciones, biomateriales, biomoléculas, oligómeros, polímeros, etc.

Nos sorprendería saber en qué lugares están presentes los cristales fotónicos con las nuevas técnicas alcanzadas en la nanotecnología

Aunque también existen sistemas nanoestructurados de dimensiones mayores como son los cristales fotónicos. En el rango de nanómetros, los materiales presentan propiedades ópticas, eléctricas, magnéticas y mecánicas únicas y totalmente diferentes de los materiales en el rango de los micrómetros o milímetros llamados también materiales en bulto.

Para tener una idea de que tan pequeño es un nanómetro podemos mencionar que un milímetro tiene un millón de nanómetros; el diámetro del cabello humano mide entre 10,000 y 50,000 nanómetros; los glóbulos rojos y blancos miden entre 2 y 5 nanómetros mientras que el ADN mide 2.5 nanómetros.

Las propiedades de los NEMs son dominadas por los efectos de superficie mientras que las de los materiales en bulto son debidas a un efecto de volumen. La tecnología para su producción y uso se ha convirtiendo en una industria muy poderosa: la nanotecnología. La nanotecnología es la ciencia e ingeniería de producir materiales o estructuras funcionales de unos cuantos nanómetros. Es la tecnología del futuro con la cual se desarrollarán los nuevos materiales y dispositivos. Las aplicaciones son sorprendentes así como variadas, por ejemplo, la industria optoelectrónica y fotónica, biomedicina, sensores, celdas solares y de combustible, catálisis, memorias ópticas, procesadores de computadoras, fotodetectores, herramientas de corte, industria automotriz y aeronáutica, moduladores e interruptores, cosméticos, etc. Aunque todas las aplicaciones son de gran interés, sin duda alguna las aplicaciones en sistemas biológicos son las más sobresalientes. Especialmente las aplicaciones de las propiedades ópticas de los sistemas nanoestructurados.

No tarderemos mucho en asombrarnos de los logros alcanzados por la Nanofotónica en diversos apartados de la tecnología del futuro

Uno de sus aprtados es, la Nanofotónica

La nanofotónica es la fusión de la nanotecnología y la fotónica. Es un campo multidisciplinario que estudia las propiedades ópticas de los sistemas nanoestructurados y la interacción luzmateria a nivel nanoscópico. Ya mencionamos que las propiedades ópticas de las nanopartículas son dominadas por los efectos de superficie. Así, controlando el tamaño de las nanopartículas o nanoestructuras podemos controlar o amplificar ciertas propiedades de los sistemas bajo estudio. En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas.

Cada una de ellas produce fenómenos de especial interés cuando interactúan con una señal óptica, pudiendo así ser aplicadas en diferentes campos. Un campo de especial interés es la biología.

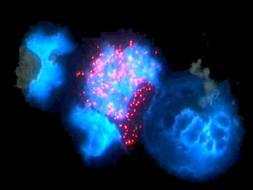

El estudio de las propiedades luminiscentes de sistemas nanoestructurados en sistemas biológicos es el campo de estudio de la bionanofotónica. Especialmente trata sobre el estudio de sistemas nanoestructurados en aplicaciones biomédicas. Diferentes nanopartículas han sido propuestas para ser utilizadas en la detección de bajas concentraciones de diferentes elementos como células cancerigenas, virus, ADN, ARN, proteínas, etc. También han sido utilizadas para la entrega de medicamentos en forma dirigida y controlada así como para la destrucción de tumores cancerigenos. En la última década, los avances han sido sorprendentes pero aún hay mucho por hacer. En el CIO, durante los últimos 6 años han estado trabajando en la síntesis de nanopartículas y estudiado sus propiedades ópticas a fin de poder ser utilizadas en distintas aplicaciones. Las propiedades luminescentes de nuestras nanopartículas son muy interesantes y prometen grandes oportunidades de aplicación en diferentes áreas.

Nanopartículas semiconductoras o puntos cuánticos

Los nanocristales semiconductores también llamados puntos cuánticos son nanoestructuras a base de materiales semiconductores inorgánicos y representan el grupo donde el efecto del tamaño es más evidente. El tamaño nano da lugar a lo que se conoce como confinamiento cuántico, que no es más que la localización de los electrones en un espacio bien definido, es como poner un electrón en una caja. Mientras que para tamaños mayores los electrones están no localizados. El confinamiento produce un ensanchamiento de la banda de energía prohibida del semiconductor así como la aparición de sub-bandas discretas en la banda de valencia y de conducción. Las dimensiones típicas oscilan entre uno y diez nanómetros.

Con frecuencia se les describe como átomos artificiales debido a que los electrones están dimensionalmente confinados como en un átomo y sólo se tiene niveles de energía discretos. Entre las nanoestructuras más estudiadas se encuentran las de CdSe/ZnS, CdSe/CdS, InP/ZnSe, CdTe/CdSe, entre otras. El resultado más vistoso de estas nanoestructuras es la capacidad para poder sintonizar la longitud de onda o color de la emisión.

Así, con un solo material y variando el tamaño de la nanopartícula es posible obtener múltiples colores o longitudes de onda de la señal emitida. Las aplicaciones son impresionantes y apuntan en todas las direcciones. Por ejemplo, podrían ser utilizados como colorantes inorgánicos sin problemas de degradación a diferencia de los colorantes orgánicos. También podrían ser utilizados en el diseño de los nuevos amplificadores ópticos de amplio ancho de banda tan importantes en los sistemas de comunicación óptica; en este caso cada nanopartícula con un diámetro determinado funcionaría como un amplificador, así el ancho de banda se determina con la selección adecuada de los diámetros de las partículas. O bien para la producción de fuentes de luz blanca mediante excitación con un LED u OLED o por electroluminiscencia.

Quizás una de las aplicaciones que mayor atención ha recibido es en su uso como etiquetas fluorescentes con emisión en la región visible del espectro, para la detección de una gran variedad de compuestos entre ellas células cancerigenas. Las técnicas actuales no detectan bajas concentraciones de células cancerigenas o compuestos de interés, por lo que la técnica de detección de fluorescencia de nanopartículas es una gran promesa para la detección temprana de este mal, para así incrementar el éxito en el tratamiento. Dado el tamaño tan pequeño de los puntos cuánticos actualmente se intenta desarrollar nanoestructuras más complejas formadas por puntos cuánticos o nanocristales acomplejados con diferentes componentes que desempeñan distintas funciones, detección, entrega de medicamento dirigido, efecto de la terapia, etc. Es decir, se busca una nanoestructura inteligente con múltiples funciones. El problema que presentan los puntos cuánticos es que son poco estables ya que tienden a aglomerarse, además de que se excitan con una fuente de luz UV donde la mayoría de los compuestos que se pueden encontrar en interior del cuerpo humano emiten luz lo que significa pérdida de contraste en la imagen de la célula deseada.

Nanopartículas dieléctricas o nanocristales

Los nanocristales dieléctricos son óxidos que presentan una banda de energía prohibida muy ancha y como consecuencia requieren altas energías de bombeo o luz en el UV para obtener emisión que en general es débil, aunque cuando se combina en forma adecuadacon diversos componentes son excelentes emisores de luz debido a su eficiencia y alta estabilidad. Son excelentes matrices para soportar iones de tierras raras que son muy buenos emisores de luz. En este caso no se observan efectos de confinamiento debido a que los electrones se encuentran localizados en orbitales atómicos del ion activo. Sin embargo, la dinámica de los iones emisores de luz se ve afectada por la interacción a nivel nanoscópico lo que puede producir una mejora en la eficiencia de emisión. Entre los nanocristales mas estudiados se encuentran algunos silicatos como Y2SiO5, la combinación nY2O3 + mAl2O3 que comprende puramente el óxido de itria, puramente el óxido de aluminio, cuando se combinan con n=3 y m=5 da lugar a la estructura cristalina mas utilizada en óptica para producir láseres conocida como YAG, o YAP para la combinación n=m=1 que corresponde a uno de los cristales mas sensibles a laradiación ionizante y que es utilizado para la detección de rayos X o rayos gama. El óxido de titanio (TiO2) y el óxido de zinc (ZnO) que se utilizan en los bloqueadores solares además de ser excelentes para los procesos de fotocatálisis, útiles en la reducción de contaminantes, para celdas solares y como bactericida.

Recientemente, hemos demostrado que el óxido de zirconio (ZrO2) combinado con otros elementos bloquea el rango completo de la luz ultravioleta, especialmente aquella región que produce el cáncer de piel. Este mismo nanocristal presenta excelente respuesta en la detección de radiación ionizante, UV, rayos X, gama, beta y alfa, tanto en tiempo real como en forma acumulada lo que sugiere buenas oportunidades para su uso en el diseño de dosímetros para la cuantificación de dosis recibidas.

Además, es excelente soporte para iones de tierras raras, con las cuales hemos obtenido luz visible (azul, verde y rojo) excitando con una fuente en el cercano infrarrojo. Ya que con esta fuente solo se excitan los nanocristales no hay emisión de fondo lo que mejora el contraste de las imágenes obtenidas. Estas características convierten a estos nanocristales en excelentes candidatos en aplicaciones biomédicas para la detección de diversos elementos a concentraciones bajas. La fabricación de estos nanocristales implica un tratamiento térmico para el proceso de oxidación lo que induce un tamaño de partícula grande. Se han reportado tamaños de partícula desde 10 a 90 nm.

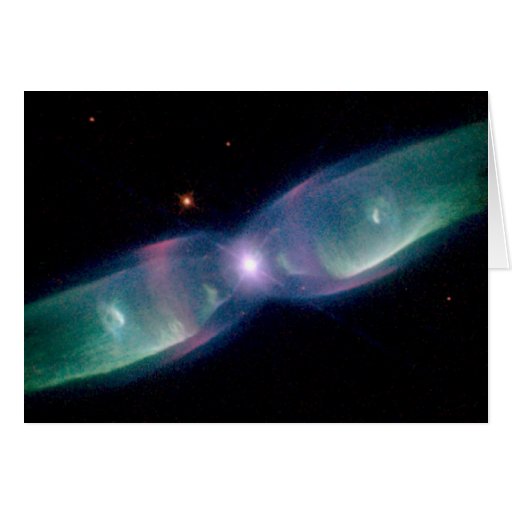

Estructura de alas de mariposa son fabricadas con la nanofotónica de cristales, y, en realidad, sólo nos limitamos a copia la Naturaleza

Muchas veces se obtienen cristales muy pequeños pero con poca eficiencia de emisión, el reto es obtener mayor eficiencia de emisión sin incrementar demasiado el diámetro de las nanopartículas. Tamaños promedios con los que se han obtenido excelente eficiencia de emisión son entre 40 y 60 nm.

Nano partículas metálicas, plasmones.

Las nanopartículas metálicas tienen la habilidad de esparcir y absorber la luz incidente. En este caso, los efectos en las propiedades ópticas respecto a su contraparte en bulto se derivan de los efectos electrodinámicos y de la modificación del ambiente dieléctrico. A escala nanométrica la frontera metaldieléctrico produce cambios considerables en las propiedades ópticas.

Como resultado de la interacción entre la nanopartícula metálica y la señal óptica se obtiene la oscilación colectiva de electrones de superficie lo que genera bandas de resonancia conocidas como plasmones localizados o plasmones de superficie localizados. La longitud de onda o color a la que se obtiene dicha resonancia se le conoce como banda de absorción del plasmón que depende tanto del tamaño como de la forma de la nanopartícula y es lo que da lugar a la diferente coloración observada. Las nanoestructuras metálicas más conocidas son partículas esféricas, barras y películas con núcleo dieléctrico. Aunque más recientemente se han reportado otras estructuras como cubos, triángulos, estrellas y ovoides. En todos los casos, la banda de resonancia se recorre hacia el cercano infrarrojo en comparación con las nanopartículas esféricas cuya banda esta centrada en la región verde del espectro.

Los plasmones producen en la interfase un campo eléctrico intensificado que a su vez intensifica varios procesos ópticos lineales y no lineales. El campo eléctrico producido es utilizado como una interfase sensible a las interacciones ópticas y se convierte en una poderosa herramienta para el monitoreo óptico y para la formación de imágenes ópticas

localizadas. Una de las aplicaciones bien establecidas es la espectroscopia Raman de superficie mejorada (SERS por sus siglas en inglés). En este caso el espectro Raman de un componente cercano a la superficie metálica se ve fuertemente amplificado. Se ha demostrado que es posible amplificar el campo hasta 11 000 veces más cuando las partículas presentan cierta aglomeración. Otros fenómenos que presentan amplificación son la espectroscopia infrarroja de superficie mejorada, espectroscopia de fluorescencia

y la espectroscopia de resonancia de plasmones de superficie. Todas estas técnicas son complementarias y son utilizadas en la detección de componentes químicos y bioquímicos a nivel de trazas.

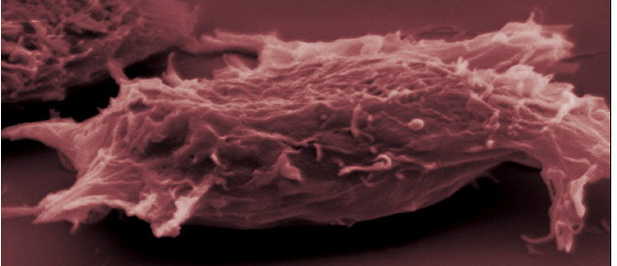

Célula cancerígena

Células modificadas y célula cancerigena que,la nanofotónica podrá modificar e incluso regenerar en el fiuturo

Quizás un proyecto más ambicioso es el de poder detectar células cancerigenas a temprana edad de lo cual ya se han reportado importantes avances. En el CIO trabajamos con nanopartículas de oro y plata a fin de desarrollar sensores ópticos para la detección de diferentes compuestos a nivel de trazas y estamos aplicado exitosamente nanopartículas deoro en la detección de células cancerigenas.

En resumen, las nanoestructuras presentan propiedades ópticas únicas que no presentan su contraparte en bulto o de escala mayor. Éstas están siendo utilizadas para el desarrollo de la nueva generación de dispositivos optoelectrónicos y/o fotónicos. Las aplicaciones son muy variadas y abarcan muchos campos haciendo de la nanociencia y nanotecnología una área

multidisciplinaria. Especial atención recibe el uso de dichas propiedades en aplicaciones biomédicas para la detección a nivel de trazas de diversos agentes patógenos. El estudio de las propiedades ópticas de las nanoestructuras ha definido una nueva área conocida como nanofotónica.

¡El futuro está aquí!

emilio silvera

May

12

Fluctuaciones de vacío, D-Branas, Dimensiones extra: ¿Será nuestro...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (3)

Comments (3)

Fluctuaciones del vacío no pueden ser frenadas eliminando su energía pero ¿Cómo?

¡Las fluctuaciones de vacío! que, al igual que las ondas “reales” de energía positiva, están sujetas a las leyes de la dualidad onda/partícula; es decir, tienen tanto aspectos de onda como aspectos de partícula. Las ondas fluctúan de forma aleatoria e impredecible, con energía positiva momentáneamente aquí, energía negativa momentáneamente allí, y energía cero en promedio. El aspecto de partícula está incorporado en el concepto de partículas virtuales, es decir, partículas que pueden nacer en pares (dos partículas a un tiempo), viviendo momentáneamente de la energía fluctuacional tomada prestada de regiones “vecinas del espacio”, y que luego se aniquilan y desaparecen, devolviendo la energía a esas regiones vecinas. Si hablamos de fluctuaciones electromagnéticas del vacío las partículas virtuales son fotones virtuales; en el caso de fluctuaciones de la Gravedad en el vacío, son gravitones virtuales.

Claro que, en realidad, sabemos poco de esas “regiones vecinas” de las que tales fluctuaciones toman la energía pero, insistimos en querer verlas para saber y no dejamos de preguntarnos… ¿Qué es lo que hay allí? ¿Está en esa región la tan buscada partícula de Higgs? En realidad sabemos que las fluctuaciones de vacío son, para las ondas electromagnéticas y gravitatorias, lo que “los movimientos de degeneración claustrofóbicos” son para los electrones.

Si confinamos un electrón a una pequeña región del espacio, entonces, por mucho que un trate de frenarlo y detenerlo, el electrón está obligado por las leyes de la mecánica cuántica a continuar moviéndose aleatoriamente, de forma impredecible. Este movimiento de degeneración claustrofóbico que produce la presión mediante la que una estrella enana blanca se mantiene contra su propia compresión gravitatoria o, en el mismo caso, la degeneración de los neutrones, mantiene estable a la estrella de neutrones que, obligada por la fuerza que se genera de la degeneración de los neutrones, es posible frenar la enorme fuerza de gravedad que está comprimiendo a la estrella.

De la misma forma, si tratamos de eliminar todas las oscilaciones electromagnéticas o gravitatorias de alguna región del espacio, nunca tendremos éxito. Las leyes de la mecánica cuántica insisten en que siempre quedarán algunas oscilaciones aleatorias impredecibles, es decir, algunas ondas electromagnéticas y gravitatorias aleatorias e impredecibles. Estas fluctuaciones del vacío no pueden ser frenadas eliminando su energía (aunque algunos estiman que, en promedio, no contienen energía en absoluto).

Ver ambos lados del nivel de Fermi es importante porque, cuando convertimos un material en superconductor, es una energía que rodea al vacío. Con una perfecta simétrica (espaciados por igual encima y por debajo del nivel de Fermi) es una fuerte indicación de que los electrones están vinculados hacia arriba. El vacío superconductor existe en y por debajo de la temperatura de transición, siempre y cuando un material actúe como un superconductor.

Claro que, como antes decía, aún nadie ha podido medir de ninguna manera la cantidad real de energía que se escapa de ese supuesto “vacío”, como tampoco se ha medido la cantidad de fuerza gravitatoria que puede salir de ese mismo espacio “vacío”. Si la energía es masa y si la masa produce gravedad, entonces ¿Qué es lo que hay en ese mal llamado “espacio vacío”?

No puedo contestar de momento esa pregunta, sin embargo, parece que no sería un disparate pensar en la existencia allí, de alguna clase de materia que, desde luego, al igual que la bariónica que sí podemos ve, genera energía y ondas gravitacionales que, de alguna manera que aún se nos oculta, escapa a nuestra vista y solo podemos constatar sus efectos al medir las velocidades a que se alejan las galaxias unas de otras: velocidad de expansión del Universo que no se corresponde en absoluto, con la masa y la energía que podemos ver. ¿Tendrá algo que ver la energía de vacío con todo eso?

“Así, como entramos en una nueva era para comprender el tiempo, también hemos entrado a una nueva era de comprender el espacio. Se ha descubierto que lo que llamamos espacio vacío, el vacío, en realidad está repleto de inmensa energía potencial. La conclusión ordinaria de considerar el espacio como la nada, el lugar donde se sitúa la materia, evidentemente se ha convertido en nuestro espacio. Pero el vacío tiene más energía que la materia que está en ese vacío y de hecho, la materia y el vacío son una misma cosa, hay una continuidad. Se ha descubierto que hay más energía en un centímetro cúbico de vacío que en todo el Universo manifiesto.”

Lo cierto es que estamos en un momento crucial de la Física, las matemáticas y la cosmología, y debemos, para poder continuar avanzando, tomar conceptos nuevos que, a partir de los que ahora manejamos, nos permitan traspasar los muros que nos están cerrando el paso para llegar a las supercuerdas, a la posible “materia oscura” o a una “teoría cuántica de la gravedad” que, también está implícita en la teoría M.

Estamos anclados, necesitamos nuevas y audaces ideas que puedan romper las cadenas “virtuales” que atan nuestras mentes a ideas del pasado que, como la relatividad y la mecánica cuántica llevan cien años predominando sobre la física. ¿No es tiempo ya de andar otros caminos que nos lleven más lejos, que nos enseñen otros horizontes?

En su momento, esas ideas eran perfectas y cumplieron su misión (y siguen cumpliendo). Sin embargo, ahora no nos dejan continuar y debemos preparar nuestras mentes para evolucionar hacia nuevos conceptos y ahondar en aquellos que, aún estando ahí presentes, no somos capaces de utilizar, como por ejemplo, el Hiperespacio de tan enorme importancia en el futuro de la Humanidad. ¿Será cuándo sepamos “ver” dimensiones más altas que todo nos resultará mucho más sencillo y encontraremos las respuestas a los problemas que hoy, no sabemos resolver?

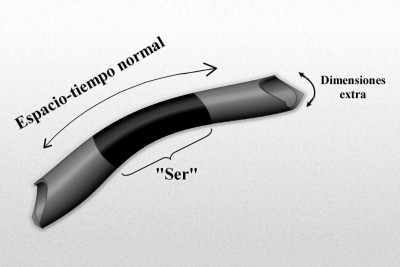

El gráfico representa un modelo de manguera de un espacio-tiempo de dimensiones más altas de tipo Kaluza-Klein, donde la longitud, o mejor, la dimensión a lo largo de la longitud de la manguera representa el 4-espacio-tiempo normal, y la dimensión alrededor de la manguera representa la dimensión extra “pequeñas” (quizá escala de Planck). Imaginemos un “ser” que habite en este mundo, que rebasa estas dimensiones extra “pequeñas”, y por ello no es realmente consciente de ellas.

Es posible que, de la misma manera, también nosotros estémos imposibilitados para ver esas dimensiones extra que, sin embargo, nos permita ver más allá de las matemáticas topológicas, más allá de las fluctuaciones de vacío, más allá de los quarks, más allá de las singularidades y… ¿Por qué no decirlo? ¡Más allá de nuestro propio Universo! No podemos olvidarnos de que dentro de varios eones, nuestro Universo podría morir. Estamos obligados a buscar la manera (si existe), de escapar de ese destino fatal.

Si el Universo, finalmente, se convierte en una singularidad que es una región donde (según las leyes de la relatividad general) la curvatura del espacio-tiempo se hace infinitamente grande, y el espacio-tiempo deja de existir, toda vez que, la singularidad es también una región de gravedad de marea infinita, es decir, una región donde la gravedad ejerce un tirón infinito sobre todos los objetos a lo largo de algunas direcciones y una compresión infinita a lo largo de otras.

Después de crear un horizonte de agujero negro a su alrededor, dicen las ecuaciones que describen este fenómeno, la materia toda que compone nuestro Universo, continuará implosionando, inexorablemente, hasta alcanzar densidad infinita y volumen cero, creándose así la singularidad que estará fundida con el espacio-tiempo.

Si eso ocurre (cosa poco probable), seguramente, de esa “nada” que se ha formado, más pronto o más tarde surgirá, mediante una enorme explosión, un nuevo Universo que, no sabemos si será igual, con las mismas fuerzas y las mismas leyes que el que ahora tenemos. Por otra parte, en el mismo inmenso tiempo, el Universo en lugar de contraerse sobre sí mismo, al no contener la materia suficiente, se expandirá para siempre y, llegará a la muerte térmica del cero absoluto (-273 ºC) Así que, si todo esto resulta ser así ¿No sería una irresponsabilidad, el no hacer nada? ¡Claro que sí!

Tenemos que continuar, cada uno en la medida de sus posibilidades, procurando avanzar hacía un futuro de profundos conocimientos que nos permitan, algún día lejano escapar de ese escenario de destrucción. Precisamente por eso, se buscan nuevas teorías y se piensa en otros universos y, nos hacemos preguntas sobre branas y dimensiones extra.

Sí, siempre estamos tratando de llegar a sitios… ¿Imposibles?, o, simplemente se trata de que nuestra intuición “sabe” que están ahí y trata de alcanzarlo

¿Qué son las D-Branas? ¿Por qué las requiere la teoría de cuerdas? La respuesta básica a la segunda pregunta es que dan sentido a las cuerdas abiertas que intervienen en la teoría tipo I: cada uno de los dos extremos de una cuerda abierta debe residir en una D-brana.

La mayoría de las versiones de la teoría de cuerdas implican dos tipos de cuerda: cuerdas abiertas con puntos finales desligados y cuerdas cerradas que forman lazos cerrados. Explorando las consecuencias de la acción Nambu-Goto, queda claro que la energía puede fluir a lo largo de una cuerda, deslizándose hasta el punto final y desapareciendo. Esto plantea un problema: la conservación de la energía establece que la energía no debe desaparecer del sistema. Por lo tanto, una teoría consistente de cuerdas debe incluir lugares en los cuales la energía pueda fluir cuando deja una cuerda; estos objetos se llaman D-branas. Cualquier versión de la teoría de cuerdas que permite cuerdas abiertas debe incorporar necesariamente D-branas, y todas las cuerdas abiertas debe tener sus puntos finales unidos a estas branas. Para un teórico de cuerdas, las D-branas son objetos físicos tan “reales” como las cuerdas y no sólo entes matemáticos que reflejan un valor.

Se espera que todas las partículas elementales sean estados vibratorios de las cuerdas cuánticas, y es natural preguntarse si las D-branas están hechas de alguna modo con las cuerdas mismas. En un sentido, esto resulta ser verdad: entre el espectro de las partículas que las vibraciones de la cuerda permiten, encontramos un tipo conocido como taquión, que tiene algunas propiedades raras, como masa imaginaria. Las D-branas se pueden imaginar como colecciones grandes de taquiones coherentes, de un modo parecido a los fotones de un rayo láser.

¿Tendrá el Universo más dimensiones de las que podemos ver?

Esto tiene implicaciones en la cosmología, porque la teoría de cuerdas implica que el universo tienen más dimensiones que lo esperado (26 para las teorías de cuerdas bosónicas y 10 para las teorías de supercuerdas) tenemos que encontrar una razón por la cual las dimensiones adicionales no son evidentes. Una posibilidad sería que el universo visible es una D-brana muy grande que se extiende sobre tres dimensiones espaciales. Los objetos materiales, conformados de cuerdas abiertas, están ligados a la D-brana, y no pueden moverse “transversalmente” para explorar el universo fuera de la brana. Este panorama se llama una Cosmología de branas. La fuerza de la Gravedad no se debe a las cuerdas abiertas; los gravitones que llevan las fuerzas gravitacionales son estados vibratorios de cuerdas cerradas. Ya que las cuerdas cerradas no tienen porque estar unidas a D-branas, los efectos gravitacionales podrían depender de las dimensiones adicionales perpendiculares a la brana.

Los dos extremos de la cuerda abierta residen en un subespacio (q+l)- dimensional de género tiempo llamado una D-brana, o D-q-brana que es una entidad esencialmente clásica (aunque posee propiedades de súpersimetría=, que representa una solución de la teoría de la supergravedad 11 dimensional.

Las teorías de dimensiones extra permiten transitar por otros caminos que, el mundo tetradimensional prohibe

En respuesta a la primera pregunta, una D-Brana es una estructura de genero tiempo, como más arriba indico, 1+q dimensiones espaciotemporales. (Invocando una de las dualidades de la teoría M, alternativamente podemos considerar una D-Grana como una solución de las ecuaciones de alguna otra versión de la teoría M de cuerdas.)

Las D-branas aparecen en muchas discusiones modernas relacionadas con las cuerdas (por ejemplo, en la entropía de los agujeros negros). Suelen tratarse como si fueran objetos clásicos que yacen dentro del espaciotiempo completo 1+9 (° 1+10) dimensiones. La “D” viene de “Dirichlet”, por analogía con el tipo de problema de valor de frontera conocido como un problema de Dirichlet, en el que hay una frontera de género tiempo sobre la que se especifican datos (según Meter G. Lejeune Dirichlet, un eminente matemático francés que vivió entre 1805 y 1859.)

Con la introducción de tales “D-branas” varios teóricos han expresado una “filosofía de cuerdas” que parece representar un profundo cambio respecto a lo anterior. En efecto, se afirma con cierta frecuencia que podríamos “vivir en” esta o esa D-brana, lo que significa que nuestro espaciotiempo percibido podría yacer realmente dentro de una D-brana, de modo que la razón de que no se perciban ciertas “dimensiones extra” se explicaría por el hecho de que “nuestra” D-brana no se extiende a esas dimensiones extra.

La última posibilidad sería la postura más económica, por supuesto, de modo que “nuestra” D-brana (una D-3 brana) sería de 1+3 dimensiones. Esto no elimina los grados de libertad en las dimensiones extra, pero los reduce drásticamente. ¿Por qué es así? Nuestra perspectiva ahora es que somos “conscientes” de los grados de libertad que están implicados en el interior profundo del espacio de mayores dimensiones entre los D-branas, y es en esto donde se está dejando sentir la excesiva libertad funcional.

Solo vamos a ser conscientes de dimensiones extra allí donde inciden directamente sobre las D-brana en la que “vivimos”. Más que una imagen de tipo “espacio cociente” que evoca la analogía de Kaluza-Klein original:

Pero ¿Cuántas dimensiones existen en realidad?

Así, nuestro espaciotiempo observado aparece ahora como un subespacio 4-dimensional del espacio real de dimensiones más altas. Con algo de imaginación, lo podemos visualizar en nuestra mente. ¿Cuánta libertad funcional esperamos ahora? La situación es ahora algo parecida a la imagen geométrica que hemos adoptado en el gráfico para obtener una perspectiva más convencional con respecto a la “supergeometría”.

Puesto que ahora estamos interesados solo en el comportamiento en la D-brana (que suponemos que es geométricamente una (1+3)-superficie ordinaria), podemos imaginar que nuestra libertad funcional se ha convertido en una aceptable αMα3, aunque para un M bastante grande. Sin embargo, incluso esto supone que la restricción de la dinámica en el 10-espacio (u 11-espacio) completo nos proporciona ecuaciones dinámicas dentro de “nuestra” D-brana 4-dimensional que son del tipo convencional, de modo que bastará los datos iniciales en una 3-superficie para determinar el comportamiento en todo el 4-espacio. Esto es difícilmente probable, en general, de modo que aún cabe esperar un excesivo αMα3.

¡El problema no ha desaparecido todavía! y, seguiremos investigando al mismo tiempo que nuestra imaginación, teoriza y conjetura… ¡De tántas maneras! que, será casi imposible que no demos, algún día, con la verdad que el Universo esconde.

emilio silvera

May

8

El vacío superconductor

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

Lo único que no resulta ser lo mismo cuando se mira a través a través del microscopio (o, en la jerca de la física teórica, cuando se realiza una transformación de escala) es la masa de la partícula. Esto se debe a que el alcance de la fuerza parece mayor a través del microscopìo y, por lo tanto, la masa de la partícula parece ser menor. Nótese que esta situación es la opuesta a la que se presenta en vida corriente donde un grano de arena parece mayor -¿más pesado, por lo tanto?- cuando se observa con un microscopio.

Granos de arena vistos al microscopio

Una consecuencia de todo esto es que en una teoría de Yang-Mills el termino de masa parece desaparecer cuando se realiza una transformación de escala, lo que implica que a través del microscopio se recupera la invariancia gauge. Esto es lo que causa la dificultad con la que se enfrentó Veltman. ¿Se puede observar directamente el potencial vector de Yang-Mills? Parece que puede observa4rse en el mundo de las cosas grandes, pero no en el mundo de lo pequeño. Esto es una contradicción y es una raz´`on por la que ese esquema nunca ha podido funcionar adecuadamente.

El objetivo de muchos investigadores cuánticos se centra precisamente en conseguir fabricar ordenadores que utilicen nuestro conocimiento en este área. El Consejo Superior de Investigaciones Científicas (CSIC) ha desarrollado, a través de una reacción química, una molécula magnética capaz de comportarse como una puerta lógica cuántica, algo básico si deseamos construir un ordenador de este tipo, junto a las memorias cuánticas.

En 2009, la empresa canadiense D-Wave Systems, conjuntamente con la NASA, desarrolló un ordenador cuántico de 128 cubits. Rainer contiene 128 dispositivos físicos (pequeños aros de metal niobidio) que a muy baja temperatura actúan como sistemas cuánticos con dos niveles (es decir, cubits) como consecuencia de la superconductividad.

¡Había una salida! Pero ésta procede de una rama muy diferente de la física teórica, la física de los metales a muy bajas temperaturas. A esas temperaturas, los “fenómenos cuánticos” dan lugar a efectos muy sorprendentes, que se describen con teorías cuánticas de campos, exactamente iguales a las que se utilizan en la física de partículas elementales. La física de partículas elementales no tienen nada que ver con la física de bajas temperaturas, pero las matemáticas son muy parecidas.

En algunos materiales, el “campo” que se hace importante a temperaturas muy bajas podría ser el que describe cómo los átomos oscilan alrededor de sus posiciones de equilibrio, o el que describe a los electrones en este tipo de material. A temperaturas muy baja nos encontramos con los “cuantos” de esos campos. Por ejemplo, el “fonón” es el cuanto del sonido. Su comportamiento recuerda al fotón, el cuanto de la luz, salvo que los números son muy diferentes: los fonones se propagan con la velocidad del sonido, a cientos o quizá miles de metros por segundo, y los fotones lo hacen a la velocidad de la luz que es de 300.000 km/s, ¡aproximadamente un millón de veces más deprisa! Las partículas elementales en las que estamos interesados generalmente tienen velocidades cercanas a las de la luz.

El fonon es la partícula elemental del sonido, como el foton lo es en la luz..

Uno de los “fenómenos cuánticos” más espectaculares que tienen lugar en los materiales muy fríos es la llamada superconductividad, fenómeno consistente en el hecho de que la resistencia que presenta ese material al paso de la corriente eléctrica se hace cero. Una de las consecuencias de ese estado es que el material no admite la más mínima diferencia de potencial eléctrico, porque ésta sería inmediatamente neutralizada por una corriente eléctrica “ideal”. El material tampoco admite la presencia de campos magnéticos porque, de acuerdo con las ecuaciones de Maxwell, la creación del campo magnético está asociada con una corriente eléctrica inducida, que al no encontrar resistencia neutralizaría completamente el campo magnético. Por lo tanto, en el interior de un superconductor no se puede crear ni un campo electrónico ni magnético. Esta situación sólo cambia si las corrientes inducidas son muy elevadas, como ocurre cuando se somete el superconductor a los campos de imanes muy potentes y que perturban el material. No siendo capaz de resistir una fuerza tan brutal, pierde la superconductividad y se rinde permitiendo la existencia de un campo magnético en su interior.

¿Pero, qué tiene que ver un superconductor con las partículas elementales? Bien, un material superconductor se puede entender como un sistema en el cual el campo electromagnético es un campo de muy corto alcance. Está siendo apantallado y, sin embargo, es un campo de Maxwell, un campo gauge. ¡Esto es lo que hace interesante un superconductor para alguien que quiera describir la interacción débil entre partículas como una teoría gauge! ¡Qué característica tan bella de la física teórica! Se pueden comparar dos mundos completamente diferentes simplemente porque obedecen a las mismas ecuaciones matemáticas.

¿Cómo funciona un superconductor? La verdadera causa de este fenómeno peculiar la descubrieron John Bardeen, Leon N. Cooper y John R. Schrieffer por lo que recibieron el premio Nobel en 1972). Los electrones de un trozo sólido de material tienen que reunir al mismo tiempo dos condiciones especiales para dar lugar a la superconductividad: la primera es apareamiento y la segunda condensación de Bose.

“Apareamiento” significa que los electrones forman pares y actúan en pares, y los que producen la fuerza que mantiene los pares unidos son los fonones. En cada par, los electrones rotan alrededor de su propio eje, pero en direcciones opuestas, de manera que el par (llamado “par de Cooper”), en su conjunto, se comporta como si no tuviera rotación (“momento angular”). Así, un par de Cooper se comporta como una “partícula” con espín 0 y carga eléctrica -2.

La “condensación de Bose” es un fenómeno típicamente mecánico-cuántico. Sólo se aplica a partículas con espín entero (bosones). Al igual que los lemmings, los bosones se agrupan juntos en el estado de menor energía posible, Recuérdese que a los bosones les gusta hacer a todos la misma cosa. En este estado todavía se puede mover, pero no pueden perder más energía y, en consecuencia, no sufren ninguna resistencia a su movimiento. Los pares de Cooper se mueven libremente, de manera que pueden crear corrientes eléctricas que no encuentran ninguna resistencia. Un fenómeno parecido tiene lugar en el helio líquido a muy bajas temperaturas. Aquí los átomos de helio forman una condensación de Bose y el líquido que forman puede fluir a través de los agujeros más pequeños sin la más mínima resistencia.

Condensado de Bose

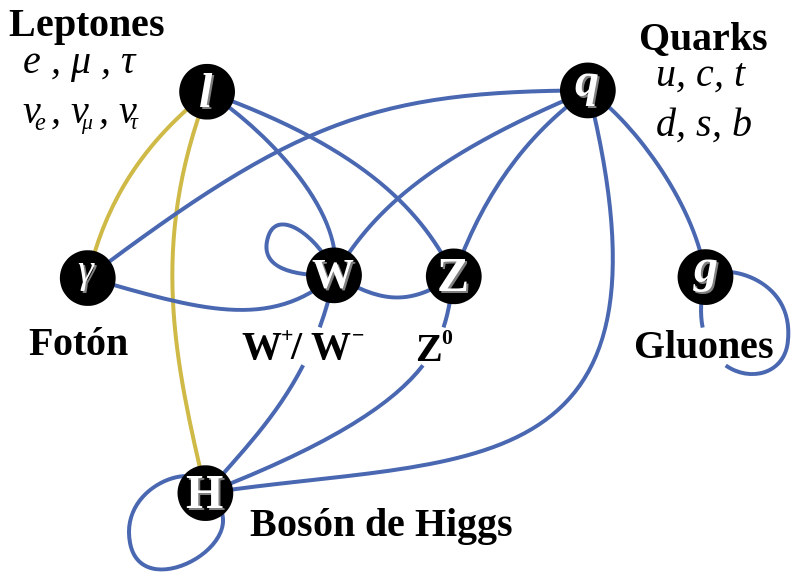

Como los electrones por separado tienen espín ⅟₂ no pueden sufrir una condensación de Bose. Las partículas cuyo espín es igual a un entero más un medio (fermiones) tienen que estar en estados cuánticos diferentes debido al principio de exclusión de Pauli. Esta es la razón por la que la superconductividad sólo se puede producir cuando se forman pares. Sí, comprendo que estas afirmaciones le sugerirán varias preguntas y me disculpo por adelantado, pero de nuevo he traducido fórmulas a palabras, lo que implica que el razonamiento pueda parecer poco satisfactorio. ¡Simplemente tome esto como una cierta “lógica cuántica” difícil de manejar! Fueron el belga François Englert, el americano Robert Brout y el inglés Peter Higgs los que descubrieron que la superconductividad podría ser importante para las partículas elementales. Propusieron un modelo de partículas elementales en el cual partículas eléctricamente cargadas, sin espín, sufrían una condensación de Bose. Esta vez, sin embargo, la condensación no tenía lugar en el interior de la materia sino el vacío. Las fuerzas entre las partículas tenían que ser elegidas de tal manera que se ahorrara más energía llenando el vacío de estas partículas que dejándolo vacío. Estas partículas no son directamente observables, pero podríamos sentir el estado, en cuyo espacio y tiempo están moviéndose las partículas de Higgs (como se las conoce ahora) con la mínima energía posible, como si el espacio tiempo estuviera completamente vacío.

Haber encontrado el bosón de Higgs puede resolver el misterio de la composición de masa de todos los objetos. Esta masa está presente en las partículas subatómicas y sin ellas la materia sólida no podría existir. El bosón de Higgs está relacionado a un campo energético, que se llama el campo de Higgs, el mismo que está presente en todo el universo de igual forma como el agua inunda una piscina. Es formando parte de ese campo, que las diversas partículas, como los protones, neutrones, electrones y otras, adquieren su masa. Las partículas más pequeñas encuentran menos dificultades para desplazarse, y las más grandes lo hacen con mayor dificultad. De todas las maneras, quedan muchas por explicar. Fandila nos prguntaba que, ¿de dónde adquiere su masa el mismo Bosón de Higgs?

Las partículas de Higgs son los cuantos del “campo de Higgs”. Una característica de este campo es que su energía es mínima cuando el campo tiene una cierta intensidad, y no cuando es nulo. Lo que observamos como espacio vacío no es más que la configuración de campo con la menor energía posible. Si pasamos de la jerga de campos a la de partículas, esto significa que el espacio vacío está realmente lleno de partículas de Higgs que han sufrido una condensación Bose”.

Este espacio vacío tiene muchas propiedades en común con el interior de un superconductor. El campo electromagnético aquí también es de corto alcance. Esto está directamente relacionado con el hecho de que, en tal mundo, el fotón tiene una cierta masa en reposo.

Y aún tenemos una simetría gauge completa, es decir, la invariancia gauge no se viola en ningún sitio. Y así, sabemos cómo transformar un fotón en una partícula “con masa” sin violar la invariancia gauge. Todo lo que tenemos que hacer es añadir estas partículas de Higgs a nuestras ecuaciones.

La razón por la que el efecto de invariancia gauge en las propiedades del fotón es tan diferente ahora es que las ecuaciones están completamente alteradas por la presencia del campo de Higgs en nuestro estado vacío. A veces se dice que “el estado vacío rompe la simetría espontáneamente”. Esto no es realmente correcto, pero el fenómeno está muy relacionado con otras situaciones en las que se produce espontáneamente una rotura de simetría.

Higgs sólo consideró campos electromagnéticos “ordinarios”, pero, desde luego, sabemos que el fotón ordinario en un vacío auténtico no tiene masa en reposo. Fue Thomas Kibble el que propuso hacer una teoría de Yang-Mills superconductora de esta forma, simplemente añadiendo partículas sin espín, con carga de Yang-Mills en vez de carga ordinaria, y suponer que estas partículas podían experimentar una condensación de Bose. Entonces el alcance de las interacciones de Yang-Mills se reduce y los fotones de Yang-Mills se convierten en partículas con espín igual a 1 y masa distinta de cero.

La discontinuidad manifiesta junto con la invariancia de escala (autosemejanza), que presenta la energía de las fluctuaciones del vacío cuántico. Las consecuencias de la existencia del cuanto mínimo de acción fueron revolucionarios para la comprensión del vacío. Mientras la continuidad de la acción clásica suponía un vacío plano, estable y “realmente” vacío, la discontinuidad que supone el cuanto nos dibuja un vacío inestable, en continuo cambio y muy lejos de poder ser considerado plano en las distancias atómicas y menores. El vacío cuántico es de todo menos vacío, en él la energía nunca puede quedar estabilizada en valor cero, está fluctuando sobre ese valor, continuamente se están creando y aniquilando todo tipo de partículas, llamadas por eso virtuales, en las que el producto de su energía por el tiempo de su existencia efímera es menor que el cuanto de acción. Se llaman fluctuaciones cuánticas del vacío y son las responsables de que exista un campo que lo inunda todo llamado campo de punto cero.

Algunos físicos proponen una controvertida teoría en la que un extraño tipo de materia, el Singlet de Higgs, se movería hacia el pasado o el futuro en el LHC. ¡Qué imaginación! Claro que, puestos a imaginar…

Bien sabido es que mientras más profundizamos en el conocimiento de los secretos del mundo que nos rodea, más interrogantes y misterios sin resolver se nos muestran. Cada vez que abrimos una puerta, llegamos a una habitación que tiene otras muchas por abrir. Es la búsqueda incesante del hombre, su insoslayable afán por saber el por qué, el cómo y el cuándo de todas las cosas.

¿Estaremos entrando en una especie de locura?

Bueno…

Por su parte, el científico británico Peter Higgs, de 80 años, que dio su nombre a la llamada “partícula divina” en 1964, afirmó que cree que su Bosón seríaá hallado gracias al Gran Colisionador. “Creo que es bastante probable” dijo pocas horas después de que entrara en funcionamiento el gigantesco acelerador. Y, según parece, se está saliendo con la suya.

De todas las maneras, estaría bien saber, a ciencia cierta, cómo es el campo de Higgs del que toman la masa todas las partículas, y conocer, mediante que sistema se transfieren la masa, o, si cuando las partículas entran en el campo de Higgs e interracionan con él, es el efecto frenado el que les otorga la masa.

emilio silvera

May

8

El vacío superconductor II

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Por su parte, el científico británico Peter Higgs, de 80 años, que dio su nombre a la llamada “partícula divina” en 1964, afirmó que cree que su Bosón seríaá hallado gracias al Gran Colisionador. “Creo que es bastante probable” dijo pocas horas después de que entrara en funcionamiento el gigantesco acelerador. Y, según parece, se está saliendo con la suya.

De todas las maneras, estaría bien saber, a ciencia cierta, cómo es el campo de Higgs del que toman la masa todas las partículas, y conocer, mediante que sistema se transfieren la masa, o, si cuando las partículas entran en el campo de Higgs e interracionan con él, es el efecto frenado el que les otorga la masa.

Claro que, esa, como otras conjeturas sobre los Océanos de Higgs y su dichosa Partícula “repartidora de masa”, no son más que conjeturas que, más adelante, debemos ir comprobando para poder escribirlas con letras de oro en el Libro de la Física, o, por el contrario, desecharlas como se ha hecho con tántas otras ideas y teorías frustradas que nunca llegaron a ninguna parte.

¡Los fotones de Yang-Mills adquieren su masa y el proncipio gauge se sigue cimpliendo! Al principio esta visión no mereció la atención que merecía. Por una parte, la gente penso que el modelo era feo. El principio gauge estaba ahí, pero ya no era el tema central. El “Campo de Higgs” había sido puesto ahí “a propósito” y la “partícula de Higgs”, en sí misma, no era una “partícula gauge”. Si se admitía esto, ¿por qué no introducir más partículas y campos arbitrarios? Estas ideas se consideraron como simples modelos con los que jugart, sin mucho significado fundamental al que ahora se quiere llegar con el LHC pretendiendo hacer bueno todo aquello y, al menos los físicos, insisten en que, el campo y la partícula están ahí…¡ya veremos en qué queda todo esto! Son muchos los cabos sueltos y las cosas sin explicar.

En segundo lugar estaba lo que se llamó “teorema de Goldstone”. Ya se habían priducido antes modelos de partículas con “rotura espontánea de simetría”, pero para la mayoría de esos modelos, Jeoffrey Goldstone habia probado que siempre contenían partículas sin masa y sin espín. Muchos investigadores, por lo tanto, pensaron que la teoría de Higgs también debía contener esa partícula de Goldstone, sin masa y que esto era un inconveniente porque entre las partículas conocidas no había ninguna partícula de Goldstone. Incluso el propio Goldstone había advertido que el Modelo de Higgs no satisfaccía las condiciones para su demostración, así que no tenía que ser válido para este caso, pero todo el mundo estaba tan impresionado con las matemáticas del teorema que el Modelo de Huggs-Kibble no tuvo éxito durante mucho tiempo.

El bosón de Higgs pretende ser una parte integral de nuestra comprensión de la Naturaleza. Se trata de una partícula que es una excitación de lo que se llama el campo de Higgs. El campo de Higgs impregna todo el espacio y cuando algunas de las partículas fundamentales que viajan a través de este campo adquieren masa (al interaccionar con el Campo dónde, probablemente, ve frenada su marcha y su desplazamiento es más lento debido al medio por el que discurre su viaje). La cantidad de masa que adquieren depende de la fuerza en que interactúan con el campo de Higgs. Algunas particulas, como el electrón adquieren una pequeña masa, mientras que otras adquieren una masa mucho mayor.

Y así, el teorema de Goldstone se utilizó como un “teorema de imposibilidad”: si el espacio vacío no es simétrico, entonces no se puede evitar la presencia de partículas sin masa y sin espín. Ahora sabemos que, en nuestro caso, la letra pequeña invalida el teorema; las partículas de Goldstone se hacen incisibles debido a la invariancia gauge y no son más que las “partículas fantasmas” que encontró Feynman en sus cáculos. Además, debemos recordar que el Mecanismo Higgs no es una auténtica rotura de simetría.

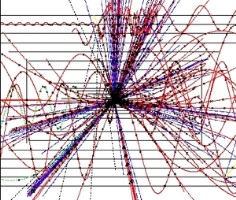

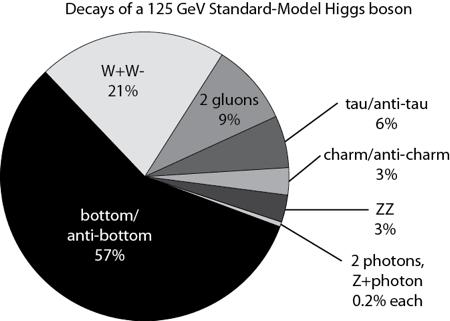

Ingenios que quieren entrar en los campos de Higgs

Un aspecto peculiar de esto es que este campo de Higgs que impregna en todo el espacio es parte de lo que llamamos espacio vacío o el vacío. Es sólo su impacto sobre las partículas que viajan a través de él y el bosón de Higgs que podemos observar en el laboratorio. El bosón de Higgs vive por un lapso muy corto de tiempo, así que no lo observan directamente, sino que más bien se observa que las partículas se descompone en y tienen que inferir su existencia a partir de eso. En la teoría actual que tenemos para comprender la naturaleza podemos hacer afirmaciones precisas acerca de qué fracción del tiempo que se desintegra en dos fotones en comparación con dos quarks abajo.

Claro que, algunos, me piden más profundidad en las explicaciones y, no se conforman con pasar por encima de las cuestiones, hay que entrar más en materia y dejar sentados algunos de los parámetros maemáticos que en todo esto están presente, y, para ellos…

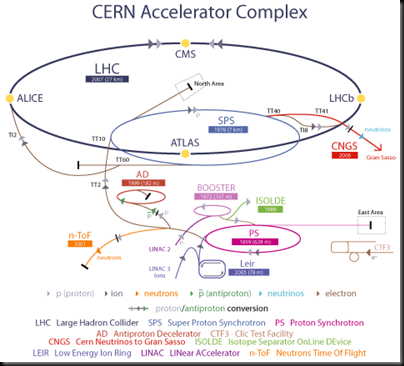

Los físicos han buscado al bosón de Higgs por cerca de 50 años porque su descubrimiento completaría el Modelo Estándar de la física de partículas. El bosón de Higgs y su campo asociado explican cómo la simetría electrodébil se rompió justo después del Big Bang, lo que le dio a ciertas partículas elementales la propiedad de la masa. Sin embargo del Modelo Estándar no predice la masa de Higgs, y varios programas experimentales en el LEP del CERN, en el Tevatron de Fermilab y ahora el LHC del CERN habían intentado medir la masa de la partícula.

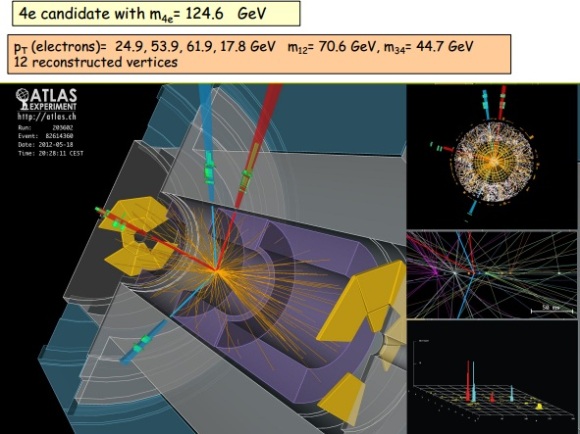

En el seminario llevado a cabo hoy en CERN como preludio a la mayor conferencia de física de partículas de este año, el ICHEP2012 en Melbourne, los experimentos ATLAS y CMS presentaron sus resultados preliminares en la búsqueda del Bosón de Higgs. Ambos experimentos observaron una nueva partícula en la región de masa entre 125-126 GeV.

“Observamos en nuestros datos claras señales de una nueva partícula, al nivel de 5 sigma, en la región de masa alrededor de 126 GeV. El impresionante rendimiento del LHC y ATLAS y el gran esfuerzo de mucha gente nos trajo a esta excitante etapa”, dijo la presentadora del experimento ATLAS Fabiola Gianotti, “pero se necesita más tiempo para preparar estos resultados para su publicación”

“Los resultados son preliminares pero la señal 5 sigma alrededor de 125 Gev que estamos viendo es dramática. Ésta es de hecho una nueva partícula. Sabemos que tiene que ser un bosón y es el bosón más pesado que hemos encontrado hasta ahora,” dijo el presentador del experimento CMS Joe Incandela. “Las implicaciones son muy significantes y es precisamente por esta razón que debemos ser extremadamente diligentes en todos nuestros estudios.”

¿Donde aparece el Higgs en todo esto?

Pues pasemos a hablar de teoría cuántica de campos, en ese tendremos unas densidades lagrangianas que dependerán del campo de cada partícula, dependiendo de su spin será un lagrangiano u otro, por ejemplo para N (a = 1,….N) campos escalares(omito fórmula).

Al buscar el mínimo del potencial (en realidad un extremal de la acción, pero para lo que nos interesa a nosotros serán mínimos) resulta que hay varios posibles (con el mismo valor) pero para que la energía se minimice hace falta fijar un vacío (debido a que el Hamiltoniano depende del potencial y de unos términos positivos que van con las derivadas del campo). Ahora bien, inicialmente nuestra acción podría tener una simetría gauge global, es decir que al efectuar una transformación de un grupo sobre los campos la acción no cambia, al fijar el vacío la simetría se reduce a un subgrupo

y algunos campos obtienen masa (originalmente ninguno tiene masa), pues bien el teorema de Goldstone lo que dice es que

campos se quedan sin masa, estos son los bosones de Goldstone.

¿Y el higgs?

Ya llegamos, en el apartado anterior hemos considerado transformaciones globales, pero por ejemplo en electromagnetismo tenemos transformaciones locales, así que hay que mirar lo que pasa en las transformaciones locales. Lo primero que pasa es que la derivada parcial no preserva los vectores (lo que hemos llamado antes

) igual que pasa en relatividad general, al hacer una transformación que depende de las coordenadas la derivada ya no es covariante, así que hay que buscar una covariante para seguir con lo que sabemos (en este caso la transformación se debe a un grupo gauge arbitrario, que no tiene porque ser el de difeomorfismos como en relatividad general. En este contexto aparecen los campos gauge que jugaran un papel similar al de la conexión en relatividad general y en el caso del electromagnetismo el campo gauge es el potencial electromagnético). Ahora al ser transformaciones locales, aparecen campos gauge que por similitud con el electromagnetismo escribiremos el lagrangiano de Yang-Mills

igual que en el electromagnetismo F depende de los campos gauge, pero debido a que

no es abeliano hay un termino extra que tiene que ver con las constantes de estructura del álgebra de Lie,

. Ahora ya vien lo bueno, aparte del lagrangiano de la partícula también tenemos el de Yang-Mills, resulta que debido a la simetría local:

- Los bosones de Goldstone desaparecen, es decir no son partículas físicas.

campos gauge obtienen masa

Pues eso es el efecto Higgs. Ahora para llegar ya al famoso bosón, en el modelo estandar no se pueden construir terminos de masa para las partículas debido a que no se pueden acoplar adecuadamente para ese propósito los campos de Yang-Mills y las partículas, debido a las simetrías que deben satisfacer (en general el famoso aunque cada campo tendrá una simetría concreta) y ahí es donde entra el bosón de Higgs, ya que el modelo más sencillo para añadir masa es justamente ese, añadir un doblete de campos escalares complejos y al romper la simetría …….. Higgs !!!!

Dos prestigiosos investigadores habñían sugerido de forma independiente que se podían construir modelos realistas dde partículas en los cuales, el sistema de Yang-Mills fuera responsable de la interacción débil y el mecanismo de Higgs-Kibble la causa de su corto alcance. Uno de ellos era el paquistaní Abdus Salam que estaba buscando modelos estéticos de partículas y pensó que la belleza de la idea de Yan-Mills era razón suficiente para intentar construir con ella un modelo de interacción débil. La partícula mediadora de la interacción débil tenía que ser un fotón de Yang-Mills y el mecanismo de Higgs-Kibble la única explicación aceptable para que esta partícula tuviera una cierta cantidad de masa en reposo.

Una simetría puede ser perfecta en el plano de las ecuaciones y resultar rota en el plano de las soluciones. Como decía Weinberg: «Aunque una teoría postule un alto grado de simetría, no es necesario que los estados de las partículas muestren la simetría. Nada me parece tan halagüeño en física como la idea de que una teoría puede tener un alto grado de simetría que se nos oculta en la vida ordinaria».

La teoría que unifica las interacciones electromagnéticas y débil se debe a Glashow, Salam y Weinberg que obtuvieron por ella el Premio Nobel de física de 1979. La dificultad esencial de esta teoría es que los bosones del estado inicial simétrico debían ser de masa nula (masa nula de los bosones de interacción origina una fuerza a gran distancia), mientras que se necesitan bosones intermedios (partículas que originan la fuerza) muy masivos para justificar la interacción débil (corto alcance) . El mecanismo de Higgs, permite resolver esa dificultad, mediante la ruptura espontánea de simetría hace masivos los bosones W y Z (interacción débil) y mantiene nula la masa del fotón (interacción electromagnética).

Los famosos diagramas de Feynaman, nos explican algunos mecanismos de los que se pueden producir (de hecho se producen) en ese misterioso campo de las partículas elementales cuando están presentes en cuertos lugares y se juntas con otros individuos de la especie.

Salam que estaba muy cerca de poder alcanzar la gloria…no llegaba a poder explicar y aplicar las reglas de Feynman y tuvo quer admitir que la teoría parecía estar llena de partículas fantasmas que estaban a punto de estropearlo todo. En estas, llegó el otro investigador, Steven Weinberg, que supo dar un paso más al formular con mucho más detalle un modelo sencillo en el cual indicaba con precisión los campos que existían y cómo podían interactuar. Pero se limitó a los leptones. Weinberg comprendió que, junto al fotón ordinario tenía que haber tres fotones de Yang-Mills pesados:

– Uno cargado positivamente.

– Otro cargado negativamente.

– Otro Neutro.

El panorama completo

En lo que se refiere a los fotones cargados, todo el mundo estaba de acuerdo en que estos se necesitarían para describir la interacción débil: serían los famoso bosones vectoriales intermediarios, W+ y W–. De acuierdo con Weinberg, sus masas tenían que ser mayores de 60.000 MeV. Pero solos, estos bosones, vectoriales cargados eran suficientes para explicar todos los procesos de interacción débil que conocían en aquella época. Que aparte de ellos y del fotón ordinario, y, también se necesita otro componente neutro (Weinberg le llamó Zº) no era evidente en absoluto. Se encontró que la masa del Zº tenía que ser un poco mayor que la de los bosones cargados.

De todo aquello surgió una tería para las interacciones débiles en las cuales jugaban un papel dominante distintos diagramas de Feynman, de los que se podían plasmar un número infinito para mostrar, de manera gráfica, los sucesos que acontecían en aquellos fenómenos de la radiación producida en la interacción débil. Pasado el tiempo y mirado con una mejor perspectiva, es fácil comprender todo aquello pero, en aquellos momentos en que se estaba gestando, las cosas no resultaban tan fáciles.

Después de todo aquello, se prestó más atención al mecanismo Higgs-Kibble y, algunos, como Veltman fueron muy escépticos con aquellas ideas, y, desde luego, no fue fácil converlo de que pudiéramos llamar vacío a algo lleno de partículas invisibles. ¿No delatarían dijo, su presencia por sus campos gravitatorios? La teoría puede ser formulada de tal manera que esos campos gravitatorios se compensen exactamente con otras partículas invibles o por una contribución misteriosa del propio espacio vacío.

Cómo consigue la Naturaleza enmascarar tan exacta y eficientemente esos factores de la gravedad que no podemos notar nada, es un misterio que continua siendo muy debatido hoy en día. Claro que, todo esto dejará de ser un misterio cuando un día (lejos aún en el futuro), podamos comprender la Gravedad Cuántica.

Miehntras todo esto sucede… ¡Dejémos volar nuestra imaginación! con ideas y teorías como la de los ¡Campos de Higgs! ¡Bosones que, generosos ellos, regalan masas a otras partículas! ¡Materia que no podemos ver pero que, dem manera acérrima, nos empeñamos en que sí está! ¡Fluctiaciones de vacío que rasgan el espacio-tiempo, y, que de vez en cuando, hace surgir nuevos universos! ¡Universos paralelos que nacieron sin vida! ¡Ciclos eternos en el que las cosas se repetin una y otra vez hasta el infinito! ¡Nuevos Big Bangs después del nuestro! ¡Agujeros negros en nuestro universo y, blancos al otro lado, en otro universo. Aquí recoge materia y, allú, la expulsa por el contrario, un Agujero Blanco! ¡Agujeros de Gusano que nos podrían llevar a otras galaxias! ¡El sueño de vencer (mejor burlar) a la velocidad de la luz, ese muro que nos tiene confinados en nuestro pequeño mundo, el Sistema Solar!

Después de leer todo esto, ¿por qué no dedicais aunque sólo sea una hora para pensar sobre ello? Últimamente nos han dicho que aquella partícula que encontraron el el LHC sí era un Higgs pero… ¿El auténtico Bosón de Higgs? Bueno, eso no… es seguro.

emilio silvera

May

5

El “universo” de lo muy pequeño. ¡Resulta fasciante!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (3)

Comments (3)

¿Os acordais? ¿Cuántos niños no habrán soñado con escenas como estas?

Cuando hablo de lo muy pequeño, puedo llegar a entender muy bien lo que es, lo que son, “licencias literarias” el papel de nada se queja y el lápiz puede escribir lo que quiera y pience el que lo sostiene, según le dicte su imaginación. Claro que, cuando comparamos ese mundo de ilusiones e imaginación y lo comparamos con el mundo real, todo el edificio se viene abajo. ¡Lástima!

Todos los niños pequños juegan con pequeños muñecos que son soldados, guerreros o seres de otras galaxias con poderes mágicos y,ellos, en su inocente mundo sin maldad, los dirigen con sus manitas gordezuelas al desarrollo de luchas y aventuras sin fin. Jonathan Swift, nos deleitó con aquellas aventuras de Gulliver, un aventurero que llegó a las tierras de Lilliput: Allí, todo era muy pequeño, la naturaleza, las plantas, los habitantes del lugar y sus casas y palacios, embarcaciones y todos los animales.

Gulliver era allí un gigante de proporciones inmensas: Incluso llegó a extinguir un fuego con una simple chorrada (es decir, hizo pipí) y acabço de inmediato con el (para ellos) enorme fuego.

Su tamaño podía, sin dificultad alguna, decidir el resultado de una guerra entre aquellos pequeñísimos seres que, ante un gigante como él, no tenían defensa alguna y, sus armas, resultaban ridículas para poder causarle algún daño. Dormido lo tucieron que coger para poder atarlo.

Durante otro viaje, las fuerzas ignotas del destino llevaron a Gulliver a un pais llamado Brobdingnag, donde la gente y todos los seres animados e inanimados eran mucho más grandes que él. Allí era un enano, mimado por una niña pequeña llamada Glumdalclitch. Al final, Gulliver es recogido en una jaula por un águila que lo deja caer en el mar de donde lo rescataron unos marineros a los que, al contarles esas historias, pusieron incrédulas caras de asombro.

Claro que, cuando nos trasladamos al mundo real, las cosas no suelen ser de esa manera. Poco importa lo fascinantes que las historias de este tipo nos puedan resultar. Las cosas no funcionan de esa manera. Todos sabemos, por ejemplo que la llama de una vela pequeña y la de una vela grande, son aproximadamente del mismo tamaño. ¿De qué tamaño serían las llamas de las velas de Lilliput? Y, desde luego, si pensamos un poco, más cuestiones nos surgen: ¿Cómo serían las gotas de lluvia en Lilliput y en Brobdingnag?, ¿eran las leyes físicas para el agua diferentes allí que en nuestro propio mundo? Y, finalmente, los físicos se preguntarían: ¿De qué tamaño eran los átomos en esos lugares?, ¿qué clase de reacciones químicas podrían tener lugar con los átomos del cuerpo de Gulliver?

Claro que, con esas preguntas esas historias fallan. La verdadera razón por la que los mundos de Los Viajes de Gulliver no pueden existir es que las leyes de la Naturaleza no permanecen exactamente iguales cuando se cambian las escalas. A veces, esto es evidente en las películas de desastres, donde quizá se ha construído una maqueta a escala para simular una gran ola o un rascacielos en llamas.

El ojo experto puede, sin problemas, distinguir entre la maqueta y la realidad. Los mejores resultados se obtienen cuando el factor de esacala para el tiempo se elige igual a la raíz cuadrada de la escala espacial. Así, si el rascacielos de turno se construye a escala 1:9, hay que rodar la película a un 1/3 de su velocidad real. Pero incluso así, como antes señalo, el ojo entrenado distingue la diferencia entre lo que sucede en la película y lo que se observaría en el mundo real.

En resumen, las leyes que gobiernan el mundo físico tienen dos características importantes: muchas leyes de la naturaleza permanecen inalterables, no se alteran cuando cambia la escala, pero hay otros fenómenos, tales como una vela encendida o las gotas de agua, que no cambian del mismo modo. La implicación final es que el mundo de los objetos muy pequeños será completamente diferente del mundo ordinario.

Justamente en el mundo de los seres vivos la escala crea importantes diferencias. En muchos aspectos, la anatomía de un ratón se podría consuiderar (más o menos y, guardando las distancias) como una copia de la de un elefante, pero mientras que un ratón puede trepar por una pared de piedra prácticamente vertical sin mucha dificultad (incluso se puede caer desde una altura varias veces mayor que su tamaño sin hacerse gran daño), un elefante sería incapaz de realizar tal hazaña. Así llegamosm a comprender que la Gravedad, se deja sentir en menor grado a medida que los objetos disminuyen de tamaño.

Cuando llegamos a los seres unicelulares, se ve que para ellos no hay distinción entre arriba y abajo. Para ellos, la tensión superficial del agua es mucho más importante que la fuerza de gravedad. Basta observar que la tensión superficial es la fuerza que da forma a una gota de agua y comparar el tamaño de esa gota con los seres unicelulares, muchísimo menores, para que sea evidente que la tensión superficial es muy importante a esta escala.

La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos fuerza de Van der Vaalls. esta fuerza tiene un alcance muy corto. para ser más precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente proporcional a 1/r7. Esto significa que si se reduce la distancia entre dos átomos a la mitad, la fuerza de Van der Vaalls con la que se atraen uno a otro se hace 2 x 2 x 2 x 2 x 2 x 2 x 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza.

Ahora tendríamos que hablar algo de la mecánica cuántica y, en ese ámbito, las reglas de la mecánica cuántica funcionan tan bien que resultaría realmente difícil refutarlas.

Acordaos de los trucos ingeniosos descubiertos por Werner Hesinberg, Paul Dirac, o, Schrödinger que vinieron a mejorar y completar las reglas generales. Sin embargo, algunos de aquellos pioneros (Einstein y el mismo Schrödinger), sin embargo, presentaron serias objeciones a dicha interpretación de la naturaleza de lo muy pequeño.

Podríamos formular una simple pregunta que pondría en un brete a más de uno: ¿Dónde está realmente el electrón, en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad? Si prestamos ate4nción a Bohr, no tiene ningún sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores serían las únicas realidades a las que deberíamos prestar atención y de las que podemos hablar.

Muchas veces me sorprende oír a muchos “científicos” que hablan con una seguridad de lo que dicen como si, de una verdad inamovible se tratara. Ellos (en realidad) creen que saben y, no llegan a darse cuenta de que están hablando de un Modelo que ha sido construído matemáticamente hablando, para poder explicar eso que, nosotros, los humanos, creemos que es la realidad del mundo. Sin embargo, más de una vez hemos tenido que cambiar esos modelos y rectificar esa “realidad” por otra que, resultó ser “más real”.

¡Sabemos tan poco

emilio silvera

Totales: 83.685.069

Totales: 83.685.069 Conectados: 38

Conectados: 38