Dic

16

¡Qué misterio esconde la materia? ¿Qué es la luz? ¿Las radiaciones?...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

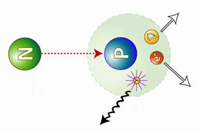

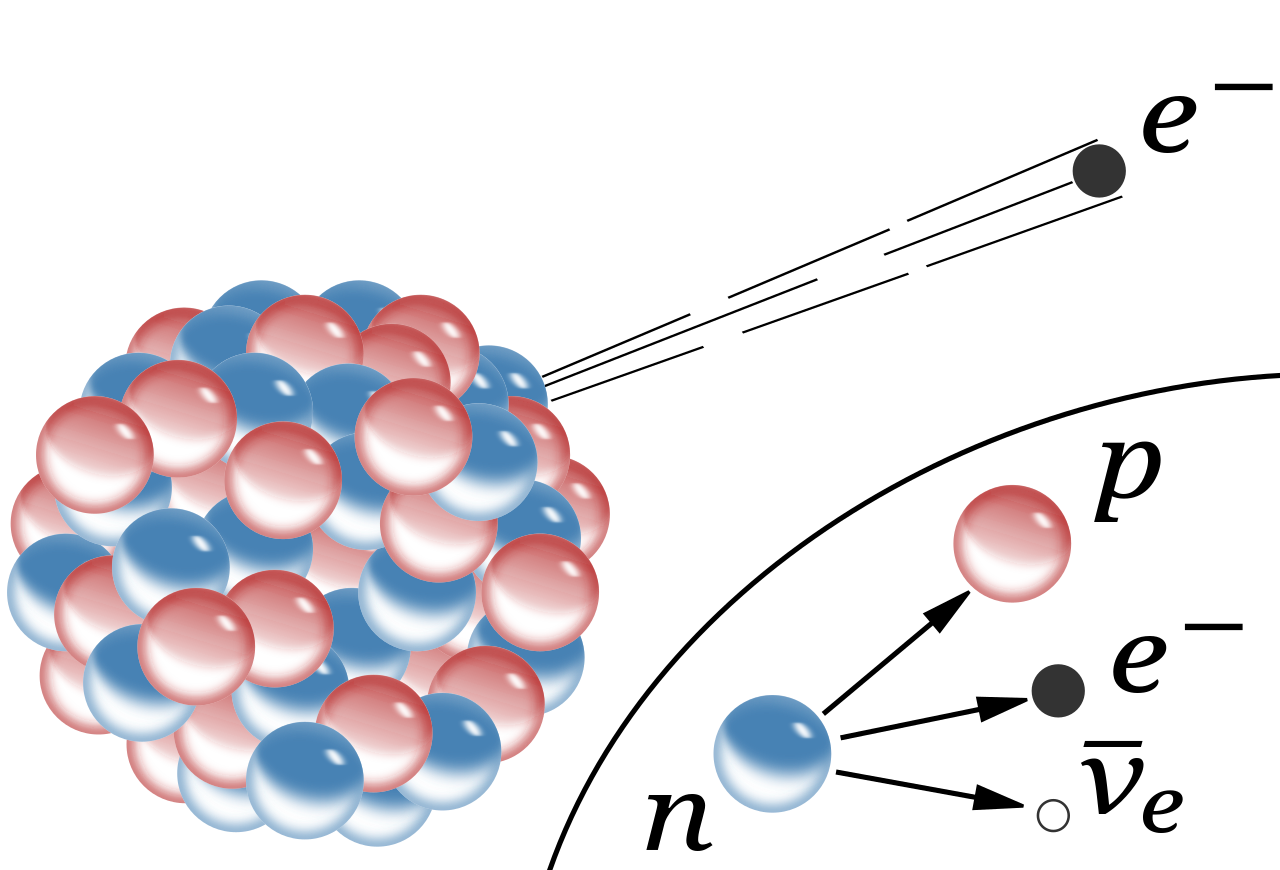

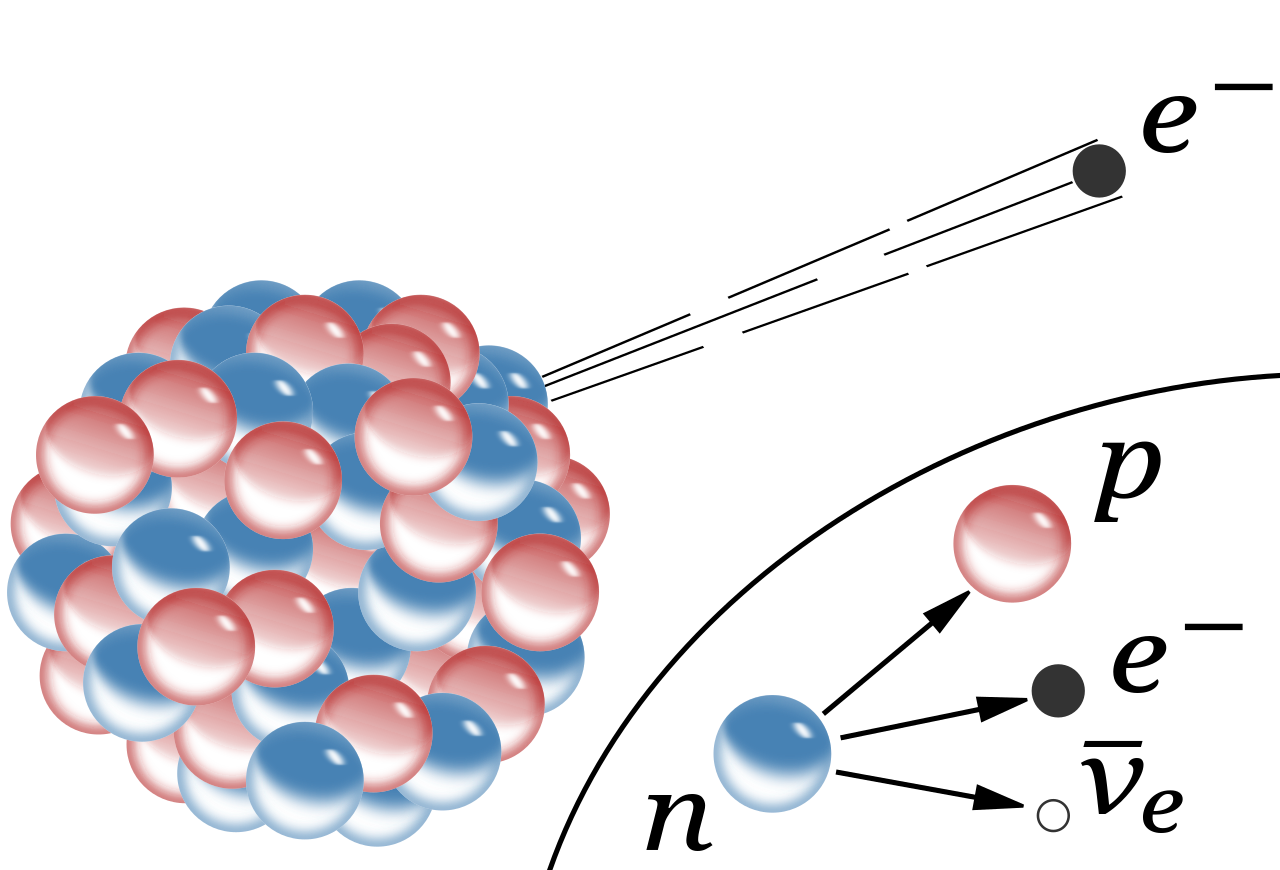

Decaimiento β– de un núcleo. Se ilustra cómo uno de los neutrones se convierte en un protón a la vez que emite un electrón(β–) y un antineutrino electrónico. La desintegración beta se debe a la interacción nuclear débil, que convierte un neutrón en un protón (desintegración β–), o viceversa (β+), y crea un par leptón–antileptón. Así se conservan los números bariónico(inicialmente 1) y leptónico (inicialmente 0). Debido a la aparente violación al principio de conservación de la energía, estas reacciones propiciaron precisamente que se propusiera la existencia del neutrino. Precisamente de eso hablamos aquí.

Una vez escenificados los conceptos, diremos que, los físicos se vieron durante mucho tiempo turbados por el hecho de que a menudo, la partícula beta emitida en una desintegración del núcleo no alberga energía suficiente para compensar la masa perdida por el núcleo. En realidad, los electrones no eran igualmente deficitarios. Emergían con un amplio espectro de energías, y el máximo (conseguido por muy pocos electrones), era casi correcto, pero todos los demás no llegaban a alcanzarlo en mayor o menor grado. Las partículas alfa emitidas por un nucleido particular poseían iguales energías en cantidades inesperadas. En ese caso, ¿Qué era errónea en la emisión de partículas beta? ¿Qué había sucedido con la energía perdida?

En 1.922, Lise Maitner se hizo por primera vez esta pregunta, y, hacia 1.930, Niels Bohr estaba dispuesto a abandonar el gran principio de conservación de la energía, al menos en lo concerniente a partículas subatómicas. En 1.931, Wolfgang Pauli sugirió una solución para el enigma de la energía desaparecida.

La radiación alfa está compuesta por un núcleo de helio y puede ser detenida por una hoja de papel. La radiación beta, compuesta por electrones, es detenida por una hoja de papel de aluminio. La radiación gamma es absorbida cuando penetra en un material denso

Digamos que la solución de Pauli para explicar la masa perdida, era muy simple: junto con la partícula beta del núcleo se desprendía otra, que se llevaba la energía desaparecida. Esa misteriosa segunda partícula tenía propiedades bastante extrañas. No poseía carga ni masa. Lo único que llevaba mientras se movía a la velocidad de la luz era cierta cantidad de energía. A decir verdad, aquello parecía un cuerpo ficticio creado exclusivamente para equilibrar el contraste de energías.

Sin embargo, tan pronto como se propuso la posibilidad de su existencia, los físicos creyeron en ella ciegamente. Y esta certeza se incrementó al descubrirse el neutrón y al saberse que se desintegraba en un protón y se liberaba un electrón, que, como en la decadencia beta, portaba insuficientes cantidades de energía. Enrico Fermi dio a esta partícula putativa el nombre de “neutrino”, palabra italiana que significa “pequeño neutro”.

Primera observación de un neutrino en una cámara de burbujas, en 1970 en el Argonne National Laboratory de EE. UU., la observación se realizo gracias a las líneas observadas en la Cámara de burbujas basada en hidrógeno líquido. Siempre hemos tenido imaginación para idear aparatos que nos ayudaran a desvelar los secretos de la Naturaleza. Más tarde, la cámara de burbujas, fue sustituida por la cámara de chispas.

El neutrón dio a los físicos otra prueba palpable de la existencia del neutrino. Como ya he comentado otras veces, casi todas las partículas describen un movimiento rotatorio. Esta rotación se expresa, más o menos, en múltiplos de una mitad según la dirección del giro. Ahora bien, el protón, el neutrón y el electrón tienen rotación de una mitad. Por tanto, si el neutrón con rotación de una mitad origina un protón y un electrón, cada uno con rotación de una mitad, ¿qué sucede con la ley sobre conservación del momento angular? Aquí hay algún error. El protón y el electrón totalizan una mitad con sus rotaciones (si ambas rotaciones siguen la misma dirección) o cero (si sus rotaciones son opuestas); pero sus rotaciones no pueden sumar jamás una mitad. Sin embargo, por otra parte, el neutrino viene a solventar la cuestión.

Supongamos que la rotación del neutrón sea +½. Y admitamos también que la rotación del protón sea +½ y la del electrón -½, para dar un resultado neto de cero. Demos ahora al neutrino una rotación de +½, y la balanza quedará equilibrada.

+½(n) = +½(p) – ½(e) + ½(neutrino)

Pero aun queda algo por equilibrar. Una sola partícula (el neutrón) ha formado dos partículas (el protón y el electrón), y, si incluimos el neutrino, tres partículas. Parece más razonable suponer que el neutrón se convierte en dos partículas y una antipartícula. En otras palabras: lo que realmente necesitamos equilibrar no es un neutrino, sino un antineutrino.

El propio neutrino surgiría de la conversación de un protón en un neutrón. Así, pues, los productos serían un neutrón (partícula), un positrón (antipartícula) y un neutrino (partícula). Esto también equilibra la balanza. En otras palabras, la existencia de neutrinos y antineutrinos debería salvar no una, sino tres, importantes leyes de conservación: la conservación de la energía, la de conservación del espín y la de conservación de partícula/antipartícula.

Para un electrón, protón o neutrón la cantidad de espín es siempre 1/2 del valor mínimo de momento permitido (ħ).

Es importante conservar esas leyes puesto que parece estar presentes en toda clase de reacciones nucleares que no impliquen electrones o positrones, y sería muy útil si también se hallasen presentes en reacciones que incluyesen esas partículas.

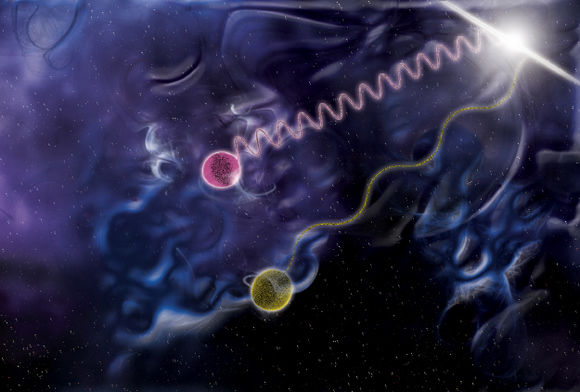

Las más importantes conversiones protón-neutrón son las relaciones con las reacciones nucleares que se desarrollan en el Sol y en los astros. Por consiguiente, las estrellas emiten radiaciones rápidas de neutrinos, y se calcula que tal vez pierdan a causa de esto el 6 u 8 % de su energía. Pero eso, sería meternos en otra historia y, por mi parte, con la anterior explicación solo trataba de dar una muestra del ingenio del hombre que, como habréis visto, no es poco.

Aunque sólo una cinco mil millonésima de la luz solar llega a la Tierra, ha sido suficiente para dar a esta calor y vida, así como bípedos bastante listos para calcular al detalle su deuda con el Sol que, si pusiera intereses, nunca podríamos pagar.

Desde que puedo recordar, he sido un amante de la Física. Me asombran cuestiones como la luz, su naturaleza de un conglomerado de colores, ondas y partículas, su velocidad que nos marca el límite máximo que se puede desplazar cualquier cosa en nuestro Universo, y en fin, muchos otros misterios que encierra esa maravilla cotidiana que nos rodea y lo inunda todo haciendo posible que podamos ver por donde vamos, que las plantas vivan y emitan oxígeno o que nos calentemos. Realmente, sin luz, nuestra vida no sería posible.

Me gustaría que alguien contestara: ¿Qué es realmente la luz?

Muchos (casi todos) opinan que es algo inmaterial. Los objetos materiales, grandes o muy pequeños como las galaxias o los electrones, son materia. La luz, sin embargo, se cree que es inmaterial, dos rayos de luz se cruzan sin afectarse el uno al otro. Sin embargo, yo que deberíamos profundizar un poco más y, sabiendo que la luz está formada por fiotones, que los fotones son energía, que la energía es un aspecto de la masa… ¿Qué es realmente la luz? Nosotros mismos, el última instancia ¿No seremos luz?

Está claro que los estudiosos de la época antigua y medieval estaban por completo a oscuras acerca de la naturaleza de la luz. Especulaban sobre que consistía en partículas emitidas por objetos relucientes o tal vez por el mismo ojo. Establecieron el hecho de que la luz viajaba en línea recta, que se reflejaba en un espejo con un ángulo igual a aquel con el que el rayo choca con el espejo, y que un rayo de luz se inclina (se refracta) cuando pasa del aire al cristal, al agua o a cualquier otra sustancia transparente.

Cuando la luz entra en un cristal, o en alguna sustancia transparente, de una forma oblicua (es decir, en un ángulo respecto de la vertical), siempre se refracta en una dirección que forma un ángulo menor respecto de la vertical. La exacta relación entre el ángulo original y el ángulo reflejado fue elaborada por primera vez en 1.621 por el físico neerlandés Willerbrord Snell. No publicó sus hallazgos y el filósofo francés René Descartes descubrió la ley, independientemente, en 1.637.

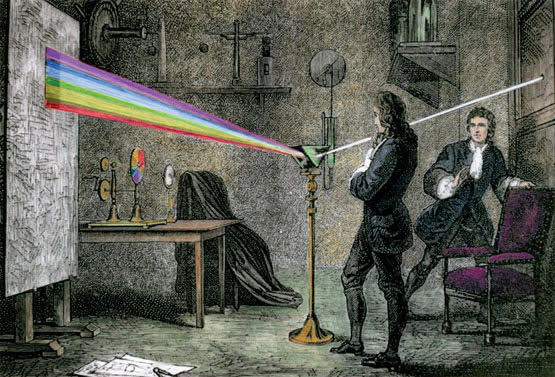

Los primeros experimentos importantes acerca de la naturaleza de la luz fueron llevados a cabo por Isaac Newton en 1.666, al permitir que un rayo de luz entrase en una habitación oscura a través de una grieta e las persianas, cayendo oblicuamente sobre una cara de un prisma de cristal triangular. El rayo se refracta cuando entra en el cristal y se refracta aún más en la misma dirección cuando sale por una segunda cara del prisma. (Las dos refracciones en la misma dirección se originan por que los dos lados del prisma de se encuentran en ángulo en vez de en forma paralela, como sería el caso en una lámina ordinaria de cristal.)

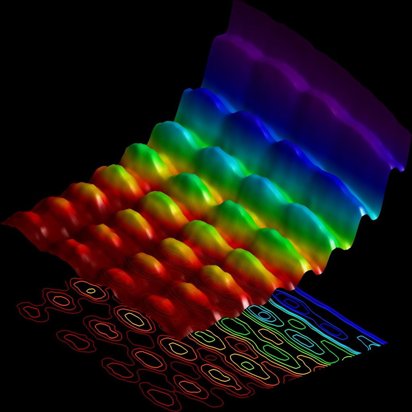

Newton atrapó el rayo emergente sobre una pantalla blanca para ver el efecto de la refracción reforzada. Descubrió que, en vez de formar una mancha de luz blanca, el rayo se extendía en una gama de colores: rojo, anaranjado, amarillo, verde, azul, y violeta, en este orden. Newton dedujo de ello que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos para producir las diversas sensaciones de colores. La amplia banda de sus componentes se denominó spectrum (palabra latina que significa “espectro” fantasma).

Newton llegó a la conclusión de que la luz se componía de diminutas partículas (“corpúsculos”), que viajaban a enormes velocidades.

Le surgieron y se planteó algunas inquietantes cuestiones. ¿Por qué se refractaban las partículas de luz verde más que los de luz amarilla? ¿Cómo se explicaba que dos rayos de luz se cruzaran sin perturbase mutuamente, es decir, sin que se produjeran colisiones entre partículas?

En 1.678, el físico neerlandés christian Huyghens (un científico polifacético que había construido el primer reloj de péndulo y realizado importantes trabajos astronómicos) propuso una teoría opuesta: la de que la luz se componía de minúsculas ondas. Y si sus componentes fueran ondas, no sería difícil explicar los diversos difracciones de los diferentes tipos de luz a través de un medio refractante, siempre y cuando se aceptara que la luz se movía más despacio en ese medio refractante que en el aire. La cantidad de refracción variaría con la longitud de las ondas: cuanto más corta fuese tal longitud, tanto mayor sería la refracción. Ello significaba que la luz violeta (la más sensible a este fenómeno) debía de tener una longitud de onda mas corta que la luz azul, ésta, más corta que la verde, y así sucesivamente.

Se encuentra la galaxias más lejana nacida después del Big Bang

Gracias a las radiaciones electromagnéticas podemos ver el Universo como fue hace ahora miles de millones de años. Cuando la luz, nos trae la imagen de galaxias situadas a distancias inconmensurables. ¿Quién podría haber pensado, en el pasado, que tal cosa fuese posible?

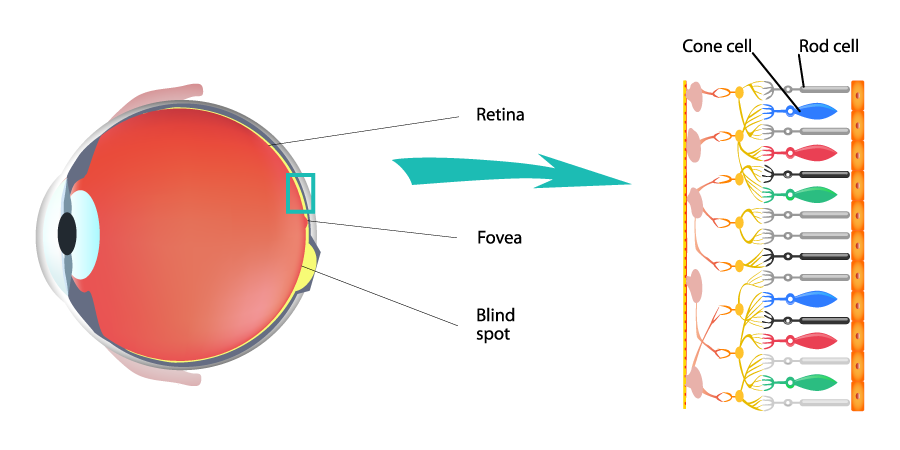

El ojo humano percibe los colores porque sus células fotorreceptoras (conos) son sensibles a diferentes longitudes de onda dentro del espectro visible, y el cerebro interpreta la combinación de estas señales, interpretando una longitud de onda como azul, otra como verde, y otras como variaciones de rojo, o mezclas de ellas, permitiéndonos ver un vasto abanico de tonos.

Lo que permitía al ojo distinguir los colores eran esas diferencias entre longitudes de onda. Y, como es natural, si la luz estaba integrada por ondas, dos rayos podrían cruzarse sin dificultad alguna. (Las ondas sonoras y las del agua se cruzan continuamente sin perder sus respectivas identidades.)

Pero la teoría de Huyqhens sobre las ondas tampoco fue muy satisfactoria. No explicaba por qué se movían en línea recta los rayos luminosos; ni por qué proyectaban sobras recortadas; ni aclaraba por qué las ondas luminosas no podían rodear los obstáculos, del mismo modo que pueden hacerlo las ondas sonoras y las ondas marinas. Por añadidura, se objetaba que si la luz consistía en ondas, ¿Cómo podía viajar por el vacío, ya que cruzaba el espacio desde el Sol y las Estrellas? ¿Cuál era esa mecánica ondulatoria?

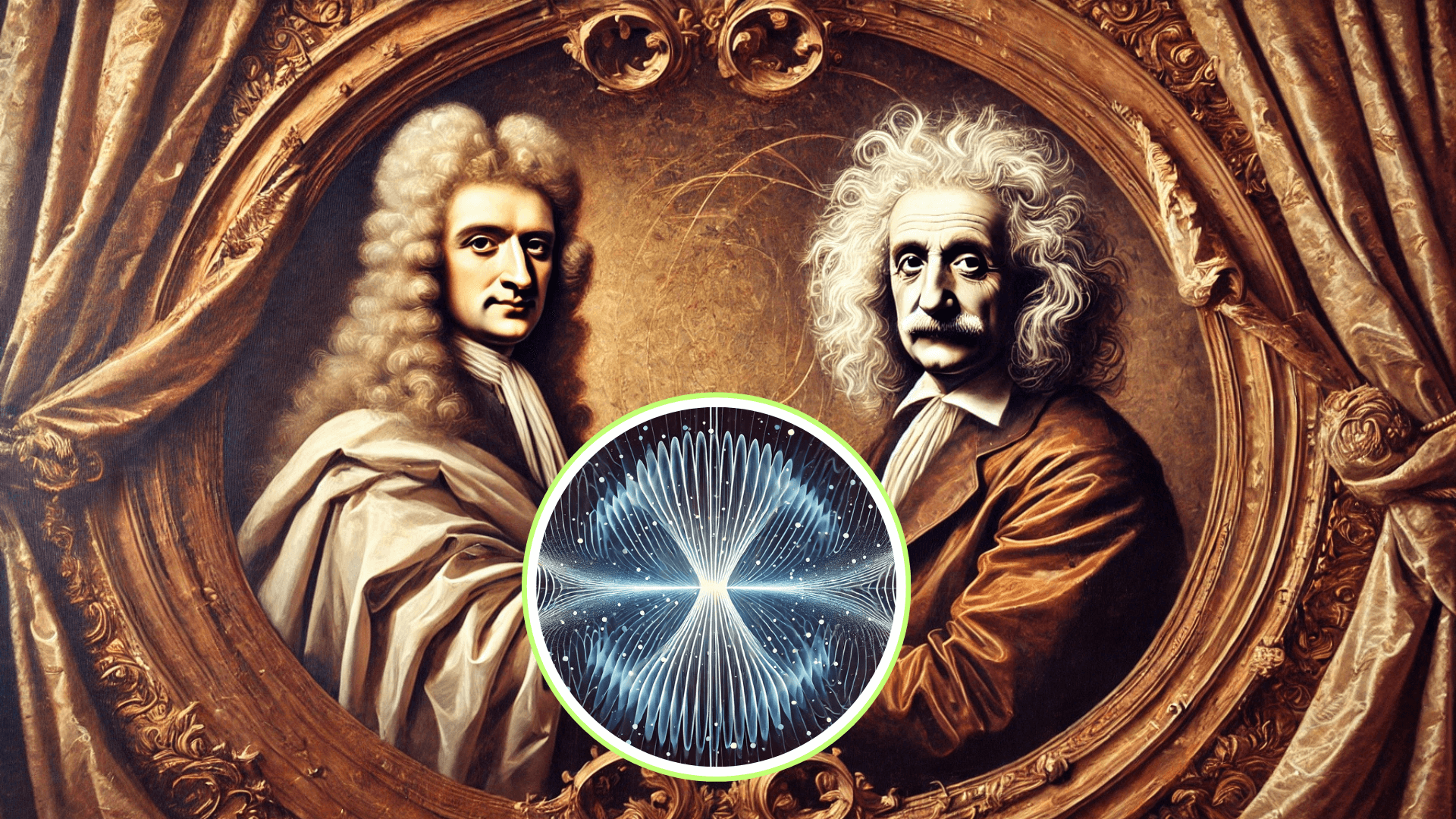

Así que, la vieja idea de Newton de que la luz estaba formada por partículas, en contra de la teoría ondulatoria de su contemporáneo Huygens corroborada por posteriores experimentos en el siglo XIX y por la teoría electromagnética de Maxwell, volvía a ser vigente en parte. La radiación electromagnética estaba formada por paquetes de energía llamados fotones, tenía una doble naturaleza: ondulatoria y corpuscular. La doble naturaleza ondulatoria y corpuscular de la luz, hizo pensar al físico francés Louis de Broglie que el resto de partículas podían disfrutar de esa cualidad y estableció que cualquier partícula lleva asociada una onda de longitud igual al cuanto de acción (h) dividido por su masa y por su velocidad (cualquier objeto macroscópico también tiene su onda asociada, pero debido al valor tan pequeño del cuanto de acción su efecto es despreciable). De hecho, cuando se diseña un experimento, dependiendo de las restricciones que se impongan a la partícula se pone de manifiesto su naturaleza ondulatoria o corpuscular pero, esa es, otra historia.

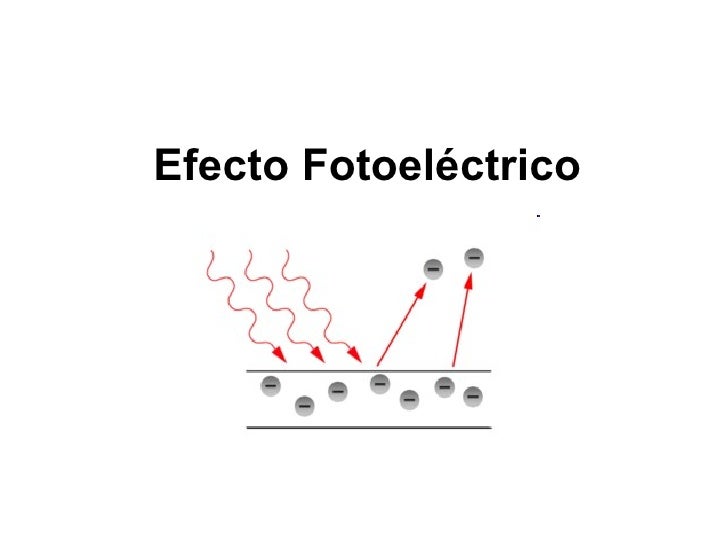

Hace tiempo que se saber que la luz tiene una dualidad onda-partícula, y se comporta como una onda (propagación, interferencia, difracción) y como una partícula (fotones, efecto fotoeléctrico) a la vez, una característica fundamental de la mecánica cuántica que depende de cómo la observes o interactúes con ella.

Primera foto de la luz como onda y partícula a la vez

Todo esto me lleva a pensar que lo que hace la Naturaleza para conseguir sus fines… ¡Es maravilloso!

¿En qué clase de universo estaríamos sin la presencia de la Luz?

El fotón en sí mismo es una maravilla, una partícula sin masa en reposo y que es la que consigue moverse a la mayor velocidad permitida en nuestro universo. ¿Es sólo energía? Pero, si es solo energía y la ecuación de E = mc2 nos dice que masa y energía son dos aspectos de la misma cosa, tendríamos que concluir que el fotón también es masa ¿No?

Planteada esta duda, me dicen:

“¡Excelente pregunta que toca el corazón de la física relativista! Sí un fotón es energía pura, pero la ecuación =2 se refiere a la energía en reposo. Un fotón tiene masa en reposo nula, por lo que toda su energía es cinética y no puede estar quieto; viaja a la velocidad de la luz (c) y su energía se define por su frecuencia, no por 2, aunque sí se cumple la equivalencia masa-energía, pero para el fotón es una masa que se manifiesta en movimiento, no en reposo, ¡una partícula sin masa intrínseca pero con una tremenda energía y momento!.

Todo esto puede ser fascinante, para nosotros es como viajar a otro “universo” sin salir de este.

Si tienes tiempo….

Emilio Silvera V.

Dic

1

¿Qué es un bosón? ¿y que es un bosón gauge?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

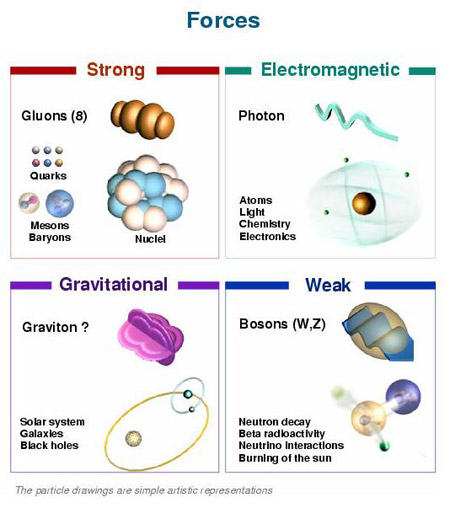

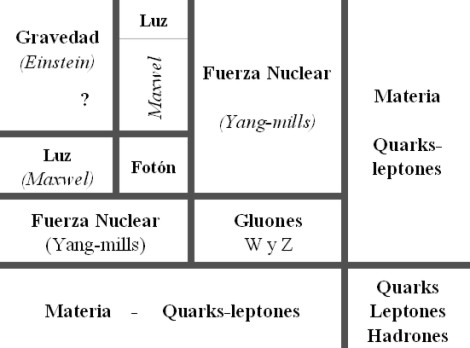

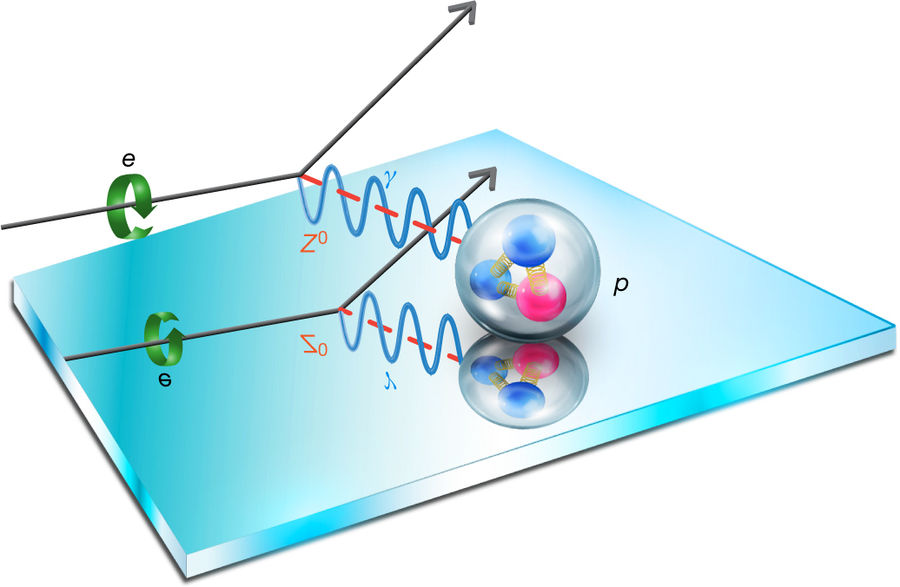

Las partículas elementales de la familia de los bosones son los mediadores de las interacciones fundamentales, Se dividen en el bosón de Higgs (escalar) y cuatro bosones vectoriales o de gauge:

Fotones ( Las radiaciones electromagnéticas transportadas por fotones son ondas de energía que abarcan un amplio espectro, incluyendo la luz visible, los rayos gamma, los rayos X, la radiación ultravioleta, el infrarrojo, las microondas y las ondas de radio. Estas radiaciones no necesitan un medio material para propagarse y se mueven a través del vacío a la velocidad de la luz.

El Gluon es el Bosón que transmite la fuerza nuclear fuerte, la cual mantiene confinados a los Quarks dentro de los Protones y los Neutrones (que son nucleones en el núcleo atómico). Es una partícula sin masa y sin carga eléctrica, pero con carga de color, que le permite interactuar consigo misma.

Decaimiento β– de un núcleo. Se ilustra cómo uno de los neutrones se convierte en un protón a la vez que emite un electrón (β–) y un anti-neutrino electrónico.

Las partículas que transmiten la fuerza nuclear débil son los bosones W± y Zº. Esta fuerza es responsable de fenómenos como la desintegración beta, que permite que una partícula cambie su “sabor”, como cuando un neutrón se transforma en un protón. El bosón W está cargado y el bosón Z es neutro y al ser partículas muy masivas, su alcance es extremadamente corto, solo dentro del núcleo atómico.

Un bosón es una partícula elemental (o estado ligado de partículas elementales, por ejemplo, un núcleo atómico o átomo) con espín entero, es decir, una partícula que obedece a la estadística de Bose-Einstein (estadística cuántica), de la cual deriva su nombre. Los bosones son importantes para el Modelo estándar de las partículas. Son bosones vectoriales de espín uno que hacen de intermediarios de las interacciones gobernadas por teorías gauge.

En física se ha sabido crear lo que se llama el Modelo estándar y, en él, los Bosones quedan asociados a las tres fuerzas que lo conforman, el fotón es el Bosón intermediario del electromagnetismo, los W+, w– y Zº son bosones gauge que transmiten la fuerza en la teoría electrodébil, mientras que los gluones son los bosones de la fuerza fuerte, los que se encargan de tener bien confinados a los Quarks conformando protones y neutrones para que el núcleo del átomo sea estable. La Gravedad, no se ha dejado meter en el modelo y, por eso su bosón no es de gauge. El gravitón que sería la partícula mediadora de la gravitación sería el hipotético cuanto de energía que se intercambia en la interacción gravitacional.

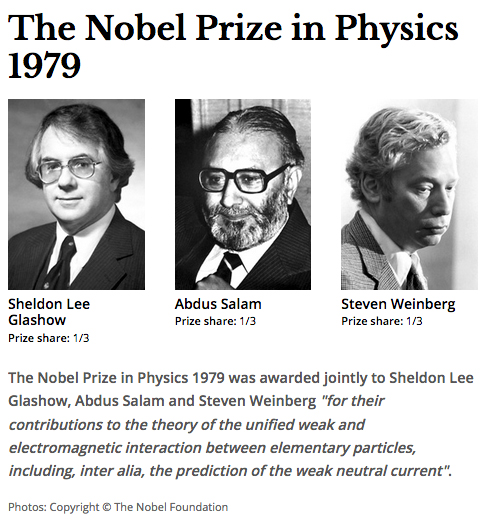

Ejemplos de los Bosones gauge son los fotones en electro-dinámica cuántica (en física, el fotón se representa normalmente con el símbolo  , que es la letra griega gamma), los gluones en cromodinámica cuántica y los bosones W y Z en el modelo de Weinberg-Salam en la teoría electrodébil que unifica el electromagnetismo con la fuerza débil. Si la simetría gauge de la teoría no está rota, el bosón gauge es no masivo. Ejemplos de bosones gauge no masivos son el fotón y el gluon.

, que es la letra griega gamma), los gluones en cromodinámica cuántica y los bosones W y Z en el modelo de Weinberg-Salam en la teoría electrodébil que unifica el electromagnetismo con la fuerza débil. Si la simetría gauge de la teoría no está rota, el bosón gauge es no masivo. Ejemplos de bosones gauge no masivos son el fotón y el gluon.

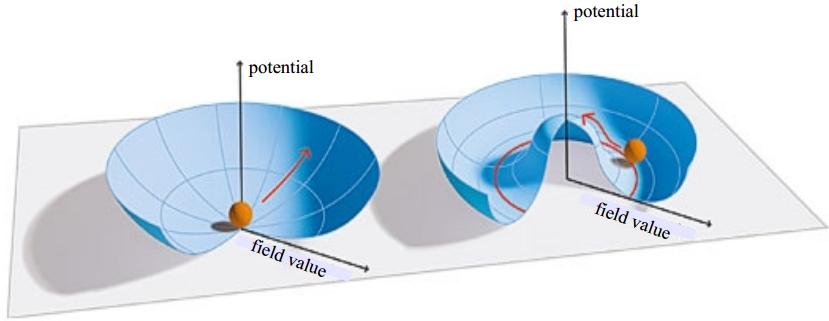

Si la simetría gauge de la teoría es una simetría rota el bosón gauge tiene masa no nula, ejemplo de ello son los bosones W y Z . Tratando la Gravedad, descrita según la teoría de la relatividad general, como una teoría gauge, el bosón gauge sería el gravitón, partícula no masiva y de espín dos.

Diagrama de Feynman mostrando el intercambio de un fotón virtual (simbolizado por una línea ondulada y  ) entre un positrón y un electrón.De esta manera podemos llegar a comprender la construcción que se ha hecho de las interacciones que están siempre intermediadas por un nosón mensajero de la fuerza.

) entre un positrón y un electrón.De esta manera podemos llegar a comprender la construcción que se ha hecho de las interacciones que están siempre intermediadas por un nosón mensajero de la fuerza.

En el modelo estándar, como queda explicado, hay tres tipos de bosones de gauge: fotones, bosones W y Z y gluones. Cada uno corresponde a tres de las cuatro interacciones: fotones son los bosones de gauge de la interacciones electromagnética, los bosones W y Z traen la interacción débil, los gluones transportan la interacción fuerte. El gravitón, que sería responsable por la interacción gravitacional, es una proposición teórica que a la fecha no ha sido detectada. Debido al confinamiento del color, los gluones aislados no aparecen a bajas energías.

Aquí, en el gráfico, quedan representadas todas las partículas del Modelo estándar, las familias de Quarks y Leptones que conforman la materia y los bones que intermedian en las interacciones o fuerzas fundamentales que están presentes en el Universo. La Gravedad no ha podido ser incluida y se ha negado a estar unida a las otras fuerzas. Así el bosón que la transnmite, tampoco está en el modelo que es incompleto al dejar fuera la fuerza que mantiene unidos los planetas en los sistemas solares, a las galaxias en los cúmulos y nuestros pies unidos a la superficie del planeta que habitamos. Se busca una teoría que permita esta unión y, los físicos, la laman gravedad cuántica pero… ¡no aparece por ninguna parte!

Llegados a este punto tendremos que retroceder, para poder comprender las cosas, hasta aquel trabajo de sólo ocho páginas que publicó Max Planck en 1.900 y lo cambió todo. El mismo Planck se dio cuenta de que, todo lo que él había tenido por cierto durante cuarenta años, se derrumbaba con ese trabajo suyo que, venía a decirnos que el mundo de la materia y la nergía estaba hecho a partir de lo que el llamaba “cuantos”.

de que, todo lo que él había tenido por cierto durante cuarenta años, se derrumbaba con ese trabajo suyo que, venía a decirnos que el mundo de la materia y la nergía estaba hecho a partir de lo que el llamaba “cuantos”.

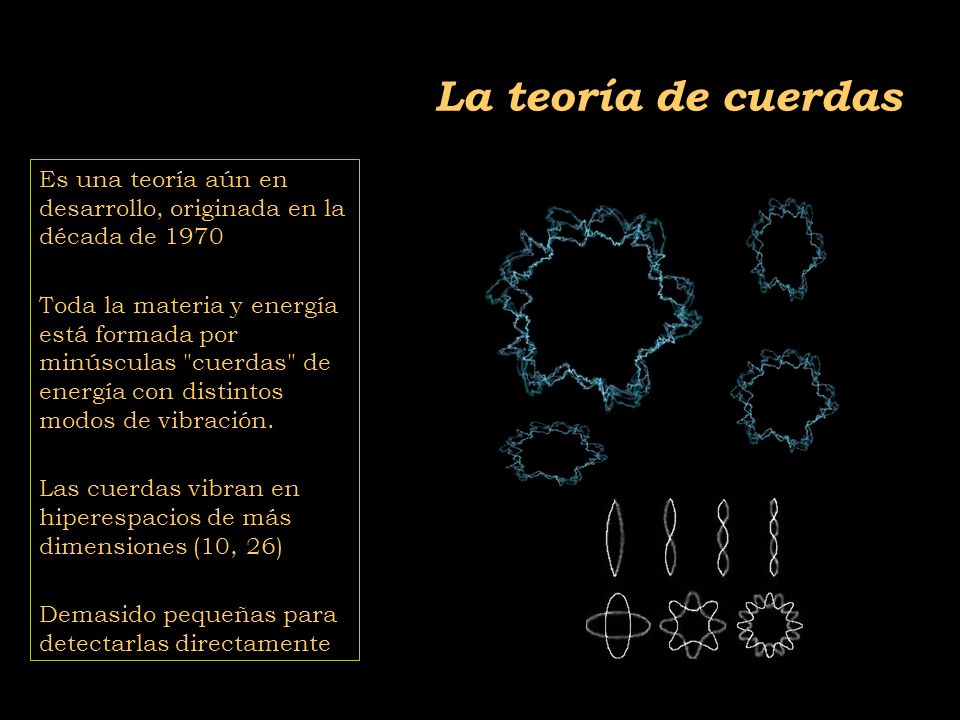

Supuso el nacimiento de la Mecánica Cuántica (MC), el fin del determinismo clásico y el comienzo de una nueva física, la Física Moderna, de la que la Cuántica sería uno de sus tres pilares junto con la Relatividad y la Teoría del Caos. Más tarde, ha aparecido otra teoría más moderna aún por comprobar, ¿las cuerdas…?

El universo según la teoría de las cuerdas sería entonces una completa extensa polícroma SINFONIA ETERNA de vibraciones, un multiverso infinito de esferas, cada una de ellas un universo independiente causalmente, en una de esas esferas nuestra Vía Láctea, en ella nuestro sistema solar, en él nuestro planeta, el planeta tierra en el cual por una secuencia milagrosa de hechos se dio origen a la vida autoconsciente que nos permite preguntarnos del cómo y del por qué de todas las cosas que podemos observar y, también, de las que intuimos que están ahí sin que se dejen ver.

una de ellas un universo independiente causalmente, en una de esas esferas nuestra Vía Láctea, en ella nuestro sistema solar, en él nuestro planeta, el planeta tierra en el cual por una secuencia milagrosa de hechos se dio origen a la vida autoconsciente que nos permite preguntarnos del cómo y del por qué de todas las cosas que podemos observar y, también, de las que intuimos que están ahí sin que se dejen ver.

Claro que, cuando nos adentramos en ese minúsculo “mundo” de lo muy pequeño, las cosas difieren y se apartan de lo que nos dicta el sentido común que, por otra parte, es posible que sea el menos común de los sentidos. Nos dejamos guiar por lo que observamos, por ese mundo macroscópico que nos rodea y, no somos consciente de ese otro “mundo” que está ahí formando parte del universo y que, de una manera muy importante incide en el mundo de lo grande, sin lo que allí existe, no podría existir lo que existe aquí.

común de los sentidos. Nos dejamos guiar por lo que observamos, por ese mundo macroscópico que nos rodea y, no somos consciente de ese otro “mundo” que está ahí formando parte del universo y que, de una manera muy importante incide en el mundo de lo grande, sin lo que allí existe, no podría existir lo que existe aquí.

Interacciones en la naturaleza

Albert Einstein habría dicho que “es más importante la imaginación que el conocimiento”, el filósofo Nelson Goodman ha dicho que “las formas y las leyes de nuestros mundos no se encuentran ahí, ante nosotros, listas para ser descubiertas, sino que vienen impuestas por las versiones-del-mundo que nosotros inventamos – ya sea en las ciencias, en las artes, en la percepción y en la práctica cotidiana-.”

ser descubiertas, sino que vienen impuestas por las versiones-del-mundo que nosotros inventamos – ya sea en las ciencias, en las artes, en la percepción y en la práctica cotidiana-.”

Sin embargo yo, humilde pensador, me decanto por el hecho cierto de que, nuestra especie, siempre llegó al conocimiento a través de la imaginación y la experiencia primero, a la que más tarde, acompañó largas secciones de estudio y muchas horas de mediatación y, al final de todo eso, llego la experimentación que hizo posible llegar a lugarés ignotos que antes nunca, habían podido ser visitados. De todo ello, pudieron surgir todos esos “nuevos mundos” que, como la Mecanica Cuántica y la Relatividad, nos describían el propio mundo que antes nos era desconocido.

nos era desconocido.

Cuando comencé éste trabajo sólo quería dar una simple explicación de los bosones y su intervención en el mundo de lo muy pequeño pero…

Demócrito de Abdera

No estaría mal echar una mirada hacia atrás en el tiempo y recordar, en este momento, a Demócrito que, con sus postulados, de alguna manera venía a echar un poco de luz sobre el asunto, dado que él decía que para determinar si algo era un á-tomo habría que ver si era indivisible. En el modelo de los quarks, el protón, en realidad, un conglomerado pegajoso de tres quarks que se mueven rápidamente. Pero como esos quarks están siempre ineludiblemente encadenados los unos a los otros, experimentalmente el protón aparece indivisible.

Acordémonos aquí de que Boscovich decía que, una partícula elemental, o un “á-tomo”, tiene que ser puntual. Y, desde luego, esa prueba , no la pasaba el protón. El equipo del MIT y el SLAC, con la asesoría de Feynman y Bjorken, cayó en la cuenta de que en este caso el criterio operativo era el de los “puntos” y no el de la indivisibilidad. La traducción de sus datos

, no la pasaba el protón. El equipo del MIT y el SLAC, con la asesoría de Feynman y Bjorken, cayó en la cuenta de que en este caso el criterio operativo era el de los “puntos” y no el de la indivisibilidad. La traducción de sus datos a un modelo de constituyentes puntuales requería una sutileza mucho mayor que el experimento de Rutherford.

a un modelo de constituyentes puntuales requería una sutileza mucho mayor que el experimento de Rutherford.

Precisamente por eso era tan conveniente fue tan conveniente para Richard Edward Taylor y su equipo, tener a dos de los mejores teóricos del mundo en el equipo aportando su ingenio, agudeza e intuición en todas las fases del proceso experimental. El resultado fue que los datos indicaron, efectivamente, la presencia de objetos puntuales en movimiento dentro del protón.

indicaron, efectivamente, la presencia de objetos puntuales en movimiento dentro del protón.

En 1990 Taylor, Friedman y Kendall recogieron su premio Nobel por haber establecido la realidad de los quarks. Sin embargo, a mí lo que siempre me ha llamado más la atención es el hecho cierto de que, este descubrimiento como otros muchos (el caso del positrón de Dirac, por ejemplo), han sido posible gracias al ingenio de los teóricos que han sabido vislumbrar cómo era en realidad la Naturaleza.

posible gracias al ingenio de los teóricos que han sabido vislumbrar cómo era en realidad la Naturaleza.

A todo esto, una buena pregunta sería: ¿Cómo pudieron ver este tipo de partículas de tamaño infinitesimal, si los quarks no están libres y están confinados -en este caso- dentro del protón? Hoy, la respuesta

sería: ¿Cómo pudieron ver este tipo de partículas de tamaño infinitesimal, si los quarks no están libres y están confinados -en este caso- dentro del protón? Hoy, la respuesta tiene poco misterio sabiendo lo que sabemos y hasta donde hemos llegado con el LHC que, con sus inmensas energías “desmenuza” un protón hasta dejar desnudos sus más íntimos secretos.

tiene poco misterio sabiendo lo que sabemos y hasta donde hemos llegado con el LHC que, con sus inmensas energías “desmenuza” un protón hasta dejar desnudos sus más íntimos secretos.

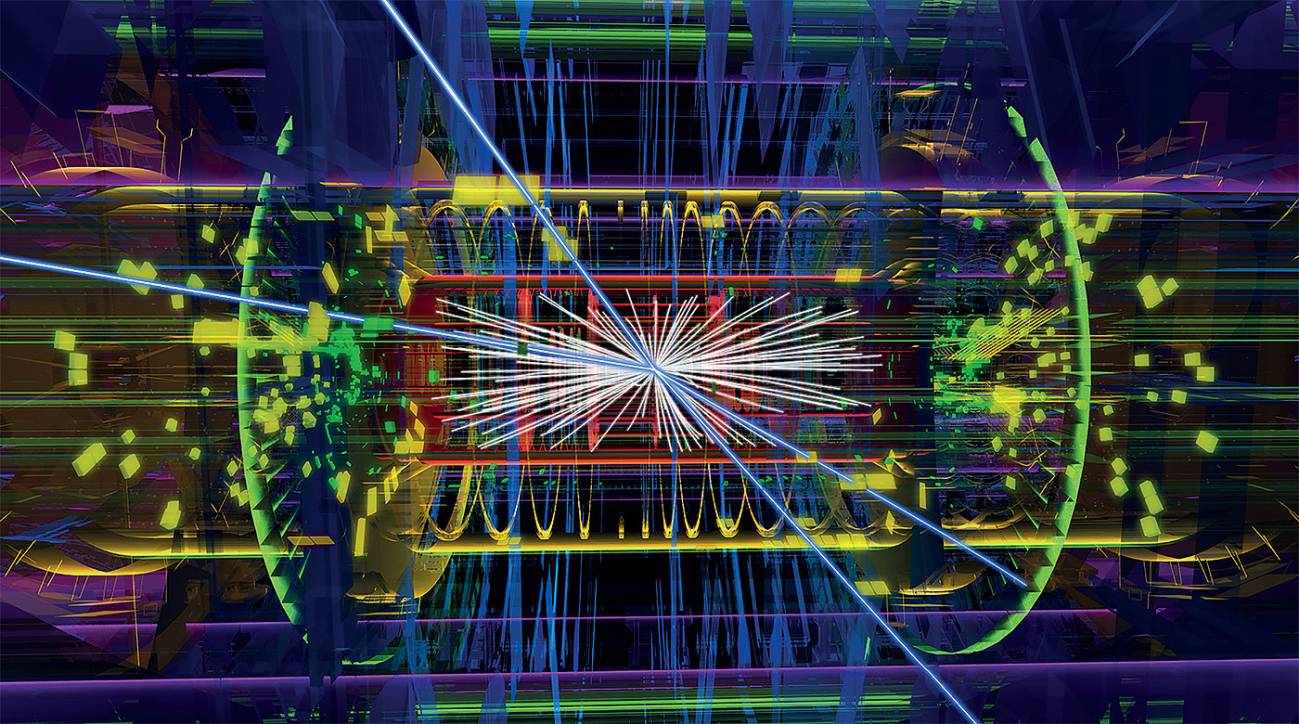

Este es, el resultado ahora de la colisión de protones en el LHC

Lo cierto es que, en su momento, la teoría de los Quarks hizo muchos conversos, especialmente a medida que los teóricos que escrutaban los datos fueron imbuyendo a los quarks una realidad creciente, conociendo mejor sus propiedades y convirtiendo la incapacidad de ver quarks libres en una virtud. La palabra

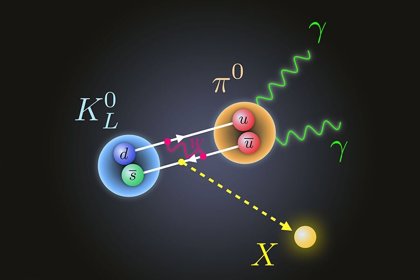

fueron imbuyendo a los quarks una realidad creciente, conociendo mejor sus propiedades y convirtiendo la incapacidad de ver quarks libres en una virtud. La palabra de moda en aquellos momentos era “confinamiento”. Los Quarks están confinados permanentemente porque la energía requerida para separarlos aumenta a medida que la distancia entre ellos crece. Esa es, la fuerza nuclear fuerte que está presente dentro del átomo y que se encarga de transmitir los ocho Gluones que mantienen confinados a los Quarks.

de moda en aquellos momentos era “confinamiento”. Los Quarks están confinados permanentemente porque la energía requerida para separarlos aumenta a medida que la distancia entre ellos crece. Esa es, la fuerza nuclear fuerte que está presente dentro del átomo y que se encarga de transmitir los ocho Gluones que mantienen confinados a los Quarks.

Así, cuando el intento de separar a los Quarks es demasiado intenso, la energía se vuelve lo bastante grande para crear un par de quark-anti-quark, y ya tenemos cuatro quarks, o dos mesones. Es como intentar conseguir un cabo de cuerda. Se corta y… ¡ya tenemos dos!

un cabo de cuerda. Se corta y… ¡ya tenemos dos!

¿Cuerdas? Me parece que estoy confundiendo el principal objetivo de este trabajo y, me quiero situar en el tiempo futuro que va, desde los quarks de Gell-Mann hasta las cuerdas de Veneziano y John Schwarz y más tarde Witten. Esto de la Física, a veces te juega malas pasadas y sus complejos caminos te llevan a confundir conceptos y momentos que, en realidad, y de manera individualizada, todos han tenido su propio tiempo y lugar.

¿Cuántas veces no habré pensado, en la posibilidad de tomar el elixir de la sabiduría para poder comprenderlo todo? Sin embargo, esa pócima mágica no existe y, si queremos saber , el único camino que tenemos a nuestro alcance es la observación, el estudio, el experimento… ¡La Ciencia!, que en definitiva, es la única que nos dirá como es, y como se producen los fenómenos que podemos contemplar en la Naturaleza y, si de camino, podemos llegar a saber el por qué de su comportamiento… ¡mucho mejor!

, el único camino que tenemos a nuestro alcance es la observación, el estudio, el experimento… ¡La Ciencia!, que en definitiva, es la única que nos dirá como es, y como se producen los fenómenos que podemos contemplar en la Naturaleza y, si de camino, podemos llegar a saber el por qué de su comportamiento… ¡mucho mejor!

El camino será largo y, a veces, penoso pero… ¡llegaremos!

Nuestra insaciable curiosidad nos llevará lejos en el saber del “mundo”. llegaremos al corazón mismo de la materia para comprobar si allí, como algunos imaginan, habitan las cuerdas vibrantes escondidas tan profundamente que no se dejan ver. Sabremos de muchos mundos habitados y podremos hacer ese primer contacto tantas veces soñado con otros seres que, lejos de nuestro región del Sistema solar, también, de manera independiente y con otros nombres, descubrieron la cuántica y la relatividad. Sabremos al fín qué es la Gravedad y por qué no se dejaba juntar con la cuántica. Podremos realizar maravillas que ahora, aunque nuestra imaginación es grande, ni podemos intuir por no tener la información necesaria que requiere la imaginación.

En fin, como decía Hilbert: ¡”Tenemos que saber, sabremos”!

Emilio Silvera V.

Nov

16

Hoy un sueño ¿Realidad mañana?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Seguramente, como hemos podido ver en una película de ciencia ficción, llegará un día en el que, podremos entrar en una inmensa habitación de hologramas, en la que, previa elección de la programación adecuada, todo se transformará en un “mundo ficticio” que, lo mismo podrá ser una playa luminosa con arena dorada, una Selva tropical o un desierto, dependiendo de los gustos del usuario.

Si repasamos la historia de la ciencia, seguramente encontraremos muchos motivos para el optimismo. Witten (el Físico de la Teoría M), está convencido de que la ciencia será algún día capaz de sondear hasta las energías de Planck. Como ya he contado en otras ocasiones, él dijo:

“No siempre es tan fácil decir cuáles son las preguntas fáciles y cuáles las difíciles. En el siglo XIX, la pregunta de por qué el agua hierve a 100 grados era desesperadamente inaccesible. Si usted hubiera dicho a un físico del siglo XIX que hacia el siglo XX sería capaz de calcularlo, le habría parecido un cuento de hadas… La teoría cuántica de campos es tan difícil que nadie la creyó completamente durante 25 años.”

Claro que, para verificar esta Teoría, se necesita disponer de la energía de Planck, es decir 1019 GeV. Esa energía no la tenemos ni reuniendo todas las disponibles por todos los Gobiernos de nuestro mundo. Es la energía de la creación que, no creo que nunca la podamos dominar.

En su opinión, las buenas ideas siempre se verifican. Los ejemplos son innumerables: la gravedad de Newton, el campo eléctrico de Faraday y el electromagnetismo de Maxwell, la teoría de la relatividad de Einstein en sus dos versiones y su demostración del efecto fotoeléctrico, la teoría del electrón de Paul Dirac, el principio de incertidumbre de Heisenberg, la función de ondas de Schrödinger, el Principio de exclusión de Pauli para los fermiones y tantos otros. Algunos de los físicos teóricos más famosos, sin embargo, protestaban de tanto empeño en la experimentación. El astrónomo Arthur Eddington se cuestionaba incluso si los científicos no estaban forzando las cosas cuando insistían en que todo debería ser verificado.

Sin embargo, muchos son los ejemplos de un ingenio superior que nos llevaron a desvelar secretos de la Naturaleza que estaban profundamente escondidos, y, el trabajo de Dirac en relación al electrón, es una buena muestra de ese ingenio humano que, de vez en cuando vemos florecer.

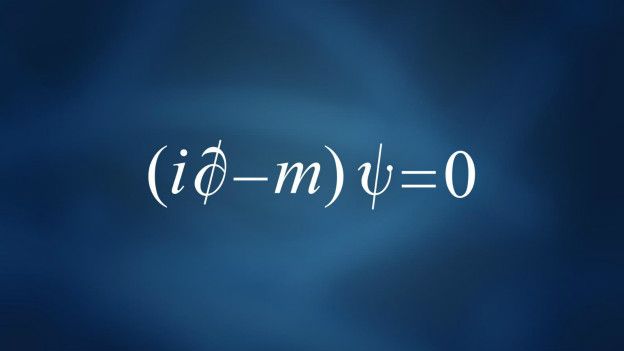

Siendo m la masa en reposo del electrón, c la velocidad de la luz, p el operador de momento,  la constante reducida de Planck, x y t las coordenadas del espacio y el tiempo, respectivamente; y ψ (x, t) una función de onda de cuatro componentes. La función de onda ha de ser formulada como un espinor (objeto matemático similar a un vectorque cambia de signo con una rotación de 2π descubierto por Pauli y Dirac) de cuatro componentes, y no como un simple escalar, debido a los requerimientos de la relatividad especial. Los α son operadores lineales que gobiernan la función de onda, escritos como una matriz y son matrices de 4×4 conocidas como matrices de Dirac.

la constante reducida de Planck, x y t las coordenadas del espacio y el tiempo, respectivamente; y ψ (x, t) una función de onda de cuatro componentes. La función de onda ha de ser formulada como un espinor (objeto matemático similar a un vectorque cambia de signo con una rotación de 2π descubierto por Pauli y Dirac) de cuatro componentes, y no como un simple escalar, debido a los requerimientos de la relatividad especial. Los α son operadores lineales que gobiernan la función de onda, escritos como una matriz y son matrices de 4×4 conocidas como matrices de Dirac.

“Es una ecuación muy poderosa por lo que significa y su papel en la historia de la física del siglo XX”.

La ecuación fue descubierta a finales de los años 20 por el físico Paul Dirac, y juntó dos de las ideas más importantes de la ciencia: la mecánica cuántica, que describe el comportamiento de objetos muy pequeños; y la teoría especial de Einstein de la relatividad, que describe el comportamiento de objetos en movimiento rápido.

Por lo tanto, la ecuación de Dirac describe cómo las partículas como electrones se comportan cuando viajan a casi la velocidad de la luz.

El premio Nobel Paul Dirac incluso llegó a decir de forma más categórica: “Es más importante tener belleza en las ecuaciones que tener experimentos que se ajusten a ellas“, o en palabras del físico John Ellis del CERN, “Como decía en una envoltura de caramelos que abrí hace algunos años, «Es sólo el optimista el que consigue algo en este mundo».“

Yo, como todos ustedes, un hombre normal y corriente de la calle, escucho a unos y a otros, después pienso en lo que dicen y en los argumentos y motivaciones que les han llevado a sus respectivos convencimientos, y finalmente, también decido según mis propios criterios mi opinión, que no obligatoriamente coincidirá con alguna de esas opiniones, y que en algún caso, hasta me permito emitirla.

Niveles de aumento de la materia:

- Materia.

- Estructura molecular.

- Átomos.

- Electrones.

- Quarks.

- ¿Cuerdas.?

Suponiendo que algún físico brillante nos resuelva la teoría de campos de cuerdas y derive las propiedades conocidas de nuestro universo, con un poco de suerte, podría ocurrir en este mismo siglo, lo que no estaría nada mal considerando las dificultades de la empresa. El problema fundamental es que estamos obligando a la teoría de cuerdas a responder preguntas sobre energías cotidianas, cuando su “ámbito natural” está en la energía de Planck. Esta fabulosa energía fue liberada sólo en el propio instante de la creación, lo que quiere decir que la teoría de supercuerdas es naturalmente una teoría de la creación.

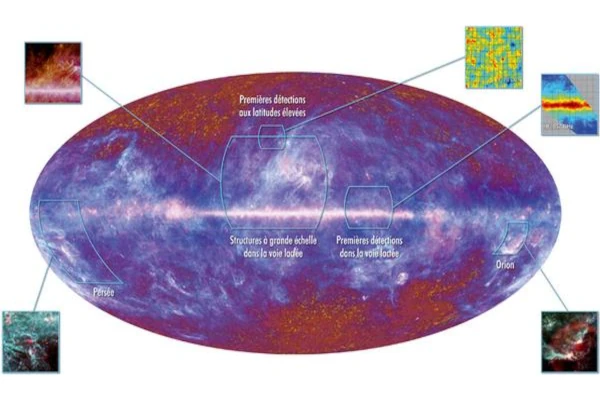

Las primeras observaciones realizadas por Planck | ESA y Axel Mellinger.

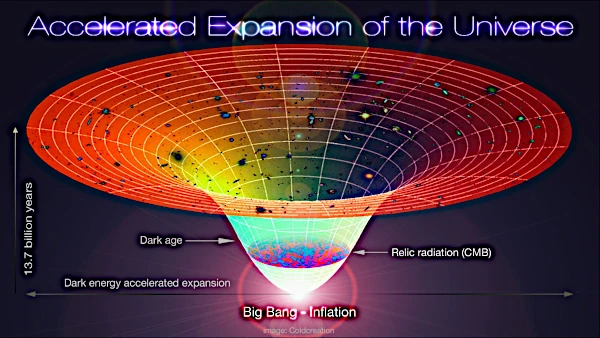

Fuimos capaces de predecir que el Big Bang produjo un “eco” cósmico reverberando en el universo y que podría ser mesurable por los instrumentos adecuados. De hecho, Arno Penzias y Robert Wilson de los Bell Telephone Laboratories ganaron el premio Nobel en 1.978 por detectar este eco del Big Bang, una radiación de microondas que impregna el universo conocido. El que el eco del Big Bang debería estar circulando por el universo miles de millones de años después del suceso fue predicho por primera vez por George Gamow y sus discípulos Ralpher y Robert Herman, pero nadie les tomó en serio.

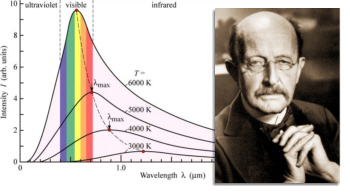

La propia idea de medir el eco de la creación parecía extravagante cuando la propusieron por primera vez poco después de la segunda guerra mundial. Su lógica, sin embargo, era aplastante. Cualquier objeto, cuando se calienta, emite radiación de forma gradual. Ésta es la razón de que el hierro se ponga al rojo vivo cuando se calienta en un horno, y cuanto más se calienta, mayor es la frecuencia de radiación que emite. Una fórmula matemática exacta, la ley de Stefan-Boltzmann, relaciona la frecuencia de la luz (o el color en este caso) con la temperatura. De hecho, así es como los científicos determinan la temperatura de la superficie de una estrella lejana; examinando su color. Esta radiación se denomina radiación de cuerpo negro.

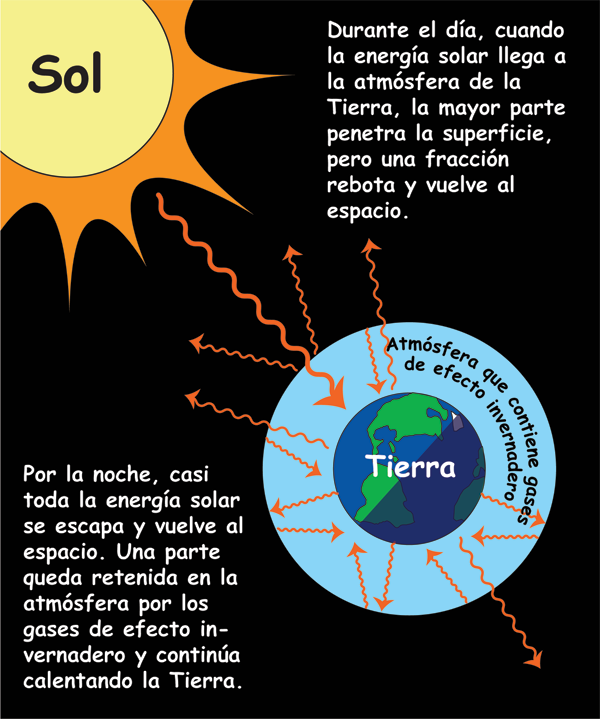

Esta radiación, cómo no, ha sido aprovechada por los ejércitos, que mediante visores nocturnos pueden operar en la oscuridad. De noche, los objetos relativamente calientes, tales como soldados enemigos o los carros de combate, pueden estar ocultos en la oscuridad, pero continúan emitiendo radiación de cuerpo negro invisible en forma de radiación infrarroja, que puede ser captada por gafas especiales de infrarrojo. Ésta es también la razón de que nuestros automóviles cerrados se calientes en verano, ya que la luz del Sol atraviesa los cristales del coche y calienta el interior. A medida que se calienta, empieza a emitir radiación de cuerpo negro en forma de radiación infrarroja. Sin embargo, esta clase de radiación no atraviesa muy bien el vidrio, y por lo tanto queda atrapada en el interior del automóvil, incrementando espectacularmente la temperatura.

Análogamente, la radiación de cuerpo negro produce el efecto invernadero. Al igual que el vidrio, los altos niveles de dióxido de carbono en la atmósfera, causados por la combustión sin control de combustibles fósiles, pueden atrapar la radiación de cuerpo negro infrarroja en la Tierra, y de este modo calentar gradualmente el planeta.

Gamow razonó que el Big Bang era inicialmente muy caliente, y que por lo tanto sería un cuerpo negro ideal emisor de radiación. Aunque la tecnología de los años cuarenta era demasiado primitiva para captar esta débil señal de la creación, Gamow pudo calcular la temperatura de dicha radiación y predecir con fiabilidad que un día nuestros instrumentos serían lo suficientemente sensibles como para detectar esta radiación “fósil”.

La lógica que había detrás de su razonamiento era la siguiente: alrededor de 300.000 años después del Big Bang, el universo se enfrió hasta el punto en el que los átomos pudieron empezar a componerse; los electrones pudieron empezar a rodear a los protones y neutrones formando átomos estables, que ya no serían destruidos por la intensa radiación que estaba impregnando todo el universo. Antes de este momento, el universo estaba tan caliente que los átomos eran inmediatamente descompuestos por esa radiación tan potente en el mismo acto de su formación. Esto significa que el universo era opaco, como una niebla espesa absorbente e impenetrable.

Pasados 300.000 años, la radiación no era tan potente; se había enfriado y por lo tanto la luz podía atravesar grades distancias sin ser dispersada. En otras palabras, el universo se hizo repentinamente negro y transparente.

- Función:

- Absorción: La radiación que entra en el orificio tiene una alta probabilidad de ser absorbida, ya que, al entrar, rebota en las paredes internas del recinto y no tiene salida fácil.

- Emisión: La radiación que emite este orificio es una buena representación de la radiación térmica del interior de la cavidad, como si fuera un cuerpo negro .

Terminaré esta parte comentando que un auténtico cuerpo negro es un concepto imaginario; un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica.

La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la disminución de energías sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumentar las temperaturas*.

Hablar, sin más especificaciones, de radiación, es estar refiriéndonos a una energía que viaja en forma de ondas electromagnéticas o fotones por el universo. También nos podríamos estar refiriendo a un chorro de partículas, especialmente partículas alfa o beta de una fuente radiactiva o neutrones de un reactor nuclear.

La radiación actínida es la electromagnética que es capaz de iniciar una reacción química. El término es usado especialmente para la radiación ultravioleta y también para denotar radiación que podría afectar a las emulsiones fotográficas.

Radiación blanda, radiación cósmica, radiación de calor, radiación de fondo, de fondo de microondas, radiación dura, electromagnética, radiación gamma, infrarroja, ionizante, monocromática, policromática, de sincrotrón, ultravioleta, de la teoría cuántica, de radiactividad… y, como se puede ver, la radiación en sus diversas formas es un universo en sí misma.

Siempre me llamó la atención y se ganó mi admiración el físico alemán Max Planck (1.858 – 1.947), responsable entre otros muchos logros de la ley de radiación de Planck, que da la distribución de energía radiada por un cuerpo negro. Introdujo en física el concepto novedoso de que la energía es una cantidad que es radiada por un cuerpo en pequeños paquetes discretos, en vez de una emisión continua. Estos pequeños paquetes se conocieron como cuantos y la ley formulada es la base de la teoría cuántica.

Einstein se inspiró en este trabajo para a su vez presentar el suyo propio sobre el efecto fotoeléctrico, donde la energía máxima cinética del fotoelectrón, Em, está dada por la ecuación que lleva su nombre: Em = hf – Φ.

Cada metal requiere, para que se produzca la extracción, una radiación con una frecuencia mínima (no). Cualquier otra radiación de menor frecuencia, no será capaz de arrancar electrones. Por debajo de la frecuencia mínima la intensidad de corriente -”i” (amperios)- será cero. No hay efecto fotoeléctrico.

Con su amigo Max Planck

En 1905, el mismo año que formuló su teoría de la relatividad especial, Albert Einstein propuso una descripción matemática de este fenómeno que parecía funcionar correctamente y en la que la emisión de electrones era producida por la absorción de cuantos de luz que más tarde serían llamados fotones. En un artículo titulado “Un punto de vista heurístico sobre la producción y transformación de la luz” mostró cómo la idea de partículas discretas de luz podía explicar el efecto fotoeléctrico y la presencia de una frecuencia característica para cada material por debajo de la cual no se producía ningún efecto. Por esta explicación del efecto fotoeléctrico Einstein recibiría el Premio Nobel de Física de 1921.

La semilla de la Mecánica cuántica

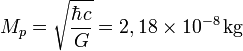

Planck publicó en 1.900 un artículo sobre la radiación de cuerpo negro que sentó las bases para la teoría de la mecánica cuántica que más tarde desarrollaron otros, como el mismo Einstein, Heisenberg, Schrödinger, Dirac, Feymann, etc. Todos los físicos son conocedores de la enorme contribución que Max Planck hizo en física: la constante de Planck, radiación de Planck, longitud de Planck, unidades de Planck, etc. Es posible que sea el físico de la historia que más veces ha dado su nombre a conceptos de física. Pongamos un par te ejemplos de su ingenio:

1. vale 10-35 metros. Esta escala de longitud (veinte órdenes de magnitud menor que el tamaño del protón, de 10-15 m) es a la que la descripción clásica de gravedad cesa de ser válida y debe ser tenida en cuenta la mecánica cuántica. En la fórmula que la describe, G es la constante gravitacional, ħ es la constante de Planck racionalizada y c en la velocidad de la luz.

2. . Es la masa de una partícula cuya longitud de onda Compton es igual a la longitud de Planck. En la ecuación, ħ es la constante de Planck racionalizada, c es la velocidad de la luz y G es la constante gravitacional. Así, Se denomina masa de Planck a la cantidad de masa (21,7644 microgramos) que, incluida en una esfera cuyo radio fuera igual a la longitud de Planck, generaría una densidad del orden de 1093 g/cm³. Según la física actual, esta habría sido la densidad del Universo cuando tenía unos  segundos, el llamado Tiempo de Planck. Su ecuación, es decir la masa de Planck se denota:

segundos, el llamado Tiempo de Planck. Su ecuación, es decir la masa de Planck se denota:

El valor de la masa de Planck  se expresa por una fórmula que combina tres constantes fundamentales, la constante de Planck, (h), la velocidad de la luz (c), y la constante de gravitación universal (G). La masa de Planck es una estimación de la masa del agujero negro primordial menos masivo, y resulta de calcular el límite donde entran en conflicto la descripción clásica y la descripción cuántica de la gravedad.

se expresa por una fórmula que combina tres constantes fundamentales, la constante de Planck, (h), la velocidad de la luz (c), y la constante de gravitación universal (G). La masa de Planck es una estimación de la masa del agujero negro primordial menos masivo, y resulta de calcular el límite donde entran en conflicto la descripción clásica y la descripción cuántica de la gravedad.

“Aunque todas estas descripciones reflejan más una abundante imaginación que un hecho existencial apoyado teóricamente con alguna hipótesis que pueda ser comprobada en el laboratorio sobre hechos que están más allá de poder ser medidos jamás en algún laboratorio construido por humanos. La única forma de confrontar la factibilidad o la posibilidad del modelo de la espuma cuántica nos lleva necesariamente a confrontar la carencia de un modelo que logre unificar exitosamente al macrocosmos con el microcosmos, a la Relatividad General con la Mecánica Cuántica, la Gravedad Cuántica. Si la energía y la materia (o mejor dicho la masa-energía) están discretizadas, se supone que también deben de estarlo el espacio y el tiempo (o mejor dicho, el espacio-tiempo), y la “partícula fundamental” del espacio-tiempo debe de serlo el gravitón, aunque de momento todo esto son especulaciones que seguirán siéndolo mientras no tengamos a la mano algo que pueda confirmar la existencia de tan exótica partícula, quizá la más exótica de cuantas hayan sido concebidas por la imaginación del hombre.”

La descripción de una partícula elemental de esta masa, o partículas que interaccionan con energías por partículas equivalentes a ellas (a través de E = mc2), requiere de una teoría cuántica de la gravedad. Como la masa de Planck es del orden de 10-8 Kg (equivalente a una energía de 1019 GeV) y, por ejemplo, la masa del protón es del orden de 10-27 Kg y las mayores energías alcanzables en los aceleradores de partículas actuales son del orden de 103 GeV, los efectos de gravitación cuántica no aparecen en los laboratorios de física de partículas. Únicamente en un laboratorio aparecieron partículas que tenían energías del orden de la masa de Planck: en el universo primitivo, de acuerdo con la teoría del Big Bang, motivo éste por el que es necesaria una teoría cuántica de la gravedad para estudiar aquellas condiciones. Esta energía de la que estamos hablando, del orden de 1019 GeV (inalcanzable para nosotros), es la que necesitamos para verificar la teoría de supercuerdas.

Máquinas inmensamente grandes que nos llevaron a las entrañas de la materia

Siempre, desde que puedo recordar, me llamó la atención los misterios y secretos encerrados en la naturaleza, y la innegable batalla mantenida a lo largo de la historia por los científicos para descubrirlos. Muchos han sido los velos que hemos podido descorrer para que, la luz cegadora del saber pudiera entrar en nuestras mentes para hacerlas comprender cómo actuaba la Naturaleza en ciertas ocasiones y el por qué de tales comportamientos, y, sin embargo, a pesar del largo camino recorrido, es mucho más el que nos queda por andar.

Emilio Silvera V.

Nov

14

La vida media de las partículas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

La Mente: Ese misterio

La mente humana es tan compleja que no todos ante la misma cosa vemos lo mismo. Nos enseñan figuras y dibujos y nos piden que digamos (sin pensarlo) la primera cosa que nos sugieren. De entre diez personas, sólo coinciden tres, los otros siete divergen en la apreciación de lo que el dibujo o la figura les trae a la Mente. Un paisaje puede ser descrito de muy distintas maneras según quién nos lo pueda contar.

Solo el 1% de las formas de vida que han vivido en la Tierra están ahora presentes, el 99%, por una u otra razón se han extinguido. Sin embargo, ese pequeño tanto por ciento de la vida actual, supone unos cinco millones de especies según algunas estimaciones. La Tierra acoge a todas esas especies u palpita de vida que prolifera por doquier. Hay seres vivos por todas partes y por todos los rincones del inmenso mosaico de ambientes que constituye nuestro planeta encontramos formas de vida, cuyos diseños parecen hechos a propósito para adaptarse a su hábitat, desde las profundidades abisales de los océanos hasta las más altas cumbres, desde las espesas selvas tropicales a las planicies de hielo de los casquetes polares. Se ha estimado la edad de 3.800 millones de años desde que aparecieron los primeros “seres vivos” sobre el planeta (dato de los primeros microfósiles). Desde entonces no han dejado de aparecer más y más especies, de las que la mayoría se han ido extinguiendo. Desde el siglo XVIII en que Carlos Linneo propuso su Systema Naturae no han cesado los intentos por conocer la Biodiversidad…, de la que por cierto nuestra especie, bautizada como Homo sapiens por el propio Linneo, es una recién llegada de apenas 200.000 años.

Ahora, hablaremos de la vida media de las partículas elementales (algunas no tanto). Cuando hablamos del tiempo de vida de una partícula nos estamos refiriendo al tiempo de vida media, una partícula que no sea absolutamente estable tiene, en cada momento de su vida, la misma probabilidad de desintegrarse. Algunas partículas viven más que otras, pero la vida media es una característica de cada familia de partículas.

También podríamos utilizar el concepto de “semivida”. Si tenemos un gran número de partículas idénticas, la semivida es el tiempo que tardan en desintegrarse la mitad de ese grupo de partículas. La semivida es 0,693 veces la vida media.

Si miramos una tabla de las partículas más conocidas y familiares (fotón, electrón muón tau, la serie de neutrinos, los mesones con sus piones, kaones, etc., y, los Hadrones bariones como el protón, neutrón, lambda, sigma, psi y omega, en la que nos expliquen sus propiedades de masa, carga, espín, vida media (en segundos) y sus principales maneras de desintegración, veríamos como difieren las unas de las otras.

Algunas partículas tienen una vida media mucho más larga que otras. De hecho, la vida media difiere enormemente. Un neutrón por ejemplo, vive 10¹³ veces más que una partícula Sigma⁺, y ésta tiene una vida 10⁹ veces más larga que la partícula sigma cero. Pero si uno se da cuenta de que la escala de tiempo “natural” para una partícula elemental (que es el tiempo que tarda su estado mecánico-cuántico, o función de ondas, en evolucionar u oscilar) es aproximadamente 10ˉ²⁴ segundos, se puede decir con seguridad que todas las partículas son bastantes estables. En la jerga profesional de los físicos dicen que son “partículas estables”.

La vida media de una partícula se determina midiendo la distancia que recorre antes de desintegrarse. Para partículas de vida larga como el neutrón y el muón, se puede calcular midiendo su trayectoria en detectores como los del LHC, ya que recorren una distancia detectable antes de decaer. La vida media es una propiedad fundamental de cada partícula y se puede expresar como el tiempo que tarda la mitad de una muestra de partículas en desintegrarse, lo que se calcula a partir de la distribución de sus trayectorias.

¿Cómo se determina la vida media de una partícula? Las partículas de vida larga, tales como el neutrón y el muón, tienen que ser capturadas, preferiblemente en grandes cantidades, y después se mide electrónicamente su desintegración. Las partículas comprendidas entre 10ˉ¹⁰ y 10ˉ⁸ segundos solían registrarse con una cámara de burbujas, pero actualmente se utiliza con más frecuencia la cámara de chispas. Una partícula que se mueve a través de una cámara de burbujas deja un rastro de pequeñas burbujas que puede ser fotografiado. La Cámara de chispas contiene varios grupos de de un gran número de alambres finos entrecruzados entre los que se aplica un alto voltaje. Una partícula cargada que pasa cerca de los cables produce una serie de descargas (chispas) que son registradas electrónicamente. La ventaja de esta técnica respecto a la cámara de burbujas es que la señal se puede enviar directamente a una computadora que la registra de manera muy exacta.

Una partícula eléctricamente neutra nunca deja una traza directamente, pero si sufre algún tipo de interacción que involucre partículas cargadas (bien porque colisionen con un átomo en el detector o porque se desintegren en otras partículas), entonces desde luego que pueden ser registradas. Además, realmente se coloca el aparato entre los polos de un fuerte imán. Esto hace que la trayectoria de las partículas se curve y de aquí se puede medir la velocidad de las partículas. Sin embargo, como la curva también depende de la masa de la partícula, es conveniente a veces medir también la velocidad de una forma diferente.

Una colisión entre un protón y un antiprotón registrada mediante una cámara de chispas del experimento UA5 del CERN. Lanzan haces de partículas a velocidades relativistas para hacerlas chocar y saber que sale de su interior, es la manera de conocer de qué está hecha la materia.

En un experimento de altas energías, la mayoría de las partículas no se mueven mucho más despacio que la velocidad de la luz. Durante su carta vida pueden llegar a viajar algunos centímetros y a partir de la longitud media de sus trazas se puede calcular su vida. Aunque las vidas comprendidas entre 10ˉ¹³ y 10ˉ²⁰ segundos son muy difíciles de medir directamente, se pueden determinar indirectamente midiendo las fuerzas por las que las partículas se pueden transformar en otras. Estas fuerzas son las responsables de la desintegración y, por lo tanto, conociéndolas se puede calcular la vida de las partículas, Así, con una pericia ilimitada los experimentadores han desarrollado todo un arsenal de técnicas para deducir hasta donde sea posible todas las propiedades de las partículas. En algunos de estos procedimientos ha sido extremadamente difícil alcanzar una precisión alta. Y, los datos y números que actualmente tenemos de cada una de las partículas conocidas, son los resultados acumulados durante muchísimos años de medidas experimentales y de esa manera, se puede presentar una información que, si se valorara en horas de trabajo y coste de los proyectos, alcanzaría un precio descomunal pero, esa era, la única manera de ir conociendo las propiedades de los pequeños componentes de la materia.

Colisionando particulas leptones tau positivos y negativos encontraron los Bosones W+ y W-.

Que la mayoría de las partículas tenga una vida media de 10ˉ⁸ segundos significa que son ¡extremadamente estables! La función de onda interna oscila más de 10²² veces/segundo. Este es el “latido natural de su corazón” con el cual se compara su vida. Estas ondas cuánticas pueden oscilar 10ˉ⁸ x 10²², que es 1¹⁴ o 100.000.000.000.000 veces antes de desintegrarse de una u otra manera. Podemos decir con toda la seguridad que la interacción responsable de tal desintegración es extremadamente débil.

Se habla de ondas cuánticas y también, de ondas gravitacionales. Las primeras han sido localizadas y las segundas están siendo perseguidas.

Aunque la vida de un neutrón sea mucho más larga (en promedio un cuarto de hora), su desintegración también se puede atribuir a la interacción débil. A propósito, algunos núcleos atómicos radiactivos también se desintegran por interacción débil, pero pueden necesitar millones e incluso miles de millones de años para ello. Esta amplia variación de vidas medias se puede explicar considerando la cantidad de energía que se libera en la desintegración. La energía se almacena en las masas de las partículas según la bien conocida fórmula de Einstein E = Mc². Una desintegración sólo puede tener lugar si la masa total de todos los productos resultantes es menor que la masa de la partícula original. La diferencia entre ambas masas se invierte en energía de movimiento. Si la diferencia es grande, el proceso puede producirse muy rápidamente, pero a menudo la diferencia es tan pequeña que la desintegración puede durar minutos o incluso millones de años. Así, lo que determina la velocidad con la que las partículas se desintegran no es sólo la intensidad de la fuerza, sino también la cantidad de energía disponible.

Si no existiera la interacción débil, la mayoría de las partículas serían perfectamente estables. Sin embargo, la interacción por la que se desintegran las partículas π°, η y Σ° es la electromagnética. Se observará que estas partículas tienen una vida media mucho más corta, aparentemente, la interacción electromagnética es mucho más fuerte que la interacción débil.

Durante la década de 1950 y 1960 aparecieron tal enjambre de partículas que dio lugar a esa famosa anécdota de Fermi cuando dijo: “Si llego a adivinar esto me hubiera dedicado a la botánica.”

Si la vida de una partícula es tan corta como 10ˉ²³ segundos, el proceso de desintegración tiene un efecto en la energía necesaria para producir las partículas ante de que se desintegre. Para explicar esto, comparemos la partícula con un diapasón que vibra en un determinado modo. Si la “fuerza de fricción” que tiende a eliminar este modo de vibración es fuerte, ésta puede afectar a la forma en la que el diapasón oscila, porque la altura, o la frecuencia de oscilación, está peor definida. Para una partícula elemental, esta frecuencia corresponde a su energía. El diapasón resonará con menor precisión; se ensancha su curva de resonancia. Dado que para esas partículas extremadamente inestable se miden curvas parecidas, a medida se las denomina resonancias. Sus vidas medias se pueden deducir directamente de la forma de sus curvas de resonancia.

Bariones Delta. Un ejemplo típico de una resonancia es la delta (∆), de la cual hay cuatro especies ∆ˉ, ∆⁰, ∆⁺ y ∆⁺⁺(esta última tiene doble carga eléctrica). Las masas de las deltas son casi iguales 1.230 MeV. Se desintegran por la interacción fuerte en un protón o un neutrón y un pión.

Existen tanto resonancias mesónicas como bariónicas . Las resonancias deltas son bariónicas. Las resonancias deltas son bariónicas. (También están las resonancias mesónicas rho, P).

Las resonancias parecen ser solamente una especie de versión excitada de los Hadrones estable. Son réplicas que rotan más rápidamente de lo normal o que vibran de diferente manera. Análogamente a lo que sucede cuando golpeamos un gong, que emite sonido mientras pierde energía hasta que finalmente cesa de vibrar, una resonancia termina su existencia emitiendo piones, según se transforma en una forma más estable de materia.

Por ejemplo, la desintegración de una resonancia ∆ (delta) que se desintegra por una interacción fuerte en un protón o neutrón y un pión, por ejemplo:

∆⁺⁺→р + π⁺; ∆⁰→р + πˉ; o п+π⁰

En la desintegración de un neutrón, el exceso de energía-masa es sólo 0,7 MeV, que se puede invertir en poner en movimiento un protón, un electrón y un neutrino. Un Núcleo radiactivo generalmente tiene mucha menos energía a su disposición.

El estudio de los componentes de la materia tiene una larga historia en su haber, y, muchos son los logros conseguidos y muchos más los que nos quedan por conseguir, ya que, nuestros conocimientos de la masa y de la energía (aunque nos parezca lo contrario), son aún bastante limitados, nos queda mucho por descubrir antes de que podamos decir que dominamos la materia y sabemos de todos sus componentes. Antes de que eso llegue, tendremos que conocer, en profundidad, el verdadero origen de la Luz que esconde muchos secretos que tendremos que desvelar.

Esperemos que con los futuros experimentos del LHC y de los grandes Aceleradores de partículas del futuro, se nos aclaren algo las cosas y podamos avanzar en el perfeccionamiento del Modelo Estándar de la Física de Partículas que, como todos sabemos es un Modelo incompleto que no contiene a todas las fuerzas de la Naturaleza y, cerca de una veintena de sus parámetros son aleatorios y no han sido explicados. Uno de ellos, el Bosón de Higgs, dicen que ha sido encontrado. Sin embargo, a mí particularmente me quedan muchas dudas al respecto.

Emilio Silvera V.

Nov

9

El adimensional 137

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

La red de materia libre ha de ser de estructura cúbica curva, la más simple, es decir un cubo según la superficie esférica. Pero en la superficie esférica los ocho elementos del cubo se distribuyen equidistantes, de tal forma que cada dos quedan comprendidos en una superficie pr² de las 4 que componen la superficie esférica: S = 4pr².

La probabilidad de choque o interacción de esos ocho elementos con los adyacentes en igual configuración de red es de 3, los elementos más probables por encontrarse más cerca y en las tres direcciones de avance.

Los elementos que resultan de las combinaciones, se combinarán a su vez en la misma probabilidad o número, 3.

El número total de elementos recombinados hasta la materia normal para una estructura cúbica de red sería:

8 x3 composiciones de 2 elementos en primera combinación.

(8×3) x2 elem. de la primera combinación, x 3 nuevas combinaciones, x 3 elementos cada una (mayoritarios para combinaciones elementales m. normal):

24 x3³

Pero esto sería si todos los elementos poseyeran la misma probabilidad de combinarse, lo que no es así.

En su movida cada uno de ellos podría ocupar una superficie r², su abanico de avance, lo cual se cumple. Entonces tendríamos:

( 24 x3³) r²

El cuadrado esférico o esfera de red sólo podría avanzar en el sentido de una de sus caras (2 elementos) de las cuatro equivalentes a pr².

El número total de elementos combinados que correspondería a toda la esfera o cuadrado esférico habrá que dividirlo por pr²; y ya que en dicha división r² se anula:

24 x3³/p = 137, 5098

Este valor será exacto si se consideran las pequeñas oscilaciones de los elementos que les influyen en su mutua probabilidad de combinación (choque).

De manera más explícita, y considerando la vibración fundamental de los elementos:

Con la simple visualización del esquema pudiera interpretarse que una partícula da lugar a 137, lo que no es, cada una de ellas dispone en el medio de otras como materia prima para combinarse o recombinarse.

NOTA. Ya se vio en otro de nuestros trabajos cual era el origen de la oscilación intrínseca. Aquella, fundamental, que no depende de la vibración calórica o de la energía sino del giro siempre presente en las partículas y su “descentrado” debido a la inexactitud de los cuantos: su pequeña asimetría. Dicho “estremecimiento” constituye un desahogo o margen propio para cada partícula junto a las otras en las uniones, y puede identificarse con el doble de la tolerancia mínima.

Consideraciones sobre el 137

Sea como sea, este número de elementos correspondería a la totalidad de los primordiales que componen la materia “másica” a partir de una estructura elemental de red.

Aquellos elementos primordiales que no consiguiesen la combinación permanecerán en su estado libre (espuma cuántica) como componentes de la abundante energía oscura.

Pero en la globalidad, en el total de energía oscura, el conjunto de cubos esféricos podrá actuar aleatoriamente por cualquiera de sus cuatro lados. De ello se deduce que la probabilidad de combinación para toda la energía oscura será de ¼, con lo que la primera generación de partículas, la materia oscura propiamente hablando, se generaría según un 25%. La siguiente generación también se generará como un 25% del 25% de esa materia generadora, la materia oscura, con lo que su porcentaje sería del 6% aprox. sin tener en cuenta otras incidencias.

Estos porcentajes teóricos oscilaran según el margen vibratorio, o los desvíos desde la uniformidad para sitios localizados, por lo que los valores no pueden ser exactos. Pero todo ello sería corregible si dichas magnitudes se conocieran.

Por otro lado, si se supiese la diferencia dimensional entre los distintos estamentos se sabría el aumento de volumen o tamaño en la evolución hasta el presente, consiguientemente la variación de volumen y el valor de la expansión, pues, como sabemos, viene generada por la presión oscura.

Claro, que todo lo dicho se ha supuesto para “generaciones en frío”. Pero en la globalidad, seguramente los fenómenos de alta presión y temperatura, no son causa, sino consecuencia de las propias generaciones en frío, que las provoquen por su acción gravitatoria, es decir que en promedio serán las materias oscuras las responsables de la expansión, y más si se considera su dominio porcentual en el Universo.

Se observa que los ordenes de dimensión conocidos comienzan a separarse notoriamente a partir de 10^-17 o 10^-18. Seguramente se pueda decir que los órdenes de dimensión hacia abajo también varíen en forma cuadrática. En este supuesto, no sería difícil calcular el volumen de ahora partiendo de las combinaciones desde la estructura de red cúbica.

Es de suponer que el 137 como número de combinaciones sea constante, y que no sea necesario partir de la energía-materia oscura para que dicho número se cumpla, sino que sea válido allá donde existan los tres saltos combinatorios equivalentes. Igual ha de ocurrir para que el fotón libre se integre al electrón. Por ello, y en principio, suponemos para éste una estructura triple.

De la Teoría de Landau del líquido de Fermi ya puede extraerse la existencia de espinones y holones. Y la existencia de híper partículas ocurre en niveles de temperatura muy bajos según la distribución Bose-Einstein.

La onda partícula electrón:

Imaginamos como más lógica una estructura de tres anillos para el electrón. Primero, porque el movimiento extensivo por causa del espín abarcaría toda la partícula. Segundo, como forma de que, aun siendo una partícula compuesta, posea una resultante de carga negativa.

Según sea la dirección de avance, dos de los anillos se comportarían como ondas ligadas perpendiculares, neutras en conjunto (al estilo del fotón).

El tercer anillo, desapareado, perpendicular a los anteriores, como onda envolvente daría la carga electrónica (siempre que gire en la forma directa; en la retrógrada se trataría de un positrón).

Los dos primeros se constituirían de espinones (no aportan carga, sólo aportan espín, como ocurre al fotón).

El otro se compondría de holones (sólo aportan carga y no espín).

Espinones y holones serían una manera de designar sus funciones, inter-cambiantes según la dirección de desplazamiento global de la partícula, y de forma continua seguramente.

Podríamos decir que el electrón sea la suma de un súper fotón muy masivo y un anillo halo responsable de su carga.

La constante de estructura fina.

La absorción de un fotón por parte de un electrón supondrá su combinación interna desde uno a tres elementos. Como se ha visto el número total de componentes habrá de ser 137.

Por el contrario, la emisión de fotones ocurrirá por el fraccionamiento de una subpartícula electrónica que no obstante permanecería reestructurada a falta de un sólo fotón en sus prolíficos anillos de componentes casi libres.

La constante de estructura fina se puede expresar como:

O lo que es lo mismo, la energía para traer dos electrones hasta una distancia S dividida por la energía de un fotón con longitud de onda igual a 2pS.

Ello nos indica que la energía electrónica de carga es 137 veces la energía del fotón, o lo que es lo mismo, la masa o número de elementos para la emisión o absorción es de 1 a 137 (equivalencia masa y energía).

Las subpartículas propicias del electrón para emisión o absorción de fotones poseerán una masa equivalente a 137 de la del fotón.

El 137 expresaría por tanto la cuantificación combinatoria en la expansión y el resultado fraccionario en la concentración, si, en según que condiciones externas, ambos procesos son reversibles.

Autor:

Fandila Soria

Granada, – Julio- 2011

Totales: 84.761.054

Totales: 84.761.054 Conectados: 36

Conectados: 36