Ene

27

Un fino equilibrio que nos permite estar aquí

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

Las estrellas típicas como el Sol, emiten desde su superficie un viento de partículas cargadas eléctricamente que barre los atmósferas de los planetas en órbitas a su alrededor y a menos que el viento pueda ser desviado por un campo magnético, los posibles habitantes de ese planeta lo podrían tener complicado soportando tal lluvia de radiactividad. En nuestro sistema solar el campo magnético de la Tierra ha protegido su atmósfera del viento solar, pero Marte, que no está protegido por ningún campo magnético, perdió su atmósfera hace tiempo.

Probablemente no es fácil mantener una larga vida en un planeta del Sistema solar. Poco a poco hemos llegado a apreciar cuán precaria es. Dejando a un lado los intentos que siguen realizando los seres vivos de extinguirse a sí mismos, agotar los recursos naturales, propagan infecciones letales y venenos mortales y emponzoñar la atmósfera, también existen serias amenazas exteriores.

Contaminamos nuestro entorno y ciudades, los océanos, incluso el Espacio exterior, y, estamos a merced de la posible caída de grandes pedruscos que podrían provocar grandes calamidades, no digamos de pandemias y otros terrores

Los movimientos de cometas y asteroides, a pesar de tener la defensa de Júpiter, son una seria y cierta amenaza para el desarrollo y persistencia de vida inteligente en las primeras etapas. Los impactos no han sido infrecuentes en el pasado lejano de la Tierra habiendo tenido efectos catastróficos. Somos afortunados al tener la protección de la luna y de la enorme masa de Júpiter que atrae hacia sí los cuerpos que llegan desde el exterior desviándolos de su probable trayectoria hacia nuestro planeta.

La caída en el Planeta de uno de estos enormes pedruscos podría producir extinciones globales y retrasar en millones de años la evolución. Como se supone que pasó con aquellos grandes animales del Jurásico.

Ene

13

La complejidad del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (1)

Comments (1)

Cuando pensamos en la edad y el tamaño del universo lo hacemos generalmente utilizando medidas de Tiempo y Espacio como años, kilómetros o años-luz. Como ya hemos visto, estas medidas son extraordinariamente antropomórficas. ¿Por qué medir la edad del universo con un “reloj” que hace “tic” cada vez que nuestro planeta completa una órbita alrededor de su estrella madre, el Sol? ¿Por qué medir su densidad en términos de átomos por metro cúbico? Las respuestas a estas preguntas son por supuesto la misma: porque es conveniente y siempre lo hemos hecho así.

Saturno es un planeta grande. Sin embargo, si lo pudiéramos poner en una piscina… ¡Flotaría!

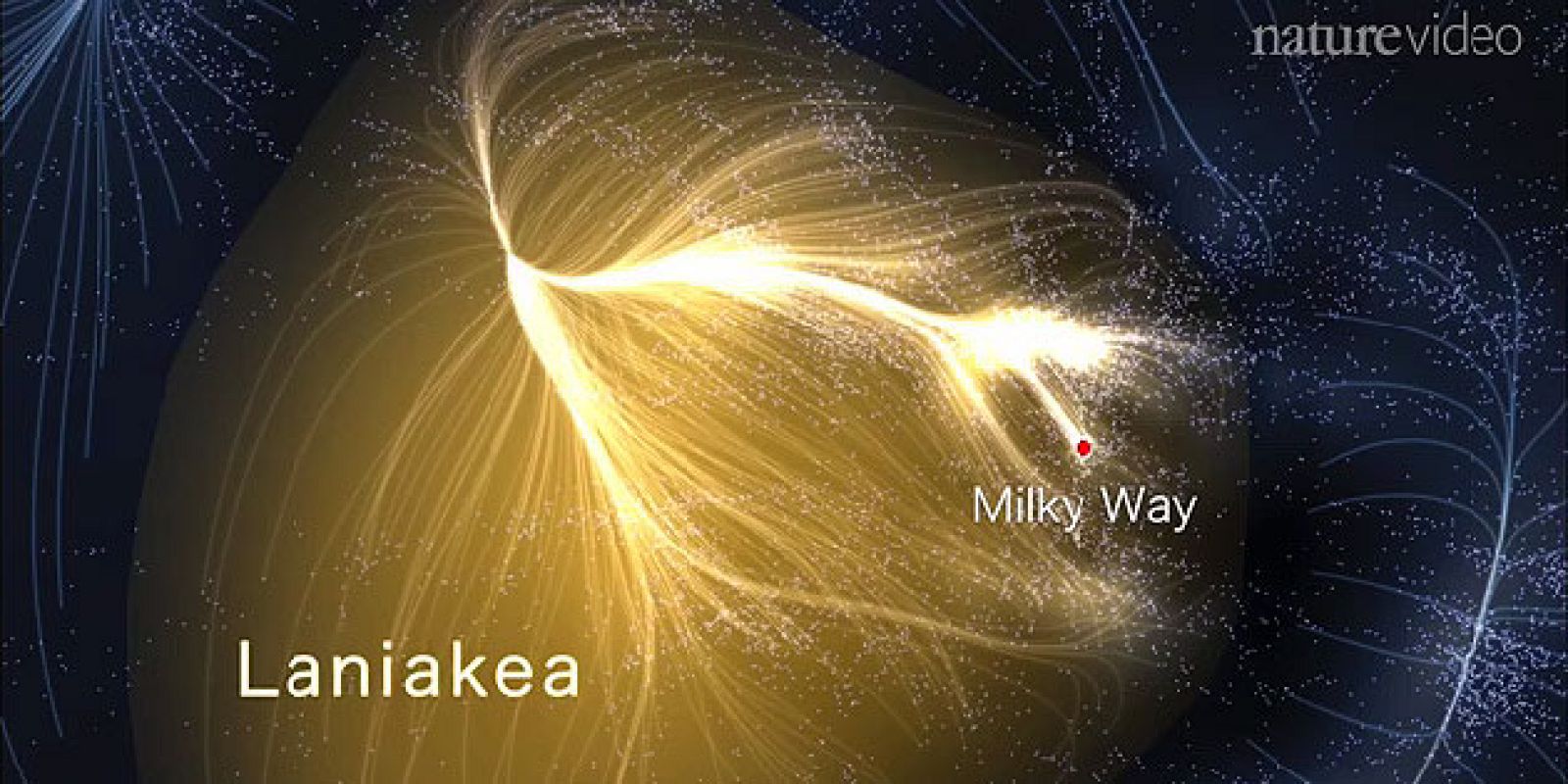

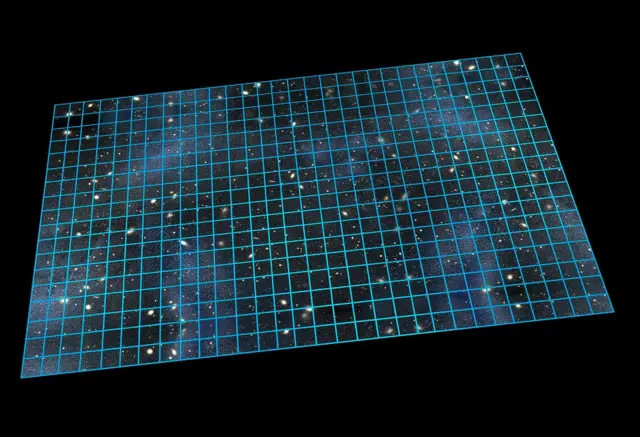

La jerarquía del Universo: A mayor tamaño, menor densidad

La jerarquía del Universo muestra una tendencia de mayor tamaño con menor densidad en sus estructuras a gran escala (vacíos cósmicos, filamentos, cúmulos), contrastando con la alta densidad de objetos pequeños como estrellas y agujeros negros (especialmente estrellas de neutrones), aunque el universo en su conjunto tiene una densidad promedio muy baja (un átomo por metro cúbico), con grandes vacíos dominando el panorama cósmico y las estructuras densas agrupándose en redes.

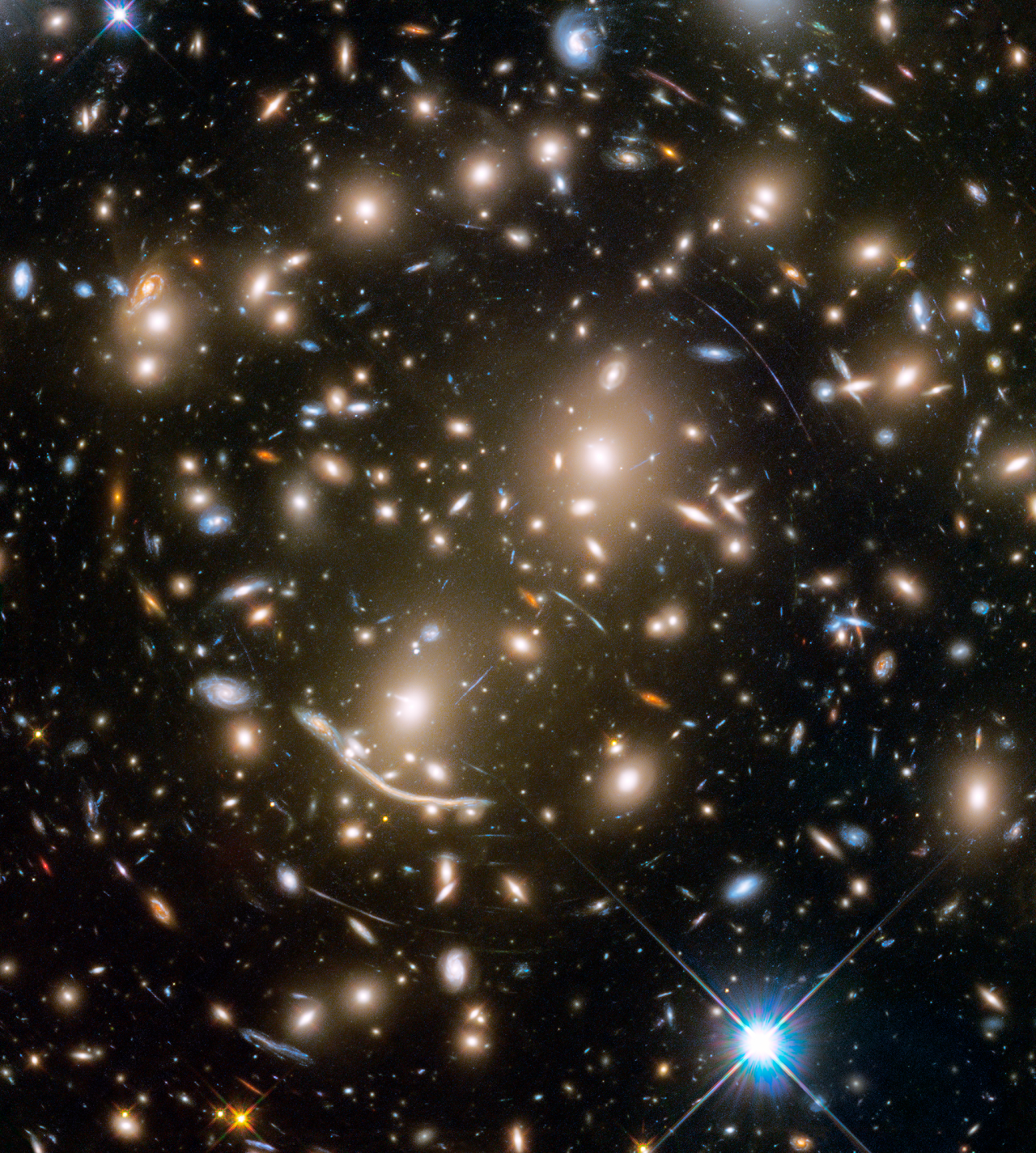

A medida que examinamos volúmenes cada vez mayores del Universo, la densidad de material que encontramos sigue disminuyendo hasta que salimos de las dimensiones de los cúmulos de galaxias. Cuando llegamos a dicha escala, la acumulación de materia empieza a desvanecerse y se parece cada vez más a una minúscula perturbación aleatoria de un mar uniforme de materia, con una densidad de aproximadamente un átomo por cada metro cúbico.

Cúmulos de galaxias 051280×800: La Jerarquía del Universo a mayor tamaño, menor densidad

A medida que buscamos en las mayores dimensiones visibles del Universo, encontramos que las desviaciones de la uniformidad perfecta de la materia y la radiación se quedan en un bajo nivel de sólo una parte en cien mil. Esto nos muestra que el Universo no es lo que se ha llegado a conocerse como un fractal, en donde la acumulación de materia en cada escala parece una imagen ampliada de la escala superior siguiente.

Dic

29

El Tiempo de Planck, materia extraña, la geometría del Universo…

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (3)

Comments (3)

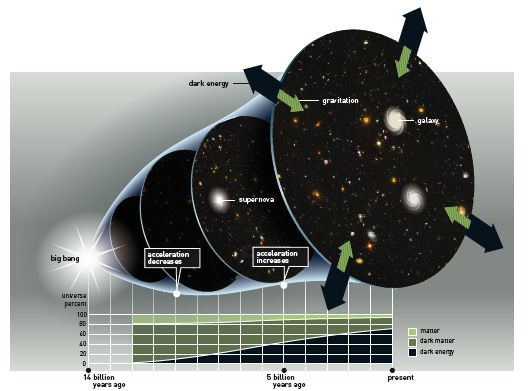

Hace años que lo vengo diciendo ¡No hay materia oscura”. Resulta que los cosmólogos no sabían explicare como se pudieron formar las galaxias, estando presente la Expansión de Hubble. ¿Cómo la materia pudo escapar de dicha expansión? En el trabajo “Son muchas las cosas que no sabemos”, decía:

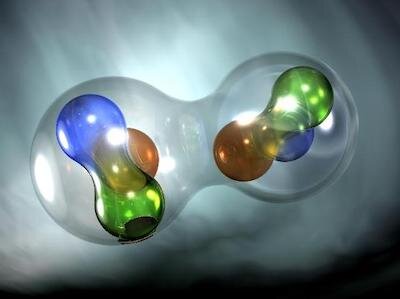

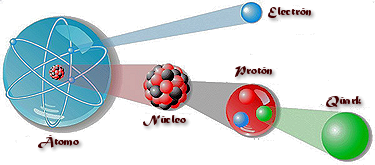

Según algunos estudios realizados es posible que, además, puedan existir estrellas Quarks-Gluones

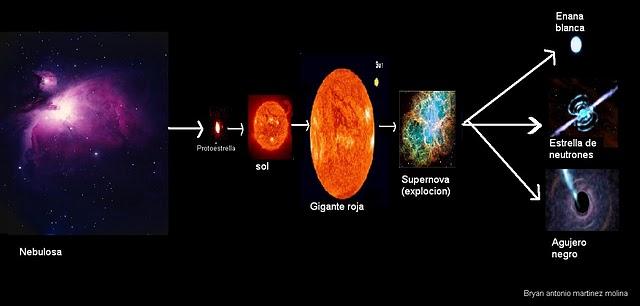

Lo que realmente sucede en las estrellas normales y según su masa, es que tienen un proceso evolutivo que las estrellas normales como el Sol, al agotar su combustible nuclear de fusión, se convierten en Gigantes roja primero y en enanas blancas después, y, si la estrella tiene más de 8 masas solares se convertirán en estrella de neutrones, y, si son hiper-gigantes (hipotéticamente serían estrellas de Quarks-Gluones de materia extraña), y, muy masivas, tendríamos un Agujero Negro.

Equilibrio, estabilidad:

El resultado de dos fuerzas contrapuestas. Protón y Electrón, hombre y mujer, el día y la noche, blanco y negro, siempre dos extremos que conforman un todo equilibrado.

Todos los objetos del Universo son el resulta de fuerzas antagónicas que, al ser iguales, se equilibran y consiguen la estabilidad. Las estrellas son el mejor ejemplo: La Gravedad trata de comprimir a la estrella que, mediante la fusión tiende a expandirse y, la lucha de esas dos fuerzas crea la estabilidad.

¡Es la Unidad de la desigualdad! Dos son uno, y, todos sabemos que, un hombre solo…

¡Está en mala compañía!

El Yin y el Yang son conceptos fundamentales de la filosofía china que representan dos fuerzas opuestas pero complementarias e independientes, presentes en todo el Universo, como la noche (Yin) y el día (Yang). El Yin es lo femenino, pasivo, oscuro, frío y de la Tierra, mientras que el Yang es lo masculino, activo, luminoso, cálido y del Cielo, y el equilibrio dinámico entre ambos es esencial para la armonía, influenciando la medicina tradicional, el Feng Shui y la vida diaria.

Características Clave:

- Oposición y Complementariedad: No son entidades separadas, sino que se necesitan mutuamente para existir (no hay día sin noche).

- Interdependencia: Uno no puede existir sin el otro; son polos de una misma totalidad.

- Dualidad en Todo: Se manifiestan en fenómenos naturales (calor/frío, sol/luna), aspectos humanos (hombre/mujer) y en la energía misma.

- Equilibrio Dinámico: Están en constante flujo; cuando uno aumenta, el otro disminuye, buscando un balance natural.

- Transformación: Pueden transformarse uno en el otro (el invierno en verano) y en cada uno reside una parte del otro (el punto negro en la parte blanca, y viceversa).

Aplicaciones Prácticas:

- Medicina China: Busca el equilibrio entre las energías Yin y Yang en el cuerpo para mantener la salud y curar enfermedades.

- Feng Shui: Organiza espacios para armonizar estas energías.

- Filosofía de Vida: Entenderlos ayuda a aceptar los ciclos naturales, buscar el balance entre actividad (Yang) y descanso (Yin), y ver oportunidades dentro de los problemas.

En resumen, Yin y Yang no son solo opuestos, sino dos caras de una misma moneda cósmica, cuya interacción crea la realidad y busca un equilibrio constante.

Equilibrio = a dos fuerzas contrapuestas

Estas estructuras, podemos decir que son entidades estables que existen en el Universo. Existen porque son malabarismos estables entre fuerzas competidoras de atracción y repulsión. Por ejemplo, en el caso de un planeta, como la Tierra, hay un equilibrio entre la fuerza atractiva de la Gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e (electrón), h (constante de Planck), G (constante de gravitación) y mp (masa del protón), c (la velocidad de la luz en el vacío). Pero, ¿Qué es el Tiempo de Planck?

Tiempo de Planck:

Es el tiempo que necesita el fotón (viajando a la velocidad de la luz, c, para moverse a través de una distancia igual a la longitud de Planck. Está dado por segundos, donde G es la constante gravitacional (6’672 59 (85) ×10-11 N m2 kg-2), ħ es la constante de Planck racionalizada (ħ = h/2π = 1’054589 × 10-34 Julios segundo) y c es la velocidad de la luz (299.792.458 m/s).

moverse a través de una distancia igual a la longitud de Planck. Está dado por segundos, donde G es la constante gravitacional (6’672 59 (85) ×10-11 N m2 kg-2), ħ es la constante de Planck racionalizada (ħ = h/2π = 1’054589 × 10-34 Julios segundo) y c es la velocidad de la luz (299.792.458 m/s).

El valor del tiempo del Planck es del orden de 10-43 segundos. En la cosmología del Big Bang, hasta un tiempo (Tp) después del instante inicial, es necesaria usar una teoría cuántica de la gravedad para describir la evolución del universo. Expresado en números corrientes que todos podamos entender, su valor es:

describir la evolución del universo. Expresado en números corrientes que todos podamos entender, su valor es:

En forma decimal (aproximada):

0.000…0005391s (con 43 ceros después del punto decimal antes del 5). Que es el tiempo que necesita el fotón para recorrer la longitud de Planck, de 10-35 metros (veinte órdenes de magnitud menor que el tamaño de del protón de 10-15 metros). el límite de Planck es: Lp = √(Għ/c3 ≈ 1’61624 x 10-35 m.

Todo, desde Einstein, es relativo. Depende de la pregunta que se formule y de quién nos de la respuesta.

Einstein, es relativo. Depende de la pregunta que se formule y de quién nos de la respuesta.

El tiempo es la escalera con peldaños infinitos que nos llevan hasta el fin de la eternidad…

Científicos descubren que el tiempo pasaba cinco veces más despacio en el Universo inmediatamente tras el Big Bang. Los científicos han observado por primera vez el universo primitivo funcionando a cámara extremadamente lenta, desvelando uno de los misterios del universo en expansión de Einstein.

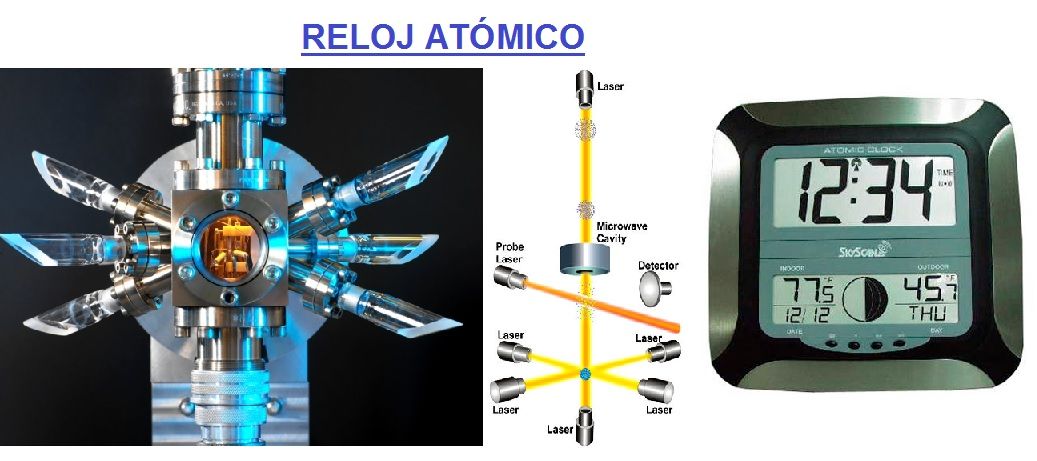

Si preguntamos ¿Qué es el tiempo?, tendríamos que ser precisos y especificar si estamos preguntando por esa dimensión temporal que no deja de fluir desde el Big Bang y que nos acompaña a lo largo de nuestras vidas, o nos referimos al tiempo atómico, ese adoptado por el SI, cuya unidad es el segundo y se basa en las frecuencias atómicas, definida a partir de una línea espectral particular de átomo de cesio-133, o nos referimos a lo que se conoce como tiempo civil, tiempo coordinado, tiempo de crecimiento, tiempo de cruce, tiempo de integración, tiempo de relajación, tiempo dinámico o dinámico de Baricéntrico, dinámico terrestre, tiempo terrestre, tiempo de Efemérides, de huso horario, tiempo estándar, tiempo local

el Big Bang y que nos acompaña a lo largo de nuestras vidas, o nos referimos al tiempo atómico, ese adoptado por el SI, cuya unidad es el segundo y se basa en las frecuencias atómicas, definida a partir de una línea espectral particular de átomo de cesio-133, o nos referimos a lo que se conoce como tiempo civil, tiempo coordinado, tiempo de crecimiento, tiempo de cruce, tiempo de integración, tiempo de relajación, tiempo dinámico o dinámico de Baricéntrico, dinámico terrestre, tiempo terrestre, tiempo de Efemérides, de huso horario, tiempo estándar, tiempo local , tiempo luz, tiempo medio, etc, etc. Cada una de estas versiones del tiempo tiene una respuesta diferente, ya que no es lo mismo el tiempo propio que el tiempo sidéreo o el tiempo solar, o solar aparente, o solar medio, o tiempo terrestre, o tiempo universal. Como se puede ver, la respuesta dependerá de cómo hagamos la pregunta.

, tiempo luz, tiempo medio, etc, etc. Cada una de estas versiones del tiempo tiene una respuesta diferente, ya que no es lo mismo el tiempo propio que el tiempo sidéreo o el tiempo solar, o solar aparente, o solar medio, o tiempo terrestre, o tiempo universal. Como se puede ver, la respuesta dependerá de cómo hagamos la pregunta.

Lo cierto es que nos hemos esforzado en medir, lo que entendemos por tiempo, con una precisión cada vez mayor.

Lp curioso del caso es , ¡Qué no hemos conseguido saber lo que el Tiempo es!

Un acuerdo internacional sobre la definición de un segundo es de fundamental importancia en la medición del tiempo”. La duración de un segundo, (por acuerdo internacional) es la frecuencia de transición entre dos subniveles de un átomo de cesio 133. Para medir esta frecuencia, los relojes de cesio fuente miden dos veces los átomos de cesio enfriados por láser en su viaje a través de la cavidad de microondas del reloj, una vez en su camino hacia arriba y de nuevo en su camino hacia abajo.

Su error se estima en un 1 segundo en 32.000 años

El reloj de Cesio cuyo funcionamiento se basa en la diferencia de energía entre dos estados del núcleo de Cesio-133 cuando se sitúa en un campo magnético. En un tipo , los átomos de cesio-133 son irradiados con radiación de radiofrecuencia, cuya frecuencia es elegida para corresponder a la diferencia de energía entre los dos estados. Es decir, nos valemos de un sistema complejo para determinar lo que el tiempo es basado en lo que de él nos indica la Naturaleza.

, los átomos de cesio-133 son irradiados con radiación de radiofrecuencia, cuya frecuencia es elegida para corresponder a la diferencia de energía entre los dos estados. Es decir, nos valemos de un sistema complejo para determinar lo que el tiempo es basado en lo que de él nos indica la Naturaleza.

En realidad, para todos nosotros el único tiempo que rige es el que tenemos a lo largo de nuestras vidas; los otros tiempos, son inventos del hombre para facilitar sus tareas de medida, de convivencia o de otras cuestiones técnicas o astronómicas pero, sin embargo, el tiempo es sólo uno; ese que comenzó cuando nació el universo y que finalizará cuando éste llegue a su final.

todos nosotros el único tiempo que rige es el que tenemos a lo largo de nuestras vidas; los otros tiempos, son inventos del hombre para facilitar sus tareas de medida, de convivencia o de otras cuestiones técnicas o astronómicas pero, sin embargo, el tiempo es sólo uno; ese que comenzó cuando nació el universo y que finalizará cuando éste llegue a su final.

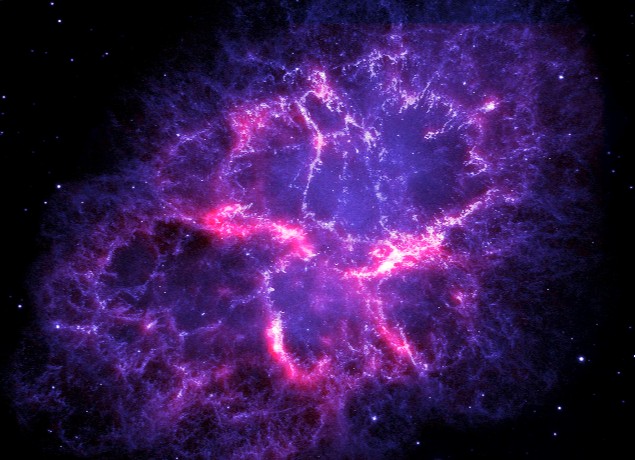

Las estrellas super-masivas:

- Masa Gigante: Su masa determina una intensa gravedad que influye sobre su entorno.

- Vida Efímera: A pesar de su tamaño, tienen una vida relativamente corta debido a la rapidez con la que consumen su combustible nuclear.

- Luminosidad Extrema: Al ser tan masivas, su emisión de luz y energía es colosal.

- Muerte Explosiva: Al final de su ciclo de vida, suelen terminar en espectaculares supernovas, dejando tras de sí un agujero negro o una estrella de neutrones.

Lo cierto es que para las estrellas supermasivas, cuando llegan al final de su ciclo y dejan de brillar por agotamiento de su combustible nuclear, en ese preciso instante, el tiempo se agota para ella. Cuando una estrella pierde el equilibrio existente entre la energía termonuclear (que tiende a expandir la estrella) y la fuerza de gravedad (que tiende a comprimirla), al quedar sin oposición esta última, la estrella supermasiva se contrae aplastada bajo su propia masa. Queda comprimida hasta tal nivel que llega un momento que desaparece, para convertirse en un agujero negro, una singularidad, donde dejan de existir el “tiempo” y el espacio. A su alrededor nace un horizonte de sucesos, que si se traspasa se es engullido por la enorme gravedad del agujero negro.

las estrellas supermasivas, cuando llegan al final de su ciclo y dejan de brillar por agotamiento de su combustible nuclear, en ese preciso instante, el tiempo se agota para ella. Cuando una estrella pierde el equilibrio existente entre la energía termonuclear (que tiende a expandir la estrella) y la fuerza de gravedad (que tiende a comprimirla), al quedar sin oposición esta última, la estrella supermasiva se contrae aplastada bajo su propia masa. Queda comprimida hasta tal nivel que llega un momento que desaparece, para convertirse en un agujero negro, una singularidad, donde dejan de existir el “tiempo” y el espacio. A su alrededor nace un horizonte de sucesos, que si se traspasa se es engullido por la enorme gravedad del agujero negro.

Según todos los indicios, la Física nos dice que al llegar a la singularidad de un agujero negro, no podremos encontrar ni tiempo ni espacio. Es una región que estando en este mundo, es como si estuviera en otro, al que sólo se podrá llegar a través de la teoría tan esperada de la gravedad cuántica. Aquí, en la Singularidad, la Relatividad de Einstein llega y hace mutis por el foro.

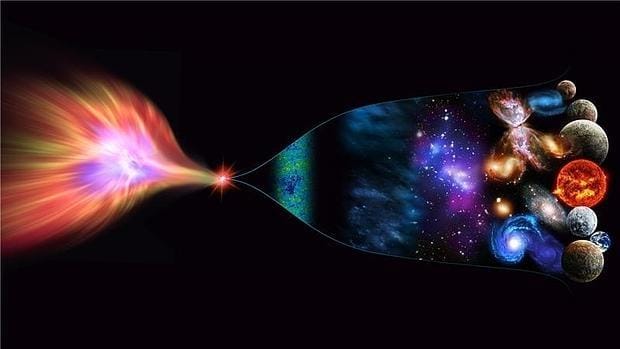

El tiempo, de esta manera, deja de existir en estas regiones del universo que conocemos como singularidad. El mismo Big Bang (según algunos), surgió de una singularidad de energía y densidad infinitas que explotó y se expandió para crear el tiempo, el espacio y la materia. Nosotros llegamos algunos miles de millones de años más tarde, cuando la materia evolucionó hacia los pensamientos.

manera, deja de existir en estas regiones del universo que conocemos como singularidad. El mismo Big Bang (según algunos), surgió de una singularidad de energía y densidad infinitas que explotó y se expandió para crear el tiempo, el espacio y la materia. Nosotros llegamos algunos miles de millones de años más tarde, cuando la materia evolucionó hacia los pensamientos.

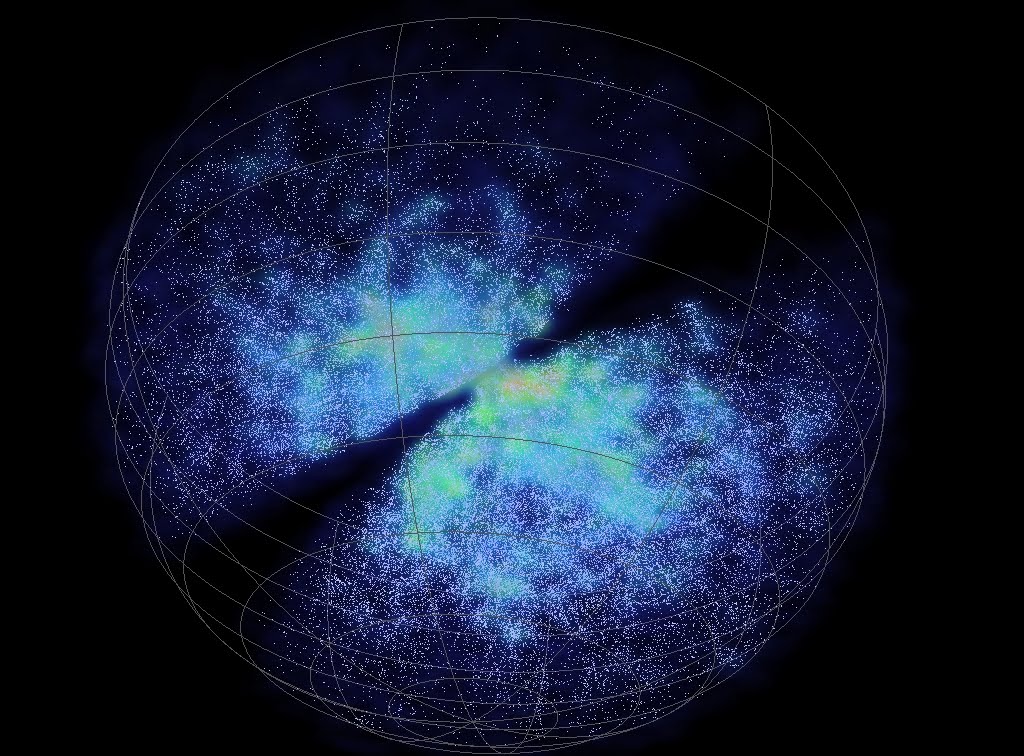

El universo está formado por grandes redes de galaxias que se entrelazan de manera aleatoria. Sin embargo, hay un aspecto de este conglomerado que apenas fue descubierto a fines de los 70. Les hablo de los vacíos cósmicos, estructuras en forma de burbujas que no contienen nada en su interior y se esparcen por todo el espacio. Las mismas, al parecer, constituyen valiosas herramientas para desentrañar los misterios del universo. Te cuento cómo pueden ser útiles estos vacíos para la ciencia.

El Vacío de Boötes es una región cósmica gigantesca, con una extensión que ronda los 330 millones de años luz de diámetro, lo que lo convierte en uno de los mayores vacíos conocidos, un espacio casi desprovisto de galaxias, salvo por unas pocas docenas en una especie de filamento central, ocupando cerca del 2% del universo observable y con un origen que desafía los modelos actuales de formación del cosmos.

Esa dimensión de superficie la estudiamos y la comprobamos, hablamos de ella pero ¿La entendemos y la escenificamos en nuestras Mentes?

De ninguna manera nos hacemos una idea exacta de lo que eso supone en distancia a recorrer, y, como antes hemos hablado del equilibrio de las cosas opuestas:

Como contraposición a estas enormes densidades de las enanas blancas, estrellas de neutrones y agujeros negros, existen regiones del espacio que contienen menos galaxias que el promedio o incluso ninguna galaxia; a estas regiones las conocemos como vacío cósmico. Han sido detectados vacíos con menos de una décima de la densidad promedio del universo en escalas de hasta

contraposición a estas enormes densidades de las enanas blancas, estrellas de neutrones y agujeros negros, existen regiones del espacio que contienen menos galaxias que el promedio o incluso ninguna galaxia; a estas regiones las conocemos como vacío cósmico. Han sido detectados vacíos con menos de una décima de la densidad promedio del universo en escalas de hasta 200 millones de años luz en exploraciones a gran escala. Estas regiones son a menudo esféricas. El primer gran vacío en ser detectado (imagen de arriba) fue el de Boötes en 1.981; tiene un radio de unos 180 millones de años luz y su centro se encuentra aproximadamente a 500 millones de años luz de la Vía Láctea. La existencia de grandes vacíos no es sorprendente, dada la existencia de cúmulos de galaxias y supercúmulos a escalas muy grandes.

200 millones de años luz en exploraciones a gran escala. Estas regiones son a menudo esféricas. El primer gran vacío en ser detectado (imagen de arriba) fue el de Boötes en 1.981; tiene un radio de unos 180 millones de años luz y su centro se encuentra aproximadamente a 500 millones de años luz de la Vía Láctea. La existencia de grandes vacíos no es sorprendente, dada la existencia de cúmulos de galaxias y supercúmulos a escalas muy grandes.

Muchos son los misterios que nos quedan por resolver y muchos también los objetos que, estando ahí fuera aún no han sido localizados. La vastedad del inmenso Universo, hace difícil saber la realidad de todo su contenido y, necesitaremos siglos de estudio y observación para poder desvelar todos sus secretos. Creo que nunca podremos saberlo todo y que, la Naturaleza, siempre tendrá enigmas que resolver para que estemos ocupados y no podamos caer en el tedio y quedarnos sin curiosidad, ese motor que siempre nos ha movido.

Así que pudimos descubrir que existen vacíos espaciales enormes. Mientras que en estas regiones la materia es muy escasa, en una sola estrella de neutrones, si pudiéramos retirar 1 cm3 de su masa, obtendríamos una cantidad de materia increíble. Su densidad es de 1017 Kg/m3; los electrones y los protones están tan juntos que se combinan y forman neutrones que se degeneran haciendo estable la estrella de ese nombre que, después del agujero negro, es el objeto estelar más denso del universo. Bueno, hasta que se descubran (si ocurre), la estrellas de Quarks.

que, después del agujero negro, es el objeto estelar más denso del universo. Bueno, hasta que se descubran (si ocurre), la estrellas de Quarks.

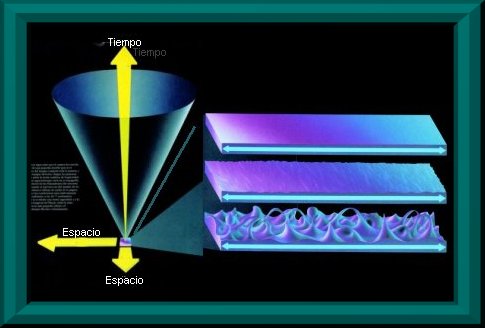

En presencia de grandes masas el Espacio-tiempo se curva

Es interesante ver cómo a través de las matemáticas y la geometría, han sabido los humanos encontrar la forma de medir el mundo y encontrar las formas del universo. Pasando por Arquímedes, Pitágoras, Newton, Gauss o Riemann (entre otros), siempre hemos tratado de buscar las respuestas de las cosas por medio de las matemáticas.

de medir el mundo y encontrar las formas del universo. Pasando por Arquímedes, Pitágoras, Newton, Gauss o Riemann (entre otros), siempre hemos tratado de buscar las respuestas de las cosas por medio de las matemáticas.

Arthur C. Clarke nos decía: “Magia es cualquier tecnología suficientemente avanzada”

Pero también es magia el hecho de que en cualquier tiempo y lugar, de manera inesperada, aparezca una persona dotada de condiciones especiales que le permiten ver estructuras complejas matemáticas que hacen posible que la humanidad avance considerablemente a través de esos nuevos conceptos que nos permiten entrar en espacios antes cerrados, ampliando el horizonte de nuestro saber.

especiales que le permiten ver estructuras complejas matemáticas que hacen posible que la humanidad avance considerablemente a través de esos nuevos conceptos que nos permiten entrar en espacios antes cerrados, ampliando el horizonte de nuestro saber.

Recuerdo aquí uno de esos extraños casos que surgió el día 10 de Junio de 1.854 con el nacimiento de una nueva geometría: la teoría de dimensiones más altas que fue introducida cuando Georg Friedrich Bernhard Riemann dio su célebre conferencia en la facultad de la Universidad de Göttingen en Alemania. Aquello fue como abrir de golpe todas las ventanas cerradas durante 2.000 años de una lóbrega habitación que, de pronto, se ve inundada por la luz cegadora de un Sol radiante. Riemann regaló al mundo las sorprendentes propiedades del espacio multidimensional.

La nueva geometría de Riemann nos dijo como era la realidad del espacio, del Universo

Su ensayo, de profunda importancia y elegancia excepcional, “sobre las hipótesis que subyacen en los fundamentos de la geometría” derribó pilares de la geometría clásica griega, que habían resistido con éxito todos los asaltos de los escépticos durante dos milenios. La vieja geometría de Euclides, en la cual todas las figuras geométricas son de dos o tres dimensiones, se venía abajo, mientras una nueva geometría riemanniana surgía de sus ruinas. La revolución riemanniana iba a tener grandes consecuencias para el futuro de las artes y las ciencias. En menos de tres decenios, la “misteriosa cuarta dimensión” influiría en la evolución del arte, la filosofía y la literatura en toda Europa. Antes de que hubieran pasado seis decenios a partir de la conferencia de Riemann, Einstein utilizaría la geometría riemanniana tetradimensional para

el futuro de las artes y las ciencias. En menos de tres decenios, la “misteriosa cuarta dimensión” influiría en la evolución del arte, la filosofía y la literatura en toda Europa. Antes de que hubieran pasado seis decenios a partir de la conferencia de Riemann, Einstein utilizaría la geometría riemanniana tetradimensional para explicar la creación del universo y su evolución mediante su asombrosa teoría de la relatividad general

explicar la creación del universo y su evolución mediante su asombrosa teoría de la relatividad general . Ciento treinta años después de su conferencia, los físicos utilizarían la geometría deca-dimensional para intentar unir todas las leyes del universo. El núcleo de la obra de Riemann era la comprensión de las leyes físicas mediante su simplificación al contemplarlas en espacios de más dimensiones.

. Ciento treinta años después de su conferencia, los físicos utilizarían la geometría deca-dimensional para intentar unir todas las leyes del universo. El núcleo de la obra de Riemann era la comprensión de las leyes físicas mediante su simplificación al contemplarlas en espacios de más dimensiones.

El niño (Riemann), le dijo al profesor que se aburría y aprendía poco. Este le dio el libro más avanzado de matemáticas de aquellos tiempos.

A los pocos días, el profesor le preguntó:

- ¿Cómo vas con el libro?

- Ya me lo se todo, no tiene algo más avanzado.

El profesor extrañado le llevó ante el director, le contó el episodio y le hicieron un examen con los problemas más complejos.

Riemann los resolvió en muy poco tiempo y les dejo claro que había “nacido” un genio.

Todavía no sabemos el por qué, en algunas personas, las neuronas funcionan de maneta diferente, y, ven el mundo con más claridad.

Contradictoriamente, Riemann era la persona menos indicada para anunciar tan profunda y completa evolución en el pensamiento matemático y físico. Era huraño, solitario y sufría crisis nerviosas. De salud muy precaria que arruinó su vida en la miseria abyecta y la tuberculosis. Al igual que aquel otro genio, Ramanujan, murió muy joven.

Emilio Silvera Vázquez

Dic

25

¡Aquellos primeros momentos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

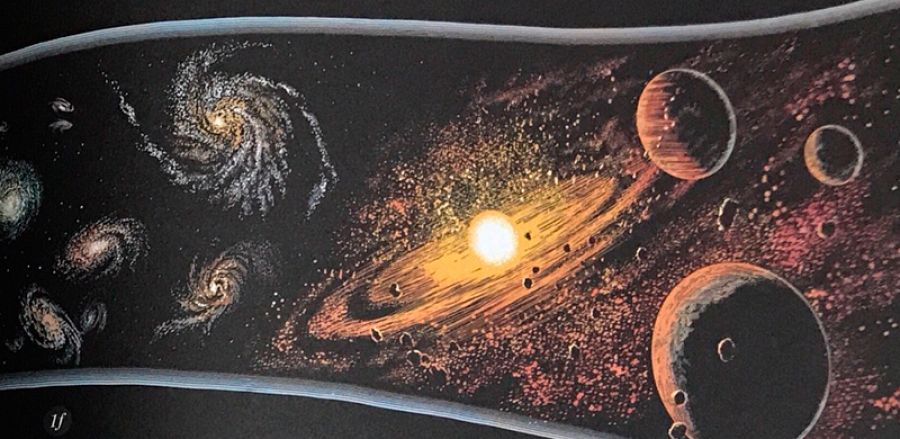

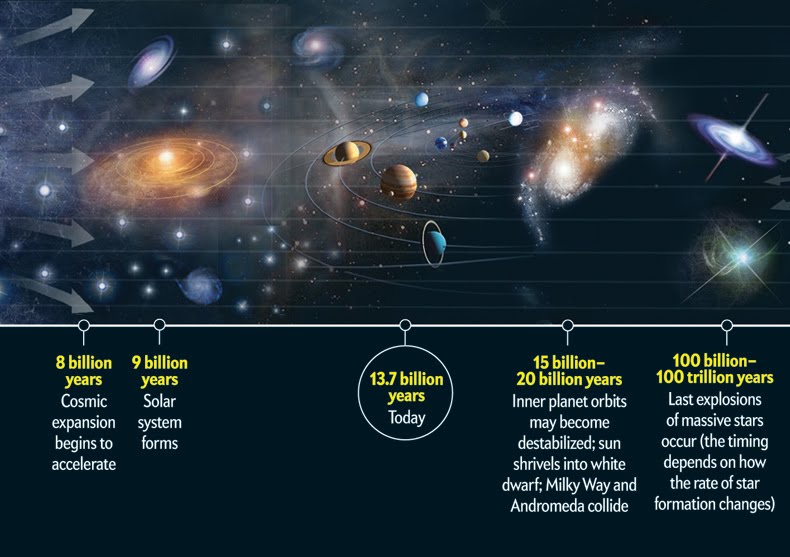

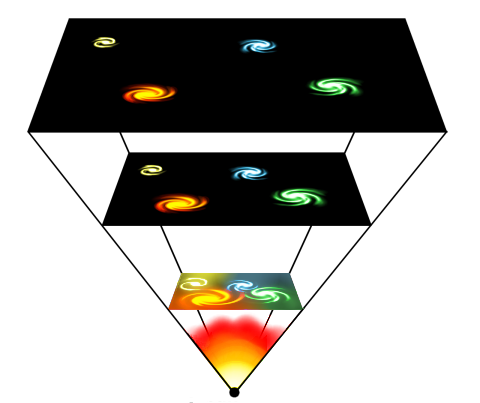

Todo en el Universo tiene un principio y un final y, el mismo universo tuvo que nacer y evolucionar para que hoy podamos contemplar, mediante nuestros sofisticados telescopios, un universo en expansión lleno de galaxias que contienen estrellas nuevas y viejas estrellas, muchas de ellas rodeadas de mundos que, aún no hemos podido determinar de qué criaturas estarán poblados muchos de ellos.

¡El Universo!

Antes de alrededor de un minuto y cuarenta segundos desde el comienzo del tiempo, no hay núcleos atómicos estables. El nivel de energía en el ambiente es mayor que la energía de unión nuclear. Por consiguiente, todos los núcleos que se forman, se destruyen de rápidamente.

Alrededor de un segundo desde el comienzo del tiempo, llegamos a la época de desacoplamiento de los neutrinos. Aunque en esa época el Universo era muy denso (y tan caliente como la explosión de una bomba de hidrógeno), ya ha empezado a parecer vacío a los neutrinos. Puesto que los neutrinos sólo reaccionan a la fuerza débil, que tiene un alcance extremadamente corto, pueden escapar de sus garras y volar indefinidamente sin experimentar ninguna otra interacción.

Aunque parezca mentira, al día de hoy no sabemos, a ciencia cierta, como se formaron las galaxias a pesar de la expansión de Hubble ¿Qué clase de materia estaba allí presente para generar la Gravedad que la retuvo y poder conformarlas?

Algunos postulan la existencia de una especie de redes cósmicas invisibles que generaban Gravedad. Aquella sustancia cósmica primigenia, muchos millones de años después, posibilitó el surgir de las primeras estrellas y de las primeras galaxias.

Así, emancipados, en lo sucesivo son libres de vagar por el Universo a su manera indiferente, volando a través de la mayor de la materia como sino existiese. (Diez trillones de neutrinos atravesarán sin causar daños el cerebro y el cuerpo del lector en el tiempo que le lleve leer esta frase. Y en el tiempo en que usted haya leído esta frase estarán más lejos que la Luna).

En menos de un siglo, el neutrino pasó de una partícula fantasma – propuesta en 1930 por el físico austríaco Wolfgang Pauli (1900-1958) a explicar el balance de energía en una forma de radioactividad, el llamado decaimiento beta, en una sonda capaz de escrutar el interior de estrellas y de la propia Tierra.

De esa manera, oleadas de neutrinos liberados en un segundo después del Big Bang persiste aún después, formando una radiación cósmica de fondo de neutrinos semejante a la radiación de fondo de microondas producida por el desacoplamiento de los fotones.

Si estos neutrinos “cósmicos” (como se los llama para diferenciarlos de los neutrinos liberados más tarde por las supernovas) pudiesen ser observador por un telescopio de neutrinos de alguna clase, proporcionarían una visión directa del Universo cuando sólo tenía un segundo.

A medida que retrocedemos en el tiempo, el Universo se vuelve más denso y más caliente, y el nivel de estructura que puede existir se hace cada vez más rudimentario.

Por supuesto, en ese tiempo, no hay moléculas, ni átomos, ni núcleos atómicos, y, a 10-6 (0.000001) de segundo después del comienzo del tiempo, tampoco hay neutrones ni protones. El Universo es un océano de quarks libres y otras partículas elementales.

Si nos tomamos el de contarlos, hallaremos que por cada mil millones de anti-quarks existen mil millones y un quark. La asimetría es importante. Los pocos quarks en exceso destinados a sobrevivir a la aniquilación general quark-antiquark formaran todos los átomos de materia del Universo del último día. Se desconoce el origen de la desigualdad; presumiblemente obedezca a la ruptura de una simetría materia antimateria en alguna etapa anterior.

Nos aproximamos a un tiempo en que las estructuras básicas de las leyes naturales, y no sólo las de las partículas y campos cuya conducta dictaban, cambiaron a medida que evolucionó el Universo.

La primera transición semejante se produjo en los 10-11 de segundo después del comienzo del tiempo, cuando las funciones de las fuerzas débiles y electromagnéticas se regían por una sola fuerza, la electrodébil. hay bastante energía ambiente para permitir la creación y el mantenimiento de gran de bosones w y z.

Estas partículas –las mismas cuya aparición en el acelerador del CERN verificó la teoría electrodébil– son las mediadoras intercambiables en las interacciones de fuerzas electromagnéticas y débiles, lo que las hace indistinguibles. En ese tiempo, el Universo está gobernando sólo por tres fuerzas: la gravedad, la interacción nuclear fuerte y la electrodébil.

Más atrás de ese tiempo nos quedamos en el misterio y envueltos en una gran nebulosa de ignorancia. Cada uno se despacha a su gusto para lanzar conjeturas y teorizar sobre lo que pudo haber sido. Seguramente, en el futuro, será la teoría M (de supercuerdas) la que contestará esas preguntas sin respuestas ahora.

En los 10-35 de segundo desde el comienzo del tiempo, entramos en un ámbito en el que las cósmicas son aún menos conocidas. Si las grandes teorías unificadas son correctas, se produjo una ruptura de la simetría por la que la fuerza electronuclear unificada se escindió en las fuerzas electrodébil y las fuertes. Si es correcta la teoría de la supersimetría, la transición puede haberse producido antes, había involucrado a la gravitación.

En el universo temprano la primera materia (hidrógeno y Helio) era llevada por la fuerza de gravedad a conformarse en grandes conglomerados de gas y polvo que interaccionaban, producían calor y formaron las primeras estrellas.

Elaborar una teoría totalmente unificada es tratar de comprender lo que ocurrió en ese tiempo remoto que, según los últimos estudios está situado entre 15.000 y 18.000 millones de años, cunado la perfecta simetría que, se pensaba, caracterizó el Universo, se hizo añicos para dar lugar a los simetrías rotas que hallamos a nuestro alrededor y que, nos trajo las fuerzas y constantes Universales que, paradójicamente, hicieron posible nuestra aparición para que , sea posible que, alguien como yo esté contando lo que pasó.

Pero hasta que no tengamos tal teoría no podemos esperar comprender lo que realmente ocurrió en ese Universo bebé. Los límites de nuestras conjeturas actuales cuando la edad del Universo sólo es de 10-43de segundo, nos da la única respuesta de encontrarnos ante una puerta cerrada.

Del otro lado de esa puerta está la época de Planck, un tiempo en que la atracción gravitatoria ejercida por cada partícula era comparable en intensidad a la fuerza nuclear fuerte.

La Era de Planck, la espuma cósmica

La fuerza nuclear fuerte hizo posible la existencia de los núcleos que atraían electrones para formar átomos

Así que, llegados a este punto podemos decir que la clave teórica que podría abrir esa puerta sería una teoría unificada que incluyese la gravitación, es decir, una teoría cuántica-gravitatoria que uniese, de una vez por todas, a Planck y Einstein que, aunque eran muy amigos, no parecen que sus teorías (la Mecánica Cuántica) y (la Relatividad General) se lleven de maravilla.

Emilio Silvera Vázquez

Dic

24

¿La masa perdida? ¿O no entendemos nada?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

Recreación artística del WHIM en la Pared del Escultor. Fuente: NASA.

La idea de la masa perdida se introdujo porque la densidad observada de la materia en el universo está cerca del valor crítico (10-29 g/cm3). Sin embargo, hasta comienzo de los ochenta, no hubo una razón teórica firme para suponer que el universo tenía efectivamente la masa crítica. En 1981, Alan Guth, publicó la primera versión de una teoría que desde entonces se ha conocido como “universo inflacionista”. desde entonces la teoría ha sufrido cierto número de modificaciones técnicas, pero los puntos centrales no han cambiado. Lo cierto es que la idea del universo inflacionista, estableció por primera vez una fuerte presunción de que la masa del universo tenía realmente el valor crítico.

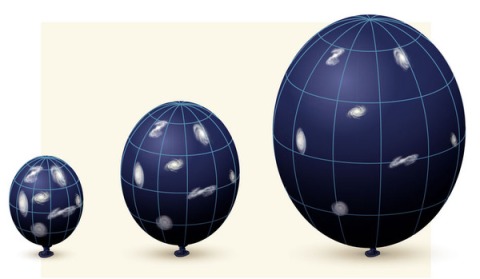

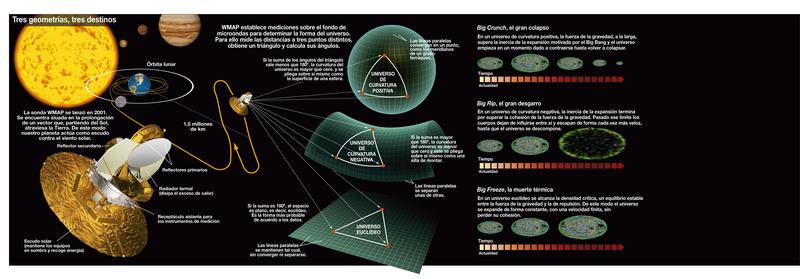

Diagrama de las tres posibles geometrías del universo: cerrado, abierto y plano, correspondiendo a valores del parámetro de densidad Ω0 mayores que, menores que o iguales a 1 respectivamente. En el universo cerrado si se viaja en línea recta se llega al mismo punto, en los otros dos no. ( Ω es lo que los cosmólogos llaman el Omega Negro, es decir, la cantidad de materia que hay en el Universo).

La predicción de Guht viene de las teorías que describen la congelación de la fuerza fuerte en el segundo 10-35 del Big Bang. Entre los muchos otros procesos en marcha en ese tiempo estaba una rápida expansión del universo, un proceso que vino a ser conocido como inflación. Es la presencia de la inflación la que nos lleva a la predicción de que el universo tiene que ser plano.

Se ha tratado de medir la Densidad Crítica del Universo para poder saber en qué clase de universo estamos y, parece que es plano.

Universo cerrado

Si Ω>1, entonces la geometría del espacio sería cerrada como la superficie de una esfera. La suma de los ángulos de un triángulo exceden 180 grados y no habría líneas paralelas. Al final, todas las líneas se encontrarían. La geometría del universo es, al menos en una escala muy grande, elíptico.

En un universo cerrado carente del efecto repulsivo de la energía oscura, la gravedad acabará por detener la expansión del universo, después de lo que empezará a contraerse hasta que toda la materia en el universo se colapse en un punto. Entonces existirá una singularidad final llamada el Big Crunch, por analogía con el Big Bang. Sin embargo, si el universo tiene una gran suma de energía oscura (como sugieren los hallazgos recientes), entonces la expansión será grande.

Universo abierto

Si Ω<1, la geometría del espacio es abierta, p.ej., negativamente curvada como la superficie de una silla de montar. Los ángulos de un triángulo suman menos de 180 grados (llamada primera fase) y las líneas paralelas no se encuentran nunca equidistantes, tienen un punto de menor distancia y otro de mayor. La geometría del universo sería hiperbólica.

Incluso sin energía oscura, un universo negativamente curvado se expandirá para siempre, con la gravedad apenas ralentizando la tasa de expansión. Con energía oscura, la expansión no sólo continúa sino que se acelera. El destino final de un universo abierto es, o la muerte térmica” o “Big Freeze” o “Big Rip”, dónde la aceleración causada por la energía oscura terminará siendo tan fuerte que aplastará completamente los efectos de las fuerzas gravitacionales, electromagnéticas y los enlaces débiles.

Universo plano

Si la densidad media del universo es exactamente igual a la densidad crítica tal que Ω=1, entonces la geometría del universo es plana: como en la geometría ecuclidiana, la suma de los ángulos de un triángulo es 180 grados y las líneas paralelas nunca se encuentran.

Sin energía oscura, un universo plano se expande para siempre pero a una tasa continuamente desacelerada: la tasa de expansión se aproxima asintóticamentre a cero. Con energía oscura, la tasa de expansión del universo es inicialmente baja, debido al efecto de la gravedad, pero finalmente se incrementa. El destino final del universo es el mismo que en un universo abierto, la muerte caliente del universo, el “Big Freeze” o el “Big Rip”. En 2005, se propuso la teoría del destino del universo Fermión-Bosón, proponiendo que gran parte del universo estaría finalmente ocupada por condensado de Bose-Einstein y la quasipartícula análoga al fermión, tal vez resultando una implosión. Muchos datos astrofísicos hasta la fecha son consistentes con un universo plano.

La teoría del Big Crunch es un punto de vista simétrico del destino final del Universo. Justo con el Big Bang empezó una expansión cosmológica, esta teoría postula que la densidad media del Universo es suficiente para parar su expansión y empezar la contracción. De ser así, se vería cómo las estrellas tienden a ultravioleta, por efecto Doppler. El resultado final es desconocido; una simple extrapolación sería que toda la materia y el espacio-tiempo en el Universo se colapsaría en una singularidad espaciotemporal adimensional, pero a estas escalas se desconocen los efectos cuánticos necesarios para ser considerados -se aconseja mirar en Gravedad-Cuántica-..

Este escenario permite que el Big Bang esté precedido inmediatamente por el Big Crunch de un Universo precedente. Si esto ocurre repetidamente, se tiene un universo oscilante. El Universo podría consistir en una secuencia infinita de Universos finitos, cada Universo finito terminando con un Big Crunch que es también el Big Bang del siguiente Universo. Teóricamente, el Universo oscilante no podría reconciliarse con la segunda ley de la termodinámica:

la entropía aumentaría de oscilación en oscilación y causaría la muerte caliente. Otras medidas sugieren que el Universo no es cerrado. Estos argumentos indujeron a los cosmólogos a abandonar el modelo del Universo oscilante. Una idea similar es adoptada por el modelo cíclico, pero esta idea evade la muerte caliente porque de una expansión de branas se diluye la entropía acumulada en el ciclo anterior.

Como podéis comprobar por todo lo anteriormente leído, siempre estamos tratando de saber en qué universo estamos y pretendemos explicar lo que pudo pasar desde aquel primer momento que no hemos podido comprender de manera exacta y científicamente autosuficiente para que sea una ley inamovible del nacimiento del universo. Simplemente hemos creado modelos que se acercan de la mejor manera a lo que pudo ser y a lo que podría ser.

Totales: 84.751.458

Totales: 84.751.458 Conectados: 99

Conectados: 99