Jun

7

De lo pequeño a lo grande

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Los fermiones no quieren juntarse, los bosones sí

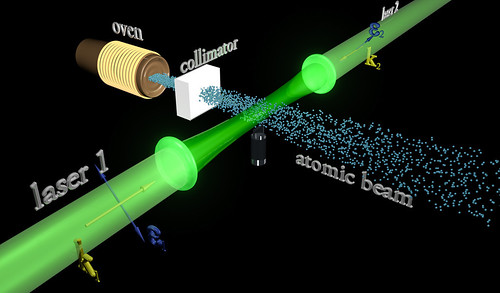

Debido al principio de exclusión de Pauli, es imposible que dos fermiones ocupen el mismo estado cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental para explicar el fenómeno de la super-fluidez. A temperaturas muy bajas (del orden de 2×10-7º K) se puede formar un condensado de Bose-Einstein, en el que varios miles de átomos forman una única entidad (un super-átomo). Este efecto ha sido observado con átomos de rubidio y litio. Como ha habréis podido suponer, la condensación Bose-Einstein es llamada así en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier número de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un momento angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. Para bosones idénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un estado cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría para explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y unos ajustes ad-hoc, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas.

La relación entre el espín y la estadística de las partículas está demostrada por el teorema espín-estadística. En un espacio de dos dimensiones es posible que existan partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el nombre de aiones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de+1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Resulta fácil comprender cómo forma un campo magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma forma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un campo magnético cuando gira la partícula.

Particularmente creo que, si el neutrón tiene masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Sea como fuere, la rotación del neutrón nos da la respuesta a esas preguntas:

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965

¿Qué es el antineutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos. Es indudable que las antipartículas pueden combinarse para formar la antimateria, de la misma forma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un antideuterón. Desde entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros antinúcleos más complicados aún si se abordara el problema con más interés.

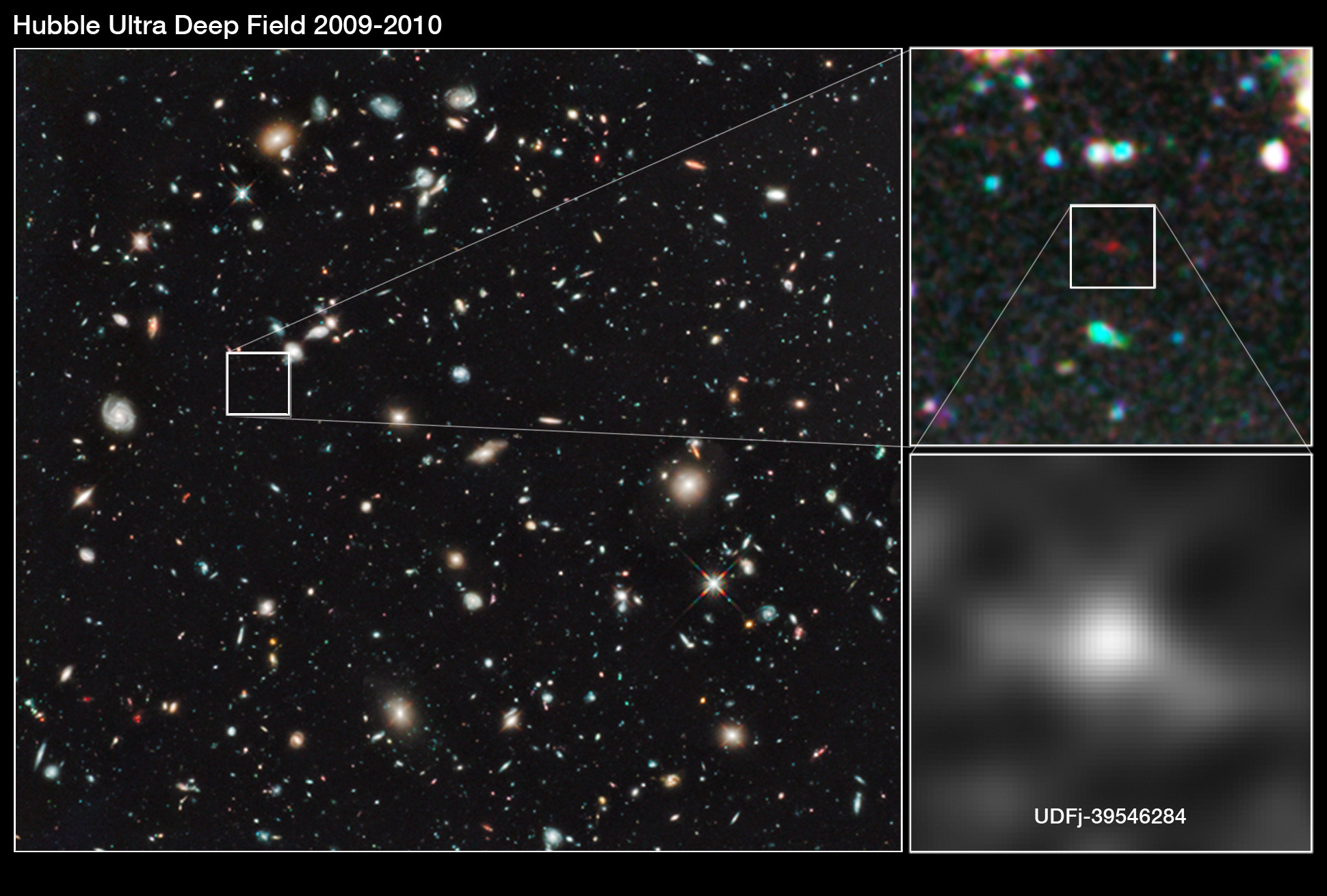

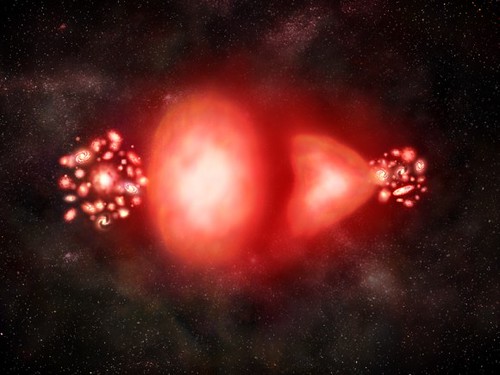

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, para tratar de encontrar alguna actividad inusual que delate interacciones materia-antimateria.

Pero…, ¿Hay masas de antimateria en el Universo? ¿Galaxias de antimateria?

Bueno, sabemos que no son las galaxias las que se alejan, sino que es el espacio el que se expande. Lo que no sabemos es encontrar antimateria en el espacio interestelar y, si la hay y está presente… ¡Aún no la hemos podido localizar! Algunos dicen que hay galaxias de antimateria y, yo digo que tengo un pariente en la galaxia Astrinia del cúmulo Ultramón a diez mil millones de años-luz de nuestra región.

No parece que dichas observaciones, al menos hasta el momento, hayan sido un éxito.

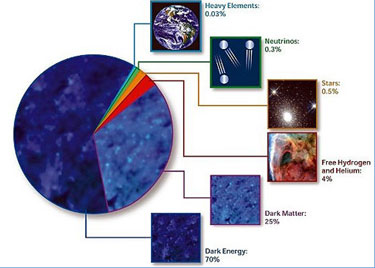

Según estimaciones recientes, resumidas en este gráfico de la NASA, alrededor del 70% del contenido energético del Universo consiste en energía oscura, cuya presencia se infiere en su efecto sobre la expansión del Universo pero sobre cuya naturaleza última no se sabe casi nada.

¿Es posible que el Universo este formado casi enteramente por materia, con muy poca o ninguna antimateria? Y si es así, ¿por qué? dado que la materia y la antimateria son equivalentes en todos los aspectos, excepto en su oposición electromagnética, cualquier fuerza que crease una originaria la otra, y el Universo debería estar compuesta de iguales cantidades de la una y de la otra.

Este es el dilema. La teoría nos dice que debería haber allí antimateria, pero las observaciones lo niegan, no lo respaldan. ¿Es la observación la que falla? ¿Y qué ocurre con los núcleos de las galaxias activas, e incluso más aún, con los causares? ¿Deberían ser estos fenómenos energéticos el resultado de una aniquilación materia-antimateria? ¡No creo! Ni siquiera ese aniquilamiento parece ser suficiente, y los astrónomos prefieren aceptar la noción de colapso gravitatorio y fenómenos de agujeros negros como el único mecanismo conocido para producir la energía requerida.

Estábamos hablando de mecánica cuántica y me pasé, sin que me diera cuenta, al ámbirto de la antimateria y el espacio del macro universo de las galaxias. Sin embargo, y aunque parezcan temas dispares, lo cierto es que, a medida que profundizamos en estas cuestiones, todas nos llevan, de una u otra manera, a relacionar el “mundo de lo muy pequeño” con el “mundo” de lo muy grande que, al fín y al cabo, está hecho de lo que existe en el primero, es decir, partículas infinitesimales de materia y… ¡de antimateria! para que todo quede compensado.

emilio silvera

Jun

7

¡Nuestro “Sentido Común”! Que a veces nos engaña

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

emilio silvera

¡Nuestros predecesores! Para ellos, era absolutamente evidente que la Tierra fuera estable y que estaba inmóvil. Éramos el centro del Universo. La ciencia occidental moderna parte de la negación de este axioma derivado del “sentido común”. Tal negación, origen y prototipo de las mayores paradojas de la ciencia, constituiría nuestra invitación a un mundo invisible e infinito. Llegó un día en que el hombre, se dio cuenta de la desnudez de sus sentidos. “El Sentido común”, pilar de la vida cotidiana, ya no servía para gobernar el mundo. En el momento en que el conocimiento “científico”, sofisticado, dio lugar a verdades incuestionables, las cosas dejaron de ser lo que parecían.

No es lo que parece a primera vista

Las cosmologías antiguas utilizaban mitos pintorescos y convincentes para adornar los veredictos del sentido común y para describir los movimientos de los cuerpos celestes. En los muros de las tumbas de los faraones egipcios del valle de los Reyes encontramos vistosas representaciones del dios del aire sosteniendo la cúpula celeste por encima de la tierra.

Asimismo, observamos que el dios del Sol, Ra, conduce su barca cada día por el cielo y que, cada noche, en otra barca que surca las aguas por debajo de la tierra, retorna al punto de partida de su viaje diurno, que vuelve a iniciar. Como hemos visto, esta visión mítica no impidió que los egipcios elaboraran el más preciso de los calendarios solares, que fue utilizado durante miles de años. Para los egipcios, tales mitos tenían sentido, no contradecían lo que veían cada día y cada noche con sus ojos.

Copérnico – Astrónomo polaco.

Con el tiempo, todo aquello cambió, y, la mente humana evolucionó. ¿Por qué se tomó Nicolás Copérnico tantas molestias para desplazar un sistema que era sostenido con firmeza por la experiencia cotidiana, la tradición y la autoridad? Cuánto más nos familiarizamos con la era de Copérnico, vemos con mayor claridad que los que no se dejaban convencer por él simplemente demostraban sensatez.

Aunque 700 años antes que él, Aristarco de Samos postuló lo mismo u sus coetáneos no le prestaron atención, Copérnico logró que todos mostraran interés en sus postulados y el Sol quedó como centro del Sistema Solar.

Las pruebas de que disponían no exigían una revisión del sistema. Habrían de pasar varias décadas para que los astrónomos y matemáticos reunieran datos nuevos y hallaran nuevos instrumentos, y al menos un siglo para que los legos se convencieran de lo que era contrario al sentido común. Lo cierto es que, pese a todas las modificaciones ideadas por astrónomos y filósofos, el esquema antiguo no incluía todos los datos conocidos. Pero tampoco lo hizo la simplificación de Copérnico. Parece que no era la fuerza de los hechos sino una preocupación estética y metafísica lo que empujaba a Copérnico.

Se le ocurrió que un sistema diferente sería mucho más hermoso. Su mente inquieta y su atrevida imaginación hicieron el resto. Como astrónomo, Copérnico no era más que un aficionado. No se ganaba la vida con la Astronomía ni con ninguna aplicación de esta ciencia. Al menos desde el punto de vista actual, era extraordinariamente polifacético, lo que le sitúa en la línea central del alto Renacimiento. Nació cuando Leonardo da Vinci se encontraba en plena actividad y fue contemporáneo de Miguel Ángel.

Copérnico se daba cuenta de que su sistema parecía transgredir el sentido común. Por esa misma razón, sus amigos habían tenido que “instarlo e incluso apremiarlo hasta el fastidio” para que publicara la obra. “Insistían en que, si bien era posible que al principio mi teoría sobre el movimiento de la Tierra pareciera extraña, resultaría admirable y aceptable una vez que la publicación de mis comentarios aclaratorios disipara las brumas de la paradoja”.

Con todo esto, sólo quiero dejar una pequeña muestra de la dificultad con la que hemos ido avanzando en el camino de la Ciencia. No siempre ha sido un camino de rosas el poder enseñar al mundo la verdadera faz de la Naturaleza, todo vez que, el mundo, la que veía era otra muy distinta y, sus sentidos, se negaban a admitir que las cosas pudieran ser diferentes a como ellos la podían ver.

Galileo por Leoni

Galileo que era un científico de vocación, escribió un libro que se trataba de “Dos ciencias nuevas”, una que se ocupaba de la Mecánica y otra de la Resistencia de los materiales. Como era costumbre en la época, también ese libro fue escrito en italiano y adoptó la forma de diálogo sostenido entre los personajes Salvati, Sagredo y Simplicio. Dado que la Inquisición había prohibido todos sus libros, la obra hubo de ser sacada furtivamente del país para que la publicaran los Elzevir en Leyden. Este fue el último libro de Galileo y en él ponía los cimientos sobre los cuales Huygens y Newton construirían la ciencia de la dinámica y, finalmente, una teoría de la gravitación universal.

Salvati, Sagredo y Simplicio

El microscopio y el telescopio fueron ambos productos de la misma era, pero mientras que Copérnico y Galileo se han convertido en héroes populares, en los profetas de la modernidad, Hooke y Leeuwenhoek, sus equivalentes en el mundo microscópico, han quedado relegados al panteón de las ciencias especializadas. Copérnico y Galileo desempeñaron importantes papeles en la tan conocida batalla entre “ciencia” y “religión”; no sucedió lo mismo con Hooke y Leewwenhoek.

Los astrónomos de todo el planeta conmemoran este martes el cuarto centenario del reconocimiento oficial por parte de las autoridades de la República de Venecia del primer telescopio, un invento del científico italiano Galileo Galilei (1564-1642) que cambió para siempre el rumbo de la Astronomía.

No se sabe quién inventó el microscopio. El principal candidato es Zacharias Jansen, humilde fabricante de anteojos de Middelburg. Si sabemos que el microscopio como las gafas y el telescopio, se usaban mucho antes de que se comprendieran los principios de la óptica, y probablemente su invención fue tan accidental como la del telescopio. No podía haber sido inventado por alguien que quisiera echar una mirada al mundo microscópico nunca imaginado hasta entonces.

Poco después de que fueran fabricados los primeros telescopios, la gente los utilizaba para ver ampliados objetos cercanos. En 1614, Galileo le decía a un visitante: “Con este tubo he visto moscas que parecían tan grandes como corderos, y he comprobado que están cubiertas de pelo y tienen unas uñas muy afiladas mediante las cuales se sostienen y andan sobre el cristal, aunque estén patas arriba, insertando la punta de las uñas en los poros del cristal”.

El aparato llamó la atención del ejército para tener más localizado al enemigo lejano. Más tarde, a Galileo se le ocurrió apuntar su telescopio hacia el cielo, y, ya nunca lo apartó de él. Con aquel simple movimiento, él, cambiaría el mundo y, la Tierra, entró a formar parte de un Sistema mayor que ahora llamamos Universo.

Claro que, lo mismo que se descubrió el mundo de lo muy grande, y, paralelamente, también se descubriría el mundo de lo muy pequeño.

Y se reveló un mundo nuevo

Al igual que el Telescopio había unido la Tierra y los cuerpos celestes más distantes en un solo esquema de pensamiento, las imágenes del microscopio revelaban un mundo minúsculo que se asemejaba de modo sorprendente al que se veía diariamente a gran escala. En Historias Insectorum Generalis, Jan Swammerdam desmostraba que los insectos, como los animales “superiores” poseían una intrincada anatomía y no se reproducían por generación espontánea. En el microscopio vio que los insectos se desarrollaban igual que el hombre, por epigénesis, o desarrollo gradual de un órgano después de otro. Con todo, sobrevivió la creencia en otras formas de generación espontánea, hasta que, en el siglo XIX, Luis Pasteur realizó sus brillantes experimentos.

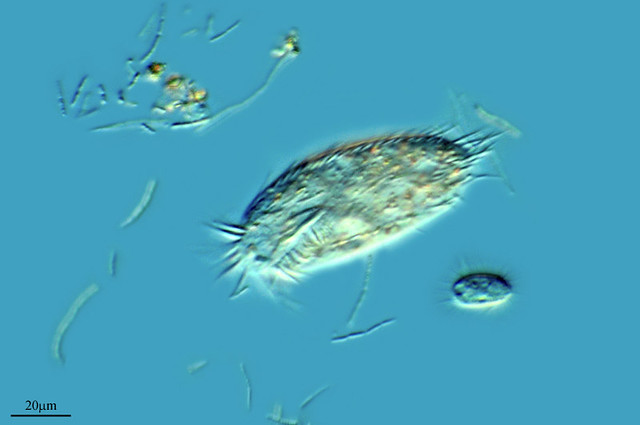

Bacterias.

El microscopio abrió las puertas de oscuros continentes en los que nunca se había entrada con anterioridad y que en muchos sentidos eran fáciles de explorar. Las grandes travesías marítimas habían exigido grandes inversiones, en genio organizador, capacidad de liderazgo y el de carisma de personajes como Colón, Magallanes o Vasco de Gama. La exploración astronómica exigía coordinación de las exploraciones realizadas en distintos lugares y con medios cada vez más costosos. Pero un hombre sólo, situado en cualquier parte con un microscopio, podía aventurarse por vez primera por vericuetos a los que no habían llegado los expertos navegantes o los valerosos pilotos.

Antoni van Leeuwenhoek fue con su microscopio el primer promotor de esta nueva ciencia de la exploración de otros mundos que resultaron estar en este. Sería bonito relatar aquí la historia del personaje pero, no tenemos el espacio necesario para ello.

Os contaré que, en una ocasión, disponiendo de un microscópico, comenzó a buscar algo que hace con él. En septiembre de 1674, por pura curiosidad, llenó un frasco de cristal de un agua turbia y verdosa, que la gente de campo llamaba “rocío de miel”, procedente de un lago pantanoso situado a tres kilómetros de Delft, y bajo la mente de aumento descubrió “muchísimos animáculos diminutos”. A continuación dirigió su microscopio hacia una gota de agua de pimienta, infusión a base de pimienta negra utilizada en sus observaciones:

“Entonces vi con claridad que se trataba de pequeñas anguilas o lombrices apiñadas y culebreando, igual que si viera en un charco lleno de pequeñas anguilas y agua, todas retorciéndose por encima de otras, y parecía que toda el agua estaba vivía y llena de estos múltiples animáculos. Para mí, ésta fue, entre todas las maravillas que he descubierto en la naturaleza, la más maravillosa de todas; y he de decir, en lo que a mí concierne, que no se ha presentado ante mis ojos ninguna visión más agradable que esos miles de criaturas vivientes, todas vivas en un diminuta gota de agua, moviéndose unas junto a otras, y cada una de ellas con su propio movimiento…”

Escherichia coli

Borrelia burgdorferi

Cyanobacterium

sp. (cyanobacterium) and Netrium and Zygnema sp. (green algae)

Holospora undulata

Chromatium

Achromatium

Tras descubrir el mundo de las bacterias, Leeuwenhoek prosiguió la tarea dignificando a estos individuos. Contradiciendo los dogmas aristotélicos relativos a los “animales inferiores”, declaró que cada uno de estos animáculos disponía de la dotación completa de órganos corporales necesarios para el tipo de vida que llevaba.

Con todo este pequeño recorrido, en el que he tomado algunos ejemplos al azar, sólo he querido significar que, la Ciencia, a lo largo de la historia de la Humanidad, ha ido tomando diversos caminos y, unas veces debido a mentes preclaras que tenían el don de “ver” lo que otros no podían, y, otras veces, por hechos del destino y la casualidad o el azar, el hombre, ha podido ir avanzando y conociendo el mundo en el que le ha tocado vivir y, al decir mundo, me refiero no sólo a la Tierra, sino que, me estoy refiriendo al Universo, tanto de lo grande como de lo pequeño. Ahora sabemos que, si nosotros estamos aquí, tal presencia es posible gracias a la existencia de esos minúsculos animáculos que descubriera Leeuwenhoek que, en sus diferentes dominios, hacen lo necesario para que nosotros podamos vivir en simbiosis con ellos y, además, son los verdaderos responsables del clima del planeta que nos permite llevar una vida tranquila gracias a la atmósfera que dichos bichitos fabrican para nosotros.

¡La Ciencia! Son tantas cosas.

emilio silvera

Jun

6

Pensando en voz alta

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Mi consejo: que nuestro comportamiento no sea nunca causante de males ajenos; que nos conformemos y sepamos valorar lo que tenemos; que tratemos cada día de ser mejores adquiriendo nuevos conocimientos, el verdadero sustento del ser.

Cuanto más sabemos, más podemos ofrecer a los demás. Es de sabio saber valorar lo que tenemos. Cuando era un chaval, aquel anciano con experiencia me dijo: “Emilito, si quieres ser feliz, y tienes diez pesetas, gasta ocho y guarda dos. Cuando se gasta más de lo que se tiene… ¡Mal irán las cosas! Estar en manos de la usura nunca te hará feliz ni libre.”

En mi despacho de Asesor fiscal

En mi transcurrir cotidiano, por mi trabajo, veo con mucha pena cómo las personas tratan de engañarse las unas a las otras. Es la forma general, y lo excepcional es el encontrar, muy de tarde en tarde, personas decentes y honradas, mejor o peor preparadas (qué más da) pero nobles de espíritu y limpias de corazón; cuando eso ocurre, es como una ráfaga de aire fresco y perfumado que inunda los sentidos.

Impone Impuestos confiscatorios, no siempre es proporcional a lo que se gana, y, vulneran el art. 31 C.E.

Como lo normal es todo lo contrario, la fealdad interior, el engaño, la falsedad, la ausencia de moralidad y de ética, la traición de los “amigos” o familiares, etc., mi remedio es bien sencillo: me encierro en mi mundo particular de la física, la astronomía y, en definitiva, de cualquier rama del saber que esté presente en ese momento en mis pensamientos, y de esa forma, por unos momentos, me olvido de la fea verdad que nos rodea.

Claro que como antes dije, ¡menos mal!, de vez en cuando nos encontramos con ráfagas de aire puro y perfumado que emiten esos espíritus puros, ¡que los hay! No hace mucho, recibí el Fallo emitido por el Tribunal Económico Administrativo Central que anulaba una Derivación de Responsabilidad que la recaudación de la Agencia Tributaria en Huelva a cargó a una pequeña Empresa a la que quería endosarle 109.000 euros. Hubiera sido su ruina y el T.E.A.C., la anuló por vulnerar el Derecho.

Cuando se quiere recaudar “como sea” se incurre en la prohibida desviación de poder

Pero hablemos de otras cuestiones más divertidas:

El mes pasado (enero de 2007), comenzó y se celebró en la India el 20 International Joint Conference of Artificial Intelligence, un encuentro en el que se pusieron al día todos los avances en inteligencia artificial, y donde fue celebrado el 50 cumpleaños de su creación.

El incremento de los resultados en este campo (ya me referí antes a esta ciencia), ha sido asombroso. Internet es una buena prueba de ello en la búsqueda de información por contenido, comercio electrónico, sistemas de recomendación, web semántica, etc. el futuro de Internet, de la industria y del comercio, de las ciudades futuras, de los viajes espaciales, de la medicina, etc., etc., etc., dependerán de los progresos que se realicen en el ámbito de la inteligencia artificial y en la nanotecnología; ahí parecen estar el progreso del futuro.

La inteligencia artificial, entre otras cosas, podrá llevar y facilitar información a países subdesarrollados que, de esta manera, podrá ofrecer educación a sus habitantes, mejorará la salud de la población, su agricultura, etc. la calidad de vida, en definitiva.

Ya se están desarrollando en Japón los ordenadores inteligentes (los llamados de quinta generación), y el entusiasmo de empresas informáticas japonesas y estadounidenses por la inteligencia artificial aconsejó a Europa no quedarse atrás y acometer sus propios proyectos mediante programas de investigación en estas nuevas tecnologías del futuro.

El término de inteligencia artificial, si no me falla la memoria, se acuñó en la reunión de Dartmouth en 1956, que fue un evento único e histórico. Único porque no se volvió a celebrar, es decir, no fue el primero de un serie como ocurro con los congresos internacionales de lo que, como comenté al principio, se llevan celebrando 20; y fue histórico por el hecho de que allí se acuñó el término que ha prevalecido de inteligencia artificial.

En DartMouth se presentó un único resultado: un programa llamado Logic Theorist, capaz de demostrar teoremas de lógica proporcional contenidos (según leí) en la famosa obra “Principia Matematica” de Bertrand Russell y Alfred Whitehead (la obra más famosa de Newton lleva el mismo título). El programa lo desarrollaron Herbert Simón (que en 1978 recibió el premio Nobel de Economía), Alan Newell y Clifford Shaw. Sin embargo, en éste de enero en la India, se presentaron 470 resultados seleccionados entre los casi 1.400 que recibieron.

Desde aquella reunión del 56, los hitos alcanzados en el campo de la IA han sido extraordinarios: desde jugar al ajedrez hasta diagnosticar enfermedades, comprender textos sobre temas concretos que implican conocimientos especializados… No obstante, el objetivo de desarrollar las inteligencias artificiales generales que los pioneros de esta ciencia, reunidos en 1956, propusieron para ser alcanzados, quedan aún muy lejanos.

Pero todo llegará; todo es cuestión de ¡tiempo!

Esta ciencia le debe mucho a las matemáticas. Alan Turing es un ejemplo. Fue un gran matemático que formalizó conceptos tan básicos para la informática como el concepto de algoritmo y el concepto de calculabilidad mediante la denominada Máquina de Turing, lo que nos lleva a considerar a Turing como a uno de los “padres” de la informática y, más concretamente, de la informática teórica. En 1950 publicó un ensayo, “Computing Machinery and Intelligence”, donde describió su famoso Test de Turing, según el cual se podría determinar si una máquina es o no inteligente. La IA le debe pues el test que lleva su nombre, pero la informática le debe más.

Está claro que la IA se aliará y formará equipo con la biología y la nanotecnología, y de esta unión surgirán avances que ahora ni podemos imaginar en nuestra actual comprensión (limitada) de la inteligencia artificial.

Como siempre me ocurre, cuando me pongo a escribir estoy hablando conmigo mismo y traslado la conversación al papel. En los garabatos quiero expresar lo que recuerdo, lo que he leído, lo que he estudiado del tema que en ese momento ocupa mi atención, y así ocurre que, no siendo infalible, los errores pueden ser muchos y algunas explicaciones o comentarios poco documentados (consulto muy poco escribiendo y me dejo llevar), por lo que pido disculpas. Sin embargo, mis lectores (que son pocos y buenos amigos), ganan en frescura y espontaneidad; el texto es más natural y en él están ausentes las artificialidades. Creo que salen ganando.

Lo que quería decir antes (como otras veces me he ido por las ramas), es que puedo comenzar hablando de una cuestión y terminar hablando de otra muy distinta. Me vienen a la mente temas diversos, y de manera natural, sigo mis pensamientos, y así lo expreso en la hoja en blanco.

Es costosa, la dan los estudios, los años de experiencia, y… ¡También la conciencia de cada cual!

¿No resulta más ameno? De todas formas, siempre trato de finalizar los temas. Básicamente soy un insaciable buscador de la razón de ser de las cosas; todo me parece interesante. Mi curiosidad es ilimitada y mi vehemencia y pasión me llevan, a veces, a olvidarme de comer o (más grave aún), de recoger a mi mujer, que en un pueblo cercano espera mi llegada como habíamos quedado. Son cosas corrientes de mi manera de ser, que cuando emprendo una tarea, una lectura, o un proyecto, lo quiero tener terminado antes de empezar.

Leo cualquier titular en un periódico: “Instalan un observatorio bajo el hielo para estudiar los confines del cosmos. Cuando esté en marcha, los científicos esperan que detecte 1.000 colisiones diarias de neutrinos, partículas minúsculas que nos traen información del universo.” No puedo, a partir de ahí, evitar el comprar el periódico o la revista para leer todo el reportaje completo, aunque sé que no dirán nada que ya no sepa sobre los neutrinos y la manera de cazarlos en las profundidades de la Tierra, en profundas minas abandonadas en las que colocan tanques de agua pesada que, conectados a potentes ordenadores, detectan la presencia de estas diminutas partículas (al parecer carentes de masa) que pertenecen a la familia de los leptones.

Cada segundo que pasa, billones de estas minúsculas partículas invisibles llamadas neutrinos, atraviesan nuestros cuerpos, en muchos casos, después de haber recorrido de un confín a otro todo el universo.

Los neutrinos, al contrario que los fotones (es decir, la luz) o los rayos cósmicos, viajan sin cesar de un lado a otro del universo sin que ningún campo magnético los desvíe de su camino, y sin ser destruidos tras colisionar con otras partículas, ya que apenas poseen carga eléctrica ni interaccionan con la materia. Por ello, estudiar de cerca un neutrino permitiría descubrir su procedencia y aportaría a los científicos una valiosa información sobre los rincones del universo de los que provienen.

Bajo una mina a gran profundidad en un recipiente de agua pesada los quieren “cazar”

El problema que se plantea es que agarrar un neutrino no es tarea nada fácil, y aunque se cree que el neutrino puede ser el mensajero cósmico ideal, primero habrá que retenerlo para poder hacer la comprobación. Esta partícula fue anunciada o prevista su existencia por Wolfgan Pauli, y su nombre, neutrino (pequeño neutro en italiano), se lo puso el físico Enrico Fermi.

Aunque parezca no venir a cuento, me viene a la mente que el fin de la Edad de Hielo, hace 300 millones de años fue precedido por bruscos cambios en el nivel de dióxido de carbono (CO2), alteraciones violentas del clima y efectos drásticos sobre la vegetación del planeta.

Pero, ¡¿qué estamos haciendo ahora?! La irresponsabilidad de algunos seres humanos es ilimitada.

Hace 300 millones de años, el hemisferio sur del planeta estaba casi totalmente cubierto por el hielo; los océanos del norte eran una sola masa gélida y los trópicos estaban dominados por espesas selvas, pero 40 millones de años después, el hielo había desaparecido; el mundo era un lugar ardiente y árido. La vegetación era escasa y los vientos secos soplaban sobre una superficie donde casi no había vegetación. Sólo un reptil podría sobrevivir en aquellas condiciones.

Ahora parece que estamos decididos a repetirlo. ¿Qué hará Gaia para defenderse? Creo que hará lo que estime necesario para preservar su integridad, y si para ello es preciso eliminar a los molestos bichitos que causaron el mal, no creo que dude en hacerlo, ya que los acogió, les ofreció todos los recursos necesarios para la supervivencia, y el pago no fue, precisamente, el más adecuado.

Lo peor de todo esto es que el comportamiento de unos pocos lo pagaremos todos. Es como cuando un niño molesta en el colegio y el maestro castiga a toda la clase.

emilio silvera

Jun

6

El universo cuántico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Veamos las partículas elementales de vida superior a 10-20 segundos que eran conocidas en el año 1970.

| Nombre | Símbolo | Masa (MeV) | Carga | Espín | Vida media (s) |

| Fotón | γ | 0 | 0 | 1 | ∞ |

| Leptones (L = 1, B = 0) | |||||

| Electrón | e– | 0’5109990 | – | ½ | ∞ |

| Muón | μ– | 105’6584 | – | ½ | 2’1970 × 10-6 |

| Tau | τ | ||||

| Neutrino electrónico | νe | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino muónico | νμ | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino tauónico | ντ | ~ 0 | 0 | ½ | ~ ∞ |

| Mesones (L = 0, B = 0) | |||||

| Pión + | π+ | 139’570 | 2’603 × 10-8 | ||

| Pión – | π– | 139’570 | 2’603 × 10-8 | ||

| Pión 0 | π0 | 134’976 | 0’84 × 10-16 | ||

| Kaón + | k+ | 493’68 | 1’237 × 10-8 | ||

| Kaón – | k– | 493’68 | 1’237 × 10-8 | ||

| Kaón largo | kL | 497’7 | 5’17 × 10-8 | ||

| Kaón corto | kS | 497’7 | 0’893 × 10-10 | ||

| Eta | η | 547’5 | 0 | 0 | 5’5 × 10-19 |

| Bariones (L = 0, B = 1) | |||||

| Protón | p | 938’2723 | + | ½ | ∞ |

| Neutrón | n | 939’5656 | 0 | ½ | 887 |

| Lambda | Λ | 1.115’68 | 0 | ½ | 2’63 × 10-10 |

| Sigma + | Σ+ | 1.189’4 | + | ½ | 0’80 × 10-10 |

| Sigma – | Σ– | 1.1974 | – | ½ | 7’4× 10-20 |

| Sigma 0 | Σ0 | 0 | ½ | 1’48 × 10-10 | |

| Ksi 0 | Ξ0 | 1.314’9 | 0 | ½ | 2’9 × 10-10 |

| Ksi – | Ξ– | 1.321’3 | – | ½ | 1’64 × 10-10 |

| Omega – | Ω– | 1.672’4 | – | 1½ | 0’82 × 10-10 |

Para cada leptón y cada barión existe la correspondiente antipartícula, con exactamente las mismas propiedades a excepción de la carga que es la contraria. Por ejemplo, el antiprotón se simboliza con ‾p y el positrón con e+. Los mesones neutros son su propia antipartícula, y el π+ es la antipartícula del π–, al igual que ocurre con k+ y k–. El símbolo de la partícula es el mismo que el de su antipartícula con una barra encima. Las masas y las vidas medias aquí reflejadas pueden estar corregidas en este momento, pero de todas formas son muy aproximadas.

Los símbolos que se pueden ver algunas veces, como s (extrañeza) e i (isospín) están referidos a datos cuánticos que afectan a las partículas elementales en sus comportamientos. En la física de partículas el isospín es un número cuántico relacionado con la interacción fuerte y aplicado a interacciones del protón y el neutrón.

Debo admitir que todo esto tiene que sonar algo misterioso. Es difícil explicar estos temas por medio de la simple palabra escrita sin emplear la claridad que transmiten las matemáticas, lo que, por otra parte, es un mundo secreto para el común de los mortales, y ese lenguaje es sólo conocido por algunos privilegiados que, mediante un sistema de ecuaciones pueden ver y entender de forma clara, sencilla y limpia, todas estas complejas cuestiones.

Ecuación dinámica de rotación Momento angular

Si hablamos del espín (o, con más precisión, el momento angular, que es aproximadamente la masa por el radio por la velocidad de rotación) se puede medir como un múltiplo de la constante de Planck, h, dividido por 2π. Medido en esta unidad y de acuerdo con la mecánica cuántica, el espín de cualquier objeto tiene que ser o un entero o un entero más un medio. El espín total de cada tipo de partícula – aunque no la dirección del mismo – es fijo.

El electrón, por ejemplo, tiene espín ½. Esto lo descubrieron dos estudiantes holandeses, Samuel Gondsmit (1902 – 1978) y George Uhlenbeck (1900 – 1988), que escribieron sus tesis conjuntamente sobre este problema en 1972. Fue una idea audaz que partículas tan pequeñas como los electrones pudieran tener espín, y de hecho, bastante grande. Al principio, la idea fue recibida con escepticismo porque la “superficie del electrón” se tendría que mover con una velocidad 137 veces mayor que la de la luz, lo cual va en contra de la teoría de la relatividad general en la que está sentado que nada en el universo va más rápido que la luz, y por otra parte, contradice E=mc2, y el electrón pasada la velocidad de la luz tendría una masa infinita.

Hoy día, sencillamente, tal observación es ignorada, toda vez que el electrón carece de superficie.

Las partículas con espín entero se llaman bosones, y las que tienen espín entero más un medio se llaman fermiones. Consultado los valores del espín en la tabla anterior podemos ver que los leptones y los bariones son fermiones, y que los mesones y los fotones son bosones. En muchos aspectos, los fermiones se comportan de manera diferente de los bosones. Los fermiones tienen la propiedad de que cada uno de ellos requiere su propio espacio: dos fermiones del mismo tipo no pueden ocupar o estar en el mismo punto, y su movimiento está regido por ecuaciones tales que se evitan unos a otros. Curiosamente, no se necesita ninguna fuerza para conseguir esto. De hecho, las fuerzas entre los fermiones pueden ser atractivas o repulsivas, según las cargas. El fenómeno por el cual cada fermión tiene que estar en un estado diferente se conoce como el principio de exclusión de Pauli. Cada átomo está rodeado de una nube de electrones, que son fermiones (espín ½). Si dos átomos se aproximan entre sí, los electrones se mueven de tal manera que las dos nubes se evitan una a otra, dando como resultado una fuerza repulsiva. Cuando aplaudimos, nuestras manos no se atraviesan pasando la uno a través de la otra. Esto es debido al principio de exclusión de Pauli para los electrones de nuestras manos que, de hecho, los de la izquierda rechazan a los de la derecha.

En contraste con el característico individualismo de los fermiones, los bosones se comportan colectivamente y les gusta colocarse todos en el mismo lugar. Un láser, por ejemplo, produce un haz de luz en el cual muchísimos fotones llevan la misma longitud de onda y dirección de movimiento. Esto es posible porque los fotones son bosones.

Cuando hemos hablado de las fuerzas fundamentales que, de una u otra forma, interaccionan con la materia, también hemos explicado que la interacción débil es la responsable de que muchas partículas y también muchos núcleos atómicos exóticos sean inestables. La interacción débil puede provocar que una partícula se transforme en otra relacionada, por emisión de un electrón y un neutrino. Enrico Fermi, en 1934, estableció una fórmula general de la interacción débil, que fue mejorada posteriormente por George Sudarshan, Robert Marschak, Murray Gell-Mann, Richard Feynman y otros. La fórmula mejorada funciona muy bien, pero se hizo evidente que no era adecuada en todas las circunstancias.

En 1970, de las siguientes características de la interacción débil sólo se conocían las tres primeras:

- La interacción actúa de forma universal sobre muchos tipos diferentes de partículas y su intensidad es aproximadamente igual para todas (aunque sus efectos pueden ser muy diferentes en cada caso). A los neutrinos les afecta exclusivamente la interacción débil.

- Comparada con las demás interacciones, ésta tiene un alcance muy corto.

- La interacción es muy débil. Consecuentemente, los choques de partículas en los cuales hay neutrinos involucrados son tan poco frecuentes que se necesitan chorros muy intensos de neutrinos para poder estudiar tales sucesos.

- Los mediadores de la interacción débil, llamados W+, W– y Z0, no se detectaron hasta la década de 1980. al igual que el fotón, tienen espín 1, pero están eléctricamente cargados y son muy pesados (esta es la causa por la que el alcance de la interacción es tan corto). El tercer mediador, Z0, que es responsable de un tercer tipo de interacción débil que no tiene nada que ver con la desintegración de las partículas llamada “corriente neutra”, permite que los neutrinos puedan colisionar con otras partículas sin cambiar su identidad.

A partir de 1970, quedó clara la relación de la interacción débil y la electromagnética (electrodébil de Weinberg-Salam).

La interacción fuerte (como hemos dicho antes) sólo actúa entre las partículas que clasificamos en la familia llamada de los hadrones, a los que proporciona una estructura interna complicada. Hasta 1972 sólo se conocían las reglas de simetría de la interacción fuerte y no fuimos capaces de formular las leyes de la interacción con precisión.

Como apuntamos, el alcance de esta interacción no va más allá del radio de un núcleo atómico ligero (10–13 cm aproximadamente). La interacción es fuerte. En realidad, la más fuerte de todas.

·De particular interés para la Resonancia Magnética Nuclear (RMN) es el espín de los protones y neutrones del núcleo atómico. En el núcleo atómico, cada protón se pueden aparear con otro protón con espín antiparalelo (algo análogo a lo que sucede con los electrones en los enlaces químicos). Los neutrones también pueden hacerlo.”

Bajo la influencia de esta interacción, las partículas que pueden desintegrarse, las “resonancias” lo hacen muy rápidamente. Un ejemplo es la resonancia Δ, con una vida media de 0’6 × 10-23 s. Esta colisión es extremadamente probable cuando dos hadrones se encuentran a una distancia cercana a 10–13 cm.

Hasta 1972 se pensaba que los mediadores de la interacción fuerte eran los piones, que tienen espín 0 y una masa comprendida entre 135 y 140 MeV. Por ejemplo, la fuerte atracción entre dos protones se debe fundamentalmente al intercambio de un pión. Hoy en día se dice que esto obedece al hecho de que los piones son los hadrones más ligeros y que, como los demás hadrones, están formados por quarks. La interacción fuerte es entonces un efecto secundario de una interacción más fuerte incluso entre quarks. Los mediadores de esta interacción más fuerte son los gluones.

El canibalismo de los gluones Campo de Yang – Mills

Los gluones en realidad son los fotones de Yang-Mills que actúan sobre el color de los quarks. Los quarks son los ladrillos de la materia; forman los protones, neutrones, piones, kaones, etc., o sea, los bariones y los mesones. Cada tipo de quarks (arriba, abajo, extraño, encantado, etc.) pueden tener un color que, en realidad, son cargas más complejas que las cargas eléctricas ordinarias que son positivas o negativas y que se neutralizan mutuamente, así que, la carga eléctrica en los quarks está suplida por “color” rojo, verde o azul (que nada tienen que ver con los colores reales y se eligen por convención). Los quarks con diferente color se atraen entre sí, forman grupos de materia con mezcla de color. Los únicos trozos de materia que pueden encontrarse libremente en la naturaleza son mezcla de quarks que no tienen color (blanco o algún tipo de gris) de acuerdo con la regla que se parece a la siguiente: rojo + verde + azul = blanco.

Los anti-quarks tienen los colores conjugados: magenta, violeta y amarillo. Los gluones transportan a la vez un color y su anti-color, lo que da lugar a nueve combinaciones, pero una mezcla, una superposición de rojo/anti-rojo, verde/anti-verde o azul/anti-azul que no tiene color, no participa. De manera que sólo quedan ocho tipos de gluones.

Aunque de pasada, parece conveniente hacer referencia aquí a las leyes de conservación, tales como la conservación de la energía, la conservación del momento* y también la conservación de la extrañeza (denotada por la letra s).

En la tabla de partículas no he querido incluir los números de extrañeza (s) y de isospín (I3). Pero es de observar que esos números no se conservan siempre que una partícula se desintegra. Esto se debe a que la interacción débil, responsable de la mayoría de las desintegraciones, no respeta estas leyes de conservación. La fuerza electromagnética tampoco conserva el isospín.

emilio silvera

* La magnitud llamada “momento” que se define para cada partícula como el producto de la masa por la velocidad. Volver

Jun

5

Nuevos materiales, nuevos procesos, nuevos dispositivos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Vuelvo a poner esta entrada que me ha sido solicitada por varios de nuestros amigos.

En los últimos años se han desarrollado materiales que, debido a su estructura nanométrica, presentan nuevas propiedades, y por tanto tienen aplicaciones en campos tan diversos como son la transmisión de información mediante luz, el almacenamiento de datos, la generación y el transporte de energía eléctrica, la síntesis de catalizadores, la elaboración de textiles más resistentes, o la implantación de nuevos implantes óseos.

El gran número de nuevos materiales y dispositivos demostradores que se han desarrollado en estos años ha sido fruto, por un lado del desarrollo de sofisticadas técnicas de síntesis, caracterización y manipulación que se han puesto a punto y, por otro, del gran avance en los métodos de computación en la nanoescala (técnicas ab-initio, dinámica molecular, etc.) que se han probado en las grandes instalaciones dedicadas al cálculo científico de altas prestaciones. Es precisamente la combinación de experimentos punteros con métodos teóricos precisos un elemento esencial para comprender un gran número de procesos y mecanismos que operan en la nano-escala.

John A. Pople de Gran Bretaña recibe el Nobel compartido con Walter Kohn

En concreto, una de las aportaciones teóricas más importantes al desarrollo de la Nanotecnología ha llegado de la mano de la Teoría de Funcionales de la Densidad (DFT, en sus siglas en inglés) por la que en 1998 Walter Kohn recibió el Premio Nobel en Química, compartido con John A. Pople, “padre” de la Química Cuántica. Con respecto al desarrollo experimental, cabe resaltar el alto grado de desarrollo de las técnicas SPM para ver y manipular la materia a escala nanométrica en multitud de ambientes diferentes (ultra alto vacío, humedad controlada, celdas catalíticas, temperaturas variables,…). Esta capacidad nos ha permitido diseñar nuevos experimentos con los que comprender el comportamiento de nuevos materiales y dispositivos. Dado la gran variedad de materiales y sus aplicaciones, es imposible en un artículo presentar una visión completa de la situación de la Nanotecnología, por lo que nos vamos a limitar a presentar algunos ejemplos que ilustran el estado actual de este campo.

Hacia la electrónica molecular

Nanocables, el futuro de la Electrónica Electrónica molecular

Debido a su tamaño nanométrico, las estructuras moleculares pueden poner de manifiesto nuevas propiedades electrónicas. Sin embargo, la necesidad de poder producir estructuras nanométricas de forma masiva, tal y como requieren las aplicaciones industriales hace que la manipulación individual de nano-objetos como las moléculas pase a un segundo plano, requiriéndose alternativas más útiles para incorporar la Nanotecnología a los procesos de fabricación. Por esta razón, en los últimos años se están estudiando profusamente las condiciones de formación y las propiedades de capas auto-ensambladas de diferentes moléculas orgánicas sobre superficies.

En estos casos la superficie no sólo proporciona un soporte, sino que posee un papel activo en la formación de diferentes patrones moleculares en dos dimensiones. Así, la posibilidad de generar sistemas auto-ensamblados de moléculas con propiedades bien definidas y dirigidas hacia la realización de funciones concretas abre un camino para cambiar desde el imperante paradigma del silicio en la electrónica hacia otro basado en la electrónica molecular. Este nuevo paradigma será mucho más rico por la gran diversidad de componentes moleculares que pueden entrar en juego. Entre los componentes prometedores para la Nanotecnología, que están relacionados con las moléculas orgánicas, y que habrá que tener en cuenta en el futuro de la microelectrónica, estarán los fullerenos, los nanotubos de carbono y el grafeno, de los que hablamos a continuación.

Los fullerenos o “bucky-balls”

Con este nombre se denomina al conjunto de distintas moléculas cerradas sobre sí mismas con formulación. El más conocido, por lo estable y abundante en naturaleza es el llamado Cn. El más conocido, por lo estable y abundante en la Naturaleza es el llamado C60, que está formado por 12 pentágonos y 20 exágonos, dispuestos como en un balón de futbol. Las aplicaciones Nanotecnológicas que se pueden derivar del uso de esta molécula están todavía en fase de estudio y son muy variadas. Sin embargo, aunque actualmente no existen aplicaciones concretas ya se han sintetizado más de mil nuevas moléculas basadas en fullereno y hay más de cien patentes internacionales registradas. El carácter rectificador de los fullerenos les hace atractivos para su uso en electrónica molecular.

Se encontraron bucky-balls en el Espacio exterior

La formación de este tipo de estructuras se produce más fácilmente de lo que podemos imaginar, pues son uno de los principales integrantes de la carbonilla y se generan abundantemente en cualquier combustión. Sin embargo, a día de hoy uno de los principales problemas para su utilización es el de conseguir una síntesis controlada de fullereno. Esto requiere complicadas técnicas, tales como la vaporización del grafito o la pirolisis láser, que normalmente producen exclusivamente los fullerenos más estables. Recientemente se ha propuesto un nuevo método para conseguirlo basado en principios “nano”. Se trata de partir de una molécula precursora sintetizada de forma tal que sea como un fullereno abierto, con los enlaces rotos saturados por hidrógeno. Esta molécula se puede plegar sobre sí misma mediante una transformación topológica de manera que de lugar a un fullereno. Se trata de partir de una estructura plana (un recortable) para posteriormente ensamblar un objeto en tres dimensiones. Este plegado se consigue mediante un proceso des-hidrogenación catalizada por una superficie. Una vez que la molécula plana ha perdido estos hidrógenos se cierran sobre sí misma de forma espontánea formando un fullereno.

Este proceso se ha podido seguir, entre otras técnicas, mediante imágenes de microscopía túnel in-situ. Los mecanismos existentes en el proceso se pueden entender gracias a los cálculos ab-initio que apoyan la investigación experimental. Esta combinación pone de manifiesto como una molécula plana de carbono sin hidrógeno se pliega espontáneamente. La belleza de este nuevo método de síntesis reside en que si se sintetizan moléculas precursoras planas con diferentes topologías se pueden conseguir moléculas cerradas de diferentes formas, tamaños e incluso que contengan átomos diferentes al Carbono. Así se ha sintetizado por primera vez la molécula C57 N3 sobre una superficie.

Nanotubos de Carbono

Si el descubrimiento del C60 fue un hito importante para la Nanotecnología, el de los llamados Nanotubos de Carbono lo ha superado con creces. Los Nanotubos de Carbono, unas diez mil veces más finos que un cabello, presentan excelentes propiedades físicas y su fabricación resulta relativamente económica. Un cable fabricado de Nanotubos de Carbono resultaría diez veces más ligero que uno de acero con el mismo diámetro pero sería ¡cien veces más resistente! A estas impresionantes propiedades mecánicas se le añaden unas interesantes propiedades eléctricas, puesto que pueden ser tanto conductores como aislantes, según la topología que presenten.

Un Nanotubo de Carbono se obtiene mediante el plegado sobre sí mismo de un plano atómico de grafito (enrollándolo). Según como se pliegue el plano grafítico se obtiene un Nanotubo que puede conducir la corriente eléctrica, ser semiconductor o ser aislante. En el primer caso, los Nanotubos de Carbono son muy buenos conductores a temperatura ambiente, pudiendo transportar elevadas densidades de corriente. En el segundo presentan propiedades rectificadoras. Por otra parte, si inducimos defectos en la estructura podemos generar moléculas semiconductoras y así formar diodos o transistores. Es decir, tenemos todos los elementos en nuestras manos para construir nano-circuitos basados en Carbono.

Grafeno

El grafeno es el material del futuro

A un solo plano atómico de grafito se le llama grafeno, y éste, a diferencia del grafito, es difícil de obtener. Recientemente, mediante cálculos teóricos, se han realizado predicciones acerca de las importantes propiedades electrónicas que podría tener este material. Entre ellas una altísima movilidad electrónica y una baja resistividad, de manera que estos planos atómicos podrían ser los futuros sustitutos del silicio en los dispositivos electrónicos. Ahora bien, al día de hoy, estas propuestas provienen esencialmente de cálculos teóricos y, por tanto, antes de que el grafeno pase a sustituir al silicio en la electrónica del futuro, es necesario verificar las predicciones teóricas en el laboratorio. Actualmente, éste es un campo muy activo de investigación, y muchos grupos están trabajando en la obtención de capas de grafeno soportadas sobre diferentes materiales, como polímeros o aislantes, para poder determinar sus propiedades eléctricas y comprobar las predicciones teóricas.

El estudio de grafeno sobre metales de transición es un campo muy activo de investigación ya que las capas de grafeno crecen de manera fácil, muy controladas y con un bajo número de defectos sobre estas superficies. Además el grafeno sobre un substrato forma patrones conocidos como redes de Moiré, en las que la periodicidad atómica de las dos redes cristalinas (substrato y grafeno), coincide cada dos-tres nm, dando lugar a deformaciones de la capa de grafeno, que se reflejan como prominencias en la imagen STM.

Nanohilos

No sólo las moléculas, los Nanotubos o el grafeno son las apuestas para sustituir al silicio. Otros elementos como los Nanohilos fabricados a partir de materiales semiconductores o los Nanohilos metálicos tendrán también cierto protagonismo. En concreto, los Nanohilos semiconductores presentan un gran potencial como transistores pero también presentan aplicaciones en campos como octoelectrónica o en la fabricación de censores biológicos. Por otro lado los Nanohilos metálicos, cuya síntesis controlada es más difícil, poseen gran interés como interconectores. En el caso de los Nanohilos formados de materiales Ni, Co o Fe se puede aprovechar también su potencial comportamiento magnetorresisitivo para ser usados en dispositivos de almacenamiento magnético. Los Nanohilos metálicos son interesantes a su vez porque los efectos de tamaño inducen en ellos la aparición de transiciones de fase martensíticas y la aparición de configuraciones no cristalinas.

En el próximo hablaremos de las Nanopartículas.

Fuente: Revista de Física de la RSEF

Totales: 85.615.804

Totales: 85.615.804 Conectados: 69

Conectados: 69