Jul

7

¿Qué pasa en Júpiter? Ahora lo sabremos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Conquista del Espacio ~

Clasificado en La Conquista del Espacio ~

Comments (2)

Comments (2)

Tras un viaje de cinco años, la sonda de la NASA llega al gigante gaseoso para desvelar, entre otros, su principal secreto: ¿es rocoso el centro del planeta?

“Yo soy el tiempo, destructor de mundos, y he venido a devorarlos a todos”. Así se expresaba Shiva, el dios de la destrucción de la mitología hindú, según el Bhagavad-gītā. Una figura cuyo papel era el de traer la destrucción para que todo pudiera ser creado nuevamente. Curiosamente, algunos modelos astrofísicos otorgan al planeta Júpiter un papel similar al de esta deidad, ya que aseguran que arrasó con los primeros planetas del Sistema Solar y permitió la formación de nuevos planetas en los que pudo surgir la vida.

Júpiter es grande. Enorme. Es lo primero que se puede decir de este gigante gaseoso, al que los romanos bautizaron como al padre de los dioses y de los hombres. Esta afirmación puede parecer una simpleza, pero no lo es, puesto que su enorme tamaño, más del doble que el resto de planetas juntos, es el que hace que este titán encierre muchos de los secretos sobre el origen de nuestro Sistema Solar.

Después del Sol, Júpiter es el cuerpo astronómico que más influencia tiene en el resto de los planetas y “a lo largo de la historia ha jugado un papel fundamental para llegar a la configuración que actualmente ocupan los planetas”, explica a EL ESPAÑOLl Santiago Pérez, investigador del grupo de Ciencias Planetarias de la Universidad del País Vasco.

“A veces incluso se refieren a Júpiter como una especie de paraguas gravitacional”, explica Pérez ya que “acapara la caída de objetos, como restos de la formación planetaria, cometas o incluso asteroides”. En suma, este enorme planeta ha sido uno de los principales actores en la formación y la evolución de nuestro vecindario cósmico.

Es por esto que se han dedicado tantos esfuerzos para averiguar lo más posible sobre este gran planeta. El último ha sido la misión Juno cuyo fin es escudriñar en su interior, más allá de la densa capa de nubes que nos oculta su interior.

El increíble viaje de Juno

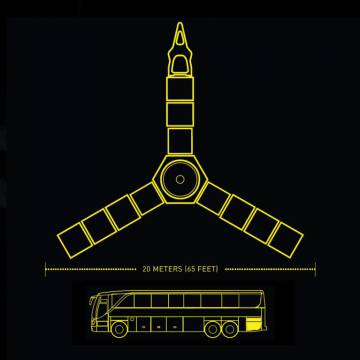

Juno inició su viaje el 5 de agosto de 2011. Con un diámetro aproximado de 3,5 metros y un peso de 3.600 kg, esta nave partió hacia el gigante gaseoso como antes lo habían hecho las misiones Pioneer, Voyager o Ulysses. Pero a diferencia de éstas, Juno se quedará. La nave de la NASA permanecerá en la órbita de Júpiter durante algo más de año y medio, como también lo hizo la sonda Galileo entre 1995 y 2003.

Su travesía por el cosmos terminó poco antes de las 4 de la mañana del pasado 5 de julio. Tras casi cinco años de viaje y cerca de 2.800 millones de kilómetros recorridos, Juno llegó a su destino a la extraordinaria velocidad de más de 250.000 kilómetros por hora (200 veces más rápido que una bala). Una vez en su órbita, la sonda se quedará flotando frente a Júpiter a una distancia que variará entre los 4.000 y los 8 millones de kilómetros.

La sonda va a pelar Júpiter como si fuera una cebolla y nos va a mostrar capas que hasta ahora no habíamos visto

El viaje ha sido largo, pero va a permitir a los científicos ver el interior de este planeta con una precisión que nunca habíamos tenido. “Nos va a pelar Júpiter como si fuera una cebolla y nos va a mostrar capas que hasta ahora no habíamos visto”, afirma Pérez. Pero de entre todas las cosas que puede ver Juno, “la más importante para la ciencia es determinar si tiene o no un núcleo rocoso”, afirma este astrofísico.

¿Tendrá Júpiter un núcleo rocoso?

Durante la etapa de formación del Sistema Solar el germen de este planeta se fue alimentando de los restos de gas y polvo que quedaron cuando se formó el Sol. De esta forma, Júpiter acabo convertido en un gigante compuesto principalmente de helio e hidrógeno y cuyo tamaño, de unos 140.000 kilómetros de diámetro, se acerca al de algunas estrellas menores.

Sin embargo, cómo sucedió esto es algo que no está tan claro. Existen fundamentalmente dos opciones. Por un lado están las hipótesis que plantean que en primer lugar se formó un núcleo rocoso, que posteriormente fue capturando todo el gas a su alrededor. Sin embargo, otra hipótesis plantea que no hizo falta la formación de tal núcleo, sino que parte de la nube de gas del sistema solar primigenio colapsó formando directamente el planeta.

Aunque las diferencias entre estos escenarios parecen nimias, determinar cuál de los dos es el válido nos dirá cómo se forman los planetas gigantes y, lo que es más importante, “nos va a dar información sobre la frecuencia con la que se originan planetas de este estilo”, explica Pérez. Según este investigador, “si no necesitas crear primero un núcleo, podría ser más sencillo tener planetas gigantes, con lo que estos serán más frecuentes”.

El origen de la vida

Otro de los aspectos interesante de este planeta es que al haberse formado en los inicios del Sistema Solar, aún mantiene elementos que pueden proporcionar información sobre los componentes originales. “Es como si tuviéramos una muestra de la nebulosa protoplanetaria que nos dará una información directa sobre la cantidad de agua que teníamos en aquel momento”, explica Pérez.

Precisamente uno de los objetivos de Juno será medir la cantidad de agua y amoníaco en la atmósfera de Júpiter. Como estos compuestos son volátiles se han evaporado en aquellos planetas más cercanos al Sol, sin embargo, “Júpiter está en la frontera y nos podría dar información sobre la cantidad de agua que había en el sistema solar primigenio”, explica este astrofísico. En definitiva, el conocimiento de la abundancia de agua en su atmósfera puede ayudarnos a comprender la formación de estos planetas e incluso nos puede ofrecer pistas sobre el origen del agua en la Tierra.

Aún está por ver si las hipótesis que definen a Júpiter como un destructor de mundos son ciertas. Probablemente Juno no sea capaz de dar respuesta a esta pregunta, pero sin duda, logrará desvelar algunos de los secretos que el gigante gaseoso guarda bajo su manto de nubes.

Jul

6

Desde los átomos hasta las estrellas: Un largo viaje

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astrofísica ~

Clasificado en Astrofísica ~

Comments (0)

Comments (0)

“Pues yo he sido a veces un muchacho y una chica,

Un matorral y un pájaro y un pez en las olas saladas.”

Esto nos decía Empédocles, el padre de aquellos primitivos elementos formados por Agua, tierra, aire y fuego que, mezclados en la debida proporción, formaban todas las cosas que podemos ver a nuestro alrededor. Claro que, él no podía llegar a imaginar hasta donde pudimos llegar después en la comprensión de la materia a partir del descubrimiento de las partículas “elementales” que formaban el átomo. Pero sí, con sus palabras, nos quería decir que, la materia, una veces está conformando mundos y, en otras, estrellas y galaxias.

Sí, hay cosas buenas y malas pero todas deben ser conocidas para poder, en el primer caso aprovecharlas, y en el segundo, prevenirlas. Está claro, y nuestra Historia nos lo cuenta que, no siempre hemos sabido ver donde estaba situada la mala para poder prevenirla y, esa ignorancia nos costó muy cara. Precisamente por eso es bueno saber sobre el por qué de las cosas.

Pero demos un salto en el tiempo y viajemos hasta los albores del siglo XX cuando se hacía cada vez más evidente que alguna clase de energía atómica era responsable de la potencia del Sol y del resto de las estrellas que más lejos, brillaban en la noche oscura. Ya en 1898, sólo dos años despuès del descubrimiento de la radiactividad por Becquerel, el geólogo americano Thomas Chrowder Chamberlin especulaba que los átomos eran “complejas organizaciones y centros de enormes energías”, y que “las extraordinarias condiciones que hay en el centro del Sol pueden…liberar una parte de su energía”. Claro que, por aquel entonces, nadie sabía cual era el mecanismo y cómo podía operar, hasta que no llegamos a saber mucho más sobre los átomos y las estrellas.

Conseguimos tener los átomos en nuestras manos

El intento de lograr tal comprensión exigió una colaboración cada vez mayor entre los astrónomos y los físicos nucleares. Su trabajo llevaría, no sólo a resolver la cuestión de la energía estelar, sino también al descubrimiento de una trenza dorada en la que la evolución cósmica se entrelaza en la historia atómica y la estelar.

La Clave: Fue comprender la estructura del átomo. Que el átomo tenía una estructura interna podía inferirse de varias líneas de investigación, entre ellas, el estudio de la radiactividad: para que los átomos emitiesen partículas, como se había hallado que lo hacían en los laboratorios de Becquerel y los Curie, y para que esas emisiones los transformasen de unos elementos en otros, como habían demostrado Rutherford y el químico inglés Frederick Soddy, los átomos debían ser algo más que simples unidades indivisibles, como implicaba su nombre (de la voz griega que significa “imposible de cortar”).

El átomo de Demócrito era mucho más de lo que él, en un principio intuyó que sería. Hoy sabemos que está conformado por diversas partículas de familias diferentes: unas son bariones que en el seno del átomo llamamos nucleones, otras son leptones que giran alrededor del núcleo para darle estabilidad de cargas, y, otras, de la familia de los Quarks, construyen los bariones del núcleo y, todo ello, está, además, vigilado por otras partículas llamadas bosones intermedios de la fuerza nuclear fuerte, los Gluones que, procuran mantener confinados a los Quarks.

Pero no corramos tanto, la física atómica aún debería recorrer un largo camino para llegar a comprender la estructura que acabamos de reseñar. De los trs principales componentes del átomo -el protón, el neutrón y el electrón-, sólo el electrón había sido identificado (por J.J. Thomson, en los últimos años del siglo XIX). Nadie hablaba de energía “nuclear” pues ni siquiera se había demostrado la existencia de un núcleo atómico, y mucho menos de sus partículas constituyentes, el protón y el neutrón, que serían identificados, respectivamente, por Thomson en 1913 y James Chawick en 1932.

De importancia capital resultó conocer la existencia del núcleo y que éste, era 1/100.000 del total del átomo, es decir, casi todo el átomo estaba compuesto de espacios “vacíos” y, la materia así considerada, era una fracción infintesimal del total atómico.

Rutherford, Hans Geiger y Ernest Marsden se encontraban entre los Estrabones y Tolomeos de la cartografía atómica, en Manchester , de 1909 a 1911, sonderaron el átomo lanzando corrientes de “partículas alfa” subatómicas -núcleos de helio- contra delgadas laminillas de oro, plata, estaño y otros metales. La mayoría de partículas Alfa se escapaban a través de las laminillas, pero, para sombro de los experimentadores, algunas rebotaban hacia atrás. Rutherford pensó durante largo tiempo e intensamente en este extraño resultado; era tan sorprendente, señalaba, como si una bala rebotase sobre un pañuelo de papel. Finalmente, en una cena en su casa en 1911, anunció a unos pocos amigos que había dado con una explicación: que la mayoría de la masa de un átomo reside en un diminuto núcleo masivo. Ruthertford pudo calcular la carga y el diámetro máximo del nucleo atómico. Así se supo que los elementos pesados eran más pesados que los elementos ligeros porque los núcleos de sus átomos tienen mayor masa.

Todos sabemos ahora, la función que desarrollan los electrones en el atomo. Pero el ámbito de los electrones para poder llegar a la comprensión completa, tuvo que ser explorado, entre otros, por el físico danés Niels Bohr, quien demostró que ocupaban órbitas, o capas, discretas que rodean al núcleo. (Durante un tiempo Bohr consideró el átomo como un diminuto sistema solar, pero ese análisis, pronto demostró ser inadecuado; el átomo no está rígido por la mecánica newtoniana sino por la mecánica cuántica.)

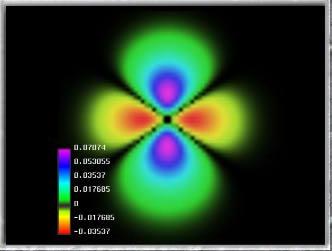

Modelo de Bohr

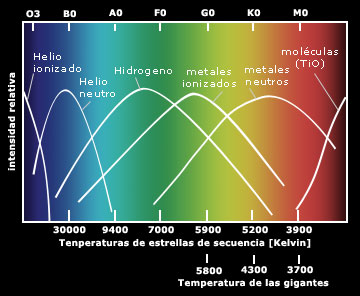

Entre sus muchos otros éxitos, el modelo de Bohr revelaba la base física de la espectroscopia. El número de electrones de un átomo está determinado por la carga eléctrica del núcleo, la que a su vez se debe al número de protones del núcleo, que es la clave de la identidad química del átomo. Cuando un electrón cae de una órbita externa a una órbita interior emite un fotón. La longitud de onda de este fotón está determinada por las órbitas particulares entre las que el electrón efectúa la transición. E esta es la razón de que un espectro que registra las longitudes de onda de los fotones, revele los elementos químicos que forman las estrellas u otros objetos que sean estudiados por el espectroscopista. En palabras de Max Planck, el fundador de la física cuántica, el modelo de Bohr del átomo nos proporciona “la llave largamente buscada de la puerta de entrada al maravilloso mundo de la espectroscopia, que desde el descubrimiento del análisis espectral (por Fraunhoufer) había desafiado obtinadamente todos los intentos de conocerlo”.

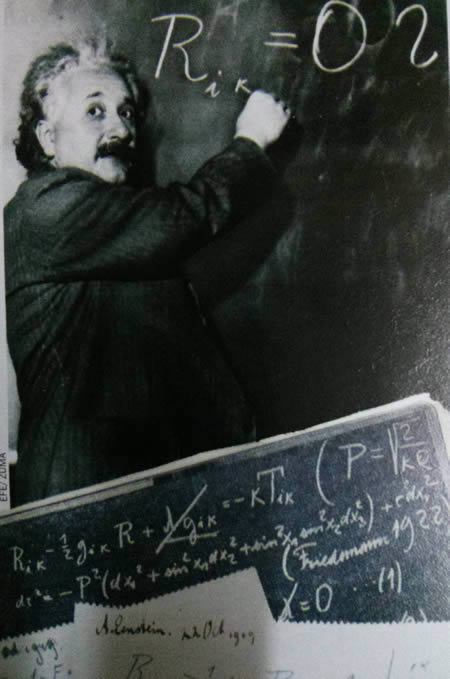

Es curioso que, mirando en la oscura noche como brillan las estrellas del cielo, nos atrae su titilar engañoso (es la atmósfera terrestre la que hace que lo parezca) y su brillo, Sin embargo, pocos llegan a pensar en lo que verdaderamente está allí ocurriendo. Las transformaciones de fase por fusión no cesan. Esta transformación de materia en energía es consecuencia de la equivalencia materia-energía, enunciada por Albert Einstein en su famosa fórmula E=mc2; donde E es la energía resultante, m es la masa transformada en energía, y c es la velocidad de la luz (300 000 kilómetros por segundo). La cantidad de energía que se libera en los procesos de fusión termonuclear es fabulosa. Un gramo de materia transformado íntegramente en energía bastaría para satisfacer los requerimientos energéticos de una familia mediana durante miles de años.

Es un gran triunfo del ingenio humano el saber de qué, están conformadas las estrellas, de qué materiales están hechas. Recuerdo aquí a aquel Presidente de la Real Society de Londres que, en una reunión multitudinaria, llegó a decir: “Una cosa está clara, nunca podremos saber de qué están hechas las estrellas”. El hombre se vistió de gloria con la, desde entonces, famosa frase. Creo que nada, con tiempo por delante, será imposible para nosotros.

Pero, por maravilloso que nos pueda parecer el haber llegado a la comprensión de que los espectros revelan saltos y tumbos de los electrones en sus órbitas de Bohr, aún nadie podía hallar en los espectros de las estrellas las claves significativas sobre lo que las hace brillar. En ausencia de una teoría convincente, se abandonó este campo a los taxonomistas, a los que seguían obstinadamente registrando y catalogando espectros de estrellas, aunque no sabían hacia donde los conduciría esto.

En el Laboratorio de la Universidad de Harvard, uno de los principales centros de la monótona pero prometedora tarea de la taxonomía estelar, las placas fotográficas que mostraban los colores y espectros de decenas de miles de estrellas se apilaban delante de “calculadoras”, mujeres solteras en su mayoría y, de entre ellas, Henrietta Leavitt, la investigadora pionera de las estrellas variables Cefeidas que tan útiles serían a Shapley y Hubble.

Imagen de Sirio A, la estrella más brillante del cielo tomada por el Telescopio Hubble (Créd. NASA). Sirio es la quinta estrella más cercana y tiene una edad de 300, millones de años. Es una estrella blanca de la secuencia principal de tipo espectral A1V con temperatura superficial de 10 000 K y situada a 8,6 años luz de la Tierra. Es una estrella binaria y, de ella, podríamos contar muchas historias. La estrella fue importante en las vidas de Civilizaciones pasadas como, por ejemplo, la egipcia.

Fue Cannon quien, en 1915, empezó a discernir la forma en una totalidad de estrellas en las que estaba presente la diversidad, cuando descubrió que en una mayoría, las estrellas, pertenecían a una de media docena de clases espectrales distintas. Su sistema de clasificación, ahora generalizado en la astronomía estelar, ordena los espectros por el color, desde las estrellas O blanco-azuladas, pasando por las estrellas G amarillas como el Sol, hasta estrellas rojas M. Era un rasgo de simplicidad denajo de la asombrosa variedad de las estrellas.

Pronto se descubrió un orden más profundo, en 1911, cuando el ingeniero y astrónomo autodidacta danés Ejnar Hertzsprung analizó los datos de Cannon y Maury de las estrellas de dos cúmulos, las Híades y las Pléyades. Los cúmulos como estos son genuinos conjuntos de estrellas y no meras alineaciones al azar; hasta un observador poco experimentado salta entusiasmado cuando recorre con el telescopio las Pléyades, con sus estrellas color azul verdoso enredadas en telarañas de polvo de diamante, o las Híades, cuyas estrellas varían en color desde el blanco mate hasta un amarillo apagado.

Las Híades desde más cerca

Hertzsprung utilizó los cúmulos como muestras de laboratorio con las que podía buscar una relación entre los colores y los brillos intrínsecos de las estrellas. Halló tal relación: la mayoría de las estrellas de ambos cúmulos caían en dos líneas suavemente curvadas. Esto, en forma de gráfico, fue el primer esbozo de un árbol de estrellas que desde entonces ha sido llamado diagrama Hertzsprung-Russell.

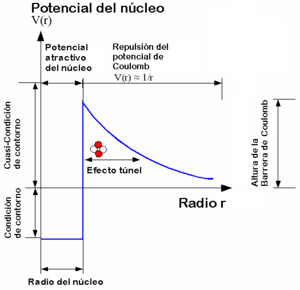

El progreso en física, mientras tanto, estaba bloqueado por una barrera aparentemente insuperable. Esto era literal: el agente responsable era conocido como barrera de Coulomb, y por un tiempo frustó los esfuerzos de las físicos teóricos para comprender como la fusión nuclear podía producir energía en las estrellas.

La línea de razonamiento que conducía a esa barrera era impecable. Las estrellas están formadas en su mayor parte por hidrógeno. (Esto se hace evidente en el estudio de sus espectros.) El núcleo del átomo de Hidrógeno consiste en un solo protón, y el protón contiene casi toda la masa del átomo. (Sabemos esto por los experimentos de Rutherford). Por tanto, el protón también debe contener casi toda la energía latente del átomo de hidrógeno. (Recordemos que la masa es igual a la energía: E = mc2.) En el calor de una estrella, los protones son esparcidos a altas velocidades -el calor intenso significa que las partículas involucradas se mueven a enormes velocidades- y, como hay muchos protones que se apiñan en el núcleo denso de una estrella, deben tener muchísimos choques. En resumen, la energía del Sol y las estrellas, puede suponerse razonablemente, implica las interacciones de los protones. Esta era la base de la conjetura de Eddintong de que la fuente de la energía estelar “difícilmente puede ser otra que la energía subatómica, la cual, como se sabe, existe en abundancia en toda materia”.

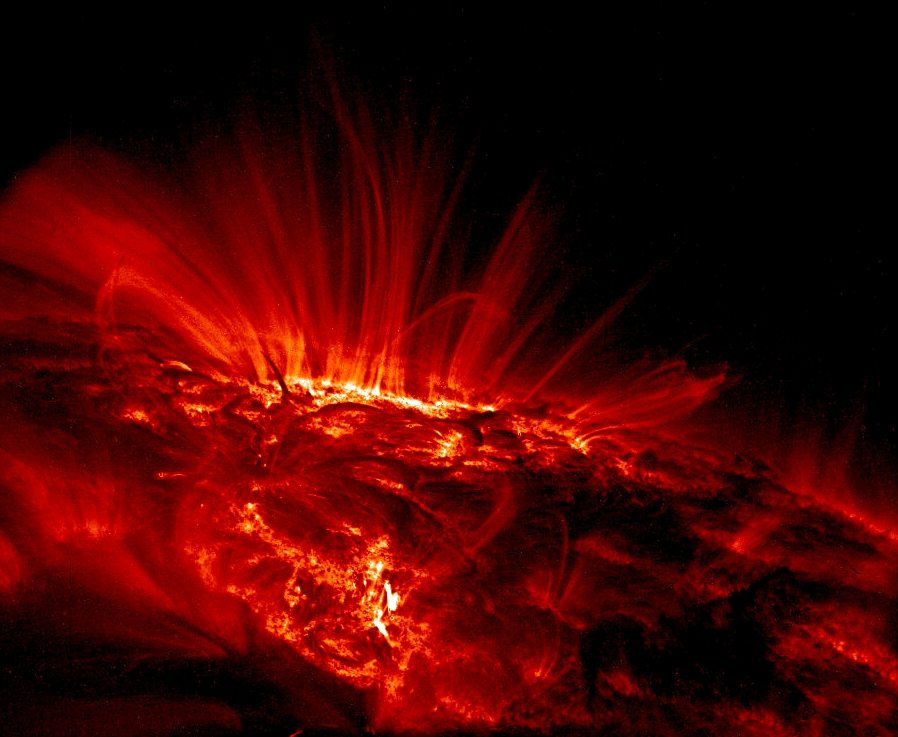

Plasma en ebullición en la superficie del Sol

Hasta el momento todo lo que hemos repasado está bien pero, ¿que pasa con la Barrera de Coulomb? Los protones están cargados positivamente; las partículasd de igual carga se repelen entre sí; y este obstáculo parecía demasiado grande para ser superado, aun a la elevada velocidad a la que los protones se agitaban en el intenso calor del interior de las estrellas. De acuerdo con la física clásica, muy raras veces podían dos protones de una estrella ir con la rapidez suficiente para romper las murallas de sus campos de fuerza electromagnéticos y fundirse en un solo núcleo. Los cálculos decían que la tasa de colisión de protones no podía bastar para mantener las reacciones de fusión. Sin embargo, allí estaba el Sol, con el rostro radiante, riéndose de las ecuaciones que afirmaban que no podía brillar.

Figura que muestra de manera artística el cambio de color cuando en una cavidad subnanométrica se produce el efecto túnel cuántico.

Afortunadamente, en el ámbito nuclear, las reglas de la Naturaleza no se rigen por las de la mecánica de la física clásica, que tienen validez para grandes objetos, como guijarros y planetas, pero pierden esa validez en el reino de lo muy pequeño. En la escala nuclear, rigen las reglas de la indeterminación cuántica. La mecánica cuántica demuestra que el futuro del protón sólo puede predecirse en términos de probabilidades: la mayoría de las veces el protón rebotará en la Barrera de Coulomb, pero de cuando en cuando, la atravesará. Este es el “efecto túnel cuántico”; que permite brillar a las estrellas.

George Gamow, ansioso de explotar las conexiones entre la astronomía y la nueva física exótica a la que era adepto, aplicó las probabilidades cuánticas a la cuestión de la fusión nuclear en las estrellas y descubrió que los protones pueden superar la Barrera de Coulomb.

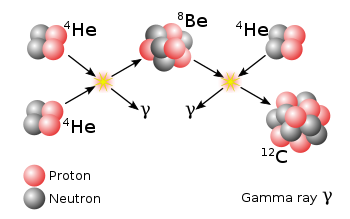

Con este mecanismo la Naturaleza encuentra el camino para sintetizar Carbono a partir del Helio

Esta historia es mucho más extensa y nos llevaría hasta los trabajos de Hans Bethe, Edward Teller y otros, así como, al famoso Fred Hoyle y su efecto Triple Alfa y otras maravillas que, nos cuentan la historia que existe desde los átomos a las estrellas del cielo.

emilio silvera

Jul

6

¿Destruye la Ciencia la Belleza? ¿O, por el contrario nos la enseña?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Belleza y la Ciencia ~

Clasificado en La Belleza y la Ciencia ~

Comments (0)

Comments (0)

“Cuando escuché al docto astrónomo,

cuando me presentaron en columnas las pruebas y guarismos,

cuando me mostraron las tablas y diagramas para medir, sumar y dividir,

cuando escuché al astrónomo discurrir con gran aplauso de la sala,

qué pronto me sentí inexplicablemente hastiado,

hasta que me escabullí de mi asiento y me fui a caminar solo,

en el húmedo y místico aire nocturno,

mirando de rato en rato, en silencio perfecto a las estrellas.

Igual que la niña mira ensimismada hacia las estrellas lejanas del cielo, tratándo de escoger la más hermosa, ponerle un nombre y hacerla suya. También muchas personas han tratado de hace los mismo cuando, en soledad, en espacios abiertos y en plena Naturaleza, ha podido estar en simbiosis plena con aquellos cuerpos celestes que, mediante invisibles hilos de plata, tienen atada la Tierra para que, nunca, podamos dejar de verlas.

Para los amantes de la belleza, el Universo supo muy bien crear sus obras y, mediante su dinámica y su ritmo de movimiento y energía, ha sabido traernos las estrellas y los mundos que, inundados de luz, pudieron hacer posible que surgiera la vida. Los antiguos filósofos, los artistas y los poetas otorgaban a la luz una posición especial entre los fenómenos del mundo natural.

Platón comparaba al Sol y sus rayos con el bien -la idea más elevada- que todo lo nutre e ilumina. Quienes le siguieron en la tradicción platónica, como san Agustín, Dante, Grosseteste y san Buenaventura, veían un vínculo especial entre luz y belleza; la luz era el principio de toda belleza sensual y visible, y bella ella misma. Iluminaba el mundo que nos acogía y, nos daba la luz y el calor para que pudiéramos vivir, calentaba las aguas y hacía posible que no muriéramos de frío-

La luz, naturalmente, ocupaba un lugar especial para los pintores que, con la colaboración de “ella” podían conseguir los más bellos reflejos cuando se expandía y avivaba para hacer del mundo y de las bellas mujeres, algo esplendoroso.

Todo gana con la luz, sea cual pudiera ser su estado en relación al movimiento planetario, todos los escenarios que su inmensa miríada de fotones hacen incidir sobre las cosas, las hace más mucho más atractivas y son expuestas con luz cegadora o mortecina, cenicienta o medio en brumas pero, siempre, dejará ver la Naruraleza en su presencia.

Claro que la Ciencia moderna, y en especial la obra de Newton, cuestionaba esta concepción. De un solo golpela luz había perdido su posición privilegiada. El mundo había dejadoi de iluminarse así mismo, a través de la luz, en benficio de los humanos; ahora era la mente humana la que proyectaba la luz para iluminar al mundo. La se había convertido en un fenómeno más gobernado por las leyes mecánicas y matemáticas susceptibles de ser conocidas. Lo que escribieron los poetas sobre lo que había hecho Newton con ese tesoro de los colores, el arco iris, nos da la medida de su respuesta a esta nueva ciencia.

…¿No se desvanecen los encantos

sólo con que los toque la gélida filosofía?

Antes había en el cielo un sobrecogedor arco iris:

hoy conocemos su urdidumbre, su textura: forma parte

del aburrido catálogo de las cosas vulgares.

La filosofía recorte las alas del ángel,

conquista los misterios con reglas y líneas,

despoja de embrijo el aire, de gnomos las minas;

desteje el arco iris…

Muchos fueron los poetas que, a partir de Newton vieron como se rompía el encanto de algunos fenómenos naturales que, como el de la luz, había tenido mucho encanto y ensoñación, era algo mágico que invitaba a imaginar “cosas” y, con la venida de la Ciencia, todo aquello se fue al garete, Ahora la luz, era un conocido fenómeno natural.

Claro que, aún nos queda un b uen margen para soñar, toda vez que, saber lo que es la luz…¡Sólo a medias lo sabemos!

La brecha entre poetas románticos de los siglos XVIII y XIX sigue viva y con nosotros en las mentes imaginaticas hasta extremos inimaginables, y que, tienen la sensación de que la Ciencia, destruye la Belleza, claro que, actualmente son muchos más los que creen que la investigación profunda de la Naturaleza , sólo se limita a sacar a la Luz la verdadera Belleza del Universo que está encerrada en los máas profundos enigmas del Universo.

En este punto, recordaremos aquella anécdota de Feymann con este tema relacionaso:

Al Físico Richard Feynman lo interpeló en este sentido un amigo poeta que afirmaba que mientras que los artistas ven la belleza en una flor, los científicos la diseccionan hasta convertirla en un objeto sin vida. El físico sabía que contestar y le contestó que como científico era capaz de ver en la flor más belleza y no menos. Podía apreciar, por ejemplo, las bellas y complejas acciones del interior de sus células, de su ecología, de su papel en los procesos evolutivos. “El conocimiento de la Ciencia”, prosiguió Feynman, “sólo agranda el interés, el misterio y el asombro que puede producir una flor cuando se sabe todo lo que hay en ella, cosa que los poetas, por su profesión “de otro mundo”, nunca podrán ver.

Claro que, en realidad, los dos, el físico y el poeta, llevaban su parte de razón: No sólo de Pan vive el Hombre y, alguna vez, se necesita tener un refigio situado en ese mundo mágico de la irrealidad para que, nos cure las heridas producidas en esa realidad que llamamos mundo y que, no siempre resulta fácil de sobrellevar.

Pero, ¿dónde está la Belleza real”

¿Aquí?

¿O, está aquí?

¿Pudiera ser esta la belleza del mundo?

También aquí está presente

Tampoco esta estaría mal elegida como símbolo de la belleza y de… La Vida

¿Y la belleza y complejidad de lo que arriba vemos esconde?

A todo estos ejemplos anteriores, podríamos añadir una bonita sinfonía que nos eleva fuera de este mundo hacia lugares soñados que nos llenan de felicidad, o, también podríamos poner en la lista de las bellezas una buena historia leida al calor de la lumbre en el crudo invierno, o, también podríamos añadir a la Belleza una mirada tierna o una caricia del ser Amado…

También aquí hay belleza

¡Son tantas las bellezas presentes en el Universo que, nunca podremos elegir…una sóla ellas…son muchas las que ocupan nuestros corazones y nuestras mentes.

emilio silvera

Jul

5

Siempre buscaremos nuevas teorías de la Física y del Universo.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Una reacción nuclear “desafiante”

Una nueva clase de reacción de fisión nuclear observada en el CERN ha mostrado importantes puntos débiles en nuestro entendimiento actual del núcleo atómico. La fisión del mercurio-180 se suponía una reacción “simétrica” que daría lugar a dos fragmentos iguales, pero en lugar de ello ha producido dos núcleos con masas bastante diferentes, una reacción “asimétrica” que plantea un serio desafío a los teóricos.

La Ciencia no duerme. En todo el mundo (ahora también fuera de él -en el espacio), son muchos los Científicos que trabajan de manera tenaz para buscar nuevas formas de alcanzar lo ahora inalcanzable y, para ello, se emplean las más sofisticadas estructuras técnicas de avanzados sistemas tecnológicos que hacen posible llegar allí donde nunca nadie había llegado.

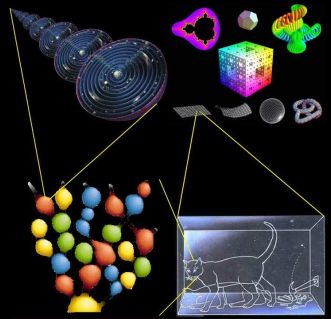

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”.

Vista hemisférica de Venus. (Cortesía de NASA)

El segundo planeta a partir del Sol. Tiene la órbita más circular de todos los planetas. Su albedo geométrico medio, 0,65, es el mayor de todos los planetas, como resultado de su cubierta de nubes blancas sin fracturas. En su máximo alcanza magnitud -4,7, mucho más brillante que cualquier otro planeta. Su eje de rotación está inclinado casi 180º con respecto a la vertical, de manera que su rotación es retrógrada. Rota alrededor de su eje cada 243 días, y, por tanto, muestra siempre la misma cara hacia la Tierra cuando los dos planetas se encuentran en su máxima aproximación.

La atmósfera de Venius es un infierno

La atmósfera de Venus es en un 96,5% de dióxido de carbono y un 3,5 de nitrógeno, con trazas de dióxido de azufre, vapor de agua, argón, hidrógeno y monóxido de carbono. La presión en la superficie es de 92 bares (es decir, 92 veces la presión a nivel del mar en la Tierra). La temperatura superficial promedio es de 460 ºC debido al “efecto invernadero” en la atmósfera del planeta. Los rayos son muy frecuentes. Existe una densa capa de nubes a una altitud de unos 45/65 Km. compuesta de ácido sulfúrico y gotitas de agua.

VENUS: El Planeta Imposible

Mundos inimaginables que tendrán, como en el nuestro, formas de vida de una rica diversidad que ni podemos imaginar. Simplemete en una galaxia, por ejemplo la nuestra, existen cientos de miles de millones de planetas de los más diversos pelajes, y, no pocos, serán muy parecidos a nuestra Tierra y estarán situados en la zona adecuada para que, la vida, pudiera surgir en ellos como lo hizo aquí, toda vez que, tanto aquellos planetas como el nuestro, están sometidos a las mismas fuerzas, a las mismas constantes, y, en consecuencia, a situaciones iguales, ¡iguales resultados!

Nuestros sueños de visitar mundos remotos, y, en ellos, encontrar otras clases de vida, otras inteligencias, es un sueño largamente acariaciado por nuestras mentes que, se resisten a estar sólas en un vasto Universo que, poseyendo cientos de miles de millones de mundos, también debe estar abarrotados de una diversidad Biológica inimaginable. No creo que estémos sólos en tan vasto universo.

Hace algún tiempo que los medios publicaron la noticias:

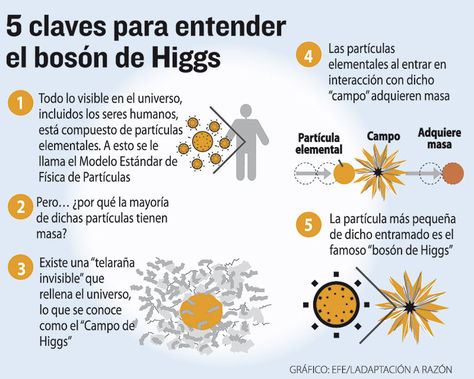

“Físicos británicos creen que el bosón de Higgs y su relación con la gravedad puede ser la clave para crear una ecuación única que explique el Universo entero.”

“La teoría del todo, también conocida como teoría unificada, fue el sueño que Einstein nunca pudo cumplir. Consiste en una teoría definitiva, una ecuación única que explique todos los fenómenos físicos conocidos y dé respuesta a las preguntas fundamentales del Universo. Esa teoría unificaría la mecánica cuántica y la relatividad general, dos conocimientos aceptados pero que describen el Cosmos de forma muy diferente. Albert Einstein no consiguió formularla. Tampoco nadie después de él, pero sigue siendo la ambición de muchos científicos. En este empeño, físicos de la británica Universidad de Sussex han dado un nuevo paso para probar que solo hay una fuerza fundamental en la naturaleza. Creen haber observado como el campo de Higgs interactúa con la Gravedad.”

Si hablamos de nuestra Galaxia, la Vía Láctea, lo hacemos de algo que tiene 100.000 millones de años-luz de diámetro y más de ciento cincuenta mil millones de estrellas, no digamos de mundos y otra infinidad de objetos de exótica estructura e increíbles conformaciones que, como los púlñsares, los agujeros negros o los manétares, no dejan de asombrarnos. Somos, una especie viviente que ha llegado a poder generar pensamientos y crear teorías encaminadas a descubrir la verdad de la Naturaleza, y, nuestra aparente “insignificante presencia”, podría ser un signo de que, el universo “ha permitido” observadores para que lo expliquen y se pueda comprender.

Tenemos el Universo dentro de nuestras mentes

El universo es un lugar tan maravilloso, rico y complejo que el descubrimiento de una teoría final, en el sentido en el que está planteada la teoría de supercuerdas, no supondría de modo alguno el fin de la ciencia ni podríamos decir que ya lo sabemos todo y para todo tendremos respuestas. Más bien será, cuando llegue, todo lo contrario: el hallazgo de esa teoría de Todo (la explicación completa del universo en su nivel más microscópico, una teoría que no estaría basada en ninguna explicación más profunda) nos aportaría un fundamento mucho más firme sobre el que podríamos construir nuestra comprensión del mundo y, a través de estos nuevos conocimientos, estaríamos preparados para comenzar nuevas empresas de metas que, en este momento, nuestra ignorancia no nos dejan ni vislumbrar. La nueva teoría de Todo nos proporcionaría un pilar inmutable y coherente que nos daría la llave para seguir explorando un universo más comprensible y por lo tanto, más seguro, ya que el peligro siempre llega de lo imprevisto, de lo desconocido que surge sin aviso previo; cuando conocemos bien lo que puede ocurrir nos preparamos para evitar daños.

Algunos dicen que para cuando tengamos una Teoría de Todo, el mundo habrá cambiado, habrá pasado tanto tiempo que, para entonces, la teoría habrá quedado vieja y se necesitará otra nueva teoría más avanzada. Eso significa, si es así, que nunca tendremos una explicación de todo y siempre quedarán cuestiones enigmáticas que tendremos que tesolver. ¡Menos mal!

La búsqueda de esa teoría final que nos diga cómo es el Universo, el Tiempo y el Espacio, la Materia y los elementos que la conforman, las Fuerzas fundamentales que interaccionan con ella, las constantes universales y en definitiva, una formulación matemática o conjunto de ecuaciones de las que podamos obtener todas las respuestas, es una empresa nada fácil y sumamente complicada; la teoría de cuerdas es una estructura teórica tan profunda y complicada que incluso con los considerables progresos que se han realizado durante las últimas décadas, aún nos queda un largo camino antes de que podamos afirmar que hemos logrado dominarla completamente. Se podría dar el caso de que el matemático que encuentre las matemáticas necesarias para llegar al final del camino, aún no sepa ni multiplicar y esté en primaria en cualquier escuela del mundo civilizado. Por otra parte, siempre andamos inventando ecuaciones para todo, que expliquen este o aquel enigma que deseamos conocer.

Lo cierto es que, no conocemos el futuro que le espera a la Humanidad pero, tal desconocimiento no incide en el hecho cierto de que siempre estemos tratando de saber el por qué de las cosas y, seguramente, si Einstein hubiera conocido la existencia de las cuatro fuerzas fundamentales, habría podido avanzar algo más, en su intento de lograr esa ecuación maravillosa que “todo” lo pudiera explicar.

Muchos de los grandes científicos del mundo (Einstein entre ellos), aportaron su trabajo y conocimientos en la búsqueda de esta teoría, no consiguieron su objetivo pero sí dejaron sus ideas para que otros continuaran la carrera hasta la meta final. Por lo tanto, hay que considerar que la teoría de cuerdas es un trabajo iniciado a partir de las ecuaciones de campo de la relatividad general de Einstein, de la mecánica cuántica de Planck, de las teorías gauge de campos, de la teoría de Kaluza-Klein, de las teorías de… hasta llegar al punto en el que ahora estamos.

Comprender de manera armoniosa cómo se juntan las dos mejores teorías de la física que tenemos actualmente, la cuántica y la relatividad general… ¡Sin que surjan infinitos!

La armoniosa combinación de la relatividad general y la mecánica cuántica será un éxito muy importante. Además, a diferencia de lo que sucedía con teorías anteriores, la teoría de cuerdas tiene la capacidad de responder a cuestiones primordiales que tienen relación con las fuerzas y los componentes fundamentales de la naturaleza. Allí, en sus ecuaciones, aparece el esquivo gravitón implicándo con ello que la teoría contiene implicitamente una teoría cuántica de la Gravedad.

Ahora, en la nueva etapa del LHC, tratarán de buscar partículas Partículas Supersimétricas

Igualmente importante, aunque algo más difícil de expresar, es la notable elegancia tanto de las respuestas que propone la teoría de cuerdas, como del marco en que se generan dichas respuestas. Por ejemplo, en la teoría de cuerdas muchos aspectos de la Naturaleza que podrían parecer detalles técnicos arbitrarios (como el número de partículas fundamentales distintas y sus propiedades respectivas) surgen a partir de aspectos esenciales y tangibles de la geometría del universo. Si la teoría de cuerdas es correcta, la estructura microscópica de nuestro universo es un laberinto multidimensional ricamente entrelazado, dentro del cual las cuerdas del universo se retuercen y vibran en un movimiento infinito, marcando el ritmo de las leyes del cosmos.

¿Serán las cuerdas las que hacen de nuestro Universo el que es?

Lejos de ser unos detalles accidentales, las propiedades de los bloques básicos que construyen la naturaleza están profundamente entrelazadas con la estructura del espacio-tiempo. En nuestro Universo, aunque no pueda dar esa sensación a primera vista, cuando se profundiza, podemos observar que, de alguna manera, todo está conectado, de la misma manera, nuestras mentes son parte del universo y, en ellas, están todas las respuestas.

Claro que, siendo todos los indicios muy buenos, para ser serios, no podemos decir aún que las predicciones sean definitivas y comprobables para estar seguros de que la teoría de cuerdas ha levantado realmente el velo de misterio que nos impide ver las verdades más profundas del universo, sino que con propiedad se podría afirmar que se ha levantado uno de los picos de ese velo y nos permite vislumbrar algo de lo que nos podríamos encontrar, a través de esa fisura parece que se escapa la luz de la comprensión que, en su momento, se podría alcanzar.

Muchos sueñan con encontrar esa Teoría del Todo

Mientras que la soñada teoría llega, nosotros estaremos tratando de construir ingenios que como el GEO600, el más sensible detector de ondas gravitacionales que existe ( capaz de detectar ínfimas ondulaciones en la estructura del espacio-tiempo ), nos pueda hablar de otra clase de universo. Hasta el momento el universo conocido es el que nos muestran las ondas electromagnéticas de la luz pero, no sabemos que podríamos contemplar si pudiéramos ver ese otro universo que nos hablan de la colisión de agujeros negros…por ejemplo.

El detector de ondas gravitacionales GEO 600, de Hanóver, en Alemania, registró un extraño ruido de fondo que ha traído de cabeza a los investigadores que en él trabajan. El actual director del Fermilab de Estados Unidos, el físico Carl Hogan, ha propuesto una sorprendente explicación para dicho ruido: proviene de los confines del universo, del rincón en que éste pasa de ser un suave continuo espacio-temporal, a ser un borde granulado. De ser cierta esta teoría, dicho ruido sería la primera prueba empírica de que vivimos en un universo holográfico, asegura Hogan. Nuevas pruebas han de ser aún realizadas con el GEO 600 para confirmar que el misterioso ruido no procede de fuentes más obvias.

Gigantesco holograma cósmico

Un extraño ruido detectado por el GEO600 trajo de cabeza a los investigadores que trabajan en él, hasta que un físico llamado Craig Hogan, director del Fermi National Accelerator Laboratory (Fermilab), de Estados Unidos, afirmó que el GEO600 se había tropezado con el límite fundamental del espacio-tiempo, es decir, el punto en el que el espacio-tiempo deja de comportarse como el suave continuo descrito por Einstein para disolverse en “granos” (más o menos de la misma forma que una imagen fotográfica puede verse granulada cuanto más de cerca la observamos).

Teniendo en cuenta que el volumen del universo esférico sería mucho mayor que el volumen de la superficie exterior, este galimatías se complica aún más. Pero Hogan también señala una solución para este punto: si ha de haber el mismo número de unidades de información o bits dentro del universo que en sus bordes, los bits interiores han de ser mayores que la longitud de Planck. “Dicho de otra forma, el universo holográfico sería borroso”.

La teoría de cuerdas, aunque en proceso de elaboración, ya ha contribuido con algunos logros importantes y ha resuelto algún que otro problema primordial como por ejemplo, uno relativo a los agujeros negros, asociado con la llamada entropía de Bekenstein-Hawking, que se había resistido pertinazmente durante más de veinticinco años a ser solucionada con medios más convencionales. Este éxito ha convencido a muchos de que la teoría de cuerdas está en el camino correcto para proporcionarnos la comprensión más profunda posible sobre la forma de funcionamiento del universo, que nos abriría las puertas para penetrar en espacios de increíble “belleza” y de logros y avances tecnológicos que ahora ni podemos imaginar.

Como he podido comentar en otras oportunidades, Edward Witten, uno de los pioneros y más destacados experto en la teoría de cuerdas, autor de la versión más avanzada y certera, conocida como teoría M, resume la situación diciendo que: “la teoría de cuerdas es una parte de la física que surgió casualmente en el siglo XX, pero que en realidad era la física del siglo XXI“.

Witten, un físico-matemático de mucho talento, máximo exponente y punta de lanza de la teoría de cuerdas, reconoce que el camino que está por recorrer es difícil y complicado. Habrá que desvelar conceptos que aún no sabemos que existen.

Ellos nos legaron parte de las teorías que hoy manejamos en el mundo para tratar de conocer el Universo pero, sigue siendo insuficientes… ¡Necesitamos Nuevas Teorías! que nos lleven al conocimientos más profundos de la realidad en que se mueve la Naturaleza, sólo de esa manera, podremos seguir avanzando.

El hecho de que nuestro actual nivel de conocimiento nos haya permitido obtener nuevas perspectivas impactantes en relación con el funcionamiento del universo es ya en sí mismo muy revelador y nos indica que podemos estar en el buen camino al comprobar que las ecuaciones topológicas complejas de la nueva teoría nos habla de la rica naturaleza de la teoría de cuerdas y de su largo alcance. Lo que la teoría nos promete obtener es un premio demasiado grande como para no insistir en la búsqueda de su conformación final.

La expansión del universo se ha estudiado de varias maneras diferentes, pero la misión WMAP completada en 2003, representa un paso importante en la precisión y los resultados presentados hasta el momento con mayor precisión para saber, en qué clase de Universo estamos, cómo pudo comenzar y, cuál podría ser su posible final. Todo ello, es un apartado más de ese todo que tratamos de buscar para saber, en qué Universo estamos, cómo funcionan las cosas y por qué lo hacen de esa determinada manera y no de otra diferente.

La relatividad general nos dijo cómo es la geometría del Universo

El universo, la cosmología moderna que hoy tenemos, es debida a la teoría de Einstein de la relatividad general y las consecuencias obtenidas posteriormente por Alexandre Friedmann. El Big Bang, la expansión del universo, el universo plano y abierto o curvo y cerrado, la densidad crítica y el posible Big Crunch.

Un comienzo y un final que abarcará miles y miles de millones de años de sucesos universales a escalas cosmológicas que, claro está, nos afectará a nosotros, insignificantes mortales habitantes de un insignificante planeta, en un insignificante sistema solar creado por una insignificante y común estrella.

Pero… ¿somos en verdad tan insignificantes?

Los logros alcanzados hasta el momento parecen desmentir tal afirmación, el camino recorrido por la humanidad no ha sido nada fácil, los inconvenientes y dificultades vencidas, las luchas, la supervivencia, el aprendizaje por la experiencia primero y por el estudio después, el proceso de humanización (aún no finalizado), todo eso y más nos dice que a lo mejor, es posible, pudiera ser que finalmente, esta especie nuestra pudiera tener un papel importante en el conjunto del universo. De momento y por lo pronto ya es un gran triunfo el que estemos buscando respuestas escondidas en lo más profundo de las entrañas del cosmos.

Tengo la sensación muy particular, una vez dentro de mi cabeza, un mensaje que no sé de dónde pero que llega a mi mente que me dice de manera persistente y clara que no conseguiremos descubrir plenamente esa ansiada teoría del todo, hasta tanto no consigamos dominar la energía de Planck que hoy por hoy, es inalcanzable y sólo un sueño.

Sus buenas aportaciones a la Física fueron bien recompensadas de muchas maneras.

En mecánica cuántica es corriente trabajar con la constante de Planck racionalizada, (ħ = h/2p = 1’054589×10-34 Julios/segundo), con su ley de radiación (Iv = 2hc-2v3/[exp(hv/KT)-1]), con la longitud de Planck , con la masa de Planck, y otras muchas ecuaciones fundamentales para llegar a lugares recónditos que, de otra manera, nunca podríamos alcanzar.

Todo lo anterior son herramientas de la mecánica cuántica que en su conjunto son conocidas como unidades de Planck, que como su mismo nombre indica son un conjunto de unidades, usadas principalmente en teorías cuánticas de la gravedad, en que longitud, masa y tiempo son expresadas en múltiplos de la longitud, masa y tiempo de Planck, respectivamente. Esto es equivalente a fijar la constante gravitacional (G), como la velocidad de la luz (c), y la constante de Planck racionalizada (ħ) iguales todas a la unidad. Todas las cantidades que tienen dimensiones de longitud, masa y tiempo se vuelven adimensionales en unidades de Planck. Debido a que en el contexto donde las unidades de Planck son usadas es normal emplear unidades gaussianas o unidades de Heaviside-Lorentz para las cantidades electromagnéticas, éstas también se vuelven adimensionales, lo que por otra parte ocurre con todas las unidades naturales. Un ejemplo de esta curiosidad de adimiensionalidad, está presente en la constante de estructura fina (2πe2/hc) de valor 137 (número adimensional) y cuyo símbolo es la letra griega α (alfa).

Estas unidades de Planck nos llevan a la cosmología del nacimiento del universo y nos proporciona un marco elegante, coherente y manejable mediante cálculos para conocer el universo remontándonos a los primeros momentos más breves posteriores a la explosión o Big Bang. El tiempo de Planck por ejemplo, expresado por , tiene un valor del orden de 10-43 segundos, o lo que es lo mismo, el tiempo que pasó desde la explosión hasta el tiempo de Planck fue de: 0,000.000.000.000.000.000.000.000.000.000.000.000.000.001 de 1 segundo. En la fórmula, G es la constante universal de Newton, ħ es la constante de Planck racionalizada y c es la velocidad de la luz.

Es una unidad de tiempo infinitesimal, como lo es el límite de Planck que se refiere al espacio recorrido por un fotón (que viaja a la velocidad de la luz) durante una fracción de tiempo de ínfima duración y que es de 0,000.000.000.000.000.000.000.000.000.000.001 de cm.

Hasta tal punto llegan los físicos en sus cálculos para tratar de adecuar los conocimientos a la realidad por medio del experimento. Buscamos incansables…¡las respuestas! Hasta que no podamos tocar con nuestras propias manos esa partícula final…

Sin embargo, cuando hablamos de estas unidades tan pequeñas, no debemos engañarnos. Precisamente, para tratar de llegar hasta esos límites tan profundos se necesitan máquinas que desarrollan inmensas energías: los aceleradores de partículas, que como el Fermilab o el LHC en el CERN, han facilitado a los físicos experimentadores entrar en las entrañas de la materia y descubrir muchos de los secretos antes tan bien guardados. Ahora, disponiendo de 14 TeV, tratán de nbuscar partículas supersimñétricas y el origen de la “materia oscurta”.

Haber fabricado acelerados tan potentes como para poder detectar la partícula de Higgs, esa partícula responsable de proporcionar masa a todas las demás partículas, en tiempos pasados era un sueño que pudimos hacer realidad y, de la misma manera, soñamos ahora con tener un Acelerador tan Potente como para poder encontrar las cuerdas o las partículas simétricas de las que se cree están conformadas. Y, por supuesto, más lejos queda la posibilidad de que podamos construir un acelerador que pudiera alcanzar la energía de Planck, del orden de 1019 eV (1 eV = 10-19 julios) = 1’60210×10-19. Hoy por hoy, ni nuestra tecnología ni todos los recursos que tenemos disponibles si empleáramos todo el presupuesto bruto de todos los países del globo unidos, ni así digo, podríamos alcanzar esta energía necesaria para comprobar experimentalmente la existencia de “cuerdas” vibrantes que confirmen la teoría de Todo.

Claro que, pudiera ser que, todo se pudiera alcanzar de manera mucho más simple y que, teniéndolo a la vista, no hemos sabido ver. Habrá que agudizar el ingenio para resolver estas y otras cuestiones que, como la de la Velocidad de la Luz, nos tienem atados y bien atados a este granito de arena inmerso en un vasto universo y que, nosotros, llamamos mundo.

emilio silvera

Jul

5

El sueño de alcanzar las estrellas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias ~

Clasificado en Noticias ~

Comments (0)

Comments (0)

‘Juno’ estudia en Júpiter la historia del Sistema Solar

La NASA alcanza hoy el planeta gigante con una sonda que estudiará su magnetosfera, su núcleo y la presencia de agua

Júpiter no es una estrella, pero casi. Durante la etapa de formación del Sistema Solar, hace algo menos de 5.000 millones de años, actuó como un hermano egoísta y devoró los restos de gas y polvo que había dejado la formación del Sol. Así se convirtió en un planeta gigantesco, hecho de hidrógeno y helio, como las estrellas.

Ahora, tiene una masa que dobla al resto de planetas combinados y su área de influencia es inmensa. Cuenta con más de 60 lunas, como Ganímedes, mayor que Mercurio, o Europa, un mundo helado con un océano subterráneo en el que algunos consideran posible encontrar vida. Bajo las nubes de ese mundo gigante y sus tormentas descomunales se esconden muchos de los secretos del origen del Sistema Solar y en la composición de su atmósfera se puede encontrar información sobre sus migraciones, en las que pudo arrasar nuestro sistema planetario para hacerlo habitable.

Los instrumentos de Juno están protegidos por titanio para sobrevivir a la radiación

A ese mundo acaba llegará esta noche [madrugada española] Juno, una nave espacial que lanzó la NASA hace cinco años. Ahora le quedan por delante 20 meses de trabajo en condiciones extremas. Colocado en una órbita polar, estará expuesta a los cinturones de radiación de la magnetosfera jupiterina en la que las partículas se aceleran a velocidades extremas convirtiéndose en una amenaza para todo lo que se cruza en su camino. Para que sus instrumentos de observación no queden abrasados por ese bombardeo, están protegidos por una caja de titanio.

La sonda Juno orbitará a unos 5.000 kilómetros de la superficie de Júpiter, diez veces más cerca que cualquiera de las nueve sondas que lo visitaron antes, y funcionará alimentado por paneles solares. Esta tecnología es una rareza en misiones que van más allá del cinturón de asteroides. Hasta ahora, todos los artefactos que han visitado el planeta gigante lo hicieron con plutonio-238, pero la escasez de ese elemento radiactivo, las preocupaciones de seguridad y los avances tecnológicos hicieron que la NASA se decidiese por la energía solar.

Sobre los objetivos científicos de Juno, Agustín Sánchez Lavega, catedrático de la Universidad del País Vasco, comenta la misión trata de resolver tres ideas básicas. Por un lado, “si el planeta tiene un núcleo rocoso y cuál es su estructura interna precisa”. Esto “ayudaría a entender cómo se han formado estos planetas gigantes, que además desempeñan un papel importante en la evolución de los sistemas planetarios”. Hay simulaciones que han planteado que una migración de Júpiter hacia el interior del Sistema Solar poco después de su formación arrasó los planetas que ocupaban las regiones más cercanas al Sol. Después, con los escombros de aquel cataclismo se formaron los planetas terrestres, y entre ellos la Tierra.

Otro de los misterios que Juno pretende resolver es “cómo se genera el campo magnético de Júpiter, el más intenso del Sistema Solar y que desempeña un papel muy importante en su entorno”, explica Sánchez Lavega. La comprensión de ese campo magnético también puede ayudar a entender las posibilidades de albergar vida de algunas de sus lunas, como Europa. “Este campo magnético, con partículas que se mueven a toda velocidad, es muy esterilizante”, señala el investigador vasco.

La nueva sonda es la primera que llega tan lejos con paneles solares, en lugar del habitual plutonio

Por último, el otro gran objetivo de la sonda recién insertada en la órbita del planeta gigante consistirá en evaluar la cantidad de agua que guarda su atmósfera. Atravesando la espesa atmósfera de Júpiter con sus instrumentos, podrá observar lo que es un reservorio del agua que contenía originalmente el Sistema Solar, ofreciendo más datos sobre nuestros orígenes, ayudando a averiguar, por ejemplo, desde dónde llegó el agua que hizo habitable la Tierra. A diferencia de nuestro planeta o de otros cuerpos más humildes del vecindario, la masa descomunal de Júpiter le ha permitido mantener su composición original más o menos intacta, algo que lo convierte en un objeto interesante para aprender sobre el pasado.

El conocimiento que recoja Juno durante los próximos 20 meses, no solo servirá para entender nuestro entorno planetario cercano. Gran parte de los planetas extrasolares descubiertos son gigantes gaseosos como Júpiter y lo que se aprenda con esta misión servirá para interpretar mejor los mundos más allá del Sistema Solar. Además, como siempre sucede con las misiones de exploración, los datos de la sonda depararán sorpresas que modificarán la imagen que tenemos del rey de los planetas.

Totales: 85.795.841

Totales: 85.795.841 Conectados: 47

Conectados: 47