Oct

24

Recordemos a un personaje, unos hechos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Euclides nos presentaba un universo de espacios planos y, dos mil años más tarde, llegó Riemann y nos habló de un Universo curvo

Recordemos aquí un extraño caso que surgió el día 10 de Junio de 1.854 con el nacimiento de una nueva geometría: la teoría de dimensiones más altas que fue introducida cuando Georg Friedrich Bernhard Riemann que dio su célebre conferencia en la facultad de la Universidad de Göttingen en Alemania. Aquello fue como abrir de golpe todas las ventanas cerradas durante 2.000 años de una lóbrega habitación que, de pronto, se ve inundada por la luz cegadora de un Sol radiante. Riemann regaló al mundo las sorprendentes propiedades del espacio multidimensional.

“¿Cuál es exactamente la geometría del universo? ¿Vivimos dentro de una especie de esfera de múltiples dimensiones o se trata más bien de un tejido espaciotemporal que se curva suavemente y sin llegar nunca a cerrarse sobre sí mismo? ¿O puede que incluso no se curve en absoluto y que en realidad habitemos en un universo plano? La cuestión, uno de los mayores interrogantes de la Cosmología, tiene para nosotros implicaciones muy concretas y que van mucho más allá de ser simples cuestiones teóricas. De hecho, la geometría del universo influye de forma decisiva en los objetos que observamos.”

El ensayo de Riemann, de profunda importancia y elegancia excepcional, “sobre las hipótesis que subyacen en los fundamentos de la geometría” derribó pilares de la geometría clásica griega, que habían resistido con éxito todos los asaltos de los escépticos durante dos milenios. La vieja geometría de Euclides, en la cual todas las figuras geométricas son de dos o tres dimensiones, se venía abajo, mientras una nueva geometría riemanniana surgía de sus ruinas. La revolución riemanniana iba a tener grandes consecuencias para el futuro de las artes y las ciencias. En menos de tres decenios, la “misteriosa cuarta dimensión” influiría en la evolución del arte, la filosofía y la literatura en toda Europa. Antes de que hubieran pasado seis decenios a partir de la conferencia de Riemann, Einstein utilizaría la geometría riemanniana tetradimensional para explicar la creación del universo y su evolución mediante su asombrosa teoría de la relatividad general. Ciento treinta años después de su conferencia, los físicos utilizarían la geometría decadimensional para intentar unir todas las leyes del universo. El núcleo de la obra de Riemann era la comprensión de las leyes físicas mediante su simplificación al contemplarlas en espacios de más dimensiones.

Contradictoriamente, Riemann era la persona menos indicada para anunciar tan profunda y completa evolución en el pensamiento matemático y físico. Era huraño, solitario y sufría crisis nerviosas. De salud muy precaria que arruinó su vida en la miseria abyecta y la tuberculosis.

Riemann nació en 1.826 en Hannover, Alemania, segundo de los seis hijos de un pobre pastor luterano que trabajó y se esforzó como humilde predicador para alimentar a su numerosa familia que, mal alimentada, tendrían una delicada salud que les llevaría a una temprana muerte. La madre de Riemann también murió antes de que sus hijos hubieran crecido.

A edad muy temprana, Riemann mostraba ya los rasgos que le hicieron famoso: increíble capacidad de cálculo que era el contrapunto a su gran timidez y temor a expresarse en público. Terriblemente apocado era objeto de bromas de otros niños, lo que le hizo recogerse aún más en un mundo matemático intensamente privado que le salvaba del mundo hostil exterior.

Portada de la décimo primera edición de los “Eléments de Geométrie” de A. M. Legendre (1794)

Para complacer a su padre, Riemann se propuso hacerse estudiante de teología, obtener un puesto remunerado como pastor y ayudar a su familia. En la escuela secundaria estudió la Biblia con intensidad, pero sus pensamientos volvían siempre a las matemáticas. Aprendía tan rápidamente que siempre estaba por delante de los conocimientos de sus instructores, que encontraron imposible mantenerse a su altura. Finalmente, el director de la escuela dio a Riemann un pesado libro para mantenerle ocupado. El libro era la Teoría de números de Adrien-Marie Legendre, una voluminosa obra maestra de 859 páginas, el tratado más avanzado del mundo sobre el difícil tema de la teoría de números. Riemann devoró el libro en seis días.

Cuando el director le preguntó: “¿hasta dónde has leído?”, el joven Riemann respondió: “este es un libro maravilloso. Ya me lo sé todo”.

Sin creerse realmente la afirmación de su pupilo, el director le planteó varios meses después cuestiones complejas sobre el contenido del libro, que Riemann respondió correctamente.

Universität Göttingen

Con mil sacrificios, el padre de Riemann consiguió reunir los fondos necesarios para que a los 19 años pudiera acudir a la Universidad de Göttingen, donde encontró a Carl Friedrich Gauss, el aclamado por todos “Príncipe de las Matemáticas”, uno de los mayores matemáticos de todos los tiempos. Incluso hoy, si hacemos una selección por expertos para distinguir a los matemáticos más grandes de la Historia, aparecerá indudablemente Euclides, Arquímedes, Newton y Gauss.

Los estudios de Riemann no fueron un camino de rosas precisamente. Alemania sacudida por disturbios, manifestaciones y levantamientos, fue reclutado en el cuerpo de estudiantes para proteger al rey en el palacio real de Berlín y sus estudios quedaron interrumpidos.

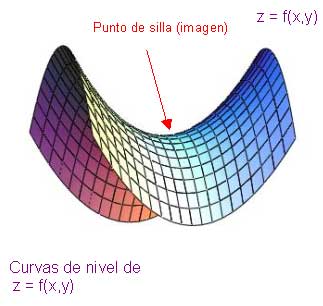

En aquel ambiente, el problema que captó el interés de Riemann fue el colapso que, según el pensaba, suponía la geometría euclidiana, que mantiene que el espacio es tridimensional y “plano” (en el espacio plano, la distancia más corta entre dos puntos es la línea recta; lo que descarta la posibilidad de que el espacio pueda estar curvado, como en una esfera).

Para Riemann, la geometría de Euclides era particularmente estéril cuando se la comparaba con la rica diversidad del mundo. En ninguna parte veía Riemann las figuras geométricas planas idealizadas por Euclides. Las montañas, las olas del mar, las nubes y los torbellinos no son círculos, triángulos o cuadrados perfectos, sino objetos curvos que se doblan y retuercen en una diversidad infinita. Riemann, ante aquella realidad, se rebeló contra la aparente precisión matemática de la geometría griega, cuyos fundamentos, descubrió él, estaban basados en definitiva sobre las arenas movedizas del sentido común y la intuición, no sobre el terreno firme de la lógica y la realidad del mundo.

Euclides nos habló de la obviedad de que un punto no tiene dimensión. Una línea tiene una dimensión: longitud. Un plano tiene dos dimensiones: longitud y anchura. Un sólido tiene tres dimensiones: longitud, anchura y altura. Y allí se detiene. Nada tiene cuatro dimensiones, incluso Aristóteles afirmó que la cuarta dimensión era imposible. En Sobre el cielo, escribió: “La línea tiene magnitud en una dirección, el plano en dos direcciones, y el sólido en tres direcciones, y más allá de éstas no hay otra magnitud porque los tres son todas”. Además, en el año 150 d. C. el astrónomo Ptolomeo de Alejandría fue más allá de Aristóteles y ofreció, en su libro sobre la distancia, la primera “demostración” ingeniosa de que la cuarta dimensión es imposible.

En realidad, lo único que Ptolomeo demostraba era que era imposible visualizar la cuarta dimensión con nuestros cerebros tridimensionales (de hecho, hoy sabemos que muchos objetos matemáticos no pueden ser visualizados, aunque puede demostrarse que en realidad, existen). Ptolomeo puede pasar a la Historia como el hombre que se opuso a dos grandes ideas en la ciencia: el sistema solar heliocéntrico y la cuarta dimensión.

La ruptura decisiva con la geometría euclidiana llegó cuando Gauss pidió a su discípulo Riemann que preparara una presentación oral sobre los “fundamentos de la geometría”. Gauss estaba muy interesado en ver si su discípulo podía desarrollar una alternativa a la geometría de Euclides.

Riemann desarrolló su teoría de dimensiones más altas.

Finalmente, cuando hizo su presentación oral en 1.854, la recepción fue entusiasta. Visto en retrospectiva, esta fue, sin discusión, una de las conferencias públicas más importantes en la historia de las matemáticas. Rápidamente se entendió por toda Europa la noticia de que Riemann había roto definitivamente los límites de la geometría de Euclides que había regido las matemáticas durante dos milenios.

Riemann creó su tensor métrico para que, a partir de ese momento, otros dispusieran de una poderosa herramienta que les hacía posible expresarse, a partir del famoso teorema de Pitágoras (uno de los grandes descubrimientos de los griegos en matemáticas que establece la relación entre las longitudes de los tres lados de un triángulo rectángulo: afirma que la suma de los cuadrados de los lados menores es igual al cuadrado del lado mayor, la hipotenusa; es decir, si a y b son los longitudes de los dos catetos, y c es la longitud de la hipotenusa, entonces a2 + b2 = c2. El teorema de Pitágoras, por supuesto, es la base de toda la arquitectura; toda estructura construida en este planeta está basada en él. Claro que, es una herramienta para utilizar en un mundo tridimensional).

El tensor métrico de Riemann, o N dimensiones, fue mucho más allá y podemos decir que es el teorema para dimensiones más altas con el que podemos describir fenómenos espaciales que no son planos, tales como un remolino causado en el agua o en la atmósfera, como por ejemplo también la curvatura del espacio en presencia de grandes masas. Precisamente, el tensor de Riemann permitió a Einstein formular su teoría de la gravedad y posteriormente lo utilizo Kaluza y Klein para su teoría en la quinta dimensión de la que años más tarde se derivaron las teorías de supergravedad, supersimetría y, finalmente, las supercuerdas.

Para asombro de Einstein, cuando tuvo ante sus ojos la conferencia de Riemann de 1.854 que le había enviado su amigo Marcel Grossman, rápidamente se dio cuenta de que allí estaba la clave para resolver su problema. Descubrió que podía incorporar todo el cuerpo del trabajo de Riemann en la reformulación de su principio. Casi línea por línea, el gran trabajo de Riemann encontraba su verdadero lugar en el principio de Einstein de la relatividad general. Esta fue la obra más soberbia de Einstein, incluso más que su celebrada ecuación E = mc2. La reinterpretación física de la famosa conferencia de Riemann se denomina ahora relatividad general, y las ecuaciones de campo de Einstein se sitúan entre las ideas más profundas de la historia de la ciencia.

No sería justo reconocer aquí que Riemann, tiene mucho que ver en ese gran logro de Einstein (Relatividad General), y de toda la física en lo que a la geometría de espacios curvos se refiere…

emilio silvera

Oct

23

¿Cuánta materia vemos?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Universo de fantasías ~

Clasificado en Universo de fantasías ~

Comments (0)

Comments (0)

La constante de Hubble en función de la Densidad Crítica

La cantidad total de Materia del Universo se da generalmente en términos de una cantidad llamada Densidad Crítica, denotada por Ω. Esta es la densidad de la materia que se necesita para producir un universo plano. Si Densidad efectivamente observada es menor o mayor que ese , en el primer caso el Universo es abierto, en el segundo es cerrado. La Densidad Crítica no es muy grande; corresponde aproximadamente a un protón por metro cúbico de espacio. Puede que no parezca mucho, dado el número inmenso de átomos en un metro cúbido de lodo, pero no debemos olvidar que existe una gran cantidad de espacio “vacío” las galaxias.

Algunos números que definen nuestro Universo:

- El de fotones por protón

- La razón densidades de Materia Oscura y Luminosa.

- La Anisotropía de la Expansión.

- La falta de homogeneidad del Universo.

- La Constante Cosmológica.

- La desviación de la expansión respecto al valor crítico.

- Fluctuaciones de vacío y sus consecuencias.

- ¿Otras Dimensiones?

En las últimas medidas realizadas, la Densidad crítica que es la densidad necesaria que la curvatura del universo sea cero, ha dado el resultado siguiente: r0 = 3H02/8pG = 1.879 h2 10-29 g/cm3, que corresponde a una densidad tan baja la de la masa de 2 a 3 átomos de hidrógeno por metro cúbico (siempre, por supuesto obviando la incertidumbre en la constante de Hubble).

Estimar la cantidad de materia luminosa del universo es una cosa muy fácil de hacer. Sabemos el brillo que tiene una estrella media, así que podemos hacer una estimación del de estrellas de una galaxia distante. Podemos contar entonces el número de galaxias en un volumen dado de espacio y sumar las masas que encontramos. Dividiendo la masa por el volumen del espacio obtenemos la densidad media de materia en ese volumen. Cuando llevamos a cabo esta operación, obtenemos que la densidad de la materia luminosa es aproximadamente entre el uno o dos % menor de la densidad crítica; es decir, menos de lo que se necesita cerrar el universo.

Por otro lado, está lo bastante cerca del valor crítico para hacer una pausa. Después de todo, esta fracción podría haber sido en principio de una billonésima o trillonésima, y también podría haber sucedido que fuese un millón de veces la materia necesaria para el cierre. ¿Por qué, entre todas las masas que podría tener el universo, la masa de materia luminosa medida está cerca del valor crítico?

Claro que el hecho de que la materia luminosa medida esté tan cercana al valor crítico, simplemente deberse a un accidente cósmico; las cosas simplemente “resultan” de ese modo. Me costaría mucho aceptar una explicación y supongo que a otros también. Es tentador decir que el Universo tiene en realidad la masa crítica, pero que de algún modo no conseguimos verla toda.

Como resultado de esta suposición, los astrónomos comenzaron a hablar de la “masa perdida” con lo que aludían a la materia que habría llenado la diferencia densidades observadas y crítica. Tales teorías de “masa perdida”, “invisible” o, finalmente “oscura”, nunca me ha gustado, toda vez que, hablamos y hablamos de ella, damos por supuesta su existencia sin haberla visto ni saber, exactamente qué es, y, en ese plano, parece como si la Ciencia se pasara al ámbito religioso, la fe de creer en lo que no podemos ver ni tocar y, la Ciencia, amigos míos, es otra cosa.

Tendremos que imaginar satélites y sondas que, de alguna manera, puedan detectar grandes halos galácticos que encierren la tan buscada materia oscura y que, al parecer, hace que nuestro Universo sea lo conocemos y, es la responsable del ritmo al que se alejan las galaxias, es decir, la expansión del Universo.

Esos halos, tendrían muchas veces las masas que podemos ver en la Materia luminosa de las estrellas, planetas, galaxias y nosotros mismos. La teoría de la materia oscura y su presencia en cúmulos y supercúmulos ha sido “descubierta” (o inventada tapar nuestra ignorancia) en época relativamente cercana para que prevalezca entre los astrónomos la uninimidad respecto a su contribución a la masa total del universo. El debate continúa, está muy vivo y, es el tema tan candente e importante que, durará bastante tiempo mientras algún equipo de observadores no pueda, de una vez por todas, demostrar que, la “materia oscura” existe, que nos digan donde está, y, de qué está conformada y actúa. Claro que, cuando se haga la suma de materia luminosa y oscura, la densidad de la masa total del universo no será todavía mayor del 30% del valor crítico. A todo esto, ocurren sucesos que no podemos explicar y, nos preguntamos si en ellos, está implicada la Materia oscura.

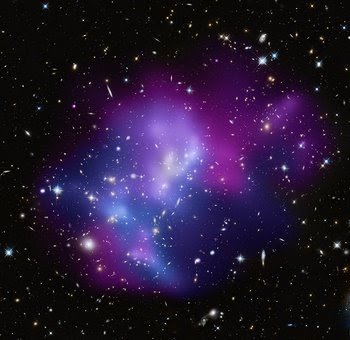

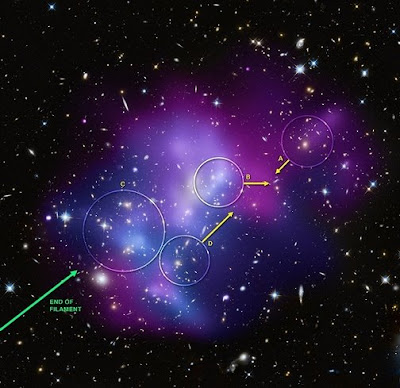

La más abarrotada colisión de cúmulos galácticos ha sido identificada al combinar información de tres diferentes telescopios. El resultado brinda a los científicos una posibilidad de aprender lo que ocurre algunos de los más grandes objetos en el universo chocan en una batalla campal cósmica.

Usando del Observatorio de rayos-X Chandra, el Telescopio Espacial Hubble y el Observatorio Keck de Hawai, los astrónomos fueron capaces de determinar la geometría tridimensional y el movimiento en el sistema MACSJ0717.5+3745 localizado a 5.4 mil millones de luz de la Tierra. Los investigadores encontraron que cuatro distintos cúmulos de galaxias están envueltos en una triple fusión, la primera vez que un fenómeno así es documentado.

La composición de imagen (arriba de todo) muestra el cúmulo de galaxias masivo MACSJ0717.5+3745. El color del gas caliente está codificado con colores mostrar su temperatura. El gas más frío es mostrado como un púrpura rojizo, el gas más caliente en azul y las temperaturas intermedias en púrpura. Las repetidas colisiones en el cúmulo son causadas por una corriente de galaxias, polvo y “materia oscura” -conocida filamento- de 13 millones de años luz.

Se han obtenido Imágenes (MACSJ0717) que muestran cómo cúmulos galácticos gigantes interactúan con su entorno en escalas de millones de años luz. Es un sistema hermoso para estudiar cómo los cúmulos crecen mientras el material cae en ellos a lo largo de filamentos. Simulaciones por ordenador muestran que los cúmulos de galaxias más masivos deben crecer en regiones donde filamentos de gran escala de gas intergaláctico, galaxias, y materia desconocida intersectan, pero…

¿Cuál debe ser la Masa del Universo?

Alan Guth

claro que la idea de masa perdida se introdujo porque la densidad observada de la materia del universo está cerca del valor crítico. Sin embargo, hasta comienzos de los ochenta, no se tuvo una razón teórica firme para suponer que el universo tenía efectivamente la masa crítica. En 1981, Alan Guth, publicó la primera versión de una teoría que entonces se ha conocido como “universo inflacionista”. Desde entonces, la teoría ha sufrido numerosas modificaciones técnicas, pero los puntos centrales no han cambiado.

nuestra conversación de hoy, diremos que el aspecto principal del universo inflacionista es que estableció por primera vez una fuerte presunción de que la masa del universo tenía realmente el valor crítico. Esta predicción viene de las teorías que describen la congelación de la fuerza fuerte en el segundo 10-35 del Big Bang. los otros muchos procesos en marcha en ese tiempo estaba una rápida expansión del universo, un proceso que vino a ser conocido como inflación. Es la presencia de la inflación la que nos lleva a la predicción de que el universo tiene que ser plano.

Abell 370 La lente gravitacional distorsiona la Imagen y nos enseña, a la derecha, algo que nos parece una inmensa cuerda cósmica , ¿que podrá ser en realidad? la materia a lo largo y ancho del universo se reparte de manera que, se ve concentrada en cúmulos de galaxias y supercúmulos que son las estructuras más grandes conocidas y, dentro de ellas, están todos los demás objetos que existen. Claro que, deajndo a un lado esas fluctuaciones de vacío y, la posible materia desconocida.

El proceso mediante el cual la fuerza fuerte se congela es un ejemplo de un cambio de fase, similar en muchos aspectos a la congelación del agua. el agua se convierte en hielo, se expande; una botella de leche explotará si la dejamos en el exterior en una noche de invierno de gélido frío. No debería ser demasiado sorprendente que el universo se expanda del mismo modo al cambiar de fase.

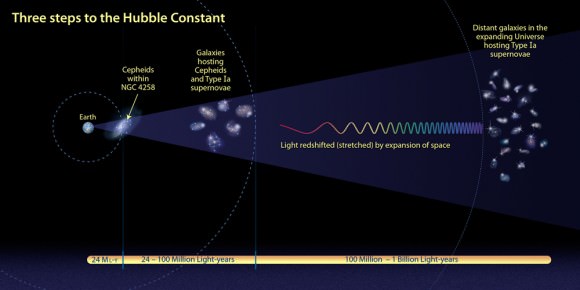

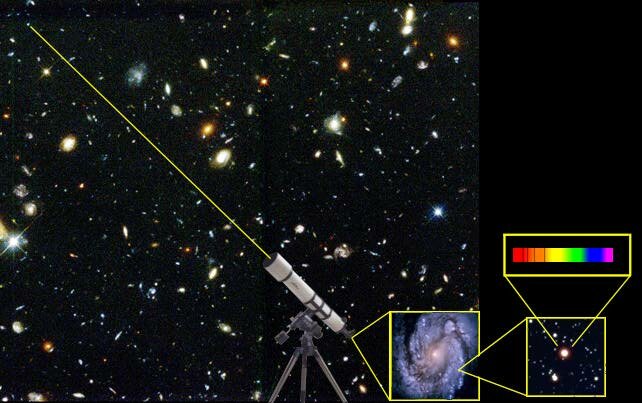

La distancia a una galaxia lejana se determina estudiando la luz proveniente de estrellas de tipo Cefeidas Variables. El expectro de la luz estelar revela la velocidad a la que se mueve la galaxia (Efecto Doppler) y la cantidad de expansión que ha sufrido el universo que la luz salió de su fuente.

Lo que es sorprendente es la enorme amplitud de la expansión. El tamaño del Universo aumentó en un factor no menor de 1050. Este es tan inmenso que virtualmente no tiene significado para la mayoría de la gente, incluido yo mismo que, no pocas veces me cuesta asimilar esas distancias inconmensurables del Cosmos. Dicho de otra manera, pongamos, por ejmplo, que la altura de los lectores aumentara en un factor tan grande como ese, se extenderían de un extremo al otro del Universo y, seguramente, faltaría sitio. Incluso un sólo protón de un sólo átomo de su cuerpo, si sus dimensiones aumentaran en 1050, sería mayor que el mismo universo. En 10-35 segundos, el universo pasó de algo con un radio de curvatura mucho menor que la partícula elemental más pequeña a algo como el tamaño de una naranja grande. No es extraño que el inflación esté ligado a este proceso.

Comparación entre un modelo de expansión desacelerada (arriba) y uno en expansión acelerada (abajo). La esfera de referencia es proporcional al factor de escala. El universo observable aumenta proporcionalmente al tiempo. En un universo acelerado el universo observable aumenta más rápidamente que el factor de escala con lo que cada vez podemos ver mayor del universo. En cambio, en un universo en expansión acelerada (abajo), la escala aumenta de manera exponencial mientras el universo observable aumenta de la misma manera que en el caso anterior. La cantidad de objetos que podemos ver disminuye con el tiempo y el observador termina por quedar aislado del resto del universo.

Cuando ( mucho tiempo ya) leí por primera vez acerca del universo inflacionario, experimenté dificultades para poder asimilar el índice de inflación. ¿No violaría un crecimineto tan rápido las reglas impuestas por la relatividad de Eintien que marcaban el límite de la velocidad en el de la luz en el vacío? Si un cuerpo material viajó de un extremo de una naranja a otro en 10-35 segundos, su velocidad excedió a la de la luz en una fracci´çon considerable.

Claro que, con esto pasar como ha pasado hace unos días con los neutrinos que, algunos decían haber comprobado que corrían más rápidos que la luz, y, sin embargo, todo fue un error de cálculo en el que no se tuvieron en algunos parámetros presentes en las mediciones y los aparatos que hacían las mismas. Aquí, podría pasar algo parecido y, la respuesta la podemos encontrar en aquella analogía con la masa de pan. Durante el período de inflación es el espacio mismo -la masa de pan- lo que está expandiéndose. Ningún cuerpo material (acordaos que en aquella masa estaban incrustadas las uvas que hacían de galaxias y, a medida que la masa se inflaba, las uvas -galaxias- se alejaban las unas de las otras pero, en realidad, ninguna de estas uvas se mueven, es la masa lo que lo hace.

El Universo se expande

Las reglas contra los viajes a mayor velocidad que la de la luz sólo se aplican al movimiento del espacio. Así no hay contradicción, aunque a primera vista pueda parecer que sí. Las consecuencias del período de rápida expansión se pueden describir mejor con referencia a la visión einsteniana de la gravitación. de que el universo tuviera 10-35 segundos de edad, es de suponer que había algún tipo de distribucón de la materia. A cauda de esa materia, el espacio-tiempo tendrá alguna forma característica. Supongamos que la superficie estaba arrugada antes de que se produjera la inflación. Y, de esa manera, cuando comenzó a estirarse, poco a poco, tomó la forma que podemos detectar de “casi” plana conforme a la materia que contiene.

En todo esto, hay un enigma que persiste, nadie sabe contestar cómo, a pesar de la expansión de Hubble, se pudieron formar las galaxias. La pregunta sería: ¿Qué clase de materia estaba allí presente, que, la materia bariónica no se expandiera sin rumbo fijo por todo el universo y, se quedara el tiempo suficiente para formar las galaxias? Todo ello, a pesar de la inflación de la que hablamos y que habrái impedido su formación. Así que, algo tenía que existir allí que generaba la gravedad necesaria para retener la materia bariónica hasta que esta, pudo formar estrellas y galaxias.

No me extrañaria que, eso que llaman materia oscura, pudiera ser como la primera fase de la materia “normal” que, estándo en una primera fase, no emite radiaciones ni se deja ver y, sin embargo, sí que genera la fuerza de Gravedad para que nuestro Universo, sea tal como lo podemos observar.

En imagenes como , los “expertos” nos dicen cosas como:

“La materia oscura en la imagen de varias longitudes de onda de arriba se muestra en un falso color azul, y nos enseña detalles de como el cúmulo distorsiona la luz emitida por galaxias más distantes. En de gas muy caliente, la materia normal en falso color rojo, son fruto de los rayos-X detectados por el Observatorio de Rayois X Chandra que orbita alrededor de la Tierra.”

Algunas galaxias individuales dominadas por materia normal aparecen en colores amarillentos o blanquecinos. La sabiduría convencional sostiene que la materia oscura y la materia normal son atraídas lo mismo gravitacionalmente, con lo que deberían distribuirse homogéneamente en Abell 520. Si se inspecciona la imagen superior, sin embargo, se ve un sorprendente vacío de concentración de galaxias visibles a lo largo de la materia oscura. Una respuesta hipotética es que la discrepancia causada por las grandes galaxias experimentan algún de “tirachinas” gravitacional.

Una hipótesis más arriesgada sostiene que la materia oscura está chocándo consigo misma de alguna forma no gravitacional que nunca se había visto antes..? (esto está sacado de Observatorio y, en el texto que se ha podido traducir podemos ver que, los astrónomos autores de dichas observaciones, tienen, al , unas grandes lagunas y, tratándo de taparlas hacen aseveraciones que nada tienen que ver con la realidad).

Lo cierto es que, en el Universo, son muchas las cosas que se expanden y, pienso yo…¿Por qué no tratamos todos de expandir nuestras mentes? De esa manera, posiblemente podríamos llegar a comprender esos fenómenos que nos atormentan y a los que no podemos encontrar una explicación que podamos constatar.

¿Materia Oscura? Sí, entonces… Unicornios y Gárgolas, también.

emilio silvera

Oct

23

¿Qué nos dirá la Física? y… ¿Qué el Universo? En 2.014

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo: Todo Energía ~

Clasificado en El Universo: Todo Energía ~

Comments (0)

Comments (0)

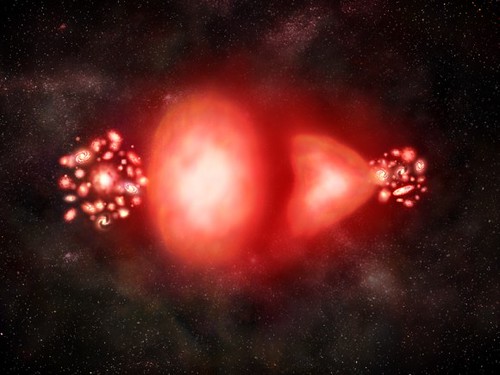

En los comienzos del universo, justo después del Big Bang, existió un ‘plasma de quarks y gluones, dos partículas confinadas hoy en la materia que entonces vagaban libremente… Ahora hemos construído aceleradores de partículas que tratan de recrear aquellos momentos para poder “ver” lo que allí pasó y, buscamos el origen de la masa y partículas exóticas que nos digan algo sobre esa supuesta masa “perdida”, o, que no alcanzamos a ver.

La galaxia NGC 2683 es una galaxia espiral que emula la clásica de las naves especiales en la ciencia ficción.

es la imagen más detallada que existe de Messier 9, una conjunción de estrellas en el centro de la Vía Láctea.

El Hubble produjo esta bella imagen de la galaxia espiral NGC 1483, localizada en el sur de la constelación Mahi-mahi.

las nubes asechan en un día de lluvia, el hubble nos regala esta imagen de la galaxia Centauro.

gigantesco grupo de jóvenes estrellas, llamado R136 está a sólo unos cuantos millones de años luz y reside en la galaxia Doradus Nebula, dentro de la gran Nube de Magallanes.

El Hubble captó imagen del sistema Eta Carinae

Un equipo de científicos ha recolectado suficientes fotos de alta resolución del Hubble durante 14 años, que es suficiente crear un timelapse.

En la celebración del 21 Aniversario del Hubble, en abril de 2011, apuntaron hacia el grupo de galaxias llamado Arp 273 y rescataron bella imagen.

El telescopio espacial Hubble ha logrado captar la extrema violencia del proceso de formación de una estrella es su etapa final, en el que el objeto astronómico se rebela contra su nebulosa.

¿Es una imagen de un anillo de agujeros negros?

En el corazón de la Nebulosa Laguna

La nebulosa IRAS 05437+2502, una pequeñuela cercana a la constelación de Tauro.

¿Qué pintor podría plasmar belleza creadora de estrrellas?

Los ingenios creados por nuestra civilización ha podido arrancar secretos de la Naturaleza que, ni soñar podrían nuestros abuelos

El Tiempo sigue su camino imparable, siempre hacia adelante, ese lugar que llamamos futuro en el que pensamos estará todo lo que buscamos , siempre tendremos preguntas que hacer y que nadie sabrá contestar pero, nuestro destino es seguir adelante y tratar de desvelar los secretos que la Naturaleza esconde…, ella, tiene todas las respuestas.

emilio silvera

Oct

22

¡El cerebro! Siempre nos interesarán sus cosas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ciencia futura ~

Clasificado en Ciencia futura ~

Comments (0)

Comments (0)

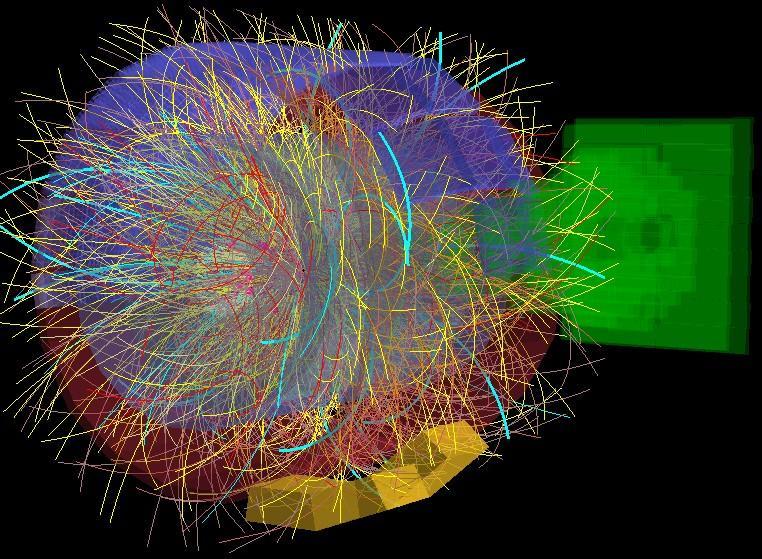

IBM simula 500 mil millones de neuronas y 100 billones de sinapsis

En una simulación neuronal sin precedentes, IBM ha logrado simular 500 mil millones de neuronas y 100 billones de sinapsis. Para ello ha utilizado Sequoia, el segundo superordenador más grande del mundo con millón y medio de núcleos. Esto es una proeza computacional, pero tiene poco que ver con la neurociencia. Veamos por qué.

El departamento de Cognitive Computing de IBM en Almaden dirigido por Dharmendra S. Modha lleva unos años realizando asombrosas simulaciones en el contexto del proyecto DARPA SyNAPSE. Como parte de este proyecto, anunció la simulación a la escala del córtex de un ratón, luego de una rata y más tarde de un gato.

El objetivo de este programa es crear un chip neurosináptico que supone una ruptura con la arquitectura tradicional de los ordenadores. Esta arquitectura es la llamada Von Neumann que usan la totalidad de los ordenadores en la actualidad, incluidos móviles y tarjetas. En la arquitectura Von Neumann la memoria está separada del procesador, el hardware del software y los programas están separados de los datos. Ha sido muy exitosa mientras se cumplía la miniaturización de componentes expresada en la ley de Moore: cada dos años se duplica el número de transistores en un espacio dado. El problema es que estamos llegando a los límites del átomo y que la ley dejará de cumplirse.

El chip neurosináptico es una ruptura total con la arquitectura Von Neumann. Se basa en el diseño de las neuronas en las que no hay distinción entre hw y sw, programas y datos, memoria y procesador. El chip consiste en una matriz de neuronas y entre sus cruces se realizan las sinapsis. De este modo, cada sinapsis del chip es hw y sw, proceso y memoria, programa y datos. Dado que todo está distribuido, no es necesaria un miniaturización tan extrema y sobre todo, un reloj tan rápido. Frente a los actuales gigahercios de frecuencia, las neuronas se disparan a un hercio, y en el caso del chip a 8 hercios. Además, los procesadores son clock driven, es decir, actúan bajo la batuta del reloj mientras que las neuronas son event driven, actúan solo si hay actividad que realizar.

Uno de los objetivos es reducir el consumo eléctrico. Un cerebro consume lo que una bombilla pequeña, 20 vatios. Un superordenador consume cientos de megavatios. El nuevo chip tiene un consumo muy reducido. Estos chips están construidos con tecnología de silicio clásica CMOS.

La arquitectura de muchos chips neurosinápticos unidos se ha llamado TrueNorth. Ya existe en desarrollo un chip de 256 neuronas, 1024 axones, y 256×1024 sinapsis.

El chip sin embargo no está en producción masiva. Para seguir trabajando en paralelo al desarrollo, se ha realizado la prueba actual. Para ello se ha usado un simulador llamado Compass. Compass traduce el comportamiento de un chip neurosináptico (no Von Neumann) a un ordenador clásico (Von Neumann). Usando Compass se ha simulado (pdf) el comportamiento de 2.000.000.000 chips. Esto supone 500 mil millones de neuronas y 100 billones de sinapsis, cifras por completo astronómicas. El resultado de la simulación se ha ejecutado 1.542 veces más lento que en tiempo real.

Para realizar la simulación se ha usado el segundo superordenador más grande del mundo, Sequoia un Blue Gene/Q de 96 armarios con 1 millón y medio de núcleos y 1,5 petabytes de memoria. Uno de los objetivos de la simulación es ver el escalado. Un problema habitual es que que cuando añadimos más cores, el sistema no funciona proporcionalmente más rápido. En el extremo, añadir más cores no aumenta el rendimiento: el sistema escala mal. Imagina un camarero atendiendo detrás de la barra. Si hay un segundo camarero, irán más rápido, pero no el doble. Si sigues añadiendo camareros, llegará un momento en que no aumente la eficiencia, incluso se verá reducida. El sistema escala mal. Pues bien, en la simulación realizada el escalado ha sido casi perfecto lo que es muy satisfactorio computacionalmente.

¿Qué tiene esto que ver con la neurociencia y el cerebro? Bien poco. La simulación no imita ningún comportamiento animal ni cognitivo ni humano. Para simular el comportamiento del cerebro, necesitamos saber cómo funciona y eso está lejos de lograrse. Para cuando llegue ese conocimiento debemos tener preparados ordenadores que sean capaces de simularlo y en este contexto se enmarca la presente investigación. Aunque no solo; la idea de diseñar estos nuevos chips es ponerlos en producción en aplicaciones comerciales tradicionales dando una gran potencia con un bajo consumo. La simulación del cerebro deberá esperar aún alguna década.

Fuente: Altioyo

Oct

21

¡La Física! ¿Estará perdiendo el Norte?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

¿Queremos imitar el salto cuántico y viajar más rápido sin tener recorrer el espacio que separan el punto de partida y el de llegada?

A finales del siglo XIX y principios del XX algunos podían creer que los secretos de la Naturaleza estaban todos descubiertos gracias a los hallazgos que en el pasado hicieran Newton y otros y más recientemente Maxwell, Planck, Einstein y otros muchos que, con sus trabajos nos desvelaron cómo funcionaba la gravedad, qué era en realidad la electricidad y el magnetismo y también, nos llevaron el fascinante mundo de lo muy pequeño con el cuanto de acción, h, de Planck que nos trajo poco más tarde, la mecánica cuántica.

La mecánica, la óptica, la electricidad… todo estaba descubierto y explicado. Los científicos de la época pansaban que sus futuros colegas sólo se dedicarían a realizar medidas para obtener las constantes con mayor precisión vez. Después de todo aquello, se siguió avanzando y continuamos haciéndonos preguntas creyendo que nos llevarían a las respuestas últimas.

Si, por ejemplo, las supercuerdas nos conducen a las respuestas últimas, entonces, ¿en qué dirección debemos nuestra investigación?, ¿es que nos hemos introducido tanto en el mundo de lo desconocido y lo ininteligible que estamos a punto de ahogarnos en un mar de lo absurdo?, ¿estamos enterrados bajo tántas preguntas de los imposibles que deberíamos considerarnos perdidos?, ¿tiene algún sentido especular acerca de la “Teoria de Todo” en un mundo extraño de las unidades de Planck?

Bueno, si queremos ser sinceros…, podemos discrepar de algunas de las cuestiones que hoy se están debatiendo y ser críticos con otras. Sin embargo, no podremos negar los avances que realmente se están logrando en el mundo de las nuevas tecnologías que, gracias a la Física, ya están en el futuro y, en nuestras vidas cotidianas lo estamos viendo continuamente.

Por otra , nada despierta más nuestra curiosidad que lo ininteligible y, precisamente por eso, tiene tanto éxito y llama la atención teorías como la de las supercuerdas. Miremos, por ejemplo, lo que es tan curioso en el mundo de la longitud de Planck es que no podemos encontrar absolutamente ningún modelo que nos pueda dar una descripción razonablemente autoconsistente de partículas que interaccionan entre sí con fuerzas gravitatorias tan intensas y que, al mismo tiempo, obedezcan a las leyes de la mecánica cuántica. Por tanto, incluso si hubiéramos sido capaces de realizar experimentos con choques de partículas con energías planckianas, no hubiéramos sabido como comparar los resultados con una teoría. Aquí hay para los físicos: hacer una teoría. No nos importa demasiado como describa esa teoría la interacción gravitatoria, pero tenemos suficientes requisitos en la lista como para que encontrar esa candidata a ser la teoría sea una labor extremadamente difícil. La Teoría de Supercuerdas parecía estar a punto de conseguirlo, pero falló en los últimos momentos. Dicen que necesitamos la energía de Planck para poder verificarla y, si es así, nos queda espera para rato.

Mientras buscamos esas teorías que están más allá de nuestras posibilidades reales de hoy, la Ciencia no se para y sigue avanzando en otros muchos campos que, como antes decía, nos están llevando a pasos agigantados un futuro que ya está con nosotros y, lo está haciendo con tal rapidez que ni nos hemos percatado de ello.

En cuanto a esa soñada Teoria de Todo, en primer lugar debe ser matemáticamente exacta y tiene que permitirnos calcular con extrema precisión el comportamiento de las partículas bajo todas las circunstancias imaginables. Por ahí circulan una y mil “teorías” que exponen las ideas más variopintas que imaginarnos podamos pero, desgraciadamente, son inútiles para los físicos porque sus descripciones no reúnen el rigor ni la prcisión que deben estar presentes en toda buena teoría. Por otra , los físicos prefieren que la teoría trate la fuerza gravitatoria de tal manera que esté de acuerdo con la obtenida en la formulación de la teoría de la relatividad general de Einstein. Sabemos que la fuerza gravitatoria cuerpos pesados como las estrellas y los planetas obedece a esta teoría con gran exactitud (como ha sido confirmado espectacularmente en las observaciones de los púlsares, estrellas compactas que rotan a gran velocidad. Nuestra teoría candidata debería explicar estas observaciones).

No digamos de los intrincados caminos que la Física ha sobrevolado cuando se ha querido meter en la posibilidad de viajes en el Tiempo y, los físicos se encontraron con una y mil paradojas extrañas. Además, como nos ocurre con la Teoría de cuerdas, al meternos en un sendero desconocido y de intrincados peligros…nunca hemos podido llegar al final después de largos y costosos recorridos. ¿Servirá para algo los muchos esfuerzos realizados?

Por otra somos conscientes y conocedores de que las leyes de la mecánica cuántica son inexorables y, por tanto, queremos que nuestra teoría sea formulada en términos de la mecánica cuántica. Tanto la mecánica cuántica como la teoría de la relatividad tienen la propiedad de que, tan pronto como uno admita la más pequeña desviación de esos principios, ambas darían lugar a una teoría totalmente diferente, que de ninguna manera se parecería al mundo que conocemos (o pensamos conocer). “Un poco relativista” o “un poco mecanicuántico” tan poco sentido como “un poco embarazado”. Podríamos imaginar, por otra parte, que la mecánica cuántica o la relatividad general, o ambas, serían marcos demasiado restrictivos nuestra avanzada teoría, de manera que habría que extender sus principios, llegar más lejos.

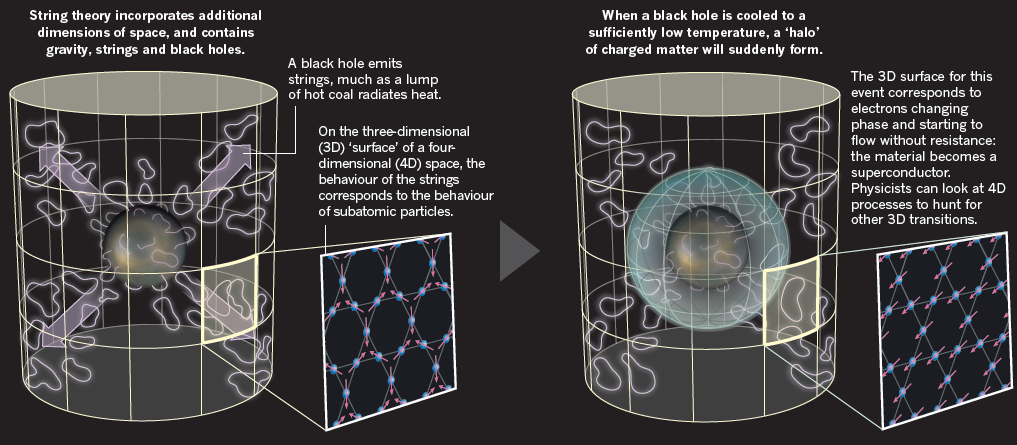

La cuerda es cuántica y gravitatoria, de sus entrañas surge, por arte de magia, la partícula mensajera de la fuerza de gravedad: el gravitón. Funde de natural las dos teorías físicas más poderosas de que disponemos, la mecánica cuántica y la relatividad general, y se convierte en supercuerda -con mayores grados de libertad- es capaz de describir bosones y fermiones, partículas de fuerza y de materia. La simple vibración de una cuerda infinitesimal podría unificar todas la fuerzas y partículas fundamentales.

Parece que todo está hecho de cuerdas, incluso el espacio y el tiempo podrían emerger de las relaciones, más o menas complejas, cuerdas vibrantes. La materia-materia, que tocamos y nos parece tan sólida y compacta, ya sabíamos que está casi vacía, pero no imaginábamos que era tan sutil como una cuerda de energía vibrando. Los átomos, las galaxias, los agujeros negros, todo son marañas de cuerdas y supercuerdas vibrando en diez u once dimensiones espaciotemporales.

Está claro que no trato de explicar aquí una teoría que no comprendo y, el tratar el tema se debe a la curiosidad de tratar de indicar el camino, o, los caminos, por los que se podría llegar más lejos, al , algo más allá. De una cosa si que estoy seguro: ¡Las cuatro fuerzas fundamentales del Universo, un día fueron una sola fuerza!

En el universo existen numerosas estrellas cuyas masas son considerablemente mayores que las del Sol, debido a lo cual, la fuerza gravitotoria en su superficie es considerablemente más intensa que sobre la Tierra o sobre el Sol. La enorme cantidad de materia de una de esas estrellas causa una presión inimaginablemente alta en su interior, pero como las tenperaturasd en el interior de las estrellas es también altísima, se produce una presión contraria que evita que la estrella se colapse. La estrella, sin embargo, pierde calor continuamente. Al proncipio de su vida, en las estrellas se producen todo de reacciones nucleares que mantienen su temperatura alta y que incluso la pueden elevar, pero antes o después el combustible nuclear se acaba. Cuanto más pesada sea la estrella, mayor es la prsión y la temperatura, y más rápidamente se consume su combustible. La contrapresión disminuye progresivamente y la estrella se va colapsando bajo la presión, según dismunye el tamaño de la estrella, la fuerza gravitatoria aumenta hasta que finalmente se produce una implosión -un colapso repentino y completo- que no puede ser evitado por más tiempo: ¡ha nacido un agujero negro!

Según todos los indicios, cuando la estrella es muy masiva, la Improsión finaliza convirtiendo toda la inmensa masa de la estrella en un A. N., pero antes, explota como supernova y llena el espacio de los materiales coplejos que han sido fabricados en sus nucleares, siembra el espacio con una Nebulosa de la que, años más tarde, nacerán nuevas estrellas y nuevos mundos…Y, ¿quién sabe? ¡Si nuevas formas de Vida!

A menudo implosión libera tanto calor que las capas exteriores de la estrella explotan por la presión de la radiación, y la implosión queda interrumpida produciéndose una esfera extremadamente compacta de “material nuclear” que conocemos como una estrella de neutrones. Algunas veces, estas estrellas de neutrones rotan con una tremenda velocidad (más de 500 revoluciones/segundo), y, debido a irregularidades en la superficie, emiten una señal de radio que pulsa con esa velocidad.

Si todos estos sucesos pudieran ser observados una distancia segura, las señales emitidas por el material durante la implosión pronto serían demasiado débiles para ser detectadas y, en el caso de un afgujero negro, el objeto se vuelve de ese color y desaparece de nuestra vista convertido en una “bola de gravedad pura”, se pueden calcular sus propiedades con precisión matemática. Sólo se necesitan tres parámetros para caracterizar completamente al agujero negro: su masa, su movimiento angular (cantidad de movimiento de rotación) y su carga eléctrica.

También se calcular como se comportan los chorros de partículas cuando se aventuiran cerca del agujero negro. Hawking ya nos habló de ello y explicó con suficiente claridad, lo que pasaba era que, en contra de lo que pudiéramos pensar, el agujero emite un débil flujo de partículas en ciertas circunstancias. ¿Esas partículas son reales! Agujero Negro está emitiendo un flujo constante de partículas de todas las especies concebibles.

El Telescopio Espacial Hubble y Chandra han captado la imagen de un impresionante anillo de Agujeros negros. La fotografía corresponde al conjunto Arp 147, en el que aparecen 2 galaxias interactuando entre sí y que se ubican a una distancia de 430 millones de años luz de la Tierra. La NASA combinó datos del Chandra con imágenes del Hubble. Mientras los tonos rojos, azules y verdes fueron resultado del trabajo del Hubble; los de color magenta, del Chandra. La captura muestra un anillo formado por estrellas masivas que evolucionaron rápidamente y explotaron en supernovas, como consecuencia de una colisión galáctica. Es así como dejaron densas estrellas de neutrones y posiblemente, también agujeros negros.

En el Universo ocurren sucesos que no podemos ni imaginar, tales son las fuerzas y energías que ahí están presentes y que dan lugar a maravillas que desembocan en transiciones de fase que convierten unas cosas en otras muy distintas haciendo que la diversidad exista, que la belleza permanezca, que la monotonía no sea el camino.

Es cierto que nunca hemos podido estar tan cerca de un agujero negro como poder comprobar, in situ, la radiación Hawking que, para su formulación, sólo utilizó leyes bien establecidas de la naturaleza y que, por tanto, el resultado debería ser incuestionable, pero no es del todo cierto por dos razones:

La primera razón es que nunca ( he dicho) hemos sido capaces de observar un agujero negro de cerca y mucho de un tamaño tan pequeño que su radiación Hawking pueda ser detectada. Ni siquiera sabemos si tales miniagujeros negros existen en nuestro universo, o si sólo forman una minoría extremadamente escasa entre los objetos del cielo. Aunque pensemos conocer la teoría, no nos habría hecho ningún daño haber podido comprobar sus predicciones de una o de otra. ¿Sucede todo exactamente como pensamos actualmente que debería suceder?

Otros, como Gerald ´t Hooft, consiguieron construir otro de teorías alternativas y le dieron resultados distintos a los de Hawking, en la que el Agujero Negro podia radiar con una intensidad considerablemente mayor que la que la teoría de Stephen predecía.

Hay un aspecto relacionado con la radiación Hawking mucho más importante. El agujero negro disminuye su tamaño al emitir partículas, y la intensidad de su radiación crece rápidamente según se reduce su tamaño. Justo de llegar a los estadios finales, el tamaño del agujero negro se hará comparable a la longitud de Planck y toda la masa llegará a ser sólo un poco mayor que la masa de Planck, Las energías de las partículas emitidas corresponderan a la masa de Planck.

¡Solamente una teoría completa de la Gravedad Cuántica podrá predecir y describir exactamente lo que sucede al agujero negro en ese ! es la importancia de los Agujeros Negros la teoría de partículas elementales en la Longitud de Planck. Los agujeros negros serían un laboratorio ideal para experimentos imaginarios. Todos alcanzan, por sí mismos, el régimen de energía de los números de Planck, y una buena teoría debe ser capaz de decirnos como calcular en ese caso. casi una década, Gerad ´t Hoofft ha resaltando esa objeción en la teoría de supercuerdas: no nos dice nada de los agujeros negros y mucho de cómo un agujero negro comenzar su vida como un agujero negro de tamaño “astronómico” y acabar su vida explosivamente.

Lo cierto es que, andamos un poco perdidos y no pocos físicos (no sabemos si de manera interesada), insisten una y otra vez, en cuestiones que parecen no llevar a ninguna parte y que, según las imposibilidades que nos presentan esos caminos, no sería conveniente elegir otros derroteros para indagar nuevas físicas mientras tanto, avanzan las tecnologías, se adquieren más potentes y nuevas formas de energías que nos puedan permitir llegar a sondear las cuerdas y poder vislumbrar si es cierto, que pueda existir alguna “materia oscura”, o, si existen bosones dadores de masa, o…¡tántas cosas más que, la lista, sería interminable! de las cosas que no sabemos. De hecho, el Modelo Estándar de la física de partículas ha tenido que dejar fuera a una de las fuerzas fundamentales, la Gravedad, no quiere cuentas con las otras fuerzas, y, además, una veintena de parámetros aleatorios conforman esa teroía que, habiendo sido (y lo sigue siendo) una buena herramienta de trabajo para los físicos, tiene muchas dudas pendientes de despejar. Aunque parece que el Bosón de Higgs, una de ellas, ha sido despejada y, esperamos que nos den muchas más explicaciones de su encuentro y de cómo ejerce sus funciones o cometidos de dar mas a las demás partículas.

emilio silvera

Totales: 83.635.908

Totales: 83.635.908 Conectados: 56

Conectados: 56