May

16

El origen de las cosas: El Telescopio de Galileo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del Saber ~

Clasificado en Rumores del Saber ~

Comments (0)

Comments (0)

Hugo de Modena, cardenal italiano, fue el primero que se conoce retratado llevando gafas allá por el año 1352. En aquellos primeros balbuceos de tan prácrtico instrumento, cualquier intento de encontrar lentes que para fines que necesitasen imágenes nítidas en toda la lente estaba condenado al fracaso. Pero los pulidores de lentes mejoraron gradualmente sus técnicas, y hacia la mitad del siglo XVI, los fabricantes de lentes alemanes estaban tallando y pudiendo sus lentes más cuidadosamente en ambos lados. Rolf Willach, un moderno ingeniero óptico con un gran interés en los instrumentos ópticos primitivos, ha estado midiendo lentes antiguas durante 20 años, probando la calidad de anteojos tan antiguos como el siglo 14 y lentes de telescopios de comienzos del siglo XVII mediante el sencillo test de Ronchi. Willach mostró que ya en 1540, unos 80 años antes de Galileo, algunas lentes eran lo suficientemente buenas como para producir formas reconocibles cuando se combinaban con modernos oculares cóncavos.

Hacia 1400, las gafas o anteojos eran algo común en Europa. Ayudaban a viejos lectores a enfocar letras pequeñas y acercaban las cosas lejanas a los miopes. Para todos estos usos la calidad de las lentes no tenía que ser alta. A los discos de cristal se les daba una forma aproximadamente esférica (tanto concava como convexa) de un lado, y plana y pulida en el otro. Éstas lentes formaban una figura esférica que no importaba mucho, puesto que nuestra visión directa utilizada únicamente una pequeña parte de las lentes: que no es mayor que la pupila de un ojo. Por lo que si una par de lentes toscas nos da una visión borrosa, podemos desplazar las gafas en nuestra cara poco para encontrar un punto dónde la imagen sea nítida.

En 1.623, Galileo escribió:

“Estamos seguros de que el inventor del telescopio fue un sencillo fabricante de anteojos que, manipulando por casualidad lentes de formas diferentes, miró, también casualmente, a través de dos de ellas, una convexa y la otra cóncava, situadas a distancias diversas del ojo; vio y se percató del inesperado resultado y descubrió así el instrumento.”

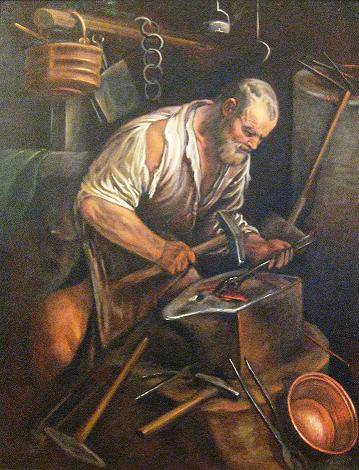

Sencillos Talleres en los que se hacía de todo

Y, no sería de extrañar que dicha afortunada casualidad se diera en varios talleres y lugares a la vez. El relato más verosímil sitúa el episodio crucial en el taller de un humilde fabricante de anteojos holandés llamado Hans Lippershey, de Mildelburg, alrededor del año 1.600. Se cuenta que en el taller entraron dos niños con sus juegos y cogieron lentes que juntaban y miraban por ellas hacia la veleta del pueblo, y, con sorpresa vieron que aquella torre con su veleta, se les venía encima. Se lo dijeron al Lippershey que también miró y así, de esa forma casual, nació la idea de lo que más tarde fue el telescopio.

Aunque inculto, se dio cuenta de que aquello podría tener su importancia y, el 2 de octubre de 1.608, en los Estados generales, Institución del Gobierno de los Países Bajos, se recibió una petición formal del registro del invento de un objeto que permitía ver en la distancia como si las cosas estuvieran cercanas.

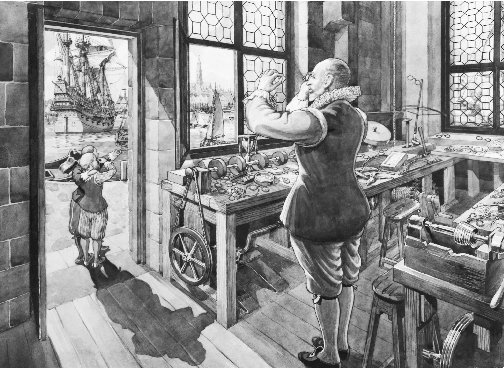

Telescopio de Galileo. El óptico holandés Hans Lippershey fue probablemente el que construyó el primer telescopio en la primera década del siglo XVII. Galileo fue uno de los que lo utilizaron para observar los cielos. El telescopio que construyó galileo en 1609 era un telescopio de refracción, con lente convexa delante y una lente ocular cóncava. Con él descubrió las fases de Venus, lo que indicaba que este planeta gira alrededor del Sol. También descubrió cuatro lunas girando alrededor de Júpiter. En la imagen, dos telescopios de Galileo conservados en el Museo de Historia de la Ciencia de Florencia.

La época era la adecuada para que apareciera un instrumento así, ya que, como aparato militar para vigilar al enemigo, no tendría precio y, se daba la circunstancia de que los Países Bajos luchaban por su Independencia contra los ejércitos del rey Felipe II.

Pero, Lippershey tuvo la mala suerte de que en aquel mismo momento otros neerlandeses reclamaban también el honor y los beneficios de ser los inventores del telescopio y, a partir de aquí, la batalla por conseguir la primacía no es la meta de esta historia que os quiero contar aquí.

La gente, como ocurre casi siempre, era prudente por lo general y, cualquier cosa que se saliera de lo que les dictaba su sentido común, en un primer momento era siempre rechazada de plano. ¡Un aparato que anulaba la evidencia que el ojo les daba de primera mano! No fue nada fácil convencer a los “filósofos naturales” de que miraran a través de aquel dichoso instrumento. Tenían muchísimas razones de índole intelectual para desconfiar de lo que no veían a simple vista.

El eminente aristotélico Cesare Cremonini se negó a perder el tiempo mirando por el artefacto de Galileo sólo para ver “…lo que nadie más que Galileo ha visto…y, además, mirar por esos anteojos me produce dolor de cabeza”. Otro colega hostíl declaraba: “Galileo Galilei, matemático de Papua, llegó a Bolonia con su telescopio, mediante el cual veía cuatro falsos planetas. El 24 y el 25 de abril no dormí ni de día ni de noche y probé el instrumento de Galileo de mil formas diferentes. Abajo, funciona de maravilla; en el cielo es engañoso, pues algunas estrellas fijas se ven dobles. Tengo como testigos a los más excelentes hombres y nobles doctores…y todos han admitido que el instrumento es engañoso. Galileo se quedó sin habla y el 26 se marchó entristecido.”

Al principio, el famoso padre Clavius, profesor de matemáticas en el Collegio Romano, burlándose de los cuatro supuestos satélites de Júpiter que había visto Galileo, dijo que él también podía enseñarlos si le daban tiempo para “meterlos primero en unas lentes”.

El propio Galileo miraba un objeto por su telescopio y luego se acercaba a él para comprobar que no se engañaba. El 24 de mayo de 1.610, declaró que había probado el telescopio “cien mil veces en cien mil astros y otros objetos”. Un año después seguía probando. “Más de dos años llevo probando mi instrumento (o más bien docenas de instrumentos que he ido mejorando) en cientos y miles de experimentos con miles y miles de objetos, cercanos y lejanos, grandes y pequeños, luminosos y oscuros; por tanto no sé cómo le puede caber a nadie en la cabeza que, ingenuamente, me haya engañado en mis observaciones.”

Galileo era uno de los primeros cruzados de las paradojas de la ciencia contra la tiranía del sentido común. El descubrimiento de la Naturaleza, de los modos de los planetas exigió ante todo la conquista del sentido común. La ciencia no avanzaría dando cuenta de la experiencia cotidiana, sino aferrándose a la paradoja, aventurándose en lo desconocido. Instrumentos nuevos como los telescopios ofrecían perspectivas nuevas muy perturbadoras en las comunidades del conocimiento.

El gran mensaje del telescopio era que existían infinidad de objetos que no podían ser examinados en persona o ser vistos por el ojo humano desnudo y desprovisto de aquella ayuda nueva que suplía las carencias mismas de la vista para poder “ver” lo que había en esas grandes distancias del cielo.

Todo aquello preocupó mucho a la gente mucho antes de que se convencieran al fin, plenamente, de que sólo se trataba de un invento artificial que el hombre había ideado para conseguir ver lo que de otra manera le sería imposible.

En 1.611, John Donne (1572?-1631), poeta inglés, observó que las ideas copernicanas, que “puede que sean ciertas”, se estaban “introduciendo furtivamente en la mente de los hombres”, y expresó así la moderna desazón:

Y la nueva filosofía lo pone todo en duda,

El elemento del fuego se ha apagado;

El sol se ha perdido, y la tierra, y el juicio de los hombres

Ya no puede guiarlos en su búsqueda.

Y confiesan libremente que el mundo ya no es lo que era,

Cuando en los planetas, y en el firmamento

Ellos buscan tanta novedad, y luego ven que esto

Se desmenuza otra vez en sus átomos.

Todo está en pedazos, toda coherencia ha desaparecido;

Todo es simple suministro, y es todo relación…

Y en estas constelaciones se alzan entonces

Nuevas estrellas, y las antiguas desaparecen ante nuestros ojos.

Linz la ciudad austríaca de Kepler a orillas del Danubio

En 1.919, durante el viaje que Donne hizo por el continente europeo, se tomó la molestia de ir a ver a Kepler a la remota población austriaca de Linz. También John Milton (1608-1674) se sentía desconcertado ante la nueva cosmología y no veía con claridad lo que aquello podía implicar. Cuando acababa de cumplir los treinta años fue a ver a Galileo, que había perdido la vista, a Arcetri, cerca de Florencia donde el astrónomo estaba confinado por orden papal.

En Areopagitica (1644), publicada dos años después de la muerte de Galileo, Milton lo describe como una victima heroica. “Esto fue lo que apagó la gloria de los genios italianos…durante muchos años no se había escrito allí más que lisonjas y culteranismo y allí encontré y visité al famoso Galileo, envejecido, prisionero de la Inquisición por pensar sobre Astronomía de modo distinto al de los franciscanos y dominicos.” No obstante, dos años después cuando Milton publicó El paraíso perdido, para “justificar la manera de actuar de Dios con los hombres, él mismo siguió de cerca la cosmología ptolemaica-cristiana tradicional. ¡La cobardía de algunos hombres!

Galileo Galilei (1564-1642) y el telescopio coincidieron por una serie de casualidades, que no tenía nada que ver con el deseo de nadie de revisar el Cosmos ptolemaico de fomentar el progreso de la Astronomía, ni de estudiar la forma del Universo. Los motivos inmediatos residían en las ambiciones militares de la República de Venecia y en el espíritu experimental inspirado por sus empresas comerciales.

Hans Lippershey tiene una lente delante de otra para magnificar un objeto distante. Al montar dos lentes en un tubo de madera, Lippershey creó el primer telescopio, influído por el juego de unos niños que descubrieron por casualidad lo que unos cristales colocados adecuadamente podía hacer.

Un mes después de que Lippershey presentara su solicitud al príncipe Mauricio, las noticias referentes al telescopio ya habían llegado a Venecia. El primero en enterarse del descubrimiento fue Paolo Sarpi (1552-1623), polifacético fraile que sentía una gran pasión por la ciencia. Como teólogo gubernamental del Senado veneciano y principal consejero en la disputa que mantenía con el papado, se esperaba que estuviera informado sobre los acontecimientos que tenían lugar en el extranjero.

Era amigo del ingenioso fabricante de instrumentos Galileo, cuya creación de un nuevo aparato de calcular acababa de defender contra las reclamaciones de un malicioso plagiario milanés. En esa época, Galileo había ocupado ya durante quince años el puesto de profesor de matemáticas en la universidad de la cercana Papua, puesto que le había sido concedido por el Senado veneciano. Galileo había realizado frecuentes viajes a los talleres del arsenal veneciano y él mismo dirigía un pequeño taller en Papua, donde fabricaba instrumentos de agrimensura, brújulas y otros aparatos matemáticos como él los llamaba. Así, con los ingresos que obtenía en el taller, complementaba sus escasos honorarios como profesor, y podía contribuir a engrosar la dote de su hermana y a mantener a sus hermanos y a su anciana madre. En ésta época Galileo tenía ya fama de buen fabricante de instrumentos.

Cuando llegó a Venecia un extranjero que pretendía vender un telescopio al Senado, el asunto le fue transferido a Sarpi, el amigo de Galileo que, si bien estaba convencido de que el telescopio le sería útil a una potencia marítima en alza, en aquel momento sólo pensó en su amigo Galileo y en que podría fabricar uno de aquellos artilugios, incluso de mejorarlos. Asi que, muy ladinamente, aconsejó al Senado que no comprara el aparato ofrecido por aquel extranjero.

Pronto quedaría justificada la confianza de Sarpi en Galileo. En julio de 1.609, el propio Galileo, que casualmente se encontraba en Venecia, había oído rumores de la existencia de tal instrumento, el telescopio, y al mismo tiempo había oído que un extranjero había llegado a Papua con uno de ellos. Inmediatamente salió para Papua con la intención de satisfacer su curiosidad, pero cuando llegó allí, el misterioso viajante se había marchado a Venecia.

Hombre de gran ingenio, se enteró de cómo se había hecho aquel aparato y de inmediato, se puso a fabricar uno. Antes de que finalizara el mes de agosto, Galileo regresó a Venecia, donde sorprendió al Senado y complació a Sarpi con un telescopio de nueve aumentos, tres veces más potente que el que ofrecía el extranjero. Galileo continuó mejorando el instrumento; a fines de 1609 había fabricado un telescopio de treinta aumentos. Éste era el límite del diseño utilizado entonces -un objetivo plano-convexo y un ocular plano-cóncavo- y pasó a ser conocido como el telescopio de Galileo.

En un grandioso gesto, y en lugar de tratar de vender el aparato, Galileo se lo regaló al Senado veneciano en una ceremonia celebrada el 25 de agosto de 1609. A cambio, el Senado le ofreció a Galileo un contrato vitalicio de su cargo de profesor, que expiraba al año siguiente, y un aumento de su salario anual de 520 a 1.000 florines. Este trato de favor y privilegio despertó el resentimiento y la envidia de sus colegas, que se dedicarían a importunarlo durante el resto de su vida. Objetaban que habían sido otros los inventores del telescopio, Galileo lo máximo que merecía era un buen precio por el aparato por él construido.

Galileo no se detuvo allí y, a principios de enero de 1610 hizo lo que ahora nos parece lo más lógico, apuntó el telescopio hacia el cielo. En ese momento, comenzó, sin él mismo saberlo, una de las aventuras más grandes que la Humanidad pudiera emprender, y, la verdad es que, en la primera década del siglo XXI, aquella aventura aún continúa.

He querido contar aquí los detalles menos conocidos del telescopio de Galileo del que todo el mundo habla en este Año Internacional de la Astronomía pero, del que en realidad, todos saben muy poco.

La historia completa sería muy larga de contar y, además, los detalles de sus descubrimientos son muy conocidos y se han relatado en muchas ocasiones así que, os he contado la parte de la historia que, siendo menos llamativa es, por ello, también menos conocida.

Lo que Galileo vio por primera vez cuando apuntó con su telescopio al cielo, le sorprendió tanto que, de inmediato, publicó una descripción de su visión. En marzo de 1610, Sidereus Nuncios (El mensajero de las estrellas”). Un folleto de veinticuatro páginas que asombró al mundo.

Claro que, en aquella época, estaba presente la Iglesia y, hablarle de otros mundos y de que la Tierra se movía alrededor del Sol, era muy arriesgado (Giardano Bruno murió en la Hoguera por expresar sus pensamientos) y, Galelio, se vio sometido a un juicio del que salió ileso por chiripa y fue condenado a vivir recluído el resto de sus días

Galileo ante el Santo Oficio, por Joseph-Nicolas Robert-Fleury

Galileo en el Juicio al que fue sometido por la Iglesia, lo pasó muy mal, y, sólo el hecho de que no discutiera y de manera humillante se plegara, le salvó la vida y le llevó al confinamiento domiciliario hasta el resto de sus días.

Gran parte de esta Historia está recopilada de la Colección “Los Descubridores”

Publica: emilio silvera

May

16

La Gravedad, esa fuerza misteriosa

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (39)

Comments (39)

Dos nuevos estudios realizados por investigadores de Australia, Austria y Alemania han puesto en entredicho la forma en la que entendemos la física de la gravedad. Los descubrimientos, publicados en las revistas Astrophysical Journal y Monthly Notices of the Royal Astronomical Society, se basan en observaciones de galaxias enanas satélite o galaxias más pequeñas que se encuentran en el extrarradio de la gran galaxia espiral que es la Vía Láctea.

Las dos se atraen, ¿será alguna forma de gravedad? Bueno, más bien, en este caso, será el magnetismo.

La Ley de la gravitación universal de Newton, publicada en 1687, sirve para explicar cómo actúa la gravedad en la Tierra, por ejemplo por qué cae una manzana de un árbol. El profesor Pavel Kroupa del Instituto de Astronomía Argelander de la Universidad de Bonn (Alemania) explicó que «a pesar de que su ley describe los efectos cotidianos de la gravedad en la Tierra, las cosas que podemos ver y medir, cabe la posibilidad de que no hayamos sido capaces de comprender en absoluto las leyes físicas que rigen realmente la fuerza de la gravedad».

La ley de Newton ha sido puesta en entredicho por distintos cosmólogos modernos, los cuales han redactado teorías contradictorias sobre la gravitación que intentan explicar la gran cantidad de discrepancias que se dan entre las mediciones reales de los sucesos astronómicos y las predicciones basadas en los modelos teóricos. La idea de que la «materia oscura» pueda ser la responsable de estas discrepancias ha ganado muchos adeptos durante los últimos años. No obstante, no existen pruebas concluyentes de su existencia.

En esta investigación, el profesor Kroupa y varios colegas examinaron «galaxias enanas satélite», cientos de las cuales deberían existir en la cercanía de las principales galaxias, incluida la Vía Láctea, según indican los modelos teóricos. Se cree que algunas de estas galaxias menores contienen tan sólounos pocos millares de estrellas (se estima que la Vía Láctea, por ejemplo, contiene más de 200.000 millones de estrellas).

Al día de hoy sólo se ha logrado detectar treinta de estas galaxias alrededor de la Vía Láctea. Esta situación se atribuye al hecho de que, al contener tan pocas estrellas, su luz es demasiado débil como para que podamos observarlas desde una distancia tan lejana. Lo cierto es que este estudio tan detallado ha deparado resultados sorprendentes.

May

15

El futuro de la física está en nuestra imaginación

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (3)

Comments (3)

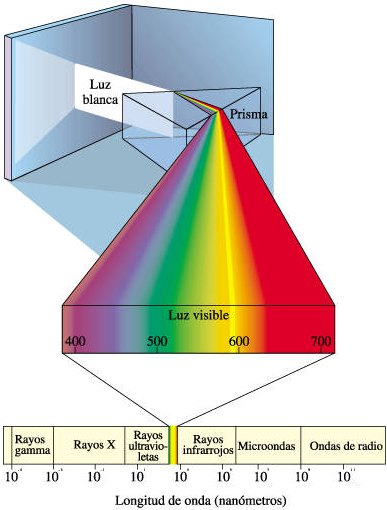

Diversidad de ideas

Me gusta escribir sin tener un objetivo predeterminado y repasar sobre cuestiones de la física. Escribo todo lo que estoy “viendo” -lo que sin llamarlo, acude a mi mente en cada instante-. Es un buen ejercicio de repaso de diversas cuestiones que recuerdas. Por ejemplo, ahora mismo me llega la idea de que desde la más remota antigüedad nos viene fascinando los fenómenos ópticos. De hecho, los estudios encaminados a desvelar la naturaleza de la luz han sido uno de los motores más fructíferos de la física. A ello se dedica la óptica, hoy día una de las áreas más activas de la física.

algunos pudieron asombrarse ante esta imágen de esplendorosa belleza natural, ¿qué produjo tal fenómeno? De nuevo, como es mi costumbre, me desvío del tema pero, me estaba regfiriendo al auge en el campo de la óptica…¿dónde radica el impulso de esa disciplina?

Buena prueba de ello es la rápida sucesión de Premios Nobel en ese campo en años recientes: 1.997, 2.001 y 2.005. En la luz se apreció por primera vez la naturaleza dual onda-partícula de los objetos cuánticos. El comportamiento ondulatorio de la luz sirvió de prueba experimental para la teoría electromagnética de Maxwell. La idea de la luz como un haz de fotones reapareció con Einstein en 1.905 para explicar el efecto fotoeléctrico (que le valió el Nobel de física). El dualismo onda-partícula de la luz, que De Broglie extendió a las partículas materiales, es contradictorio en el marco de la física clásica. Para reconciliar ambas imágenes hubo que desarrollar la física cuántica. No obstante, como señalaba Glauber en uno de sus artículos…

“la teoría cuántica ha tenido una influencia sobre la óptica que es sólo una fracción de la que históricamente ha tenido la óptica sobre la teoría cuántica”.

Premio Nobel de Física de 2.005. Roy J. Glauber, de la Universidad de Harvard, Theodor W. Hänsch, del Instituto Max Plack y John L. Hall, de la Universidad de Colorado, comparten el premio Nobel de Física 2005. Glauber lo recibe por su contribución a la teoría cuántica de la coherencia óptica, mientras que Hänsch y Hall por sus contribuciones a la espectroscopía de precisión basada en láser, incluyendo la técnica de barrido de frecuencia óptica.

Motivado por los experimentos de Hanbury-Brown y Twiss en 1.954-56, y por la invención del láser en 1.960, Glauber realizó una aplicación de la electrodinámica cuántica a problemas ópticos. Mientras que los experimentos previos habían usado interferencia de amplitudes y registraban intensidades con un solo detector, Hanbury-Brown y Twiss estudiaron correlaciones en las intensidades recibidas de una estrella por dos detectores separados, observando que los fotones térmicos parecen emitirse agrupados (bunched). ¿También los de un haz de láser? Esta y otras cuestiones llevaron a Glauber a desarrollar la teoría cuántica de la coherencia, basada en los estados coherentes y en la teoría cuántica de la fotodetección. Estudiando coincidencias retardadas en la detección de fotones por varios detectores, Glauber introdujo una sucesión de funciones de correlación que mostraban las características cuánticas de la radiación y permitían diferenciar entre haces de luz con la misma distribución espectral, pero diferente estadística de fotones.

En el universo temprano los fotones se convertían continuamente en pares

Particularmente relevantes han sido los estudios posteriores de “luz no clásica”, tales como resonancia-fluorescencia de un solo átomo, que muestra el llamado antibunching, luz cuyo ruido cuántico depende de la fase; y pares de fotones entrelazados.

El estado más común de la materia en el universo, no es ni líquido, ni sólido, ni gaseoso, sino que es el plasma; el estado de la materia que conforman las estrellas. Sin embargo, particularmente apuesto por una idea que no se va de mi cabeza, el estado último de la materia es la luz.

La otra mitad del Premio Nobel se otorgó a partes iguales a John L. Hall, de la Universidad de Colorado, JILA y NIST, Boulder y a Theodor W. Hänsch, del Max Planck Instit für Quantenoptik, Garching, y de la Ludwig-Maximilians-Universität, Munich, “por sus contribuciones al desarrollo de métodos de espectroscopia láser de precisión, incluyendo la técnica de peines de frecuencias ópticas“.

espectroscopia de absorción atómica

A lo largo de toda la historia la ingeniería se ha convertido en unas de las fuentes de solución a todos los problemas de la humanidad, de la mano de las ciencias y la tecnología, la cual ha aportado tantos métodos de mayor exactitud como lo es el utilizado por la espectrofotometría de absorción atómica; ya que es una técnica capaz de detectar y determinar cuantitativamente la mayoría de los elementos del sistema periódico.

En espectroscopia se analiza la composición en frecuencias de la luz absorbida o emitida por la materia, lo cual proporciona información valiosa, por ejemplo, sobre la estructura cuántica de los átomos.

Los galardonados lideraron un proyecto espectacular en el desarrollo de métodos para producir y medir estas frecuencias ópticas, con una precisión actual de 15 cifras significativas y potencial de 18. De hecho, este tipo de medidas son de las de mayor precisión alcanzadas en física y permiten abordar cuestiones de gran interés básico, como la observación de la variación temporal de “constantes” fundamentales, como la estructura fina (α = 1/137, ó 2πe2/hc). Tienen también repercusión en el desarrollo de relojes atómicos ultraprecisos (con desajuste menor a una décima de segundo cada 100 años), útiles por ejemplo en sistemas GPS.

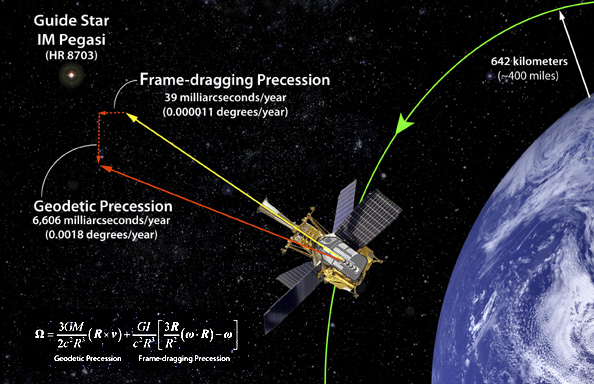

No dejamos de enviar ingenios al espacio para tratar de medir la Densidad Crítica y poder saber en qué clase de universo nos encontramos: Plano, cerrado o abierto. Pero, también mandamos satélirtes artificiales que, desde el cielo, dominan y controlan aspectos de la Tierra que nos son muy útiles en navegación, circulación víal, y otros muchos conceptos que, tanto en la vida cotidiana como en la investigación, nos sitúan en el más alto nivel de la tecnología…del futuro.

En espectroscopia óptica de precisión han de determinarse frecuencias de varios cientos de THz en términos de la definición del patrón de tiempo representado por desdoblamiento hiperfino del estado fundamental del cesio a 9’2 GHz. Hasta el año 2.000, esta tarea requería esfuerzos heroicos porque los detectores sólo permiten comparar directamente frecuencias separadas por algunas decenas de GHz. Se usaban por tanto complejas cadenas de generación de sucesivos armónicos de la frecuencia del cesio.

Esas cadenas eran costosas, delicadas, y de hecho, sólo algunos laboratorios las desarrollaron. El problema se ha simplificado enormemente con la introducción por Hall y Hänsch del llamado peine de frecuencias ópticas, formado por del orden de un millón de frecuencias equiespaciadas unos 100 MHz y cubriendo varios cientos de THz. De estas frecuencias pueden realizarse una medida absoluta con el patrón de cesio. Por tanto el peine sirve como una “regla” para determinar cualquier frecuencia óptica desconocida. Estos peines o sintetizadores de frecuencias, que ya se comercializan, usan láseres de femtosegundos y un nuevo tipo de fibra óptica microestructurada o de cristal fotónico…

¿Dónde estará el límite?

Han pasado ya unos cincuenta años desde que Richard Feynman dictara su famosa plática There is plenty of room at the bottom: An invitation to enter a new field of physics (Hay suficiente espacio en el fondo: Una invitación a entrar en un nuevo campo en la Física). En ella estableció que las leyes de la Física no impiden manipular las cosas átomo a átomo; –es algo que se puede hacer pero no se ha hecho debido a que somos demasiado grandes para hacerlo-. Desde entonces se ha estado buscando la manera de poder diseñar los materiales átomo a átomo. De hecho, los materiales nanoestructurados ya han sido utilizados en aplicaciones prácticas, siendo importantes en nuestra vida diaria. El color rojo de los vitrales en las catedrales góticas de Europa se obtenía utilizando nanopartículas de oro; la película fotográfica utiliza nanopartículas de plata; los bloqueadores solares utilizan nanopartículas de dióxido de titanio y de zinc como parte activa. El primer caso es una aplicación del efecto nano del oro y es quizás la primera aplicación de la nanotecnología. Quizás el mayor desarrollo de las nanoestructuras se dio con el descubrimiento de la microscopia de fuerza atómica ya que con esta se podía manipular a los átomos o partículas muy pequeñas. Hoy día, la investigación en el campo de los materiales nanoestructurados se ha multiplicado y sus aplicaciones abarcan todas las disciplinas convirtiendo a la nanotecnología en un campo interdisciplinario. Muchos países han implementado programas especiales para la investigación en este campo invirtiendo grandes cantidades de dinero. La apuesta puede ser de alto riesgo, pero el premio promete ser enorme.

Materiales nanoestructurados y nanotecnología

Los materiales nanoestructurados (NEMs, por siglas en inglés) han despertado rápidamente un gran interés debido a la diversidad de sus aplicaciones. De acuerdo a la definición más aceptada, los materiales nanoestructurados son aquellos en los que por lo menos una de sus dimensiones se encuentra en el rango de 1-100 nm. Es decir, los NEMs son tres órdenes de magnitud más pequeños que los MEMS (sistemas microelectromecánicos, por sus siglas en inglés), e incluyen nanopartículas, nanocristales, nanoalambres, nanobarras, nanotubos, nanofibras, nanoespumas, etc. Los NEMs pueden ser semiconductores, dieléctricos, metales, orgánicos, inorgánicos, aleaciones, biomateriales, biomoléculas, oligómeros, polímeros, etc.

Nos sorprendería saber en qué lugares están presentes los cristales fotónicos con las nuevas técnicas alcanzadas en la nanotecnología

Aunque también existen sistemas nanoestructurados de dimensiones mayores como son los cristales fotónicos. En el rango de nanómetros, los materiales presentan propiedades ópticas, eléctricas, magnéticas y mecánicas únicas y totalmente diferentes de los materiales en el rango de los micrómetros o milímetros llamados también materiales en bulto.

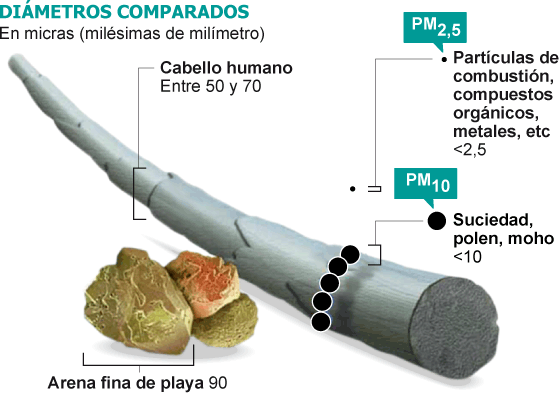

Para tener una idea de que tan pequeño es un nanómetro podemos mencionar que un milímetro tiene un millón de nanómetros; el diámetro del cabello humano mide entre 10,000 y 50,000 nanómetros; los glóbulos rojos y blancos miden entre 2 y 5 nanómetros mientras que el ADN mide 2.5 nanómetros.

Las propiedades de los NEMs son dominadas por los efectos de superficie mientras que las de los materiales en bulto son debidas a un efecto de volumen. La tecnología para su producción y uso se ha convirtiendo en una industria muy poderosa: la nanotecnología. La nanotecnología es la ciencia e ingeniería de producir materiales o estructuras funcionales de unos cuantos nanómetros. Es la tecnología del futuro con la cual se desarrollarán los nuevos materiales y dispositivos. Las aplicaciones son sorprendentes así como variadas, por ejemplo, la industria optoelectrónica y fotónica, biomedicina, sensores, celdas solares y de combustible, catálisis, memorias ópticas, procesadores de computadoras, fotodetectores, herramientas de corte, industria automotriz y aeronáutica, moduladores e interruptores, cosméticos, etc. Aunque todas las aplicaciones son de gran interés, sin duda alguna las aplicaciones en sistemas biológicos son las más sobresalientes. Especialmente las aplicaciones de las propiedades ópticas de los sistemas nanoestructurados.

No tarderemos mucho en asombrarnos de los logros alcanzados por la Nanofotónica en diversos apartados de la tecnología del futuro

Uno de sus aprtados es, la Nanofotónica

La nanofotónica es la fusión de la nanotecnología y la fotónica. Es un campo multidisciplinario que estudia las propiedades ópticas de los sistemas nanoestructurados y la interacción luzmateria a nivel nanoscópico. Ya mencionamos que las propiedades ópticas de las nanopartículas son dominadas por los efectos de superficie. Así, controlando el tamaño de las nanopartículas o nanoestructuras podemos controlar o amplificar ciertas propiedades de los sistemas bajo estudio. En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas.

Cada una de ellas produce fenómenos de especial interés cuando interactúan con una señal óptica, pudiendo así ser aplicadas en diferentes campos. Un campo de especial interés es la biología.

El estudio de las propiedades luminiscentes de sistemas nanoestructurados en sistemas biológicos es el campo de estudio de la bionanofotónica. Especialmente trata sobre el estudio de sistemas nanoestructurados en aplicaciones biomédicas. Diferentes nanopartículas han sido propuestas para ser utilizadas en la detección de bajas concentraciones de diferentes elementos como células cancerigenas, virus, ADN, ARN, proteínas, etc. También han sido utilizadas para la entrega de medicamentos en forma dirigida y controlada así como para la destrucción de tumores cancerigenos. En la última década, los avances han sido sorprendentes pero aún hay mucho por hacer. En el CIO, durante los últimos 6 años han estado trabajando en la síntesis de nanopartículas y estudiado sus propiedades ópticas a fin de poder ser utilizadas en distintas aplicaciones. Las propiedades luminescentes de nuestras nanopartículas son muy interesantes y prometen grandes oportunidades de aplicación en diferentes áreas.

Nanopartículas semiconductoras o puntos cuánticos

Los nanocristales semiconductores también llamados puntos cuánticos son nanoestructuras a base de materiales semiconductores inorgánicos y representan el grupo donde el efecto del tamaño es más evidente. El tamaño nano da lugar a lo que se conoce como confinamiento cuántico, que no es más que la localización de los electrones en un espacio bien definido, es como poner un electrón en una caja. Mientras que para tamaños mayores los electrones están no localizados. El confinamiento produce un ensanchamiento de la banda de energía prohibida del semiconductor así como la aparición de sub-bandas discretas en la banda de valencia y de conducción. Las dimensiones típicas oscilan entre uno y diez nanómetros.

Con frecuencia se les describe como átomos artificiales debido a que los electrones están dimensionalmente confinados como en un átomo y sólo se tiene niveles de energía discretos. Entre las nanoestructuras más estudiadas se encuentran las de CdSe/ZnS, CdSe/CdS, InP/ZnSe, CdTe/CdSe, entre otras. El resultado más vistoso de estas nanoestructuras es la capacidad para poder sintonizar la longitud de onda o color de la emisión.

Así, con un solo material y variando el tamaño de la nanopartícula es posible obtener múltiples colores o longitudes de onda de la señal emitida. Las aplicaciones son impresionantes y apuntan en todas las direcciones. Por ejemplo, podrían ser utilizados como colorantes inorgánicos sin problemas de degradación a diferencia de los colorantes orgánicos. También podrían ser utilizados en el diseño de los nuevos amplificadores ópticos de amplio ancho de banda tan importantes en los sistemas de comunicación óptica; en este caso cada nanopartícula con un diámetro determinado funcionaría como un amplificador, así el ancho de banda se determina con la selección adecuada de los diámetros de las partículas. O bien para la producción de fuentes de luz blanca mediante excitación con un LED u OLED o por electroluminiscencia.

Quizás una de las aplicaciones que mayor atención ha recibido es en su uso como etiquetas fluorescentes con emisión en la región visible del espectro, para la detección de una gran variedad de compuestos entre ellas células cancerigenas. Las técnicas actuales no detectan bajas concentraciones de células cancerigenas o compuestos de interés, por lo que la técnica de detección de fluorescencia de nanopartículas es una gran promesa para la detección temprana de este mal, para así incrementar el éxito en el tratamiento. Dado el tamaño tan pequeño de los puntos cuánticos actualmente se intenta desarrollar nanoestructuras más complejas formadas por puntos cuánticos o nanocristales acomplejados con diferentes componentes que desempeñan distintas funciones, detección, entrega de medicamento dirigido, efecto de la terapia, etc. Es decir, se busca una nanoestructura inteligente con múltiples funciones. El problema que presentan los puntos cuánticos es que son poco estables ya que tienden a aglomerarse, además de que se excitan con una fuente de luz UV donde la mayoría de los compuestos que se pueden encontrar en interior del cuerpo humano emiten luz lo que significa pérdida de contraste en la imagen de la célula deseada.

Nanopartículas dieléctricas o nanocristales

Los nanocristales dieléctricos son óxidos que presentan una banda de energía prohibida muy ancha y como consecuencia requieren altas energías de bombeo o luz en el UV para obtener emisión que en general es débil, aunque cuando se combina en forma adecuadacon diversos componentes son excelentes emisores de luz debido a su eficiencia y alta estabilidad. Son excelentes matrices para soportar iones de tierras raras que son muy buenos emisores de luz. En este caso no se observan efectos de confinamiento debido a que los electrones se encuentran localizados en orbitales atómicos del ion activo. Sin embargo, la dinámica de los iones emisores de luz se ve afectada por la interacción a nivel nanoscópico lo que puede producir una mejora en la eficiencia de emisión. Entre los nanocristales mas estudiados se encuentran algunos silicatos como Y2SiO5, la combinación nY2O3 + mAl2O3 que comprende puramente el óxido de itria, puramente el óxido de aluminio, cuando se combinan con n=3 y m=5 da lugar a la estructura cristalina mas utilizada en óptica para producir láseres conocida como YAG, o YAP para la combinación n=m=1 que corresponde a uno de los cristales mas sensibles a laradiación ionizante y que es utilizado para la detección de rayos X o rayos gama. El óxido de titanio (TiO2) y el óxido de zinc (ZnO) que se utilizan en los bloqueadores solares además de ser excelentes para los procesos de fotocatálisis, útiles en la reducción de contaminantes, para celdas solares y como bactericida.

Recientemente, hemos demostrado que el óxido de zirconio (ZrO2) combinado con otros elementos bloquea el rango completo de la luz ultravioleta, especialmente aquella región que produce el cáncer de piel. Este mismo nanocristal presenta excelente respuesta en la detección de radiación ionizante, UV, rayos X, gama, beta y alfa, tanto en tiempo real como en forma acumulada lo que sugiere buenas oportunidades para su uso en el diseño de dosímetros para la cuantificación de dosis recibidas.

Además, es excelente soporte para iones de tierras raras, con las cuales hemos obtenido luz visible (azul, verde y rojo) excitando con una fuente en el cercano infrarrojo. Ya que con esta fuente solo se excitan los nanocristales no hay emisión de fondo lo que mejora el contraste de las imágenes obtenidas. Estas características convierten a estos nanocristales en excelentes candidatos en aplicaciones biomédicas para la detección de diversos elementos a concentraciones bajas. La fabricación de estos nanocristales implica un tratamiento térmico para el proceso de oxidación lo que induce un tamaño de partícula grande. Se han reportado tamaños de partícula desde 10 a 90 nm.

Estructura de alas de mariposa son fabricadas con la nanofotónica de cristales, y, en realidad, sólo nos limitamos a copia la Naturaleza

Muchas veces se obtienen cristales muy pequeños pero con poca eficiencia de emisión, el reto es obtener mayor eficiencia de emisión sin incrementar demasiado el diámetro de las nanopartículas. Tamaños promedios con los que se han obtenido excelente eficiencia de emisión son entre 40 y 60 nm.

Nano partículas metálicas, plasmones.

Las nanopartículas metálicas tienen la habilidad de esparcir y absorber la luz incidente. En este caso, los efectos en las propiedades ópticas respecto a su contraparte en bulto se derivan de los efectos electrodinámicos y de la modificación del ambiente dieléctrico. A escala nanométrica la frontera metaldieléctrico produce cambios considerables en las propiedades ópticas.

Como resultado de la interacción entre la nanopartícula metálica y la señal óptica se obtiene la oscilación colectiva de electrones de superficie lo que genera bandas de resonancia conocidas como plasmones localizados o plasmones de superficie localizados. La longitud de onda o color a la que se obtiene dicha resonancia se le conoce como banda de absorción del plasmón que depende tanto del tamaño como de la forma de la nanopartícula y es lo que da lugar a la diferente coloración observada. Las nanoestructuras metálicas más conocidas son partículas esféricas, barras y películas con núcleo dieléctrico. Aunque más recientemente se han reportado otras estructuras como cubos, triángulos, estrellas y ovoides. En todos los casos, la banda de resonancia se recorre hacia el cercano infrarrojo en comparación con las nanopartículas esféricas cuya banda esta centrada en la región verde del espectro.

Los plasmones producen en la interfase un campo eléctrico intensificado que a su vez intensifica varios procesos ópticos lineales y no lineales. El campo eléctrico producido es utilizado como una interfase sensible a las interacciones ópticas y se convierte en una poderosa herramienta para el monitoreo óptico y para la formación de imágenes ópticas

localizadas. Una de las aplicaciones bien establecidas es la espectroscopia Raman de superficie mejorada (SERS por sus siglas en inglés). En este caso el espectro Raman de un componente cercano a la superficie metálica se ve fuertemente amplificado. Se ha demostrado que es posible amplificar el campo hasta 11 000 veces más cuando las partículas presentan cierta aglomeración. Otros fenómenos que presentan amplificación son la espectroscopia infrarroja de superficie mejorada, espectroscopia de fluorescencia

y la espectroscopia de resonancia de plasmones de superficie. Todas estas técnicas son complementarias y son utilizadas en la detección de componentes químicos y bioquímicos a nivel de trazas.

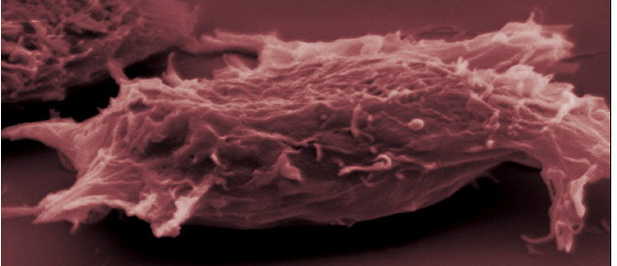

Célula cancerígena

Células modificadas y célula cancerigena que,la nanofotónica podrá modificar e incluso regenerar en el fiuturo

Quizás un proyecto más ambicioso es el de poder detectar células cancerigenas a temprana edad de lo cual ya se han reportado importantes avances. En el CIO trabajamos con nanopartículas de oro y plata a fin de desarrollar sensores ópticos para la detección de diferentes compuestos a nivel de trazas y estamos aplicado exitosamente nanopartículas deoro en la detección de células cancerigenas.

En resumen, las nanoestructuras presentan propiedades ópticas únicas que no presentan su contraparte en bulto o de escala mayor. Éstas están siendo utilizadas para el desarrollo de la nueva generación de dispositivos optoelectrónicos y/o fotónicos. Las aplicaciones son muy variadas y abarcan muchos campos haciendo de la nanociencia y nanotecnología una área

multidisciplinaria. Especial atención recibe el uso de dichas propiedades en aplicaciones biomédicas para la detección a nivel de trazas de diversos agentes patógenos. El estudio de las propiedades ópticas de las nanoestructuras ha definido una nueva área conocida como nanofotónica.

¡El futuro está aquí!

emilio silvera

May

14

¡Las cosas que no sabemos! ¡Son tantas!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Lo que no sabemos ~

Clasificado en Lo que no sabemos ~

Comments (0)

Comments (0)

¿Cuántas personalidades llevamos dentro de nosotros?Siempre hemos tratado de lograr mediante la psicología transpersonal ese enfoque que trata de que el ser humano alcance los niveles óptimos de bienestar en el estado de la conciencia, mucho más allá de los límites del yo personal y lograr conectarse con ese otro mundo “espiritual” y transcendente que busca la plenitud de la mente en ese “universo” que fuera del nuestro material, presentimos que puede existir.

Hay cosas que no podemos explicar y una de ellas es el “El Mundo” transpersonal de la Conciencia Humana en el que destaca algo de increíble aceptación como, por ejemplo, la capacidad de conexión de la mente humana. Siempre hemos tratado de despertar la conciencia hacia niveles más elevados que están más allá de lo cotidiano, de lo que podemos tocar y se sitúa en un “universo” en el que dejamos la física para entrar en ese otro campo metafísico que no hemos llegado a comprender.

Han existidos tribus nativas que parece que eran capaces de comunicarse sin necesidad verse ni oirse. Así lo demuestran las vestimentas, edificaciones y los distintos aparatos y herramientas que utilizaban distintas tribus separadas por miles de kilómetros y que, en su rudimentario mundo, no tenían la posiblidad de comunicarse y menos de verse, incluso algunas, pudieron vivir no ya en lugares distintos y alejados, sino que lo hicieron en distintos momento del tiempo. Y, sin embargo, según todos los indicios, tribus enteras pudieron compartir, de alguna manera, información.

En Laboratorios de nuestros días, se ha demostrado que existen personas que muestran una capacidad para la transferencia espontánea de imágenes e impresiones, y, en especial, cuando tienen una estrecha relación afectiva y emocional con la otra persona.

De manera inexplicable, algunas imágenes, ideas y símbolos universales arquetipos, aparecen y reaparecen en la cultura de todas las civilizaciones, tanto modernas como antigüas, sin que los componentes de esas civilizaciones hayan tenido contacto alguno.

No sabemos hasta donde puede llegar el poder de nuestras mentes que, de alguna manera, está conectada con el Universo del que formamos parte y, esos hilos invisibles que nos mantiene a todos unidos…algo tendrán que ver en todos estos fenómenos ciertos y comprobados.

Tenemos muchas más conexiones en el cerebro que la más potente computadora

Cada día la Humanidad logra dar un paso más hacia terrenos antes desconocidos y hacia descubrimientos que, hasta hace relativamente poco tiempo eran impensables que se pudieran alcanzar. Los descubrimientos actuales de los mayores logros alcanzados por la Conciencia humana nos vienen a recordar aquel pronunciamiento de Einstein:

“Un ser humano, es simplemente parte de un todo que llamamos Universo”.

Sí, por separado podemos ser una parte limitada en el espacio y en el Tiempo pero, unidos todos y enlazados como una cadena que recoge todas y cada una de las consciencias que aquí estuvieron presentes a lo largo de los milenios…, podría ser posible pensar en una cierta conexión real con el pasado y que de alguna manera, tuviéramos una conexión mental con aquellos ancestros que nos dejaron sus conocimientos y experiencias que, conservamos.

Estamos conectados con el pasado y con el universo y, presentimos el futuro

Sí, mucho hemos hablado aquí de la maravilla que el cerebro humano es, de la inmensa complejidad que está presente en en él, de lo mucho que sensorialmente podemos esperar de un objeto que tiene tantas neuronas como estrellas tiene nuestra Galaxia y, nos extraña y fascina que una estructura así, haya podido surgir a partir de la “materia inerte” que, posiblemente, no sea tan inerte como nuestra ignorancia nos lleva a pensar.

Sí, es cierto que hemos podido evolucionar hasta adquirir una cierta comprensión que, de ninguna manera, lo puede explicar todo. Sin embargo, si repasamos todos los enigmas (los innumerables enigmas) que en la Ciencia podemos encontrar, nos podamos percatar de que, en el fondo de los mismos subyacen las respuestas que buscamos y que, nuestras mentes, son las herramientas fundamentales para lograrlo.

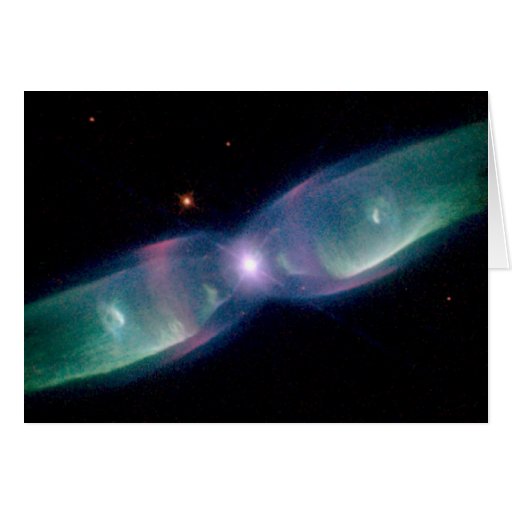

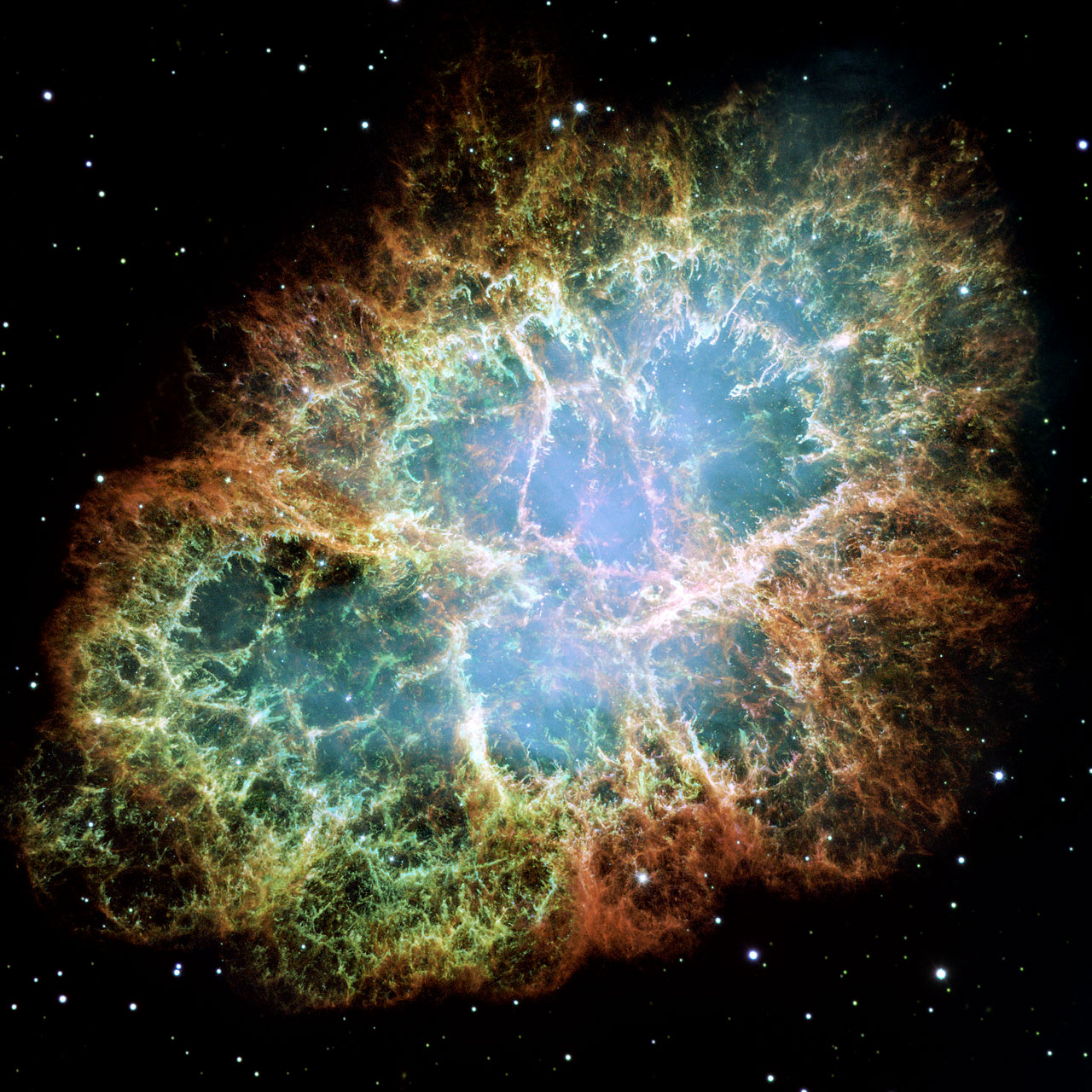

Poque, ¿Tiene memoria el Universo? El Universo tiene y conserva (como ocurre en la Tierra), las reliquias de su pasado. A lo largo y a la ancho del Cosmos podemos encontrar muestras de objetos que nos cuentan lo que antes pasó en el Universo. Una supernova es el momento de la explosión de una estrella masiva, debido a que la presión para mantener todos los átomos nucleares es insostenible. “La simetría es la armonía de posición de las partes o puntos similares unos respecto de otros, y con referencia a un punto, línea o plano determinado. Una estrella tiene forma esférica, por lo tanto se espera que si la explosión es en todas las direcciones, su remanente también presente la misma apariencia simétrica. Sin embargo los remanentes de las supernovas no son simétricos. Una posible causa de asimetría en remanentes de supernovas consiste en la variación de masas de los elementos de la estrella. Todo eso, lo podemos saber al leer en la memoria del Universo que nos dejó bien grabado (en este caso) en la Nebulosa del Cangrejo, lo que pasó.

Si observamos el Universo como un todo, podemos localizar que en él se manifiestan correlaciones bien afinadas que desafían todo lo que nos dicta nuestro sentido común. Unas de esas correlaciones pueden estar situadas en el nivel cuántico, donde, cada partícula que haya ocupado alguna vez el mismo nivel cuántico de otra partícula permanece relacionada con ella, de una misteriosa manera no energética.

Sabemos que, la teoría de la evolución post-darwiniana y la biología cuántica descubren enigmáticas correlaciones similares en el organismo y entre el organismo y su entorno. Todas las correlaciones que salen a la luz en las investigaciones más avanzadas sobre la conciencia vienen a resultar igual de extrañas: tienen la forma de conexiones temporales entre la conciencia de una persona y el cuerpo de otra.iaAl parecer, las redes de conexiones que constituyen un Cosmos Evolutivo Coherente, para el enmarañamiento cuántico, para la conexión instantánea entre organismos y entornos y entre las conciencias entre distintos e incluso distantes seres humanos, tienen una única explicación, que es la misma en todos los casos.

¿Será posible que, además de materia y energía, en el Universo pueda existir algún otro elemento muy sutil, aunque no por eso menos real: información en forma de “in-formación” activa y efectiva que puede conectar todas las cosas presentes en el espacio-tiempo, de manera tal que, exista una especie de memoria en el Universo que, cuando ahondamos en la observación y el estudio, allí se nos aparece y la podemos “ver” tan real como podemos ver los objetos que nos rodean.

Algunos dicen que; “Las interacciones en los dominios de la Naturaleza, así como en los de la Mente, están medidas por un campo fundamental de información en el corazón del Universo”. Así, todo el Universo es un contenedor de información dinámico que evoluciona y acumula más información a medida que el tiempo transcurre y su dinámica “viva” no deja de crear para que nada permaneza y todo se transforme.

Arriba contemp`lamos a la Nebulosa de Orión (cuyo material una vez, formó parte de una estrella masiva) y, se trata de una enorme nube de turbulencia del gas, con una formación de hidrógeno, que es iluminada por brillantes estrellas jóvenes y calientes, incluyendo una estrella llamada Trapezium, que están en vías de desarrollo dentro de la nebulosa. Esa es la dinámica a que antes me refería y que, en el Universo está presente de mil formas distintas.

Pero claro, el Universo es grande y complejo, muchas son las cosas que de él desconocemos, y, si nos preguntamos, por ejemplo, ¿qué es el vacío cuántico? podemos responder conforme a la información que actualmente tenemos pero, ¿es la respuesta la adecuada?

El concepto de espacio-tiempo como medio físico lleno de energía virtual fue emergiendo gradualmente a lo largo del siglo XX. Al comienzo del siglo se pensaba que el espacio estaba ocupado por un campo energético invisible que producía rozamiento cuando los cuerpos se movían a través de él y ralentizaba su movimiento. Todos conocemos eso como la Teoría del Éter Lumínico o Luminífero. Cuando ese rozamiento no se pudo detectar con el experimento de Michelson-Morley, el éter quedó rechazado de la imagen del mundo físico. Sin embargo, se cree que algo permea todo el espacio.

Es cierto que, nuestra inmensa intuición nos lleva a pensar que, en el Universo, existen muchas cosas que no comprendemos, otras muchas que ni sabemos que están ahí y, sin embargo, de alguna manera, las presentimos y, de vez en cuando, sí que podemos pensar en ellas, en cosas que aún no siendo conocidas, algo dentro de nosotros nos dice que están y las encontraremos, “ellas” están esperando que las descubramos.

El tic tac cósmico nos lleva hacia el futuro mientras nuestras mentes evolucionan

El tiempo pasa y los conocimientos avanzan, y, se llegará a demostrar que, el vacío cósmico estaba lejos de ser espacio vacío. En las Teorías de Gran Unificación (GUT) que fueron desarrolladas durante la segunda mitad de ese siglo XX, el concepto de vacío se transformó a partir del espacio vacío en el medio que transporta el campo de energías de punto cero que, son energías de campo que han demostrado estar presentes incluso cuando todas las formas clásicas de energía desaparecen: en el cero absoluto de temperatura. En las teorías unificadas subsiguientes, las raíces de todos los campos y las fuerzas quedan adscritas a ese mar de energía misterioso denominado “vacío unificado”.

Allá por los años sesenta, Paul Dirac demostró que las fluctuiaciones en los campos fermiónicos producían una polarización de vacío, mediante la cual, el vacío afectaba a la masa de las partículas, a su carga, al spin o al momento angular. Esta es una idea revolucionaria, ya que, en este concepto el vacío es más que el continuo tetradimensional de la Teoría de la Relatividad: no es sólo la geometría del espacio-tiempo, sino un campo físico real que produce efectos físicos reales.

La interpretación física del vacío en términos del campo de punto cero fue reforzada en los años 70 , cuando Paul Davis y William Unruth propusieron la hiótesis que diferenciaba entre el movimiento uniforme y el acelerado en los campos de energía de punto cero. El movimiento uniforme no perturbaría el ZPF, dejándolo isotrópico (igual en todas las direcciones), mientras que el movimiento acelerado produciría una radiación térmica que rompería la simetria en todas las direcciones del campo. Así quedó demostrado durante la década de los 90 mediante numerosas investigaciones que fueron mucho más allá de la “clásica” fuerza Casimir y del Desplazamiento de Lamb, que han sido investigados y reconocidos muy rigurosamente.

De las Placas Casimir ¿que podemos decir? es bien conocido por todos que dos placas de metal colocadas muy cerca, se excluyen algunas longitudes de onda de las energías del vacío. Este fenómeno, que parece cosa de magia, es conocido como la fuerza de Casimir. Ésta ha sido bien documentada por medio de experimentos. Su causa está en el corazón de la física cuántica: el espacio aparentemente vacío no lo está en realidad, sino que contiene partículas virtuales asociadas con las fluctuaciones de campos electromagnéticos. Estas partículas empujan las placas desde el exterior hacia el interior, y también desde el interior hacia el exterior. Sin embargo, sólo las partículas virtuales de las longitudes de onda más cortas pueden encajar en el espacio entre las placas, de manera que la presión hacia el exterior es ligeramente menor que la presión hacia el interior. El resultado es que las placas son forzadas a unirse.

También aparecen otros efectos, algunos científicos han postulado que la fuerza inercial, la fuerza gravitatoria e incluso la masa eran consecuencia de interacción de partículas cargadas con el ZPF. Es todo tan misterioso.

Debido a que el Universo es finito, en los puntos críticos dimensionales, las ondas se superponen y crean ondas estacionarias duraderas. Las ondas determinan interacciones físicas fijando el valor de la fuerza Gravitatoria, la Electromagnética, y las fuerzas nucleares Débil y Fuerte. Estas son las responsables de la distribución de la materia a través del Cosmos pero, a quién o a qué responsabilizamos de esa otra clase (hipotética) de materia que, al parecer está por ahí oculta. ¿Tendrá, finalmente el vacío algo que ver con ella?

Sí, en el Universo resulta que están presentes misterios que no podemos explicar. El Observatorio de rayos X Chandra, el tercero de los grandes observatorios de la NASA, ha descubierto un excepcional objeto según la página web de la propia NASA, y, de la misma manera, hay descubrimientos recientes que confirman la presencia de ondas de presión en el vacío. Utilizando el Observatorio de rayos X Chandra, los Astrónomos han encontrado una onda generada por el agujero negro supermasivo en Perseus, a 250 millones de años luz de la Tierra. Esta onda de presión se traduce en la onda musical Si menor. Se trata de una nota real, que ha estado viajando por el espacio durante los últimos 2.500 millones de años. Nuestro oído no puede percibirla, porque su frecuencia es 57 octavas más baja que el Do medio, más de un millón de veces más grande de lo que la audición del hombre puede percibir.

Sí, resulta ser todo muy misterioso y nosotros, que somos parte de este Universo, también lo somos.Si pensamos en todo lo que la mente humana ha logrado, en todo lo que ha elucubrado, en todo lo que ha llegado a conseguir en todos los campos del saber…

Por ejemplo, por salirnos de la Ciencia y arrimarnos al arte. las Siete notas musicales: Do, Re, Mi, Fa, Sol, La y Si. son los nombres de las notas musicales que se derivan del poema Ut queant laxis, del monje benedictino friulano Pablo el Diácono, específicamente de las sílabas iniciales del Himno a San Juan Bautista. Las frases de este himno, en latín, son así: Ut queant laxis/Resonare..

Hemos llegado a saber de lo grande y de lo muy pequeño, del Universo en fin y, estamos tratando de llegar a los dominios más profundos de la mente, ese lugar que viene a ser un extractado resumen de todo el trabajo que ha realizado el Universo hasta llegar a la cúspide de esa montaña que llamamos Cosmos y que, en realidad, tenía por destino construir la Consciencia de SER. Antes de que estuviera presente la consciencia… ¿Qué había? ¿Qué podía percibir lo que pasaba? ¿Cómo podría algo en el vasto universo “saber” de estrellas y mundos?

El Universo nos ha traído aquí para verse así mismo, eso es lo que dijo un sabio, y, lo cierto es que, no estaba demasiado desencaminado, toda vez que, los pensamientos, la imaginación, las ideas y todos los frutos de la mente que genera la conciencia, debe ser -no lo puedo concebir de otra manera-, el fin último del universo en su normal evolución que, partiendo de la más simple sustancia cósmica, ha llegado hasta la Conciencia y, tal maravilla… ¿No tendrá alguna razón que desconocemos?

emilio silvera

May

14

¿Sabremos algún día? ¿Seguirá avanzando la Física?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (10)

Comments (10)

El nombre de David Hilbert (1862–1942) ocupa un lugar muy especial en el imaginario colectivo de los matemáticos . Sin duda se trata del matemático más famoso del siglo XX, a lo que contribuyeron de manera muy especial su aportación a la configuración de los métodos axiomáticos actuales, sus profundos resultados en álgerbra, teoría de números, geometría y teoría de funciones [análisis complejo], los celebérrimos “problemas matemáticos” que dejó planteados en 1900, y las venturas y desventuras de sus intentos de resolver la cuestión de los fundamentos de la matemática.

Esas letras que se ven gravadas abajo, en la piedra, lo que dicen es su célebre: ” “wir müssen wissen, wir werden wissen” [debemos saber; llegaremos a saber].

Pero yo quería hablar de los físicos y del hecho cierto de que son conscientes de que, en el panorama de su disciplina, en el lejano horizonte, vislumbran oscuros nubarrones que empañan el paisaje, oscurecen el futuro y pertuban sus pensamientos al ver con diáfana claridad las dificultades que tendrán que solventar si quieren continuar en el camino del progreso desvelando los secretos de la naturaleza.

Ellos, los físicos, son muy conscientes de que toda la física moderna está apoyada sobre la base de dos imponentes columnas: La Relatividad General de Einstein, que proporciona un marco teórico para la comprensión del universo en la escala más alta: estrellas, galaxias, cúmulos de galaxias y más allá, hasta los confines del universo observable en su contínua expansión. La otra columna es la Mecánica Cuántica, que les ofrece el marco teórico para la comprensión del Universo en sus mínimas escalas: Átomos y moléculas comenzando por las partículas que todo lo conforman como los Quarks y los electrones.

El estudio de fenómenos a escala microscópica mediante las hipótesis de la cuantización de la energía y la dualidad onda-partícula fue desarrolado bajo el nombre de Mecánica cuántica por Erwin Schrödinger, Werner Heisenberg, Paul Dirac y el mismo Einstein entre otros muchos, a partir de la idea seminal de Max Planck con su cuanto de acción, h, allá por los alrededores de 1925-1926, Aunque el trabajo de Einstein, inspirado en el de Planck, sobre el Efecto fotoeléctrico fue antes (creo).

A partir de 1930 la mecánica cuántica se aplicó con mucho éxito a problemas relacionados con núcleos atómicos, moléculas y materia en estado sólido. La mecánica cuántica hizo posible comprender un extenso conjunto de datos, de otra manera enigmáticos. Sus predicciones han sido de una exactitud notable. Ejemplo de ésto último es la increíble precisión de diesciciete cifras significativas del momento magnético del electrón calculadas por la EDC (Electrodinámica Cuántica) comparadas con el experimento.

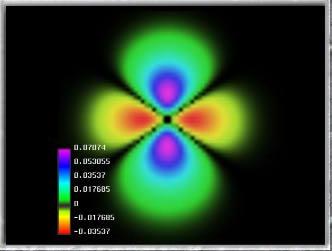

Imagen ilustrativa de la dualidad onda-partícula, en el que se aprecia cómo un mismo fenómeno puede ser percibido de dos modos distintos. La mecánica cuántica describe, en su visión más ortodoxa, cómo en cualquier sistema físico –y por tanto, en todo el universo- existe una diversa multiplicidad de estados, los cuales habiendo sido descritos mediante ecuaciones matemáticas por los físicos, son denominadoss estados cuánticos. De esta forma la mecánica cuántica puede explicar la existencia del átomo y desvelar los misterios de la estructura atómica, tal como hoy son entendidos; fenómenos que no puede explicar debidamente la física o más propiamente la mecánica clásica.

Pocas dudas nos pueden caber sobre el hecho cierto de que, la Mecánica cuántica ha sido uno de los más grandes avances de la Humanidad y, gracias a ella, hemos podido tener acceso a grandes logros e inventos que hoy hacen más cómoda nuestras vidas y también, en el campo de las nuevas tenologías este apartado de la física, ha tenido mucho que decir: Explica el comportamiento de lamateria y de la energía. Su aplicación ha hecho posible el descubrimiento y desarrollo de muchas tenologías, como por ejemplo, los transistores, componentes profusamente utilizados en casi todos los aparatos que tengan alguna parte funcional electrónica y muchos más cuya lista pormenorizada no cabría aquí en un simple comentario.

A lo largo de años de investigación, los físicos han confirmado experimentalmente, con una exactitud casi inimaginable, la práctica totalidad de las predicciones que hace cada una de estas dos teorías (la Relatividad General y la Mecánica Cuántica). Sin embargo, estos mismos instrumentos teóricos conducen a otra conclusión inquietante: tal como se formulan actualmente, la rrlatividad general y la mecánica cuántica no pueden ambas ser ciertas a la vez. Las dos teorías en las que se bazan los enormes avances realizados por la física durante los últimos cien años -unos avances que han explicado la expansión de los cielos y las estructuras fundamentales de la materia- son mutuamente incompatibles.

Creo que todos hemos pódp hablar, en alguna ocasión, de la incompatibilidad de estas dos teorías que, siendo ciertas por separado hasta lómites insospechados, cuando se juntan, aquello resulta un auténtico desastre. ¿Por qué será? Bueno, la respuesta podría estar en el hecho cierto de que, los físicos, estudian cosas muy pequeñas y ligeras (como los átomos y sus partes constituyentes), o cosas que son enormes y muy pesadas (como los mundos, las estrellas y las galaxias), pero no estudian mabas al mismo tiempo. Y, siendo así (que lo es), no necesitan utilizar las dos teorías al mismo tiempo, sino que, dependiendo del estudio a realizar de lo muy pequeño (la me´canica cuántica) y de lo muy grande (la relatividad general) y, de esta manera, ahogan el grito que mientras operan, les lanza la otra teoría, la que no están utilizando. Así, durante las últimas décadas, este planteamiento no ha sido tan feliz como la ignorancia, pero ha estado muy cerca de serlo. Lo único que ha enturbiado la paz, ha sido el hecho cierto de que, los físicos, han sido muy conscientes de que se necesita encontrar esa teoría de la Gravedad-Cuántica que, al parecer, sólo en el ámbito de la Teoría de Supercuerdas pueden encontrar.

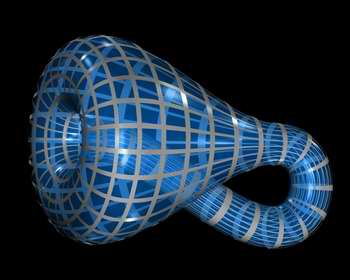

Cuerda cerrada en forma de botella de Klein

Algunos veces hemos podido llegar apensar que, el Universo, puede encontrar en casos extremos: Unas veces en las profundidades nucleares de un agujero negro donde se aplasta una inmensa cantidad de masa que se reduce hasta un minúsculo tamaño. Estos dos conceptos del tamaño diminuto y de la inmensa masa, nos requieren para poder explicarlos, a los dos teorías: La Mecánica cuántica y la Relatividad General y, sin embargo, cuando hemos tratado de unir las fórmulas de ambas teorías, los “tornillos” de sus estructuras saltan y aquello parece explotar, la incompatibilidad es manifiesta.

La Teoría de supercuerdas, una advenidiza que se mueve en las arenas movedizas de no poder ser verificada, en comparación con los dos venerables edificios de la M.C. y la R.G., que por el contrario no tienen nada que demostrar más allá de lo ya demostrado, y, sin embargo, la llegada de esta incipiente teoría (aunque lleve muchos años en el candelero), nos viene a decir lo que, las otras dos no han podido: Que en ella (en la Teoría de Cuerdas), no sólo se puede explicar la materia en su nivel más básico sino que, además, se resuelve la tensión existente entre las dos teorías incompatibles hasta el momento y, además, hace posible que la unión de ambas avance dando un paso de gigante. De hecho, la teoría de las supercuerdas muestra aún más: dentro de este nuevo marco, la relatividad general y la mecánica cuántica, se necesitan la una a la otra para que esta teoría tenga sentido y pueda explicar el universo en su conjunto. Según la teoría de supercuerdas, , el matrimonio entre las leyes de lo muy grande y lo muy pequeño no sólo es feliz, sino inevitable.

Por otra parte, la teoría bosónica no habla tampoco de los fermiones sino sólo a bosones como los fotones. Pero sabemos que los bosones son un caso particular de comportamiento, y que muchas otras partículas observan conductas muy distintas. ¿Qué haremos si no podemos explicar a los fermiones como los quarks, componentes fundamentales de la materia y la energía? Algunas nuevas teorías como la supersimetría intentan describir tanto a bosones como fermiones, y todas ellas juntas han llevado a los nuevos modelos que tenemos actualmente.

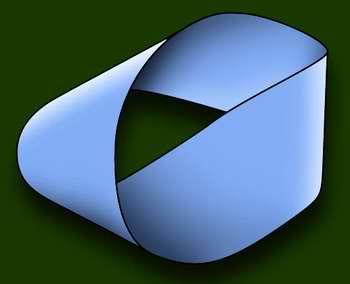

Una cinta de Moebius, posible en esta teoría

En nuestra mirada del siglo XXI, si las cuerdas determinan una realidad plana, es posible imaginar a las partículas y sus interacciones como “ondas” o “montículos” e incluso “ondas concéntricas” sobre ese plano. Las cuerdas pueden dividirse (como un hilo en forma de Y) o reunirse, entrecruzarse y fundirse, y todas estas conductas repercutirán en la topología del plano que determinan. Varias cuerdas de tipo cerrado pueden juntarse y converger en un solo tubo único, emitir ramales laterales e incluso cerrarse sobre sí mismas para configurar un mundo con la forma del cuerpo geométrico conocido como toro. O una cinta de Moebius. O una botella de Klein. O lo que se nos ocurra o nos guste imaginar. En este caso, podríamos imaginar a las partículas como ondulaciones que se desplazaran por los tubos. La adición de una partícula se vería como cuerdas que convergen, y la emisión como ramales divergentes.

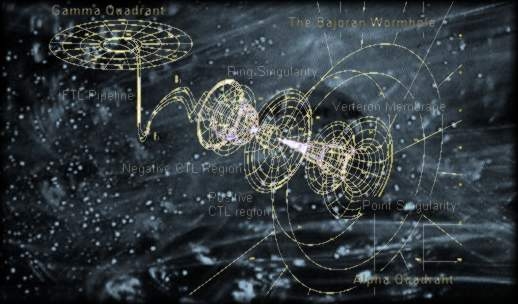

Cuerdas toroidales

La gravedad, por su parte (protagonista fundamental de las interacciones del universo) puede representarse fácilmente como tres tubos unidos en forma de H. El Sol atrae a la Tierra: los tubos verticales son las partículas del Sol y de nuestro planeta, y el trazo horizontal es el gravitón del Sol que viaja desde él hacia nosotros. Las formas determinadas por las cuerdas tienen una cantidad de dimensiones que varían de acuerdo con la teoría que se considere. Si la supersimetría es correcta, el universo tiene 10 u 11 dimensiones. Si la teoría bosónica es la que tiene razón, la realidad consta de nada menos que 26 dimensiones. El problema, como es fácil comprender, es que todo ello entra en conflicto directo con nuestro universo espaciotemporal de 4 dimensiones, que cualquiera puede observar, medir y confirmar.

Algunos científicos postulan hoy que la teoría de las cuerdas no merece ni siquiera que se le aplique el método científico, porque no es capaz de describir el universo ni siquiera a un grado básico. Otros creen que algún día demostraremos que existen gigantescas cuerdas uniendo inclusive las galaxias a nivel universal. Esta cuerdas irradiarían grandes ondas gravitatorias en todas direcciones y podrían explicar algunos fenómenos de gran escala que hoy en día no podemos explicar. La realidad es que hay que darle tiempo. No hemos tenido, hasta hoy, ocasión de chequear todas la complejas implicaciones de la teoría (LAS teorías) de cuerdan en cuanto a explicaciones completas, coherentes e inatacables de la realidad que observamos. Tal vez algún día, en un futuro no tan lejano, podamos probarlas o descartarlas definitivamente.

Claro que, aparte de que no tenemos la energía de Planck para poder llegar hasta ellas (1019 GeV), además, nos topamos con el hecho cierto de que nos encontramos anclados a las viejas teorías (R.G. y M.C.) y, si queremos avanzar, las características encontradas en las teorías de cuerdas, nos ecigen que cambiémos drácticamente nuestra manera de entender el espacio, el tiempo y la materia, y, esa ttarea amigos míos, no será nada fácil. No estamos (yo diría que estamos lejos) en ese nivel en el que mnos resultaría cómodo manejar esas nuevas teorías.

¿Pero las cuerdas? Las cuerdas no parecen ser una estructura preferida por la naturaleza en el diseño de los cielos. No vemos cuerdas en el espacio exterior. De hecho no las vemos por ninguna parte. ¡A que va a resultar que, la verdadera semilla de la materia y el componente esencial del Universo, va a resultar ser, finalmente, algo tan pequeño que reside fuera de nuestro alcance?

Un momento de reflexión, sin embargo, revelará que la naturaleza ha reservado un papel especial a las cuerdas, como un ladrillo básico para otras formas. Por ejemplo, la característica esencial de la vida en el planeta Tierra es la molécula de ADN similar a una cuerda, que contiene la información compleja y el código de la propia vida. Para construir la materia de la vida, tanto como la materia subatómica, las cuerdas parecen ser la respuesta perfecta. En ambos casos, queremos encerrar una gran cantidad de información en una estructura reproducible y relativamente simple. La característica distintiva de una cuerda es que es una de la forma más compacta de almacenar grandes cantidades de datos de un modo en que la información pueda ser replicada.

Para los seres vivos la naturaleza utiliza la doble cadena de la molécula de ADN, que se separa y forma copias duplicadas de cada una de ellas. Nuestros cuerpos también contienen millones de millones de cadenas de proteínas, formadas de ladrillos de aminoácidos. Nuestro cuerpo, en cierto sentido, puede ser considerado como una enorme colección de cuerdas: moléculas de proteínas que revisten nuestros huesos. Sin embargo, nadie puede dar una explicación de nuestro entendimiento, de la inteligencia que se crea y que llevamos con nosotros desde el mismo momento del nacimiento, está ahí presente, a la espera de que se la despierte, es la inteligencia dormida y evolucionada por el conocimiento de las cosas. La conciencia de SER a la que llamamos alma, y que de alguna manera es inmortal, ya que lo que sabemos lo cedemos y lo dejamos aquí para los que nos siguen en la tarea emprendida por la humanidad desde que, en el preciso momento en que surgió aquella primera célula original que fue capaz de dividirse para replicarse a sí misma, se dio el primer paso para el nacimiento de la vida en nuestro planeta. Pero esa es otra cuestión que será tratada en otro próximo trabajo, ahora volvamos al tema de la teoría de cuerdas de la física.

Se habla de cuerdas abiertas, cerradas o de lazos, de p branas donde p denota su dimensionalidad (así, 1 brana podría ser una cuerda y 2.Brana una membrana) o D-Branas (si son cuerdas abiertas) Y, se habla de objetos mayores y diversos que van incorporados en esa teoría de cuerdas de diversas familias o modelos que quieren sondear en las profundidades del Universo físico para saber, como es.

Claro que, a todo esto, no debemos perder de vista ni olvidar que, la teoría de cuerdas emerge como un producto impresionante, pero natural, a partir de los descubrimientos revolucionarios que ha realizado la física durante los últimos cien años. De hecho, veremos que el conflicto existente entre la reltiviad general y la mecánica cuántica no es precisamente el primero, sino el tercero de una serie de conflictos decisivos con los que se tuvieron que enfrentar los científicos durante el siglo pasado, y que han resuelto como consecuencia de una revisión radical de nuestro modo de comprender en universo.

Uno de aquellos conflictos eran las desconcertante propiedades del movimiento de la Luz. Dicho resumidamente, según las leyes del movimiento de Isaac Newton, si alguien corre a una velocidad suficientemente rápida podría emparejarse con un rayo de luz que se esté emitiendo, mientras que, según las leyes del electromagnetismo de james Clerl Maxwell, esto es imposible. Einstein resolvió el conflicto mediante su teoría de la relatividad especial y así dio un vuelco completo a nuestro modo de entender el espacio y el tiempo que ya no podían entenderse como conceptos universales grabados en piedra y percibidos por todos los individuos de forma idéntica.

El desarrollo de la relatividad especial creó inmediatamente el escenario para el segundo conflicto. Una de las conclusiones del trabajo de Eisntein es que ningún objeto -de hecho, ninguna influencia o perturbación de ninguna clase- puede viajar a una velocidad mayor que la de la luz. Sin embargo, como hemos podido leer muchas veces, la teoría universal de la gravedad de Newton, que experimentalmente funciona tan bien y es tan grata para la intuición, habla de influencias que se transmiten en el espacio a grandes distancias instantáneamente. De nuevo fue Eisntein el que intervino en el conflicto y lo resolvió ofreciendo un nuevo concepto de la Gravedad en su teoría general de la relatividad.

No es sólo que el Espacio y el Tiempo estén influidos por el esatado del movimiento del observador, sino que, además, pueden alabearse y curvarse en respuesta a la presencia de materia o energía. Tales distorsiones en la estructura del Espacio y el Tiempo, transmiten la fuerza de Gravedad de un lugar a otro que, más cercano o más lejano, recibe la influencia de esta fuerza fundamental. Así que, desde entonces, no se puede ya pensar que el Espacio y el Tiempo sean un telón de fondo inamovible e inerte en el que se desarrollan los sucesos del universo; al contrario, según la relatividad especial y la relatividad general, son actores de primera fila que desempeñan un papel óntimamente ligado al desarrollo de todos los hechos que en el universo ocurren.

Una vez más el modelo se repite: el descubrimiento de la relatividad general, aunque resuleve un cnflicto, nos lleva a otro. A lo largo de tres décadas a partir de 1900, los físicos desarrollaron la me´canica cuántica en respuesta a varios problemas evidentes que se pusieron de manifiesto cuando los conceptos de la física del siglo XIX se aplicaron al mundo microscópico. Como he mencionado anteriormente, el tercer conflicto, el más trascendental, surge de la incompatibilidad entrem la mecánica cuántica y la relatividad general. La forma geométrica ligeramente curvada del esapcio, que aparece a partir de la relatividad general, es incompatible con el comportamiento microscópico irritante y frenético del universo que se deduce de la mecánica cuántica.

Y, volvemos otra vez al principio: Tenemos que persistir en aquellos trabajos de los años ochenta, cuando se presentó la solución que ofrecía la teoría de cuerdas para este tercer conflicto o problema. En realidad, es el mayor conflicto que se nos presenta en la física moderna. Necesitamos ya, para poder explicar muchas cosas y seguir avanzando, una teoría cuántica de la gravedad. Estamos parados, no podemos avanzar como sería deseable y, desde luego muchas son las iniciativas que se intentan: Teoría de Cuerdas, Teoría Luz-luz, y otras muchas que están, en la mente de los mejores físicos del mundo perom que, no acaban de germinar.

Esperémos que, a no tardar mucho, alguna de esas teorías venga a decirnos algo más, del mundo que nos coge,

emilio silvera.

Totales: 80.135.933

Totales: 80.135.933 Conectados: 24

Conectados: 24