May

26

Energías de nuestro propio planeta

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ciencia futura ~

Clasificado en Ciencia futura ~

Comments (1)

Comments (1)

Estamos en una época en la que existe la convicción de que buena parte del desarrollo tecnológico del futuro dependerá de la capacidad que tengamos para fabricar dispositivos con un tamaño comprendido entre el de los átomos (< 1 mm) y el de los dispositivos actuales (≈ 100 nm). Con estas dimensiones, la materia presenta comportamientos peculiares, en muchos casos de origen cuántico, que no resultan de una simple extrapolación de sus propiedades macroscópicas (mecánicas, electrónicas, magnéticas, químicas u ópticas), y que por ello son, a menudo, sorprendentes. Estas dimensiones corresponden al territorio límite entre la química molecular y supramolecular, y la física del estado sólido. El estudio de la materia a escala nanométrica y su utilización para la fabricación de compuestos (componentes) y dispositivos con prestaciones avanzadas y novedosas reciben el nombre de, respectivamente, nanociencia y nanotecnología.

El IDM está trabajando en el desarrollo de “puertas nanoscópicas moleculares” mediante el anclaje de moléculas que actúan de “puerta” en las aperturas de los poros de sistemas mesoporosos y que permiten el control del acceso o salida de sustancias del interior de los poros a la disolución o viceversa.

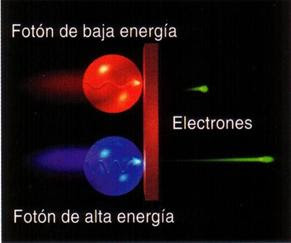

Curiosamente, existe una creencia bastante arraigada en amplios sectores de la comunidad científica de que la fotónica (conjunto de tecnologías relacionadas con la luz) es un campo que cae fuera del universo de la nanotecnología. La creencia se apoya en el clásico criterio de Rayleigh de que la resolución espacial de un sistema óptico está limitada por la longitud de onda de la luz (≈ 500 nm), y por ello es próxima al micrómetro, muy lejos de los requisitos de la nanotecnología. Por otra parte, cuidado con los aprovechados que tratan de utilizar estos medios en su parte pseudocientifica para captar dinero de los ignorantes.

La “Reflexología Celular por Estimulación Fotónica”, que se vende a 200€ la sesión, asegura un rápido exito en acabar con el tabaquismo, asegurando que aplica la física para conseguir desengancharse del tabaco. Sin embargo, analizando las bases de la supuesta revolución médica no encontramos más que pura charalatanería típica de cualquier remedio mágico.

May

26

Buscando la Materia Oscura en los Aceleradores

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en ¿La materia Oscura! ~

Clasificado en ¿La materia Oscura! ~

Comments (2)

Comments (2)

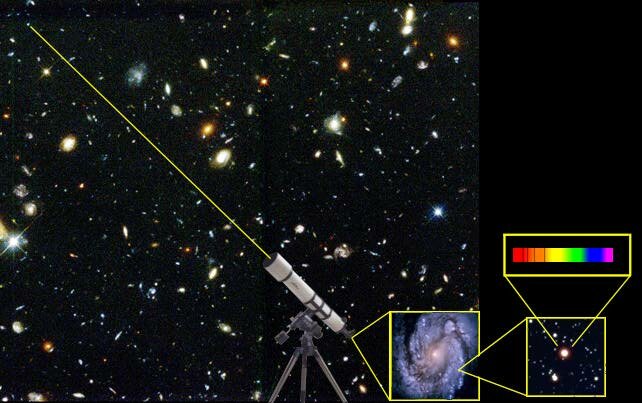

Las galaxias son los bloques básicos que forman el universo; son como los ladrillos que forman una casa. Y, al igual que los ladrillos están compuestos por partículas más pequeñas (granos de arena), las galaxias están formadas por estrellas. Nuestro Sol es una estrella más en nuestra galaxia, muy importante para nosotros porque está muy cerca y nos da luz y calor, pero nada más. Es una estrella como las demás de la Vía Láctea, que está formada por 200.000 millones de estrellas, el Sol entre ellas.

Las estrellas de una galaxia no están quietas; están en movimiento girando siempre alrededor del centro de la galaxia. Si estuvieran quietas, la atracción gravitatoria haría que inmediatamente cayeran hacia el centro de la galaxia: es lo mismo que les pasaría a la Tierra y a los demás planetas si dejaran de girar en torno al Sol, caerían hacia el Sol.

Lo que nos preguntamos en concreto es ¿cómo giran las estrellas de una galaxia? La respuesta es muy fácil: usando las leyes de Newton, exactamente igual que las usamos para estudiar el movimiento de los planetas alrededor del Sol, deducimos que deben girar en órbitas circulares o elípticas alrededor del centro de masas (el centro galáctico). Las estrellas más lejanas irán más despacio (tardarán mucho tiempo en dar una vuelta completa a la galaxia); las más cercanas, más rápido. El Sol, que es una estrella ni muy cercana al centro galáctico ni muy alejada (está, aproximadamente, a 2/3 de radio galáctico, hacia afuera) emplea unos 250 millones de años en completar una vuelta. Pero estos números no son lo importante ahora. Lo importante es que podemos calcular con mucha exactitud los movimientos de las estrellas en cualquier galaxia usando las leyes de Newton (en realidad ni siquiera son necesarias las correcciones relativistas de Einstein, ya que las velocidades estelares, pocos cientos de km/s, son mucho menores que la velocidad de la luz; Newton es, a todos los efectos, exacto aquí).

La rotación de las galaxias se observó por primera vez en 1914, y desde entonces se ha medido con gran precisión en muchas galaxias, no sólo en la Vía Láctea. La gran sorpresa surgió cuando, en 1975, se pudo medir la velocidad de giro de las estrellas que ocupan posiciones muy alejadas del centro: esas estrellas van muchísimo más rápido que lo que les correspondería por las leyes de Newton (es como si los planetas más alejados, por ejemplo Neptuno y Plutón, orbitaran mucho más deprisa de lo que calculamos con las leyes de Newton). El hecho es que esto ocurre no en una, sino en muchas galaxias donde hemos podido medir su rotación: las partes externas de las galaxias giran mucho más deprisa que lo que esperamos. ¿Por qué ocurre eso? No se sabe.

Tampoco sabemos si es la materia oscura la que nos trae hacia nosotros a nuestra vecina Andrómeda

Desde hace treinta años, los astrofísicos se enfrentan a este dilema: o bien las galaxias tienen mucha materia que no vemos, pero que causa una fuerte atracción gravitatoria sobre las estrellas externas (que por ello orbitarían tan rápido) o bien ni la ley de la gravedad de Newton ni la de Einstein serían válidas para esas regiones externas de las galaxias. Las dos opciones son revolucionarias para la física: la primera implica la existencia de materia oscura en el universo (materia que no vemos pero que sí afecta al movimiento de las estrellas y galaxias), y la segunda implica que una ley básica (la de Newton/Einstein de la gravitación) es incorrecta. En el momento actual, no sabemos cual de esas dos opciones es la buena (podrían incluso ser buenas las dos, es decir, que existiera materia oscura y además que la teoría de Newton/Einstein estuviera mal. No creom que sea ese el problema, debe haber una tercera opción desconocida que debemos encontrar). La gran mayoría de los astrofísicos prefieren explicarlo con la materia oscura (un camino cómodo y fácil) antes que dudar de las leyes de la gravitación de Newton/Einstein. Esto no es sólo cuestión de gustos, es que las leyes de la gravitación funcionan con una increíble exactitud en todos los demás casos donde las hemos puesto a prueba (en los laboratorios, en las naves espaciales y los vuelos interplanetarios, en la dinámica del Sistema Solar, etc.).

Este problema de la materia oscura (si es que realmente existe y no es que las leyes de Newton sean incompletas) es uno de los más importantes con los que se enfrenta la astrofísica hoy en día (texto de Cosmo-Educa).

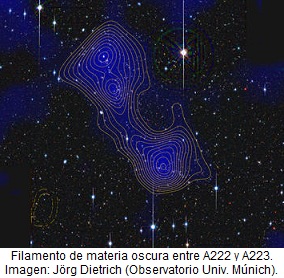

Últimamente están saliendo a la luz estudios diversos (algunos contradictorios) en relación a la (posible presencia) de materia oscura todeando las galaxias.

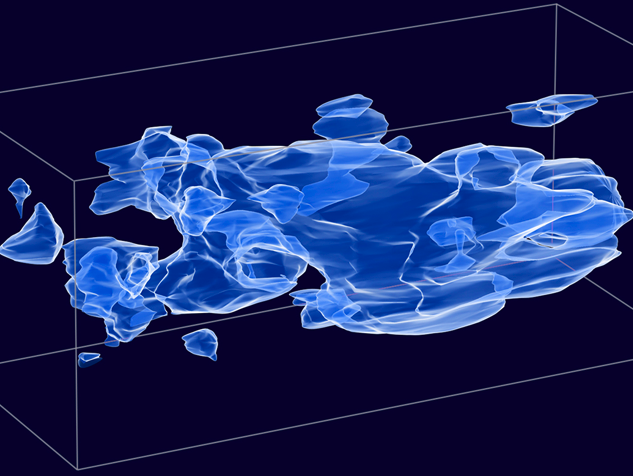

Usando una de las más poderosas supercomputadoras del mundo para simular el halo de materia oscura que envuelve a nuestra galaxia, unos investigadores han encontrado densos grumos y filamentos de la misteriosa materia oscura ocultándose en las regiones internas del halo, en el mismo vecindario que nuestro Sistema Solar.

“En simulaciones anteriores, esta región resultó lisa, pero ahora tenemos suficientes detalles para ver los grumos de materia oscura”. La permanete contradicción nos hace dudar de lo que realmente pueda haber alrededor de las galaxias y cúmulos de galaxias. Y, la materia oscura es la salida más cómoda para explicar lo que desconocemos.

Parece obvio que la cuestión de la naturaleza de la materia oscura no se puede dejar reposar hasta que alguien, algún proyecto, obtenga una respuesta que, de ser posible, venga acompañada de un buen “pedazo” de esa materia que, seguramente, encontraremos finalmente en el laboratorio.

Está muy bien generar nuevas teorías y mostrar que la materia oscura se debe comportar de este modo o de aquel otro, pero hasta que podamos aislar algo de esa materia y realmente verla comportándose como se supone que debe hacerlo, muchos no estaremos satisfechos.

Si estamos pendientes de las noticias especializadas, todos quieren su parte del pastel y dicen haber hallado, por fín, la dichosa materia oscura, unos en forma de filamentos y otros en un tenue material “invisible” que sólo se deja detectar por su incidencia en el movimiento de las estrellas, las galaxias y, en la expansión misma del Universo entero, ya que, estamos hablando de más del 90 por ciento (entre materia y energía oscura) de toda la materia que, supuestamente existe en nuestro universo.

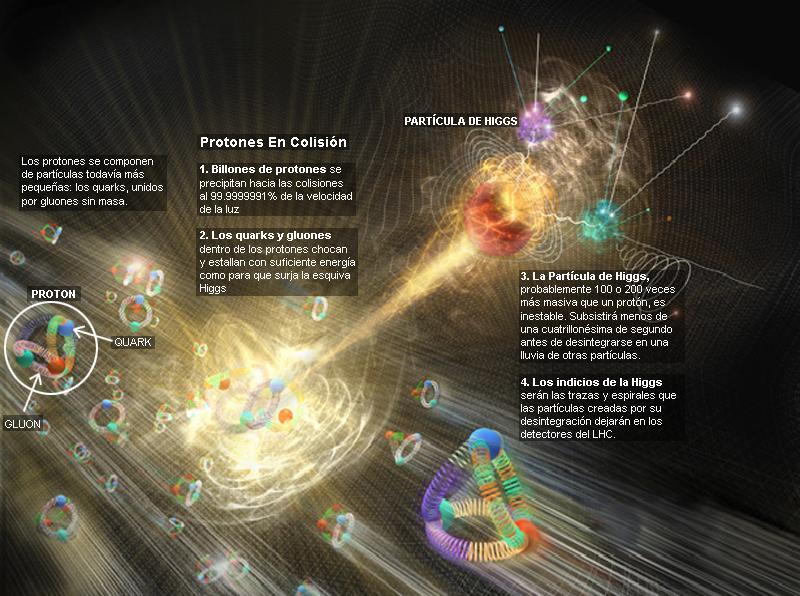

No sería de extrañar que, finalmente, sean los Aceleradores de Partículas los que harán el trabajo y localizaran esas partículas componentes de la supuesta materia oscura (o lo que pueda ser) que, de existir, tendrá que estar formada por objetos pequeños al igual que la materia conocida y, aunque éstos puedan tener otras propiedades extrañas para nosotros, en procesos de grandes energías se podrá llegar hasta ellos y quedar al descubierto para que los podamos ver.

Todos sabemos como funcionan estos inmensos aparatos. Son instrumentos que produce un haz de partículas -ya sean protones, electrones o cualquier otra- que viajan a velocidades cercanas a la de la luz. Dirigidas a un objetivo en alguna de las colisionesw resultantes, parte de la energía del haz será convertida (E =mc2) en la masa de nuevas partículas. No importa lo improbable que pueda ser que una partícula se produzca en tal reacción, si tenemos suficiente energía en el haz y esperamos pacientemente, más pronto o más tarde veremos lo que estamos esperando. La esperanza de los experimentadores actuales es que esto será verdad y se produzca la aparición de las partículas que copmponen la materia oscura, como aparecieron otras en el pasado.

El descomunal conglomerado técnico del LHC, cuanta con energías hasta hace bien poco impensables, es decir, podrá llegar hasta los 14 TeV, pero, ¿será suficiente esa energía para encontrar la materia oscura? Por otra parte, no será nada fácil el hallazgo por este método ya que, los candidatos más exóticos para la materia oscura de los que hemos hablado en estos días pasados, no se pueden producir aisladamente, sino que siempre deben ser creados por pares. Las teorías nos dicen, por ejemplo, que no podemos producir un único fotino aislado en ninguna reacción iniciada por el impacto de un electrón o un fotón sobre la materia ordinaria. Igualmente, no podremos producir un único selectrón, sino que debemos producir un par; un selectrín y un antiselectrón. En efecto, esto divide por la mitad la energía disponible para la conversión en masa en cualquier acelerador, pues la energía debe ser compatible para para ambos miembros del par.

Somos capaces de bautizar “al niño” antes de su nacimiento. Así de impulsivos solemos ser y dados a poner nombre a todo aunque ese todo no sea seguro de que, en realidad, pueda existir. Así nos sucede con la materia oscura a la que le hemos adjudicado ciertas anomalías observadas en el movimiento de las galaxias y las estrellas, los cúmulos y la expansión misma. Pero, ¿será debido a la existencia de esa otra clase de materia?

¡Cuánto nos hace trabajar la ignorancia!

Busca, busca que hallarás

Si no lo que pretendías, sí alguna respuesta

que, aunque negativa, te enseñará

En qué no debes hacer la apuesta.

emilio silvera

May

25

El fascinante “universo” cuántico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (2)

Comments (2)

Las leyes que gobiernan el mundo físico tienen dos características importantes: muchas leyes de la naturaleza permanecen inalterables, no se alteran cuando cambia la escala, pero hay otros fenómenos, tales como una vela encendida o las gotas de agua, que no cambian del mismo modo. La implicación final es que el mundo de los objetos muy pequeños será completamente diferente del mundo ordinario.

Ahora tendríamos que hablar algo de la mecánica cuántica y, en ese ámbito, las reglas de la mecánica cuántica funcionan tan bien que resultaría realmente difícil refutarlas. Acordaos de los trucos ingeniosos descubiertos por Werner Hesinberg, Paul Dirac, o, Schrödinger que vinieron a mejorar y completar las reglas generales. Sin embargo, algunos de aquellos pioneros (Einstein y el mismo Schrödinger), sin embargo, presentaron serias objeciones a dicha interpretación de la naturaleza de lo muy pequeño.

Esta cosita tan pequeñita, el electrón, es inversamente proporcional en importancia para que el mundo, la Naturaleza, y, nuestro Universo sea como es. Se ha conseguido fotografíar a un electrón. Poder filmar y fotografiar un electrón no es fácil por dos razones: primero, gira alrededor del núcleo atómico cada 0,000000000000000140 segundos , y, porque para fotografiar un electrón es necesario bombardearlo con partículas de luz (y cualquier que haya intentado sacarle una foto a un electrón sabe que hay que hacerlo sin flash). La imagen de la izquierda es el resultado.

El electrón fue descubierto en 1.897 por el físico británico Joseph John Thomson (1.856 – 1940). El problema de la estructura (si la hay) del electrón no está resuelto. Si el electrón se considera como una carga puntual, su autoenergía es infinita y surgen dificultades en la ecuación conocida como de Lorentz–Dirac.

Muchas veces hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; tiene una masa de solamente 1/1.836 de la del núcleo más ligero, el del hidrógeno que está formado por un solo protón. La importancia del electrón es vital en el universo.

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = hν, donde E es la energía del paquete, ν es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ν de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza, pero esto lo veremos más adelante.

Onda y partícula

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Cuando Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero para los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

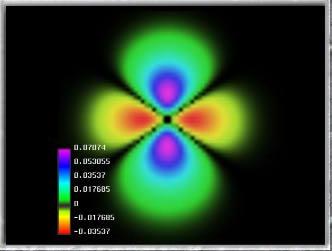

![]() La notable capacidad de un electrón de existir en dos lugares al mismo tiempo ha sido controlada en el material electrónico más comun el – silicio – por primera vez, siendo este un gran avance para la electrónica moderna y tiene un potencial enorme para el futuro y para la creación de la computadora cuantica.

La notable capacidad de un electrón de existir en dos lugares al mismo tiempo ha sido controlada en el material electrónico más comun el – silicio – por primera vez, siendo este un gran avance para la electrónica moderna y tiene un potencial enorme para el futuro y para la creación de la computadora cuantica.

Imagen: El movimiento de los electrones en el silicio. El electrón gira alrededor de una átomo de fósforo embebido en la estructura cristalina del silicio, que se muestra en plata. La distribución de densidad electrónica no perturbado, a partir de la ecuaciones de la mecánica cuántica del movimiento se muestra en amarillo. Un pulso de láser de electrones puede modificar el estado de manera que tiene la distribución de la densidad se muestra en verde. Nuestro pulso láser en primer lugar, que llegan desde la izquierda, pone el electrón en una superposición de ambos estados, que podemos controlar con un segundo impulso, también desde la izquierda, para dar un pulso que se detecte que, saliendo a la derecha. Las características de este “eco” del pulso nos hablan de la superposición que hemos hecho.

Cuando podamos dominar el “universo” de lo muy pequeño… ¡Nuestro Universo será otro para nosotros!

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento musical se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Sí, la música influye en el cerebro

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

Aunque la semilla la puso Planck en 1900, fue a partir de 1930 cuando la mecánica cuántica se aplicó con mucho éxito a problemas relacionados con núcleos atómicos, moléculas y materia en estado sólido. La mecánica cuántica hizo posible comprender un extenso conjunto de datos, de otra manera enigmáticos. Sus predicciones han sido de una exactitud notable. Ejemplo de ésto último es la increíble precisión de diesciciete cifras significativas del momento magnético del electrón calculadas por la EDC (Electrodinámica Cuántica) comparadas con el experimento.

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que ahora vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su nombre al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio nombre da a entender, no hay carga eléctrica; es neutro.

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

Sí, las reglas de la mecánica cuántica son extrañas y misteriosas, pero…

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a esta interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos ahora se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de forma estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (Ψ) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un momento dado.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.

Albert Einstein, Nathan Rosen y Boris Podolski idearon un “Gedankenexperiment”, un experimento hipotético, realizado sobre el papel, para el cual la mecánica cuántica predecía como resultado algo que es imposible de reproducir en ninguna teoría razonable de variables ocultas. Más tarde, el físico irlandés John Stewar Bell consiguió convertir este resultado en un teorema matemático; el teorema de imposibilidad.

emilio silvera

Fuente: En su mayor parte, Gerard ´t Hofft

May

25

Las fuerzas fundamentales

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (3)

Comments (3)

No es el poder de recordar, sino todo lo contrario,

el poder de olvidar, la condición necesaria para nuestra existencia.

SHOLEM ASH

En realidad debe ser así, ya que, en caso contrario…¿Quién podría soportar el dolor de los recuerdos?.

Durante mucho tiempo se creyó que los protones y neutrones que conforman el núcleo de los átomos eran partículas “elementales”, pero experimentos en los aceleradores de partículas en los que colisionaban protones con otros protones o con electrones a velocidades cercanas a la de la luz indicaron que, en realidad, estaban formados por partículas aun más pequeñas. Estas partículas fueron llamadas quarks por el físico de Caltech, el norteamericano, Murray Gell–Mann, que ganó el Nobel en 1.969 por su trabajo sobre dichas partículas y el modelo del óctuple camino.

La palabra quark se supone que debe pronunciarse como quart (“cuarto”), pero con una k al final en vez de una t, pero normalmente se pronuncia de manera que rima con lark (“juerga”).

May

24

Los secretos del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y los pensamientos ~

Clasificado en El Universo y los pensamientos ~

Comments (2)

Comments (2)

La cantidad total de Materia del Universo se da generalmente en términos de una cantidad llamada Densidad Crítica, denotada por el signo Ω. Esta es la densidad de la materia que se necesita para producir un universo plano. La Densidad efectivamente observada ¿es menor o mayor que ese número?. En el primer caso el Universo es abierto, en el segundo es cerrado. La Densidad Crítica no es muy grande; corresponde aproximadamente a un protón por metro cúbico de espacio. Puede que no parezca mucho, dado el número inmenso de átomos en un metro cúbido de lado, pero no debemos olvidar que existe una gran cantidad de espacio “vacío” entre las galaxias.

Algunos números que definen nuestro Universo:

- El número de fotones por protón

- La razón entre densidades de Materia Oscura y Luminosa.

- La Anisotropía de la Expansión.

- La falta de homogeneidad del Universo.

- La Constante Cosmológica.

- La desviación de la expansión respecto al valor crítico.

- Fluctuaciones de vacío y sus consecuencias.

- ¿Otras Dimensiones?

Estimar la cantidad de materia luminosa del universo es una cosa muy fácil de hacer. Sabemos el brillo que tiene una estrella media, así que podemos hacer una estimación del número de estrellas de una galaxia distante. Podemos contar entonces el número de galaxias en un volumen dado de espacio y sumar las masas que encontramos. Dividiendo la masa por el volumen del espacio obtenemos la densidad media de materia en ese volumen. Cuando llevamos a cabo esta operación, obtenemos que la densidad de la materia luminosa es aproximadamente entre el 1 o 2% de la densidad crítica; mucho menos de lo que se necesita para cerrar el universo.

Por otro lado, está lo bastante cerca del valor crítico para hacer una pausa. Después de todo, esta fracción podría haber sido en principio de una billonésima o trillonésima, y también podría haber sucedido que fuese un millón de veces la materia necesaria para el cierre. ¿Por qué, entre todas las masas que podría tener el universo, la masa de materia luminosa medida está cerca del valor crítico que nos dice que estamos en un Universo abierto?

No toda la materia del Universo son estrellas, Nebulosas, galaxias o, agujeros negros. También existe otra clase de materia que conforman las cosas que vemos a nuestro alrededor (ríos y océanos, bosques y montañas…, ¡infinidad de mundos!) y, en ocasiones, incluso podemos relacionarla con esa clase de materia evolucionado que alcanzó la consciencia. ¿Cómo fue posible tal maravilla? Y todo, sin excepción -al menos hasta donde podemos saber-, está hecho de Quarks y Leptones.

Claro que el hecho de que la materia luminosa medida esté tan cercana al valor crítico, puede simplemente deberse a un accidente cósmico; las cosas simplemente “resultan” de ese modo. Me costaría mucho aceptar una explicación y supongo que a otros también. Es tentador decir que el Universo tiene en realidad la masa crítica, pero que de algún modo no conseguimos verla toda.

Como resultado de esta suposición, los astrónomos comenzaron a hablar de la “masa perdida” con lo que aludían a la materia que habría llenado la diferencia entre densidades observadas y crítica. Tales teorías de “masa perdida”, “invisible” o, finalmente “oscura”, nunca me ha gustado, toda vez que, hablamos y hablamos de ella, damos por supuesta su existencia sin haberla visto ni saber, exactamente qué es, y, en ese plano, parece como si la Ciencia se pasara al ámbito Religioso de la Fé, de creer en lo que no podemos ver ni tocar, y, la Ciencia, amigos míos, es otra cosa.

Tendremos que imaginar satélites y sondas que, de alguna manera, puedan detectar grandes halos galácticos que encierren la tan buscada materia oscura y que, al parecer, hace que nuestro Universo sea como lo conocemos y, es la responsable del ritmo al que se alejan las galaxias, es decir, la expansión del Universo.

Esos halos, tendrían muchas veces la masa que podemos ver en la Materia luminosa, la Bariónica formada por Quarks y Leptones que conforman las estrellas, planetas, galaxias y nosotros mismos. La teoría de la materia oscura y su presencia en cúmulos y supercúmulos ha sido “descubierta” (o inventada para tapar nuestra ignorancia) en época relativamente cercana para que prevalezca entre los astrónomos la uninimidad respecto a su contribución a la masa total del universo. El debate continúa, está muy vivo y, es el tema tan candente e importante que, durará bastante tiempo mientras algún equipo de observadores no pueda, de una vez por todas, demostrar que, la “materia oscura” existe, que nos digan donde está, y, de qué está conformada y como actúa. Claro que, cuando se haga la suma de materia luminosa y oscura, la densidad de la masa total del universo no será todavía mayor del 30% del valor crítico. A todo esto, ocurren sucesos que no podemos explicar y, nos preguntamos si en ellos, está implicada la Materia oscura.

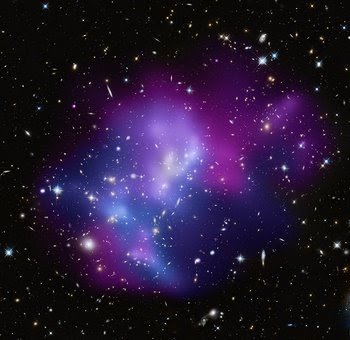

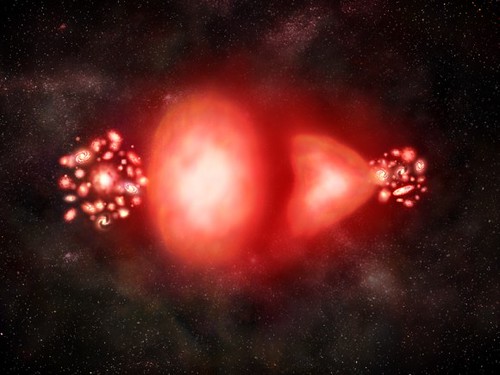

La más abarrotada colisión de cúmulos galácticos ha sido identificada al combinar información de tres diferentes telescopios. El resultado brinda a los científicos una posibilidad de aprender lo que ocurre cuando algunos de los más grandes objetos en el universo chocan en una batalla campal cósmica.

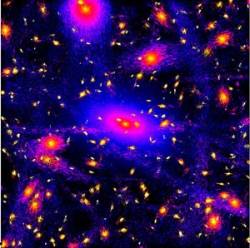

Usando datos del Observatorio de rayos-X Chandra, el Telescopio Espacial Hubble y el Observatorio Keck de Hawai, los astrónomos fueron capaces de determinar la geometría tridimensional y el movimiento en el sistema MACSJ0717.5+3745 localizado a 5.4 mil millones de años luz de la Tierra. Los investigadores encontraron que cuatro distintos cúmulos de galaxias están envueltos en una triple fusión, la primera vez que un fenómeno así es documentado.

La composición de imagen (arriba de todo) muestra el cúmulo de galaxias masivo MACSJ0717.5+3745. El color del gas caliente está codificado con colores para mostrar su temperatura. El gas más frío es mostrado como un púrpura rojizo, el gas más caliente en azul y las temperaturas intermedias en púrpura. Las repetidas colisiones en el cúmulo son causadas por una corriente de galaxias, polvo y “materia oscura” -conocida como filamento- de 13 millones de años luz.

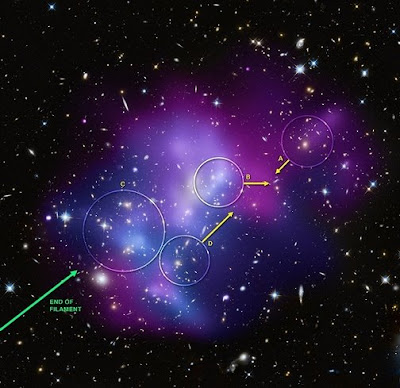

La versión etiquetada muestra las galaxias en los cuatro diferentes cúmulos, identificados por las letras A, B, C y D, envueltas en la colisión, además de la dirección del movimiento de los tres cúmulos de movimiento más rápido. La región más fría (más rojiza) de gas hacia la parte inferior izquierda del cúmulo identificado como D, ha sobrevivido probablemente de antes de la colisión. El cúmulo A parece estar cayendo hacia el cúmulo principal luego de haber pasado a través en la dirección opuesta. El cúmulo B tiene una velocidad mucho mayor que los otros a lo largo de la línea de visión.

MACSJ0717 muestra cómo cúmulos galácticos gigantes interactúan con su entorno en escalas de millones de años luz. Es un sistema hermoso para estudiar cómo los cúmulos crecen mientras el material cae en ellos a lo largo de filamentos. Simulaciones por ordenador muestran que los cúmulos de galaxias más masivos deben crecer en regiones donde filamentos de gran escala de gas intergaláctico, galaxias, y materia oscura intersectan.

¿Cuál debe ser la Masa del Universo?

Alan Guth

Esta claro que la idea de masa perdida se introdujo porque la densidad observada de la materia del universo está cerca del valor crítico. Sin embargo, hasta comienzos de los ochenta, no se tuvo una razón teórica firme para suponer que el universo tenía efectivamente la masa crítica. En 1981, Alan Guth, publicó la primera versión de una teoría que desde entonces se ha conocido como “universo inflacionista”. Desde entonces, la teoría ha sufrido numerosas modificaciones técnicas, pero los puntos centrales no han cambiado.

Para nuestra conversación de hoy, diremos que el aspecto principal del universo inflacionista es que estableció por primera vez una fuerte presunción de que la masa del universo tenía realmente el valor crítico. Esta predicción viene de las teorías que describen la congelación de la fuerza fuerte en el segundo 10-35 del Big Bang. Entre los otros muchos procesos en marcha en ese tiempo estaba una rápida expansión del universo, un proceso que vino a ser conocido como inflación. Es la presencia de la inflación la que nos lleva a la predicción de que el universo tiene que ser plano.

Abell 370 La lente gravitacional distorsiona la Imagen y nos enseña, a la derecha, algo que nos parece una inmensa cuerda cósmica pero, ¿que podrá ser en realidad? la materia a lo largo y ancho del universo se reparte de manera que, se ve concentrada en cúmulos de galaxias y supercúmulos que son las estructuras más grandes conocidas y, dentro de ellas, están todos los demás objetos que existen. Claro que, deajndo a un lado esas fluctuaciones de vacío y, la posible materia desconocida.

El proceso mediante el cual la fuerza fuerte se congela es un ejemplo de un cambio de fase, similar en muchos aspectos a la congelación del agua. Cuando el agua se convierte en hielo, se expande; una botella de leche explotará si la dejamos en el exterior en una noche de invierno de gélido frío. No debería ser demasiado sorprendente que el universo se expanda del mismo modo al cambiar de fase.

La distancia a una galaxia lejana se determina estudiando la luz proveniente de estrellas de tipo Cefeidas Variables. El expectro de la luz estelar revela la velocidad a la que se mueve la galaxia (Efecto Doppler) y la cantidad de expansión que ha sufrido el universo desde que la luz salió de su fuente.

Lo que es sorprendente es la enorme amplitud de la expansión. El tamaño del Universo aumentó en un factor no menor de 1050. Este número es tan inmenso que virtualmente no tiene significado para la mayoría de la gente, incluido yo mismo que, no pocas veces me cuesta asimilar esas distancias inconmensurables del Cosmos. Dicho de otra manera, pongamos, por ejmplo, que la altura de los lectores aumentara en un factor tan grande como ese, se extenderían de un extremo al otro del Universo y, seguramente, faltaría sitio. Incluso un sólo protón de un sólo átomo de su cuerpo, si sus dimensiones aumentaran en 1050, sería mayor que el mismo universo. En 10-35 segundos, el universo pasó de algo con un radio de curvatura mucho menor que la partícula elemental más pequeña a algo como el tamaño de una naranja grande. No es extraño que el nombre inflación esté ligado a este proceso.

Comparación entre un modelo de expansión desacelerada (arriba) y uno en expansión acelerada (abajo). La esfera de referencia es proporcional al factor de escala. El universo observable aumenta proporcionalmente al tiempo. En un universo acelerado el universo observable aumenta más rápidamente que el factor de escala con lo que cada vez podemos ver mayor parte del universo. En cambio, en un universo en expansión acelerada (abajo), la escala aumenta de manera exponencial mientras el universo observable aumenta de la misma manera que en el caso anterior. La cantidad de objetos que podemos ver disminuye con el tiempo y el observador termina por quedar aislado del resto del universo.

Cuando (hace mucho tiempo ya) leí por primera vez acerca del universo inflacionario, experimenté dificultades para poder asimilar el índice de inflación. ¿No violaría un crecimineto tan rápido las reglas impuestas por la relatividad de Eintien que marcaban el límite de la velocidad en el de la luz en el vacío? Si un cuerpo material viajó de un extremo de una naranja a otro en 10-35 segundos, su velocidad excedió a la de la luz en una fracci´çon considerable.

Claro que, con esto puede pasar como ha pasado hace unos días con los neutrinos que, algunos decían haber comprobado que corrían más rápidos que la luz, y, sin embargo, todo fue un error de cálculo en el que no se tuvieron en cuenta algunos parámetros presentes en las mediciones y los aparatos que hacían las mismas. Aquí, podría pasar algo parecido y, la respuesta la podemos encontrar en aquella analogía con la masa de pan. Durante el período de inflación es el espacio mismo -la masa de pan- lo que está expandiéndose. Ningún cuerpo material (acordaos que en aquella masa estaban incrustadas las uvas que hacían de galaxias y, a medida que la masa se inflaba, las uvas -galaxias- se alejaban las unas de las otras pero, en realidad, ninguna de estas uvas se mueven, es la masa lo que lo hace.

El Universo se expande

Las reglas contra los viajes a mayor velocidad que la de la luz sólo se aplican al movimiento del espacio. Así no hay contradicción, aunque a primera vista pueda parecer que sí. Las consecuencias del período de rápida expansión se pueden describir mejor con referencia a la visión einsteniana de la gravitación. Antes de que el universo tuviera 10-35 segundos de edad, es de suponer que había algún tipo de distribucón de la materia. A cauda de esa materia, el espacio-tiempo tendrá alguna forma característica. Supongamos que la superficie estaba arrugada antes de que se produjera la inflación. Y, de esa manera, cuando comenzó a estirarse, poco a poco, tomó la forma que ahora podemos detectar de “casi” plana conforme a la materia que contiene.

En todo esto, hay un enigma que persiste, nadie sabe contestar cómo, a pesar de la expansión de Hubble, se pudieron formar las galaxias. La pregunta sería: ¿Qué clase de materia estaba allí presente, para que, la materia bariónica no se expandiera sin rumbo fijo por todo el universo y, se quedara el tiempo suficiente para formar las galaxias? Todo ello, a pesar de la inflación de la que hablamos y que habrái impedido su formación. Así que, algo tenía que existir allí que generaba la gravedad necesaria para retener la materia bariónica hasta que esta, pudo formar estrellas y galaxias.

No me extrañaria que, eso que llaman materia oscura, pudiera ser como la primera fase de la materia “normal” que, estándo en una primera fase, no emite radiaciones ni se deja ver y, sin embargo, sí que genera la fuerza de Gravedad para hacer que nuestro Universo, sea tal como lo podemos observar.

Una hipótesis más arriesgada sostiene que la materia oscura está chocándo consigo misma de alguna forma no gravitacional que nunca se había visto antes..? (esto está sacado de Observatorio y, en el texto que se ha podido traducir podemos ver que, los astrónomos autores de dichas observaciones, tienen, al menos, unas grandes lagunas y, tratándo de taparlas hacen aseveraciones que nada tienen que ver con la realidad).

Lo cierto es que, en el Universo, son muchas las cosas que se expanden y, pienso yo…¿Por qué no tratamos todos de expandir nuestras mentes? De esa manera, posiblemente podríamos comprender éstas y otras muchas cuestiones que nos atormentan al no poder llegar a saber qué son y cuáles son sus significados y mensajes.

emilio silvera

Totales: 67.470.770

Totales: 67.470.770 Conectados: 37

Conectados: 37