May

4

¡La Física! Que no deja de sorprendernos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (2)

Comments (2)

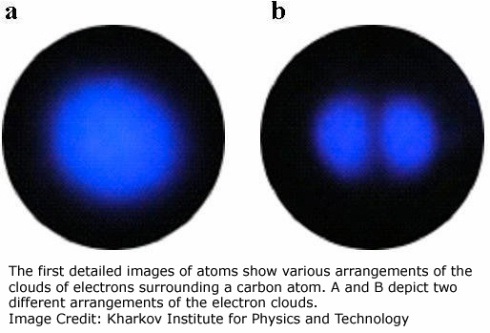

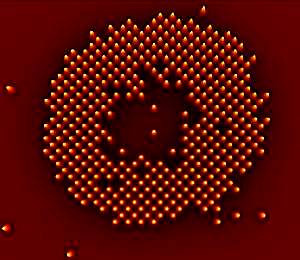

Las veloces computadoras cuánticas hechas con átomos atrapados por haces de luz pueden estar un poco más cerca, gracias a las primeras imágenes de átomos individuales obtenidas en una de estas grillas

La velocidad de las computadoras cuánticas tiene que ver con el hecho de que sus componentes pueden ocupar una serie de estados en lugar de sólo dos como ocurre en una computadora binaria. Ciertos algoritmos especiales podrían explotar estos estados cuánticos para resolver problemas que derrotarían a una computadora convencional.

Una candidata a computadora de este tipo es la llamada “rejilla óptica”, en la que haces de rayos láser estratégicamente ubicados hacen que los átomos ultrafríos se coloquen en forma de grilla, como si fueran huevos en su envase de cartón. Pero antes de que uno pudiera leer o escribir sobre estos átomos, algo indispensable si la rejilla fuera a actuar como una computadora cuántica, haría falta determinar las posiciones exactas de los mismos.

Ahora dos equipos de investigadores, uno conducido por Stefan Kuhr del Instituto Max Planck de Óptica Cuántica de Garching, Alemania, y el otro por Markus Greiner de la Universidad de Harvard, han dado el primer paso al obtener imágenes de átomos individuales de rubidio en una rejilla óptica. Este es un reto no sólo porque los átomos son pequeños, sino también porque los fotones de los átomos cercanos pueden interferir unos con otros, enturbiando cualquier patrón.

Para superar esto, los equipos estudiaron el patrón de luz de un solo átomo. Luego crearon un algoritmo capaz de generar una combinación de este patrón a partir de diferentes disposiciones de una grilla de átomos. Cotejando estas simulaciones con el modelo real observado, el algoritmo podía determinar cuál era la distribución de los átomos.

Cada átomo en la grilla actúa como un bit cuántico. Kuhr dice que la rejilla óptica tiene muchos más de estos “qubits” que otros sistemas enfocados en la computación cuántica, por lo que puede ofrecer mayor velocidad.

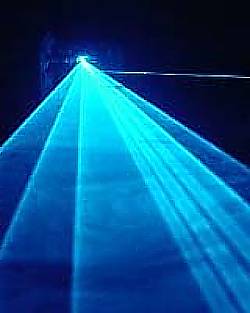

Los láseres pueden volver reales las partículas virtuales. Los láseres de última generación tienen el poder de crear materia por medio de la captura de partículas fantasmales que, de acuerdo a la mecánica cuántica, permean el espacio aparentemente vacío

Los láseres pueden volver reales las partículas virtuales. Los láseres de última generación tienen el poder de crear materia por medio de la captura de partículas fantasmales que, de acuerdo a la mecánica cuántica, permean el espacio aparentemente vacío

El principio de incertidumbre de la mecánica cuántica implica que el espacio nunca puede estar realmente vacío. En cambio, las fluctuaciones aleatorias causan el nacimiento de un caldero hirviente de partículas, como electrones y sus homólogos de antimateria, los positrones.

Las llamadas “partículas virtuales” normalmente se aniquilan entre sí demasiado rápido para que las veamos. Pero los físicos predijeron en los años 30 que un campo eléctrico muy fuerte transformaría las partículas virtuales en reales, y entonces las podríamos observar. El campo las impulsa en direcciones opuestas, porque tienen cargas eléctricas que se oponen, y las separándolos de modo que no puede destruirse mutuamente.

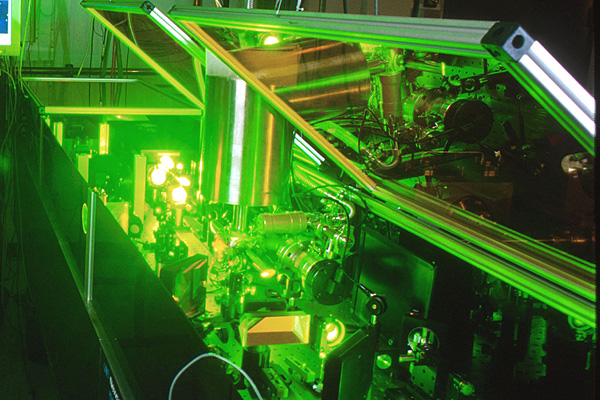

Los láseres son ideales para esta tarea, porque su luz posee campos eléctricos fuertes. En 1997, los físicos del Stanford Linear Accelerator Center (SLAC), en Menlo Park, California, utilizaron luz láser para crear unas pocas parejas de electrón-positrón. Ahora, nuevos cálculos indican que los láser de nueva generación serán capaces de crear pares por millones.

Reacción en cadena

En el experimento de SLAC, sólo se creó un par electrón-positrón a la vez. Pero con los láseres más potentes, es probable que se produzca una reacción en cadena.

El primer par es acelerado a gran velocidad por el láser, haciendo que emita luz. Esta luz, junto con la del láser, genera aún más pares, dice Alexander Fedotov de la Dirección Nacional de Investigaciones Nucleares de la Universidad de Moscú y sus colegas en un estudio que aparecerá en Physical Review Letters.

“Surgirá una gran cantidad de partículas del vacío”, dice John Kirk del Instituto Max Planck de Física Nuclear en Heidelberg, Alemania, que no participó en el estudio.

En los láseres que pueden concentrar cerca de 1026 vatios en un centímetro cuadrado, esta reacción desatada debería convertir de manera eficiente la luz del láser en millones de pares de electrones positrones, calcula el equipo.

Fábrica de antimateria

Ese nivel de intensidad lo podría alcanzar un láser que será construido por el proyecto Extreme Light Infrastructure en Europa. La primera versión del láser se podría construir en 2015, pero podría llevar un año más completar las actualizaciones necesarias para llegar a 1026 vatios por centímetro cuadrado, dice el coautor del estudio Georg Korn del Instituto Max Planck de Óptica Cuántica en Garching , Alemania.

La capacidad de generar una gran cantidad de positrones podría ser útil para los colisionadores de partículas, como el propuesto del Colisionador Lineal Internacional, que impactará electrones y positrones, dice Kirk McDonald de la Universidad de Princeton en Nueva Jersey.

Pero Pisin Chen, de la Universidad Nacional de Taiwan en Taipei, dice que el costo de los poderosos láseres puede hacer que este método sea más caro que el alternativo. En la actualidad, la manera estándar de crear una gran cantidad de positrones es disparar un haz de electrones de alta energía a una pieza de metal, para producir pares electrón-positrón.

La materia supera a la antimateria en un experimento que imita a la creación

El desequilibrio en el acelerador de partículas de Illinois podría presagiar grandes avances en Física

Menos de una billonésima de segundo después del Big Bang ocurrió otro evento tumultuoso. Aunque el Cosmos nació con partes iguales de materia y antimateria, que se destruyeron una a la otra al entrar en contacto, de alguna forma la materia comenzó a predominar.

Los físicos han descubierto una nueva pista sobre la causa de este desequilibrio fortuito, que condujo a la existencia de galaxias, planetas y personas.

Circunferencia de 4 kilómetros de diámetro del Acelerador de Partículas del Laboratorio Fermi de Chicago /Fuente: http://www.efenal.gov

El nuevo hallazgo se basa en ocho años de estudio de la desintegración de partículas de vida corta, llamadas mesones B, que se produce durante las colisiones de alta energía en el acelerador de partículas Tevatrón del Laboratorio Fermi (Fermilab), ubicado en Batavia, Illinois. Los científicos del experimento DZero del Tevatrón han descubierto que los mesones B, cuando se desintegran, producen cerca del 1 % más de pares de muones (una versión pesada del electrón) que de pares de sus antipartículas, los antimuones. Los físicos se refieren a este fenómeno como una violación CP.

El desequilibrio, reportado el 14 de mayo en un seminario del Fermilab y publicado en Internet el 18 de mayo, podría servir para entender cómo fue que la materia superó a la antimateria en el Universo. También aumenta las posibilidades de que el Gran Colisionador de Hadrones, el acelerador de Suiza que sustituyó al Tevatrón como el colisionador de partículas más poderoso del mundo, encuentre nuevas partículas elementales o una nueva física.

“Aunque pequeño, este excedente del 1 % es 50 veces más grande que la asimetría entre materia y antimateria prevista para la desintegración de mesones B por el modelo estándar de la Física de Partículas”, señala el portavoz del DZero, Stefan Söldner-Rembold, de la Universidad de Manchester en Inglaterra.

“Se nos puso la piel de gallina”, cuenta Söldner-Rembold acerca del momento en el que él y los 500 colaboradores del DZero comprendieron lo que habían descubierto. “Estábamos muy contentos porque significa que hay una nueva Física más allá del modelo estándar que tiene que estar a nuestro alcance para que la asimetría sea tan grande”.

“Aunque hay una probabilidad de menos del 0,1 % de que los resultados del DZero sean una casualidad, de acuerdo con las normas de la Física de Partículas hay que considerarlos como indicios aún por confirmar”, advierte el teórico Yuval Grossman de la Universidad de Cornell. Söldner-Rembold señala que los hallazgos del DZero son similares a una asimetría en la producción de materia-antimateria descubierta hace un año por otro experimento llevado a cabo en el Tevatrón, el CDF, pero los nuevos resultados tienen una precisión mayor.

“Las teorías que podrían explicar las observaciones del DZero incluyen la supersimetría, que supone que cada partícula elemental en el modelo estándar de la Física de Partículas tiene una superpareja más pesada todavía por descubrir”, explica la teórica del Fermilab Marcela Carena, que no pertenece al equipo descubridor. “Otras teorías posibles incluyen un modelo en el que la gravedad y otras fuerzas operan en otras dimensiones ocultas, y la noción de que hay una cuarta familia de quarks más allá de las tres generaciones (arriba y abajo, encanto y extraño, y cima y fondo) que sirven como bloques de construcción de los núcleos atómicos y otras partículas.

“En los modelos que consideran una cuarta familia de quarks, la presencia de quarks nuevos y pesados y su interacción con las tres familias conocidas podrían dar lugar a un desequilibrio mayor entre materia y antimateria que el que se encuentra en el modelo estándar”, señala Carena. Y agrega: “En la teoría de la supersimetría, las superparejas pesadas jugarían un rol similar al de los quarks pesados, creando interacciones que podrían favorecer la producción de materia sobre la antimateria”.

No siempre la física lo puede explicar todo. Sin embargo… ¡Lo va consiguiendo!

En la teoría de las dimensiones extra, nuevas partículas mensajeras (portadoras de fuerzas previamente desconocidas) se moverían en dimensiones ocultas. Estas partículas transportadoras podrían alterar la carga y otra propiedad, llamada “sabor”, de las partículas elementales, causando el desequilibrio adicional entre materia y antimateria.

Carena añade: “Sin embargo, es difícil encontrar una teoría que pueda explicar esta asimetría sin contradecir otros resultados experimentales”.

Ulrich Nierste, de la Universidad de Karlsruhe en Alemania, advierte: “La conexión del resultado del DZero con el excedente de materia que existe en el Universo es vaga. Si bien el hallazgo insinúa una nueva fuente de asimetría en las propiedades del mesón B y de su antipartícula, el proceso que creó más partículas que antipartículas en el Universo primitivo podría involucrar un mecanismo físico muy diferente”.

“Sin embargo”, dice Carena, “hace falta alguna nueva fuente de asimetría para explicar el desequilibrio que hay entre la materia y la antimateria en el Universo, y, por lo tanto, nuestra existencia”. En cualquiera de los modelos propuestos “el Gran Colisionador de Hadrones debería ser la ventana directa para observar nuevas partículas”.

Uno de los experimentos más pequeños del Colisionador, diseñado para estudiar los mesones B, podría confirmar los hallazgos del DZero dentro de uno o dos años”, dice Yuval Grossman. Y agrega: “Los experimentos más grandes podrían entonces buscar nuevas partículas que serían el origen del desequilibrio cósmico entre materia y antimateria y determinar sus masas”.

El experimento Beauty (Belleza) es la matriz de investigación para la creación de antimateria. El choque de dos protones contra otro a la velocidad de la luz, ha tenido como resultado una partícula con 5 veces más masa que sus protones originales. A esa exótica partícula se le ha llamado B+ y está compuesta por un quark b-anti y un quark u. La partícula B+ se desintegra a una altísima velocidad pero le da tiempo a recorrer ¡¡2 mm!! antes de desintegrarse en dos partículas, el mesón J / ? y el Kaon K+. Esta distancia, comparada con los minúsculos tamaños que estamos tratando, es una auténtica pasada. Hemos tenido antimateria pura moviéndose a lo largo de dos extensos milímetros de “nuestro” espacio. Impresionante.

Lo revolucionario sin embargo es que de esta forma, los investigadores habrían demostrado la teoría de Albert Einstein. “Sí, podemos crear masa a partir de energía usando la famosa fórmula de Einstein, E=mc2, dicen los responsables del CERN. Aunque también hay que destacar que la confirmación de que existe la antimateria plantea muchas preguntas de difícil resolución puesto que esa sustancia no existe en nuestro universo. “Ya que la desaparición de antimateria primordial no puede ser explicada por el modelo tradicional, tendremos que comenzar a pensar en algo nuevo”, afirman los investigadores. “Los científicos están evaluando diferentes posibilidades pero, dado que sólo podemos observar un 4% de la energía y materia total del universo, podemos inferir que la respuesta al misterio de la antimateria se encuentra en la parte desconocida del mismo”, concluyen.

Como podéis ver, las preguntas son muchas y, las respuestas, son más escasas. Sin embargo, no dejamos de insistir y buscar con todos medios a nuestro alcance para saber sobre la Naturaleza no ya de la materia y la antimateria, sino sobre los muchos enigmas que tenemos planteados y a los que no sabemos dar una adecuada explicación. Parece que a lo lejos vemos una luz cegadora que nos inyecta la esperanza necesaria para seguir la búsqueda y tratar de llegar al corazón de todos esos secretos que el Universo esconde.

Hay cosas que… más que sorprendentes son… ¡Inclreibles! He leído por ahí que…

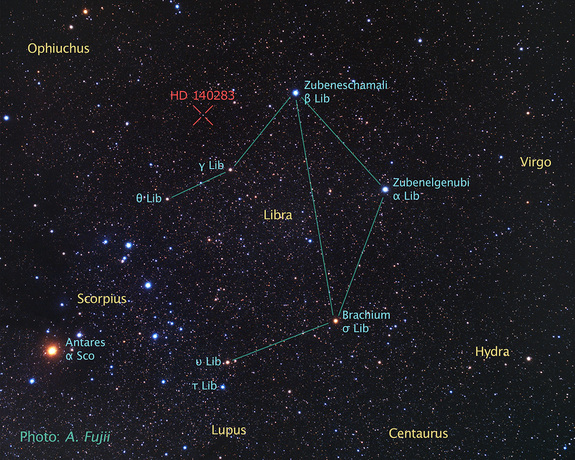

“Un grupo de astrónomos, usando datos del telescopio espacial Hubble, ha determinado la edad de la que es la estrella más vieja cuya edad puede medirse con precisión. El resultado ha sido que la edad de la estrella es de 14.500 ± 800 millones de años, mayor que la estimación de la edad del universo, unos 13.800 millones de años. La estrella en cuestión (HD 140283), también llamada “estrella Matusalén,” una gigante roja que se encuentra a una distancia de 190,1 años luz en la constelación de Libra (distancia medida con precisión mediante la técnica de paralaje). En el año 2000 se dató su edad en 16.000 millones de años. Sin embargo, existen algunas cuestiones que podrían aclarar la extrema edad de esta estrella. Nuevos modelos sobre la difusión de helio en el núcleo indican que la penetración del mismo podría ser mayor de la que se piensa, lo que provocaría un menor ritmo de combustión. También la relación oxígeno-hierro en esta estrella es anómala, demasiado grande, por lo que se cree que futuras observaciones que puedan determinar con mayor grado de precisión la abundancia de oxígeno podrían reducir nuevamente la estimación de la edad de la estrella.”

May

4

¡Los materiales para la vida!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo ~

Clasificado en El Universo ~

Comments (0)

Comments (0)

¡La Física! Cuando se asocia a otras disciplinas ha dado siempre un resultado espectacular y, en el caso de la Astronomía, cuando se juntó con la Física, surgió esa otra disciplina que llamamos Astrofísica. La Astrofísica es esa nueva rama de la Astronomía que estudia los procesos físicos y químicos en los que intervienen los fenómenos astronómicos. La Astrofísica se ocupa de la estructura y evolución estelar (incluyendo la generación y transporte de energía en las estrellas), las propiedades del medio interestelar y sus interacciones en sus sistemas estelares y la estructura y dinámica de los sistemas de estrellas (como cúmulos y galaxias) y sistemas de galaxias. Se sigue con la Cosmología que estudia la naturaleza, el origen y la evolución del universo. Existen varias teorías sobre el origen y evolución del universo (big bang, teoría del estado estacionario, etc.

Las estrellas, como todo en el Universo, no son inmutables y, con el paso del Tiempo, cambian para convertirse en objetos diferenters de los que, en un principio eran. Por el largo trayecto de sus vidas, transforman los materiales simples en materiales complejos sobre los que se producen procesos biológico-químicos que, en algunos casos, pueden llegar hasta la vida.

May

3

Los límites de las teorías actuales

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (2)

Comments (2)

¿Cuáles son los límites de la teoría cuántica de Planck y de la teoría de la relatividad general de Einstein? Afortunadamente, hay una respuesta simple y las unidades de Planck nos dicen cuales son esos limites, o, dicho de otra manera, el nivel de sabiduría al que hemos podido llegar y que, de momento, no sabemos como superar. Llevamos cerca de un siglo atados a teorías que deben ser ampliadas y que podamos llegar más lejos en el conocimiento de la Naturaleza.

¿Será así la espuma cuántica?

Aunque una suposición matemática esencial grabada en las ecuaciones de campo de la Relatividad General es que el espacio y el tiempo pueden ser subdivididos hasta el infinito, la naturaleza cuántica de la materia nos impone otra realidad de la cual posiblemente ya desde 1899 se había percatado el científico alemán Max Planck cuando introdujo su propuesta para el uso de un nuevo sistema de unidades conocidas como unidades naturales, unidades de medición diseñadas de modo tal que ciertas constantes físicas fundamentales sean utilizadas como unidades fundamentales en lugar de las unidades convencionales para longitud, masa y tiempo creadas arbitrariamente por el hombre.

May

3

Hay que recorrer un largo camino para saber

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Transiciónes de fase en las estrellas ~

Clasificado en Transiciónes de fase en las estrellas ~

Comments (1)

Comments (1)

Verdaderamente si pudiéramos contemplar de cerca, el comportamiento de una estrella cuando llega el final de su vida, veríamos como es, especialmente intrigante las transiciones de fase de una estrella en implosión observada desde un sistema de referencia externo estático, es decir, vista por observadores exteriores a la estrella que permanecen siempre en la misma circunferencia fija en lugar de moverse hacia adentro con la materia de la estrella en implosión. La estrella, vista desde un sistema externo estático, empieza su implosión en la forma en que uno esperaría. Al igual que una pesada piedra arrojada desde las alturas, la superficie de la estrella cae hacia abajo (se contrae hacia adentro), lentamente al principio y luego cada vez más rápidamente. Si las leyes de gravedad de Newton hubieran sido correctas, esta aceleración de la implosión continuaría inexorablemente hasta que la estrella, libre de cualquier presión interna, fuera aplastada en un punto de alta velocidad. Pero no era así según las fórmulas relativistas que aplicaron Oppenheimer y Snyder. En lugar de ello, a medida que la estrella se acerca a su circunferencia crítica su contracción se frena hasta hacerse a paso lento. Cuanto más pequeña se hace la estrella, más lentamente implosiona, hasta que se congela exactamente en la circunferencia crítica y, dependiendo de su masa, explosiona como supernova para formar una inmensa nebulosa o, se tranforma en nebulosa planetaria, más pequeña.

Los fenómenos que se pueden observar cuando las estrellas mueren son fascinantes

En la escena que antes explicabámos, por mucho tiempo que nos quedemos esperando y comtemplando el suceso, si uno está en reposo fuera de la estrella (es decir, en reposo en el sistema de referencia externo estático), uno nunca podrá ver que la estrella implosiona a través de la circunferencia crítica. Ese fue el mensaje inequívoco que Oppenheimer y Snyder nos enviaron. Para poder ver eso, habría que estar dentro de la estrella, instalado en la materia que está sufriendo la contracción y, no sabemos porque eso es así.

¿Se debe esta congelación de la implosión a alguna fuerza inesperada de la relatividad general en el interior de la estrella? No, en absoluto, advirtieron Oppenheimer y Snyder. Más bien se debe a la dilatación gravitatoria del tiempo (el frenado del flujo del tiempo) cerca de la circunferencia crítica. Tal como lo ven los observadores estáticos, el tiempo en la superficie de la estrella en implosión debe fluir cada vez más lentamente cuando la estrella se aproxima a la circunferencia crítica; y, consiguientemente, cualquier cosa que ocurre sobre o en el interior de la estrella, incluyendo su implosión, debe aparecer como si el movimiento se frenara poco a poco hasta congelarse.

Por extraño que esto pueda parecer, aún había otra predicción más extrañas de las fórmulas de Oppenheimer y Snyder: si bien es cierto que vista por observadores externos estáticos la implosión se congela en la circunferencia crítica, no se congela en absoluto vista por los observadores que se mueven hacia adentro con la superficie de la estrella. Si la estrella tiene una masa de algunas masas solares y empieza con un tamaño aproximado al del Sol, entonces vista desde su propia superficie implosiona hacia la circunferencia crítica en aproximadamente una hora, y luego sigue implosionando más allá de la criticalidad hacia circunferencias más pequeñas.

Allá por el año 1939, cuando Oppenheimer y Snyder descubrieron estas cosas, los físicos ya se habían acostumbrados al hecho de que el tiempo es relativo; el flujo del tiempo es diferente medido en diferentes sistemas de referencia que se mueven de diferentes formas a través del Universo. Claro que, nunca antes había encontrado nadie una diferencia tan extrema entre sistemas de referencia. Que la implosión se congele para siempre medida en el sistema externo estático, pero continúe avanzando rápidamente superando al punto de congelación medida en el sistema desde la superficie de la estrella era extraordinariamente difícil de comprender. Nadie que estudiara las matemáticas de Oppenheimer y Snyder se sentía cómodo con semejante distorsión extrema del tiempo. Pero ahí estaba, en sus fórmulas. Algunos podían agitar sus brazos con explicaciones heurísticas, pero ninguna explicación parecía muy satisfactoria. No sería completamente entendido hasta finales de los cincuenta.

Fue Wheeler el que discrepó del trabajo de Oppenheimer y Snyder, alegando, con toda la razón que, cuando ellos habían realizado su trabajo, habría sido imposible calcular los detalles de la implosión con una presión realista (presión térmica, presión de degeneración y presión producida por la fuerza nuclear), y con reacciones nucleares, ondas de choque, calor, radiación y expulsión de masa. Sin embargo, los trabajos desde las armas nucleares de los veinte años posteriores proporcionaron justamente las herramientas necesarias.

Presión, reacciones nucleares, ondas de choque, calor radiación y expulsión de masa eran todas ellas características fundamentales de una bomba de hidrógeno; sin ellas, una bomba no explosionaría. A finales de los años cincuenta, Stirling Colgate quedó fascinado por el problema de la implosión estelar. Con el apoyo de Edward Teller, y en colaboración con Richard White y posteriormente Michael May, Colgate se propuso simular semejante implosión en un ordenador. Sin embargo, cometieron un error, mantuvieron algunas de las simplificaciones de Oppenheimer al insistir desde el principio en que la estrella fuera esférica y sin rotación, y, aunque tuvieron en cuenta todos los argumentos que preocupaban a Wheeler, aquello no quedó perfeccionado hasta después de varios años de esfuerzo y, a comienzo de los años sesenta ya estaban funcionando correctamente.

Un día a principio de los años sesenta, John Wheeler entró corriendo en la clase de relatividad de la Universidad de Princeton. Llegaba un poco tarde, pero sonreía con placer. Acababa de regresar de una visita a Livermore donde había visto los resultados de las simulaciones recientes de Colgate y su equipo. Con excitación en su voz dibujó en la pizarra un diagrama tras otro explicando lo que sus amigos de Livermore habían aprendido.

Cuando la estrella en implosión tenía una masa pequeña, desencadenaba una implosión de supernova y formaba una estrella de neutrones precisamente en la forma que Fritz Wicky había especulado treinta años antes. Sin embargo, si la estrella original era más masiva lo que allí se producía (aparte de la explosión supernova) era un agujero negro notablemente similar al altamente simplificado modelo que veinticinco años calcularon Oppenheimer y Snyder. Vista desde fuera, la implosión se frenaba y se quedaba congelada en la circunferencia crítica, pero vista por alguien en la superficie de la estrella, la implosión no se congelaba en absoluto. La superficie de la estrella se contraía a través de la circunferencia crítica y seguía hacia adentro sin vacilación.

Lo cierto fue que allí, por primera vez, se consiguió simular por ordenador la implosión que debía producir agujeros negros. Está claro que la historia de todo esto es mucho más larga y contiene muchos más detalles que me he saltado para no hacer largo el trabajo que, en realidad, sólo persigue explicar a ustedes de la manera más simple posible, el trabajo que cuesta obtener los conocimientos que no llegan (casi nunca) a través de ideas luminosas, sino que, son el resultado del trabajo de muchos.

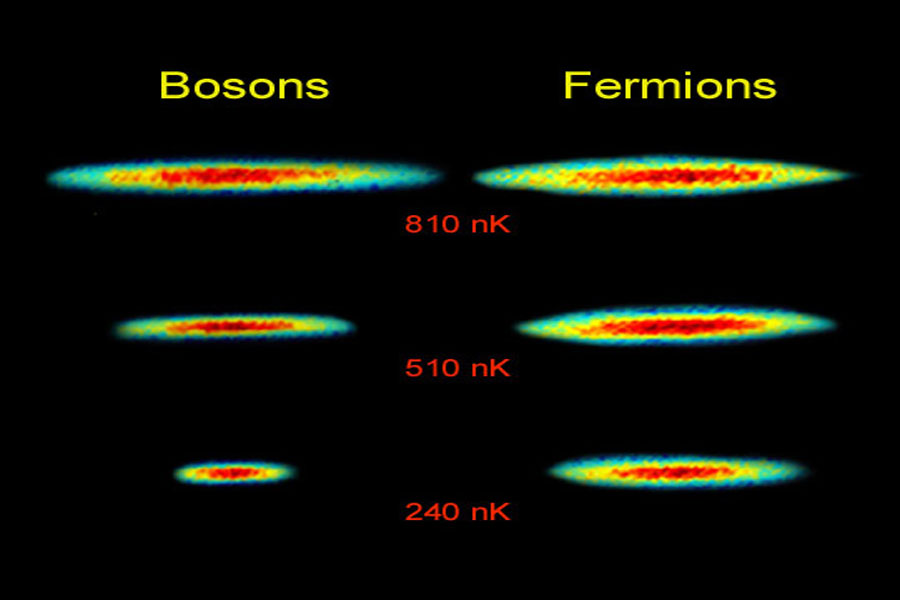

Hoy, sabemos mucho más de cómo finaliza sus días una estrella y, dependiendo de su masa, podemos decir de manera precisa que clase de Nebulosa formará, que clase de explosión (si la hay) se producirá, y, finalmente, si el resultado de todo ello será una estrella enana blanca que encuentra su estabilidad final por medio del Principio de exclusión de Pauli (en mecánica cuántica)que se aplica a los fermiones pero no a los Bosones (son fermiones los quarks, electrones, protones y neutrones), en virtud del cual dos partículas idénticas en un sistema, como los electrones en un átomo o quarks en un hadrón (protón o neutrón, por ejemplo), no pueden poseer un conjunto idéntico de números cuánticos.

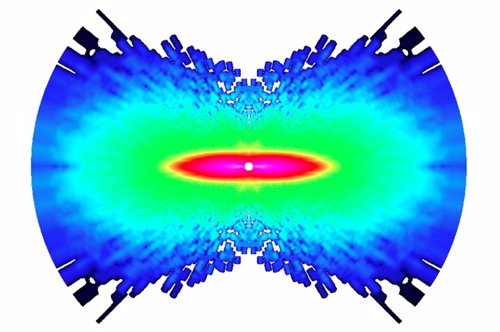

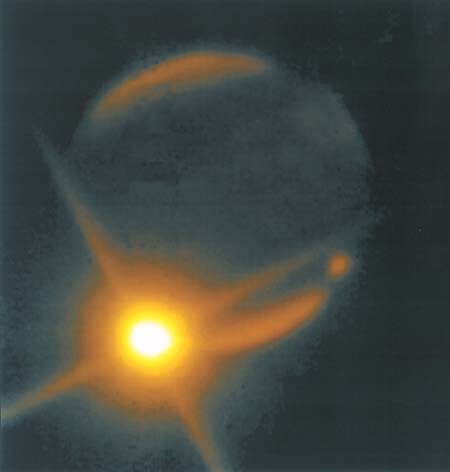

La estrella azul cerca del centro de esta imagen es Zeta Ophiuchi. Cuando se ve en luz visible aparece como una estrella roja relativamente débil rodeada de otras estrellas tenues y sin polvo. Sin embargo, en esta imagen infrarroja tomada con campo amplio por el Explorador Infrared Survey de la NASA, o WISE, un punto de vista completamente diferente emerge. Zeta Ophiuchi es en realidad una muy masiva y caliente estrella azul, brillante que traza su camino a través de una gran nube de polvo y gas interestelar.

Una estrella masiva alejándose de su antiguo compañero se manifiesta haciendo un imponente surco a través de polvo espacial, como si se tratase de la proa de un barco. La estrella, llamada Zeta Ophiuchi, es enorme, con una masa de cerca de 20 veces la de nuestro Sol. En esta imagen, en los que se ha traducido la luz infrarroja a colores visibles que vemos con nuestros ojos, la estrella aparece como el punto azul en el interior del arco de choque. Zeta Ophiuchi orbitó una vez alrededor de una estrella aún más grande. Pero cuando la estrella explotó en una supernova, Zeta Ophiuchi se disparó como una bala. Viaja a la friolera velocidad de 24 kilómetros por segundo arrastrando con ella un conglomerado de polvo que distorsiona la región por la que pasa.

Mientras la estrella se mueve través del espacio, sus poderosos vientos empujan el gas y el polvo a lo largo de su camino en lo que se llama un arco de choque. El material en el arco de choque está tan comprimido que brilla con luz infrarroja que WISE puede captar. El efecto es similar a lo que ocurre cuando un barco cobra velocidad a través del agua, impulsando una ola delante de él. Esta onda de choque queda completamente oculta a la luz visible. Las imágenes infrarrojas como esta son importantes para arrojar nueva luz sobre lo que ocurre en situaciones similares.

Pero, siguiendo con el tema de las implosiones de las estrellas, ¿cuál es la razón por la que la materia no se colapsa, totalmente, sobre sí misma? El mismo principio que impide que las estrellas de neutrones y las estrellas enanas blancas implosionen totalmente y que, llegado un momento, en las primeras se degeneran los neutrones y en las segundas los electrones, y, de esa manera, se frena la compresión que producía la gravedad y quedan estabilizadas gracias a un principio natural que hace que la materia normal sea en su mayor parte espacio vacio también permite la existencia de los seres vivos. El nombre técnico es: El Principio de Exclusión de Pauli y dice que dos fermiones (un tipo de partículas fundamentales) idénticos y con la misma orientación no pueden ocupar simultáneamente el mismo lugar en el espacio. Por el contrario, los bosones (otro tipo de partículas, el fotón, por ejemplo) no se comportan así, tal y como se ha demostrado recientemente por medio de la creación en el laboratorio de los condensados de Bose-Einstein.

Pero, estábamos diciendo: “…no pueden poseer un conjunto idéntico de números cuánticos.” A partir de ese principio, sabemos que, cuando una estrella como nuestro Sol deja de fusionar Hidrógeno en Helio que hace que la estrella deje de expandirse y quede a merced de la Gravedad, ésta implosionará bajo el peso de su propia masa, es decir, se contraerá sobre sí misma por la fuerza gravitatoria pero, llegará un momento en el cual, los electrones, debido a ese principio de exclusión de Pauli que les impide estar juntos, se degeneran y se moverán de manera aleatoria con velocidades relativista hasta el punto de ser capaces de frenar la fuerza provocada por la gravedad, y, de esa manera, quedará estabilizada finalmente una estrella enana blanca.

Si la estrella original es más masiva, la degeneración de los electrones no será suficiente para frenar la fuerza gravitatoria y, los electrones se fusionaran con los protones para convertirse en neutrones que, bajo el mismo principio de exclusión sufrirán la degeneración que frenará la fuerza de gravedad quedando entonces una estrella de neutrones. Por último, si la estrella es, aún más masiva, ni la degeneración de los neutrones será suficiente para frenar la inmensa fuerza gravitatoria generada por la masa de la estrella que, continuará la implosión contrayéndose cada vez más hasta desaparecer de nuestra vista convertida en un agujero negro.

¿Qué forma adoptará, qué transición de fase se produce en la materia dentro de una Singularidad?

¡Resulta todo tan complejo!

emilio silvera

May

2

Formamos parte del misterio que tratamos de desvelar

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (10)

Comments (10)

Una parte de la ciencia estudia la estructura y la evolución del Universo: La cosmología.

La cosmología observacional se ocupa de las propiedades físicas del Universo, como su composición física referida a la química, la velocidad de expansión y su densidad, además de la distribución de Galaxias y cúmulos de galaxias. La cosmología física intenta comprender estas propiedades aplicando las leyes conocidas de la física y de la astrofísica. La cosmología teórica construye modelos que dan una descripción matemática de las propiedades observadas del Universo basadas en esta comprensión física.

La cosmología también tiene aspectos filosóficos, o incluso teológicos, en el sentido de que trata de comprender por qué el Universo tiene las propiedades observadas. La cosmología teórica se basa en la teoría de la relatividad general, la teoría de Einstein de la gravitación. De todas las fuerzas de la naturaleza, la gravedad es la que tiene efectos más intensos a grandes escalas y domina el comportamiento del Universo en su conjunto.

El espacio-tiempo, la materia contenida en el Universo con la fuerza gravitatoria que genera, los posibles agujeros de gusano y, nuestras mentes que tienen conocimientos de que todo esto sucede o puede suceder. De manera que, nuestro consciente (sentimos, pensamos, queremos obrar con conocimiento de lo que hacemos), es el elemento racional de nuestra personalidad humana que controla y reprime los impulsos del inconsciente, para desarrollar la capacidad de adaptación al mundo exterior.

Al ser conscientes, entendemos y aplicamos nuestra razón natural para clasificar los conocimientos que adquirimos mediante la experiencia y el estudio que aplicamos a la realidad del mundo que nos rodea. Claro que, no todos podemos percibir la realidad de la misma manera, las posibilidades existentes de que el conocimiento de esa realidad, responda exactamente a lo que ésta es en sí, no parece fácil.

Descartes, Leibniz, Locke, Berkeley, Hume (que influyó decisivamente en Kant), entre otros, construyeron una base que tomó fuerza en Kant, para quien el conocimiento arranca o nace de nuestras experiencias sensoriales, es decir, de los datos que nos suministra nuestros cinco sentidos, pero no todo en él procede de esos datos. Hay en nosotros dos fuentes o potencias distintas que nos capacitan para conocer, y son la sensibilidad (los sentidos) y el entendimiento (inteligencia). Esta no puede elaborar ninguna idea sin los sentidos, pero éstos son inútiles sin el entendimiento.

A todo esto, para mí, el conocimiento está inducido por el interés. La falta y ausencia de interés aleja el conocimiento. El interés puede ser de distinta índole: científico, social, artístico, filosófico, etc. (La gama es tan amplia que existen conocimientos de todas las posibles vertientes o direcciones, hasta tal punto es así que, nunca nadie lo podrá saber todo sobre todo). Cada uno de nosotros puede elegir sobre los conocimientos que prefiere adquirir y la elección está adecuada a la conformación individual de la sensibilidad e inteligencia de cada cual.

Lo que ocurría allá arriba, siempre despertó en nosotros interés y curiosidad

También se da el caso de personas que prácticamente, por cuestiones genéticas o de otra índole, carecen de cualquier interés por el conocimiento del mundo que les rodea, sus atributos sensoriales y de inteligencia funcionan a tan bajo rendimiento que, sus comportamientos son casi-animales (en el sentido de la falta de racionalidad), son guiados por la costumbre y las necesidades primarias: comer, dormir…

El polo opuesto lo encontramos en múltiples ejemplos de la historia de la ciencia, donde personajes como Newton, Einstein, Riemann, Ramanujan y tantos otros (cada uno en su ámbito del conocimiento), dejaron la muestra al mundo de su genio superior.

Pero toda la realidad está encerrada en una enorme burbuja a la que llamamos Universo y que encierra todos los misterios y secretos que nosotros, seres racionales y conscientes, persiguen.

A veces la conciencia nos grita

Todo el mundo sabe lo que es la conciencia; es lo que nos abandona cada noche cuando nos dormimos y reaparece a la mañana siguiente cuando nos despertamos. Esta engañosa simplicidad me recuerda lo que William James escribió a finales del siglo XIX sobre la atención:”Todo el mundo sabe lo que es la atención; es la toma de posesión por la mente, de una forma clara e intensa, de un hilo de pensamiento de entre varios simultáneamente posibles”. Más de cien años más tarde somos muchos los que creemos que seguimos sin tener una comprensión de fondo ni de la atención, ni de la conciencia que, desde luego, no creo que se marche cuando dormimos, ella no nos deja nunca.

La falta de comprensión ciertamente no se debe a una falta de atención en los círculos filosóficos o científicos. Desde que René Descartes se ocupara del problema, pocos han sido los temas que hayan preocuado a los filósofos tan persistentemente como el enigma de la conciencia.

Para Descartes, como para James más de dos siglos después, ser consciente era sinónimo de “pensar”: el hilo de pensamiento de James no era otra cosa que una corriente de pensamiento. El cogito ergo sum, “pienso, luego existo”, que formuló Descartes como fundamento de su filosofía en Meditaciones de prima philosophía, era un reconocimiento explícito del papel central que representaba la conciencia con respecto a la ontología (qué es) y la epistemología (qué conocemos y cómo le conocemos).

Claro que tomado a pie juntillas, “soy consciente, luego existo”, nos conduce a la creencia de que nada existe más allá o fuera de la propia conciencia y, por mi parte, no estoy de acuerdo. Existen muchísimas cosas y hechos que no están al alcance de mi conciencia. Unas veces por imposibilidad física y otras por imposibilidad intelectual, lo cierto es que son muchas las cuestiones y las cosas que están ahí y, sin embargo, se escapan a mi limitada conciencia.

Todo el entramado existente alrededor de la conciencia es de una complejidad enorme, de hecho, conocemos mejor el funcionamiento del Universo que el de nuestros propios cerebros. ¿Cómo surge la conciencia como resultado de procesos neuronales particulares y de las interacciones entre el cerebro, el cuerpo y el mundo? ¿Cómo pueden explicar estos procesos neuronales las propiedades esenciales de la experiencia consciente ?

Cada uno de los estados conscientes es unitario e indivisible, pero al mismo tiempo cada persona puede elegir entre un número ingente de estados conscientes distintos.

Charles Sherrington

Muchos han sido los que han querido explicar lo que es la conciencia. En 1.940, el gran neurofisiólogo Charles Sherrington lo intento y puso un ejemplo de lo que él pensaba sobre el problema de la conciencia. Unos pocos años más tarde también lo intentaron otros y, antes, el mismo Bertrand Russell hizo lo propio, y, en todos los casos, con más o menos acierto, el resultado no fue satisfactorio, por una sencilla razón: nadie sabe a ciencia cierta lo que en verdad es la conciencia y cuales son sus verdaderos mecanismos; de hecho, Russell expresó su escepticismo sobre la capacidad de los filósofos para alcanzar una respuesta:

“Suponemos que un proceso fisico da comienzo en un objeto visible, viaja hasta el ojo, donde se convierte en otro proceso físico en el nervio óptico y, finalmente, produce algún efecto en el cerebro al mismo tiempo que vemos el objeto donde se inició el proceso; pero este proceso de ver es algo “mental”, de naturaleza totalmente distinta a la de los procesos físicos que lo preceden y acompañan. Esta concepción es tan extraña que los metafísicos han inventado toda suerte de teorías con el fin de sustituirla con algo menos increíble”.

Está claro que en lo más profundo de ésta consciencia que no conocemos, se encuentran todas las respuestas planteadas o requeridas mediante preguntas que nadie ha contestado.

Al comienzo mencionaba el cosmos y la gravedad junto con la consciencia y, en realidad, con más o menos acierto, de lo que estaba tratando era de hacer ver que todo ello, es la misma cosa. Universo-Galaxia-Mente. Nada es independiente en un sentido global, sino que son partes de un todo y están estrechamente relacionados.

Una Galaxia es simplemente una parte pequeña del Universo, nuestro planeta es, una mínima fracción infinitesimal de esa Galaxia, y, nosotros mismos, podríamos ser comparados (en relación a la inmensidad del cosmos) con una colonia de bacterias pensantes e inteligentes. Sin embargo, todo forma parte de lo mismo y, aunque pueda dar la sensación engañosa de una cierta autonomía, en realidad todo está interconectado y el funcionamiento de una cosa incide directamente en las otras.

Pocas dudas pueden caber a estas alturas de que, el hecho de que podamos estar hablando de estas cuestiones, es un milagro en sí mismo.

Después de millones y millones de años de evolución, se formaron las conciencias primarias que surgieron en los animales conciertas estructuras cerebrales de cierta (aunque limitadas) complejidad que, podían ser capaces de construir una escena mental, pero con capacidad semántica o simbólica muy limitada y careciendo de un verdadero lenguaje.

La conciencia de orden superior (que floreció en los humanos y presupone la coexistencia de una conciencia primaria) viene acompañada de un sentido de la propia identidad y de la capacidad explícita de construir en los estados de vigilia escenas pasadas y futuras. Como mínimo, requiere una capacidad semántica y, en su forma más desarrollada, una capacidad lingüística.

Los procesos neuronales que subyacen en nuestro cerebro son en realidad desconocidos y, aunque son muchos los estudios y experimentos que se están realizando, su complejidad es tal que, de momento, los avances son muy limitados. Estamos tratando de conocer la máquina más compleja y perfecta que existe en el Universo.

Si eso es así, resultará que después de todo, no somos tan insignificantes como en un principio podría parecer, y solo se trata da tiempo. En su momento y evolucionadas, nuestras mentes tendrán un nivel de conciencia que estará más allá de las percepciones físicas tan limitadas. Para entonces, sí estaremos totalmente integrados y formando parte, como un todo, del Universo que ahora presentimos.

El carácter especial de la conciencia me hace adoptar una posición que me lleva a decidir que no es un objeto, sino un proceso y que, desde este punto de vista, puede considerarse un ente digno del estudio científico perfectamente legítimo.

La conciencia plantea un problema especial que no se encuentra en otros dominios de la ciencia. En la Física y en la Química se suele explicar unas entidades determinadas en función de otras entidades y leyes. Podemos describir el agua con el lenguaje ordinario, pero podemos igualmente describir el agua, al menos en principio, en términos de átomos y de leyes de la mecánica cuántica. Lo que hacemos es conectar dos niveles de descripción de la misma entidad externa (uno común y otro científico de extraordinario poder explicativo y predictivo. Ambos niveles de descripción) el agua líquida, o una disposición particular de átomos que se comportan de acuerdo con las leyes de la mecánica cuántica (se refiere a una entidad que está fuera de nosotros y que supuestamente existe independientemente de la existencia de un observador consciente.

En el caso de la conciencia, sin embargo, nos encontramos con una simetría. Lo que intentamos no es simplemente comprender de qué manera se puede explicar las conductas o las operaciones cognitivas de otro ser humano en términos del funcionamiento de su cerebro, por difícil que esto parezca. No queremos simplemente conectar una descripción de algo externo a nosotros con una descripción científica más sofisticada. Lo que realmente queremos hacer es conectar una descripción de algo externo a nosotros (el cerebro), con algo de nuestro interior: una experiencia, nuestra propia experiencia individual, que nos acontece en tanto que observadores conscientes. Intentamos meternos en el interior o, en la atinada ocurrencia del filósofo Tomas Negel, saber qué se siente al ser un murciélago. Ya sabemos qué se siente al ser nosotros mismos, qué significa ser nosotros mismos, pero queremos explicar por qué somos conscientes, saber qué es ese “algo” que no s hace ser como somos, explicar, en fin, cómo se generan las cualidades subjetivas experienciales. En suma, deseamos explicar ese “Pienso, luego existo” que Descartes postuló como evidencia primera e indiscutible sobre la cual edificar toda la filosofía.

Ninguna descripción, por prolija que sea, logrará nunca explicar cabalmente la experiencia subjetiva. Muchos filósofos han utilizado el ejemplo del color para explicar este punto. Ninguna explicación científica de los mecanismos neuronales de la discriminación del color, aunque sea enteramente satisfactorio, bastaría para comprender cómo se siente el proceso de percepción de un color. Ninguna descripción, ninguna teoría, científica o de otro tipo, bastará nunca para que una persona daltónica consiga experimentar un color.

En un experimento mental filosófico, Mary, una neurocientífica del futuro daltónica, lo sabe todo acerca del sistema visual y el cerebro, y en particular, la fisiología de la discriminación del color. Sin embargo, cuando por fin logra recuperar la visión del color, todo aquel conocimiento se revela totalmente insuficiente comparado con la auténtica experiencia del color, comparado con la sensación de percibir el color. John locke vio claramente este problema hace mucho tiempo.

Pensemos por un momento que tenemos un amigo ciego al que contamos lo que estamos viendo un día soleado del mes de abril: El cielo despejado, limpio y celeste, el Sol allí arriba esplendoroso y cegador que nos envía su luz y su calor, los árabes y los arbustos llenos de flores de mil colores que son asediados por las abejas, el aroma y el rumor del río, cuyas aguas cantarinas no cesan de correr transparentes, los pajarillos de distintos plumajes que lanzan alegres trinos en sus vuelos por el ramaje que se mece movido por una brisa suave, todo esto lo contamos a nuestro amigo ciego que, si de pronto pudiera ver, comprobaría que la experiencia directa de sus sentidos ante tales maravillas, nada tiene que ver con la pobreza de aquello que le contamos, por muy hermosas palabras que para hacer la descripción empleáramos.

La mente humana es tan compleja que, no todos ante la misma cosa, vemos lo mismo. Nos enseñan figuras y dibujos y nos piden que digamos (sin pensarlo) la primera cosa que nos sugiere. De entre diez personas solo coinciden tres, los otro siete divergen en la apreciación de lo que el dibujo o la figura les sugiere.

Esto nos viene a demostrar la individualidad de pensamiento, el libre albedrío para decidir. Sin embargo, la misma prueba, realizada en grupos de conocimientos científicos similares y específicos: Físicos, matemáticos, químicos, etc. hace que el número de coincidencias sea más elevada, más personas ven la misma respuesta al problema planteado. Esto nos sugiere que, la mente, está en un estado virgen que cuenta con todos los elementos necesarios para dar respuestas pero que necesita experiencias y aprendizaje para desarrollarse.

¿ Debemos concluir entonces que una explicación científica satisfactoria de la conciencia queda para siempre fuera de nuestro alcance? ¿O es de alguna manera posible romper esa barrera, tanto teórica como experimental, para resolver las paradojas de la conciencia?

Todavía no sabemos encajar las piezas

La respuesta a estas y otras preguntas, en mi opinión, radica en reconocer nuestras limitaciones actuales en este campo del conocimiento complejo de la mente, y, como en la Física cuántica, existe un principio de incertidumbre que, al menos de momento (y creo que en muchos cientos de años), nos impide saberlo todo sobre los mecanismos de la conciencia y, aunque podremos ir contestando a preguntas parciales, alcanzar la plenitud del conocimiento total de la mente no será nada sencillo, entre otras razones está el serio inconveniente que su ponemos nosotros mismos, ya que, con nuestro que hacer podemos, en cualquier momento, provocar la propia destrucción.

Una cosa si está clara: ninguna explicación científica de la mente podrá nunca sustituir al fenómeno real de lo que la propia mente pueda sentir.

¿ Cómo se podría comparar la descripción de un gran amor con sentirlo, vivirlo física y sensorialmente hablando ?

Hay cosas que no pueden ser sustituidas, por mucho que los analistas y especialistas de publicidad y maketin se empeñen, lo auténtico siempre será único.

emilio silvera

Totales: 83.354.572

Totales: 83.354.572 Conectados: 56

Conectados: 56