Ene

20

La fantasía de otros mundos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

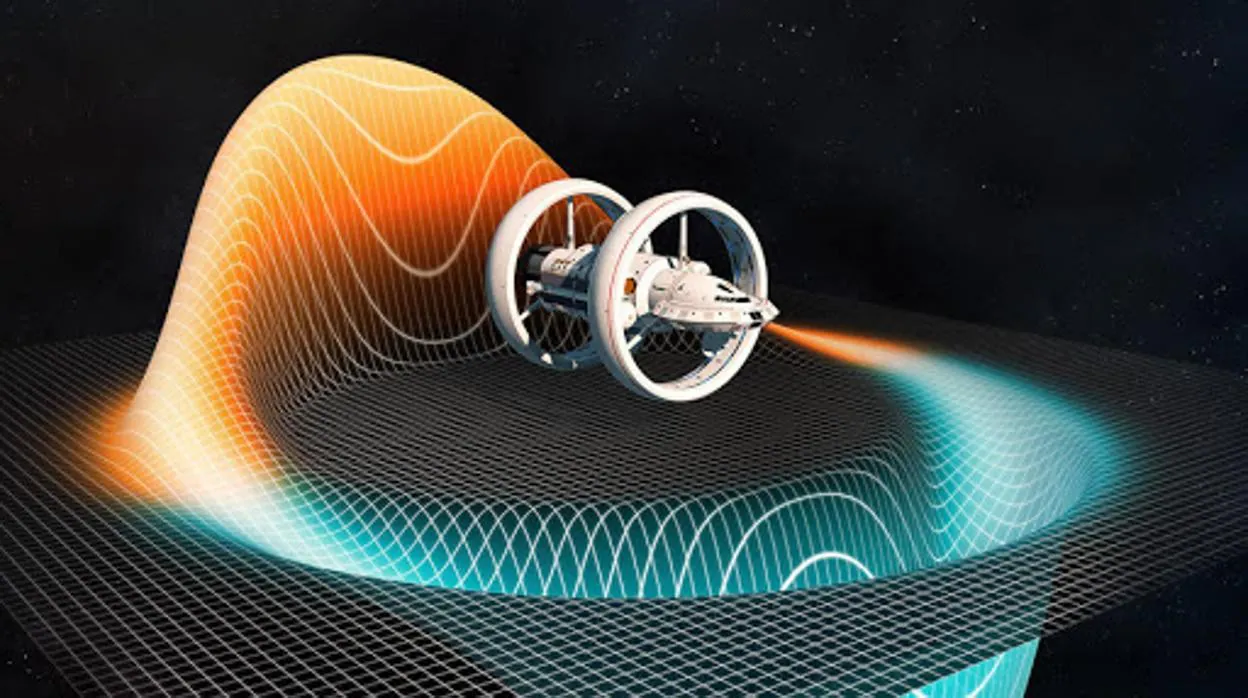

Hemos imaginado la existencia de otros mundos en los que viven Civilizaciones muy avanzadas que, algún día situado en el Futuro, vendrán a señalarnos el camino a seguir, ese camino que la Humanidad parece haber perdido. Enzarzados en la Inteligencia Artificial y Teorías imposibles de poder demostrar, y no viendo otras salidas, echamos manos de lo menos probable, imposible de negar podría podría ser, y también, imposible de demostrar por quedar lejos de nuestros recursos.

:format(jpg)/f.elconfidencial.com%2Foriginal%2Fd56%2F120%2F41c%2Fd5612041c8780993349e8448c60fa5a6.jpg)

- Posibilidad Teórica: Algunos científicos han planteado la idea de que una civilización tecnológica podría haber existido en el Sistema Solar mucho antes que nosotros, o que hay otras civilizaciones inteligentes en la Vía Láctea.

- Ausencia de Evidencia: A pesar de las especulaciones, no se han encontrado señales claras de ciudades o tecnología no humana en los objetos del Sistema Solar, haciendo improbable una civilización avanzada activa en la actualidad.

- Huellas Borradas: Se argumenta que una civilización muy avanzada podría usar tecnología de bajo impacto o biodegradable, o que la Tierra borra eficientemente las huellas tecnológicas con el tiempo, haciendo difíciles de detectar civilizaciones pasadas.

- Escala de Kardashev: Una civilización muy avanzada podría medirse por la cantidad de energía que utiliza, lo que nos permite imaginar diferentes niveles de desarrollo tecnológico, aunque no es una prueba directa de su presencia.

La idea de una civilización avanzada en nuestro sistema solar es fascinante y se explora en la ciencia ficción y, de manera más cautelosa, en la ciencia. Sin embargo, no hay pruebas concluyentes de que una civilización así haya llegado o permanezca en nuestro sistema; por ahora, sigue siendo una cuestión abierta.

:format(jpg)/f.elconfidencial.com%2Foriginal%2F360%2F5f1%2F11b%2F3605f111bc707e41dd1e54d8b6e4896f.jpg)

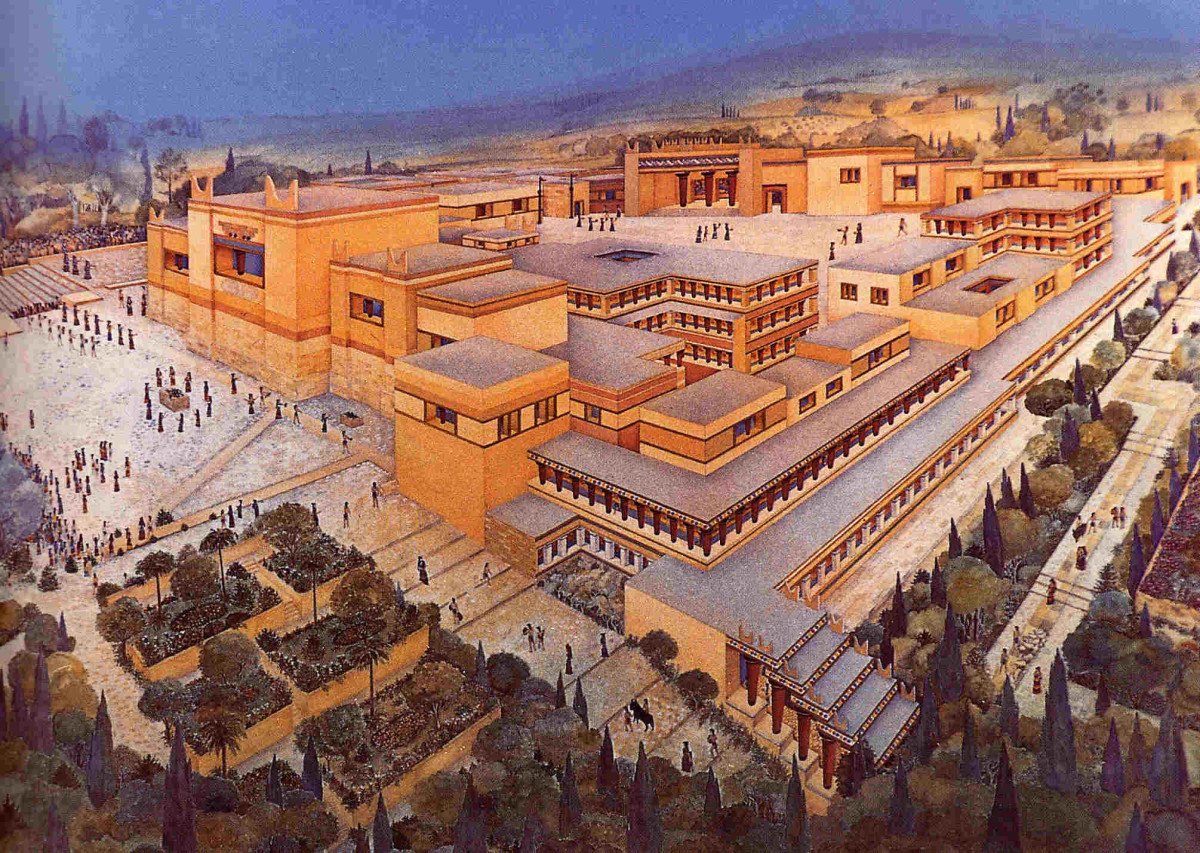

- Mesopotamia (Sumerios): Considerada la “cuna de la civilización”, inventaron la escritura (cuneiforme) y sistemas matemáticos avanzados, bases para el desarrollo posterior.

- Egipto: Maestros en arquitectura, ingeniería, medicina y matemáticas, con un sistema de escritura jeroglífica y calendarios precisos.

- Valle del Indo: Desarrollaron urbanismo planificado, sistemas de saneamiento y pesos y medidas uniformes.

- Mayas (Mesoamérica): Conocidos por su avanzado calendario, matemáticas (concepto del cero) y escritura jeroglífica, además de arquitectura monumental.

- Aztecas e Incas (Mesoamérica y Andes): Grandes ingenieros (caminos, acueductos), astrónomos y organizadores sociales, a pesar de no usar la rueda para transporte.

- Griegos y Romanos: Fundamentales en filosofía, democracia, derecho, ingeniería civil (acueductos, carreteras) y organización militar.

- Culturas como los Minoicos, Anasazi o civilizaciones en la Isla de Pascua desaparecieron, dejando preguntas sobre sus logros y declive, pero no sobre haber “guiado” a otras.

Emilio Silvera V.

Ene

20

¿Pequeño o grande? Todo es como tiene que ser para su propósito

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

https://youtu.be/A5iNGPeK22M

La Escala del Universo

El “universo” de lo infinitesimal (que por ahora termina en los Quarks), no sabemos hasta donde podrá llegar en el Futuro. ¿Daremos alguna vez con las cuerdas vibrantes de que habla la Teoría? Dicen que para llegar a ellas se necesitaría la energía de Planck, es decir, 1019 GeV, lo que está muy lejos de nuestro alcance.

La Naturaleza le ha dado un tamaño a cada ser vivo y a cada objeto del Universo” refleja la diversidad de escala en el cosmos, desde lo microscópico hasta lo gigantesco, donde cada elemento tiene una magnitud adecuada a su función y contexto, como lo ilustra el propio universo observable con miles de millones de galaxias y estructuras colosales, en contraste con el diminuto punto azul de la Tierra, mostrando un orden y propósito subyacente en el tamaño de todo lo existente.

Las partículas subatómicas son los componentes más pequeños que el mismo átomo, como los electrones, protones y neutrones, que determinan sus propiedades, dividiéndose en elementales (indivisibles, como quarks y leptones) y compuestas (como protones y neutrones, formados por quarks unidos por gluones). Existen docenas, incluyendo neutrinos y bosones, la mayoría inestables y producidas en aceleradores de partículas o rayos cósmicos, estudiando sus interacciones en física de partículas

Inmenso grupo de cuásares, que son galaxias distantes que emiten gran cantidad de radiación procedente de agujeros negros, también rompió el principio cosmológico al medir, de un extremo a otro, cerca de 4.000 millones de años luz, siendo la segunda mayor estructura del Universo tras la Gran Muralla de Hércules Corona Boreal.

- Variedad de Escalas: El Universo presenta una gama inmensa de tamaños, desde partículas subatómicas hasta supercúmulos de galaxias que miden millones de años luz, como la Gran Muralla de Hércules-Corona Boreal (arriba).

- Universo Observable: Aunque desconocido en su totalidad, se estima que el Universo observable tiene al menos 93,000 millones de años luz de diámetro, repleto de miles de millones de galaxias.

- La Tierra como un “Punto Azul Pálido”: Esta perspectiva, popularizada por Carl Sagan (1934-1996), enfatiza la pequeñez de nuestro planeta y la vida que alberga en la inmensidad cósmica, según artículos de Psicología y Mente y National Geographic.

- Inteligibilidad del Mundo Natural: La frase sugiere una armonía y una razón detrás de los tamaños, indicando que cada entidad tiene su lugar y proporción dentro del orden universal, un tema explorado por pensadores como Mariano Artigas en su obra sobre la inteligibilidad del mundo natural.

No podemos olvidar que… ¡Todo lo grande está hecho de cositas pequeñas! Como las Galaxias, Nosotros, una hormiga…

Ene

19

Mucha conjetura y pocas pruebas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Yo creo que lo que llaman “materia oscura”, en realidad es una Quinta Fuera fundamental de la Naturaleza. yo la llamo la Energía estructural, la que permitió que se formaran las galaxias a pesar de la expansión de Hubble. Las otras cuatro fuerzas tienen cada una de ellas un fin o misión muy determinados, mientras que esta Quinta fuerza cohesiona todo el Universo haciendo posible que todo sea como lo podemos observar. Sin esta Quinta Fuerza Fundamental, sería un Universo muy diferente (es una opinión personal), creo que la Fuerza que llamo Energía Estructural del Universo, tiene el mismo cometido que las neuronas en nuestro cerebro, hacen posible comportamientos que, sin ellas, no sería posible.

Los hilos invisibles de energía que cohesionan todo el Universo

La ignorancia con la que cargamos en Ciencia, nos lleva a explicar lo que no comprendemos de extrañas maneras, en este caso “materia oscura” paras tratar de tapar la inmensa ignorancia. Como dice el premio Nobel de Física Martinus J. G. Veltman, nos dice:

“La “materia oscura” es la alfombra bajo la cual, los cosmólogos, barren su ignorancia.”

Hay que reconocer que utilizan la imaginación y nos hablan de Materia de sombra, Axiones y WIMPs.

:format(jpg)/f.elconfidencial.com%2Foriginal%2F36c%2Fd84%2F8d0%2F36cd848d0237142e84f77843b9d0a5db.jpg)

No saben lo que es, no tienen idea de qué pueda estar conformada, dicen que es invisible porque no la ven, no emite radiación pero sí genera Gravedad… Y, con todas esas carencias de datos, dicen que permea todo el Espacio.

Algunas veces hablando de los extensos y complejos temas que subyacen en la Astronomía, lo mismo hablamos de “materia de sombre” que de “súper-cuerdas” y, se ha llegado a decir que existe otro universo de materia de sombra que existe en paralelo al nuestro. Los dos universos se separaron cuando la Gravedad se congeló separándose de las otras fuerzas. Las partículas de sombra interaccionan con nosotros sólo a través de la fuerza de la gravedad, lo cual las convierte en candidatas ideales para la tan traída y llevada “materia oscura”.

El estado actual de la cuestión es que los cosmólogos creen saber que hay una gran cantidad de “materia oscura” en el Universo y, han conseguido eliminar la candidatura de cualquier tipo de partícula ordinaria que conocemos. En tales circunstancias no se puede llegar a otra conclusión que la materia oscura debe de existir en alguna forma que todavía no hemos visto y cuyas propiedades ignoramos totalmente. Sin embargo, se atreven a decir que, la Gravedad, es el efecto que se produce cuando la “materia oscura” pierde consistencia… , o algo así. ¡Cómo son!

A los teóricos nada les gusta más que aquella situación en la cual puedan dejar volar libremente la imaginación sin miedo a que nada tan brusco como un experimento u observación acabe con su juego. En cualquier caso, han producido sugerencias extraordinarias acerca de lo que podría ser la “materia oscura” del universo.

Lo que hay en el Universo…no siempre lo podemos comprender, y si no sabemos… ¡Conjeturamos!

Otro de los WIMPs favoritos se llama axión. Como el fotino y sus compañeros, el axión fue sugerido por consideraciones de simetría. Sin embargo, a diferencia de las partículas, sale de las Grandes Teorías Unificadas, que describen el Universo en el segundo 10ˉ³5, más que de las teorías totalmente unificadas que operan en el tiempo de Planck.

Durante mucho tiempo han sabido los físicos que toda reacción entre partículas elementales obedece a una simetría que llamamos CPT. Esto significa que si miramos la partícula de una reacción, y luego vemos la misma reacción cuando (1) la miramos en un espejo, (2) sustituimos todas las partículas por antipartículas y (3) hacemos pasar la película hacia atrás, los resultados serán idénticos. En este esquema la P significa paridad (el espejo), la C significa conjugación de carga (poner las antipartículas) y T la reversa del tiempo (pasar la película al revés).

Se pensaba que el mundo era simétrico respecto a CPT porque, al menos al nivel de las partículas elementales, era simétrico respecto a C, P y T independientemente. Ha resultado que no es éste el caso. El mundo visto en un espejo se desvía un tanto al mundo visto directamente, y lo mismo sucede al mundo visto cuando la película pasa al revés. Lo que sucede es que las desviaciones entre el mundo real y el inverso en cada uno de estos casos se cancelan una a la otra cuando miramos las tres inversiones combinadas.

Aunque esto es verdad, también es verdad que el mundo es casi simétrico respecto a CP actuando solos y a T actuando solo; es decir, que el mundo es casi el mismo si lo miran en un espejo y sustituyen las partículas por anti-partículas que si lo miran directamente. Este “casi” es lo que preocupa a los físicos. ¿Por qué son las cosas casi perfectas, pero les falta algo?

La respuesta a esta cuestión parece que puede estar en la posible existencia de esa otra partícula apellidada axión. Se supone que el Axión es muy ligero (menos de una millonésima parte de la masa del electrón) e interacciona sólo débilmente con otra materia. Es la pequeña masa y la interacción débil lo que explica el “casi” que preocupa a los teóricos.

Cuando nos asomamos a la Teoría de cuerdas, entramos en un “mundo” lleno de sombras en los que podemos ver brillar, a lo lejos, un resplandor cegador. Todos los físicos coinciden en el hecho de que es una teoría muy prometedora y de la que parece se podrán obtener buenos rendimientos en el futuro pero, de momento, es imposible verificarla.

El misterio de las funciones modulares podría ser explicado por quien ya no existe, Srinivasa Ramanujan, el hombre más extraño del mundo de los matemáticos. Igual que Riemann, murió antes de cumplir cuarenta años, y como Riemann antes que él, trabajó en total aislamiento en su universo particular de números y fue capaz de reinventar por sí mismo lo más valioso de cien años de matemáticas occidentales que, al estar aislado del mundo en las corrientes principales de los matemáticos, le eran totalmente desconocidos, así que los buscó sin conocerlos. Perdió muchos años de su vida en redescubrir matemáticas conocidas.

Dispersas entre oscuras ecuaciones en sus cuadernos están estas funciones modulares, que figuran entre las más extrañas jamás encontradas en matemáticas. Ellas reaparecen en las ramas más distantes e inconexas de las matemáticas. Una función que aparece una y otra vez en la teoría de las funciones modulares se denomina (como ya he dicho otras veces) hoy día “función de Ramanujan” en su honor. Esta extraña función contiene un término elevado a la potencia veinticuatro.

¿Podéis imaginar la existencia de un Universo en permanente sombra?

La idea de un universo en sombra nos proporciona una manera sencilla de pensar en la materia oscura. El universo dividido en materia y materia se sombra en el Tiempo de Planck, y cada una evolucionó de acuerdo con sus propias leyes. Es de suponer que algún Hubble de sombra descubrió que ese universo de sombra se estaba expandiendo y es de suponer que algunos astrónomos de sombras piensan en nosotros como candidatos para su materia oscura.

¡Puede que incluso haya unos ustedes de sombras leyendo la versión de sombra de este trabajo!

¿Partículas y partículas super-simétricas? ¿Dónde están?

Partículas son las que todos conocemos y que forman la materia, la super-simétricas, fotinos, squarks y otros, las estamos buscando sin poder hallarlas.

Estas partículas son predichas por las teorías que unifican todas las fuerzas de la naturaleza. Forman un conjunto de contrapartidas de las partículas a las que estamos habituados, pero son mucho más pesadas. Se nombran en analogía con sus compañeras: el squark es el compañero super-simétrico del quark, el fotino del fotón, etc. Las más ligeras de estas partículas podrían ser la materia oscura. Si es así, cada partícula probablemente pesaría al menos cuarenta veces más que el protón.

Materia de sombra, si existe, no hemos sabido dar con ella y, sin embargo, existen indicios de que está ahí

En algunas versiones de las llamadas teorías de super-cuerdas hay todo un universo de materia de sombra que existe paralelo con el nuestro. Los dos universos se separaron cuando la gravedad se congeló separándose de las otras fuerzas. Las partículas de sombra interaccionan con nosotros sólo a través de la fuerza de la gravedad, lo que las convierte en candidatas ideales para la materia oscura.

Habiendo inventado la “materia oscura” para explicar lo que no pueden, se inventan también, las partículas que la conforma: Axiones, unas partículas super-simétricas que buscará el LHC.

El Axión es una partícula muy ligera (pero presumiblemente muy común) que, si existiera, resolvería un problema antiguo en la teoría de las partículas elementales. Se estima que tiene una masa menor que una millonésima parte de la del electrón y se supone que impregna el universo de una manera semejante al

fondo de microondas. La materia oscura consistiría en agregaciones de axiones por encima del nivel general de fondo.

Construímos inmensos aparatos de ingeniosas propiedades tecnológicas para tratar de que nos busquen las WIMPs

¿WIMPs en el Sol?

A lo largo de todo el trabajo se ha dado a entender que todas estas partículas candidatas a materia oscura de la que hemos estado hablando, son puramente hipotéticas. No hay pruebas de que ninguna de ellas se vaya a encontrar de hecho en la naturaleza. Sin embargo sería negligente si no mencionase un argumento –un diminuto rayo de esperanza- que tiende a apoyar la existencia de WIMPs de un tipo u otro. Este argumento tiene que ver con algunos problemas que han surgido en nuestra comprensión del funcionamiento y la estructura del Sol.

Creemos que la energía del Sol viene de reacciones nucleares profundas dentro del núcleo. Si éste es el caso en realidad, la teoría nos dice que esas reacciones deberían estar produciendo neutrinos que en principio son detectables sobre la Tierra. Si conocemos la temperatura y composición del núcleo (como creemos), entonces podemos predecir exactamente cuántos neutrinos detectaremos. Durante más de veinte años se llevó a cabo un experimento en una mina de oro de Dakota del Sur para detectar esos neutrinos y, desgraciadamente, los resultados fueron desconcertantes. El número detectado fue de sólo un tercio de lo que se esperaba. Esto se conoce como el problema del neutrino solar.

:format(jpg)/f.elconfidencial.com%2Foriginal%2Fc94%2F19a%2Fabd%2Fc9419aabddc05d7a754fc8b29b9f31d8.jpg)

El problema de los neutrinos solares se debió a una gran discrepancia entre el número de neutrinos que llegaban a la Tierra y los modelos teóricos del interior del Sol. Este problema que duró desde mediados de la década de 1960 hasta el 2002, ha sido recientemente resuelto mediante un nuevo entendimiento de la física de neutrinos, necesitando una modificación en el modelo estándar de la física de partículas, concretamente en las neutrinos“ Básicamente, debido a que los neutrinos tienen masa, pueden cambiar del tipo de neutrino que se produce en el interior del Sol, el neutrino electrónico, en dos tipos de neutrinos, el muónico y el tauónico, que no fueron detectados. (Wikipedia).

La segunda característica del Sol que concierne a la existencia de WIMPs se refiere al hecho de las oscilaciones solares. Cuando los astrónomos contemplan cuidadosamente la superficie solar, la ven vibrar y sacudirse; todo el Sol puede pulsar en períodos de varias horas. Estas oscilaciones son análogas a las ondas de los terremotos, y los astrónomos llaman a sus estudios “sismología solar”. Como creemos conocer la composición del Sol, tenemos que ser capaces de predecir las propiedades de estas ondas de terremotos solares. Sin embargo hay algunas duraderas discrepancias la teoría y la observación en este campo.

No mucho que los astrónomos han señalado que si la Galaxia está en realidad llena de materia oscura en la forma de WIMPs, entonces, durante su vida, el Sol habría absorbido un gran de ellos. Los WIMPs, por tanto, formarían parte de la composición del Sol, una parte que no se había tenido en cuenta hasta ahora. Cuando los WIMPs son incluidos en los cálculos, resultan dos consecuencias: primero, la temperatura en el núcleo del Sol resulta ser menor de lo que se creía, de forma que son emitidos menos neutrinos, y segundo, las propiedades del cuerpo del Sol cambian de tal modo que las predicciones de las oscilaciones solares son exactas.

Hasta nos atrevemos a exponer una imagen que nos muestra la distribución de los WIMPs

Este resultado es insignificante en lo que se refiere a la existencia de WIMPs, pero como no debemos despreciar las coincidencias halladas, lo más prudente será esperar a nuevos y más avanzados experimentos (SOHO y otros). Tanto el problema del neutrino como las oscilaciones se pueden explicar igualmente bien por otros efectos que no tienen nada que ver con los WIMPs. Por ejemplo, el de oscilaciones de neutrinos podría resolverse si el neutrino solar tuviera alguna masa, aunque fuese muy pequeña, y diversos cambios en los detalles de la estructura interna del Sol podrían explicar las oscilaciones. No obstante estos fenómenos solares constituyen la única indicación que tenemos de que uno de los candidatos a la materia oscura pueda existir realmente.

Toda esta charla sobre supersimetría y teoría últimas da a la discusión de la naturaleza de la materia oscura un tono solemne que no tiene ningún parecido con la forma en que se lleva en realidad el debate entre los cosmólogos. Una de las cosas que más me gusta de este campo es que todo el mundo parece ser capaz de conservar el sentido del humor y una distancia respecto a su propio , ya que, los buenos científicos saben que, todos los cálculos, conjeturas, hipótesis y finalmente teorías, no serán visadas en la aduana de la Ciencia, hasta que sean muy, pero que muy bien comprobadas mediante el experimento y la observación y, no una sino diez mil veces antes de que puedan ser aceptadas en el ámbito puramente científico.

Buscan partículas super-simétricas

Posiblemente, el LHC nos pueda decir algo al respecto si, como no pocos esperan, de sus colisiones surgen algunas partículas supersimétricas que nos hablen de ese otro mundo oscuro que, estando en este, no hemos sabido encontrar hasta este momento. Otra posibilidad sería que la tan manoseada materia oscura no existiera y, en su lugar, se descubriera otro fenómeno o mecanismo natural desconocido hasta que, incidiendo en el comportamiento de expansión del Universo, nos hiciera pensar en la existencia de la “materia oscura” cubrir el hueco de nuestra ignorancia.

Hace algún tiempo, en esas reuniones periódicas que se llevan a cabo entre científicos de materias relacionadas: física, astronomía, astrofísica, cosmología…, alguien del grupo sacó a relucir la idea de la extinción de los dinosaurios y, el hombre se refirió a la teoría (de las muchas que circulan) de que el Sol, en su rotación alrededor de la Vía Láctea, se salía periódicamente fuera del plano de la Galaxia. Cuando hacía esto, el polvo existente en ese plano podía cesar de proteger la Tierra, que entonces quedaría bañada en rayos cósmicos letales que los autores de la teoría pensaban que podían permeabilizar el cosmos. Alguien, el fondo de la sala lanzó: ¿Quiere decir que los dinosaurios fueron exterminados por la radiación de fotinos?

La cosa se tomó a broma y risas marcaron el final de la reunión en la que no siempre se tratan los temas con esa seriedad que todos creen, toda vez que, los conocimientos que tenemos de las cosas son muy limitados y tomarse en serio lo que podría no ser… ¡No sería nada bueno!

En lo que a la “Materia Oscura” se refiere, dejaría en cuarentena el afirmar su existencia hasta tener una confirmación auto consistente acogida al método científico y no a la mera imaginación.

Emilio Silvera V.

Ene

19

Estamos rodeados de misterios

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Fue en el siglo XX (al observar partículas subatómicas que, en los grandes aceleradores de partículas, se movían a velocidades de decenas de miles de kilómetros por segundo) cuando se empezaron a encontrar aumentos de masa que eran suficientemente grandes para poder detectarlos. Un cuerpo que se moviera a unos 260.000 Km por segundo respecto a nosotros mostraría una masa dos veces mayor que cuando estaba en reposo (siempre respecto a nosotros).

En el universo todo es cambiante. Hasta “la nada” es cambiante. La energía que lo integra, que es parte de la misma materia, también es cambiante. Se transforma de una a otra. No se destruye. Cambia y evoluciona. El cuerpo humano es una gran máquina transformadora de energía porque es energía pura. El universo, en un setenta y tanto por ciento de su espacio “infinito”, es energía. Vivimos y formamos parte de un universo repleto de energía. Y en ese universo variable y lleno de energía existen miles de cuatrillones de formas de comunicación, entre otras, la del intercambio de energía entre los objetos que pueblan el Universo.

Nos comunicamos con el Sol que nos manda su energía para hacer posible nuestra presencia aquí, en el planeta Tierra. La energía que se comunica a un cuerpo libre puede integrarse en él de dos maneras distintas:

- En forma de velocidad, con lo cual aumenta la rapidez del movimiento.

- En forma de masa, con lo cual se hace “más pesado”.

La división entre estas dos formas de ganancia de energía, tal como la medimos nosotros, depende en primer lugar de la velocidad del cuerpo (medida, una vez más, por nosotros). Si el cuerpo se mueve a velocidades normales, prácticamente toda la energía se incorpora a él en forma de velocidad: se moverá más aprisa sin cambiar su masa.

A medida que aumenta la velocidad del cuerpo (suponiendo que se le suministra energía de manera constante) es cada vez menor la energía que se convierte en velocidad y más la que se transforma en masa. Observamos que, aunque el cuerpo siga moviéndose cada vez más rápido, el ritmo de aumento de velocidad decrece. Como contrapartida, notamos que gana más masa a un ritmo ligeramente mayor.

La luz, formada por cuentos llamados fotones, es tan rápida que nada en el Universo, la puede alcanzar. Sin embargo sí hay algo que la puede retener mediante la fuerza de Gravedad.

Al aumentar aún más la velocidad y acercarse a los 299.792’458 Km/s, que es la velocidad de la luz en el vacío, casi toda la energía añadida entra en forma de masa. Es decir, la velocidad del cuerpo aumenta muy lentamente, pero la masa es la que sube a pasos agigantados. En el momento en que se alcanza la velocidad de la luz, toda la energía añadida se traduce en masa.

El cuerpo no puede sobrepasar la velocidad de la luz porque para conseguirlo hay que comunicarle energía adicional, y a la velocidad de la luz toda esa energía, por mucha que sea, se convertirá en nueva masa, con lo cual la velocidad no aumentaría ni un ápice.

Si pudiéramos coger con los dedos, un muón que es lanzado por el Acelerador de partículas a velocidad cercana a la de la luz, veríamos como su masa a podido aumentar más de diez veces, toda vez que, la energía que se le ha inyectado no puede seguir convirtiéndose en velocidad más allá de la de la luz, y, el excedente, se convierte en masa. Todo esto no es pura teoría, sino que tal como ha sido comprobado, es la realidad de los hechos.

La velocidad de la luz es la velocidad límite en el universo. Cualquier cosa que intente sobrepasarla adquiriría una masa infinita.

La velocidad de la luz, por tanto, es un límite en nuestro universo; no se puede superar. Siendo esto así, el hombre tiene planteado un gran reto, no será posible el viaje a las estrellas si no buscamos la manera de esquivar este límite de la Naturaleza, ya que, las distancias que nos separan de otros sistemas planetarios son tan enormes que, viajando a velocidades por debajo de la velocidad de la luz, sería casi imposible alcanzar el destino deseado.

La estrella más cercana a nosotros, Próxima Centauri, está a 4.2 años luz de distancia, y, viajando a la velocidad que alcanzan nuestras naves del presente (50.000/60.000 Km/h), tardaríamos 30.000 años en llegar.

Ninguna nave espacial, por los métodos convencionales, podrá alcanzar nunca la velocidad de la luz. Seguramente, los hombres inventarán otros procedimientos para que esas naves puedan burlar ese muro ahora infranqueable y, discurrirán otros caminos que nos posibiliten llegar hasta las estrellas.

Los científicos, físicos experimentales, tanto en el CERN como en el FERMILAB, aceleradores de partículas donde se estudian los componentes de la materia haciendo que haces de protones o de muones, por ejemplo, a velocidades cercanas a la de la luz choquen entre sí para que se desintegren y dejen al descubierto sus contenidos de partículas aún más elementales. Pues bien, a estas velocidades relativistas cercanas a c (la velocidad de la luz), las partículas aumentan sus masas; sin embargo, nunca han logrado sobrepasar el límite de c, la velocidad máxima permitida en nuestro universo.

La velocidad de la luz en el vacío es de 299.792,458 kilómetros por segundo, aunque siempre suele decirse que es de 300.000 kilómetros por segundo para aproximar y que es lo mismo que decir 1.080.000.000 kilómetros por hora.

Nada nunca podrá viajar a la velocidad de la luz ni acercarse siquiera

“Al diez por ciento de la velocidad de la luz, la masa de un objeto sólo es un 0,5 por ciento mayor que en reposo, mientas que al noventa por ciento de la velocidad de la luz sería más del doble de la masa normal en reposo”.

Lo cierto es que, en la práctica, ni la nave ni el cuerpo humano podrían soportar dicha velocidad sin ser destruidos.

La radiación, la luz, el electromagnetismo…. A la Ciencia le quedan muchas cuestiones por explicar

Es preciso ampliar un poco más las explicaciones anteriores que no dejan sentadas todas las cuestiones que el asunto plantea, y quedan algunas dudas que incitan a formular nuevas preguntas, como por ejemplo: ¿por qué se convierte la energía en masa y no en velocidad?, o ¿por qué se propaga la luz a 299.793 Km/s y no a otra velocidad?

La única respuesta que podemos dar hoy es que así es el universo que nos acoge y las leyes naturales que lo rigen, donde estamos sometidos a unas fuerzas y unas constantes universales de las que la velocidad de la luz en el vacío es una muestra.

A velocidades grandes cercanas a la de la luz (velocidades relativistas) no sólo aumenta la masa del objeto que viaja, sino que disminuye también su longitud en la misma dirección del movimiento (contracción de Lorentz) y en dicho objeto y sus ocupantes – si es una nave – se retrasa al paso del tiempo, o dicho de otra manera, el tiempo allí transcurre más despacio. A menudo se oye decir que las partículas no pueden moverse “más deprisa que la luz” y que la “velocidad de la luz” es el límite último de velocidad.

Pero decir esto es decir las cosas a medias, porque la luz viaja a velocidades diferentes dependiendo del medio en el que se mueve. Donde más deprisa se mueve la luz es en el vacío: allí lo hace a 299.792’458 Km/s. Este sí es el límite último de velocidades que podemos encontrar en nuestro universo.

Fotones viajeros

Tenemos el ejemplo del fotón, la partícula mediadora de la fuerza electromagnética, un bosón sin masa que recorre el espacio a esa velocidad antes citada.

Einstein en su teoría de la relatividad especial de 1.905, nos decía que en nuestro universo nada puede ir más rápido que la luz. También nos dejó dicho que masa y energía don dos aspectos de una misma cosa. Que la materia se puede convertir en energía (muchos son los ejemplos que tenemos de ello, y, no todos son buenos) pero, ¿es posible hacer lo contrario y convertir energía en materia?

Sí sería posible convertir energía en materia, pero hacerlo en grandes cantidades resulta poco práctico. Veamos por qué .Según la teoría de Einstein, tenemos que E = mc2, donde e representa la energía, medida en ergios, m representa la masa, medida en gramos, y c es la velocidad de la luz en centímetros por segundo.

La luz se propaga en cualquier medio.

La luz se propaga en el vacío a una velocidad aproximada a los 30.000 millones (3×1010) de centímetros por segundo. La cantidad c2 representa el producto c×c, es decir:

3×1010 × 3×1010, ó 9×1020.

Por tanto, c2 es igual a 900.000.000.000.000.000.000.

Así pues, una masa de un gramo puede convertirse, en teoría, en 9×1020 ergios de energía.

El ergio es una unida muy pequeña de energía que equivale a: “Unidad de trabajo o energía utilizado en el sistema c.g.s y actúa definida como trabajo realizado por una fuerza de 1 dina cuando actúa a lo largo de una distancia de 1 cm: 1 ergio = 10-7 julios”. La kilocaloría, de nombre quizá mucho más conocido, es igual a unos 42.000 millones de ergios. Un gramo de materia convertido en energía daría 2’2×1010 (22 millones) de kilocalorías. Una persona puede sobrevivir cómodamente con 2.500 kilocalorías al día, obtenidas de los alimentos ingeridos. Con la energía que representa un solo gramo de materia tendríamos reservas para unos 24.110 años, que no es poco para la vida de un hombre.

Convertir energía en materia resulta poco práctico

En el contexto del universo, hay energías que se convierten en masa. Esa difícil transformación, no resulta nada fácil de conseguir en un laboratorio manipulado por el hombre, Hay cosas que aún, se escapan a nuestras posibilidades y a las de nuestros ingenios tecnológicos.

O digámoslo de otro modo: si fuese posible convertir en energía eléctrica la energía representada por un solo gramo de materia, bastaría para tener luciendo continuamente una bombilla de 100 vatios durante unos 28.200 años. O bien: la energía que representa un solo gramo de materia equivale a la que se obtendría de quemar unos 32 millones de litros de gasolina.

Nada tiene de extraño, por tanto, que las bombas nucleares, donde se convierten en energías cantidades apreciables de materia, desaten tanta destrucción. La conversión opera en ambos sentidos. La materia se puede convertir en energía y la energía en materia. Esto último puede hacerse en cualquier momento en el laboratorio, donde continuamente convierten partículas energéticas (como fotones de rayos gamma) en 1 electrón y 1 positrón sin ninguna dificultad. Con ello se invierte el proceso, convirtiéndose la energía en materia. Claro que, sólo lo hacemos en esas infinitesimales proporciones. Bueno, para empezar no está mal.

Estos personajes del futuro, tenían la posibilidad de obtener alimentos de una máquina que transformaba la energía en viandas. ¿Cuándo será realidad tal logro? Sería una buena solución para muchas regiones de la Tierra. Sin embargo, lejos queda esa posibilidad futura.

Pero, lo que nosotros podemos lograr en ese plano, sería hablar de una transformación de ínfimas cantidades de masa casi despreciable. ¿Pero podremos utilizar el mismo principio para conseguir cantidades mayores de materia a partir de energía?

Bueno, si un gramo de materia puede convertirse en una cantidad de energía igual a la que produce la combustión de 32 millones de litros de gasolina, entonces hará falta toda esa energía para fabricar un solo gramo de materia, lo que nos lleva al convencimiento de que no sería muy rentable invertir el proceso.

Ya arriba dejo la imagen de aquellos viajeros espaciales de la Nave Enterprise, cuando tenían hambre, le piden a una dispensadora de alimentos lo que desean comer o beber, y la máquina, a partir de la energía, le facilita todo aquello que necesiten. La serie Star Trek, unas de las mejores que han sido realizadas, reflejan algunas licencias que como esta de la máquina dispensadora, no explican de dónde precede la fuente de energía que utilizan y, que según lo que se ve, tendría que ser inagotable.

Antes de que llegara Einstein, los físicos del siglo XIX creían que la materia y la energía eran dos cosas completamente diferentes. Materia es todo aquello que ocupaba un espacio y que poseía masa. Y al tener masa también tenía inercia y respondía al campo gravitatorio. La energía en cambio, no ocupaba espacio ni tenía masa, pero podía efectuar trabajo. Además, se pensaba que la materia consistía en partículas (átomos), mientras que la energía, se componía de ondas.

Por otra parte, esos mismos físicos del XIX creían que ni la materia ni la energía, cada una por su parte, podía ser creada ni destruida. La cantidad de materia del universo era constante, igual que la cantidad total de energía. Había pues una ley de conservación de la energía y de conservación de la materia.

Albert Einstein, en 1.905, les demostró que la masa es una forma muy concentrada de energía. La masa podía convertirse en energía y viceversa. Lo único que había que tener en cuenta era la ley de conservación de la energía. En ella iba incluida la materia.

Hacia los años veinte se vio además que no se podía hablar de partículas y ondas como si fuesen dos cosas diferentes. Lo que se consideraban partículas actuaban en ciertos aspectos como si de ondas se tratara, y lo que normalmente se consideraban ondas actuaban en ciertos aspectos como partículas.

Hay que reconocer que en el “universo” cuántico, existen cosas extrañas: El efecto túnel es una

Así podemos hablar de ondas del electrón, por ejemplo; y también de partículas de luz, o fotones. Pero existe una diferencia entre la una y el otro, mientras que la partícula que denominamos electrón, posee una “masa en reposo” mayor a cero, los fotones por el contrario, no tienen masa alguna, por ese motivo, estas partículas se mueven siempre a una velocidad de 299.792’458 metros por segundo a través del vacío, no debemos olvidar que un fotón es una partícula de luz.

Estamos inmersos en un Universo palpitante, en el que todo es movimiento y energía, nada está estático y, hasta las más ínfimas partículas de materia, se mueven a velocidades alucinantes. Es una dinámica que está marcada, o, regida, por las leyes fundamentales, las fuerzas rigen el Cosmos infinito. Nosotros, siempre curiosos y deseosos de saber, buscamos en lo más profundo del SER del UNIVERSO, para desentrañar lo que es y lo que somos. ¿Lo conseguiremos algún día?

Eso, me lo podéis preguntar dentro de unos pocos millones de años, y, seguramente, aún no os sabría contestar.

Emilio Silvera V.

Ene

19

El Pasado Fascinante

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Un Tiempo incompatible con nuestra presencia en el planeta, y, precisamente por eso, llegamos 65.000.000 de años después

Totales: 84.795.289

Totales: 84.795.289 Conectados: 63

Conectados: 63