Abr

30

Los nuevos descubrimientos que alargan nuestra salud

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (3)

Comments (3)

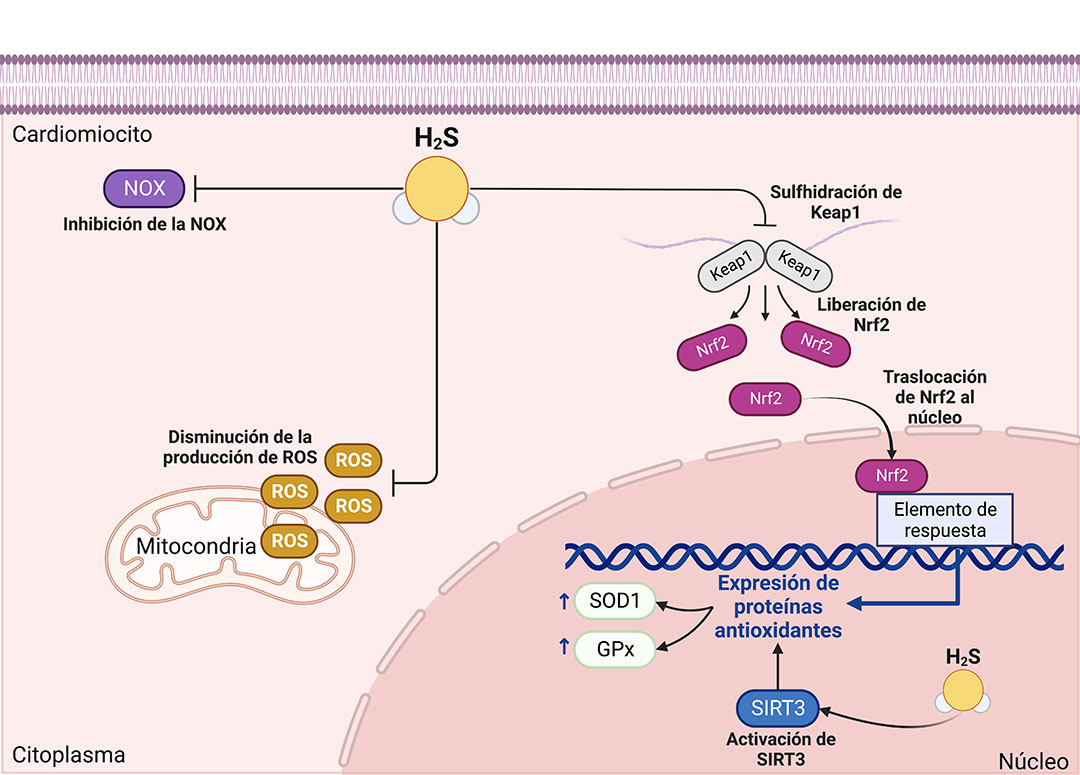

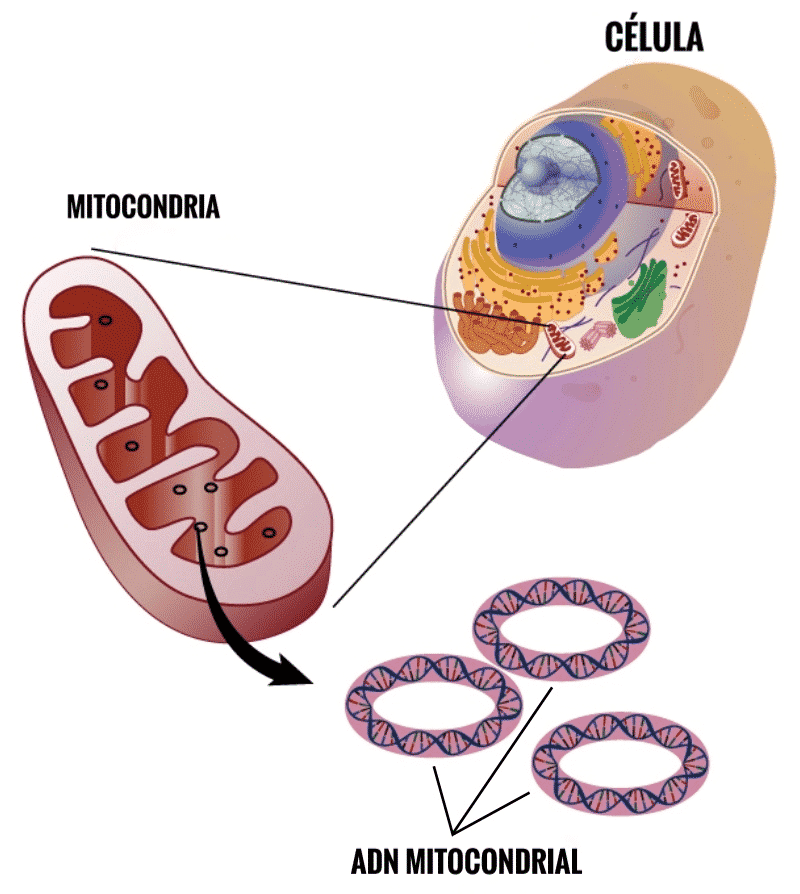

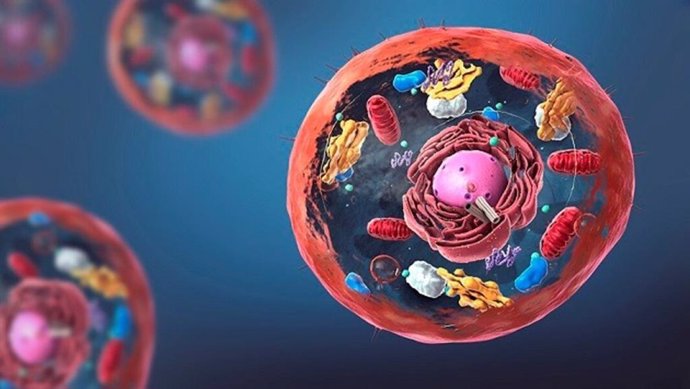

Los nuevos descubrimientos, los experimentos que incansablemente se llevan a cabo en todos los laboratorios del mundo y que hace posible que cada día, sepamos más de nosotros mismos y de cómo funciona nuestro organismo. Se han descubierto los mecanismos mediante los cuales, el Sulfuro de Hidrógeno (H2S), protege a nuestros organismo al proteger a las Mitocondrias, y, eso hace posible que el envejecimiento sea más lento en nosotros.

El H2S, o sulfuro de hidrógeno, puede causar daño en el organismo dependiendo de la concentración y el tiempo de exposición, siendo un gas tóxico y peligroso. Puede provocar irritación en los ojos y el tracto respiratorio.

Si llegamos a poder saber la manera de restringir en nuestra dieta la presencia de 2 aminoácido (la metionina y la cisteína), incrementaremos la producción de H2S y se reducen los daños en nuestro organismo. La principal cuestión a tener en cuenta es que la ingestión sea somera, es decir, que no comamos más de lo necesario y, se ha demostrado que, comer de manera moderada, es conveniente para nuestra Salud.

Así que debemos procurar que las mitocondrias (en simbiosis con nuestro organismo desde tiempos ancestrales), tengan unas condiciones idóneas para su propia salud, y. ya que son los motores que nos proporcionan la energía a nosotros., si ellas están saludables será beneficioso para nosotros. ¿Cómo hacer posible que todo esto se pueda llevar a buen término? Bueno, actualmente, equipos especializados están estudiando sobre el tema y, finalmente, conseguirán su objetivo de que nuestras vidas sean más largas dentro de un estado de salud que llegará a duplicar la vida media de los seres humanos.

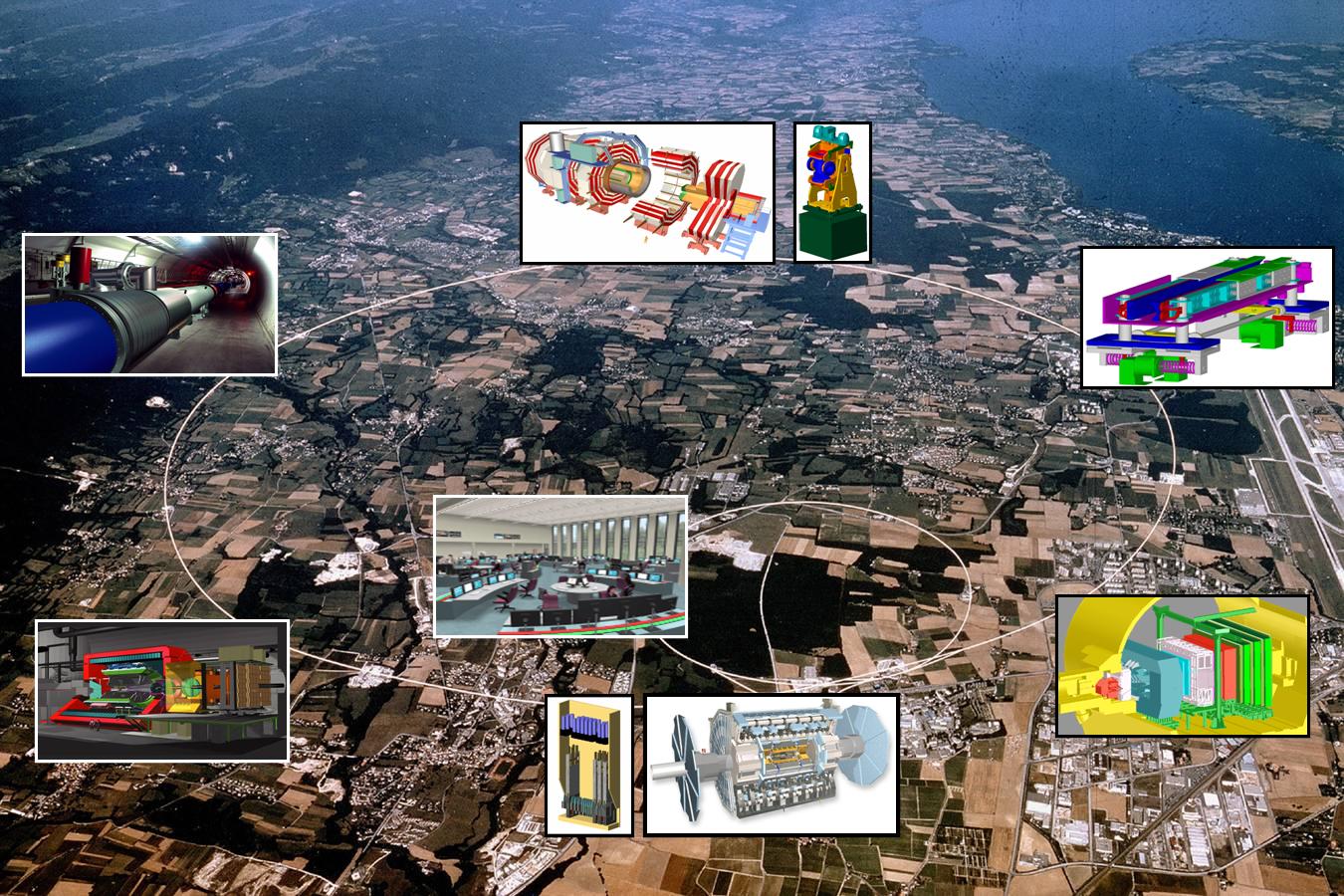

En este punto, quisiera recordar aquí un trabajo que publicó la Revista de la Real Sociedad Española de Física, y, nos constaba como el CERN con su LHC, además de investigar los componentes de la materia, había colaborado y estaba al Servicio de la Salud (entre otras muchas cosas).

Partículas y mucho más

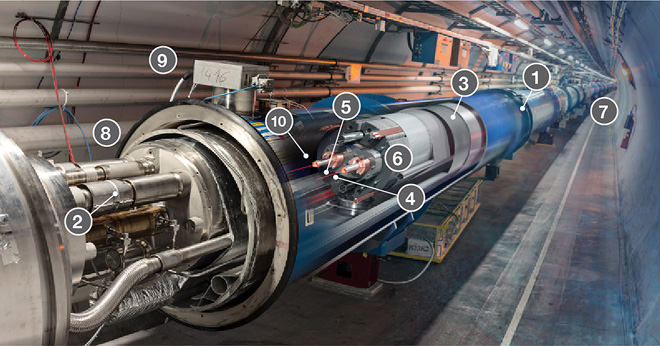

Los lectores de la Revista Española de Física han oído más de una vez hablar del CERN. Fundado en 1954, constituye el mayor laboratorio de física de partículas del mundo, con veinte países miembros y un personal de unas 3.000 personas entre físicos, ingenieros y personal técnico y administrativo de todo tipo. Seguramente están también al tanto de los grandes experimentos que se están preparando en este centro como el Large Hadron Collider (LHC), situado en un túnel circular de 27 km de longitud, destinado a elucidar el origen de la llamada ruptura de la simetría electrodébil y en última instancia el origen de las masas de las partículas elementales (no de la masa del protón o del neutrón como erróneamente se dice a veces en los medios de comunicación), o del proyecto CERN Neutrino Gran Sasso (CNGS), que consiste en enviar un haz de neutrinos de alta energía desde el CERN al laboratorio subterráneo italiano del Gran Sasso que se encuentra a 730 km, para estudiar las oscilaciones de estas huidizas partículas.

También es muy probable que muchos lectores asocien de manera natural la palabra acelerador de partículas a los instrumentos que utilizan los físicos modernos para estudiar y comprender mejor la estructura y el comportamiento de la materia a pequeñas escalas. Sin embargo, de los 17.000 aceleradores de partículas que se estima existen en la actualidad en todo el mundo, aproximadamente la mitad de ellos se usan en medicina y sólo una parte muy pequeña se usan para investigación fundamental. Por este y otros motivos que se discutirán más adelante, en este número especial de la Revista Española de Física dedicado a la física y las ciencias de la vida, ha parecido conveniente incluir un artículo en el que, al menos brevemente, se describieran algunas de las transferencias tecnológicas (spinoffs) importantes que la actividad del CERN aporta a dichas ciencias.

Mucho de lo que aquí se descubre, se aplica a nuestra Salud

Es bastante razonable que, como ocurre con las ciencias del espacio, mucha gente se pregunte cuál es la utilidad social de la física de partículas más allá de la adquisición de conocimientos fundamentales de la naturaleza. Sin embargo, es preciso señalar que los aceleradores y detectores de partículas del CERN y otros laboratorios similares requieren el uso, y muchas veces el desarrollo, de tecnologías de punta que obligan a una estrecha colaboración con la industria que redunda en beneficio de ambas partes. Las transferencias tecnológicas que se producen en este proceso se incorporan inmediatamente a nuestra vida diaria en áreas tales como la electrónica, procesamiento industrial y médico de imágenes, manejo y usos de la radiación , metrología, nuevos materiales, tecnologías de la computación y la información, tratamiento del cáncer, etc. En este artículo se pondrá el énfasis en aquellas actividades del CERN que han redundado de una forma más clara en beneficio de las ciencias biomédicas.

PET/TC o más allá de los rayos X

- ¿Qué es una exploración por tomografía por emisión de positrones/tomografía computarizada (PET/TC)?

- ¿Cuáles son algunos de los usos comunes del procedimiento?

- ¿Cómo debo prepararme para una exploración PET y PET/TC?

- ¿Cómo es el equipo?

- ¿Cómo funciona el procedimiento?

- ¿Cómo se realiza?

- ¿Qué experimentaré durante y después del procedimiento?

- ¿Quién interpreta los resultados y cómo los obtengo?

- ¿Cuáles son los beneficios y los riesgos?

- ¿Cuáles son las limitaciones de la tomografía por emisión de positrones – tomografía computada (PET/TC)?

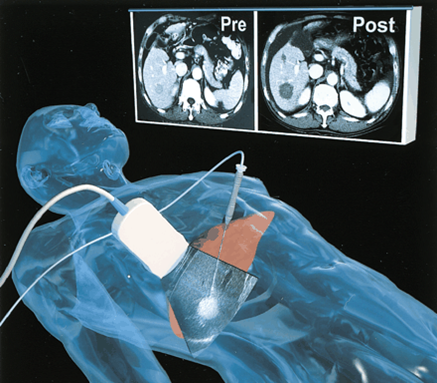

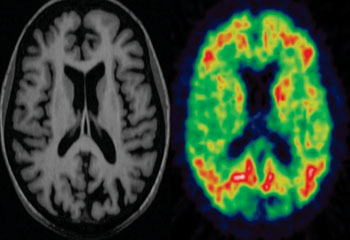

En el ámbito de la medicina los aceleradores de partículas se utilizan con dos finalidades; una para la formación de imágenes con propósitos diagnósticos y otra, para terapia, principalmente oncológica. Desde el descubrimiento de los rayos X por Röntgen en 1895, este tipo de radiación electromagnética ha proporcionado una información de valor incalculable y aún sigue proporcionándola. Sin embargo, mucho más recientemente, se han desarrollado otras técnicas complementarias de diagnóstico basadas en los llamados radiofármacos. Estas sustancias radiactivas presentan idealmente la propiedad de poder ser inyectadas en el organismo humano de forma segura y de fijarse exclusivamente a determinados tejidos. Posteriormente, a medida que van desintegrándose, emiten ciertas partículas que pueden ser detectadas y analizadas produciendo de esta forma imágenes estáticas o incluso dinámicas de los órganos en los que se depositaron los radiofármacos y, en definitiva, proporcionando información no solamente sobre la morfología de aquellos, sino también, en muchos casos, sobre su función y metabolismo. Los radiofármacos se producen utilizando haces de protones de alta intensidad y, como tienen una vida media muy baja, deben utilizarse cerca de donde se han creado. Se calcula que unos 20 millones de personas son diagnosticadas cada año mediante el uso de este tipo de sustancias.

Son técnicas no invasivas que dejan al descubierto lo que interesa ver y eliminar

Una de las técnicas de este tipo más utilizada en la actualidad es la Positrón Emisión Tomography (PET). En su aplicación se utiliza normalmente un ciclotrón para irradiar alguna sustancia que se convierte en radiactiva por desintegración beta positiva (emisora de positrones). Esta sustancia se une por ejemplo a la glucosa y se inyecta al paciente. Los positrones producidos se aniquilan con los electrones circundantes dando lugar a dos fotones de energía muy bien definida, emitidos en direcciones opuestas. Estos fotones interaccionan con un material escintilador dando lugar a la emisión de otros fotones que pueden ser detectados por fotomultiplicadores o fotodiodos para formar la imagen de los tejidos que se pretenden estudiar en función de la distribución de la glucosa radiactiva. Por ejemplo, en el caso del diagnóstico del cáncer las células cancerosas suelen consumir más glucosa que las células sanas debido a su mayor vascularización y a su mayor actividad metabólica y reproductiva, produciendo por tanto una mayor emisión de fotones. Por el contrario, las zonas donde el tejido presente mayor número de células muertas brillarán menos debido a la menor concentración de glucosa radioactiva, lo cual puede ser muy útil para el diagnóstico de infartos y otras lesiones.

Nuevas tecnologías que llegan más lejos

De acuerdo con David Townsend, uno de los pioneros en el desarrollo de la tecnología PET, aunque ésta no fue inventada en el CERN, una cantidad esencial e inicial de trabajo desarrollado en el CERN a partir de 1977 contribuyó de forma significativa al desarrollo del PET 3D. La tecnología PET alcanza su grado más alto de utilidad diagnóstica cuando se combina con la Computed Tomography (CT). La CT es un método de formación de imágenes tridimensionales a partir del procesamiento digital de un gran número de imágenes bidimensionales de rayos X. Inicialmente, las diferentes imágenes se obtenían alrededor de un solo eje de rotación y de ahí su nombre original de Computed Axial Tomography (CAT).

La técnica combinada PET/CT es uno de los desarrollos más excitantes de la medicina nuclear y la radiología modernas. Las reconstrucciones de imágenes CT permiten el diagnóstico precoz de tumores basándose en sus características morfológicas, mientras que la tecnología PET es capaz de diferenciar con grane eficiencia los tejidos malignos de los benignos. La fusión PET/CT permite ahora integrar las imágenes morfológica y fisiológica en una única imagen. El prototipo del scanner ART, el Partial Ring Tomograph (PRT), fue desarrollado en el CERN en 1980 y 1990 por David Townsend, Martín Wensveen y Henri Tochon-Danguy, y evaluado clínicamente en el departamento de medicina nuclear del Hospital Cantonal de Ginebra. ART puede considerarse como el precursor de la parte PET del moderno scanner PET/CT, que ha producido un impacto extraordinario en la tecnología de imágenes con fines médicos. Además, el CERN continua hoy en día contribuyendo a este campo fundamental de la medicina moderna mediante proyectos como Clear PET, Clear PEM, HPD PET etc.

Sin embargo, la importancia del CERN en el desarrollo de las tecnologías PET o CT, y en general de todo tipo de scanner, va mucho más allá. En efecto, todo este tipo de dispositivos se basa, de una forma u otra, en los detectores desarrollados a finales de los sesenta en el CERN por George Charpak. Su trabajo fue reconocido en 1992 con la concesión del Premio Nobel de Física por su invención y desarrollo de detectores de partículas, en particular de la cámara proporcional multihilos, que produjo una revolución en la técnica de exploración de las partes más íntimas de la materia. Los detectores desarrollados por Charpak se usan aún para todo tipo de investigaciones médicas y biológicas y podrían eventualmente sustituir completamente a las placas fotográficas en la radio-biología aplicada. La velocidad creciente con la que permiten registrar las imágenes en radio medicina conducen a una menor tiempo de exposición y a menores dosis de radiación indeseada recibida por los pacientes.

Hadrón-terapia, o las partículas contra el cáncer

Como es bien sabido, una de las herramientas terapéuticas esenciales en el campo de la oncología es la radioterapia. Dicho tratamiento se aplica hoy en día aproximadamente a la mitad de los pacientes de cáncer. En cierto modo se puede considerar como una forma sutil de cirugía donde el bisturí es reemplazado por un haz colimado de partículas capaz de esterilizar las células malignas mediante la inactivación de su ADN, impidiendo así su reproducción. Tradicionalmente, la radioterapia se ha basado en el uso de rayos X (fotones), electrones y, más recientemente, hadrones, es decir, partículas capaces de interaccionar fuerte o nuclearmente, si bien no es ésta la propiedad más interesante de estas partículas para las aplicaciones radio-terapéuticas. Los haces de rayos X y los electrones se obtienen normalmente a partir de aceleradores lineales como los del CERN, aunque mucho más pequeños, y se apuntan hacia los tumores con la energía, dirección y colimación apropiadas para optimizar su efecto destructivo sobre los mismos. Por su parte, los neutrones pierden energía en el interior del organismo de una forma diferente, lo cual les hace más indicados para el tratamiento de ciertos tipos especiales de tumores. Se obtienen a partir de las colisiones de protones, previamente acelerados en un ciclotrón, con núcleos de berilio. Este hecho hace que esta terapia sea bastante más cara que las anteriores, pero a cambio el ciclotrón puede ser usado también para la producción de radiofármacos.

Científicos del CERN aplican antimateria contra el Cáncer

El estudio de las posibilidades de utilización de haces de hadrones en la terapia del cáncer tuvo su origen en el trabajo seminal de R.R Wilson titulado Radiological Use of Fast Protons (Radiology 47, 1946). En dicho artículo se ponía de manifiesto que los protones, así como otras partículas cargadas pesadas, presentan la propiedad única de que al penetrar en el cuerpo humano depositan la mayor parte de su energía a una profundidad que depende de su energía inicial. Este hecho permite seleccionar cuidadosamente el área que se quiere irradiar, preservando de dicha radiación al tejido sano que pudiera encontrarse a menor profundidad. Además, como las partículas se detienen a una distancia de la superficie bien definida por la energía del haz, tampoco resultarían dañadas las células situadas detrás del blanco seleccionado.

En contraste, la energía depositada por los rayos X alcanza su máximo cerca de la superficie de entrada y decae exponencialmente hasta que abandona el cuerpo humano en el lado opuesto, haciendo por tanto muy difícil seleccionar la zona que quiere irradiarse sin dañar otras áreas de células sanas. El trabajo de Wilson de 1946 condujo a toda una nueva línea de investigación experimental, principalmente en el Lawrence Berkeley Laboratory, que ha dado lugar al desarrollo de una nueva clase de terapias antitumorales basadas en la irradiación con protones y más recientemente con iones de carbono. Estas técnicas han sido aplicadas en más de 40 centros de todo el mundo, y de ellas se han beneficiado hasta la fecha más de 50.000 pacientes. No obstante, continúan investigándose nuevas formas de intentar mejorar el ratio entre la energía depositada en las células tumorales y en el tejido sano.

Hidroterapia

En la actualidad, el CERN se encuentra involucrado en diversos proyectos relacionados con la hadrón-terapia. Por ejemplo, en el diseño de un acelerador de protones e iones de carbono dedicado exclusivamente a usos médicos conocido como Proton Ion Medical Machine Study (PIMMS). Otro proyecto interesante es la realización de las pruebas del Linear Booster ( LIBO), capaz de acelerar una haz de protones hasta 200 Mev (los hospitales habitualmente utilizan energías en torno a los 65 MeV) y que estaría especializado en el tratamiento de tumores profundos.

Finalmente, y situándonos en un plano de investigación a un nivel más básico, es interesante señalar que en octubre de 2006 se presentaron los primeros resultados de un experimento llevado a cabo en el CERN con potencial para futuras aplicaciones en la terapia del cáncer. Se trataba del Antiproton Cell Experiment (ACE), que constituye la primera investigación realizada hasta la fecha sobre efectos biológicos de los antiprotones. Los antiprotones se comportan como los protones cuando entran en el organismo, pero generan mucha más energía en el blanco seleccionado debido a du aniquilación con los protones existentes en los núcleos de los átomos de las células, y además depositan esta energía de una forma biológicamente más efectiva.

Cómo la antimateria permite diagnosticar cáncer de manera más directa y certera.

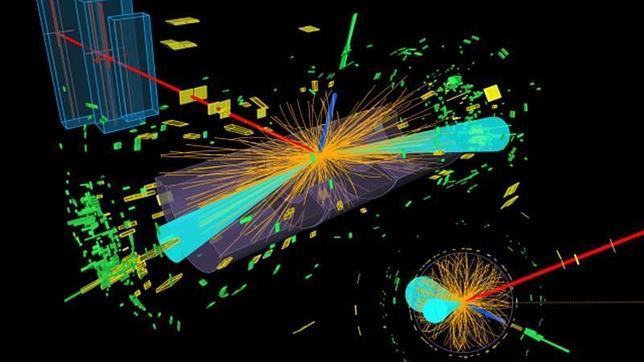

Se busca antimateria contra el Cáncer. Los resultados muestran que los antiprotones son cuatro veces más efectivos que los protones para destruir células vivas. (Foto: Especial CERN )

Evaluando la fracción de células supervivientes después de la irradiación con el haz de antiprotones, el experimento ACE ha encontrado que a eficiencia de éstos es unas cuatro veces mayor que la de los protones, mientras que el daño producido a las células situadas antes del blanco era básicamente el mismo. De acuerdo con Michael Holzscheiter, portavoz del experimento ACE, este hecho podría ser extremadamente importante para el tratamiento de casos de cáncer recurrente, donde este tipo de propiedad es vital. La tecnología desarrollada previamente en el CERN para la obtención de haces de antiprotones de buena calidad a la energía apropiada es esencial para este prometedor experimento, que difícilmente podría haberse realizado en ningún otro laboratorio. Éste es por tanto un magnífico ejemplo de cómo la investigación en física de partículas desarrollada en el CERN puede generar soluciones innovadores con excelentes beneficios médicos potenciales.

Los investigadores de ACE, en colaboración con otras instituciones de todo el mundo, están realizando en la actualidad nuevos tests para comprobar la eficacia de este método en el caso de tumores situados a mayor profundidad, y comparando sus resultados con los de otros métodos más convencionales como la irradiación mediante iones de carbono. Si todo sale como se espera, los beneficios clínicos de esta nueva técnica podrían empezar a producirse dentro de la próxima década.

No es un metal precioso ni un diamante ni un mineral estratégico… Es la antimateria, la otra cara (invisible) de la materia común. Sus cualidades son extraordinarias. Ya la usamos para detectar células cancerosas y servirá para destruirlas sin dañar los tejidos sanos. Y puede ser el combustible del futuro. Con solo diez miligramos una nave llegaría a Marte. El problema es que producir un solo miligramo de antimateria cuesta 57.000 millones de euros. Y el precio no es el único inconveniente…

Otro ejemplo importante de tecnología creada en el CERN con aplicaciones a la terapia del cáncer es el Neutrón Driven Element Trasmuter. Se trata de un sistema de producción de radioisótopos específicos específicos a partir de un acelerador de protones cuyo desarrollo fue liderado por Carlo Rubbia, Premio Nobel de Física en 1984 por el descubrimiento de los bosones W y Z y ex director general del CERN. La idea es utilizar el haz de protones para producir neutrones los cuales provocan reacciones en un ambiente apropiado donde ciertos elementos son convertidos en los isótopos deseados.

La diferencia principal entre este método, seguro y barato, y el método más tradicional de utilizar los neutrones provenientes de un reactor nuclear, es que no requiere el uso de material fisionable ni funciona críticamente, es decir las reacciones se detienen en el momento en el que el acelerador es apagado. Más aún, el método tiene la ventaja de que sólo se producen los isótopos requeridos, lo que redunda en una importante reducción de impacto ambiental. Normalmente, el blanco utilizado es plomo, elemento idóneo por presentar el menor ritmo de captura de neutrones. Los neutrones se producen por espalación a partir del haz de protones y permanecen en el interior del blanco de plomo, que está rodeado de un deflector de grafito, hasta que su espectro se suaviza suficientemente para cubrir un gran rango de energías que permiten su utilización para la transmutación de los elementos necesarios para la obtención de los isótopos deseados.

El Neutron Driven Element Trasmuter ha permitido, entre otras cosas, la producción de radioisótopos beta emisores como el 166Ho, 186 Re o el 188Re que son de gran importancia en braquiterapia. Dicha técnica, muy utilizada en el tratamiento de cánceres ginecológicos y en el de cáncer de próstata, es un tipo de radioterapia de proximidad donde la fuente radiactiva se sitúa dentro o muy cerca de los tejidos que requieren irradiación. Típicamente, la fuente radiactiva, de alta actividad y corta vida media, se encapsula en una semilla, filamento o tubo y se implanta en quirófano en la zona deseada. Las diferentes dosis requeridas en cada caso hacen que sea fundamental disponer del mayor muestrario posible de radioisótopos con la actividad y vida media apropiadas, lo cual convierte al Neutrón Driven Element Trasmuter en una herramienta valiosísima para el futuro de este tipo de técnica terapéutica.

Información y computación sin fronteras

CERN, … where the web was born; éste es uno de los reclamos publicitarios que suelen utilizarse para hacer ver al público la importancia de los retornos tecnológicos que en este laboratorio tienen lugar. Y en efecto, fue a finales de los ochenta cuando Tim Berners-Lee desarrolló estándar de Hyper Text Transfer Protocol (HTTP) e implementó los primeros servidores web en el CERN. Su esfuerzo permitió la comunicación fácil y segura y el intercambio de todo tipo de información entre todos los ordenadores del mundo conectados a internet, dando lugar de esta forma a una de las revoluciones tecnológicas más importantes de las últimas décadas. Las repercusiones científicas, tecnológicas, culturales, comerciales y de ocio de la web son ya tan conocidas que apenas merecen comentario alguno.

El término Grid fue acuñado por Ian Foster and Carl Kesselman en su libro The Grid, Blueprint for new Computing Infraestructure (Morgan Kaufman, 1998), aunque las ideas básicas habían sido consideradas con anterioridad. No existe un acuerdo general sobre cual debería ser la definición precisa de las tecnologías Grid, pero hay un amplio concenso en que esta debería contener elementos tales como recursos compartidos, virtualización, abstracción del acceso a los recursos y estandarización. La filosofía Grid consistiría, no sólo en compartir información entre diferentes usuarios, sino también recursos, como por ejemplo, procesadores, tiempo de CPU, unidades de almacenamiento, así como otros aparatos e instrumentos, de tal forma que eventualmente cada usuario tendría acceso virtual, por ejemplo, a la capacidad de cálculo de todos los demás usuarios de esa Grid. En los primeros tiempos de esta tecnología de la información se llegó a hablar de la Grid, refiriéndose a la posibilidad de existencia de una única World Wide Grid.

Todo surgió del CERN

El CERN creó su propia red de computación, o Grid, conocida como LHC Computing Grid (LCG), para manejar la gran cantidad de datos generados por el Gran Colisionador de Hadrones (LHC). Esta red permite a miles de científicos de todo el mundo acceder y analizar los datos de las colisiones.

Hasta el momento,, sin embargo, este concepto no es una realidad y más bien lo que se encuentra es que diferentes grupos de proyectos crean su propia Grid usando sus propias implementaciones, estándares y protocolos y dando acceso restringido solamente a una cierta comunidad de usuarios autorizados. Así, aunque se siguen realizando importantes esfuerzos en cuanto a la estandarización de los protocolos, no está claro cual será el camino que este tipo de tecnología seguirá en el futuro en lo que se refiere a la futura existencia de un única Grid.

En cualquier caso es importante resaltar que una vez más el CERN ha sido pionero en este tipo de tecnología. Los detectores que se están instalando (a estas alturas, todos instalados y en marcha) en el LHC (ATLAS, CMS, ALICE, LHCb, SUSY, etc.), son tan complejos, que han requerido cada uno de ellos el concurso de muchas instituciones de todo el mundo para su construcción, y lo seguirán requiriendo para su mantenimiento cuando el acelerador empiece a funcionar (ya está en marcha), y, como no, para el análisis de los datos que se obtengan. Para hacerse una idea de la dimensión y complejidad de estos análisis baste mencionar que el compact Muon Selenoid (CMS), una vez pasado su primer filtro, deberá almacenar información sobre el resultado de las colisiones producidas en su interior a un ritmo del orden de 100 a 200 MB por segundo durante un tiempo esperado de unos cien días por año. Resulta obvio que sólo una tecnología tipo Grid puede afrontar con posibilidades de éxito un reto semejante y de hecho el CERN ha inspirado varios proyectos Grid multinacionales por este motivo. Posiblemente, el más grande de ellos hasta la fecha sea el EGEE (Enablinbg Grids for E-Science), que conecta más de 150 paises y ofrece 20 000 CPUs y más de 10 Petabytes de memoria.

![]()

De manera análoga a como ocurrió con las tecnologías de la detección y aceleración, las tecnologías Grid tendrán, y de hecho ya empiezan a tener, un fuerte impacto en las ciencias de la vida y de la salud. En este sentido, uno de los campos obvios de aplicación es la bioinformática. Gracias a los espectaculares avances llevados a cabo en los últimos años en el campo de la biología molecular, se dispone hoy en día de cantidades crecientes de información genética de diferentes especies e individuos. Dicha información codificada en el ADN en forma de secuencia de tripletes o codones de ácidos nucleicos, que constituyen los genes que contienen la estructura primaria de las diferentes proteínas, ha sido y está siendo obtenida por centenares de grupos diferentes distribuidos por todo el mundo y debe almacenarse en gigantescas bases de datos de forma eficiente para su compartición, contrastación y análisis.

Ejemplos típicos serían la búsqueda de determinadas secuencias, comparaciones, búsqueda de determinadas mutaciones o alelos, etc. Resulta evidente que esta ingente labor puede verse enormemente beneficiada por el uso de tecnologías Grid. De hecho, la Bioinformática, y en particular sus aplicaciones biomédicas, han sido una parte importante del proyecto EGEE desde el comienzo del mismo.

Finalmente, y como última muestra de cómo puede revertir en la sociedad las tecnologías de la información y la computación provenientes de la física de partículas, es interesante mencionar el Proyecto Mammogrid y su continuación Mammogrid Plus. Liderado por el CERN, dicho proyecto de la UE utiliza la tecnología Grid para crear una base de datos de mamografías que pueda ser usada para investigar un gran conjunto de datos e imágenes que, aparte de otras aplicaciones sanitarias, sea útil para estudiar el potencial de esta tecnología para servir de soporte a la colaboración entre los profesionales de la salud de la UE.

Ciencia, Tecnología y Sociedad

A estas alturas debería haber quedado claro que los centros científicos de élite internacionales como el CERN, no sólo nos proporcionan un conocimiento más profundo de la naturaleza, sino que las tecnologías de punta que en ellos se desarrollan acaban permeando a la Sociedad y se incorporan a nuestras vidas cotidianas. El autor del artículo, Antonio Dobado, del Departamento de Física Teórica I de la Universidad Complutense de Madrid, ha pretendido ilustrar el hecho innegable de la conexión existente entre temas tan aparentemente dispares como el de la Física de Partículas y la Biomedicina, pero ejemplos semejantes podrían haberse encontrado en prácticamente cualquier área de la actividad humana.

La Sociedad no puede permanecer por más tiempo ajena a la Ciencia y a todo lo que trae consigo. Precisamente por eso la RSEF dedica un gran esfuerzo a la difícil tarea de convencer al público de la importancia de la Física como valor científico, cultural y social, como una forma rigurosa y profunda del acercamiento al conocimiento de la naturaleza, y a la vez como generadora de nuevas tecnologías. En este sentido, es una espléndida noticia la inminente creación de un nuevo Grupo especializado en el seno de la RSEF denominado Física Médica. Y, desde aquí, aprovechamos la oportunidad para darles la bienvenida y desearles el mayor éxito en sus futuras andaduras en la búsqueda de la verdad científica.

Fuente: Revista Española de FÍSICA.

Emilio Silvera Vázquez, el titular de este Blog (el creador y Administrador es SHALAFI) es miembro numerario de la R.S.E.F. y adscrito a los Grupos Especializados de Física Teórica y Astrofísica.

Abr

28

¿La Vida en otros mundos? ¡Cada vez más cerca!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

La tecnología tiene la palabra.

Comprobar desde inmensas distancias la presencia de vida en otros mundos… No será nada fácil, y, la posibilidad de ir hacia ellos… No está a nuestro alcance. Sin embargo, simplemente aplicando la lógica, tendremos que convdenir en que, lo más probable e que la vida prolifera por todo el Universo.

Abr

27

El fino equilibrio que permite la presencia de la Vida

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

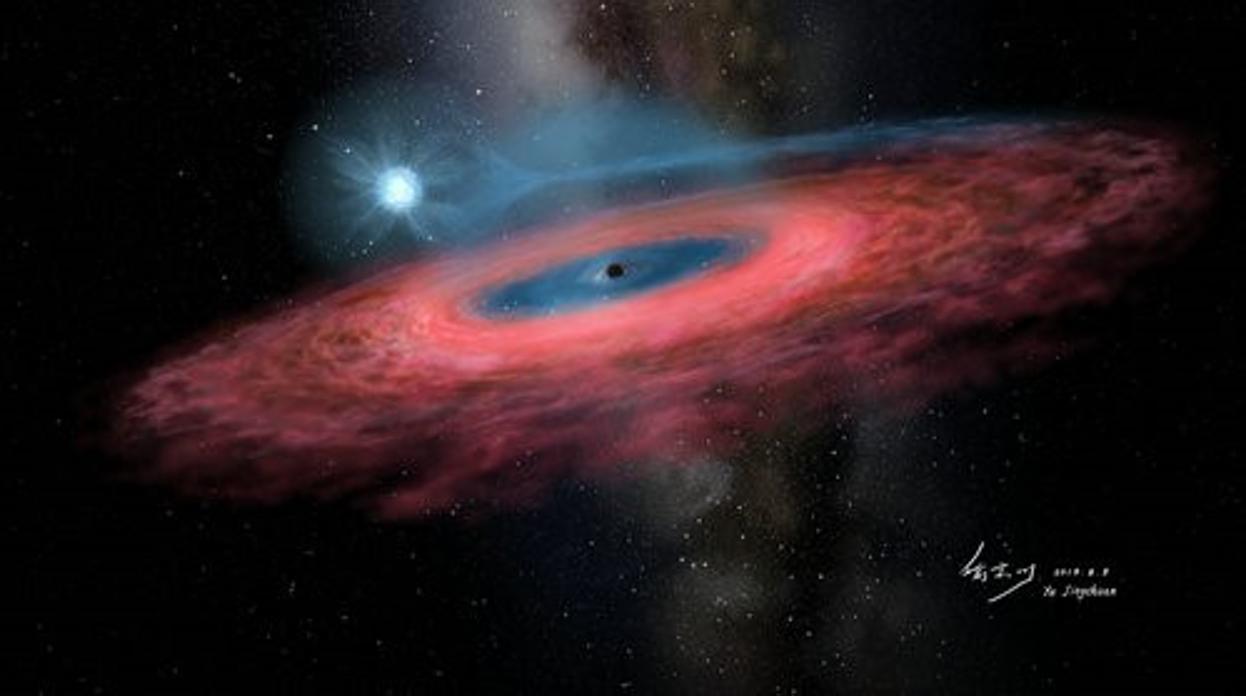

Acreción de gas en un agujero negro estelar desde su estrella compañera azul . Descubren en nuestra Galaxia un agujero negro tan descomunal que no debería existir. Su masa es 70 veces mayor que la del sol.

YU JINGCHUAN, PLANETARIO DE PEKÍN.

Animación del Péndulo de Foucault oscilando en el hemisferio sur

Un año más tarde, Jean Foucault (quien realizaría poco después su experimento con los péndulos) precisó más estas medidas empleando un espejo giratorio en vez de una rueda dentada. Entonces se midió el tiempo transcurrido desviando ligeramente el ángulo de reflexión mediante el veloz espejo giratorio. Foucault obtuvo un valor de la velocidad de la luz de 300.883 Km/s. También el físico francés utilizó su método para determinar la velocidad de la luz a través de varios líquidos. Averiguó que era notablemente inferior a la alcanzada en el aire. Esto concordaba con la teoría ondulatoria de Huyghens.

Las estrellas típicas como el Sol, emiten desde su superficie un viento de partículas cargadas eléctricamente que barre los atmósferas de los planetas en órbitas a su alrededor y a menos que el viento pueda ser desviado por un campo magnético, los posibles habitantes de ese planeta lo podrían tener complicado soportando tal lluvia de radiactividad. En nuestro sistema solar el campo magnético de la Tierra ha protegido su atmósfera del viento solar, pero Marte, que no está protegido por ningún campo magnético, perdió su atmósfera hace tiempo.

Hasta el momento sólo sabemos de la vida en la Tierra

Probablemente no es fácil mantener una larga vida en un planeta del Sistema solar. Poco a poco hemos llegado a apreciar cuán precaria es. Dejando a un lado los intentos que siguen realizando los seres vivos de extinguirse a sí mismos, agotar los recursos naturales, propagan infecciones letales y venenos mortales y emponzoñar la atmósfera, también existen serias amenazas exteriores.

Los movimientos de cometas y asteroides, a pesar de tener la defensa de Júpiter, son una seria y cierta amenaza para el desarrollo y persistencia de vida inteligente en las primeras etapas. Los impactos no han sido infrecuentes en el pasado lejano de la Tierra habiendo tenido efectos catastróficos. Somos afortunados al tener la protección de la luna y de la enorme masa de Júpiter que atrae hacia sí los cuerpos que llegan desde el exterior desviándolos de su probable trayectoria hacia nuestro planeta.

La caída en el Planeta de uno de estos enormes pedruscos podría producir extinciones globales y retrasar en millones de años la evolución.

Dominaron la Tierra durante 150 millones de años, y, hace ahora 65 millones de años que se extinguieron

Dominaron la Tierra durante 150 millones de años, y, hace ahora 65 millones de años que se extinguieron

Cuando comento éste tema no puedo evitar el recuerdo del meteorito caído en la Tierra que impactó en la península de Yucatán hace 65 millones de años, al final de la Era Mesozoica, cuando según todos los indicios, los dinosaurios se extinguieron. Sin embargo, a aquel suceso catastrófico para los grandes lagartos, en realidad supuso que la Tierra fue rescatada de un callejón sin salida evolutivo. Parece que los dinosaurios evolucionaron por una vía que desarrollaba el tamaño físico antes que el tamaño cerebral.

Purgatorius, un ancestro de los primates, estuvo presente en el momento en el que los mamíferos empezamos a convertirnos en los dominadores del mundo.

“Cuando los dinosaurios desparecieron en una de las extinciones masivas que ha sufrido nuestro planeta, bajo tierra, entre las raíces de los árboles y al refugio de sus madrigueras, sobrevivieron los pequeños mamíferos que habían vivido huyendo de los grandes reptiles hasta entonces. Con la extinción de los grandes depredadores, el mundo se mostró como un camino despejado para estas pequeñas criaturas. Los mamíferos salieron de sus escondites para colonizar el mundo y diversificarse como nunca. Entre ellos se encontraba Purgatorius, uno de los antepasados de los primates, que con su habilidad para trepar pudo alimentarse de los frutos de los árboles e iniciar el éxito evolutivo de los primates hasta hoy día, cuando los seres humanos dominamos el mundo.”

La desaparición de los dinosaurios junto con otras formas de vida sobre la Tierra en aquella época, hizo un hueco para la aparición de los mamíferos. Se desarrollo la diversidad una vez desaparecidos los grandes depredadores. Así que, al menos en este caso concreto, el impacto nos hizo un gran favor, ya que, hizo posible que 65 millones de años más tarde pudiéramos llegar nosotros. Los dinosaurios dominaron el planeta durante 150 millones de años; nosotros, en comparación, llevamos tres días y, desde luego, ¡la que hemos formado!

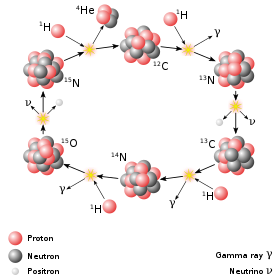

En nuestro sistema solar la vida se desarrolló por primera vez sorprendentemente pronto tras la formación de un entorno terrestre hospitalario. Hay algo inusual en esto. El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas cristalicen los materiales complejos necesarios para la vida, tales como el hidrógeno, nitrógeno, oxígeno, carbono, etc.

Parece que la similitud en los “tiempos” no es una simple coincidencia. El argumento, en su forma más simple, lo introdujo Brandon Carter y lo desarrolló John D. Barrow por un lado y por Frank Tipler por otro. Al menos, en el primer sistema Solar habitado observado ¡el nuestro!, parece que sí hay alguna relación entre t(bio) y t(estrella) que son aproximadamente iguales el t(bio) –tiempo biológico para la aparición de la vida- algo más extenso.

Colonias de bacterias (estromatolitos), poblaron las aguas

La evolución de una atmósfera planetaria que sustente la vida requiere una fase inicial durante la cual el oxígeno es liberado por la fotodisociación de vapor de agua. En la Tierra esto necesitó 2.400 millones de años y llevó el oxígeno atmosférico a aproximadamente una milésima de su valor actual. Cabría esperar que la longitud de esta fase fuera inversamente proporcional a la intensidad de la radiación en el intervalo de longitudes de onda del orden de 1000-2000 ángstroms, donde están los niveles moleculares clave para la absorción de agua.

Este simple modelo indica la ruta que vincula las escalas del tiempo bioquímico de evolución de la vida y la del tiempo astrofísico que determina el tiempo requerido para crear un ambiente sustentado por una estrella estable que consume hidrógeno en la secuencia principal y envía luz y calor a los planetas del Sistema Solar que ella misma forma como objeto principal.

A muchos les cuesta trabajo admitir la presencia de vida en el Universo como algo natural y corriente, ellos abogan por la inevitabilidad de un Universo grande y frío en el que, es difícil la aparición de la vida, y, en el supuesto de que ésta aparezca, será muy parecida a la nuestra.

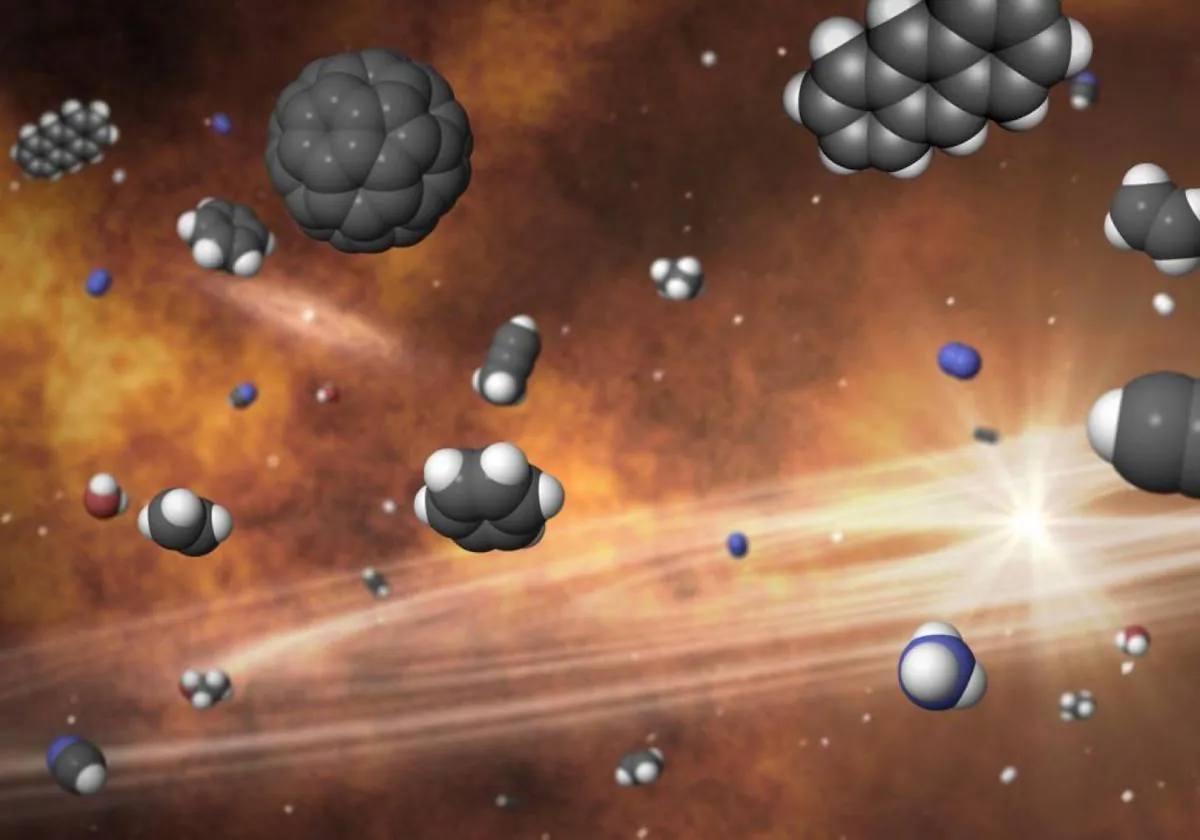

Creo que la clave está en los compuestos del carbono, toda la vida terrestre actualmente conocida exige también el Agua como disolvente. Y como para el carbono, se supone a veces que el agua es el único producto químico conveniente para cumplir este papel. El amoníaco (el nitruro de hidrógeno) es la alternativa ciertamente al agua, la más generalmente posible propuesta como disolvente bioquímico. Numerosas reacciones químicas son posibles en disolución en el amoníaco, y el amoníaco líquido tiene algunas semejanzas químicas con el agua. El amoníaco puede disolver la mayoría de las moléculas orgánicas al menos así como el agua, y por otro lado es capaz de disolver muchos metales elementales. A partir de este conjunto de propiedades químicas, se teorizó que las formas de vida basada en el amoníaco podrían ser posibles. También se dijo del Silicio. Sin embargo, ninguno de esos elementos son tan propicios para la vida como el Carbono y tienen, como ya sabemos, parámetros negativos que no permiten la vida tal como la conocemos.

Hasta rel momento, todas las formas de vida descubiertas en la Tierra, están basadas en el Carbono.

Los biólogos, sin embargo, parecen admitir sin problemas la posibilidad de otras formas de vida, pero no están tan seguros de que sea probable que se desarrollen espontáneamente, sin un empujón de formas de vida basadas en el carbono. La mayoría de los estimaciones de la probabilidad de que haya inteligencias extraterrestres en el Universo se centran en formas de vida similares a nosotras que habiten en planetas parecidos a la Tierra y necesiten agua y oxígeno o similar con una atmósfera gaseosa y las demás condiciones de la distancia entre el planeta y su estrella, la radiación recibida, etc. En este punto, parece lógico recordar que antes de 1957 se descubrió la coincidencia entre los valores de las constantes de la Naturaleza que tienen importantes consecuencias para la posible existencia de carbono y oxígeno, y con ello para la vida en el Universo.

Hay una coincidencia o curiosidad adicional que existe entre el tiempo de evolución biológico y la astronomía. Puesto que no es sorprendente que las edades de las estrellas típicas sean similares a la edad actual del Universo, hay también una aparente coincidencia entre la edad del Universo y el tiempo que ha necesitado para desarrollar formas de vida como nosotros.

Si miramos retrospectivamente cuánto tiempo han estado en escena nuestros ancestros inteligentes (Homo sapiens) vemos que han sido sólo unos doscientos mil años, mucho menos que la edad del Universo, trece mil millones de años, o sea, menos de dos centésimos de la Historia del Universo. Pero si nuestros descendientes se prolongan en el futuro indefinidamente, la situación dará la vuelta y cuando se precise el tiempo que llevamos en el Universo, se hablará de miles de millones de años.

- C: Carbono

- H: Hidrógeno

- O: Oxígeno

- N: Nitrógeno

- P: Fósforo

- Fe: Hierro

- S: Azufre

- Ca: Calcio

- I: Yodo

- Na: Sodio

- K: Potasio

- Cl: Cloro

- Mg: Magnesio

- F: Flúor

- Cu: Cobre

- Zn: Zinc

- Glúcidos o Hidratos de Carbono

- Lípidos

- Proteínas

- Ácidos Nucleicos

Todas estas extrañas formas de vida comparten el planeta Tierra co nosotros, y, lo mismo que aquí ¿Por qué no habrían de existir también “allí”, ya que, teniendo en cuenta qu el universo es igual en todas partes, así tendría que ser.

A veces, nuestra imaginación dibuja mundos de ilusión y fantasía pero, en realidad… ¿serán sólo sueños?, o, por el contrario, pudieran estar en alguna parte del Universo todas esas cosas que imaginamos aquí y que pudieran estar presentes en otros mundos lejanos que, como el nuestro…posibilito la llegada de la vida.

:format(jpg)/f.elconfidencial.com%2Foriginal%2Fcec%2Ff74%2Fea1%2Fcecf74ea171f8425e2e58313288ed71b.jpg)

Sí, imaginamos demasiado pero… ¿Qué hay más poderoso que la imaginación?

Brandon Carter y Richard Gott han argumentado que esto parece hacernos bastante especiales comparados con observadores en el futuro muy lejano.

¿Cuántos secretos están en esos números escondidos? La mecánica cuántica (h), la relatividad (c), el electromagnetismo (e–). Todo eso está ahí escondido. El número 137 es un número puro y adimensional, nos habla de la constante de estructura fina alfa (α), y, el día que sepamos desentrañar todos sus mensajes… ¡Ese día sabremos!

Extraños mundos que pudieran ser

Por ahí fuera existen mundos de todo tipo, y, algunos… ¡Mejor no visitarlos!

Podríamos imaginar fácilmente números diferentes para las constantes de la Naturaleza de forma tal que los mundos también serían distintos al planeta Tierra y, la vida no sería posible en ellos. Aumentemos la constante de estructura fina más grande y no podrá haber átomos, hagamos la intensidad de la gravedad mayor y las estrellas agotarán su combustible muy rápidamente, reduzcamos la intensidad de las fuerzas nucleares y no podrá haber bioquímica, y así sucesivamente.

Hay cambios infinitesimales que seguramente podrían ser soportados sin notar cambios perceptibles, como por ejemplo en la vigésima cifra decimal de la constante de estructura fina. Si el cambio se produjera en la segunda cifra decimal, los cambios serían muy importantes. Las propiedades de los átomos se alteran y procesos complicados como el plegamiento de las proteínas o la replicación del ADN pueden verse afectados de manera adversa. Sin embargo, para la complejidad química pueden abrirse nuevas posibilidades. Es difícil evaluar las consecuencias de estos cambios, pero está claro que, si los cambios consiguen cierta importancia, los núcleos dejarían de existir, n se formarían células y la vida se ausentaría del planeta, siendo imposible alguna forma de vida.

“Es difícil formular cualquier teoría firme sobre las etapas primitivas del universo porque no sabemos si hc/e2 es constante o varía proporcionalmente a log(t). Si hc/e2 fuera un entero tendría que ser una constante, pero los experimentadores dicen que no es un entero, de modo que bien podría estar variando. Si realmente varía, la química de las etapas primitivas sería completamente diferente, y la radiactividad también estaría afectada. Cuando empecé a trabajar sobre la gravedad esperaba encontrar alguna conexión ella y los neutrinos, pero esto ha fracasado.”

Las constantes de la naturaleza ¡son intocables!

“Los secretos más ocultos del Universo están codificados en unos valores numéricos, aparentemente eternos, a los que llamamos “constantes de la naturaleza”. Entre ellas se encuentran algunas tan famosas como la de la gravitación universal, G, la de la velocidad de la luz, c, o la de Planck, h. John D. Barrow, profesor de la Universidad de Cambridge, célebre por sus obras de divulgación científica, nos invita aquí a explorar esos principios y a someterlos a crítica: ¿son las “constantes de la naturaleza” realmente constantes? ¿Son las mismas en todas partes? ¿Están todas ellas ligadas? ¿Podría haber evolucionado y persistido la vida si fueran ligeramente distintas? Con sus respuestas, Barrow nos conduce hasta las fronteras más retadoras de la ciencia, nos desvela las profundas implicaciones que estas constantes tienen para el destino del universo y el lugar de los hombres en él, y teoriza sobre las realidades que podrían encontrarse en un universo que tuviera distintos parámetros del nuestro.”

Ahora sabemos que el Universo tiene que tener miles de millones de años para que haya transcurrido el tiempo necesario par que los ladrillos de la vida sean fabricados en las estrellas y, la gravitación nos dice que la edad del Universo esta directamente ligada con otros propiedades como la densidad, temperatura, y el brillo del cielo.

Ahora, cuando miramos el Universo, comprendemos, en parte, lo que ahí está presente.

Puesto que el Universo debe expandirse durante miles de millones de años, debe llegar a tener una extensión visible de miles de millones de años luz. Puesto que su temperatura y densidad disminuyen a medida que se expande, necesariamente se hace frío y disperso. Como hemos visto, la densidad del Universo es hoy de poco más que 1 átomo por M3 de espacio. Traducida en una medida de las distancias medias entre estrellas o galaxias, esta densidad tan baja muestra por qué no es sorprendente que otros sistemas estelares estén tan alejados y sea difícil el contacto con extraterrestres. Si existe en el Universo otras formas de vía avanzada, entonces, como nosotros, habrán evolucionado sin ser perturbadas por otros seres de otros mundos hasta alcanzar una fase tecnológica avanzada, entonces, como nosotros, habrán evolucionado sin ser perturbadas por otros seres de otros mundos hasta alcanzar una fase tecnológica avanzada.

La expansión del Universo es precisamente la que ha hecho posible que el alejamiento entre estrellas con sus enormes fuentes de radiación, no incidieran en las células orgánicas que más tarde evolucionarían hasta llegar a nosotras, diez mil millones de años de alejamiento continuado y el enfriamiento que acompaña a dicha expansión, permitieron que, con la temperatura ideal y una radiación baja los seres vivos continuaran su andadura en este planeta minúsculo, situado en la periferia de la galaxia que comparado al conjunto de esta, es solo una cuota de polvo donde unos insignificantes seres laboriosos, curiosos y osados, son conscientes de estar allí y están pretendiendo determinar las leyes, no ya de su mundo o de su galaxia, sino que su osadía ilimitada les lleva a pretender conocer el destino de todo el Universo.

Cuando a solas pienso en todo esto, la verdad es que no me siento nada insignificante y nada humilde ante la inmensidad de los cielos. Las estrellas pueden ser enormes y juntas, formar inmensas galaxias… pero no pueden pensar ni amar; no tienen curiosidad ni en ellas está el poder de ahondar en el porqué de las cosas, nosotros si podemos hacer todo eso y más.

La constante de estructura fina de Sommerfeld (símbolo α) es la constante física fundamental que caracteriza la fuerza de la fuerza electromagnética. Es una cantidad sin dimensiones, por lo que su valor numérico es independiente del sistema de unidades usado.

La estructura de los átomos y las moléculas está controlada casi por completo por dos números: la razón entre las masas del electrón y el protón b, que es aproximadamente igual a 1/1.836, y la constante de estructura fina a, que es aproximadamente 1/137. Supongamos que permitimos que estas dos constantes cambien su valor de forma independiente y supongamos también (para hacerlo sencillo) que ninguna otra constante de la Naturaleza cambie. ¿Qué le sucede al mundo si las leyes de la naturaleza siguen siendo las mismas?

Si deducimos las consecuencias pronto encontramos que no hay muchos espacios para maniobrar. Incrementemos b demasiado y no puede haber estructuras moleculares ordenadas porque es el pequeño valor de Beta (aF) el que asegura que los electrones ocupen posiciones bien definidas alrededor de un núcleo atómico y las cargas negativas de los electrones igualan las cargas positivas de los protoneshaciendo estable el núcleo y el átomo.

La fuerza nuclear fuerte es la que permite que tripletes de Quarks creen hadrones del tipo barión y dupletes del tipo meson. La fuerza nuclear fuerte es dos veces más potente que la electromagnética, de hecho es la más potente que se conoce en el universo y, sin embargo, sólo actúa a distancias ínfimas.

Si en lugar de a versión b, jugamos a cambiar la intensidad de la fuerza nuclear fuerte aF, junto con la de a, entonces, a menos que aF > 0,3 a½, los elementos como el carbono no existirían.

No podrían existir químicos orgánicos, no podrían mantenerse unidos. Si aumentamos aF en solo un 4 por 100, aparece un desastre potencial porque ahora puede existir un nuevo núcleo de helio, el helio-2, hecho de 2 protones y ningún neutrón, que permite reacciones nucleares directas y más rápidas que de protón + protón → helio-2.

Las estrellas agotarían rápidamente su combustible y se hundirían en estados degenerados o en agujeros negros. Por el contrario, si aF decreciera en un 10 por 100, el núcleo de deuterio dejaría de estar ligado y se bloquearía el camino a los caminos astrofísicos nucleares hacia los elementos bioquímicos necesarios para la vida.

Hasta donde sabemos, en nuestro sistema solar la vida se desarrolló por primera vez sorprendentemente pronto tras la formación de un entorno terrestre hospitalario. El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas que llegaran a poder cristalizar los materiales complejos necesarios para la vida, tales como el hidrógeno, nitrógeno, oxígeno, carbono… Si miramos por ahí, encontraremos múltiples noticias como estas:

Telescopio Spitzer de la NASA ha detectado los pilares de la vida en el universo distante, aunque en un entorno violento. Ha posado su poderoso ojo infrarrojo en un débil objeto situado a una distancia de 3.200 millones de años luz (recuadro), Spitzer ha observado la presencia de agua y moléculas orgánicas en la galaxia IRAS F00183-7111.

Como podemos ver, amigos míos, la vida, como tantas veces vengo diciendo aquí, pulula por todo el Universo en la inmensa familia galáctica compuesta por más de ciento veinticinco mil millones y, de ese número descomunal, nos podríamos preguntar: ¿Cuántos mundos situados en las zonas habitables de sus estrellas habrá y, de entre todos esos innumerables mundos, cuántos albergaran la vida?

¿Qué sentido tendría un Universo sin vida?

A muchos les cuesta trabajo admitir la presencia de vida en el universo como algo natural, ellos abogan por la inevitabilidad de un universo grande y frío en el que es difícil la aparición de la vida. Yo (como muchos otros), estoy convencido de que la vida es, de lo más natural en el universo y estará presente en miles de millones de planetas que, como la Tierra, tienen las condiciones para ello. Una cosa no se aparta de mi mente, muchas de esas formas de vida, serán como las nuestras aquí en la Tierra y estarán también, basadas en el Carbono. Sin embargo, no niego que puedan existir otras formas de vida diferentes a las terrestres.

Emilio Silvera Vázquez

Abr

27

Miles de millones de Mundos en nuestra Galaxia

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

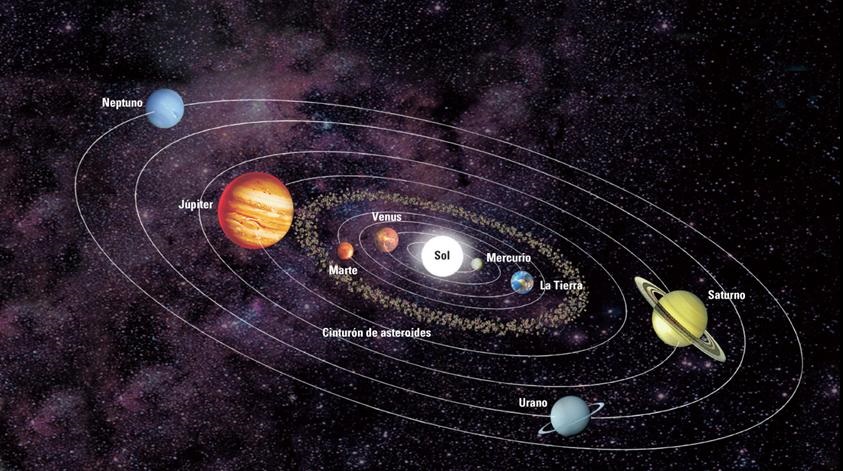

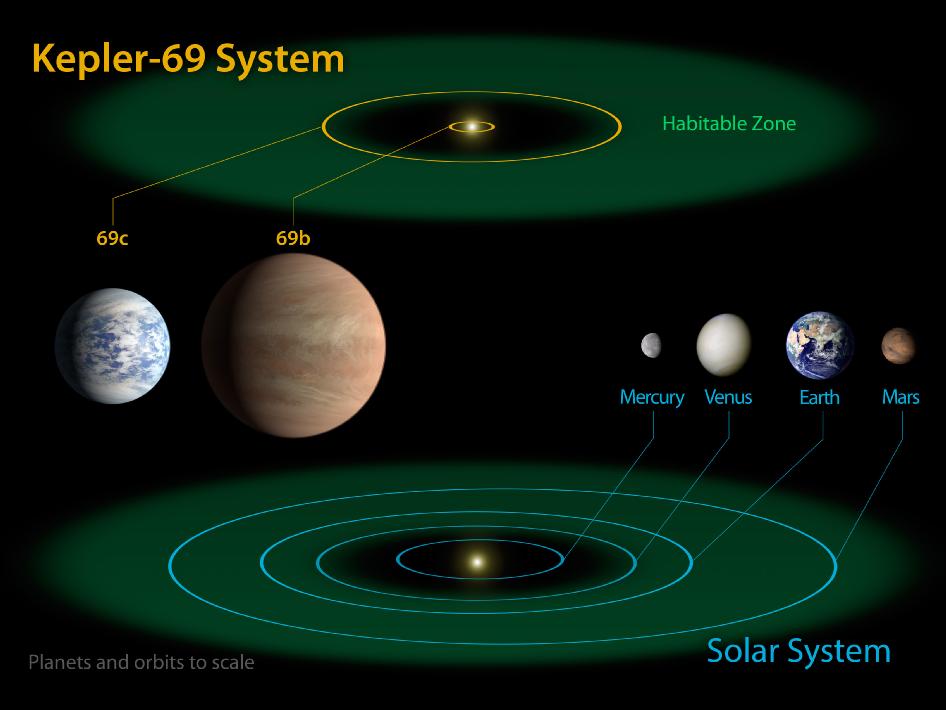

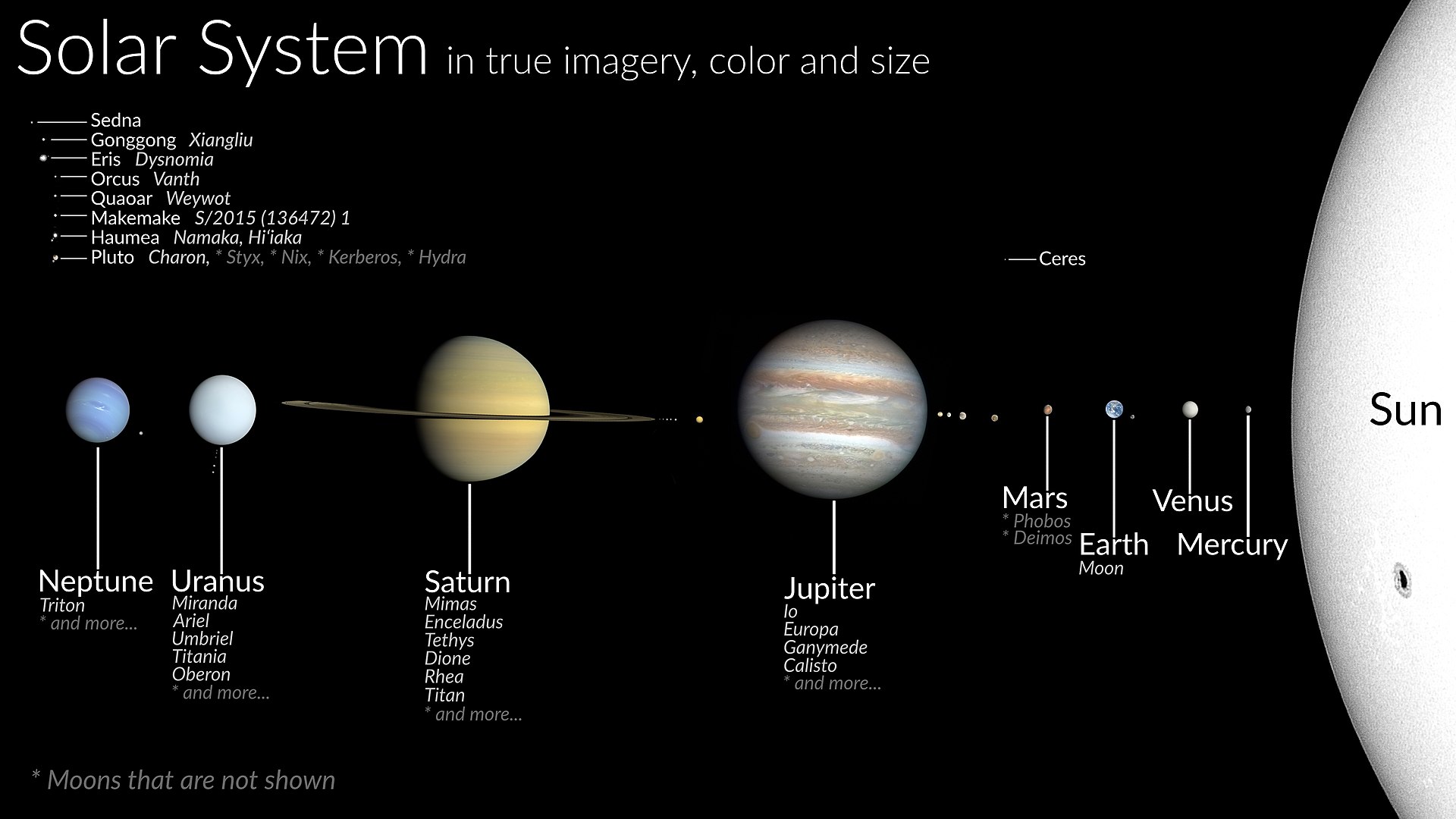

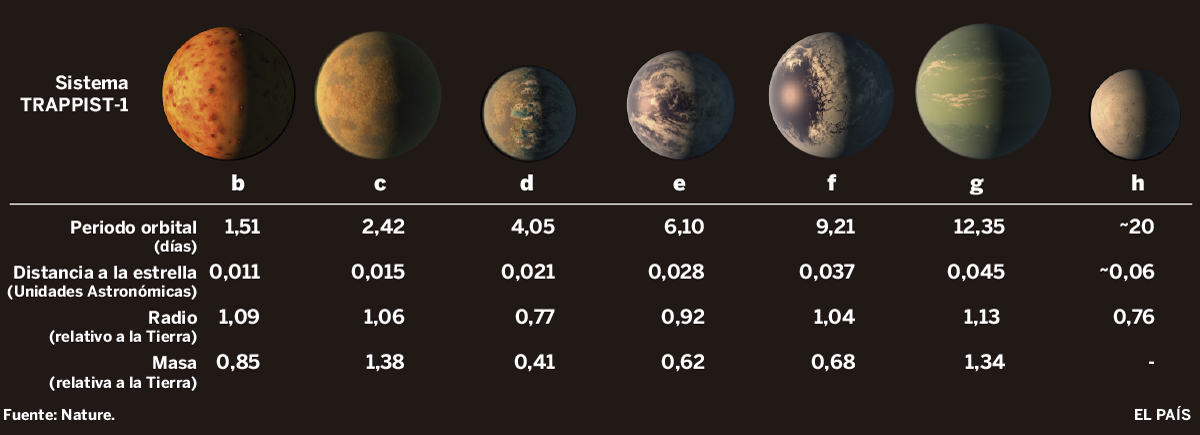

Nuevos cálculos implican la existencia potencial de mucha agua y, lo más importante, de mucha vida. Los planetas situados en la zona habitable de sus estrellas son incalculables, y, como en el Sistema solar, algunos de ellos son aptos para el surgir de la vida.

Los mundos, como todo en el Universo, evolucionan

En esos mundos (como sucedió en la Tierra). Para que la vida surja en un planeta, se necesitan varios parámetros clave: agua en estado líquido, un suministro de energía (como la luz solar o la energía química), y los elementos fundamentales para la vida como carbono, hidrógeno, oxígeno, nitrógeno, fósforo y azufre. hierro…

La Naturaleza se encarga de nutrir a los distintos ecosistemas en las que surgirán diversas formas de vida

Damos por supuesto que al estar en la zona habitable, cuenta con un campo magnético que lo preserva de la radiación ultravioletas y gamma que emiten los vientos estelares de su estrella, la distancia que lo separa de su estrella madre, la masa planetaria que genere una fuerza de Gravedad soportable para la vida, y, debemos suponer que, como sucedió en el planeta Tierra, aquel mundo primigenio evolucionó y se fue enfriando creando mares y océanos, mientras que el agua líquida discurre por los meandros cantarina y transparente para que los elementos químicos hagan su trabajo, es decir, que a partir de la materia “inerte”, pasados miles de millones de años… ¡Surjan formas de vida!

Como hipótesis de trabajo se asume que para que un planeta sea habitable se debe cumplir que tenga una fuente de energía (una estrella o su propio calor interior), una cierta abundancia de átomos esenciales para la vida (C, N, O, P, etc.) y que exista agua en forma líquida. Aplicando estas condiciones a la superficie del planeta, ello permite definir la denominada zona habitable, que es el rango de distancias orbitales alrededor de una estrella donde un planeta tiene un clima estable y su temperatura permite que el agua esté en forma líquida, entre 0 ºC y 100 ºC.

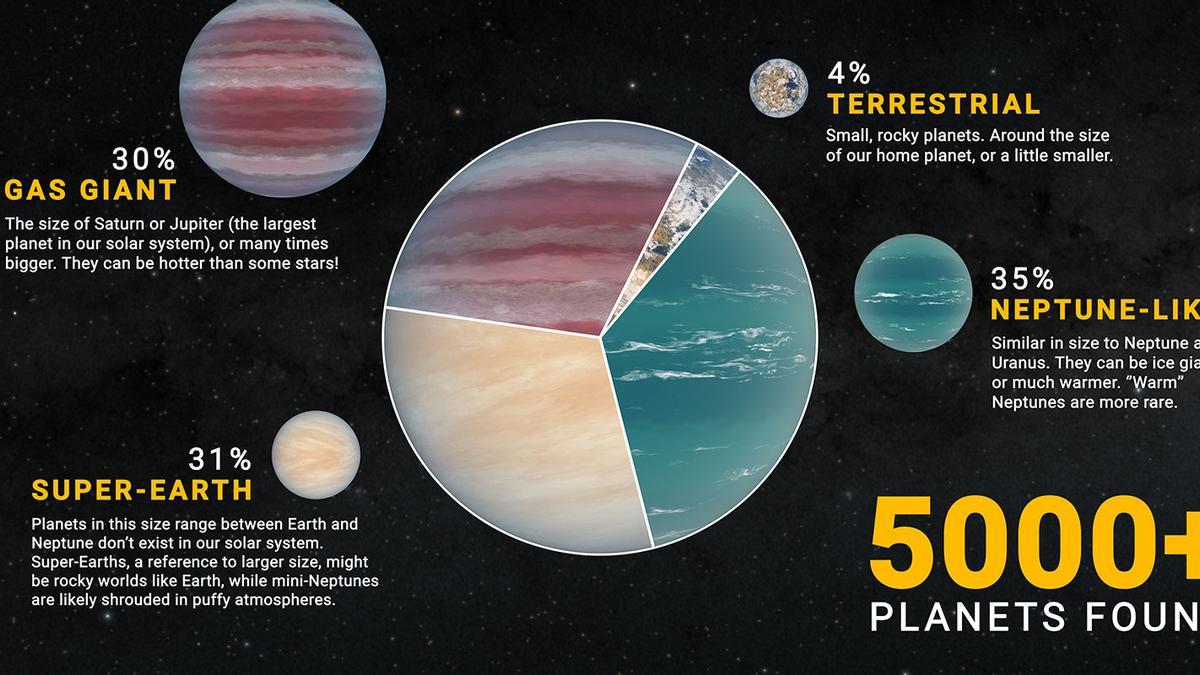

Hasta ahora, los astrónomos han descubierto ya miles de exoplanetas en nuestra galaxia, la Vía Láctea. Mundos lejanos que giran alrededor de otras estrellas y muchos de los cuales, además, forman parte de sistemas planetarios que recuerdan a nuestro Sistema Solar. La sonda Kepler, especialmente diseñada para esta búsqueda, es el instrumento que más planetas extrasolares ha descubierto hasta ahora. Y ha sido precisamente utilizando sus datos como un grupo de investigadores de la Universidad Nacional de Australia y el Instituto Niels Bohr, en Copenhague, ha calculado cuál es la probabilidad de que las estrellas de nuestra galaxia tengan planetas en la zona habitable, esto es, a la distancia precisa de ellas para permitir que exista agua líquida en sus superficies.

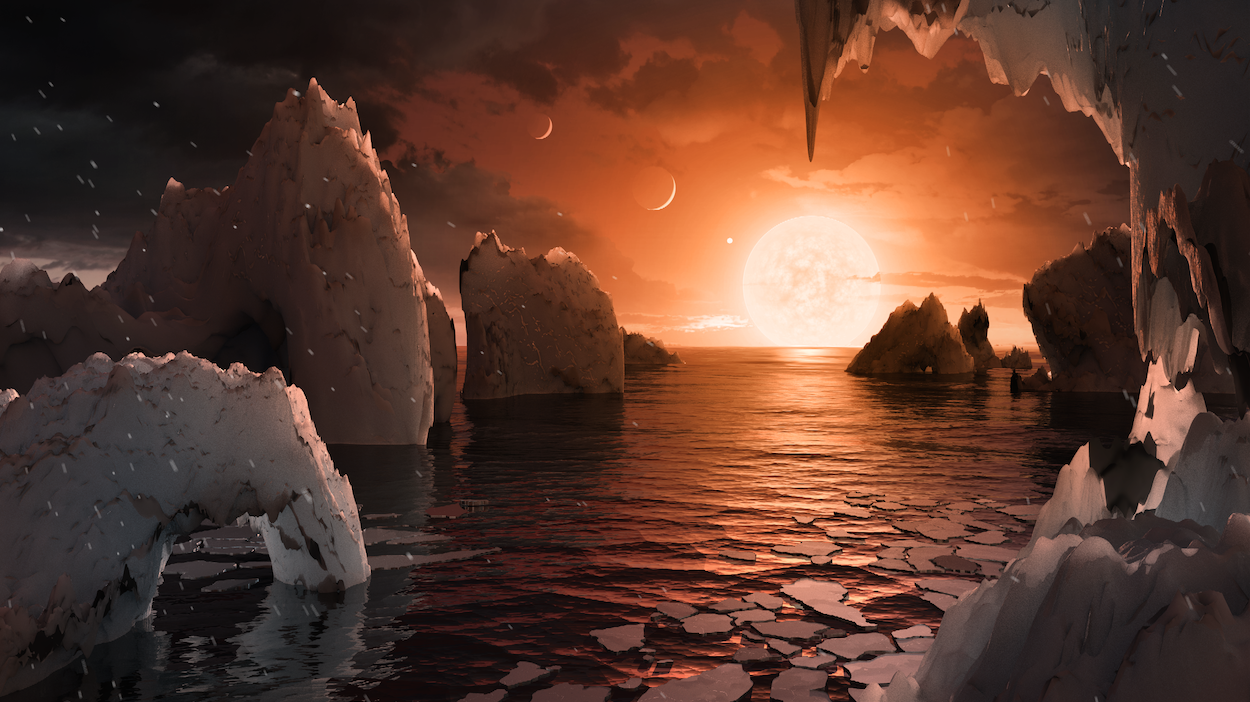

Recreación de la superficie de uno de los planetas de TRAPPIST-1 (NASA/

Los resultados han sido sorprendentes. De hecho, los cálculos muestran que miles de millones de estrellas de nuestra galaxia pueden tener entre uno y tres planetas en sus zonas habitables, lo que implica la existencia potencial de mucha agua y, lo más importante, de mucha vida. El esperanzador estudio se publica hoy en Monthly Notices of the Royal Astronomical Society.

Gracias a los instrumentos del Kepler los astrónomos han descubierto ya cerca de mil planetas alrededor de estrellas de nuestra galaxia y trabajan ahora para confirmar otros tres mil potenciales. Muchas estrellas cuentan con sistemas que contienen entre dos y seis planetas, aunque podría ser que hubiera más fuera del alcance de los instrumentos de la sonda Kepler, que está mejor equipada para buscar mundos grandes y que estén relativamente cerca de sus soles.

Pero los mundos que orbitan muy cerca de sus estrellas suelen ser demasiado calientes para la vida. Por eso, los investigadores han tratado de averiguar si también podría haber mundos algo más lejos de esos soles, en sus zonas habitables, donde el agua y la vida son teóricamente posibles. Para conseguirlo, los autores del estudio han llevado a cabo una serie de cálculos basados en una nueva versión de un método que tiene ya 250 años de antigüedad y que se conoce como la Ley de Titus-Bode.

Una ley planetaria

Formulada alrededor del año 1770, esta ley permitió calcular la posición exacta de Urano mucho antes de que fuera descubierto. La Ley de Titus-Bode afirma que existe una relación entre los periodos orbitales de los distintos planetas de nuestro sistema solar. Así, la relación entre el periodo orbital del primer y segundo planeta es la misma que existe entre el segundo y el tercero, que entre el tercero y el cuarto y así sucesivamente. Por eso, si sabemos cuánto tardan algunos de los planetas en completar una órbita alrededor de su estrella, es posible calcular cuánto tardarían otros planetas que aún no conocemos en hacer lo mismo, lo que nos permitiría calcular su posición.

“Decidimos usar este método para calcular las posiciones potenciales de planetas en 151 sistemas en los que Kepler ya había encontrado entre tres y seis mundos -explica Steffen Kjaer Jacobsen, del Instituto Niels Bohr-. En 124 de los sistemas planetarios, la Ley de Titus-Bode logró fijar la posición de los planetas. Usando el mismo método, intentamos predecir dónde podría haber más planetas algo más externos en esos sistemas solares. Pero sólo hicimos los cálculos para planetas cuya existencia pudiera después ser confirmada con los instrumentos del propio Kepler”.

En 27 de los 151 sistemas planetarios analizados, los planetas observados no se ajustaban, a primera vista, a la Ley de Titus-Bode. Por lo que los investigadores intentaron encajar los planetas en el “patrón” en el que los planetas deberían ubicarse. Luego añadieron los planetas aparentemente “perdidos” entre los que ya eran conocidos y añadieron, por último, un planeta adicional en cada sistema, más allá del mundo más lejano conocido. De este modo, lograron predecir un total de 228 planetas en los 151 sistemas planetarios.

“Hicimos entonces una lista prioritaria con 77 planetas de 40 sistemas planetarios -explica Jacobsen-. Los que tenían más posibilidades de ser vistos por Kepler. Y animamos a otros investigadores a buscar esos mundos. Si los encuentran, sería un indicativo de que el método se sostiene”.

Los planetas más cercanos a sus estrellas están demasiado calientes como para tener agua y vida. Y los más alejados tampoco sirven por todo lo contrario: son demasiado fríos. Pero entre estos extremos está la zona habitable, donde el agua y la vida son teóricamente posibles. Por supuesto, la zona habitable varía de estrella a estrella, y depende de lo grande y brillante que ésta sea.

Por eso, los investigadores calcularon el posible número de planetas en las zonas habitables basándose en esos mundos “extra”, que habían añadido a los 151 sistemas planetarios estudiados siguiendo la Ley de Titus-Bode. Y el resultado fue de entre uno y tres planetas en la zona habitable para cada uno de los sistemas.

Sólidos y con agua líquida

Más allá de los 151 sistemas planetarios analizados, los científicos se fijaron también en otros 31 sistemas en los que ya se ha descubierto algún planeta en las zonas habitables o en los que bastaba con añadir un solo mundo extra para llevar a cabo los cálculos.

“En estos 31 sistemas planetarios -asegura Jacobsen- nuestros cálculos mostraron que tienen una media de dos mundos dentro de la zona habitable. Según las estadísticas y las indicaciones que tenemos, un buen porcentaje de esos planetas serían sólidos, con agua líquida y con posibilidades de albergar vida”.

La Vía Láctea es un “universo en miniatura”

Si extrapolamos estos resultados al resto de nuestra galaxia, significaría que sólo aquí, en la Vía Láctea, podría haber miles de millones de estrellas con planetas en la zona privilegiada para la vida. Jacobsen asegura que lo que pretende ahora es animar a otros investigadores para que rebusquen en los datos de Kepler y comprueben si los planetas predichos por él y su equipo existen realmente y se encuentran en las posiciones calculadas.

Si no ha sucedido… ¿Por qué será?

Lástima que en nuestro Tiempo, aún no estemos preparados para poder recorrer las distancias que nos separan de esos mundos para poder entablar amistad con otros seres. En este punto, me freno, pienso y me pregunto:

¿Si la Naturaleza es sabia, podría ser posible que todo es así porque está supeditado a un plan, y, por el momento, no ha llegado el momento de ese soñado contacto?

Emilio Silvera Vázquez

Abr

27

Misterios del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

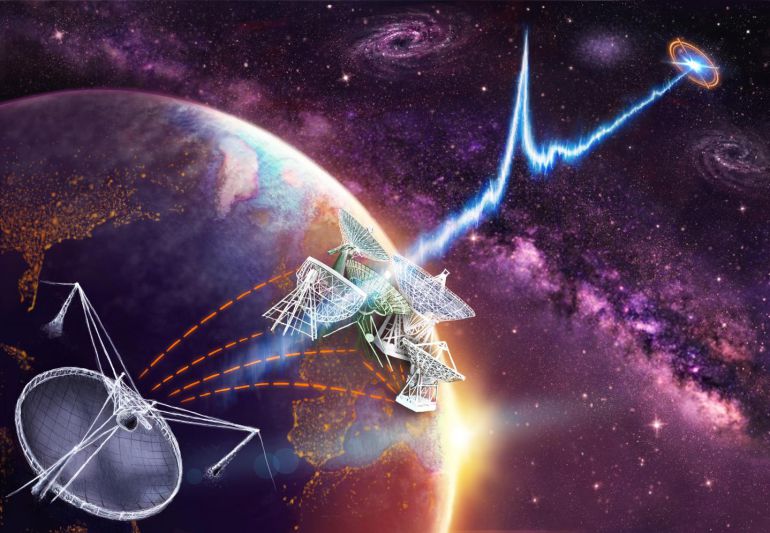

Astrónomos de Estados Unidos afirman que estas emisiones de milisegundos pero de gran potencia provienen de una estrella de neutrones situada a 3.000 millones de años luz, fuera de nuestra Galaxia.

La antenas del Very Large Array (VLA), en EE UU. Cordón Press

Un equipo de astrónomos ha conseguido localizar el origen de unas potentes señales de radio que llevan años intrigando a muchos expertos. Se trata de un fenómeno conocido como estallido rápido de radio (FRB en inglés), que libera en unas fracciones de segundo tanta energía como el Sol en varios días.

Radiotelescopio Parkes, en Australia

En 2007, David Narkevic, un estudiante de física y ciencias políticas en la Universidad de Virginia Occidental (EE UU), fue el primero en descubrir una de estas señales entre los datos recogidos seis años antes por el radiotelescopio Parkes, en Australia. Desde entonces se han detectado otros estallidos similares. Todos duran apenas milisegundos, por lo que ha sido muy difícil aclarar de dónde vienen y qué los produce. Esta incertidumbre ha dado lugar a todo tipo de teorías sobre su origen, desde algunas fundadas como que se trata de cataclismos como el colapso de estrellas de neutrones o la evaporación de agujeros negros, a otras menos probables, como que sean mensajes de civilizaciones alienígenas, ya que algunas parecen seguir una lógica matemática.

“Si nuestros ojos fueran sensibles a las ondas de radio, veríamos iluminarse el cielo [por estas señales] unas dos veces por minuto”, escribe el astrónomo de la Universidad Radboud Heino Falcke hoy en Nature, que le ha dedicado su portada esta semana a este descubrimiento. La dispersión de estas señales de radio a su paso por el espacio indica que los FRB vienen de fuera de la Vía Láctea y que, antes de alcanzar la Tierra, viajan por el universo durante miles de millones de años , lo que los convierte en las señales de radio “más distantes y brillantes, del universo conocido”, resalta Falcke.

/s3.amazonaws.com/arc-wordpress-client-uploads/infobae-wp/wp-content/uploads/2017/10/18174222/GettyImages-831502910.jpg)

Los FRB “han sido objeto de un gran misterio” durante los últimos 10 años que parece una “historia de detectives”, reconoce Joe Lazio, científico del Laboratorio de Propulsión a Chorro de la NASA. Lazio es uno de los 25 astrónomos que acaban de escribir el último capítulo de la saga al estudiar el FRB más enigmático de todos. Se detectó por primera vez en 2012 y, al contrario que el resto de las señales conocidas, que solo se producen una sola vez, esta se ha repetido en varias ocasiones, pero sin un patrón claro. La existencia de este tipo de estallido cuestiona la teoría de que su origen esté en eventos destructivos que suceden una sola vez.

La fuente de estos estallidos está en una galaxia enana y poco brillante

El equipo de Lazio usó la red de telescopios VLA de EE UU para intentar captar de nuevo la señal descubierta en 2012. Después de detectarla recurrieron a la red de telescopios europea VLBI y una similar en EE UU para situar su origen con más precisión que ningún otro estudio anterior. Sus resultados, publicados hoy en Nature y en Astrophysical Journal Letters, muestran que la fuente de estos estallidos está en una galaxia enana y poco brillante, nada parecido a un gran cataclismo cósmico.

“Gracias al espectro medido con los telescopios Gemini [instrumentos ópticos], hemos comprobado que esta galaxia” está “a unos 3.000 millones de años luz de nosotros”, resalta Shami Chatterjee, astrónomo de la Universidad Cornell (EE UU) y coautor de los estudios. “Esto supone que estos estallidos son excepcionalmente potentes, y que han atravesado el medio intergaláctico durante 3.000 millones de años”, añade.

Los investigadores aún no saben qué objeto dentro de esta galaxia está produciendo las señales. “Posiblemente se trata de un fenómeno asociado con un núcleo de galaxia activo o, más probablemente, los enormes pulsos emitidos por un magnetar, una estrella de neutrones joven con un campo magnético extraordinario”, explica Chatterjee. En cualquier caso, “es enormemente improbable que se trate de señales artificiales”, añade. Su objetivo ahora es aclarar el origen exacto de los estallidos analizados y buscar una nueva fuente de FRB repetidos que ayude a zanjar las preguntas sobre el origen de estos fenómenos.

Fuente: El País

Totales: 83.916.234

Totales: 83.916.234 Conectados: 40

Conectados: 40