Oct

24

El Tiempo de Planck y otros

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

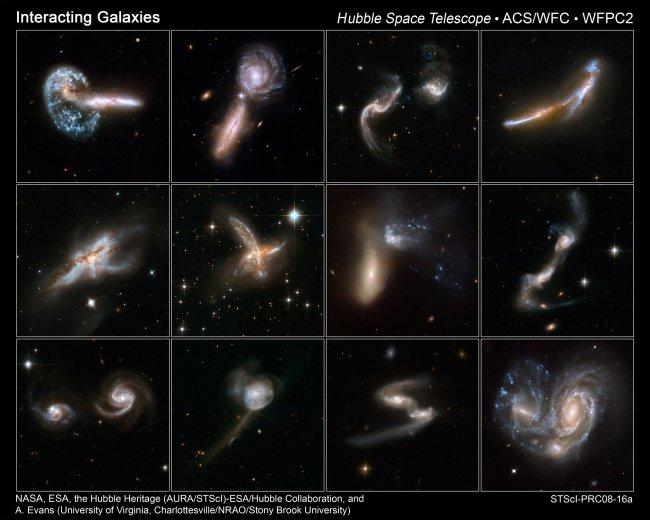

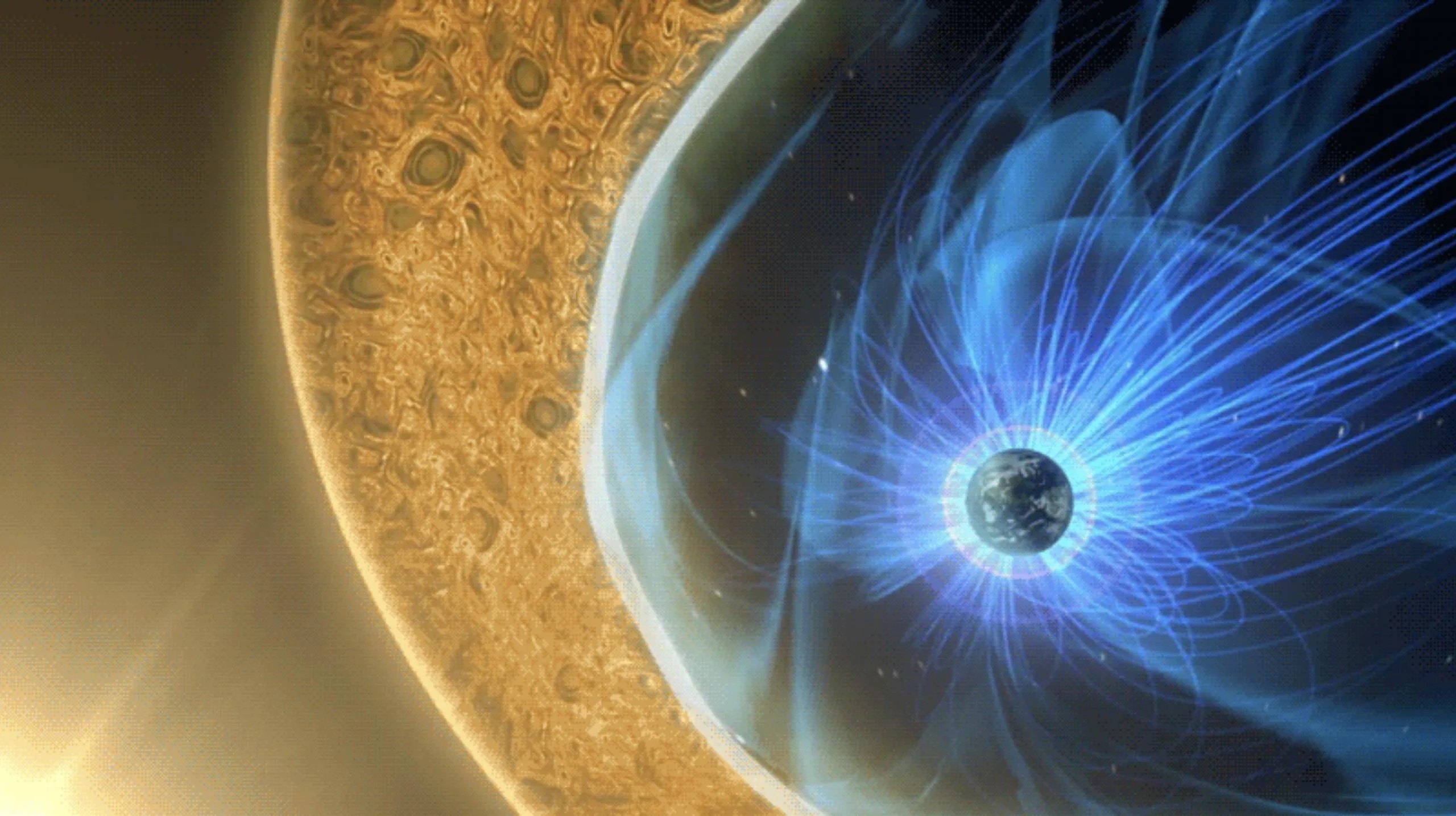

Nuestra estrella gira en torno al centro de la galaxia. Lo hace a una velocidad de 828 000 km/h. Tarda unos 230 millones de años en completar una vuelta a la galaxia (si bien se suele utilizar una franja que va de los 225 a los 250 millones de años). Este concepto es conocido como un año galáctico.

Sí, estamos en…

¡Un Universo dinámico!

El viaje el Sol por la de la Galaxia

Los átomos, las estrellas, las galaxias, el Sol, los seres vivos… Todo está en un movimiento permanente, también el Tiempo es dinámico y no deja de viajar hacia ese Futuro que nunca podremos conocer. Lo dinámico de nuestras vidas lo podemos ver en los cambios que padecemos dese que venimos al mundo, como las estrellas, también nosotros, como sistemas cerrados que somos (a nivel individual), somos afectado por la Entropía que, nunca deja de aumentar, hasta dejarnos sin fuerzas para crear trabajo.

Hemos podido llegar a unas alturas en el mundo de la exploración científica que, nos posibilita reconocer los impactos de los cambios que se producen con el devenir del Tiempo en la Naturaleza y, hemos llegado a comprender que, el Universo, es dinámico. Hacia finales del siglo XIX se había llegado a saber que hubo un tiempo en el que la Tierra, y nuestro Sistema solar, no existían; que la especie humana debía haber cambiado en apariencia y en el promedio de su capacidad mental a lo largo de enormes períodos de tiempo; y que en cierto sentido, amplio y general, el Universo debería estar degradándose, haciéndose un lugar menos hospitalario y ordenado. Durante el siglo XX pudimos ampliar esa imagen de un Universo cambiante y seguimos haciéndolo en el XXI.

Cosas que no todos conocéis

Mileva Marić Ruzić y Einstein

Del familiar Einstein, tan conocidos por todos los aficionados a la Física y también por algunos que no lo son, existen aspectos de su vida que no siempre han sido aireados y, por lo general, son desconocidos para el gran público que sólo sabe de su gran obra y de su esplendor pero, como todos en esta vida, él también pasó por sus momentos bajos y tuvo que sufrir situaciones adversas.

Como alumno, la verdad, no era muy apreciado por sus profesores, el mismo Minkowski, cuando publicó la teoría de la relatividad especial, le recordaba como un alumno poco disciplinado, algo vago y que faltaba a clases para irse a navegar con Mileva Maric, en las clases se aburría. Incluso se cuenta aquella anécdota de su profesor de griego que, viendo lo desaliñado que era y el poco interés que ponía en las clases, llegó a decirle: “muchacho, en esto de la ciencia no llegarás a ninguna parte, es mejor que te dediques a otra cosa”. El hombre pasó a la Historia por sus “proféticas” palabras.

El símbolo del taijitu, la forma más conocida de representar juntos el yin y el yang

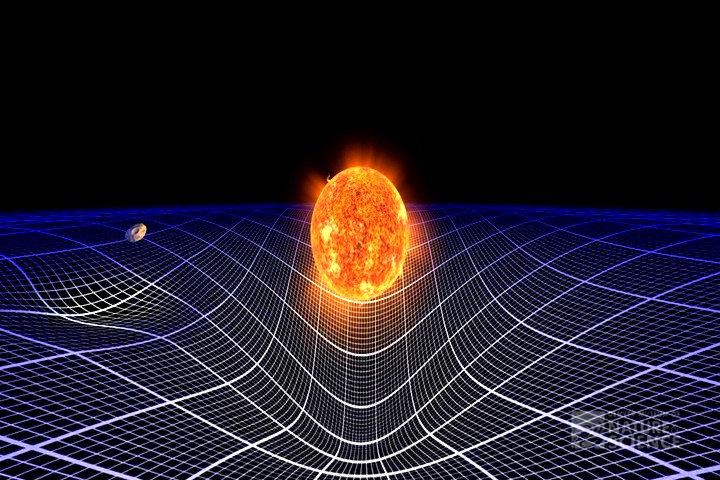

La dinámica de la Fusión nuclear hade que las estrellas se expanda y la Fuerza de Gravedad hace que se contraiga, así, las dos fuerzsas iguales se equilibran y la estrella vive miles de millones de años

Todos los objetos del Universo son el resulta de fuerzas antagónicas que, al ser iguales, se equilibran y consiguen la estabilidad. Las estrellas son el mejor ejemplo: La Gravedad trata de comprimir a la estrella que, mediante la fusión tiende a expandirse y, la lucha de esas dos fuerzas crea la estabilidad.

Estas estructuras, podemos decir que son entidades estables que existen en el Universo. Existen porque son malabarismos estables entre fuerzas competidoras de atracción y repulsión. Por ejemplo, en el caso de un planeta, como la Tierra, hay un equilibrio entre la fuerza atractiva de la Gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e (electrón), h (constante de Planck), G (constante de gravitación) y mp (masa del protón), c (la velocidad de la luz en el vacío). Pero, ¿que es el Tiempo de Planck.

Tiempo de Planck

![]() 10-43 s. = 5.391247(60)×10−43 s

10-43 s. = 5.391247(60)×10−43 s

Es el tiempo que necesita el fotón (viajando a la velocidad de la luz, c, para moverse a través de una distancia igual a la longitud de Planck. Está dado por segundos, donde G es la constante gravitacional (6’672 59 (85) ×10-11 N m2 kg-2), ħ es la constante de Planck racionalizada (ħ = h/2π = 1’054589 × 10-34 Julios segundo) y c es la velocidad de la luz (299.792.458 m/s).

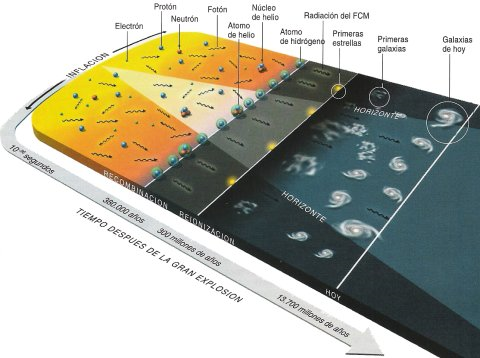

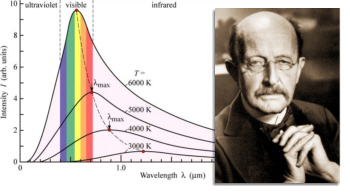

El tiempo de Planck, nombrado en honor al físico alemán Max Planck, es una unidad de tiempo extremadamente breve, es decir aproximadamente:

0.0000000000000000000000000000000000000000001 segundos, una fracción tan diminuta que resulta difícil de imaginar.

Es curioso que hemos podido llegar por diversos medios y experimentos hasta unos momentos después del Big Bang. Sin embargo, nunca pudimos ir más allá del Tiempo de Planck, parece existir una línea invisible que nos impide entrar en aquella fracción de segundo para poder saber lo que pasó. Ningún telescopio por muy potente que sea, ningún acelerador de partículas, nada, ha podido nunca traspasar ese límite.

El valor del tiempo del Planck es del orden de 10-43 segundos. En la cosmología del Big Bang, hasta un tiempo (Tp) después del instante inicial, es necesaria usar una teoría cuántica de la gravedad para describir la evolución del universo.

Como decía antes:

Expresado en números corrientes que todos podamos entender, su valor es 0’000.000.000.000.000.000.000.000.000.000.000.000.000.000.1 de 1 segundo, que es el tiempo que necesita el fotón para recorrer la longitud de Planck, de 10-35 m (veinte órdenes de magnitud menor que el tamaño de del protón de 10-15 metros). el límite de Planck es Lp = √(Għ/c3 ≈ 1’61624 x 10-35 m.

Todo, desde Einstein, es relativo. Depende de la pregunta que se formule y de quién nos de la respuesta.

El tiempo es la escalera con peldaños infinitos que nos llevan hasta el fin de la eternidad…

Si preguntamos ¿Qué es el tiempo?, tendríamos que ser precisos y especificar si estamos preguntando por esa dimensión temporal que no deja de fluir desde el Big Bang y que nos acompaña a lo largo de nuestras vidas, o nos referimos al tiempo:

- Atómico, ese adoptado por el SI, cuya unidad es el segundo y se basa en las frecuencias atómicas, definida a partir de una línea espectral particular de átomo de cesio-133.

- O nos referimos a lo que se conoce como tiempo civil, tiempo coordinado, tiempo de crecimiento, tiempo de cruce.

- Tiempo de integración.

- Tiempo de relajación.

- tiempo dinámico o dinámico de Baricéntrico.

- Dinámico terrestre, tiempo terrestre.

- Tiempo de Efemérides.

- Tiempo de huso horario.

- Tempo estándar.

- tiempo local, tiempo luz.

- Tiempo medio.

- Tiempo de vida media de las cosas y de los seres vivos.

Cada una de estas versiones del tiempo tiene una respuesta diferente, ya que no es lo mismo el tiempo propio que el tiempo sidéreo o el tiempo solar, o solar aparente, o solar medio, o tiempo terrestre, o tiempo universal. Como se puede ver, la respuesta dependerá de cómo hagamos la pregunta.

Al hablar de un reloj atómico de cesio (RAC), nos referimos a un dispositivo que usa como referencia a la frecuencia de emisión del isótopo de cesio 133Cs, donde dicha emisión está medida en la línea espectral de microondas, la cual, se encuentra aproximadamente entre 300 MHz y 30 GHz.

Reloj de Cesio cuyo funcionamiento se basa en la diferencia de energía entre dos estados del núcleo de Cesio-133 cuando se sitúa en un campo magnético. En un tipo, los átomos de cesio-133 son irradiados con radiación de radiofrecuencia, cuya frecuencia es elegida para corresponder a la diferencia de energía entre los dos estados. Es decir, nos valemos de un sistema complejo para determinar lo que el tiempo es basado en lo que de él nos indica la Naturaleza.

En realidad, para todos nosotros el único tiempo que rige es el que tenemos a lo largo de nuestras vidas; los otros tiempos, son inventos del hombre para facilitar sus tareas de medida, de convivencia o de otras cuestiones técnicas o astronómicas pero, sin embargo, el tiempo es sólo uno; ese que comenzó cuando nació el universo y que finalizará cuando éste llegue a su final.

Lo cierto es que para las estrellas supermasivas, cuando llegan al final de su ciclo y dejan de brillar por agotamiento de su combustible nuclear, en ese preciso instante, el tiempo se agota para ella. Cuando una estrella pierde el equilibrio existente entre la energía termonuclear (que tiende a expandir la estrella) y la fuerza de gravedad (que tiende a comprimirla), al quedar sin oposición esta última, la estrella supermasiva se contrae aplastada bajo su propia masa. Queda comprimida hasta tal nivel que llega un momento que desaparece, para convertirse en un agujero negro, una singularidad, donde dejan de existir el “tiempo” y el espacio. A su alrededor nace un horizonte de sucesos, que si se traspasa se es engullido por la enorme gravedad del agujero negro.

Según todos los indicios, la Física nos dice que, al llegar a la singularidad de un agujero negro, no podremos encontrar ni tiempo ni espacio. Es una región que, estando en este mundo, es como si estuviera en otro al que sólo se podrá llegar a través de la teoría tan esperada de la gravedad cuántica. Aquí, en la Singularidad, la Relatividad de Einstein llega y hace mutis por el foro.

El tiempo, de esta manera, deja de existir en estas regiones del universo que conocemos como singularidad. El mismo Big Bang surgió de una singularidad de energía y densidad infinitas que, al explotar, se expandió y creó el tiempo, el espacio y la materia.

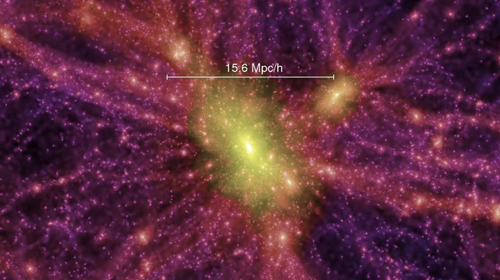

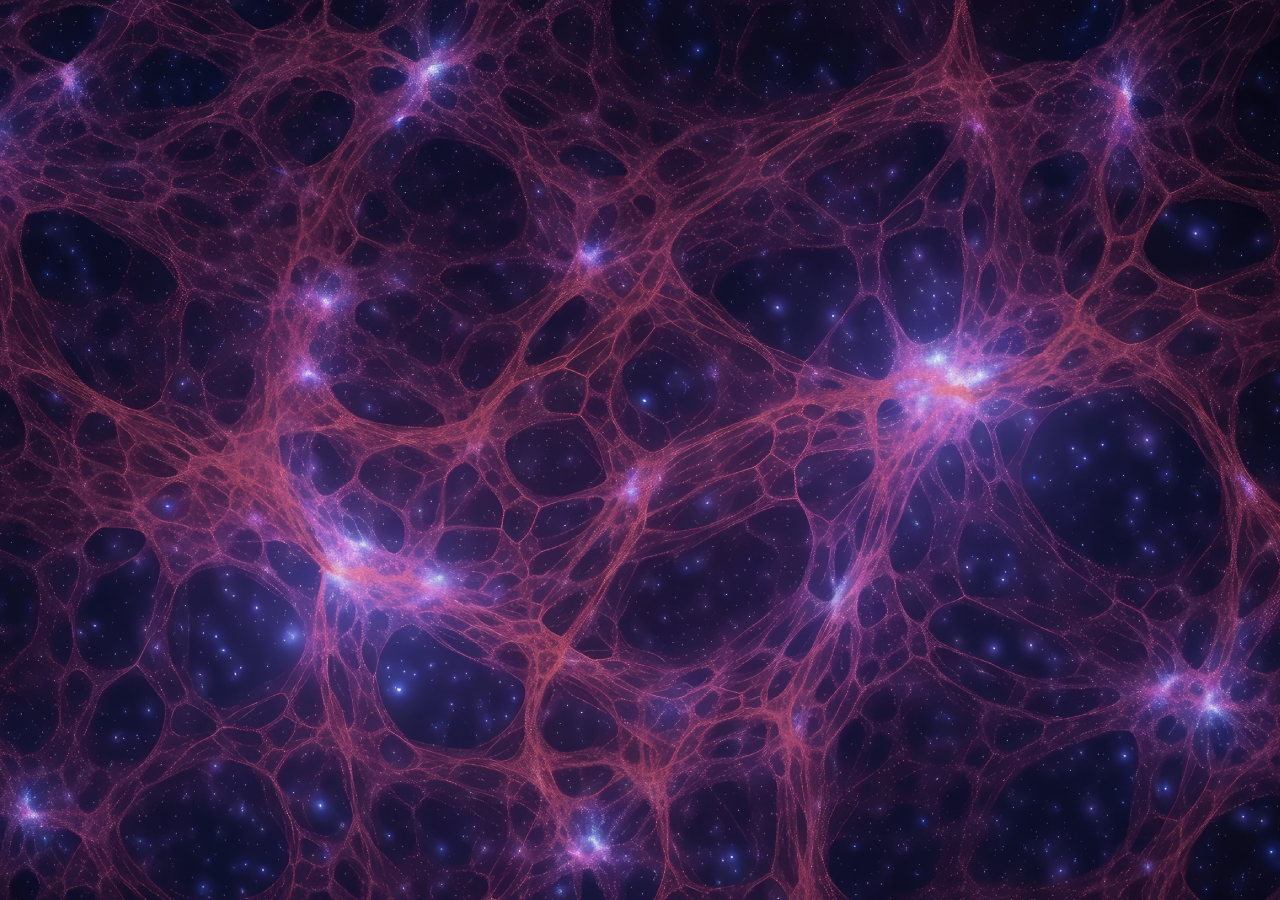

Como contraposición a estas enormes densidades de las enanas blancas, estrellas de neutrones y agujeros negros, existen regiones del espacio que contienen menos galaxias que el promedio o incluso ninguna galaxia; a estas regiones las conocemos como vacío cósmico. Han sido detectados vacíos con menos de una décima de la densidad promedio del universo en escalas de hasta 200 millones de años luz en exploraciones a gran escala. Estas regiones son a menudo esféricas. El primer gran vacío en ser detectado fue el de Boötes en 1.981; tiene un radio de unos 180 millones de años luz y su centro se encuentra aproximadamente a 500 millones de años luz de la Vía Láctea. La existencia de grandes vacíos no es sorprendente, dada la existencia de cúmulos de galaxias y supercúmulos a escalas muy grandes.

Muchos son los misterios que nos quedan por resolver y muchos también los objetos que, estando ahí, aún no han sido localizados. La vastedad del inmenso Universo, hace difícil saber la realidad de todo su contenido y, necesitaremos siglos de estudio y observación para poder acernos, aunque sea mínimamente, a sus secretos.

Mientras que en estas regiones la materia es muy escasa, en una sola estrella de neutrones, si pudiéramos retirar 1 cm3 de su masa, obtendríamos una cantidad de materia increíble. Su densidad es de 1017 Kg/m3; los electrones y los protones están tan juntos que se combinan y forman neutrones que se degeneran haciendo estable la estrella de ese nombre que, después del agujero negro, es el objeto estelar más denso del universo.

Es interesante ver cómo a través de las matemáticas y la geometría, han sabido los humanos encontrar la forma de medir el mundo y encontrar las formas del universo. Pasando por Arquímedes, Pitágoras, Newton, Gauss o Riemann (entre otros), siempre hemos tratado de buscar las respuestas de las cosas por medio de las matemáticas.

Arthur C. Clarke nos decía:

“Magia es cualquier tecnología suficientemente avanzada”

Pero también es magia el hecho de que en cualquier tiempo y lugar, de manera inesperada, aparezca una persona dotada de condiciones especiales que le permiten ver estructuras complejas matemáticas que hacen posible que la humanidad avance considerablemente a través de esos nuevos conceptos que nos permiten entrar en espacios antes cerrados, ampliando el horizonte de nuestro saber.

Recuerdo aquí uno de esos extraños casos que surgió el día 10 de Junio de 1.854 con el nacimiento de una nueva geometría: la teoría de dimensiones más altas que fue introducida cuando Georg Friedrich Bernhard Riemann dio su célebre conferencia en la facultad de la Universidad de Göttingen en Alemania. Aquello fue como abrir de golpe todas las ventanas cerradas durante 2.000 años de una lóbrega habitación que, de pronto, se ve inundada por la luz cegadora de un Sol radiante. Riemann regaló al mundo las sorprendentes propiedades del espacio multidimensional.

La nueva geometría de Riemann nos dijo como era la realidad del espacio, del Universo

Su ensayo, de profunda importancia y elegancia excepcional, “sobre las hipótesis que subyacen en los fundamentos de la geometría” derribó pilares de la geometría clásica griega, que habían resistido con éxito todos los asaltos de los escépticos durante dos milenios. La vieja geometría de Euclides, en la cual todas las figuras geométricas son de dos o tres dimensiones, se venía abajo, mientras una nueva geometría riemanniana surgía de sus ruinas. La revolución riemanniana iba a tener grandes consecuencias para el futuro de las artes y las ciencias. En menos de tres decenios, la “misteriosa cuarta dimensión” influiría en la evolución del arte, la filosofía y la literatura en toda Europa. Antes de que hubieran pasado seis decenios a partir de la conferencia de Riemann, Einstein utilizaría la geometría riemanniana tetradimensional para explicar la creación del universo y su evolución mediante su asombrosa teoría de la relatividad general. Ciento treinta años después de su conferencia, los físicos utilizarían la geometría decadimensional para intentar unir todas las leyes del universo. El núcleo de la obra de Riemann era la comprensión de las leyes físicas mediante su simplificación al contemplarlas en espacios de más dimensiones.

Contradictoriamente, Riemann era la persona menos indicada para anunciar tan profunda y completa evolución en el pensamiento matemático y físico. Era huraño, solitario y sufría crisis nerviosas. De salud muy precaria que arruinó su vida en la miseria abyecta y la tuberculosis. Al igual que aquel otro genio, Ramanujan, murió muy joven.

Emilio Silvera Vázsquez

Oct

16

¿Dónde están las respuestas?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

La vida que surgió de un protoplasma vivo, de la química de los elementos que la conforman, de los lugares que tenían aquellos parámetros que la permitieron, de células que supieron adaptarse y evolucionar hacia una más completa complejidad que, pasó de procariota a eucariota mediante la adhesión de orgánulos y mitocondrias que le dieron un algo valor adaptativo. Ha surgido en el Universo de manera expontánea y, el Azar, bajo ciertas circunstancias muy especiales que estaban presentes en lugares privilegiados del Universo, dio lugar al surgir de la vida tal como la conocemos y, posiblemente, de muchas más formas desconocidas para nosotros. Y, todo eso amigos, es Entropía Negativa. Ahora, Las características de un ser vivo son siempre una recombinación de la información genética heredada que, con el paso del tiempo, sufre alguna mutación que, por lo general, la mejora.

CONSECUENCIA LOGICA: Las variaciones dentro de una misma especie son el resultado de una gran cantidad de información genética presente ya en sus antepasados y, como consecuencia de la lógica evolución, de la aparición espontánea de nueva información genética…

El Universo es igual en todas partes, y, en las mismas circunstancias… ¡Lo que pasó “Aquí” pasará “Allí”.

¡Son posibles tantas cosas!

Algunos quieren encontrar las respuestas en la religión (que si ha sido escogida voluntariamente… ¡bien está!). Pero, como todos sabemos, es cosa de fe. Creer en aquello que no podemos ver ni comprobar no es precisamente el camino de la ciencia que empieza por imaginar, después conjeturar, más tarde teorizar, se comprueba una y mil veces la teoría aceptada a medias y sólo cuando todo está amarrado y bien atado, todas esas fases pasan a la categoría de una ley o norma que se utiliza para continuar investigando en la buena dirección. Einstein solía decir: “La religión sin Ciencia es ciega.”

Otros han sido partidarios de la teoría del caos y argumentan que a medida que el nivel de complejidad de un sistema aumenta, entran en juego nuevos tipos de leyes. Entender el comportamiento de un electrón o un quark es una cosa; utilizar este conocimiento para comprender el comportamiento de un tornado es otra muy distinta. La mayoría está de acuerdo con este aspecto. Sin embargo, las opiniones divergen con respecto a si los fenómenos diversos y a veces inesperados que pueden darse en sistemas más complejos que las partículas individuales son realmente representativos del funcionamiento de los nuevos principios de la física, o si los principios implicados son algo derivado y están basados, aunque sea de un modo terriblemente complicado, en los principios físicos que gobiernan el ingente número de componentes elementales del universo.

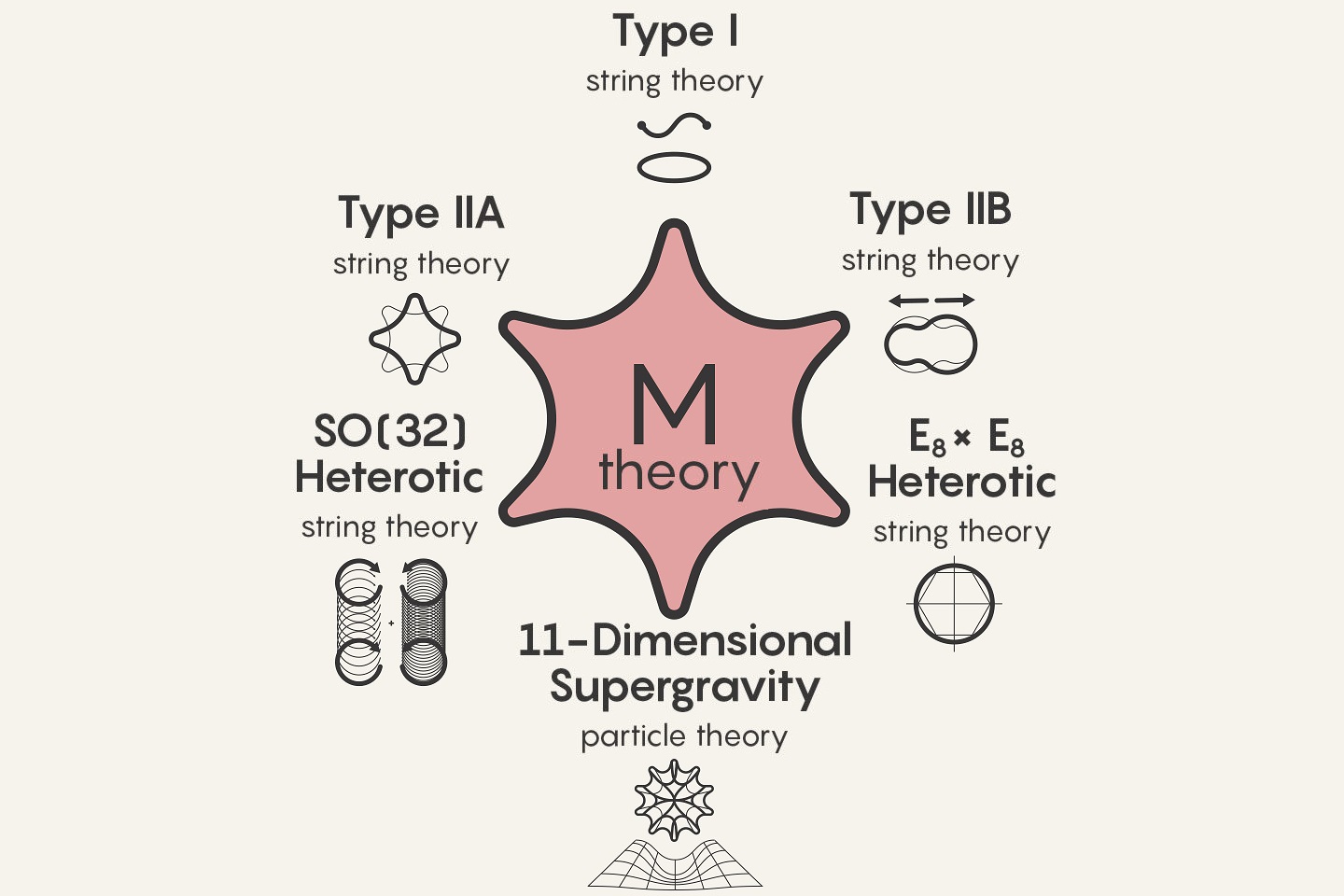

“La teoría del todo o teoría unificada fue el sueño incumplido de Einstein. A este empeñó dedicó con pasíón los últimos 30 años de su vida. No lo logró, y hoy continúa sin descubrirse. Consiste en una teoría definitiva, una ecuación única que dé respuesta a todas las preguntas fundamentales del Universo. Claro que, Einstein no sabía que las matemáticas para plasmar esa Teoría mágica… ¡No se habían inventado en su tiempo ni tampoco en el nuestro!

La teoría del todo debe explicar todas la fuerzas de la Naturaleza, y todas las características de la energía y la materia. Debe resolver la cuestión cosmológica, es decir, dar una explicación convincente al origen del Universo. Debe unificar relatividad y cuántica, algo hasta ahora no conseguido. Y además, debe integrar otros universos en caso de que los haya. No parece tarea fácil. Ni siquiera se sabe si existe una teoría del todo en la Naturaleza. Y, en caso de que exista, si es accesible a nuestro entendimiento y a nuestras limitaciones tecnológicas para descubrirla.”

Hace ya muchos años, estando en Nueva York, paseaba por la 5ª Avenida y, me llamó la atención un escaparate en el que la gente, se arremolinaba. ¿Qué trataban de ver? Curioso me acerqué, y, asombrado ví que miraban las últimas ecuaciones de Einstein de la Teoría del Todo. Nadie entendía nada pero, se pegaban por verlas.

Einstein se pasó los últimos treinta años de su vida en la búsqueda de esa teoría que nunca pudo encontrar. En los escaparates de la 5ª Avenida de Nueva York, exponían sus ecuaciones y la gente, sin entender lo que veían, se arremolinaban ante el cristal para verlas.

:format(jpg)/f.elconfidencial.com%2Foriginal%2F68c%2Fe14%2Fc51%2F68ce14c519946fca88d27a853ea6ce98.jpg)

Casi todo el mundo está de acuerdo en que el hallazgo de la Gran Teoría Unificada (teoría del Todo), no significaría de modo alguno que la psicología, la biología, la geología, la química, y también la física, hubieran resuelto todos sus problemas.

El universo es un lugar tan maravilloso, rico y complejo que el descubrimiento de una teoría final, en el sentido en el que esta planteada la teoría de supercuerdas, no supondría de modo alguno el fin de la ciencia ni podríamos decir que ya lo sabemos todo y para todo tendremos respuestas. Más bien será, cuando llegue, todo lo contrario: el hallazgo de esa teoría de Todo (la explicación completa del universo en su nivel más microscópico, una teoría que no estaría basada en ninguna explicación más profunda) nos aportaría un fundamento mucho más firme sobre el que podríamos construir nuestra comprensión del mundo y, a través de estos nuevos conocimientos, estaríamos preparados para comenzar nuevas empresas de metas que, en este momento, nuestra ignorancia no nos dejan ni vislumbrar. La nueva teoría de Todo nos proporcionaría un pilar inmutable y coherente que nos daría la llave para seguir explorando un universo más comprensible y por lo tanto, más seguro, ya que el peligro siempre llega de lo imprevisto, de lo desconocido que surge sin aviso previo; cuando conocemos bien lo que puede ocurrir nos preparamos para evitar daños.

La búsqueda de esa teoría final que nos diga cómo es el universo, el tiempo y el espacio, la materia y los elementos que la conforman, las fuerzas fundamentales que interaccionan, las constantes universales y en definitiva, una formulación matemática o conjunto de ecuaciones de las que podamos obtener todas las respuestas, es una empresa nada fácil y sumamente complicada; la teoría de cuerdas es una estructura teórica tan profunda y complicada que incluso con los considerables progresos que ha realizado durante los últimos décadas, aún nos queda un largo camino antes de que podamos afirmar que hemos logrado dominarla completamente. Se podría dar el caso de que el matemático que encuentre las matemáticas necesarias para llegar al final del camino, aún no sepa ni multiplicar y esté en primaria en cualquier escuela del mundo civilizado.

Muchos de los grandes científicos del mundo (Einstein entre ellos), aportaron su trabajo y conocimientos en la búsqueda de esta teoría, no consiguieron su objetivo pero sí dejaron sus ideas para que otros continuaran la carrera hasta la meta final. Por lo tanto, hay que considerar que la teoría de cuerdas es un trabajo iniciado a partir de las ecuaciones de campo de la relatividad general de Einstein, de la mecánica cuántica de Planck, de las teorías gauge de campos, de la teoría de Kaluza-Klein, de las teorías de… hasta llegar al punto en el que ahora estamos.

El Universo de lo muy grande y el de lo muy pequeño… ¡Es el mismo universo! Simplemente se trata de mirar en distintos ámbitos del saber, y, la importancia de las medidas… ¡también es relatividad! Porque, ¿podríamos valorar la importancia de los electrones. La existencia de los fotones, o, simplemente la masa del protón? Si alguno de esos objetos fuese distinto, el Universo también lo sería.

La armoniosa combinación de la relatividad general y la mecánica cuántica es un éxito muy importante. Además, a diferencia de lo que sucedía con teorías anteriores, la teoría de cuerdas tiene la capacidad de responder a cuestiones primordiales que tienen relación con las fuerzas y los componentes fundamentales de la naturaleza.

Igualmente importante, aunque algo más difícil de expresar, es la notable elegancia tanto de las respuestas que propone la teoría de cuerdas, como del marco en que se generan dichas respuestas. Por ejemplo, en la teoría de cuerdas muchos aspectos de la naturaleza que podrían parecer detalles técnicos arbitrarios (como el número de partículas fundamentales distintas y sus propiedades respectivas) surgen a partir de aspectos esenciales y tangibles de la geometría del universo. Si la teoría de cuerdas es correcta, la estructura microscópica de nuestro universo es un laberinto multidimensional ricamente entrelazado, dentro del cual las cuerdas del universo se retuercen y vibran en un movimiento infinito, marcando el ritmo de las leyes del cosmos.

Lejos de ser unos detalles accidentales, las propiedades de los bloques básicos que construyen la naturaleza están profundamente entrelazadas con la estructura del espacio-tiempo.

Accede al artículo original espacioprofundo.es/2013/01/11/einstein-tenia-razon-el-espacio-tiempo-es-una-estructura-suave/ © Espacio Profundo

¿Dónde estarán las cuerdas vibrantes? Dicen que se necesita una energía de 1019 GeV para poder verificarlas, y, esa energía corresponde al momento de la creación no disponemos de ella.

Claro que, siendo todos los indicios muy buenos, para ser serios, no podemos decir aún que las predicciones sean definitivas y comprobables para estar seguros de que la teoría de cuerdas ha levantado realmente el velo de misterio que nos impedía ver las verdades más profundas del universo, sino que con propiedad se podría afirmar que se ha levantado uno de los picos de ese velo y nos permite vislumbrar algo de lo que nos podríamos encontrar.

La teoría de cuerdas, aunque en proceso de elaboración, ya ha contribuido con algunos logros importantes y ha resuelto algún que otro problema primordial como por ejemplo, uno relativo a los agujeros negros, asociado con la llamada entropía de Bekenstein-Hawking, que se había resistido pertinazmente durante más de veinticinco años a ser solucionada con medios más convencionales. Este éxito ha convencido a muchos de que la teoría de cuerdas está en el camino correcto para proporcionarnos la comprensión más profunda posible sobre la forma de funcionamiento del universo, que nos abriría las puertas para penetrar en espacios de increíble belleza y de logros y avances tecnológicos que ahora ni podemos imaginar.

Como he podido comentar en otras oportunidades, Edward Witten, uno de los pioneros y más destacados experto en la teoría de cuerdas, autor de la versión más avanzada y certera, conocida como teoría M, resume la situación diciendo que: “la teoría de cuerdas es una parte de la física que surgió casualmente en el siglo XX, pero que en realidad era la física del siglo XXI“.

Witten, un físico-matemático de mucho talento, máximo exponente y punta de lanza de la teoría de cuerdas, reconoce que el camino que está por recorrer es difícil y complicado. Habrá que desvelar conceptos que aún no sabemos que existen.

El hecho de que nuestro actual nivel de conocimiento nos haya permitido obtener nuevas perspectivas impactantes en relación con el funcionamiento del universo es ya en sí mismo muy revelador y nos indica que podemos estar en el buen camino revelador de la rica naturaleza de la teoría de cuerdas y de su largo alcance. Lo que la teoría nos promete obtener es un premio demasiado grande como para no insistir en la búsqueda de su conformación final.

El universo, la cosmología moderna que hoy tenemos, es debida a la teoría de Einstein de la relatividad general y las consecuencias obtenidas posteriormente por Alexandre Friedmann. El Big Bang, la expansión del universo, el universo plano y abierto o curvo y cerrado, la densidad crítica y el posible Big Crunch que, según parece, nunca será un hecho y, el universo, tendrá una “muerte” térmica, es decir, cuando el alejamiento de las galaxias lo haga más grande, más oscuro y más frío. En el cero absoluto de los -273 ºC, ni los átomos se moverán.

Un comienzo y un final que abarcará miles y miles de millones de años de sucesos universales a escalas cosmológicas que, claro está, nos afectará a nosotros, insignificantes mortales habitantes de un insignificante planeta, en un insignificante sistema solar creado por una insignificante y común estrella.

Pero… ¿somos en verdad tan insignificantes.

Claro que, tampoco debemos tomar a pie juntillas todo lo que digamos.

Emilio Silvera V.

Oct

16

La Gravedad… ¡Sigue siendo misteriosa!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

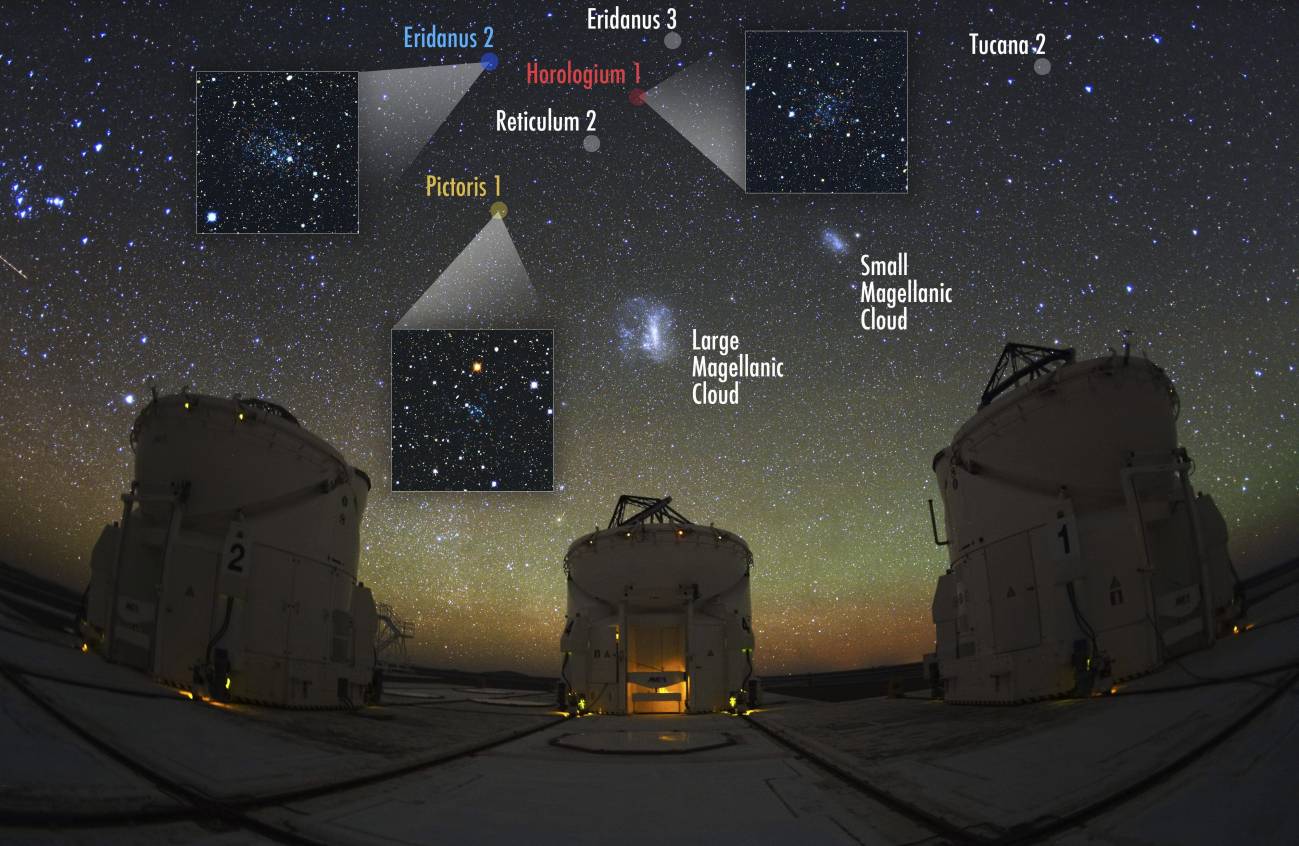

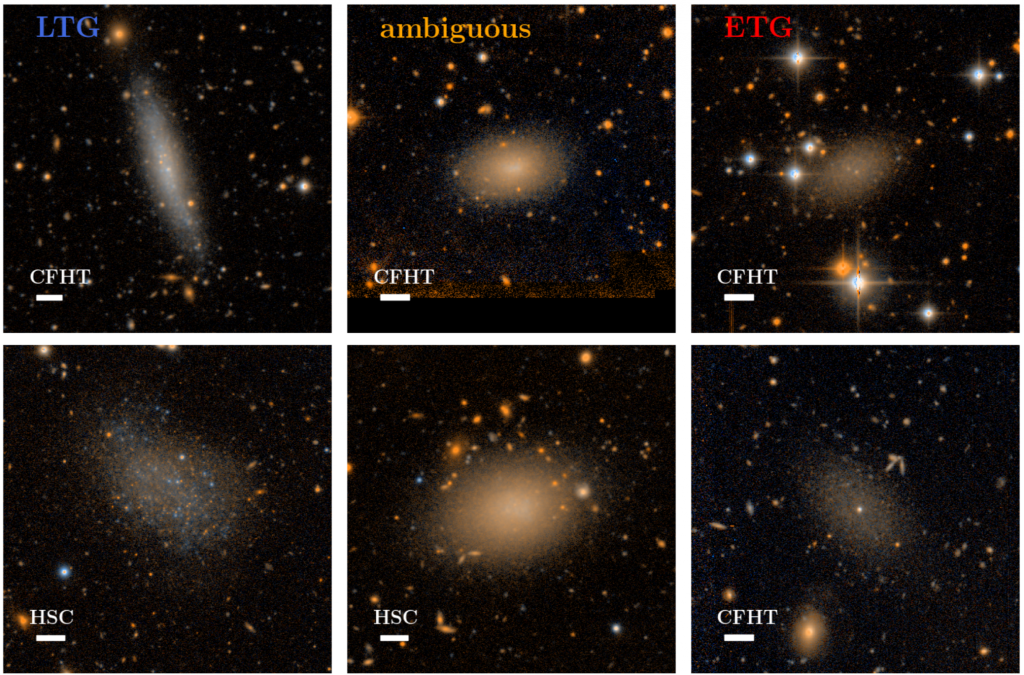

Dos nuevos estudios realizados por investigadores de Australia, Austria y Alemania han puesto en entredicho la forma en la que entendemos la física de la gravedad. Los descubrimientos, publicados en las revistas Astrophysical Journal y Monthly Notices of the Royal Astronomical Society, se basan en observaciones de galaxias enanas satélite o galaxias más pequeñas que se encuentran en el extrarradio de la gran galaxia espiral que es la Vía Láctea.

en la que entendemos la física de la gravedad. Los descubrimientos, publicados en las revistas Astrophysical Journal y Monthly Notices of the Royal Astronomical Society, se basan en observaciones de galaxias enanas satélite o galaxias más pequeñas que se encuentran en el extrarradio de la gran galaxia espiral que es la Vía Láctea.

La Ley de la gravitación universal de Newton, publicada en 1687, sirve para explicar cómo actúa la gravedad en la Tierra, por ejemplo por qué cae una manzana de un árbol. El profesor Pavel Kroupa del Instituto de Astronomía Argelander de la Universidad de Bonn (Alemania) explicó que «a pesar de que su ley describe los efectos cotidianos de la gravedad en la Tierra, las cosas que podemos ver y medir, cabe la posibilidad de que no hayamos sido capaces de comprender en absoluto las leyes físicas que rigen realmente la fuerza de la gravedad».

explicar cómo actúa la gravedad en la Tierra, por ejemplo por qué cae una manzana de un árbol. El profesor Pavel Kroupa del Instituto de Astronomía Argelander de la Universidad de Bonn (Alemania) explicó que «a pesar de que su ley describe los efectos cotidianos de la gravedad en la Tierra, las cosas que podemos ver y medir, cabe la posibilidad de que no hayamos sido capaces de comprender en absoluto las leyes físicas que rigen realmente la fuerza de la gravedad».

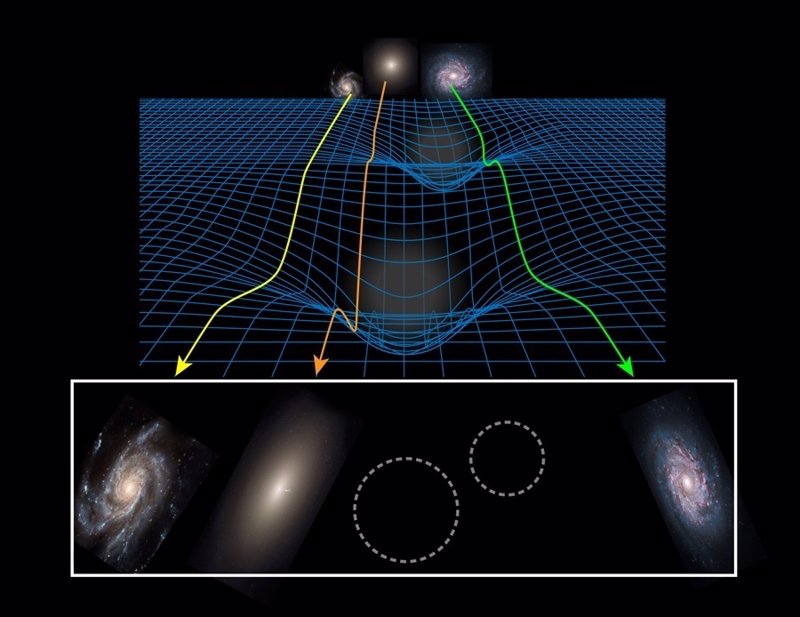

“Imagen compuesta del cúmulo de galaxias CL0024+17 tomada por el telescopio espacial Hubble muestra la creación de un efecto de lente gravitacional. Se supone que este efecto se debe, en gran parte, a la interacción gravitatoria con la materia oscura.”

La ley de Newton ha sido puesta en entredicho por distintos cosmólogos modernos, los cuales han redactado teorías contradictorias sobre la gravitación que intentan explicar la gran cantidad de discrepancias que se dan entre las mediciones reales de los sucesos astronómicos y las predicciones basadas en los modelos teóricos. La idea de que la «materia oscura» pueda ser la responsable de estas discrepancias ha ganado muchos adeptos durante los últimos años

las mediciones reales de los sucesos astronómicos y las predicciones basadas en los modelos teóricos. La idea de que la «materia oscura» pueda ser la responsable de estas discrepancias ha ganado muchos adeptos durante los últimos años . No obstante, no existen pruebas concluyentes de su existencia.

. No obstante, no existen pruebas concluyentes de su existencia.

En esta investigación, el profesor Kroupa y varios colegas examinaron «galaxias enanas satélite», cientos de las cuales deberían existir en la cercanía de las principales galaxias, incluida la Vía Láctea, según indican los modelos teóricos. Se cree que algunas de estas galaxias menores contienen tan sólo unos pocos millares de estrellas (se estima que la Vía Láctea, por ejemplo, contiene más de 200.000 millones de estrellas).

investigación, el profesor Kroupa y varios colegas examinaron «galaxias enanas satélite», cientos de las cuales deberían existir en la cercanía de las principales galaxias, incluida la Vía Láctea, según indican los modelos teóricos. Se cree que algunas de estas galaxias menores contienen tan sólo unos pocos millares de estrellas (se estima que la Vía Láctea, por ejemplo, contiene más de 200.000 millones de estrellas).

Descubiertas nueve galaxias enanas orbitando la Vía Láctea

No obstante, a día de hoy sólo se ha logrado detectar treinta de estas galaxias alrededor de la Vía Láctea. Esta situación se atribuye al hecho de que, al contener tan pocas estrellas, su luz es demasiado débil como para que podamos observarlas desde una distancia tan lejana. Lo cierto es que este estudio tan detallado ha deparado resultados sorprendentes.

una distancia tan lejana. Lo cierto es que este estudio tan detallado ha deparado resultados sorprendentes.

«En primer lugar, hay algo extraño en su distribución», indicó el profesor Kroupa. «Estas galaxias satélite deberían estar distribuidas uniformemente alrededor de su galaxia madre, pero

no es el caso.»

Son abundantes las galaxias enanas que orbitan a la Vía Láctea

Los investigadores descubrieron que la totalidad de los satélites clásicos de la Vía Láctea (las once galaxias enanas más brillantes) están situados prácticamente en un mismo plano que dibuja una especie de disco. También observaron que la mayoría de estas once galaxias rotan en la misma dirección en su movimiento circular alrededor de la Vía Láctea, de forma muy similar a como lo hacen los planetas alrededor del Sol.

muy similar a como lo hacen los planetas alrededor del Sol.

Grupo Local de Galaxias

La explicación de los físicos a estos fenómenos es que los satélites debieron surgir de una colisión entre galaxias más jóvenes. «Los fragmentos resultantes de un acontecimiento así pueden formar galaxias enanas en rotación», explicó el Dr. Manuel Metz, también del Instituto de Astronomía Argelarder. Éste añadió que «los cálculos teóricos nos indican la imposibilidad de que los satélites creados contengan materia oscura».

galaxias más jóvenes. «Los fragmentos resultantes de un acontecimiento así pueden formar galaxias enanas en rotación», explicó el Dr. Manuel Metz, también del Instituto de Astronomía Argelarder. Éste añadió que «los cálculos teóricos nos indican la imposibilidad de que los satélites creados contengan materia oscura».

Estos cálculos contradicen otras observaciones del equipo. «Las estrellas contenidas en los satélites que hemos observado se mueven a mucha más velocidad que la predicha por la Ley de la gravitación universal. Si se aplica la física clásica, esto sólo puede atribuirse a la presencia de materia oscura», aseveró el Dr. Metz.

atribuirse a la presencia de materia oscura», aseveró el Dr. Metz.

Este enigma nos indica que quizás se hayan interpretado de forma incorrecta algunos de los principios fundamentales de la física. «La única solución posible sería desechar la Ley de la gravitación de Newton», indicó el profesor Kroupa. «Probablemente habitemos un universo no Newtoniano. De ser cierto, nuestras observaciones podrían tener explicación sin necesidad de recurrir a la materia oscura.»

incorrecta algunos de los principios fundamentales de la física. «La única solución posible sería desechar la Ley de la gravitación de Newton», indicó el profesor Kroupa. «Probablemente habitemos un universo no Newtoniano. De ser cierto, nuestras observaciones podrían tener explicación sin necesidad de recurrir a la materia oscura.»

Universo sin la materia oscura

Hasta ahora , la Ley de la gravitación de Newton sólo ha sido modificada en tres ocasiones: para

, la Ley de la gravitación de Newton sólo ha sido modificada en tres ocasiones: para incluir los efectos de las grandes velocidades (la teoría especial de la relatividad), la proximidad de grandes masas (la teoría general de la relatividad) y las escalas subatómicas (la mecánica cuántica). Ahora, las graves inconsistencias reveladas por los datos

incluir los efectos de las grandes velocidades (la teoría especial de la relatividad), la proximidad de grandes masas (la teoría general de la relatividad) y las escalas subatómicas (la mecánica cuántica). Ahora, las graves inconsistencias reveladas por los datos obtenidos sobre las galaxias satélite respaldan la idea de que hay que adoptar una «dinámica newtoniana modificada» (MOND) para el espacio.

obtenidos sobre las galaxias satélite respaldan la idea de que hay que adoptar una «dinámica newtoniana modificada» (MOND) para el espacio.

Según un nuevo análisis, unos datos recientes sobre galaxias ricas en gas coinciden exactamente con la predicción hecha por una teoría conocida como MOND, la cual constituye una modificación de la gravedad con respecto a los planteamientos teóricos más aceptados.

Esta predicción, la última de varias hechas a la luz de esta teoría y que han tenido acierto, despierta nuevas dudas sobre la precisión del modelo cosmológico hoy vigente del universo.

predicción, la última de varias hechas a la luz de esta teoría y que han tenido acierto, despierta nuevas dudas sobre la precisión del modelo cosmológico hoy vigente del universo.

De todo esto, lo que sí podemos obtener es una nueva conclusión: ¡De la Gravedad desconocemos muchas cosas! Es la fuerza misteriosa que no se deja “controlar” del todo, como ocurre con las otras tres fuerzas fundamentales de la Naturaleza que, bien sometidas en el Modelo Estándar, dejan al desnudo todos sus misterios, mientras que la Gravedad, no deja que se incluya en el Modelo, y, hasta su Bosón mediador, el hipotético gravitón se niega a ser hallado (si es que realmente existe).

La teoría MOND, propuesta en 1981, modifica la segunda ley de la dinámica de Newton para que con ella se pueda explicar la rotación a velocidad uniforme de las galaxias, que contradice las predicciones newtonianas que afirman que la velocidad de los objetos separados del centro será menor.

Los nuevos descubrimientos poseen implicaciones de gran calado para la física fundamental y para las teorías sobre el Universo. Según el astrofísico Bob Sanders de la Universidad de Groningen (Países Bajos), «los autores de este artículo aportan argumentos contundentes. Sus resultados coinciden plenamente con lo predicho por la dinámica newtoniana modificada, pero completamente contrarios a la hipótesis de la materia oscura. No es normal encontrarse con observaciones tan concluyentes.»

artículo aportan argumentos contundentes. Sus resultados coinciden plenamente con lo predicho por la dinámica newtoniana modificada, pero completamente contrarios a la hipótesis de la materia oscura. No es normal encontrarse con observaciones tan concluyentes.»

Una nueva teoría de la Gravedad podría explicar el movimiento de las estrellas en las galaxias

Claro que, todos estos nuevos derroteros y atisbos de teorías (hay algunas más circulando por ahí), no son más que demostraciones de la insatisfacción que algunos sienten al comprender que…, ¡falta algo! y, yo personalmente en mi modestia y con humildad, me decanto por el simple hecho de que aún, no conocemos a fondo eso que llamamos Gravitación que debe ser mucho más amplia de lo que nos dijo Einstein y, no me extrañaría que, incluso eso que llamamos “materia oscura” no sea otra cosa que un continuo de esa Gravedad, es decir, la parte desconocida y que, al ser ignorantes de su existencia, nos hemos inventado “la materia oscura” para

desconocida y que, al ser ignorantes de su existencia, nos hemos inventado “la materia oscura” para que nos cuadren los números.

que nos cuadren los números.

Para más información, consulte:

Oct

15

La vida cotidiana: incompatible con la relatividad especial y con la...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

En el Espacio suceden cosas extrañas a las que no estamos adaptados, nuestro físico es solo para la Tierra o mundo similar. El Universo se mueve de otra maneta distinta a la nuestra, nuestras vidas cotidianas se desenvuelven a un ritmo lento, el que puede soportar nuestros cuerpos y los órganos que contiene toda su complejidad.

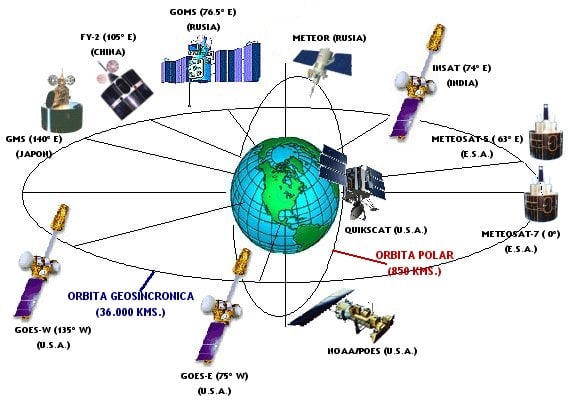

En esos viajes alucinantes, nosotros somos ajenos a dichas velocidades, ya que, son continuas y ni aceleran ni desaceleran, se mantienen uniformes y nos pasan desapercibidas, El Sol viaja como vemos en la imagen de abajo de la izquierda arrastrando a todos los planetas y objetos que contiene el Sistema Solar, la Galaxia también se ve arrastra por la expansión del Universo que se produce a mucha más velocidad que la de la luz, y, tal cosa no viola el límite de c (la velocidad de la luz en el vacío), ya que los objetos arrastrados por la expansión del Universo no se mueven por sí mismos, es como si fuesen montados en una alfombra mágica que viaja a velocidad alucinante.

Estamos confinados en un pequeño planeta, el tercero a partir del Sol, que es parte de un Sistema Planetario situado en la periferia de la Galaxia, en el interior del Brazo de Orión, a 27.000 años luz del Centro Galáctico. Nuestro Ritmo de vida en comparación a como se mueven los objetos celestes, es muy lento. La Tierra gira sobre sí misma a una velocidad de 1.666 Km/h en el Ecuador, y, alrededor del Sol a 107.280 Km/h., el Sistema Solar se mueve alrededor de la Galaxia a una velocidad de 828 000 km/h. Tarda unos 230 millones de años en completar una vuelta a la galaxia. Las observaciones del fondo cósmico de microondas del observatorio espacial europeo Planck sugieren que el universo se expande a un ritmo de unos 67,4 kilómetros por segundo por mega-parsec (una distancia equivalente a 3,26 millones de años-luz).

En la vida cotidiana, donde las velocidades son pequeñas, las diferencias entre alguien que corre y otro que está parado, puede ser tan insignificante que, en realidad, es despreciable. Nuestras capacidad de movernos rápido es muy limitada y, nunca, se podrá comparar con la de los objetos celestes y, mucho menos, con la velocidad de la luz, ese límite que nos impone el Universo y que nos facilita la oportunidad de poder ver galaxias situadas a miles de millones de años-luz tal como eran cuando la luz, partió de ellas hacia nosotros. Algunas de esas galaxias que podemos contemplar, incluso podrían haber dejado de existir.

Otra curiosidad de la relatividad especial es que el objeto que se mueva a la velocidad de la luz se acorta a lo largo de la dirección del movimiento. Por ejemplo, las ecuaciones de la relatividad especial demuestran que un objeto que se mueva aproximadamente al 98 por ciento de la velocidad de la luz, será medido por un observador inmóvil como un 80% más corto que cuando estaba parado, es lo que se conoce como la “Contracción de Lorentz”, que también es totalmente cierta. Pero además, a estas velocidades ocurre otra curiosidad: la masa del objeto aumenta considerablemente, ya que como el universo limita la velocidad que podemos alcanzar a la de la luz, cuando nos estamos acercando a ella, la energía que se traducía antes en velocidad, a partir de cierto punto se convierte en masa. No podemos olvidar que E = mc2, nos dice que la masa es energía y la energía es masa, son dos aspectos de la misma cosa.

Oct

14

La Cuántica… ¿Cuántos caminos tendrá?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (8)

Comments (8)

El mundo de la Física tiene planteado un gran problema y los físicos son muy conscientes de ello, conocen su existencia desde hace décadas. El problema es el siguiente:

Hemos tratado de juntar lo pequeño con lo grande pero… Infinitos son la respuesta

Existen dos pilares fundamentales en los cuales se apoya toda la física moderna. Uno es la relatividad general de Albert Einstein, que nos proporciona el marco teórico para la comprensión del universo a una escala máxima: estrellas, galaxias, cúmulos de galaxias, y aún más allá, hasta la inmensa expansión del propio universo.

|

|

|

El otro pilar es la mecánica cuántica, que en un primer momento vislumbró Max Planck y posteriormente fue desarrollada por W. Heisenberg, Schrödinger, el mismo Einstein, Dirac, Niels Bohr y otros, que nos ofrece un marco teórico para comprender el universo en su escala mínima: moléculas, átomos, y así hasta las partículas subatómicas, como los electrones y quarks.

Durante años de investigación, los físicos han confirmado experimentalmente, con una exactitud casi inimaginable, la practica totalidad de las predicciones que hacen las dos teorías. Sin embargo, estos mismos instrumentos teóricos nos llevan a una conclusión inquietante: tal como se formulan actualmente, la relatividad general y la mecánica cuántica no pueden ser ambas ciertas a la vez.

Nos encontramos con que las dos teorías en las que se basan los enormes avances realizados por la física durante el último siglo (avances que han explicado la expansión de los cielos y la estructura fundamental de la materia) son mutuamente incompatibles. Cuando se juntan ambas teorías, aunque la formulación propuesta parezca lógica, aquello explota; la respuesta es un sinsentido que nos arroja un sin fin de infinitos a la cara.

Así que si tú, lector, no has oído nunca previamente hablar de este feroz antagonismo, te puedes preguntar a que será debido. No es tan difícil encontrar la respuesta. Salvo en algunos casos muy especiales, los físicos estudian cosas que son o bien pequeñas y ligeras (como los átomos y sus partes constituyentes), o cosas que son enormes y pesadas (como estrellas de neutrones y agujeros negros), pero no ambas al mismo tiempo. Esto significa que sólo necesitan utilizar la mecánica cuántica, o la relatividad general, y pueden minimizar el problema que se crea cuando las acercan demasiado; las dos teorías no pueden estar juntas. Durante más de medio siglo, este planteamiento no ha sido tan feliz como la ignorancia, pero ha estado muy cerca de serlo.

No obstante, el universo puede ser un caso extremo. En las profundidades centrales de un agujero negro se aplasta una descomunal masa hasta reducirse a un tamaño minúsculo. En el momento del Bing Bang, la totalidad del universo salió de la explosión de una bolita microscópica cuyo tamaño hace que un grano de arena parezca gigantesco. Estos contextos son diminutos y, sin embargo, tienen una masa increíblemente grande, por lo que necesitan basarse tanto en la mecánica cuántica como en la relatividad general.

Por ciertas razones, las fórmulas de la relatividad general y las de la mecánica cuántica, cuando se combinan, empiezan a agitarse, a traquetear y a tener escapes de vapor como el motor de un viejo automóvil. O dicho de manera menos figurativa, hay en la física preguntas muy bien planteadas que ocasionan esas respuestas sin sentido, a que me referí antes, a partir de la desafortunada amalgama de las ecuaciones de las dos teorías.

Lo grande y lo pequeño, en última instancia, deberían estar juntos en una sola teoría que explicara, esa conexión que ahora se nos va de las manos y de los ojos de la mente que, por mucho que nos esforcemos… Senos escapa. Dicen que en las teorías de 11 dimensiones están tan ricamente instaladas las dos teorías, la cuántica y la relatividad que, allí, no sólo no se rechazan sino que, se complementan en un todo bello y armónico.

Aunque se desee mantener el profundo interior de un agujero negro y el surgimiento inicial del universo envueltos en el misterio, no se puede evitar sentir que la hostilidad entre la mecánica cuántica y la relatividad general está clamando por un nivel más profundo de comprensión.

El Universo es muy complejo y solo estudiante sus partes por separado… ¡Lo vamos entendiendo!

¿Puede ser creíble que para conocer el universo en su conjunto tengamos que dividirlo en dos y conocer cada parte por separado? Las cosas grandes una ley, las cosas pequeñas otra. Bueno, aunque de momento parece que nos tendremos que conformar con eso, finalmente, cuando adelantemos más…

Ver4 unificadas esas dos grandes teorías, la cuántica y la relatividad. estará completo el Modelo estándar

Como otros muchos logros que tenemos pendientes, también la Gravedad cuántica será uno de los que, en el futuro, podremos alcanzar y, para cuando eso suceda, seguramente, también y de manera paralela, habremos podido lograr la manera de vencer mediante una artimaña imaginativa, a la velocidad de la luz.

No, no creo que tengamos que dividir el universo en dos. Creo que eso no puede ser así. Mi opinión es que aún no hemos encontrado la llave que abre la puerta de una teoría cuántica de la gravedad, es decir, una teoría que unifique de una vez por todas las dos teorías más importantes de la física: mecánica cuántica + relatividad general.

La teoría de supercuerdas ha venido a darme la razón. Los intensos trabajos de investigación llevada a cabo durante los últimos 20 años demuestran que puede ser posible la unificación de las dos teorías cuántica y relativista a través de nuevas y profundas matemáticas topológicas que han tomado la dirección de nuevos planteamientos más avanzados y modernos, que pueden explicar la materia en su nivel básico para resolver la tensión existente entre las dos teorías.

En esta nueva teoría de supercuerdas se trabaja en 10, 11 ó en 26 dimensiones, se amplía el espacio ahora muy reducido y se consigue con ello, no sólo el hecho de que la mecánica cuántica y la relatividad general no se rechacen, sino que por el contrario, se necesitan la una a la otra para que esta nueva teoría tenga sentido. Según la teoría de supercuerdas, el matrimonio de las leyes de lo muy grande y las leyes de lo muy pequeño no sólo es feliz, sino inevitable.

Esto es sólo una parte de las buenas noticias, porque además, la teoría de las supercuerdas (abreviando teoría de cuerdas) hace que esta unión avance dando un paso de gigante. Durante 30 años, Einstein se dedicó por entero a buscar esta teoría de unificación de las dos teorías, no lo consiguió y murió en el empeño; la explicación de su fracaso reside en que en aquel tiempo, las matemáticas de la teoría de supercuerdas eran aún desconocidas. Sin embargo, hay una curiosa coincidencia en todo esto, me explico:

Cuando los físicos trabajan con las matemáticas de la nueva teoría de supercuerdas, Einstein, sin que nadie le llame, allí aparece y se hace presente por medio de las ecuaciones de campo de la relatividad general que, como por arte de magia, surgen de la nada y se hacen presentes en la nueva teoría que todo lo unifica y también todo lo explica; posee el poder demostrar que todos los sorprendentes sucesos que se producen en nuestro universo (desde la frenética danza de una partícula subatómica que se llama quark hasta el majestuoso baile de las galaxias o de las estrellas binarias bailando un valls, la bola de fuego del Big Bang y los agujeros negros) todo está comprendido dentro de un gran principio físico en una ecuación magistral.

Einstein se pasó los últimos 30 años de su vida tratando de buscar esa teoría del Todo. Sus ecuaciones se exponían en los escaparates de la 5ª Avenida en Hueva York. La gente se amontonaba para verlas y, aunque no entendía nada, aquellos guarismos les fascinaba.

¿11 dimensiones? ¿Dónde? ¿En el límite de Planck?

Esta nueva teoría requiere conceptos nuevos y matemáticas muy avanzados y nos exige cambiar nuestra manera actual de entender el espacio, el tiempo y la materia. Llevará cierto tiempo adaptarse a ella hasta instalarnos en un nivel en el que resulte cómodo su manejo y su entendimiento. No obstante, vista en su propio contexto, la teoría de cuerdas emerge como un producto impresionante pero natural, a partir de los descubrimientos revolucionarios que se han realizado en la física del último siglo. De hecho, gracias a esta nueva y magnifica teoría, veremos que el conflicto a que antes me refería existente entre la mecánica cuántica y la relatividad general no es realmente el primero, sino el tercero de una serie de conflictos decisivos con los que se tuvieron que enfrentar los científicos durante el siglo pasado, y que fueron resueltos como consecuencia de una revisión radical de nuestra manera de entender el universo.

El primero de estos conceptos conflictivos, que ya se había detectado nada menos que a finales del siglo XIX, está referido a las desconcertantes propiedades del movimiento de la luz.

Isaac Newton y sus leyes del movimiento nos decía que si alguien pudiera correr a una velocidad suficientemente rápida podría emparejarse con un rayo de luz que se esté emitiendo, y las leyes del electromagnetismo de Maxwell decían que esto era totalmente imposible. Einstein, en 1.905, vino a solucionar el problema con su teoría de la relatividad especial y a partir de ahí le dio un vuelco completo a nuestro modo de entender el espacio y el tiempo que, según esta teoría, no se pueden considerar separadamente y como conceptos fijos e inamovibles para todos, sino que por el contrario, el espacio-tiempo era una estructura maleable cuya forma y modo de presentarse dependían del estado de movimiento del observador que lo esté midiendo.

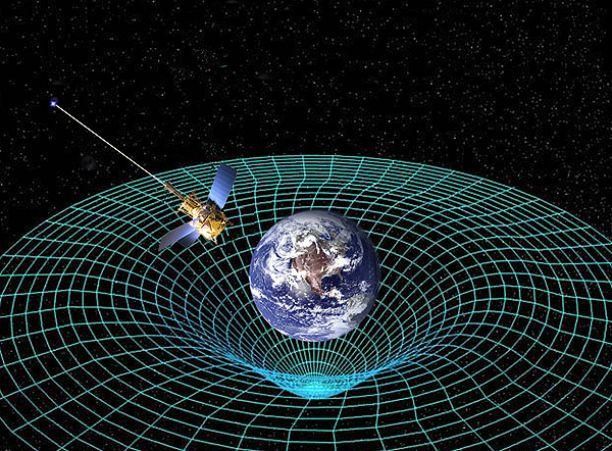

El escenario creado por el desarrollo de la relatividad especial construyó inmediatamente el escenario para el segundo conflicto. Una de las conclusiones de Einstein es que ningún objeto (de hecho, ninguna influencia o perturbación de ninguna clase) puede viajar a una velocidad superior a la de la luz. Einstein amplió su teoría en 1915 – relatividad general – y perfeccionó la teoría de la gravitación de Newton, ofreciendo un nuevo concepto de la gravedad que estaba producida por la presencia de grandes masas, tales como planetas o estrellas, que curvaban el espacio y distorsionaban el tiempo.

Tales distorsiones en la estructura del espacio y el tiempo transmiten la fuerza de la gravedad de un lugar a otro. La luna no se escapa y se mantiene ahí, a 400.000 Km de distancia de la Tierra, porque está influenciada por la fuerza de gravedad que ambos objetos crean y los mantiene unidos por esa cuerda invisible que tira de la una hacia la otra y viceversa. Igualmente ocurre con el Sol y la Tierra que, separados por 150 millones de kilómetros, están influidos por esa fuerza gravitatoria que hace girar a la Tierra (y a los demás planetas del Sistema Solar) alrededor del Sol.

Así las cosas, no podemos ya pensar que el espacio y el tiempo sean un telón de fondo inerte en el que se desarrollan los sucesos del universo, al contrario; según la relatividad especial y la relatividad general, son actores que desempeñan un papel íntimamente ligado al desarrollo de los sucesos.

El descubrimiento de la relatividad general, aunque resuelve un conflicto, nos lleva a otro. Durante tres décadas desde 1.900, en que Max Planck publicó su trabajo sobre la absorción o emisión de energía de manera discontinua y mediante paquetes discretos a los que él llamo cuantos, los físicos desarrollaron la mecánica cuántica en respuesta a varios problemas evidentes que se pusieron de manifiesto cuando los conceptos de la física del siglo XIX se aplicaron al mundo microscópico. Así que el tercer conflicto estaba servido, la incompatibilidad manifiesta entre relatividad general y mecánica cuántica.

La forma geométrica ligeramente curvada del espacio que aparece a partir de la relatividad general, es incompatible con el comportamiento microscópico irritante y frenético del universo que se deduce de la mecánica cuántica, lo cual era sin duda alguna el problema central de la física moderna.

Las dos grandes teorías de la física, la relatividad general y la mecánica cuántica, infalibles y perfectas por separado, no funcionaban cuando tratábamos de unirlas resulta algo incomprensible, y, de todo ello podemos deducir que, el problema radica en que debemos saber como desarrollar nuevas teorías que modernicen a las ya existentes que, siendo buenas herramientas, también nos resultan incompletas para lo que, en realidad, necesitamos.

Emilio Silvera V.

Totales: 84.920.437

Totales: 84.920.437 Conectados: 107

Conectados: 107

![Galaxia espiral UGC 2885. (Foto: Zagursky & McGaugh) [Img #1748]](http://noticiasdelaciencia.com/upload/img/periodico/img_1748.jpg)