Feb

18

La búsqueda de lo escondido

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (5)

Comments (5)

Las fuerzas que podemos sentir en la vida cotidiana, es decir, la Gravedad y el electromagnetismo, aumentan con la cercanía: así, cuando más cerca está un clavo de un imán o una manzana del suelo, más se verán atraídos.

En el mapa aparecen representadas las regiones del planeta en las que la Gravedad es más intensa (rojo) y menos intensa (azul). La intensidad de la gravedad no es constante por toda la superficie de la Tierra y que, por este motivo, nuestro peso puede variar hasta un 0,7% cuando viajamos.

“En el medio en que vivimos, hay campos electromagnéticos por todas partes, pero son invisibles para el ojo humano. Se producen campos eléctricos por la acumulación de cargas eléctricas en determinadas zonas de la atmósfera por efecto de las tormentas. El campo magnético terrestre provoca la orientación de las agujas de los compases en dirección Norte-Sur y los pájaros y los peces lo utilizan para orientarse.”

Por el contrario, la interacción fuerte disminuye cuanto más cerca y juntas están las partículas en el interior de los átomos, aumentando cuando las partículas se alejan las unas de las otras.

El descubrimiento de esta extraña propiedad, llamada libertad asintótica, supuso toda una revolución teórica en los años 70 (se publicó en 1.973), pero ya plenamente respaldada por los experimentos en los aceleradores de partículas, aconsejó, a la Academia, conceder 30 años más tarde, el Premio Nobel de Física a sus autores.

“Ha sido un gran alivio. He estado pensando en ello durante mucho tiempo”, comentó al enterarse de la noticia Franck Wilczek.

“No estaba claro que fuera un adelanto en aquel momento. La teoría que propusimos era descabellada en muchos aspectos y tuvimos que dar muchas explicaciones”, reconoció el investigador.”

Tanto Wilczek como Politzer eran aun aspirantes a doctores en 1.973, cuando publicaron su descubrimiento en Physical Review letters. Junto a su informe, la misma revista incluyó el trabajo de David Gross, que unido al de los dos estudiantes ha dado lugar a la celebrada teoría de la Cromo-dinámica Cuántica (QCD).

Feb

13

El Tiempo que transcurre inexorable

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Relativista ~

Clasificado en Física Relativista ~

Comments (0)

Comments (0)

En la tumba de David Hilbert (1862-1943), en el cementerio de Gotinga (Alemania), dice:

“Debemos saber. Sabremos”.

Estoy totalmente de acuerdo con ello. El ser humano está dotado de un resorte interior, algo en su mente que llamamos curiosidad y que nos empuja (sin que en muchas ocasiones pensemos en el enorme esfuerzo y en el alto precio que pagamos) a buscar respuestas, a querer saber el por qué de las cosas, a saber por qué la naturaleza se comporta de una u otra manera y, sobre todo, siempre nos llamó la atención aquellos problemas que nos llevan a buscar nuestro origen en el origen mismo del universo y, como nuestra ambición de saber no tiene límites, antes de saber de dónde venimos, ya nos estamos preguntando hacia dónde vamos. Nuestra osadía no tiene barreras y, desde luego, nuestro pensamiento tampoco las tiene, gracias a lo cual, estamos en un estadio de conocimiento que a principios del siglo XXI, se podría calificar de bastante aceptable para dar el salto hacia objetivos más valiosos.

Es mucho lo que hemos avanzado en los últimos ciento cincuenta años. El adelanto en todos los campos del saber es enorme. Las matemáticas, la física, la astronomía, la química, la biología genética, y otras muchas disciplinas científicas que, en el último siglo, han dado un cambio radical a nuestras vidas.

Feb

13

¿Por qué Cuerdas? II

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (2)

Comments (2)

Cerramos el comentario de ayer.

Podemos concluir diciendo que las simetrías que vemos a nuestro alrededor, desde un arco iris a las flores y a los cristales, pueden considerarse en última instancia como manifestaciones de fragmentos de la teoría deca-dimensional original. Riemann y Einstein habían confiado en llegar a una comprensión geométrica de por qué las fuerzas pueden determinar el movimiento y la naturaleza de la materia.

Dado el enorme poder de sus simetrías, no es sorprendente que la teoría de supercuerdas sea radicalmente diferente de cualquier otro tipo de física. De hecho, fue descubierta casi por casualidad. Muchos físicos han comentado que si este accidente fortuito no hubiese ocurrido, entonces la teoría no se hubiese descubierto hasta bien entrado el siglo XXI. Esto es así porque supone una neta desviación de todas las ideas ensayadas en este siglo. No es una extensión natural de tendencias y teorías populares en este siglo que ha pasado; permanece aparte.

Por el contrario, la teoría de la relatividad general de Einstein tuvo una evolución normal y lógica. En primer lugar, su autor, postula el principio de equivalencia. Luego reformuló este principio físico en las matemáticas de una teoría de campos de la gravitación basada en los campos de Faraday y en el tensor métrico de Riemann. Más tarde llegaron las “soluciones clásicas”, tales como el agujero negro y el Big Bang. Finalmente, la última etapa es el intento actual de formular una teoría cuántica de la gravedad. Por lo tanto, la relatividad general siguió una progresión lógica, desde un principio físico a una teoría cuántica.

Feb

13

El enigma maravilloso de los cuantos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (2)

Comments (2)

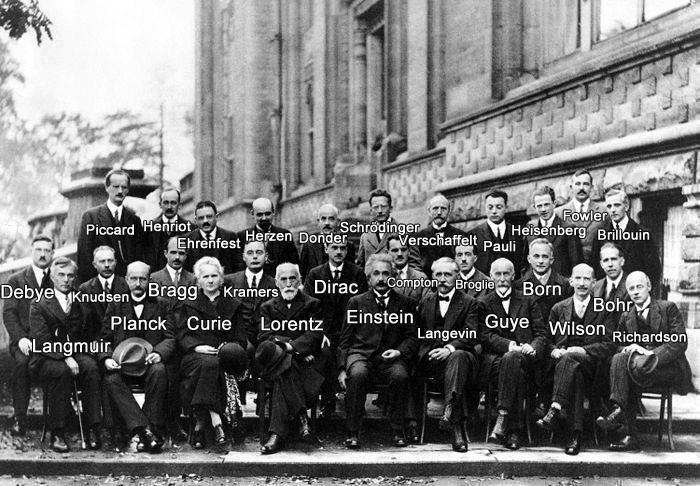

Podríamos decir sin temor a equivocarnos que la Física del siglo XX empezó exactamente en el año 1900, cuando el físico Max Planck propuso, en un artículo de ocho páginas, una posible solución a un problema que había estado intrigando a los físicos durante muchos años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la Naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calos, la así llamada “termodinámica”, o al menos eso parecía. Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para longitudes menores.

Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo” (arriba en la imagen), el objeto está radiando en la zona de la luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitidas en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda y, por lo tanto, proporcional a la frecuencia de la radiación.

E = h x ν,

donde E es la energía del paquete, ν es la frecuencia y h es una nueva constante fundamental de la naturaleza, la Constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

A partir de aquello se comenzó a hablar de la ley de radiación de Planck que proporciona la distribución de energía radiada por un cuerpo negro (cuerpo hipotético que absorbe toda la radiación que incide sobre él. Tiene, por tanto, una absortancia y una emisividad de 1. Mientras que un auténtico cuerpo negro es un concepto imaginario, un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica).

Planck introdujo en la Física el concepto novedoso de que la energía es una cantidad que es radiada por un cuerpo en pequeños paquetes discretos, en vez de en una emisión continua. estos paquetes que se conocieron como cuantos y la ley formulada fue la base de la Teoría cuántica.

“El efecto fotoeléctrico consiste en la emisión de electrones por un material al incidir sobre él una radiación electromagnética.”

Poco tiempo después, en 1905, Einstein formuló esta teoría de una forma más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck.

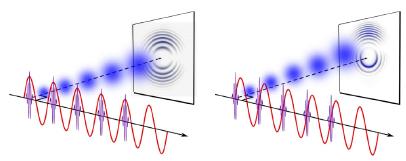

El príncipe francés Louis- Victor de Broglie, dándole otra vuelta a la teoría, que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia, ν, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

Muchas veces hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; tiene una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el universo.

El curioso comportamiento de los electrones en el interior del átomo descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de Broglie. Poco después, en 1926, Erwin Schrödinger descubrió como escribir la teoría ondulatoria de De Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recien descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿Qué significan realmente estas ecuaciones?, ¿Qué es lo que están describiendo? Cuando Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Ecuación de Dirac sobre el electrón

Pero para los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

“Proyecta lo difícil partiendo de donde aún es fácil, realiza lo grande partiendo de donde aún es pequeño, todo lo dificil comienza siempre fácil, todo lo grande comienza siempre pequeño, por eso el sabio nunca hace nada grande y realiza lo grande sin embargo, el arbol de ancho tronco esta ya en el pequeño brote, un gran edificio se basa en una capa de tierra, el camino hacia lo eterno comienza ante tus pies” (Lao Tsé)

Niels Bohr consiguió responder a esta pregunta de forma tal que con su explicación se pudo seguir trabajando, y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica.

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento musical se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”.

Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

La plegaria, la afirmación metafísica, la oración científica, la meditación y la visualización creativa son funciones elevadas de la conciencia humana, y estas funciones interactúan con la realidad de manera específica en el mundo cuántico que es la matriz del mundo material, ya que es aquí donde la energía se convierte en materia. En el preciso instante en que pensamos “estoy contento”, un mensajero químico traduce nuestras emociones, todas las células de nuestro cuerpo entienden nuestro deseo de felicidad y se suman a él.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a esta interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos ahora se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de forma estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (Ψ) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un momento dado.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.

Albert Einstein, Nathan Rosen y Boris Podolski idearon un “Gedankenexperiment”, un experimento hipotético, realizado sobre el papel, para el cual la mecánica cuántica predecía como resultado algo que es imposible de reproducir en ninguna teoría razonable de variables ocultas. Más tarde, el físico irlandés John Stewar Bell consiguió convertir este resultado en un teorema matemático; el teorema de imposibilidad.

Como probablemente algunos de ustedes sospechen, yo todavía creo en la hipótesis de las variables ocultas. Seguramente, nuestro mundo debe estar construido de una forma tan ingeniosa que algunas de las suposiciones que Einstein y otros encontraron tan naturales terminen siendo erróneas. Lo que no puedo imaginar es cómo sucederá esto. En cualquier caso, tener las “variables ocultas” para sostén de mi ignorancia acerca de la mecánica cuántica…, resulta un alivio, ya que, son muchos los teoremas de imposibilidades que nos podemos encontrar por el camino de las cosas que no comprendemos.

emilio silvera

Feb

6

Las Fluctuaciones de vacío, las D-Branas y otros enigmas que deseamos...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

En realidad sabemos que las fluctuaciones de vacío son, para las ondas electromagnéticas y gravitatorias, lo que “los movimientos de degeneración claustrofóbicos” son para los electrones.

Si confinamos un electrón a una pequeña región del espacio, entonces, por mucho que uno trate de frenarlo y detenerlo, el electrón está obligado por las leyes de la mecánica cuántica a continuar moviéndose aleatoriamente, de forma impredecible. Este movimiento de degeneración claustrofóbico que produce la presión mediante la que una estrella enana blanca se mantiene contra su propia compresión gravitatoria o, en el mismo caso, la degeneración de los neutrones, mantiene estable a la estrella de neutrones que, obligada por la fuerza que se genera de la degeneración de los neutrones, es posible frenar la enorme fuerza de gravedad que está comprimiendo a la estrella.

De la misma forma, si tratamos de eliminar todas las oscilaciones electromagnéticas o gravitatorias de alguna región del espacio, nunca tendremos existo. Las leyes de la mecánica cuántica insisten en que siempre quedarán algunas oscilaciones aleatorias impredecibles, es decir, algunas ondas electromagnéticas y gravitatorias aleatorias e impredecibles.

Estas fluctuaciones del vacío no pueden ser frenadas eliminando su energía (aunque algunos estiman que, en promedio, no contienen energía en absoluto).

Totales: 85.890.642

Totales: 85.890.642 Conectados: 49

Conectados: 49