Jun

2

En nuestro Universo: ¡La Eternidad no existe

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (3)

Comments (3)

Resulta imposible frenar el cáncer y a la vez impedir la acumulación de células defectuosas – FOTOLIA

Una fórmula matemática desmonta la idea de que se puede detener el envejecimiento.

Se puede ralentizar, pero no hay ninguna vía de escape para evitarlo: es una característica propia de los organismos multicelulares.

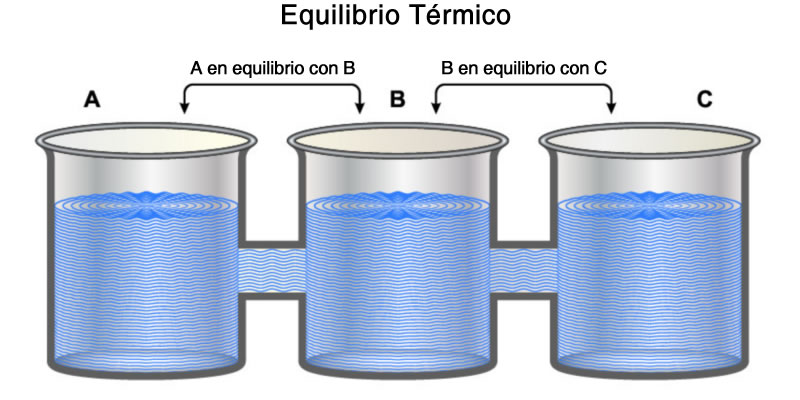

Investigadores de la Universidad de Arizona han probado que es matemáticamente imposible detener el envejecimiento en organismos multicelulares, entre los que están las plantas y los animales. De hecho, han concluido que la senescencia es una característica propia de los seres vivos complejos.

«El envejecimiento es matemáticamente y totalmente inevitable. No hay ninguna vía de escape lógica, teórica ni matemática», ha dicho en un comunicado Joanna Masel, profesora de ecología y biología evolutiva en la Universidad de Arizona y coautora de la investigación.

En un artículo publicado en la revista Proceedings of the National Academy of Sciences, Masel y su colaborador Paul Nelson han aplicado un modelo matemático para simular la evolución de las células de un organismo y han encontrado pruebas de por qué el envejecimiento es «una verdad incontrovertible» y «una propiedad intrínseca de ser multicelular».

Para ello, han simulado el proceso de selección natural, a través del cual los individuos que son más aptos sobreviven con mayor frecuencia que los menos aptos. La idea que trataron de poner a prueba es si se podría evitar el envejecimiento de un organismo complejo si cada una sus células pasara por un fenómeno de selección natural «perfecto» que permitiera «depurar» a todas y cada una de las que son defectuosas o viejas.

Por desgracia, según Masel y Nelson no es posible hacerlo.

Los dos motivos del envejecimiento

El principal impedimento es que el envejecimiento consiste en dos procesos distintos que el organismo no puede frenar a la vez: si bloquease uno, se dispararía el otro, y viceversa. El primero de ellos es la disminución de la velocidad de crecimiento de las células y la pérdida de función de los tejidos: por ejemplo, cuando las células epiteliales envejecen dejan de producir pigmentos y el cabello se blanquea; cuando ocurre lo mismo en el tejido conjuntivo, el organismo deja de regenerar las redes de colágeno y la piel pierde elasticidad y se arruga. El segundo proceso es que algunas células quedan fuera de control y disparan su crecimiento, a veces generando tumores.

No hay forma de frenar ambos fenómenos a la vez: «Si te deshaces de las células que funcionan mal, entonces las células cancerosas proliferan. Pero si te deshaces de las cancerosas, o simplemente las frenas, entonces permites que se acumulen las células defectuosas (…). Puedes hacer una cosa u otra, pero no las dos a la vez», ha dicho Paul Nelson, coautor de la investigación.

«No es nada nuevo que todos vamos a morir; muchas cosas son obvias y muy familiares para todos, pero realmente, ¿por qué envejecemos?», se ha preguntado Masel.

«Nosotros hemos investigado por qué ocurre el envejecimiento, desde la perspectiva de por qué la selección natural no lo ha detenido aún», ha continuado el investigador. La respuesta que ellos han encontrado es que al final, según las matemáticas, tratar de arreglar las cosas solo empeora el proceso.

«Quizás puedas ralentizar el envejecimiento, pero no puedes detenerlo», ha dicho Masel. «Tenemos una demostración matemática de por qué es imposible solucionar los dos problemas (la eliminación de las células defectuosas e impedir el crecimiento de las cancerosas). Puedes arreglar uno pero el otro permanecerá. (…) Y la razón básica es que las cosas se rompen. No importa cuánto lo intentes, no puedes evitarlo».

Quizás no sea un consuelo, pero según este investigador, es algo que todos debemos afrontar: «Es sencillamente algo con lo que lidiar si “quieres” ser un organismo multicelular». A diferencia de ellos, las bacterias son capaces de reparar sus daños en el ADN y cada cierto tiempo se reproducen y generan clones para garantizarse la inmortalidad. Pero, ¿Quién querría ser una bacteria?

May

31

Cosas de la Mecánica Cuántica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

¡La Física! Esa maravilla que está presente en todo lo que podemos ver y en aquello donde la vista no llega. La infinitud de las partículas elementales que forman todo cuanto existe en la Naturaleza, no siempre se dejan ver ni hacen posible que podamos observar las maravillas que pueden llevar a cabo,

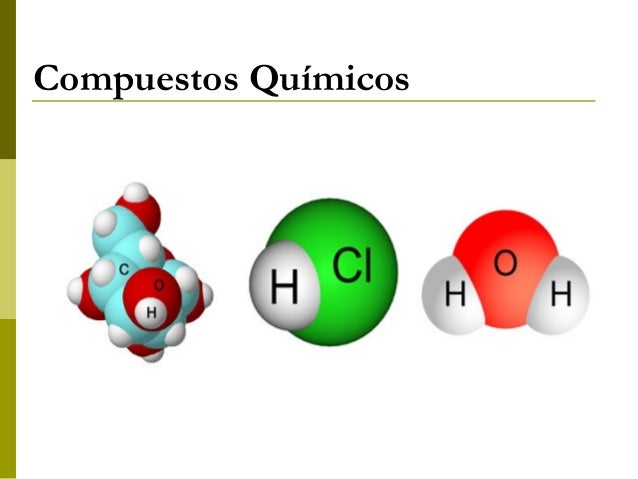

Las sustancias formadas por una sola clase de átomos se llaman elementos químicos, y, si está conformada por distintos átomos, son compuestos. La palabra “átomo” procede del griego ατομος, que significa “indivisible” y el uso de la palabra “elemento” sugiere que se ha llegado a los ladrillos básicos con los que está formada la materia. De hecho, esta es la imagen que se tenía a mediados del siglo XIX cuando se acuñaron estos términos. Sin embargo, hoy sabemos que todo esto es falso, que los átomos se pueden dividir y que, de esta manera, los elementos han dejado de ser verdaderamente elementales. Los físicos continúan con esta nomenclatura aunque sea formalmente incorrecta, ya que, la costumbre, como dicen los juristas, no pocas veces rigen la jerga de las leyes.

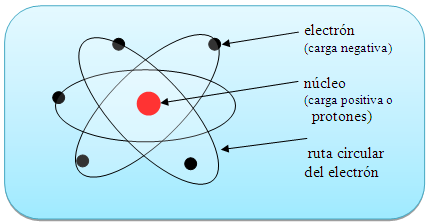

A todo esto y hablando de los átomos, por fuerza, nos tenemos que acordar del electrón que da al átomo su forma esférica. Son partículas cargadas eléctricamente que se mueven alegremente alrededor del núcleo. El electrón es muy ligero: su masa es solamente 1/1.8836 de la del núcleo más ligero (el hidrógeno). La carga eléctrica del electrón es de signo opuesto a la del núcleo, de manera que los electrones están fuertemente atraídos hacia el núcleo y se repelen mutuamente. Si la carga eléctrica total de los electrones en un átomo iguala a la del núcleo, para lo que generalmente se necesitan varios electrones, se dice que el átomo está en equilibrio o que es eléctricamente neutro.

Claro que, no debemos olvidarnos de que, ¡Todo lo grande está hecho de cosas pequeñas! Una inmensa galaxia se conforma de un conjunto inmenso de átomos infinitesimales que juntos, hace ese gran todo.

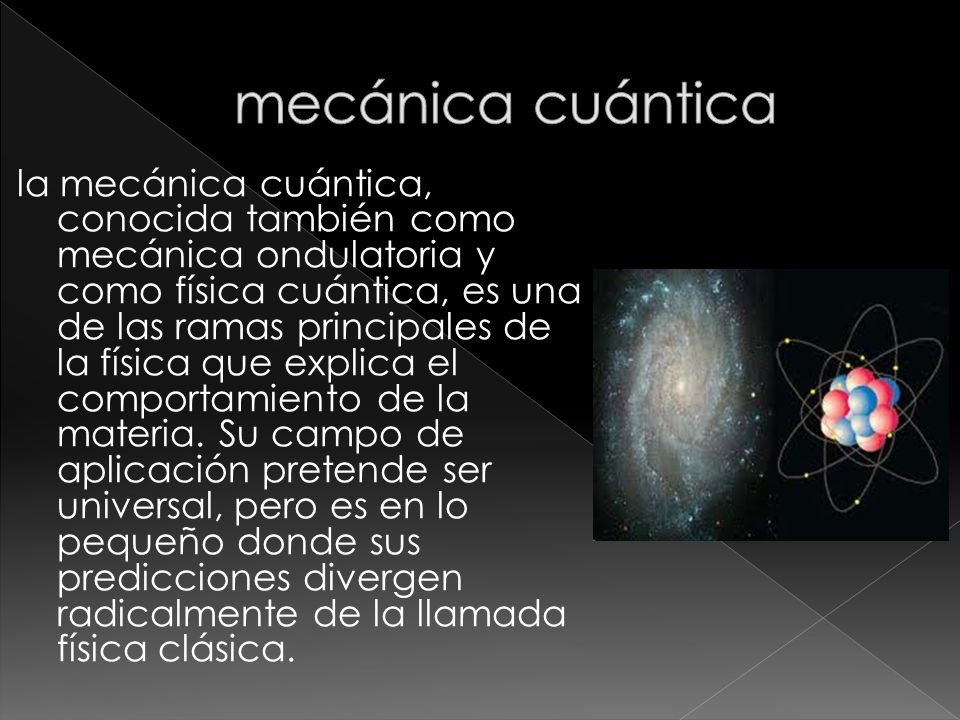

La fuerza a la que obedecen los electrones, la denominada fuerza electrostática o de Coulomb, es matemáticamente bastante sencilla y, sin embargo, los electrones son los responsables de las importantes propiedades de los “enlaces químicos”. Esto se debe a que las leyes de movimiento de los electrones están regidas completamente por la “mecánica cuántica”, teoría que se completó a principios del siglo XX. Es una teoría paradójica y difícil de entender y explicar, pero al mismo tiempo es muy interesante, fantástica y revolucionaria. Cuando uno se introduce en las maravillas de la mecánica cuántica es como si hiciera un viaje a un universo que está situado fuera de este mundo nuestro, ya que, las cosas que allí se ven, desdicen todo lo que dicta nuestro sentido común de cómo tiene que ser el mundo que nos rodea.

La perfecta sincronía Está en la Naturaleza

No solamente los electrones, sino también los núcleos atómicos y los átomos en su conjunto obedecen y se rigen por la mecánica cuántica. La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck, escribió un artículo de ocho páginas y allí propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

Radiación electromagnética

Estaban bien aceptados entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para las longitudes mayores como para las longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de la onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

E = h x v

Donde E es la energía del paquete, v la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Los cuantos de energía están presentes por todas partes y en todos los objetos

El Efecto Foto-eléctrico

Dualidad onda partícula

Los paquetes de energía de Planck

Poco tiempo después, en 1905, Einstein formuló esta teoría de una forma mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos de los paquetes de energía de Planck. El príncipe francés Louis-Víctor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

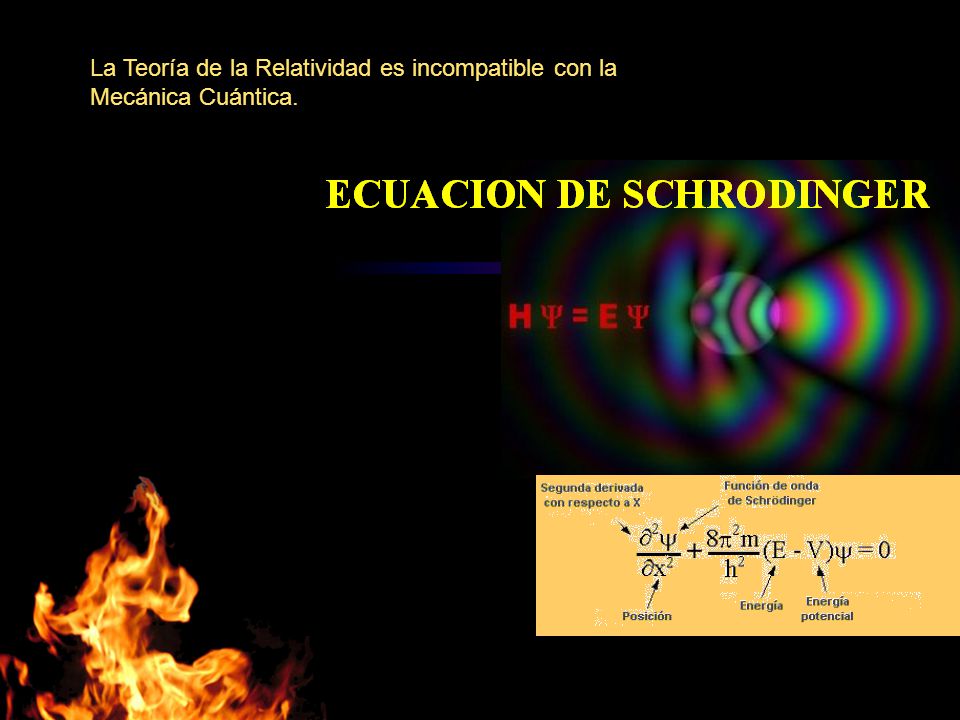

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Erwin Schrödinger descubrió como escribir la teoría ondulatoria de De Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños estaban exactamente determinados por la recién descubiertas “ecuaciones de onda cuánticas”.

14 de diciembre de 1900: Max Planck publica un arículo de ocho páginas y quedó sembrada la semilla de lo que, más tarde, sería la Mecánica Cuántica.

https://youtu.be/bzFWEHaOj0Q

En 1905 y más tarde en 1915, Einstein publicó la Teoría de la Relatividad Especial y General, lo que dio un giro al entendimiento de la Física, y, en la segunda parte, nos trajo una nueva forma de ver y entender el Universo.

Pocas dudas nos pueden caber a estas alturas de que la mecánica cuántica (de Planck) y, la Relatividad –tanto especial como general- (de Einstein), además de ser las dos teorías más importantes de la Física de nuestro tiempo, funcionan de tal forma que uno, cuando profundiza en sus predicciones y las compara con lo que ocurre en el Universo, no puede por menos que, asombrarse, al comprobar como unas mentes humanas han sido capaces de llegar a estos profundos pensamientos que nos acerca a la realidad de la Naturaleza.

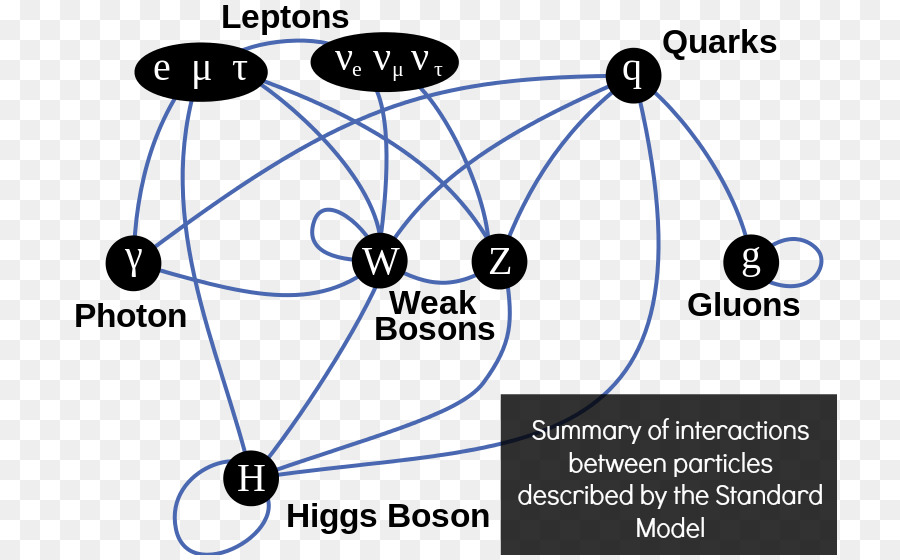

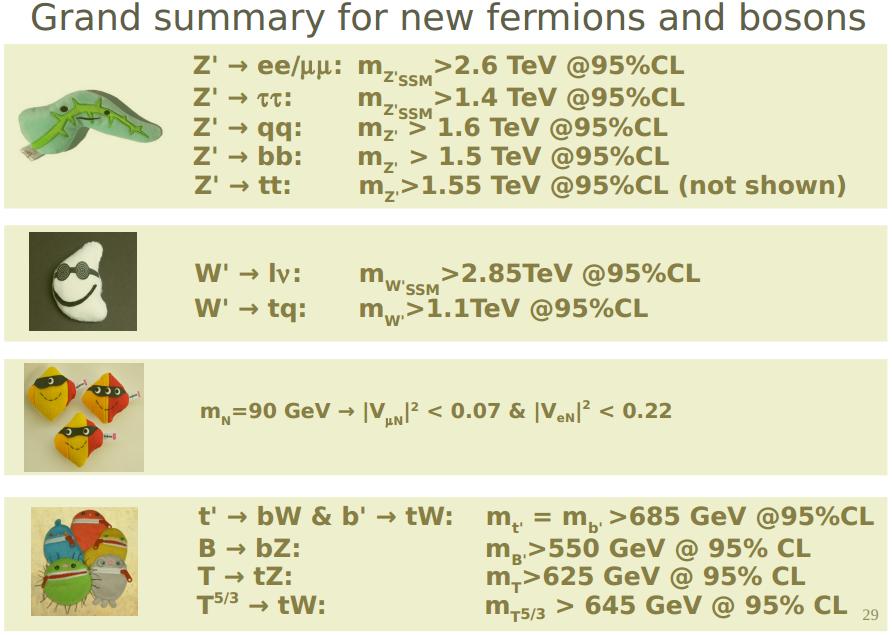

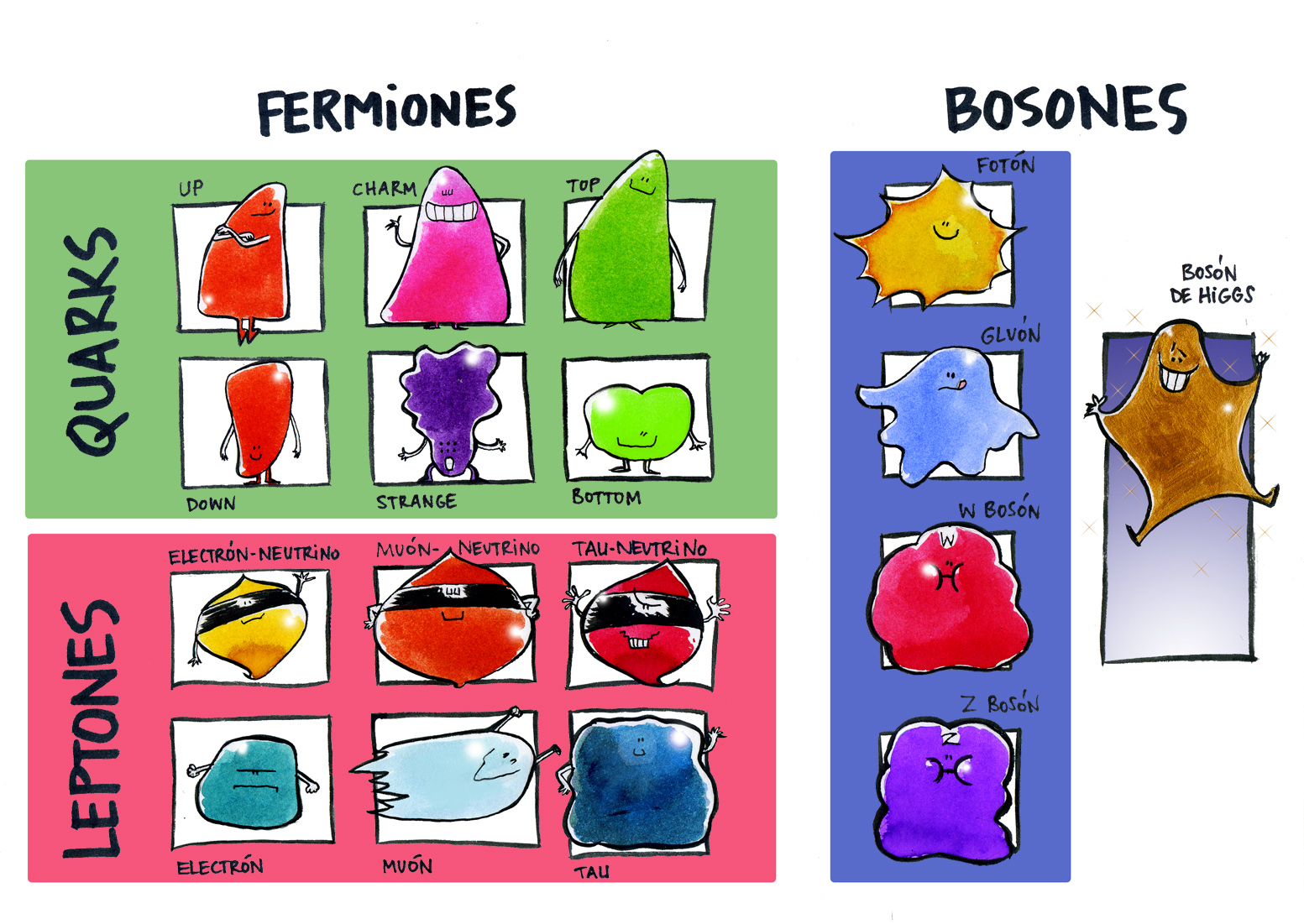

No me parece completa la reseña anterior sin repasar un poco lo que concierne al llamado Modelo Estándar de la Física de partículas, que supone una gran herramienta de trabajo para los físicos.

Precisamente, en los dos últimos comentarios del contertulio Sr. Fandila y otro mío, nos estábamos refiriendo a las teorías y, los dos coincidimos en que, a medida que se avanza y se descubren nuevos parámentros, tienen que ser refinadas para que reflejen de manera más real lo que quieren representar de los fenómenos que vemos en la Naturaleza.

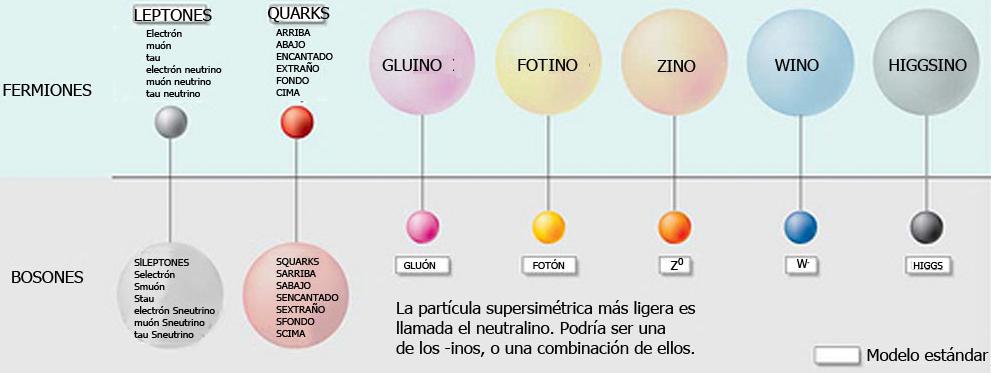

“El modelo estándar de la física de partículas es una teoría relativista de campos cuánticos desarrollada entre 1970 y 1973[cita requerida] basada en las ideas de la unificación y simetrías1 que describe la estructura fundamental de la materia y el vacío considerando las partículas elementales como entes irreducibles cuya cinemática está regida por las cuatro interacciones fundamentales conocidas (exceptuando la gravedad, cuya principal teoría, la relatividad general, no encaja con los modelos matemáticos del mundo cuántico). La palabra “modelo” en el nombre viene del período de los 70 cuando no había suficiente evidencia experimental que confirmara el modelo.1 Hasta la fecha, casi todas las pruebas experimentales de las tres fuerzas descritas por el modelo estándar están de acuerdo con sus predicciones. Sin embargo el modelo estándar no alcanza a ser una teoría completa de las interacciones fundamentales debido a varias cuestiones sin resolver.”

Han pasado 50 años desde que Steven Weinberg y Abdus Salam publicaran aquel artículo en el que formalizaron el llamado Modelo Estándar de las Interacciones Fundamentales. Han sido 5 décadas de actividad científica muy intensa en las que se han realizado toda clase de experimentos para someter a esta teoría a las más complicadas pruebas que nos dijeran si realmente era un modelo que reflejaba la realidad que la naturaleza nos quiere transmitir.

El Modelo Estándar está construido de manera imperfecta, y aunque ha sido y será una herramienta de un enorme rendimiento para los físicos, hay que reconocer que estaba construido con 20 parámetros aleatorios (metidos con calzador) y, de los cuales solo uno de ellos (el Bosón de Higgs) ha sido hallado.

En el modelo estándar que nos habla de las familias de partículas subatómicas que conforman la materia y también de aquellas otras que son intermediarias en la transmisión de las fuerzas fundamentales. Las partículas están divididas en familias como los quarks, los leptones y los hadrones. En realidad, los hadrones que se dividen en bariones y mesones se consideran una clase de subpartículas al estar conformadas por tripletes de quarks los bariones, y, por quarks y anti-quarks los mesones.

Además de las partículas mencionadas, en el Modelo Estándar están incluidas tres de las cuatro fuerzas fundamentales de la Naturaleza: Fuerza Nuclear Fuerte, Fuerza Nuclear Débil y, Electromagnetismo. La cuarta fuerza que es la Gravedad se resiste a reunirse en el modelo con las otras tres, y, precisamente por eso, los físicos están tratando de construir el modelo de la Gravedad Cuántica que por fin, reúna a todas las fuerzas.

Parece (aunque esto será objeto de un artículo a parte) que en la teoría de cuerdas (pendiente de ser verificada) puede subyacer esa teoría cuántica de la gravedad.

La teoría estándar constituye un logro científico de inmensa importancia. A partir de simples postulados de simetría, es posible deducir las propiedades dinámicas de las interacciones electrodébil y fuerte, es decir, el lagrangiano completo que rige las fuerzas entre los constituyentes básicos de la materia, prediciendo así el comportamiento del mundo microscópico, de forma muy precisa y en perfecto acuerdo con las observaciones experimentales.

Más aún, la consistencia matemática de la teoría hizo necesario introducir un nuevo campo de fuerza escalar, el campo de Higgs, del que no teníamos ninguna evidencia empírica hasta que los experimentos realizados en el acelerador de partículas LHC, encontraron el Bosón de Higgs y se consiguió añadir uno de los veinte parámetros aleatorios que tenía el modelo para convertirlo en un parámetro real y muy positivo, de tal manera que 50 años más tarde, lo que era una hipótesis teórica se ha convertido en una realidad tangible.

Desde la perspectiva actual, la Teoría Estándar se obtiene fácilmente a partir de un mínimo número de ingredientes: la existencia de constituyentes elementales de la materia con espín ½, quarks y leptones, y las propiedades de simetría de los campos cuánticos que los describen.

La derivación matemática de su estructura parece tan simple y elegante que se podría llegar a pensar que es el resultado de una idea brillante (¿por qué no se nos había ocurrido antes?). Nada más lejos de la realidad. El desarrollo histórico de la teoría se produjo mediante una concatenación de pequeños pasos, no siempre en la buena dirección, en los que poco a poco se fueron superando grandes dificultades técnicas y conceptuales.

El modelo que formularon Weinberg y Salam en 1967-1968 estaba basado en los desarrollos anteriores realizados por muchos otros científicos. Además, era un modelo solo de leptones y por lo tanto, tal como ahora sabemos, matemáticamente inconsistente debido a anomalías cuánticas. Harían falta todavía algunos años de profunda investigación y nuevas ideas para hacer posible la incorporación de los quarks, dando lugar al modelo definitivo. La celebración de este cincuentenario es una buena oportunidad para analizar retrospectivamente la evolución conceptual que ha permitido alcanzar este gran éxito científico.

Para terminar este trabajo, me retrotraigo a ese “puntito” infinitesimal que es el Núcleo Atómico

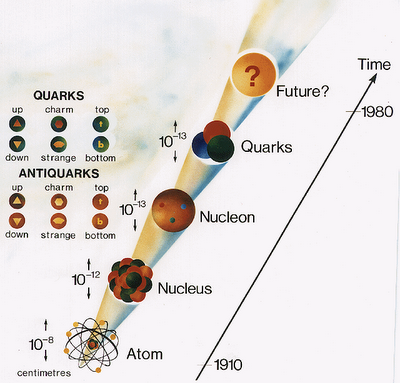

Rutherford con su experimento, descubrió que en el átomo existía un pequeño núcleo cargado positivamente, rodeado de electrones cargados negativamente. Los experimentos sobre la dispersión de partículas pusieron de manifiesto que el núcleo tiene dimensiones del orden de 10-14 m. Dado que el diámetro de un átomo es del orden de 10-10 m, el núcleo ocupa solo una fracción muy pequeña del volumen de un átomo. Sin embargo, el núcleo contiene casi toda la masa del átomo, como también demostraron esos experimentos.

Pero profundicemos un poco más

El núcleo atómico está constituido de los llamados Nucleones (es decir: Protones y Neutrones, partículas no elementales de la familia de los Hadrones en su rama Bariónica). Pero resulta que los nucleones están conformados, al mismo tiempo, por tripletes de partículas elementales de la familia Quarks, un protón tiene en sus entrañas a dos Quarks Up y un Quark Down, mientras que el Neutrón, tiene en su interior a dos Quarks Down y un Quarks Up.

Estos Quarks están allí confinados mediante la fuerza nuclear fuerte (la más potente de las cuatro fuerzas fundamentales), que es la única fuerza que crece con la distancia. Pues bien, la fuerza es transmitida e intermediada por otra familia de partícula que se llaman Bosones, y, aquí aparecen los Gluones que retienen a los Quarks confinados en el interior de los nucleones, y, cuando los Quarks tratan de separarse… ¡La fuerza nuclear aumenta y lo impide! Es lo que se conoce como libertad Asintótica de los Quarks.

Es difícil imaginar como en un espacio tan diminuto como lo es el núcleo atómico, puedan existir tantas cosas y ocurran tantos sucesos, realmente la Naturaleza es Asombrosa.

Emilio Silvera Vázquez

May

30

Si existe la perfección, estará en la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (5)

Comments (5)

Paul Valery

El Universo está construido según un plan cuya profunda simetría está presente de algún modo en la estructura interna de nuestro intelecto. Y, desde luego, si lo pensamos profundamente, tendremos que dar la razón a Paul Valery por tales pensamientos, ya que, la Mente Humana, alcanzó cotas inimaginables. Sin embargo, si realmente existe la perfección, ésta está, en la Naturaleza. Nosotros siempre seremos imperfectos y nos dejaremos llevar por los sentimientos.

¡Agua! El Universo está lleno de agua por todas partes y, si eso es así ¿Qué pasa con la vida?

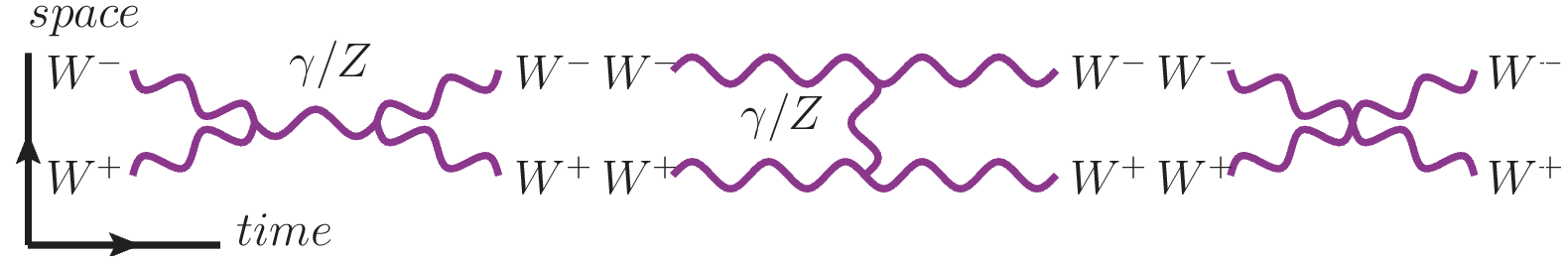

Hubo un tiempo, el el Universo muy temprano, en el que la temperatura estaba encima de algunos cientos de veces la masa del protón, cuando la simetría aún no se había roto, y la fuerza débil y electromagnética no sólo eran la misma matemáticamente, sino realmente la misma. Un físico que hubiera podido estar allí presente, en aquellos primeros momento, no habría podido observar ninguna diferencia real entre las fuerzas producidas por el intercambio de estas cuatro partículas: la W+, la W– , la Z y el Fotón.

Un electrón puede escapar de un átomo si recibe suficiente energía para superar la atracción del núcleo y las fuerzas que lo mantienen unido al átomo. Esto puede ocurrir a través de varios procesos, como la ionización, el efecto fotoeléctrico, o la emisión de radiación beta en núcleos inestables.

Electrones saltarines que saltan de un átomo a otro

Al llegar a escalas cada vez menores, también hemos entrado en ámbitos de energías de unión cada vez mayores. Un átomo puede ser despojado de su electrón aplicando sólo unos miles de electrón-voltios de energía, más para dispersar los nucleones que conforman un núcleo atómico se requieren varios millones de electrón-voltios, y para librar los quarks que constituyen cada nucleón se necesitaría cientos de veces más energía. Así, hemos llegado a comprender que, las estructuras más pequeñas y más fundamentales están ligadas por niveles de energía mayores porque sus estructuras mismas fueron forjadas en el calor del Big Bang.

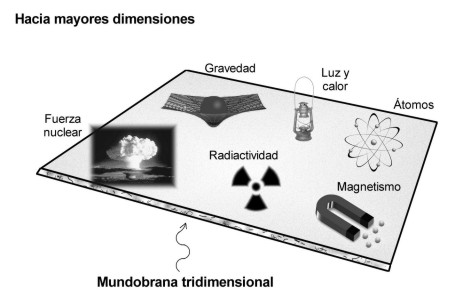

También hemos llegado a comprender que, las fuerzas de la naturaleza que gobiernan la electricidad, el magnetismo, la radiactividad y las reacciones nucleares están confinadas a un “mundo-brana” tridimensional, mientras que la gravedad actúa en todas las dimensiones y es consecuentemente más débil. Seguramente ese será el motivo por el cual, encontrar al Bosón mediador de la fuerza, el Gravitón, resulta tan difícil.

De manera similar, aunque menos clara, las teorías de supersimetrías conjeturaban que las cuatro fuerzas tal vez estaban ligadas por una simetría que se manifestaba en los niveles de energía aún mayores que caracterizaban al universo ya antes del Big Bang. La introducción de un eje histórico en la cosmología y la física de partículas (como decía ayer en uno de los trabajos), beneficio a ambos campos. Los físicos proporcionaron a los cosmólogos una amplia gama de herramientas útiles para saber cómo se desarrolló el universo primitivo. Evidentemente, el Big Bang no fue una muralla de fuego de la que se burló Hoyle, sino un ámbito de sucesos de altas energías que muy posiblemente pueden ser comprensibles en términos de teoría de campo relativista y cuántica.

La cosmología, por su parte, dio un tinte de realidad histórica a las teorías unificadas. Aunque ningún acelerador concebible podrían alcanzar las titánicas energías supuestas por las grandes teorías unificadas y de la supersimetría, esas exóticas ideas aún pueden ser puestas a prueba, investigando si las partículas constituyentes del universo actual son compatibles con el tipo de historia primitiva que implican las teorías. Las partículas elementales aparentemente proporcionan las claves de algunos de los misterios fundamentales de la Cosmología temprana… y resulta que la Cosmología brinda una especia de terreno de prueba para alguna de las ideas de la física de partículas elementales. Esto implica que los aceleradores de partículas, como los telescopios, funcionen como máquinas del tiempo. Un telescopio penetra en el pasado en virtud del tiempo que tarda la luz en desplazarse entre las estrellas; un acelerador recrea, aunque sea fugazmente, las condiciones que prevalecían en el Universo primitivo.

Moléculas, átomos y conexiones para formar pensamientos que nos llevaron hacia los conocimientos que hoy, tras muchos miles de millones de años de evolución del Universo, hizo posible la aparición de especies que, tras miles de años de experiencia, de observación, y, de imaginar…, llegó a conseguir la intuición necesaria para presentir que, formamos parte de un todo inmenso del que sólo somos una parte, la que piensa. También la que tiene que descubrir, los secretos de la Naturaleza, en ello, le va la existencia en el futuro.

Hemos aprendido que cuanto más íntimamente examinemos la Naturaleza, tanto más lejos hacia atrás vamos en el tiempo. Alguna vez he puesto el ejemplo de mirar algo que no es familiar, el dorso de la mano, por ejemplo, e imaginemos que podemos observarlo con cualquier aumento deseado.

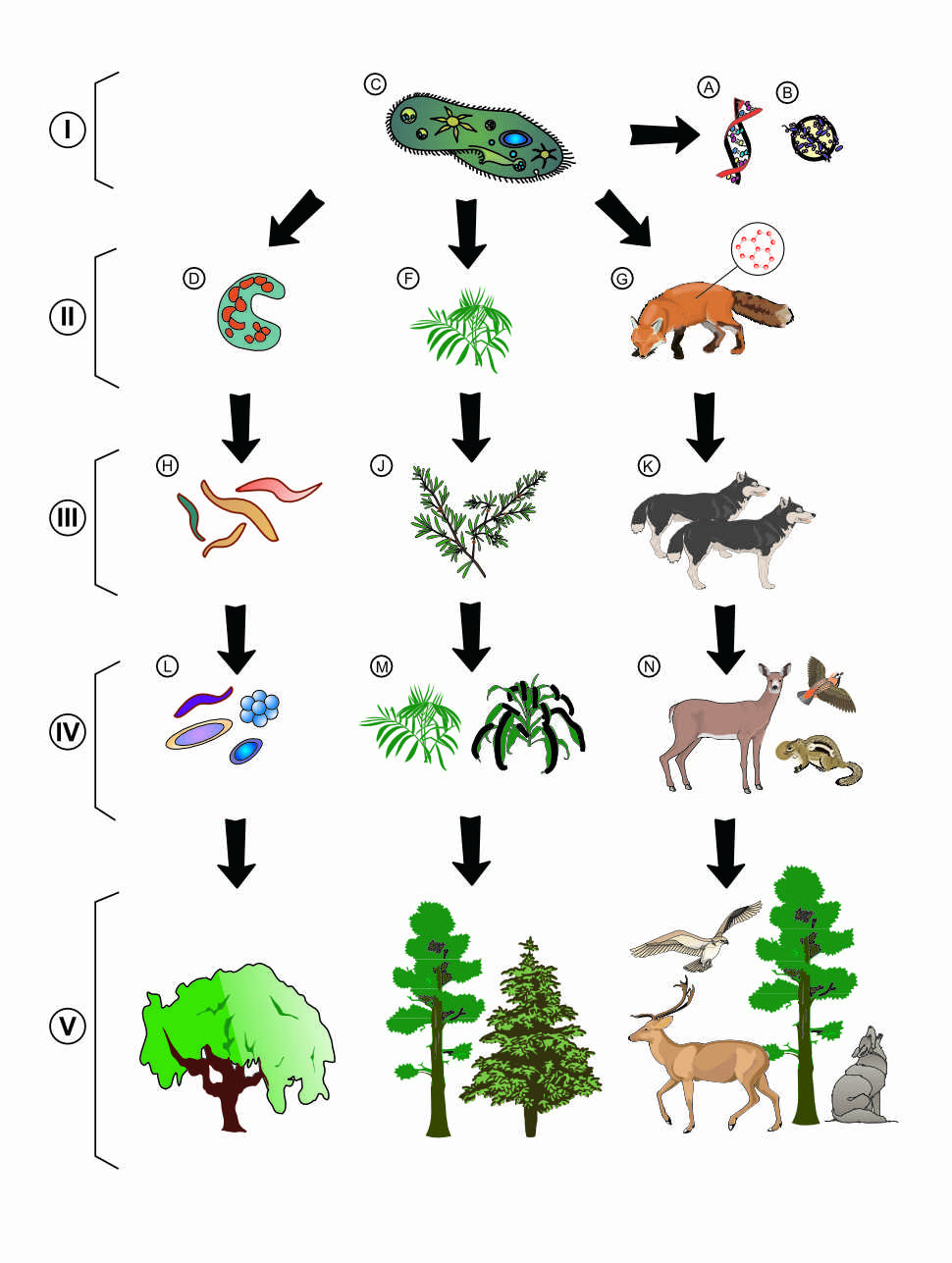

Con un aumento relativamente pequeño, podemos ver las células de la piel, cada una con un aspecto tan grande y complejo como una ciudad, y con sus límites delineados por la pared celular. Si elevamos el aumento, veremos dentro de la célula una maraña de ribosomas serpenteando y mitocondrias ondulantes, lisosomas esféricos y centríolos, cuyos alrededores están llenos de complejos órganos dedicados a las funciones respiratorias, sanitarias y de producción de energía que mantienen a la célula.

Ya ahí tenemos pruebas de historia. Aunque esta célula particular solo tiene unos pocos años de antigüedad, su arquitectura se remonta a más de mil millones de años, a la época en que aparecieron en la Tierra las células eucariota o eucarióticas como la que hemos examinado.

Hemos llegado a poder discernir la relación directa que vincula el tamaño, la energía de unión y la edad de las estructuras fundamentales de la Naturaleza. Ahora, hemos llegado a comprender muchas de las cosas que, hasta bien poco tiempo, eran auténticos secretos que, el Universo, celosamente se guardaba, y, esa comprensión, nos llevará más lejos y nos permitirá realizar un largo camino hacia el corazón mismo de la materia, donde según parece, pueden residir objetos infinitesimales, más pequeños que los Quarks, en esa distancia inalcanzable ahora que hemos llamado, el Límite de Planck.

Aún estamos en el camino, no hemos podido llegar más lejos y, con la ayuda de los aceleradores hemos podido llegar hasta una diez billonésima de segundo después del big bang que es menos que un pestañeo con los párpados en toda la historia humana registrada. A pesar de ello, extrañamente, la investigación de la evolución del Universo recién nacido indica que ocurrieron muchas cosas aún antes, durante la primera ínfima fracción de un segundo. Todos los teóricos han tratado de elaborar una explicación coherente de los primeros momentos de la historia cósmica. Por supuesto, sus ideas fueron esquemáticas e incompletas, muchas de sus conjeturas, sin duda, se juzgaran deformadas o sencillamente erróneas, pero constituyeron una crónica mucho más aclaradora del Universo primitivo que la que teníamos antes.

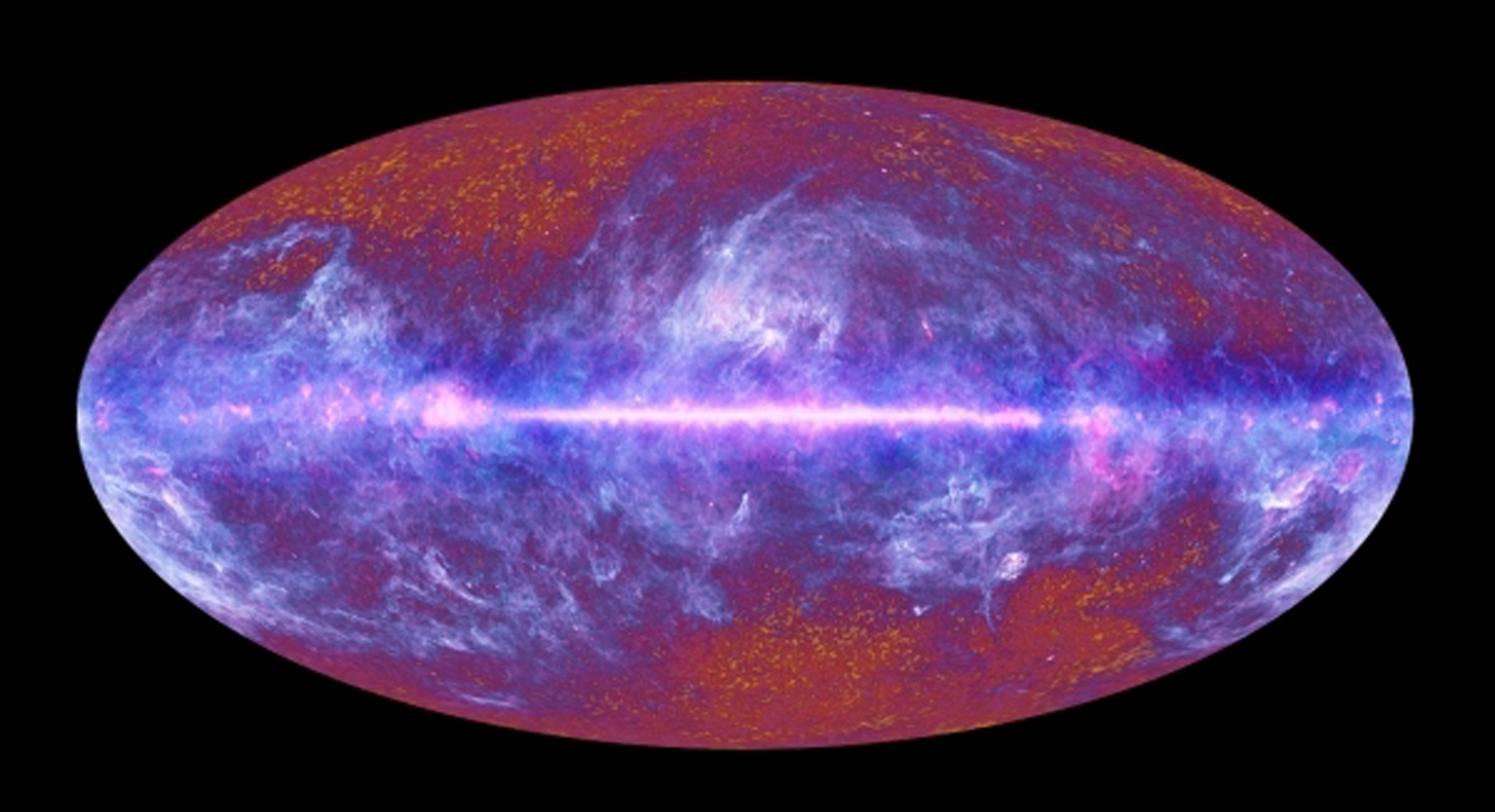

Recreación del Universo primitivo al que no hemos podido llegar en el momento mismo de su creación, nos ha sido imposible recrear ese momento que llamamos Big Bang, las matemáticas no funcionan al tratar de formular la ecuación precisa que nos muestre aquel momento.

Los neutrinos dejaron al descubierto la simetría rota del universo

Al principio, cuando el universo era simétrico, sólo existía una sola fuerza que unificaba a todas las que ahora conocemos, la gravedad, las fuerzas electromagnéticas y las nucleares débil y fuerte, todas emergían de aquel plasma opaco de alta energía que lo inundaba todo. Más tarde, cuando el universo comenzó a enfriarse, se hizo transparente y apareció la luz, las fuerzas se separaron en las cuatro conocidas, emergieron los primeros quarks para unirse y formar protones y neutrones, los primeros núcleos aparecieron para atraer a los electrones que formaron aquellos primeros átomos. Doscientos millones de años más tarde, se formaron las primeras estrellas y galaxias. Con el paso del tiempo, las estrellas sintetizaron los elementos pesados de nuestros cuerpos, fabricados en supernovas que estallaron, incluso antes de que se formase el Sol. Podemos decir, sin temor a equivocarnos, que una supernova anónima explotó hace miles de millones de años y sembró la nube de gas que dio lugar a nuestro sistema solar, poniendo allí los materiales complejos y necesarios para que algunos miles de millones de años más tarde, tras la evolución, apareciéramos nosotros.

¡Qué cosas! El asombro se junta con la maravilla y nos lleva a comprender que, la ignorancia, quizá sea nuestro mayor patrimonio, ya que, el saber es escaso y comprender, comprendemos con cierta lentitud, la que impone el ritmo del Universo. Todo tiene su tiempo marcado y nuestra comprensión…también.

Emilio Silvera Vázquez

May

28

Desde la materia “inerte”… ¡Hasta los pensamientos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (2)

Comments (2)

Agua, luz y calor, sustancia cósmica… ¡El surgir de la vida!

Pero no está muerto lo que duerme eternamente

¿Cómo es posible que, a partir de la materia “inerte”, hayan podido surgir seres vivos e incluso, algunos que, como nosotros, puedan pensar? Que cosa mágica se pudo producir en el corazón de las estrellas para que, materiales sencillos como el Hidrógeno se convirtieran a miles de millones de grados de calor en otros que, como el Carbono, Oxigeno y Nitrógeno, muchos miles de Millones de años más tardes, en mundos perdidos en sistemas planetarios como el nuestro, dieran lugar a la formación de Protoplasma vivo del que surgieron aquellos infinitesimales seres que llamamos bacterias y que, posibilitaron la evolución hacia formas de vida superiores?

“La generación de una nueva especie a partir de una especie anterior es un proceso que necesita centenares de miles de años de evolución. Desde una perspectiva evolutiva se piensa que la biodiversidad es la respuesta de los seres vivos, mediante la evolución adaptativa de las especies, a la multitud de ambientes que han ido apareciendo a lo largo de la historia de la vida en la Tierra. Cada especie tiene una serie de características, muchas veces únicas, que los humanos, en ocasiones, hemos sabido aprovechar para nuestra alimentación o para curar nuestras enfermedades. Por todo ello vale la pena mantener amplios espacios naturales dónde puedan continuar viviendo todas las especies.”

Los sentidos: las herramientas que utiliza el cerebro para estar comunicado con el exterior

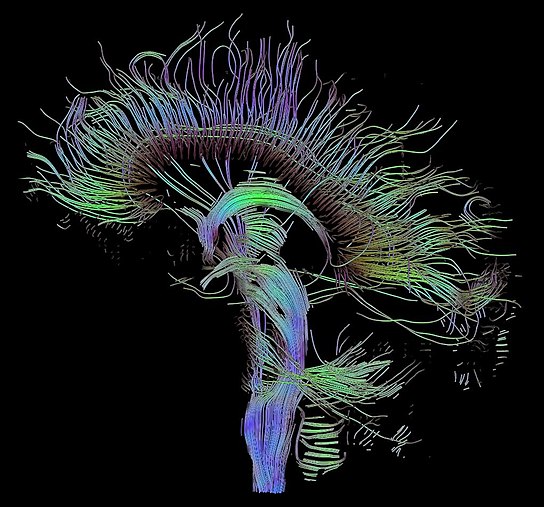

La percepción, los sentidos y los pensamientos… Para poder entender la conciencia como proceso es preciso que entendamos cómo funciona nuestro cerebro, su arquitectura y desarrollo con sus funciones dinámicas. Lo que no está claro es que la conciencia se encuentre causalmente asociada a ciertos procesos cerebrales pero no a otros.

:format(jpg)/f.elconfidencial.com%2Foriginal%2F1a4%2Faae%2F9f5%2F1a4aae9f54865c4bd6fbdb7a34be1c43.jpg)

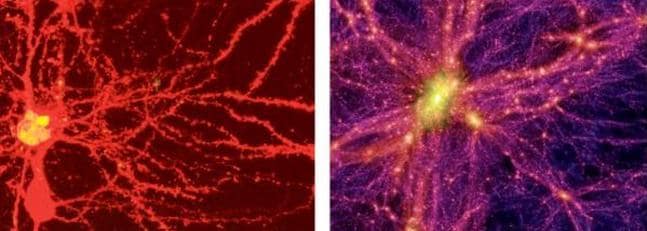

El cerebro humano ¿es especial?, su conectividad, su dinámica, su forma de funcionamiento, su relación con el cuerpo y con el mundo exterior, no se parece a nada que la ciencia conozca. Tiene un carácter único y ofrecer una imagen fidedigna del cerebro no resulta nada fácil; es un reto tan extraordinario que no estamos preparados para cumplir en este momento. Estamos lejos de ofrecer esa imagen completa, y sólo podemos dar resultados parciales de esta enorme maravilla de la Naturaleza.

Nuestro cerebro adulto, con poco más de 1.300 gr de peso, contiene unos ochenta y seis mil mil millones de células nerviosas o neuronas. La parte o capa ondulada más exterior o corteza cerebral, que es la parte del cerebro de evolución más reciente, contiene alrededor de treinta millones de neuronas y un billón de conexiones o sinapsis. Si contáramos una sinapsis cada segundo, tardaríamos 32 millones de años en acabar el recuento. Si consideramos el número posible de circuitos neuronales, tendremos que habérnoslas con cifras hiper-astronómicas. Un 10 seguido de, al menos, un millón de ceros (en comparación, el número de partículas del universo conocido asciende a “tan sólo” un 10 seguido de 79 ceros). ¡A que va a resultar que no somos tan insignificantes!

El suministro de datos que llega en forma de multitud de mensajes procede de los sentidos, que detectan el entorno interno y externo, y luego envía el resultado a los músculos para dirigir lo que hacemos y decimos. Así pues, el cerebro es como un enorme ordenador que realiza una serie de tareas basadas en la información que le llega de los sentidos. Pero, a diferencia de un ordenador, la cantidad de material que entra y sale parece poca cosa en comparación con la actividad interna. Seguimos pensando, sintiendo y procesando información incluso cuando cerramos los ojos y descansamos.

Con tan enorme cantidad de circuitos neuronales, ¿Cómo no vamos a ser capaces de descifrar todos los secretos de nuestro universo? ¿De qué seremos capaces cuando podamos disponer de un rendimiento cerebral del 80 ó 90 por ciento? Algunas veces hemos oido comentar: “Sólo utilizamos un diez por ciento del cerebro…” En realidad, la frase no indica la realidad, se refiere al hecho de que, aunque utilizamos el cerebro en su totalidad, se estima que está al diez por ciento de su capacidad real que, será una realidad a medida que evolucione y, en el futuro, esa capacidad de hoy será un 90 por ciento mayor.

Aún no conocemos bien la direccionalidad de los circuitos neuronales

El límite de lo que podremos conseguir tiene un horizonte muy lejano. Y, llega un momento en el cual, se puede llegar a pensar que no existen limites en lo que podemos conseguir: Desde hablar sin palabras sonoras a la auto-transportación. Si -como pienso- somos pura energía pensante, no habrá límite alguno; el cuerpo que ahora nos lleva de un lugar a otro, ya no será necesario, y como los fotones que no tienen masa, podremos desplazarnos a velocidades lumínicas.

Creo que estoy corriendo demasiado en el tiempo, volvamos a la realidad. A veces mi mente se dispara. Lo mismo visito mundos extraordinarios con mares luminosos de neón líquido poblados por seres transparentes, que viajo a galaxias muy lejanas pobladas de estrellas de fusión fría circundadas por nubes doradas compuestas de antimateria en la que, los positrones medio congelados, se mueven lentamente formando un calidoscopio de figuras alucinantes de mil colores. ¡La mente, qué tesoro!

¿Quién podría decir, si no se les explicara, que son “universos diferentes”

La unidad a partir de la cual se configuran todas las fabulosas actividades del cerebro es una célula del mismo, la neurona. Las neuronas son unas células fantásticamente ramificadas y extendidas, pero diminutas que, sin embargo y en sentido figurado, podríamos decir que son tan grandes como el universo mismo.

Cuando seamos capaces de convertir en realidad todo aquello en lo que podamos pensar, entonces, habremos alcanzado la meta. Para que eso pueda llegar a ocurrir, aún falta mucho tiempo. Sin embargo, si el Universo no lo impide y nuestro transcurrir continúa, todo lo que podamos imaginar… podrá ser posible. Incluso imposibilidades físicas de hoy, dejarán de existir mañana y, ¡la Mente! posiblemente (al igual que hoy ordena a las distintas partes del cuerpo que realice esta o aquella función), se encargará de que todo funcione bien, erradicará cualquier enfermedad que nos pueda atacar y, tendrá el conjunto del “sistema” en perfectas condiciones de salud, lo cual me lleva a pensar que, para cuando eso llegue, los médicos serán un recuerdo del pasado.

Es curioso y sorprendente la evolución alcanzada por la Mente Humana. El mundo físico se representa gobernado de acuerdo a leyes matemáticas. Desde este punto de vista, todo lo que hay en el universo físico está realmente gobernado en todos sus detalles por principios matemáticos, quizá por ecuaciones tales que aún no hemos podido llegar a comprender y, ni que sabemos que puedan existir.

Lo más seguro es que la descripción real del mundo físico esté pendiente de matemáticas futuras, aún por descubrir, fundamentalmente distintas de las que ahora tenemos. Llegarán nuevos Gauss, Riemann, Euler, o, Ramanujans… que, con sus nuevas ideas transformarán el pensamiento matemático para hacer posible que podamos, al fin, comprender lo que realmente somos.

Son nuestras Mentes, productos de la evolución del Universo que, a partir de la materia inerte, ha podido alcanzar el estadio bio-químico de la consciencia y, al ser conscientes, hemos podido descubrir que existen “números misteriosos” dentro de los cuales subyacen mensajes que tenemos que desvelar.

Antes tendremos que haber descifrado las funciones modulares de los cuadernos perdidos de Ramanujan, o por ejemplo, el verdadero significado del número 137, ése número puro adimensional que encierra los misterios del electrón (e) – electromagnetismo -, de la constante de Planck (h) – el cuando te acción – y de la luz (c) – la relatividad -.

Las primeras proto-estrellas, grandes grumos e gas y polvo

Los resultados son lentos, no se avanza con la rapidez que todos deseamos. Sin embargo, eso ocurre por algo, el ritmo del Universo considerado como Naturaleza, podríamos decir que es “sabio” y, si actúa de esa manera…Por algo será. Deja que de vez en cuando, sobresalgan algunas mentes y se eleven por encima del común, de ejemplos tenemnos la historia llena. Esos “saltos” de la conciencia son los tiempos que marca el Universo para que, poco a poco, se produzca nuestra evolución, es la única forma de que todo se haga de manera correcta y de que, los nuevos pensamientos se vayan asentando debidamente en las Mentes futuras. Pongamos un ejemplo: Poincaré expuso su conjetura y, más de un siglo después, Perelman la resolvió. Riemann expuso su geometría del espacio curvo, y hasta 60 años más tarde no fue descubierta por Einstein para hacer posible su formulación de la relatividad general, donde describe cómo las grandes masas distorsionan el espacio y el tiempo por medio de la fuerza de gravedad que generan. El conocimiento humano avanza al ritmo que le impone la Naturaleza.

![[dark-matter-625x450.jpg]](http://3.bp.blogspot.com/_gLo7v9af5Sg/SWXgCyeo8cI/AAAAAAAABTE/p3tYMUr7GAc/s1600/dark-matter-625x450.jpg)

¡Son tantos los secretos que nos quedan por desvelar! la Naturaleza es la portadora de todas las respuestas…Observémosla con atención y, aprendamos de ella y, de ser posible, procuremos no molestarla, “Ella” nos permite estar aquí para que evolucionemos y, algún día, cuando seamos mayores…quizás nos deje formar parte de algo más…¿mental?

Visto así…. ¡No parece que seamos gran cosa!

No, no será nada fácil imitar a la Naturaleza…¡Esa perfección! Sin embargo, llegados a ese punto, debemos pensar que nosotros también formamos parte de ella, la parte que piensa y, si es así, ¿Qué cometido tendremos asignado en este Universo? Esa es la pregunta que ninguno de los grandes pensadores de la Historia, han podido contestar.

Pensar, por ejemplo, en las complejas matemáticas topológicas requeridas por la teoría de supercuerdas puede producir incomodidad en muchas personas que, aún siendo físicos, no están tan capacitados como para entender tan profundas ideas (me incluyo).

Bernhard Riemann introdujo muchas nuevas ideas y fue uno de los más grandes matemáticos. En su corta vida (1.826 – 1.866) propuso innumerables propuestas matemáticas que cambiaron profundamente el curso del pensamiento de los números en el planeta Tierra, como el que subyace en la teoría relativista en su versión general de la gravedad, entre otras muchas (superficie de Riemann, etc.). Riemann les enseñó a todos a considerar las cosas de un modo diferente.

La geometría de las espacios curvos. Superficie de Riemann que aparece al extender el dominio de la función

.

La superficie de Riemann asociada a la función holomorfa “tiene su propia opinión” y decide por sí misma cuál debería ser el, o mejor, su dominio, con independencia de la región del plano complejo que nosotros podamos haberle asignado inicialmente.

Podríamos encontrar otros muchos tipos de superficies de Riemann.

Este bello concepto desempeña un papel importante en algunos de los intentos modernos de encontrar una nueva base para la física matemática (muy especialmente en la teoría de cuerdas), y al final, seguramente se descubrirá el mensaje que encierra.

El caso de las superficies de Riemann es fascinante, aunque desgraciadamente sólo es para iniciados. Proporcionaron los primeros ejemplos de la noción general de variedad, que es un espacio que puede pensarse “curvado” de diversas maneras, pero que localmente (por ejemplo, en un entorno pequeño de cualquiera de sus puntos), parece un fragmento de espacio euclídeo ordinario.

En matemática, la esfera de Riemann (o plano complejo extendido), llamado en honor al matemático del siglo XIX del mismo nombre, es una esfera obtenida del plano complejo mediante la adición de un punto del infinito. La esfera es la representación geométrica de los números complejos extendidos  , (véase fig.1 y fig.2), la cual consiste en los números complejos ordinarios en conjunción con el símbolo

, (véase fig.1 y fig.2), la cual consiste en los números complejos ordinarios en conjunción con el símbolo  para representar el infinito.

para representar el infinito.

La esfera de Riemann, superficie de Riemann compacta, el teorema de la aplicación de Riemann, las superficies de Riemann y aplicaciones complejas… He tratado de exponer en unas líneas la enorme importancia de este personaje para las matemáticas en general y la geometría y para la física en particular. Es uno de esos casos a los que antes me refería. Después de él, la Humanidad ha tenido un parón en el desarrollo de las ideas hasta que asimilaron las suyas y, después, llegó Einstein y otros que supieron aplicarlas. Einstein, sin el Tensor métrico de Riemann, nunc habría podido finalizar su Teoría de la Relatividad General.

La Geometría de Riemann de los espacios curvos que Einstein aprovechó

Tenemos que convenir que todo, sin excepción, es relativo y resulta ya evidente la gran crisis de la noción de realidad “veritas” que el mundo padece, la ciencia BASE, la matemática, sufrió el varapalo a partir de la matemática topológica de Poincaré, y el desarrollo sorpresivo de la matemática del caos; de pronto el idealismo de la ecuación diferencial queda derribado : el mundo que funciona como un reloj de Tolomeo queda finiquitado; ¿donde puñetas está la materia perdida?; de pronto nuestras consciencias “comprenden” que la “verdad” no existe, es decir, que no existe nuestra realidad del mundo.

Y, mientras tanto, nuestras mentes siguen su camino, siempre queriendo ir más allá y siempre profundizando en los secretos de la Naturaleza de lo que tenemos muchos ejemplos, tales como nuestras consideraciones sobre los dos aspectos de la relatividad general de Einstein, a saber, el principio de la relatividad, que nos dice que las leyes de la física son ciegas a la distinción entre reposo y movimiento uniforme; y el principio de equivalencia, que nos dice de qué forma sutil deben modificarse estas ideas para englobar el campo gravitatorio.

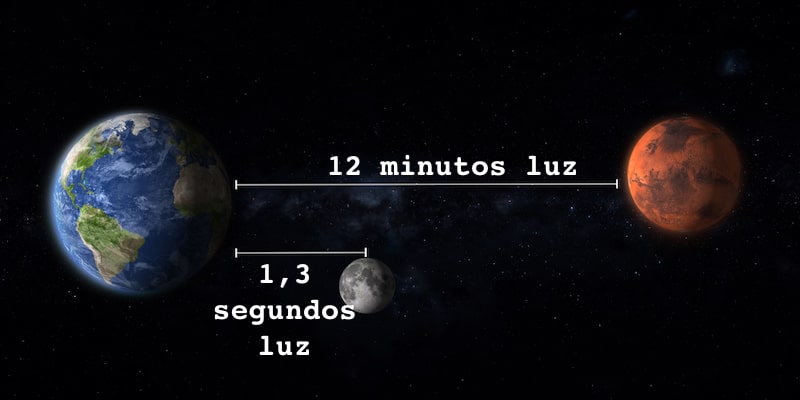

Todo es finito, es decir, que tiene un fin, y la velocidad de la luz no podía ser una excepción

Ahora hay que hablar del tercer ingrediente fundamental de la teoría de Einstein, que está relacionada con la finitud de la velocidad de la luz. Es un hecho notable que estos tres ingredientes básicos puedan remontarse a Galileo; en efecto, parece que fue también Galileo el primero que tuvo una expectativa clara de que la luz debería viajar con velocidad finita, hasta el punto de que intentó medir dicha velocidad. El método que propuso (1.638), que implica la sincronización de destellos de linternas entre colinas distantes, era, como sabemos hoy, demasiado tosco (otro ejemplo de la evolución que, con el tiempo, se produce en nuestras mentes). Él no tenía forma alguna de anticipar la extraordinaria velocidad de la luz.

Parece que tanto Galileo como Newton tenían poderosas sospechas respecto a un profundo papel que conecta la naturaleza de la luz con las fuerzas que mantienen la materia unida y, si consideramos que esa fuerza que hace posible la unión de la materia reside en el corazón de los átomos (en sus núcleos), podemos hacernos una clara idea de lo ilimitado que puede ser el pensamiento humano que, ya en aquellos tiempos -en realidad mucho anters- pudo llegar a intuir las fuerzas que están presentes en nuestro Universo.

Los Quarks están confinados dentro de los nucleones (protones y neutrones)

En los núcleos atómicos reside la fuerza (nuclear fuerte) que hace posible la existencia de la materia que comienza por los átomos que, al juntarse y formar células, hace posible que éstas se junten y formen moléculas que a su vez, se reunen para formar sustancias y cuerpos.

Pero la comprensión adecuada de estas ideas tuvo que esperar hasta el siglo XX, cuando se reveló la verdadera naturaleza de las fuerzas químicas y de las fuerzas que mantienen unidos los átomos individuales. Ahora sabemos que tales fuerzas tienen un origen fundamentalmente electromagnético (que vincula y concierne a la implicación del campo electromagnético con partículas cargadas) y que la teoría del electromagnetismo es también la teoría de la luz.

Para entender los átomos y la química se necesitan otros ingredientes procedentes de la teoría cuántica, pero las ecuaciones básicas que describen el electromagnetismo y la luz fueron propuestas en 1.865 por el físico escocés James Clark Maxwell, que había sido inspirado por los magníficos descubrimientos experimentales de Michael Faraday unos treinta años antes y que él plasmó en una maravillosa teoría.

El escudo magnético de la tierra nos defiende de los campos magnéticos del Sol

El electromagnetismo es una rama de la Física que estudia y unifica los fenómenos eléctricos y magnéticos en una sola teoría. El electromagnetismo es una teoría de campos; es decir, las explicaciones y predicciones que provee se basan en magnitudes físicas vectoriales dependientes de la posición en el espacio y del tiempo.

Esta teoría del electromagnetismo de Maxwell tenía la particularidad de que requería que la velocidad de la luz tuviera un valor fijo y definido, que normalmente se conoce como c, y que en unidades ordinarias es aproximadamente 3 × 108 metros por segundo. Maxwell, guiado por los experimentos de Faraday, hizo posible un hecho que cambió la historia de la humanidad para siempre. Un hecho de la misma importancia que el descubrimiento del fuego, la rueda o los metales. El matemático y poeta escocés unificó los campos eléctrico y magnético a través de unas pocas ecuaciones que describen como estos campos se entretejen y actúan sobre la materia.

Claro que, estos importantísimos avances han sido simples escalones de la “infinita” escalera que tenemos que subir y, la misma relatividad de Einstein no ha sido (después de un siglo) aún comprendido en su plenitud y muchos de sus mensajes están escondidos en lo más profundo de nuestras mentes que, ha sabido parcialmente descubrir el mensaje de Einstein pero, seguimos buscando.

Sin embargo, esto nos presenta un enigma si queremos conservar el principio de relatividad. El sentido común nos diría que si se mide que la velocidad de la luz toma el valor concreto c en el sistema de referencia del observador, entonces un segundo observador que se mueva a una velocidad muy alta con respecto al primero medirá que la luz viaja a una velocidad diferente, aumentada o disminuida, según sea el movimiento del segundo observador.

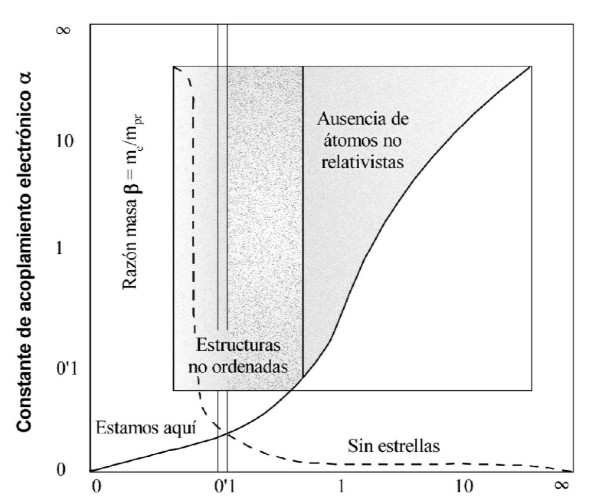

Estaría bueno que, al final se descubriera que alfa (α) tuviera un papel importante en la compleja teoría de cuerdas, ¿Por qué no? En realidad alfa, la constante de estructura fina, nos habla del magnetismo, de la constante de Planck y de la relatividad especial, es decir, la velocidad de la luz y, todo eso, según parece, emergen en las ecuaciones topológicas de la moderna teoría de cuerdas. ¡Ya veremos!

Pero el principio de relatividad exigiría que las leyes físicas del segundo observador (que definen en particular la velocidad de la luz que percibe el segundo observador) deberían ser idénticas a las del primer observador. Esta aparente contradicción entre la constancia de la velocidad de la luz y el principio de relatividad condujo a Einstein (como de hecho, había llevado previamente al físico holandés Hendrick Antón Lorentz y muy en especial al matemático francés Henri Poincaré) a un punto de vista notable por el que el principio de relatividad del movimiento puede hacerse compatible con la constancia de una velocidad finita de la luz.

¿Cómo funciona esto? Sería normal que cualquier persona creyera en la existencia de un conflicto irresoluble entre los requisitos de una teoría como la de Maxwell, en la que existe una velocidad absoluta de la luz, y un principio de relatividad según el cual las leyes físicas parecen las mismas con independencia de la velocidad del sistema de referencia utilizado para su descripción.

¿No podría hacerse que el sistema de referencia se moviera con una velocidad que se acercara o incluso superara a la de la luz? Y según este sistema, ¿no es cierto que la velocidad aparente de la luz no podría seguir siendo la misma que era antes? Esta indudable paradoja no aparece en una teoría, tal como la originalmente preferida por Newton (y parece que también por Galileo), en la que la luz se comporta como partículas cuya velocidad depende de la velocidad de la fuente. En consecuencia, Galileo y Newton podían seguir viviendo cómodamente con un principio de relatividad.

La velocidad de la luz en el vacío es una constante de la Naturaleza y, cuando cientos de miles de millones de millones salen disparados de esta galaxia hacia el vacío espacial, su velocidad de 299.792.450 metros por segundo, es constante independientemente de la fuente que pueda emitir los fotones y de si ésta está en reposo o en movimiento.

Así que, la antigua imagen de la naturaleza de la luz entró en conflicto a lo largo de los años, como era el caso de observaciones de estrellas dobles lejanas que mostraban que la velocidad de la luz era independiente de la de su fuente. Por el contrario, la teoría de Maxwell había ganado fuerza, no sólo por el poderoso apoyo que obtuvo de la observación (muy especialmente en los experimentos de Heinrich Hertz en 1.888), sino también por la naturaleza convincente y unificadora de la propia teoría, por la que las leyes que gobiernan los campos eléctricos, los campos magnéticos y la luz están todos subsumidos en un esquema matemático de notable elegancia y simplicidad.

Las ondas luminosas como las sonoras, actúan de una u otra manera dependiendo del medio en el que se propagan.

En la teoría de Maxwell, la luz toma forma de ondas, no de partículas, y debemos enfrentarnos al hecho de que en esta teoría hay realmente una velocidad fija a la que deben viajar las ondas luminosas.

El punto de vista geométrico-espaciotemporal nos proporciona una ruta particularmente clara hacia la solución de la paradoja que presenta el conflicto entre la teoría de Maxwell y el principio de relatividad.

Este punto de vista espaciotemporal no fue el que Einstein adoptó originalmente (ni fue el punto de vista de Lorentz, ni siquiera, al parecer, de Poincaré), pero, mirando en retrospectiva, podemos ver la potencia de este enfoque. Por el momento, ignoremos la gravedad y las sutilezas y complicaciones asociadas que proporciona el principio de equivalencia y otras complejas cuestiones, que estimo aburrirían al lector no especialista, hablando de que en el espacio-tiempo se pueden concebir grupos de todos los diferentes rayos de luz que pasan a ser familias de íneas de universo.

La maravilla de los cuantos llamados fotones

Baste saber que, como quedó demostrado por Einstein, la luz, independientemente de su fuente y de la velocidad con que ésta se pueda mover, tendrá siempre la misma velocidad en el vacío, c, o 299.792.458 metros por segundo. Cuando la luz atraviesa un medio material, su velocidad se reduce. Precisamente, es la velocidad c el límite alcanzable de la velocidad más alta del universo. Es una constante universal y, como hemos dicho, es independiente de la velocidad del observador y de la fuente emisora.

El Universo está dentro de nuestras Mentes

¡La Mente! Qué caminos puede recorrer y, sobre todo ¿Quién la guía? Comencé este trabajo con la imagen del ojo humano y hablando de los sentidos y de la consciencia y mira donde he finalizado…Sí, nos falta mucho camino por recorrer para llegar a desvelar los misterios de la Mente que, en realidad, es la muestra más alta que el Universo nos puede mostrar de lo que puede surgir a partir de la sencillez de los átomos de hidrógeno que, evolucionados, primero en las entrañas de las estrellas y después en los circuitos de nuestras mentes, llega hasta los pensamientos y la imaginación que…son palabras mayores de cuyo alcance, aún no tenemos una idea que realmente refleje su realidad.

Todo en nuestro universo ambia, comienza siendo una cosa y finaliza siendo otra

Pero, ¿existe alguna realidad?, o, por el contrario todo es siempre cambiante y lo que hoy es mañana no existirá, si “realmente” es así, ocurre igual que con el tiempo. La evolución es algo que camina siempre hacia adelante, es inexorable, nunca se para y, aunque como el tiempo pueda ralentizarse, finalmente sigue su camino hacia esos lugares que ahora, sólo podemos imaginar y que, seguramente, nuestros pensamientos no puedan (por falta de conocimientos) plasmar en lo que será esa realidad futura.

Emilio Silvera Vázquez

May

26

La Masa y la Energía ¿Qué son en realidad?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (3)

Comments (3)

“A día de hoy, las constantes universales son la velocidad de la luz en el vacío, que sustituye al metro; la constante de Planck, que sustituiría al kilogramo; el número de Avogadro, que reemplazaría al mol; la eficacia luminosa, que supliría a la candela; la constante de Boltzmann, que relevaría al Kelvin y el segundo de un reloj atómico de cesio para el segundo tradicional. Estos valores se ajustan mucho mejor a las necesidades y medidas físicas, pero recordemos que no son las únicas que le dan “vida” al universo.”

“Pero, ¿Qué son en realidad las constantes? Aunque apenas hemos comenzado a profundizar sobre este tema, ahora que tenemos más clara la identidad de algunas constantes será más fácil definirlas. Una constante física es el valor de una magnitud que permanece invariable en los procesos físicos a lo largo del tiempo. Las magnitudes pueden variar, cosa que tiene sentido, o estaríamos ante un universo muerto. Sin embargo, como veíamos, existen valores que no lo hacen, convirtiéndose en auténticas piedras de toque existenciales.”

La Mente humana ha logrado descorrer el velo de muchos secretos profundamente escondidos en la Naturaleza

Todos los intentos y los esfuerzos por hallar una pista del cuál era el origen de la masa fallaron. Feynman escribió su famosa pregunta: “¿Por qué pesa el muón?”. Ahora, por lo menos, tenemos una respuesta parcial, en absoluto completa. Una voz potente y ¿segura? nos dice: “!Higgs¡” Durante más de 60 años los físicos experimentadores se rompieron la cabeza con el origen de la masa, y ahora el campo Higgs presenta el problema en un contexto nuevo; no se trata sólo del muón. Proporciona, por lo menos, una fuente común para todas las masas. La nueva pregunta feynmaniana podría ser: ¿Cómo determina el campo de Higgs la secuencia de masas, aparentemente sin patrón, que da a las partículas de la materia?

La variación de la masa con el estado de movimiento, el cambio de masa con la configuración del sistema y el que algunas partículas (el fotón seguramente y los neutrinos posiblemente) tengan masa en reposo nula son tres hechos que ponen entre dicho que el concepto de masa sea un atributo fundamental de la materia. Habrá que recordar aquel cálculo de la masa que daba infinito y nunca pudimos resolver; los físicos sólo se deshicieron de él “renormalizándolo”, ese truco matemático que emplean cuando no saben encontrar la respuesta al problema planteado.

Ese es el problema de trasfondo con el que tenemos que encarar el problema de los quarks, los leptones y los vehículos de las fuerzas, que se diferencian por sus masas. Hace que la historia de Higgs se tenga en pie: la masa no es una propiedad intrínseca de las partículas, sino una propiedad adquirida por la interacción de las partículas y su entorno.

La idea de que la masa no es intrínseca como la carga o el espín resulta aún más plausible por la idílica idea de que todos los quarks y fotones tendrían masa cero. En ese caso, obedecerían a una simetría satisfactoria, la quiral, en la que los espines estarían asociados para siempre con su dirección de movimiento. Pero ese idilio queda oculto por el fenómeno de Higgs.

¡Ah, una cosa más! Hemos hablado de los bosones gauge y de su espín de una unidad; hemos comentado también las partículas fermiónicas de la materia (espín de media unidad). ¿Cuál es el pelaje de Higgs? Es un bosón de espín cero. El espín supone una direccionalidad en el espacio, pero el campo de Higgs da masa a los objetos dondequiera que estén y sin direccionalidad. Al Higgs se le llama a veces “bosón escalar” [sin dirección] por esa razón.

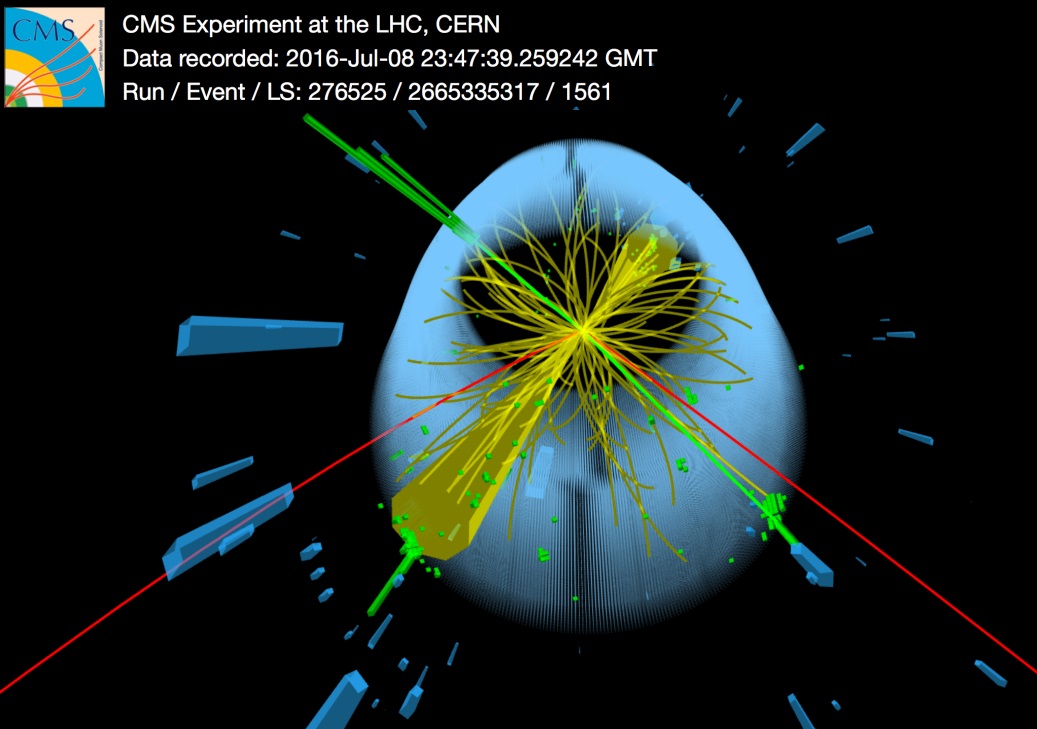

La interacción débil, recordareis, fue inventada por E. Fermi para describir la desintegración radiactiva de los núcleos, que era básicamente un fenómeno de poca energía, y a medida que la teoría de Fermi se desarrolló, llegó a ser muy precisa a la hora de predecir un enorme número de procesos en el dominio de energía de los 100 MeV. Así que ahora, con las nuevas tecnologías y energías del LHC, las esperanzas son enormes para, por fin, encontrar el bosón Higgs origen de la masa… y algunas cosas más.

Fabiola Gianotti, portavoz del experimento ATLAS, ofrece algunos avances:

“En nuestros datos observamos claros signos de una nueva partícula compatible con la teoría de Higgs, con un nivel aproximado de 5 sigma [99,977% de eficiencia], en la región de masa alrededor de los 126 GeV. El increíble rendimiento del LHC y el ATLAS y los enormes esfuerzos de mucha gente nos han traído a este excitante punto, pero hace falta un poco más de tiempo para preparar estos resultados cara a su publicación.”

El Modelo Estándar extendido

El Modelo Estándar describe las partículas de todo cuanto nos rodea, incluso de nosotros mismos. Toda la materia que podemos observar, sin embargo, no parece significar más que el 4% del total. Higgspodría ser el puente para comprender el 96% del universo que permanece oculto.

El 4 de julio de 2012 se anunció el descubrimiento de un nuevo bosón. Punto. En diciembre de 2012 se empezó a hablar de “un” Higgs (en lugar de “el” Higgs), pero oficialmente seguía siendo un nuevo bosón. ¿Importa el nombre? El Premio Nobel de Física para el bosón de Higgs sólo será concedido cuando el CERN afirme con claridad y rotundidad que se ha descubierto “el” Higgs, si el CERN es conservador, la Academia Sueca lo es aún más. Sin embargo, el rumor es que quizás baste con que el CERN diga que se ha descubierto “un” Higgs.

¿Por qué, a pesar de todas las noticias surgidas desde el CERN, creo que no ha llegado el momento de celebrarlo? ¿Es acaso el Higgs lo encontrado? Creo que quedan algunas cuestiones por explicar y, el Nobel ha sido algo prematuro. Sin embargo, los científicos se agarran a un clavo ardiendo (como el que se ahoga) para conseguir subvenciones.

Hay que responder montones de preguntas. ¿Cuáles son las propiedades de las partículas de Higgs y, lo que es más importante, cuál es su masa? ¿Cómo reconoceremos una si nos la encontramos en una colisión de LHC? ¿Cuántos tipos hay? ¿Genera el Higgs todas las masas, o solo las hace incrementarse? ¿Y, cómo podemos saber más al respecto? También a los cosmólogos les fascina la idea de Higgs, pues casi se dieron de bruces con la necesidad de tener campos escalares que participasen en el complejo proceso de la expansión del Universo, añadiendo, pues, un peso más a la carga que ha de soportar el Higgs.

El campo de Higgs, tal y como se lo concibe ahora, se puede destruir con una energía grande, o temperaturas altas. Estas generan fluctuaciones cuánticas que neutralizan el campo de Higgs. Por lo tanto, el cuadro que las partículas y la cosmología pintan juntas de un universo primitivo puso y de resplandeciente simetría es demasiado caliente para Higgs. Pero cuando la temperatura cae bajo los 10’5grados kelvin o 100 GeV, el Higgs empieza a actuar y hace su generación de masas. Así por ejemplo, antes de Higgs teníamos unos W, Z y fotones sin masa y la fuerza electrodébil unificada.

El Universo se expande y se enfría, y entonces viene el Higgs (que engorda los W y Z, y por alguna razón ignora el fotón) y de ello resulta que la simetría electrodébil se rompe. Tenemos entonces una interacción débil, transportada por los vehículos de la fuerza W+, W–, Z0, y por otra parte una interacción electromagnética, llevada por los fotones. Es como si para algunas partículas del campo de Higgs fuera una especie de aceite pesado a través del que se moviera con dificultad y que las hiciera parecer que tienen mucha masa. Para otras partículas, el Higgs es como el agua, y para otras, los fotones y quizá los neutrinos, es invisible.

![]()

Para cada suceso, la línea del haz es el eje común de los cilindros de malla de alambre ECAL y HCAL. ¿Cuál es el mejor candidato W? el mejor candidato Z? En cada evento, ¿Dónde ocurrió la colisión y el decaimiento de las partículas producidas? Lo cierto es que, en LHC se hacen toda clase de pruebas para saber del mundo de las partículas, de dónde vienen y hacia dónde se dirigen y, el Bosón de Higgs, es una asignatura pendiente a pesar de las noticias y de los premios

De todas las maneras, es tanta la ignorancia que tenemos sobre el origen de la masa que, nos agarramos como a un clavo ardiendo el que se ahoga, en este caso, a la partícula de Higgs que viene a ser una de las soluciones que le falta al Modelo Estándar para que todo encaje con la teoría.

¡Ya veremos en que termina todo esto! Dicen que descubrieron el famoso Bosón pero… Y, aunque el que suena siempre es Higgs, lo cierto es que los autores de la teoría del “Bosón de Higgs”, son tres a los que se ha concedido, junto al CERN, el Premio Principe de Asturias. Peter Ware Higgs —el primero en predecir la existencia del bosón— junto a los físicos François Englert, y el belga Robert Brout—fallecido en el año 2011— y que no ha podido disfrutar del Nóbel.

Peter Higgs, de la Universidad de Edimburgo, introdujo la idea en la física de partículas. La utilizaron los teóricos Steven Weinberg y V. Salam, que trabajaban por separado, para comprender como se convertía la unificada y simétrica fuerza electrodébil, transmitida por una feliz familia de cuatro partículas mensajeras de masa nula, en dos fuerzas muy diferentes: la QED con un fotón carente de masa y la interacción débil con sus W+, W– y Z0 de masa grande. Weinberg y Salam se apoyaron en los trabajos previos de Sheldon Glasgow, quien tras los pasos de Julian Schwinger, sabía sólo que había una teoría electrodébil unificada, coherente, pero no unió todos los detalles. Y estaban Jeffrey Goldstone y Martines Veltman y Gerard’t Hooft. También hay otras a los que había que mencionar, pero lo que siempre pasa, quedan en el olvido de manera muy injusta. Además, ¿Cuántos teóricos hacen falta para encender una bombilla?

La verdad es que, casi siempre, han hecho falta muchos. Recordemos el largo recorrido de los múltiples detalle sueltos y físicos que prepararon el terreno para que, llegara Einstein y pudiera, uniéndolo todo, exponer su teoría relativista.

Sobre la idea de Peter Higgs, Veltman, uno de sus arquitectos, dice que es una alfombra bajo la que barremos nuestra ignorancia. Glasgow es menos amable y lo llamó retrete donde echamos las incoherencias de nuestras teorías actuales. La objeción principal: que no teníamos la menor prueba experimental que ahora parece que va asomando la cabeza en el LHC.

![]()

Esperemos que la partícula encontrada, el bosón hallado, sea en realidad el Higgs dador de masa a las demás partículas pero… ¡Cabe la posibilidad de que sólo sea el hermano menor! de la familia. El modelo estándar es lo bastante fuerte para decirnos que la partícula de Higgs de menor masa (podría haber muchas) debe “pesar” menos de 1 TeV. ¿Por qué? Si tiene más de 1 TeV, el modelo estándar se vuelve incoherente y tenemos la crisis de la unitariedad.

Después de todo esto, tal como plantearon las cosas los del CERN, se podría llegar a la conclusión de que, el campo de Higgs, el modelo estándar y nuestra idea de cómo se hizo el Universo dependía de que se encuentrara el Bosón de Higgs. Y ahora, por fin, el mayor Acelerador del mundo, el LHC, nos dice que el Bosón ha sido encontrado y las pruebas tienen una fiabilidad enorme.

“El 4 de julio de 2012 se anunció el bosón de Higgs en el LHC del CERN. Se observó con cinco sigmas de confianza estadística por dos detectores independientes, ATLAS y CMS. Más aún, en dos canales de desintegración independientes en ambos, la desintegración en dos fotones vía un bucle de tres bosones W y en cuatro leptones vía un par de bosones Z. Más tarde, combinando ATLAS y CMS, se observó en el canal de desintegración en dos leptones tau (alcanzando 5,5 sigmas). El LHC Run 1 determinó que la masa del Higgs es de 125,09 ± 0,24 GeV/c² y que sus propiedades coinciden con las predicciones del modelo estándar, hasta donde se espera que puedan coincidir; hay anomalías, pero todas parecen tener un origen estadístico. Recuerda que en el LHC Run 1 (2010–2012) se acumularon ~5 /fb de colisiones protón contra protón a una energía de 7 TeV c.m. (2010–2011) y ~20 /fb a 8 TeV c.m. (2012).”

¡La confianza en nosotros mismos, no tiene límites! Pero el camino no ha sido recorrido por completo y quedan algunos tramos que tendremos que andar para poder, al fín, dar una explicación más completa, menos oscura y neblinosa que lo que hasta el momento tenemos, toda vez que, del Bosón de Higgs y de su presencia veraz, dependen algunos detalles de cierta importancia para que sean confirmados nuestros conceptos de lo que es la masa y, de paso, la materia.

¿Pasará igual con las cuerdas?

Emilio Silvera Vázquez

Fuente: León M. Lederman

Totales: 85.841.487

Totales: 85.841.487 Conectados: 32

Conectados: 32