Jun

19

Las simetrías “biológicas” del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

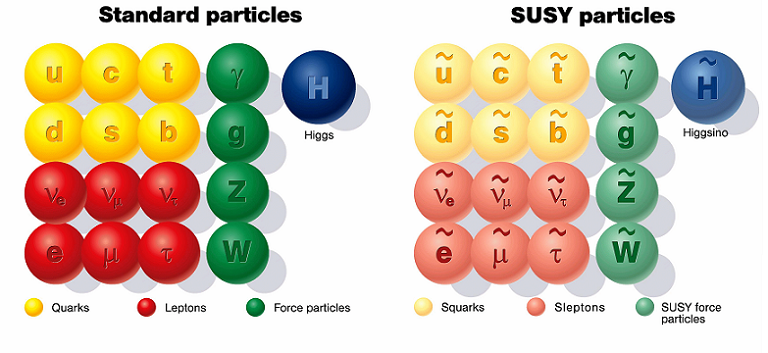

En cualquier sitio que miremos nos dirán que la supersimetría en la física de partículas es: Una simetría hipotética propuesta que relacionaría las propiedades de los Bosones y los Fermiones. Aunque todavía no se ha verificado experimentalmente que la supersimetría sea una simetría de la naturaleza, es parte fundamental de muchos modelos teóricos, incluyendo la teoría de supercuerdas. La sipersimetría La también es conocida por el acrónimo inglés SUSY.

La Supersimetría tiene unas matemáticas muy bellas y por esa razón los artículos sobre el tema están llenos de ellas. Como ha sucedido antes, por ejemplo, cuando se propuso la teoría de Yang–Mills, tenemos un esquema matemático brillante que aún no sabemos como encajar en el conjunto de las leyes naturales. No tiene ningún sentido, todavía, pero esperamos que lo tenga en un tiempo futuro.

“Apesar de constituir la pieza central del paradigma de la física de interacciones fundamentales basado en teorías relativistas cuánticas de campos, las teorías gauge no abelianas presentan a los 50 años de su descubrimiento por Yan y Mills numerosos interrogantes que afectan incluso a su propia consistencia. La importancia de resolver alguno de estos problemas impulsó al Instituto Clay a considerarlos como uno de los retos matemáticos del nuevo milenio. El planteamiento del problema requiere elementos de las teorías físicas de la relatividad especial y la mecánica cuántica al mismo tiempo que campos de matemática como la teoría de probabilidades, geometría diferencial y análisis funcional

Hay otro escenario mucho más atractivo para nuestra imaginación. Hemos podido ver que los átomos están formados por pequeños constituyentes, los fotones, neutrones y electrones. Luego descubrimos que esos constituyentes, a su vez, tienen una subestructura: están formados de quarks y gluones. ¿Por qué, como probablemente hayas pensado tú antes, el proceso no continúa así? Quizñá esos Quarks y Gluones, e igualmente los electrones y todas las demás partículas aún llamadas “elementales” en el Modelo Estándar, estén también construidas de unos granos de materia aún menores y, finalmente, toda esa materia, si seguimos profundizando, nos daría la sorpresa de que toda ella es pura luz, es decir, la esencia de la materia.

Yo he tenido esa idea muy frecuentemente, nadie me quita de la cabeza que la materia, en lo más profundo de su “ser”, es la luz congelada en trozos de materia que, cuando llegan los sucesos, las transiciones de fase, se deja ver y sale a la “luz” del mundo para que la podamos contemplar.

Simetría es nuestra presencia aquí como observadores, la concha de un caracol, una galaxia, una flor y también las estrellas y los mundos, todo forma un conjunto armónico que hace ese todo en el que nosotros, inmersos en tanta grandeza, no acabamos de asimilar lo mucho que la Naturaleza nos quiere transmitir y, al formar parte de ella, nos cuesta más mirarla desde “fuera” para entenderla, sin ser conscientes que, en realidad, la debemos mirar desde dentro, ahí es donde estamos. ¡Dentro de ella! Siempre hay algo más allá:

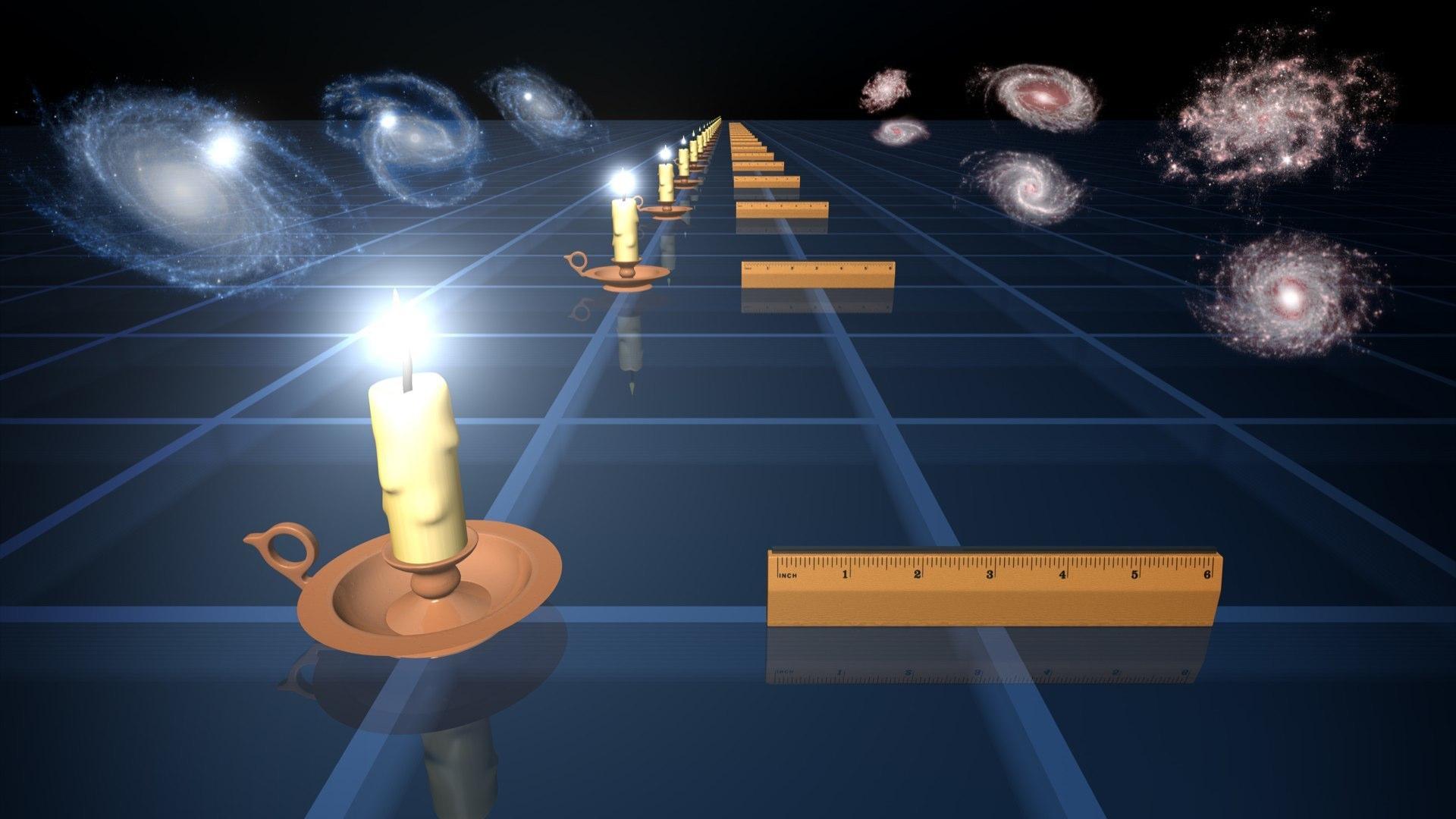

The Scale of the Universe 2 – HTwins.net

¿Quieres darte una vueltecita por el universo, en un tiempo razonable y entre las escalas de lo más inimaginablemente grande y lo infinitesimalmente pequeño? Prueba The Scale of the Universe 2, segunda parte de un interactivo similar que hace tiempo estuvo circulando por la Red, y a disfrutar. Basta mover la barra de desplazamiento o usar la rueda del ratón, y también se puede hacer clic sobre los objetos para aprender algo sobre ellos.

Todos sabemos de las grandes estructuras (inertes o vivas) que, en su inmensidad, transportan dentro de ellas o en la misma superficie, otras estructuras más pequeñas que, no por ello, dejan de ser también complejas. Grandes pulgas transportan pequeñas pulgas en su piel y, al igual que nosotros, llevan en ellas mismas a otros animáculos más pequeños, o, infinitesimales que, también, como nosotros, animales más grandes, tienen una misión encomendada sin la cual, seguramente nosotros, ni podríamos ser. Así que, tenemos que prestar mucha atención a lo que creemos “ínfimo” y que, en la mayoría de las veces, resulta ser más importante de lo que podemos llegar a imaginar.

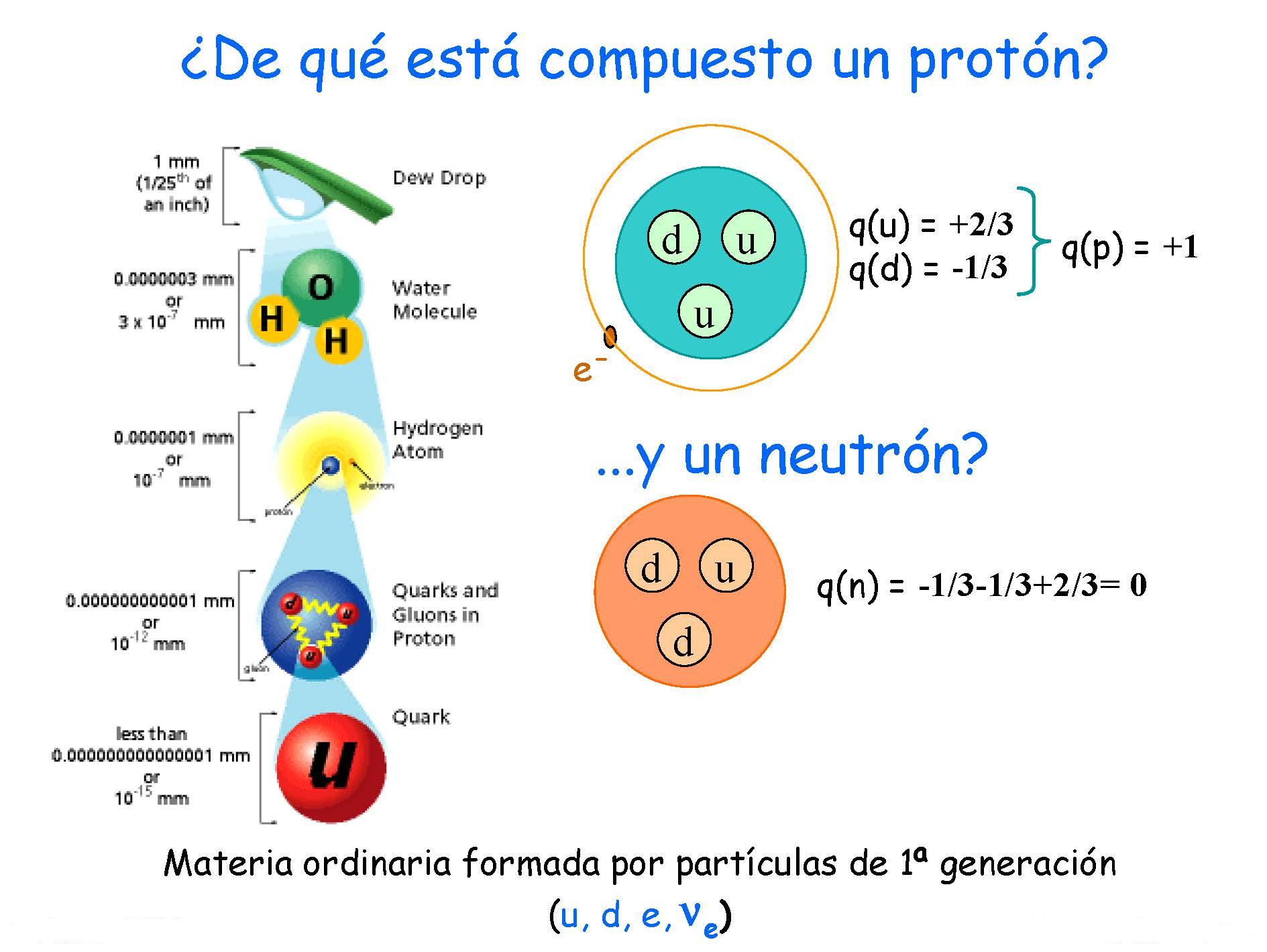

Si miramos a los Quarks de un protón, por ejemplo, la mecánica cuántica (esa teoría maravillosa que controla todo el micromundo con increíble precisión), exige que el producto de la masa por la velocidad, el llamado “momento”, debe ser inversamente proporcional al tamaño de la “caja” en la cual ponemos nuestro sistema. El protón puede ser considerado como una de tales cajas y es tan pequeño que los quarks en su interior tendrían que moverse con una velocidad cercana a la de la luz. Debido a esto, la masa efectiva de los quarks máss pequeños, u y d, es aproximadamente de 300 MeV, que es mucho mayor que el valor que vemos en las Tablas de Partículas; eso también expñlica porque la masa del Protón es de 900 MeV, mucho mayor que la suma de las masas en reposo de los quarks /y Gluones).

Sí, dentro de los protones y neutrones, seguramente pueda haber mucho más de lo que ahora podemos vislumbrar. Nuestros aceleradores de partículas han podido llegar hasta ciertos límites que nos hablan de Quarks y ahora se buscan partículas supersimétricas o bosones traficantes de masa (como diría Ton Wood), y, nosotros, no sabemos si esos objetos existen o si podremos llegar a encontrarlos pero, por intentarlo… No dudamos en gastar ingentes cantidades y en utilizar cuantos recursos humanos sean precisos. El conocimiento de la Naturaleza es esencial para que, el futuro de la Física, sea la salvación de la Humanidad o, en su caso, de la raza que vendrá detrás de nosotros.

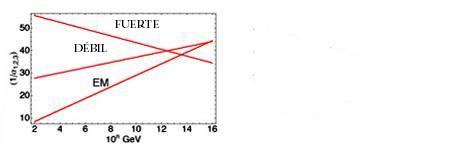

Algunas Teorías, como todos conocemos, han intentado unificar teorías de color con las de supersimetría. Quizá los nuevos Aceleradores de Hadrones (LHC) y otros similares que estarán acabamos poco después de estas primeras décadas del siglo XXI, nos puedan dar alguna pista y desvelar algunos de los nuevos fenómenos asociados a los nuevos esquemas que se dibujan en las nuevas teorías.

Los astrofísicos están muy interesados en estas ideas que predicen una gran cantidad de nuevas partículas superpesadas y, también varios tipos de partículas que interaccionan ultradébilmente. Estas podrían ser las “famosas” WIMPs que pueblan los huecos entre galaxias para cumplir los sueños de los que, al no saber explicar algunas cuestiones, acudieron a la “materia oscura” que, como sabeis, les proporcionó el marco perfecto para ocultar su inmensa ignorancia. “¡La masa perdida!” ¿Qué masa es esa? Y, sin embargo, los Astrofísicos, incansables, se aferran a ella y la siguen buscando…¡Ilusos!

¡El Universo! ¡Son tántas cosas! Desde nosotros los observadores, hasta la más ínfina partícula de materia

Yo, en mi inmensa ignorancia, no puedo explicar lo que ahí pueda existir. Sin embargo, sospecho que, deberíamos ahondar algo más en esa fuerza que llamamos Gravedad y que, me da la sensación de que nos esconde secretos que aún no hemos sabido desvelar. Y, por otra parte, tengo la sospecha de que la Luz, es más de lo que podemos suponer.

“Se analizan las interacciones electromagnéticas y nucleares débiles utilizando el principio fundamental de simetría en espacios abstractos denominados teoría de campos de Yang-Mills, también conocidos como campos de norma (gauge fields) y el mecanismo de Higgs. Los campos de norma actúan como mediadores de las interacciones, cuyo alcance está determinado de manera directa por la masa. Por este motivo los campos de norma se unen al mecanismo de Higgs que genera masa a los portadores de las interacciones, manteniendo la teoría invariante bajo una transformación de norma. Esto se logra a través de un rompimiento espontaneo de simetría para finalmente aplicar esta metodología con la finalidad de unificar las teorías de las interacciones considerando el modelo estándar de Weinberg-Salam.”

emilio silvera

Jun

14

¿La teoría cuántica y la Gravedad, dentro de las cuerdas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (4)

Comments (4)

Todo se degrada con el paso del Tiempo

Sí, a veces la Física, parece un Carnaval. Imaginamos universos que… ¿serán posibles?

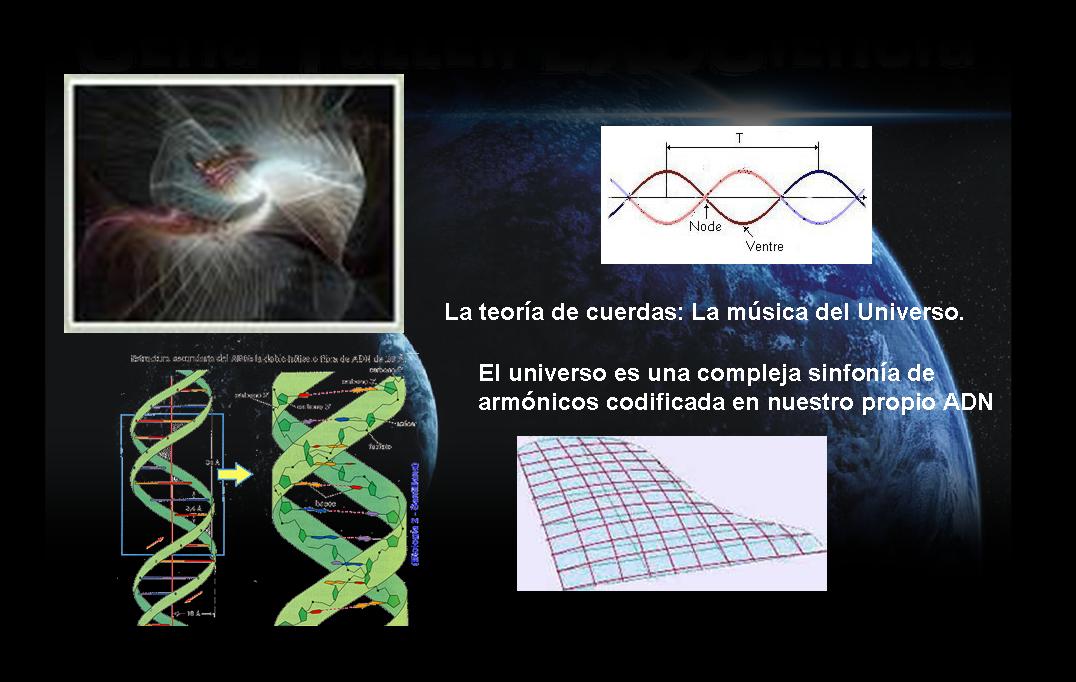

Las teorías de cuerdas [TC’s] no son una invención nueva, ni mucho menos. La primera TC se inventó a finales de los años sesenta del siglo XX en un intento para encontrar una teoría para describir la interacción fuerte. La idea medular consistía en que partículas como el protón y el neutrón podían ser consideradas como ondas de «notas de una cuerda de violín». La interacción fuerte entre las partículas correspondería a fragmentos de cuerda que se extenderían entre pequeños pedacitos de cuerda, como las telas que forman algunos simpáticos insectos. Para que esta teoría proporcionase el valor observado para la interacción fuerte entre partículas, las cuerdas tendrían que ser semejantes a las de un violín, pero con una tensión de alrededor de unas diez toneladas.

La primera expresión de las TC’s fue desarrollada por Jöel Scherk, de París, y John Schwuarz, del Instituto de Tecnología de California, quienes en el año 1974 publicaron un artículo en el que demostraban que la TC podía describir la fuerza gravitatoria, pero sólo si la tensión en la cuerda se tensiometrara alrededor de un trillón de toneladas métricas. Las predicciones de la teoría de cuerdas serían las mismas que las de la relatividad general a escala de longitudes normales, pero diferirían a distancias muy pequeñas, menores que una trillonésima de un cm. Claro está, que en esos años, no recibieron mucha atención por su trabajo.

Ahora se buscan indicios de la teoría de cuerdas en los grandes aceleradores de partículas donde parece que algunos indicios nos dicen que se va por el buen camino, sin embargo, nuestros aceleradores más potentes necesitarían multiplicar por un número muy elevado su potencia para poder, comprobar la existencia de las cuerda situadas a una distancia de 10-35 m, lugar al que nos será imposible llegar en muchas generaciones. Sin embargo, en las pruebas que podemos llevar a cabo en la actualidad, aparecen indicios de una partlicula de espín 2 que todos asocian con el esquivo Gravitón, y, tal indicio, nos lleva a pensar que, en la teoría de supercuerdad, está implícita una Teoría Cuántica de la Gravedad.

Los motivos que tuvo la comunidad científica, entonces, para no brindarle la suficiente atención al trabajo de Scherk y Schwuarz, es que, en esos años, se consideraba más viable para describir a la interacción fuerte a la teoría basada en los quarks y los gluones, que parecía ajustarse mucho mejor a las observaciones. Desafortunadamente, Scherk murió en circunstancias trágicas (padecía diabetes y sufrió un coma mientras se encontraba solo en su estudio). Así, Schwuarz se quedó solo, en la defensa de la teoría de cuerdas, pero ahora con un valor tensiométrico de las cuerdas mucho más elevado.

Pero con los quarks, gluones y también los leptones, en la consecución que se buscaba, los físicos entraron en un cuello de botella. Los quarks resultaron muy numerosos y los leptones mantuvieron su número e independencia existencial, con lo cual seguimos con un número sustancialmente alto de partículas elementales (60), lo que hace que la pregunta ¿son estos los objetos más básicos?

Si esos sesenta objetos fuesen los más básicos, entonces también aflora otra pregunta ¿por qué son como son y por qué son tantos? Los físicos quisieran poder decir «salen de esto», o «salen de esto y aquello», mencionar dos principios bien fundamentales y ojalá sea tan simples que puedan ser explicados a un niño. La respuesta «porque Dios lo quiso así» posiblemente a muchos les cause «lipotimia», ya que esa respuesta nos lleva a reconocer nuestra ignorancia y, además, la respuesta que esperamos no pertenece al ámbito de la religión. Por ahora, ¿cuál es la última respuesta que puede dar la ciencia?

El cuello de botella incentivó a que se encendiera una luz de esperanza. En 1984 el interés por las cuerdas resucitó de repente. Se desempolvaron las ideas de Kaluza y Klein, como las que estaban inconclusas de Scherk y Schwuarz. Hasta entonces, no se habían hecho progresos sustanciales para explicar los tipos de partículas elementales que observamos, ni tampoco se había logrado establecer que la supergravedad era finita.

El ser humano –en función de su naturaleza– cuando se imagina algo muy pequeño, piensa en un puntito de forma esférica. Los físicos también son seres de este planeta y, para ellos, las partículas elementales son como puntitos en el espacio, puntos matemáticos, sin extensión. Son sesenta misteriosos puntos y la teoría que los describe es una teoría de puntos matemáticos. La idea que sugieren las TC’s es remplazar esos puntos por objetos extensos, pero no como esferitas sino más bien como cuerdas. Mientras los puntos no tienen forma ni estructura, las cuerdas tienen longitud y forma, extremos libres como una coma “,” (cuerda abierta), o cerradas sobre sí misma como un circulito. Si el punto es como una esferita inerte de la punta de un elastiquito, la cuerda es el elástico estirado y con él se pueden hacer círculos y toda clase de figuras. Está lleno de posibilidades.

Muchas son las imágenes que se han elaborado para representar las cuerdas y, como nadie ha visto nunca ninguna, cualquiera de ellas vale para el objetivo de una simple explicación y, las cuerdas que se han imaginado han tomado las más pintorescas conformaciones para que, en cada caso, se adapten al modelo que se expone.

diferencia entre un punto y una coma. Según la teoría de cuerdas importa, y mucho. Por su extensión, a diferencia del punto, la cuerda puede vibrar. Y hacerlo de muchas maneras, cada modo de vibración representando una partícula diferente. Así, una misma cuerda puede dar origen al electrón, al fotón, al gravitón, al neutrino y a todas las demás partículas, según cómo vibre. Por ello, la hemos comparado con la cuerda de un violín, o de una guitarra, si se quiere.

Al dividir la cuerda en dos, tres, cuatro, cinco, o más partes iguales, se generan las notas de la escala musical que conocemos, o técnicamente, los armónicos de la cuerda. En general, el sonido de una cuerda de guitarra o de piano es una mezcla de armónicos. Según la mezcla, la calidad (timbre) del sonido. Si distinguimos el tono de estos instrumentos, es por la «receta» de la mezcla en cada caso, por las diferentes proporciones con que cada armónico entra en el sonido producido. Pero, también es posible hacer que una buena cuerda vibre en uno de esos armónicos en particular, para lo cual hay que tocarla con mucho cuidado. Los concertistas lo saben, y en algunas obras como los conciertos para violín y orquesta, usan este recurso de «armónicos». Así, la naturaleza, con su gran sabiduría y cuidado para hacer las cosas, produciría electrones, fotones, gravitones, haciendo vibrar su materia más elemental, esa única y versátil cuerda, en las diversas (infinitas) formas que la cuerda permite.

Una partícula ocupa un punto del espacio en todo momento. Así, su historia puede representarse mediante una línea en el espaciotiempo que se le conoce como «línea del mundo». Por su parte, una cuerda ocupa una línea en el espacio, en cada instante de tiempo. Por tanto, su historia en el espaciotiempo es una superficie bidimensional llamada la «hoja del mundo». Cualquier punto en una hoja del mundo puede ser descrito mediante dos números: uno especificando el tiempo y el otro la posición del punto sobre la cuerda. Por otra parte, la hoja del mundo es una cuerda abierta como una cinta; sus bordes representan los caminos a través del espaciotiempo (flecha roja) de los extremos o comas de la cuerda (figura 12.05.03.02). La hoja del mundo de una cuerda cerrada es un cilindro o tubo (figura 12.05.03.03); una rebanada transversal del tubo es un círculo, que representa la posición de la cuerda en un momento del tiempo.

No cabe duda que, de ser ciertas las TC’s, el cuello de botella queda bastante simplificado. Pasar de sesenta objetos elementales a una sola coma o circulito es un progreso notable. Entonces, ¿por qué seguir hablando de electrones, fotones, quarks, y las demás?

Que aparentemente las cosas se simplifican con las TC’s, no hay duda, pero desafortunadamente en física las cosas no siempre son como parecen. Para que una teoría sea adoptada como la mejor, debe pasar varias pruebas. No basta con que simplifique los esquemas y sea bella. La teoría de las cuerdas está –se puede decir– en pañales y ha venido mostrado distintas facetas permeables. Surgen problemas, y se la deja de lado; se solucionan los problemas y una avalancha de trabajos resucitan la esperanza. En sus menos de treinta años de vida, este vaivén ha ocurrido más de una vez.

Uno de los problemas que más afecta a la cuerda está ligado con su diminuto tamaño. Mientras más pequeño algo, más difícil de ver. Es una situación que se agudiza en la medida que se han ido corrigiendo sus permeabilidades. En sus versiones más recientes, que se llaman supercuerdas, son tan superpequeñas que las esperanzas de ubicarlas a través de un experimento son muy remotas. Sin experimentos no podemos comprobar sus predicciones ni saber si son correctas o no. Exagerando, es como una teoría que afirmara que los angelitos del cielo tienen alitas. ¿Quién la consideraría seriamente?

La propia base conceptual de la teoría comporta problemas. Uno de ellos, es el gran número de dimensiones que se usan para formularla. En algunos casos se habla de 26 o, en el mejor, de 10 dimensiones para una cuerdita: espacio (son 3), tiempo (1) y otras seis (o 22) más, que parecen estar enroscadas e invisibles para nosotros. Por qué aparecieron estas dimensiones adicionales a las cuatro que nos son familiares y por qué se atrofiaron en algún momento, no lo sabemos. También, la teoría tiene decenas de miles de alternativas aparentemente posibles que no sabemos si son reales, si corresponden a miles de posibles universos distintos, o si sólo hay una realmente posible. Algunas de estas versiones predicen la existencia de 496 fuerzones, partículas como el fotón, que transmiten la fuerza entre 16 diferentes tipos de carga como la carga eléctrica. Afirmaciones como éstas, no comprobables por la imposibilidad de hacer experimentos, plagan la teoría de cuerdas. Quienes alguna vez intentaron trabajar matemáticamente en las cuerdas, muchas veces deben haber pensado de que lo que estaban calculando más se asemejaba a juegos de ejercicios que la consecución de una base matemática teórica tras objetivo de dar un paso trascendental en el conocimiento de la naturaleza. Ahora, los que tienen puesta su fe en ella suelen afirmar que se trata de una teoría que se desfasó de la natural evolución de la física, que su hallazgo fue un accidente, y no existe aún el desarrollo matemático para formularla adecuadamente.

En las teorías de cuerdas, lo que anteriormente se consideraba partículas, se describe ahora como ondas viajando por las cuerdas, como las notas musicales que emiten las cuerdas vibrantes de un violín. La emisión o absorción de una partícula por otra corresponde a la división o reunión de cuerdas.

“Al principio se vio como un gran éxito, pero pronto esta “reunificación”, no tan exacta, empezó a dar fallos entre los físicos que trabajaban en las “grandes teorías unificadas”. Como puede verse en la gráfica que representa las intensidades de las fuerzas básicas respecto a la energía expresada en GeV (en la figura se representa en el eje horizontal los exponentes de las potencias de diez), las gráficas no llegan a coincidir en un punto como era de esperar aunque la “tendencia” si se apreciaba unificadora.”

La Teoría de cuerdas trata de incorparar la Gravedad a las otras tres fuerzas y completar asíel panorama actual de la Física de Partículas en el Modelo Estándar en el que sólo están incluídas estas tres interacciones de arriba, la Gravedad queda fuera por surgir infinitos no renormalizables que, desaparecen en la Teoría de supercuerdas de 26 dimensdiones de espacio tiempo para los Bosones y de 10 y 11 dimensiones de espacio tiempo para los Ferniones.

El trabajo que aquí hemos leido lo he obtenido de fuentes diversas y, como tantos otros, nos dice más o menos lo que todos. La realidad de la Teoría de supercuerdas está en que no podemos llegar a ese límite necesario de los 10-35 m, donde supuestamente, está instalada la cuerda, y, como llegar a esa distancia nos exige una energía de 1019 GeV con la que no podemos ni soñar. Seguirán, por mucho tiempo, las especulaciones y cada cual, tendrá su idea, su propia teoría, toda vez que, ninguna de ellas podrá ser verificadas y mientras eso sea así (que lo es), todas las teorías tendrán la posibilidad de ser refrendadas…algún día.

- ¿Dónde estarán las respuestas?

Sin embargo, una cosa es cierta, es la única teoría, la de supercuerdas, que nos da cierta garantía de que vamos por el buen camino, en su desarrollo aparecen indicios confirmados por los experimentos, como por ejemplo, la aparici´çon de una partícula de espín 2, el Gravitón que nos lleva a pensar que, en la teoría de supercuerdas está integrada una teoría Cuántica de la Gravedad que nos, podrá llevar, hasta esos primeros momentos del Big Bang que ahora quedan tan oscuros a la vista de los observadores y, de la misma manera, nos dejará entrar en la Singularidad de un Agujero Negro para poder ver (al fin) lo que allí pueda haber, qué clase de partículas o de materia se ha podido formar en un material tan extremadamente denso como el de la singularidad.

Habrá que tener paciencia con la Teoría de cuerdas y con el hallazgo tan esperado del Gravitón que nos confirmará, al fín, que la Gravedad como las demás interacciones, también está cuantizada y tiene su Bosón transmisor. De lo que no acabo de estar seguro es…del hecho en sí, de que podamos univer la Gravedad con la cuántica…¡son tan dispares! y habitan en reinos tan diferentes.

emilio silvera

Jun

8

¿Qué es un bosón? ¿y que es un bosón gauge?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (4)

Comments (4)

Un bosón es una partícula elemtal (o estado ligado de partículas elementales, por ejemplo, un núcleo atómico o átomo) con espín entero, es decir, una partícula que obedece a la estadísitca de Bose-Einstein (estadísictica cuántica), de la cual deriva su nombre. Los bosones son importantes para el Modelo estándar de las partículas. Son bosones vectoriales de espín uno que hacen de intermediarios de las interacciones gobernadas por teorías gauge.

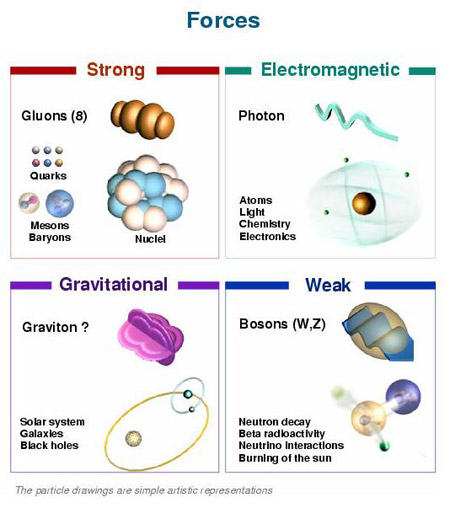

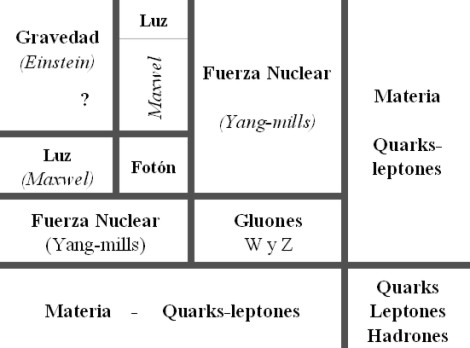

En física se ha sabido crear lo que se llama el Modelo estándar y, en él, los Bosones quedan asociados a las tres fuerzas que lo conforman, el fotón es el Bosón intermediario del electromagnetismpo, los W+, w– y Zº son bosones gauge que transmiten la fiuerza en la teoría electrodébil, mientras que los gluones son los bosones de la fuerza fuerte, los que se encargan de tener bien confinados a los Quarks conformando protones y neutrones para que el núcleo del átomo sea estable. La Gravedad, no se ha dejado meter en el modelo y, por eso su bosón no es de gauge. El gravitón que sería la partícula mediadora de la gravitación sería el hipótetico cuanto de energía que se intercambia en la interacción gravitacional.

Ejemplos de los Bosones gauge son los fotones en electrodinámioca cuántica (en física, el fotón se representa normalmente con el símbolo  , que es la letra griega gamma), los gluones en cromodinámica cuántica y los bosones W y Z en el modelo de Winberg-Salam en la teoría electrodébil que unifica el electromagnetismo con la fuerza débil. Si la simetría gauge de la teoría no está rota, el bosón gauge es no masivo. Ejemplos de nbosones gauge no masivos son el fotón y el gluón.

, que es la letra griega gamma), los gluones en cromodinámica cuántica y los bosones W y Z en el modelo de Winberg-Salam en la teoría electrodébil que unifica el electromagnetismo con la fuerza débil. Si la simetría gauge de la teoría no está rota, el bosón gauge es no masivo. Ejemplos de nbosones gauge no masivos son el fotón y el gluón.

Si la simetría gauge de la teoría es una simetría rota el bosón gauge tiene masa no nula, ejemplo de ello son los bosones W y Z . Tratando la Gravedad, descrita según la teoría de la relatividad general, como una teoría gauge, el bosón gauge sería el gravitón, partícula no masiva y de espín dos.

Diagrama de Feynman mostrando el intercambio de un fotón virtual (simbolizado por una línea ondulada y  ) entre un positrón y un electrón.De esta manera podemos llegar a comprender la construcción que se ha hecho de las interacciones que están siempre intermediadas por un nosón mensajero de la fuerza.

) entre un positrón y un electrón.De esta manera podemos llegar a comprender la construcción que se ha hecho de las interacciones que están siempre intermediadas por un nosón mensajero de la fuerza.

En el modelo estándar, como queda explicado, hay tres tipos de bosones de gauge: fotones, bosones W y Z y gluones. Cada uno corresponde a tres de las cuatro interacciones: fotones son los bosones de gauge de la interacciones electromagnética, los bosones W y Z traen la interacción débil, los gluones transportan la interacción fuerte. El gravitón, que sería responsable por la interacción gravitacional, es una proposición teórica que a la fecha no ha sido detectada. Debido al confinamiento del color, los gluones aislados no aparecen a bajas energías.

Aquí, en el gráfico, quedan representadas todas las partículas del Modelo estándar, las familias de Quarks y Leptones que conforman la materia y los bones que intermedian en las interacciones o fuerzas fundamentales que están presentes en el Universo. La Gravedad no ha podido ser incluida y se ha negado a estar unida a las otras fuerzas. Así el bosón que la transnmite, tampoco está en el modelo que es incompleto al dejar fuera la fuerza que mantiene unidos los planetas en los sistemas solares, a las galaxias en los cúmulos y nuestros pies unidos a la superficie del planeta que habitamos. Se busca una teoría que permita esta unión y, los físicos, la laman gravedad cuántica pero… ¡no aparece por ninguna parte!

Max Planck

Llegados a este punto tendremos que retroceder, para poder comprender las cosas, hasta aquel trabajo de sólo ocho páginas que publicó Max Planck en 1.900 y lo cambió todo. El mismo Planck se dio de que, todo lo que él había tenido por cierto durante cuarenta años, se derrumbaba con ese trabajo suyo que, venía a decirnos que el mundo de la materia y la nergía estaba hecho a partir de lo que el llamaba “cuantos”.

Supuso el nacimiento de la Mecánica Cuántica (MC), el fin del determinismo clásico y el comienzo de una nueva física, la Física Moderna, de la que la Cuántica sería uno de sus tres pilares junto con la Relatividad y la Teoría del Caos. Más tarde, ha aparecido otra teoría más moderna aún por comprobar, ¿las cuerdas…?

El universo según la teoría de las cuerdas sería entonces una completa extensa polícroma SINFONIA ETERNA de vibraciones, un multiverso infinito de esferas, una de ellas un universo independiente causalmente, en una de esas esferas nuestra vía láctea, en ella nuestro sistema solar, en él nuestro planeta, el planeta tierra en el cual por una secuencia milagrosa de hechos se dió origen a la vida autoconsciente que nos permite preguntarnos del cómo y del por qué de todas las cosas que podemos observar y, también, de las que intiuimos que están ahí sin que se dejen ver.

En el “universo cuántico” pueden suceder cosas que en el macromundo no se entenderían. Sin embargo, a base de estudio y observación, hemos llegado a comprenderlas y, por muy raro que nos parezcan esos fenómenos, todos ellos tienen su explicación científica.

Claro que, cuando nos adentramos en ese minúsculo “mundo” de lo muy pequeño, las cosas difieren y se apartan de lo que nos dicta el sentido común que, por otra parte, es posible que sea el común de los sentidos. Nos dejamos guiar por lo que observamos, por ese mundo macroscópico que nos rodea y, no somos consciente de ese otro “mundo” que está ahí formando parte del universo y que, de una manera muy importante incide en el mundo de lo grande, sin lo que allí existe, no podría existir lo que existe aquí.

Interacciones en la naturaleza

Albert Einstein habría dicho que “es más importante la imaginación que el conocimiento”, el filósofo Nelson Goodman ha dicho que “las formas y las leyes de nuestros mundos no se encuentran ahí, ante nosotros, listas ser descubiertas, sino que vienen impuestas por las versiones-del-mundo que nosotros inventamos – ya sea en las ciencias, en las artes, en la percepción y en la práctica cotidiana-.”

Sin embargo yo, humilde pensador, me decanto por el hecho cierto de que, nuestra especie, siempre llegó al conocimiento a través de la imaginación y la experiencia primero, a la que más tarde, acompañó largas secciones de estudio y muchas horas de mediatación y, al final de todo eso, llego la experimentación que hizo posible llegar a lugarés ignotos que antes nunca, habían podido ser visitados. De todo ello, pudieron surgir todos esos “nuevos mundos” que, como la Mecanica Cuántica y la Relatividad, nos describían el propio mundo que nos era desconocido.

Cuando comencé éste trabajo sólo quería dar una simple explicación de los bosones y su intervención en el mundo de lo muy pequeño pero…

Demócrito de Abdera

No estaría mal echar una mirada hacia atrás en el tiempo y recordar, en este momento, a Demócrito que, con sus postulados, de alguna manera venía a echar un poco de luz sobre el asunto, dado que él decía que para determinar si algo era un á-tomo habría que ver si era indivisible. En el modelo de los quarks, el protón, en realidad, un conglomerado pegajoso de tres quarks que se mueven rápidamente. Pero como esos quarks están siempre ineludiblemente encadenados los unos a los otros por bosones llamados Gluones, experimentalmente el protón aparece indivisible.

Acordémonos aquí de que Boscovich decía que, una partícula elemental, o un “á-tomo”, tiene que ser puntual. Y, desde luego, esa , no la pasaba el protón. El equipo del MIT y el SLAC, con la asesoría de Feynman y Bjorken, cayó en la cuenta de que en este caso el criterio operativo era el de los “puntos” y no el de la indivisibilidad. La traducción de sus a un modelo de constituyentes puntuales requería una sutileza mucho mayor que el experimento de Rutherford.

Precisamente por eso era tan conveniente fue tan conveniente para Richard Edward Taylor y su equipo, tener a dos de los mejores teóricos del mundo en el equipo aportando su ingenio, agudeza e intuición en todas las fases del proceso experimental. El resultado fue que los indicaron, efectivamente, la presencia de objetos puntuales en movimiento dentro del protón.

En 1990 Taylor, Friedman y Kendall recogieron su premio Nobel por haber establecido la realidad de los quarks. Sin embargo, a mí lo que siempre me ha llamado más la atención es el hecho cierto de que, este descubrimiento como otros muchos (el caso del positrón de Dirac, por ejemplo), han posible gracias al ingenio de los teóricos que han sabido vislumbrar cómo era en realidad la Naturaleza.

A todo esto, una buena sería: ¿cómo pudieron ver este tipo de partículas de tamaño infinitesimal, si los quarks no están libres y están confinados -en este caso- dentro del protón? Hoy, la tiene poco misterio sabiendo lo que sabemos y hasta donde hemos llegado con el LHC que, con sus inmensas energías “desmenuza” un protón hasta dejar desnudos sus más íntimos secretos.

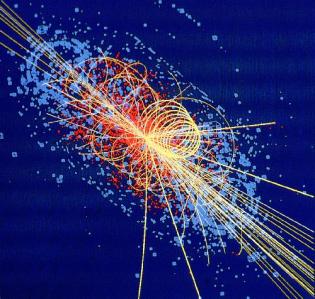

Este es, el resultado ahora de la colisión de protones en el LHC

Lo cierto es que, en su momento, la teoría de los Quarks hizo muchos conversos, especialmente a medida que los teóricos que escrutaban los fueron imbuyendo a los quarks una realidad creciente, conociendo mejor sus propiedades y convirtiendo la incapacidad de ver quarks libres en una virtud. La de moda en aquellos momentos era “confinamiento”. Los Quarks están confinados permanentemente porque la energía requerida para separarlos aumenta a medida que la distancia entre ellos crece. Esa es, la fuerza nuclear fuerte que está presente dentro del átomo y que se encarga de transmitir los ocho Gluones que mantienen confinados a los Quarks.

Así, cuando el intento de separar a los Quarks es demasiado intenso, la energía se vuelve lo bastante grande para crear un par de quark-anti-quark, y ya tenemos cuatro quarks, o dos mesones. Es como intentar un cabo de cuerda. Se corta y… ¡ya tenemos dos!

¿Cuerdas? Me parece que estoy confundiendo el principal objetivo de este trabajo y, me quiero situar en el tiempo futuro que va, desde los quarks de Gell-Mann hasta las cuerdas de Veneziano y John Schwarz y más tarde Witten. Esto de la Física, a veces te juega malas pasadas y sus complejos caminos te llevan a confundir conceptos y momentos que, en realidad, y de manera individualizada, todos han tenido su propio tiempo y lugar.

¿Cuántas veces no habré pensado, en la posibilidad de tomar el elixir de la sabiduría para poder comprenderlo todo? Sin embargo, esa pósima mágica no existe y, si queremos , el único camino que tenemos a nuestro alcance es la observación, el estudio, el experimento… ¡La Ciencia!, que en definitiva, es la única que nos dirá como es, y como se producen los fenómenos que podemos contemplar en la Naturaleza y, si de camino, podemos llegar a saber el por qué de su comportamiento… ¡mucho mejor!

El camino será largo y, a veces, penoso pero… ¡llegaremos!

Nuestra insaciable curiosidad nos llevará lejos en el saber del “mundo”. llegaremos al corazón mismo de la materia para conmprobar si allí, como algunos imaginan, habitan las cuerdas vibrantes escondidas tan profundamente que no se dejan ver. Sabremos de muchos mundos habitados y podremos hacer ese primer contacto tántas veces soñado con otros seres que, lejos de nuestro región del Sistema solar, también, de manera independiente y con otros nombres, descubrieron la cuántica y la relatividad. Sabremos al fín qué es la Gravedad y por qué no se dejaba juntar con la cuántica. Podremos realizar maravillas que ahora, aunque nuestra imaginación es grande, ni podemos intuir por no tener la información necesaria que requiere la imaginación.

En fín, como decía Hilbert: ¡”Tenemos que saber, sabremos”!

emilio silvera

Jun

8

Entrelazamiento Cuántico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

En 1935 un molesto Albert Einstein, junto con sus colegas Podolsky y Rosen, presentaron la llamada “paradoja EPR”, por sus iniciales. Esta quería servir de ejemplo para decir que la mecánica cuántica era una “teoría” incompleta y fallida. Que necesitaba de una profunda revisión. ¿Y por qué? Porque, según el propio Einstein, este conjunto de hipótesis violaba el universo tal y como lo conocemos. Por lo tanto, tenía que estar mal en algún punto. Sin embargo, lo que no sabía Einstein es que la paradoja presentada es en realidad una manifestación real de lo que ocurre en la naturaleza. Efectivamente, en los tiempos que corren hemos podido comprobar un fenómeno inquietante y extraordinario que permite que dos partículas separadas entre sí por una distancia monstruosa sean capaces de “comunicarse” sin que exista nada, ningún canal de transmisión, entre las dos. A este extraño fenómeno, que rompe por completo nuestra manera de entender el mundo, lo llamamos entrelazamiento cuántico.

Científicos del Instituto de Óptica Cuántica e Información Cuántica (IQOQI) de la Academia Austríaca de Ciencias, de la Universidad de Viena y de la Universidad Autónoma de Barcelona (UAB) han conseguido por primera vez entrelazar tres partículas de luz o fotones utilizando una propiedad cuántica relacionada con el retorcimiento (twist) de la estructura de sus frentes de onda.

De la misma manera que el famoso gato de Schrödinger está simultáneamente vivo y muerto, todas las demostraciones experimentales realizadas hasta ahora de entrelazamiento de varias partículas han sido llevadas a cabo con objetos cuánticos en dos dimensiones, dos niveles discretos posibles. Los fotones retorcidos utilizados en el experimento de Viena no tienen ese límite bidimensional y pueden existir en tres o más estados cuánticos vez.

El estado de entrelazamiento entre tres fotones creado por el grupo de Viena bate el récord previo de dimensionalidad, y da luz a una nueva forma de entrelazamiento asimétrico que nunca ha sido observado hasta ahora. Los resultados aparecen esta semana publicados en Nature Photonics.

El entrelazamiento es una propiedad antiintuitiva de la física cuántica que siempre ha desconcertado a los científicos y los filósofos. Los cuantos de luz entrelazados parecen ejercer una influencia entre ellos, no importa la distancia a la que se encuentren. De manera metafórica puede considerarse un patinador de hielo con la asombrosa habilidad de girar sobre sí mismo tanto en el sentido de las agujas del reloj como en el sentido contrario, al mismo tiempo.

Un par de patinadores entrelazados alejándose entre ellos mientras hacen este sorprendente giro tendrán las direcciones de giro perfectamente correlacionadas: si en un instante el primero gira en un sentido, también lo hace el otro, aunque estén tan lejos que terminen en pistas en continentes diferentes.

“Los fotones entrelazados de nuestro experimento se pueden ilustrar no con dos, sino con tres patinadores, danzando una coreografía cuántica pefectamente sincronizada”, explica Mehul Malik, el primer autor del artículo. “Su danza es un poco más compleja, con dos de los patinadores mostrando, además, otro movimiento correlacionado, además del giro mencionado. De hecho, somos los primeros que hemos conseguido este tipo de entrelazamiento cuántico asimétrico en el laboratorio”, continúa Malik.

Los investigadores han creado el estado de entrelazamiento entre tres fotones utilizando otro artificio cuántico: han combinado dos pares de fotones con entrelazamiento de alta dimensión de tal manera que era imposible saber de dónde procedía cada uno de los fotones. Aparte de servir como campo de pruebas para estudiar muchos conceptos fundamentales de la mecància cuántica, los estados de entrelazamiento de varios fotones vez, como este, tienen aplicaciones que van desde la computación cuántica hasta la encriptación cuántica.

En esta línea, los autores de la investigación proponen un nuevo tipo de protocolo de criptografía cuántica, basado en este estado de entrelazamiento asimétrico, que permite que diferentes capas de información se compartan de forma asimétrica entre varios emisores y destinatarios con total seguridad.

Los científicos consideran que, aunque todavía habrá que solventar muchos obstáculos técnicos antes de que este protocolo se pueda utilizar en la práctica, el rápido progreso de la tecnología cuántica hace que sea sólo cuestión de tiempo que esta tecnología encuentre su lugar en las redes cuánticas del futuro. “El experimento abre las puertas a un futuro Internet cuántico, con más de dos interlocutores, que permitiría una comunicación de más de dos bits por fotón”, añade Zeilinger.

En la investigación ha participado Mehul Malik, Manuel Erhard, Mario Krenn, Robert Fickler, Anton Zeilinger, del Instituto de Óptica Cuántica e Información Cuántica de la Academia Austríaca de Ciencia (IQOQI) y el investigador del Grupo de información y de Fenómenos Cuánticos del Departamento de Física de la UAB Marcus Huber, físico teórico que ha inventado las técnicas necesarias para analizar el experiemento. La investigación ha sido financiada por la Comisión Europea, el Consejo Europeo de Investigación (ERC) y la Austrian Science Fund (FWF).

(Fuente: UAB)

Jun

5

LOS QUARKS INVISIBLES.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

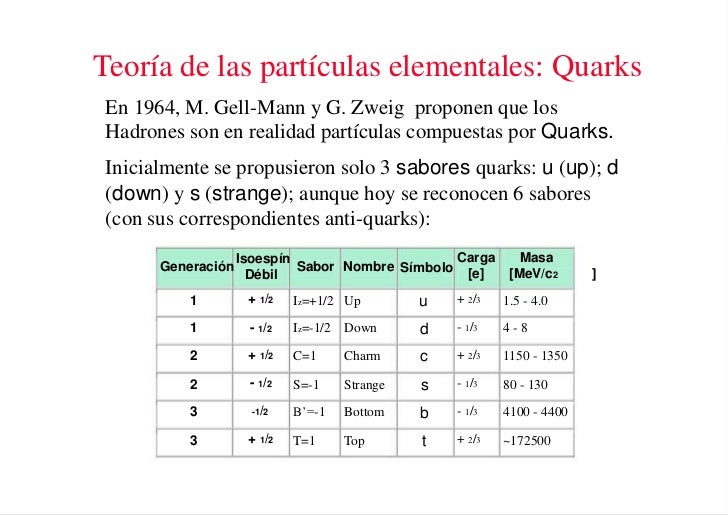

Una vez que se ha puesto orden entre las numerosas especies de partículas, se puede reconocer una pauta. Igual que Dimitri Ivanovich Mendeleev descubrió el sistema periódico de los elementos químicos en 1869, así también se hizo visible un sistema similar para las partículas. Esta pauta la encontraron independientemente el americano Murray Gell-Mann y el israelí Yuval Ne’eman. Ocho especies de mesones, todos con el mismo espín, u ocho especies de bariones, con el mismo espín, se podían reagrupar perfectamente en grupos que llamaremos multipletes. El esquema matemático correspondiente se llama SU(3). Grupletes de ocho elementos forman un octete “fundamental”. Por esta razón Gell-Mann llamó a esta teoría el “óctuplo camino”. Lo tomó prestado del budismo de acuerdo con el cual el camino hacia el nirvana es el camino óctuplo.

Pero las matemáticas SU(3) también admiten multipletes de diez miembros. Cuando se propuso este esquema se conocían nueve bariones con espín 3/2. Los esquemas SU(3) se obtienen al representar dos propiedades fundamentales de las partículas, la extrañeza S frente al isoespín I₃ , en una gráfica.

Imagen de trazas en la cámara de burbujas del primer evento observado incluyendo bariones Ω, en el Laboratorio Nacional Brookhaven.

De esta manera, Gell-Mann predijo un décimo barión, el omega-menos (Ω¯), y pudo estimar con bastante precisión su masa porque las masas de los otros nueve bariones variaban de una forma sistemática en el gráfico (también consiguió entender que las variaciones de la masa eran una consecuencia de una interacción simple). Sin embargo, estaba claro que la Ω¯, con una extrañeza S = -3, no tenía ninguna partícula en la que desintegrarse que no estuviera prohibida por las leyes de conservación de la interacción fuerte. De modo que, la Ω¯ sólo podía ser de tan sólo 10¯²³ segundos como los demás miembros del multiplete, sino que tenía que ser del orden de 10¯¹⁰ segundos. Consecuentemente, esta partícula debería viajar varios centímetros antes de desintegrarse y esto la haría fácilmente detectable. La Ω¯ fue encontrada en 1964 con exactamente las mismas propiedades que había predicho Gell-Mann.

Se identificaron estructuras multipletes para la mayoría de los demás bariones y mesones y Gell-Mann también consiguió explicarlas. Sugirió que los mesones, igual que los bariones, debían estar formados por elementos constitutivos “más fundamentales aún”. Gell-Mann trabajaba en el Instituto de Tecnología de California en Pasadena (CalTech), donde conversaba a menudo con Richard Feynman. Eran ambos físicos famosos pero con personalidades muy diferentes. Gell-Mann, por ejemplo, es conocido como un entusiasta observador de Pájaros, familiarizado con las artes y la literatura y orgulloso de su conocimiento de lenguas extranjeras. Feynman fue un hombre hecho a sí mismo, un analista riguroso que se reía de cualquier cosa que le recordara la autoridad establecida. Hay una anécdota que parece no ser cierta de hecho, pero que me parece tan buena que no puedo evitar el contarla; podía haber sucedido de esta forma. Gell-Mann le dijo a Feynman que tenía un problema, que estaba sugiriendo un nuevo tipo de ladrillos constitutivos de la materia y que no sabía qué nombre darles. Indudablemente debía haber de haber pensado en utilizar terminología latina o griega, como ha sido costumbre siempre en la nomenclatura científica. “Absurdo”, le dijo Feynman; “tú estás hablando de cosas en las que nunca se había pensado antes. Todas esas preciosas pero anticuadas palabras están fuera de lugar. ¿Por qué no los llamas simplemente “shrumpfs”, “quacks” o algo así?”.

Cuando algún tiempo después le pregunté a Gell-Mann, éste negó que tal conversación hubiera tenido lugar. Pero la palabra elegida fue quark, y la explicación de Gell-Mann fue que la palabra venía de una frase de Fynnegan’s Wake de James Joyce; “¡Tres quarks para Muster Mark!”. Y, efectivamente así es. A esas partículas les gusta estar las tres juntas. Todos los bariones están formados por tres quarks, mientras que los mesones están formados por un quark y un antiquark.

Los propios quarks forman un grupo SU(3) aún más sencillo. Los llamaremos “arriba (u)”, “abajo” (d), y “extraño” (s). Las partículas “ordinarias” contienen solamente quarks u y d. Los hadrones “extraños” contienen uno o más quarks s (o antiquarks ŝ).

La composición de quarks de espín 3/2 se puede ver en la tabla 5. La razón por la que los bariones de espín ½ sólo forman un octete es más difícil de explicar. Está relacionada con el hecho de que en estos estados, al menos dos de los quarks tienen que ser diferentes unos de otros.

Realmente, la idea de que los hadrones estuvieran formados por ladrillos fundamentales sencillos había sido también sugerida por otros. George Zweig, también en el CalTech, en Pasadena, había tenido la misma idea. Él había llamado a los bloques constitutivos “ases!, pero es la palabra “quark” la que ha prevalecido. La razón por la que algunos nombres científicos tienen más éxito que otros es a veces difícil de comprender.

Pero en esta teoría había algunos aspectos raros. Aparentemente, los quarks (o ases) siempre existen en parejas o tríos y nunca se han visto solos. Los experimentadores habían intentado numerosas veces detectar un quark aislado en aparatos especialmente diseñados para ello, pero ninguno había tenido éxito.

Loa quarks –si se pudieran aislar- tendrían propiedades incluso más extrañas. Por ejemplo, ¿cuáles serían sus cargas eléctricas? Es razonable suponer que tanto los quarks u como los quarks s y d deban tener siempre la misma carga. La comparación de la tabla 5 con la tabla 2 sugiere claramente que los quarks d y s tienen carga eléctrica -1/3 y el quark u tiene carga +2/3. Pero nunca se han observado partículas que no tengan carga múltiplo de la del electrón o de la del protón. Si tales partículas existieran, sería posible detectarlas experimentalmente. Que esto haya sido imposible debe significar que las fuerzas que las mantienen unidas dentro del hadrón son necesariamente increíblemente eficientes.

Aunque con la llegada de los quarks se ha clarificado algo más la flora y la fauna de las partículas subatómicas, todavía forman un conjunto muy raro, aún cuando solamente unas pocas aparezcan en grandes cantidades en el universo (protones, neutrones, electrones y fotones). Como dijo una vez Sybren S. de Groot cuando estudiaba neutrinos, uno realmente se enamora de ellos. Mis estudiantes y yo amábamos esas partículas cuyo comportamiento era un gran misterio. Los leptones, por ser casi puntuales, son los más sencillos, y por tener espín se ven afectados por la interacción que actúa sobre ellos de forma muy complicada, pero la interacción débil estaba bastante bien documentada por entonces.

Los hadrones son mucho más misteriosos. Los procesos de choque entre ellos eran demasiado complicados para una teoría respetable. Si uno se los imagina como pequeñas esferas hachas de alguna clase de material, aún quedaba el problema de entender los quarks y encontrar la razón por la que se siguen resistiendo a los intentos de los experimentadores para aislarlos.

Si queréis saber más sobre el tema, os recomiendo leer el libro Partículas de Gerard ´t Hooft

Totales: 85.696.234

Totales: 85.696.234 Conectados: 50

Conectados: 50