Ago

2

¿La teoría cuántica y la Gravedad, dentro de las cuerdas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (13)

Comments (13)

Todo se degrada con el paso del Tiempo

Sí, a veces la Física, parece un Carnaval. Imaginamos universos que… ¿serán posibles?

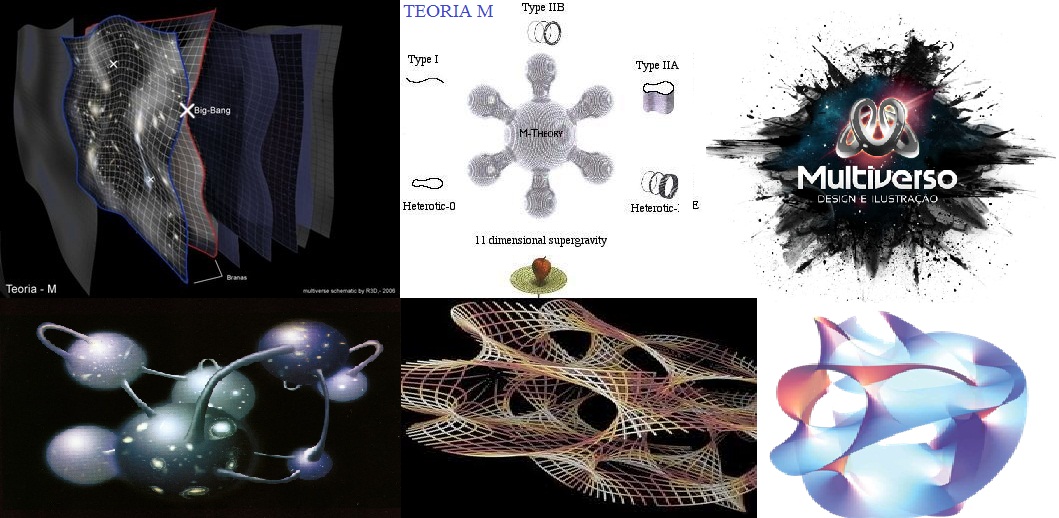

Las teorías de cuerdas [TC’s] no son una invención nueva, ni mucho menos. La primera TC se inventó a finales de los años sesenta del siglo XX en un intento para encontrar una teoría para describir la interacción fuerte. La idea medular consistía en que partículas como el protón y el neutrón podían ser consideradas como ondas de «notas de una cuerda de violín». La interacción fuerte entre las partículas correspondería a fragmentos de cuerda que se extenderían entre pequeños pedacitos de cuerda, como las telas que forman algunos simpáticos insectos. Para que esta teoría proporcionase el valor observado para la interacción fuerte entre partículas, las cuerdas tendrían que ser semejantes a las de un violín, pero con una tensión de alrededor de unas diez toneladas.

La primera expresión de las TC’s fue desarrollada por Jöel Scherk, de París, y John Schwuarz, del Instituto de Tecnología de California, quienes en el año 1974 publicaron un artículo en el que demostraban que la TC podía describir la fuerza gravitatoria, pero sólo si la tensión en la cuerda se tensiometrara alrededor de un trillón de toneladas métricas. Las predicciones de la teoría de cuerdas serían las mismas que las de la relatividad general a escala de longitudes normales, pero diferirían a distancias muy pequeñas, menores que una trillonésima de un cm. Claro está, que en esos años, no recibieron mucha atención por su trabajo.

Ahora se buscan indicios de la teoría de cuerdas en los grandes aceleradores de partículas donde parece que algunos indicios nos dicen que se va por el buen camino, sin embargo, nuestros aceleradores más potentes necesitarían multiplicar por un número muy elevado su potencia para poder, comprobar la existencia de las cuerda situadas a una distancia de 10-35 m, lugar al que nos será imposible llegar en muchas generaciones. Sin embargo, en las pruebas que podemos llevar a cabo en la actualidad, aparecen indicios de una partlicula de espín 2 que todos asocian con el esquivo Gravitón, y, tal indicio, nos lleva a pensar que, en la teoría de supercuerdad, está implícita una Teoría Cuántica de la Gravedad.

Los motivos que tuvo la comunidad científica, entonces, para no brindarle la suficiente atención al trabajo de Scherk y Schwuarz, es que, en esos años, se consideraba más viable para describir a la interacción fuerte a la teoría basada en los quarks y los gluones, que parecía ajustarse mucho mejor a las observaciones. Desafortunadamente, Scherk murió en circunstancias trágicas (padecía diabetes y sufrió un coma mientras se encontraba solo en su estudio). Así, Schwuarz se quedó solo, en la defensa de la teoría de cuerdas, pero ahora con un valor tensiométrico de las cuerdas mucho más elevado.

Pero con los quarks, gluones y también los leptones, en la consecución que se buscaba, los físicos entraron en un cuello de botella. Los quarks resultaron muy numerosos y los leptones mantuvieron su número e independencia existencial, con lo cual seguimos con un número sustancialmente alto de partículas elementales (60), lo que hace que la pregunta ¿son estos los objetos más básicos?

Si esos sesenta objetos fuesen los más básicos, entonces también aflora otra pregunta ¿por qué son como son y por qué son tantos? Los físicos quisieran poder decir «salen de esto», o «salen de esto y aquello», mencionar dos principios bien fundamentales y ojalá sea tan simples que puedan ser explicados a un niño. La respuesta «porque Dios lo quiso así» posiblemente a muchos les cause «lipotimia», ya que esa respuesta nos lleva a reconocer nuestra ignorancia y, además, la respuesta que esperamos no pertenece al ámbito de la religión. Por ahora, ¿cuál es la última respuesta que puede dar la ciencia?

El cuello de botella incentivó a que se encendiera una luz de esperanza. En 1984 el interés por las cuerdas resucitó de repente. Se desempolvaron las ideas de Kaluza y Klein, como las que estaban inconclusas de Scherk y Schwuarz. Hasta entonces, no se habían hecho progresos sustanciales para explicar los tipos de partículas elementales que observamos, ni tampoco se había logrado establecer que la supergravedad era finita.

El ser humano –en función de su naturaleza– cuando se imagina algo muy pequeño, piensa en un puntito de forma esférica. Los físicos también son seres de este planeta y, para ellos, las partículas elementales son como puntitos en el espacio, puntos matemáticos, sin extensión. Son sesenta misteriosos puntos y la teoría que los describe es una teoría de puntos matemáticos. La idea que sugieren las TC’s es remplazar esos puntos por objetos extensos, pero no como esferitas sino más bien como cuerdas. Mientras los puntos no tienen forma ni estructura, las cuerdas tienen longitud y forma, extremos libres como una coma “,” (cuerda abierta), o cerradas sobre sí misma como un minúsculo círculo . Si el punto es como una minúscula esfera inerte de la punta de un elástico, la cuerda es el elástico estirado y con él se pueden hacer círculos y toda clase de figuras. Está lleno de posibilidades.

Muchas son las imágenes que se han elaborado para representar las cuerdas y, como nadie ha visto nunca ninguna, cualquiera de ellas vale para el objetivo de una simple explicación y, las cuerdas que se han imaginado han tomado las más pintorescas conformaciones para que, en cada caso, se adapten al modelo que se expone.

diferencia entre un punto y una coma. Según la teoría de cuerdas importa, y mucho. Por su extensión, a diferencia del punto, la cuerda puede vibrar. Y hacerlo de muchas maneras, cada modo de vibración representando una partícula diferente. Así, una misma cuerda puede dar origen al electrón, al fotón, al gravitón, al neutrino y a todas las demás partículas, según cómo vibre. Por ello, la hemos comparado con la cuerda de un violín, o de una guitarra, si se quiere.

Al dividir la cuerda en dos, tres, cuatro, cinco, o más partes iguales, se generan las notas de la escala musical que conocemos, o técnicamente, los armónicos de la cuerda. En general, el sonido de una cuerda de guitarra o de piano es una mezcla de armónicos. Según la mezcla, la calidad (timbre) del sonido. Si distinguimos el tono de estos instrumentos, es por la «receta» de la mezcla en cada caso, por las diferentes proporciones con que cada armónico entra en el sonido producido. Pero, también es posible hacer que una buena cuerda vibre en uno de esos armónicos en particular, para lo cual hay que tocarla con mucho cuidado. Los concertistas lo saben, y en algunas obras como los conciertos para violín y orquesta, usan este recurso de «armónicos». Así, la naturaleza, con su gran sabiduría y cuidado para hacer las cosas, produciría electrones, fotones, gravitones, haciendo vibrar su materia más elemental, esa única y versátil cuerda, en las diversas (infinitas) formas que la cuerda permite.

Una partícula ocupa un punto del espacio en todo momento. Así, su historia puede representarse mediante una línea en el espacio-tiempo que se le conoce como «línea del mundo». Por su parte, una cuerda ocupa una línea en el espacio, en cada instante de tiempo. Por tanto, su historia en el espaciotiempo es una superficie bidi-mensional llamada la «hoja del mundo». Cualquier punto en una hoja del mundo puede ser descrito mediante dos números: uno especificando el tiempo y el otro la posición del punto sobre la cuerda. Por otra parte, la hoja del mundo es una cuerda abierta como una cinta; sus bordes representan los caminos a través del espaciotiempo (flecha roja) de los extremos o comas de la cuerda (figura 12.05.03.02). La hoja del mundo de una cuerda cerrada es un cilindro o tubo (figura 12.05.03.03); una rebanada transversal del tubo es un círculo, que representa la posición de la cuerda en un momento del tiempo.

No cabe duda que, de ser ciertas las TC’s, el cuello de botella queda bastante simplificado. Pasar de sesenta objetos elementales a una sola coma o circulito es un progreso notable. Entonces, ¿por qué seguir hablando de electrones, fotones, quarks, y las demás?

Que aparentemente las cosas se simplifican con las TC’s, no hay duda, pero desafortunadamente en física las cosas no siempre son como parecen. Para que una teoría sea adoptada como la mejor, debe pasar varias pruebas. No basta con que simplifique los esquemas y sea bella. La teoría de las cuerdas está –se puede decir– en pañales y ha venido mostrado distintas facetas permeables. Surgen problemas, y se la deja de lado; se solucionan los problemas y una avalancha de trabajos resucitan la esperanza. En sus menos de treinta años de vida, este vaivén ha ocurrido más de una vez.

Uno de los problemas que más afecta a la cuerda está ligado con su diminuto tamaño. Mientras más pequeño algo, más difícil de ver. Es una situación que se agudiza en la medida que se han ido corrigiendo sus permeabilidades. En sus versiones más recientes, que se llaman supercuerdas, son tan superpequeñas que las esperanzas de ubicarlas a través de un experimento son muy remotas. Sin experimentos no podemos comprobar sus predicciones ni saber si son correctas o no. Exagerando, es como una teoría que afirmara que los angelitos del cielo tienen alitas. ¿Quién la consideraría seriamente?

La propia base conceptual de la teoría comporta problemas. Uno de ellos, es el gran número de dimensiones que se usan para formularla. En algunos casos se habla de 26 o, en el mejor, de 10 dimensiones para una cuerdita: espacio (son 3), tiempo (1) y otras seis (o 22) más, que parecen estar enroscadas e invisibles para nosotros. Por qué aparecieron estas dimensiones adicionales a las cuatro que nos son familiares y por qué se atrofiaron en algún momento, no lo sabemos. También, la teoría tiene decenas de miles de alternativas aparentemente posibles que no sabemos si son reales, si corresponden a miles de posibles universos distintos, o si sólo hay una realmente posible. Algunas de estas versiones predicen la existencia de 496 fuerzones, partículas como el fotón, que transmiten la fuerza entre 16 diferentes tipos de carga como la carga eléctrica. Afirmaciones como éstas, no comprobables por la imposibilidad de hacer experimentos, plagan la teoría de cuerdas. Quienes alguna vez intentaron trabajar matemáticamente en las cuerdas, muchas veces deben haber pensado de que lo que estaban calculando más se asemejaba a juegos de ejercicios que la consecución de una base matemática teórica tras objetivo de dar un paso trascendental en el conocimiento de la naturaleza. Ahora, los que tienen puesta su fe en ella suelen afirmar que se trata de una teoría que se desfasó de la natural evolución de la física, que su hallazgo fue un accidente, y no existe aún el desarrollo matemático para formularla adecuadamente.

En las teorías de cuerdas, lo que anteriormente se consideraba partículas, se describe ahora como ondas viajando por las cuerdas, como las notas musicales que emiten las cuerdas vibrantes de un violín. La emisión o absorción de una partícula por otra corresponde a la división o reunión de cuerdas.

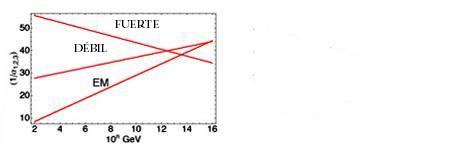

“Al principio se vio como un gran éxito, pero pronto esta “reunificación”, no tan exacta, empezó a dar fallos entre los físicos que trabajaban en las “grandes teorías unificadas”. Como puede verse en la gráfica que representa las intensidades de las fuerzas básicas respecto a la energía expresada en GeV (en la figura se representa en el eje horizontal los exponentes de las potencias de diez), las gráficas no llegan a coincidir en un punto como era de esperar aunque la “tendencia” si se apreciaba unificadora.”

La Teoría de cuerdas trata de incorporar la Gravedad a las otras tres fuerzas y completar asíel panorama actual de la Física de Partículas en el Modelo Estándar en el que sólo están incluidas estas tres interacciones de arriba, la Gravedad queda fuera por surgir infinitos no renormalizables que, desaparecen en la Teoría de supercuerdas de 26 dimensciones de espacio tiempo para los Bosones y de 10 y 11 dimensiones de espacio tiempo para los Fermiones.

El trabajo que aquí hemos leído lo he obtenido de fuentes diversas y, como tantos otros, nos dice más o menos lo que todos. La realidad de la Teoría de supercuerdas está en que no podemos llegar a ese límite necesario de los 10-35 m, donde supuestamente, está instalada la cuerda, y, como llegar a esa distancia nos exige una energía de 1019 GeV con la que no podemos ni soñar. Seguirán, por mucho tiempo, las especulaciones y cada cual, tendrá su idea, su propia teoría, toda vez que, ninguna de ellas podrá ser verificadas y mientras eso sea así (que lo es), todas las teorías tendrán la posibilidad de ser refrendadas…algún día.

- ¿Dónde estarán las respuestas?

Sin embargo, una cosa es cierta, es la única teoría, la de supercuerdas, que nos da cierta garantía de que vamos por el buen camino, en su desarrollo aparecen indicios confirmados por los experimentos, como por ejemplo, la aparici´çon de una partícula de espín 2, el Gravitón que nos lleva a pensar que, en la teoría de supercuerdas está integrada una teoría Cuántica de la Gravedad que nos, podrá llevar, hasta esos primeros momentos del Big Bang que ahora quedan tan oscuros a la vista de los observadores y, de la misma manera, nos dejará entrar en la Singularidad de un Agujero Negro para poder ver (al fin) lo que allí pueda haber, qué clase de partículas o de materia se ha podido formar en un material tan extremadamente denso como el de la singularidad.

Habrá que tener paciencia con la Teoría de cuerdas y con el hallazgo tan esperado del Gravitón que nos confirmará, al fín, que la Gravedad como las demás interacciones, también está cuantizada y tiene su Bosón transmisor. De lo que no acabo de estar seguro es…del hecho en sí, de que podamos univer la Gravedad con la cuántica…¡son tan dispares! y habitan en reinos tan diferentes.

emilio silvera

Jul

20

¡La Luz! ¡La Mecánica Cuántica! Nuestro Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

Cuando en nuestro Uni9verso quedaron libres los fotones… ¡Se hizo la Luz!

En alguna parte he podido leer que para comprender la realidad en sus niveles más elementales, basta con conocer el comportamiento de dos infinitesimales objetos: el electrón y el fotón. Todo el argumento de la QED [electrodinámica cuántica] gira en torno a un proceso fundamental: la emisión de un único fotón por un único electrón.

Cuando el movimiento de un electrón es alterado súbitamente, puede responder desprendiendo un fotón. La emisión de un fotón es el suceso básico de la mecánica cuántica:

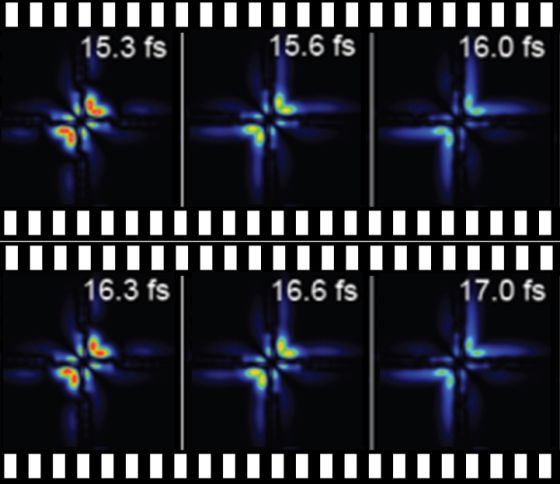

Un equipo de científicos lograron filmar por primera vez un electrón en movimiento gracias a una tecnología reciente que genera pulsos cortos e intensos de luz láser.

Toda la luz visible que vemos, así como las ondas de radio, la radiación infrarroja y los rayos X, está compuesta de fotonesque han sido emitidos por electrones, ya sea en el Sol, el filamento de una bombilla, una antena de radio o un aparato de rayos.

Los electrones no son las únicas partículas que pueden emitir fotones. Cualquier partícula eléctricamente cargada puede hacerlo, incluido el protón. Esto significa que los fotones pueden saltar entre dos protones o incluso entre un protón y un electrón. Este hecho es de enorme importancia para toda la ciencia y la vida en general. El intercambio continuo de fotonesentre el núcleo y los electrones atómicos proporciona la fuerza que mantiene unido al átomo. Sin estos fotones saltarines, el átomo se desharía y toda la materia dejaría de existir.

|

Se ha conseguido observar por primera vez la desintegración radiativa del neutrón.

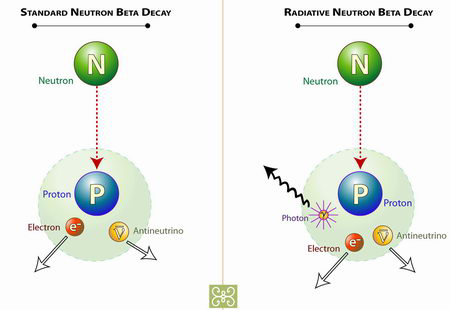

Dentro de los núcleos de los átomos hay neutrones y protones. En condiciones normales y mientras que están ahí los neutrones son estables. Sin embargo los neutrones libres son inestables, tienen una vida media de unos 10 minutos, y se desintegran produciendo un protón un electrón y un antineutrino. Pero los físicos nucleares teóricos predijeron que una de cada mil veces los neutrones decaerían en todas esas partículas y además en un fotón.

Típicamente el neutrón decae en un protón, un antineutrino y un electrón. Muy raramente lo hace radiativamente emitiendo además un fotón. Diagrama: Zina Deretsky, National Science Foundation.

Típicamente el neutrón decae en un protón, un antineutrino y un electrón. Muy raramente lo hace radiativamente emitiendo además un fotón. Diagrama: Zina Deretsky, National Science Foundation.

Mientras que un electrón pertenece al grupo de partículas llamadas fermiones, los fotones pertenecen a la familia de los bosones. Intentemos comprender esta película que es la intermediaria de todas las formas de radiación electromagnética.

…protagonizada por bosones…

Los fermiones hacen posible la materia “al estilo tradicional”, mientras que los bosones son elementos muy raros desde la forma de pensar a que estamos acostumbrados el común de los mortales. Para no complicarnos, la tabla periódica de elementos existe porque los fermiones no pueden “ser iguales”: no pueden solaparse uno sobre otro y se repelen si los obligamos. Es lo que damos por hecho cuando hablamos de materia, que cada pedazo de ésta ocupa su lugar y tiene sus propias cualidades.

Toda la materia que conocemos, la que forma las estrellas y los mundos y las galaxias, esa que llamamos luminosa o bariónica, la que emite radiación, está hecha de Leptones y Quarks, partículas que son Fermiones, y, esas otras partículas intermediarias de las cuatro fuerzas fundamentales, son las que pertenecen a la familia de los Bosones, tales como el Fotón, las W+, W- y Zº, los Gluones y el Gravitón.

Los bosones carecen de este sentido de la individualidad que tienen los Fermiones, digamos que poseen “alma grupal” y, en su estado más puro, todos forman una misma “súperpartícula”.

Para entenderlo mejor, conviene recordar que las partículas no son bolitas como nos siguen enseñando en la escuela, sino que más allá de esta imagen existen como ondas o, al menos, sus funciones se equiparan al comportamiento de una onda.

En la década de 1920, Albert Einstein y el hindú Satyendra Nath Bose pronosticaron un quinto estado de la materia: el condensado de Bose-Einstein (BEC), el cual fue conseguido en laboratorio en 1995, algo que le valió el premio Nobel de 2001 a los científicos que lo lograron.

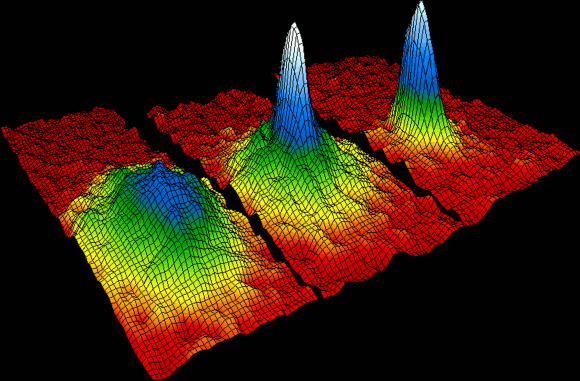

Un condensado de Bose-Einstein es un estado de la materia que se da en ciertos materiales a muy baja temperatura. En este estado de la materia, todos los átomos que lo constituyen se encuentran en el nivel de mínima energía, denominado estado fundamental. Descubierto en 1924 para los fotones por el indio Bose y por Einstein, no fue obtenido en laboratorio hasta 1995 por Cornell y Wieman al enfriar átomos a pocos nanokelvin por encima del cero absoluto. El condensado de Bose-Einstein fue la “molécula del año” según la revista Science en 1995 ya que se trata de un sistema cuántico macroscópico similar a una molécula pero con millones de átomos. Un átomo en un gas se mueve a una velocidad de unos unos 1000 km/h (unos 300 m/s) pero un condensado de Bose-Einstein se mueve a sólo 1 cm/s. Un condensado de Bose-Einstein es respecto a la materia ordinaria, como la luz de un láser es respecto a la de una bombilla. Gracias a ello se puede fabricar un láser de átomos, que en lugar de producir un haz de luz como un láser óptico, produce un haz (coherente) de átomos. En 1997 Ketterle fabricó el primer láser de átomos que producía un haz de átomos de sodio.

Cuando ciertas formas de materia [bosones] se enfrían hasta casi el cero absoluto, sus átomos se ponen en el estado de energía más baja, de modo que todos sus átomos vibran al unísono y se hacen coherentes. Las funciones de onda de todos los átomos se solapan, de manera que, en cierto sentido, un BEC [condensado de Bose-Einstein] es como un “superátomo” gigante en donde todos los átomos individuales vibran al unísono.

Al enfriar los átomos, su velocidad disminuye hasta que las longitudes de onda de cada uno de ellos se vuelven casi planas, superponiéndose unas a otras para formar una única onda que los describe a todos.

Así que un BEC se forma cuando los átomos en un gas sufren la transición de comportarse como “bolas de billar” al estilo de la física clásica, a comportarse como una onda gigante de materia al estilo de mecánica cuántica:

Si creamos dos BECs y los colocamos juntos, no se mezclan como gases ordinarios ni rebotan como lo harían dos sólidos. Donde los dos BECs se superponen, ellos “interfieren” como las ondas: delgadas capas paralelas de materia son separadas por capas delgadas de espacio vacío. El patrón se forma porque las dos ondas se suman donde sus crestas coinciden, y se cancelan donde una cresta se encuentra con un valle — a lo cual llamamos interferencia “constructiva” y “destructiva” respectivamente. El efecto es similar al de dos ondas que se superponen cuando dos piedras son lanzadas a un lago.

…ambientada en el vacío…

Y ahora, retrocedamos un poco más en este asunto del misterio que nos ocupa. Gracias a la tecnología láser, la física ha podido comprobar el extremo poder de la luz. Los láseres pueden hacer que las partículas virtuales se vuelvan reales. Pero, primero, aclaremos conceptos…

Las “Partículas virtuales”son partículas fundamentales que están constantemente surgiendo aparentemente de la nada y permanecen en el espacio-tiempo la friolera de una milésima de trillonésima de segundo –una cantidad que se forma poniendo una veintena de ceros a la derecha de la coma—. A pesar de denominarse “virtuales”, sus efectos son muy reales: la constante agitación de este burbujeo cuántico de partículas hace que el vacío tenga energía. Y esto es algo que afecta a la realidad, pues en ésta las fuerzas de atracción y repulsión dependen de la masa, y la masa no es sino energía expresada en unidades diferentes: E=mc².

Partículas virtuales que surgen de la NADA. Claro que, surgieron,¡es porque había! La Nada no existe.!

En el uso corriente la palabra vacío significa espacio vacío, espacio del que se ha extraído todo el aire, vapor de agua u otro material. Eso es también lo que significa para un físico experimental que trabaja con tubos de vacío y bombas de vacío. Pero para un físico teórico, el término vacío tiene muchas más connotaciones. Significa una especie de fondo en el que tiene lugar el resto de la física. El vacío representa un potencial para todas las cosas que pueden suceder en ese fondo. Significa una lista de todas las partículas elementales tanto como de las constantes de la Naturaleza que se pondrían de manifiesto mediante experimentos en dicho vacío. En resumen, significa un ambiente en el que las leyes de la física toman una forma particular. Un vacío diferente significa leyes de la física diferentes; cada punto en el paisaje representa un conjunto de leyes que son, con toda probabilidad, muy diferentes de las nuestras pero que son, en cualquier caso, posibilidades consistentes. El modelo estándar es meramente un punto en el paisaje de posibilidades.

La energía del vacío es, por tanto, la suma total de las energías de todas las partículas posibles. Es la llamada “energía oscura” que hace que el universo se expanda, haciendo frente a la atracción de la gravedad, y que proporciona alrededor del 80% de la materia-energía al universo –un 26% es “materia oscura”, y sólo un 4% es la materia conocida hasta el momento—.

Pero, ¿cómo una partícula virtual se convierte en real? Es decir, ¿cómo queda “atrapada” en el espacio-tiempo de forma más estable?

¡Los fotones de Yang-Mills adquieren su masa y el principio gauge se sigue cumpliendo! Al principio esta visión no mereció la atención que merecía. Por una parte, la gente pensó que el modelo era feo. El principio gauge estaba ahí, pero ya no era el tema central. El “Campo de Higgs” había sido puesto ahí “a propósito” y la “partícula de Higgs”, en sí misma, no era una “partícula gauge”

La Teoría de la Sipersimetría establece que, por cada partícula de materia, nace una gemela de antimateria. La antimateria es igual que la materia, pero con carga opuesta. Por ejemplo, el electrón tiene carga negativa, y su partícula de antimateria, el positrón, positiva. Materia y antimateria se aniquilan mutuamente pero, por algún motivo aún no aclarado, la simetría se rompió en algún momento, surgiendo más materia que antimateria, de ahí que nuestro universo, materia, pueda existir.

Pero hay algo más en todo esto. Y para ello, la luz es la clave.

Controlar los estados cuánticos macroscópicos de osciladores micromecánicos no es fácil; hacerlo con luz (fotones) requiere el acoplamiento coherente entre …

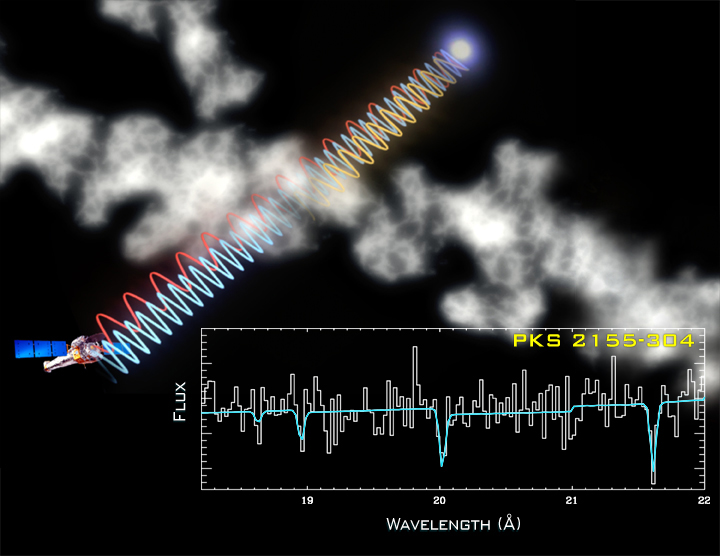

Una de los modelos teóricos elaborados para superar la visión de la gravedad de Einstein indica que los fotones de los rayos gamma de alta energía viajarían algo más despacio que los de baja energía, lo que viola el axioma del sabio alemán acerca de que toda radiación electromagnética, desde las ondas radio hasta los rayos gamma, viajan en el vacío a la misma velocidad (la de la luz). Sin embargo, no ha sido verificado mediante experimento, con lo cual, Einstein sigue teniendo razón.

… protagonizada por la “luz” como la propia …

Ya en los años 30, los físicos predijeron que un campo eléctrico muy fuerte, que no es sino un espacio alterado por la actividad de un montón de fotones coordinados, podría impulsar a las partículas virtuales con carga opuesta en diferentes direcciones, impidiendo que la materia y la antimateria se aniquilen.

Según el efecto de creación de pares, un fotón con energía suficiente, lo que equivale a tener el doble de la energía que posee un electrón en reposo, da lugar a una pareja de electrón y positrón.

Aunque esto ya se consiguió en los años 90 a pequeña escala, gracias al desarrollo de la tecnología láser los científicos creen que estarán cerca de conseguir crear materia “en serie” mediante este proceso en unos pocos años.

Sabemos desde 1932, que un fotón gama con suficiente energía, puede formar un par de antipartículas, al interactuar con un átomo masivo, como el plomo. Pero el problema no termina, sino que, el electrón formado por un rayo gama, no interactúa con este tipo de fotón (gama), sino uno de luz visible,

Por otra parte, una vez que existen las partículas, los fotones interactúan sin cesar con ellas, siendo absorbidos y emitidos por las mismas de manera ininterrumpida.

Y de ello nace el movimiento gracias al cual todo existe en el espacio-tiempo. Sin movimiento, nuestra realidad desaparecería.

La carencia de masa de un fotón está ligada a su movimiento. Para que un cuerpo alcance la velocidad de la luz, su masa ha de ser cero. Y, como Einstein explicó en su día, la luz se mueve siempre a la velocidad de la luz. Si pretendemos que un fotónse pare, en lugar de ralentizarse observaremos que desaparece. Y, como se ha dicho al principio, si estos “fotones saltarines” desaparecieran, toda la materia dejaría de existir.

Su esencia es el movimiento y su misión, según parece, hacer girar la rueda de la existencia.

Ello es así debido al impacto de los fotones sobre las partículas elementales. La energía transmitida por un fotón es inversamente proporcional a su longitud de onda. Cuanto menos longitud de onda, más energía. Así, un fotón de luz visible tiene la energía suficiente para hacer reaccionar a un bastón de la retina. Si nos movemos en el espectro electromagnético, los fotones con longitud de onda ultravioleta pueden expulsar a los electrones de los átomos. Más allá, los rayos gamma pueden romper protones y neutrones…

Y ahora, vayamos al meollo de la cuestión e indaguemos en la cita con que se iniciaba este artículo: ¿qué hace que los electrones absorban y emitan fotones? Esto, en otros términos, vendría a ser lo mismo que preguntarnos: ¿por qué existe nuestro universo?

…con un misterio: el 137…

¿Qué determina el momento exacto en que un electrón emite un fotón? La física cuántica dice que nada lo hace, pues la Naturaleza es caprichosa en sus niveles más elementales. Aunque no es caótica en extremo, sólo probabilística.

A diferencia de la física newtoniana, la mecánica cuántica nunca predice el futuro en función del pasado. En su lugar, ofrece reglas muy precisas para computar la probabilidad de varios resultados alternativos de un experimento.

Y la probabilidad de que un electrón emita o absorba un fotón es la constante de estructura fina. El valor de esa constante es 1/137.

En otras palabras, sólo un afortunado electrón de cada 137 emite un fotón. Este es el significado de alfa: es la probabilidad de que un electrón, cuando se mueve a lo largo de su trayectoria, emita caprichosamente un fotón.

El inverso de la constante de estructura fina es 137. Desde su descubrimiento, éste número ha traído de cabeza a los grandes científicos.

No puedo recordar si fue Richard Feynman o León Lederman, quien sugirió que todos los físicos pusiesen un cartel en sus despachos o en sus casas que les recordara cuánto es lo que no sabemos. En el cartel no pondría nada más que esto: 137. Ciento treinta y siete es el inverso de algo que lleva el nombre de constante de estructura fina. Este número guarda relación con la probabilidad de que un electrón emita o absorba un fotón. La constante de estructura fina responde también al nombre de alfa, y sale de dividir el cuadrado de la carga del electrón por el producto de la velocidad de la luz y la constante de Planck. Tanta palabra no significa otra cosa sino que ese solo número, 137, encierra los meollos del electromagnetismo (el electrón), la relatividad (la velocidad de la luz) y la teoría cuántica (la constante de Planck). Menos perturbador sería que la relación entre todos estos importantes conceptos hubiera resultado ser un uno o un tres o quizás un múltiplo de pi. Pero ¿137?

![]()

… es un número que determina la fuerza de una interacción) y equivale a 1/137,03599911.

“Lo más notable de este notable número es su adimensionalidad. La velocidad de la luz es de unos 300.000 kilómetros por segundo. Abraham Lincoln medía 1,98 metros. La mayoría de los números vienen con dimensiones. Pero resulta que cuando uno combina las magnitudes que componen alfa, ¡se borran todas las unidades! El 137 está solo: se exhibe desnudo a donde va. Esto quiere decir que a los científicos de Marte, o a los del decimocuarto planeta de la estrella Sirio, aunque usen Dios sabe qué unidades para la carga y la velocidad y qué versión de la constante de Planck, también les saldrá 137. Es un número puro.”

(Leon Ledderman, La partícula divina)

Uno de los padres de la mecánica cuántica, Wolfgang Pauli, se obsesionó tanto con este número que dijo que, de poder hacerle una pregunta a Dios, sería esta: “¿Por qué 137?”

Gracias a su gran amistad con Carl G. Jung, Pauli conoció el mundo “alternativo” de los estudios sobre la psique y accedió a la tradición esotérica que ha acompañado al hombre desde el principio de los tiempos. Es así como supo que 137 se aproxima al valor correspondiente al ángulo áureo. Esto es, la versión circular del número áureo o φ (phi).

Sin fotones… ¡El Universo sería inestable, sería otro universo diferente!

En realidad, el ángulo de oro es, más o menos, 137,5º, y está presente en todo proceso natural donde se dé una combinación de espirales. Así, por ejemplo, las hojas de una planta surgen a lo largo del tallo cada 137,5º, pues así se logra la mayor eficiencia de espacio y de captación de la luz solar, ya que únicamente con éste ángulo es posible evitar que ninguna hoja obstaculice a las demás en la toma de luz sin que existan espacios muertos o vacíos.

Esta semejanza entre los valores de la constante de estructura fina y el ángulo áureo llevó a la doctora Raji Heyrovska a buscar el ángulo áureo en el universo atómico (véase versión en español de su estudio).

Que esto sea así no debería extrañarnos, pues si el número áureo es una constante en toda la Naturaleza, su versión angular es la apropiada para estar presente en el universo cuántico, donde, recordemos, los elementos básicos de la realidad se reducen a funciones de onda.

…y un final místico.

Los fotones no tienen masa ni carga eléctrica. Sin embargo, pueden “extraer” del vacío partículas con masa y carga, tanto negativa como positiva.

Más allá de la matería y la energía, del tiempo y del espacio, el concepto de función de onda nos introduce en una realidad abstracta de donde surge todo.Y si, como hemos dicho, a menor longitud de onda mayor energía, también es posible afirmar que, en eso que David Bohm llamaba “orden implicado”, cuanto menor es la longitud de una onda cuántica, mayor es la presencia de masa en el espacio-tiempo.

Para la física, las matemáticas se han mostrado como la realidad que subyace a la materia. Todo se puede reducir a números, entidades que forman y organizan el espacio-tiempo. En este nivel de realidad, ni la materia ni la energía existen como tales, sino que demuestran ser el resultado de la interacción de entidades abstractas.

En esta pasión por los números, no podemos evitar recordar la versión cabalística de la filosofía perenne. Para la Kabbalah, lo divino responde a la “Nada”, ya que lo trascendente no puede ser aprehendido desde nuestra posición en el mundo finito.

En el momento de la Creación, la luz infinita se habría divido, quedando encerrada en conductos que, al romperse, producen la materia y, en definitiva, la fractura de la unidad primordial de la luz.

Esta materia o qelippot, en el sentido de “conchas” o caparazones que “encierran” la luz y rompen la harmonía unitaria de la luz, es el origen del mundo, de su finitud y causa del mal en la realidad no-divina. El mundo creado es así una fractura de la harmonía de la luz que crea la diferenciación y la tensión entre unas cosas y otras: este es el origen del mal, de la falta de harmonía que debe recuperarse en el curso de la historia.

¡Qué a estas alturas de la vida, existan personas, que estén inmersos en estas patrañas! No lo entenderé munca

La Kabbalah enseña, según esto, el camino para desarrollar la Vasija interior donde recibir la Luz, la cual, según va llenando dicha vasija, nos acerca a la unidad del Espíritu. Es así que la Luz, al tiempo que “absorbida” por el alma, puede ser “proyectada” en el mundo mediante los actos del hombre trascendido.

Que la luz ha sido usada por todos los movimientos espirituales para referirse a lo divino es algo que a nadie se le escapa. La imagen que la Kabbalah ofrece aquí no es muy diferente de la que podríamos encontrar en textos rosacruces o en escritos orientales, entre otros.

Sin embargo, si esta vez he preferido usar el hermetismo hebreo es, como he mencionado, por su pasión hacia los números. Y es que el valor numérico para el término hebreo de “kabbalah” (cuya traducción es “recepción”) es…

como muchos ya sabrán…

Efectivamente…

137.

Ciencia y tradición hermética unidas por un número que, en ambas, define la interacción entre luz y materia.

Cosas…

Luz que, también en ambos casos, procede de la Nada.

Decía Jung que el espacio y el tiempo son conceptos hipostasiados, fenómenos que hemos decidido convertir en reales. La física teórica y la consolidación de la mecánica cuántica han dejado claro, a lo largo de las últimas décadas, que toda esta realidad por la que combatimos, matamos, morimos, odiamos, repudiamos, humillamos, codiciamos, envidiamos o ansiamos consiste, simplemente, en Nada.

Nada…

Una ilusión de la psique por la que renunciamos a indagar en el misterio de la Vida y nuestra experiencia momentánea en el espacio-tiempo se convierte en un vagar ausentes, asumiendo que todo es un sinsentido.

A veces, en momentos de bajón, me pregunto si no será por eso por lo que, casi cien años después, nos siguen diciendo que la física cuántica es muy complicada para que lleguemos a entenderla…

Lo más triste, sin embargo, es que lo aceptamos…

Todo esto lo he leido o aprendido de gente que son más sabias que yo, ideas que tienen sus fuentes en trabajos realizados con la misión y el propósito de desvelar los secretos de la Naturaleza para saber, como es el Universo.

Lo conseguiremos alguna ve?

emilio silvera

Jul

19

¡El Límite de las Teorías!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Presentado en la XIX Edición del

Siempre andamos a vueltas con las teorías, y, tenemos que ser conscientes que las teorías tienen unos límites que están bien determinados. Veamos:

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad general de Einstein? Afortunadamente, hay una respuesta simple y las unidades de Planck nos dicen cuales son.

Y precisamente esta constante es el segundo motivo por el que no encuentras los muebles en una posición diferente cada vez que entras en el salón.

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de onda cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 centímetros, más joven que el tiempo de Planck 10ˉ⁴³ segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de aplicación de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido cerca del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

La Gravedad Cuántica, el eslabón perdido para comprender la evolución del Universo. Los físicos teóricos la han encontrado, ellos saben que dicha teoría subyace en la Teoría de Supercuerdas que, desgraciadamente, es inverificable… ¡Por el momento! Se cree que llegar hasta las cuerdas requeriría disponer de la energía de Planck (1019 GeV).

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “información” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”.

La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele mostrar en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

Representación gráfica de la obtención experimental de la constante de Planck

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos. Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El número máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de información producida hasta ahora. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, desde el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un gráfico que recree la escala logarítmica de tamaño desde el átomo a las galaxias. Todas las estructuras del universo existen porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón.

En nuestro Universo todo es energía y el resultado de dos fuerzas contrapuestas que, al ser iguales en potencia, equilibran el todo y hace posible la estabilidad que podemos contemplar en las estrellas y en los átomos.

| α = 2πe2 / hc ≈ 1/137 |

| αG = (Gmp2)2 / hc ≈ 10-38 |

La identificación de constantes adimensionales de la naturaleza como a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

Nunca nadie ha explicado el valor numérico de ninguna de las constantes de la naturaleza. ¿Recordáis el 137? Ese número puro, adimensional, que guarda los …

Cuando surgen comentarios de números puros y adimensionales, de manera automática aparece en mi mente el número 137. Ese número encierra más de lo que estamos preparados para comprender; me hace pensar y mi imaginación se desboca en múltiples ideas y teorías. Einstein era un campeón en esta clase de ejercicios mentales que él llamaba “libre invención de la mente”. El gran físico creía que no podríamos llegar a las verdades de la naturaleza sólo por la observación y la experimentación. Necesitamos crear conceptos, teorías y postulados de nuestra propia imaginación que posteriormente deben ser explorados para averiguar si existe algo de verdad en ellos.

Para poner un ejemplo de nuestra ignorancia poco tendríamos que buscar, tenemos a mano miles de millones.

Hablamos de portales cuánticos, fluctuaciones de vacío… Cuerdas y de Taquiones pero…

Un gran Físico nos decía:

“Todos los físicos del mundo, deberían tener un letrero en el lugar más visible de sus casas, para que al mirarlo, les recordara lo que no saben. En el cartel sólo pondría esto: 137. Ciento treinta y siete es el inverso de algo que lleva el nombre de constante de estructura fina”.

Este número guarda relación con la posibilidad de que un electrón emita un fotón o lo absorba. La constante de estructura fina responde también al nombre de “alfa” y sale de dividir el cuadrado de la carga del electrón, por el producto de la velocidad de la luz y la constante de Planck. Tanta palabrería y numerología no significan otra cosa sino que ese solo numero, 137, encierra los misterios del electromagnetismo (el electrón, e–), la relatividad (la velocidad de la luz, c), y la teoría cuántica (la constante de Planck, h).

¡Sabemos aun tan poco!

emilio silvera

Jul

5

¿Cuál es el Camino? No hay ningún camino.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

El Camino lo tenemos que hacer nosotros al andar. Lo mismo que se forma la vereda en la Montaña cuando los seres vivos pasan por el mismo sitio una y otra vez, dando lugar a que se forme una línea en la tierra mil veces pisada que nos habla del paso por aquel lugar que los viandantes han creído el más idóneo para transitar hacia algún otro sitio. Lo tuvieron que elegir de manera racional al ser el más indicado y, por ese “camino” se creó el sendero por el que caminar. Antes allí, no había camino.

No pocas veces, el camino se crea a partir de una idea, una intuición, una ganas de saber lo que hay más allá de nuestros dominios, de explorar lo desconocido, de comprobar si la fascinación que presentimos por lo que pensamos que “allí” pueda existir, se debe a una certera intuición, o, por el contrario, es sólo un espejismo. No siempre el explorardor encontró aquella civilización perdida que gritaba insistente en su mente llamándolo sin cesar, ni el científico encuentra la anhelada explicación a un secreto de la Naturaleza que, tan claramente veía en sus sueños.

Está claro que el mismo acto de la exploración, modifica la perspectiva del explorador; Ni Ulises, Marco Polo o Colón podían ser los mismos cuando, después de sus respectivas aventuras regresaron a sus hogares. Lo mismo ha sucedido con la investigación científica en los extremos de las escalas, desde la grandiosa extensión del esapcio cosmológico…

… hasta el mundo minúsculo y enloquecido de las partículas subatómicas.

Estos viajes nos cambiaron y cambiaron muchos de los conceptos ancestrales que, en nuestras mentes, estaban apaciblemente aposentados y, desafiaron muchas de las concepciones científicas y también filosóficas que más valorábamos. Algunas, ante aquella realidad nueva, tuvieron que ser desechadas, como el bagaje que se deja atrás en una larga y pesada travesía un desierto. Otras tuvieron que ser modificadas y reconstituidas hasta quedar casi irreconocibles.

La exploración en el ámbito de las galaxias y cúmulos de galaxias esxtendió el alcanza de la visión humana en un factor de 1026 veces mayor que la propia escala humana, y produjo la revolución que identificamos con la relatividad, la cual reveló que la concepción newtoniana del mundo sólo era una perspectiva parroquiana dentro de un universo más vasto donde el espacio es curvo y el tiempo se hace flexible.

La exploración en el dominio subatómico nos llevó lejos en el ámbito de lo muy pequeño, a unos 10-15 de la escala humana, y también significó una revolución. Esta fue la física cuántica que transformó todo lo que abordó a partir de su nacimiento en 1900, cuando Max Planck, escribió aquel artículo de ocho páginas que fueron las semillas de las que más tarde, germiron “las flores” de la M.C.. Planck, comprendiò que sólo podía explicar lo que se llamaba la Curva del Cuerpo Negro -el espectro de energía que genera un objeto de radiación perfecta- si abandonaba el supuesto clásico de que la emisión de enertgía es continua, y lo reemplazó por la hipótesis sin presecentes de que la energía se emite en unidades discretas. Planck llamó cuantos a estas unidades y quedaron simbolizadas por la letra h.

Plan no era ningún revolucionario -a la edad de 42 años era un viejo, juzgado por los patrones de las ciencias matemáticas y, además, un pilar de la elevada cultura germana del siglo XIX-, pero se percató fácilmente de que el principio cuántico echaría abajo buena parte de la física clásica a la que habñía dedicado buena parte de su vida y de su carrera.

“Cuanto mayores sean sus dificultades -escribió-… tanto más importante será finalmente para la ampliación y profundización del conocimiento de la Física.” Aquellas palabras fueron proféticas: cambiando y desarrollándose constantemente, modificando su coloración de manera tan impredecible como una reflexión en una burbuja de jabón, la física cuántuica pronto se expandió prácticamente a todo el ámbito de la física, y el cuanto de acción de Planck, h, llegó a ser considerado una constante de la naturaleza tan fundamental como la velocidad de la luz, c, de Einstein.

En una batalla entre los principios estrellas de la historia cuántica, sólo puede haber un ganador. O no puede? . En el invierno de 1926-1927, Werner Heisenberg el brillante joven alemán estaba trabajando como jefe asistente de Niels Bohr , alojado en un desván en la parte superior del instituto del gran danés de Copenhague. Después de un día de trabajo, Bohr se acercaba al encuentro con Heisenberg para hablar de física cuántica. A menudo se sentaban hasta altas horas de la noche, en un intenso debate sobre el significado de la teoría cuántica revolucionaria, entonces en su infancia.

Un rompecabezas que se ponderó eran los rastros de las gotitas que dejan los electrones al pasar a través de las cámara de niebla un aparato utilizado para rastrear los movimientos de partículas cargadas. Cuando Heisenberg trató de cálcular estas aparentemente precisas trayectorias usando las ecuaciones de la mecánica cuántica, no lo consiguió.

Una noche de mediados de febrero, Bohr había dejado la ciudad en un viaje de esquí, y Heisenberg se había deslizado a tomar un poco de aire de la noche en las amplias avenidas de Fælled Parque, detrás del instituto. Mientras caminaba, se le ocurrió. El rastro de los electrones no era preciso en lo absoluto: si uno lo mira de cerca, consiste en una serie de puntos difusos. Eso reveló algo fundamental sobre la teoría cuántica. De vuelta en su ático, Heisenberg escribió con entusiasmo su idea en una carta a su colega el físico Wolfgang Pauli. Lo esencial de esto apareció en un documento unas pocas semanas más tarde: “Mientras más precisa la posición es determinada, menor precisión, en el momento se conoce en este instante, y viceversa.”

Fórmula y gráfico que escenifican el Principio de Incertidumbre o Indeterminación

Así el notorio principio de incertidumbre de Heisenberg había nacido. Una declaración de la incognoscibilidad fundamental del mundo cuántico, que se ha mantenido firme durante la mayor parte del siglo. Pero ¿por cuánto tiempo? Corren rumores de que un segundo principio cuántico – el entrelazamiento- puede sonar el tañido de muerte para la incertidumbre.

Sólo podemos obtener respuestas parciales, cuya narturaleza está determinada en cierta medida por las cuestiones que optamos por infagar. Cuando Hesinberg calculó la cantidad mínima ineludible de incertidumbre que limita nuestra comprensión de los sucesos de pequeña escala, halló que está definida que nada menos que por h, el cuanto de acción de Planck.

La indeterminación cuántica no depende del aparato experimental que podamos emplear para la investigación del mundo subatómico. Se trata, en la medida de nuestro conocimiento, de una limitación absoluta, que los más destacados sabios de una civilización extraterrestre avanzada conpartirían con los más humildes físicos de la Tierra. En la física atómioca clásica se suponía que se podía, en proncipio, medir las situaciones y trayectorias precisas de miles de millones de partículas -digamos, protones– y a partir de los datos resultantes hacer predicciones exactas de donde estarían los protones en determinado tiempo futuro.

Heisenberg demostró que tal supuesto era falso, que nunca podremos saberlo todo sobre la conducta de siquiera una sóla partícula, mucho menos de una gran cantidad de ellas, y, por lo tanto, nunca podremos hacer predicciones sobre el futuro que sean completamente exactas en todos los detalles. Esto marcó un cambio fundamental en la visión del mundo de la física. Revelaba que no sólo la materia y la energía sino también el conocimiento están cuántizados.

El principio de incertidumbre es aplicado a modelos del espacio 3D ordinario, donde el espacio tiempo es continuo. En los sistema cuantizados con retículos diminutos que conforman a los superejes, la información de las partículas pasa de un retículo a otro o a una zona cuántica distinta del mismo retículo. Dado que en el modelo de los eventos, los objetos no pertenecen a los eventos, simplemente evolucionan generando más información de nuevos eventos, la incertidumbre asociada a estos puede estar relacionada con radio del bucle de los retículos diminutos, y para el traslado de la información de un retículo a otro debe existir un nivel incertidumbre en cuanto a cual retículo pertenece el evento durante la transferencia de dicha información, o ¿a qué conjunto de valores cuánticos del mismo pertenece?

La mecánica cuántica (el salto cuantico del electrón) nos desvelará el secreto de cómo el electrón puede, al recibir un fotón, desaparecer del nivel nuclear que ocupa para de manera instantánea, y sin necesidad de recorrer la distancia que los separa, aparecer como por arte de magia en un nivel superior. Copiaremos el salto cuántico para viajar. Nos introduciremos en un cabina, marcaremos las coordenadas, pulsaremos un botón y desapareceremos en Madrid y de manera instantánea, apareceremos de la nada en otra cabina igual situada en Nueva York a 6.000 Km de distancia.

…cuando el núcleo de un átomo es excitado por una fuente de energía exterior, tiene lugar el salto quántico, que consiste en el paso de un electrón a otra órbita con una energía mayor. No se sabe por donde hizo el viaje sin tener que andar la distancia entre el lugar de origen y el de llegada… ¿Por dónde habría hecho el viaje?

No puede quitarme de la cabeza que, el Salto Cuántico, nos dará la idea para viajar de manera que podamos burlar, la velocidad de la luz. Sin embargo, ese “futuro” no podré verlo. Resulta que un electrón situado alrededor del núcleo de un átomo, es impacto por un fotón energético y, de inmediato, el electrón desaparece del lugar que ocupa en la órbita atómica y, de manera instantánea, aparece en otro lugar más cercano al núcleo. Lo asombroso del caso es que, no se sabe qué camino pudo coger para desplazarse de un lugar a otro. Simplemente desapareció de uno y apareció en el otro. Ese es, amigos míos, el Salto cuántico. Si somos capaces de copiarlo, viajaremos a las estrellas sin que nos importe cuántos años-luz nos puedan separar de ellas.

¿Quién sabe lo que podemos extraer del salto cuántico? El efecto túnel nos podría dar la fórmula para viajar a lugares lejanos. Creo que todos nuestros sueños se podrían realizar si, en el momento adecuado, observando la Naturaleza, sabemos elegirt el camino que tenemos que andar para llegar a ese destino soñado,o, imaginado.

Nuestras Mentes buscarán las formas de solucionar todos esos problemas complejos que ahora inquietan a la Humanidad.

La Física cuántica nos obliga a tomarnos en serio lo que antes eran puramentes consideraciones filosóficas: que no vemos las cosas en sí mismas, sino sólo aspectos de las cosas. Lo que vemos en la trayectoria de un electrón en la cámara de niebla no es un electrón, y lo que vemos en el cielo no son estrellas, como una grabación de la voz de Pavoroti no es Pavoroti. Al revelar que el observador desempeña un papel en la observación, la física cuántica hizo por la física lo que Darwin ha hecho por las ciencias de la vida: Echó abajo las paredes, reunificando la Mente con el Universo más vasto.

emilio silvera

Jul

4

Los secretos de la Naturaleza ¿Los podremos desvelar?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

El psicólogo Eric Ericsson llegó a proponer una teoría de estadios psicológicos del desarrollo. Un conflicto fundamental caracteriza cada fase. Si este conflicto no queda resuelto, puede enconarse e incluso provocar una regresión a un periodo anterior. Análogamente, el psiicólogo Jean Piaget demostró que el desarrollo mental de la primera infancia tampoco es un desarrollo continuo de aprendizaje, sino que está realmente caracterizado por estadios discontinuos en la capacidad de conceptualización de un niño. En un mes, un niño puede dejar de buscar una pelota una vez que ha rodado fuera de su campo de visión, sin comprender que la pelota existe aunque no la vea. Al mes siguiente, esto resultará obvio para el niño.

Los procesos siguen, las cosas cambian, el Tiempo inexorable transcurre, si hay vida vendrá la muerte, lo que es hoy mañana no será.

Esta es la esencia de la dialéctica. Según esta filosofía, todos los objetos (personas, gases, estrellas, el propio universo) pasan por una serie de estadios. Cada estadio está caracterizado por un conflicto entre dos fuerzas opuestas. La naturaleza de dicho conflicto determina, de hecho, la naturaleza del estadio. Cuando el conflicto se resuelve, el objeto pasa a un objetivo o estadio superior, llamado síntesis, donde empieza una nueva contradicción, y el proceso pasa de nuevo a un nivel superior.

Los filósofos llaman a esto transición de la “cantidad” a la “cualidad”. Pequeños cambios cuantitativos se acumulan hasta que, eventualmente, se produce una ruptura cualitativa con el pasado. Esta teoría se aplica también a las sociedades o culturas. Las tensiones en una sociedad pueden crecer espectacularmente, como la hicieron en Francia a finales del siglo XVIII. Los campesinos se enfrenaban al hambre, se produjeron motines espontáneos y la aristocracia se retiró a sus fortalezas. Cuando las tensiones alcanzaron su punto de ruptura, ocurrió una transición de fase de lo cuantitativo a lo cualitativo: los campesinos tomaron las armas, tomaron París y asaltaron la Bastilla. ¿No pasará aquí lo mismo con los políticos y los ciudadanos? Ellos tienen muchos privilegios a costa de quitarnos derechos a los demás.

Las transiciones de fases pueden ser también asuntos bastante explosivos. Por ejemplo, pensemos en un río que ha sido represado. Tras la presa se rápidamente un embalse con agua a enorme presión. Puesto que es inestable, el embalse está en el falso vacío. El agua preferiría estar en su verdadero vacío, significando esto que preferiría reventar la presa y correr aguas abajo, hacia un estado de menor energía. Así pues, una transición de fase implicaría un estallido de la presa, que tendría consecuencias desastrosas.

También podría poner aquí el ejemplo más explosivo de una bomba atómica, donde el falso vacío corresponde al núcleo inestable de uranio donde residen atrapadas enormes energías explosivas que son un millón de veces más poderosas, para masas iguales, que para un explosivo químico. De vez en cuando, el núcleo pasa por efecto túnel a un estado más bajo, lo que significa que el núcleo se rompe espontáneamente. Esto se denomina desintegración radiactiva. Sin embargo, disparando neutrones contra los núcleos de uranio, es posible liberar de golpe esta energía encerrada según la formula de Einstein E = mc2. Por supuesto, dicha liberación es una explosión atómica; ¡menuda transición de fase! De nefasto recuerdo por cierto.

Las transiciones de fase no son nada nuevo. Traslademosló a nuestras propias vidas. En un libro llamado Pasajes, el autor, Gail Sheehy, destaca que la vida no es un flujo continuo de experiencias, como parece, sino que realmente pasa por varios estadios, caracterizados por conflictos específicos que debemos resolver y por objetivos que debemos cumplir.

Los contornos recubiertos muestran la estructura de la galaxia al ser reconstruida desde las observaciones hechas bajo el fenómeno de lente gravitatorio con el radiotelescopio Submillimeter Array. La formación de nuevas estrellas en el Universo es imparable y, la materia más sencilla se constituye en una estructura que la transformará en más compleja, más activa, más dispuesta para que, la vida, también pueda surgir en mundos ignotos situados muy lejos del nuestro.

Sí, todo cambia y nada permanece: transiciones de fases hacia la complejidad

Las nuevas características descubiertas por los científicos en las transiciones de fases es que normalmente van acompañadas de una ruptura de simetría. Al premio Nobel Abdus Salam le gusta la ilustración siguiente: consideremos una mesa de banquete circular, donde todos los comensales están sentados con una copa de champán a cada lado. Aquí existe simetría. Mirando la mesa del banquete reflejada en un espejo, vemos lo mismo: cada comensal sentado en torno a la mesa, con copas de champán a cada lado. Asimismo, podemos girar la mesa de banquete circular y la disposición sigue siendo la misma.

Rompamos ahora la simetría. Supongamos ahora que el primer comensal toma la copa que hay a su derecha. Siguiendo la pauta, todos los demás comensales tomaran la copa de champán de su derecha. Nótese que la imagen de la mesa del banquete vista en el espejo produce la situación opuesta. Cada comensal ha tomado la copa izquierda. De este modo, la simetría izquierda-derecha se ha roto.

El niño del espejo le da a su “amiguito” reflejado la mano derecha y aquel, le saluda, con la izquierda. ¡La simetría especular…! Así pues, el estado de máxima simetría es con frecuencia también un estado inestable, y por lo tanto corresponde a un falso vacío.

Con respecto a la teoría de supercuerdas, los físicos suponen (aunque todavía no lo puedan demostrar) que el universo decadimensional original era inestable y pasó por efecto túnel a un universo de cuatro y otro de seis dimensiones. Así pues, el universo original estaba en un estado de falso vacío, el estado de máxima simetría, mientras que hoy estamos en el estado roto del verdadero vacío.

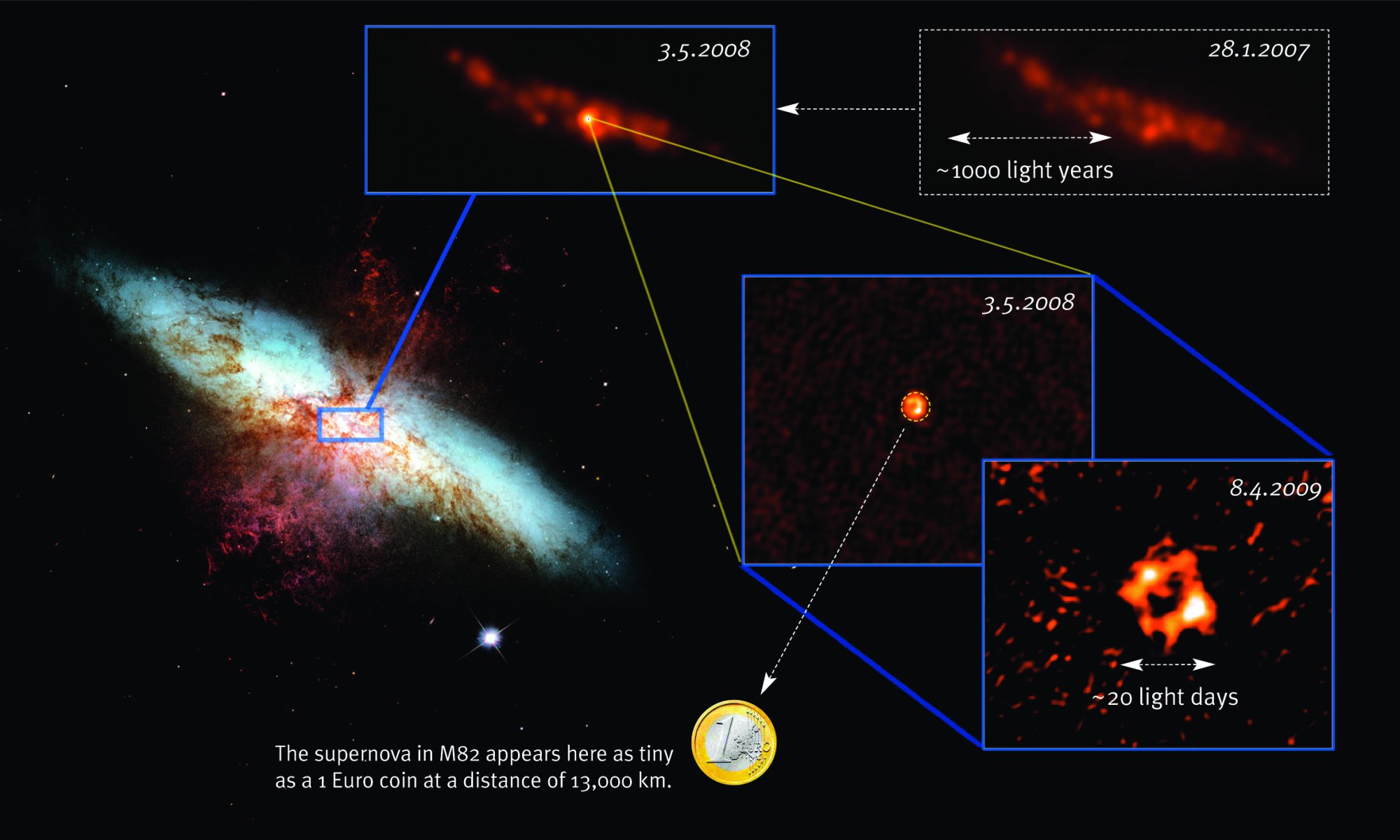

Al principio, cuando el universo era simétrico, sólo existía una sola fuerza que unificaba a todas las que ahora conocemos, la gravedad, las fuerzas electromagnéticas y las nucleares débil y fuerte, todas emergían de aquel plasma opaco de alta energía que lo inundaba todo. Más tarde, cuando el universo comenzó a enfriarse, se hizo transparente y apareció la luz, las fuerzas se separaron en las cuatro conocidas, emergieron las primeras quarks para unirse y formar protones y neutrones, los primeros núcleos aparecieron para atraer a los electrones que formaron aquellos primeros átomos. Doscientos millones de años más tarde, se formaron las primeras estrellas y galaxias. Con el paso del tiempo, las estrellas sintetizaron los elementos pesados de nuestros cuerpos, fabricados en supernovas que estallaron, incluso antes de que se formase el Sol. Podemos decir, sin temor a equivocarnos, que una supernova anónima explotó hace miles de millones de años y sembró la nube de gas que dio lugar a nuestro sistema solar, poniendo allí los materiales complejos y necesarios para que algunos miles de millones de años más tarde, tras la evolución, apareciéramos nosotros.

En las estrellas se tiene que producir el proceso triple alfa para que exista el Carbono

Las estrellas evolucionan desde que en su núcleo se comienza a fusionar hidrógeno en helio, de los elementos más ligeros a los más pesados. Avanza creando en el hornotermonuclear, cada vez, metales y elementos más pesados. Cuando llega al hierro y explosiona en la forma explosiva de una supernova. Luego, cuando este material estelar es otra vez recogido en una nueva estrella rica en hidrógeno, al ser de segunda generación (como nuestro Sol), comienza de nuevo el proceso de fusión llevando consigo materiales complejos de aquella supernova.

Puesto que el peso promedio de los protones en los productos de fisión, como el cesio y el kriptón, es menor que el peso promedio de los protones de uranio, el exceso de masa se ha transformado en energía mediante la conocida fórmula E = mc2. Esta es la fuente de energía que también subyace en la bomba atómica. Es decir, convertir materia en energía.

Así pues, la curva de energía de enlace no sólo explica el nacimiento y muerte de las estrellas y la creación de elementos complejos que también hicieron posible que nosotros estemos ahora aquí y, muy posiblemente, será también el factor determinante para que, lejos de aquí, en otros sistemas solares a muchos años luz de distancia, puedan florecer otras especies inteligentes que, al igual que la especie humana, se pregunten por su origen y estudien los fenómenos de las fuerzas fundamentales del universo, los componentes de la materia y, como nosotros, se interesen por el destino que nos espera en el futuro.

Cuando alguien oye por vez primera la historia de la vida de las estrellas, generalmente (lo sé por experiencia), no dice nada, pero su rostro refleja escepticismo. ¿Cómo puedo vivir una estrella 10.000 millones de años? Después de todo, nadie ha vivido tanto tiempo como para ser testigo de su evolución y poder contarlo.

Hay cosas que, cambiando… ¡Nunca cambian! La entropía se encarga de ello

Pero volviendo a las cosas de la Naturaleza y de la larga vida de las estrellas, sí, tenemos los medios técnicos y científicos para saber la edad que tiene, por ejemplo, el Sol. Nuestro Sol, la estrella alrededor de la que giran todos los planetas de nuestro Sistema Solar, la estrella más cercana a la Tierra (150 millones de Km = 1 UA), con un diámetro de 1.392.530 Km, tiene una edad de 4.500 millones de años, y, como todo en el Universo, su discurrir la va desgantando, evoluciona hacia su imparable destino como gigante roja primero y enana blanca después.

Una gigante roja engulle a un planeta cercano

Cuando ese momento llegue, ¿dónde estaremos? Pues nosotros, si es que estamos, contemplaremos el acontecimiento desde otros mundos. La Humanidad habrá dado el gran salto hacia las estrellas y, colonizando otros planetas se habrá extendido por regiones lejanas de la Galaxia.

El Universo siempre nos pareció inmenso, y, al principio, aquellos que empezaron a preguntarse cómo sería, lo imaginaron como una esfera cristalina que dentro contenía unos pocos mundos y algunas estrellas, hoy, hemos llegado a saber un poco más sobre él. Sin embargo, dentro de unos cuantos siglos, los que detrás de nosotros llegaran, hablarán de universos en plural, y, cuando pasen algunos eones, estaremos de visita de un universo a otro como vamos de una ciudad a otra.

¡Quién pudiera estar allí!

¡Es todo tan extraño! ¡Es todo tan complejo! y, sobre todo…¡sabemos tan poco!

Todo lo grande está hecho de cosas pequeñas

Según lo que podemos entender y hasta donde han podido llegar nuestros conocimientos actuales, ahora sabemos donde están las fronteras: donde las masas o las energías superan 1019 veces la masa del protón, y esto implica que estamos mirando a estructuras con un tamaño de 10-33 centímetros.

Esta ecuación nos habla de lo que se conoce como masa de Planck y a la distancia correspondiente la llamamos distancia de Planck. La masa de Planck expresada en gramos es de 22 microgramos, que es la masa de un grano muy pequeño de azúcar (que, por otra parte, es el único número de Planck que parece más o menos razonable, ¡los otros números son totalmente extravagantes!).

Esto significa que tratamos de localizar una partícula con la precisión de una Longitud de Planck, las fluctuaciones cuánticas darán tanta energía que su masa será tan grande como la masa de Planck, y los efectos de la fuerza gravitatoria entre partículas, así, sobrepasarán los de cualquier otra fuerza. Es decir, para estas partículas la gravedad es una interacción fuerte.

Lo cierto es que, esas unidades tan pequeñas, tan lejanas en las distancias más allá de los átomos, son las que marcan nuestros límites, los límites de nuestras teorías actuales que, mientras que no puedan llegar a esas distancias… No podrán avanzar en el conocimiento de la Naturaleza y, tampoco, como es natural, en la teoría de supercuerdas o en poder saber, lo que pasó en el primer momento del supuesto big bang, hasta esos lugares, nunca hemos podido llegar.

emilio silvera

Totales: 85.684.948

Totales: 85.684.948 Conectados: 61

Conectados: 61