May

18

El Universo, la Vida…y, el Azar

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

(99942) Aphofis, el asteroide que sembró el pánico cuando surgió la noticia.

El Meteorito Aphofis (el dios del Caos)Pasará dos veces cerca de la Tierra

Hace días que salió en algunos medios (otra vez), la noticias de que se nos acercaba el Asteroide Aphofis. Se le puede apreciar en el centro de la imagen, moviéndose de derecha a izquierda, tomado el 30 de diciembre de 2004 (Observatorio Astronómico Sormano). La trayectoria ha sido estudiada en varias ocasiones y, finalmente, el 9 de enero de 2013, el Laboratorio de Propulsión a Chorro en Pasadena (California) de la NASA descartó la posibilidad de una colisión de este asteroide, tanto en 2029 como en 2036. Aunque su tamaño de algo más de 300 metros no es descomunal, su caída sobre nuestras cabezas no hubiera sido una fiesta.

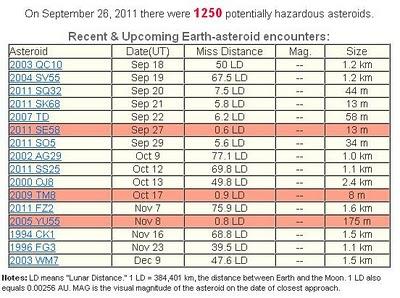

Muchos son los objetos que pasan por nuestra vecindad sin que nos causen problemas. Pasan a distancias que no pueden inquietarnos. En la Tabla adjunta podéis ver algunos de esos visitantes y a las Distancias Lunares (LD) que pasaron de nosotros.

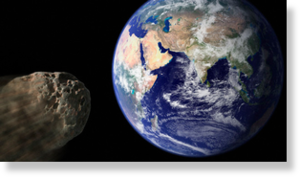

Los movimientos de cometas y asteroides, a pesar de tener la defensa de Júpiter, son una seria y cierta amenaza para el desarrollo y persistencia de vida. Los impactos no han sido infrecuentes en el pasado lejano de la Tierra, habiendo tenido efectos catastróficos. Somos afortunados al tener la protección de la Luna y de la enorme masa de Júpiter que atrae hacia sí los cuerpos que llegan desde el exterior desviándolos de su probable trayectoria hacia nuestro planeta.

El pasado mes de Octubre, un asteroide de un diámetro comprendido entre 25 y 50 metros pasó junto a la Tierra a unos 256.500 kilómetros.

La caída en el planeta de un asteroide de dimensiones considerables, nos podría causar muy graves problemas y producir extinciones globales que retrasarían en millones de años la evolución y hacer desaparecer algunas especies. Cuando comento este tema no puedo evitar el recuerdo del meteorito caído en la Tierra que impactó en la península de Yucatán hace 65 millones de años, al final de la Era Mesozoica, cuando según todos los indicios, los dinosaurios se extinguieron. Sin embargo, aquel suceso catastrófico para los grandes lagartos, en realidad supuso que la Tierra fue rescatada de un callejón sin salida evolutivo. Parece que los dinosaurios evolucionaron por una vía que desarrollaba el tamaño físico antes que el tamaño cerebral.

Aquel no era un mundo para nosotros

La desaparición de los dinosaurios junto con otras formas de vida sobre la Tierra en aquella época, hizo un hueco para la aparición de los mamíferos. Se desarrolló la diversidad una vez desaparecidos los grandes depredadores. Así que, al menos en este caso concreto, el impacto nos hizo un gran favor, dado que hizo posible que 65 millones de años más tarde pudiéramos llegar nosotros. Los dinosaurios dominaron el planeta durante 150 millones de años; nosotros, en comparación, llevamos aquí tres días y, desde luego, ¡la que hemos formado!

La Vida eligió a la Tierra para surgir

En nuestro sistema solar la vida se desarrolló por primera vez sorprendentemente pronto tras la formación de un entorno terrestre hospitalario. Hay algo inusual en esto. El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas cristalicen los materiales complejos necesarios para la vida, tales como el hidrógeno, nitrógeno, oxígeno, carbono, etc.

Parece que la similitud en los “tiempos” no es una simple coincidencia. El argumento, en su forma más simple, lo introdujo Brandon Carter y lo desarrolló John D. Barrow por un lado y por Frank Tipler por otro. Al menos, en el primer sistema solar habitado observado, ¡el nuestro!, parece que sí hay alguna relación entre tiempo(bio) y tiempo(estrella) que son aproximadamente iguales; el t(bio) –tiempo biológico para la aparición de la vida– algo más extenso.

La evolución de una atmósfera planetaria que sustente la vida requiere una fase inicial durante la cual el oxígeno es liberado por la foto-disociación de vapor de agua. En la Tierra esto necesitó 2.400 millones de años y llevó el oxígeno atmosférico a aproximadamente una milésima de su valor actual. Cabría esperar que la longitud de esta fase fuera inversamente proporcional a la intensidad de la radiación en el intervalo de longitudes de onda del orden de 1000-2000 ángstroms, donde están los niveles moleculares clave para la absorción de agua.

Este simple modelo indica la ruta que vincula las escalas del tiempo bioquímico de evolución de la vida y la del tiempo astrofísico que determina el tiempo requerido para crear un ambiente sustentado por una estrella estable que consume hidrógeno en la secuencia principal y envía luz y calor a los planetas del Sistema Solar que ella misma forma como objeto principal.

Telescopio Spitzer de la NASA ha detectado los pilares de la vida en el universo distante, aunque en un entorno violento. Ha posado su poderoso ojo infrarrojo en un débil objeto situado a una distancia de 3.200 millones de años luz (recuadro), Spitzer ha observado la presencia de agua y moléculas orgánicas en la galaxia IRAS F00183-7111.

A muchos les cuesta trabajo admitir la presencia de vida en el universo como algo natural y corriente, ellos abogan por la inevitabilidad de un universo grande y frío en el que es difícil la aparición de la vida. Yo (como muchos otros), estoy convencido de que la vida, es de lo más natural en el universo y estará presente en millones de planetas que, como la Tierra, tienen las condiciones para ello. Una cosa no se aparta de mi mente, muchas de esas formas de vida, serán como las nuestras aquí en la Tierra y estarán también, basadas en el Carbono. Claro que, no por eso niego que puedan existir otras formas de vida diferentes a las terrestres.

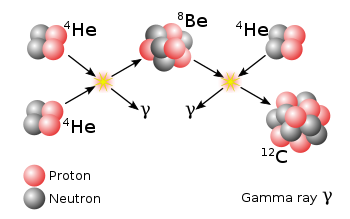

Los biólogos, parecen admitir sin problemas la posibilidad de otras formas de vida, pero no están tan seguros de que sea probable que se desarrollen espontáneamente, sin un empujón de formas de vida basadas en el carbono. La mayoría de las estimaciones de la probabilidad de que haya inteligencias extraterrestres en el universo se centran en formas de vida similares a nosotros que habiten en planetas parecidos a la Tierra y que necesiten agua y oxígeno o similar con una atmósfera gaseosa y las demás condiciones de la distancia entre el planeta y su estrella, la radiación recibida, etc. En este punto, parece lógico recordar que antes de 1.957 se descubrió la coincidencia entre los valores de las constantes de la Naturaleza que tienen importantes consecuencias para la posible existencia de carbono y oxígeno, y con ello para la vida en el universo.

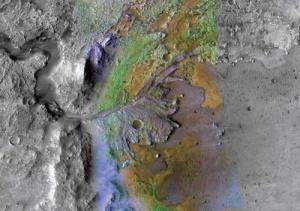

Un nuevo estudio revela la innovadora investigación en la formación hidrotermal de rocas de carbonato de arcilla en la Fosa Nili, en una región de Marte. Los resultados pueden proporcionar un vínculo a la evidencia de organismos vivos en Marte hace 4 mil millones de años aproximadamente.

Hay una coincidencia o curiosidad adicional que existe entre el tiempo de evolución biológico y la astronomía. Puesto que no es sorprendente que las edades de las estrellas típicas sean similares a la edad actual del universo, hay también una aparente coincidencia entre la edad del universo y el tiempo que ha necesitado para desarrollar formas de vida como nosotros.

Si miramos retrospectivamente cuánto tiempo han estado en escena nuestros ancestros inteligentes (Homo Sapiens) vemos que han sido sólo unos doscientos mil años, mucho menos que la edad del universo, trece mil millones de años, o sea, menos de dos centésimos de la Historia del Universo. Pero si nuestros descendientes se prolongan en el futuro indefinidamente, la situación dará la vuelta y cuando se precise el tiempo que llevamos en el universo, se hablará de miles de millones de años. Lo que parece poco probable. La dinámica del Universo es cambiante y nada dura eternamente.

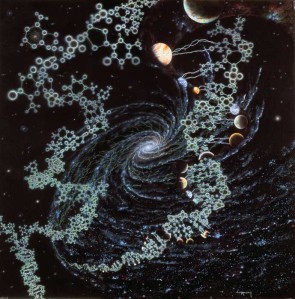

Una galaxia, una estrella, un planeta situado a la distancia adecuada y presencia de agua… La Vida prolifera por todo el universo que es igual en todas partes y en todas sus regiones, por lejos que puedan estar, están gobernadas por las mismas leyes y constantes.

Entristece que la llegada de un asteroide de grandes dimensiones pueda acabar con todo lo que la Naturaleza ha logrado, en el sentido de planetas situados en los lugares adecuados para que, habiendo evolucionado con el paso del tiempo, habiendo logrado el surgir de la Vida que ha evolucionado hacia niveles complejos, se pudiera ir al traste con un suceso del que ya, en varias ocasiones, se plasmaron en nuestro planeta.

No alcanzamos el nivel que se esperaba de nosotros

Surgirá otra especie más avanzada para sustituirnos

Sin descartar que esa especie sea artificial y ya la estemos “fabricando” nosotros mismos

Claro que, los Dinosaurios reinaron aquí durante 150 millones de años y desaparecieron (según parece), por la caída de uno de estos grandes monstruos espaciales. A veces he llegado a pensar que, si la Naturaleza es realmente sabia… ¿No habrá pensado que nuestra especie no ha sabido alcanzar el nivel de humanización que se esperaba de ella, y, se puede valer de este suceso para eliminarnos y que pueda dar entrada a otra especie que sí pueda alcanzar lo que nosotros no pudimos

Emilio Silvera Vázquez

Aparte de varias fuentes más y otras propias, lo que pudimos leer tiene su origen en un artículo publicado el 29 de julio de 2011 en la web del IAC.

May

18

¡El Universo! ¡Esa Maravilla!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (8)

Comments (8)

El Cúmulo Copo de Nieve en la Nebulosa del Cono, es como tantas otras Nebulosas, el resultado de la explosión de una estrella al final de sus días. Las estrellas nunca quieren morir del todo y, cuando lo hacen al finalizar sus ciclos de fusión, se convierten en otros objetos distintos y, sus materiales sobrantes son dejados esparcidos por grandes regiones del espacio interestelar, en forma de bellas nebulosas de las que surgen nuevas estrellas, nuevos mundos y… -seguramente- nuevas formas de vida.

Ahora sabemos que el Universo está constituido de innumerables galaxias que forman cúmulos que, a su vez, se juntan en supercúmulos. Estas galaxias están abarrotadas de estrellas y las estrellas, no pocas veces, están acompañadas de planetas que forman sistemas planetarios. Nosotros, los humanos, hemos realizado profundas observaciones que, con nuestros modernos ingenios, nos han podido llevar hasta el espacio profundo, allí donde habitan galaxias que nacieron hace ahora doce mil millones de años.

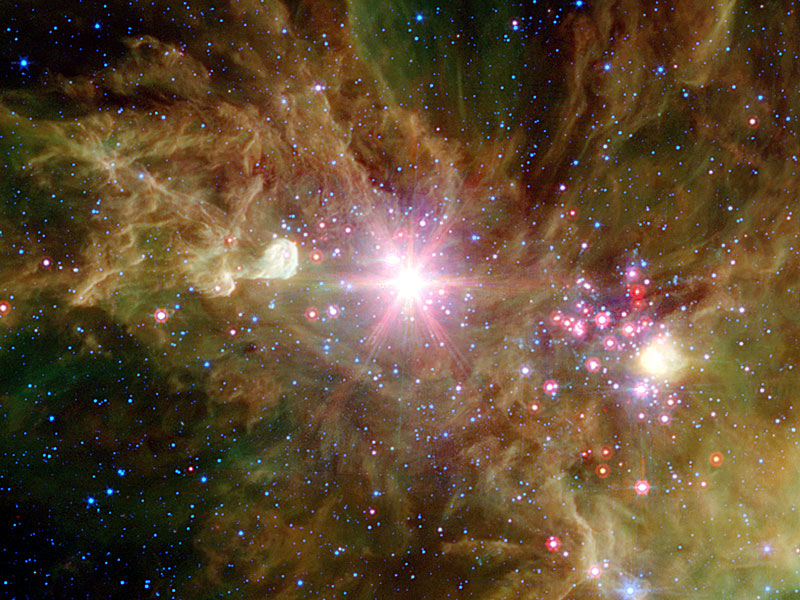

Arriba podemos contemplar una especie de incubadora estelar que todos conocemos como la Gran Nebulosa de Orión, una familiar imagen que está cerca de “nuestro barrio” dentro de la Galaxia Vía Láctea y también conocida como M42 con sus resplandecientes nubes y sus jóvenes y masivas estrellas nuevas que radian en el ultravioleta ionizando la región que toma ese familiar tono azulado.

Situada en el borde de un complejo de nubes moleculares gigantes, esta cautivadora nebulosa -laboratorio espacial- es solo una pequeña fracción de la inmensa cantidad de material interestelar en nuestra vecindad galáctica.El campo de la imagen se extiende cerca de 75 años-luz a la distancia estimada a la Nebulosa de Orión de 1.500 años-luz. Es una de las Nebulosas más estudiada por los Astrónomos y astrofísicos debido a su enorme capacidad de crear nuevas estrellas y estar en ella presentes procesos de transmutación de elementos y una vertiginosa actividad que es la mejor muestra del comportamiento de la materia en estos lugares.

Sin salir de nuestra región, nos vamos al barrio vecino que conocemos como Cinturón de Orión donde destacan las estrellas azuladas Alnitak, Alnilam y Mintaka, estrellas supermasivas y muy calientes que forman el Cinturón del Cazador. Ahí podemos ver, abajo a la izquierda la famosa Nebulosa oscura Cabeza de Caballo.

Del Brazo de Orión, la región que nos acoge y en la que se encuentra situado nuestro Sistema solar, al no poderlo tomar desde fuera y tenerlo tan cerca (de hecho estamos en él inmersos), no podemos tener una imagen como las que hemos captado de otros lugares y regiones más alejadas. También conocido como “brazo local” que es alternativo al Brazo de Orión de nuestra Galaxia, así se define algunas veces al Brazo espiral que contiene a nuestro Sol.

Cuando hablamos de brazo espiral nos estamos refiriendo a una estructura curvada en el disco de las galaxias espirales (y de algunas irregulares) donde se concentran las estrellas jóvenes, las nebulosas (regiones H II) y el polvo. Algunas galaxias tienen un patrón bien definido de dos brazos espirales, mientras que otras pueden tener tres o cuatro brazos, estando en ocasiones fragmentados. Los brazos son visibles por la reciente formación de estrellas brillantes, masivas y de corta vida en ellos. Esta actividad de formación de estrellas es periódica, correspondiendo al movimiento a través del disco de una onda de densidad gravitatoria y de fuertes vientos estelares.

Nuestra curiosidad nos ha llevado, mediante la observación y estudio del cielo, desde tiempos inmemoriales, a saber de las estrellas, de cómo se forman, viven y mueren y, de las formas que adoptan al final de sus vidas, en qué se convierten cuando llega ese momento final y a dónde va a parar la masa de las capas exteriores que eyectan con violencia al espacio interestelar para formar nuevas nebulosas. De la estrella original, según sus masas, nos quedará una enana blanca, una estrella de neutrones y, un agujero negro. También, en encuentros atípicos o sucesos inesperados, pueden crearse estrellas por fusión que las transforman en otras diferentes de lo que en su origen fueron.

Uno de los acontecimientos más increíbles que podríamos contemplar en el Universo sería, cómo se forma un Agujero negro que, lo mismo es el resultado de la muerte de una estrella masiva que implosiona y se contrae más y más hasta que desaparece de nuestra vista, o, también, se podría formar en otros sucesos como, por ejemplo, la fusión de dos estrellas de neutrones.

La formación de un agujero negro es una de las manifestaciones más grandes de las que tenemos constancia con la Gravedad. La estrella, en este caso gigante y muy masiva, llega a su final por haber agotado todo su combustible nuclear de fusión y, queda a merced de la fuerza de gravedad que genera su propia masa que, entonces, comienza a contraerse sobre sí misma más y más hasta llegar a convertirse en una singularidad, es decir, un punto matemático en el que ciertas cantidades físicas pueden alcanzar valores infinitos de temperatura y densidad. Por ejemplo, de acuerdo con la relatividad general, la curvatura del espacio-tiempo se hace infinita en un agujero negro en el que, el espacio y el tiempo…¡dejan de existir!

Es tan fuerte la Gravedad generada que nada la puede frenar. Muchas veces hemos hablado aquí de la estabilidad de una estrella que se debe a la igualdad de dos fuerzas antagómicas: por un lado, la fuerza de fusión y de radiación de una estrella que la impulsa a expandirse y que, sólo puede ser frenada por aquella otra fuerza que emite la misma masa estelar, la Gravedad. Las dos se ven compensadas y, de esa manera, la estrella vive miles de millones de años.

Mientras la estrella está fusionando elementos, la radiación hace que toda su masa quiera expandirse, y, por el contrario, la misma masa genera una fuerza de Gravedad que tiende a contraerse, así las dos fuerza antagónicas se equilibran y la estrella vive fusionando elementos miles de años. Sin embargo, cuando agota todo el combustible nuclear de fusión, la Gravedad se ve libre para contraer toda aquella ingente masa que implosiona najo la fuerza de la gravedad que genera, y, acaba convirtiéndose en una estrella de neutrones o un agujero negro.

Las estrellas implosionan y se contraen sobre sí mismas cuando la fusión finaliza en sus núcleos por falta de combustible nuclear, tales como el hidrógeno, helio, berilio, Carbono, Oxígeno… Entonces, el proceso de contracción no es igual en todas ellas, sino que, está reglado en función de la masa que cada estrella pueda tener. En una estrella como nuestro Sol, cuando comienza a contraerse está obligando a la masa a que ocupe un espacio cada vez menor.

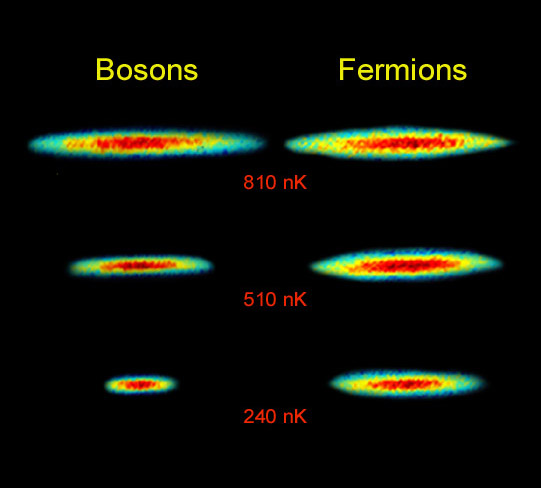

La masa, la materia, como sabemos está formada por partículas subatómicas que, cada una de ellas tienen sus propias singularidades, y, por ejemplo, el electrón, es una partícula que, siendo de la familia de los leptones es, además, un fermión que obedece a la estadística de Fermi-Dirac y está sometido al Principio de exclusión de Pauli que es un principio de la mecánica cuántica aplicable sólo a los fermiones y no a los bosones, y, en virtud del cual dos partículas idénticas en un sistema, como por ejemplo electrones en un átomo o quarks en un hadrón, no pueden poseer un conjunto idénticos de números cuánticos. (esto es, en el mismo estado cuántico de partícula individual) en el mismo sistema cuántico ligado (El origen de este Principio se encuentra en el teorema de espín-estadística de la teoría relativista).

Toda la explicación anterior está encaminada a que, podáis comprender el por qué, se forman las estrellas enanas blancas y de neutrones debido al Principio de exclusión de Pauli. Sabemos que la materia, en su mayor parte son espacios vacíos pero, si la fuerza de Gravedad va comprimiendo la masa de una estrella más y más, lo que está haciendo es que va juntando, cada vez más, a las partículas que conforman esa materia. Así, los electrones se ven más juntos cada vez y, llega un momento, en el que sienten una especie de “claustrofobia”, su condición de fermiones, no les permite estar tan juntos y, entonces, se degeneran y comienzan a moverse a velocidades relativista. Tal suceso, es de tal magnitud que, la Gravedad que estaba comprimiendo la nasa de la estrella, se ve frenada y se alcanza una estabilidad que finaliza dejando una estrella enana blanca estable.

Pero, ¿qué pasaría si la estrella en vez de tener la masa de nuestro Sol, tiene varias veces su masa? Entonces, ni la degeneración de los electrones puede frenar la fuerza gravitatoria que sigue comprimiendo la masa de la estrella y fusiona electrones con protones para formar neutrones. Los neutrones, que también son fermiones, se ven comprimidos hasta tal punto que, también se degeneran y, ellos, sí son capaces de frenar la fuerza gravitatoria quedando esa masa estabilizada como estrella de Neutrones.

Como el niño que no deja de hacer preguntas, nosotros, llegados a este punto también, podríamos preguntar: ¿Qué ocurriría si la estrella es muy masiva? Entonces amigos míos, el Principio de Exclusión de Pauli haría mutis por el foro, impotente ante la descomunal fuerza gravitatoria desatada y, ni la degeneración de electrones y neutrones podría frenarla. La masa se vería comprimida más y más hasta convertirse en un agujero negro de donde, ni la luz puede escapar.

Pero los mecanismos del Universo son muchos y los sucesos que podemos contemplar son asombrosos. Por ejemplo, si una inocente estrella está situada cerca de una enana blanca de gran densidad, se vería atraída por ella y “vería” como, poco a poco, le robaría su masa hasta que, finalmente, la engulliría en su totalidad.

Si eso ocurre tal y como vemos en la imagen, ¿qué pasaría entonces? Sencillamente que, la estrella enana blanca pasaría a transformarse en una estrella de neutrones, ya que, la masa que a pasado a engrosar su entidad, es demasiado para poder quedar estable como enana blanca y, de nuevo la gravedad hace que electrones y protones se fundan para formar neutrones que, degenerados, estabilizan la nueva estrella.

Sí, hemos llegado a ser conscientes de nuestro entorno y hemos podido crear ingenios que nos hablan y muestran las lejanas regiones del Universo. Ahora podemos hablar de las tremendas energías presentes en el espacio cosmológico y sabemos por qué se generan y cuáles son sus consecuencias. Conocemos de la importancia del Sol para la vida en la Tierra, hemos observado el Sistema solar al que pertenecemos dentro una inmensa galaxia de estrellas y, sobre todo, hemos llegado a comprender que, la Vida en nuestro planeta, puede no ser un privilegio, sino cosa cotidiana repartida por todo el universo infinito.

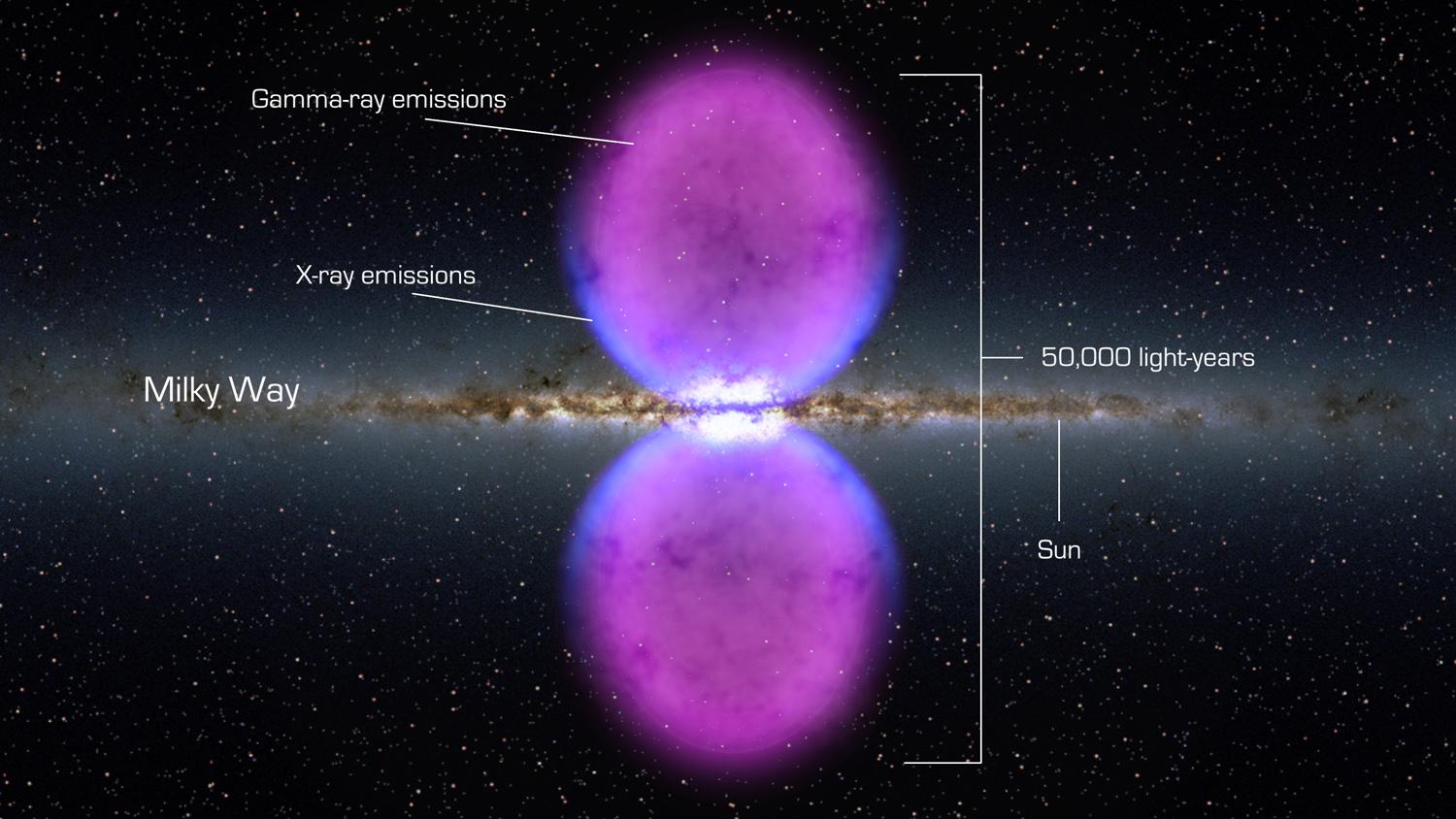

El Telescopio Espacial Fermi, de Rayos Gamma de la NASA ha descubierto y nos enseña una estructura nunca antes vista en el centro de nuestra Galaxia, la Vía Láctea. La estructura se extiende a 50.000 años luz y puede ser el remanente de una erupción de un agujero negro de enorme tamaño en el centro de nuestra Galaxia.

El desarrollo de la ciencia tiene su frontera superior en el desarrollo de tecnologías que hacen posible el conocimiento de nuestro universo. Satélites, telescopios, radio telescopios, sondas espaciales, naves, cohetes y transbordadores son el fruto de la investigación de muchos profesionales de diversas áreas del conocimiento que están llevando a toda la Humanidad hacia el futuro.

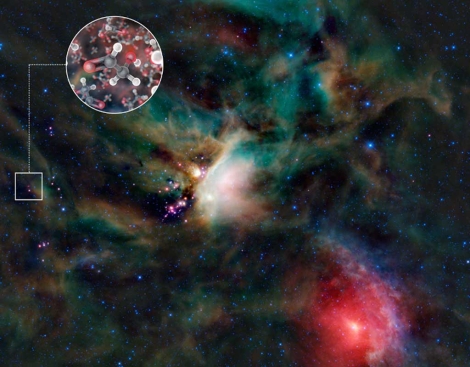

Con el radiotelescopio ALMA, ubicado en el desierto de Atacama (Chile), a 5.000 metros de altura, los científicos lograron captar moléculas de glicolaldehído en el gas que rodea la estrella binaria joven IRAS 16293-2422, con una masa similar a la del Sol y ubicada a 400 años luz de la Tierra.

El glicolaldehído ya se había divisado en el espacio interestelar anteriormente, pero esta es la primera vez que se localiza tan cerca de una estrella de este tipo, a distancias equivalentes a las que separan Urano del Sol en nuestro propio sistema solar.

“En el disco de gas y polvo que rodea a esta estrella de formación reciente encontramos glicol-aldehído, un azúcar simple que no es muy distinto al que ponemos en el café”, señaló Jes Jørgensen, del Instituto Niels Bohr de Dinamarca y autor principal del estudio.

Voyager I y II en su viaje sin fin, llegan a los límites del Sistema Solar

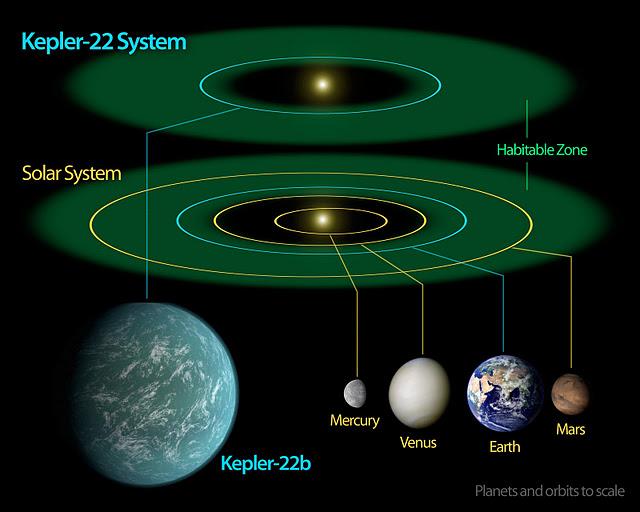

El observatorio espacial Kepler encontró en el sistema planetario Kepler-22, a 600 años luz, el primer planeta situado en la llamada “zona habitable”, un área en la que, por su distancia a su sol, puede haber agua líquida, según anunció este lunes la NASA en una rueda de prensa. Los científicos del Centro de Investigación Ames de la NASA anunciaron además que Kepler ha identificado 1.000 nuevos “candidatos” a planeta, diez de los cuales tienen un tamaño similar al de la Tierra y orbitan en la zona habitable de la estrella de su sistema solar, esto es, ni demasiado cerca ni demasiado lejos de una estrella.

El planeta, Kepler-22b, es el más pequeño hallado por la sonda espacial orbitando en la “zona habitable” -aquella donde las temperaturas permiten la vida- de una estrella similar a la de la Tierra. 55 planetas son aún más grandes que Júpiter, el más grande de nuestro sistema solar Es más grande que la Tierra y todavía no se ha determinado si es rocoso, gaseoso o líquido, pero, según dijo la subdirectora del equipo científico del Centro Ames, Natalie Batalha, “estamos cada vez más cerca de encontrar un planeta parecido a la Tierra”.

Esta escena es del día en que, en 1997, fue lanzada la Misión Cassini-Huygens hacia el vecino Saturno. ¿Qué podemos comentar de esa misión que nos llevó al más grande de los asombros, al podernos mostrar imágenes nunca antes vistas?

Imágenes tomadas por Cassini a su paso por Júpiter

La misión Cassini a Saturno y Huygens a Titán, es una de las misiones más ambiciosas hasta el momento jamás llevado a cabo. Todos sabemos ahora de su alta rentabilidad y de los muchos logros conseguidos. Gracias a esta misión sabemos de mucho más sobre el planeta hermano y de su gran satélite Titán del que hemos podido comprobar que es una “pequeña Tierra” con sus océanos de metano y su densa atmósfera inusual en cuerpos tan pequeños.

¡El ingenio humano!

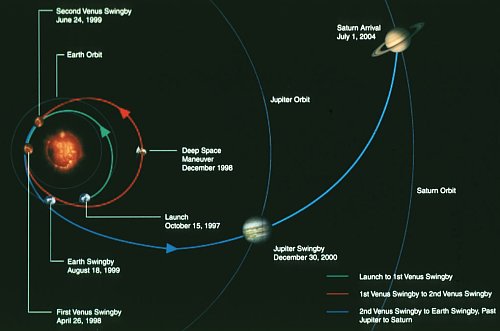

La masa de la sonda Cassini es tan grande que no fue posible emplear un vehículo de lanzamiento que la dirigiese directamente a Saturno. Para alcanzar este planeta fueron necesarias cuatro asistencias gravitacionales; de esta forma, Cassini empleó una trayectoria interplanetaria que la llevaría a Venus en dos ocasiones, posteriormente hacia la Tierra y después hacia Júpiter. Después de sobrevolar Venus en dos ocasiones a una altitud de 284 Km, el 26 de abril de 1998 y a 600 Km, el 24 de junio de 1999, el vehículo se aproximó a la Tierra, acercándose a 1171 Km de su superficie el 18 de agosto de 1999. Gracias a estas tres asistencias gravitacionales, Cassini adquirió el momento suficiente para dirigirse al Sistema Solar externo. La cuarta y última asistencia se llevaría a cabo en Júpiter, el 30 de diciembre de 2000, lo sobrevoló a una distancia de 9.723.890 Km, e impulsándose hacia Saturno.

La masa de la sonda Cassini es tan grande que no fue posible emplear un vehículo de lanzamiento que la dirigiese directamente a Saturno. Para alcanzar este planeta fueron necesarias cuatro asistencias gravitacionales; de esta forma, Cassini empleó una trayectoria interplanetaria que la llevaría a Venus en dos ocasiones, posteriormente hacia la Tierra y después hacia Júpiter. Después de sobrevolar Venus en dos ocasiones a una altitud de 284 Km, el 26 de abril de 1998 y a 600 Km, el 24 de junio de 1999, el vehículo se aproximó a la Tierra, acercándose a 1171 Km de su superficie el 18 de agosto de 1999. Gracias a estas tres asistencias gravitacionales, Cassini adquirió el momento suficiente para dirigirse al Sistema Solar externo. La cuarta y última asistencia se llevaría a cabo en Júpiter, el 30 de diciembre de 2000, lo sobrevoló a una distancia de 9.723.890 Km, e impulsándose hacia Saturno.

¿Os dais cuenta de la asombrosa imaginación y los conocimientos que son necesarios para llevar a cabo todo este conglomerado de datos?

Fase de Crucero:

Cassini llevó a cabo un plan de vuelo de baja actividad durante el cual sólo se realizaron las actividades de navegación e ingeniería imprescindibles, como maniobras de chequeo o corrección de trayectoria. Los instrumentos científicos fueron desconectados permanentemente, salvo en el transcurso de unas pocas actividades de mantenimiento. Estas incluían sólo un chequeo de todo su instrumento cuando la sonda estaba cerca de la Tierra, así como la calibración del magnetómetro. Las comprobaciones sobre el estado de la sonda Huygens se llevaron a cabo cada seis meses, mientras que las observaciones científicas se realizaron cuando el vehículo se aproximó a Venus, la Tierra y Júpiter.

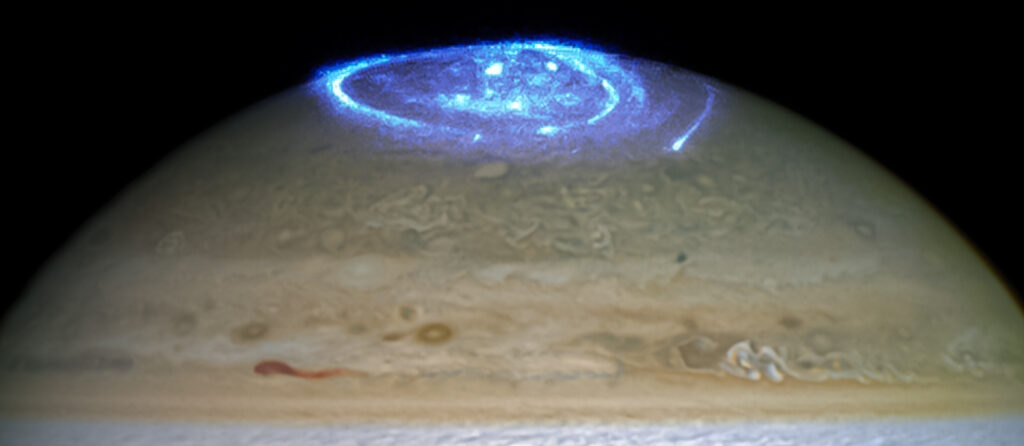

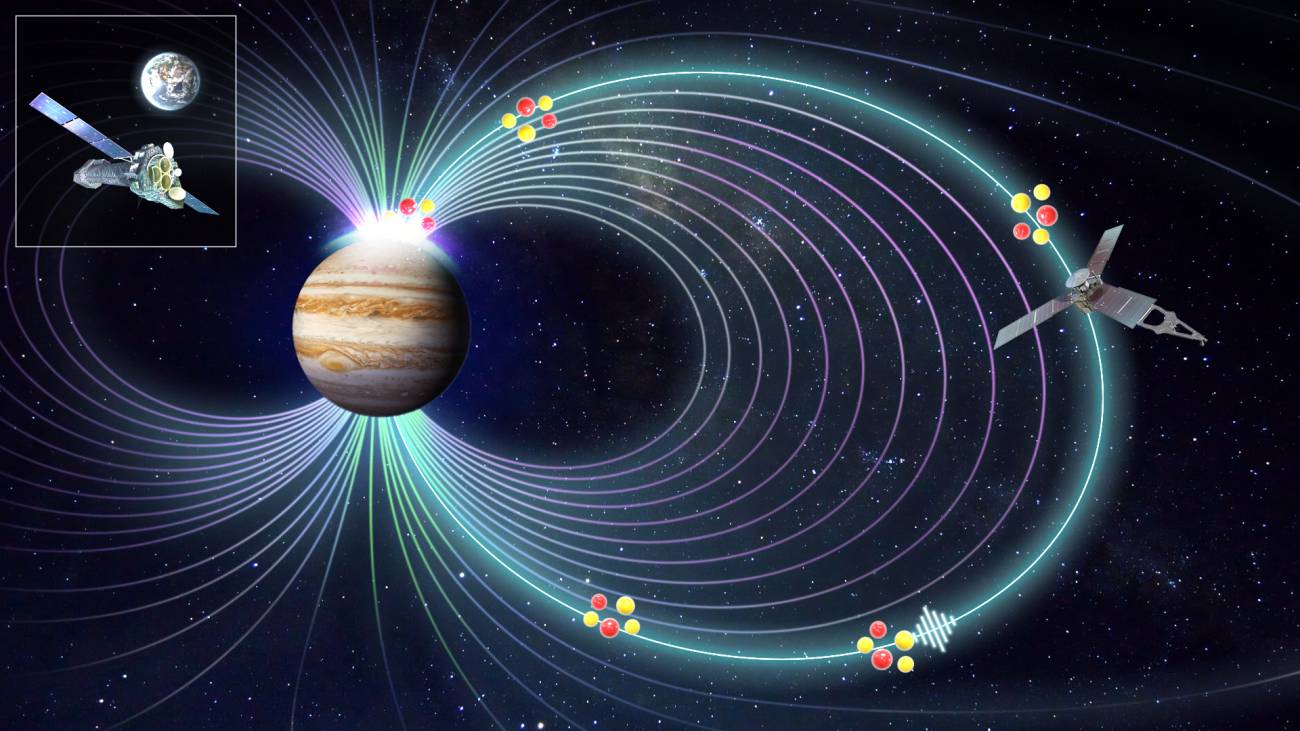

El sobrevuelo de Júpiter significó una buena oportunidad para las sondas Cassini y Galileo de cara a estudiar varios aspectos de este planeta y su medio circundante desde octubre de 2000 hasta marzo de 2001, es decir, antes, durante y después de la máxima aproximación a Júpiter, el 30 de diciembre de 2000. Las observaciones científicas contaron con la ventaja de disponer de dos sondas espaciales en las cercanías del planeta al mismo tiempo. Algunos de los objetivos llevados a cabo conjuntamente por la Cassini y la Galileo incluyeron el estudio de la magnetosfera y los efectos del viento solar en ésta, así como la obtención de datos sobre las auroras en Júpiter.

Durante este sobrevuelo, la mayor parte de los instrumentos del orbitador Cassini fueron conectados, calibrados y trabajaron recogiendo información. Este estudio conjunto sirvió como buena práctica para comprobar el funcionamiento del instrumental de la sonda tres años antes de su llegada a Saturno.

Llegada a Saturno

Después de un viaje de casi siete años y más de 3500 millones de kilómetros recorridos, la sonda Cassini llegará a Saturno el día 1 de julio de 2004.

La fase más crítica de la misión –además del lanzamiento– es la inserción orbital del vehículo en torno al planeta. Cuando el vehículo alcance el planeta, la sonda pondrá en marcha su motor principal durante 96 minutos a las 04:36 T.U., con la finalidad de reducir su velocidad y permitir que la gravedad de Saturno la capture como un satélite del planeta. Atravesando el hueco entre los anillos F y G, Cassini se aproximará al planeta para iniciar así la primera de sus 76 órbitas que completará durante su misión principal de cuatro años.

Todos hemos podido admirar las imágenes y sabido de los datos científicos que la Cassini ha podido enviar a la Tierra para que, todos podamos saber mucho más del planeta Saturno y de su entorno. Imágenes inolvidables y de increíble belleza forman parte ya de la historia de la misión.

La misión de la sonda Huygens

La sonda Huygens viajó junto a la Cassini hacia Saturno. Anclada a ésta y alimentada eléctricamente por un cable umbilical, Huygens ha permanecido durante el viaje de siete años en modo inactivo, sólo puesta en marcha cada seis meses para realizar chequeos de tres horas de duración de su instrumental y de sus sistemas ingenieriles.

Unos 20 días antes de alcanzar la atmósfera alta de Titán, Huygens fue eyectada por Cassini. Esto ocurrió el 24 de diciembre de 2004. Tras cortar su cable umbilical y abrir sus anclajes, Huygens se separó de su nave madre y voló en solitario hacia Titán, con una trayectoria balística, girando a 7 revoluciones por minuto para estabilizarse. Varios temporizadores automáticos conectarán los sistemas de la sonda espacial antes de que ésta alcance la atmósfera superior de Titán.

Unos 20 días antes de alcanzar la atmósfera alta de Titán, Huygens fue eyectada por Cassini. Esto ocurrió el 24 de diciembre de 2004. Tras cortar su cable umbilical y abrir sus anclajes, Huygens se separó de su nave madre y voló en solitario hacia Titán, con una trayectoria balística, girando a 7 revoluciones por minuto para estabilizarse. Varios temporizadores automáticos conectarán los sistemas de la sonda espacial antes de que ésta alcance la atmósfera superior de Titán.

Dos días después de la eyección de la sonda, Cassini realizará una maniobra de desviación, de manera que ésta puedo seguir a la Huygens cuando penetró en la atmósfera de Titán. Esta maniobra servió también para establecer la geometría requerida entre el orbitador con Huygens, así como las comunicaciones de radio durante el descenso.

Dos días después de la eyección de la sonda, Cassini realizará una maniobra de desviación, de manera que ésta puedo seguir a la Huygens cuando penetró en la atmósfera de Titán. Esta maniobra servió también para establecer la geometría requerida entre el orbitador con Huygens, así como las comunicaciones de radio durante el descenso.

Huygens porta dos transmisores de microondas en la banda S y dos antenas, las cuales enviarán simultáneamente la información recogida hacia el orbitador Cassini. Una de ellas emitirá con un retraso de seis segundos respecto a la otra, para evitar cualquier pérdida de información si tuviesen lugar problemas con las comunicaciones.

El descenso de Huygens tuvo lugar el 15 de enero de 2005. La sonda entró en la atmósfera de Titán a una velocidad de 20.000 Km/h. Este vehículo ha sido diseñado tanto para soportar el extremo frío del espacio (temperaturas de –200°C) como el intenso calor que se encontrará durante su entrada atmosférica (más de 12000°C).

El descenso de Huygens tuvo lugar el 15 de enero de 2005. La sonda entró en la atmósfera de Titán a una velocidad de 20.000 Km/h. Este vehículo ha sido diseñado tanto para soportar el extremo frío del espacio (temperaturas de –200°C) como el intenso calor que se encontrará durante su entrada atmosférica (más de 12000°C).

Los paracaídas que transporta Huygens frenaron más la sonda, de tal modo que ésta puedo llevar a cabo un amplio programa de observaciones científicas al tiempo que desciende hacia la superficie de Titán. Cuando la velocidad de la sonda descendido hasta los 1400 Km/h, se desprendió su cubierta mediante un paracaídas piloto. Acto seguido se desplegó otro paracaídas de 8.3 metros de diámetro que frenó aún más el vehículo, permitiendo la eyección del decelerador y del escudo térmico.

Durante la primera parte del descenso, el trabajo de los instrumentos situados a bordo de la sonda Huygens será dirigido por un sistema temporizador, pero en los últimos 10 a 20 Km, será un altímetro radar quien medirá la altura a la que se encuentra el vehículo y controlará el instrumental científico.

Durante el descenso, el instrumento de estructura atmosférica de Huygens medió las propiedades físicas de la atmósfera. El cromatógrafo de gases y el espectrómetro de masas determinarán la composición química de la atmósfera en función de la altitud. El colector de aerosoles y el pirolizador capturarán partículas de aerosol –las finas partículas líquidas o sólidas suspendidas en la atmósfera–, las calentará y enviará el vapor resultante al espectrómetro y el cromatógrafo para su análisis.

El sistema de imagen de descenso y el radiómetro espectral trabajarán en la toma de imágenes de formaciones nubosas y de la superficie de Titán, determinando además la visibilidad en la atmósfera de este mundo. Según se vaya aproximando a la superficie, el instrumento encenderá un sistema de iluminación brillante que para medir la reflectividad superficial. Paralelamente a ello, la señal emitida por la sonda Huygens será recogida por el experimento Doppler de la Cassini, con lo cual se podrán determinar los vientos, ráfagas y turbulencias de la atmósfera. Cuando la sonda sea empujada por el viento, la frecuencia de su señal de radio variará ligeramente –en lo que se conoce como efecto Doppler, similar a la variación de la frecuencia del silbido de un tren que percibimos cuando éste pasa por delante de nosotros. Estos cambios en la frecuencia se emplearán para deducir la velocidad del viento que ha experimentado la sonda.

Pequeños mundos muy cercanos a nosotros y que nos podrían dar buenas sorpresas

La misión principal de la sonda Cassini tenía previsto que finalizaría el 30 de junio de 2008, cuatro años después de su llegada a Saturno y 33 días después de su último sobrevuelo a Titán, el cual tuvo lugar el 28 de mayo de 2008. Este sobrevuelo estaba diseñado para posicionar a la sonda de cara a un nuevo acercamiento a dicho satélite el 31 de julio de 2008, ofreciendo la oportunidad de proceder con más sobrevuelos durante la misión extendida, si es que los recursos disponibles la permiten. No hay ningún factor en la misión principal que impida una misión extendida. Lo cierto es que, Cassini sigue ahí y, como otros ingenios espaciales enviados al espacio, continúan más allá de la misión en principio previstas enviando datos e imagines que nos acercan al saber del mundo que nos rodea y nos dice cómo y por qué funciona así la Naturaleza.

Me he extendido más de lo previsto en este trabajo y, no puedo seguir nombrando otras misiones que, como las enviadas a Marte, tan buenos réditos de conocimiento nos han suministrado. Ya habrá lugar más adelante para continuar profundizando en todo lo que hicimos y, también, ¿Cómo no? en lo mucho nos queda por hacer.

No podemos negar que, escenas como la que arriba contemplamos, no sea algo cotidiano en el devenir de la Humanidad. El futuro que nos aguarda puede ser algo maravilloso y de asombrosos descubrimientos que nos llevaran lejos, hacia otros mundos, otras estrellas… ¡otras amistades!

Pero todo eso amigo míos, sólo podrá ser posible gracias al conocimiento y al hecho de ser conscientes de nuestras limitaciones. No debemos nunca querer superar a la Naturaleza, simplemente debemos aprender de ella.

Emilio Silvera Vázquez

May

18

Lo cierto es que…, ¡nunca dejáremos de hacernos preguntas!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Nunca dejaremos de hacer preguntas ~

Clasificado en Nunca dejaremos de hacer preguntas ~

Comments (1)

Comments (1)

¡Sabemos tanto de las estrellas!¡Nos queda tanto por saber!

SE produce el proceso Triple Alfa y se “fabrica” Carbono en las estrellas

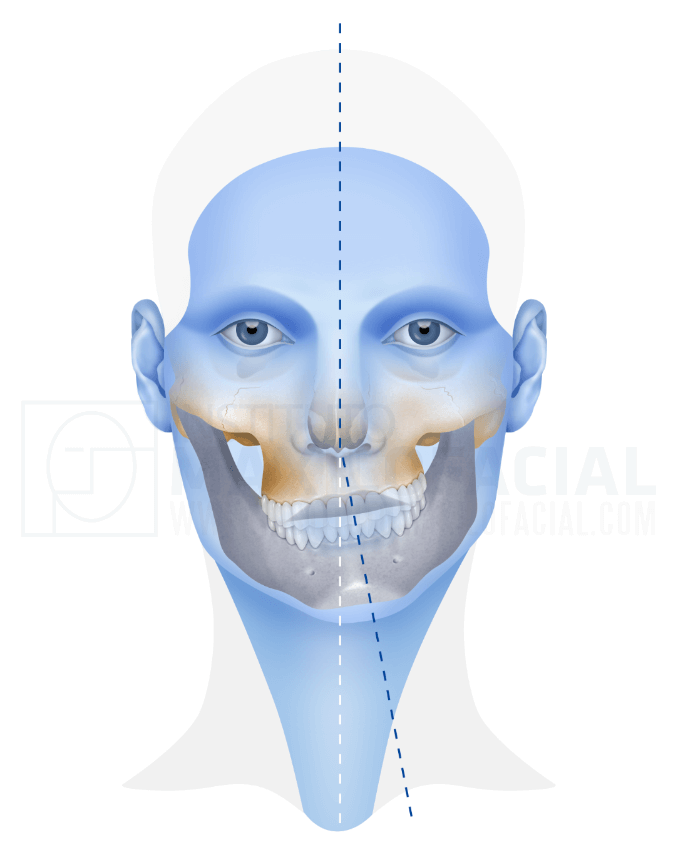

La plenitud de la belleza en una cara simétrica contrasta con la desagradable sensación de la asimétrica. Ese es el sentido que tenemos, nuestras mentes tienden hacia la perfección.

Aunque es cierto que “sobre gustos no hay nada escrito”, los humanos nos sentimos más a gusto con las caras más simétricas. En la cultura popular, y salvo alguna rara excepción, las caras asimétricas están relacionadas con la maldad. Los biólogos encontraron rápidamente una explicación evolutiva: los individuos más evolucionados pueden mantener sus formas simétricas inclusive cuando están expuestos al estrés y las enfermedades. Es decir, cuando las partes del cuerpo que tienden a la simetría no lo son, costará más pasar esos genes porque será rechazado por potenciales parejas. De esta manera la evolución distingue a la simetría como una característica valiosa.

David (1501-1504), de Miguel Ángel, Galería de la Academia de Florencia.

El desnudo de una figura presenta una simetría bilateral casi perfecta. Ciertamente, parte del atractivo del mismo, tanto en la realidad como en el arte, reside en la identificación de los lados derecho e izquierdo del cuerpo mediante mediante una simetría especular. La figura femenina raramente presenta asimetrías. La asimetría de un varón se rompe solamente por la curiosa circunstancia de que su testículo izquierdo cuelga más bajo que el derecho.

(1532), de Lucas Cranach el Viejo, Städelsches Kunstinstitut, Fráncfort del Meno, censurada por el Metro de Londres en 2008.

Evidentemente, cada cuerpo, considerado de forma individual, puede otras desviaciones menores de su simetría: un hombro más alto que otro, un pecho mayor que su pareja, una ligera desviación de la columna, una peca o un antojo en un costado…, pero tales anomalías, en su mayor parte, pueden encontrarse tanto a un lado como al otro.

“La simetría bilateral (también conocida como simetría planar) se define por la existencia de un único plano, llamado plano sagital, que divide el cuerpo de un organismo en aproximadamente dos mitades especularmente idénticas, llamadas mitad izquierda y mitad derecha,

La simetría bilateral se mantiene en el interior del cuerpo, en en los músculos y en el esqueleto, pero queda rota por la disposición fuertemente asimétrica de algunos órganos. El corazón, el estómago y el páncreas están desviados hacia la izquierda; el hígado y el apéndice, hacia la derecha. El pulmón derecho es mayor que el izquierdo. Los retorcimientos y vueltas de los intestinos son completamente asimétricos. El cordón umbilical humano, una magnifica hélice triple formada por dos arterias y una vena, puede enrollarse en cualquiera de los dos sentidos.

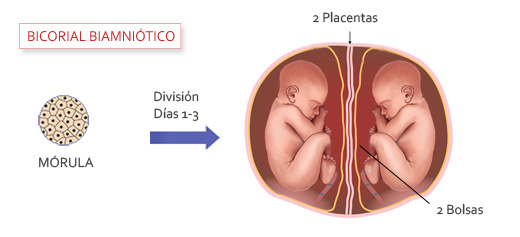

Los mellizos que se desarrollan por la fecundación simultánea de dos óvulos separados, pueden tener detalles asimétricos en un sentido en uno de ellos, y en el contrario en el otro, pero esto no ocurre con mayor frecuencia que la que cabría esperar como fruto del azar. Es una creencia generalizada que los gemelos (formados a partir de un único óvulo, que se divide inmediatamente después de la fecundación) tiene una marcada tendencia a aparentar especulares recíprocas. Por desgracia, las estadísticas al respecto son confusas y muchos expertos creen que los gemelos idénticos no se presentan como imágenes especulares uno de otro en mayor medida que cualquier otro tipo de hermanos.

En el caso de gemelos siameses (gemelos idénticos, unidos uno a otro a causa de un a partición tardía e incompleta del óvulo), el tema no ofrece duda alguna. Son exactamente enantiomorfos en casi todos los detalles: si uno es diestro, el otro es zurdo; si uno tiene el remolino del pelo que va en el sentido de las agujas del reloj, el de su hermano/hermana irá en el sentido contrario. Diferencias en los oídos, los dientes…, aparecen en ambos como especulares unas respecto de otras (hasta en eso es perfecta la Naturaleza). Las huellas dactilares o de la palma de la mano derecha de uno serán muy parecidas a las correspondientes a la mano izquierda del otro.

Todavía más: un gemelo siamés tendrá “vísceras transpuestas”; sus órganos internos estarán colocados de manera inversa, el corazón a la derecha, el hígado a la izquierda. Esta transposición de órganos, o inverse situs, como se denomina a veces, se da siempre en cualquier par de gemelos siameses, pero puede aparecer también en no incluidas en estas circunstancias.

Merece la pena hacer notar que Lewis Carroll, en A través del espejo (Alianza Editorial, 1990), pretende tomar los gemelos idénticos Tararí y Tarará como imágenes especulares uno de otro. Cuando los hermanos Tara ofrecen enlazar sus manos con Alicia, uno de ellos alarga su derecha; el otro la izquierda. Si observamos detenidamente las ilustraciones de Tenniel, especialmente la que muestra los dos gemelos uno frente a otro, para la batalla, veremos que los ha dibujado como si fueran enantiomorfos.

Claro que, algunos son completos

En el comportamiento y los hábitos de los seres humanos hay muchos ejemplos de marcada asimetría; los más evidentes son consecuencia de que la mayoría de las personas son diestras. La mano derecha está controlada por la parte izquierda del cerebro, y la parte derecha de éste controla la mano izquierda, por lo que la condición de diestro es, en realidad, un fenómeno de lateralidad izquierda del cerebro. Hubo un tiempo en el que se creía que los bebés nacían sin tendencia alguna de tipo genético que favoreciera el uso de una mano concreta, que la lateralidad de un niño era exclusivamente el resultado de las enseñanzas de sus padres. Platón era un notable defensor de esta opinión.

“En el uso de las manos estamos, y estábamos, viciados por las manías de nuestras institutrices y madres -escribe Platón en sus Leyes-, pues aunque nuestros miembros están compensados por naturaleza, creamos una diferencia entre ellos como consecuencia de un mal hábito.”

Sabemos hoy en día que Platón estaba equivocado. Como hace notar Aristóteles con buen criterio. De todas las maneras, la tendencia innata para muchas personas de usar preferentemente la mano derecha es común desde que la puede constatarlo de manera evidente.

Los antropólogos culturales no han encontrado todavía ni una sola sociedad, o incluso una tribu , en la que la norma sea la lateralidad izquierda: los esquimales, los indios americanos, los maoríes y los africanos son todos diestros. Los antiguos egipcios, griegos y romanos eran diestros. Naturalmente, si retrocedemos todavía más en la Historia, la evidencia de la lateralidad diestra es ya escasa e indirecta y hay que dilucidarla a partir del estudio de la forma de sus utensilios y armas, así como de las pinturas que muestran los hombres trabajando o en la batalla.

Las propias palabras que se usan en muchas lenguas para designar la izquierda y la derecha dan testimonio de un sesgo universal hacia el lado derecho. En , ir a derechas es hacer las cosas correctamente, mientras que no dar una a derechas, es sinónimo de hacerlo todo mal.

Ser diestro en algo es lo mismo que poseer una habilidad especial para ello, mientras que una cosa siniestra (del latín sinester, izquierda) es una cosa hecha con mala intención. En otras lenguas el significado viene a ser más o menos el mismo. Los italianos, tan suyos ellos, llaman a la mano izquierda stanca, fatigada, o manca, la que no se tiene. Lo cierto es que, por lo , los zurdos son ambidiestros.

Para tener una buena visión histórica de mlos prejuicios virulentos contra los zurdos en cualquier parte del mundo, veáse el séptimo capítulo de The Dragons of Eden, de Carl Sagan (Random House, 1977), y el delicioso de Jack Fincher, Sinister People (Putnam, 1977). Este último da una lista de más de cien personajes famosos que fueron zurdos.

Por lo que hemos observado , y hasta donde sabemos, la especie humana tiene la tendencia a utilizar la mano derecha. Claro que no sabemos. La mayoría de los mamíferos subhumanos son ambidiestros y, ¿Cómo serán las especies que viven en otros mundos? El personaje de arriba, al menos, parece que es zurdo.

Lo cierto es que, poco importa si somos zurdos o no, la igualdad en lo esencial es casi idéntica. La verdadera diferencia está en el cerebro, en la manera de ver las cosas, en cómo cada cual enfoca los problemas y qué soluciones aplica a cada situación, en que perspectiva podamos tener de nuestra Sociedad, de nuestras leyes, de nuestros derechos, de la moral y la ética… Todo lo demás, son circunstancias anecdóticas que poco influyen en el devenir del mundo.

Mi curiosidad y mi predilección por la lectura, me proporcionó un poquito de saber, algunos temas llamaron mi atención más que otros. Sin embargo, no r4echacé ninguno que me llevara a comprender sobre diferentes secretos de la Naturaleza, de la condición humana, de los hechos del pasado, las historias de los distintos pueblos del mundo, la complejidad que llevamos con nosotros y que llamamos Mente, ese “algo” inmaterial que surge del cerebro en el que están trabajando miles de millones de neuronas que no dejan de crear pensamientos y también sentimientos.

Nunca me he sentido saciado de conocer nuevas “cosas”, y, en el Blog trato de divulgar los conocimientos del mundo, de tal manera que, si los visitantes a este humilde lugar, cuando pasan por aquí, han conseguido ser un poquito más sabios… ¡El objetivo está cumplido! Creo que a medida que sabemos… ¡Seremos mejores!

Emilio Silvera Vázquez

May

18

¿Libre Albedrío? ¿Dónde está?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Libre Albedrío ~

Clasificado en Libre Albedrío ~

Comments (9)

Comments (9)

El cerebro es capaz de inventar recuerdos de hechos que nunca ocurrieron

La capacidad humana para aprender, inventar, buscar recursos, y sobre todo, adaptarse a las circunstancias es bastante grande. A lo largo de los últimos milenios Civilizaciones del pasado han demostrado que puedes desarrollarse y constituir sociedades que apuntan maneras de querer hacer bien las cosas. Bueno, al menos esas son las sensaciones que yo he podido percibir.

desarrollarse y constituir sociedades que apuntan maneras de querer hacer bien las cosas. Bueno, al menos esas son las sensaciones que yo he podido percibir.

Aunque examinando la realidad de los hechos y la Historia del pasado, las perspectivas no se cumplieron…, del todo. No se cumplen dichas expectativas. Sociedades democráticas y de derecho –aquellas polis griegas del pasado-, El sueño de un reparto equitativo de la riqueza es una quimera.

Hay cosas de las que, sin ser los responsables directos, nos hacen sentir vergüenza

Medio mundo se muere desnutrido y, el otro medio, se muere por la obesidad. Los pueblos, por motivos religiosos, de ocupación de zonas ricas en recursos energéticos y por otras causas que nunca justificaron el resultado, se están matando en pleno siglo XXI.

Mientras estos monstruos sean necesarios… ¡Mal van las cosas!

Con tal panorama, nadie podrá negar que la Humanidad, no se ha ganado el derecho a tal nombre, estamos deshumanizados y en pleno proceso de “humanización”. Tenemos ingenios espaciales que nos envían datos de las estrellas, robots que hacen fotos de planetas lejanos y hacen análisis de la composición del terreno de las lunas de Júpiter o Saturno, satélites orbitando la Tierra que nos facilitan las comunicaciones y nos envían los parámetros del tiempo en los rincones más alejados del globo, ordenadores que se programan para que un láser opere un ojo humano o mil maravillas más. Sin embargo, a pesar de todo eso, dentro de nosotros prevalece el instinto animal salvaje que de manera inconciente, nos hace desconfiar de los demás y nos empuja incluso a matar, de forma

de las estrellas, robots que hacen fotos de planetas lejanos y hacen análisis de la composición del terreno de las lunas de Júpiter o Saturno, satélites orbitando la Tierra que nos facilitan las comunicaciones y nos envían los parámetros del tiempo en los rincones más alejados del globo, ordenadores que se programan para que un láser opere un ojo humano o mil maravillas más. Sin embargo, a pesar de todo eso, dentro de nosotros prevalece el instinto animal salvaje que de manera inconciente, nos hace desconfiar de los demás y nos empuja incluso a matar, de forma inhumana, por defender aquello que consideramos nuestro o que simplemente queremos. Y mientras que sea así, la “Humanidad” no será “humana”…, todavía. Parece que nos falta evolución y que el proceso continúa, aún falta bastante tiempo para alcanzar el nivel que, de manera definitiva, nos distinga de los animales irracionales. De momento, no hemos podido conquistar esa racionalidad que tanta falta nos hace. En algunos aspectos, nos comportamos como auténticos idiotas.

inhumana, por defender aquello que consideramos nuestro o que simplemente queremos. Y mientras que sea así, la “Humanidad” no será “humana”…, todavía. Parece que nos falta evolución y que el proceso continúa, aún falta bastante tiempo para alcanzar el nivel que, de manera definitiva, nos distinga de los animales irracionales. De momento, no hemos podido conquistar esa racionalidad que tanta falta nos hace. En algunos aspectos, nos comportamos como auténticos idiotas.

Además de EE.UU. y China, otros países también les sigue la pauta armamentística

Esta estadística clasifica los 15 países con el gasto militar más alto en 2019. Estados Unidos, con un gasto de defensa total de aproximadamente 259.000 millones de dólares estadounidenses, se situaba en la primera posición del ranking. seguida de China, con 250.000.

Y mientras, miles de personas mueren de hambre en las calles de esos Estados

¿Cuántos problemas podríamos solucionar y cuántos programas de investigación podríamos llevar a buen fin, si se destinaran los presupuestos de todos los países del mundo gastados en armas y ejércitos a causas más nobles? Estamos inmersos en una sociedad del miedo, en la que los poderosos, tienen dominado al mundo que se rige por sus intereses, y, la mayoría de las personas, aunque no tienen cadenas ni grilletes como los esclavos del pasado, sí tienen otros amarres que los tienen confinados en un mundo de Hipotecas y de trabajos precarios que, de alguna manera, viene a ser lo mismo.

los esclavos del pasado, sí tienen otros amarres que los tienen confinados en un mundo de Hipotecas y de trabajos precarios que, de alguna manera, viene a ser lo mismo.

Hoy parece que me he salido del guion científico para explicar el motivo por el cual (guiado por el egoísmo de unos pocos), la Humanidad está dejando de lado su verdadera obligación de avanzar en el sentido del conocimiento para que, llegado el momento, podamos hacer frente a los terribles problemas que tendremos que resolver. De momento, el más prioritario y terrible de todos es el de conseguir una digna capacidad de vida para nuestros hermanos, tenemos que procurar una digna forma de vida para todos los seres del planeta y que, de manera práctica y efectiva las regiones ricas acudan en ayuda de las regiones pobres del mundo evitando la miseria, el hambre, la enfermedad y la muerte que sin inmutarnos, estamos presenciando, cada día, cómodamente sentados en nuestro confortable sofá viendo y oyendo las horribles noticias que nos llegan desde esas desgraciadas regiones. Lo más lamentable es que tales sucesos, por su cotidianidad, han pasado a ser parte de nuestras vidas, se toma como algo inevitable que, al estar lejos de nosotros, no nos afecta.

viendo y oyendo las horribles noticias que nos llegan desde esas desgraciadas regiones. Lo más lamentable es que tales sucesos, por su cotidianidad, han pasado a ser parte de nuestras vidas, se toma como algo inevitable que, al estar lejos de nosotros, no nos afecta.

Habrá que despejar las brumas de la mente que nos impiden ver el paisaje. Tenemos que despertar de este terrible sueño, para poder ver la horrible realidad. Tenemos la obligación moral, ética y social de cambiar el estado actual de las cosas. El mundo no puede seguir así por mucho tiempo.

poder ver la horrible realidad. Tenemos la obligación moral, ética y social de cambiar el estado actual de las cosas. El mundo no puede seguir así por mucho tiempo.

Un futuro mejor

Newton pasaba grandes temporadas en la casa labriega de su padre

Sin importar la procedencia familiar, ni el lugar de nacimiento, y teniendo en cuenta las capacidades personales de cada uno, todos, sin excepción, recibirán las enseñanzas más adecuadas a sus capacidades. No podemos dejar escapar mentes de inmensa imaginación y poderosas ideas por el simple hecho de no tener los medios para poder desarrollarlas. Recuerdo, en este punto que, el padre de Newton, era un humilde y pequeño agricultor que ni sabia escribir. Sin embargo, ello no impidió que su hijo destacara como

las capacidades personales de cada uno, todos, sin excepción, recibirán las enseñanzas más adecuadas a sus capacidades. No podemos dejar escapar mentes de inmensa imaginación y poderosas ideas por el simple hecho de no tener los medios para poder desarrollarlas. Recuerdo, en este punto que, el padre de Newton, era un humilde y pequeño agricultor que ni sabia escribir. Sin embargo, ello no impidió que su hijo destacara como uno de los científicos más grandes de nuestro mundo.

uno de los científicos más grandes de nuestro mundo.

Matemáticos, físicos, químicos, biólogos, astrónomos, o simples peones de factorías, cada uno será lo que quiera ser, lo que su mente le permita y sus deseos les exijan, hagamos que sea una realidad el tan aireado -pero inexistente- libre albedrio. Dejemos que cada cual pueda elegir su destino y que surjan escritores, músicos pintores o actores. También el espíritu tiene que ser alimentado.

El mejor amigo… ¡Un libro! Allí, lo mismo encontramos bellas historias que hacen volar nuestra imaginación, como las respuestas a preguntas que nadie nos supo contestar. Desde una fantástica aventura, pasando por un poema de amor, hasta el más intrincado secreto de la Naturaleza

una fantástica aventura, pasando por un poema de amor, hasta el más intrincado secreto de la Naturaleza

Ahora , cada uno de nosotros -por lo general-, tiene lo que ha podido conseguir, no lo que verdaderamente quería. ¿Cuántos magníficos médicos, profesores, ingenieros o físicos no se habrán perdido por falta de apoyo? Tenemos que poner los medios que sean necesarios para que todos podamos ser lo que realmente queremos, una de las bases de la felicidad está en el principio de realizar aquello que más nos atrae. ¿Cuántas veces hemos oído decir… ¡me gusta tanto lo que hago que, más que un trabajo, es un gozo!?

, cada uno de nosotros -por lo general-, tiene lo que ha podido conseguir, no lo que verdaderamente quería. ¿Cuántos magníficos médicos, profesores, ingenieros o físicos no se habrán perdido por falta de apoyo? Tenemos que poner los medios que sean necesarios para que todos podamos ser lo que realmente queremos, una de las bases de la felicidad está en el principio de realizar aquello que más nos atrae. ¿Cuántas veces hemos oído decir… ¡me gusta tanto lo que hago que, más que un trabajo, es un gozo!?

Es totalmente cierto, el que hace lo que le gusta no siente el paso del tiempo, se podría pasar horas y horas inmerso en su trabajo, fascinado con lo que llena sus sentidos, mentalmente situado en su mundo particular, sin que nada le pueda distraer, se aísla del entorno y consigue la felicidad personal a través de lo que hace.

a través de lo que hace.

Bueno, siempre que hacer lo que nos gusta no vulneren los derechos de los demás

Está claro que la calidad de vida, en todos los aspectos, estará presente allí donde se esté desarrollando una actividad acorde con los deseos de las personas que la llevan a cabo. Quien desarrolla un trabajo no deseado se limita a cumplir de cualquier manera, está todo el rato mirando el reloj deseando que la jornada finalice, su rostro refleja el fastidio que la tarea le produce. Por el contrario, quien hace aquello que de verdad le gusta, lo hará a conciencia, buscará la perfección y la belleza en aquello que realiza, y, mientras lo hace, estará tan centrado y concentrado en su trabajo que, para un atento observador, pareciera que está fuera de este mundo, fuera del entorno, sumergido en su propia realidad.

no deseado se limita a cumplir de cualquier manera, está todo el rato mirando el reloj deseando que la jornada finalice, su rostro refleja el fastidio que la tarea le produce. Por el contrario, quien hace aquello que de verdad le gusta, lo hará a conciencia, buscará la perfección y la belleza en aquello que realiza, y, mientras lo hace, estará tan centrado y concentrado en su trabajo que, para un atento observador, pareciera que está fuera de este mundo, fuera del entorno, sumergido en su propia realidad.

Otros, inmersos en lo que les gusta, ni se acuerdan de comer

Dicho todo lo anterior, si no conseguimos algún día que todo eso sea una realidad para todos, difícilmente lograremos un mundo plenamente desarrollado y habitado por gente felices que, habiendo desarrollado sus intelectos, también, como consecuencia de ello, habrán logrado construir una Sociedad en la que, todos tendrán su lugar y nadie estará ni se sentirá postergado.

todos, difícilmente lograremos un mundo plenamente desarrollado y habitado por gente felices que, habiendo desarrollado sus intelectos, también, como consecuencia de ello, habrán logrado construir una Sociedad en la que, todos tendrán su lugar y nadie estará ni se sentirá postergado.

¿Cuántos problemas desaparecerán si pudiéramos conseguir eso? Quizás algún día lejos, muy lejos aún en el futuro, podremos gozar de un panorama así, en el que todos, tengan la oportunidad de desarrollar sus cualidades y las mentes, plenamente evolucionadas, darán sus ideas para que todas las puedan compartir.

¿Que aún falta mucho para que eso llegue -si es que llega algún día-? No tanto como a simple vista nos pueda parecer, el transcurrir del tiempo es inexorable y, lo mismo que todo tuvo un principio, también tendrá un final y, mientras ese final llega, si por el camino podemos alcanzar cosas buenas…, mucho mejor. Cuando me pongo a escribir y a dejar mis ideas por ahí, escritas en las hojas de papel de una libreta, o, en éstas mismas páginas del Blog … Pienso que:

… Pienso que:

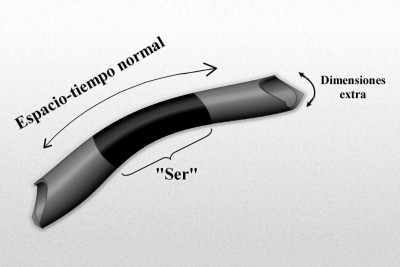

“El gráfico representa un modelo de manguera de un espacio-tiempo de dimensiones más altas de tipo Kaluza-Klein, donde la longitud, o mejor, la dimensión a lo largo de la longitud de la manguera representa el 4-espacio-tiempo normal, y la dimensión alrededor de la manguera representa la dimensión extra “pequeñas” (quizá escala de Planck). Imaginemos un “ser” que habite en este mundo, que rebasa estas dimensiones extra “pequeñas”, y por ello no es realmente consciente de ellas.

Kaluza-Klein, donde la longitud, o mejor, la dimensión a lo largo de la longitud de la manguera representa el 4-espacio-tiempo normal, y la dimensión alrededor de la manguera representa la dimensión extra “pequeñas” (quizá escala de Planck). Imaginemos un “ser” que habite en este mundo, que rebasa estas dimensiones extra “pequeñas”, y por ello no es realmente consciente de ellas.

Es posible que, de la misma manera, también nosotros estémos imposibilitados para ver esas dimensiones extra que, sin embargo, nos permita ver más allá de las matemáticas topológicas, más allá de las fluctuaciones de vacío, más allá de los quarks, más allá de las singularidades y… ¿Por qué no decirlo? ¡Más allá de nuestro propio Universo! No podemos olvidarnos de que dentro de varios eones, nuestro Universo podría morir. Estamos obligados a buscar la manera (si existe), de escapar de ese destino fatal.”

ver esas dimensiones extra que, sin embargo, nos permita ver más allá de las matemáticas topológicas, más allá de las fluctuaciones de vacío, más allá de los quarks, más allá de las singularidades y… ¿Por qué no decirlo? ¡Más allá de nuestro propio Universo! No podemos olvidarnos de que dentro de varios eones, nuestro Universo podría morir. Estamos obligados a buscar la manera (si existe), de escapar de ese destino fatal.”

“Algo tuyo queda en esas hojas de papel o en las páginas escritas en un blog virtual que, de alguna manera, grita los mensajes que surgen de tu mente”.

virtual que, de alguna manera, grita los mensajes que surgen de tu mente”.

Aquí estoy en mi oficina señalando a la galaxia Andrómeda

Cuando escribo, mis pensamientos recorren los caminos más inesperados, y relaciono cosas que a simple vista nadan tienen que ver con el tema que estoy tratando, pero no es así, todo, de alguna manera, está conectado. Nuestros cerebros son tan complejos que se podrían definir como los entes pensante del Universo -en otra ocasión trataremos sobre “La expansión del Universo–La expansión de la mente“, un tema que nos habla de cómo todo evoluciona, cambia y se transforma y, nosotros, no somos ninguna excepción.

¡Ah! Si no podemos hacer aquello que queremos hacer… ¿Dónde queda el libre Albedrío?

aquello que queremos hacer… ¿Dónde queda el libre Albedrío?

Emilio Silvera Vázquez

May

17

Nuestra curiosidad, siempre haciendo preguntas… Que nadie sabe...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

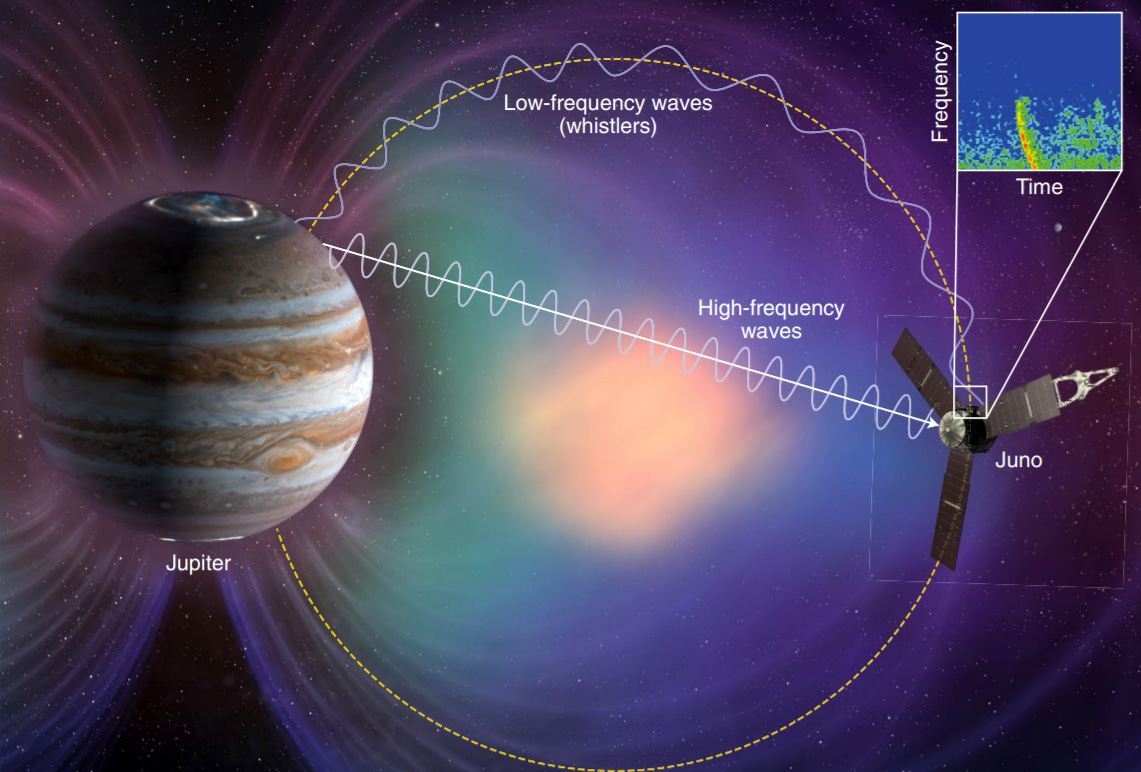

Recreación digital de las auroras de Júpiter. Esta imagen ha sido generada por inteligencia artificial a partir de datos científicos, y no corresponde a una fotografía real del planeta. Fuente: ChatGPT / E. F

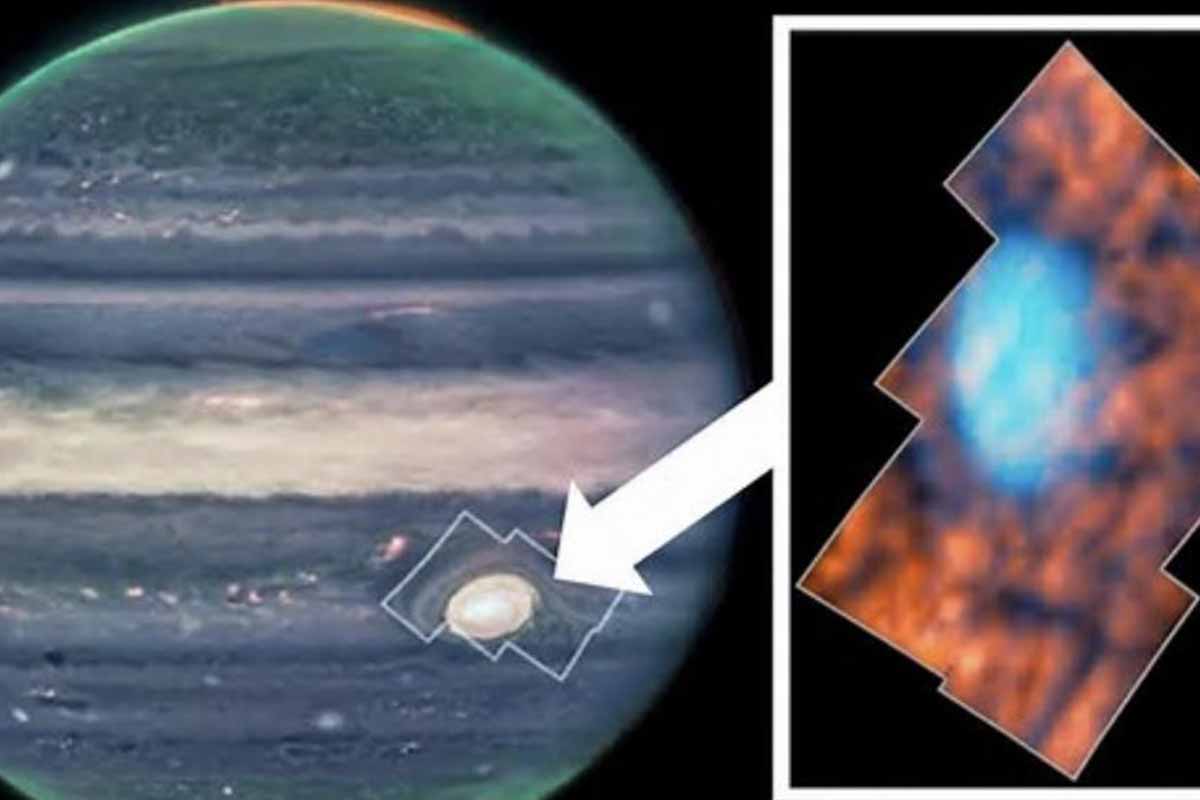

El telescopio James Webb capta luces en Júpiter que cambian tan rápido que ni los científicos lo entienden

Lo que revela la vida media del H₃⁺

Determinar la vida media del H₃⁺ es crucial porque esta molécula no solo emite luz: también ayuda a enfriar la atmósfera superior del planeta, disipando parte de la energía que entra por las auroras. Si su vida es muy corta, ese enfriamiento es menos eficiente, lo que implica que la atmósfera retiene más calor del que se pensaba. Según los investigadores, el tiempo de vida de 150 segundos implica que el H₃⁺ solo puede disipar una fracción del calor generado por un episodio auroral intenso.

Para llegar a este dato, el equipo comparó el ritmo de subida y bajada de las emisiones infrarrojas con las ultravioletas. Utilizando un modelo de decaimiento exponencial, hallaron que el perfil temporal del H₃⁺ se ajustaba muy bien a una caída con ese valor. “Este valor es nuestro resultado principal”, explican. También señalan que en casos extremos, como en las extinciones rápidas, la vida media podría reducirse a 29 segundos.

Un enigma aún sin resolver

Este video es independiente dle reportaje, se inserta para tener una idea de lo que es Júpiter

Uno de los aspectos más desconcertantes del estudio tiene que ver con la región activa del anochecer (DAR, por sus siglas en inglés). Esta zona mostró emisiones infrarrojas muy brillantes que no parecen tener una causa clara. En particular, los autores destacan que la energía emitida por el H₃⁺ en esta región supera la energía de entrada de los electrones que supuestamente la originan. “Esto indica que la fuente no es simplemente la precipitación de partículas”, escriben. Es decir, la cantidad de luz emitida no puede explicarse solo con el bombardeo de partículas energéticas.

Las hipótesis para este exceso energético son varias, pero ninguna es concluyente. Se han planteado mecanismos como la fricción entre iones y neutros (ion drag) o el calentamiento por corrientes eléctricas (Joule heating), pero los tiempos requeridos para producir cambios serían demasiado largos. Según el artículo, “las escalas temporales para los cambios de temperatura (10³–10⁴ s) y para la difusión o transporte (10⁴–10⁵ s) no pueden explicar la variabilidad en escalas de 10 minutos”.

Una aurora que cambia en segundos

Uno de los descubrimientos más sorprendentes fue la detección de lo que el equipo llama “extinciones”: caídas abruptas de intensidad de la aurora. En una de las secuencias analizadas, la emisión infrarroja cayó un 40 % en apenas 12 segundos. Este tipo de comportamiento no había sido observado con anterioridad. En palabras del artículo: “En estos eventos, la radiancia de H₃⁺ en regiones localizadas disminuyó súbitamente en casi un factor de 2 en unos 10 segundos”. Este comportamiento extremo sugiere que el ambiente auroral de Júpiter es mucho más variable de lo que se pensaba.

El equipo también detectó pulsaciones aurorales que se propagan a través de determinadas regiones del planeta, con velocidades equivalentes a 60 kilómetros por segundo. Estas ondas se repetían con una cadencia de 1,6 minutos y podrían estar relacionadas con perturbaciones magnéticas conocidas en la magnetosfera joviana, aunque no hay una explicación definitiva. La combinación de estos datos muestra una aurora “viva”, lejos del concepto de fenómeno estable y continuo.

Además, al comparar las imágenes del James Webb en el infrarrojo con otras obtenidas simultáneamente en el ultravioleta por el telescopio Hubble, los investigadores hallaron diferencias llamativas. Por ejemplo, una de las zonas más brillantes en el infrarrojo no tenía equivalente visible en el ultravioleta. Esto es desconcertante, porque en teoría ambas emisiones deberían responder al mismo tipo de excitación atmosférica. “La causa de tal emisión sigue sin estar clara”, señalan los autores.

Lo más probable, apuntan, es que el fenómeno esté controlado por la formación y destrucción local de H₃⁺, en lugar de por cambios en la temperatura. Esta hipótesis se apoya en los datos espectrales obtenidos con otro instrumento del James Webb (NIRSpec), que muestran que en la región brillante del anochecer aumenta la densidad de columna del H₃⁺, pero no su temperatura, lo que refuerza la idea de que lo que cambia es la cantidad de moléculas, no el calor que emiten.

Júpiter, laboratorio natural

Estos resultados tienen implicaciones que van mucho más allá del planeta Júpiter. El estudio del H₃⁺ y sus emisiones sirve como modelo para comprender las atmósferas de otros planetas gigantes y también de enanas marrones y exoplanetas, donde fenómenos similares podrían estar ocurriendo. Si las emisiones infrarrojas de H₃⁺ pueden variar con tanta rapidez y complejidad, entonces los modelos actuales sobre atmósferas planetarias podrían estar subestimando su dinámica energética.

También se plantea un reto para futuras observaciones. El telescopio Webb ha abierto una nueva ventana de alta resolución temporal que obliga a reinterpretar datos anteriores tomados con exposiciones mucho más largas. Lo que antes parecía estable, podría haber estado variando sin que pudiéramos verlo. El estudio concluye que será necesario combinar estos datos con futuras observaciones de la sonda Juno y con modelos más avanzados para desentrañar los mecanismos que controlan la aurora joviana.

Finalmente, hay un mensaje claro: no todo está explicado en Júpiter, un planeta que sigue sorprendiendo incluso a los científicos que llevan décadas estudiándolo. Las auroras que creíamos comprender ahora muestran un rostro mucho más volátil, cambiante y energético de lo que imaginábamos.

Esta es la Fuente del Reportaje.

Totales: 84.232.567

Totales: 84.232.567 Conectados: 50

Conectados: 50