May

31

¡La Astronomía! Que nos habla del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El hombre en el Universo ~

Clasificado en El hombre en el Universo ~

Comments (1)

Comments (1)

Además de A. N., estrellas de N., galaxias y planetas extrasolares… ¡Hay mucho más!

Otra manera de mirar el universo nos da nuevas ideas, no todo el espacio son agujeros negros, estrellas de neutrones, galaxias y desconocidos planetas; la verdad es que casi todo el universo está vacío y sólo en algunas regiones tiene agrupaciones de materia en forma de estrellas y otros objetos estelares y cosmológicos; muchas de sus propiedades y características más sorprendentes (su inmenso tamaño y su enorme edad, la soledad y oscuridad del espacio) son condiciones necesarias para que existan observadores inteligentes como nosotros.

No debería sorprendernos la vida extraterrestre; si existe, pudiera ser tan rara y lejana para nosotros como en realidad nos ocurre aquí mismo en la Tierra, donde compartimos hábitat con otros seres vivos con los que hemos sido incapaces de comunicarnos, a pesar de que esas formas de vida, como la nuestra, están basadas también en el carbono. No se puede descartar formas de vida inteligente basadas en otros elementos, como por ejemplo, el silicio.

La baja densidad media de materia en el universo significa que si agregáramos material en estrellas o galaxias, deberíamos esperar que las distancias medias entre objetos fueran enormes.

| El universo visible contiene sólo: |

|

May

31

El pensamiento humano (Siempre buscando la verdad)

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Lo que no puede llevarnos a ninguna clase de dudas, es el hecho de que no podemos afirmar que sabemos. Muchos son los Secretos que la Naturaleza oculta a nuestros ojos y a nuestro entendimiento.

¿Quién sabe donde está la verdad?

Y, mientras buscamos (algunas veces por casualidad y otras por causalidad), nos encontramos con alguna respuesta a las preguntas planteadas.

¿Mente y materia eran dos aspectos de la misma cosa?

¿La Vida y la muerte son dos caras de la misma moneda?

Esta última pregunta da que pensar, ya que, nosotros tenemos en la Mente esa imagen de la vieja fea de la guadaña, cuando en realidad, la muerte siempre ha estado con nosotros, no tiene que venir de ninguna parte, simplemente sale de nuestro propio interior, donde duerme “eternamente”, hasta que se nos termina el tiempo que la Naturaleza nos concedió.

Así, con todo el sentido, aquel pensador decía:

“… Con el paso de los Eones, hasta la muerte tendrá que morir!

Bueno, la muerte morirá cuando la vida deje de existir, sin la una no puede existir la otra.

De todas las maneras… ¡Prefiero saber la verdad, no me gusta vivir en la mentira por placentera que sea!

Emilio Silvera Vázquez

May

31

Cosas de la Mecánica Cuántica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

¡La Física! Esa maravilla que está presente en todo lo que podemos ver y en aquello donde la vista no llega. La infinitud de las partículas elementales que forman todo cuanto existe en la Naturaleza, no siempre se dejan ver ni hacen posible que podamos observar las maravillas que pueden llevar a cabo,

Las sustancias formadas por una sola clase de átomos se llaman elementos químicos, y, si está conformada por distintos átomos, son compuestos. La palabra “átomo” procede del griego ατομος, que significa “indivisible” y el uso de la palabra “elemento” sugiere que se ha llegado a los ladrillos básicos con los que está formada la materia. De hecho, esta es la imagen que se tenía a mediados del siglo XIX cuando se acuñaron estos términos. Sin embargo, hoy sabemos que todo esto es falso, que los átomos se pueden dividir y que, de esta manera, los elementos han dejado de ser verdaderamente elementales. Los físicos continúan con esta nomenclatura aunque sea formalmente incorrecta, ya que, la costumbre, como dicen los juristas, no pocas veces rigen la jerga de las leyes.

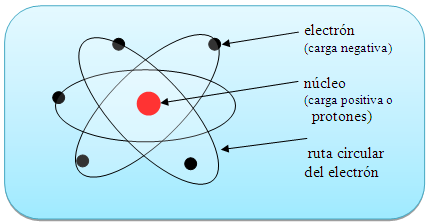

A todo esto y hablando de los átomos, por fuerza, nos tenemos que acordar del electrón que da al átomo su forma esférica. Son partículas cargadas eléctricamente que se mueven alegremente alrededor del núcleo. El electrón es muy ligero: su masa es solamente 1/1.8836 de la del núcleo más ligero (el hidrógeno). La carga eléctrica del electrón es de signo opuesto a la del núcleo, de manera que los electrones están fuertemente atraídos hacia el núcleo y se repelen mutuamente. Si la carga eléctrica total de los electrones en un átomo iguala a la del núcleo, para lo que generalmente se necesitan varios electrones, se dice que el átomo está en equilibrio o que es eléctricamente neutro.

Claro que, no debemos olvidarnos de que, ¡Todo lo grande está hecho de cosas pequeñas! Una inmensa galaxia se conforma de un conjunto inmenso de átomos infinitesimales que juntos, hace ese gran todo.

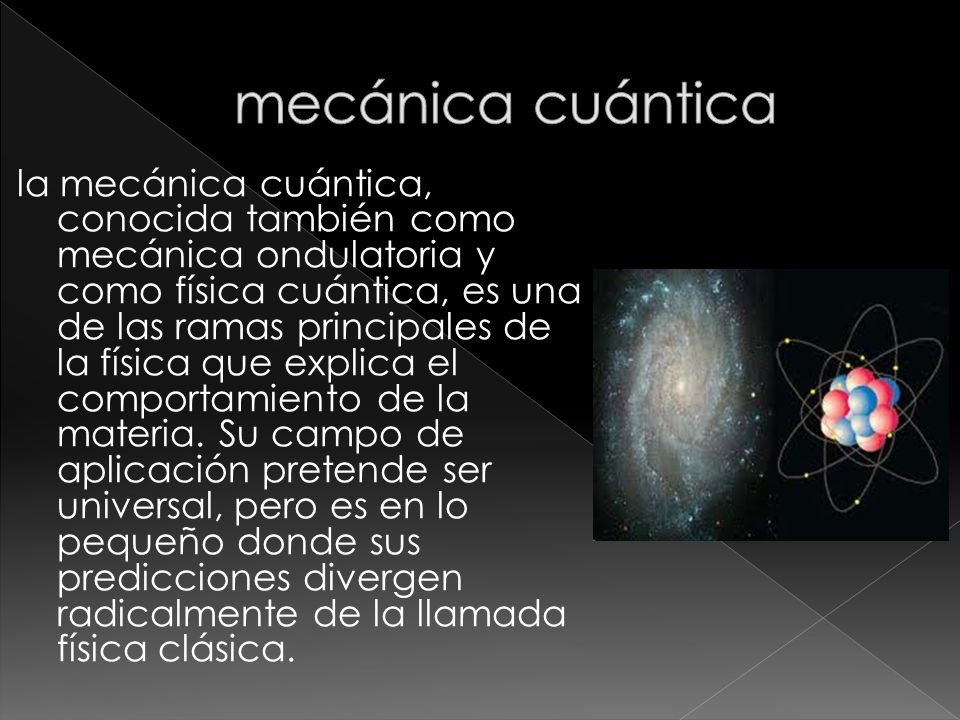

La fuerza a la que obedecen los electrones, la denominada fuerza electrostática o de Coulomb, es matemáticamente bastante sencilla y, sin embargo, los electrones son los responsables de las importantes propiedades de los “enlaces químicos”. Esto se debe a que las leyes de movimiento de los electrones están regidas completamente por la “mecánica cuántica”, teoría que se completó a principios del siglo XX. Es una teoría paradójica y difícil de entender y explicar, pero al mismo tiempo es muy interesante, fantástica y revolucionaria. Cuando uno se introduce en las maravillas de la mecánica cuántica es como si hiciera un viaje a un universo que está situado fuera de este mundo nuestro, ya que, las cosas que allí se ven, desdicen todo lo que dicta nuestro sentido común de cómo tiene que ser el mundo que nos rodea.

La perfecta sincronía Está en la Naturaleza

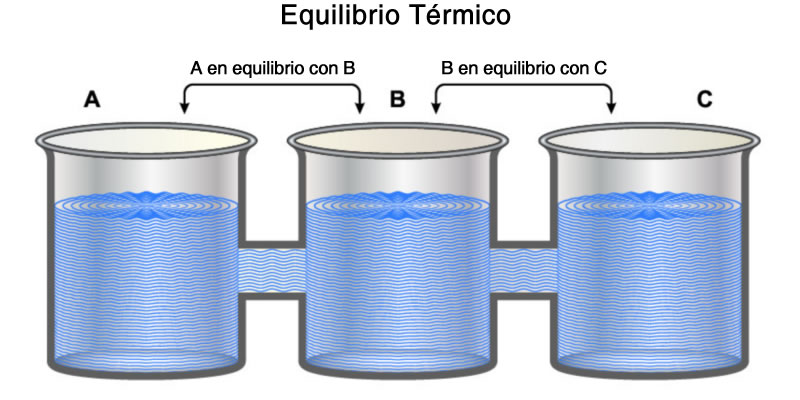

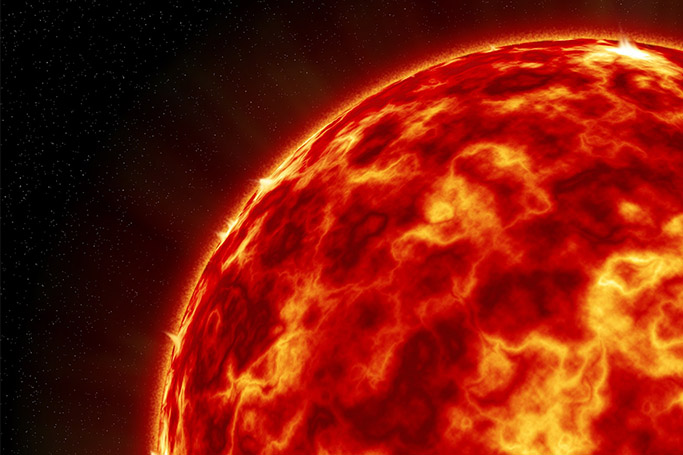

No solamente los electrones, sino también los núcleos atómicos y los átomos en su conjunto obedecen y se rigen por la mecánica cuántica. La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck, escribió un artículo de ocho páginas y allí propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

Radiación electromagnética

Estaban bien aceptados entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para las longitudes mayores como para las longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de la onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

E = h x v

Donde E es la energía del paquete, v la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Los cuantos de energía están presentes por todas partes y en todos los objetos

El Efecto Foto-eléctrico

Dualidad onda partícula

Los paquetes de energía de Planck

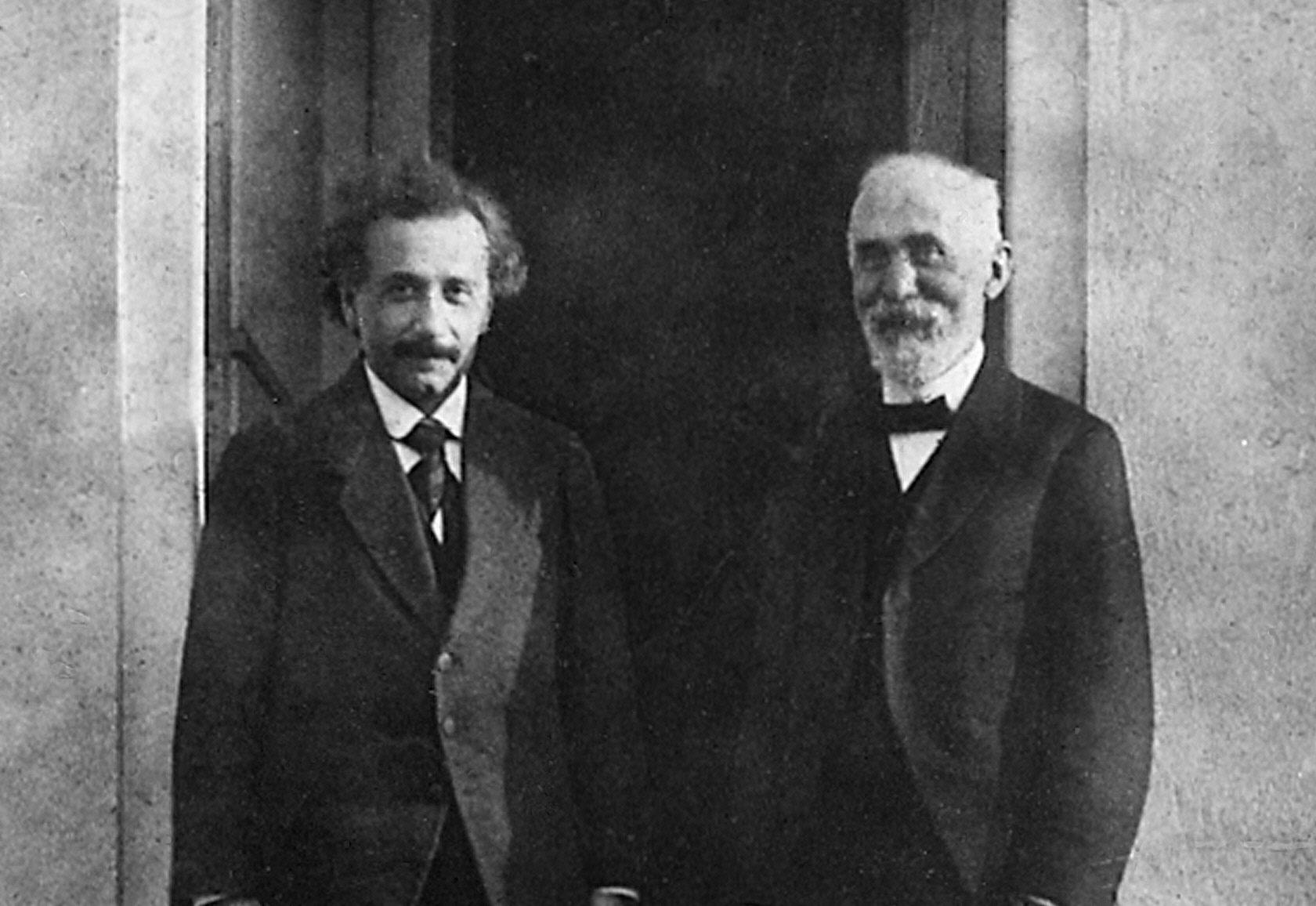

Poco tiempo después, en 1905, Einstein formuló esta teoría de una forma mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos de los paquetes de energía de Planck. El príncipe francés Louis-Víctor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Erwin Schrödinger descubrió como escribir la teoría ondulatoria de De Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños estaban exactamente determinados por la recién descubiertas “ecuaciones de onda cuánticas”.

14 de diciembre de 1900: Max Planck publica un arículo de ocho páginas y quedó sembrada la semilla de lo que, más tarde, sería la Mecánica Cuántica.

https://youtu.be/bzFWEHaOj0Q

En 1905 y más tarde en 1915, Einstein publicó la Teoría de la Relatividad Especial y General, lo que dio un giro al entendimiento de la Física, y, en la segunda parte, nos trajo una nueva forma de ver y entender el Universo.

Pocas dudas nos pueden caber a estas alturas de que la mecánica cuántica (de Planck) y, la Relatividad –tanto especial como general- (de Einstein), además de ser las dos teorías más importantes de la Física de nuestro tiempo, funcionan de tal forma que uno, cuando profundiza en sus predicciones y las compara con lo que ocurre en el Universo, no puede por menos que, asombrarse, al comprobar como unas mentes humanas han sido capaces de llegar a estos profundos pensamientos que nos acerca a la realidad de la Naturaleza.

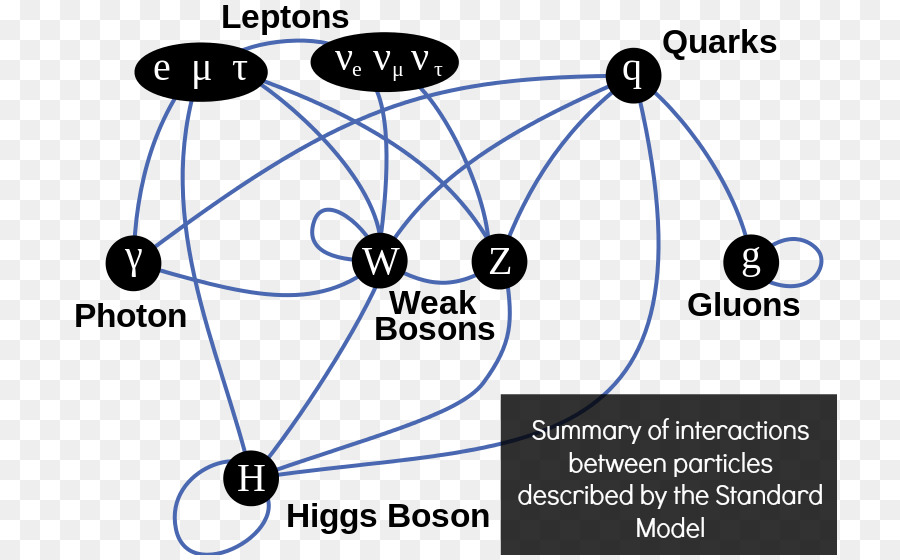

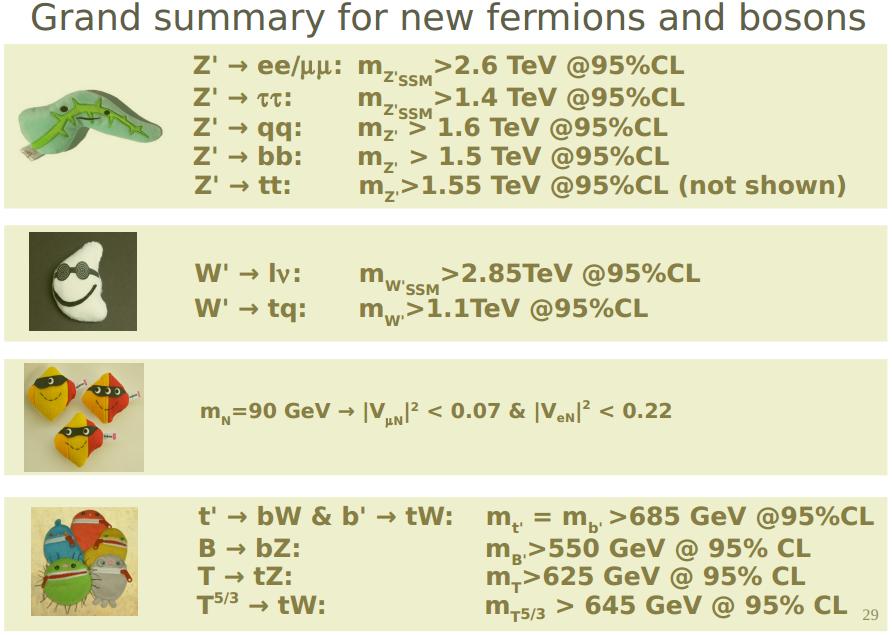

No me parece completa la reseña anterior sin repasar un poco lo que concierne al llamado Modelo Estándar de la Física de partículas, que supone una gran herramienta de trabajo para los físicos.

Precisamente, en los dos últimos comentarios del contertulio Sr. Fandila y otro mío, nos estábamos refiriendo a las teorías y, los dos coincidimos en que, a medida que se avanza y se descubren nuevos parámentros, tienen que ser refinadas para que reflejen de manera más real lo que quieren representar de los fenómenos que vemos en la Naturaleza.

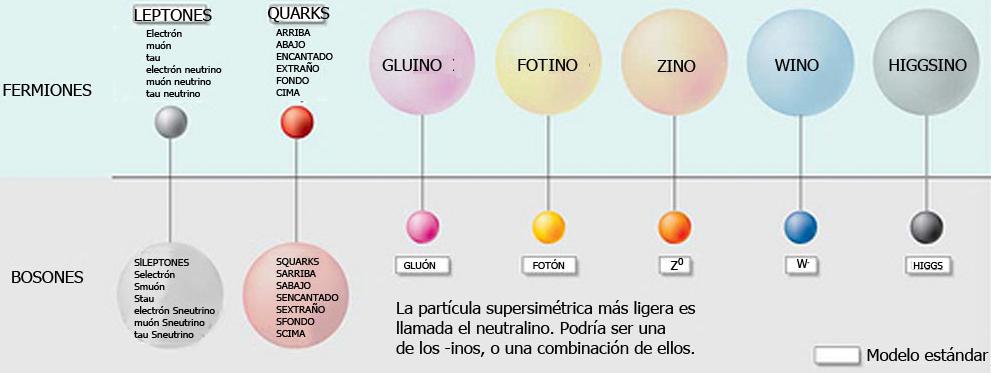

“El modelo estándar de la física de partículas es una teoría relativista de campos cuánticos desarrollada entre 1970 y 1973[cita requerida] basada en las ideas de la unificación y simetrías1 que describe la estructura fundamental de la materia y el vacío considerando las partículas elementales como entes irreducibles cuya cinemática está regida por las cuatro interacciones fundamentales conocidas (exceptuando la gravedad, cuya principal teoría, la relatividad general, no encaja con los modelos matemáticos del mundo cuántico). La palabra “modelo” en el nombre viene del período de los 70 cuando no había suficiente evidencia experimental que confirmara el modelo.1 Hasta la fecha, casi todas las pruebas experimentales de las tres fuerzas descritas por el modelo estándar están de acuerdo con sus predicciones. Sin embargo el modelo estándar no alcanza a ser una teoría completa de las interacciones fundamentales debido a varias cuestiones sin resolver.”

Han pasado 50 años desde que Steven Weinberg y Abdus Salam publicaran aquel artículo en el que formalizaron el llamado Modelo Estándar de las Interacciones Fundamentales. Han sido 5 décadas de actividad científica muy intensa en las que se han realizado toda clase de experimentos para someter a esta teoría a las más complicadas pruebas que nos dijeran si realmente era un modelo que reflejaba la realidad que la naturaleza nos quiere transmitir.

El Modelo Estándar está construido de manera imperfecta, y aunque ha sido y será una herramienta de un enorme rendimiento para los físicos, hay que reconocer que estaba construido con 20 parámetros aleatorios (metidos con calzador) y, de los cuales solo uno de ellos (el Bosón de Higgs) ha sido hallado.

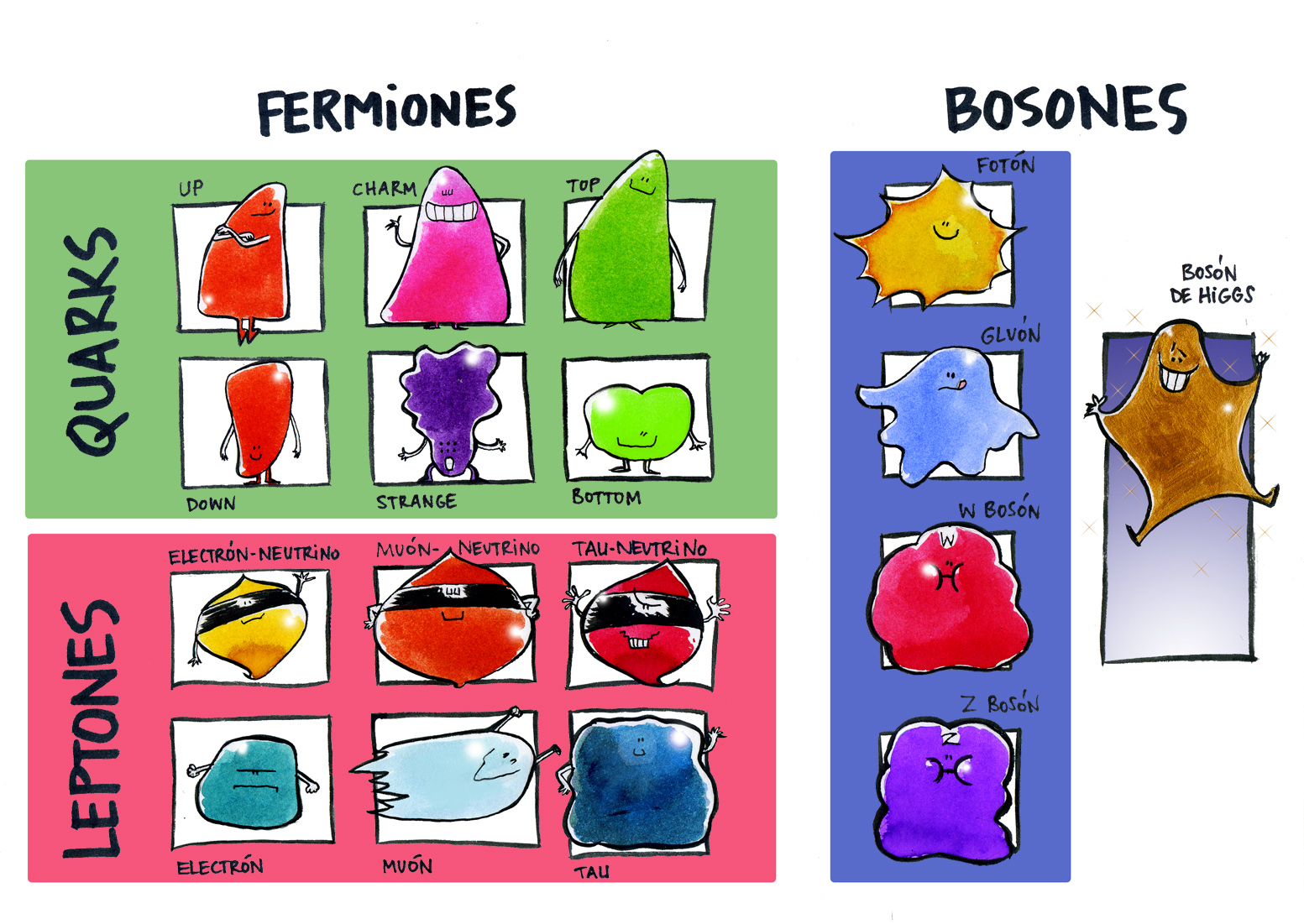

En el modelo estándar que nos habla de las familias de partículas subatómicas que conforman la materia y también de aquellas otras que son intermediarias en la transmisión de las fuerzas fundamentales. Las partículas están divididas en familias como los quarks, los leptones y los hadrones. En realidad, los hadrones que se dividen en bariones y mesones se consideran una clase de subpartículas al estar conformadas por tripletes de quarks los bariones, y, por quarks y anti-quarks los mesones.

Además de las partículas mencionadas, en el Modelo Estándar están incluidas tres de las cuatro fuerzas fundamentales de la Naturaleza: Fuerza Nuclear Fuerte, Fuerza Nuclear Débil y, Electromagnetismo. La cuarta fuerza que es la Gravedad se resiste a reunirse en el modelo con las otras tres, y, precisamente por eso, los físicos están tratando de construir el modelo de la Gravedad Cuántica que por fin, reúna a todas las fuerzas.

Parece (aunque esto será objeto de un artículo a parte) que en la teoría de cuerdas (pendiente de ser verificada) puede subyacer esa teoría cuántica de la gravedad.

La teoría estándar constituye un logro científico de inmensa importancia. A partir de simples postulados de simetría, es posible deducir las propiedades dinámicas de las interacciones electrodébil y fuerte, es decir, el lagrangiano completo que rige las fuerzas entre los constituyentes básicos de la materia, prediciendo así el comportamiento del mundo microscópico, de forma muy precisa y en perfecto acuerdo con las observaciones experimentales.

Más aún, la consistencia matemática de la teoría hizo necesario introducir un nuevo campo de fuerza escalar, el campo de Higgs, del que no teníamos ninguna evidencia empírica hasta que los experimentos realizados en el acelerador de partículas LHC, encontraron el Bosón de Higgs y se consiguió añadir uno de los veinte parámetros aleatorios que tenía el modelo para convertirlo en un parámetro real y muy positivo, de tal manera que 50 años más tarde, lo que era una hipótesis teórica se ha convertido en una realidad tangible.

Desde la perspectiva actual, la Teoría Estándar se obtiene fácilmente a partir de un mínimo número de ingredientes: la existencia de constituyentes elementales de la materia con espín ½, quarks y leptones, y las propiedades de simetría de los campos cuánticos que los describen.

La derivación matemática de su estructura parece tan simple y elegante que se podría llegar a pensar que es el resultado de una idea brillante (¿por qué no se nos había ocurrido antes?). Nada más lejos de la realidad. El desarrollo histórico de la teoría se produjo mediante una concatenación de pequeños pasos, no siempre en la buena dirección, en los que poco a poco se fueron superando grandes dificultades técnicas y conceptuales.

El modelo que formularon Weinberg y Salam en 1967-1968 estaba basado en los desarrollos anteriores realizados por muchos otros científicos. Además, era un modelo solo de leptones y por lo tanto, tal como ahora sabemos, matemáticamente inconsistente debido a anomalías cuánticas. Harían falta todavía algunos años de profunda investigación y nuevas ideas para hacer posible la incorporación de los quarks, dando lugar al modelo definitivo. La celebración de este cincuentenario es una buena oportunidad para analizar retrospectivamente la evolución conceptual que ha permitido alcanzar este gran éxito científico.

Para terminar este trabajo, me retrotraigo a ese “puntito” infinitesimal que es el Núcleo Atómico

Rutherford con su experimento, descubrió que en el átomo existía un pequeño núcleo cargado positivamente, rodeado de electrones cargados negativamente. Los experimentos sobre la dispersión de partículas pusieron de manifiesto que el núcleo tiene dimensiones del orden de 10-14 m. Dado que el diámetro de un átomo es del orden de 10-10 m, el núcleo ocupa solo una fracción muy pequeña del volumen de un átomo. Sin embargo, el núcleo contiene casi toda la masa del átomo, como también demostraron esos experimentos.

Pero profundicemos un poco más

El núcleo atómico está constituido de los llamados Nucleones (es decir: Protones y Neutrones, partículas no elementales de la familia de los Hadrones en su rama Bariónica). Pero resulta que los nucleones están conformados, al mismo tiempo, por tripletes de partículas elementales de la familia Quarks, un protón tiene en sus entrañas a dos Quarks Up y un Quark Down, mientras que el Neutrón, tiene en su interior a dos Quarks Down y un Quarks Up.

Estos Quarks están allí confinados mediante la fuerza nuclear fuerte (la más potente de las cuatro fuerzas fundamentales), que es la única fuerza que crece con la distancia. Pues bien, la fuerza es transmitida e intermediada por otra familia de partícula que se llaman Bosones, y, aquí aparecen los Gluones que retienen a los Quarks confinados en el interior de los nucleones, y, cuando los Quarks tratan de separarse… ¡La fuerza nuclear aumenta y lo impide! Es lo que se conoce como libertad Asintótica de los Quarks.

Es difícil imaginar como en un espacio tan diminuto como lo es el núcleo atómico, puedan existir tantas cosas y ocurran tantos sucesos, realmente la Naturaleza es Asombrosa.

Emilio Silvera Vázquez

May

30

Los Misterios de la Tierra

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

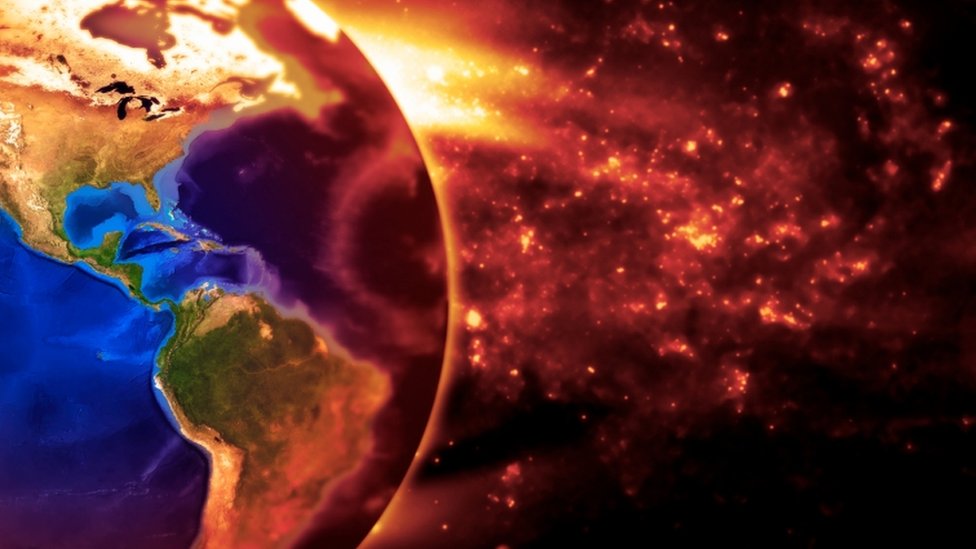

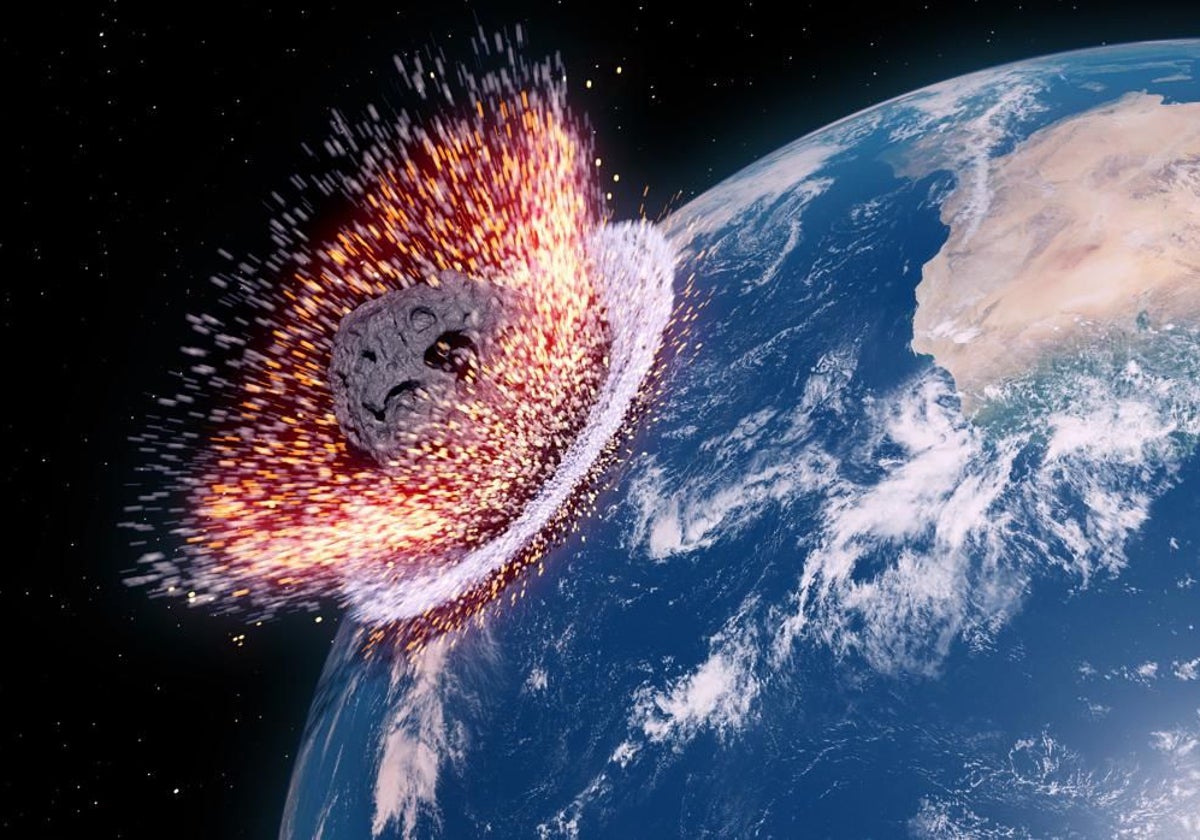

Encuentros espaciales

La más destructiva intensificación temporal de los normalmente suaves flujos de energía geotectónica –erupciones volcánicas o terremotos extraordinariamente potentes– o de energía atmosférica –vientos o lluvias anormalmente intensas–, parecen irrelevantes cuando se comparan con las (en el pasado) repetidas colisiones del planeta con cuerpos extraterrestres relativamente grandes. Que por ahora, nos están respetando y, además, tenemos el escudo de Júpiter que los atrae.

Apophis (conocido anteriormente por su designación provisional 2004 MN4) es un asteroide Atón, con una órbita próxima a la de la Tierra que, en un primer momento pareció que colisionaría con el planeta.

Parece un tradición hacer grandes titulares cuando un nuevo asteroide se acerca a la Tierra. Las redes sociales se inflaman y todo el mundo se acuerda del asteroide que parece que terminó con los dinosaurios.

En el caso de Apophis, 99942 para sus íntimos, es cierto que se trata del objeto con más probabilidades de impacto, aunque sean muy lejanas. Además el nombre no ayuda. Apophis es el Dios del Caos o de las fuerzas del mal de los egipcios, lo cual sin duda es perfecto para hacer grandes titulares.

Tampoco ayuda su calificación astronómica: la NASA clasifica algunos objetos cercanos a la tierra (Near Earth Objects) como “potencialmente peligrosos”. El cóctel está servido para crear supuestos alarmantes.

Existen simulaciones de lo que puede ser el choque del meteorito en la Tierra y, desde luego, no quisiera estar aquí cuando suceda. La Tierra está siendo bombardeada continuamente por invisibles partículas microscópicas de polvo muy abundantes en todo el Sistema Solar, y cada treinta segundos se produce un choque con partículas de 1 mm de diámetro, que dejan un rastro luminoso al autodestruirse en la atmósfera. También son relativamente frecuentes los choques con meteoritos de 1 metro de diámetro, que se producen con una frecuencia de, al menos, uno al año.

Pero los impactos, incluso con meteoritos mayores, producen solamente efectos locales. Esto es debido a que los meteoritos que deambulan por la región de asteroides localizada entre Marte y Júpiter están girando alrededor del Sol en el mismo sentido que la Tierra, de manera que la velocidad de impacto es inferior a 15 Km/s.

Entre Marte y Júpiter hay cientos de miles de cuerpos pequeños que orbitan alrededor del Sol llamados asteroides. También podemoas encontrarlos más allá de Plutón, llamado cinturón de Kuiper, y que en este caso reciben el nombre de objetos transneptunianos y que están hecho de hielo. Ceres es el asteroide más grande y tiene 913 km de diámetro.

El cráter de Arizona, casi perfectamente simétrico, se formó hace 25.000 años por el impacto de un meteorito que iba a una velocidad de 11 Km/s, lo que representa una potencia cercana a 700 PW. Estas gigantescas liberaciones de energías palidecen cuando se comparan con un choque frontal con un cometa típico. Su masa (al menos de 500 millones de toneladas) y su velocidad relativa (hasta 70 Km/s) elevan su energía cinética hasta 1022 J. Aunque se perdiera un diez por ciento de esta energía en la atmósfera, el impacto sería equivalente a una explosión de unas 2.500 bombas de hidrógeno de 100 megatones.

Si choca con la Tierra uno de esos gigantes…

Está claro que un fenómeno de estas características produciría impresionantes alteraciones climatológicas. Sin embargo, no es seguro y sí discutible que un impacto parecido fuese la causa de la extinción masiva del cretácico, siendo lo más probable, si tenemos en cuenta el periodo relativamente largo en que se produjo, que se podría explicar por la intensa actividad volcánica de aquel tiempo.

La frecuencia de impactos sobre la Tierra disminuye exponencialmente con el tamaño del objeto. Muchas toneladas son las que recibimos cada año de pequeños fragmentos de todo tipo pero, cuando estos van aumentando de tamaño, los sucesos de espacian de manera sustancial

Aproximadamente, cada cincuenta o sesenta millones de años se produce una colisión con un cometa, lo que significaría que la biosfera, que ha evolucionado durante cuatro mil millones de años, ha debido superar unos cuarenta impactos de este tipo. Está claro que ha salido airosa de estas colisiones, ya que aunque haya sido modificada, no ha sido aniquilada.

Supernova 1994D (SN1994D) en la galaxia NGC 4526. La supernova es el punto brillante abajo a la izquierda. Pueden llegar a brillar más que toda la galaxia completa durante un breve período de tiempo. (Crédito: NASA). Ahí, en esa explosión sin igual, se gesta la “fabricación” de materiales muy complejos como el oro y el platino…entre otros.

Igualmente, la evolución de la biosfera ha sobrevivido a las explosiones altamente energéticas de las supernovas más “cercanas”. Dado que en nuestra galaxia se produce por término medio la explosión de una supernova cada 50 años, el Sistema Solar se encuentra a una distancia de 100 parsecs de la explosión cada dos millones de años y a una distancia menor de 10 parsecs cada dos mil millones de años. En este último caso, la parte alta de la atmósfera se vería inundada por un flujo de rayos X y UV de muy corta longitud de onda, diez mil veces mayor que el flujo habitual de radiación solar, lo que implica que la Tierra recibiría, en unas pocas horas, una dosis de radiación ionizante igual a la que recibe anualmente. Exposiciones de 500 roentgens son letales para la mayoría de los vertebrados y, sin embargo, los diez episodios de esta magnitud que se han podido producir en los últimos 500 millones de años no han dejado ninguna consecuencia observable en la evolución de la biosfera.

Si suponemos que una civilización avanzada podría preparar refugios para la población durante el año que transcurre ente la llegada de la luz y la llegada de la radiación cósmica, se encontraría con la inevitable dosis de 500 roentgens cada mil millones de años, tiempo suficiente para permitir el desarrollo de una sociedad cuyo conocimiento le sirviera para defenderse de un flujo tan extraordinario y de consecuencias letales.

La fotosíntesis

Todo el Oxígeno de la Atmósfera terrestre procede del oxígeno que desprenden los organismos autótrofos durante la fotosíntesis.

“… Las plantas con estructuras mayores y más complejas son las que tienen un balance de producción de oxígeno menor, o, dicho de otra forma, aquellas con una estructura sencilla (mucho “verde” y poco “tronco” dicho sea por simplificar) son las que presentan una mayor producción de oxígeno neta. Siguiendo ese razonamiento, parece lógico pensar que las grandes productoras de oxígeno son las plantas en crecimiento, las praderas, los bosques jóvenes, los cultivos y casi todas las plantas en crecimiento que te rodean, las cuales desprenden más oxigeno del que consumen. ¿Dónde se encuentran las comunidades vegetales que se multiplican continuamente y no cesan de crecer?: en el océano.”

Bioluminiscencia del fitoplancton en una playa de Maldivas.

“Por encima de todo, el verdadero oxigenador del planeta, el responsable de que puedas respirar y estés leyendo este artículo se encuentra en los océanos. Los minúsculos organismos que se conocen como fitoplancton están en la base de la cadena trófica de los ecosistemas marinos y sirven de alimento tanto para el zooplancton como para para las ballenas y otros grandes animales marinos. Un estudio global de cuatro años ha descubierto, entre otras cosas, que el fitoplancton es una fuente clave de oxígeno en nuestro planeta. Los microorganismos autótrofos que lo componen producen entre el 50 y el 85% del oxígeno que se libera cada año a la atmósfera. Ese intervalo es muy amplio, porque todavía resulta muy difícil evaluar la productividad real del fitoplancton habida cuenta de sus oscilaciones anuales ligadas a factores que comentaremos y a su desigual distribución en las aguas oceánicas.”

https://www.sobreestoyaquello.com/2016/09/pulmones-de-la-tierra-2-el-maravilloso.html

https://youtu.be/dEbcFntiuGc

La fotosíntesis es el principal proceso bioquímico que consigue pasar materiales desde el biotopo hasta la biocenosis de un ecosistema. Una vez incorporados como parte de los organismos autótrofos, los heterótrofos (por ejemplo, los animales) solo tienen que aprovecharse de aquellos; con la existencia de pequeñas cantidades de agua, todo está preparado para que el ecosistema entero comience a funcionar. Además, siempre habrá animales depredadores, carnívoros, que seguirán aprovechando los materiales de otros.

La conocida ecuación básica que describe la reacción endotérmica por la cual se sintetiza una molécula de glucosa a partir de sus seis moléculas de CO2 y H2O, y 2’8 MJ de radiación solar, es una simplificada caja negra. Una caja negra más realista sería la siguiente:

106 CO2 + 90 H2O + 16 NO3 + PO4 + nutrientes minerales + 5’4 MJ de radiación = 3’258 g de protoplasma (106 C, 180 H, 46 O, 16 N, 1 P y 815 g de cenizas minerales) + 154 O2 + 5’35 MJ de calor disipado.

Sin macronutrientes ni micronutrientes no se puede producir fito-masa, que está compuesta por los nutrientes básicos necesarios para todos los seres heterótrofos: azúcares complejos, ácidos grasos y proteínas.

Para entender esta caja negra hay que comenzar por destacar la acción de unos pigmentos sensibles a la luz entre los cuales destacan las clorofilas. Éstas absorben la luz en dos bandas estrechas, una entre 420 y 450 nm, y la otra entre 630 y 690 nm. Así, la energía necesaria para la fotosíntesis sólo procede de la radiación azul y roja a la que corresponde menos de la mitad de la energía total de la insolación. Esta parte de la radiación fotosintéticamente activa (RFA) no se utiliza en reducir CO2, sino en la regeneración de compuestos consumidos durante la fijación del gas.

La síntesis de fitomasa en el ciclo reductor del fosfato pentosa (RPP) –un proceso con varios pasos de carboxilación por catálisis enzimática, reducción y regeneración– tiene que empezar con la formación de trifosfato de adenosina (ATP) y nicotinamida adenina dinucleótido fosfato (NADP), que son los dos compuestos que suministran energía a todas las reacciones biosintéticas. La síntesis de las tres moléculas de ATP y las dos de NADP que se necesitan para reducir cada molécula de CO2 requiere de diez cuantos de radiación solar con longitud de onda próxima al pico rojo de absorción de la clorofila (680 nm). El carbono procedente del CO2, combinado con el hidrógeno del agua y con los micronutrientes, dará lugar a nueva fitomasa que contiene 465 KJ/mol.

La cantidad de energía de un cuanto de luz roja es de 2’92×10-19 J (el producto de la constante de Planck, 6’62×10-34 por la frecuencia de la luz, que a su vez es el cociente entre la velocidad de la luz y la longitud de onda).

Un einstein (definido como un mol o número de Avogadro, 6’02×1023) de fotones rojos tiene una energía aproximadamente igual a 17 Kg. Suponiendo que la RFA es el 45% de la luz directa, la eficiencia global de la fotosíntesis es del 11%, que equivale a 456/(1.760/0’43). Esta eficiencia se reduce por lo menos en una décima parte más si tenemos en cuenta la reflexión de la luz en las hojas y la pérdida que supone atravesar la cubierta vegetal. Ninguna planta, sin embargo, se acerca siquiera a esta eficiencia teórica, porque parte de la luz absorbida por las clorofilas (generalmente, el 20 – 25 por ciento) vuelve a ser emitida en forma de calor, debido a que los pigmentos no pueden almacenar la luz y las reacciones enzimáticas no se producen con suficiente velocidad como para utilizar completamente el flujo de energía incidente. En la respiración se cede el carbono fijado en el metabolismo de la planta y en el mantenimiento de las estructuras que la soportan.

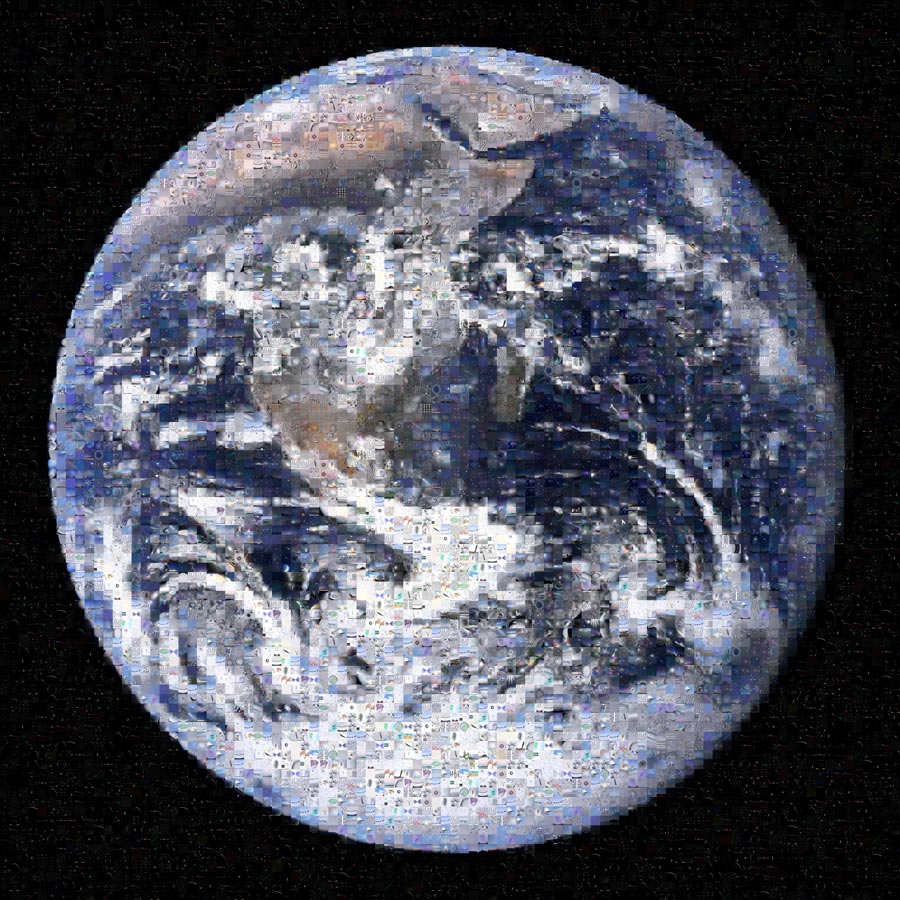

Mosaico de nuestro planeta Tierra que recibe una fracción de la energía solar

Para cada especie, la tasa con la que se pierde carbono está determinada principalmente por el tipo de fotosíntesis. Así, existen diferencias sustanciales entre las plantas C3 y C4. La respiración a escala de una comunidad o ecosistema depende del estado de crecimiento, y varía entre menos del 20 por ciento en plantas jóvenes en rápido crecimiento, hasta más del 90 por ciento en bosques maduros.

Con una pérdida del 25 por ciento para la reacción, y otro tanto para la respiración, la eficiencia fotosintética es ligeramente superior al 5 por ciento. En este punto, las estimaciones teóricas y los valores reales coinciden, ya que el valor medio de fotosíntesis neta en plantas muy productivas y en condiciones óptimas y durante cortos periodos de tiempo, oscila entre el 4 y el 5 por ciento. La mayoría de las plantas rinden en función de los nutrientes, especialmente nitrógeno y agua, o por las bajas temperaturas en las regiones de mayor altura y latitud. Los mejores rendimientos en sistemas naturales muy productivos, como los humedales y los cultivos, están entre el 2 y el 3 por ciento. En otros ecosistemas, como los pantanos tropicales templados y los bosques templados, el rendimiento de la transformación es del 1’5 por ciento, y en las praderas muy áridas sólo del 0’1 por ciento. Globalmente, la producción anual es, al menos, de 100.000 millones de toneladas de fitomasa, que se sintetizan con un rendimiento medio del 0’6 por ciento.

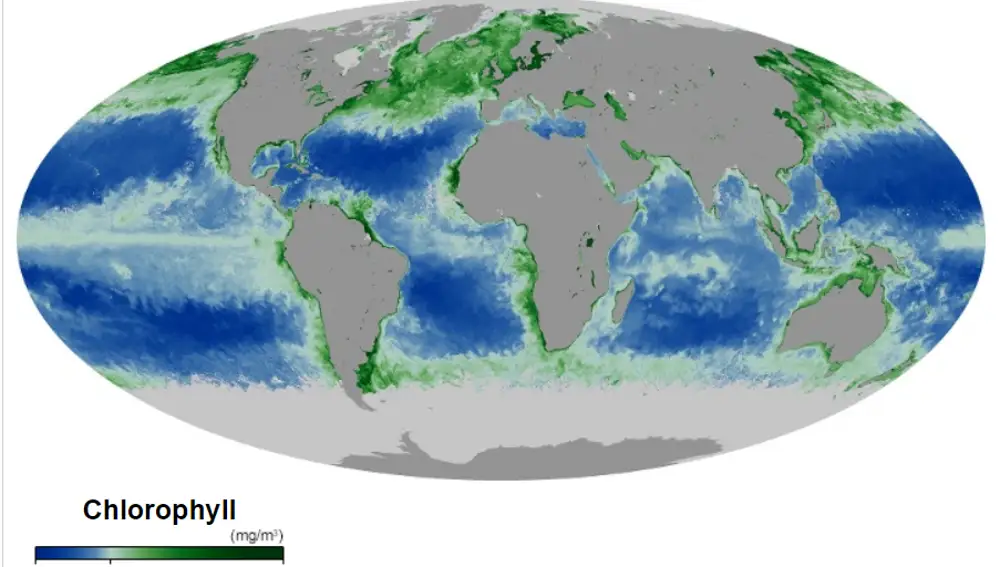

Mapa de clorofila en los océanos, gran presencia de algas

La fotosíntesis en los océanos, muy afectada por la escasez de nutrientes, es incluso menos eficiente. La productividad medie es de poco más de 3 MJ/m2 y se realiza con un rendimiento fotosintético del 0’06 por ciento. La media ponderada total es 0’2 por ciento, es decir, que sólo uno de cada 500 cuantos de energía solar que llega a la superficie de la Tierra se transforma en energía de biomasa en forma de tejido vegetal.

La mayor parte de esta energía se almacena en forma de azúcares simples, que contienen más energía, y que sólo se encuentran en las semillas.

La mayor parte de la fitomasa está en los bosques. En los océanos, los principales productores son los organismos que componen el fitoplancton, que son muy pequeños y flotan libres. Su tamaño varía entre algo menos de 2 y 200 μm de diámetro y están formados por cantidades variables de bacterias y protoctistas eucarióticos. Las cianobacterias cocoides son tan abundantes en algunas aguas oligo-trópicas que pueden ser las responsables de la mayor parte de la producción de fitoplancton.

Los protoctistas fotosintetizadores varían entre los más pequeños flagelados pigmentados (como las criptómonas y crisofitos), hasta las diatomeas y dinoflagelados, que son mayores (más de 10 mm) y generalmente dominantes. Las diatomeas están formadas por células sin flagelos, con paredes de silicio amorfo mezclados con otros compuestos orgánicos. Presentan una sorprendente y amplia variedad de diseño, desde las que tienen simetría central (las de forma radial son las dominantes en el océano), a las pennadas (simetría lateral), y otras forman largas cadenas.

La productividad de fitoplancton está controlada por la temperatura del agua y por la disponibilidad de radiación solar y nutrientes. La temperatura no es determinante, porque muchas especies son muy adaptables y consiguen una productividad similar en distintos ambientes. Aunque es frecuente la adaptación a diferentes condiciones lumínicas, tanto el volumen como en contenido en clorofila de las diatomeas aumenta con la intensidad de la luz. En el mar abierto, la mayor limitación es la cantidad de nutrientes disponibles.

Entre las carencias que más limitan la producción de fitoplancton está la de nitrógeno, el macro-nutriente más importante, la de fósforo, y la de algunos otros micronutrientes clave como el hierro y el silicio.

Los medios menos productivos de la Tierra están en la capa superficial y la capa inmediatamente inferior de los océanos. En el mar abierto, las concentraciones más altas de nutrientes se encuentran entre los 500 y los 1.000 metros, a bastante más profundidad que la zona eufórica, capa en la que penetra la luz solar y que se extiende a unos 100 metros en las aguas transparentes.

El pequeñísimo tamaño de los productores dominantes es una adaptación eficaz a la escasez de nutrientes, ya que cuanto mayor sea el cociente entre la superficie y el volumen, y más lento el hundimiento de las células de fitoplancton en la capa eufórica, mayor es la tasa de absorción de nutrientes.

Cuando las corrientes elevan a la superficie las aguas frías y cargadas de nutrientes, la producción de fitoplancton aumenta sustancialmente. Las aguas costeras de Perú, California, noroeste y sudoeste de África, y de la India occidental son ejemplos destacados de ascensión costera de aguas frías. También se dan casos de ascensión mar adentro en la mitad del Pacífico, cerca del ecuador y en las aguas que rodean la Antártida. Otras zonas altamente productivas se encuentran en las aguas poco profundas cercanas a la costa que están enriquecidas por el aporte continental de nutrientes. Este enriquecimiento, con una proporción N/P muy descompensada, es especialmente elevados en los estuarios adonde van a parar grandes cantidades de aguas residuales y fertilizantes.

Las diferentes medidas de la productividad en las aguas oligotróficas de los mares subtropicales y de las aguas eutróficas con corrientes ascensionales, varían entre menos de 50 gC/m2 y 1 gC/m2, más de un orden de magnitud. Las estimaciones de la producción global de fitoplancton están comprendidas entre 80.000 y 100.000 millones de toneladas, que representan entre dos tercios y cuatro quintos de la fitomasa total terrestre. Contrasta con el resultado anterior el hecho de que, dado el corto periodo de vida del fitoplancton (1 – 5 días), la fitomasa marina represente sólo una pequeña fracción de todo el almacenamiento terrestre.

La distribución espacial del fitoplancton muestra zonas delimitadas que se extienden a escala local y global. La exploración desde los satélites es, con gran diferencia, la que permite detectar con mayor precisión las concentraciones de clorofila y la que ha posibilitado obtener las pautas de la distribución de fitoplancton. En las aguas que rodean la Antártida se observa claramente una distribución asimétrica en dos bandas casi concéntricas. La mejor distribución se explica por el hecho de que se deba a corrientes circumpolares y a la abundancia de ácido silicílico. Pero las zonas de mayor riqueza de fitoplancton se encuentran cerca de los continentes donde los ríos arrastran abundantes nutrientes disueltos.

La vida necesita un aporte continuo de energía que llega a la Tierra desde el Sol y pasa de unos organismos a otros a través de la cadena trófica.

El plancton es el conjunto de organismos que flotan y derivan en suspensión en aguas dulces o saladas. El termino del “plancton” provienen del griego que significa “a la deriva” o “errante” el cual fue acuñado en 1887 por el alemán Victor Hensen para describir a los organismos que derivan con las corriente marinas y aguas frescas.

El plancton es el conjunto de organismos, la mayoría microscópicos, que flotan en el agua del mar o en los ríos y lagos. Existen más de 1.000.000 de especies, entre pequeños animales, microalgas y bacterias que crecen y se distribuyen alrededor del globo para llevar a cabo importantes funciones en los ecosistemas.

El fitoplancton es la base energética de las intrincadas pirámides tróficas. Las cadenas alimenticias en el océano, generalmente, son redes complicadas. Una gran parte de la fitomasa disponible no la consumen directamente los herbívoros, sino que primero se almacena en depósitos de materia muerta que, transformada por bacterias, se convertirá en alimento para otros seres heterótrofos.

La gran producción de fitoplancton puede alimentar grandes cantidades de zoo-masa. El kril, pequeños crustáceos parecidos a las quisquillas que se alimentan de diatomeas, son los organismos más abundantes en la superficie del mar; sus densas acumulaciones pueden contener hasta mil millones de individuos y su producción anual de zoo-masa quizá llegue hasta los 1.300 millones de toneladas. Esta prodigiosa cantidad de zoomasa sirve de alimento a focas, calamares y peces, así como a los mayores carnívoros de la biosfera, las especies de ballenas con barbas que se alimentan filtrando el agua.

Sí, es mucho lo que no sabemos ¡Nos queda ránto por descubrir!

Emilio Silvera Vázquez

May

30

Ese “mundo” cuántico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Se cuenta que una vez Albert Einstein alagó al actor Charles Chaplin diciéndole:

- “Lo que siempre he admirado de Usted es que su arte es universal, sin decir ni una palabra todo el mundo le comprende y admira”. A esto Chaplin respondió a Einstein: “

- Lo suyo es mucho más digno de respeto, todo el mundo le admira y prácticamente nadie le comprende”.

Es cierto lo que Chaplin decía, todos admiraban a Einstein y pocos comprendían sus postulados. De hecho, cuando estaba buscando la teoría de Todo, la gente se amontonaban, literalmente, ante los escaparates de la Quinta Avenida para ver las Ecuaciones que pocos entendían…¡Así somos los Humanos! Lo que no comprendemos nos produce temor o admiración, o, las dos cosas a la vez.

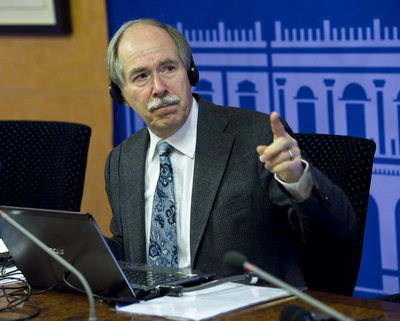

Gerad ´t Hooft

Hace ya algún tiempo que me desplace a Madrid, invitado para asistir a una Conferencia que sobre el LHC y el Bosón de Higgs, la impartía el físico y premio Nobel de Física Gerad ´t Hooft.

La charla de ‘t Hooft se inscribía en el ciclo La ciencia y el cosmos, y, entre otras cosas nos decía a los presentes que, la física, en concreto la física de partículas, ha sido siempre su gran pasión. “cuando era joven, la física estaba cambiando el mundo radicalmente: la energía nuclear, la televisión, los ordenadores, las primeras misiones espaciales….yo quería formar parte de todo eso”.

Y las partículas elementales “eran el mayor misterio de todos”, añade. “En cierto modo aún lo son, aunque ahora sabemos de ellas muchísimo más que entonces. Hoy los ordenadores siguen siendo emocionantes, la biología y el código del ADN, la astronomía y los vuelos espaciales… Sigue habiendo muchas cosas capaces de estimular la imaginación de jóvenes deseosos de aprender cosas nuevas impulsados por el deseo de estar ahí, en el momento en que se están haciendo los descubrimientos que cambian el mundo”.

Gerard ‘t Hooft explicó lo que significa, en los modelos teóricos, el famoso bosón: “El campo de la partícula de Higgs actúa como una especie de árbitro; proyectado contra otras partículas, este campo determina su comportamiento, si tienen carga o masa y hasta qué punto se diferencian de otras partículas. Si no encontramos el Higgs, si realmente no está, necesitaremos algo más que haga ese papel de árbitro”. Eso significaría, continuaba el Nobel, que “nuestras teorías ya no funcionan, y han funcionado tan bien hasta ahora que eso es difícil de imaginar”.

La espera fue enorme y todos esperaban las noticias sobre el dichoso Bosón

Cuando comenzó la búsqueda se decía:

Sí al LHC se le resiste el Bosón de Higgs…, bueno, si es que anda por ahí.

Fue en 1999 cuando ‘t Hooft recibió el premio Nobel de Física (junto con su colega y director de tesis Martinus Veltman), por “dilucidar la estructura cuántica de las interacciones electro-débiles” -según palabras de la Academia sueca- de la física de las partículas elementales.

Aquello fue un gran acontecimiento

Acerca del Gran Colisionador de Hadrones (el acelerador LHC situado en el Laboratorio Europeo de Física de partículas, CERN, junto a Ginebra), el científico holandés explica que se trata “de una máquina única en el mundo” y continúa: “Esperamos descubrir nuevas cosas con él y poner a prueba teorías que, hasta donde hemos podido comprobar hasta ahora, funcionan muy bien, pero necesitamos ir más allá”.

El descubrimiento de la partícula de Higgs, o bosón de Higgs, fue el objetivo número uno del LHC, y tras un largo período de funcionamiento del acelerador, los miles de físicos que trabajan en los detectores, han logrado acotar el terreno de búsqueda, aunque, insisten, seguramente necesitarán tomar muchos más datos para descubrirlo. O tal vez descubrir que no existe, lo que supondría una revolución en la física de partículas, al obligar a replantear el llamado Modelo Estándar, que describe todas las partículas elementales y sus interacciones, y que hasta ahora funciona con altísima precisión aunque, dicen los expertos, está incompleto.

Gerard ‘t Hooft, uno de los grandes físicos teóricos de partículas elementales, considera que será muy difícil desarrollar una teoría del todo, un cuerpo teórico capaz de explicar todas las fuerzas que actúan en la naturaleza aunando la Relatividad General de Einstein y la Mecánica Cuántica, tan eficaces por separado en la descripción del macrocosmos y el microcosmos, respectivamente. “Mi impresión es que esta teoría unificadora, una teoría del todo, aún requerirá el trabajo de muchas nuevas generaciones de investigadores jóvenes y listos”, afirma. “No llegaremos a ella de un momento a otro por la simple razón de que el universo es demasiado complejo para que una única teoría lo abarque todo. Vale, no digo que sea imposible, pero me parece muy improbable. Y mientras llega, queda mucho por descubrir, incluso hallazgos espectaculares”.

Muchas son las actividades desconocidas para el público que se desarrollan en el LHC.

Por ejemplo: Lo que se creó en el CERN fue la World Wide Web (WWW), la base de la tecnología de Internet, por Tim Berners-Lee en 1989.

Por otra parte, el científico holandés ha señalado que el LHC realiza más actividades que intentar encontrar el bosón de Higgs. En este sentido, ha destacado que se buscan también partículas que podrían construir la materia oscura, un tipo de materia de la que los físicos tienen la certeza de que es cinco veces más abundante que el universo que la materia ‘normal’, pero que no absorbe, refleja ni emite luz, lo que hace muy difícil su detección y, por tanto, estudiar su naturaleza. Del mismo modo, también se está desarrollando una teoría capaz de unificar la teoría de la relatividad general de Einstein y la mecánica cuántica que, según ha explicado Hooft, “permitiría descubrir lo que ocurre dentro de los átomos”.

De vez en cuando lo consulto

Recuerdo un pasaje escrito por él al principio de su interesante e instructivo libro “Partículas Elementales“, que decía:

“Mi intención es narrar los últimos 25 años de investigación sobre las partículas más pequeñas que constituyen la materia. Durante esos 25 años, yo empecé a ver la Naturaleza como un test de inteligencia para toda la Humanidad en su conjunto, como un gigantesco puzle con el que podemos jugar. Una y otra vez, nos tropezamos con nuevas piezas, grandes y pequeñas, que encajan maravillosamente con las que ya tenemos. Yo quiero compartir con ustedes la sensación de triunfo que sentimos en esos momentos.”

Tenía la intención (si se presentaba la oportunidad), de preguntarle sobre “su Principio Holográfico” pero, no pudo ser. Sólo pude saludarlo e intercambiar unas breves palabras junto con Ignacio Cirac presente también en el evento.

“En la década de los 90, los físicos Gerard ‘t Hooft, y Leonard Susskind postularon una hipótesis que sacudió por igual a la ciencia y a la opinión pública. Se la conoce como Principio Holográfico, y defiende la idea de que el universo puede ser interpretado como un holograma.”

El Principio Holográfico de Gerard ´t Hooft

Publicó el principio holográfico, el cual explica que la información de una dimensión extra es visible como una curvatura del espacio tiempo con una menos dimensiones. Por ejemplo, los hologramas son imágenes de 3 dimensiones colocadas en una superficie de 2 dimensiones, el cual da a la imagen una curvatura cuando el observador se mueve. Similarmente, en relatividad general, la cuarta dimensión esta manifestada en 3 dimensiones observables como la curvatura de un sendero de un movimiento de partícula (criterio) infinitesimal. Hooft ha especulado que la quinta dimensión es realmente la fábrica del espacio-tiempo.

Acordaos de que, a mediados del año 2,003 apareció la noticia de que la “información sería el componente fundamental de la naturaleza” postulada por un grupo de físicos entre los que se incluyen el Premio Nóbel danés Gerard t´Hooft y el físico de la Universidad de California Raphael Bousso, basadas en el “Principio Holográfico”. Esta teoría, por singular y chocante que pareciese en su momento ha tenido a lo largo de estos siete años una influencia notable tanto en la sociedad científica como en los círculos alternativos.

Personajes tan influyentes como Deepak Chopra sin ir más lejos habla del ámbito cuántico como el campo de información de donde parte todo lo conocido, materia, emociones, pensamientos. El controvertido joven físico Nassam Haramein defiende un universo basado en el holograma. Científicos japoneses -al igual que del resto del mundo- investigan con hologramas creando imágenes 3D o explican el funcionamiento del mundo físico basado en los campos de energía e información. Hay hasta “farmacología holográfica” a cargo de empresas farmacéuticas. El año pasado el físico Craig Hogan tras la detección de un extraño ruido en el detector de ondas gravitacionales el GEO 600, afirma que podría probar que, efectivamente, vivimos en un holograma.

La información sería el componente fundamental de la naturaleza. Es la que especifica el cuándo, dónde, cómo y cuánto del espacio, del tiempo y de la materia. El Big Bang que dio lugar al nacimiento del Universo tendría más que ver con una gigantesca “bajada” de bytes de información por parte de un superordenador, que con una explosión masiva de materia, según una nueva teoría que establece que en su origen la naturaleza está formada únicamente por pequeños paquetes de información pura que son los que especifican el cuándo, dónde, cómo y cuánto del Espacio, del Tiempo y de la Materia.

Emilio Silvera Vázquez

Totales: 85.573.256

Totales: 85.573.256 Conectados: 109

Conectados: 109