Ago

5

Hoy un sueño ¿Realidad mañana?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Llegará un día en el que, podremos entrar en un inmenso espacio, una enorme habitación, en la que, previa elección de la programación adecuada, todo se transformará en un “mundo ficticio”, un holograma que lo mismo podrá ser una playa luminosa con arena dorada por el Sol que una Selva tropical o un desierto, dependiendo de los gustos del usuario.

Si repasamos la historia de la ciencia, seguramente encontraremos muchos motivos para el optimismo. Witten (el Físico de la Teoría M), está convencido de que la ciencia será algún día capaz de sondear hasta las energías de Planck. Como ya he referido en otras ocasiones, él dijo:

“No siempre es tan fácil decir cuáles son las preguntas fáciles y cuáles las difíciles. En el siglo XIX, la pregunta de por qué el agua hierve a 100 grados era desesperadamente inaccesible. Si usted hubiera dicho a un físico del siglo XIX que hacia el siglo XX sería capaz de calcularlo, le habría parecido un cuento de hadas… La teoría cuántica de campos es tan difícil que nadie la creyó completamente durante 25 años.”

En su opinión, las buenas ideas siempre se verifican. Los ejemplos son innumerables: la gravedad de Newton, el campo eléctrico de Faraday y el electromagnetismo de Maxwell, la teoría de la relatividad de Einstein en sus dos versiones y su demostración del efecto fotoeléctrico, la teoría del electrón de Paul Dirac, el principio de incertidumbre de Heisenberg, la función de ondas de Schrödinger, y tantos otros. Algunos de los físicos teóricos más famosos, sin embargo, protestaban de tanto empeño en la experimentación. El astrónomo arthur Eddington se cuestionaba incluso si los científicos no estaban forzando las cosas cuando insistían en que todo debería ser verificado. ¡Cómo cambia todo con el Tiempo! Hasta la manera de pensar.

Sin embargo, muchos son los ejemplos de un ingenio superior que nos llevaron a desvelar secretos de la Naturaleza que estaban profundamente escondidos, y, el trabajo de Dirac en relación al electrón, es una buena muestra de ese ingenio humano que, de vez en cuando vemos florecer.

“En la práctica, ’(∂ + m) ψ = 0’ define que “si dos sistemas interaccionan entre ellos durante cierto periodo de tiempo y luego se separan, podemos describirlos como dos sistemas distintos, pero de una forma sutil se vuelven un sistema único. Lo que le ocurre a uno sigue afectando al otro, incluso a millones de kilómetros o a años luz”

Ya que la ecuación de Dirac fue originalmente formulada para describir el electrón, las referencias se harán respecto a “electrones”, aunque actualmente la ecuación se aplica a otros tipos de partículas elementales de espín ½, como los quarks. Una ecuación modificada de Dirac puede emplearse para describir de forma aproximada los protones y los neutrones, formados ambos por partículas más pequeñas llamadas quarks (por este hecho, a protones y neutrones no se les da la consideración de partículas elementales).

La ecuación de Dirac presenta la siguiente forma:

Siendo m la masa en reposo del electrón, c la velocidad de la luz, p el operador de momento,

la constante reducida de Planck, x y t las coordenadas del espacio y el tiempo, respectivamente; y ψ (x, t) una función de onda de cuatro componentes. La función de onda ha de ser formulada como un espinor (objeto matemático similar a un vectorque cambia de signo con una rotación de 2π descubierto por Pauli y Dirac) de cuatro componentes, y no como un simple escalar, debido a los requerimientos de la relatividad especial. Los α son operadores lineales que gobiernan la función de onda, escritos como una matriz y son matrices de 4×4 conocidas como matrices de Dirac.

Paul Dirac

El premio Nobel Paul Dirac incluso llegó a decir de forma más categórica:

“Es más importante tener belleza en las ecuaciones que tener experimentos que se ajusten a ellas“, o en palabras del físico John Ellis del CERN, “Como decía en una envoltura de caramelos que abrí hace algunos años, «Es sólo el optimista el que consigue algo en este mundo».“

Yo, como todos ustedes, un hombre normal y corriente de la calle, escucho a unos y a otros, después pienso en lo que dicen y en los argumentos y motivaciones que les han llevado a sus respectivos convencimientos, y finalmente, también decido según mis propios criterios mi opinión, que no obligatoriamente coincidirá con alguna de esas opiniones, y que en algún caso, hasta me permito emitirla.

¿Será que en la Teoría de cuerdas subyace una teoría cuántica de la Gravedad?

¿No es curioso que, cuando se formula la moderna Teoría M, surjan, como por encanto, las ecuaciones de Einstein de la Relatividad General? Nadie las llama y, sin embargo, allí aparecen para decirnos que, la Teoría de cuerdas es un buen camino a seguir, ya que, si en ella subyacen las ecuaciones de Einstein de la relatividad General… ¡No debe ser por casualidad!

Suponiendo que algún físico brillante nos resuelva la teoría de campos de cuerdas y derive las propiedades conocidas de nuestro universo, con un poco de suerte, podría ocurrir en este mismo siglo, lo que no estaría nada mal considerando las dificultades de la empresa. El problema fundamental es que estamos obligando a la teoría de supercuerdas a responder preguntas sobre energías cotidianas, cuando “ámbito natural” está en la energía de Planck. Esta fabulosa energía fue liberada sólo en el propio instante de la creación, lo que quiere decir que la teoría de supercuerdas es naturalmente una teoría de la creación.

Las primeras observaciones realizadas por Planck | ESA

Fuimos capaces de predecir que el Big Bang produjo un “eco” cósmico reverberando en el universo y que podría ser mesurable por los instrumentos adecuados. De hecho, Arno Penzias y Robert Wilson de los Bell Telephone Laboratories ganaron el premio Nobel en 1.978 por detectar este eco del Big Bang, una radiación de microondas que impregna el universo conocido. El que el eco del Big Bang debería estar circulando por el universo miles de millones de años después del suceso fue predicho por primera vez por George Gamow y sus discípulos Ralpher y Robert Herman, pero nadie les tomó en serio. La propia idea de medir el eco de la creación parecía extravagante cuando la propusieron por primera vez poco después de la segunda guerra mundial. Su lógica, sin embargo, era aplastante.

La estufa básica es la resistencia por hilo enrollado de nicrom. Ésta se llega a poner al rojo vivo, por lo que emite también algo de calor por radiación.

Cualquier objeto, cuando se calienta, emite radiación de forma gradual. Ésta es la razón de que el hierro se ponga al rojo vivo cuando se calienta en un horno, y cuanto más se calienta, mayor es la frecuencia de radiación que emite. Una fórmula matemática exacta, la ley de Stefan-Boltzmann, relaciona la frecuencia de la luz (o el color en este caso) con la temperatura. De hecho, así es como los científicos determinan la temperatura de la superficie de una estrella lejana; examinando su color. Esta radiación se denomina radiación de cuerpo negro.

Esta radiación, cómo no, ha sido aprovechada por los ejércitos, que mediante visores nocturnos pueden operar en la oscuridad. De noche, los objetos relativamente calientes, tales como soldados enemigos o los carros de combate, pueden estar ocultos en la oscuridad, pero continúan emitiendo radiación de cuerpo negro invisible en forma de radiación infrarroja, que puede ser captada por gafas especiales de infrarrojo. Ésta es también la razón de que nuestros automóviles cerrados se calientes en verano, ya que la luz del Sol atraviesa los cristales del coche y calienta el interior. A medida que se calienta, empieza a emitir radiación de cuerpo negro en forma de radiación infrarroja. Sin embargo, esta clase de radiación no atraviesa muy bien el vidrio, y por lo tanto queda atrapada en el interior del automóvil, incrementando espectacularmente la temperatura.

Análogamente, la radiación de cuerpo negro produce el efecto invernadero. Al igual que el vidrio, los altos niveles de dióxido de carbono en la atmósfera, causados por la combustión sin control de combustibles fósiles, pueden atrapar la radiación de cuerpo negro infrarroja en la Tierra, y de este modo calentar gradualmente el planeta.

Gamow razonó que el Big Bang era inicialmente muy caliente, y que por lo tanto sería un cuerpo negro ideal emisor de radiación. Aunque la tecnología de los años cuarenta era demasiado primitiva para captar esta débil señal de la creación, Gamow pudo calcular la temperatura de dicha radiación y predecir con fiabilidad que un día nuestros instrumentos serían lo suficientemente sensibles como para detectar esta radiación “fósil”.

Ya la lista de ingenios robóticos es larga. Todos quieren medir la radiación del fondo de microondas generadas por el Big Bang. Incluso hemos preparado telescopios especiales para que nos puedan captar las ondas gravitatorias surgidas en aquellos primeros momento de la inflación.

La lógica que había detrás de su razonamiento era la siguiente: alrededor de 300.000 años después del Big Bang, el universo se enfrió hasta el punto en el que los átomos pudieron empezar a componerse; los electrones pudieron empezar a rodear a los protones y neutrones formando átomos estables, que ya no serían destruidos por la intensa radiación que estaba impregnando todo el universo. Antes de este momento, el universo estaba tan caliente que los átomos eran inmediatamente descompuestos por esa radiación tan potente en el mismo acto de su formación. Esto significa que el universo era opaco, como una niebla espesa absorbente e impenetrable.

Pasados 300.000 años, la radiación no era tan potente; se había enfriado y por lo tanto la luz podía atravesar grades distancias sin ser dispersada. En otras palabras, el universo se hizo repentinamente negro y transparente.

Terminaré esta parte comentando que un auténtico cuerpo negro es un concepto imaginario; un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica.

La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la disminución de energías sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumentar las temperaturas*.

Hablar, sin más especificaciones, de radiación, es estar refiriéndonos a una energía que viaja en forma de ondas electromagnéticas o fotones por el universo. También nos podríamos estar refiriendo a un chorro de partículas, especialmente partículas alfa o beta de una fuente radiactiva o neutrones de un reactor nuclear.

La radiación actínida es la electromagnética que es capaz de iniciar una reacción química. El término es usado especialmente para la radiación ultravioleta y también para denotar radiación que podría afectar a las emulsiones fotográficas.

La radiación gamma es un tipo de radiación electromagnética producida generalmente por elementos radioactivos o procesos subatómicos como la aniquilación de un par positrón-electrón. Este tipo de radiación de tal magnitud también es producida en fenómenos astrofísicos de gran violencia.

Debido a las altas energías que poseen, los rayos gamma constituyen un tipo de radiación ionizante capaz de penetrar en la materia más profundamente que la radiación alfa o beta. Dada su alta energía pueden causar grave daño al núcleo de las células, por lo que son usados para esterilizar equipos médicos y alimentos.

La Radiación expone un amplio abanico dependiendo de la fuente: blanda, radiación cósmica, radiación de calor, radiación de fondo, de fondo de microondas, radiación dura, electromagnética, radiación gamma, infrarroja, ionizante, monocromática, policromática, de sincrotón, ultravioleta, de la teoría cuántica, de radiactividad… y, como se puede ver, la radiación en sus diversas formas es un universo en sí misma.

Siempre me llamó la atención y se ganó mi admiración el físico alemán Max Planck (1.858 – 1.947), responsable entre otros muchos logros de la ley de radiación de Planck, que da la distribución de energía radiada por un cuerpo negro. Introdujo en física el concepto novedoso de que la energía es una cantidad que es radiada por un cuerpo en pequeños paquetes discretos, en vez de una emisión continua. Estos pequeños paquetes se conocieron como cuantos y la ley formulada es la base de la teoría cuántica.

Einstein se inspiró en este trabajo para a su vez presentar el suyo propio sobre el efecto fotoeléctrico, donde la energía máxima cinética del fotoelectrón, Em, está dada por la ecuación que lleva su nombre: Em = hf – Φ.

Cada metal requiere, para que se produzca la extracción, una radiación con una frecuencia mínima (no). Cualquier otra radiación de menor frecuencia, no será capaz de arrancar electrones. Por debajo de la frecuencia mínima la intensidad de corriente -”i” (amperios)- será cero. No hay efecto fotoeléctrico.

Planck publicó en 1.900 un artículo sobre la radiación de cuerpo negro que sentó las bases para la teoría de la mecánica cuántica que más tarde desarrollaron otros, como el mismo Einstein, Heisenberg, Schrödinger, Dirac, Feymann, etc. Todos los físicos son conocedores de la enorme contribución que Max Planck hizo en física: la constante de Planck, radiación de Planck, longitud de Planck, unidades de Planck, etc. Es posible que sea el físico de la historia que más veces ha dado su nombre a conceptos de física. Pongamos un par te ejemplos de su ingenio:

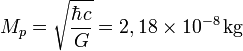

1. vale 10-35 metros. Esta escala de longitud (veinte órdenes de magnitud menor que el tamaño del protón, de 10-15 m) es a la que la descripción clásica de gravedad cesa de ser válida y debe ser tenida en cuenta la mecánica cuántica. En la fórmula que la describe, G es la constante gravitacional, ħ es la constante de Planck racionalizada y c en la velocidad de la luz.

2. . Es la masa de una partícula cuya longitud de onda Compton es igual a la longitud de Planck. En la ecuación, ħ es la constante de Planck racionalizada, c es la velocidad de la luz y G es la constante gravitacional. Así, Se denomina masa de Planck a la cantidad de masa (21,7644 microgramos) que, incluida en una esfera cuyo radio fuera igual a la longitud de Planck, generaría una densidad del orden de 1093 g/cm³. Según la física actual, esta habría sido la densidad del Universo cuando tenía unos 10-44 metros segundos, el llamado Tiempo de Planck. Su ecuación, es decir la masa de Planck se denota:

El valor de la masa de Planck  se expresa por una fórmula que combina tres constantes fundamentales, la constante de Planck, (h), la velocidad de la luz (c), y la constante de gravitación universal (G). La masa de Planck es una estimación de la masa del agujero negro primordial menos masivo, y resulta de calcular el límite donde entran en conflicto la descripción clásica y la descripción cuántica de la gravedad.

se expresa por una fórmula que combina tres constantes fundamentales, la constante de Planck, (h), la velocidad de la luz (c), y la constante de gravitación universal (G). La masa de Planck es una estimación de la masa del agujero negro primordial menos masivo, y resulta de calcular el límite donde entran en conflicto la descripción clásica y la descripción cuántica de la gravedad.

“Aunque todas estas descripciones reflejan más una abundante imaginación que un hecho existencial apoyado teóricamente con alguna hipótesis que pueda ser comprobada en el laboratorio sobre hechos que están más allá de poder ser medidos jamás en algún laboratorio construido por humanos. La única forma de confrontar la factibilidad o la posibilidad del modelo de la espuma cuántica nos lleva necesariamente a confrontar la carencia de un modelo que logre unificar exitosamente al macrocosmos con el microcosmos, a la Relatividad General con la Mecánica Cuántica, la Gravedad Cuántica. Si la energía y la materia (o mejor dicho la masa-energía) están discretizadas, se supone que también deben de estarlo el espacio y el tiempo (o mejor dicho, el espacio-tiempo), y la “partícula fundamental” del espacio-tiempo debe de serlo el gravitón, aunque de momento todo esto son especulaciones que seguirán siéndolo mientras no tengamos a la mano algo que pueda confirmar la existencia de tan exótica partícula, quizá la más exótica de cuantas hayan sido concebidas por la imaginación del hombre.”

La descripción de una partícula elemental de esta masa, o partículas que interaccionan con energías por partículas equivalentes a ellas (a través de E = mc2), requiere de una teoría cuántica de la gravedad. Como la masa de Planck es del orden de 10-8 Kg (equivalente a una energía de 1019 GeV) y, por ejemplo, la masa del protón es del orden de 10-27 Kg y las mayores energías alcanzables en los aceleradores de partículas actuales son del orden de 103 GeV, los efectos de gravitación cuántica no aparecen en los laboratorios de física de partículas. Únicamente en un laboratorio aparecieron partículas que tenían energías del orden de la masa de Planck: en el universo primitivo, de acuerdo con la teoría del Big Bang, motivo éste por el que es necesaria una teoría cuántica de la gravedad para estudiar aquellas condiciones. Esta energía de la que estamos hablando, del orden de 1019 GeV (inalcanzable para nosotros), es la que necesitamos para verificar la teoría de supercuerdas.

¿Por qué el número 137 es adimensional y esconde los secretos del electromagnetismo (e), de la constante de Planck (h), y de la velocidad de la luz (c). Es el resultado de Alfa (α), la Constante de Estructura Fina.

Siempre, desde que puedo recordar, me llamó la atención los misterios y secretos encerrados en la Naturaleza, y la innegable batalla mantenida a lo largo de la historia por los científicos para descubrirlos. Muchos han sido los velos que hemos podido descorrer para que, la luz cegadora del saber pudiera entrar en nuestras mentes para hacerlas comprender cómo actuaba la Naturaleza en ciertas ocasiones y el por qué de tales comportamientos, y, sin embargo, a pesar del largo camino recorrido, es mucho más el que nos queda por andar.

emilio silvera

Ago

4

Los Misterios de la Tierra

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ciencias de la Tierra ~

Clasificado en Ciencias de la Tierra ~

Comments (1)

Comments (1)

Encuentros espaciales

La más destructiva intensificación temporal de los normalmente suaves flujos de energía geotectónica – erupciones volcánicas o terremotos extraordinariamente potentes – o de energía atmosférica – vientos o lluvias anormalmente intensas –, parecen irrelevantes cuando se comparan con las repetidas colisiones del planeta con cuerpos extraterrestres relativamente grandes.

Existen simulaciones de lo que puede ser el choque del meteorito en la Tierra y, desde luego, no quisiera estar aquí cuando suceda. La Tierra está siendo bombardeada continuamente por invisibles partículas microscópicas de polvo muy abundantes en todo el Sistema Solar, y cada treinta segundos se produce un choque con partículas de 1 mm de diámetro, que dejan un rastro luminoso al autodestruirse en la atmósfera. También son relativamente frecuentes los choques con meteoritos de 1 metro de diámetro, que se producen con una frecuencia de, al menos, uno al año.

Pero los impactos, incluso con meteoritos mayores, producen solamente efectos locales. Esto es debido a que los meteoritos que deambulan por la región de asteroides localizada entre Marte y Júpiter están girando alrededor del Sol en el mismo sentido que la Tierra, de manera que la velocidad de impacto es inferior a 15 Km/s.

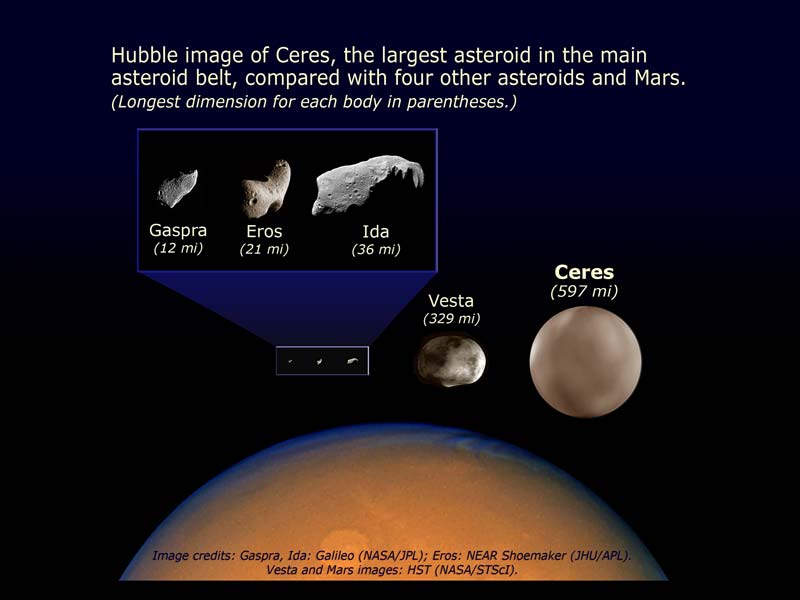

Entre Marte y Júpiter hay cientos de miles de cuerpos pequeños que orbitan alrededor del Sol llamados asteroides. También podemoas encontrarlos más allá de Plutón, llamado cinturón de Kuiper, y que en este caso reciben el nombre de objetos transneptunianos y que están hecho de hielo. Ceres es el asteroide más grande y tiene 913 km de diámetro.

El cráter de Arizona, casi perfectamente simétrico, se formó hace 25.000 años por el impacto de un meteorito que iba a una velocidad de 11 Km/s, lo que representa una potencia cercana a 700 PW. Estas gigantescas liberaciones de energías palidecen cuando se comparan con un choque frontal con un cometa típico. Su masa (al menos de 500 millones de toneladas) y su velocidad relativa (hasta 70 Km/s) elevan su energía cinética hasta 1022 J. Aunque se perdiera un diez por ciento de esta energía en la atmósfera, el impacto sería equivalente a una explosión de unas 2.500 bombas de hidrógeno de 100 megatones. Está claro que un fenómeno de estas características produciría impresionantes alteraciones climatológicas. Sin embargo, no es seguro y sí discutible que un impacto parecido fuese la causa de la extinción masiva del cretácico, siendo lo más probable, si tenemos en cuenta el periodo relativamente largo en que se produjo, que se podría explicar por la intensa actividad volcánica de aquel tiempo.

La frecuencia de impactos sobre la Tierra disminuye exponencialmente con el tamaño del objeto. Muchas toneladas son las que recibimos cada año de pequeños fragmentos de todo tipo pero, cuando estos van aumentando de tamaño, los sucesos de espacian de manera sustancial

Aproximadamente, cada cincuenta o sesenta millones de años se produce una colisión con un cometa, lo que significaría que la biosfera, que ha evolucionado durante cuatro mil millones de años, ha debido superar unos cuarenta impactos de este tipo. Está claro que ha salido airosa de estas colisiones, ya que aunque haya sido modificada, no ha sido aniquilada.

Igualmente, la evolución de la biosfera ha sobrevivido a las explosiones altamente energéticas de las supernovas más “cercanas”. Dado que en nuestra galaxia se produce por término medio la explosión de una supernova cada 50 años, el Sistema Solar se encuentra a una distancia de 100 parsecs de la explosión cada dos millones de años y a una distancia menor de 10 parsecs cada dos mil millones de años. En este último caso, la parte alta de la atmósfera se vería inundada por un flujo de rayos X y UV de muy corta longitud de onda, diez mil veces mayor que el flujo habitual de radiación solar, lo que implica que la Tierra recibiría, en unas pocas horas, una dosis de radiación ionizante igual a la que recibe anualmente. Exposiciones de 500 roentgens son setales para la mayoría de los vertebrados y, sin embargo, los diez episodios de esta magnitud que se han podido producir en los últimos 500 millones de años no han dejado ninguna consecuencia observable en la evolución de la biosfera.

Si suponemos que una civilización avanzada podría preparar refugios para la población durante el año que transcurre ente la llegada de la luz y la llegada de la radiación cósmica, se encontraría con la inevitable dosis de 500 roentgens cada mil millones de años, tiempo suficiente para permitir el desarrollo de una sociedad cuyo conocimiento le sirviera para defenderse de un flujo tan extraordinario y de consecuencias letales.

La fotosíntesis

Todo el Oxígeno de la Atmósfera terrestre procede del oxígeno que desprenden los organismos autótrofos durante la fotosíntesis.

La fotosíntesis es el principal proceso bioquímico que consigue pasar materiales desde el biotopo hasta la biocenosis de un ecosistema. Una vez incorporados como parte de los organismos autótrofos, los heterótrofos (por ejemplo, los animales) solo tienen que aprovecharse de aquellos; con la existencia de pequeñas cantidades de agua, todo está preparado para que el ecosistema entero comience a funcionar. Además, siempre habrá animales depredadores, carnívoros, que seguirán aprovechando los materiales de otros.

La conocida ecuación básica que describe la reacción endotérmica por la cual se sintetiza una molécula de glucosa a partir de sus seis moléculas de CO2 y H2O, y 2’8 MJ de radiación solar, es una simplificadisima caja negra. Una caja negra más realista sería la siguiente:

106 CO2 + 90 H2O + 16 NO3 + PO4 + nutrientes minerales + 5’4 MJ de radiación = 3’258 g de protoplasma (106 C, 180 H, 46 O, 16 N, 1 P y 815 g de cenizas minerales) + 154 O2 + 5’35 MJ de calor disipado.

Sin macronutrientes ni micronutrientes no se puede producir fito-masa, que está compuesta por los nutrientes básicos necesarios para todos los seres heterótrofos: azúcares complejos, ácidos grasos y proteínas.

Para entender esta caja negra hay que comenzar por destacar la acción de unos pigmentos sensibles a la luz entre los cuales destacan las clorofilas. Éstas absorben la luz en dos bandas estrechas, una entre 420 y 450 nm, y la otra entre 630 y 690 nm. Así, la energía necesaria para la fotosíntesis sólo procede de la radiación azul y roja a la que corresponde menos de la mitad de la energía total de la insolación. Esta parte de la radiación fotosintéticamente activa (RFA) no se utiliza en reducir CO2, sino en la regeneración de compuestos consumidos durante la fijación del gas.

La síntesis de fitomasa en el ciclo reductor del fosfato pentosa (RPP) – un proceso con varios pasos de carboxilación por catálisis enzimática, reducción y regeneración – tiene que empezar con la formación de trifosfato de adenosina (ATP) y nicotinamida adenina dinucleótido fosfato (NADP), que son los dos compuestos que suministran energía a todas las reacciones biosintéticas. La síntesis de las tres moléculas de ATP y las dos de NADP que se necesitan para reducir cada molécula de CO2 requiere de diez cuantos de radiación solar con longitud de onda próxima al pico rojo de absorción de la clorofila (680 nm). El carbono procedente del CO2, combinado con el hidrógeno del agua y con los micronutrientes, dará lugar a nueva fitomasa que contiene 465 KJ/mol.

La cantidad de energía de un cuanto de luz roja es de 2’92×10-19 J (el producto de la constante de Planck, 6’62×10-34 por la frecuencia de la luz, que a su vez es el cociente entre la velocidad de la luz y la longitud de onda).

Un einstein (definido como un mol o número de Avogadro, 6’02×1023) de fotones rojos tiene una energía aproximadamente igual a 17 Kg. Suponiendo que la RFA es el 45% de la luz directa, la eficiencia global de la fotosíntesis es del 11%, que equivale a 456/(1.760/0’43). Esta eficiencia se reduce por lo menos en una décima parte más si tenemos en cuenta la reflexión de la luz en las hojas y la pérdida que supone atravesar la cubierta vegetal. Ninguna planta, sin embargo, se acerca siquiera a esta eficiencia teórica, porque parte de la luz absorbida por las clorofilas (generalmente, el 20 – 25 por ciento) vuelve a ser emitida en forma de calor, debido a que los pigmentos no pueden almacenar la luz y las reacciones enzimáticas no se producen con suficiente velocidad como para utilizar completamente el flujo de energía incidente. En la respiración se cede el carbono fijado en el metabolismo de la planta y en el mantenimiento de las estructuras que la soportan.

Mosaico de nuestro planeta Tierra que recibe una fracción de la energía solar

Para cada especie, la tasa con la que se pierde carbono está determinada principalmente por el tipo de fotosíntesis. Así, existen diferencias sustanciales entre las plantas C3 y C4. La respiración a escala de una comunidad o ecosistema depende del estado de crecimiento, y varía entre menos del 20 por ciento en plantas jóvenes en rápido crecimiento, hasta más del 90 por ciento en bosques maduros.

Con una pérdida del 25 por ciento para la reacción, y otro tanto para la respiración, la eficiencia fotosintética es ligeramente superior al 5 por ciento. En este punto, las estimaciones teóricas y los valores reales coinciden, ya que el valor medio de fotosíntesis neta en plantas muy productivas y en condiciones óptimas y durante cortos periodos de tiempo, oscila entre el 4 y el 5 por ciento. La mayoría de las plantas rinden en función de los nutrientes, especialmente nitrógeno y agua, o por las bajas temperaturas en las regiones de mayor altura y latitud. Los mejores rendimientos en sistemas naturales muy productivos, como los humedales y los cultivos, están entre el 2 y el 3 por ciento. En otros ecosistemas, como los pantanos tropicales templados y los bosques templados, el rendimiento de la transformación es del 1’5 por ciento, y en las praderas muy áridas sólo del 0’1 por ciento. Globalmente, la producción anual es, al menos, de 100.000 millones de toneladas de fitomasa, que se sintetizan con un rendimiento medio del 0’6 por ciento.

Mapa de clorofila en los océanos

La fotosíntesis en los océanos, muy afectada por la escasez de nutrientes, es incluso menos eficiente. La productividad medie es de poco más de 3 MJ/m2 y se realiza con un rendimiento fotosintético del 0’06 por ciento. La media ponderada total es 0’2 por ciento, es decir, que sólo uno de cada 500 cuantos de energía solar que llega a la superficie de la Tierra se transforma en energía de biomasa en forma de tejido vegetal.

La mayor parte de esta energía se almacena en forma de azúcares simples, que contienen más energía, y que sólo se encuentran en las semillas.

La mayor parte de la fitomasa está en los bosques. En los océanos, los principales productores son los organismos que componen el fitoplancton, que son muy pequeños y flotan libres. Su tamaño varía entre algo menos de 2 y 200 μm de diámetro y están formados por cantidades variables de bacterias y protoctistas eucarióticos. Las cianobacterias cocoides son tan abundantes en algunas aguas oligotrópicas que pueden ser las responsables de la mayor parte de la producción de fitoplancton.

Los protoctistas fotosintetizadores varían entre los más pequeños flagelados pigmentados (como las criptomonas y crisofitos), hasta las diatomeas y dinoflagelados, que son mayores (más de 10 mm) y generalmente dominantes. Las diatomeas están formadas por células sin flagelos, con paredes de silicio amorfo mezclados con otros compuestos orgánicos. Presentan una sorprendente y amplia variedad de diseño, desde las que tienen simetría central (las de forma radial son las dominantes en el océano), a las pennadas (simetría lateral), y otras forman largas cadenas.

La productividad de fitoplancton está controlada por la temperatura del agua y por la disponibilidad de radiación solar y nutrientes. La temperatura no es determinante, porque muchas especies son muy adaptables y consiguen una productividad similar en distintos ambientes. Aunque es frecuente la adaptación a diferentes condiciones lumínicas, tanto el volumen como en contenido en clorofila de las diatomeas aumenta con la intensidad de la luz. En el mar abierto, la mayor limitación es la cantidad de nutrientes disponibles.

Entre las carencias que más limitan la producción de fitoplancton está la de nitrógeno, el macro-nutriente más importante, la de fósforo, y la de algunos otros micronutrientes clave como el hierro y el silicio.

Los medios menos productivos de la Tierra están en la capa superficial y la capa inmediatamente inferior de los océanos. En el mar abierto, las concentraciones más altas de nutrientes se encuentran entre los 500 y los 1.000 metros, a bastante más profundidad que la zona eufórica, capa en la que penetra la luz solar y que se extiende a unos 100 metros en las aguas transparentes.

El pequeñísimo tamaño de los productores dominantes es una adaptación eficaz a la escasez de nutrientes, ya que cuanto mayor sea el cociente entre la superficie y el volumen, y más lento el hundimiento de las células de fitoplancton en la capa eufórica, mayor es la tasa de absorción de nutrientes.

Cuando las corrientes elevan a la superficie las aguas frías y cargadas de nutrientes, la producción de fitoplancton aumenta sustancialmente. Las aguas costeras de Perú, California, noroeste y sudoeste de África, y de la India occidental son ejemplos destacados de ascensión costera de aguas frías. También se dan casos de ascensión mar adentro en la mitad del Pacífico, cerca del ecuador y en las aguas que rodean la Antártida. Otras zonas altamente productivas se encuentran en las aguas poco profundas cercanas a la costa que están enriquecidas por el aporte continental de nutrientes. Este enriquecimiento, con una proporción N/P muy descompensada, es especialmente elevados en los estuarios adonde van a parar grandes cantidades de aguas residuales y fertilizantes.

Las diferentes medidas de la productividad en las aguas oligotróficas de los mares subtropicales y de las aguas eutróficas con corrientes ascensionales, varían entre menos de 50 gC/m2 y 1 gC/m2, más de un orden de magnitud. Las estimaciones de la producción global de fitoplancton están comprendidas entre 80.000 y 100.000 millones de toneladas, que representan entre dos tercios y cuatro quintos de la fitomasa total terrestre. Contrasta con el resultado anterior el hecho de que, dado el corto periodo de vida del fitoplancton (1 – 5 días), la fitomasa marina represente sólo una pequeña fracción de todo el almacenamiento terrestre.

La distribución espacial del fitoplancton muestra zonas delimitadas que se extienden a escala local y global. La exploración desde los satélites es, con gran diferencia, la que permite detectar con mayor precisión las concentraciones de clorofila y la que ha posibilitado obtener las pautas de la distribución de fitoplancton. En las aguas que rodean la Antártida se observa claramente una distribución asimétrica en dos bandas casi concéntricas. La mejor distribución se explica por el hecho de que se deba a corrientes circumpolares y a la abundancia de ácido silicílico. Pero las zonas de mayor riqueza de fitoplancton se encuentran cerca de los continentes donde los ríos arrastran abundantes nutrientes disueltos.

La vida necesita un aporte continuo de energía que llega a la Tierra desde el Sol y pasa de unos organismos a otros a través de la cadena trófica.

El fitoplancton es la base energética de las intrincadas pirámides tróficas. Las cadenas alimenticias en el océano, generalmente, son redes complicadas. Una gran parte de la fito-masa disponible no la consumen directamente los herbívoros, sino que primero se almacena en depósitos de materia muerta que, transformada por bacterias, se convertirá en alimento para otros seres heterótrofos.

La gran producción de fitoplancton puede alimentar grandes cantidades de zoo-masa. El kril, pequeños crustáceos parecidos a las quisquillas que se alimentan de diatomeas, son los organismos más abundantes en la superficie del mar; sus densas acumulaciones pueden contener hasta mil millones de individuos y su producción anual de zoo-masa quizá llegue hasta los 1.300 millones de toneladas. Esta prodigiosa cantidad de zoo-masa sirve de alimento a focas, calamares y peces, así como a los mayores carnívoros de la biosfera, las especies de ballenas con barbas que se alimentan filtrando el agua.

emilio silvera

Ago

4

¡La Vida se abre paso!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Vida ~

Clasificado en El Universo y la Vida ~

Comments (0)

Comments (0)

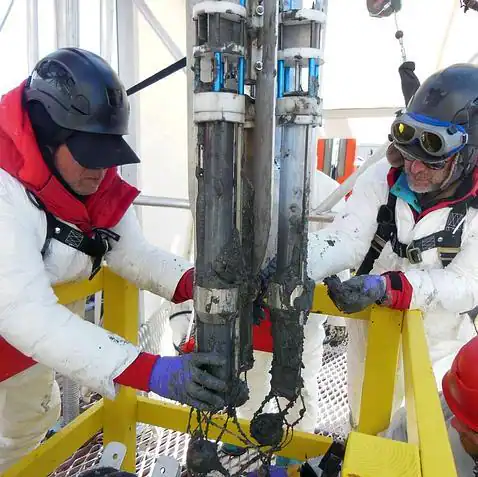

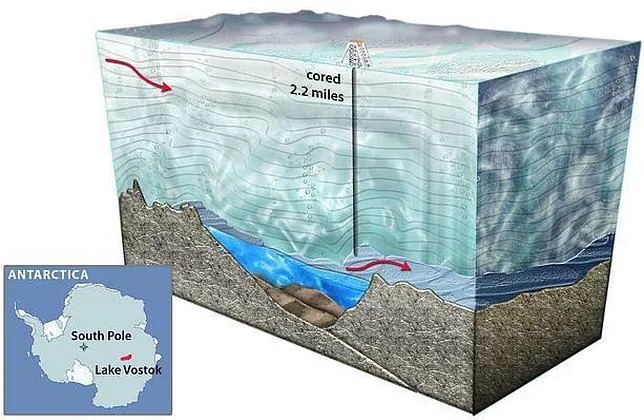

“Miles de especies viven en un lago subterráneo al que la luz y el aire no han llegado en millones de años.”

Bajo los hielos de la Antártida hay vida en abundancia. Lo acaba de demostrar una expedición norteamericana, llamada Wissard (Whillans Ice Stream Subglacial Access Research Drilling), formada por investigadores de varias universidades y que esta semana ha publicado en Nature sus primeras conclusiones. Bajo una capa de hielo de más de 800 metros de grosor, los científicos han encontrado todo un ecosistema viviendo en un lago subterráneo al que la luz y el aire no han llegado en millones de años.

Las formas de vida descubiertas son microorganismos unicelulares que para subsistir convierten amoniaco y metano en energía. La mayor parte de estos organismos pertenecen al dominio de las Arqueas, en el que se encuentran los seres vivos más antiguos del planeta. La investigación tiene implicaciones para la búsqueda de vida en otros ambientes extremos, tanto en la Tierra como en otros mundos del Sistema Solar.

Para John Priscu, profesor de la Universidad de Montana y jefe científico de la expedición Wissard, “ahora podemos probar al mundo de forma inequívoca que la Antártida no es un continente muerto”. El estudio, en efecto, aporta las primeras pruebas directas de que la vida es capaz de resistir en las más duras condiciones del ambiente subglacial.

Brent Christner, otro de los autores del estudio, afirma que se trata de la primera prueba definitiva de que bajo la capa de hielo antártico “no solo hay vida, sino ecosistemas activos que hemos estado buscando durante décadas. Con este trabajo damos un golpe sobre la mesa y afirmamos: šSí, teníamos razón”.

Priscu, por su parte, asegura no estar del todo sorprendido de que el equipo haya logrado encontrar por fin vida tras perforar más de 800 metros de hielo hasta llegar al lago subglacial Whillans. No en vano, se trata de un investigador experimentado y que ha trabajado tanto en el Polo Norte como en el Polo Sur. Este otoño, en efecto, cumplirá su campaña número 30 en la Antártida, y hace mucho que predijo este descubrimiento.

Aunque nos parezca imposible, bajo los hielos Antárticos, la vida está presente

Hace ya más de una década, Priscu publicó dos artículos en Science describiendo por primera vez cómo la vida microbiana podría vivir y multiplicarse bajo los hielos de la Antártida. Y hace cinco años, publicó otro artículo en el que predijo que el ambiente subglacial antártico podría albergar el humedal más extenso de toda la Tierra, uno que no estaría dominado por aves y otros animales, sino por microorganismos que utilizan los minerales de las rocas heladas para obtener la energía que necesitan para vivir.

Durante la última década, Priscu se ha dedicado a recorrer el mundo dando conferencias sobre lo que podríamos encontrar bajo la Antártida, y recaudando fondos para una expedición que podría cambiar para siempre nuestra visión sobre el mayor continente del planeta.

Microbios que viven a 800 metros bajo el Hielo

Sin embargo, Priscu sí que se muestra muy excitado con respecto a varios detalles del hallazgo, especialmente en la forma de funcionar de estos organismos, sin luz solar y a temperaturas muchos grados bajo cero, y al hecho de que la mayoría de ellos, tal y como revelan los análisis de ADN, sean Arqueas. Arquea es uno de los tres dominios principales de la vida. Los otros dos son Bacteria y Eukariota.

La mayoría de las arqueas subgaciales encontradas utilizan la energía de los enlaces químicos del amoniaco para fijar el dióxido de carbono y llevar a cabo otras funciones metabólicas. Otro grupo de organismos utilizan la energía y el carbono presente en el gas metano para sobrevivir. Para Priscu, probablemente todo este amoniaco y metano procedan de la descomposición de materia orgánica que se depositó en la zona hace cientos de miles de años, cuando la Antártida era aún templada y el mar inundó la parte occidental del continente.

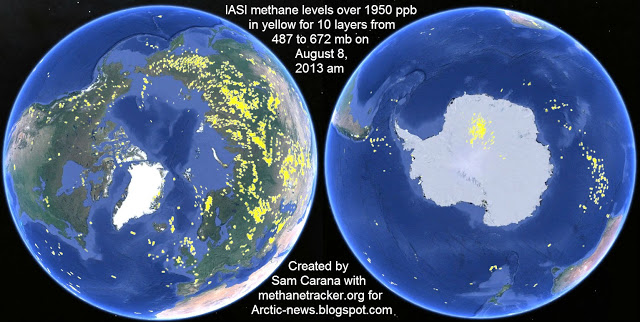

Las emisiones de metano del Ártico este mes se registraron en niveles históricos-altos, causando gran preocupación entre los climatólogos, que citan fusión rápida del hielo marino y el calentamiento del océano Ártico como las principales causas.

También advierte el investigador de que si la Antártida continúa calentándose, se liberarán a la atmósfera enormes cantidades de metano acumulado en el hielo, un poderoso gas de efecto invernadero capaz de acelerar dramáticamente el cambio climático.

El equipo de científicos también demostró que los microorganismos que viven en el lago Whillans no pueden ser fruto de la contaminación de los materiales de los propios científicos, tal y como se sospecha que ocurrió con los hallados en el lago subglacial de Vostok. Los escépticos, por su parte, apoyan esta posibilidad y sugieren que los microorganismos encontrados son los que llevaban consigo los propios investigadores.

“Hemos llegado hasta el extremo -asegura Priscu- para garantizar que no hemos contaminado en absoluto uno de los ambientes más puros y prístinos del planeta y que nuestras muestras tienen la máxima integridad”.

4.000 especies

“La expedición norteamericana bajo el nombre de “Wissard” (Whillans Ice Stream Subglacial Access Research Drilling) ha descubierto que bajo los fríos hielos de la Antártida reside vida y, además, en abundancia: debajo de una capa de 800 metros de grosor donde no pasa ni la luz ni el aire desde hace millones de años, existe un ecosistema completo.”

En cuanto a las especies encontradas, resulta muy difícil su identificación, pero, afirma Christner por su parte, “hemos visto una columna de agua que probablemente tiene unas 4.000 cosas que podríamos llamar especies. Existe una increíble diversidad”.

El equipo de Wissard volverá a perforar durante el próximo verano austral. Wissard es el primer esfuerzo multidisciplinar a gran escala para examinar directamente la biología del ambiente subglacial antártico. La masa de hielo de la Antártida cubre una superficie equivalente a una vez y media la de los Estados Unidos y contiene el 70% del agua dulce de la Tierra.

Muy por debajo de la gruesa capa de hielo que cubre la Antártida, hay lagos de agua dulce sin una conexión directa con el océano. Estos lagos son de gran interés para los científicos, que tratan de entender el transporte de agua y la dinámica del hielo bajo la superficie congelada del continente.

El lago Whillans es uno de los más de 200 lagos que se conocen bajo la superficie del continente helado y el río subterráneo que lo alimenta fluye bajo la plataforma de Ross, una masa de hielo del tamaño de Francia, y desemboca en el océano, a gran profundidad, al que proporciona grandes cantidades de nutrientes y contribuye a la circulación de las corrientes marinas.

¡No conocemos ni nuestra propia casa… ¡Y queremos viajar hacia las lejanas estrellas! ¡Ilusos!

¡Cómo somos los Humanos!

Publica: emilio silvera

Ago

4

Final de “Los Misterios de la Tierra”

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

El metabolismo heterótrofo

Son esenciales para toda la vida porque son los productores primarios en la base de todas las cadenas alimentarias.

Los seres autótrofos siguen dos vías diferentes para transformar la biomasa que ingieren en los compuestos complejos de los que se componen sus tejidos. Esta transformación puede ser mediante fermentación anaeróbica o a través de respiración aeróbica. La primera vía se restringe a las células procariotas simples, como las fermentadoras, las bacterias metano-génicas y los hongos Ascomycota responsables de la fermentación del etanol (alcohol etílico).

Hongos ascomycota

La segunda vía se hizo posible a partir del momento en que la cantidad de oxígeno atmosférico, generado por los vegetales, alcanzó un nivel suficientemente alto como para que algunos seres procariotas pudieran utilizar la respiración aeróbica para generar trifosfato de adenosina más eficientemente que por fermentación. Desde un punto de vista energético, la oxidación es claramente ventajosa. Así, por cada mol de glucosa se liberan 197 KJ por fermentación en ácido láctico, 232 KJ por fermentación alcohólica y 2’87 MJ por la oxidación completa, lo que representa para esta última una ganancia que está comprendida entre 12 y 14 veces.

Seres vivos procariotas

Los nutrientes necesarios para el metabolismo de tipo heterótrofo proceden de la digestión de los tejidos vegetales o de otros heterótrofos. En el metabolismo heterótrofo hay notables regularidades orgánicas. Entre ellas destaca claramente el hecho de que al representar en un gráfico logarítmico la tasa metabólica basal (TMB), – metabolismo mínimo cuando el animal se encuentra en reposo absoluto – frente al peso, los resultados relativos a los animales comprendidos entre el ratón y el elefante se dispongan a lo largo de una línea recta.

Representación de Kleiber del metabolismo basal de los mamíferos desde el ratón al elefante.

Esta dependencia lineal en un gráfico logarítmico fue descubierta por Kleiber en 1.932, y muestra que, si representamos las TMB en vatios y el peso, p, en kilogramos, la dependencia funcional entre ambas magnitudes es 3’52 p0’74. Si en vez del peso, se representa la TMB frente a la superficie corporal de los animales, el exponente de Kleiber es 0’67, que es el valor que se había supuesto anteriormente. Las medidas posteriores de la TMB en cientos de especies han confirmado la primera dependencia funcional que ha sido redondeada en 1.961 por el propio Kleiber, en 3’4 p0’75 (en W).

Aunque aún no se ha encontrado una explicación definitiva de la razón de esta ley de potencia con exponente ¾, el análisis de los requerimientos mecánicos de los cuerpos animales dan una buena pista. Con criterios elásticos se deduce que el cubo de la longitud crítica de rotura de los huesos varía linealmente con el cuadrado del diámetro (d) de la sección de los mismos, que a su vez, es proporcional a p3/8. La potencia muscular es proporcional al área de su sección transversal (esto es, proporcional a d2), y por tanto, la forma funcional de la potencia máxima se expresa como (p3/8)2, o lo que es lo mismo, p0’75.

Una explicación aún más fundamental se basa en la geometría y en la física de la red vascular necesaria para distribuir los nutrientes y eliminar los materiales de desecho del cuerpo de los animales. Estas redes que llenan el espacio, son fractales que determinan las propiedades estructurales y funcionales de los sistemas cardiovasculares y respiratorios, y de sus propiedades se deduce que el metabolismo total de los organismos escala con su masa elevada a la potencia ¾.

El exponente de Kleiber tiene una consecuencia importante para los organismos con TMB específica (la TMB dividida por el peso corporal) decrecientes. Esta relación limita el tamaño mínimo de los animales homeotermos y facilita que las grandes criaturas puedan sobrevivir en condiciones ambientales adversas. La ingesta diaria de néctar de un pequeño colibrí es equivalente a la mitad del peso de su cuerpo (para los seres humanos, la comida diaria representa alrededor del 3% del peso corporal), y los animales de sangre caliente, de tamaño menor que un colibrí, tendrían que estar comiendo continuamente para poder compensar las rápidas pérdidas de calor.

En el otro extremo, los grandes mamíferos pueden pasar varios días sin alimentarse, recurriendo a las reservas de grasa acumuladas para mantener su bajo metabolismo durante periodos de hibernación relativamente largos.

Los casos de separación de la tendencia general ilustran varios modos de adaptación al medio. Para regular térmicamente su cuerpo en agua fría, la TMB de las focas y las ballenas es el doble de las de otros animales de su tamaño. Los mamíferos del desierto, con sus bajas TMB, se han adaptado a los periodos de carencia de alimentos y a la escasez recurrente o crónica de agua.

Naturalmente, la TMB representa sólo una parte de las necesidades energéticas. La digestión eleva las tasas metabólicas de todos los animales y la reproducción requiere aumentos periódicos de energía (como también ocurre con el cambio de plumaje o pelaje en los pájaros y mamíferos). La búsqueda de comida es una actividad ineludible para todos los animales que no estén hibernando. Simplemente por estar de pie, la tasa metabólica en los pájaros es un 15 por ciento superior a la tasa de reposo; y en los mamíferos, exceptuando al caballo, esta diferencia llega al 30 por ciento. El límite metabólico, múltiplo de la TMB durante el máximo esfuerzo, es mucho mayor durante la carrera, natación o el vuelo.

Tendría que mencionar ahora la reproducción y sus distintas formas, que varían de modo continuo entre los casos extremos de la cría generalizada generada de golpe y los nacimientos espaciados de un único neonato. El primer caso maximiza la producción de individuos que maduran con rapidez, y estas especies son más oportunistas. La mayoría de las bacterias, así como muchas especies de insectos, pertenecen a este grupo de seres que se reproducen de forma oportunista e intensa. En condiciones adecuadas llegan a invertir una parte tan importante de su metabolismo en la reproducción que acaban convirtiéndose en plagas indeseables. En unos pocos días de verano, pequeños insectos como los áfidos, dedican el 80% de su metabolismo a reproducirse, en una estrategia que reduce de forma importante la vida de los progenitores y también las posibilidades de reproducción repetida. Los endoparásitos, sin embargo, son una desafortunada excepción a esta restricción: la tenia, debido al fácil suministro de energía que recibe, se reproduce copiosamente y puede sobrevivir más de quince años.

En el otro extremo del rango reproductivo están las especies del tipo selección-k que se reproducen varias veces, espaciando los nacimientos y cada vez con crías poco numerosas, y que maduran lentamente. El resultado de esta forma de reproducción es una tasa baja de crecimiento y poca capacidad de colonización, que se compensa con la mayor longevidad, competitividad, adaptabilidad y frecuentemente por un comportamiento social altamente desarrollado.

Independientemente de su posición en el rango reproductivo, los rasgos comunes que presentan las transformaciones bioquímicas asociadas con la producción de los gametos y el crecimiento de los embriones permiten estimar la eficiencia de la reproducción heterótrofa. El máximo teórico de la eficiencia, para transformar los monómeros procedentes de la alimentación en los polímeros de la biomasa, está en torno a un impresionante 96%. Ineficiencias inevitables en la digestión de nutrientes y en la reproducción de recambio de tejidos reducen algo esta eficiencia, que siempre se mantiene por encima del 70%.

Los rendimientos se pueden medir fácilmente en los seres heterótrofos unicelulares que se reproducen rápidamente: los rendimientos más altos son los de las bacterias (50 – 65%) y se encuentra un valor medio en las levaduras y los protozoos. No es sorprendente que los poiquilotermos sedentarios sean, entre los heterótrofos superiores, los más eficientes en la transformación de nutrientes en zoo-masa: sus tasas se aproximan frecuentemente al 70 – 80%, que es la máxima eficiencia posible.

Entre los vertebrados, los homeotermos presentan tasas de crecimiento fetal mucho más altas que las especies poiquilotermas. Los ornitólogos han sido los primeros en estudiar la energética de la reproducción debido a la importancia del huevo en la vida de las aves. La energía necesaria para el crecimiento testicular en los pájaros, durante el periodo de rápido desarrollo de las gónadas, está comprendido entre el 0’4 y el 2 por ciento del metabolismo basal. El crecimiento de las gónadas femeninas generalmente requiere aportes energéticos tres veces mayores que las masculinas pero, en cualquier caso, es una cantidad pequeña comparada con el coste energético de la producción e incubación de un huevo.

La cadena alimenticia, los herbívoros, los carnívoros, peces, natación, carreras y saltos, el vuelo, y tantos y tantos conceptos implicados me aconsejan reducir el presente trabajo que, en realidad, sólo quería limitarse a facilitar algunos conocimientos del planeta y que, por mi cuenta y riesgo, he unido a los seres que lo pueblan y cómo se mantienen y están relacionados. Pero no es eso lo que pretendía al empezar, así que, volvamos al tema principal de la libreta: la física.

emilio silvera

Ago

4

Somos una parte del Universo…¡La que piensa! II

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Los ladrillos del cerebro: Es evidente que el estímulo para la expansión evolutiva del cerebro obedeció a diversas necesidades de adaptación como puede ser el incremento de la complejidad social de los grupos de homínidos y de sus relaciones interpersonales, así como la necesidad de pensar para buscar soluciones a problemas surgidos por la implantación de sociedades más modernas cada vez. Estas y otras muchas razones fueron las claves para que la selección natural incrementara ese prodigioso “universo” que es el cerebro humano.

Claro que, para levantar cualquier edificio, además de un estímulo para hacerlo se necesitan los ladrillos específicos con las que construirlo y la energía con la que mantenerlo funcionando.

La evolución rápida del cerebro no solo requirió alimentos de una elevada densidad energética y abundantes proteínas, vitaminas y minerales; el crecimiento del cerebro necesitó de otro elemento fundamental:

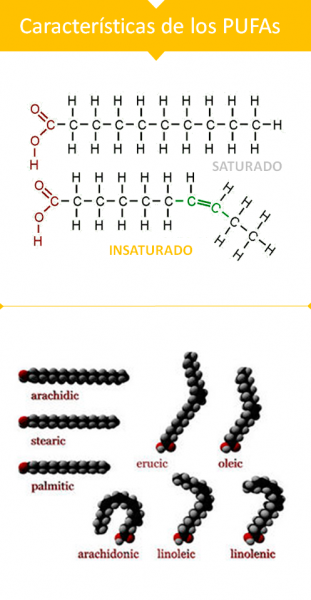

“Los ácidos grasos poliinsaturados de cadena larga ω-3 (AGPICL ω-3) de origen marino, principalmente el ácido eicosapentaenoico (EPA) y el ácido docosahexaenoico (DHA), presentes especialmente en pescados grasos o azules, producen diversos efectos saludables en la salud humana, especialmente a nivel cardiovascular.”

Un aporte adecuado de ácidos grasos poliinsaturados de larga cadena, que son componentes fundamentales de las membranas de las neuronas, las células que hacen funcionar nuestro cerebro.

Nuestro organismo, como ya he señalado, es incapaz de sintetizar en el hígado suficiente cantidad de estos ácidos grasos; tiene que conseguirlos mediante la alimentación. Estos ácidos grasos son abundantes en los animales y en especial en los alimentos de origen acuático (peces, moluscos, crustáceos). Por ello, algunos especialistas consideran que la evolución del cerebro no pudo ocurrir en cualquier parte del mundo y, por lo tanto, requirió un entorno donde existiera una abundancia de estos ácidos grasos en la dieta: un entorno acuático.

En la segunda imagen estructura molecular del ácido araquidónico

El cerebro humano contiene 600 gramos de estos lípidos tan especiales imprescindibles para su función. Entre estos lípidos destacan los ácidos grasos araquidónico (AA, 20:4 W-6) y docosahexaenoico (D H A, 22:6 W-3); entre los dos constituyen el noventa por 100 de todos los ácidos grasos poliinsaturados de larga cadena en el cerebro humano y en el resto de los mamíferos.

Una buena provisión de estos ácidos grasos es tan importante que cualquier deficiencia dentro del útero o durante la infancia puede producir fallos en el desarrollo cerebral.

El Gran Valle del Rift

El entorno geográfico del este de África donde evolucionaron nuestros ancestros proporcionó una fuente única nutricional, abundante de estos ácidos grasos esenciales para el desarrollo cerebral. Esta es otra de las circunstancias extraordinarias que favoreció nuestra evolución.

El lago Malawi es el corazón cálido de África

Las evidencias fósiles indican que el género Homo surgió en un entorno ecológico único, como es el formado por los numerosos lagos que llenan las depresiones del valle del Rift, el cual, en conjunto y desde un punto de vista geológico, es considerado un “proto-océano”. El área geográfica formada por el mar Rojo, el golfo de Adén y los grandes lagos del Rift forman lo que en geología se conoce como “océano fallido”. Son grandes lagos algunos de una gran profundidad (el lago Malwi tiene 1.500 metros y el lago Tanganika 600 m.).

El Lago Victoria de una gran belleza y tranquilidad

De una enorme extensión (el lago Victoria, de casi 70.000 km2, es el mayor lago tropical del mundo). Se llenaban, como hacen hoy, del agua de los numerosos ríos que desembocan en ellos; por eso sus niveles varían según las condiciones climatológicas regionales y estaciónales.

Muchos de estos lagos son alcalinos debido al intenso volcanismo de la zona. Son abundantes en peces, moluscos y crustáceos que tienen proporciones de lípidos poliinsaturados de larga cadena muy similares a los que componen el cerebro humano. Este entorno, en el que la especie Homo evolucionó durante al menos dos millones de años, proporcionó a nuestros ancestros una excelente fuente de proteínas de elevada calidad biológica y de ácidos grasos poliinsaturados de larga cadena, una combinación ideal para hacer crecer el cerebro.

El Lago Victoria siempre fue una buena despensa para nuestros antepasados

Ésta es otra de las razones en las que se apoyan algunos para sugerir que nuestros antecesores se adaptaron durante algunos cientos de miles de años a un entorno litoral, posiblemente una vida lacustre, en el “océano fallido” de los grandes lagos africanos y que nuestra abundante capa de grasa subcutánea es la prueba de esta circunstancia de nuestra evolución.

La realidad es que este entorno lacustre proporcionó abundantes alimentos procedentes del agua, ricos en proteínas de buena calidad y en ácidos grasos poliinsaturados. Estos alimentos completaban la carroña incierta o la caza casi imposible. Durante cientos de miles de años evolucionaron los homínidos en este entorno entre la sabana ardiente y las extensiones interminables de aguas someras por las que vagaban los clanes de nuestros antepasados chapoteando a lo largo de kilómetros en busca de alimento. Este entorno único no solo garantizó los nutrientes necesarios para desarrollar el cerebro, sino que aceleró numerosos cambios evolutivos que confluirían en el Homo sapiens.

Nuestra especie es muy homogénea en sus características: somos muy similares a pesar de lo que pudiera parecer a causa de las diferencias del color en la piel o en los rasgos faciales de las diferentes poblaciones. Tanto los datos de la genética homo los de la paleoantropología muestran que los seres humanos, como especie, procedemos de un grupo pequeño de antepasados que vivían en África hace unos cuatrocientos mil años.

Hemos logrado determinar con precisión nuestros orígenes como especie mediante precisos análisis genéticos; por ejemplo, los estudios llevados a cabo sobre los genes de las mitocondrias pertenecientes a individuos de todas las poblaciones del mundo y de todas las razas.

Estudiando el A D N mitocondrial de miles de personas se ha llegado a formular la llamada “Teoría de la Eva Negra”, según la cual todos nosotros, los Homo sapiens, procedemos de una hembra que vivió en algún lugar de África hace ahora unos tres cientos mil años. Otros estudios se han realizado mediante el análisis del polimorfismo del cromosoma Y.

Pero tanto unos estudios como otros han dado el resultado similar. Los estudios del material genético del cromosoma Y confirman que la Humanidad tuvo un antepasado varón que vivió en África hace unos doscientos mil años. Seria la “Teoría del Adán Negro”. Estudios del Gen de la hemoglobina ratifican que todas las poblaciones humanas modernas derivan de una población ancestral africana de hace unos doscientos mil años compuesta por unos seiscientos individuos.

Los hallazgos paleoantropológicos ratifican el origen único y africano de nuestra especie. Se han encontrado en diversa regiones de África algunos fósiles, de características humanas modernas, con una antigüedad de entre tres cientos mil y cien mil años; estos incluyen: el cráneo de kabwe (en Zambia), de 1.285 c.c.; el fósil KNM-ER-3834 del lago Turkan, en Kenia, de casi litro y medio; los fósiles encontrados en los yacimientos de Border Cave y Klassies River Mouth, de África del sur; y los esqueletos y cráneos encontrados en los enterramientos de la Cueva de Qafzeh y del abrigo de Skhul, ambos en Israel y datados en unos cien mil años.

El cráneo y la cara re-construida

En 1.968 se descubrieron en Dordoña el cráneo y el esqueleto de uno de nuestros antepasados, al que se denominó Hombre de Cro-Magnon. Hoy sabemos que hace unos cuarenta mil años aparecieron en Europa unos inmigrantes de origen africano, que eran los primeros representantes de la especie Homo sapiens sapiens que alcanzaban estos territorios. Llegaron con unas armas terribles e innovadoras, conocían el modo de dominar el fuego y poseían una compleja organización social; y por lo que se refiere a las otras especies de homínidos que habitaban por aquel entonces Europa, concretamente los Homo neandertales, al parecer, los eliminaron por completo.

Los cromañones poseían las características de los pobladores de las regiones próximas al ecuador: poco macizos, muy altos y de brazos y piernas largas; sus huesos eran muy livianos por aumento del canal medular, dentro de la diáfisis. Los huesos que formaban las paredes del cráneo eran más finos, que los de sus predecesores. Habían sufrido una reducción de la masa muscular. El desarrollo de armas que podían matar a distancia con eficacia y sin requerir gran esfuerzo, como los propulsores, las hondas y, más tarde, el arco y las flechas, hicieron innecesarias una excesiva robustez. En general, eran muy parecidos a nosotros y, hasta tal punto es así que, si cogiéramos a uno de estos individuos, lo lleváramos a la peluquería, le pusiéramos un buen traje, y lo sacáramos de paseo, se confundiría con el resto de la gente sin llamar a atención.

Llegados a este punto, no merece la pena relatar aquí las costumbres y forma de vida de esas poblaciones que, en tantos y tantos escritos hemos podido leer y conocemos perfectamente. El objeto de todo esto era esbozar un perfil de lo que fuimos, de manera que dejemos ante nosotros la evolución por la que hemos pasado hasta llegar aquí, y, a partir de ahora, pensar en la evolución que nos queda hasta convertirnos en los seres del futuro que, seguramente, regirán en el Universo.

emilio silvera

Totales: 82.939.088

Totales: 82.939.088 Conectados: 199

Conectados: 199