Si existen miles de millones de posibilidades de que haya civilizaciones inteligentes, ¿por qué ninguna ha contactado todavía con nosotros?

IMPRESIÓN NO PERMITIDA - TEXTO SUJETO A DERECHOS DE AUTOR

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Podríamos decir sin temor a equivocarnos que la Física del siglo XX empezó exactamente en el año 1900, cuando el físico Max Planck propuso, en un artículo de ocho páginas, una posible solución a un problema que había estado intrigando a los físicos durante muchos años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la Naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calos, la así llamada “termodinámica”, o al menos eso parecía. Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para longitudes menores.

Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo” (arriba en la imagen), el objeto está radiando en la zona de la luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitidas en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda y, por lo tanto, proporcional a la frecuencia de la radiación. la fórmula es

E = h x ν,

dinde E es la energía del paquete, ν es la frecuencia y h es una nueva constante fundamental de la naturaleza, la Constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

A partir de aquello se comenzó a hablar de la ley de radiación de Planck que proporciona la distribución de energía radiada por un cuerpo negro (cuerpo hipotético que absorbe toda la radiación qye incide sobre él. Teine, por tanto, una absortancia y una emisividad de 1. Mientras que un auténtico cuerpo negro es un concepto imaginario, un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica).

Planck introdujo en la Física el concepto novedoso de que la energía es una cantidad que es radiada por un cuerpo en pequeños paquetes discretos, en vez de en una emisión continua. estos paquetes que se conocieron como cuantos y la ley formulada fue la base de la Teoría cuántica.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una forma más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis- Víctor de Broglie, dándole otra vuelta a la teoría, que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia, ν, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

Muchas veces hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; tiene una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el universo.

El curioso comportamiento de los electrones en el interior del átomo descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de Broglie. Poco después, en 1926, Erwin Schrödinger descubrió como escribir la teoría ondulatoria de De Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recien descubiertas “ecuaciones de ondas cuánticas”.

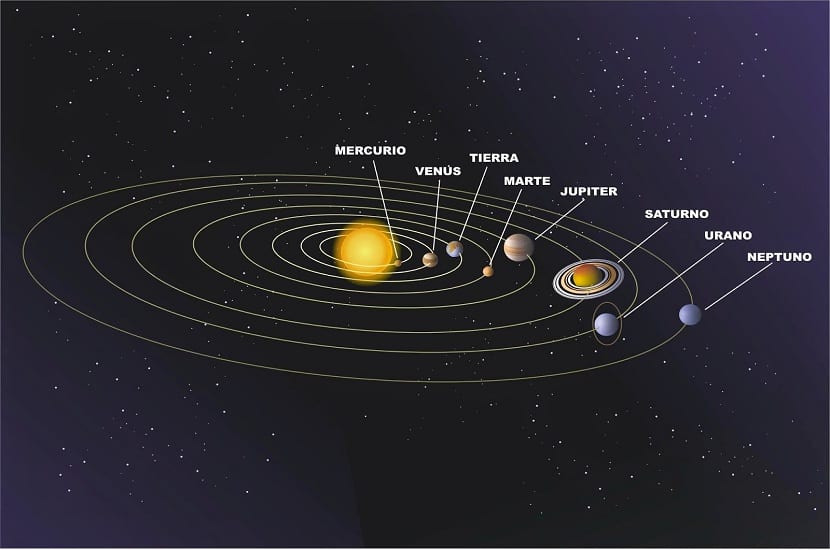

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿Qué es lo que están describiendo? Cuando Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero para los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

“Proyecta lo difícil partiendo de donde aún es fácil, realiza lo grande partiendo de donde aún es pequeño, todo lo dificil comienza siempre fácil, todo lo grande comienza siempre pequeño, por eso el sabio nunca hace nada grande y realiza lo grande sin embargo, el árbol de ancho tronco esta ya en el pequeño brote, un gran edificio se basa en una capa de tierra, el camino hacia lo eterno comienza ante tus pies” (Lao Tsé)

Niels Bohr consiguió responder a esta pregunta de forma tal que con su explicación se pudo seguir trabajando, y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica.

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento musical se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

La plegaria, la afirmación metafísica, la oración científica, la meditación y la visualización creativa son funciones elevadas de la conciencia humana, y estas funciones interactúan con la realidad de manera específica en el mundo cuántico que es la matriz del mundo material, ya que es aquí donde la energía se convierte en materia. En el preciso instante en que pensamos “estoy contento”, un mensajero químico traduce nuestras emociones, todas las células de nuestro cuerpo entienden nuestro deseo de felicidad y se suman a él.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a esta interpretación. Quizá funcione bien, pero ¿Dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿Dónde está en realidad?, y ¿Cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos ahora se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de forma estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (Ψ) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un momento dado.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.

Albert Einstein, Nathan Rosen y Boris Podolski idearon un “Gedankenexperiment”, un experimento hipotético, realizado sobre el papel, para el cual la mecánica cuántica predecía como resultado algo que es imposible de reproducir en ninguna teoría razonable de variables ocultas. Más tarde, el físico irlandés John Stewar Bell consiguió convertir este resultado en un teorema matemático; el teorema de imposibilidad.

Como probablemente algunos de ustedes sospechen, yo todavía creo en la hipótesis de las variables ocultas. Seguramente, nuestro mundo debe estar construido de una forma tan ingeniosa que algunas de las suposiciones que Einstein y otros encontraron tan naturales terminen siendo erróneas. Lo que no puedo imaginar es cómo sucederá esto. En cualquier caso, tener las “variables ocultas” para sostén de mi ignorancia acerca de la mecánica cuántica…, resulta un alivio, ya que, son muchos los teoremas de imposibilidades que nos podemos encontrar por el camino de las cosas que no comprendemos.

emilio silvera

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

L A S A B I D U R Í A N A T U R A L

“Quien realmente ama aprender está dotado por naturaleza para luchar para encontrar el ser. No se detiene en cada una de las muchas cosas que se opina que son, sino que avanza y no flaquea ni abandona su intenso deseo hasta que alcanza la naturaleza de cada cosa. Y lo hace con la parte del alma a la que corresponde alcanzarla, con la cual se aproxima y se mezcla con el verdadero ser, engendrando inteligencia y verdad. Así adquiere el conocimiento y vive y se nutre verdaderamente, cesando entonces y no antes, sus dolores de parto.”

Para resolver el “Problema de Platón”, enunciado por él desde esa alta cúspide del pensamiento humano, dice el doctor Ovidio Pracilio que, hay que liberarse primero, como es lógico, de todo prejuicio científico que contradiga el enunciado del problema, porque si se acepta como verídico y exacto lo que lo niega, sería tarea absurda buscarle una solución en la que no se cree.

Sir Arthur Eddington señala en su obra La naturaleza del mundo físico, que “es de las preconcepciones rutinarias del hombre de lo primero que debe liberarse la mente para acceder a los hallazgos de la ciencia”.

Hace falta, pues, fe en que el problema de Platón tiene solución.

Si admitimos que el Universo físico surgió del caos, o sea de lo informe o materia aún no organizada, así como cada organismo natural que se incorpora a la vida del Universo surge de esa materia informe a la que las leyes inmanentes dictadas por la Sabiduría Natural va estructurando hasta que alcanza las formas de su compleja y completa planificación, es evidente que el caos o lo informe fue reemplazado por una Creación grandiosamente perfecta.

Suponer lo contrario, o sea que tal Creación, que es el Universo físico, es a su vez un caos porque de tal modo aparecería a nuestros sentidos o así lo interpretamos al desconocer la perfección de las leyes que lo gobiernan, nos llevaría a admitir que, antes de que existiera este Universo aparentemente caótico, ocupaba su lugar en lo físico algo más perfecto que lo informe, en cuyo caso la Naturaleza habría involucionado de lo mejor a lo peor, lo cual parece poco probable.

Según la teoría super-densa, única y explosiva del Universo, el caos original estaba compuesto por entero de radiación, es decir, era indiferenciado, no existiendo nexos particulares entre los puntos de la extensión así colmada de radiación térmica. Luego aparecen los primeros corpúsculos elementales de la Materia, y esta se va estructurando en conjuntos materiales diferenciados, lo que constituye la creación del Universo.

Ahora bien: si todos los procesos físicos se han desarrollado y organizado partiendo de un caos inicial pero compuesto de energía (y nada se ha dicho sobre la manera en que el caos inicial habría salido de la Nada o sea de la ausencia de energía, ni como ésta ha podido estructurarse en Materia, silencio científico excusable si se ajusta al argumento de que tal problema constituye una cuestión “metafísica”), tal argumento no sería valedero si se probase de algún modo que la Materia constitutiva del Universo se ha diferenciado de la radiación del caos primitivo respondiendo a esquemas hipergeométricos esferoidales, porque esta hiper-geometría y sus leyes matemáticas no pueden ser fruto físico del caos indiferenciado compuesto exclusivamente de energía ni tampoco de la propia Materia que es simple consecuencia del sometimiento de la energía a esa leyes hipergeométricas.

Es verdad, y nadie puede negarlo, que los cuerpos celestes, para tomar lo más grande que nos es dado apreciar, surgen a nuestra observación con movimientos que no serían uniformes y recorriendo órbitas que no serían circulares. Y es cierto, por ello, que los movimientos de los mundos que forman

nuestro sistema solar, por ejemplo, se nos muestran así, al parecer más imperfectos que el de los satélites artificiales creados por el hombre que logró colocarlos en órbitas circulares y moviéndose a velocidades uniformes (casi burlándose de las exigencias elípticas de las leyes de Kepler y de la gravitación universal de Newton) y como quería Platón para los cuerpos celestes, y en cambio Mercurio, Venus, la Tierra, Marte, etc., parecen marchar a veces más rápido y otras veces más despacio en su viaje alrededor del Sol, para no apartarse de ese camino geométricamente imperfecto que se llama “elipse”

Es verdad, también, que iguales movimientos caóticos surgirían del abismo de lo infinitamente pequeño, donde las partículas elementales que forman los átomos y los átomos mismos, parecieran moverse en forma desordenada y caprichosa al girar a velocidades vertiginosas

Y es verdad, igualmente, que casi ninguna forma de organismo viviente creado en nuestro mundo por la Naturaleza parecería adecuarse a la perfección del trazo circular, único digno de la sabiduría divina, según Platón.

Empédocles imaginó los elementos y Demócrito el átomo

Pero todo eso es verdad, debemos reconocerlo en tanto la mente investigadora se mantenga sujeta a determinados prejuicios preestablecidos, y se quiera fundar toda conclusión científica en los resultados exclusivos que arrojan la observación sensual e instrumental. Pero que, en cambio, cuando la mente del investigador se libera de tales prejuicios, cuando deja de lado a sus sentidos y a sus instrumentos y eleva el vuelo de su pensamiento a las altas regiones donde la Realidad puede ser percibida independientemente de los fenómenos que son su consecuencia, recién entonces es dable descubrir y afirmar, como lo hizo Copérnico, por ejemplo, que no es el Sol ni la Luna ni los planetas ni las estrellas las que dan vueltas alrededor de la Tierra como todos los días así nos lo hacen creer nuestros ojos y lo registran nuestros instrumentos, sino, al parecer, todo lo contrario.

Ya lo dijo Bailly con más hermosas palabras que las que pudiera emplear yo, al hacer el elogio de la concepción copernicana: “Si alguna vez se ha propuesto en el mundo un sistema atrevido, no hay duda que es el de Copérnico. Tenía que contradecir a todos los que juzgaban por sus sentidos. Era mejor persuadirlos de que, lo que veían, no existía. En vano había visto la humanidad desde el nacer, al Sol y a las estrellas moverse, pues Sol y estrellas estaban inmóviles y solo había movimiento en la pesada masa que habitamos. Hay que olvidar el movimiento que vemos, para creer en el movimiento que no percibimos. Más todavía; hay que destruir un sistema recibido y aprobado por las tres partes del mundo y derribar el trono de Tolomeo que recibió el homenaje de catorce siglos”.

“La observación y el experimento no os han dado –se lee en La Grande Síntesis, de Pietro Ubaldi- más que resultados exteriores, de índole práctica, pero la realidad profunda se os escapa, porque el uso de los sentidos como instrumentos de investigación, aún ayudados por medios adecuados, os hará permanecer siempre en la superficie, cerrándonos la vía del progreso”.

¡Qué equivocado estaba Newton, pues, cuando dijo, en la segunda edición de sus célebres Principios!:

“Poco importa la causa de la gravitación. Observo el movimiento de los astros y escribo la ley más simple y más adecuada para describir ese movimiento. No quiero establecer ninguna hipótesis sobre las causas. Porque todo lo que no se deduce de los fenómenos es una hipótesis y las hipótesis no deben tener acceso en la filosofía experimental. En esta filosofía se sacan las preposiciones de los fenómenos y se las hace luego generales por inducción.”

Todos los antecesores de Copérnico también observaron el movimiento de los astros y escribieron la ley más simple y adecuada para describir ese movimiento, que era el movimiento de la Esfera Celeste, del Sol, de los planetas, alrededor de la Tierra.

Lamentablemente, tanto para los astrónomos antiguos como para Newton, el movimiento real era, precisamente, el movimiento que no se observaba.

“Hacemos distinción entre materia viva y materia muerta –dice Max Born, premio Nobel de Física en su libro El inquieto universo-; entre cuerpos en movimiento y cuerpos en reposo. Este es un punto de vista primitivo. Lo que parece muerto, una piedra, por ejemplo, está en realidad en eterno movimiento. Lo que ocurre es, simplemente, que nos hemos acostumbrado a juzgar por apariencias exteriores, por las impresiones engañosas que recibimos a través de nuestros sentidos.”

“Los trabajos de Kepler –dijo Einstein- muestran que el conocimiento no puede derivar únicamente de la experiencia: es necesaria la comparación de lo que el espíritu ha concebido, con lo que ha observado.”

Por mi parte, -sigue diciendo el doctor Pracilio- refiriéndome específicamente al problema planteado por Platón sobre circularidad de las órbitas planetarias, quiero aquí parafrasear la hermosa y exacta expresión de Bailly, diciendo que: “hay que olvidar los movimientos elípticos que vemos, para creer en los movimientos circulares que no percibimos”.

Trabajo basado en los escritos del doctor Ovidio Pracilio

© Todos los derechos reservados

Dante Pracilio – 2008/2021.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Esplendoroso Arco de la Vía Láctea desde Monument Valley en los Estados Unidos. Aquí, como en otros muchos rincones de nuestro planeta Tierra, podemos contemplar esa inmensidad, ese carrusel de estrellas, gas y polvo que conforma la Galaxia espiral en kla que nos encontramos, y, de la misma manera, otros muchos cientos de miles de mundos, también podrán ser el habitat de criaturas inteligentes que, como nosotros, se ven allí confinadas sin poder recorrer “infinitas” distancias que las separan de otras civilizaciones situadas a decenas, cientos o miles de años-luz de ellos. Lo explica bien el reportaje publicado por El País.

La Paradoja de fermi: ¿Dónde está todo el mundo?

Si existen miles de millones de posibilidades de que haya civilizaciones inteligentes, ¿por qué ninguna ha contactado todavía con nosotros?

Artículo originalmente escrito por Tim Urban. Traducción de Eva Millán.

Todo el mundo siente algo cuando está en un sitio desde el que se ven muy bien las estrellas en una noche especialmente estrellada y mira hacia arriba y ve esto.

Algunos prefieren lo tradicional y se sobrecogen por la belleza épica del Universo o les impresiona su absurda escala. Yo, personalmente, me decanto por la clásica “crisis existencial y posterior comportamiento extraño durante la siguiente media hora”. Pero todo el mundo siente algo.

El físico Enrico Fermi también sintió algo: ”¿Dónde está todo el mundo?”.

Un cielo repleto de estrellas parece enorme… pero lo que vemos no es más que nuestro vecindario más próximo. En las mejores noches posibles podemos ver hasta 2.500 estrellas (aproximadamente una cienmillonésima parte de las estrellas de nuestra galaxia), y casi todas ellas están a menos de 1.000 años luz de nosotros (o un 1% del diámetro de la Vía Láctea). Así que a lo que realmente estamos mirando es a esto:

Cuando se enfrentan al tema de las estrellas y galaxias, una pregunta que atormenta a la mayoría de los humanos es: “¿Hay más vida inteligente ahí fuera?”. Veamos algunos números.

Hay tantas estrellas en nuestra galaxia (100.000 – 400.000 millones) como galaxias hay en el universo observable, aproximadamente, así que por cada estrella en la colosal Vía Láctea hay toda una galaxia ahí fuera. Si las sumamos todas llegamos al intervalo típicamente citado de entre 1022 y 1024 estrellas en total, lo que significa que por cada grano de arena en cada playa de la Tierra hay 10.000 estrellas ahí fuera.

El mundo científico no acaba de ponerse de acuerdo sobre qué porcentaje de esas estrellas son de “tipo solar” (similares al Sol en tamaño, temperatura y luminosidad): las opiniones suelen estar entre el 5% y el 20%. Quedándonos con el cálculo más conservador (5%), y el extremo más bajo del número total de estrellas (1022), nos da 500 trillones o 500 millones de billones de estrellas de tipo solar.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

En 1.949, el físico francés Louis de Broglie, que ganó el premio Nobel, propuso construir un laboratorio europeo de física de partículas. Su idea caló hondo en la comunidad internacional, y tres años más tarde, 11 países europeos dieron el visto bueno y el dinero para construir el CERN, inaugurado en Ginebra en 1.954, y al que tanto le debe la física y las Sociedades modernas del mundo.

Los aceleradores de partículas son un gran invento que ha permitido comprobar (hasta donde se ha podido, al menos) la estructura del átomo. En el acelerador del Fermilab, por ejemplo, un detector de tres pisos de altura que en su momento costó unos ochenta millones de dólares para poder captar electrónicamente los “restos” de la colisión entre un protón y un antiprotón. Aquí la prueba consiste en que decenas de miles de sensores generen un impulso eléctrico cuando pasa una partícula. Todos esos impulsos son llevados a procesadores electrónicos de datos a través de cientos de miles de cables. Por último, se hace una grabación en carrete de cinta magnética codificada con ceros y unos. La cinta graba las violentas colisiones de los protones y antiprotones, en las que generan unas setenta partículas que salen disparadas en diferentes direcciones dentro de las varias secciones del detector.

El 13 de octubre de 1985 se produjo la primera colisión protón-antiprotón en el Tevatrón del Fermilab.

La ciencia, en especial la física de partículas, gana confianza en sus conclusiones por duplicación, es decir, un experimento en California se confirma mediante un acelerador de un estilo diferente que funciona en Ginebra con otro equipo distinto, que incluye en cada experimento los controles necesarios y todas las comprobaciones para que puedan confirmar con muchas garantías el resultado finalmente obtenido. Es un proceso largo y muy complejo; la consecuencia de muchos años de investigación de muchos equipos diferentes.

No es suficiente con un único resultado. Si muchos, en distintos lugares dan lo mismo…se pueden considerar ciertos

Yo puedo visualizar la estructura interna de un átomo. Puedo hacer que me vengan imágenes mentales de nebulosas de “presencia” de electrón alrededor de la minúscula mota del núcleo que atrae esa bruma de la nube electrónica hacia sí. Puedo ver los átomos, los protones y los neutrones, y en su interior, los diminutos quarks enfangados en un mar de neutrones. Claro que todo eso es posible por el hecho de que dicha imagen me es muy familiar. Creo que cada uno construirá sus propias imágenes conforme él las vea a partir de las ecuaciones o bien de cómo las formó en su mente a partir de sus lecturas o explicaciones oídas en charlas científicas.

“Frank Wilczek. compartió el Premio Nobel de Física del 2004 con David Cross y David Politzer. Los laureados han realizado un importante descubrimiento teórico relativo a la fuerza fuerte, o la “fuerza de color” como también ha sido llamada. La fuerza fuerte es la que domina en los núcleos atómicos, actuando entre los quarks del próton y del neutrón.

Wilczek es considerado uno de los físicos teóricos más eminentes del mundo. Conocido entre otras cosas, por el descubrimiento de la libertad asintólica, el desarrollo de la Cromodinamica Cuántica, la invención de axions, y el descubrimiento y explotación de nuevas formas de estadísticas quántum (el anyons). A los 21 años siendo estudiante graduado de la Universidad de Princenton, trabajando con David Gross, definió las propiedades del gluen coloreado que une a los núcleos atómicos.”

Cuando entraron en escena David Politrer, de Harvard, y David Gross y Frank Wilczek, de Pinceton, el panorama de lo que ocurría en el interior del núcleo se aclaró bastante. Ellos, descubrieron algo que llamaron libertad asintótica. Asintótico significa, burdamente, “que se acerca cada vez más, pero no toca nunca”. La interacción fuerte se debilita más y más a medida que un quark se aproxima a otro. Esto significa, paradójicamente, que cuando los quarks están muy juntos se portan casi como si fuesen libres; pero cuando se apartan, las fuerzas se hacen efectivamente mayores. Las distancias cortas suponen energías altas, así que la interacción fuerte se debilita a altas energías. Esto es justo lo contrario de lo que pasa con la fuerza eléctrica. Aún más importante era que la interacción fuerte necesitase una partícula mensajera, como las otras fuerzas, y en alguna parte le dieron al mensajero el nombre de gluón (del inglés glue, pegamento).

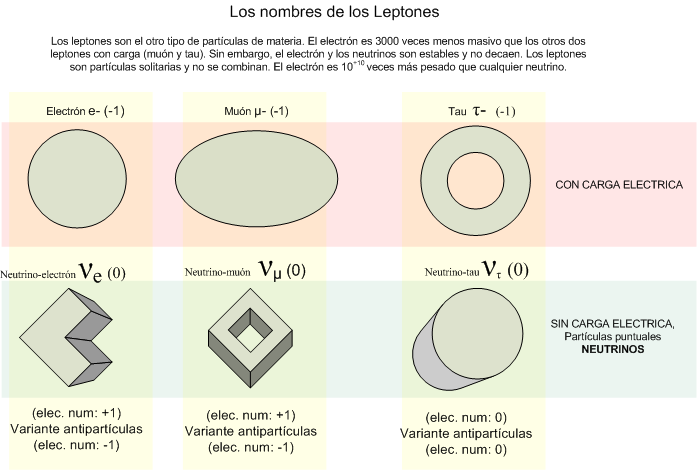

A todo esto, llegó Murray Gell-Mann con sus quarks para completar el panorama. Adjudicó a estas diminutas partículas color y sabor (nada que ver con el gusto y los colores reales) y llegó la teoría denominada cromodinámica cuántica. Todo aquello dio mucho que hablar y mucho trabajo a los teóricos y experimentadores, y al entrar en los años ochenta, se había dado ya con todas las partículas de la materia (los quarks y los leptones), y teníamos las partículas mensajeras, o bosones gauge, de las tres fuerzas, a excepción de la gravedad.

|

MATERIA |

|||

|

Primera generación |

Segunda generación |

Tercera generación |

|

|

u |

c |

t |

|

|

d |

s |

b |

|

|

Son los quarks up, down, charmed, strange, top y bottom. |

|||

|

Los leptons son: |

|||

|

υe |

υμ |

υτ |

|

|

e |

μ |

τ |

|

|

FUERZAS |

|||

|

Fotón |

Electromagnetismo |

||

|

W+, W–, Z0 |

Interacción débil |

||

|

Ocho gluones |

Interacción fuerte |

||

La familia de los leptones está compuesta por el electrón, muón y tau con sus correspondientes neutrinos. Así quedó prácticamente completo el llamado modelo estándar que describe las partículas que forman la materia conocida y las fuerzas que intervienen e interaccionan con ellas. La gravedad quedó plasmada en la relatividad general de Einstein.

¿Por qué es incompleto el modelo estándar? Una carencia es que no se haya visto todavía el quark top; otra, la ausencia de una de las cuatro fuerzas fundamentales, la gravedad. Otro defecto estético es que no es lo bastante simple; debería parecerse más a la tierra, aire, fuego y agua de Empédocles. Hay demasiados parámetros y demasiados controles que ajustar. Necesitamos una nueva teoría que sea menos complicada, más sencilla y bella, sin vericuetos intrincados que salvar, con la limpieza y serena majestad de la teoría de la gravedad que, con enorme simpleza y aplicando los principios naturales, trata los temas más profundos del universo. Esperemos que continúe desarrollándose la teoría de cuerdas y que, como parece, incluya todas las fuerzas, todas las partículas y, en fin, todos los parámetros que dan sentido al universo.

Sí, al Modelo Estándar la faltan algunas cosas y le sobran otras, o, al menos, sería necesario explicarlas mejor. La Gravedad no está presente y, hay una veintena de parámetros aleatorios que, como el Bosón de Higgs, no se pueden explicar…aún. La Historia viene de lejos:

|

El modelo estándar: Historia resumida |

|||||

|

Autores |

Fechas |

Partículas |

Fuerza |

Nota |

Comentario |

|

Tales (milesio) |

600 a.C. |

Agua |

No se menciona |

8 |

Fue el primero en explicar el mundo mediante causas naturales. Lógica en lugar de mito. |

|

Empédocles (agrigento) |

460 a.C. |

Tierra, agua, aire y fuego |

Amor y discordia |

9 |

Aportó la idea de que hay múltiples partículas que se combinan para formar toda la materia. |

|

Demócrito (Abdera) |

430 a.C. |

El átomo indivisible e invisible, o a-tomo |

Movimiento violento constante |

10 |

Su modelo requería demasiadas partículas, cada una con una forma diferente, pero su idea básica de que hay un átomo que no puede ser partido sigue siendo la definición básica de partícula elemental. |

|

Isaac Newton (inglés) |

1.687 |

Átomos duros con masa, impenetrables |

Gravedad (cosmos); fuerzas desconocidas (átomos) |

7 |

Le gustaban los átomos pero no hizo que su causa avanzase. Su gravedad fue un dolor de cabeza para los peces gordos en la década de 1.990 |

|

Roger J. Boscovich (dálmata) |

1.760 |

“Puntos de fuerza” indivisibles y sin forma o dimensión |

Fuerzas atractivas y repulsivas que actúan entre puntos |

9 |

Su teoría era incompleta, limitada, pero la idea de que hay partículas de “radio nulo”, puntuales, que crean “campos de fuerza”, es esencial en la física moderna. |

|

Michael Faraday (inglés) |

1.820 |

Cargas eléctricas |

Electromagnetismo |

8’5 |

Aplicó el atomismo a la electricidad al conjeturar que las corrientes estaban formadas por “corpúsculos de electricidad”, los electrones. |

|

Dimitri Mendeleev (siberiano) |

1.870 |

Más de 50 átomos dispuestos en la tabla periódica de los elementos |

No hace cábalas sobre las fuerzas |

8’5 |

Tomó la idea de Dalton y organizó todos los elementos químicos conocidos. En su tabla periódica apuntaba con claridad una estructura más profunda y significativa. |

|

Ernest Rutherford (neozelandés) |

1.911 |

Dos partículas; núcleo y electrón |

La fuerza nuclear fuerte más el electromagnetismo. La gravedad |

9’5 |

Al descubrir el núcleo, reveló una nueva simplicidad dentro de todos los átomos de Dalton. El experimentador por excelencia. |

|

Bjorken, Fermi, Friedman, Gell-Mann, Glasgow, Kennedy, Lederman, Peri, Richter, Schwartz, Steinberger, Taylor, Ting, más un reparto de miles. |

1.992 |

Seis quarks y seis leptones, más sus antipartículas. Hay tres colores de quarks |

El electromagnetismo, la interacción fuerte y débil: doce partículas que llevan las fuerzas más la gravedad. |

? |

Demócrito de Abdera ríe. |

A todo esto y como he dicho, el quark top está perdido (ya se encontró) y el neutrino tau no se ha detectado directamente (pero experimentos nos han dicho que un neutrino muónico se puede transformar en uno tau), y muchos de los números que nos hacen falta conocer los tenemos de forma imprecisa. Por ejemplo, no sabemos si los neutrinos tienen alguna masa en reposo.

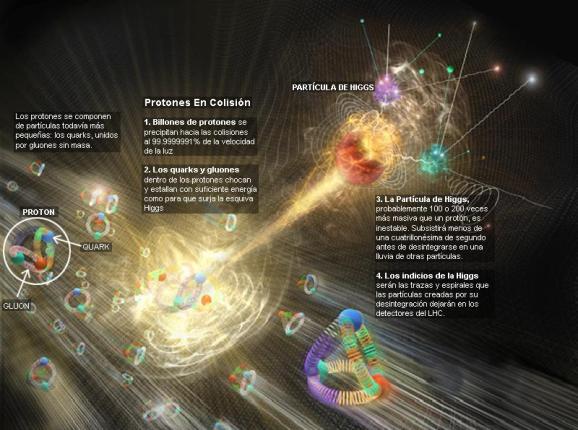

Tenemos que saber cómo la violación de la simetría CP (el proceso que originó la materia) aparece, y lo que es más importante, hemos de introducir un nuevo fenómeno, al que llamamos campo de Higgs, para preservar las coherencia matemática del modelo estándar. La idea de Higgs y su partícula asociada, el bosón de Higgs, cuenta en todos los problemas que he mencionado antes. Parece, con tantos parámetros imprecisos (19), que el modelo estándar está asentado sobre arenas movedizas.

En realidad, no sabemos si la relatividad general y la teoría cuántica, son dos mundos antagónicos que nos empeñamos en unir. Por eso buscamos la gravedad Cuántica.

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “super-gravedad”, “supersimetría”, “supercuerdas”, “teoría M” o, en último caso, “teoría de todo” o “gran teoría unificada”.

¿Universo de dimensiones extras?

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo. Hablan de 10, 11 y 26 dimensiones, siempre todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos ni sabemos, o no nos es posible intuir en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron en la longitud de Planck las dimensiones que no podíamos ver; ¡problema solucionado! ¿Quién puede ir a la longitud de Planck para verlas?

La puerta de las dimensiones más altas quedó abierta y a los teóricos se les regaló una herramienta maravillosa: el hiperespacio; todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí sí es posible encontrar esa soñada teoría de la gravedad cuántica.

¡Tiene tantos secretos el Universo!

Así que las teorías se han embarcado a la búsqueda de un objeto audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos; una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC, se necesitaría una energía de 1019 GeV.

La verdad es que la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías. ¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las partículas que carecen de ella, disfrazando así la verdadera simetría del mundo. Cuando su autor lanzó la idea al mundo, resultó además de nueva, muy extraña. El secreto de todo radica en conseguir la simplicidad: el átomo resultó ser complejo, lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones. Resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún; los quarks que estaban instalados en nubes de otras partículas llamadas gluones, y ahora queremos continuar profundizando, sospechando que después de los quarks puede haber algo más.

Con aquellos últimos experimentos en el LHC, pudimos leer declaraciones como éstas:

“…confirmaron que durante este año, tal y como se ha anunciado hace semanas, se ha obtenido una auténtica marea de datos que dejan poco o ningún lugar a dudas sobre la existencia de la partícula que la teoría considera responsable de la masa de todas las demás partículas y sin la que el Universo, sencillamente no existiría tal y como lo conocemos.”

En 1964 se predijo la existencia de esa partícula

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes, es decir, que si miramos a las estrellas en una noche clara, estamos mirando el campo de Higgs. Las partículas influidas por este campo toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado: del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquirirá energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra. Como E = mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein: la masa, m, tiene en realidad dos partes; una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c), o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Pero la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas. Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de qué reglas controlan los incrementos de masa generados por Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC), pero el problema es irritante: ¿Por qué sólo esas masas - las masas de los W+, W–, Z0, y el up, down, encanto, extraño, top y bottom, así como los leptones – que no forman ningún patrón obvio?

Las masas van desde la del electrón (0’0005 GeV) a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-Salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnética y débil. En la unidad hay cuatro partículas mensajeras sin masa – los W+, W–, Z0 y el fotón – que llevan la fuerza electrodébil. Además está el campo de Higgs, y rápidamente, los W y Z absorben la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos), y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen las teorías. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y Z se predijeron con éxito a partir de los parámetros de la teoría electro-débil, y las relajadas sonrisas de los físicos teóricos nos recuerdan que Hooft y Veltman dejaron sentado que la teoría entera está libre de infinitos.

Todos los intentos y los esfuerzos por hallar una pista de cuál era el origen de la masa fallaron. Feynman escribió su famosa pregunta: “¿por qué pesa el muón?”. Ahora, por lo menos, tenemos una respuesta parcial, en absoluto completa. Una voz potente y segura nos dice “¡Higgs!”. Durante más de sesenta años los físicos experimentadores se rompieron la cabeza con el origen de la masa, y ahora el campo de Higgs presenta el problema en un contexto nuevo; no se trata sólo del muón. Proporciona, por lo menos, una fuente común para todas las masas. La nueva pregunta feynmaniana podría ser: ¿Cómo determina el campo de Higgs la secuencia de masas, aparentemente sin patrón, que da a las partículas de la materia?

La variación de la masa con el estado de movimiento, el cambio de masa con la configuración del sistema y el que algunas partículas (el fotón seguramente, y los neutrinos posiblemente) tengan masa en reposo nula son tres hechos que ponen en entredicho que el concepto de masa sea un atributo fundamental de la materia. Habrá que recordar aquel cálculo de la masa que daba infinito y nunca pudimos resolver; los físicos sólo se deshicieron de él “renormalizándolo”, ese truco matemático que emplean cuando no saben hacerlo bien.

¿Sabremos alguna vez cómo adquieren masa las partículas?

Ese es el problema de trasfondo con el que tenemos que encarar el problema de los quarks, los leptones y los vehículos de las fuerzas, que se diferencian por sus masas. Hace que la historia de Higgs se tenga en pie: la masa no es una propiedad intrínseca de las partículas, sino una propiedad adquirida por la interacción de las partículas y su entorno.

La idea de que la masa no es intrínseca como la carga o el espín resulta aún más plausible por la idílica idea de que todos los quarks y fotones tendrían masa cero. En ese caso, obedecerían a una simetría satisfactoria, la quiral, en la que los espines estarían asociados para siempre con su dirección de movimiento. Pero ese idilio queda oculto por el fenómeno de Higgs.

Una cosa más; hemos hablado de los bosones gauge y de su espín de una unidad. Hemos comentado también las partículas fermiónicas de la materia (espín de media unidad). ¿Cuál es el pelaje de Higgs? Es un bosón de espín cero. El espín supone una direccionalidad en el espacio, pero el campo de Higgs da masa a los objetos donde quiera que estén y sin direccionalidad. Al Higgs se le llama a veces “bosón escalar” (sin dirección) por esa razón.

La interacción débil, recordaréis, fue inventada por E. Fermi para describir la desintegración radiactiva de los núcleos, que era básicamente un fenómeno de poca energía, y a medida que la teoría de Fermi se desarrolló, llegó a ser muy precisa a la hora de predecir un enorme número de procesos en el dominio de energía de los 100 MeV. Así que ahora, con las nuevas tecnologías y energías del LHC, las esperanzas son enormes para, por fin, encontrar el bosón de Higgs “origen de la masa”… y algunas cosas más.

Hay que responder montones de preguntas: ¿Cuáles son las propiedades de las partículas de Higgs? y, lo que es más importante, ¿Cuál es su masa? ¿Cómo reconoceremos una si nos la encontramos en una colisión del LHC? ¿Cuántos tipos hay? ¿Genera el Higgs todas las masas o sólo las hace incrementarse? ¿Cómo podemos saber más al respecto? Cómo es su partícula, nos cabe esperar que la veremos ahora después de gastar más de 50.000 millones de euros en los elementos necesarios para ello.

También a los cosmólogos les fascina la idea de Higgs, pues casi se dieron de bruces con la necesidad de tener campos escalares que participasen en el complejo proceso de la expansión del universo, añadiendo pues, un peso más a la carga que ha de soportar el Higgs.

Existirán los campos de Higgs, o…

… sólo será una creación de la mente.

El campo de Higgs, tal como se lo concibe ahora, se puede destruir con una energía grande, o temperaturas altas. Éstas generan fluctuaciones cuánticas que neutralizan el campo de Higgs. Por lo tanto, el cuado que las partículas y la cosmología pintan juntas de un universo primitivo puro y de resplandeciente simetría es demasiado caliente para Higgs. Pero cuando la temperatura cae bajo los 10-5 grados Kelvin o 100 GeV, el Higgs empieza a actuar y hace su generación de masas. Así, por ejemplo, antes del Higgs teníamos unos W, Z y fotones sin masa y la fuerza electro-débil unificada.

El universo se expande y se enfría, y entonces viene el Higgs (que “engorda” los W y Z, y por alguna razón ignora el fotón) y de ello resulta que la simetría electro-débil se rompe.

Tenemos entonces una interacción débil, transportada por los vehículos de la fuerza W+, W–, Z0, y por otra parte una interacción electromagnética, llevada por los fotones. Es como si para algunas partículas del campo de Higgs fuera una especie de aceite pesado a través del que se moviera con dificultad y que les hiciera parecer que tienen mucha masa. Para otras partículas, el Higgs es como el agua, y para otras, los fotones y quizá los neutrinos, es invisible.

De todas formas, es tanta la ignorancia que tenemos sobre el origen de la masa que nos agarramos como a un clavo ardiendo, en este caso, a la partícula de Higgs, que algunos han llegado a llamar “la partícula divina”.

¡Ya veremos en qué termina todo esto!

Sí, dudas hemos tenido todos

Hay otras muchas cuestiones de las que podríamos hablar y, la Física y la Astronomía, siendo mi gran Pasión, ocupa mucho de mi tiempo. La Física, amigos míos, nos dirá como es el “mundo” y digo mundo querinedo significar Naturaleza y Universo. La Física encierra una belleza…, que está presente en:

El Modelo Estándar falla en ambos aspectos, mientras que la relatividad general los exhibe, ambos, de manera bien patente. Nunca una teoría dijo tanto con tan poco; su sencillez es asombrosa y su profundidad increíble. De hecho, desde que se publicó en 1.915, no ha dejado de dar frutos, y aún no se han obtenido de ella todos los mensajes que contiene.

emilio silvera

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Si existen las estrellas de Quarks, tendrían una densidad intermedia entre las estrellas de Neutrones y los Agujeros Negros

“Si bien no se han observado objetos que puedan ser asociados a estrellas compuestas completamente de quarks, la existencia de quarks desconfinados en el interior de estrellas de neutrones no está descartada, ya que la composición de la materia a esas densidades (ρ ~ 1015 g/cm3) es aún incierta.

Se han descubierto dos posibles candidatos a estrellas de quarks, RX J1856.5-3754 y 3C58.[cita requerida] Inicialmente catalogadas como estrellas de neutrones, la primera parece más pequeña y la segunda más fría de lo que deberían ser, lo que sugiere que pueden estar compuestas por un material de mayor densidad que la materia degenerada. No obstante, los resultados no son concluyentes. Recientemente, un tercer objeto, denominado XTE J1739-285, también ha sido propuesto como posible candidato.”

Ya se especula con la existencia cierta de estrellas de Quarks y, el río suena…

La Hipótesis de estrella de Quarks (EQs) podrían responder a muchos interrogantes surgidos a partir de observaciones astrofísicas que no coinciden con los modelos canónicos teóricos de las Estrellas de Neutrones ( ENs ). Decimos que son hipotéticas porque se conjetura que estarían formadas por Materia Extraña ( ME ). La comunidad astrofísica espera evidencias observacionales que permitan diferenciarlas de las ENs, ya que podrían explicar un conjunto de observaciones astronómicas que aún resultan una incógnita. Es sabido que una EN es el remanente del colapso de una estrella masiva. El colapso de la estrella, la supernova, da lugar a un núcleo compacto hiperdenso de hierro y otros metales pesados que sigue comprimiéndose y calentándose. Su densidad continúa aumentando, dando lugar a una “neutronización“ (recombinación de electrones con protones que resultan en neutrones) y el gas degenerado de neutrones frena el colapso del remanente.

Se especula con la posibilidad de que existan estrellas de Quarks que estarían hechas de materia extraña de Quaks y Gluones.

Una EQ, a diferencia de una EN, no se originaría necesariamente de una evolución estelar después del agotamiento del combustible nuclear de una estrella normal. Sería, probablemente, producto de la transición de fase hadrón-quark a altísima densidad. La Cromo-dinámica Cuántica (CDC), la Teoría de las Interacciones Fuertes que ocurren dentro de los nucleones (protones y neutrones), concibe teóricamente la idea de la transición de fase hadrón-quark a temperaturas y/ o densidades extremadamente altas con el consecuente desconfinamiento de quarks y gluones, que formarían una especie de “sopa “. Sin embargo, los quarks libres no se han encontrado aún, en uno u otro límite, en ningún experimento terrestre.

La “sopa“ que mencionamos antes, se conoce Plasma Quark-Gluón ( PQG ). En el límite de altas temperaturas, el PQG está tratando de obtenerse en el laboratorio y existen fuertes indicios de que se logre con éxito experimentos de altas energías como el Colisionador Relativista de Iones Pesados (conocido por sus siglas en ingles como RHIC) de Brookhaven, New York.

Por otro lado, se espera que a través de observaciones astronómicas se compruebe que la transición a altas densidades se hubiese producido en el interior de alguna EN. Esto se debe a que los valores de densidades estimados para que dicha transición tuviese lugar coinciden con densidades del orden de (3 exp. – 12) ρ0 (siendo ρ0 ̃ 0, 17 fmˉ ³ la densidad de equilibrio nuclear) que son típicas del interior de las ENs. Los cálculos basados en diferentes ecuaciones de de la materia nuclear muestran estos resultados, por lo que sería razonable que el núcleo de las ENs estuviese formado por materia de quarks.

Recientemente, la relación entre campo magnéticos y materia densa está atrayendo la atención de los astrofísicos, especialmente después de las observaciones de emisiones peculiares de pulsares anómalos de rayos X, que se interpretan como ENs en rotación, y de emisiones de radiación γ de baja energía de los llamados repetidores de rayos γ suaves ( SGRs – soƒt gamma-ray repeaters ). El motor central de esas radiaciones podría ser un campo magnético mayor que 4 x 10¹³ Gauss, que es el campo crítico previsto por la Electrodinámica Cuántica.

Muchas observaciones astronómicas indirectas sólo se explicarían a través de la existencia de campos magnéticos muy intensos en los núcleos de ENs en EQs, de manera que el papel que el campo magnético en la ME aún constituye un problema abierto y de sumo interés en la Astrofísica.

En particular, en un trabajo reciente, se ha analizado la ME considerando neutralidad de carga, equilibrio β y conservación del bariónico. En dicho trabajo se obtuvo una cota superior para el valor del campo magnético que determina una transición de fase cuya explicación requiere ser estudiada en profundidad ya que sería independiente de la interacción fuerte entre los quarks. También se ha comprobado que la presencia de de campos magnéticos intensos favorece la estabilidad de la ME.

Por otro lado, estudios teóricos han demostrado que si la materia es suficientemente densa, la materia de quarks deconfinada podría estar en un estado superconductor de color. Este estado estaría formado por pares de quarks, análogos a los pares de Cooper (constituidos por electrones) existentes en los superconductores ordinarios.

Los quarks, a diferencia de los electrones, poseen grados de libertad asociados con el color, el sabor y el espín. Por este motivo, dependiendo del rango de densidades en el cual estamos trabajando, algunos patrones de apareamiento pueden verse favorecidos generando la aparición de distintas fases superconductoras de color. Según estudios teóricos, la fase superconductora más favorecida a densidades extremadamente altas sería la Color Flavor Locked (CFL), en la cual los quarks u, d y s poseen igual momento de Fermi, y en el apareamiento participan los tres colores y las dos proyecciones de espín de cada uno de ellos. Estudios recientes sobre la fase CFL han incluido los efectos de campos magnéticos intensos, obteniendo que bajo determinadas el gas superconductor, que corresponde a la separación entre bandas de energía en el espectro fermiónico, crece con la intensidad del campo. A esta fase se la llama Magnetic Color Flavor Locked (MCFL).

Son muchos los misterios que contiene el Universo y, nosotros, debemos recorrer los caminos para desvelarlos.

En la superconductividad electromagnética usual, un campo magnético suficientemente fuerte destruye el superconductor. Para la superconductividad de color no existe aún un consenso de cómo, la presencia del campo magnético, podría afectar al apareamiento entre los quarks.

En este describiremos brevemente la materia extraña, con el objetivo de explicar su formación en el interior de una EN y entender la composición y características de una EQ. Posteriormente, utilizaremos el modelo fenomenológico de bag del Massachussets Institute of Technology (MIT) para encontrar las ecuaciones de estado de la ME en condiciones determinadas, comprobando la estabilidad de la misma, frente a la materia de quarks ordinaria formada sólo por quarks u y d. Presentaremos, además, algunas candidatas posibles a EQs según observaciones astrofísicas. Por último, trataremos de entender la superconductividad de color y la influencia del campo magnético intenso en las fases superconductoras.

Materia de Quarks:

Uno de los mayores logros alcanzados por los físicos en el último siglo, fue la construcción del Modelo Estándar en la física de partículas elementales. Este modelo sostiene que la materia en el Universo está compuesta por fermiones, divididos en quarks y leptones, que interactúan a través de los llamados bosones de calibre: el fotón (interacción electromagnética), los bosones W± y Zº (interacción débil), y 8 tipos de gluones (interacción fuerte). Junto con los bosones de calibre, existen tres generaciones de fermiones: ( v e, e ), u, d ); ( vµ, µ ), ( c, s ) ; ( v….); y sus respectivas antipartículas. Cada “ sabor “ de los quarks, up ( u ), down ( d ), charme ( c ), strange ( s , top ( t ) y bottom ( b), tiene tres colores ( el color y el sabor son números cuánticos ). La partícula que aún no ha sido descubierta experimentalmente es el bosón de Higgs, que cabe suponer sería responsable del origen de la masa de las partículas.

Muchos son los científicos que buscan respuestas

Los quarks son los componentes fundamentales tanto de los hadrones fermiónicos (bariones formados por la combinación de tres quarks) como de los bosónicos (mesones formados por un quark y un antiquark). ES sabido que el núcleo de un átomo está compuesto por nucleones (protones y neutrones) que a su vez están compuestos por quarks (protón = udd). David Gross y Franks Wilczek y David Politzer, descubrieron teóricamente que en la CDC el acoplamiento efectivo entre los quarks disminuye a medida que la energía entre ellos aumenta (libertad asintótica). La elaboración de teoría permitió que recibieran el Premio Nobel de Física en el año 2004. En los años 60, la libertad asintótica fue comprobada experimentalmente en el acelerador lineal de Stanford ( SLAC ).

Sin embargo, la CDC no describe completamente el desconfinamiento en un régimen de alta densidad y baja temperatura, debido a su complejidad matemática y a su naturaleza no lineal bajas energías. No obstante, es posible recurrir a una descripción fenomenológica para intentar entender la física de la formación de la materia de quarks en las ENs. La materia de quarks, es decir, el plasma de quarks deconfinados y gluones, es una consecuencia directa de la libertad asintótica cuando la densidad bariónica o la temperatura son suficientemente altas como para considerar que los quarks son partículas más fundamentales que los neutrones o protones. Esta materia, entonces, dependiendo de la temperatura y del potencial químico (µ) de los quarks, aparecería esencialmente en dos regímenes. Uno de ellos, el PQG, constituiría la fase “caliente” de la materia de quarks cuando T >> µ constituyendo la mencionada ME, que se formaría en el interior de las Ens. Esta transición de fase estaría ocurriendo en el Universo cada vez que una estrella masiva explotara en de supernova, con la consecuente aparición de una EN.

Las estrellas de Quarks, aunque de momento son una conjetura su existencia, hasta donde podemos saber, no sería nada extraña que, en cualquier momento, se pudieran algunas y, pasarían a engrosar la lista de los objetos más masivos del Universo. Ellas estarían entre las estrellas de Neutrones y los Agujeros Negros.

En 1971 A.R. Bodmer propuso que la ME es más estable que el Fe, que es el más estable de todos los núcleos ordinarios. Por lo tanto, según su hipótesis, la ME constituía el más fundamental de la materia. En la Naturaleza, la presencia de núcleos atómicos ordinarios. Por lo tanto, según su hipótesis, la ME constituía el estado más fundamental de la materia. En la Naturaleza, la presencia de núcleos atómicos ordinarios no se halla en contradicción con la mayor estabilidad que presenta la ME. Esto se debe a que la conversión de un núcleo atómico en ME, requiere que se transformen quarks u y d en quarks extraños s. La probabilidad de que esto ocurra involucra una transición débil que hace que los núcleos con peso atómico A ≥ 6 sean estables por más de 1060 Años.

De manera que si la hipótesis de la ME fuera correcta, estaríamos en presencia del estado más estable de la materia hadrónica y su formación se necesitaría un ambiente rico en quarks s o la formación de un PQG, Como ya mencionamos, podríamos alcanzar dicho estado en las colisiones de iones pesados relativistas, segundos después del Big Bang en el Universo primordial y en el interior de las Ens.

A) Formación de Materia Extraña en una Estrella de Neutrones:

Inmediatamente después de la transición de fase hadrónquark en el interior de la estrella, no existe una configuración de equilibrio químico los quarks. Esto puede entenderse de la siguiente : en el punto de transición, la materia bariónica predominante son los quarks u y d con una pequeña cantidad de electrones. Así, la densidad del quark d es aproximadamente dos veces la densidad del quark u, Nd ~ 2Nu, debido al hecho de que la materia en las estrellas compactas es eléctricamente neutra. Por el principio de exclusión de Pauli, sería energéticamente más favorable los quarks d decaer en quarks s hasta restablecer el equilibrio entre sabores vía interacciones débiles. Dado que la densidad bariónica de la materia de quarks en el interior de la estrella sería ~ 5ρ0, los potenciales químicos de los quarks deberían ser grandes respecto de las masas. Esto implicaría que las densidades de los quarks fueran prácticamente iguales. De esta forma, la configuración más estable en el interior de la EN, sería un núcleo de ME con una densidad bariónica Nb = Ni ( i= u , d, s ). Si el interior de una EN estuviese compuesto por ME, cabe entonces preguntarnos: ¿podría transformarse una EN en una EQ?

los astrónomos ha quedado bien establecido que el remanente estelar después de la explosión de una supernova podría resultar ser una Enana Blanca, una En o un Agujero Negro, dependiendo de la masa de la estrella de origen. Observaciones astronómicas recientes sugieren un remanente aún más exótico: las EQs. La idea de la existencia de estas estrellas apareció en 1969, cinco años después de la predicción de Gell- Mann de la existencia de los quarks. En el año 1984, Farhi y Jaffe, basándose en el modelo de bag del MIT, mostraron en sus cálculos que la energía por barión de la ME era menor que la del núcleo atómico más estable, el Fe. Esto daba mayor solidez a la hipótesis de Bodmer- Witten e inmediatamente se comenzaron a desarrollar modelos teóricos de Eqs. En el año 2002, el Observatorio de Rayos X Chandra, de la NASA, reportó el descubrimiento de dos estrellas candidatas a ser Eqs.

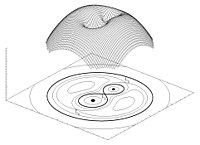

Para que una EN se transforme en una EQ pura, necesitamos algún mecanismo mediante el cual su densidad aumente cada vez más. Pensemos, por ejemplo, que la EN parte de un sistema binario. Para considerar que dos estrellas están en un sistema binario, debe analizarse su proximidad comparando el tamaño de las mismas con el radio del lóbulo de Roche, que es la región que define el campo de la acción gravitatoria de una estrella sobre otra.

Si el radio de cada estrella es menor que el lóbulo de Roche, las estrellas están desconectadas. Por el contrario, si una de ellas llena el lóbulo de Roche, el sistema es semi-conectado y la materia puede fluir a través del punto de Lagrange interno. El potencial gravitatorio de un sistema binario se consume la masa de la estrella compañera. Cuando la masa de la EN alcanza el valor de ~2 M (M corresponde a la masa solar), sufre un colapso gravitatorio, pudiéndose transformar en una EQ.

¿Podría el colapso de una supernova dar origen a la formación de una EQ? pregunta nos conduce a otra hipótesis teórica acerca de la formación de la EN, hay conservación del momento angular. La proto-estrella de neutrones tiene una fracción pequeña de su radio original, que era el de la supernova, por lo que su momento de inercia se reduce bruscamente. Como resultado, la EN se con una altísima velocidad de rotación que disminuye gradualmente. Los períodos de rotación se hacen cada vez más largos debido a la pérdida de energía rotacional por la emisión de vientos de electrones y positrones y de la radiación bipolar electromagnética. Cuando la alta frecuencia de rotación o el campo electromagnético alcanzan un valor crítico, la EN se transforma en un pulsar que emite pulsos del orden de los milisegundos. Debido a la enorme fuerza centrífuga en estos objetos, la estructura interna se modifica, pudiendo alcanzar una densidad crítica por encima de la que corresponde a la transición de fase hadrón-quark. En estas , la fase de materia nuclear relativamente incomprensible se convertiría en la fase de ME, más comprensible, cuyo resultado final sería la aparición de una EQ.

La identificación de una EQ requiere señales observacionales consistentes. Con esto nos referimos a propiedades físicas de la estrella tales como su masa máxima, radio, período mínimo de rotación, enfriamiento por emisión de neutrinos. Todas estas propiedades dependen de una única ecuación de para la materia densa de quarks que aún no ha sido completamente establecida. Sin embargo, existe un rango de valores aceptados para las cantidades antes mencionadas, con base en observacionales recientes, que marcarían importantes diferencias entre las posibles Eqs y los demás objetos compactos.

Un rasgo característico de las Eqs es que la materia no se mantendría unida por la atracción gravitacional, como ocurre en las Ens, sino que sería consecuencia directa de la interacción fuerte entre los quarks. En este caso, la estrella se dice auto-ligada. Esto implica una diferencia sustancial entre las ecuaciones de estado para las dos clases de estrellas. Las correcciones perturbativas a la ecuación de estado de la materia de quarks y los efectos de superconductividad de color complican aun más este punto. Otra característica para poder diferenciar las Eqs de las Ens es la relación entre su masa M y el radio R. Mientras que para una EQ, M ~ R³. De acuerdo con relación, las Eqs tendrían radios más pequeños que los que usualmente se le atribuyen a las Ens. Además, las Eqs violarían el llamado límite de Eddington. Arthur Eddington (1882-1994) observó que las fuerzas debido a la radiación y a la gravitación de las estrellas normales dependían del inverso del cuadrado de la distancia. Supuso, entonces, que ambas fuerzas podían estar relacionadas de algún modo, compensándose para que la estrella fuera más estable. Para estrellas de altísima masa, la presión de radiación es la dominante frente a la gravitatoria. Sin embargo, debería existir una presión de radiación máxima para la cual la fuerza expansiva debido a la radiación se equilibrara con la gravedad local. Para una estrella normal, el límite de Eddington está dado por una ecuación que omito para no hacer más complejo el tema.

Para cualquier valor de radiación que supere este límite, no habrá equilibrio hidrostático, causando la pérdida de masa de la estrella normal. El mecanismo de emisión en una EQ produciría luminosidades por encima de dicho límite. Una posible explicación a este hecho sería que la EQ es autoligada y por lo tanto su superficie alcanzaría temperaturas altísimas con la consecuente emisión térmica.

Por otro lado, una alternativa para explicar algunas observaciones de destellos de rayos γ, sería suponer que las emisiones provienen de Eqs con radios R ~ 6 km, valores demasiados pequeños si pensáramos que los destellos provienen de ENs.

En sección, hemos presentado algunas características de las Eqs que las diferenciarían de las Ens. Futuras evidencias experimentales y observacionales nos permitirían saber si las Eqs realmente existen en la naturaleza.

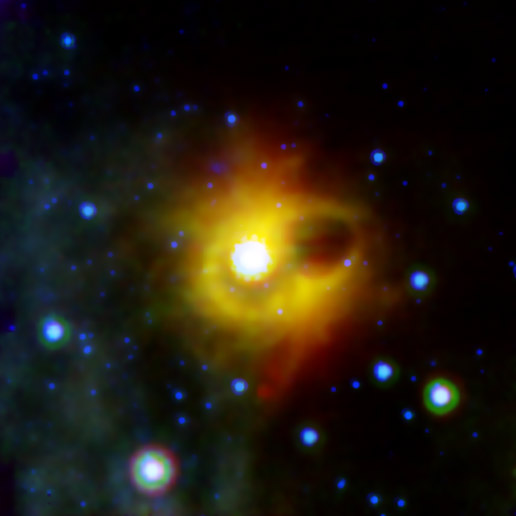

Observaciones astrofísicas: posibles Eqs

El mes de febrero de 1987 fue la primera oportunidad de poner a prueba, a través de las observaciones directas, las teorías modernas sobra la formación de las supernovas. En el observatorio de Las Campanas, en Chile, fue observada la Supernova 1987A en la Gran de Magallanes. Algunas características de la emisión de neutrinos de la SN 1987ª, podrían explicarse sin una hipotética fuente de energía subnuclear como la ME contribuyera a su explosión. El remanente estelar que ha quedado como consecuencia de la explosión de la Supernova 1987ª, podría ser una EQ, ya que el período de emisión de este pulsar es de P= 0.5 ms. Una EN canónica no podría tener una frecuencia de rotación tan alta.

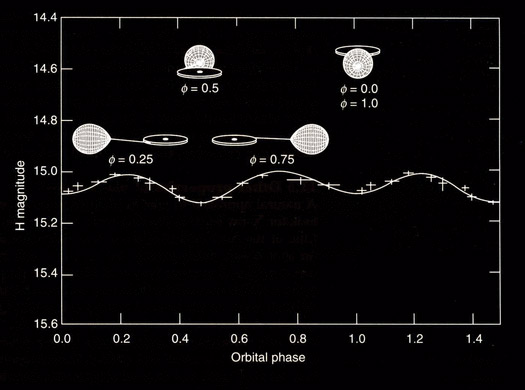

El observatorio Chandra de rayos X de la NASA también encontró dos estrellas inusuales: la fuente RX J1856.5-3754 con una temperatura de 10 exp5. K y la fuente 3C58 con un período de 65 ms. RX J1856.5-3754 es demasiado pequeña ser una EN convencional y 3C58 parece haberse enfriado demasiado rápido en el tiempo de vida que se le estima.

Combinando los del Chandra y del telescopio espacial Hubble, los astrónomos determinaron que RX J1856. 5 – 3754 radia como si fuera un cuerpo sólido con una temperatura de unos 1x 10 exp5. ºC y que tiene un diámetro de alrededor de 11 km, que es un tamaño demasiado pequeño como para conciliarlo con los modelos conocidos de las Ens.

Las observaciones realizadas por el Chandra sobre 3C58 también produjeron resultados sorprendentes. No se pudo detectar la radiación que se esperaba en la superficie de 3C58, una EN que se cree producto de la explosión de una supernova vista por astrónomos japoneses y chinos en el año 1181 de nuestra era. Se llegó a la conclusión de que la temperatura de la estrella, de menos de un millón de grados Celsius, era un valor mucho menor que el que predice el modelo. Estas observaciones incrementan la posibilidad de que los objetos estelares mencionados sean Eqs.

Ecuación de para la materia de quarks:

Las técnicas utilizadas para resolver las ecuaciones de la CDC no proveyeron aún un resultado aceptable para densidades bariónicas finitas como en el caso de la Electrodinámica Cuántica para el núcleo atómico. Como consecuencia, es necesario recurrir a modelos fenomenológicos para describir la materia de quarks dentro de las estrellas compactas cuando se consideran las propiedades de confinamiento y de libertad asintótica de la CDC. Uno de los modelos más usados es el modelo bag del MIT. En este modelo los hadrones son considerados como quarks libres confinados en una región finita del espacio: el “Bag“ o bolsa. El confinamiento no es un resultado dinámico de la teoría fundamental, sino que se coloca como parámetro libre, imponiendo de contorno apropiadas. Así, el modelo bag del MIT se basa en una realización fenomenológica del confinamiento.

Está claro que, las estrellas de Quarks, aunque con certeza no han sido aún detectadas, es casi seguro que andarán pululando por el inmenso Universo que, en relación a la materia bariónica, en muy buena parte, está conformado por Quarks.

Fuente: Revista de la RSEF