Oct

3

¿Que pinta el Azar en todo esto?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Catástrofes Naturales ~

Clasificado en Catástrofes Naturales ~

Comments (1)

Comments (1)

Sí, la Naturaleza nos muestra constantemente su poder. Fenómenos que no podemos evitar y que nos hablan de unos mecanismos que no siempre comprendemos. Nuestro planeta por ejemplo, se comporta como si de un ser vivo se tratara, la llaman Gaia y realiza procesos de reciclaje y renovación por medio de terremotos y erupciones volcánicas, Tsunamis y tornados debastadores que cambian el paisaje y nosotros, lo único podemos hacer es acatar el destino que ignoramos de lo que está por venir.

El mundo nos parece un lugar complicado. Sin embargo, existen algunas verdades sencillas que nos parecen eternas, no varían con el paso del tiempo (los objetos caen hacia el suelo y no hacia el cielo, el Sol se levanta por el Este, nunca por el Oeste, nuestras vidas, a pesar de las modernas tecnologías, están todavía con demasiada frecuencia a merced de complicados procesos que producen cambios drásticos y repentinos. La predicción del tiempo atmosférico es más un arte que una ciencia, los terremotos y las erupciones volcánicas se producen de manera impredecible y aparentemente aleatoria, los cambios en las Sociedades fluctuan a merced de sucesos que sus componentes no pueden soportar y exigen el cambio.

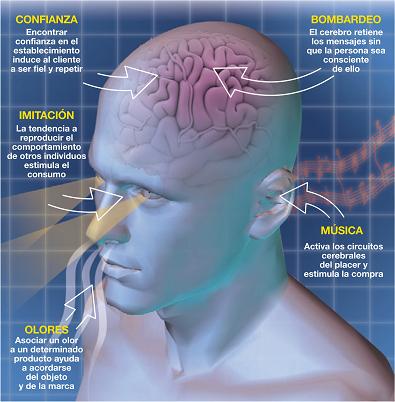

La inmensa complejidad que está presente en el cerebro humano y de cómo se genera lo que llalamos “la mente”, a partir de una maraña de conexiones entre más de cien mil millones de neuronas, más que estrellas existen en nuestra Galaxia, la Vía Láctea. Es algo grande que, en realidad, no hemos alcanzado a comprender.

La mente humana es de tal complejidad que no hemos podido llegar a comprender su funcionamiento. ¿Por qué unas personas tienen una gran facilidad para tocar el piano, otros para comprender las matemáticas complejas y algunos para ver lo que nadie ha sido capaz de detectar en el ámbito de la Naturaleza, pongamos por ejemplo un paisaje, o, llegar a comprender fenómenos físicos que configuran el mundo, el Universo y la vida?

Es precisamente a escala humana, donde se dan las características (posiblemente) más complejas del Universo, las que se resisten más a rendirse ante métodos y reglamentos fijos que las pretenda mantener estáticas e inamovibles por el interés de unos pocos. Las Sociedades son dinámicas en el tiempo y en el espacio y, su natural destino es el de evolucionar siempre, el de buscar las respuestas a cuestiones patra ellas desconocidas y que al estar inmersas en el corazón de la Naturaleza, se sirven de la Ciencia para poder llegar al lugar más secreto y arrancar esas respuestas que tánto, parecen necesitar para continuar hacia el futuro.

Claro que, ese futuro, no depende de esas Sociedades Humanas que de alguna manera, están a merced de sucesos como aquel de Yucatán, cuando al parecer, hace ahora 65 millones de años, perecieron los Dinosaurios que reinaron en el Planeta durante 150 millones de años hasta que llegó aquél fatídico (para ellos) pedrusco que, en realidad, posibilitó nuestra llegada.

Aquellos terribles animales que poblaban la Tierra hubiera hecho imposible nuestra presencia en el planeta. Formas de vida incompatibles con nuestra especie que desaparecieron -según parece- por causas naturales venidas del espacio exterior para que más tarde, pudiéramos nosotros hacer acto de presencia en el planeta que nos acoge.

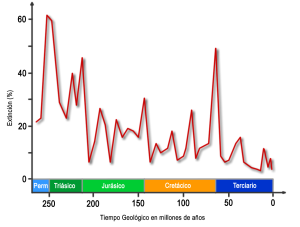

Aquello se considera una extinción masiva ocurrida en la Tierra, algo tan claramente reflejado en el registro fósil que se utiliza para marcar el final de un período de tiempo geológico, el Cretáseo, y el comienzo de otro, el Terciario. Puesto que la “C” ya se ha utilizado como inicial en un contexto similar en relación con el período Cámbrico, este marcador se suele denominar frontera K-T, con una “K” de Kreide, que es el nombre del Cretáceo en alemán. No fueron solos los dinosaurios los que resultaron afectados, aunque son los que aparecen con mayor protagonismo en los relatos populares cuando se habla de este desastre.

Esqueletos de dinosaurios expuestos en el Museo Real de Ontario, Canadá.

Alrededor del 70 por ciento de todas las especies que vivían en la Tierra al finales del cretáceo habian desaparecidos a principios del Terciario, lo cual indica que se trató realmente de una “extinción en masa” y explica por qué los geólogos y los paleontólogos utilizan la frontera K-T como un marcador importante en el registro fósil. Dadas las dificultades que plantean unas pruebas de tiempos tan remotos, y la lentitud con la que se acumulan los estratos geológicos, todo lo que podemos decir realmente sobre la velocidad a la que se produjo aquella extinción es que sucedió en menos de unas pocas decenas de miles de años, pero en ningún caso durante muchos millones de años; sin embargo, esto se considera un cambio brusco en relación con la escala de tiempo utilizada en geología.

Las preguntas obvias que esto plantea son las mismas que surgen tras un gran terremoto -por qué sucedió, y si podría suceder de nuevo y, en su caso, cuándo- En el caso del suceso K-T hay un candidato muy adecuado para ser el desencadenante que hizo que la extinción se produjera, por ejemplo, hace 60 0 55 millones de años. Los restos del enorme cráter que data justo de entonces ha sido descubierto bajo lo que es ahora la península de Yucatán, en Méjico, y por todo el mundo se han hallado estratos de hace 65 millones de años que contienen restos de iridio, un metal pesado que es raro en la corteza terrestre, pero del que sabemos que es un componente de algunos tipos de meteoritos. La capa de iridio es tan delgada que tuvo que depositarse en menos de 10.000 años (quizá mucho menos), lo cual es coherente con la teoría de que el suceso K-T fue desencadenado en su totalidad, de manera más o menos instantánea, por un gran golpe que llegó del espacio interestelar.

La catástrofe está servida

No sería difícil explicar por que pudo suceder todo esto. La energía cinética contenida en un impacto de este calibre sería equivalente a la explosión de unos mil millones de megatoneladas de TNT y arrojaría al espacio unos detritos en forma de grandes bloques que se desplazarían siguiendo trayectorias balísticas (como las de los misiles balísticos intercontinentales) y volverían a entrar en la atmósfera por todo el globo terráqueo, difundiendo calor y aumentando la temperatura en todas las regiones. Se produciría un efecto de calentamiento de 10 kilowatios por cada metro cuadrado de la superficie terrestre durante varias horas, un fenómeno que ha sido descrito gráficamente por Jay Melosh. A continuación, unas diminutas partículas de polvo lanzadas al interior de la parte superior de la atmósfera se extendería alrededor del todo el planeta y, combinada con el humo de todos los incendios desencadenados por el “asado a la parrilla”, bloquearían el paso de la luz del Sol, causando la muerte de todas las plantas que dependían de la fotosíntesis y congelando temporalmente el planeta.

Si el planeta se congela, ¿dónde nos meteremos? ¿cuántas criaturas tendrán la oportunidad de sobrevivir?

Hay pruebas de que, en épocas pasadas, la Tierra sufrió visitas inesperadas desde el espacio que trajo muerte y desolación. Hace unos 35 millones de años, la Tierra soportó unos impactos parecidos sin que se produjera una extinción del calibre del suceso K-T. Aunque los factores desencadenantes tengan la misma magnitud. Por otra parte, existen pruebas de que los Dinosaurios y otras especies estaban ya en decadencia en los dos últimos millones de años del Cretáceo. Parece que los grandes lagartos habían experimentado altibajos durante los 150 millones de años que se pasaron vagando por la Tierra. Hay opiniones para todos y algunos dicen que su desparición se debió, en realidad, al aumento del Oxígeno en nuestra atmósfera.

El suceso K-T es en realidad sólo una entre cinco catástrofes similares (en la medida en que afectó en aquella época a la vida en la Tierra) a las que los geólogos denominan en conjunto las “cinco grandes” -y no es en absoluto la mayor-. Cada una de ellas se utiliza como marcador entre períodos geológicos y todas han sucedido durante los últimos 600 millones de años.

La razón por la que nos centramos en este pasado geológico relativamente reciente es que fue en esa época cuando los seres vivos desarrollaron por primera vez algunas características, tales como las conchas, que podían fosilizarse fácilmente, dejando rastros que pueden reconocerse en los estratos que se estudian en la actualidad.

Nuevas especies de fósiles de invertebrados marinos, que vivieron hace 465 millones de años, se han hallado en diversos yacimientos de la provincia de Ciudad Real en España, y, por todas partes del mundo, si se profundiza en la Tierra, se encuentran fósiles y conchas de tiempos pasados. En la imagen recreada arriba se recoge el descubrimiento especies nuevas, de animales marinos con concha que han posibilitado su hallazgo después de tantos millones de años.

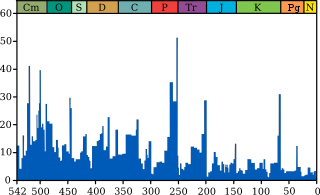

Pero centrémonos en las “cinco grandes extinciones” que, tomándolas cronológicamente se produjeron hace unos 440 millones de años (que marcaron la frontera entre los períodos Ordovícico y Silúrico), hace 360 millones de años (entre el Devónico y el Carbonífero), 250 millones de años (entre el Pérmico y el Triásico), 215 millones de años (en la frontera entre el Triásico y el Jurásico) y 65 millones de años (en la frontera K-T).

Millones de años

Intensidad de la extinción marina a través del tiempo. El gráfico azul muestra el porcentaje aparente (no el número absoluto) de los géneros de animales marinos extintos durante un determinado intervalo de tiempo. Se muestran las ultimas cinco grandes extinciones masivas.

Hay otras muchas extinciones en el registro fósil pero, las más importantes son las mencionadas. La más espectacular de todas ellas es el suceso que tuvo lugar hace unos 250 millones de años, al final del Pérmico. Se extinguieron al menos el 80 por ciento, y posiblemente hasta el 95 por ciento, de todas las especies que vivían en nuestro planeta en aquellos tiempos, tanto en la tierra como en los océanos, y lo hizo durante un intervalo de menos de 100.000 años. Sin embargo, dado que también se calcula que el 99 por ciento de todas las especies que han vivido en la Tierra se han extinguido, esto significa que son el doble las que han desaparecido en sucesos de -aparente- menor importancia.

La cuestión que nos intriga es si las extinciones en masa son realmente acontecimientos especiales, de carácter diferente al de las extinciones de menor importancia, o si son el mismo tipo de suceso, pero a gran escala -¿son las extinciones de vida en la Tierra unos hechos cuya naturaleza es independiente de su magnitud, como los terremotos y todos los demás fenómenos que la Naturaleza nos envía periódicamente que dan lugar a catástrofes y pérdidas de muchas vidas? La respuesta sincera es “no lo sabemos”, pero hay bastantes evidencias como para intuir que ésta es una posibilidad muy real.

El logotipo del Movimiento por la Extinción Humana Voluntaria es un globo terráqueo sobre el que aparece la letra V y sobre ella otra pequeña tierra y el acrónimo VHEMT de Voluntary Human Extinction Movement.

Gracias a un meticuloso trabajo de investigación de Jack Sepkoski, de la Universidad de Chicago que, pudo trazar un gráfico en el que mostraba como ha fluctuado durante los últimos 600 millones de años el nivel de extinciones que se produjo en cada intervalo de cuatro millones de años.

Extinciones segun Sepkoski

El gráfico nos muestra que la muerte de los dinosaurios fue también la muerte de los invertebrados marinos. La pregunta que se puede plantear es que clase de aleatoriedad es ésta, si realmente son sucesos aleatorios. Resulta que es una ley potencial -nuestro viejo amigo, el ruido 1/f-. El origen de esta señal aleatoria, de enorme interés por su ubicuidad y propiedades matemáticas, sigue siendo un misterio, a pesar de la atención que se le ha dedicado.

Ahora bien, no parece probable que todas las extinciones de vida que han sucedido en la Tierra hayan tenido como causa impactos procedentes del espacio. Lo que parece estar diciéndonos el registro fósil es que las extinciones se producen en todas las escalas, todos los tiempos, y que (como en el caso de los terremotos) puede producirse una extinción de cualquier magnitud en cualquier época. Algunas extinciones podrían ser desencadenadas por impactos de meteoritos; otras, por períodos glaciares. Una cosa sí que nos queda clara: es necesario un gran desencadenante para que ocurra un gran suceso, y, no podemos olvidar que estamos inmersos en un Sistema Complejo -la vida en la Tierra- que es autoorganizador, se alimenta a partir de un flujo de energía, y existe al borde del Caos. Si comprendemos eso, estaremos preparados para entender lo que todo esto significa para la vida en sí misma, siempre expuesta a las fuerzas del Universo.

Por otra parte, a lo largo de nuestra Historia hemos conocido situaciones de muertes masivas como por ejemplo: La Peste de la Guerra del Peloponeso (430 a.C.), La Plaga Antonina (165 y 180), La Plaga de Justiniano (541 y 542), La Peste Negra (1348 y 1350), o, La Gripe Española (1918) y, todas ellas son en realidad de origen desconocido. Esto me lleva a pensar que la Tierra, nuestro planeta, viaja por el espacio como una gran nave espacial y recorre regiones interestelares en las que no sabemos qué puede haber, y, ¿quién puede negar que al atravesar esas regiones, no estén presenten en esllas esporas fuertemente acorazadasa contra la radiación que, atravesando la atmósfera terrestre se instalen tan ricamente en nuestro mundo para florecer y sembrar la muerte entre nosotros? Lo cierto es que son muchas las cosas que no sabemos.

De todas las maneras, no podemos negar que grandes cambios nos acechan y, como la medida del “tiempo” es distinta para la escala humana que para la del Universo, en cualquier momento podrá tener lugar un acontecimiento de índole diversa (la caída de un meteorito, una pandemia debastadora, cataclismos tectónicos de gran magnitud, explosiones supernovas de inmensa intensidad que barra nuestra atmósfera y siembre de radiación el planeta…) que vendrá a transformar todo lo que nosotros consideramos importante y que, para la Naturaleza, no es nada.

De todas las maneras, en una cosa sí tenemos que estar de acuerdo: ¡La vida! Esa cosa tan frágil pero tan fuerte, se ha resistido a desaparecer a lo largo de los millones de años que lleva en el planeta y, eso nos lleva a sospechar que, lo mismo habrá sucedido en otros lugares y la Vida, debe estar por todas partes… ¡A pesar de todo!

emilio silvera

La fuente de la mayor parte del contenido de este trabajo, hay que buscarla en los pensamientos del maestro J. Gribbin, un Astrofísico de nuestro tiempo.

Oct

3

¡Nuestras Mentes! ¿Estarán predestinadas?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Vida ~

Clasificado en El Universo y la Vida ~

Comments (0)

Comments (0)

Vivimos en un mundo hecho para la Vida

Algunas veces, mirando la historia evolutiva de la vida, uno tiende a pensar que, de todas las estructuras complejas producidas por la biología terrestre (es lo único que conocemos), ninguna es más importante que el cerebro, el más complejo de todos los órganos. Lo que nos lleva a plantearnos una prgunta: ¿Son los cerebros sólo accidentes aleatorios de la evolución, o son los unevitables productos derivados de un proceso de complejificación que sigue unas leyes? Una hipótesis muy generalizada es que si surge la vida en otros planetas, ésta tendrá un desarrollo muy similar al de la vida en nuestro planeta, la Tierra. Los defensosres de SETI, la bísqueda de inteligencia estraterrestre, argumentan que en el curso de miles de años la vida estraterrrestre se hará más compleja para formar plantas y animales, y finalmente descubrirá su cognición y la inteligencia, como sucedió aquí. Eso en los planetas que estén en evolución y, en otros, evolucionados como la Tierra, la vida ya estará presente.

Hablamos del cerebro humano por ser el “desconocido” mejor conocido, muchas son las inteligencias que están presentes en nuestrto planeta y que, no hemos podido llegar a conocer. De algunos animales, podemos haber vislumbrado alguna clase de inteligencia y, si me apuran, hasta de sentimientos pero, lo que se dice conocer lo que se puede fraguar en sus cerebros…, es una gran incognita para nosotros que, somos los seres predominantes en el planeta y, además de ser conscientes hemos llegado a presentir que tenemos “Alma”, algo tan complejo que, siendo portadora de los sentimientos y los pensamientos, es, sin embargo, inmaterial y eterea. Eso que llamamos Alma es en realidad la sabiduría, la que nos lleve a comprender sobre las cosas, sobre el mundo, sobre el Universo y, también sobre la misma condición humana.

El cerebro es de una complejidad tal que, no hemos podido llegar a comprender toda su grandeza, y, sabemos que rige todo lo que acontece en nuestros cuerpos, desde él se emiten las ordenes necesarias para hacer los precisos movimientos, para hablar o correr, o, en otros casos, para pensar y generar pensamientos y…

también sentimientos que, en realidad y a través del Amor y la Familia, es el verdadero motor que mueve el mundo en el que vivímos, es el mayor incentivo que tenemos para luchar y seguir adelante en la dura batalla que, la Naturaleza y la Vida, nos plantea cada día.

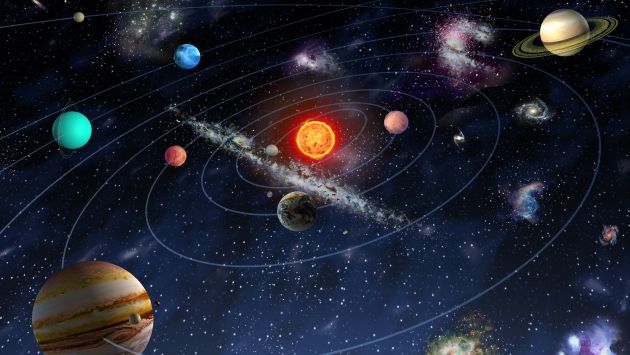

Decíamos que en otros planetas (al menos en una fracción de todos los planetas presentes en las galaxias), también habrá surgido y evolucionado la vida inteligente que, como la nuestra, habrá avanzado y desarrollado su propia tecnología, e incluso algunas de esas comunidades tecnológicos pueden estar en este preciso momento tratando (como hacemos nosotros) de entrar en contacto con nosotros y con otras inteligencias dispersas a lo largo y a lo ancho del vasto Universo. Así pues, los investigadores de SETI suscriben generalmente la idea de la escala de progreso, al aceptar que no sólo la vida, sino también la mente, están en cierto sentido predestinadas a aparecer en el universo.

Así, el recipiente puede ser diferente pero, el cerebro portador de la mente, será parecido o similar al nuestro y se regirá por los mismos parámetros y funciones. Un inmenso entramado de neuronas y cogniciones que reciben, controlan y envían información que procesa para conocer el mundo exterior y comprender, su lugar en el Cosmos.

Claro que, este punto de vista, aunque dominante, esconde de nuevo una hipótesis enorme acerca de la naturaleza del Universo. Significa aceptar, de hecho, que las leyes de la naturaleza están “amañadas” no sólo a favor de la complejidad, o sólo a favor de la vida, sino también a favor de la Mente. Dicho de otra manera, creo que la Naturaleza misma es MENTE, de otra manera a mí me resulta muy difícil copmprender que la mente no esté inscrita de una fiorma fundamental en esas leyes naturales que todo lo rigen y hacen que las cosas ocurran como vemos que pasan. Es,así, altamente significativo, por supuesto, que los productos de la tendencia de complejificación de la naturaleza -seres inteligentes como el Homo Sapiens- sean capaces de entender lass propias leyes que han dado lugar al “entendimiento” si, esos sujetos, fueran totalmente ajenos a ella.

En cierta manera, tales pensamientos son visiones inspiradoras. Pero, ¿es verosímil? ¿Podemos que creer que el universo no sólo es bioamigable, sino también menteamigable. ¿Son tántos los mundos que, como la Tierra, tendrán las condiciones precisas para la vida? y, ¿Será la vida, toda la vida del Universo, basada, como la de la Tierra en el Carbono?

Claro que, en este apartado del saber humano, son muchas las versiones que, a lo largo de nuestra historia han sido vertidas. En 1964, el biólogo George Simpson escribió un artíoculo escéptico titulado “Sobre la no predominancia de los humanoides”, en el que reslataba la futulidad de la búsqueda de vida estraterrestre acanzada. Lo calificaba como “una apuesta contra las probabilidades más adversas de la historia”. Señalando que los seres humanos son el producto de innumerables incidentes históricos especiales, concluía:

“La hipótesis hecha tan abiertamente por astrónomos, físicos y algunos bioquímicos, según la cual una vez que la vida se pone en marcha en alguna parte, los humanoides aparecerán final e inevitablemente, es lisa y llanamente falsa”. En un famoso debate con el defensor de SETI Carl Sagan, el Biólogo Ernst Mayr se hacía eco del escepticismo de Simpson: “En la Tierra entre millones de linajes u organismos y quizá 50.000 millones de sucesos de especiación, sólo uno condujo a una alta inteligencia; eso me hace creer en su completa improbabilidad”.

¿De qué manera podría ser la vida en otros mundos? De haberla, podría ser ¡de tántas maneras! que no debemos descartar aquella que teniendo la condición de vida, incluso esté fuera de nuestro alcance de visión y, estándo a nuestro lado, sea totalmente ajena a nuestros sentidos. Las formas que la vida pueda tomar (aquí mismo en la Tierra somos testigos), son de múltiples fasetas, de diversas maneras y, hasta desconocidas. ¿quién conoce a todos los seres vivos que conviven con nostros en el aTierra?

Por otra parte, el especialista Jay Gould denuncia análogamente la idea de que la vida está destinada a producir mente. Imaginemos, dice él, que una catastrofe barriera toda la vida avanzada sobre la Tierra, dejando sólo microbios. Si se repitiera el drama evolutivo, ¿qué sucedería? ¿Cabría esperar una pauta de desarrollo básicamente similar, en la que volverían a emerger peses, vertebrados, mamíferos, reptiles y bípedos inteligentes? Nada de eso, concluye él. La historia de la vida sobre la Tierra es una loteria gigantesca, con muchos más perdedores que ganadores.

Muchas formas de vida pasada, ya no están aquí con nosotros. De hecho, sólo el 1% de las epecies que han poblado la Tierra viven actualmente y, tenemos que tener claro que, la única manera de evolucionar es mutar, sin mutaciones no hay evolución, dado que la dinámica del planeta es cambiante y nos exige una adaptación, aunque a lo largo de miles de años, nosotros y otros seres vivos mutan para sobrevivir.

La vida contiene tantos accidentes del destino, tántas carambolas arbitrarias que la pauta de cambnio es esencialmente aleatoria. Los millones de pasos fortuitos que construyen nuestra propia historia evolutiva nunca sucederían por segunda vez, ni siquiera en lineas generales. La historia recorrería “otro camino” , de modo que, “la enorme mayoría de las repeticiones nunca produciría…una criatura con autoconsciencia… La probabilidad de que este escenario alternativo (por ejemplo, repetición) contenga algo remotamente parecido a un ser humano debe ser practicamente nula”.

Claro que, las posibilidades de vida en otros planetas es grande

Si eso fuera así (que lo podría ser, ningún dato tenemos a favor de lo contrario), ¿qué seres surgirían a la vida? o, quizás, no surgiera ninguno. Es difícil refutar la lógica del argumento de Simpson y Gould. Si la evolución mno es otra cosa que una lotería, una caminata de borracho, entonces hay pocas razones por las que la vida debiera ir más allá del nivel de los microbios, ninguna expectativa que avanzara obligatoriamente hacia la inteligencia, el cerebro, la conciencia y al “Alma” y, mucho menos, que pudiera desarrollar características humanoides. Nos veríamos entonces obligados a coincidir con la melancólica conclusión de Monod: “El hombre sabe que finalmente está solo en la inmensidad del universo, del que ha emergido sólo por azar”.Sólo si hay más que azar en ello, , sólo si la Naturaleza tiene un sesgo ingeniosamente incorporado hacia la vida y la muerte, esperaríamos ver repetido en otros mundos, lo que con la vida ocurrió en el nuestro.

La búsqueda de la vida en otros lugares del Universo es, por consiguiente, el terreno de prueba para dos visiones del mundo diametralmente opuestas. Por una parte, está la ciencia ortodoxa, con su filosofía nihilista del universo sin sentido, leyes impersonales carentes de finalidad, un cosmos en el que la vida y la mente, la ciencia y el arte, la esperanza y el miedo son sólo embellecimientos accidentales y casuales en un tapiz de corrupción cósmica irreversible.

Creo que todo lo que podamos imaginar… será menos que la realidad que ahí fuera nos podemos encontrar cuando, de verdad, salgamos al espacio.

Por otra parte, hay una versión alternativa innegablemente romántica, pero posiblemente cierta de todas formas, la visión de un universo autoorganizador y autocomplejificador, gobernado por leyes ingeniosas que animan a la materia para que ésta alcance una evolución predeterminada que la lleva hacia la consciencia y la mente. Un Universo en el que la emergencia de seres pensantes sería una parte fundamental e integral del esquema global de las cosas. Es decir, un Universo en el que no estamos solos y en el que, esa misma complejidad de la que hablamos, nos lleva a través de la mutación hacia la evolución necesaria para la adaptación al ritmo que el Universo nos marca.

Particularmente me quedo con la segunda opción. De no ser así, si el Universo nos trajo por razones fortuítas y sólo se debe al azar nuestra presencia aquí, entonces, ¿para qué tantos mundos?, ¿para qué tanto sufrimiento y dolor?, ¿para qué, en definitiva, tanto Amor y sacrificio? ¡Sería todo un sinsentido tan grande!

emilio silvera

PD. Doy las gracias a Paul Davies por escribir “El Quinto Milagro”, de cuyas páginas pude sacar algunas de estas ideas.

Oct

3

¡Aquellos primeros momentos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo ~

Clasificado en El Universo ~

Comments (0)

Comments (0)

Todo en el Universo tiene un principio y un final y, el mismo universo tuvo que nacer y evolucionar para que hoy podamos contemplar, mediante nuestros sofisticados telescopios, un universo en expansión lleno de galaxias que contienen estrellas nuevas y viejas estrellas, muchas de ellas rodeadas de mundos que, aún no hemos podido determinar de qué criaturas estarán poblados muchos de ellos.

¡El Universo!

Antes de alrededor de un minuto y cuarenta segundos desde el comienzo del tiempo, no hay núcleos atómicos estables. El nivel de energía en el ambiente es mayor que la energía de unión nuclear. Por consiguiente, todos los núcleos que se forman, se destruyen de rápidamente.

Alrededor de un segundo desde el comienzo del tiempo, llegamos a la época de desacoplamiento de los neutrinos. Aunque en esa época el Universo es más denso que las otras (y tan caliente como la explosión de una bomba de hidrógeno), ya ha empezado a parecer vacío a los neutrinos. Puesto que los neutrinos sólo reaccionan a la fuerza débil, que tiene un alcance extremadamente corto, pueden escapar de sus garras y volar indefinidamente sin experimentar ninguna otra interacción.

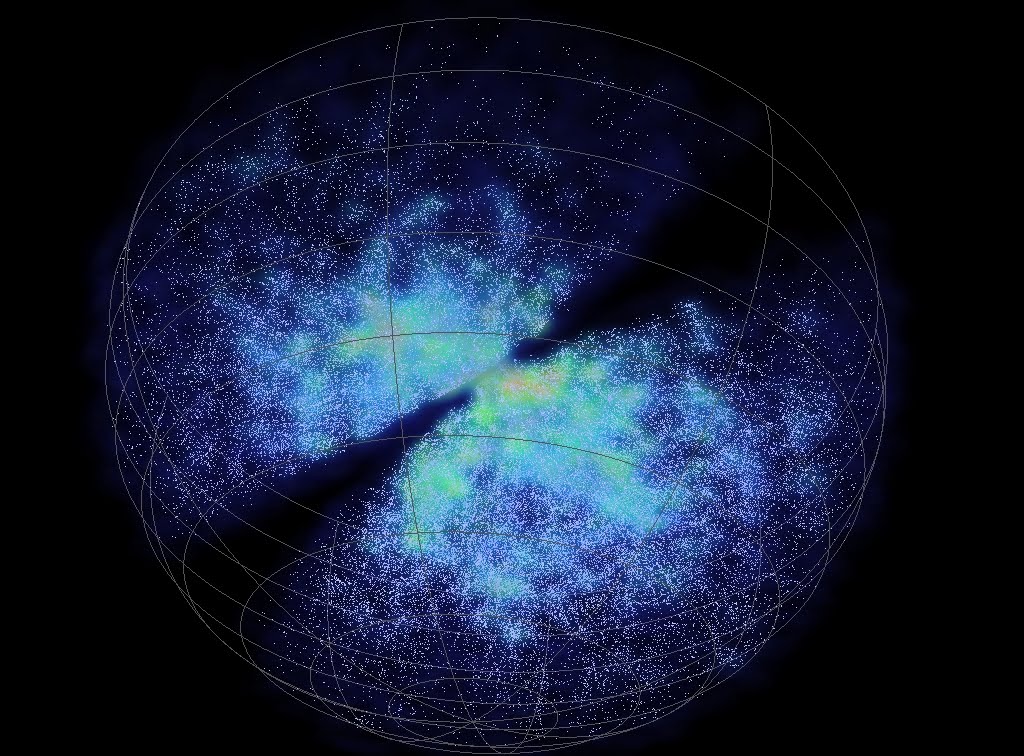

Aunque parezca mentira, al día de hoy no sabemos, a ciencia cierta, como se formaron las galaxias

Así, emancipados, en lo sucesivo son libres de vagar por el Universo a su manera indiferente, volando a través de la mayor de la materia como sino existiese. (Diez trillones de neutrinos atravesarán sin causar daños el cerebro y el cuerpo del lector en el tiempo que le lleve leer esta frase. Y en el tiempo en que usted haya leído esta frase estarán más lejos que la Luna).

En menos de un siglo, el neutrino pasó de una partícula fantasma – propuesta en 1930 por el físico austríaco Wolfgang Pauli (1900-1958) a explicar el balance de energía en una forma de radioactividad, el llamado decaimiento beta, en una sonda capaz de escrutar el interior de estrellas y de la propia Tierra.

De esa manera, oleadas de neutrinos liberados en un segundo después del big bang persiste aún después, formando una radiación cósmica de fondo de neutrinos semejante a la radiación de fondo de microondas producida por el desacoplamiento de los fotones.

Si estos neutrinos “cósmicos” (como se los llama para diferenciarlos de los neutrinos liberados más tarde por las supernovas) pudiesen ser observador por un telescopio de neutrinos de alguna clase, proporcionarían una visión directa del Universo cuando sólo tenía un segundo.

A medida que retrocedemos en el tiempo, el Universo se vuelve más denso y más caliente, y el nivel de estructura que puede existir se hace cada vez más rudimentario.

Por supuesto, en ese tiempo, no hay moléculas, ni átomos, ni núcleos atómicos, y, a 10-6 (0.000001) de segundo después del comienzo del tiempo, tampoco hay neutrones ni protones. El Universo es un océano de quarks libres y otras partículas elementales.

Si nos tomamos el de contarlos, hallaremos que por cada mil millones de antiquarks existen mil millones y un quark. La asimetría es importante. Los pocos quarks en exceso destinados a sobrevivir a la aniquilación general quark-antiquark formaran todos los átomos de materia del Universo del último día. Se desconoce el origen de la desigualdad; presumiblemente obedezca a la ruptura de una simetría materia antimateria en alguna etapa anterior.

Nos aproximamos a un tiempo en que las estructuras básicas de las leyes naturales, y no sólo las de las partículas y campos cuya conducta dictaban, cambiaron a medida que evolucionó el Universo.

La primera transición semejante se produjo en los 10-11 de segundo después del comienzo del tiempo, cuando las funciones de las fuerzas débiles y electromagnéticas se regían por una sola fuerza, la electrodébil. hay bastante energía ambiente para permitir la creación y el mantenimiento de gran de bosones w y z.

Estas partículas –las mismas cuya aparición en el acelerador del CERN verificó la teoría electrodébil– son las mediadoras intercambiables en las interacciones de fuerzas electromagnéticas y débiles, lo que las hace indistinguibles. En ese tiempo, el Universo está gobernando sólo por tres fuerzas: la gravedad, la interacción nuclear fuerte y la electrodébil.

Más atrás de ese tiempo nos quedamos en el misterio y envueltos en una gran nebulosa de ignorancia. Cada uno se despacha a su gusto para lanzar conjeturas y teorizar sobre lo que pudo haber sido. Seguramente, en el futuro, será la teoría M (de supercuerdas) la que contestará esas preguntas sin respuestas ahora.

En los 10-35 de segundo desde el comienzo del tiempo, entramos en un ámbito en el que las cósmicas son aún menos conocidas. Si las grandes teorías unificadas son correctas, se produjo una ruptura de la simetría por la que la fuerza electronuclear unificada se escindió en las fuerzas electrodébil y las fuertes. Si es correcta la teoría de la supersimetría, la transición puede haberse producido antes, había involucrado a la gravitación.

En el universo temprano la primera materia (hidrógeno y Helio) era llevada por la fuerza de gravedad a conformarse en grandes conglomerados de gas y polvo que interacioban, producían calor y formaron las primeras estrellas.

Elaborar una teoría totalmente unificada es tratar de comprender lo que ocurrió en ese tiempo remoto que, según los últimos estudios está situado entre 15.000 y 18.000 millones de años, cunado la perfecta simetría que, se pensaba, caracterizó el Universo, se hizo añicos para dar lugar a los simetrías rotas que hallamos a nuestro alrededor y que, nos trajo las fuerzas y constantes Universales que, paradójicamente, hicieron posible nuestra aparición para que , sea posible que, alguien como yo esté contando lo que pasó.

Pero hasta que no tengamos tal teoría no podemos esperar comprender lo que realmente ocurrió en ese Universo bebé. Los límites de nuestras conjeturas actuales cuando la edad del Universo sólo es de 10-43 de segundo, nos da la única respuesta de encontrarnos ante una puerta cerrada.

Del otro lado de esa puerta está la época de Plank, un tiempo en que la atracción gravitatoria ejercida por cada partícula era comparable en intensidad a la fuerza nuclear fuerte.

La fuerza nuclear fuerte hizo posible la existencia de los núcleos que atraían electrones para formar átomos

Así que, llegados a este punto podemos decir que la clave teórica que podría abrir esa puerta sería una teoría unificada que incluyese la gravitación, es decir, una teoría cuántica-gravitatoria que uniese, de una vez por todas, a Planck y Einsteins que, aunque eran muy amigos, no parecen que sus teorías (la Mecánica Cuántica) y (la Relatividad General) se lleven de maravilla.

emilio silvera

Oct

2

La persistencia de los enigmas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El hombre en el Universo ~

Clasificado en El hombre en el Universo ~

Comments (0)

Comments (0)

Un equipo de científicos ha diseñado un test para descubrir si el universo primitivo poseía una sola dimensión espacial. Este concepto alucinante es el núcleo de una teoría que el físico de la Universidad de Buffalo, Dejan Stojkovic y sus colegas proponen y que sugiere que el Universo primitivo tuvo solo una dimensión antes de expandirse e incluir el resto de dimensiones que vemos en el mundo actualmente. De ser válida, la teoría abordaría los problemas importantes de la física de partículas. Han descrito una prueba que puede probar o refutar la hipótesis de la “fuga de dimensiones”.

¿Cómo sería el universo primitivo? En cosmología es aquel que se estudia en un tiempo muy poco después del big bang. En realidad, las teorías del Universo primitivo han dado lugar a interacciones muy beneficiosas entre la cosmología y la teoría de partículas elementales, especialmente las teorías de gran unificación.

Debido a que en el universo primitivo había temperaturas muy altas, muchas de las simetrías rotas en las teorías gauge se vuelven simetrías no rotas a esas temperaturas. A medida que el universo se enfrió después del big bang se piensa que hubo una secuencia de transiciones a estado de simetrías rotas.

Combinando la cosmología con las teorías de gran unificación se ayuda a explicar por qué el universo observado parece consistir de materia y no de antimateria. Esto significa que uno tiene un número bariónico no nulo para el universo. La solución se encuentra en el hecho de que hubo condiciones de no equilibrio en este universo primitivo debido a su rápida expansión después del big bang.

Una idea importante en la teoría del universo primitivo es la de inflación: la idea de que la naturaleza del estado de vacío dio lugar, después del big bang, a una expansión exponencial del universo. La hipótesis del universo inflacionario soluciona varios problemas muy antiguos de la cosmología, como la planitud y la homogeneidad del universo.

Nosotros, los habitantes de este mundo, hemos logrado armar un cuadro plausible de un universo (mucho) mayor. Hemos logrado entrar en lo que podríamos llamar la “edad adulta”, con lo que quiero significar que, a través de siglos de esporádicos esfuerzos, finalmente hemos empezado a comprender algunos de los hechos fundamentales del Universo, conocimiento que, presumiblemente, es un requisito de la más moderna pretensión de madurez cosmológica.

La Nebulosa del Capullo, catalogada como IC 5146, es una nebulosa particularmente hermosa situada a unos 4.000 años-luz de distancia hacia la constelación del Cisne (Cygnus). Un hermoso complejo de Luz y nebulosidad oscura que rodea a un cúmulo muy disperso que, a su derecha, está custodiado por estrellas masivas de intensa radiación UV.

Sabemos, por ejemplo, dónde estamos, que vivímos en un planeta que gira alrededor de una estrella situada en la parte interior de uno de los brazos de la Galaxia (el Brazo de Ortión). La Vía Láctea, una galaxia espiral, está a su vez situada cerca de las afueras de un supercúmulos de galaxias, cuya posición ha sido determinada con respecto a varios supercúmulos vecinos que, en conjunto albergan a unas cuarenta mil galaxias extendidas a través de un billón de de años-luz cúbicos de espacio.

Vivímos en la periferia de la Galaxia, a 30.000 años-luz del centro galáctico

En la parte interios del Brazo de Orión (señalada con la línea) está el Sistema Solar, a 30.000 años-luz del Centro Galáctico en una región bastante tranquila que nos permite contemplar (con nuestros ingenios) lo que que ocurre en otras regiones lejanas y las fuerzas desatadas que azotan aquellos lugares.

También sabemos (más o menos), cuando hemos entrado en escena, hace cinco mil millones de años que se formaron el Sol y sus planetas, en un universo en expansión que probablemente tiene una edad entre dos y cuatro veces mayor. Hemos determionado los mecanismos básicos de la evolución en la Tierra, hallado pruebas también de la evolución química a escala cósmica y aprendido suficiente física como para investigar la Naturaleza en una amplia gama de escalas, desde los saltarines quarks hasta el vals de las galaxias.

Hay realizaciones de las que la Humanidad puede, con justicia, sentirse orgullosa. Desde que los antiguos griegos pusieron el mundo occidental en el camino de la Ciencia, nuestra medición del pasado se ha profundizado desde unos pocos miles de años a más de diez mil milloners de años, y la del espacio se ha extendido desde un cielo de techo bajo no mucho mayor que la distancia real de la Luna hasta el radio de más de doce mil millones de años-luz del universo observable. Tenemos razones para esperar que nuestra época sea recordada (si finalmente queda alguien para recordarlo) por sus contribuciones al supremo tesoro intelectual de toda la sociedad, su concepto del Universo en su conjunto.

Sin embargo, cuando más sabemos sobre el universo, tanto más claramente nos damos cuenta de cuan poco sabemos. Cuando se concebía el Cosmos como un pulcro jardín, con el cielo como techo y la Tierra como suelo y su historia coextensa con la del árbol genealógico humano, aún era posible imaginar que podíamos llegar algún día a comprenderlo en su estructura y sus detalles. Ya no puede abrigarse esa ilusión. Con el tiempo, podemos lograr una comprensión de la estructura cósmica, pero nunca comprenderemos el universo en detalle; resulta demasiado grande y variado para eso. Y, tal inmensidad, siempre tendrá secretos por desvelar.

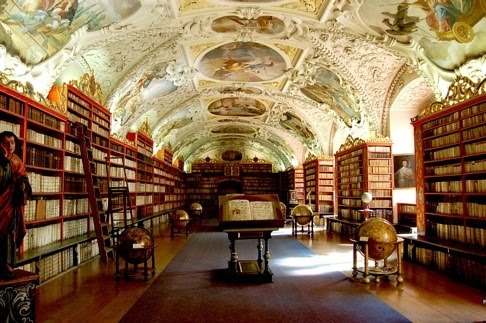

Si poseyésemos un atlas de nuestra galaxia que dedicase una sola página a cada sistema estelar de la Vía Láctea (de modo que el Sol y sus planetas estuviesen comprimidos en una página), tal atlas tendría más de diez mil millones de volúmenes de diez mil páginas cada uno. Se necesitaría una biblioteca del tamaño de la de Harvard para alojar el atlas, y solamente ojearlo al ritmo de una página por segundo requieriría más de diez mil años. Añádanse los detalles de la cartografía planetaria, la potencial biología extraterrestre, las sutilezas de los principios científicos involucrados y las dimensiones históricas del cambio, y se nos hará claro que nunca aprenderemos más que una diminuta fracción de la historia de nuestra galaxia solamente, y hay cien mil millones de galaxias más.

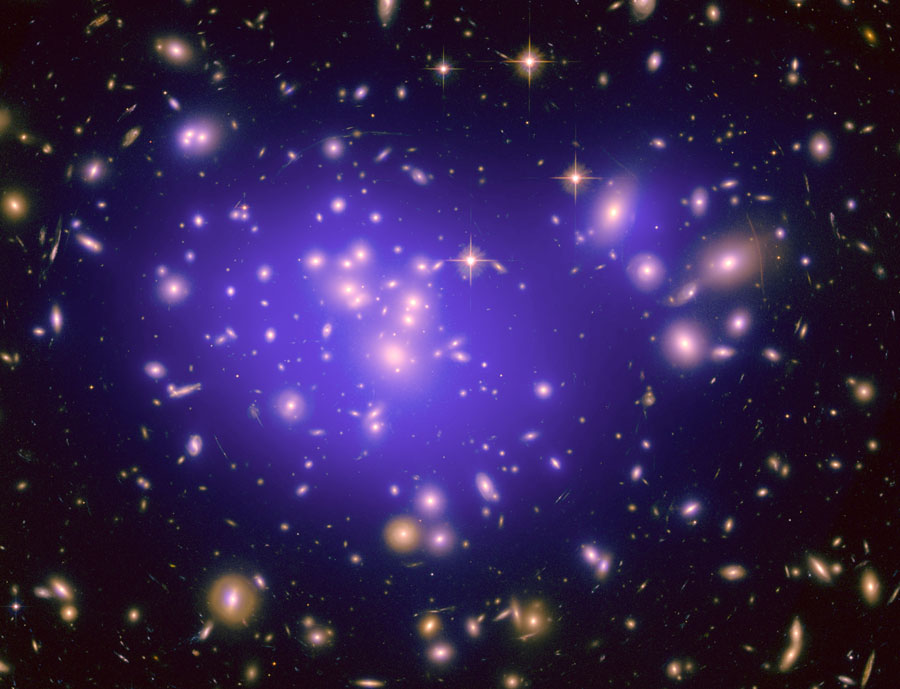

Bellos y extraños objetos que están presentes en el universo y tratamos de comprender

Ya nos lo dijo el físico Lewis Thomas: “El mayor de todos los logros de la ciencia del siglo XX ha sido el descubrimiento de la ignorancia humana”. Nuestra ignorancia, por supuesto, siempre ha estado con nosotros, y siempre seguirá estando. Lo nuevo es nuestra conciencia de ella, nuestro despertar a sus abismales dimensiones, y es esto, más que cualquier otra cosa, lo que señala la madurez de nuestra especie. El espacio puede tener un horizonte y el tiempo un final, pero la ventura del aprendizaje es interminable.

Hay una difundida y errónea suposición de que la ciencia se ocupa de explicarlo todo, y que, por ende, los fenómenos inexplicados preocupan a los científicos al amenazar la hegemonía de su visión del mundo. El técnico en bata del laboratorio, en la película de bajo presupuesto, se da una palmada en la frente cuando se encuentra con algo nuevo, y exclama con voz entrecortada: “¡Pero…no hay explicación para esto!” En realidad, por supuesto, cada científico digno se apresura a abordar lo inexplicado, pues es lo que hace avanzar la ciencia. Son los grandes sistemas místicos de pensamiento, envueltos en terminologías demasiado vagas para ser erróneas, los que explican todo, raramente se equivocan y no crecen.

Los grandes pensadores como Aristarco de Samos

La ciencia es intrínsecamente abierta y exploratoria, y comete errores todos los días. En verdad, éste será siempre su destino, de acuerdo con la lógica esencial del segundo teorema de incompletitud de Kurt Gödel. El teorema de Gödel demuestra que la plena validez de cualquier sistema, inclusive un sistema científico, no puede demostrarse dentro del sistema. En otras palabras, la comprensibilidad de una teoría no puede establecerse a menos que haya algo fuera de su marco con lo cual someterla a prueba, algo más allá del límite definido por una ecuación termodinámica, o por la anulación de la función de onda cuántica o por cualquier otra teoría o ley. Y si hay tal marco de referencia más amplio, entonces la teoría, por definición, no lo explica todo. En resumen, no hay ni habrá nunca una descripción científica completa y comprensiva del universo cuya validez pueda demostrarse.

El Creador (si en verdad existe un “creador”) debe haber sido afecto a la incertidumbre, pues Él nos la ha legado para siempre. La cual, diría yo, es una conclusión saludable y debe de alegrarnos. Mirar esa imposibilidad de saberlo todo, esa incertidumbre cierta que llevamos con nosotros y que nos hace avanzar a la búsqueda incansable de nuevos conocimientos, es, en realidad, la fuente de la energía que nos mueve.

Busto de Alejandro Magno

Podemos recordar aquí lo que cuentan de Alejandro Magno: Él lloró cuando le dijeron que había infinitos mundos (“¡Y nosotros no hemos conquistado ni siquiera uno!”), pero la situación parece más optimista a quienes se inclinan a desatar, no a cortar, el nudo gordiano de la Naturaleza. Ningún hombre o mujer, realmente reflexivos, deberían desear saberlo todo, pues cuando el conocimiento y el análisis son completos, el pensamiento se detiene y llega la decadencia.

René Magritte, en 1926, pintó un cuadro de una pipa y escribió debajo de él sobre la tela, con una cuidadosa letra de escolar, las palabras: “Ceci nést pas une pipe” (Esto no es una pipa). Esta pintura podría convertirse apropiadamente en el emblema de la Cosmología científica. La palabra “universo” no es el universo; ni lo son las ecuaciones de la teoría de la supersimetría, ni la ley de Hubble ni la métrica de Friedman-Walker-Robinson. Generalmente, la ciencia tampoco sirve de mucho para explicar lo que es algo, y mucho menos lo que el Universo entero, realmente “es”. La Ciencia describe y predice sucesos.

¿Cuantos secretos se esconden en ese laberinto de conexiones sin fin?

Si la Ciencia tuviera que tener un símbolo, yo escogería éste de arriba que nos señala el lugar donde habita la Mente, dónde se fraguan las ideas. Una configuración de átomos de energía donde residen todos los secretos del Universo, toda vez que, la podríamos considerar la obra suprema del Universo

¿Por qué, pués, la ciencia tiene éxito? La respuesta es que nadie lo sabe. Es un completo misterio -por qué la mente humana…, puede comprender algo del vasto universo-. Como solía decir Einstein: “Lo más incomprensible del universo es que sea comprensible”. Quizá como nuestro cerebro evolucionó mediante la accion de las leyes naturales, éstas resuenan de algún modo en él. La Naturaleza presenta una serie de repeticiones -pautas de conducta que reaparecen a escalas diferentes, haciendo posible identificar principios, como las leyes de la conservación, que se aplican de modo universal- y éstas pueden proporcional el vínculo entre lo que ocurre dentro y fuera del cráneo humano. Pero el misterio, realmente, no es que coincidamos con el universo, sino que en cierta medida estamos en conflicto con él, y sin embargo podemos comprender algo de él. ¿Por qué esto es así?

Habrá que seguir buscando respuestas. Desde tiempos inmemoriales, el hombre pregunta a las estrellas si el Universo es eterno e infinito y el cielo le responde cada noche. Pero, ¿sabemos oir la respuesta?

¡Es todo tan complejo! ¡Es todo tan hermoso!

emilio silvera

Oct

2

¿El Misterio? Persistirá, ¡como el Tiempo!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

Los habitantes de este mundo hemos, hemos conseguido construir un cuadro plausible del Universo, de la Naturaleza que tratamos de comprender. Hemos llegado a ser conscientes de que, en ella, en la Naturaleza, están todas las respuestas que buscamos y, nosotros mismos no hemos llegado a conocernos por ese mismo hecho de que, formando parte de la Naturaleza, también somos parte del enigma que tratamos de desvelar.

Parece que ahora estamos entrando en la edad adulta, quiero significar que después de siglos y milenios de esporádicos esfuerzos, finalmente hemos llegado a comprender algunos de los hechos fundamentales del Universo, conocimiento que, presumiblemente, es un requisito de la más modesta pretensión de nuestra maduirez cosmológica.

Sabemos, por ejemplo, dónde estamos, que vivímos en un planeta que gira alrededor de una estrella situada en el borde de la Galaxia espiral a la que llamamos Vía Láctea, cuya posición ha sido determinada con respecto a varios cúmulos vecinos que, en conjunto, albergan a unas cuarenta mil galaxias extendidas a través de un billón de años-luz cúbicos de espacio.

También sabemos más o menos, cuando hemos entrado en escena, hace unos cinco mil millones de años que se formaron el Sol yn los planetas de nuestro Sistema Solar , en un Universo en expansión que probablemente tiene una edad entre dos y cuatro veces mayor. Hemos determinado los mecanismos básicos de la evolución de la Tierra, hallado prueba también de evolución química a escala cósmica y hemos podido aprender suficiente física como para comprender e investigar la Naturaleza en una amplia gama de escalas desde los Quarks saltarines en el “mundo” microscópico hasta el vals de las galaxias.

El Tiempo inexorable nunca dejó de fluir y mientras eso pasaba, nuestra especie evolucionaba, aprendia al obervar los cielos y cómo y por qué pasaban las cosas. Hay realizaciones humanas de las que, en verdad, podemos sentirnos orgullosos. Aquellos habitantes de Sumer y Babilonia, de Egipto o China y también de la India y otros pueblos que dejaron una gran herencia de saber a los Griegos que pusieron al mundo occidental en el camino de la ciencia, nuestra medición del pasado se ha profundizado desde unos pocos miles de años a más de diez mil millones de años, y la del espacio se ha extendido desde un cielo de techo bajo no mucho mayor que la distancia que nos separa de la Luna hasta el radio de más de diez mil millones de años-luz del universo observable.

Tenemos razones para esperar que nuestra época sea recordada (si por ventura queda alguien para recordarlo) por sus contribuciones al supremo tesoro intelectual de toda la Humanidad unida al contexto del Universo en su conjunto por unos conocimientos que, aunque no suficiente, sí son los necesarios para saber dónde estamos y, ahora, debemos buscar la respuesta a esa pregunta: ¿Hacia dónde vamos?

Claro que, el futuro es incierto

Como en la física, en el mundo y en nuestras vidas, también está presente el principio de incertidumbre y, de ninguna manera, podemos saber del mañana. Sin embargo, cuanto más sabemos del universo, tanto más claramente comprendemos lo poco que sabemos de él. La vastedad del Universo nos lleva a poder comprender algunas estructuras cósmicas y mecanismos que se producen y repiten como, el caso de la destrucción que nos lleva a la construcción. Es decir, una estrella masiva vieja explota y siembre el Caos y la destrucción en una extensa región del espacio, y, es precisamente ese hecho el que posibilita que, nuevas estrellas y nuevos mundos surgan a la vida. Sin embargo, la grandeza, la lejanía, esa inmensidad que se nos escapa a nuestra comprensión terrestre, nunca nos dejará comprender el universo en detalle y, siendo así, siempre tendremos secretos que desvelar y misterios que resolver.

Si añadimos a todo eso que, si poseyésemos un atlas de nuestra propia Galaxia y que dedicase una sóla página a cada sistema estelar de la Vía Láctea (de modo que el Sol y sus planetas estuviesen comprimidos en una página), tal atlas tendría más de dies mil millones de volúmenes de dies mil páginas cada uno. Se necesitaria una biblioteca del tamaño de la de Harvard para alojar el Atlas, y solamente ojearlo al ritmo de una página por segundo nos llevaría más de diez mil años. Añádance los detalles de la cartografía planetaria, la potencial biología extraterrestre, las sutilezas de los principios científicos involucrados y las dimensiones históricas del cambio, y se nos hará claro que nunca aprenderemos más que una diminuta fracción de la historia de nuestra Galaxia solamente, y hay cien mil millones de galaxias más.

Sabiendo todo todo esto, siendo consciente de que, realmente, es así, tendremos que convenir con el físico Lewis Thomas cuando dijo: “El mayor de todos los logros de la ciencia del siglo XX ha sido el descubrimiento de la ignorancia humana”.

La ignorancia, como todo en el Universo, es relativa. Nuestra ignorancia, por supuesto, siempre ha estado con nosotros, y siempre seguirá estando, es una compañera con la que cargamos toda nuestra vida y que nos pesa. Algunos procuramos que pese lo menos posible para hacer más llevadero el viaje. Lo nuevo está en nuestras consciencias y de ellas, ha surgido nuestro despertar al comprender de sus abismales dimensiones, y es eso más que otro cosa, lo que señala la madurez de nuestra especie. El espacio puede tener un horizonte y el tiempo un final pero la aventura del aprendizaje siempre será interminable y eterno, quizá (no me he parado a pensarlo) pueda ser esa la única forma de eternidad que pueda existir.

La ciencia tiene límites. Foto CC-BY Galería de NASA Goddard Photo and Video.

La dificultad de explicarlo todo no se debe a nuestra debilidad mental, sino a la estructura misma del universo. En los últimos siglos hemos descubierto que la trama del cosmos puede abordarse en varios niveles diferentes. Mientras no se descubre el siguiente nivel, lo que ocurre en el anterior no se puede explicar, sólo puede describirse. En consecuencia, para el último nivel que se conoce en cada momento nunca hay explicaciones, sólo puede haber descripciones.

La Ciencia es intrínsicamente abierta y exploratoria, y comete errores todos los días. En verdad, ese será siempre su destino, de acuerdo con la lógica esencial del segundo teorema de incompletitud de Kurt Gödel. El teorema demuestra que la plena validez de cualquier sistema, inclusive un sistema científico, no puede demostrarse dentro del sistema. Es decir, tiene que haber algo fuera del marco de cualquier teoría para poder comprobarla. La lección que podemos haber aprendido es que, no hay ni habrá nunca una descripción científica completa y comprensiva del universo cuya validez pueda demostrarse.

No es que pertenezcamos al Universo, formamos parte de él

Y, a todo esto, debemos alegrarnos de que así sea, de que no podamos comprender el Universo en toda su inmensa dimensión y diversidad. Nuestras mentes necesitan que así sea y, tendrán, de esa manera, el escenario perfecto para seguir creciendo a medida que busca todas esas rrespuestas que nos faltan y, lo bueno del caso es que, cada respuesta que encontramos, viene acompañada de un montón de nuevas preguntas y, de esa manera, esa historia interminable de nuestra aventuira del saber…llegará hasta la etermindad de nuestro tiempo que, necesariamente, no tiene por que ser el tiempo del universo.

emilio silvera.

Totales: 85.935.100

Totales: 85.935.100 Conectados: 67

Conectados: 67