Mar

16

Necesitamos una teoría unificada del Cosmos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (0)

Comments (0)

Hace mucho tiempo ya que el hombre mira al cielo y observa los objetos celestes. Muy lejos queda ya la teoría geocéntrica de Ptolomeo con una Tierra ocupando el centro del universo. En Babilonia ya tenían aquella visión de una Tierra en el centro de todo y en su obra El Almagesto, Claudio Ptolomeo continuó reflejando esa teoría alla por el siglo II y estuvo en vigor hasta el siglo XVI, cuando fue reemplazada por la teoría heliocéntrica. Fueron muchos los que discrepaban de la teoría que ponía a la Tierra en el centro de todo y, ya en el siglo II a. C., Aristarco de Samos fue el que defendió la idea con más fuerza e incluso llegó a escribir un libro que no ha llegado a nuestros días.

El tiempo transcurría y las ideas se hicieron más claras y, fue Copérnico el que al fín, en un libro publicado en 1543, De Revolutionibus Orbium Coelestium, dejó fijado el punto de partida que situaba al Sol en el centro y los planetas a su alrededor. Todo aquello, no fue suficiente para que el antiguo modelo de la Tierra central continuara durante algún tiempo, toda vez que Copérnico, no explicaba de manera suficiente algunos fenómenos y, además, se alejaba de la educación religiosa del momento.

Kepler en un retrato de 1610

Kepler con la herramienta de las muchas observaciones realizadas por Tycho Brahe que estudió a fondo, pudo formular sus Tres Leyes en 1609 y 1619, en las que dejó sentado que las planetas se movían en trayectorias elípticas. Galileo con sus observaciones despejó el camino hacia la comprensión de dónde nos encontrábamos. Más tarde llegaría Newton con su Ley de la Gravedad y no fue hasta 1915 que la entrada en escena de Einstien nos trajo un Modelo más moderno y coherente con su Teoría de la Relatividad General.

La Teoría hilocéntrica llegó con fuerza hasta los principios del siglo XX, el Sol estaba situado en el centro sobre el cual giraba todo el universo con los objetos del espacio profundo que contenían “nebulosas espirales”.

Harlow Shapley

La llegada de Shapley al “mundo” de las estrellas le dieron otro giro a la visión que del universo se tenía. Sus observaciones iniciaron el estudio de las estrellas variables que llevó a descubrir un tipo especial de ellas que se caracterizaban por el hecho de que los cambios de brillo estaban relacionados con su liuminosidad intrínseca y, como la estrella prototipo se encontró en la Constelación de Cefeo, se las llamó Cefeidas.

A partir de aquel momento, y, conociendo la luminosidad de un objeto celeste bastaba aplicar la ley del cuadrado inverso que nos dice que el brillo disminuye de acuerdo al cuadrado de la distancia y se pudo calcular la distancia a la que se encontraba el objeto estudiado. Así Shapley siguió con su impresionante trabajo y pudo observar cúmulos globulares, grupos de millones de estrellas que estaban “juntas” en un cúmulo compacto y redondo girando alrededor de los centros galácticos. Se pudo apreciar que el Sol, debería estar situado en la periferia del Universo y muy lejos del centro de la Galaxia.

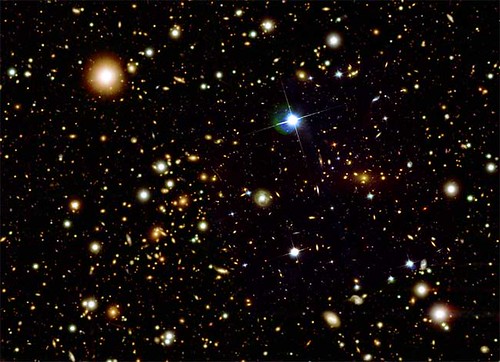

Los cúmulos globulares pueden contener hasta miles de millones de estrellas

Todos aquellos nuevos descubrimientos llamaron la atención de muchos y, hasta el filósofo Immanuel Kant contribuyó al conocimiento del universo con sus obra Historia general de la naturaleza y teoría del cielo, en la que exponía la hipótesis de que a partir a una nebulosa de gas surgió el Sistema solar y sugirió la idea de que existían otras muchas galaxias que eran como “universos islas”, es decir, una especie de universos en miniatura cuajado de estrellas y de mundos.

Su idea de los universos islas llegaron hasta principios del siglo XX y “las nebulosas espirales”, eran en realidad otros universos islas como la Vía Láctea pero separados de ella y, esa teoría fue firmemente apoyada por Herschel aunque no se tenían pruebas contundentes de ello. Pero como el avance del conocimiento no se para, aquellas pruebas llegaron de la mano de las observaciones de Hubble, realizadas en el Observatorio de Monte Wilson.

Como inmensas pompas de jabón que reflejan el brillo multicolor de las estrellas

El Universo dejó de ser algo estático para convertirse en un universo en expansión. El descubrimiento de varios supercúmulos galácticos en 1978, como el de Perseo-Pegaso (que, se extiende por el cielo a través de mil millones de años-luz), es la mayor de las estructuras que se han podido constar hasta la fecha en el universo. Otro hallazgo importante ocurrió en 1981, cuando se halló el primer “vacío” en la Constelación de Boötes. El vacío, o “Burbuja de Hubble”, una gran región del espacio en la que no existen galaxias -o muy pocas- y cuya extensión puede alcanzar los 250 millones de años-luz de diámetro. En 1985 se descubrieron nuevos vacíos que vinieron a configurar una nueva imagen de nuestro universo que está lleno de burbujas.

Hubble, el 19 de febrero de 1924, escribió a Shapley, quien defendía la existencia de una sola galaxia:

«Seguramente le interesará saber que he hallado una variable cefeida en la nebulosa de Andrómeda». De esta manera se reveló que las nebulosas espirales no eran simples cúmulos de gas dentro de la vía láctea sino verdaderas galaxias independientes o como Kant describió «universos isla».

Pero la historia de las variables Cefeidas tiene otra protagonista que no quiero dejar aquí oculta en el olvido y que es de justicia destacar para que los méritos sean repartidos conforme a quién los ganó. No siempre se han otorgado los premios a los que lo merecieron. Claro que todo aquello no era nada fácil toda vez que…

El ojo humano solo es capaz de percibir la pequeña porción que corresponde a la luz visible, situada entre los 3900 Å y 7500 Å, donde la menor se encuentra del violeta y la mayor del rojo. El Sol emite en todas las longitudes de onda, pero solo llegan a la superficie una pequeña porción de estas, las demás son frenadas por la atmósfera: el ozono absorbe las mas altas longitudes de onda hasta el ultravioleta, y el vapor de agua absorbe gran parte de las infrarrojas. Fueron los telescopios los que nos permitieron llegar más lejos y ver más.

En el Observatorio de la Universidad de Harvard, uno de los principales centros de la monótona pero prometedora tarea de la taxonomía estelar, las placas fotográficas que mostaban los colores y espectros de decenas de miles de estrellas se apilaban ante “calculadoras”, mujeres empleadas como miembros del personal de una facultad que les impedía asistir a clases u obtener un título pero que, desarrollaban una labor importante de infinita paciencia

Una de esas mujeres, Henrietta Leavitt (arriba), fue la investigadora pionera de las estrellas variables cefeidas que tan útiles serían a Shapley y Hubble, ella fue una de esas “calculadoras” de Harvard que, se encargaban de examinar las placas y los datos en una pulcra escritura victoriana para su compilación en volúmenes como el Henry Draper Catalog, así llamado en honor al primer astrofotógrafo y físico que tomó las primeras fotografías del espectro de una estrella. Como presos que marcan el de los días en los muros de su celda, señalaban su progreso en totales de estrellas catalogadas. Antonia Maury, sobrina de Draper, contaba que había clasificado los espectros de más de quinientas mil estrellas. Su labor era auténticamente baconiana, del tipo que Newton y Darwin instaban a hacer pero raramente hicieron ellos, y se enorgullecían de ella. Como afirmaba la “calculadora” de Harvard Annie Jump Cannon: “Cada dato es un facto valioso en la imponente totalidad”.

Precisamente fue Cannon quien, en 1915, empezó a discernir la forma de esa totalidad, cuando descubrió que la mayoría de las estrellas pertenecían a una de media docena de clases espectrales distintas. Su de clasificación (ahora generalizado en la astronomía estelar), ordena los espectros por color, desde las estrellas O blancoazuladas, pasando por las estrellas G amarillas como el Sol, hasta las estrellas rojas M. Era un rasgo de simplicidad debajo de la asombrosa variedad de las estrellas.

Pronto se descubrió un orden más profundo, en 1911, cuando el ingeniero y astrónomo autodidacto danés Ejnar Hertzsprung analizó los de Cannon y Maury de las estrellas de dos cúmulos, Las Híades y las Pléyades. Los cúmulos como estos son genuínos conjuntos de estrellas y no meras alineaciones al azar; hasta un observador inexperimentado salta entusiamado cuando recorre con el telescopio las Pléyades, con sus estrellas color azul verdoso enredadas en telarañas de polvo de diamante, o las Híades, cuyas estrellas varían en color desde el blanco mate hasta el amarillo apagado.

Las Pléyades

Las Híades

Puesto que puede supònerse que todas las estrellas de un cúmulo están a la misma distancia de la Tierra, toda diferencia observada en sus magnitudes aparentes pueden atribuirse, no a una diferencia en las distancias, sino en las magnitudes absolutas. Hertzsprung aprovechó este hecho para utilizar los cúmulos como muestras de laboratorio con las que podía una realción entre los colores y los brillos intrínsecos de las estrellas. Halló tal relación: la mayoría de las estrellas de ambos cúmulos caían en dos líneas suavemente curvadas. Esto, en forma de gráfico, fue el primer esbozo de un árbol de estrellas que desde entonces ha sido llamado diagrama Hertzsprung-Russell. Claro, como cabía esperar, la aplicabilidad del método se amplió también a estrellas no pertenecientes a cúmulos.

Henry Norris Russell, un astrofísico de Princeton con un enciclopédico dominio de su campo, pronto se puso a justamente en eso. Sin conocer siquiera el trabajo de Hertzsprung, Russell diagramó las magnitudes absolutas en función de los colores, y halló que la mayoría están a lo largo de una estrecha zona inclinada: el trondo del árbol de estrellas. El árbol ha estado creciendo desde entonces y hoy, está firmemente grabado en la conciencia de todos los astrónomos estelares del mundo. Su tronco es la “serie principal”, una suave curva en forma de S a lo largo de la cual se sitúan entre el 80 y el 90 por 100 de todas las estrellas visibles. El Sol, una típica estrella amarilla, está en la serie a poco menos de la mitad del tronco hacia arriba. Una rama más fina sale del tronco y se esxtiende hacia arriba y a la derecha, donde florece en un ramillete de estrellas más brillantes y más rojas: las gigantes rojas. Debajo y a la izquierda hay una cantidad de mantillo de pálidas estrellas entre azules y blancas: las enanas.

El Diagrama de Hertzsprung-Russell resumido

Este diagrama proporcionó a los astrónomos un congelado de la evolución, el equivalente astrofísico del registro fósil que los geólogos estudian en los estratos rocosos. Presumiblemente, las estrellas evolucionan de algún modo, pasan la mayor parte de su tiempo en la serie principal (la mayoría de las estrellas en la actualidad, en el brevísimo tiempo que tenemos para observar, se encuentran allí), pero empiezan y terminan su vida en alguna otra parte, entre las ramas o en el mantillo. Por supuesto, no podemos esperar para ver que esto sucede, pues el tiempo de vida, aun de estrellas de vida corta, se mide en millones de años. Hallar las respuestas exigirá conocer toda la física del funcionamiento estelar.

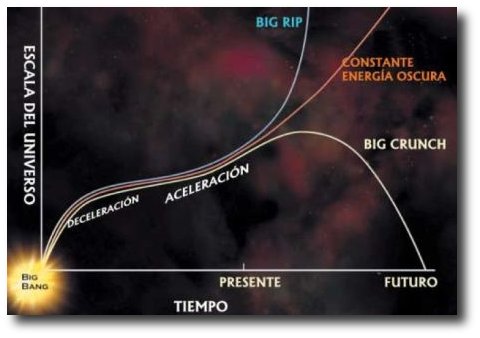

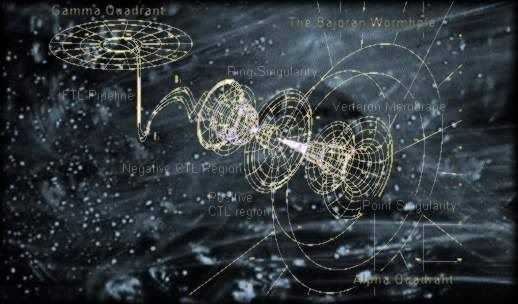

Todo esto nos lleva de nuevo a pensar que, sería conveniente que surgiera una teoría unificada del Cosmos, acorde con los primeros pasos del Big Bang y con la aún misteriosa formación de estructuras a gran escala: un modelo, en fin, que contendría en un todo coherente el origen, la evolución, la estructura actual y el destino último del Universo.

Me hubiera gustado contar de manera paralela que, a finales del s. XIX y principios del s. XX, el progreso de la Física, estaba bloqueado por una barrera aparentemente insuperable. Esto era literal: el agente responsable era conocido como la barrera de Coulomb, y por un tiempo frustó los esfuerzos de los físicos teóricos para comprender cómo la fusión nuclear podía producir energía en las estrellas… Pero eso, amigos, es otra historia que os contaré en otro momento.

emilio silvera

Mar

15

Las galaxias y la Vida… ¡Crean entropía negativa!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

Estamos en un planeta lleno de vida y tal maravilla se nos olvida con frecuencia

Nuestro planeta, la Tierra, forma parte del Universo, y, es una prueba indiscutible de que sus componentes biológicos y físicos forman parte de una única red que funciona de un modo autorregulado, y, de esa forma, mantiene las que son ampliamente adecuadas para la existencia de vida, pero que sufren fluctuaciones a todas las escalas (incluidos los ritmos de alternancia de glaciaciones y periodos interglaciales, así como las extinciones masivas). En un sentido real, la Tierra es el lugar que alberga una red de vida multiforme, y la existencia de esta red (Gaia) sería visible para cualquier forma de vida inteligente que hubiera en Marte o en cualquier otro planeta y que fuera capaz de aplicar la prueba conocida de Lovelock y buscar señales de reducción de la entropía.

Las cosas que podemos encontrar en el espacio interestelar nos pueden sorprender

La vida es un signo de entropía negativa se replica

Ni la NASA, tomó nunca la prueba de Lovelock lo suficientemente en serio como para aplicarla a la búsqueda de vida en el Sistema Solar; pero si se lo tomó en serio para buscar vida más allá del Sistema Solar. Ahora, parece que han recapacitado y han enviado a Marte y otros lugares de nuestro entorno, una pléyade de ingenios que ya nos han enviado e imágenes de cómo son otros mundos y de las posibilidades que en ellos pueden existir de que la vida esté presente. De momento han encontrado hielo de agua, han diluido porciones de la tierra marciana en agua y debidamente tratada, han hallado la presencia de magnesio, sodio, potasio y cloruros. En algunos lugares, como Titán, por ejemplo, hay más que evidencia de agua porque las sales están allí con otros elementos esperanzadores y una atmósfera prometedora. Además han encontrado los compuestos químicos necesarios para la vida como la conocemos. y, lo sorprendente de estos lugares (también Marte) es que no son un mundos extraños, sino que, en muchos aspectos, son iguales que la Tierra fue en el pasado o podrá ser en el futuro. Por eso es importante que los estudiémos.

La Vida puede estar presente… ¡En tántos mundos!

En alguna ocasión me he referido al comentario que hizo Darwin:

“… los materiales primigenios… en alguna pequeña charca caliente, tendrían la oportunidad de hacer el y organizarse en sistemas vivos…”

Hasta que supimos que existían otros sistemas planetarios en nuestra Galaxia, ni siquiera se podía considerar esta posibilidad como una prueba de que la vida planetaria fuera algo común en la Vía Láctea. Pero ahora se sabe que más de cien estrellas de nuestra zona de la galaxia tienen planetas que describen órbitas alrededor de ellas. Casi todos los planetas descubiertos hasta ahora son gigantes de gas, como Júpiter y Saturno (como era de esperar, los planetas grandes se descubrieron primero, por ser más fáciles de detectar que los planetas pequeños), sin embargo, es difícil no conjeturar que allí, junto a esos planetas, posiblemente estarán también sus hermanos planetarios más pequeños que, como la Tierra, pudieran tener para generar la vida en cualquiera de sus millones de formas, incluso desconocidas para nosotros como ocurre aquí mismo en nuestro planeta.

Supertierras que son fáciles de detectar por su inemnsas masas pero, los planetas terrestres también están por ahí, orbitando a miles y miles de estrellas y a la distancia adecuada poder contener la vida. Los elementos más abundantes del Universo: carbono, hidrógeno, oxígeno y nitrógeno (CHON). Están ahí, dispersos por las Nebulosas que forman los mundos y las estrellas y… ¡la vida!

Lee Smolin, de la Universidad de Waterloo, Ontario, ha investigado la relación existente entre, por una parte, las estrellas que convierten unos elementos más sencillos en algo como el CHON y arroja esos materiales al espacio, y, por otra parte, las nubes de gas y polvo que hay en éste, que se contrae formar nuevas estrellas y mundos.

De sitios así surgen las estrellas y los mundos… ¿Y la vida?

Nuestro dentro del espacio, la Vía Láctea, es una entre los cientos de miles de millones de estructuras similares dispersas por todo el Universo visible, y parece ser una más, con todas las características típicas – de tipo medio en cuanto a tamaño, composición química, etc.- La Vía Láctea tiene forma de disco plano, con alrededor de cien mil años luz de diámetro, y está formada por doscientos mil millones de estrellas que describen órbitas en torno al centro del disco.

El Sol, en realidad, sólo es importante para nosotros al ser el cuerpo central de nuestro Sistema Solar, y con mucho, la estrella más cercana al planeta Tierra y la única que se puede estudiar con todo lujo de detalles. Se clasifica como una estrella G2V: una estrella amarilla con una temperatura efectiva de 5.770 K ( espectral G2) y una enana de la secuencia principal (clase de luminosidad V). Los detalles de su composición son sobradamente sabidos por todos y cabe destacar su abundancia de hidrógeno – 71% en masa- y de helio el 27% y elementos más pesados hasta completarlo. Por lo tanto, nuestro Sol no destaca por nada entre esa multitud de de cientos de miles de millones de estrellas.

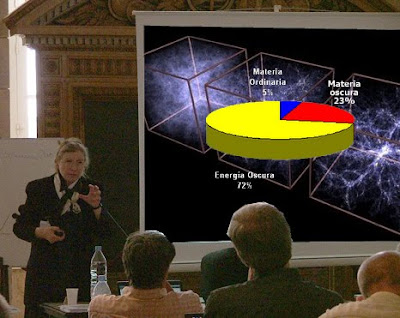

Recorre su órbita a una distancia del centro que viene a ser más o menos dos tercios del diámetro. En el centro de la Galaxia las estrellas forman una protuberancia, de tal modo que el exterior daría la sensación de estar viendo un enorme huevo frito, en el que la protuberancia sería la yema. Sin embargo, el modo en que este disco gira revela que todo el material brillante (materia bariónica) que compone la parte visible de la Vía Láctea queda sujeto por el tirón gravitatorio que la propia masa galáctica genera. Otros hablan de una materia invisible que no brilla ni emite radiación y que viene a ser más o menos diez veces mayor que la materia visible de la Galaxia y que suponen diseminada en un halo situado alrededor de ella, extendiéndose mucho más allá del borde del disco de estrellas brillantes.

qué es realmente esta materia oscura (si existe, yo prefiero llamarla no luminosa o materia escondida) constituye un tema de crucial interés para los astrónomos, pero no entraremos ahora en eso, ya que, para lo que estamos tratando, no tiene importancia. Muchas galaxias en forma de disco se caracterizan por una especie de serpentinas que se alejan en espiral desde su centro, lo que hace que se les aplique el de galaxias espirales. Es fácil estudiar las pautas que siguen los llamados “brazos espirales”, porque las galaxias se encuentran relativamente cerca unas de otras, si comparamos estas distancias con sus tamaños.

Andrómeda (que no es la que arriba vemos), la galaxia espiral más cercana comparable a la Vía Láctea, se encuentra con respecto a nosotros a una distancia de poco más de dos millones de años luz; parece una gran distancia, pero la galaxia de Andrómeda es tan grande (un poco mayor que la Vía Láctea) que, incluso a esa distancia, vista la Tierra cubre un trozo de cielo del tamaño de la Luna, y puede observarse a simple vista en una noche despejada y sin luz lunar, si nos situamos lejos de las ciudades y de otras fuentes de emisión de luz.

Los brazos espirales, que son una característica tan llamativa en galaxias la nuestra, son visibles porque están bordeados por estrellas calientes de gran masa que relucen con mucho brillo. Esto significa que también son estrellas jóvenes, ya que no hay estrellas viejas que tengan gran cantidad de masa.

No hay misterio alguno en cuanto al modo en que mantienen esa forma espiral. Se debe exclusivamente a un fenómeno de retroalimentación. Las nubes gigantescas a partir de las cuales se forman las estrellas pueden contener hasta un millón de veces la masa del Sol cuando empieza a contraerse gravitatoriamente para formar estrellas. Cada nube que se contrae produce, no una sola estrella de gran tamaño, sino todo un conglomerado de estrellas, así como muchas estrellas menores. Cuando las estrellas brillantes emiten luz, la energía de esta luz estelar (especialmente en la parte ultravioleta del espectro) forma una burbuja dentro de la nube, y tiende a frenar la de más estrellas. Sin embargo, una vez que las estrellas de gran masa han recorrido sus ciclos vitales y han explotado, sembrando además el material interestelar con elementos de distintos tipos, la onda expansiva ejerce presión sobre las nubes interestelares cercanas y hace que éstas comiencen a contraerse.

Las ondas procedentes de distintas supernovas, al entrecruzarse unas con otras, actúan mutuamente barrer el material interestelar y formar nuevas nubes de gas y polvo que se contraen produciendo más estrellas y supernovas, en un ejemplo clásico de interacción que se mantiene por sí sola en la que intervienen una absorción de energía (procedentes de las supernovas) y una retroalimentación.

Si la nube es demasiado densa, su parte interna se contraerá gravitatoriamente de manera rápida, formando unas pocas estrellas grandes que recorren sus ciclos vitales rápidamente y revientan la nube en pedazos antes de que puedan formarse muchas estrellas. Esto significa que la generación siguiente de estrellas nace de una nube más delgada, porque ha habido pocas supernovas que barrieran material formando pedazos densos. Si la nube es tan delgada que su densidad queda por debajo de la densidad óptima, nacerán muchas estrellas, y habrá gran cantidad de explosiones supernovas, lo cual producirá gran de ondas de choque que barrerán el material interestelar, acumulándolo en nubes más densas.

De esta manera, por ambas partes, las retroalimentaciones operan mantener un equilibrio aproximadamente constante entre la densidad de las nubes y el de supernovas (y estrellas de tipo Sol) que se producen en cada generación. La propia pauta espiral resulta del hecho de que la galaxia realiza movimiento de rotación y está sometida al tirón gravitatorio que crea la fuerza de marea proveniente de esa materia no luminosa.

Claro que, la materia interestelar es variada. Existen nubes de gas y polvo fríos, que son ricas en interesantes moléculas y se llaman nubes moleculares gigantes; a partir de estas nubes se forman nuevas estrellas (y planetas). Hay nubes de lo que consideraríamos gas “normal”, formadas por átomos y moléculas de sustancias tales como el hidrógeno, y quizá tan caliente como una habitación cerrada durante toda la noche y con la temperatura de dos cuerpos dormidos y emitiendo calor. Además, hay regiones que se han calentado hasta temperaturas extremas mediante la energía procedente de explosiones estelares, de tal modo que los electrones han sido arrancados de sus átomos para formar un plasma cargado de electricidad.

La densidad de materia las estrellas es escasa, dado que estas la obsorbieron y la que había están convertidas en cuerpos homogéneos que brillan y generan calor transformando el material más sencillo en otro más complejo y pesado. También, alrededor de estas estrellas se forman los mundos.

Dentro del medio interestelar las densidades varían. En la modalidad más común, la materia existente las estrellas es tan escasa que sólo hay un átomo por cada mil centímetros cúbicos de espacio: en la modalidad más densa, las nubes que están a punto de producir nuevas estrellas y nuevos planetas contienen un millón de átomos por centímetro cúbico. Sin embargo, esto es algo muy diluido si se compara con el aire que respiramos, donde cada centímetro cúbico contiene más de diez trillones de moléculas, pero incluso una diferencia de mil millones de veces en densidad sigue siendo un contraste espectacular.

La cuestión es que, unos pocos investigadores destacaron allá por 1.990 en que todos estos aspectos –composición, temperatura y densidad- en el medio interestelar dista mucho de ser uniforme. Por decirlo de otra manera más firme, no está en equilibrio, y parece que lo que lo mantiene lejos del equilibrio son unos pocos de procesos asociados con la generación de las pautas espirales.

Esto significa que la Vía Láctea ( otras galaxias espirales) es una zona de reducción de la entropía. Es un sistema auto-organizador al que mantienen lejos del equilibrio, por una parte, un flujo de energía que atraviesa el sistema y, por otra, como ya se va viendo, la retroalimentación. En este sentido, nuestra Galaxia supera el test de Lovelock la vida, y además prestigiosos astrofísicos han argumentado que las galaxias deben ser consideradas como sistemas vivos.

Creo que llevan toda la razón.

emilio silvera

Mar

14

No siempre hablamos de lo que comprendemos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física... ¡Y mucho más! ~

Clasificado en Física... ¡Y mucho más! ~

Comments (1)

Comments (1)

¡La Física! Lo que busca la física fundamental es reducir las leyes de la naturaleza a una teoría final sencilla que lo explique todo. El físico y premio Nobel Steven Weinberg señala que las reglas fundamentales son lo más satisfactorio (al menos él). Las leyes básicas de Isaac Newton, que predicen el comportamiento de los planetas, son más satisfactorias, por ejemplo, que un almanaque en el que se indique la posición de todos los planetas en cada . Weinberg nos dice que la Física no puede explicarlo todo, matizando que sólo puede explicar los sucesos relacionándolos con otros sucesos y con las reglas existentes.

Por ejemplo, las órbitas de los planetas son el resultado de unas reglas, pero las distancias de los planetas al Sol son accidentales, y no son consecuencia de ley fundamental alguna. Claro que, las leyes podrían ser fruto de casualidades. Lo que sí es cierto es que los físicos están más interesados por descubrir las reglas que por los sucesos que dichas reglas determinan, y más por los hechos que son independientes del tiempo; por ejemplo, les interesa más la masa del electrón que un tornado que se pueda producir en un lugar determinado.

La ciencia, como nos dice Weinberg, no puede explicarlo todo y, sin embargo, algunos físicos tienen la sensación de que nos estamos acercando a “una explicación del mundo” y, algún día, aunando todos los esfuerzos de muchos, las ideas de las mejores mentes que han sido, y las nuevas que llegarán, podremos, al fín, construir esa Teoría final tan largamente soñada que, para que sea convincente, deberá también, incluirnos a nosotros. Pero, paradógicamente y a pesar de estos pensamientos, existen hechos que los contradicen, por ejemplo, conocemos toda la física fundamental de la molécula de agua desde hace 7 decenas de años, pero todavía no hay nadie que pueda explicar por qué el agua hierve a los 100 ºC. ¿Qué ocurre? ¿Somos acaso demasiado tontos? Bueno, me atrevería a pronosticar que seguiremos siendo “demasiado tontos” incluso los físicos consigan (por fin) esa teoría final que nos pueda dar una “explicación del mundo”. Siempre seguiremos siendo aprendices de la naturaleza que, sabia ella, nos esconde sus secretos para que persista el misterio.

¿Qué sería de nosotros si lo supiéramos todo?

La explicación que dan los físicos actualmente sobre la subestructura de la materia se llama “el modelo estándar”. En este modelo están incluídas las doce partículas elementales y las tres fuerzas que, cuando se mezclan y se encajan, sirven para construir todo lo que hay en el universo, desde un redondo pan de pueblo hecho en un horno de leña, hasta las más complejas galaxias, y puede explicar todos los mecanismos de acción, es decir, la mecánica del mundo.

Entre las partículas figuran los seis Quarks famosos: arriba, abajo, extraño, encanto, fondo y . Las otras seis partículas son Leptones: el electrón y sus dos parientes más pesados, el muón y el tau y los tres neutrinos a ellos asociados. Las tres fuerzas son la electromagnética, la fuerza nuclear fuerte (que mantiene unidos a los quarks) y la fuerza nuclear débil (responsable de la radioactividasd). Hay una cuarta fuerza: la Gravedad que, aunque tan importante como las demás, nadie ha sabido como encajarla en el modelo estándar. Todas las partículas y fuerzas de este modelo son cuánticas; es decir, siguen las reglas de la mecánica cuántica. Aún no existe una teoría de la gravedad cuántica.

En realidad, la región que denominamos Gravedad cuántica nos lleva y comprende preguntas sobre el origen del universo observable que nadie ha sabido contestar. Nos lleva a complejos procesos cuánticos situados en las épocas más cercanas imaginables en un espacio-tiempo clásico, es decir, en lo que se conoce como Tiempo de Planck a 10-43 segundos del supuesto big bang, cuando reinaba una temperatura del orden de 10 x 1031 K. Pero, como hemos dicho, al no existir una teoría autoconsistente de la Gravedad cuántica, lo único que podemos hacer (como en tantas otras áreas de la Ciencia) es especular.

El Modelo Estándar no es, ni mucho , satisfactorio. Los científicos piensan que no sólo es incompleto, sino que es demasiado complicado y, desde hace mucho tiempo, buscan, incansables, otro modelo más sencillo y completo que explique mejor las cosas y que, además, no tenga (como tiene el modelo actual) una veintena de parámetros aleatorios y necesarios para que cuadren las cuentas…, un ejemplo: el bosón de Higgs necesario para dar masa a las partículas.

¡La masa! ese gran problema. Todas las partículas masa diferentes pero nadie sabe de donde salen sus valores. No existe fórmula alguna que diga, por ejemplo, que el quark extraño debería pesar el (o lo que sea) del quark arriba, o que el electrón deba tener 1/200 (u otra proporción) de la masa del muón. Las masas son de todo tipo y es preciso “ponerlas a mano”, como se suele decir: cada una ha de ser medida experimental e individualmente. En realidad, ¿por qué han de tener masa las partículas? ¿de dónde viene la masa?

No puedo evitarlo ni tampoco me puedo quedar callado, he asistido a alguna conferencia sobre la materia y, el ponente de turno se agarra a la “materia oscura” para justificar lo que no sabe, si al final hay debate, entro en escena para discutir sobre la existencia de esa “materia fantasma” que quiere tapar nuestra enorme ignorancia.

Pero, sigamos con el de la masa. Para resolverlo, muchos expertos en física de partículas creen actualmente en algo que llaman “campo de Higgs”. Se trata de un campo misterioso, invisible y etéreo que está permeando todo el espacio (¿habrán vuelto al antiguo éter pero cambiándole el nombre?). que la materia parezca pesada, como cuando tratamos de correr por el fondo de la piscina llena de agua pero que el agua no se pudiera ver. Si pudiéramos encontrar ese campo, o más bien la partícula la partícula que se cree es la manifestación de ese campo (llamada el bosón de Higgs), avanzaríamos un largo trecho hacia el conocimiento del universo.

Aquí, en este imponente artilugio inventiva de nuestras mentes, se quiere dar respuesta a una serie de interrogantes que se espera solucionar con este experimento:

• Qué es la masa.

• El origen de la masa de las partículas

• El origen de la masa para los bariones.

• El número exacto de partículas del átomo.

Claro que, si no fuera tan largo de contar, os diría que, en realidad, el de Higgs se descubrió hace ya muchos siglos en la antigua India, con el nopmbre de maya, que sugiere la idea de un velo de ilusión para dar peso a los objetos del mundo material. Pocos conocen que, los hindúes fueron los que más se acercaron a las modernas sobre el átomo, la física cuántica y otras teorías actuales. Ellos desarrollaron muy temprano sólidas teorías atomistas sobre la materia. Posiblemente, el pensamiento atomista griega recibió las influencias del pensamiento de los hindúes a través de las civilizaciones persas. El Rig-Veda, que data de alguna fecha situada entre el 2000 y el 1500 a. C., es el primer texto hindú en el que se exponen unas ideas que pueden considerarse leyes naturales universales. La ley cósmica está realcionada con la luz cósmica.

Anteriores a los primeros Upanishads tenemos en la India la creación de los Vedas, visiones poéticas y espirituales en las que la imaginación humana ve la Naturaleza y la expresa en creación poética, y después va avanzando unidades más intensamente reales que espirituales hasta llegar al Brahmán único de los Upanishads.

la época de Buda (500 a, C.), los Upanishad, escritos durante un período de varios siglos, mencionaban el concepto de svabhava, definido “la naturaleza inherente de los distintos materiales”; es decir, su eficacia causal única, , tal como la combustión en el caso del fuego, o el hecho de fluir hacia abajo en el caso dela agua. El pensador Jainí Bunaratna nos dijo: “Todo lo que existe ha llegado a existir por acción de la svabhava. Así… la tierra se transforma en una vasija y no en paño… A partir de los hilos se produce el paño y no la vasija”.

El pensamiento Hindú tendrçia que ser mejor estudiado

También aquellos pensadores, manejaron el concepto de yadrccha, o azar desde tiempos muy remotos. Implicaba la falta de orden y la aleatoriedad de la causalidad. Ambos conceptos se sumaron a la afirmación del griego Demócrito medio siglo más tarde: “Todo lo que hay en el universo es fruto del azar y la necesidad”. El ejemplo que que dio Demócrito -similar al de los hilos del paño- fue que, toda la materia que existe, está formada por a-tomos o átomos.

Bueno, no lo puedo evitar, mi imaginación se desboca y corre rápida por los diversos pensamientos que por la mente pasan, de uno se traslada a otros y, al final, todo resulta un conglomerado de ideas que, en realidad, quieren explicar, dentro de esa diversidad, la misma cosa.

emilio silvera

Mar

14

Bosques y Praderas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Naturaleza ~

Clasificado en Naturaleza ~

Comments (3)

Comments (3)

Desde tiempos inmemoriales, la Humanidad ha venido esquilmando, sin saber administrarla, la materia prima que la Naturaleza le ofrecía su sustento y, han sido devastadas cientos de miles de hectareas de bosque persiguiendo objetivos diversos pero, sin pensar en el futuro.

Los bosques almacenan la mayor parte de la fitomasa terrestre, entre tres cuartos y nueve décimos del total. La razón de tanta incertidumbre en estimación se debe a la rápida deforestación tropical, la falta de una clasificación uniforme de los bosques y a su alta variabilidad.

Quema de Bosques en el Sur de México para uso agrario

Los bosques cerrados (en contraste con los bosques abiertos) se pueden definir como ecosistemas cuya cubierta ocupa entre el 20 y el 40 por ciento del suelo. Nuestro escaso conocimiento de los bosques tropicales implica que tengamos que extrapolar almacenamientos típicos de un inadecuado de terrenos bien estudiados. El mejor inventario disponible establece que, a principios de los noventa, el área total de bosques cerrados era de aproximadamente 25 millones de Km2, dos quintas partes de los cuales estaban situados en los trópicos. La superficie total de todos los bosques es aproximadamente el doble; almacenan cerca de nueve décimas partes de la fitomasa del planeta y están casi equitativamente repartidos entre los biomas tropicales, templaros y boreales.

En el bosque tropical se encuentra el máximo almacenamiento medio de fitomasa. Desde el aire, las copas de los árboles muestran una decepcionante uniformidad, vistas desde aviones a reacción y de un rojo intenso en las imágenes con falso color de los satélites. Desde el suelo umbrío, frecuentemente con escasa maleza, se elevan los troncos de los árboles, rectos, otros delgados, algunos enormes y también apuntalados; luego un revoltijo de ramas superpuestas, lianas y epifitos. Un claro del bosque o la orilla de una corriente muestran la estructura en capas de esta selva.

Los bosques tropicales más espesos de la Amazonia albergan en cada hectárea casi 100.000 plantas de más de seiscientas especies vegetales diferentes. Pero al menos tres cuartas partes de la fitomasa almacenada (unas 600 toneladas por hectárea) se encuentran en las copas de pocos cientos de árboles que sobresalen.

Debido a la alta biodiversidad de la selva, ningún árbol almacena más de un pequeño porcentaje de toda la fitomasa. Ésta es una estrategia evasiva que ha incrementado las posibilidades de supervivencia en un ambiente rebosante de predadores de semillas y agentes patógenos. Otras defensas activas son sus finas cortezas o la simbiosis con hormigas guardianas.

Por el contrario, en los bosques templados y en los boreales domina una sola especie de árbol, y sin embargo, su almacenamiento de fitomasa supera a los bosques tropicales más espesos. Los máximos del planeta se dan en las costas del noroeste del océano Pacífico, donde los bosques de secuoyas pueden llegar a almacenar, por encima del suelo, 3.500 toneladas de fitomasa por hectárea, lo que representa una cantidad cinco veces mayor que en la Amazonia central. Estos árboles son los seres vivos más altos (más de 100 metros) y más pesados (más de 300 toneladas) del planeta (las ballenas azules adultas pesan alrededor de las 100 tonelas).

En todos los bosques, los tejidos leñosos por encima del nivel del suelo (tronco, corteza, ramas) contienen la mayor de la fitomasa (70 – 80 por ciento) del árbol; las raíces almacenan entre el 10 y el 35 por ciento, las acículas un 1’5 – 8 por ciento y las hojas sólo el 1 – 2 por ciento.

El tronco cortado en la forma tradicional su comercialización contiene solamente la mitad de toda la fitomasa, mientras que los troncos demasiados delgados, el tocón, ramas, corteza, artículos y hojas suman la otra mitad.

En un buen bosque en crecimiento, templado o boreal, se obtienen entre 85 y 100 m3/ha (35 – 50 t/ha en seco, dependiendo de la clase de árbol); en los bosques tropicales pueden llegar 180 m3/ha. Con los nuevos métodos de corta, para obtener pulpa se utiliza todo el árbol (a menudo hasta el tocón), recuperándose prácticamente toda la fitomasa.

producir un kilogramo de fitomasa nueva, los árboles tropicales requieren hasta 12 g de nitrógeno, mientras que un bosque de coníferas necesita menos de 4 g. Los bosques templados, con unas tasas relativamente altas de crecimiento y un uso económico de los nutrientes, son productores relativamente eficientes de fitomasa.

Todas la civilizaciones preindustriales cortaron madera, no sólo material de construcción indispensable, sino también como combustible, bien quemado directamente o transformándolo previamente en carbón. La contribución de los bosques a la energía global primaria ha ido declinando según ha aumentado el consumo de combustibles fósiles, pero su presencia ha seguido creciendo, tanto como suministradores de madera y pulpa como por su función de albergues de alta biodiversidad y por sus servicios como ecosistemas insustituibles.

El ámbito de las praderas

La extensión global de las praderas ha cambiado profundamente desde la mitad del siglo XIX. El principal motivo de cambio es el de transformar las praderas en tierras de cultivo, lo que ha provocado la disminución, en superficie, de este bioma, pero por otra parte, según avanza la deforestación han surgido praderas secundarias.

Aunque la extensión de las praderas es casi igual a la de los bosques cerrados, la diferencia sus respectivos promedios de fitomasa almacenada sobre el nivel del suelo por unidad de superficie (20 t/ha en hierba, 250 t/ha en fitomasa leñosa) es de un orden de magnitud. Hay, sin embargo, más fitomasa en las praderas de lo que parece a simple vista, porque salvo en las hierbas altas tropicales, la fitomasa subterránea es varias veces mayor que en los árboles en lo que se refiere a los brotes en su cubierta.

La cantidad de fitomasa contenida en los renuevos está comprendida entre de 1 t/ha, en regiones semidesérticas, hasta más de 20 t/ha en algunas praderas tropicales. Si se incluyen los tallos secos, la fitomasa aérea llega a alcanzar las 35 t/ha. En regiones con clima semihúmedo tropical, y en climas templados con irrigación natural, las mayores acumulaciones de fitomasa se encuentran en los renuevos. En general, es indiscutible la correlación entre la cantidad de fitomasa y la de lluvia, aunque esta relación pierde importancia en condiciones de humedad elevadas.

Los valores extremos de la cantidad de fitomasa subterránea global varía entre menos de 0’5 t/ha en los trópicos, hasta casi 50 t/ha en las praderas templadas (media de 20 t/ha). Con cerca de 10 t/ha al año, la productividad media de las praderas templadas iguala la de los bosques en latitudes medias.

Una gran cantidad de herbívoros se alimentan de las praderas. Solamente las hojas tiernas tienen un alto contenido en proteínas y son relativamente digestibles. Los tallos y los troncos son peores en ambos aspectos, pero componen la mayor parte de la de algunas especies que comparten las praderas con otros animales. En la estación seca del Serengueti, la dieta de los ñus se compone aproximadamente de un 20 por ciento de hojas y un 30 por ciento de tallos, mientras que para las cebras los correspondientes valores son de menos del 1 por ciento y de más del 50 por ciento respectivamente.

Una sola especie numerosa de invertebrados puede consumir una pequeña fracción de la producción anual de fitomasa, y el consumo total de todos los invertebrados está comprendido entre el 10 y el 20 por ciento. Los ungulados consumen el 60 por ciento de la producción de fitomasa aérea de las fértiles praderas del este de África. Algunas hierbas se adaptan para evitar su excesivo consumo incorporando a su composición sustancias que disminuyen su digestibilidad, y compuestos tóxicos; otras reaccionan con un rápido crecimiento cuando son dañadas por los animales que pastan.

En el Serengueti, donde las praderas sirven de alimento a la mayor concentración de grandes herbívoros del mundo, así como a muchos otros animales de menos tamaño y a numerosos invertebrados, un moderado consumo de hierba aumenta la producción de la misma hasta el doble de la que se produce en terrenos donde no se pace. El césped es la prueba más asequible de la productividad, no siempre deseada, de la pradera.

emilio silvera

Mar

13

¡Conocer la Naturaleza! No será nada fácil

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Sus dimensiones y masa le permiten ¡lo imposible! para nosotros. La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una que nosotros llamamos fuerza de Van der Vaalls. esta fuerza tiene un alcance muy corto. para ser más precisos, diremos que la intensidad de esta fuerza a una distancia r es proporcional a 1/r7. Esto significa que si se reduce la distancia entre dos átomos a la mitad, la fuerza de Van der Vaalls con la que se atraen uno a otro se hace 2 x 2 x 2 x 2 x 2 x 2 x 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza.

La mecánica cuántica domina en el micromundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es como una onda de agua. Se parece más a una ola de histeria que se expande: es una onda de . Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

Por el , la relatividad general era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la de agujeros negros.

Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el y distorsiona el tiempo.

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica.

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad de Einstein? Afortunadamente, hay una respuesta y las unidades de Planck nos dicen cuales son. En realidad, es la propia Naturaleza la que marca esos límites que Stoney-Planck, supieron plasmar en ecuaciones que los marcan.

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 de centímetros, más joven que el tiempo de Planck, 10-43 segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1.975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

La velocidad de la luz en el vacío es por definición una constante universal de valor 299.792.458 m/s (suele aproximarse a 3·108 m/s), o lo que es lo mismo 9,46·1015 m/año; la segunda cifra es la usada para definir al intervalo llamado año luz. La se transmitirá a esa velocidad como máximo, nuestro Universo, no permite mayor rapidéz, al menos, por los métodos convencionales.

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1.981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos.

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de producida hasta ahora. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

Stoney Planck

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, desde el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un que recree la escala logarítmica de tamaño desde el átomo a las galaxias.

Todas las estructuras del universo porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón

“Tras medir alfa en unas 300 galaxias lejanas, vimos un patrón constante: este número, que nos dice la fuerza del electromagnetismo, no es igual en otras partes que en la Tierra, y parecer variar de forma continua a lo largo de un eje”. Algunos se empeñan en variar la constante de estructura fina y, si eso llegara a producirse… las consecuencias serían funestas para nosotros. Otros nos dicen que esa constante, no ha variado a lo largo de los miles de millones de años del Universo y, así debe ser, o, si varió, lo hizo en una escala ínfima.

|

α = 2πe2 / hc ≈ 1/137 |

|

αG = (Gmp2)2 / hc ≈ 10-38 |

Si varian algunas de las dos en sólo una diezmillonésima, muchas de las cosas que conforman el Universo serían imposible y, la consecuencia sería, la ausencia de vida. La identificación de constantes adimensionales de la naturaleza como a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

“Todos los físicos del mundo, deberían tener un letrero en el lugar más visible de sus casas, para que al mirarlo, les recordara lo que no saben. En el cartel sólo pondría esto: 137. Ciento treinta y siete es el inverso de algo que lleva el de constante de estructura fina”

Lederman

Este guarda relación con la posibilidad de que un electrón emita un fotón o lo absorba. La constante de estructura fina responde también al nombre de “alfa” y sale de dividir el cuadrado de la carga del electrón, por el de la velocidad de la luz y la constante de Planck. Tanta palabrería y numerología no significan otra cosa sino que ese solo numero, 137, encierra los misterios del electromagnetismo (el electrón, e–), la relatividad (la velocidad de la luz, c), y la teoría cuántica (la constante de Planck, h).

Todo eso está relacionado: leyes fundamentales, constantes, materia y espacio tiempo… ¡nosotros!

emilio silvera

Totales: 84.684.722

Totales: 84.684.722 Conectados: 73

Conectados: 73