Ago

25

Si la respuesta es…¡El Universo! ¿Cuál es la pregunta?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (2)

Comments (2)

El pensamiento “generalizado” hoy en día en la mayoría de los astrónomos, astrofísicos y demás científicos afines a la ciencia del Universo, es que, pueden existir miles de planetas habitados dentro de nuestra propia Galaxia, la Vía Láctea. Ahora sabemos que el Universo no conoce límite alguno ni en el espacio ni en el tiempo que, según todos los indicios, ha estado expandiéndose durante 13.700 millones de años que, es un período de tiempo más que suficiente para que las estrellas que han existido desde entonces, tuvieran el tiempo necesario para producir todos los elementos que conocemos y que hicieron posible el surgir de la vida aquí en la Tierra y…probablemente, en “otras Tierras” que en la Galaxia Vía Láctea estén, y, de la misma manera, en los miles de millones de galaxias que pueblan el vasto universo que hemos llegado a conocer.

Más allá de la meta-galaxia, a la que pertenecen todos los sistemas galácticos que conocemos, tienen, necesariamente, que existir otros mundos que, como el nuestro, estén habitados por seres de toda índole y pelaje, inteligentes también. La meta-galaxia consta de hiper-galaxias, es decir, de grupos de sistemas galácticos. Nuestro sistema galáctico cuenta con dos “satélites”:

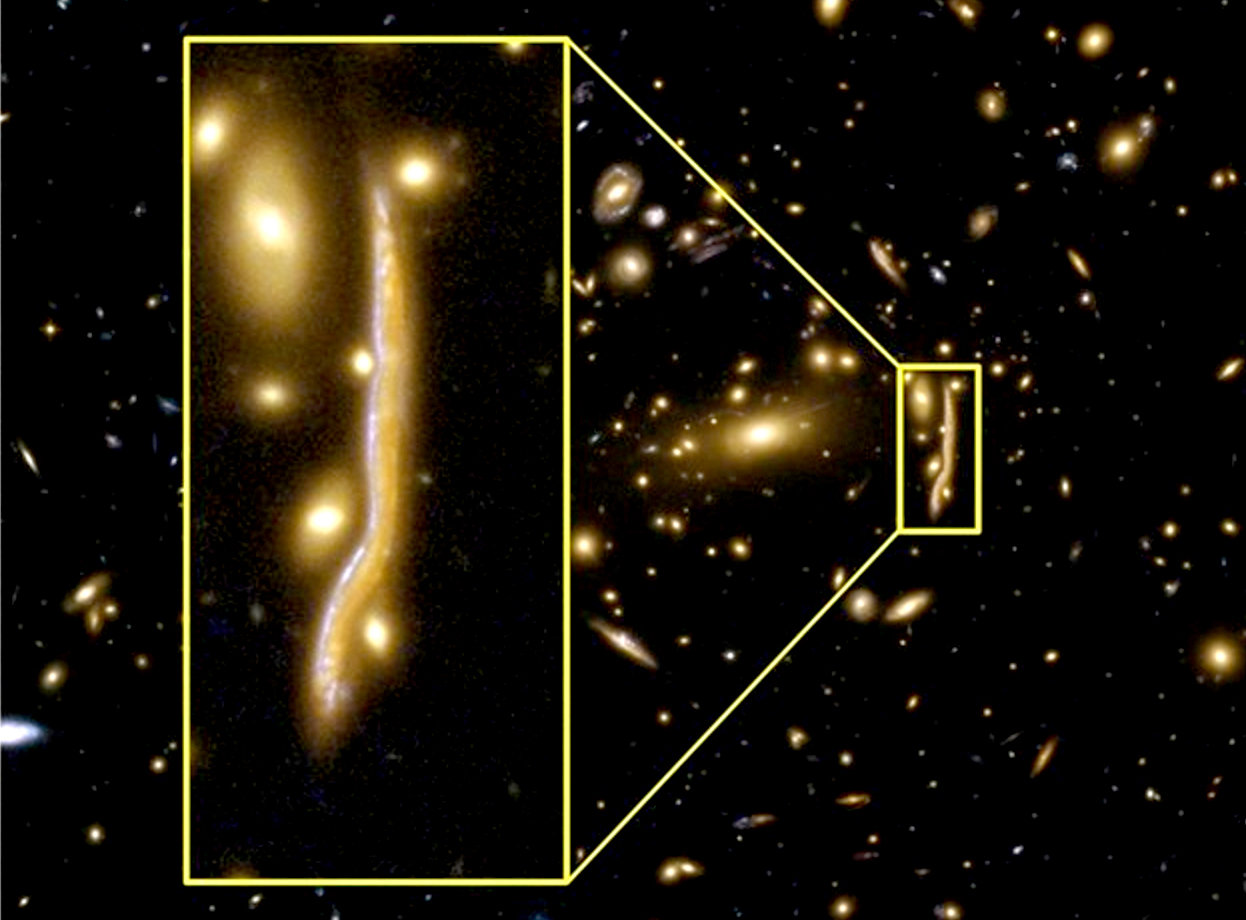

La Gran Nebulosa de Magallanes (la 1ª de arriba), distante 38.000 Parsec de nosotros y la Pequeña Nebulosa de Magallanes (la segunda), a 36.000 Parsecs. La Nebulosa de Andrómeda es un sistema compuesto por cinco galaxias. Por lo general existen “puentes” de estrellas entre galaxias que constituyen un grupo. Se podría decir que que los grupos de galaxias estarían unidos por hilos de estrellas de manera tal que, muchas veces, nos cuesta trabajo asegurar a qué galaxia pertenece una estrella determinada.

Tengo la suerte de que, Ken Crawford (Rancho Del Sol Obs.), me envíe regularmente imagines que obtiene en su Observatorio, y, en esta ocasión, recibí la imagen de la gran y bella galaxia espiral NGC 7331 que es a menudo vendida como una análoga a nuestra Vía Láctea. Está situada a 50 millones de años luz de distancia en la norteña constelación de Pegaso. En la imagen podemos vislumbrar otras galaxias que achican su imagen debido a que sus distancias están mucho más alejadas de nosotros.

La Constelación de Virgo cuenta con más de 3.000 galaxias, la Cabellera de Berenice con más de 10.000. Las super-galaxias tienen un diámetro de 30 o 40 mega-parsecs. No conocemos el número exacto de super-galaxias cuyos conjuntos constituyen las mega-galaxias. Y, sin embargo, la meta-galaxia es sólo una pequeña fracción del “universo infinito” de un universo que, para nuestro tiempo, se podría decir que existe desde la eternidad y que existirá también eternamente (aunque sabemos que no es así), al menos nos lo puede parecer.

Nuestro Universo está cuajado de maravillas como ésta. La Galaxia de la rueda de la carreta (también conocido bajo el nombre de ESO 350-40) es una galaxia lenticular o anular situada a cerca de 500 millones de años luz de distancia en la constelación del escultor en el hemisferio meridional. Es rodeada de un anillo de 150 000 años de luz de diámetro, compuesto de estrellas jóvenes y brillantes. Esta galaxia era una galaxia idéntica a la Vía láctea antes de que sufra una colisión frontal con una galaxia vecina. Cuando galaxia vecina atravesó la Galaxia Cartwheel, la fuerza de la colisión causó una onda de choque poderosa sobre la galaxia, como una piedra echada en las tranquilas aguas de un estanque. Desplazándose a gran velocidad, este onda de choque barrió el gas y el polvo, creando así un halo alrededor de la parte central de la galaxia quedada indemne. Esto explica la nube azul alrededor del centro, la parte más brillante.

Observando la imagen con su collar de perlas azulado compuesto por brillantes y radiantes estrellas, nos hablan de una ingente producción de elementos complejos que, en el futuro, pasarán a formar parte de los mundos nuevos y, en ellos, con el tiempo, surgirá también la vida nueva de vaya usted a saber qué criaturas.

El Universo es una maravilla, y, cualquier objeto que podamos mirar nos podrá llevar al más alto grado de éstaxis. A mí me pasó con la luna Titán que visto a contraluz por la nave Cassini en órbita alrededor de Saturno. La atmósfera dispersa la luz del Sol mostrando un anillo completo mientras se filtra por las capas más altas. En este pequeño mundo de ríos de metano y atmósfera imposible, se han puesto altas esperanzas de que, en un futuro, pudiera surgir allí la vida. Es similar a nuestra Tierra de hace algunos millones de años.

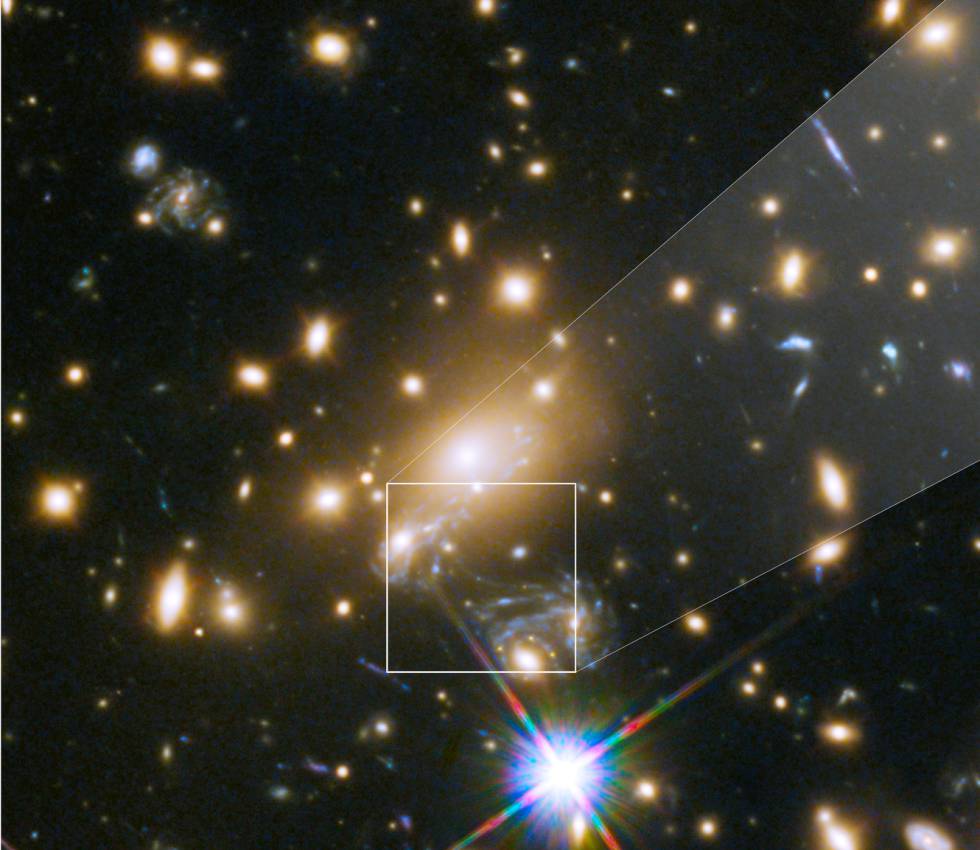

El cúmulo de galaxias MACS J0717 localizado a 5400 millones de años luz, en una imagen lograda combinando datos ópticos del Hubble y en rayos-X del Chandra, muestra a cuatro cúmulos colisionando. Si hemos podido llegar hasta aquí, una voz en nuestra mente pregunta: ¿Hasta dónde podremos llegar?

La galaxia NGC 55, fotografiada por el observatorio de La Silla utilizando el Wide Field Imagen del telescopio de 2.2 metros MPG/ESO. ¿Cuántos mundos estarán ahí presentes? y, ¿tendrá alguno presencia de vida?

“NGC 55, es una galaxia irregular localizada en la constelación de Sculptor. Está ubicada a unos 7 millones de años luz de distancia en la constelación Sculptor. Junto con su vecino NGC 300, es una de las galaxias más cercanas al Grupo Local, probablemente entre la Vía Láctea y el Grupo de Sculptor.”

Arp 261, un par de galaxias localizadas a 70 millones de años luz, fotografiadas por el instrumento FORS2 del VLT en Cerro Paranal. La riqueza de la imagen nos puede llevar (mediante un estudio profundo) a saber lo mucho que en ella está presente, estrellas surgidas de inmensas nubes de gas interestelar, mundos nuevos llenos e promesas futuras y, otros, más viejos que, pudieran tener los vestigios de Civilizaciones perdidas.

NGC 4194, la Galaxia Medusa, el resultado de la colisión entre dos galaxias, mostrada con datos ópticos del Telescopio Hubble y datos en rayos-x del Telescopio Chandra. La imagen nos habla de vestigios que están en el universo y nos cuentan dramáticas historias de galaxias que dejaron de existir para convertirse en otra nueva que, conteniendo materiales más complejos que aquellas primarias, hacen posible el surgir de estrellas cuyos materiales son más sofisticados que el simple hidrógeno, y, de esas estrellas descendientes de algunas generaciones anteriores…qué materiales podrán salir?

Primavera en el Polo Sur de Marte

Hemos podido admirar, la región de Rupes Tenuis fotografiada por la Mars Express de la ESA, mostrando gran cantidad de nieve sobre el polo marciano. Marte, el planeta hermano, nos tiene que dar muchas sorpresas y, a no tardar mucho (menos de 30 años), podremos por fin cobrar la apuesta del café que hice con algunos amigos sobre si había o no alguna clase de vida en aquel mundo.

El trío de galaxias Hickson 90, un grupo compacto localizado en la constelación de Piscis Austrinus a 100 millones de años luz del Sol. Fotografiado por el Telescopio Espacial Hubble. Viendo objetos como los de arriba, podríamos preguntarnos: ¿Cuándo dejará de sorprendernos el Universo? ¡Es tanta su riqueza!

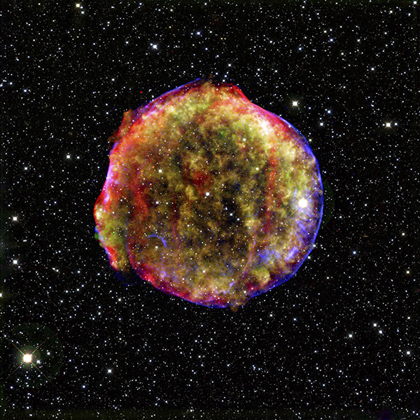

La supernova de Tycho, localizada en Cassiopeia y mostrada en una imagen tomada en rayos-X por el telescopio Chandra y en luz infrarroja por el telescopio Spitzer. No por haberla visto muchas veces deja de sorprendernos, esa masa inmensa que, como remanente de los restos de una estrella masiva, nos muestra los filamentos de plasma que crean campos magnéticos a su alrededor sin importar el tiempo transcurrido desde el suceso. En dicha explosión se produjeron miles de toneladas de oro y platino que regaron el espacio interestelar para formar parte, más tarde, de algún mundo perdido.

La siempre fascinante Eta Carinae está escondida detrás de una de las nebulosas más grandes y brillantes del cielo en una imagen tomada desde La Silla utilizando el ESO/MPG de 2.2 metros. Aquí contemplamos parte de la Nebulosa, la estrella, una de las más grandes conocidas (unas 100 masas solares) parece que está a punto de explotar, y, sus consecuencias, podrían ser impredecibles.

La galaxia espiral M 101, localizada a 22 millones de años luz, en una imagen compuesta por datos del telescopio Chandra, el telescopio Hubble y el telescopio Spitzer. La bella y enorme galaxia está cuajada de estrellas nuevas y otras que no lo son tanto. El conjunto parece una luminaria de feria, la radiación que se expande por toda la galaxia no parece que sea un lugar muy seguro. Prefiero nuestra Vía Láctea.

Atípica y extraña Galaxia. Una nueva imagen del Telescopio Espacial Hubble revela finos detalles de la galaxia espiral NGC 4921 y los objetos circundantes de fondo. La diversidad en el Universo es la norma y, por mucho que podamos pensar en objetos extraños que puedan existir, ahí estarán.

Una imagen que combina luz visible y rayos-X y muestra la actividad del agujero negro super-masivo en la galaxia Centaurus A. Los Agujeros Negros que pueden contener miles y millones de masas solares, son tan peligrosos que, nada de lo que deambule por sus alrededores estará seguro. Se engulle toda la materia que caiga en su radio de acción, su fuerza de gravedad es descomunal y, por mucho que queramos correr, nos atrapará. Ya sabéis, ni la luz es capaz de burlar su fuerza de atracción.

¡Increíble región de formación estelar! NGC 604, una zona formación estelar en la galaxia M 33. Imagen capturada en alta resolución por el telescopio espacial de rayos-X Chandra. No podéis ni imaginar la enorme cantidad de estrellas jóvenes y masivas que están ahí presentes, sus emisiones de radiación ultravioleta producen fuertes vientos solares que dibujan las formas de las nubes circundantes formando arabescas figuras de gas ionizado por el ultravioleta que tiñe de azul toda la región.

La variedad está servida, el prolífico Universo nos suministra de toda clase de objetos activos que, mediante transiciones de fase, pasen a convertirse en otros objetos distintos de lo que en un principio fueron. Nada permanece, todo se transforma. Es es la regla de oro que impone un Universo dinámico creador de materia en el espacio-tiempo infinito que nunca podremos dominar, y, si nos permite seguir en este maravilloso Sistema de Galaxias y mundos, podremos, en el futuro, conocer a nuestros hermanos inteligentes y, si las cosas salen como deberían salir, formaremos una Federación de mundos en la que, por fin, impere la igualdad para todos dentro de un clima de mutuo respeto y en el que, la sabiduría adquirida a través de muchas civilizaciones que fueron, nos habrá dado, ese algo del que ahora carecemos: Racionalidad y Temple, Sabiduría para poder discernir sobre lo que verdaderamente tiene valor y aquello que sólo es el falso brillo de la gloria y el poder que sólo puede traer destrucción y mal para muchos.

Esperemos que, observando el Universo y mirando dentro de nuestras Mentes, podamos llegar a comprender que, nuestro destino, no depende de nosotros pero sí, podremos mejorarlo si nuestro comportamiento contribuye a que sea mejor.

Si la respuesta es…¡El Universo! ¿Cuál es la pregunta?

La única que podría ser: ¿Qué es lo que todo lo contiene?

Emilio Silvera V.

Ago

25

Desde el pasado al presente…¿Qué será de mañana?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (2)

Comments (2)

La ruta de la seda que tantos sueños despertaron en las mentes de muchos

La investigación rigurosa del pasado con el fin de descubrir las raíces humanas, la percepción y el estudio de las diferencias culturales, el interés por indagar los mecanismos profundos que gobiernan los sistemas económicos y sociales, e incluso el análisis del funcionamiento de la mente humana, surgieron y se desarrollaron en épocas relativamente recientes. Salvo la Psicología, que tiene una original y larguísima y valiosa tradición en la India, las restantes ciencias sociales son una creación propia de de la cultura europea occidental, lo que no deja de llamar la tención de muchos estudiosos puesto que culturas milenarias con trayectorias prácticamente ininterrumpidas como la de China e India parecían las masa adecuadas para que de ellas surgieran disciplinas como Historia, la Economía o la Sociología. Es curioso el indagar sobre la génesis y los primeros logros de las ciencias que tienen como objeto el hombre y la sociedad que este ha creado.

Hemos pasado de la tradición oral a las bibliotecas y, ahora… ¡Internet!

Antes de la invención de la escritura, la cultura humana ya se había desarrollado extensamente en áreas tan variadas como las artes plásticas, la religión, , la agricultura, la poesía y las técnicas de la metalurgia, la alfarería y de la construcción. Nuestra especie, comenzó a crear Sociedades de convivencia que ganaron estadios superiores en áreas hasta entonces desconocidas.

Pero incluso después de que se generalizaran los escritos, la transmisión oral y la memorización de los acontecimientos continuaron siendo imprescindibles durante mucho tiempo, por lo que el cultivo y mejoramiento de la memoria humana fue una de las grandes preocupaciones de la Antigüedad.

Sutra del Diamante, hallado en la cueva de Dunhuang (China).

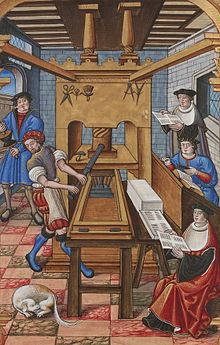

Es el documento impreso de fecha conocida más antiguo que se conserva. Fue realizado el 11 de mayo del año 871. La imprenta es un método mecánico destinado a reproducir textos e imágenes sobre papel, tela u otros materiales. En su forma clásica, consiste en aplicar una tinta, generalmente oleosa, sobre unas piezas metálicas (tipos)para transferirla al papel por presión. Aunque comenzó como un método artesanal, su implantación trajo consigo una revolución cultural.

Muchos expertos estudiosos han sido los que han explicado el largo proceso de seguido por la Humanidad desde que empleo las antiguas técnicas de memorización y recitación hasta la invención de la imprenta de tipos móviles, la producción masiva de libros y su clasificación y conservación en extensas bibliotecas.

Culturas como la China, la Japonesa y la Coreana, fueron pioneras en la utilización de la imprenta, pero sería el europeo Gutemberg quien le dio el impulso definitivo que había de convertirla en la herramienta básica de la cultura moderna.

Del mito a la construcción del pasado histórico.

Sin embargo, hasta el siglo XV no aparecería un pionero que introdujera las primeras técnicas de lo que hoy conocemos como crítica histórica. En efecto, fue Lorenzo Valla quien utilizó por primera ves el conocimiento de la gramática histórica para descubrir anacronismos en documentos falsificados y quien aplicó el análisis filológico y del estilo para fijar autoría de libros y documentos.

Por otra parte, también durante los siglos y XV y XVI surgió el interés por el estudio de las ruinas, sobre todo las de Roma, aunque no fue hasta el XVIII, con la obra de Johann Joachim Winckekmnn, que se sentaron las bases de la formación de la moderna arqueología: esta conocería durante esta centuria y la siguiente un espectacular desarrollo.

De la construcción del pasado al análisis del presente.

Boorstin demuestra finalmente cómo el descubrimiento y la colonización americana fueron elementos fundamentales para que surgiera la Antropología y la Etnología y, con ellas, ideas como la del origen común de toda la humanidad, a pesar de la diversidad racial y cultural.

Más propias de los siglos XVIII y XIX son la Economía, la Sociología y la Psicología , de las que Adam Smith, Jonh Graunt y Sigmund Freud fueron, más que precursores, auténticas fundadores. Hay otras aportaciones considerables como las de David Ricardo, Kal Marx, o John Mynard Keynes en los análisis económicos. Malthus en los estudios demográficos y Adolphe Quletet en la Estadística aplicada a la sociología.

Pero, todo este recorrido, estaría falto de algo esencial, los descubrimientos de la Física del siglo XIX que han posibilitado a los físicos de nuestro tiempo conquistar los secretos de la constitución íntima de la materia, llegando hasta las constituyentes del núcleo atómico.

Es verdad, aquellos que comentó Valery, cuando en 1924 dijo: “El hombre sólo está en mala compañía” Sí, el hombre es eminentemente un animal social y, necesita, que sus congéneres sean sabedores y admiradores de sus obras. Sin otros que vean lo que haces el esfuerzo tendrá menor sentido. Se estaba refiriendo a la divulgación de los conocimientos, de los descubrimientos, de que investigar sin divulgar tenía poco o ningún valor.

Desde la noche de los Tiempos todos quisieron divulgar su obra, sus pensamientos

Con todo este repaso llegamos a la conclusión de que debimos descubrir la historia antes de poder explorarla. Y, como he dicho antes, los mensajes del pasado se transmitían primero a través de las habilidades de la memoria, luego de la escritura, y, finalmente, de manera explosiva en los libros. Y, en el Presente ha entrado en nuestro “mundo” ¡Internet!

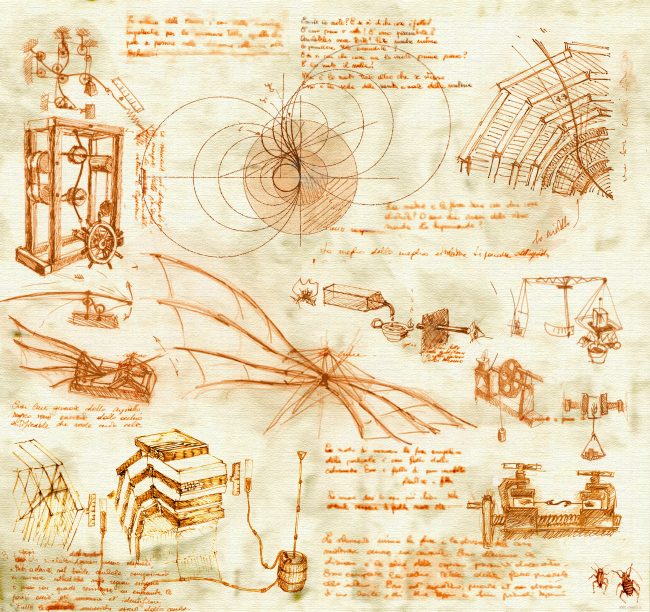

Los pensamientos llevados a la escritura para decir al mundo cómo están conformadas las cosas, la Naturaleza y el Universo mismo. Todo lo que se fragua en nuestras Mentes son fruto del conocimiento.

El insospechado tesoro de reliquias que guarda la tierra se remontaba a la prehistoria. El pasado se convirtió en algo más que un almacén de mitos o un catálogo de lo familiar. Nuevos mundos terrestres y marinos, riquezas de continentes remotos, modos de vida de pueblos lejanos, abrieron nuevas perspectivas en nuestras mentes que, así, de esa manera, comprendieron que, muchos antes que nosotros estuvieron aquí y crearon grandes cosas, hicieron grandes ciudades, inventaron grandes formas de vivir y elevaron los grupos humanos a la categoría de Sociedad, de Civilización que trajeron progreso y novedades,

Así, las nuevas formas cotidianas de convivencia en Sociedad, llevó a estos seres a tener que aprender a convivir de distinta manera, a compartir con los demás y, se dio cuenta de que, las ideas, en conjunto, alcanzaban cotas mayores y mayores logros también no quedando perdidas como tantas veces ocurrió a lo largo la Historia de la Humanidad.

Claro que, hoy tenemos una idea muy clara: Toda la Humanidad es una. El origen y el destino de todos… ¡Es el mismo! Estamos abocados y supeditados (si perduramos en el Tiempo), al destino del Sol. El final de su “vida” nos obligará a dejar este mundo y buscar acomodo en otros, claro que…

Sin embargo, nos falta dar el paso final y hacer que esa unidad sea realmente cierta, estamos en la edad de la globalización (interesada), las noticias diarias nos traen escenas de cualquier parte del mundo en tiempo real, y, sin embargo, las diferencias continúan.

Necesitamos un sólo Gobierno Mundial, un Consejo compuesto por seres de todo el planeta y que rija nuestros destinos y distribuya las riquezas de manera proporcional al número de la población de cada región. La igualdad debe estar presente en todas partes. No hablar de ella con bonitas palabras en un alto estrado, NO, sino que, se deben evitar desigualdades que, a estas alturas están fuera de lugar. Si las riquezas del Mundo se reparten de manera justa… ¡Se erradicará el hambre y la enfermedad en no pocos casos! Y, sobre todo, hay que dar conocimiento a todos.

Así se conforman los pobres para no caer en la desesperación e impotencia

Es imperdonable que puedan existir algunas personas (unos pocos cientos de miles, o, incluso algunos millones) que domine el 90% de toda la riqueza mundial. Eso no es moral. Algunas familias, para que sus hijos puedan estudiar están pasándolo mal y tienen carencias de necesidades primarias, mientras que otros, tienen a sus hijos estudiando en el extranjero en colegios por los que paga en un año lo que aquí en España se paga por todo el curso, y, los padres del primero están pasando necesidades mientras que, los del segundo, su mayor preocupación es hacer una lista de los invitados que vendrán el domingo a su próxima montería en la finca de 6.000 Has.

Mientras todo esto siga a sí, el avance será pequeño. Hoy días, el lugar de aquellos Sacerdotes de las épocas pasadas, lo ocupan los gurús del dinero que se pavonean por el mundo y…si se profundizara un poco en el origen de las fortunas, muy pocos podrían pasar el examen.

En fin amigos, me desvío de mi cometido principal que es hablaros de lo que pasó en tiempos pasados, de como podemos actuar en el presente para preparar el terreno y tener un futuro mejor.

Hablamos de Ciencia y de Cultura, de Letras y de Números, de lo infinito y de lo infinitesimal, de la Mente y de la Conciencia pero, ¿seremos alguna vez conscientes? En cuanto a la pregunta planteada…. ¡El futuro siempre será incierto!

Emilio Silvera V.

Ago

25

¿Cómo será el futuro? Me gustaría conocerlo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

La mayor parte del material genético se encuentra en los cromosomas en el interior del núcleo de la célula, pero las mitocondrias, unos orgánulos del interior celular que producen la energía que se utiliza en el metabolismo, también contienen una pequeña cantidad de ADN denominado ADN mitocondrial.

Las alteraciones del material genético de las mitocondrias es la causa de algunas enfermedades que se transmiten con un patrón característico debido a que las mitocondrias solo se heredan de la madre. Todos los hijos e hijas de una mujer afectada heredarán las mitocondrias con la mutación y serán afectados por la enfermedad (figura 1), mientras que ninguno de los hijos e hijas de un hombre afectado heredaran la alteración ni desarrollaran la enfermedad (figura 2).

Figura 1. Patrón de herencia mitocondrial cuando la madre está afectada (azul).

Lo cierto es que, cada vez que ha salido alguien, que como el precursor de la ciencia ficción, el entrañable Julio Verne, nos hablaba de viajes imposibles y de mundos insólitos, nadie pudo creer, en aquellos momentos, que todas aquellas “fantasías” serían una realidad en el futuro más o menos lejano. Todo lo que él imagino hace tiempo que se hizo realidad y, en algunos casos, aquellas realidades fantásticas, han sido sobrepasadas como podemos contemplar, en nuestras vidas cotidianas. Ingenios espaciales surcan los espacios siderales y, otros, lo hacen por el misterioso fondo oceánico como fue predicho hace ahora más de un siglo.

oceánico como fue predicho hace ahora más de un siglo.

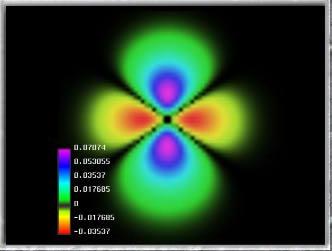

Las fluctuaciones del vacío entre una esfera y una plana

En un estudio por un equipo de físicos con avanzados aparatos, han hallado un resultado del que nos dicen:

“La materia se construye sobre frágiles objetos. Los físicos acaban de confirmar que la materia, aparentemente sustancial, es en realidad nada más que fluctuaciones en el vacío cuántico. Los investigadores simularon la frenética actividad que sucede en el interios de los protones y neutrones, que como sabéis son las partículas que aportan casi la totalidad de la masa a la materia común.”

Las consecuencias de la existencia del cuanto mínimo de acción fueron revolucionarios para la comprensión del vacío. Mientras la continuidad de la acción clásica suponía un vacío plano, estable y “realmente” vacío, la discontinuidad que supone el cuanto nos dibuja un vacío inestable, en continuo cambio y muy lejos de poder ser considerado plano en las distancias atómicas y menores. El vacío cuántico es de todo menos vacío, en él la energía nunca puede quedar estabilizada en valor cero, está fluctuando sobre ese valor, continuamente se están creando y aniquilando todo tipo de partículas, llamadas por eso virtuales, en las que el de su energía por el tiempo de su existencia efímera es menor que el cuanto de acción. Se llaman fluctuaciones cuánticas del vacío y son las responsables de que exista un que lo inunda todo llamado de punto cero.

Ahora, los profetas modernos resultan ser Físicos que nos hablan de sucesos cuánticos que no llegamos a comprender y que, son ¡tan extraños! que nos resultan poco familiares y como venidos de “otro mundo”, aunque en realidad, son fenómenos que ocurren en las profundidades del mundo de la materia.

de la materia.

Cada vez van siendo menor los visionarios y más los estudiosos científicos, tanto teóricos como experimentadores que, en todos los campos , nos llevan, sin que nos demós cuenta, hacia el futuro que, ¡puede ser de tantas maneras! Precisamente por eso, será bueno que nuestras mentes, no se resignen a que estemos confinados aquí, en esta nave espacial que llamamos Tierra y que surca el espacio interestelar a muy buena velocidad aunque no todos sean conscientes de ello.

, nos llevan, sin que nos demós cuenta, hacia el futuro que, ¡puede ser de tantas maneras! Precisamente por eso, será bueno que nuestras mentes, no se resignen a que estemos confinados aquí, en esta nave espacial que llamamos Tierra y que surca el espacio interestelar a muy buena velocidad aunque no todos sean conscientes de ello.

Ascensor Espacial Erkki Halkka

Los avances que veremos en este mismo siglo, en todos los ámbitos del saber humano, serán sorprendentes y cambiaran nuestras vidas, nuestra Sociedad para el próximo siglo, será ya muy diferentes a ésta que conocemos. Nuestras propias vidas darán un salto cuantitativo y cualitativo en su período de duración y en su calidad de bienestar, podremos vivir un siglo y medio y tendremos menos enfermedades que ahora. las posibles innovaciones tecnológicas en campos tan dispares como la salud, la economía, la demografía, la energía, la robótica, el espacio, las telecomunicaciones y los transportes, darán un vuelco a nuestra forma de vida y entraremos en otra fase del futuro que viene y del pasado que dejamos atrás.

tan dispares como la salud, la economía, la demografía, la energía, la robótica, el espacio, las telecomunicaciones y los transportes, darán un vuelco a nuestra forma de vida y entraremos en otra fase del futuro que viene y del pasado que dejamos atrás.

Estos serán los materiales con los que se construirá ese ascensor “imposible” que nos llevará 500 Km lejos de la Tierra, hacia las Estaciones Espaciales con las que se podrá acoplar, sin ninguno de los riesgos que conllevan los transbordadores actuales impulsados por Hidrógeno líquido de fácil combustión, es decir, los pasajeros van montados sobre una bomba volante y, al mejor fallo…

combustión, es decir, los pasajeros van montados sobre una bomba volante y, al mejor fallo…

Los ascensores espaciales eran hasta hace muy poco materia de ficción pura, pues ningún material conocido podía soportar la enorme tensión producida por su propio peso. Actualmente ciertos materiales comienzan a parecer viables como materia prima: los expertos en nuevos materiales consideran que teóricamente los nanotubos de carbono pueden soportar la tensión presente en un ascensor espacial.3 Debido a este avance en la resistencia de los nuevos materiales, varias agencias están estudiando la viabilidad de un futuro ascensor espacial:

En Estados Unidos, un antiguo ingeniero de la NASA llamado Bradley C. Edwards

ingeniero de la NASA llamado Bradley C. Edwards ha elaborado un proyecto preliminar que también están estudiando científicos de la NASA.Edwards afirma que ya existe la tecnología necesaria, que se necesitarían 20 años para construirlo y que su costo sería 10 veces menor que el de la Estación Espacial Internacional. El ascensor espacial de Edwards no se parece a los presentes en las obras de ficción, al ser mucho más modesto y a la vez innovador en lo que concierne a su eventual método de construcción.

ha elaborado un proyecto preliminar que también están estudiando científicos de la NASA.Edwards afirma que ya existe la tecnología necesaria, que se necesitarían 20 años para construirlo y que su costo sería 10 veces menor que el de la Estación Espacial Internacional. El ascensor espacial de Edwards no se parece a los presentes en las obras de ficción, al ser mucho más modesto y a la vez innovador en lo que concierne a su eventual método de construcción.

Este sería el final del recorrido y estaría preparado para conectar con bases espaciales. Ahora nos parece un suelo paero hace tiempo ya que se está trabajando, de manera muy seria, en su construcción en un futuro próximo y, desde luego, conseguirlo será un buen logro.

del recorrido y estaría preparado para conectar con bases espaciales. Ahora nos parece un suelo paero hace tiempo ya que se está trabajando, de manera muy seria, en su construcción en un futuro próximo y, desde luego, conseguirlo será un buen logro.

Existen algunos tratamientos con células madre, pero la mayoría todavía se encuentran en una etapa experimental. Investigaciones médicas, anticipan que un día con el uso de la tecnología, derivada de investigaciones para las células madre adultas y embrionarias, se podrá tratar el cáncer, diabetes, heridas en la espina dorsal y daño en los músculos, como también se podrán tratar otras enfermedades. Se les presupone un destino lleno de aplicaciones , que van desde patologías neurodegenerativas, como la enfermedad de Alzheimer o de Parkinson, hasta la fabricación de tejidos y órganos destinados al trasplante, pasando por la diabetes y los trastornos cardíacos.

, que van desde patologías neurodegenerativas, como la enfermedad de Alzheimer o de Parkinson, hasta la fabricación de tejidos y órganos destinados al trasplante, pasando por la diabetes y los trastornos cardíacos.

En un futuro se espera utilizar células madre de cordón umbilical en terapia génica: podemos así tratar enfermedades causadas por la deficiencia o defecto de un determinado gen, introduciendo un determinado gen en la proliferación de las células madre In Vitro y trasplantar tales células en el paciente receptor. El uso de otros tipos de células como portadores de genes buenos en pacientes con enfermedades causadas por deficiencias o déficits genéticos, está siendo testeado a nivel clínico. El primer trasplante de órgano bio-artificial en humanos, por su parte, confían en que pueda ver la luz dentro de “unos cinco o diez años”.

clínico. El primer trasplante de órgano bio-artificial en humanos, por su parte, confían en que pueda ver la luz dentro de “unos cinco o diez años”.

La bioinformática o la biotecnología consiste en la aplicación de tecnología informática en el análisis de datos biológicos . Los principales esfuerzos de investigación en estos campos

biológicos . Los principales esfuerzos de investigación en estos campos incluyen el alineamiento de secuencias , la predicción de genes , predicción de la expresión génica y modelado de la evolución . Algunos ejemplos son el diseño de organismos para producir antibióticos , el desarrollo de vacunas más seguras y nuevos fármacos, los diagnósticos moleculares, las terapias regenerativas y el desarrollo de la ingeniería genética para curar enfermedades a través de la manipulación génica . Veamos algunas de ellas…

incluyen el alineamiento de secuencias , la predicción de genes , predicción de la expresión génica y modelado de la evolución . Algunos ejemplos son el diseño de organismos para producir antibióticos , el desarrollo de vacunas más seguras y nuevos fármacos, los diagnósticos moleculares, las terapias regenerativas y el desarrollo de la ingeniería genética para curar enfermedades a través de la manipulación génica . Veamos algunas de ellas…

Formas nuevas de comunicarse y de adquirir datos

La fusión, energía limpia y barata y, sobre todo, inagotable

todo, inagotable

Y mientras el mundo está pendiente de la crisis económica internacional, científicos e ingenieros trabajan intensamente en lo que podría ser la solución a los problemas energéticos del futuro. La palabra clave es “fusión”. Al contrario que la tradicional energía nuclear, la energía de fusión es limpia y no contamina y, sus residuos, es el Helio fácilmente aprovechable. El Proyecto ITER sigue adelante.

clave es “fusión”. Al contrario que la tradicional energía nuclear, la energía de fusión es limpia y no contamina y, sus residuos, es el Helio fácilmente aprovechable. El Proyecto ITER sigue adelante.

La ciencia de la medicina está avanzando a pasos agigantados. Los últimos avances en medicina que se dieron en estos diez o quince años pasados han sido sorprendentes, y podemos esperar un salto muy grande en la medicina dentro de los próximos años.

está avanzando a pasos agigantados. Los últimos avances en medicina que se dieron en estos diez o quince años pasados han sido sorprendentes, y podemos esperar un salto muy grande en la medicina dentro de los próximos años.

Algunos descubrimientos todavía no están al alcance de los pacientes, a pesar de que ya se han revelado como grandes avances científicos son necesarios muchos estudios y pruebas antes de que se puedan aplicar . No perdamos de vista en este ámbito del saber humano, ni la genética ni las nuevas nanotecnologías, lo que llaman el ojo biónico, la sangre artificial…

. No perdamos de vista en este ámbito del saber humano, ni la genética ni las nuevas nanotecnologías, lo que llaman el ojo biónico, la sangre artificial…

Cambiaran nuestras ciudades y nuestras Sociedades serán diferentes, los nuevos conocimientos llegarán también, a la vida cotidiana del hábitat humano y a su forma de trabajo , de viajar, e, incluso los alimentos del futuro no muy lejano, nos harán recordar con cierta nostalgia, estos que ahora criticamos.

, de viajar, e, incluso los alimentos del futuro no muy lejano, nos harán recordar con cierta nostalgia, estos que ahora criticamos.

Los modernos celulares irán insertados en el brazo

Cualquier vivienda será controlada por mecanismos informáticos

será controlada por mecanismos informáticos

Este programa va más allá de los avances actuales para revelar la tecnología e inventos que nos permitirán ver a través de las paredes, viajar en el tiempo y en el espacio y colonizar planetas distantes. La tecnología inteligente que llevará ayudantes robóticos a los hogares, ciudades enteras a la Internet, y sistemas de entretenimiento que harán los sueños realidad en forma virtual . Sí, virtual hoy pero… ¿Y mañana?

. Sí, virtual hoy pero… ¿Y mañana?

¡Tantas galaxias y estrellas, tantos mundos, tantas maravillas! Si no podemos en un futuro más o menos lejano, visitarlas, ¿Para qué tanta diversidad y tanta belleza? Si están ahí , por algo será y, nosotros, aunque parezca que somos una ínfima cuestión en tan vasto Universo, seguramente seremos, unos privilegiados llamados a realizar grandes cosas. A pesar de nuestras muchas faltas y carencias…¡Lo estamos logrando!

, por algo será y, nosotros, aunque parezca que somos una ínfima cuestión en tan vasto Universo, seguramente seremos, unos privilegiados llamados a realizar grandes cosas. A pesar de nuestras muchas faltas y carencias…¡Lo estamos logrando!

Ya hemos dado los primeros pasos y, nuestros ingenios espaciales tecnológicos robotizados, han realizado para nosotros las tareas que, de momento nos están vedadas pero, denle tiempo al tiempo y, sin duda alguna, en ese futuro soñado, estaremos en las estrellas y en esos otros mundos que presentimos hermanos de la Tierra y que podrán acoger a la Humanidad que, dentro de otros cincuenta años, llegará a la cifra de 8.000 millones de seres y, nuestro planeta, no puede con todo.

y, nuestros ingenios espaciales tecnológicos robotizados, han realizado para nosotros las tareas que, de momento nos están vedadas pero, denle tiempo al tiempo y, sin duda alguna, en ese futuro soñado, estaremos en las estrellas y en esos otros mundos que presentimos hermanos de la Tierra y que podrán acoger a la Humanidad que, dentro de otros cincuenta años, llegará a la cifra de 8.000 millones de seres y, nuestro planeta, no puede con todo.

El futuro convive ya con nosotros y, al tenerlo tan cercano, no le prestamos atención a esos muchos cambios que con nosotros conviven. Lo cierto es que debe ser así, de otra manera, los cambios tan bruscos que se están produciendo, nos traumatizaría y, sin embargo, lo tomamos -unas veces por comprenderlos y otras por ignorarlos- con toda la normalidad. Esa es la manera en la que se desenvuelve el mundo de nuestra especie.

atención a esos muchos cambios que con nosotros conviven. Lo cierto es que debe ser así, de otra manera, los cambios tan bruscos que se están produciendo, nos traumatizaría y, sin embargo, lo tomamos -unas veces por comprenderlos y otras por ignorarlos- con toda la normalidad. Esa es la manera en la que se desenvuelve el mundo de nuestra especie.

Sueños convertidos en realidad

La Tierra del mañana nada tiene que ver con la Tierra de hoy. Será calcinada por la Gigante roja en que se convertirá el Sol antes de pasar a la fase final de enana blanca.

¿Cómo no podemos predecir que le puede pasar a la Tierra en el futuro?, mejor será ir “preparando las maletas” que, como decía mi padre, un viejo marinero curtido en mil tempestades: ¡”Más vale un por si acaso, que un yo creí”!

Emilio Silvera V.

Ago

24

¿Cerebro y Mente? ¿Inteligencia y Sabiduría?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Mente ~

Clasificado en El Universo y la Mente ~

Comments (1)

Comments (1)

¡El Universo! Y nosotros… ¿Seremos su parte que piensa?

Bueno, el mismo título de éste trabajo denota nuestra egolatría, cuando introduce la pregunta: “Seremos su parte que piensa?” Estamos dando por supuesto que sólo nosotros, en el Inmenso Universo, tenemos la facultad de pensar… ¡Ilusos!

Los imaginamos de muchas maneras y podrían ser muy parecidos a nosotros y basados en el carbono

Aunque no puedo saber como serían físicamente (dependería de muchos factores: La Gravedad del planeta, la atmósfera, la química allí presente…), lo que no me cabe duda alguna es de que, también estaría basada en el Carbono, ya que, el Universo es igual en todas partes y, en todas sus regiones están presentes las mismas leyes y constantes.

Y como contestó al viejo astrónomo al joven periodista que le preguntó:

- ¿verdad maestro que sería un milagro encontrar extraterrestres?

- Amigo mío, el milagro sería que, finalmente, no lo encontráramos.

El mito del eterno retorno: la Regeneración del Tiempo

Tomado literalmente, el tiempo cíclico hasta sugiere una especie de inmortalidad. Eudemo de Rodas, discípulo de Aristóteles, decía a sus propios discípulos: “Si creéis a los pitagóricos, todo retornorá con el tiempo en el mismo orden numérico, y yo conversaré con vosotros con el bastón en la mano y vosotros os sentaréis como estáis sentados ahora, y lo mismo sucederá con toda otra cosa”. Por estas o por otras razones, el tiempo cíclico aún es popular hoy, y muchos cosmólogos defienden modelos del “universo oscilante” en los que se supone que la expansión del universo en algún momento se detendrá y será seguida por un colapso cósmico en los fuegos purificadores del siguiente Big Bang.

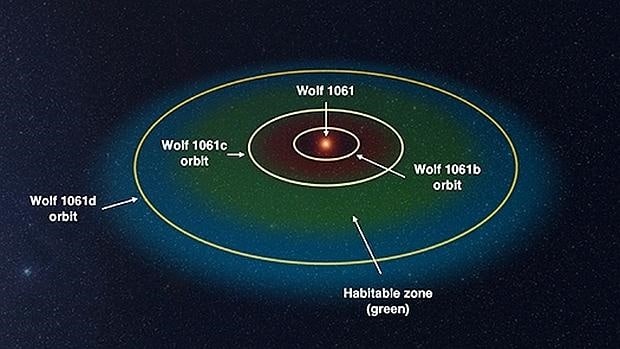

La estrella Wolf 1061 y sus tres planetas. El «c» es el potencialmente habitable – UNSW

Un equipo de astrónomos australianos ha descubierto el planeta potencialmente habitable más cercano a la Tierra fuera del Sistema Solar, a «solo» 14 años luz, una distancia que puede parecer muy larga, pero que es mucho más corta que la que nos separa de la mayoría de candidatos a albergar vida y una nadería en la inmensidad del Universo. Este nuevo mundo, que tiene más de cuatro veces la masa del nuestro, es uno de los tres que el equipo detectó alrededor de una estrella enana roja llamada Wolf 1061.

Por aquel tiempo pudimos leer en la prensa de todo el mundo: ESTOCOLMO, Suecia.- El premio Nobel de Física (2.008) fue atribuido hoy al norteamericano Yoichiro Nambu y a los japoneses Makoto Kobayashi y Toshihide Maskawa por sus trabajos separados sobre la física de las partículas que mejoraron la comprensión de la materia, Demos un repaso hoy aquí a esos componentes de la materia, y, profundicemos en sus propiedades., en sus “vidas”.

Cuando hablamos del tiempo de vida de una partícula nos estamos refiriendo al tiempo de vida media, una partícula que no sea absolutamente estable tiene, en cada momento de su vida, la misma probabilidad de desintegrarse. Algunas partículas viven más que otras, pero la vida media es una característica de cada familia de partículas.

También podríamos utilizar el concepto de “semivida”. Si tenemos un gran número de partículas idénticas, la semivida es el tiempo que tardan en desintegrarse la mitad de ese grupo de partículas. La semivida es 0,693 veces la vida media.

En el Universo existen muchas clases de resonancias…inesperadas

Las resonancias parecen ser solamente una especie de versión excitada de los Hadrones estable. Son réplicas que rotan más rápidamente de lo normal o que vibran de diferente manera. Análogamente a lo que sucede cuando golpeamos un gong, que emite sonido mientras pierde energía hasta que finalmente cesa de vibrar, una resonancia termina su existencia emitiendo piones, según se transforma en una forma más estable de materia.

Por ejemplo, la desintegración de una resonancia ∆ (delta) que se desintegra por una interacción fuerte en un protón o neutrón y un pión, por ejemplo:

∆⁺⁺→р + π⁺; ∆⁰→р + πˉ; o п+π⁰

En la desintegración de un neutrón, el exceso de energía-masa es sólo 0,7 MeV, que se puede invertir en poner en movimiento un protón, un electrón y un neutrino. Un Núcleo radiactivo generalmente tiene mucha menos energía a su disposición.

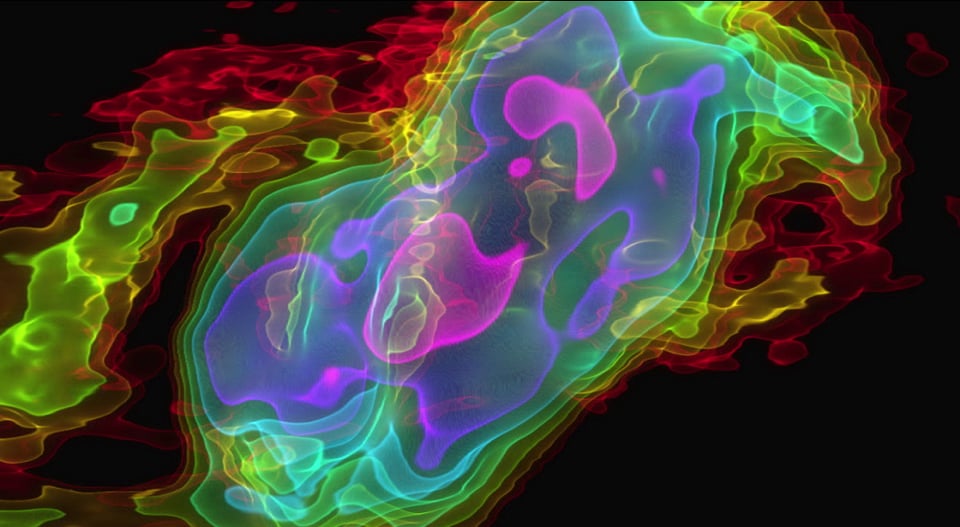

Visión tridimensional del gas expulsado de NGC 253. El eje vertical muestra la velocidad y el horizontal la posición. Los colores representan la intensidad de la emisión; rosa es la emisión más fuerte y rojo la más débil. : ALMA (ESO/NAOJ/NRAO)/Erik Rosolowsky.

Cerebro y Mente, son dos entes separados que depende el uno del otro… ¡Siempre nos dio mucho en que pensar! El cerebro quizás sea la “máquina” más compleja del Universo, la Mente, el Ente inmaterial (metafísico) que surge de ella y que podría llegar a emitir un poder inimaginable.

No acabamos de ponernos de acuerdo en el hecho de si, la sabiduría, o la competencia profesional o la pericia, también la Inteligencia, pueden ser catalogadas como categorías biológicas, pero lo son. La mayoría de la gente comprende, de forma general y vaga, que la mente es producto del cerebro, pero no siempre resulta fácil comprender lo íntima que es esta relación. Aunque acepte la conexión entre Mente y Cerebro en tanto que proposición abstracta, la mayoría de las personas no llegan a entender ni asimilar de forma inmediata estas cuestiones del cerebro-mente-inteligencia-sabiduría, como sí lo hacen con las cuestiones más cotidianas.

En realidad, cuando hablamos de Mente y cerebro lo hacemos como parte de un vestigio pertinaz y recalcitrante que nos viene de lejos, cuando algunos estudiosos de la Filosofía como René Descartes, proponían que mente y cerebro estaban separados y que la Mente existe de manera independiente del cuerpo. Muchos son los libros que sobre el tema han sido escritos, algunos excelentes como: El error de Descartes, La Table rasa y otros muchos. La secular incapacidad para entender que la mente es producto del cuerpo inspiró la pintoresca imagen de la mente como el ente superior, inmaterial, que viviendo en el cerebro, en realidad era sensorialmente inmaterial y podía, estar fuera o dentro de nosotros para general ideas y pensamientos.

Las reglas de causa y efecto, tal como las aceptas, te han metido en el volumen de un cuerpo, y la duración de la vida humana. En realidad, el campo de la vida humana es abierto e ilimitado en su más profundo plano.

Tu cuerpo carece de edad y tu mente de tiempo. Una vez que te identifiques con esa realidad, que es congruente con la visión cuántica del universo, entraras en el nuevo paradigma, y tu conciencia, sé expandirá, cósmica y cuánticamente en fractales radiales exponenciales y dimensionales.

Al mirar el Microscopio electrónico, (Microcosmos) vemos como las partículas cuánticas se mueven, (virtualmente) a la velocidad de la luz, y si miramos al cielo y observamos las Estrellas, veremos la inmutabilidad del Macrocosmos. Cada uno habita en una realidad que se encuentra mas allá de todo cambio. En lo más profundo de nosotros, sin que lo sepan nuestros sentidos externos tridimensionales o físicos, existe un intimo núcleo del ser, un campo de inmortalidad, que crea la personalidad, él yo y el cuerpo. Este ser es nuestro estado esencial, es nuestra esencia (Alma), es quien realmente somos. Somos Almas en este inmutable escenario eterno.

Nadie ha sabido nunca explicar lo que el Tiempo es. Lo único que hemos podido sacar en claro es que, su transcurrir lo cambia todo. Su hermana inseparable, la Entropía, se encarga de ello. Y, de su hipotética prima, la Eternidad, no podemos decir que la tengamos localizada, ya que, todo tiene un principio y un final y, siendo así (que lo es), la Eternidad no tiene cabida aquí.

Ni una Galaxia, cuya vida se remonta a miles de millones de años… ¡Es Eterna!

Otros dicen que el Tiempo existe solo como eternidad, el tiempo es Eternidad Cuantificada, es la temporalidad cortada por nosotros, en trozos o fragmentos, de tiempo que llamamos días, horas, minutos, y segundos. Lo que llamamos tiempo lineal es solo un reflejo de nuestro modo de percibir los sucesos o los cambios en que nos vemos envuelto en nuestro limitado sistema perceptual .

Si se pudiera percibir lo inmutable, el tiempo dejaría de existir tal como lo conocemos. Podemos empezar por aprender, a concebir y metabolizar lo Inmutable, la Eternidad, lo Absoluto, al hacerlo, estaremos listos para crear la fisiología de la Inmortalidad. Claro que es difícil, si se tiene una comprensión aceptable del universo, asimilar esos conceptos de eternidad, infinito o inmortalidad que… ¡En nuestro universo no están presentes! Aquí todo se transforma, todo comienza y termina, todo nace y muere.

Somos propensos los Humanos, cuando hablamos y queremos contar cosas, hacer referencias que, en realidad, sólo son metáforas de “Vacío”, de “Infinito”, o, de “Eternidad” esos tres conceptos que utilizamos para decir que hay poco, que nunca muere, y que dura siempre. Claro que, ninguno de los tres conceptos son ciertos en nuestro Universo: Ni existe el Vacío (siempre hay), Ni tampoco nada es infinito (todo muere), y, de la Eternidad que podemos decir: Sólo es una abstracción de la Mente.

Si somos capaces de entrar en ese campo transcendente de superior nivel filosófico y hasta metafísico se podría decir, ya no creeremos en ese dualismo cartesiano entre cuerpo y mente…nos podremos despojar de vestigios del pasado y llegar a comprender, con claridad meridiana que, la Mente es algo evolucionado dentro de nuestro cuerpo que ha sido puesta ahí por mecanismos del universo que no hemos podido llegar a entender pero que, de todas formas intuimos que, la conexión entre ambos, Mente y Universo, es tan real como la vida misma.

Los mecanismos del Universo hizo posible el surgir de la Vida y, en alguna de sus modalidades (seguro que exioten muchas más) se plasmó esa simbiosis primera de Cuerpo y Mente que haría posible la evolución de la segunda para que, después de algunos miles o millones de años, pudiera alcanzar el zenit en individuos que eran poseedores de rasgos e ingredientes predeterminados de personalidad e inteligencia, empuje y energía, la capacidad para entender lo que otros no entienden, el poder fijarse objetivos a largo plazo que requerían de un talento innato y especial que no era posible adquirir sino que se nace con él. Es el destino biológico de unos pocos que, a pesar de su talento, sí necesitaron del empuje y la ambición y, finalmente, los triunfos, llegaban como frutos del esfuerzo individual.

Al fin y al cabo todo el mundo acepta que el esfuerzo solo no basta para convertirse en un Mozart, un Shakesperare o un Ramanujan. Para subir esa escalera que te llevará a la cumbre, principalmente, el ingrediente necesario será el Talento, la Sabiduría y, de vez en cuando, se agregara un poquito de suerte o azar.

Claro que la Sabiduría es una buena noticia para todos nosotros. Si alguien la posee, siempre tenderá a exponerla a los demás para que, de una u otra forma podamos disfrutar de ella aunque sólo sea a través de la admiración hacia el Sabio que no la muestra pero, en realidad, en el último momento, lo que deseamos es apropiarnos de algo de esa sabiduría para nosotros. ¡Necesitamos saber!

Es el saber popular de todas las Sociedades a lo largo de la Historia, la sabiduría siempre ha sido asociada con los ancianos. La sabiduría ha sido el más preciado bien y, en torno a ella, todos nos hemos puesto en coro a escuchar esas palabras sabias que nos indicaban el camino a seguir.

No siempre hemos sabido determinar lo que es la realidad y lo que son sólo sueños. Escenarios que nuestros ojos ven y que nuestros oidos oyen, son los mensajes que el cerebro recibe y se los cree. Así que, teniendo unos sentidos limitados, es posible, que los mensajes no sean todo lo fiables que debería y, el “mundo” que el cerebro conforma… ¡Puede que no se ajuste a la realidad del “mundo”!

¿Qué es la realidad?, ¿Cómo la definimos?, ¿Cuántas realidades hay?, ¿Cada uno de nosotros tiene su propia realidad?¿Qué realidad nos transmite el Universo en nuestro Mundo, será distinta a realidades de otros Mundos? ¿Es una realidad la cuántica? ¿Existen realidades que no podemos percibir? La realidad va en función de la percepción que se tenga de ella, y esta forma parte de la Conciencia. Nuestra conciencia actual es un condicionamiento de nuestra visión del mundo actual y colectivo, es la que nos enseñaron nuestros padres, maestros, la sociedad, gobierno y religiones. A esta manera de ver y entender el mundo, pertenece el antiguo paradigma. Y, como nos diría Tom Wood, necesitamos nuevos paradigmas para poder entender la “realidad” de la Naturaleza.

Es cierto que, algunas veces, cuando profundamente pensamos en todos estos conceptos, llegamos a la conclusión de que la realidad no existe, y, si entramos en el mundo de la filosofía podríamos argumentar que nunca nadie ha podido “ver” un pensamiento y, sin embargo, ¿Cuántos generamos durante nuestras vidas?

A partir del mundo físico de Faraday Maxwell nos pudo señalar su mundo mental de la electricidad y el magnetismo

El mundo físico, incluido nuestro cuerpo, es una reacción del observador. Creamos el cuerpo según creamos la experiencia de nuestro mundo.En su estado esencial (micro-cósmico), el cuerpo está formado de energía e información, y no de materia sólida. Esta energía e información, surge de los infinitos campos de energía e información que abarcan todos los universos. La mente y sus cuerpos, desde el físico hasta el espiritual y sus múltiples manifestaciones multidimensionales, son inseparablemente uno, o sea la unidad YO SOY.

Esta unidad Yo Soy, la separaremos en dos corrientes de experiencia. La experimentamos primero como corriente subjetiva, como pensamientos, ideas, sentimientos, deseos y emociones. La corriente objetiva la experimentamos como el cuerpo físico, mas sin embargo en un plano mas profundo, las dos corrientes se encuentran en una sola fuente creativa, y es a partir de esta , desde donde realmente nos manifestamos y tenemos nuestro ser.

La bioquímica del cuerpo es un producto de la conciencia, las creencias, los sentimientos, las emociones, los pensamientos e ideas, crean reacciones que sostienen la vida en cada célula. La percepción parece como algo automático, pero esto es un fenómeno aprendido, si cambias tu percepción, cambias la experiencia de tu yo , y por ende de tu mundo.

Por supuesto, todos sabemos el dilema del observador en la cuántica. Se trata del enigmático principio de incertidumbre que nos impide medir una partícula sin afectar el resultado. Es posible conocer una cosa, más no la otra. Por mucho tiempo, Copenhague fue el modelo que rigió ese conocimiento específico de la cuántica pero ya existe otro. Tenemos el experimento del físico John Cramer que basó su modelo en la teoría de radiación electromagnética de Wheeler-Feynman y predice los resultados de los experimentos cuánticos tan bien como el “viejo” modelo lo hace. Lo más atractivo: el observador no tiene ningún papel especial en el resultado.

En realidad, solo somos una parte infinitesimal de lo mucho que podemos vislumbrar.

Los humanos seguimos afianzándonos a todo lo que nos ponga en el centro de las cosas. Los fenómenos que no pueden ser explicados nos excitan y hemos estado usándolos para justificar a nuestros dioses desde que descubrimos que podemos producir ilusiones para tapar nuestra ignorancia. Cada vez que algo es explicado, movemos nuestras pertenencias hacia el próximo misterio; y cuando ese enigma revela sus mecanismos nos pasamos a otro. No es la ausencia de evidencia lo que mortifica al creyente que propone afirmaciones extraordinarias como verdaderas, son las evidencias del otro, del científico en el laboratorio; él lo obliga a buscar otra casa y mudarse donde no haya iluminación.

Lo cierto es que, creamos nuestra propia realidad dentro de otra realidad más grande que resulta ser el UNIVERSO.

Claro que, esa sabiduría a la que antes me refería nos debería llevar hasta propósitos superiores, incluso de una célula podríamos aprender: Cada Célula del cuerpo acuerda trabajar por el bien del Todo; el Bienestar individual es secundario. Si es preciso, morirá para proteger al cuerpo (Lo que ocurre con frecuencia). La vida de cualquier célula es muchísimo más breve que la nuestra. Las células de la piel mueren por cientos cada hora, al igual que las inmunológicas que combaten los microbios invasores. El egoísmo resulta inconcebible, incluso cuando la supervivencia de las células está en juego.

Los paisajes cambian como todo en nuestro Universo

¿Por qué no hacemos nosotros lo mismo? ¿Acaso no hemos finalizado nuestro proceso de Humanización, o, por el contrario, simplemente se trata de que somos así. Seres egoístas en los que prima lo individual y el YO, contra el NOSOTROS, como Ente principal. Hay una cuestión que me da algo de esperanza: Cuando hablamos de nuestros hijos, de nuestro ser Amado…El Yo se queda detrás y prevalecen esos valores que, en realidad, son los que nos ditinguen y nos hacen grandes.

Bueno, pero ¿no estaba hablando de la Mente, la Sabiduría y la Inteligencia? Sí, es posible. Sin embargo, todo siempre viene a desembocar en lo mismo: Nosotros y el Universo.

Emilio Silvera V.

Ago

23

Siempre buscaremos nuevas teorías de la Física y del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

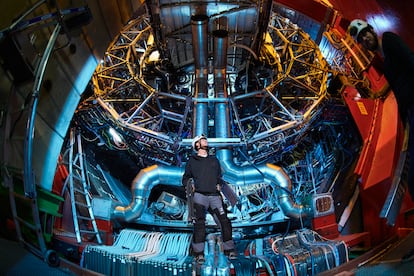

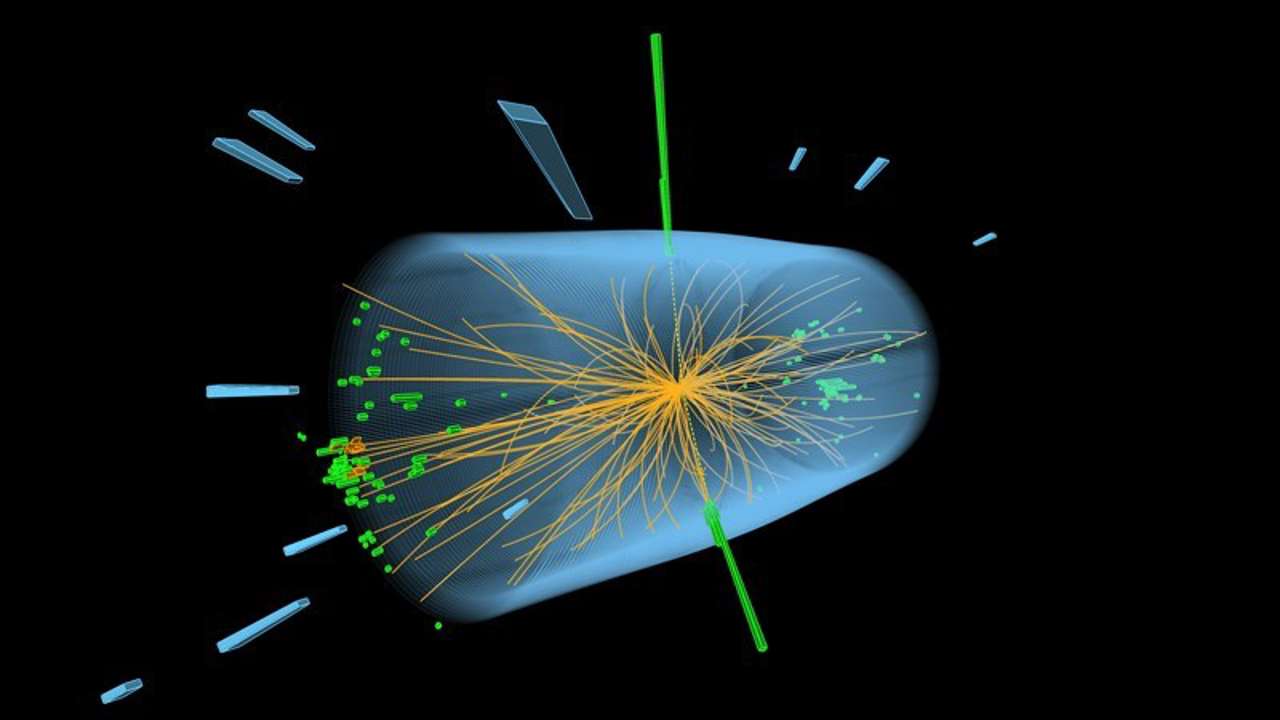

Una reacción nuclear “desafiante”

Una nueva clase de reacción de fisión nuclear observada en el CERN ha mostrado importantes puntos débiles en nuestro entendimiento actual del núcleo atómico. La fisión del mercurio-180 se suponía una reacción “simétrica” que daría lugar a dos fragmentos iguales, pero en lugar de ello ha producido dos núcleos con masas bastante diferentes, una reacción “asimétrica” que plantea un serio desafío a los teóricos.

La Ciencia no duerme. En todo el mundo (ahora también fuera de él -en el espacio), son muchos los Científicos que trabajan de manera tenaz para buscar nuevas formas de alcanzar lo ahora inalcanzable y, para ello, se emplean las más sofisticadas estructuras técnicas de avanzados sistemas tecnológicos que hacen posible llegar allí donde nunca nadie había llegado.

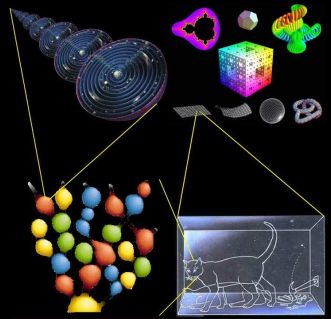

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “super-gravedad”, “súper-simetría”, “super-cuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”.

Esta es una vista hemisférica de Venus, los colores representan las elevaciones. Cortesía de NASA/JPL.

El segundo planeta a partir del Sol. Tiene la órbita más circular de todos los planetas. Su albedo geométrico medio, 0,65, es el mayor de todos los planetas, como resultado de su cubierta de nubes blancas sin fracturas. En su máximo alcanza magnitud -4,7, mucho más brillante que cualquier otro planeta. Su eje de rotación está inclinado casi 180º con respecto a la vertical, de manera que su rotación es retrógrada. Rota alrededor de su eje cada 243 días, y, por tanto, muestra siempre la misma cara hacia la Tierra cuando los dos planetas se encuentran en su máxima aproximación.

La atmósfera de Venus es en un 96,5% de dióxido de carbono y un 3,5 de nitrógeno, con trazas de dióxido de azufre, vapor de agua, argón, hidrógeno y monóxido de carbono. La presión en la superficie es de 92 bares (es decir, 92 veces la presión a nivel del mar en la Tierra). La temperatura superficial promedio es de 460 ºC debido al “efecto invernadero” en la atmósfera del planeta. Los rayos son muy frecuentes. Existe una densa capa de nubes a una altitud de unos 45/65 Km. compuesta de ácido sulfúrico y gotitas de agua.

VENUS: El Planeta Imposible

Mundos inimaginables que tendrán, como en el nuestro, formas de vida de una rica diversidad que ni podemos imaginar. Simplemete en una galaxia, por ejemplo la nuestra, existen cientos de miles de millones de planetas de los más diversos pelajes, y, no pocos, serán muy parecidos a nuestra Tierra y estarán situados en la zona adecuada para que, la vida, pudiera surgir en ellos como lo hizo aquí, toda vez que, tanto aquellos planetas como el nuestro, están sometidos a las mismas fuerzas, a las mismas constantes, y, en consecuencia, a situaciones iguales, ¡iguales resultados!

Nuestros sueños de visitar mundos remotos, y, en ellos, encontrar otras clases de vida, otras inteligencias, es un sueño largamente acariaciado por nuestras mentes que, se resisten a estar sólas en un vasto Universo que, poseyendo cientos de miles de millones de mundos, también debe estar abarrotados de una diversidad Biológica inimaginable. No creo que estémos sólos en tan vasto universo.

Hace algún tiempo que los medios publicaron la noticias:

“Físicos británicos creen que el bosón de Higgs y su relación con la gravedad puede ser la clave para crear una ecuación única que explique el Universo entero.”

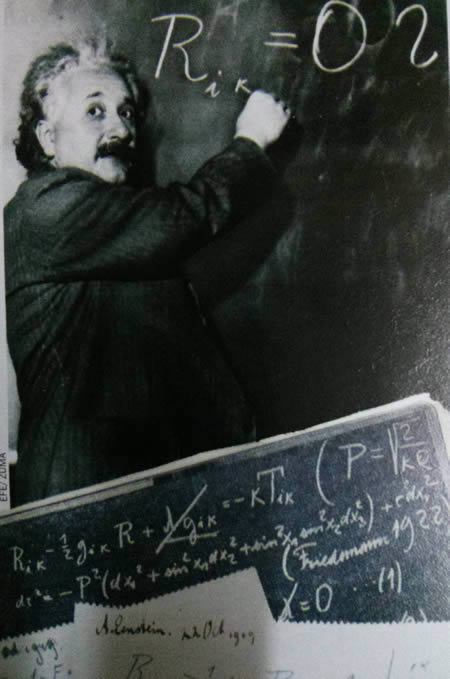

Imagen de Archivo donde Einstein escribe una ecuación sobre la densidad de la Vía Láctea en el Instituto Carnegie en Pasadena (California)

“La teoría del todo, también conocida como teoría unificada, fue el sueño que Einstein nunca pudo cumplir. Consiste en una teoría definitiva, una ecuación única que explique todos los fenómenos físicos conocidos y dé respuesta a las preguntas fundamentales del Universo. Esa teoría unificaría la mecánica cuántica y la relatividad general, dos conocimientos aceptados pero que describen el Cosmos de forma muy diferente. Albert Einstein no consiguió formularla. Tampoco nadie después de él, pero sigue siendo la ambición de muchos científicos. En este empeño, físicos de la británica Universidad de Sussex han dado un nuevo paso para probar que solo hay una fuerza fundamental en la naturaleza. Creen haber observado como el campo de Higgs interactúa con la Gravedad.”

Si hablamos de nuestra Galaxia, la Vía Láctea, lo hacemos de algo que tiene 100.000 millones de años-luz de diámetro y más de ciento cincuenta mil millones de estrellas, no digamos de mundos y otra infinidad de objetos de exótica estructura e increíbles conformaciones que, como los púlsares, los agujeros negros o los magnétares, no dejan de asombrarnos.

Somos, una especie viviente que ha llegado a poder generar pensamientos y crear teorías encaminadas a descubrir la verdad de la Naturaleza, y, nuestra aparente “insignificante presencia”, podría ser un signo de que, el universo “ha permitido” observadores para que lo expliquen y se pueda comprender.

Tenemos el Universo dentro de nuestras mentes. Bueno, lo cierto es que… ¡Somos parte de él!

El universo es un lugar tan maravilloso, rico y complejo que el descubrimiento de una teoría final, en el sentido en el que está planteada la teoría de supercuerdas, no supondría de modo alguno el fin de la ciencia ni podríamos decir que ya lo sabemos todo y para todo tendremos respuestas. Más bien será, cuando llegue, todo lo contrario: el hallazgo de esa teoría de Todo (la explicación completa del universo en su nivel más microscópico, una teoría que no estaría basada en ninguna explicación más profunda) nos aportaría un fundamento mucho más firme sobre el que podríamos construir nuestra comprensión del mundo y, a través de estos nuevos conocimientos, estaríamos preparados para comenzar nuevas empresas de metas que, en este momento, nuestra ignorancia no nos dejan ni vislumbrar. La nueva teoría de Todo nos proporcionaría un pilar inmutable y coherente que nos daría la llave para seguir explorando un universo más comprensible y por lo tanto, más seguro, ya que el peligro siempre llega de lo imprevisto, de lo desconocido que surge sin aviso previo; cuando conocemos bien lo que puede ocurrir nos preparamos para evitar daños.

Una Teoría que abarcará a todas las demás

Algunos dicen que para cuando tengamos una Teoría de Todo, el mundo habrá cambiado, habrá pasado tanto tiempo que, para entonces, la teoría habrá quedado vieja y se necesitará otra nueva teoría más avanzada. Eso significa, si es así, que nunca tendremos una explicación de todo y siempre quedarán cuestiones enigmáticas que tendremos que tesolver. ¡Menos mal!

La búsqueda de esa teoría final que nos diga cómo es el Universo, el Tiempo y el Espacio, la Materiay los elementos que la conforman, las Fuerzas fundamentales que interaccionan con ella, las constantes universales y en definitiva, una formulación matemática o conjunto de ecuaciones de las que podamos obtener todas las respuestas, es una empresa nada fácil y sumamente complicada; la teoría de cuerdas es una estructura teórica tan profunda y complicada que incluso con los considerables progresos que se han realizado durante las últimas décadas, aún nos queda un largo camino antes de que podamos afirmar que hemos logrado dominarla completamente. Se podría dar el caso de que el matemático que encuentre las matemáticas necesarias para llegar al final del camino, aún no sepa ni multiplicar y esté en primaria en cualquier escuela del mundo civilizado. Por otra parte, siempre andamos inventando ecuaciones para todo, que expliquen este o aquel enigma que deseamos conocer.

Lo cierto es que, no conocemos el futuro que le espera a la Humanidad pero, tal desconocimiento no incide en el hecho cierto de que siempre estemos tratando de saber el por qué de las cosas y, seguramente, si Einstein hubiera conocido la existencia de las cuatro fuerzas fundamentales, habría podido avanzar algo más, en su intento de lograr esa ecuación maravillosa que “todo” lo pudiera explicar. Se pasó sus últimos 30 años buscando la Teoría del Todo, y, en un escaparate de la 5ª Avda. en Nueva York, exponían sus ecuaciones, la gente, se amontonaban para verlas y, lo cierto es que no entendían nada… ¡La curiosidad humana!

Muchos de los grandes científicos del mundo (Einstein entre ellos), aportaron su trabajo y conocimientos en la búsqueda de esta teoría, no consiguieron su objetivo pero sí dejaron sus ideas para que otros continuaran la carrera hasta la meta final. Por lo tanto, hay que considerar que la teoría de cuerdas es un trabajo iniciado a partir de las ecuaciones de campo de la relatividad general de Einstein, de la mecánica cuántica de Planck, de las teorías gauge de campos, de la teoría de Kaluza-Klein, de las teorías de… hasta llegar al punto en el que ahora estamos.

Comprender de manera armoniosa cómo se juntan las dos mejores teorías de la física que tenemos actualmente, la cuántica y la relatividad general… ¡Sin que surjan infinitos!

La armoniosa combinación de la relatividad general y la mecánica cuántica será un éxito muy importante. Además, a diferencia de lo que sucedía con teorías anteriores, la teoría de cuerdas tiene la capacidad de responder a cuestiones primordiales que tienen relación con las fuerzas y los componentes fundamentales de la naturaleza. Allí, en sus ecuaciones, aparece el esquivo gravitón implicándo con ello que la teoría contiene implícitamente una teoría cuántica de la Gravedad.

Ahora, en la nueva etapa del LHC, tratarán de buscar partículas Super-simétricas y las partículas componentes de la materia oscura, objetos que expliquen algunos enigmas sin resolver. Para ello emplearán nuevos métodos y nuevas energías, se quiere llegar hasta los 100 TeV, para el Bosón de Higss sólo hicieron falta 14 TeV, veremos que pasa.

Igualmente importante, aunque algo más difícil de expresar, es la notable elegancia tanto de las respuestas que propone la teoría de cuerdas, como del marco en que se generan dichas respuestas. Por ejemplo, en la teoría de cuerdas muchos aspectos de la Naturaleza que podrían parecer detalles técnicos arbitrarios (como el número de partículas fundamentales distintas y sus propiedades respectivas) surgen a partir de aspectos esenciales y tangibles de la geometría del universo. Si la teoría de cuerdas es correcta, la estructura microscópica de nuestro universo es un laberinto multidimensional ricamente entrelazado, dentro del cual las cuerdas del universo se retuercen y vibran en un movimiento infinito, marcando el ritmo de las leyes del cosmos.

¿Serán las cuerdas las que hacen de nuestro Universo el que es?

Lejos de ser unos detalles accidentales, las propiedades de los bloques básicos que construyen la naturaleza están profundamente entrelazadas con la estructura del espacio-tiempo. En nuestro Universo, aunque no pueda dar esa sensación a primera vista, cuando se profundiza, podemos observar que, de alguna manera, todo está conectado, de la misma manera, nuestras mentes son parte del universo y, en ellas, están todas las respuestas.

Claro que, siendo todos los indicios muy buenos, para ser serios, no podemos decir aún que las predicciones sean definitivas y comprobables para estar seguros de que la teoría de cuerdas ha levantado realmente el velo de misterio que nos impide ver las verdades más profundas del universo, sino que con propiedad se podría afirmar que se ha levantado uno de los picos de ese velo y nos permite vislumbrar algo de lo que nos podríamos encontrar, a través de esa fisura parece que se escapa la luz de la comprensión que, en su momento, se podría alcanzar.

Muchos sueñan con encontrar esa Teoría del Todo

Mientras que la soñada teoría llega, nosotros estaremos tratando de construir ingenios que como el GEO600, el más sensible detector de ondas gravitacionales que existe ( capaz de detectar ínfimas ondulaciones en la estructura del espacio-tiempo ), nos pueda hablar de otra clase de universo. Hasta el momento el universo conocido es el que nos muestran las ondas electromagnéticas de la luz pero, no sabemos que podríamos contemplar si pudiéramos ver ese otro universo que nos hablan de la colisión de agujeros negros…por ejemplo.

“El detector de ondas gravitacionales GEO 600, de Hannover, en Alemania, registró un extraño ruido de fondo que ha traído de cabeza a los investigadores que en él trabajan. El actual director del Fermilab de Estados Unidos, el físico Carl Hogan, ha propuesto una sorprendente explicación para dicho ruido: proviene de los confines del universo, del rincón en que éste pasa de ser un suave continuo espacio-temporal, a ser un borde granulado. De ser cierta esta teoría, dicho ruido sería la primera prueba empírica de que vivimos en un universo holográfico, asegura Hogan. Nuevas pruebas han de ser aún realizadas con el GEO 600 para confirmar que el misterioso ruido no procede de fuentes más obvias. “

La teoría de cuerdas, aunque en proceso de elaboración, ya ha contribuido con algunos logros importantes y ha resuelto algún que otro problema primordial como por ejemplo, uno relativo a los agujeros negros, asociado con la llamada entropía de Bekenstein-Hawking, que se había resistido pertinazmente durante más de veinticinco años a ser solucionada con medios más convencionales. Este éxito ha convencido a muchos de que la teoría de cuerdas está en el camino correcto para proporcionarnos la comprensión más profunda posible sobre la forma de funcionamiento del universo, que nos abriría las puertas para penetrar en espacios de increíble “belleza” y de logros y avances tecnológicos que ahora ni podemos imaginar.

Como he podido comentar en otras oportunidades, Edward Witten, uno de los pioneros y más destacados experto en la teoría de cuerdas, autor de la versión más avanzada y certera, conocida como teoría M, resume la situación diciendo que: “la teoría de cuerdas es una parte de la física que surgió casualmente en el siglo XX, pero que en realidad era la física del siglo XXI“.

Witten, un físico-matemático de mucho talento, máximo exponente y punta de lanza de la teoría de cuerdas, reconoce que el camino que está por recorrer es difícil y complicado. Habrá que desvelar conceptos que aún no sabemos que existen.

Ellos nos legaron parte de las teorías que hoy manejamos en el mundo para tratar de conocer el Universo pero, sigue siendo insuficientes… ¡Necesitamos Nuevas Teorías! que nos lleven al conocimientos más profundos de la realidad en que se mueve la Naturaleza, sólo de esa manera, podremos seguir avanzando.

El hecho de que nuestro actual nivel de conocimiento nos haya permitido obtener nuevas perspectivas impactantes en relación con el funcionamiento del universo es ya en sí mismo muy revelador y nos indica que podemos estar en el buen camino al comprobar que las ecuaciones topológicas complejas de la nueva teoría nos habla de la rica naturaleza de la teoría de cuerdas y de su largo alcance. Lo que la teoría nos promete obtener es un premio demasiado grande como para no insistir en la búsqueda de su conformación final.

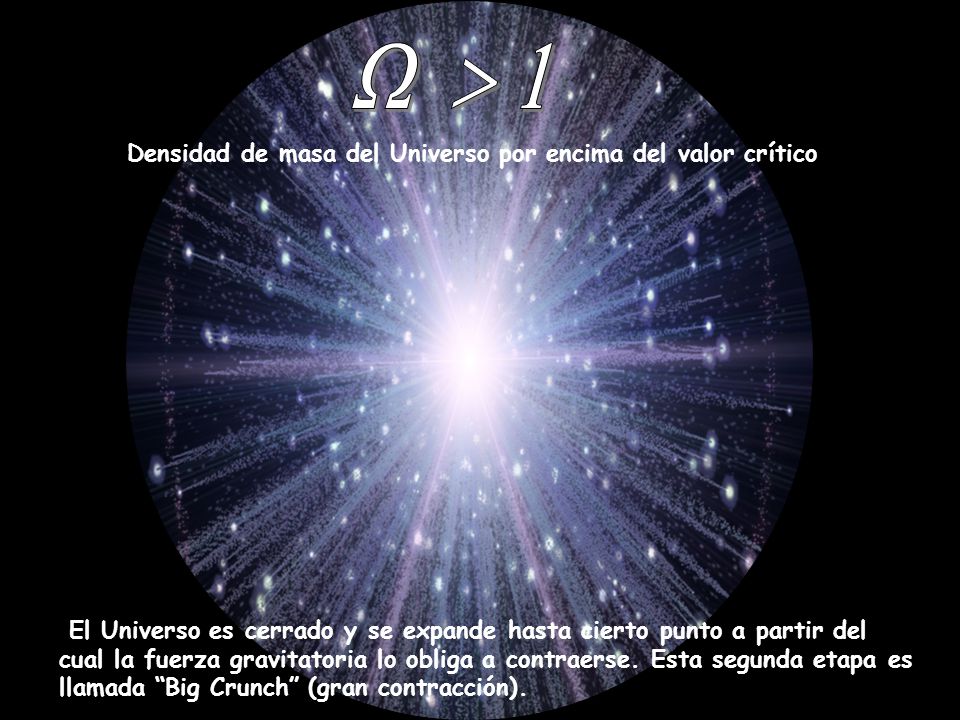

Ω el signo omega es el que representa la densidad que tiene nuestro Universo, es decir, lo que llaman Densidad Crítica ” El Omega Negro”, y, dependiendo de esa densidad, tendremos un universo plano, abierto o cerrado con distintos finales.

La expansión del universo se ha estudiado de varias maneras diferentes, pero la misión WMAP completada en 2003, representa un paso importante en la precisión y los resultados presentados hasta el momento con mayor precisión para saber, en qué clase de Universo estamos, cómo pudo comenzar y, cuál podría ser su posible final. Todo ello, es un apartado más de ese todo que tratamos de buscar para saber, en qué Universo estamos, cómo funcionan las cosas y por qué lo hacen de esa determinada manera y no de otra diferente.

La relatividad general nos dijo cómo es la geometría del Universo

El universo, la cosmología moderna que hoy tenemos, es debida a la teoría de Einstein de la relatividadgeneral y las consecuencias obtenidas posteriormente por Alexandre Friedmann. El Big Bang, la expansión del universo, el universo plano y abierto o curvo y cerrado, la densidad crítica y el posible Big Crunch.

Un comienzo y un final que abarcará miles y miles de millones de años de sucesos universales a escalas cosmológicas que, claro está, nos afectará a nosotros, insignificantes mortales habitantes de un insignificante planeta, en un insignificante sistema solar creado por una insignificante y común estrella.

Pero… ¿somos en verdad tan insignificantes?

Los logros alcanzados hasta el momento parecen desmentir tal afirmación, el camino recorrido por la humanidad no ha sido nada fácil, los inconvenientes y dificultades vencidas, las luchas, la supervivencia, el aprendizaje por la experiencia primero y por el estudio después, el proceso de humanización (aún no finalizado), todo eso y más nos dice que a lo mejor, es posible, pudiera ser que finalmente, esta especie nuestra pudiera tener un papel importante en el conjunto del universo. De momento y por lo pronto ya es un gran triunfo el que estemos buscando respuestas escondidas en lo más profundo de las entrañas del cosmos.

Tengo la sensación muy particular, una vez dentro de mi cabeza, un mensaje que no sé de dónde pero que llega a mi mente que me dice de manera persistente y clara que no conseguiremos descubrir plenamente esa ansiada teoría del todo, hasta tanto no consigamos dominar la energía de Planck que hoy por hoy, es inalcanzable y sólo un sueño.

Sus buenas aportaciones a la Física fueron bien recompensadas de muchas maneras.

En mecánica cuántica es corriente trabajar con la constante de Planck racionalizada, (ħ = h/2p = 1’054589×10-34 Julios/segundo), con su ley de radiación (Iv = 2hc-2v3/[exp(hv/KT)-1]), con la longitud de Planck , con la masa de Planck, y otras muchas ecuaciones fundamentales para llegar a lugares recónditos que, de otra manera, nunca podríamos alcanzar.

Todo lo anterior son herramientas de la mecánica cuántica que en su conjunto son conocidas como unidades de Planck, que como su mismo nombre indica son un conjunto de unidades, usadas principalmente en teorías cuánticas de la gravedad, en que longitud, masa y tiempo son expresadas en múltiplos de la longitud, masa y tiempo de Planck, respectivamente. Esto es equivalente a fijar la constante gravitacional (G), como la velocidad de la luz (c), y la constante de Planck racionalizada (ħ) iguales todas a la unidad. Todas las cantidades que tienen dimensiones de longitud, masa y tiempo se vuelven adimensionales en unidades de Planck. Debido a que en el contexto donde las unidades de Planck son usadas es normal emplear unidades gaussianas o unidades de Heaviside-Lorentz para las cantidades electromagnéticas, éstas también se vuelven adimensionales, lo que por otra parte ocurre con todas las unidades naturales. Un ejemplo de esta curiosidad de adimiensionalidad, está presente en la constante de estructura fina (2πe2/hc) de valor 137 (número adimensional) y cuyo símbolo es la letra griega α (alfa).

Estas unidades de Planck nos llevan a la cosmología del nacimiento del universo y nos proporciona un marco elegante, coherente y manejable mediante cálculos para conocer el universo remontándonos a los primeros momentos más breves posteriores a la explosión o Big Bang. El tiempo de Planck por ejemplo, expresado por , tiene un valor del orden de 10-43 segundos, o lo que es lo mismo, el tiempo que pasó desde la explosión hasta el tiempo de Planck fue de:

0,000.000.000.000.000.000.000.000.000.000.000.000.000.001 de 1 segundo. En la fórmula, G es la constante universal de Newton, ħ es la constante de Planck racionalizada y c es la velocidad de la luz.

Es una unidad de tiempo infinitesimal, como lo es el límite de Planck que se refiere al espacio recorrido por un fotón (que viaja a la velocidad de la luz) durante una fracción de tiempo de ínfima duración y que es de 0,000.000.000.000.000.000.000.000.000.000.001 de cm.

Hasta tal punto llegan los físicos en sus cálculos para tratar de adecuar los conocimientos a la realidad por medio del experimento. Buscamos incansables…¡las respuestas! Hasta que no podamos tocar con nuestras propias manos esa partícula final…

Sin embargo, cuando hablamos de estas unidades tan pequeñas, no debemos engañarnos. Precisamente, para tratar de llegar hasta esos límites tan profundos se necesitan máquinas que desarrollan inmensas energías: los aceleradores de partículas, que como el Fermilab o el LHC en el CERN, han facilitado a los físicos experimentadores entrar en las entrañas de la materia y descubrir muchos de los secretos antes tan bien guardados. Ahora, disponiendo de 14 TeV, tratan de buscar partículas supersimétricas y el origen de la “materia oscura”.

Haber fabricado acelerados tan potentes como para poder detectar la partícula de Higgs, esa partícula responsable de proporcionar masa a todas las demás partículas, en tiempos pasados era un sueño que pudimos hacer realidad y, de la misma manera, soñamos ahora con tener un Acelerador tan Potente como para poder encontrar las cuerdas o las partículas simétricas de las que se cree están conformadas. Y, por supuesto, más lejos queda la posibilidad de que podamos construir un acelerador que pudiera alcanzar la energía de Planck, del orden de 1019 eV (1 eV = 10-19 julios) = 1’60210×10-19. Hoy por hoy, ni nuestra tecnología ni todos los recursos que tenemos disponibles si empleáramos todo el presupuesto bruto de todos los países del globo unidos, ni así digo, podríamos alcanzar esta energía necesaria para comprobar experimentalmente la existencia de “cuerdas” vibrantes que confirmen la teoría de Todo.

Claro que, pudiera ser que, todo se pudiera alcanzar de manera mucho más simple y que, teniéndolo a la vista, no hemos sabido ver. Habrá que agudizar el ingenio para resolver estas y otras cuestiones que, como la de la Velocidad de la Luz, nos tienen atados y bien atados a este granito de arena inmerso en un vasto universo y que, nosotros, llamamos mundo.

Emilio Silvera Vázquez

Totales: 84.200.001

Totales: 84.200.001 Conectados: 119

Conectados: 119