Astronomía: Reportaje en El Español

IMPRESIÓN NO PERMITIDA - TEXTO SUJETO A DERECHOS DE AUTOR

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Vida ~

Clasificado en El Universo y la Vida ~

Comments (0)

Comments (0)

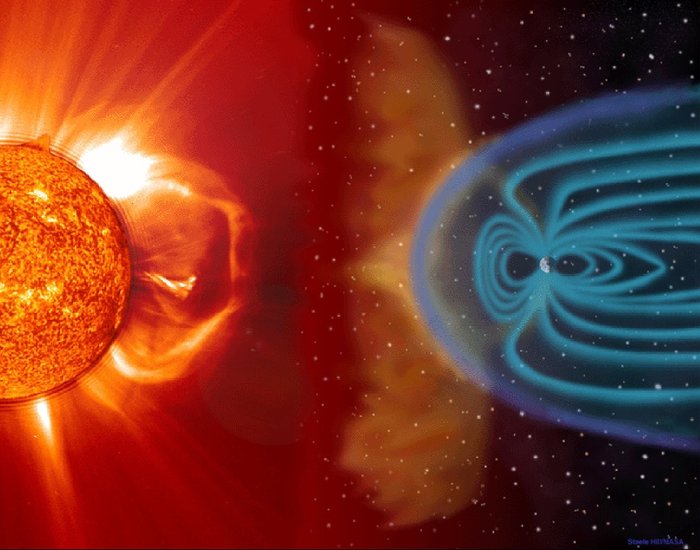

La regularidad de la Tierra que viene dada por la intensidad de energía que nos envía el Sol, desde 150 millones de kilómetros, y, la intensidad está amortiguada por la rica y densa atmósfera terrestre, y, los seres vivos, tienen un escudo contra las radiaciones nosivas. Ahora sabemos que, sólo en nuestra Galaxia, existen cientos de miles, millones de planetas que, como la Tierra, pueden albergar alguna clase de vida.

El día en Marte dura 687 días terrestres, su período de rotación es de 24 horas

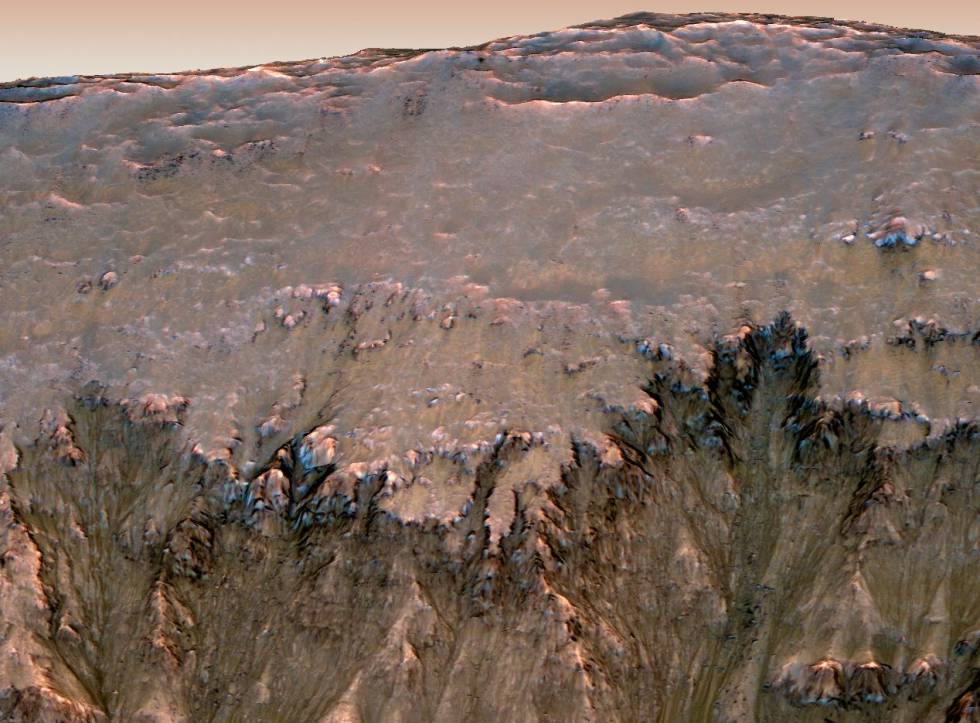

Al contrario que ocurre con la Tierra, muy distinto es el caso de Marte que, aunque situado a mayor distancia, no tiene atmósfera que le preserve de esos rayos solares tan nosivos para la vida.

Así que la vida en marte (si es que finalmente está presente en aquel planeta alguna forma de ella), tendría que haber emigrado al subsuelo, lejos de la superficie, a salvo de la radiación y, en las profundidades, con temperaturas más altas, probablemente, el agua correría líquida por los regusos caminos oradados por la antigua actividad volcánica que, en aquel planeta fue rica y dejó la huella de profundos túneles, grutas y cuevas que, en la actualidad, podrían ser idóneos para albergar algunas formas de vida como líquenesw y hongos, sin olvidar las bacterias.

Pero sigamos con los mecanismos más familiares que afectan a nuestro planeta y a todos sus moradores, entre los que, nuestra especie también cuenta. Las influencias lunares a nuestro alrededor son notables y han dejado su huella en nuestros cuerpos por las presiones del Tiempo.

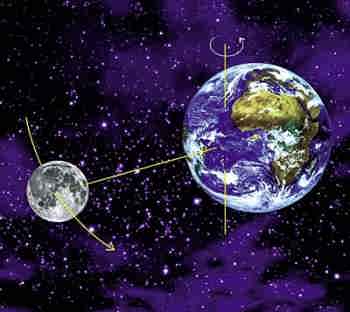

La doceava parte del año que llamamos mes, un período próximo a 27,32 días, es el tiempo que la Luna tarda en dar una vuelta alrededor de la Tierra, con respecto a las lejanas estrellas fijas.

Durante este período que llamamos el período Sidereo de la Luna, la Tierra también se habrá movido en su órbita alrededor del Sol, y la Luna tendrá que moverse una distancia adicional (unos 27 grados) para completar el ciclo de fases con respecto al Sol. De hecho, teniendo esto en cuenta, el ciclo mensual entero de las fases lunares es de 29,53 días.

La presencia de la Luna como todos sabemos, ejerce una atracción gravitatoria sobre el planeta Tierra y viceversa. Esa atracción, lógicamente, es más fuerte en el lado de la Tierra que está más próxima a la Luna.

Esa atracción crea una variación de marea en las alturas de los océanos, que varía mensualmente con el movimiento de la Luna alrededor de la Tierra. Existen indicios sorprendentes de que esta variación ha dejado su huella de diversas maneras en las pautas de conducta de los seres vivos que pueblan el planeta.

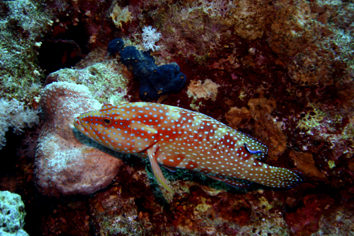

En el caso de criaturas que viven en aguas someras, o son anfibias, la variación de las mareas les proporciona una escena diversificada importante que les obliga a tener que adaptarse para poder beneficiarse de esos cambios.

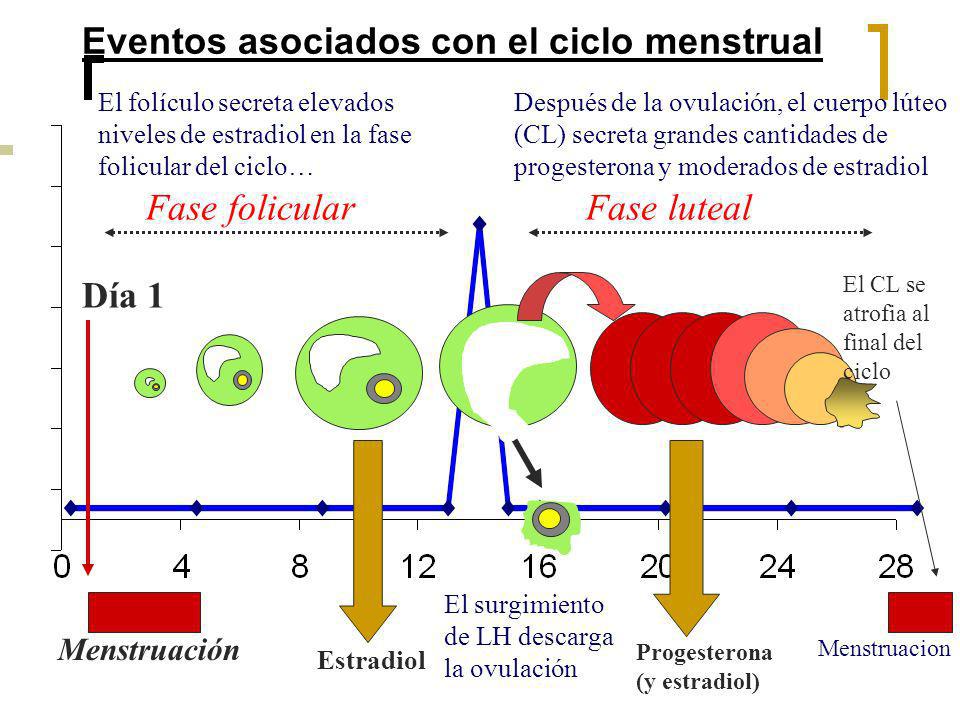

La producción de ovocitos en la mujer es cíclica. Implica tanto la interacción de hormonas como cambios en las células foliculares y en las paredes del útero. A este ciclo se lo conoce como ciclo menstrual o ciclo sexual femenino

Todos sabemos que las mujeres muestran un ciclo de producción de estrógenos de 28 días, que está próximo al período mensual lunar. Le llamamos “ciclo menstrual” -derivado de meses, o mes

Muchos otros mamíferos tienen ciclos menstruales con variaciones asociadas a la temperatura corparal, y se ha encontrado que el tiempo de ovulación, en los primates, varía entre 25 y 35 días.

No se han encontrado explicaciones simples para estas correlaciones entre las fases de la Luna y los ciclos menstruales. ¿Por qué la fertilidad Humana debería reflejar el ciclo de las fases cambiantes de la Luna?Se ha sugerido que podía ser un vestigio de una etapa anterior de nuestra evolución, cuando nuestros ancestros vivían en el mar, y estaban sometidos de alguna manera, al cicvlo de las mareas.

Otra propuesta es que estos ciclos son ligeras adaptaciones del período en que los Humanos eran cazadores recolectores primitivos. En tales circunstancias, la luz del día era un bien escaso y la Luna llena debía explotarse al máximo.

El período oscuro, cuando la Luna habia desaparecido podría dedicarse de forma natural a la actividad del apareamiento, y entonces habría adaptación a un ciclo corporal con una periodicidad química que reflejaría la variación lunar.

Pero sigue siendo un misterio como una variación suficientemente robusta se podría preservar de forma universal hasta el presente, y, en tantas especies.

De todo lo anterior, no tenemos más opción que pensar dos cosas:

Pasó el Tiempo Y los Mamuts desaparecieron

Sabemos que nada es Eterno, que todo cambia con el paso del Tiempo, y, la Tierra, no podía ser ninguna excepción, así que, de esas dos opciones que nos habla el Autor del trabajo, podrían ser:

UNA: Que nuestro mundo, como cualquier otro objeto del Universo, ha tenido un principio que, con el paso del tiempo cambió, y, lo que fue primero se transformó en algo diferente en el presente, y, como el tiempo inexorable no deja de transcurrir llevando con él a esa temible “compañera” que llamamos Entropía, el resultado previsible será que, los cambios serán imparables y nada permanecerá estático tal y como hoy lo conocemos que es como se conocío hace cientos o miles o millones de años.

Todos los seres vivos que viven actualmente en el planeta Tierra, se verán abocados a mutar para que, en el mejor de los casos, sus especies perduren a los cambios que se avecinan. Los que no se adapten, como antes pasó en la historia de nuestro planeta, sucumbiran y esas especies desaparecerán para siempre.

Un equipo científico ha encontrado en las rocas del oeste de Australia microbios fosilizados que vivían hace 3.400 millones de años en un mundo sin oxígeno … Más tarde, otros lo hicieron en Canadá donde los fósiles tenían más de 3.900 millones de años. Es decir, la vida en la Tierra apareció muy temprano.

Todas las especies que han vivido en este planeta desede hace unos 3.800 millones de años, unas más y otras menos, trataron de adaptarse a esos cambios irreversibles que la Naturaleza impone. Sabemos de las importantes extenciones que por uno u otro motivo ha padecido la fauna del planeta, y, actualmente el 99% de todas las especies que poblaron la Tierra, han dejado de existir.

De hecho, hoy día, sólo el 1% de las especie que vivieron en el planeta están vivas y compartiendo el planeta con nosotros, algunas son muy antiguas, otras han surgido recientemente, y, por ejemplo nosotros, que hemos podido sobresalir por nuestras características de los demás seres vivos de la Tierra, se podría decir que somos unos recien llegados, y, sin embargo, nos creemos “los amos”.

Aunque no sea parte del texto que transcribo (bueno algunos otros pasajes tampoc0), tenemos que recordar aquí que los Dinosaurios reinaron en nuestro planeta durante 150 millones de años, según parece, aquel meteorito caído en el Yucatán (México), acabó con ellos, y, gracias a ese suceso, 65 millones de años más tarde, llegamos nosotros aquí. Es decir, se abrió el callejón sin salido en el que estabn metidos mos mamíferos que, con estas bestias campando por el planeta, poco porvenir podían tenerr. Ahí cabe perfectamente aquella frase: “No hab mal que por bien no venga”.

De todas las maneras y con respecto a la vida, hasta donde podemos saber, ésta se abre paso en los lugares más insospechados y, los materiales que son necesarios para que pueda surgir en planetas como la Tierra, es fusionado en el corazón de los hornos nucleares de las estrellas, donde materiales sencillos hacen su transición de fase a otros más complejos, y, cuando la estrella “muere”, se esparcen en inmensas Nebulosas de las que surgen nuevas estrellas, nuevos mundos y, seguramente, nuevas formas de vida.

Desde siempre hemos querido saber y preguntamos por el por qué de las cosas. Así que, procuremos seguir conquistando ese saber que tanto necesitamos hoy, y, posiblemente, mañana necesitemos más, ya que, se avecinan acontecimientos que, de no conocer sus posibles efectos, ningún remedio podremos preparar para paliar los destrozos.

Es bastante instructivo el saber de hechos del pasado que nos abren “los ojos de la mente” a nuestro escaso entendimiento para que nos hagan saber el por qué, de algunos sucesos que han quedado registrados en la Historia del Planeta y de la Humanidad.

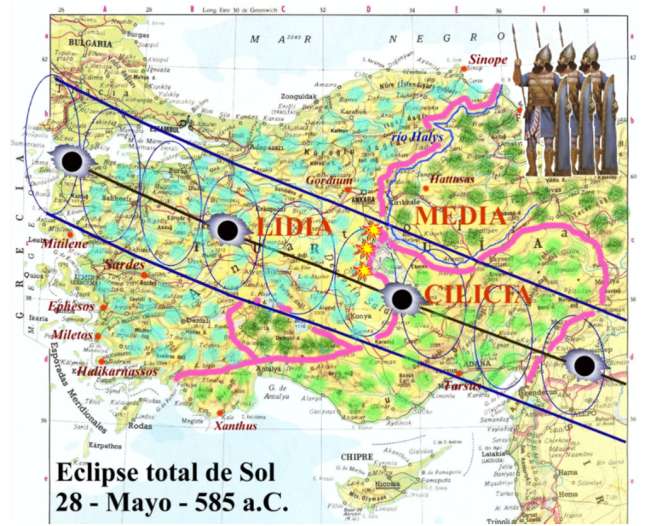

Resulta que, el 28 de mayo del año 585 a. C., cuando la guerra en Lidios y Medas era más cruenta y duraba ya cinco años, de pronto, el día se convirtió en noche, asombrados, todos los contendientes dejaron de luchar y, se tomaron aquello como una señal “divina”, los dioses no querían que la lucha continuara. Así que, los reyes y nobles, casaron a sus hijos e hijas con los de los hasta entonces enemigos y, la paz, perduró durante mucho, mucho tiempo.

Claro que, lo que no supieron nunca Lidios y Medos es que, el evento había sido un simple eclipse solar producido por la Luna al tapar por completo el astro rey. Y, aquel acontecimiento astronómico, en este caso, sirvió para algo bueno.

Ahora sabemos que la inclinación del eje terrestre hace posible las Estaciones del planeta y que, dichas cambios, son tan beneficiosos para todo y para todos. También conocemos de los fenómenos naturales como los volcanes y movimientos de las placas tectónicas, tsunamis y otros acontecimientos naturales que no achacamos a ninguna divinidad y para los que tenemos explicaciones científicas.

El repaso ha sido bueno de una parte de la obra y, aquí lo dejo transcrito con algún que otro matiz propio como licencia que, de ninguna manera, perjudica a la idea original que el autor nos cuenta.

La Fuente: “El Universo como Obra de Arte” JOHN D. BARROW.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

La supervivencia del universo depende de las reservas de gas. Los astrónomos han podido descubrir el mecanismo que está acabando con ellas.

Nuestro universo se apaga. Por supuesto, su sombrío y gélido final no llegará hasta dentro de muchos miles de millones de años, sin embargo el camino hacia la oscuridad ya está en marcha y se puede constatar en la luz, cada vez más roja y antigua, que nos llega de las galaxias.

“Las galaxias son sistemas que van reciclando gas”, explica Miguel Santander, investigador en el Grupo de Astrofísica molecular del ICMM, “ese gas se acumula, se va condensando y finalmente forma estrellas. Pasa el tiempo y cuando esos soles mueren, devuelven gran parte del gas al medio, que una vez más se utiliza para formar nuevas estrellas, y así sucesivamente… mientras haya reservas de gas, las galaxias seguirán formando estrellas pero cuando se agoten esas reservas de gas, dejarán de formar estrellas y entonces podemos decir que son galaxias muertas”

Entonces, ¿se puede decir que las galaxias también mueren?

“No es un término científico, pero sí. Los astrofísicos decimos coloquialmente que una galaxia ha muerto cuando ha perdido la capacidad de formar nuevas estrellas”, aclara el investigador. “La galaxia pasa entonces a tener colores más apagados, al no surgir nuevos repuestos, las estrellas que tiene cada vez serán más viejas y su luz irá pasando del azul, al amarillo, al rojo… galaxias dominadas por antiguas estrellas rojas, que paulatinamente se irán apagando y que ya no serán reemplazadas por otras más jóvenes”.

Los astrofísicos saben desde hace años que la formación estelar en el universo primitivo, (hace 10.000 millones de años o más), era mucho mayor que hoy en día. Las galaxias que vemos cercanas, que son más jóvenes y actuales, presentan mucha menos formación estelar que las galaxias lejanas. Esto nos lleva a la triste conclusión de que el universo se está apagando progresivamente y hasta ahora no sabíamos exactamente por qué las galaxias actuales tenían menos capacidad para generar nuevas estrellas.

“Conocemos varios mecanismos que impiden formar nuevas estrellas”, explica Miguel Santander. “Por ejemplo, un gas cuanto más frío está, más se condensa. Así, una posibilidad para impedir que una galaxia forme nuevas estrellas sería calentar el gas… Lo calientas, aumenta la presión y entonces se opone a la acción de la gravedad que hace que ese gas se condense y forme nuevas estrellas”. Sin embargo, en un universo cada vez más frío esta posibilidad no parece una buena pista.

También existen colisiones de galaxias en las que una de ellas se queda con el gas de la otra. Aquí tenemos otro posible fenómeno que puede apagar una galaxia. Pero tampoco parece ser el caso que nos ocupa puesto que nuestras galaxias víctimas no presentan “signos de colisión”.

Así pues, si planteamos el asunto como un caso de detectives, debemos concluir que ha de existir algún otro mecanismo que esté robando el gas frío de las galaxias, impidiendo que formen nuevas estrellas, y haciendo por tanto que, tarde o temprano, terminen como galaxias muertas.

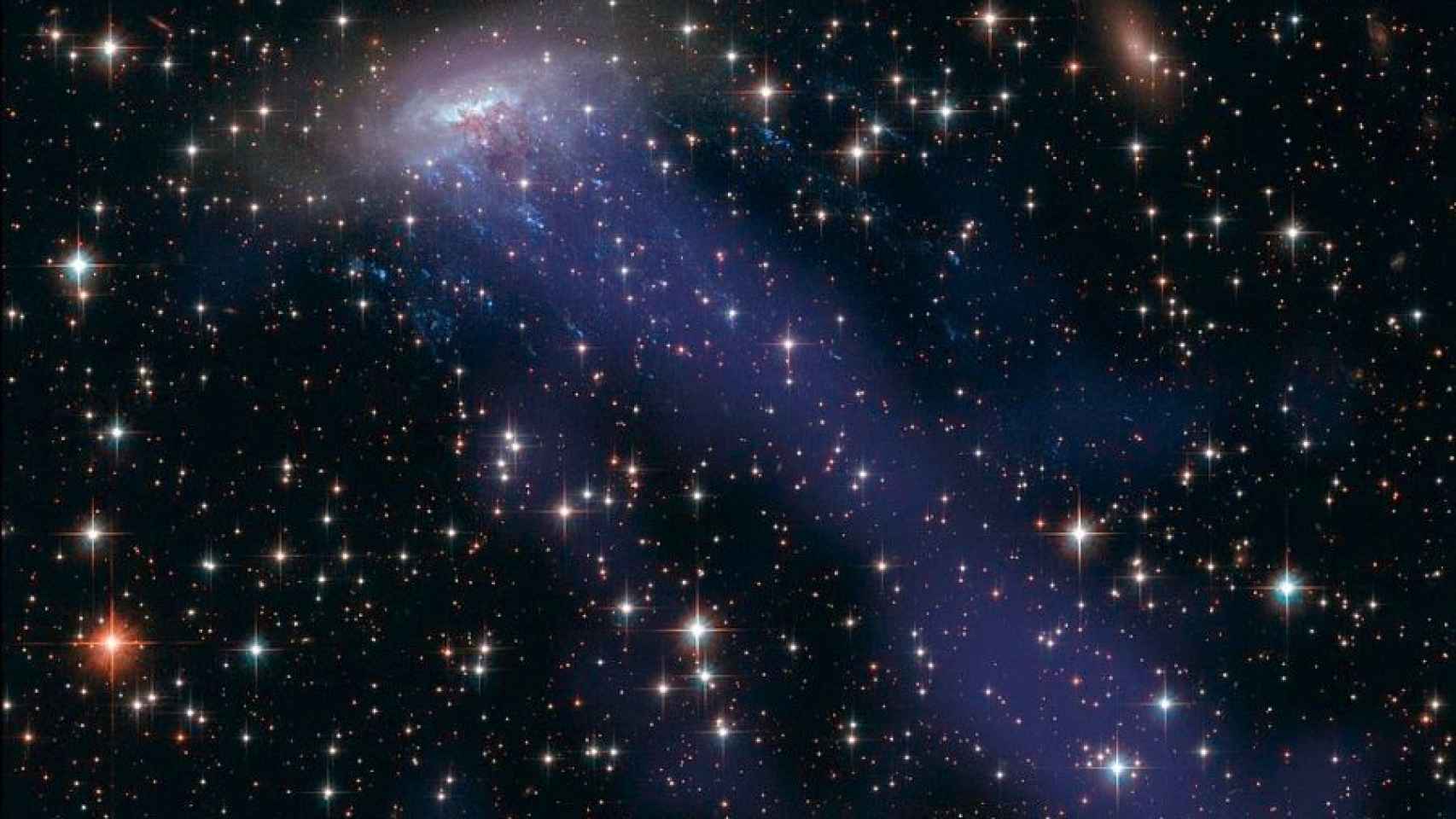

La imagen superior corresponde a una de las víctimas. Se trata de la galaxia ESO 137-001 y se está desplazando hacia el centro de un gigantesco cúmulo galáctico conocido como Norma Cluster o Abell 3627.

En su viaje interestelar hacia el centro del cúmulo está pasando de un medio con pocas partículas a otro medio mucho más denso. Esa diferencia de densidad hace que las partículas más ligeras, como el gas frío, se escapen de la galaxia y formen largas colas, igual que lo haría un cometa.

“Se les conoce como galaxias medusa (Jellyfish galaxies) y para ver más claramente a qué nos referimos, en la imagen se ha coloreado artificialmente de azul el gas que van perdiendo en su viaje hacia el centro del cúmulo”. Casi podríamos decir que la galaxia se desangra lenta y sigilosamente, dejando atrás el gas frío que necesita para formar estrellas.

Bajo el sugerente título de Galaxy murder mistery investigadores del International Centre for Radio Astronomy Research (ICRAR) en Australia han publicado esta semana una posible solución al enigma que está apagando estas galaxias. Y precisamente en Australia se encuentra el investigador español, Ángel R. López-Sánchez, astrofísico multifrecuencia en el Australian Astronomical Observatory y la Universidad de Macquarie (Sídney), quien finalmente nos desvela el misterio: “El gran sospechoso es un mecanismo conocido como Ram-pressure stripping... que traducido sería algo así como expulsión de gas por la presión de arrastre”.

Cada galaxia se mueve por el espacio y se siente atraída gravitatoriamente por los objetos masivos que encuentra a su paso, tales como grandes cúmulos u otras galaxias. Cuando esa galaxia, que originariamente se estaba moviendo en un medio que casi era vacío, se aproxima a estos cúmulos muy masivos, empieza a desplazarse en un medio que es más denso.

“Es entonces, cuando la galaxia se adentra en un medio más denso, pierde sus componentes más livianos, en este caso el gas frío, mediante este mecanismo de Ram-pressure stripping, y al decir adiós a esas reservas de gas, pierde también la capacidad de formar nuevas estrellas”, señala López-Sánchez.

“Este fenómeno de Ram-pressure stripping se había comprobado en numerosos cúmulos de galaxias”, indica el astrofísico, “teníamos constancia de que ocurría en estas gigantescas agrupaciones en donde las galaxias que estaban más próximas al centro suelen tener mucho menos gas que las galaxias que están en las regiones más exteriores. Al desplazarse dentro del cúmulo, las galaxias que se adentran en un medio más denso ven como el gas frío se queda atrás”.

Hasta ahora sabíamos que este mecanismo afectaba a galaxias que se desplazaban en grandes cúmulos con más de 100 galaxias, en los que además existen grandes cantidades de materia oscura que también influían gravitatoriamente en su desplazamiento.

Sin embargo, el artículo publicado por los investigadores de ICRAR amplía el modus operandi de nuestro asesino, no solo a grandes cúmulos galácticos sino también a pequeñas galaxias fuera de esas regiones. El estudio ha utilizado métodos estadísticos con miles de galaxias y han encontrado que la pérdida de gas frío es mayoritaria.

El estudio ha utilizado datos en óptico del cartografiado SLOAN (que tiene datos de millones de galaxias) y con el que han analizado el color y magnitud de las galaxias. En paralelo, y es lo que tiene un valor extra, han usado también datos en radio del cartografiado ALFALFA, realizado por el gran telescopio de Arecibo. “Con estos dos tipos de datos (óptico y radio) han analizado más de 10.000 galaxias diferentes y han podido correlacionar estadísticamente dónde se encuentra la galaxia, qué ritmo de formación estelar tiene, qué color tiene (lo que además nos indica la edad de la galaxia) y qué cantidad de gas posee” aclara López-Sánchez. “De esta manera a cada galaxia de SLOAN le dan un valor de hidrógeno (el gas frío más común para formar estrellas) extraído del cartografiado ALFALFA”.

¿Qué han encontrado? La solución es que un alto porcentaje de las galaxias analizadas están perdiendo gas. Son galaxias que aún están formando estrellas, sí, pero que apenas tienen gas frío para continuar renovándose. El mecanismo de Ram-pressure stripping las está “asfixiando“, haciendo que el combustible necesario para renovar sus estrellas se escape fuera de ellas y consiguiendo que, lenta y sigilosamente, se conviertan en galaxias muertas.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Marte ~

Clasificado en Marte ~

Comments (0)

Comments (0)

Los primeros héroes de la Tierra fueron microbios. Hace 2.700 millones de años la atmósfera comenzó a acumular oxígeno producido por cianobacterias que vivían en los océanos y eran capaces de realizar fotosíntesis. El oxígeno fue fundamental para la aparición de vida más compleja, incluidos los primeros animales, y hoy sustenta el tipo de metabolismo más habitual del planeta.

Cianobacterias; De izquierda a derecha: Synechocystis, Gloeothece, Nostoc, Dermocarpa, Anabaena, Scytonema,Pleurocapsa, Oscillatoria, Fischerella, … La acumulación de cianobacterias en los embalses del río Negro llegó a un nivel que pone en riesgo la salud de quienes utilizan su agua para baños. La zona está en la mira de los investigadores de la Facultad de Ciencias y del Ministerio de Defensa de Uruguay.

En la NASA Proponen ‘sembrar’ cianobacterias en Marte para generar oxígeno

Ahora, un nuevo estudio apunta a que en zonas de Marte también puede haber suficiente oxígeno como para mantener a algunos seres vivos terrestres. Vlada Stamenkovic, investigador de la NASA, y colegas del Instituto Tecnológico de California han desarrollado un modelo que calcula la cantidad de oxígeno que podría encontrarse en disolución en las aguas saladas que pueden existir en algunas zonas del planeta. Las sales presentes en estas salmueras permiten que el agua permanezca líquida a temperaturas por debajo de los cero grados. Según el estudio, publicado hoyen Nature Geoscience, en torno a un 6,5% de todo el planeta puede albergar cantidades de oxígeno en la superficie o a unos centímetros por debajo de ella similares a las que en la Tierra bastan para sustentar a algunos microbios y esponjas.

Estudios recientes apuntan a que los primeros ancestros de los animales actuales eran esponjas y que estos seres vivos pueden proliferar en concentraciones de oxígeno muy bajas. Las zonas con posible oxígeno están por encima de los 50 grados de latitud en torno a los polos. Entre las misiones marcianas que analiza el estudio solo una ha explorado estas zonas: la misión Phoenix, que aterrizó sobre lo que podría ser hielo de agua en 2008.

Este mismo año se descubrió en Marte un gran lago de agua salada oculto bajo el hielo del polo sur. El nuevo estudio especula que la concentración de oxígeno en su interior podría ser “alta” si hay un contacto temporal con la superficie o si hay radiación suficiente para que se separen el oxígeno y el hidrógeno. Los responsables del trabajo consideran que estos resultados teóricos pueden explicar el estado de oxidación de algunas rocas marcianas e implican “que hay oportunidades para la vida basada en el oxígeno en el Marte actual u otros cuerpos planetarios gracias a fuentes de oxígeno alternativas a la fotosíntesis”.

Víctor Parro, investigador del Centro de Astrobiología (CAB-CSIC), destaca que hasta ahora la presencia de oxígeno en Marte se ha “despreciado”, debido a las bajas concentraciones. Aunque se trata de un estudio teórico que habría que confirmar con mediciones reales, el científico destaca que “estos modelos resaltan el papel que puede jugar el O₂ disuelto incluso actualmente tanto para la respiración de microorganismos como en la oxidación de metales”.

“Los microorganismos no necesitan O₂ para respirar”, explica, “pero el oxígeno molecular permite obtener mayor energía en los procesos de respiración y su presencia en Marte en concentraciones adecuadas aumenta las posibilidades de nuevos metabolismos y más eficientes. “Por ejemplo permitiría la existencia de bacterias como las que se encuentran en río Tinto [Huelva], que oxidan el hierro de la pirita para obtener energía. Y algo que abunda en Marte es el hierro”, destaca.

Las bacterias halófilas, o amantes de la sal, son organismos extremófilos; es decir, adaptados a condiciones ambientales muy difíciles de soportar para la mayoría de los seres vivos; en este caso, altísimas concentraciones de sal.

“Los autores eligen el grupo de organismos terrestres que son capaces de vivir a concentraciones de oxígeno disuelto en agua más bajas, que son básicamente ciertos tipos de bacterias y las esponjas, y concluyen que las concentraciones de oxígeno que calculan que pueden existir en las salmueras marcianas serían suficientes para que estos organismos pudieran medrar en Marte hoy”, explica Alberto González Fairén, investigador del CAB y la Universidad Cornell. “Por supuesto, es solo una comparación gráfica para resaltar lo elevado de los niveles de oxígeno disuelto en estas salmueras y los autores no insinúan que puedan existir esponjas en bolsas de líquido escondidas en los hielos de Marte. Los posibles habitantes de las salmueras no solo dependerían del oxígeno disponible para respirar: las bajísimas temperaturas, la altísima concentración de sales y la radiación no permiten la existencia de vida similar a la terrestre cerca de la superficie de Marte hoy”, añade.

Otra de las preguntas sin responder que deja el trabajo es si realmente hay salmueras de agua líquida en la superficie de Marte, ya que las pruebas acumuladas hasta ahora no son concluyentes.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Las corrientes de convección son movimientos que describen los fluidos. Cuando éstos se calientan, se dilatan y ascienden. Al llegar esos materiales a la corteza terrestre se enfrían debido a que esta capa tiene una baja temperatura. Al enfriarse los materiales, se contraen y descienden hasta alcanzar el núcleo de la Tierra, donde el proceso volverá a comenzar.

Toda esta energía térmica actúa sobre los materiales provocando el movimiento de estos, generando elevadas presiones que llevan a transformaciones en la estructura de los materiales. En ocasiones, estas presiones se liberan bruscamente. Todos hemos podido contemplar las consecuencias devastadoras de tales acontecimientos.

Ulises de Itaca se hizo amarrar al palo de la embarcación para oir el canto de las sirenas y no quedar encantado. Andar nuevos caminos, descubrir cosas nuevas, siempre ha sido una permanente de nuestra especie.

“Quien ha visto las cosas presentes ha visto todo, todo lo ocurrido desde la eternidad y todo lo que ocurrirá en el tiempo sin fin; pues todas las cosas son de la misma clase y la misma forma”.

Marco Aurelio

Claro que él, quería significar que todo, desde el comienzo del mundo, ha sido igual, sigue unos patrones que se repiten una y otra vez a lo largo del transcurso de los tiempos: el día y la noche, el hombre y la mujer, el frío y el calor, el río muerto por la sequía o aquel que, cantarino y rumoroso ve correr sus aguas cristalinas hasta que desembocan en el océano. La Bondad y la maldad…Así ha sido siempre y, así continuará siendo por toda la eternidad.

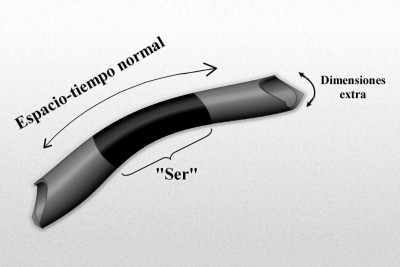

Sólo vamos a ser conscientes de dimensiones extra allí donde inciden directamente sobre las D-brana en la que “vivimos”. Más que una imagen de tipo “espacio cociente” que evoca la analogía de Kaluza-Kleinoriginal:

El gráfico representa un modelo de manguera de un espacio-tiempo de dimensiones más altas de tipo Kaluza-Klein, donde la longitud, o mejor, la dimensión a lo largo de la longitud de la manguera representa el 4-espacio-tiempo normal, y la dimensión alrededor de la manguera representa la dimensión extra “pequeñas” (quizá escala de Planck). Imaginemos un “ser” que habite en este mundo, que rebasa estas dimensiones extra “pequeñas”, y por ello no es realmente consciente de ellas.

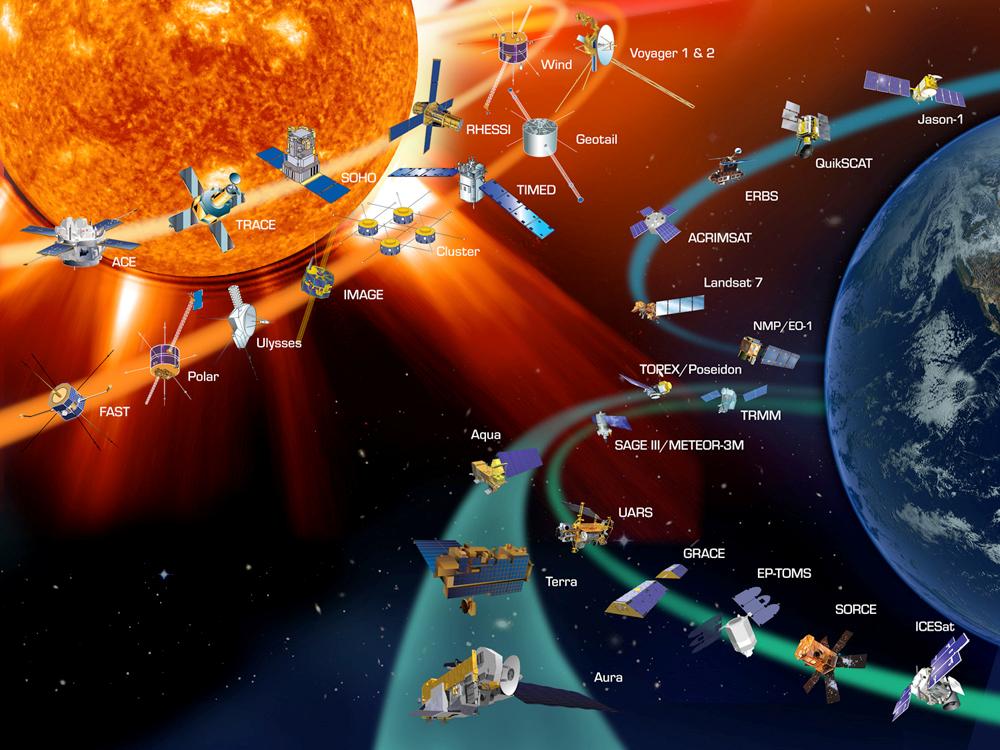

Es ampliamente sabido que el planeta Tierra actúa como un gran imán cuyas líneas de campo geomagnético surgen de un polo (el polo sur magnético) y convergen en el otro polo (polo norte magnético). El eje longitudinal de este imán tiene una desviación de aproximadamente 11^o con respecto al eje de rotación. Por ello, los polos del campo magnético generado no coinciden exactamente con los polos geográficos.

Este campo geomagnético es producido por la combinación de varios campos generados por diversas fuentes, pero en un 90% es generado por la exterior del núcleo de la Tierra (llamado Campo Principal o “Main Field”).

Por otra , la interacción de la ionosfera con el viento solar y las corrientes que fluyen por la corteza terrestre componen la mayor del 10% restante. Sin embargo, durante las tormentas solares (eventos de actividad solar exacerbada) pueden introducirse importantes variaciones en el campo magnético terrestre.

Las grandes tormentas solares inciden sobre nosotros y nuestras obras

Las fuerzas magnéticas y eléctricas están entrelazadas. En 1873, James Clerk Maxwell consiguió formular las ecuaciones completas que rigen las fuerzas eléctricas y magnéticas, descubiertas experimentalmente por Michael Faraday. Se consiguió la teoría unificada del electromagnetismo que nos vino a decir que la electricidad y el magnetismo eran dos aspectos de una misma cosa.

La interacción es universal, de muy largo alcance (se extiende entre las estrellas), es bastante débil. Su intensidad depende del cociente entre el cuadrado de la carga del electrón y 2hc (dos veces la constante de Planck por la velocidad de la luz). Esta fracción es aproximadamente igual a 1/137’036…, o lo que llamamos α y se conoce como constante de estructura fina.

En general, el alcance de una interacción electromagnética es inversamente proporcional a la masa de la partícula mediadora, en este caso, el fotón, sin masa.

![[stephan_quinteto_2009_hubble.jpg]](http://3.bp.blogspot.com/_xBXZbW6ivIs/SqpvjP3SBJI/AAAAAAAAEqc/fh3ULAFurbs/s1600/stephan_quinteto_2009_hubble.jpg)

Muchas veces he comentado sobre la interacción gravitatoria de la que Einstein descubrió su compleja estructura y la expuso al mundo en 1915 con el de teoría general de la relatividad, y la relacionó con la curvatura del espacio y el tiempo. Sin embargo, aún no sabemos cómo se podrían reconciliar las leyes de la gravedad y las leyes de la mecánica cuántica (excepto cuando la acción gravitatoria es suficientemente débil).

La teoría de Einstein nos habla de los planetas y las estrellas del cosmos. La teoría de Planck, Heisemberg, Schrödinger, Dirac, Feynman y tantos otros, nos habla del comportamiento del átomo, del núcleo, de las partículas elementales en relación a estas interacciones fundamentales. La primera se ocupa de los cuerpos muy grandes y de los efectos que causan en el espacio y en el tiempo; la segunda de los cuerpos muy pequeños y de su importancia en el universo atómico. Cuando hemos tratado de unir ambos mundos se produce una gran explosión de rechazo. Ambas teorías son (al menos de momento) irreconciliables.

Lo podríamos representar de cualquier manera, ya que, su cara nos es desconocida. El Gravitón es la única partícula mediadora de una fuerza (en este caso de la Gravedad), que no ha sido encontrada en ningún experimento. Sin embargo, todos los físicos creen que existe… ¡Dónde se esconde el puñetero!

La partícula mediadora es el hipotético gravitón. Aunque aún no se ha descubierto experimentalmente, sabemos lo que predice la mecánica cuántica: que tiene masa nula y espín 2.

La ley general para las interacciones es que, si la partícula mediadora tiene el espín par, la fuerza cargas iguales es atractiva y entre cargas opuestas repulsiva. Si el espín es impar (como en el electromagnetismo) se cumple a la inversa.

Pero antes de seguir profundizando en estas cuestiones hablemos de las propias partículas subatómicas, para lo cual la teoría de la relatividad especial, que es la teoría de la relatividad sin fuerza gravitatoria, es suficiente.

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio da a entender, no hay carga eléctrica; es neutro.

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

La mayoría de los núcleos atómicos contienen más neutrones que protones. Los protones se encuentran tan juntos en el interior de un núcleo tan pequeño que se deberían repeles sí fuertemente, debido a que tienen cargas eléctricas del mismo signo. Sin embargo, hay una fuerza que los mantiene unidos estrechamente y que es mucho más potente e intensa que la fuerza electromagnética: la fuerza o interacción nuclear fuerte, unas 102 veces mayor que la electromagnética, y aparece sólo hadrones para mantener a los nucleones confinados dentro del núcleo. Actúa a una distancia tan corta como 10–15metros, o lo que es lo mismo, 0’000000000000001 metros.

La interacción fuerte está mediada por el intercambio de mesones virtuales, 8 gluones que, como su mismo indica (glue en inglés es pegamento), mantiene a los protones y neutrones bien sujetos en el núcleo, y cuanto más se tratan de separar, más aumenta la fuerza que los retiene, que crece con la distancia, al contrario que ocurre con las otras fuerzas.

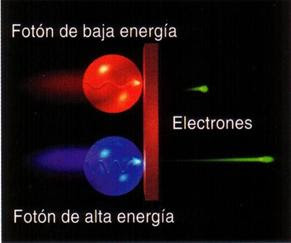

La luz es una manifestación del fenómeno electromagnético y está cuantizada en “fotones”, que se comportan generalmente como los mensajeros de todas las interacciones electromagnéticas. Así mismo, como hemos dejado reseñado en el párrafo anterior, la interacción fuerte también tiene sus cuantos (los gluones). El físico japonés Hideki Yukawa (1907 – 1981) predijo la propiedad de las partículas cuánticas asociadas a la interacción fuerte, que más tarde se llamarían piones. Hay una diferencia muy importante los piones y los fotones: un pión es un trozo de materia con una cierta cantidad de “masa”. Si esta partícula está en reposo, su masa es siempre la misma, aproximadamente 140 MeV, y si se mueve muy rápidamente, su masa parece aumentar en función E = mc2. Por el contrario, se dice que la masa del fotón en reposo es nula. Con esto no decimos que el fotón tenga masa nula, sino que el fotón no puede estar en reposo. Como todas las partículas de masa nula, el fotón se mueve exclusivamente con la velocidad de la luz, 299.792’458 Km/s, una velocidad que el pión nunca puede alcanzar porque requeriría una cantidad infinita de energía cinética. Para el fotón, toda su masa se debe a su energía cinética.

Una de las fuentes productoras de rayos cósmicos es el Sol

Los físicos experimentales buscaban partículas elementales en las trazas de los rayos cósmicos que pasaban por aparatos llamados cámaras de niebla. Así encontraron una partícula coincidente con la masa que debería tener la partícula de Yukawa, el pión, y la llamaron mesón (del griego medio), porque su masa estaba comprendida la del electrón y la del protón. Pero detectaron una discrepancia que consistía en que esta partícula no era afectada por la interacción fuerte, y por tanto, no podía ser un pión. Actualmente nos referimos a esta partícula con la abreviatura μ y el de muón, ya que en realidad era un leptón, hermano gemelo del electrón, pero con 200 veces su masa.

emilio silvera

por Emilio Silvera ~

por Emilio Silvera ~

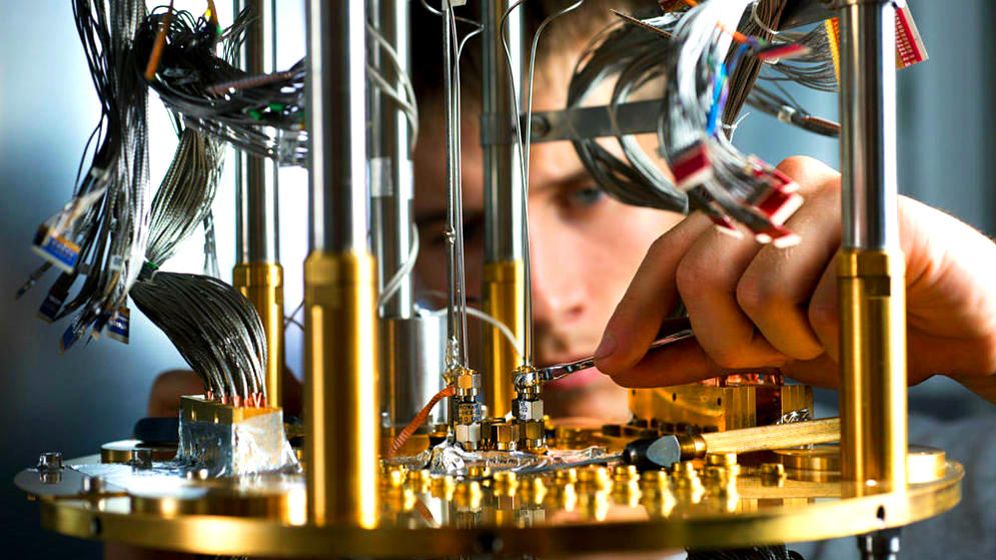

Clasificado en Computación cuantica ~

Clasificado en Computación cuantica ~

Comments (8)

Comments (8)

El joven Max Planck

Si Max Planck fue el padre de la física cuántica, Juan Ignacio Cirac sentó las bases teóricas para su aplicación a la computación. Es el idéologo del ordenador cuántico. Cirac es físico. Fue la persona más joven en recibir el premio Príncipe de Asturias de Ciencias por ser, según el jurado, “un referente internacional que ha producido algunas de las ideas más originales y brillantes tanto en el campo de la información cuántica como en el de la física atómica”.

Ignacio Cirac – Director del Instituto MAX PLANCK de Óptica Cuántica.

Desde 2001 vive en Alemania donde dirige la División Teórica del Instituto Max-Planck de Óptica Cuántica en Garching. Hablamos con él desde su despacho en Munich, aunque el próximo día 25 estará en Madrid para cerrar la sesión plenaria de Retina LTD, el evento organizado por EL PAÍS RETINA en en el que expertos de todo el mundo presentarán las últimas tendencias en innovación y tecnología.

Empecemos fuerte, ¿ la computación cuántica es otra de esas “revoluciones” que va a cambiar el mundo?

/s3.amazonaws.com/arc-wordpress-client-uploads/infobae-wp/wp-content/uploads/2018/07/23092437/Computacion-cuantica.jpg)

La promesa de la computación cuántica que cuando llegue cambiará nuestro mundo

La computación cuántica es un a nueva forma de hacer cálculos con ordenadores, muy distinta a la forma en la que los utilizamos actualmente y eso hace que nos de nuevas posibilidades. Aumentará la capacidad de proceso y nos permitirá realizar operaciones matemáticas que antes eran imposibles. Pero es importante entender dos aspectos importantes en su evolución. Por un lado, sabemos ya que un ordenador cuántico supondrá una mejora sustancial en la capacidad operacional para resolver problemas en ámbitos muy específicos, pero estos ámbitos no son infinitos y no podemos esperar que esta nueva forma de computación aplique a cualquier problema. Por otro lado estos ordenadores tardarán en llegar. Grandes empresas como Google IBM o Alibaba tienen ya prototipos y se han logrado grandes avances pero son eso, prototipos, y hasta que estos evolucionen a sistemas que podamos utilizar pasarán 10 o 15 años. Por eso debemos descartar esa idea que a menudo aparece en la prensa de que los ordenadores cuánticos están a la vuelta de la esquina y van a ser capaces de solucionar todos los problemas de la humanidad.

Retina LTD: la cita de los líderes de la nueva generación de la economía

El próximo 25 de octubre, en los Auditorios Nouvel del Museo Reina Sofía, tendrá lugar una nueva edición de Retina LTD, que reunirá a algunos de los líderes más influyentes de distintos sectores y contará con la participación de directivos y CEOs, que debatirán y compartirán sus experiencias a lo largo de la jornada.

El evento estará dividido en dos sesiones. En la sesión de mañana, se hará un recorrido de la mano de destacados profesionales de empresas globales líderes por las distintas esferas de la disrupción digital que impactan en las organizaciones: estrategia, organización y tecnología. En la sesión de tarde, habrá diferentes salas con contenidos paralelos, segmentadas por roles y dirigidas a profesionales de tecnología, marketing, recursos humanos y departamentos legales

Resumiendo, que ni tanto ni tan pronto…¿pero en esos ámbitos específicos, que mejoras podemos esperar en lo que a capacidad de proceso se refiere?

La tecnología cuántica en computación asombrará al mundo y nos llevará a un nivel superior

Dependerá mucho del ámbito de aplicación. Por ejemplo en algunos cálculos, como el de factorizar, la mejora será exponencial. Cálculos que con un ordenador actual tardarían en realizarse toda la edad del universo se podrán realizar en minutos. Sin embargo en otras áreas las ganancias, siendo muy importantes, no serán exponenciales sino lineales como es el caso de las búsquedas en bases de datos. Eso sí el impacto económico de estas reducción en el tiempo de búsqueda puede ser muy alto.

Pero el avance no se limita a la capacidad de proceso. Estamos en la segunda revolución cuántica que va más allá de la computación y los ordenadores. La física cuántica tiene aplicación en las comunicaciones, permite diseñar nuevos sensores y desarrollar métodos de medida de precisión. Dentro de pocos años tendremos estas tecnologías cuánticas en nuestros móviles. Una de las aplicaciones más inmediatas es en el área de la seguridad. Las tecnologías cuánticas permiten encriptar mensajes que no pueden ser desencriptados con ninguna otra tecnología, lo que podría suponer un gran avance en la lucha contra la ciberdelincuencia. Hoy hay ya empresas comercializando este tipo de aplicaciones y países como Corea ya han realizado pequeños despliegues. Son tecnologías cuánticas que están en un nivel de desarrollo mayor que los ordenadores en este momento.

I.A. y C.C., irán cogidas de la mano

Hablabas antes de datos, lo que nos conecta a otras grandes tendencias del momento como Big Data o Inteligencia artificial que serán temas centrales también de RetinaLTD. ¿ Cómo interactúa la computación cuántica con estas tendencias?

Parece que uno de los ámbitos de aplicación de la computación cuántica delos que hablábamos antes será la inteligencia artificial y el tratamiento de datos que es básicamente lo que hacen los algoritmos, analizar grandes cantidades de datos para tomar decisiones. No estamos todavía completamente seguros, pero la mayoría de científicos y empresas coincidimos en que los ordenadores cuánticos acelerarán los algoritmos de inteligencia artificial y machine learning y abrirán nuevas puertas y casos de uso. De hecho existe una interacción muy grande entre las personas que están desarrollando tecnologías cuánticas y los científicos de datos e investigadores que trabajan con inteligencia artificial. Los algoritmos de inteligencia artificial son uno de los primeros casos de uso de los ordenadores cuánticos, pero a su vez se usan algoritmos para mejorar el diseño de estos ordenadores por lo que son dos campos que se retroalimentan.

Europa ha liderado la investigación científica en tecnología cuánticas durante más de 20 años, pero es cierto que en estos últimos dos o tres Estados Unidos nos está ganando en su desarrollo industrial

En el caso de la inteligencia artificial, se habla de una revolución muy polarizada geográficamente. Las grandes inversiones y avances se concentran en Estados Unidos y China y el resto del mundo parece estar muy a la zaga. ¿Pasa algo similar con las tecnología cuánticas?

Yo diría que Europa ha liderado la investigación científica en tecnología cuánticas durante más de 20 años, pero es cierto que en estos últimos dos o tres Estados Unidos nos está ganando en su desarrollo industria. Sus empresas, con grandes inversiones, han conseguido avances significativos. Si uno ve las empresas que están desarrollando ordenadores cuánticos, la mitad son estadounidenses y la otra mitad chinas. En Europa prácticamente no hay ninguna. Hablamos de tendencias que sin duda van a tener un impacto económico, y los estados europeos deberían plantearse estratégicamente el rol que las tecnologías cuánticas o la inteligencia artificial pueden jugar en la digitalización de su economía.

/s3.amazonaws.com/arc-wordpress-client-uploads/infobae-wp/wp-content/uploads/2018/03/21123750/IBM-Laboratorio-computacion-cuantica-1920.jpg)

Esta disonancia entre la investigación científica y su desarrollo empresarial suele citarse como uno de los grandes déficits del modelo Europeo. ¿Crees que la transferencia tecnológica entre la investigación y la empresa es una asignatura pendiente en nuestro continente?

Creo que en general, Estados Unidos o Japón están muchos más avanzados en este ámbito. Pero veo excepciones, en Alemania, donde vivo, empresas como Siemens o Infineon son ejemplos de éxito. El sector de la automoción es un referente. Marcas como BMW tienen grandes acuerdos con universidades; muchos departamentos de ingeniería aquí en Munich están financiados por empresas del sector del automóvil y la conexión con la investigación es excelente. Quizás la principal diferencia con Estados Unidos es que aquí solo las grandes empresas se embarcan en este tipo de proyectos cuando allí compañías de todos los tamaños tienen recursos de I+D y se vinculan a la investigación científica. Pese a esto en Europa ya tenemos casos interesantes: en Ginebra una empresa que desarrolla soluciones de seguridad con tecnologías cuánticas tiene ya más de 200 empleados y sus beneficios superan el millón de euros.

Parece un momento interesante para los investigadores con todavía multitud de cuestiones abiertas…

Sin duda, para los investigadores esta incertidumbre crea un momento muy interesante. Quizás no lo sea tanto para las empresas, especialmente para las pequeñas a las que cuesta conseguir financiación para proyectos que no tendrán retorno hasta dentro de 10 o 15 años. Probablemente el camino para ellas no sea construir ordenadores cuánticos sino buscar aplicaciones de estos a su negocio.